Материалы по тегу: llm

|

13.01.2025 [23:15], Владимир Мироненко

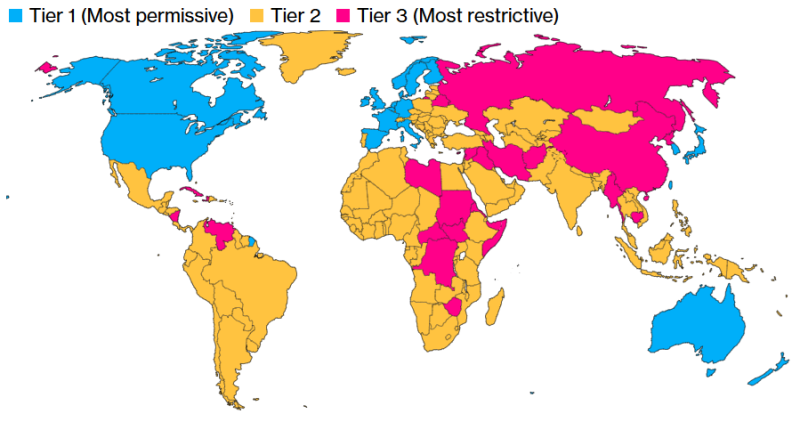

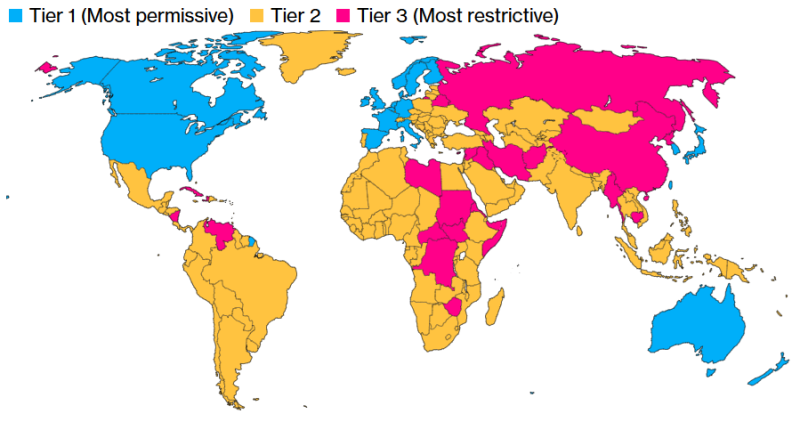

Полупроводниковая отрасль США раскритиковала новые ограничения на экспорт ИИ-чипов и ИИ-моделейАдминистрация США объявила в понедельник о введении в действие правила AI Diffusion rule («Правило распространения ИИ»), которым теперь будет регулироваться режим экспортного контроля ИИ-технологий. 20 близким союзникам и партнерам США будет предоставлен беспрепятственный доступ к ИИ-чипам и мощным ИИ-моделям. При этом требования лицензирования теперь касаются большинства других стран, пишет Financial Times. Как сообщается, цель новых ограничений — затруднить для Китая использование других стран для обхода существующих ограничений США и получения технологий, которые могут быть использованы для укрепления военной мощи КНР — от моделирования ядерного оружия до разработки гиперзвуковых ракет. Новое правило предлагает трёхуровневую систему лицензирования для чипов, используемых в ИИ ЦОД. Верхний уровень (Tier I) включает членов G7, а также Австралию, Новую Зеландию, Южную Корею, Тайвань, Нидерланды и Ирландию, которые не будут подвергаться ограничениям. Страны Tier II, не подпадающие под контроль вооружений, смогут получить до 1700 новейших ИИ-ускорителей без специального разрешения. Если нужно больше чипов, придётся подать заявку на получение специальной лицензии. Также лицензия потребуется для получения доступа к самым мощным закрытым моделям ИИ. Для получения лицензии компании должны будут иметь адекватное обеспечение физической защиты и кибербезопасности. Третий уровень (Tier III) включает такие страны, как Китай, Иран, Россия и Северная Корея, на которые также распространяется эмбарго на поставки оружия. Эти страны подпадают под полный запрет на поставку продвинутых технолгий ИИ. Новым правилом также впервые ограничивается их доступ к передовым ИИ-моделям. Вместе с тем правило не распространяется на деятельность в цепочке поставок, включая проектирование, производство и хранение чипов. Администрация Байдена заявила, что правило также не будет ограничивать доступ к моделям ИИ с открытым исходным кодом, таким как Llama от Meta✴. «Полупроводники, которые питают [ИИ], и мощные модели, как мы все знаем, являются технологией двойного назначения, — отметила министр торговли США Джина Раймондо (Gina Raimondo) перед объявлением нового правила. — Они используются во многих коммерческих приложениях, но также могут использоваться нашими противниками для ядерного моделирования, разработки биологического оружия и развития своих армий». Введение ограничений на международные продажи ИИ-технологий в критический момент для отрасли вызвало яростную реакцию со стороны полупроводниковой промышленности США, отметила Financial Times. На прошлой неделе Ассоциация полупроводниковой промышленности США (SIA) и Фонд информационных технологий и инноваций США (ITIF), комментируя подготовку властями этого правила с предварительным названием Export Control Framework for Artificial Intelligence Diffusion (Рамки экспортного контроля для распространения ИИ), выступили с заявлениями, в которых говорилось, что его введение даст иностранным конкурентам лишь преимущество перед американскими компаниями.

Источник изображения: Bloomberg «Отрасль по-прежнему обеспокоена настойчивостью администрации в публикации сложного и значимого правила такого рода — без каких-либо предварительных консультаций с индустрией или другими заинтересованными сторонами — в последние дни срока полномочий президента Байдена», — написал Джейсон Оксман (Jason Oxman), президент Совета индустрии информационных технологий (ITI) министру торговли Раймондо за несколько дней до публикации правила, сообщил ресурс WTTLonline. Исполнительный вице-президент Oracle Кен Глак (Ken Gluck) заявил в блоге, что новое ограничение администрации Байдена войдет в историю как «одно из самых разрушительных, когда-либо ударявших по технологической отрасли США». NVIDIA назвала новое правило «беспрецедентным и ошибочным». «Хотя эти правила и замаскированы под “антикитайские” меры, они никак не повысят безопасность США. Вместо того чтобы смягчить любую угрозу, они лишь ослабят глобальную конкурентоспособность Америки, подрывая инновации, обеспечивавшие лидерство США», — сообщила компания.

10.01.2025 [14:21], Руслан Авдеев

ИИ по квотам: США распространят ограничения на поставку ускорителей и обучение моделей почти на весь мирАдминистрация действующего президента США Джо Байдена (Joe Biden) до окончания своих полномочий намерена провести очередной раунд ограничений на экспорт ИИ-чипов. Это новая попытка перекрыть доступ к передовым технологиям Китаю, Ирану, России и другим странам, сообщает Bloomberg. После появления новостей акции NVIDIA и AMD несколько упали в цене. По данным источников, США намерены ограничить продажи ИИ-полупроводников для ЦОД как на уровне стран, так и на уровне отдельных компаний. Основная цель — обеспечить развитие передовых ИИ-систем только «дружественным» государствам и приведение мирового бизнеса в соответствие с американскими стандартами. В результате ограничения в той или иной степени распространятся почти на весь мир. Неограниченный доступ к современным технологиям сохранит только небольшая группа союзников США вроде Канады, ряда стран ЕС, Южной Кореи и Японии. Остальным доступ постараются перекрыть максимально, а большая часть мира, по мнению администрации, оказалась недостаточно благонадёжной, чтобы покупать ИИ-ускорители без ограничений. Появятся квоты, ограничивающие вычислительные способности каждой отдельной страны. Компании, базирующиеся в таких странах, могут обойти подобные ограничения — но для этого им необходимо будет привести свой бизнес в соответствие с американскими стандартами. Для этого вводится термин «проверенный конечный пользователь» (Validated End User, VEU). Разумеется, в NVIDIA выступили против инициативы, подчеркнув, что ограничение экспорта не прекратит злоупотребления, но создаст угрозу экономическому росту и поставит под вопрос лидерство США. Пока общемировой интерес к ускоренным вычислениям в повседневной жизни — невероятная возможность для экономики Соединённых Штатов. Многолетние санкции уже ограничивают возможности NVIDIA, AMD и др. компаний поставлять передовые чипы любому заказчику. Теперь США пытаются ограничить доступ к чипам через посредников на Ближнем Востоке и в Юго-Восточной Азии. Против инициативы выступает и Ассоциация полупроводниковой промышленности (Semiconductor Industry Association). Ассоциация не одобряет принятия решения в период смены президентов, без учёта мнения отрасли — это может сказаться на конкурентоспособности США в мире. Китай имеет собственные ИИ-чипы, хотя и не такие производительные и, возможно, будет поставлять их и другим странам, усиливая своё влияние. Новые меры готовятся ввести на фоне гигантского спроса на ИИ-ускорители. Буквально каждая страна намерена использовать их в своих ЦОД, в чём и заключается «уникальная возможность» США и в политической плоскости — чтобы, по словам конгрессменов, «увести компании и страны с орбиты Пекина». К первому «разряду» (Tier I), по данным источников издания, отнесут США и 18 союзников, включая Канаду, Австралию, Японию, Великобританию, Германию, Францию, Южную Корею и Тайвань. Компании из этих регионов могут свободно пользоваться вычислительными ресурсами, а их штаб-квартиры в этих странах смогут получить разрешение на поставку чипов в ЦОД практически по всему миру. Однако им запрещено размещать более 25 % вычислительных мощностей за пределами стран Tier I и более 7 % — в любой из стран Tier II. Кроме того, они должны будут соблюдать требования к безопасности, выдвигаемые американским правительством. Компании со штаб-квартирами в США должны будут размещать не менее половины вычислительных мощностей на американской земле. В целом США и приближённые страны, согласно новому плану, должны располагать большими вычислительными мощностями, чем весь остальной мир. Подавляющее большинство стран относится ко второму разряду (Tier II). Каждой из них можно внедрить порядка 50 тыс. ИИ-ускорителей с 2025 по 2027 гг. При этом отдельные компании могут добиться гораздо больших лимитов, если получат статус VEU в каждой стране, где намерены оснастить ЦОД. Для этого необходимо иметь доказанную историю соблюдения американских норм и стандартов в сфере прав человека, или, как минимум, иметь убедительные планы для достижения необходимых результатов. Если компания получит статус VEU, её импорт чипов не будет сказываться на общей квоте страны. Это поощряет бизнес приводить свою деятельность в соответствие с американскими стандартами. Вместе с тем накладываются и требования по физической безопасности объектов, кибербезопасности и отбору персонала. Наконец, больше всего ограничения коснутся России, Беларуси, Китая, Ирана, КНДР, а также всех стран, на которые распространяется американское эмбарго на поставки вооружений. Речь идёт приблизительно о двух дюжинах государств уровня Tier III. Поставки ИИ-ускорителей в ЦОД этих стран будут запрещены. Помимо контроля над полупроводниками, новые правила также ограничивают и экспорт закрытых ИИ-моделей. Компаниям будет запрещён их хостинг в странах Tier III, а страны Tier II должны будут выполнять ряд требований. Конечно, ограничения не распространяются на страны, получившие универсальный статус VEU. Открытых моделей эти правила не коснутся, то же касается и маломощных закрытых моделей, менее производительных, чем имеющиеся в свободном доступе. Тем не менее, если компания захочет настроить открытую модель для выполнения специальных задач и этот процесс потребует значительных вычислительных мощностей, ей также понадобится подавать заявку на получение разрешения США для выполнения подобных задач в странах Tier II. Ранее США запрещали поставки в страны вроде России на неопределённый срок. В Китай разрешено было поставлять версии с ограниченной функциональностью, а в ноябре прошлого года появилась новость, что США запретили TSMC выпускать передовые ускорители по заказу китайских компаний. На большинство стран мира ограничения не распространялись, что способствовало стремительному росту бизнеса NVIDIA.

26.12.2024 [12:32], Владимир Мироненко

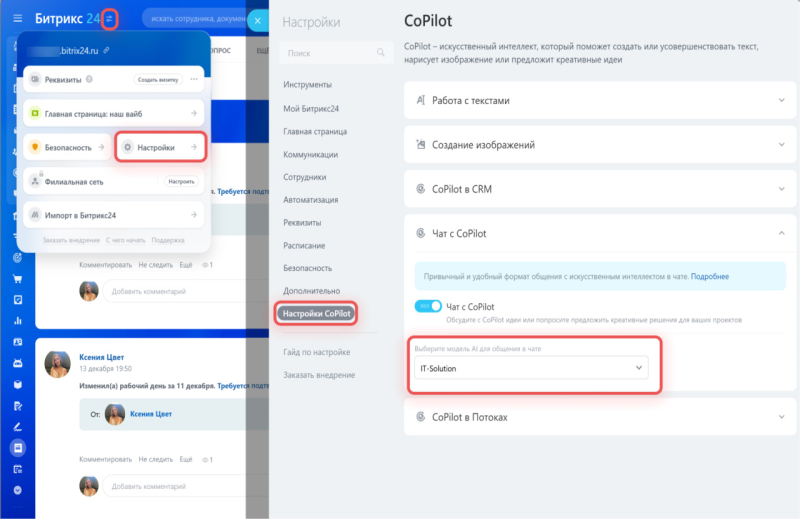

«Битрикс24» представил собственную ИИ-модель BitrixGPTРоссийский сервис для управления бизнесом «Битрикс24» представил ИИ-модель собственной разработки BitrixGPT 4x, призванную упростить пользователям работу с ежедневными задачами. Как показала внутренняя аналитика «Битрикс24», бизнес стал чаще использовать нейросети. Наибольший интерес к использованию нейросетей отмечен у крупных компаний с большим количеством сотрудников, в которых автоматизировать процессы сложнее, а уровень рутины выше. Для оптимизации работы 57,5 % порталов в них регулярно используют ИИ для расшифровки звонков, составления резюме разговора и заполнения карточек в CRM. И хотя бы раз нейросети в работе попробовали 80 % порталов, пишет CNews со ссылкой на представителей «Битрикс24». Наиболее популярным инструментом в «Битрикс24» является «Чат с CoPilot», который помогает пользователям в решении различных задач: от написания seo-текстов и писем до анализа кода и составлением стратегии. Им пользуются в 58 % случаев. 48 % порталов используют «Чат с Copilot» более 15 дней в месяц. Модель BitrixGPT доступна в коробочной версии продукта. В 2025 году она станет доступна для облачных порталов «Битрикс24», а также будет моделью по умолчанию в CoPilot. Пользователи также смогут по-прежнему воспользоваться GigaChat, YandexGPT, и подключить партнёрское или собственное решение.

24.12.2024 [19:26], Владимир Мироненко

VK запустила инициативу OpenVK для публикации ПО с открытым кодомVK объявила о запуске инициативы OpenVK для публикации ПО с открытым кодом, которая «будет способствовать обмену знаний и опытом между профессионалами ИТ-отрасли», стимулируя развитие сообщества разработчиков благодаря предоставлению доступа к передовым технологиям и инструментам. Главные направления OpenVK: ИТ-системы и продукты, инструменты и библиотеки для разработчиков, а также ИИ-модели. Уже сейчас на OpenVK доступны платформа Tarantool для создания высоконагруженных приложений, система визуализации данных для мониторинга StatsHouse, дизайн-система VKUI для создания удобных пользовательских интерфейсов, инструмент для патчинга байт‑кода Android‑приложений ByteWeaver, ИИ-модели и библиотеки для их создания и т.д. В их числе есть и модель для синтеза речи EmoSpeech, которая позволяет генерировать эмоциональную и естественную речь. Согласно пресс-релизу, ресурс будет регулярно пополняться новыми продуктами, которые также принесут пользу сообществу разработчиков решений с открытым кодом. «Открытый исходный код — основной драйвер развития IT во всём мире. Без него нейросети, быстрые базы данных и современный интернет могли бы не появиться», — отметила VK, одна из первых компаний в России, которые открыли исходный код собственных проектов. «Мы понимаем, что надо не только брать из open source, но и отдавать. Поэтому мы хотим делиться функциональными инструментами и разработками, которые были созданы внутри VK и принесут реальную пользу сообществу», — подчеркнула VK.

17.12.2024 [08:38], Руслан Авдеев

В 2025 году в Европе появится сразу семь ИИ-фабрик EuroHPC

eurohpc

hardware

hpc

llm

германия

греция

европа

евросоюз

ии

испания

италия

люксембург

суперкомпьютер

финляндия

швеция

Консорциум EuroHPC выбрал площадки для первых европейских ИИ-фабрик (AI Factory), которые появятся В 2025 году в Финляндии, Германии, Греции, Италии, Люксембурге, Испании и Швеции. Всего в проекте участвуют 17 стран. В Финляндии, Германии, Италии, Люксембурге и Швеции будут установлены новые ИИ-суперкомпьютеры. В Испании фабрика будет создана путём модернизации суперкомпьютера MareNostrum 5. В Греции фабрика будет связана с суперкомпьютером DAEDALUS, внедрение которого происходит сейчас. В Испании и Финляндии AI Factory будут включать в себя экспериментальную платформу, которая послужит передовой инфраструктурой для разработки и тестирования инновационных ИИ-моделей и приложений. Первые семь фабрик объединят как ресурсы отдельных стран, так и ресурсы ЕС в целом. Инициатива EuroHPC AI Factories призвана создать надёжную и взаимосвязанную сеть ИИ-хабов, которые предоставят ИИ-стартапам, малому и среднему бизнесу и исследователям комплексную поддержку, включая доступ к оптимизированным для ИИ и HPC ресурсам, обучению и техническому опыту. Финская ИИ-фабрика предложит передовую вычислительную платформу LUMI-AI и доступ к новым источникам данных, а также сервисному центру и кадровому резерву. Систему разместят в IT-центре CSC, расположенном в Каяани рядом с действующим суперкомпьютером LUMI. В консорциуме LUMI AI Factory помимо Финляндии участвуют Чехия, Дания, Эстония, Норвегия и Польша. В Германии на базе HammerHAI (Hybrid and Advanced Machine Learning Platform for Manufacturing, Engineering, And Research @ HLRS) будет создан единый центр для промышленности и академических кругов. Особое внимание будет уделяться барьерам, в настоящее время мешающим использовать ИИ стартапам и бизнеса. Новая облачная ИИ-платформа разместится в HPC-центре Штутгарта (HLRS) и будет создана при участии GWDG, BADW-LRZ, KIT и SICOS. HammerHAI обеспечит комплексную поддержку на протяжении всего цикла разработки ИИ, от обучения модели до инференса, а также поддержку пользователей и профессиональное образование. Также будут подготовлены базовые модели и наборы данных. Греческая ИИ-фабрика Pharos будет использовать суперкомпьютер DAEDALUS для решения задач Греции и ЕС в области здравоохранения, культуры и языка, а также устойчивого развития (энергетика, окружающая среда, климат). Предполагается комплексная поддержка пользователей, включая повышение квалификации, предоставление датасетов и обучение ИИ-моделей, а также поддержка бизнес-инноваций. Платформа будет управляться Национальной инфраструктурой исследований и технологий GRNET S.A. в Афинах, действующей под патронажем Министерства цифрового управления Греции. Особое внимание будет уделяться созданию ИИ-решений, соответствующих требованиям ЕС и отдельных индустрий. ИИ-фабрика IT4LIA, совместно создаваемая Италией, Австрией и Словенией, предоставит инфраструктуру ИИ и экосистему, которая объединит исследователей, разработчиков, стартапы и малый и средний бизнес. Это упростит доступ к ИИ-ресурсам государственным органам, студентам, учёным и бизнесу. Новая система будет сформирована в CINECA Consorzio Interuniversitario в Болонье как дополнение к суперкомпьютеру LEONARDO. ИИ-кластер производительностью более 40 Эфлопс (смешанная точность вычислений) будет в основном использоваться для внедрения ИИ в агросекторе, кибербезопасности, землепользовании и производстве. Люксембургу достанется L-AI Factory на базе ИИ-суперкомпьютера MeluXina-AI, который будет соседствовать с действующим суперкомпьютером MeluXina. Местная AI Factory призвана укрепить позиции страны в качестве европейского лидера в сфере ИИ. AI Factory обеспечит быструю адаптацию и персонализированную поддержку для всех предприятий, особенно стартапов и малого и среднего бизнеса. BSC AI Factory — совместная инициатива Испании, Португалии, Турции и Румынии, представленных Барселонским суперкомпьютерным центром (BSC-CNS), Фондом науки и технологий (FCT) и Советом научных и технологических исследований Турции (TÜBİTAK), и Национальным институтом исследований и разработок в области информатики (ICI, Бухарест). Система обеспечит внедрение ИИ в промышленности, стартапах, малом и среднем бизнесе и государственных организациях.

Источник изображения: BSC Фабрика ориентирована на услуги для государственного управления, здравоохранения, фармацевтики и биотехнологий, финансов и права, сельского хозяйства и климата, государственного сектора, энергетики, связи и средств массовой информации. В числе прочего предусмотрена модернизация суперкомпьютера MareNostrum 5 — BSC AI Factory станет частью Суперкомпьютерного центра Барселоны (BSC-CNS). Наконец, AI Factory MIMER будет организована Национальной академической суперкомпьютерной инфраструктурой (NAISS) Швеции в Университете Линчепинга в сотрудничестве с исследовательскими институтами Швеции (RISE). MIMER получит специализированный ИИ-суперкомпьютер среднего уровня, причём приоритет отдаётся облачному доступу и предоставление масштабного хранилища конфиденциальных данных. MIMER будет наращивать опыт использования ИИ в области естественных наук и здравоохранения, материаловедения, автономных систем и игровой индустрии. Проект будет сосредоточен на генеративных моделях в структурной биологии и разработке лекарств, персонализированной медицине и работе с международными партнёрами над разработкой базовых моделей следующего поколения, которые будут настроены для конкретных целей.

14.12.2024 [15:20], Сергей Карасёв

Liquid AI получила $250 млн на развитие «жидких» ИИ-моделей, в том числе от AMDСтартап Liquid AI, специализирующийся на разработке моделей генеративного ИИ с принципиально новой архитектурой, объявил о проведении раунда финансирования Series A, в ходе которого на развитие привлечено $250 млн. Деньги в числе прочих предоставила AMD. Liquid AI, связанная с Массачусетским технологическим институтом (MIT), базируется в Бостоне. Её специализация — ИИ-модели LFM, или Liquid Foundation Models. Утверждается, что такие решения по производительности идентичны или превосходят традиционные большие языковые модели (LLM), представленные на рынке. В основе современных популярных чат-ботов, таких как OpenAI ChatGPT и Google Gemini, лежит генеративный предобученный трансформер — Generative Pre-trained Transformer (GPT): для обучения применяются обширные массивы информации. Модели LFM, в свою очередь, основаны на концепции «жидких» нейронных сетей. Для работы LFM требуется меньше памяти по сравнению с GPT, что открывает новые возможности при использовании ИИ на платформах с ограниченными аппаратными ресурсами. В частности, Liquid AI предлагает три варианта моделей: LFM-1B с 1,3 млрд параметров для маломощных устройств, таких как смартфоны, LFM-3B с 3,1 млрд параметров для периферийных развертываний и LFM-40B Mixture of Experts с 40 млрд параметров для решения сложных задач. Такие модели могут использоваться корпоративными клиентами разного масштаба. В 2023 году в ходе посевного раунда стартап Liquid AI получил $46,6 млн. В программе Series A, помимо AMD, приняли участие OSS Capital, Duke Capital Partners и PagsGroup. Полученные средства будут использованы для дальнейшей разработки LFM разного размера. Кроме того, компания намерена предлагать решения, оптимизированные для конкретных отраслей, таких как потребительская электроника, биотехнологии, телекоммуникации, финансовые услуги и электронная коммерция.

12.12.2024 [23:59], Руслан Авдеев

Царь-ускоритель Cerebras WSE-3 в одиночку обучил ИИ-модель с 1 трлн параметровCerebras Systems совместно с Сандийскими национальными лабораториями (SNL) Министерства энергетики США (DOE) провели успешный эксперимент по обучению ИИ-модели с 1 трлн параметров с использованием единственной системы CS-3 с царь-ускорителем WSE-3 и 55 Тбайт внешней памяти MemoryX. Обучение моделей такого масштаба обычно требует тысяч ускорителей на базе GPU, потребляющих мегаватты энергии, участия десятков экспертов и недель на наладку аппаратного и программного обеспечения, говорит Cerebras. Однако учёным SNL удалось добиться обучения модели на единственной системе без внесения изменений как в модель, так и в инфраструктурное ПО. Более того, они смогли добиться и практически линейного масштабирования — 16 систем CS-3 показали 15,3-кратный прирост скорости обучения. Модель такого масштаба требует терабайты памяти, что в тысячи раз больше, чем доступно отдельному GPU. Другими словами, классические кластеры из тысяч ускорителей необходимо корректно подключить друг к другу ещё до начала обучения. Системы Cerebras для хранения весов используют внешнюю память MemoryX на базе 1U-узлов с самой обычной DDR5, благодаря чему модель на триллион параметров обучать так же легко, как и малую модель на единственном ускорителе, говорит компания. Ранее SNL и Cerebras развернули кластер Kingfisher на базе систем CS-3, который будет использоваться в качестве испытательной платформы при разработке ИИ-технологий для обеспечения национальной безопасности.

13.11.2024 [23:33], Руслан Авдеев

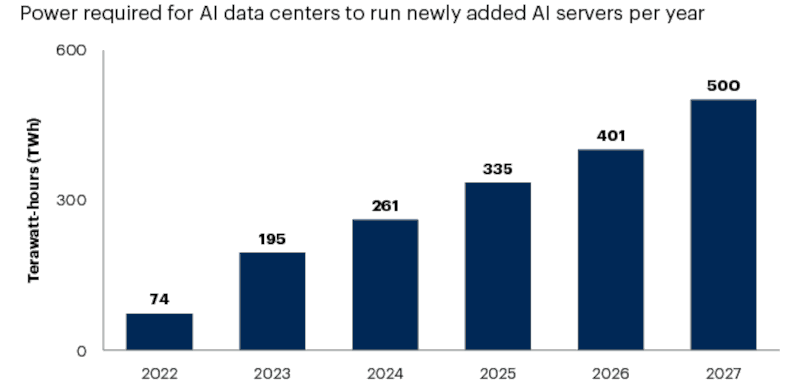

Дефицит энергии ограничит возможности 40 % ИИ ЦОД уже к 2027 годуИИ вообще и генеративный ИИ в частности привели к стремительному росту энергопотребления ЦОД — по прогнозам агентства Gartner, в следующие два года рост составит 160 %. В результате ожидается, что 40 % существующих ИИ ЦОД будут ограничены в энергоресурсах к 2027 году. Как утверждают в агентстве, взрывной рост новых ИИ ЦОД гиперскейл-уровня обеспечивает постоянный рост спроса на электроэнергию, который совсем скоро превысит возможности поставщиков электричества. Это грозит нехваткой энергии и перебоями в энергоснабжении, что ограничит рост новых ЦОД для систем генеративного ИИ и прочих целей с 2026 года. По оценкам Gartner, для обеспечения работы для ИИ серверов в 2027 году понадобится 500 ТВт∙ч, что в 2,6 раза больше, чем в 2023 году. Дефицит энергии может затянуться, поскольку на создание новой инфраструктуры для генерации, распределения и доставки энергии уйдут годы, а уже назревшие проблемы никуда не денутся. В скором будущем число новых ЦОД и развитие систем генеративного ИИ будет определяться доступностью энергии. В Gartner рекомендуют организациям и компаниям оценить влияние риск дефицита энергии на их продукты и сервисы. Стоит не только принимать в расчёт рост стоимости электричества при планировании новых продуктов и сервисов, но и искать новые решения, требующие меньше энергии.

Источник изображения: Gartner Неизбежно связанное с дефицитом повышение цен на электричество увеличит стоимость эксплуатации больших языковых моделей (LLM). Хотя ключевые пользователи электроэнергии заранее работают над заключением долгосрочных контрактов, зачастую по фиксированным ставкам, стоимость энергии для питания дата-центров в любом случае значительно вырастет. Это скажется на стоимости ИИ как продукта и бизнесе соответствующих сервис-провайдеров. Вероятно, цели по достижению экоустойчивости при этом пострадают. Ранее уже прогнозировалось, что операторы ЦОД не смогут добиться заявленных целей, теперь к сходным выводам приходят и в Gartner. В краткосрочной перспективе растущий спрос заставит поставщиков добывать энергию любыми доступными способами. В некоторых случаях это означает сохранение электростанций на ископаемом топливе, которые при других обстоятельствах закрылись бы в плановом порядке. В Gartner подчёркивают, что масштабирование ЦОД приведёт и к росту выбросов CO2 в краткосрочной перспективе.

Источник изображения: Janusz Walczak/unsplash.com Дата-центрам требуется энергоснабжение в режиме 24/7, а такого не могут обеспечить классические ветряные и солнечные электростанции. Надёжно поставлять энергию в больших объёма могут только ГЭС, станции на ископаемом топливе и АЭС. В долгосрочной перспективе новые технологии энергохранилищ (вроде натрий-ионных аккумуляторов) или «чистая» энергия вроде малых модульных реакторов (SMR) позволит легче добиваться ESG-целей. В Gartner рекомендуют пересмотреть цели достижения экоустойчивости, связанные с выбросами углекислого газа с учётом будущих требований ЦОД и доступности источников энергии в ближайшие годы. При разработке ИИ-приложений стоит сконцентрировать усилия на использовании минимальных вычислительных мощностей и оценивать другие возможности вроде широкого применение периферийных вычислений и т.н. малых языковых моделей (SLM), имеющих узкую специализацию.

05.11.2024 [17:34], Руслан Авдеев

Развитие генеративного ИИ всё больше зависит от доступности качественных данных, пресной воды, электроэнергии и чистой медиСистемам генеративного ИИ требуются самые разные ресурсы, но в некоторых сферах их нехватка может носить критический характер. По данным DigiTimes, серьёзную проблему может составить нехватка качественных массивов данных, рост потребления электроэнергии и пресной воды, а также дефицит поставок меди для IT-индустрии. Как сообщают эксперты CB Insights, к 2026 году может снизиться доступность высококачественных данных для обучения языковых моделей. В результате их разработчикам придётся полагаться либо на дорогие лицензированные данные, либо на синтезированные самим же ИИ наборы данных. С 2022 года около 50 вендоров уже вышли на рынок синтетических данных для обучения, а ещё 30 компаний ищут средства. Однако выход на этот рынок гигантов вроде Microsoft и Meta✴ сократил возможности привлечения средств стартапами. В 2024 году в этой сфере отмечены всего пять раундов финансирования, тогда как в 2022 году был 21 раунд. Кроме того, теперь в некоторых стартапах соответствующего профиля начались и увольнения, а израильская Datagen, основанная ещё в 2018 году, подала заявление о банкротстве. При этом Scale AI, основанная чуть раньше, сумела привлечь $1 млрд. Развитие ИИ также значительно увеличивает энергопотребление, например, ИИ-поиск Google, по слухам, требует в 10 раз больше энергии, чем обычный. По информации Международного энергетического агентства (IEA), спрос на электроэнергию, связанный ЦОД. ИИ и криптовалютами, достиг в 2022 году 460 ТВт∙ч, а к 2026 году должен вырасти до 620–1050 ТВт∙ч. По оценкам IEA к 2026 году отрасли на основе ИИ, возможно, будут потреблять в 10 раз больше энергии, чем в 2023 году. Компенсировать спрос частично могут технологические инновации в сфере энергетики. Исследователи Central Research Institute of Electric Power Industry (CRIEPI) отмечают, что развитие энергосберегающих технологий может вдвое снизить рост спроса на электричество. Впрочем, коммерческая судьба таких проектов не всегда благоприятна. Развитию ИИ угрожает и рост потребления воды системами охлаждения ЦОД. В 2023 году Microsoft сообщала о 23-% росте потребления воды до 7,844 млн м3, в основном из-за расширения ЦОД. Например, обучение модели OpenAI GPT-3 с 175 млрд параметров потребовало 700 м3 только на охлаждение серверов в новейшем американском ЦОД Microsoft. С учётом воды, потраченной при генерации энергии и производстве оборудования, расход составил и вовсе 5,4 тыс. м3. А при эксплуатации GPT-3 каждый диалог из 10–50 запросов обходился в 0,5 л воды. К 2027 году спрос на воду на охлаждение и производство энергии во всех ЦОД должен достичь 4,2–6,6 млрд м3/год. Приблизительно столько за полгода потребляет Великобритания. Наконец, угрозу индустрии ИИ представляет дефицит меди. Спрос на медь растёт вместе со спросом на возобновляемую энергию, электротранспорт и генеративный ИИ. По данным JPMorgan Chase & Co. К 2030 году только ИИ ЦОД могут требовать 2,6 млн т меди ежегодно. Каждый дополнительный МВт ёмкости может требовать 20–40 т меди. Дефицит предложения меди по прогнозам вырастет до 4 млн т в год к 2030 году, спрос ИИ-индустрии добавит этому показателю ещё 2,6 млн т. Здесь тоже могут помочь новые технологии, способные прямо или косвенно снизить спрос или замедлить его рост. По оценкам Macquarie Investment Bank, ежегодный рост спроса на медь может быть ограничен 200 тыс. т до 2030 года — другие аналитики куда более пессимистичны. Оценка потребления для ЦОД составляет 27 т/МВт, что приблизительно соответствует оценкам JPMorgan. В Macquarie отмечают, что технологии энергосбережения помогут компенсировать рост энергопотребления ИИ-инфраструктурой, а также рост использования меди в отрасли.

08.10.2024 [12:36], Сергей Карасёв

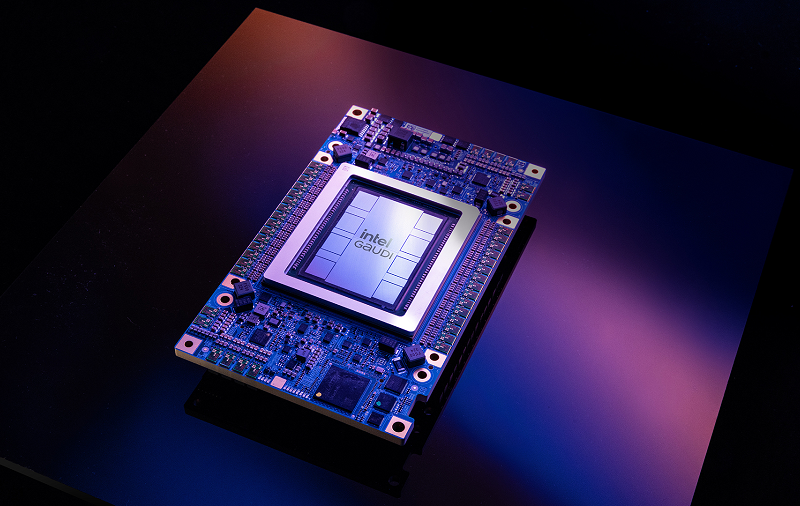

Inflection AI и Intel представили ИИ-систему на базе Gaudi3Стартап Inflection AI и корпорация Intel объявили о сотрудничестве с целью ускорения внедрения ИИ в корпоративном секторе. В рамках партнёрства состоялся анонс Inflection for Enterprise — первой в отрасли ИИ-системы корпоративного класса на базе ускорителей Intel Gaudi3 и облака Intel Tiber AI Cloud (AI Cloud). Inflection AI основана в 2022 году Мустафой Сулейманом (Mustafa Suleyman), одним из основателей Google DeepMind, а также Ридом Хоффманом (Reid Hoffman), одним из учредителей LinkedIn. Стартап специализируется на технологиях генеративного ИИ. В середине 2023 года Inflection AI получила на развитие $1,3 млрд: в число инвесторов вошли Microsoft и NVIDIA. Inflection for Enterprise объединяет Gaudi3 с большой языковой моделью (LLM) Inflection 3.0. Утверждается, что это ПО при использовании на аппаратной платформе Intel демонстрирует вдвое более высокую экономическую эффективность по сравнению с некоторыми конкурирующими изделиями. Заказчики получат LLM, настроенную в соответствии с их пожеланиями. Для удовлетворения потребностей каждого конкретного клиента применяется обучение с подкреплением на основе отзывов людей (RLHF). При этом используются данные, предоставленные самим заказчиком.

Источник изображения: Intel Отмечается, что облако AI Cloud упрощает создание, тестирование и развёртывание ИИ-приложений в единой среде, ускоряя время выхода продуктов на рынок. Тонко настроенные ИИ-модели доступны исключительно клиенту и не передаются в третьи руки. На первом этапе системы Inflection for Enterprise будут предлагаться через облако AI Cloud. В I квартале 2025 года планируется организовать поставки программно-аппаратных комплексов. |

|