Материалы по тегу: llm

|

06.08.2024 [16:17], Руслан Авдеев

LLM с доставкой на дом: в продаже появились жёсткие диски с комплектом открытых ИИ-моделейТо ли в шутку, то ли всерьёз компания Torrance Computer Supply (TCS) начала продажи накопителей с предзаписанными большими язковыми моделями. Доступны как HDD ёмкостью 14 Тбайт, так и карта памяти вместимостью 1 Тбайт. HDD-вариант базируется на недорогом 14-Тбайт LFF-накопителе MDD (MDD16TSATA25672E): SATA-3, 7200 RPM, кеш 256 Мбайт. Это один из самых доступных жёстких дисков такой ёмкости, поскольку MDD занимается восстановлением б/у накопителей и продажей складских остатков крупных вендоров под своим брендом. В комплекте с жёстким диском поставляется кейс Orico и адаптер USB 3.0 с внешним питанием (12 В, 24 Вт). Согласно описанию, на жёсткий диск записаны актуальные версии более двух десятков открытых больших языковых моделей (LLM), включая различные варианты Llama, Mistral, Nemotron и др. Предлагаются версии от нескольких миллиардов до почти полутриллиона параметров максимальным объёмом до 820 Гбайт. Продавцы уверяют, что постоянно меняют набор в зависимости от изменений рынка и технологий. Покупка обойдётся в $229, но если накопитель вернуть, то можно получить $125 на дальнейшие покупки в этом же магазине. На том же сайте предлагается и комплект LLM «для бедных» — желающие могут приобрести флэш-карту SanDisk 1TB Ultra microSDXC UHS-I на 1 Тбайт с адаптером в комплекте. Этот вариант стоит всего $119 и поставляется как минимум с тремя ИИ-моделями: Llama3.1 на 8, 70 и 405 млрд параметров. Практическая ценность данных предложений сомнительна, поскольку никто не мешает скачать те же самые модели и записать их на свой накопитель. Впрочем, некоторые компании предлагают услуги по оффлайн-транспортировке данных, но в этом случае речь идёт о на порядок больших объёмах.

25.07.2024 [09:59], Сергей Карасёв

OpenAI намерена потратить до $7 млрд на обучение ИИ в 2024 году, потеряв при этом $5 млрдЗатраты OpenAI на обучение ИИ-моделей и задачи инференса в 2024 году, по сообщению The Information, могут составить до $7 млрд. При этом компания может зафиксировать денежные потери в размере $5 млрд, что вынудит её искать новые возможности для привлечения инвестиций. Как рассказали осведомлённые лица, OpenAI использует мощности, эквивалентные приблизительно 350 тыс. серверов с ускорителями NVIDIA A100. Из них около 290 тыс. обеспечивают работу ChatGPT. Утверждается, что оборудование работает практически на полную мощность. В рамках обучения ИИ-моделей и инференса OpenAI получает значительные скидки от облачной платформы Microsoft Azure. В частности, Microsoft взимает с OpenAI около $1,3/час за ускоритель A100, что намного ниже обычных ставок. Тем не менее, только на обучение ChatGPT и других моделей OpenAI может потратить в 2024 году около $3 млрд.

Источник изображения: pixabay.com На сегодняшний день в OpenAI работают примерно 1500 сотрудников, и компания продолжает расширять штат. Затраты на заработную плату и содержание работников в 2024-м могут достичь $1,5 млрд. Компания получает около $2 млрд в год от ChatGPT и может получить ещё примерно $1 млрд от взимания платы за доступ к своим большим языковым моделям (LLM). Общая выручка OpenAI, согласно недавним результатам, лежит на уровне $280 млн в месяц. В 2024 году, по оценкам, суммарные поступления компании окажутся в диапазоне от $3,5 млрд до $4,5 млрд. Таким образом, с учётом ожидаемых затрат в размере $7 млрд на обучение ИИ и инференс, а также расходов в $1,5 млрд на персонал OpenAI может потерять до $5 млрд. Это намного превышает прогнозируемые расходы конкурентов, таких как Anthropic (поддерживается Amazon), которая ожидает, что в 2024 году потратит $2,7 млрд. Не исключено, что OpenAI попытается провести очередной раунд финансирования. Компания уже завершила семь инвестиционных раундов, собрав в общей сложности более $11 млрд.

22.07.2024 [08:57], Сергей Карасёв

Mistral AI и NVIDIA представили корпоративную ИИ-модель Mistral NeMo 12B со «здравым смыслом» и «мировыми знаниями»Корпорация NVIDIA и французская компания Mistral AI анонсировали большую языковую модель (LLM) Mistral NeMo 12B, специально разработанную для решения различных задач корпоративного уровня — чат-боты, обобщение данных, работа с программным кодом и пр. Mistral NeMo 12B насчитывает 12 млрд параметров и использует контекстное окно в 128 тыс. токенов. Для инференса применяется формат данных FP8, что, как утверждается, позволяет уменьшить размер требуемой памяти и ускорить развёртывание без какого-либо снижения точности ответов. При обучении модели была задействована библиотека Megatron-LM, являющаяся частью платформы NVIDIA NeMo. При этом использовались 3072 ускорителя NVIDIA H100 на базе DGX Cloud. Утверждается, что Mistral NeMo 12B отлично справляется с многоходовыми диалогами, математическими задачами, программированием и пр. Модель обладает «здравым смыслом» и «мировыми знаниями». В целом, говорится о точной и надёжной работе применительно к широкому спектру приложений. Модель выпущена под лицензией Apache 2.0 и предлагается в виде NIM-контейнера. На внедрение LLM, по словам создателей, требуются считанные минуты, а не дни. Для запуска модели достаточно одного ускорителя NVIDIA L40S, GeForce RTX 4090 или RTX 4500. Среди ключевых преимуществ развёртывания посредством NIM названы высокая эффективность, низкая стоимость вычислений, безопасность и конфиденциальность. UPD 21.08.2024: компании представили Mistral-NeMo-Minitron 8B, более компактную, но не менее эффективную, по словам создателей, версию Mistral NeMo 12B, которая может работать даже на ускорителе NVIDIA RTX.

11.07.2024 [12:22], Руслан Авдеев

AMD приобрела за $665 млн финский ИИ-стартап Silo AIAMD сообщила о приобретении за $665 млн крупнейшей в Европе частной ИИ-лаборатории — Silo AI. Silo AI включает более 300 «специалистов мирового уровня» с опытом создания специализированных ИИ-моделей, платформ и решений для ведущих корпоративных клиентов, применяющих их в облачных, встраиваемых и клиентских IT-проектах. Сооснователь Silo AI и её глава Питер Сарлин (Peter Sarlin) сохранит руководящую должность в команде, которая войдёт в AMD Artificial Intelligence Group. Завершение сделки планируется на II половину 2024 года. Как отмечает AMD, предприятия каждой отрасли ищут эффективные способы разработки и внедрения ИИ-решений, а команда Silo AI уже имеет экспертов и опыт в разработке передовых ИИ-моделей и решений, включая создание больших языковых моделей (LLM) на платформах AMD. Теперь команда поможет ускорить реализацию ИИ-стратегии AMD, создание и внедрение ИИ-решений по заказу клиентов со всего мира. Базирующаяся в Финляндии компания действует как в Европе, так и в Северной Америке, специализируясь на комплексных решениях, которые позволяют клиентом быстро внедрять ИИ в свои продукты, сервисы и рабочие процессы. В числе клиентов — Allianz, Philips, Rolls-Royce и Unilever. Также Silo AI создаёт мультиязычные LLM, например, Poro и Viking, и предлагает платформу кастомизации LLM SiloGen. В Silo рассматривают продажу компании как очередной этап развития, который позволит масштабировать бизнес. Это последнее из серии поглощений и инвестиций AMD в области ИИ. За последние 12 месяцев компания уже инвестировала $125 млн в дюжину ИИ-компаний и приобрела стартапы Mipsology и Nod.ai для расширения своей ИИ-экосистемы. По имеющимся данным, Silo AI стала пионером в масштабировании процесса обучения LLM на суперкомпьютере LUMI — самом быстром в Европе и включающем 12 тыс. ускорителей AMD Instinct MI250X. Совместно с учёными из разных университетов специалисты Silo создали передовые модели для разных языков Евросоюза.

05.07.2024 [09:18], Владимир Мироненко

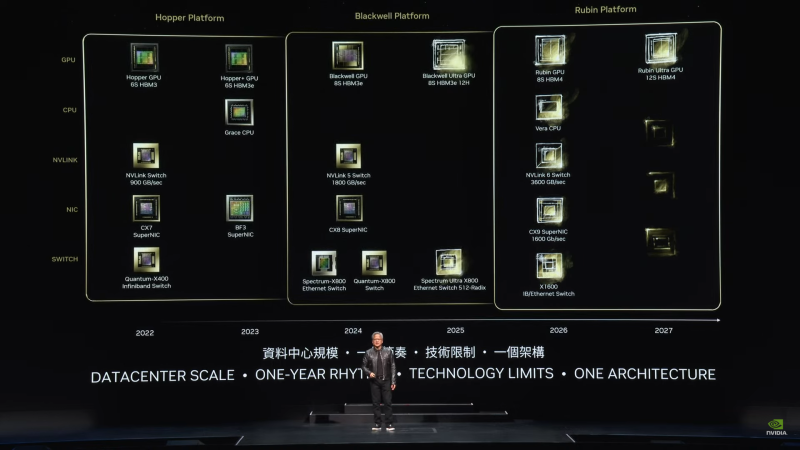

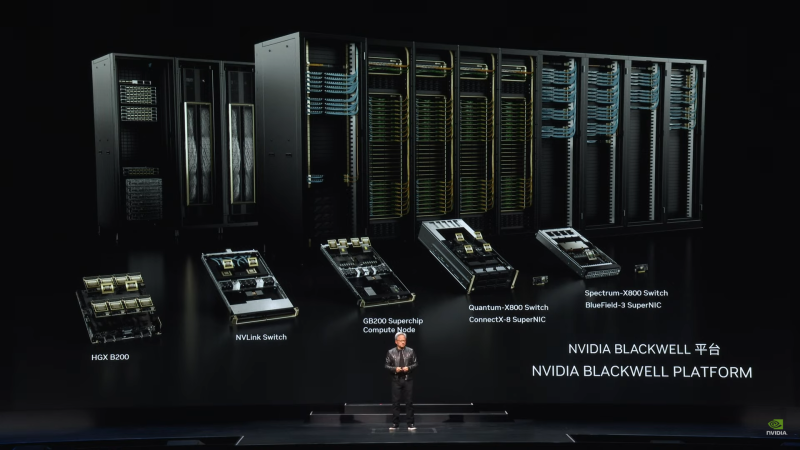

Потрать доллар — получи семь: ИИ-арифметика от NVIDIANVIDIA заявила, что инвестиции в покупку её ускорителей весьма выгодны, передаёт ресурс HPCwire. По словам NVIDIA, компании, строящие огромные ЦОД, получат большую прибыль в течение четырёх-пяти лет их эксплуатации. Заказчики готовы платить миллиарды долларов, чтобы не отстать в ИИ-гонке. «Каждый доллар, вложенный провайдером облачных услуг в ускорители, вернётся пятью долларами через четыре года», — заявил Иэн Бак (Ian Buck), вице-президент HPC-подразделения NVIDIA на конференции BofA Securities 2024 Global Technology Conference. Он отметил, что использование ускорителей для инференса несёт ещё больше выгоды, позволяя получить уже семь долларов за тот же период. Как сообщается, инференс ИИ-моделей Llama, Mistral и Gemma становится всё масштабнее. Для удобства NVIDIA упаковывает открытые ИИ-модели в оптимизированные и готовые к запуску контейнеры NIM. Компания отметила, что её новейшие ускорители Blackwell оптимизированы для инференса. Они, в частности, поддерживают типы данных FP4/FP6, что повышает энергоэффективность оборудования при выполнении рабочих нагрузок ИИ с низкой интенсивностью. Провайдеры облачных услуг планируют строительство ЦОД на пару лет вперёд и хотят иметь представление о том, какими будут ускорители в обозримом будущем. Бак отметил, что провайдерам важно знать, как будут выглядеть ЦОД с серверами на базе чипов Blackwell и чем они будут отличаться от дата-центров на Hopper. Скоро на смену Blackwell придут ускорители Rubin. Их выпуск начнётся в 2026 году, так что гиперскейлерам уже можно готовиться к обновлению дата-центров. Как ожидается, чипы Blackwell, первые партии которых будут поставлены к концу года, будут в дефиците. «С каждым новым технологическим переходом возникает… сочетание проблем спроса и предложения», — отметил Бак. По его словам, операторы ЦОД постепенно отказываются от инфраструктуры на базе CPU, освобождая место под большее количество ускорителей. Ускорители Hopper пока остаются в ЦОД и всё ещё будут основными «рабочими лошадками» для ИИ, но вот решения на базе архитектур Ampere и Volta уже перепродаются. Microsoft и Google сделали ставку на ИИ и сейчас работают над более функциональными большими языковыми моделями, причём Microsoft (и OpenAI) в значительной степени полагается на ускорители NVIDIA, тогда как Google опирается на TPU собственной разработки для использования в своей ИИ-инфраструктуре. Пока что самая крупная модель насчитывает порядка 1,8 трлн параметров, но по словам Бака, это только начало. В дальнейшем появятся модели с триллионами параметров, вокруг которой будут построены более мелкие и более специализированные модели. Так, свежая GPT-модель (вероятно, речь о GPT-4o) включает 16 отдельных нейросетей. NVIDIA уже адаптирует свои ускорители к архитектуре Mixture of Experts (MoE, набор экспертов), где процесс обработки запроса пользователя делится между несколькими специализированными «экспертными» нейросетями. GB200 NVL72, по словам Бака, идеально подходит для MoE благодаря множеству ускорителей связанных быстрым интерконнектом, каждый из которых может обрабатывать часть запроса и быстро делится ответом с другими.

02.07.2024 [23:55], Алексей Степин

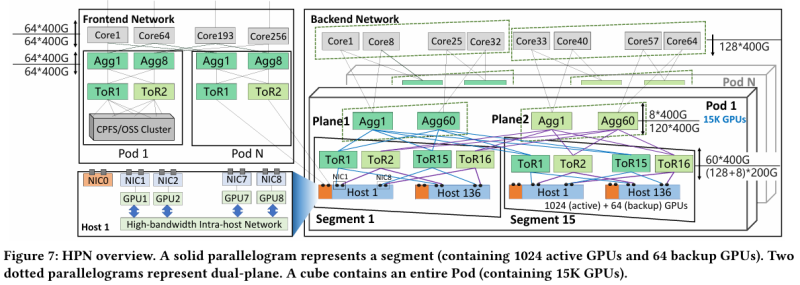

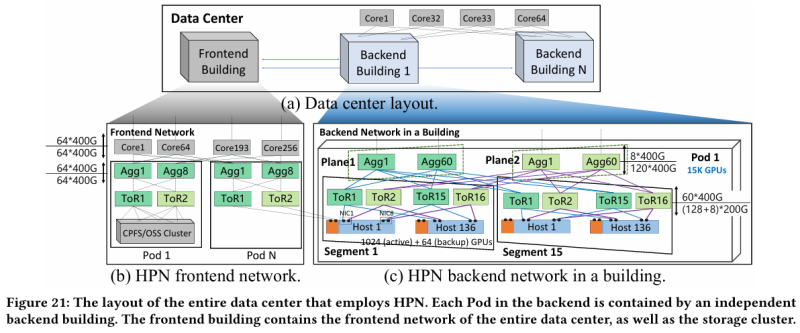

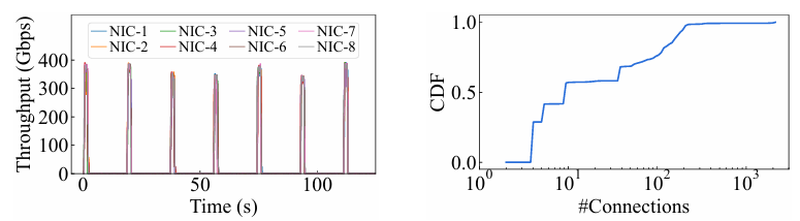

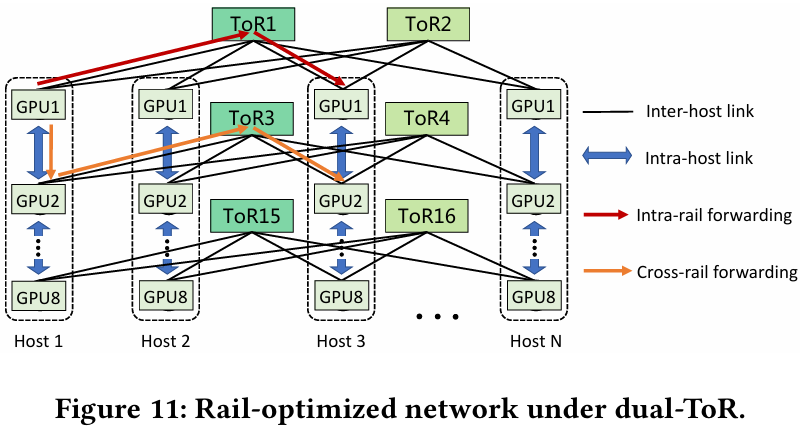

15 тыс. ускорителей на один ЦОД: Alibaba Cloud рассказала о сетевой фабрике, используемой для обучения ИИAlibaba Cloud раскрыла ряд сведений технического характера, касающихся сетевой инфраструктуры и устройства своих дата-центров, занятых обработкой ИИ-нагрузок, в частности, обслуживанием LLM. Один из ведущих инженеров компании, Эньнань Чжай (Ennan Zhai), опубликовал доклад «Alibaba HPN: A Data Center Network for Large Language Model Training», который будет представлен на конференции SIGCOMM в августе этого года. В качестве основы для сетевой фабрики Alibaba Cloud выбрала Ethernet, а не, например, InfiniBand. Новая платформа используется при обучении масштабных LLM уже в течение восьми месяцев. Выбор обусловлен открытостью и универсальностью стека технологий Ethernet, что позволяет не привязываться к конкретному вендору. Кроме того, меньше шансы пострадать от очередных санкций США. Отмечается, что традиционный облачный трафик состоит из множества относительно небыстрых потоков (к примеру, менее 10 Гбит/с), тогда как трафик при обучении LLM включает относительно немного потоков, имеющих периодический характер со всплесками скорости до очень высоких значений (400 Гбит/с). При такой картине требуются новые подходы к управлению трафиком, поскольку традиционные алгоритмы балансировки склонны к перегрузке отдельных участков сети.

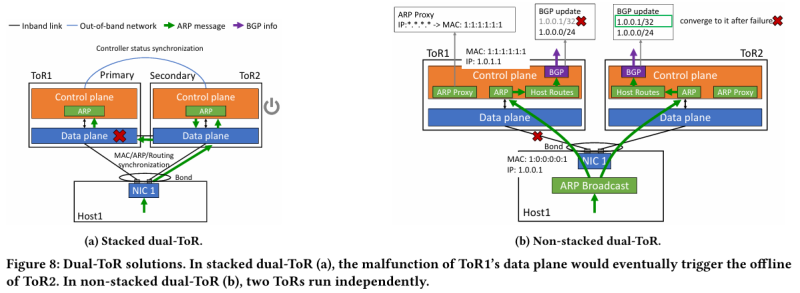

Источник здесь и далее: Alibaba Cloud Разработанная Alibaba Cloud альтернатива носит название High Performance Network (HPN). Она учитывает многие аспекты работы именно с LLM. Например, при обучении важна синхронизация работы многих ускорителей, что делает сетевую инфраструктуру уязвимой даже к единичным точкам отказа, особенно на уровне внутристоечных коммутаторов. Alibaba Cloud использует для решения этой проблемы парные коммутаторы, но не в стековой конфигурации, рекомендуемой производителями.

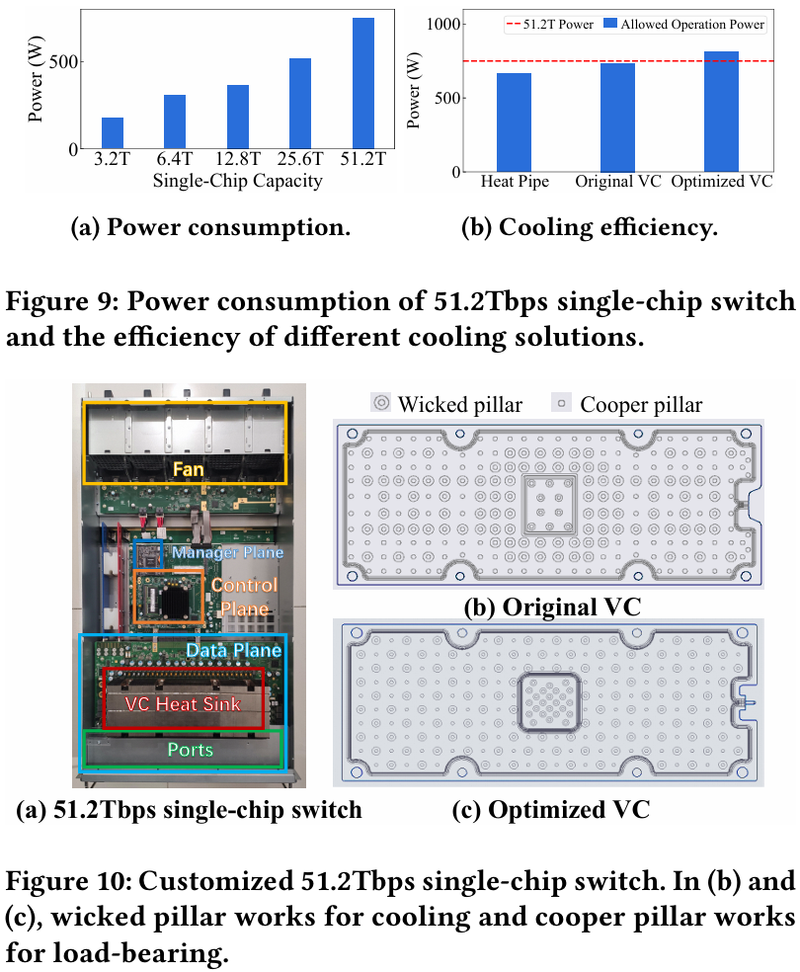

Характер трафика при обучении LLM Каждый хост содержит восемь ИИ-ускорителей и девять сетевых адаптеров. Каждый из NIC имеет по паре портов 200GbE. Девятый адаптер нужен для служебной сети. Между собой внутри хоста ускорители общаются посредством NVLink на скорости 400–900 Гбайт/с, а для общения с внешним миром каждому из них полагается свой 400GbE-канал с поддержкой RDMA. При этом порты сетевых адаптеров подключены к разным коммутаторам из «стоечной пары», что серьёзно уменьшает вероятность отказа.  В докладе говорится, что Alibaba Cloud использует современные одночиповые коммутаторы с пропускной способностью 51,2 Тбит/с. Этим условиям отвечают либо устройства на базе Broadcom Tomahawk 5 (март 2023 года), либо Cisco Silicon One G200 (июнь того же года). Судя по использованию выражения «начало 2023 года», речь идёт именно об ASIC Broadcom. Своё предпочтение именно одночиповых коммутаторов компания объясняет просто: хотя многочиповые решения с большей пропускной способностью существуют, в долгосрочной перспективе они менее надёжны и стабильны в работе. Статистика показывает, что аппаратные проблемы у подобных коммутаторов возникают в 3,77 раза чаще, нежели у одночиповых. Одночиповые решения класса 51,2 Тбит/с выделяют много тепла, но ни один поставщик оборудования не смог предложить Alibaba Cloud готовые решения, способные удерживать температуру ASIC в пределах 105 °C. Выше этого порога срабатывает автоматическая защита. Поэтому для охлаждения коммутаторов Alibaba Cloud создала собственное решение на базе испарительных камер.  Сетевая фабрика позволяет создавать кластеры, каждый из которых содержит 15360 ускорителей и располагается в отдельном здании ЦОД. Такое высокоплотное размещение позволяет использовать оптические кабели длиной менее 100 м и более дешёвые многомодовые трансиверы, которые дешевле одномодовых примерно на 70 %. Ёмкость такого дата-центра составляет около 18 МВт. Но есть у HPN и недостаток: использование топологии с двумя внутристоечными коммутаторами и другие особенности архитектуры усложняют кабельную подсистему, поэтому инженеры поначалу столкнулись с ростом ошибок при подключении сетевых интерфейсов. В настоящее время активно используются тесты, позволяющие проверить каждое подключение на соответствие идентификаторов портов и коммутаторов рабочим схемам. Отмечается, что параметры Ethernet-коммутаторов удваиваются каждые два года, поэтому компания уже разрабатывает сетевую архитектуру следующего поколения, рассчитанную на применение будущих ASIC 102,4 Тбит/с. По словам Alibaba Cloud, обучение LLM с сотнями миллиардов параметров потребует огромного распределённого кластера, количество ускорителей в котором исчисляется миллионами. И ему требуется соответствующая сетевая инфраструктура.

22.06.2024 [14:34], Сергей Карасёв

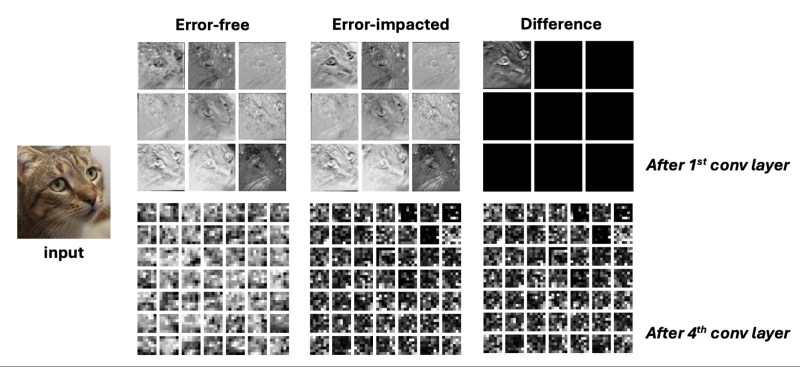

Галлюцинации от радиации: аппаратные сбои могут провоцировать ошибки в работе ИИ-системКомпания Meta✴, по сообщению The Register, провела исследование, результаты которого говорят о том, что ошибки в работе ИИ-систем могут возникать из-за аппаратных сбоев, а не только по причине несовершенства алгоритмов. Это может приводить к неточным, странным или просто плохим ответам ИИ. Говорится, что аппаратные сбои способны провоцировать повреждение данных. Речь идёт, в частности, о так называемом «перевороте битов» (bit flip), когда значение ячейки памяти может произвольно меняться с логического «0» на логическую «1» или наоборот. Это приводит к появлению ложных значений, что может обернуться некорректной работой ИИ-приложений. Одной из причин ошибок является космическое излучение, причём с ростом плотности размещения ресурсов его влияние нарастает. Впрочем, в современных комплексных системах такие ошибки по разным причинам могут возникать на любом из этапов хранения, передачи и обработки информации.

Ошибка в одном бите одного параметра существенно меняет ответ ИИ (Источник: Meta✴) Такие необнаруженные аппаратные сбои, которые не могут быть выявлены и устранены «на лету», называют тихими повреждениями данных (Silent Data Corruption, SDC). Подобные ошибки могут провоцировать изменения ИИ-параметров, что, в конечном счёте, приводит к некорректному инференсу. Утверждается, что в среднем 4 из 1000 результатов инференса неточны именно из-за аппаратных проблем. «Растущая сложность и неоднородность платформ ИИ делает их всё более восприимчивыми к аппаратным сбоям», — говорится в исследовании Meta✴. При этом изменение одного бита может привести к тому, что ошибки будут расти как снежный ком. Для оценки возможных неисправностей предлагается ввести новую величину — «коэффициент уязвимости параметров» (Parameter Vulnerability Factor, PVF). PVF показывает вероятность того, как повреждение конкретного параметра в конечном итоге приведёт к некорректному ответу ИИ-модели Эта метрика, как предполагается, позволит стандартизировать количественную оценку уязвимости модели ИИ к возможным аппаратным сбоям. Показатель PVF может быть оптимизирован под различные модели и задачи. Метрику также предлагается использовать на этапе обучения ИИ и для выявления параметров, целостность которых надо отслеживать. Производители аппаратного оборудования также принимают меры к повышению надёжности и устойчивости работы своих решений. Так, NVIDIA отдельно подчеркнула важность RAS в ускорителях Blackwell. Правда, делается это в первую очередь для повышения стабильности сверхкрупных кластеров, простой которых из-за ошибок обойдётся очень дорого.

20.06.2024 [14:54], Владимир Мироненко

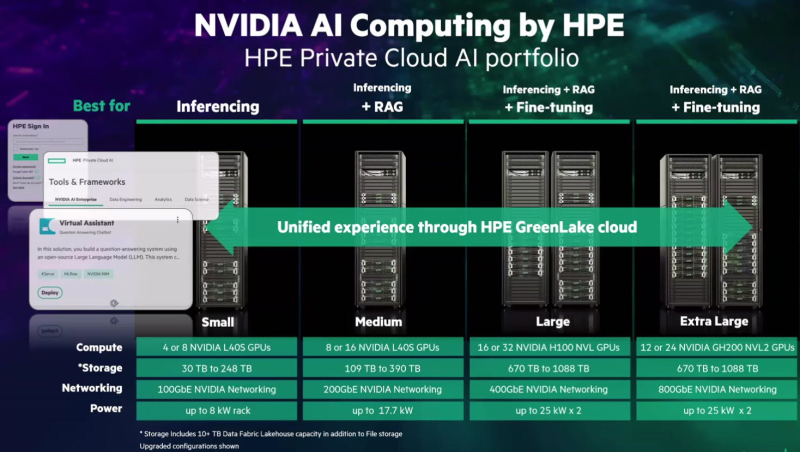

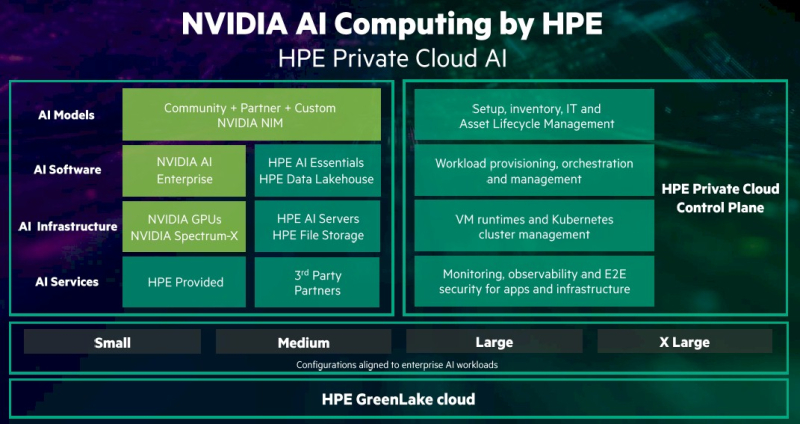

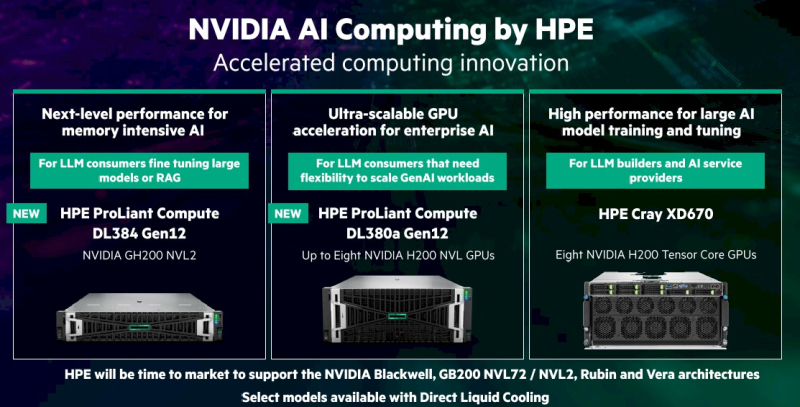

HPE и NVIDIA представили совместные решения для ускорения внедрения ИИHewlett Packard Enterprise (HPE) и NVIDIA представили платформу NVIDIA AI Computing by HPE — портфель совместно разработанных решений для ускорения внедрения генеративного ИИ. Ключевым в портфеле является предложение HPE Private Cloud AI. Как указано в пресс-релизе, это первое в своём роде комплексное решение, которое обеспечивает самую глубокую на сегодняшний день интеграцию вычислительных технологий, сетей и ПО NVIDIA с хранилищем, вычислительными ресурсами и облачной платформой HPE GreenLake. Решение предоставляет предприятиям любого размера возможность быстрой и эффективной разработки и развёртывания приложений генеративного ИИ. Решение HPE Private Cloud AI с новой функцией OpsRamp AI Copilot, которая позволяет повысить эффективность ИТ-операций и обработки рабочих нагрузок, включает в себя облачную среду самообслуживания с полным управлением жизненным циклом. Оно доступно в четырёх конфигурациях (Small, Medium, Large и Extra Large) для поддержки рабочих нагрузок ИИ различной сложности. HPE Private Cloud AI также поддерживает инференс, точную настройку моделей и их дообучение посредством RAG с использованием собственных данных. Решение сочетает в себе средства контроля конфиденциальности, безопасности, прозрачности и управления данными, в том числе средства ITOps и AIOps. AIOps использует машинное обучение и анализ данных для автоматизации и улучшения ИТ-операций. ITOps включает в себя ряд инструментов, обеспечивающих бесперебойное функционирование ИТ-инфраструктуры организации. Конфигурация HPE Private Cloud AI Small, предназначенная для инференса, включает от четырёх до восьми ускорителей NVIDIA L40S, до 248 Тбайт дискового пространства и 100GbE-подключение в стойке мощностью 8 кВт. Конфигурация Medium, предназначенная для инференса и RAG, включает до 16 ускорителей NVIDIA L40S, до 390 Тбайт дискового пространства и 200GbE-подключение в стойке мощностью 17,7 кВт. Конфигурации Large и Extra Large предлагают дополнительные возможности по обработке нагрузок ИИ и ML, а также тонкой настройке ИИ-модели. Конфигурация Large включает до 32 ускорителей NVIDIA H100 NVL, до 1,1 Пбайта дискового пространства и 400GbE-интерконнект в двух стойках мощностью 25 кВт каждая. В свою очередь, конфигурация Extra Large включает до 24 ускорителей NVIDIA GH200 NVL2, до 1,1 Пбайта дискового пространства и 800GbE-интeрконнект в двух стойках мощностью 25 кВт каждая. Стойки могут управляться клиентом самостоятельно или обслуживаться HPE. Каждая конфигурация может работать как автономное локальное решение ИИ или в составе гибридного облака. Используется программная платформа NVIDIA AI Enterprise, включающая микросервисы инференса NIM. Её дополняет ПО HPE AI Essentials. Кроме того, поддержку новых ускорителей NVIDIA получили три аппаратные платформы:

HPE также объявила, что её облачная платформа HPE GreenLake for File Storage прошла сертификацию Nvidia DGX BasePOD и валидацию хранилища NVIDIA OVX, HPE Private Cloud AI, а также анонсированное оборудование будут доступны этой осенью за исключением платформы Cray XD670 на базе NVIDIA H200 NVL, который поступит в продажу этим летом. А после станут доступны и решения на базе Blackwell.

15.06.2024 [18:04], Владимир Мироненко

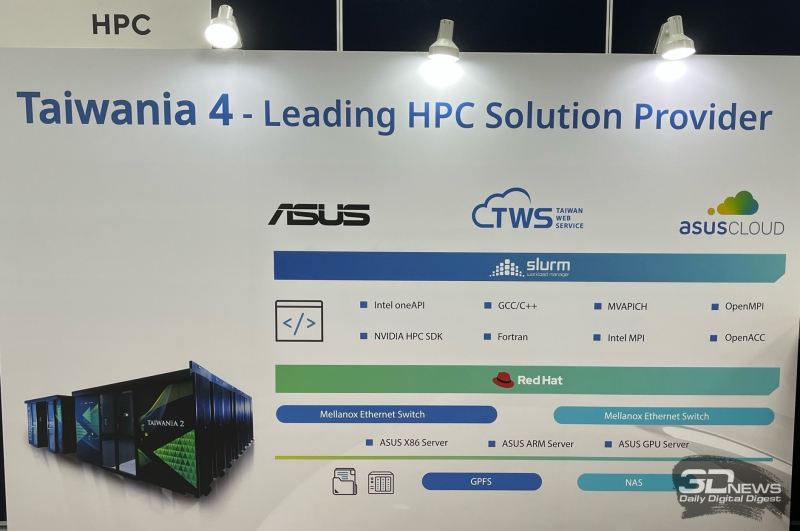

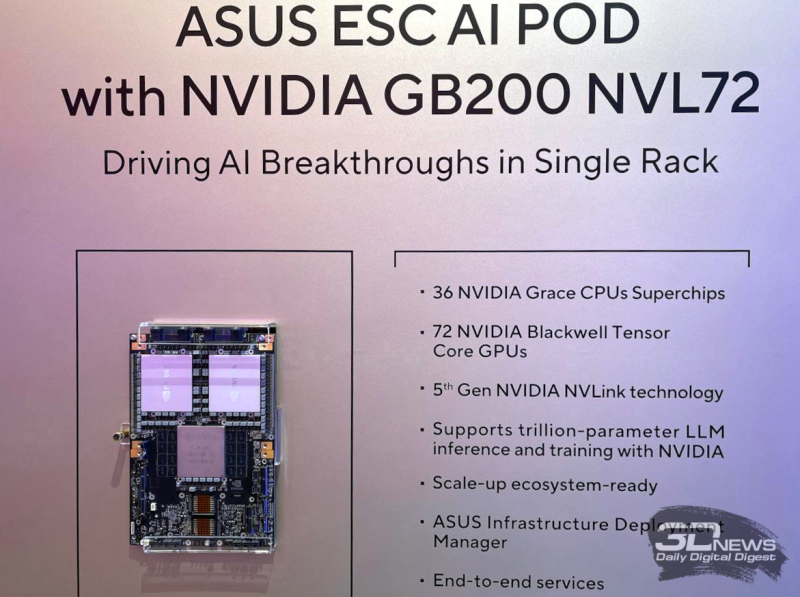

ASUS осваивает строительство суперкомпьютеров, ЦОД и комплексных ИИ-системПроизводитель потребительской электроники ASUS уже давно работает на рынке серверов и ЦОД. Пока он занимает на нём не очень большую долю, но как сообщил ресурсу The Register старший вице-президент ASUS Джеки Сюй (Jackie Hsu), высокопроизводительных вычислений (HPC) и серверов стал для компании «областью большого роста». Сюй рассказал, что ASUS участвовала в строительстве на Тайване суперкомпьютера Taiwania 2 производительностью 9 Пфлопс, занявшего в рейтинге TOP500 двадцатую позицию после дебюта в 2018 году. А в прошлом году ASUS выиграла тендер на участие в создании суперкомпьютера Taiwania 4. Сюй сообщил, что ASUS построила ЦОД для Taiwania 4. Причём PUE новой площадки составляет 1,17, что является неплохим показателем для любого подобного объекта, а тем более для Тайваня, отличающегося климатом с высокими температурой и влажностью. Также ASUS участвовала в ряде проектов в области ИИ, включая разработку собственной большой языковой модели (LLM) Formosa Foundation со 176 млрд параметров. Модель была обучена на наборах данных на местном языке для генерации текста с традиционной китайской семантикой. Благодаря накопленному опыту ASUS начала предлагать услуги на рынке ИИ. Компания уже заключила несколько контрактов, в рамках которых она проектирует и создаёт мощные системы для работы с ИИ, предлагая большую часть программного и аппаратного стека, необходимого для обработки ИИ-нагрузок. Гендиректор NVIDIA Дженсен Хуанг (Jensen Huang) назвал ASUS в числе компаний, с кем NVIDIA будет сотрудничать в работе над созданием так называемых фабрик ИИ. На Computex 2024 компания представила новые серии серверов ASUS RS700-E12 и RS720-E12 с процессорами Intel Xeon 6, разработанные специально для обработки высокопроизводительных рабочих нагрузок, а также серверы хранения семейства VS320D, предназначенные для использования в составе инфраструктур SAN для работы с базами данных, системами виртуализации и пр. Также ASUS представила ИИ-систему ESC AI POD на базе суперускорителей NVIDIA GB200 NVL72.

02.06.2024 [15:30], Владимир Мироненко

NVIDIA объявила о доступности NIM для разработчиков ИИNVIDIA объявила о доступности NVIDIA NIM, микросервисов инференса, которые предоставляют готовые модели в виде заранее оптимизированных контейнеров, доступных для развёртывания в облаках, ЦОД или на рабочих станциях. Это, по словам компании, позволяет разработчикам возможность без труда создавать приложения генеративного ИИ за считанные минуты, хотя ранее на это уходили недели. Сложность приложений генеративного ИИ растёт и часто в них используется несколько моделей с различными возможностями для генерации текста, изображений, видео, речи и т.д. NVIDIA NIM позволяет значительно повысить производительность разработчиков, предоставляя простой стандартизированный способ добавления генеративного ИИ в их приложения. NIM также позволяет компаниям максимизировать свои инвестиции в инфраструктуру. Например, NIM-контейнер с оптимизированным вариантом Meta✴ Llama 3-8B выдаёт втрое больше токенов за единицу времени, чем LLM без оптимизаций. Более 200 технологических партнёров NVIDIA, включая Cadence, Cloudera, Cohesity, DataStax, NetApp, Scale AI и Synopsys, уже используют NIM, чтобы ускорить развёртывание генеративного ИИ для приложений, специфичных для их индустрии, таких как ИИ-помощники, помощники по созданию кода, цифровые человеческие аватары и многое другое. Кроме того, экосистему NIM поддерживают Canonical, Red Hat, Nutanix, VMware, Kinetica и Redis. Доступна и интеграция с KServe. NIM интегрирован в платформу NVIDIA AI Enterprise. Начиная со следующего месяца участники программы NVIDIA Developer Program получат бесплатный доступ к NIM для исследований, разработки и тестирования. Контейнеры NIM могут включать ПО NVIDIA CUDA, NVIDIA Triton Inference Server и NVIDIA TensorRT-LLM. А на ai.nvidia.com уже доступно более 40 готовых моделей, включая Databricks DBRX, Google Gemma, Meta✴ Llama 3, Microsoft Phi-3, Mistral Large, Mixtral 8x22B и Snowflake Arctic. Компания также представила и NVIDIA BioNeMo NIM для биомедицинской сферы. Ведущие провайдеры ИИ-решений и MLOps-платформ, включая Amazon SageMaker, Microsoft Azure AI, Dataiku, DataRobot, deepset, Domino Data Lab, LangChain, Llama Index, Replicate, Run.ai, ServiceNow, Securiti AI и Weights & Biases также внедрили NIM. Hugging Face теперь тоже предлагает NIM-контейнейры и позволяет развернуть модели в различных облаках всего за несколько кликов. Микросервисы NIM также интегрированы в AWS, Google Cloud, Microsoft Azure и Oracle Cloud. Наконец, компетенциями в области NIM обзавелись Accenture, Deloitte, Infosys, Latentview, Quantiphi, SoftServe, TCS и Wipro. Предприятия могут запускать приложения с поддержкой NIM практически в любом месте, в том числе на сертифицированных NVIDIA системах Cisco, Dell, HPE, Lenovo и Supermicro, а также ASRock Rack, ASUS, GIGABYTE, Ingrasys, Inventec, Pegatron, QCT, Wistron и Wiwynn. Более того, например, Foxconn и Pegatron уже используют NIM для разработки предметно-ориентированных LLM для собственных производственных нужд. |

|