Материалы по тегу: llm

|

24.05.2024 [07:38], Сергей Карасёв

К2Тех и MTS AI помогут компаниям во внедрении технологий генеративного ИИ на базе российской LLM CotypeКомпании К2Тех и MTS AI объявили о заключении соглашения о стратегическом партнёрстве. Его целью является ускорение цифровой трансформации крупного бизнеса путём внедрения технологий генеративного ИИ. Отмечается, что MTS AI имеет опыт в создании больших языковых моделей (LLM), тогда как К2Тех реализует цифровые проекты полного цикла в ключевых отраслях экономики: финсектор, ретейл и FMCG, химия, нефтегаз, энергетика, машиностроение, горная добыча и др. Объединив компетенции, партнёры намерены предложить заказчикам комплексные решения, которые будут безопасно и гибко интегрироваться в их IT-ландшафт. В рамках сотрудничества К2Тех на базе большой языковой модели Cotype (ex. MTS AI Chat) будет создавать отраслевые решения для заказчиков в различных сферах. Среди них называются документооборот, маркетинг, производственные процессы и другие области, где необходима обработка большого количества данных в режиме реального времени. По словам MTS AI, модель « обладает достаточным количеством знаний и способна начать работу сразу после установки на серверах клиента». Cotype занимает первую позицию в бенчмарке MERA (Multimodal Evaluation for Russian-language Architectures) среди LLM и вторую после человека. Отмечается, что Cotype способна решать такие задачи, как составление текста официального письма, должностной инструкции или описания вакансии, заполнение данных в CRM-системе, выделение краткого содержания переписки и пр. К2Тех поможет сократить время развёртывания Cotype в инфраструктуре заказчиков, осуществить интеграцию с действующими системами и обеспечить дополнительную безопасность данных. Клиент сможет подключить систему поиска по корпоративным базам данных, а также чат-боты для найма и онбординга персонала.

22.05.2024 [12:54], Сергей Карасёв

Поставщик данных для обучения ИИ Scale AI привлёк $1 млрдСтартап Scale AI, основанный в 2016 году, объявил о проведении раунда финансирования Series F, в ходе которого привлекла $1 млрд, а оценка компании составила $13,8 млрд. Сложные ИИ-модели обучаются на огромных массивах данных, для сбора и подготовки которых может потребоваться много времени. Scale AI предоставляет облачный сервис Generative AI Data Engine, который ускоряет и упрощает этот процесс. Клиенты Scale AI указывают, данные какого типа им необходимы для обучения ИИ-моделей, после чего стартап занимается подготовкой соответствующих наборов. Кроме того, платформа Scale AI упрощает задачу разметки данных. Поддерживается работа с текстовой информацией, изображениями и аудиоматериалами, а также более специализированными данными, такими как журналы датчиков (лидаров) беспилотных автомобилей.

Источник изображения: Scale AI Scale AI также предоставляет ряд дополнительных услуг. В их число входит сервис проверки новый сетей на наличие уязвимостей, галлюцинаций и других проблем. Для организаций государственного сектора компания разработала чат-бота Donovan, который рассчитан на работу с конфиденциальной информацией. Программу финансирования Series F возглавила Accel. Кроме того, средства предоставили существующие инвесторы — Y Combinator, Nat Friedman, Index Ventures, Founders Fund, Coatue, Thrive Capital, Spark Capital, NVIDIA, Tiger Global Management, Greenoaks и Wellington Management. В число новых инвесторов вошли Cisco Investments, DFJ Growth, Intel Capital, ServiceNow Ventures, AMD Ventures, WCM, Amazon, Elad Gil и Meta✴. Полученные деньги будут направлены на улучшение существующих продуктов и развитие новых проектов.

13.05.2024 [22:33], Владимир Мироненко

Ресурсы в обмен на технологии: Alibaba Cloud предлагает ИИ-стартапам GPU-мощности за долю в компанииКитайский гигант электронной коммерции Alibaba по примеру Microsoft, финансировавшей успешный ИИ-стартап OpenAI, пытается расширить своё присутствие на рынке ИИ-технологий с помощью инвестиций в китайские стартапы в области генеративного ИИ. Разница лишь в том, что Alibaba предлагает большей частью не традиционное финансирование деньгами, а кредиты на использование своей облачной инфраструктуры для обучения ИИ-моделей, пишет газета Financial Times. В числе стартапов, пользующихся поддержкой Alibaba, газета назвала Moonshot, Zhipu, MiniMax и 01.ai, которые разрабатывают локальные версии американских приложений, таких как ChatGPT и чат-бот-аватар Character.ai. Так, в феврале этого года Alibaba возглавила раунд финансирования Moonshot AI, разработчика ИИ-решений для компаний в сфере электронной коммерции, включая чат-бот Kimi AI, привлёкшего $1 млрд инвестиций, после чего его рыночная стоимость оценивалась в $2,5 млрд. По словам источников Financial Times, Alibaba инвестировала в Moonshot AI $800 млн, но лишь чуть больше половины было предоставлено деньгами, а остальная часть поступила в виде кредитов на облачные вычисления. Как утверждают источники, в течение 2023 года глава Alibaba Эдди Юнмин У (Eddie Yongming Wu) лично контролировал выделение инвестиций четырём ведущим ИИ-стартапам Китая, что говорит о том, какое значение компания придаёт этому направлению. После отказа из-за санкций США от амбициозного плана реструктуризации, предполагавшего проведение IPO облачным подразделением, на фоне растущей конкуренцией со стороны ByteDance и PDD Holdings на своём основном рынке электронной коммерции, Alibaba пытается найти новые драйверы роста. После отмены реструктуризации Эдди Юнмин У взял под личный контроль облачный бизнес, сделав ставку на ИИ в скорректированной стратегии по стимулированию роста компании. Порядок выделения инвестиций Alibaba в Moonshot повторяет подход Microsoft и Amazon, согласно которому денежные средства передаются ИИ-стартапам при условии, что те будут использовать их для обучения и запуска моделей в облаках Azure и AWS соответственно. Разница заключается в том, что в случае Alibaba напрямую деньги никогда не передаются китайским стартапам. Вместо этого они хранятся на условном депонировании, который компания может считать поступающим доходом. «Предоставление вычислений на самом деле более ценно, чем наличные, — заявил китайский эксперт в области ИИ. — Из-за нехватки чипов очень сложно получить доступ к кластеру Alibaba из 10 тыс. ускорителей». Alibaba Cloud и другие игроки успели приобрести крупные объёмы современных ускорителей NVIDIA, в том числе урезанные A800 и H800, прежде чем США ввели ограничения. И теперь компания стремится извлечь из владения ими выгоду, прежде чем они устареют. Крупнейшие интернет-компании Китая, в том числе Alibaba, Meituan, Xiaohongshu и Tencent, играют огромную роль в финансировании новой волны ИИ-стартапов по сравнению с предыдущим поколением стартапов, где доминировали компании SenseTime и Megvii, специализирующиеся на разработке решений для распознавания лиц и видеонаблюдения.

09.05.2024 [23:56], Владимир Мироненко

Red Hat представила ИИ-дистрибутив RHEL AI, который требует минимум 320 Гбайт GPU-памяти

ibm

ibm cloud

linux

llm

open source

openshift

red hat

red hat enterprise linux

software

ии

разработка

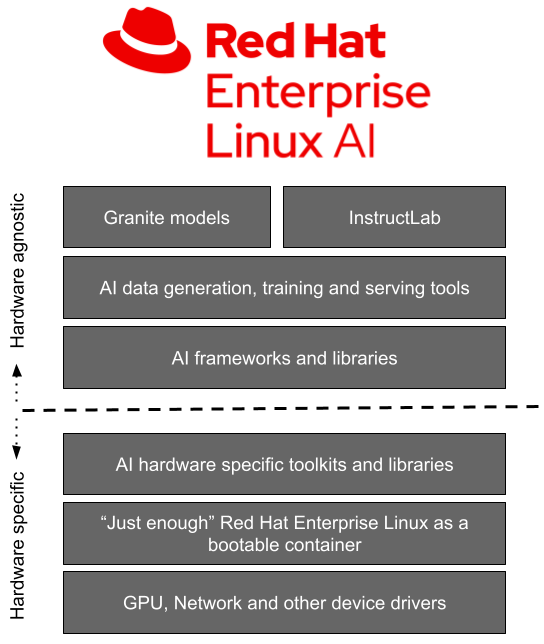

Red Hat представила Red Hat Enterprise Linux AI (RHEL AI), базовую платформу, которая позволит более эффективно разрабатывать, тестировать и запускать генеративные модели искусственного интеллекта (ИИ) для поддержки корпоративных приложений. Фактически это специализированный дистрибутив, включающий базовые модели, инструменты для работы с ними и необходимые драйверы.

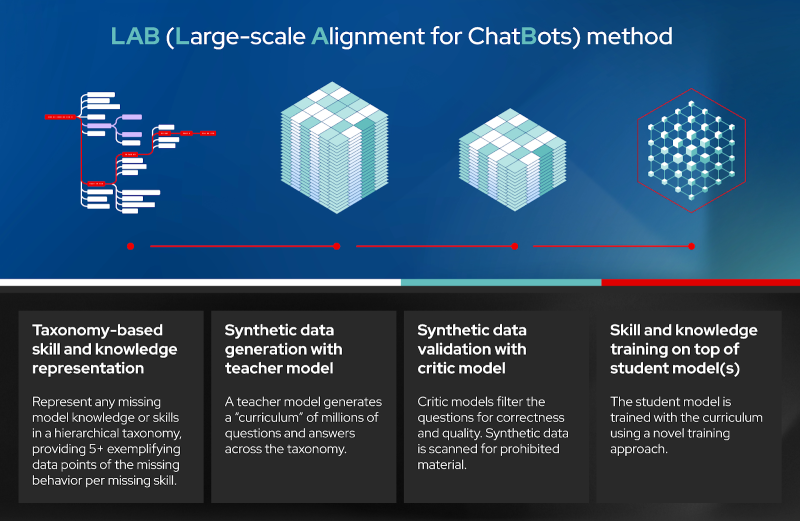

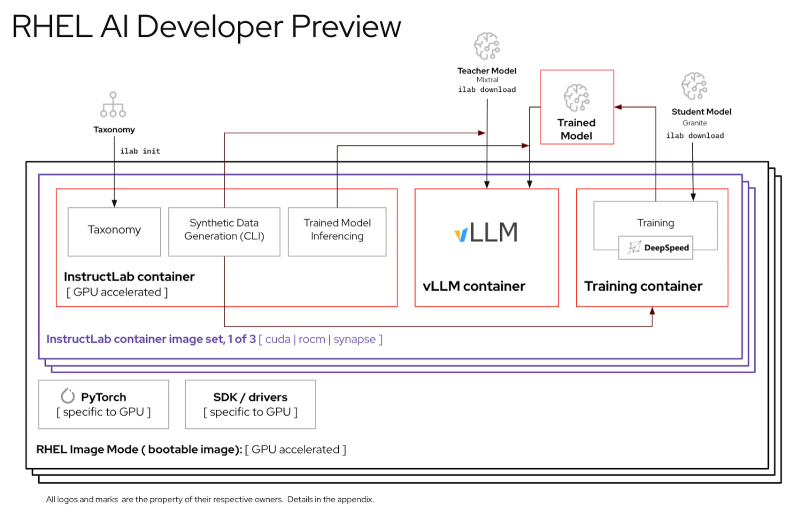

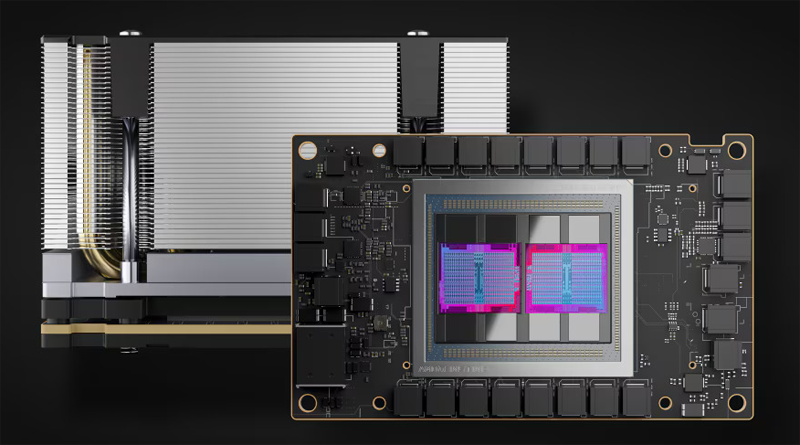

Источник изображений: Red Hat Доступная сейчас в качестве превью для разработчиков, платформа RHEL AI включает в себя семейство больших языковых моделей (LLM) IBM Granite, недавно ставших доступными под лицензией Apache 2.0, инструментом тюнинга и доработки моделей InstructLab посредством методики LAB (Large-Scale Alignment for Chatbots), а также различные библиотеки и фреймворки.  Решение представляется в виде готового для развёртывания образа и является частью MLOps-платформы OpenShift AI. По словам Red Hat, RHEL AI предоставляет поддерживаемую, готовую к корпоративному использованию среду для работы с ИИ-моделями на аппаратных платформах AMD, Intel и NVIDIA. По словам компании, open source подход позволит устранить препятствия на пути реализации стратегии в области ИИ, такие как недостаток навыков обработки данных и финансовых возможностей. Основная цель RHEL AI и проекта InstructLab — предоставить экспертам в предметной области возможность напрямую вносить свой вклад в большие языковые модели, используя свои знания и навыки. Новая платформа позволит им более эффективно создавать приложения с использованием ИИ, например, чат-боты. Впоследствии при наличии подписки RHEL AI компания предложит поддержку корпоративного уровня на протяжении всего жизненного цикла продукта, начиная с модели Granite 7B и ПО и заканчивая возможным возмещение ущерба в отношении интеллектуальной собственности. «Опираясь на инфраструктуру GPU, доступную в IBM Cloud, которая используется для обучения моделей Granite и поддержки InstructLab, IBM Cloud получит поддержку RHEL AI и OpenShift AI. Эта интеграция позволит предприятиям легче внедрять генеративный ИИ в свои критически важные приложения», — отметила компания. При этом прямо сейчас для запуска RHEL AI требуются весьма производительные сертифицированные системы с ускорителями, имеющими минимум 320 Гбайт памяти, а также хранилищем ёмкостью от 200 Гбайт. Среди протестированных указаны серверы Dell с четырьмя NVIDIA H100, Lenovo с восемью AMD Instinct MI300X, а также инстансы IBM Cloud GX3. Вскоре обещана поддержка инстансов AWS EC2 P5 с NVIDIA H100 и ускорителей Intel.

07.05.2024 [21:26], Руслан Авдеев

Apple работает над собственными серверными ИИ-ускорителямиКомпания Apple занимается разработкой собственных ИИ-полупроводников для дата-центров, передаёт The Wall Street Journal. В перспективе это поможет ей в «гонке вооружений», развернувшейся на рынке ИИ-решений. И у Apple есть ресурсы для создания передовых ИИ-чипов. В последние десять лет компания уже выбилась в лидеры полупроводниковой индустрии, представляя всё новые чипсеты для мобильных устройств и компьютеров Mac-серии. Как свидетельствуют источники СМИ, серверный проект Project ACDC (Apple Chips in Data Center) задействует компетенции компании в деле создания решений для ЦОД. Недавно сообщалось, что Apple наняла создателя ИИ-кластеров Google. Реализацию проекта Apple начала несколько лет назад, но данных о том, когда будут готовые первые чипы, пока нет. По имеющимся данным, компания уже тесно сотрудничает с TSMC. Предполагается, что чипы для серверов Apple будут оптимизированы для запуска ИИ-моделей, а не их обучения — на этом рынке по-прежнему будет доминировать NVIDIA. Время поджимает, поскольку Google и Microsoft уже имеют собственные ИИ-ускорители, хотя и разных классов — TPU и Maia 100. Обе компании имеют компетенции в области LLM, а Microsoft весьма дружна с OpenAI, которая тоже не прочь заняться «железом». Такое положение дел не устраивает инвесторов Apple, поскольку компания не продемонстрировала никаких впечатляющих успехов в соответствующей сфере, в то время как цена акций конкурентов продолжает расти на фоне новостей об их достижениях. В Apple пытаются убедить инвесторов, что это лишь временное явление и скоро грядут анонсы, связанные с ИИ. Опыт Apple в сфере разработки современных полупроводников должен помочь в создании ИИ-чипов. Сегодня компания представила 3-нм процессор M4 с самым мощным, по её словам, NPU в мире. Хотя компания добилась определённых успехов в разработке чипов для потребительской и профессиональной электроники, определённые задачи даются ей с трудом. Например, она всё ещё бьётся над созданием собственного беспроводного модуля. Хотя в Apple предпочли бы, чтобы большинство ИИ-вычислений осуществлялись силами самих чипов, некоторые задачи будут по-прежнему выполняться в облаке, где и пригодятся новые полупроводники. Это позволит компании лучше контролировать свою стратегию развития в сфере ИИ.

04.05.2024 [17:55], Владимир Мироненко

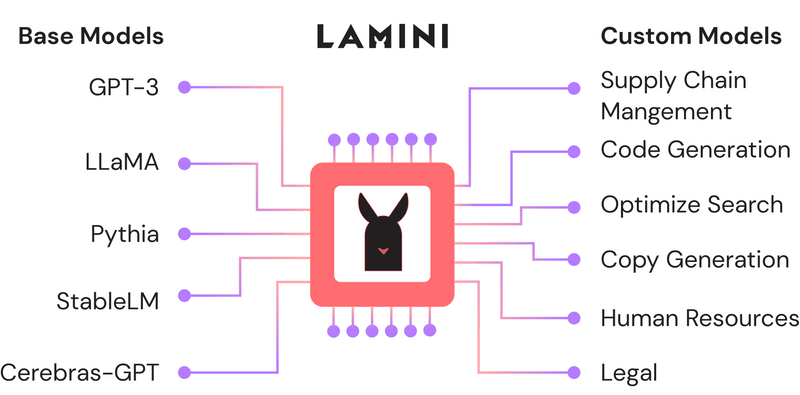

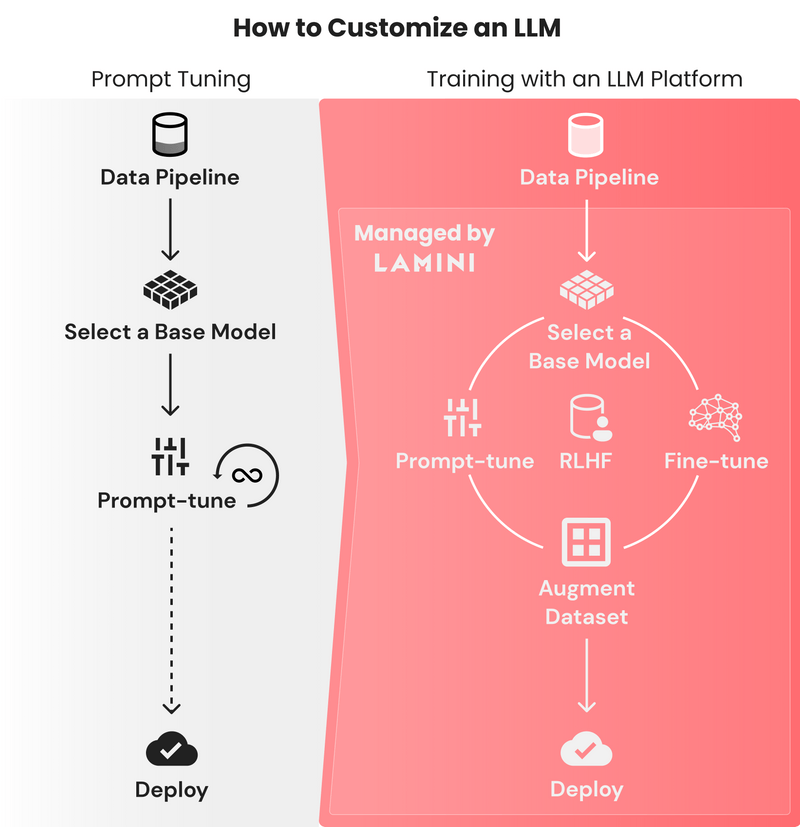

PowerML привлекла $25 млн на развитие ИИ-платформы Lamini, в том числе от AMD и Louis VuittonСтартап PowerML Inc., разработчик платформы Lamini для обучения и развёртывания ИИ-моделей, сообщил о привлечении $25 млн в ходе двух раундов финансирования. В раундах приняли участие компании Amplify Partners, возглавившая раунд Series A, First Round Capital, возглавившая Seed-раунд, AMD Ventures, пионер ИИ Эндрю Ын (Andrew Ng), соучредитель OpenAI Андрей Карпати (Andrej Karpathy), руководители Dropbox Inc., Figma Inc. и LVMH, материнской компании Louis Vuitton. Разработанная PowerML программная платформа предназначена для обучения и запуска больших языковых моделей (LLM) на ускорителях AMD или NVIDIA как в облачных, так и в локальных средах. В последнем случае можно развернуть Lamini в изолированной инфраструктуре. Платформа была создана с расчётом на крупномасштабные ИИ-проекты, которым может потребоваться более 1000 ускорителей.

Источник изображений: Lamini Одной из наиболее сложных задач, связанных с обучением LLM, является настройка гиперпараметров. Lamini предоставляет готовые наборы гиперпараметров, устраняя необходимость всё настраивать с нуля. Вместе с тем остаётся возможность определения пользовательских настроек LLM. Платформа также может использоваться для точной настройки уже обученных моделей ИИ под конкретную задачу. Lamini использует подход PEFT, который позволяет значительно сократить количество изменений параметров, а также снизить стоимость адаптации LLM к выполнению новых задач. Вместе с тем Lamini поддерживает методику RAG (Retrieval Augmented Generation), которая позволяет дообучать модель на собственных данных без изменения кода. Заодно Lamini предоставляет панель мониторинга, которая позволяет разработчикам сравнивать корректность точной настройки своих ИИ-моделей с исходной версией.  PowerML также упрощает развёртывание готовых ИИ-моделей, предоставляя различные настройки инференса и позволяя управлять стилем генерации, форматом выводимых данных и т.д. Компания утверждает, что её платформа в инференс-задачах более экономична по сравнению с проприетарными LLM-платформами, такими как Claude 3. Полученные инвестиции PowerML планирует использовать для найма большего количества сотрудников и расширения своей инфраструктуры ИИ, в частности, за счёт ускорителей большего количества ускорителей AMD, поскольку стартап делает ставку на решения AMD: ускорители Instinct и стек ROCm. Компания также планирует разработать «более глубокую техническую оптимизацию» для рабочих нагрузок машинного обучения.

30.04.2024 [12:39], Сергей Карасёв

Утилита llamafile для быстрого запуска ИИ-моделей получила расширенную поддержку ускорителей AMD и свежих LLMКомпания Mozilla анонсировала обновлённую версию инструмента llamafile с индексом 0.8.1. В данном релизе устранены ошибки, из-за которых происходило некорректное распознавание ускорителей AMD на базе GPU. Кроме того, реализованы некоторые другие изменения. Напомним, llamafile даёт возможность упаковать веса большой языковой модели (LLM) в исполняемый файл, который без установки можно запустить практически на любой современной платформе. Поддерживаются архитектуры x86-64 и ARM64, а также системы macOS, Windows, Linux, FreeBSD, OpenBSD и NetBSD. Как отмечается, изначально в llamafile корректно определялись только числовые идентификаторы графических блоков AMD GFX, из-за чего возникали сбои при использовании определённого оборудования AMD Instinct/Radeon. Например, ускоритель Instinct MI250 имеет обозначение GFX90A IP, и символ «A» ранее не распознавался должным образом. В результате, при работе с такими GPU происходили ошибки. Теперь данная проблема устранена.

Источник изображения: AMD Кроме того, в llamafile 0.8.1 имеется поддержка модели Phi-3 Mini 4k, а также LLaMA3, Grok, Mixtral 8x22b и Command-R. Производительность F16 повышена приблизительно на 20 % на платформе Raspberry Pi 5, примерно на 30 % — на Intel Skylake и на 60 % — на Apple M2.

24.04.2024 [12:25], Владимир Мироненко

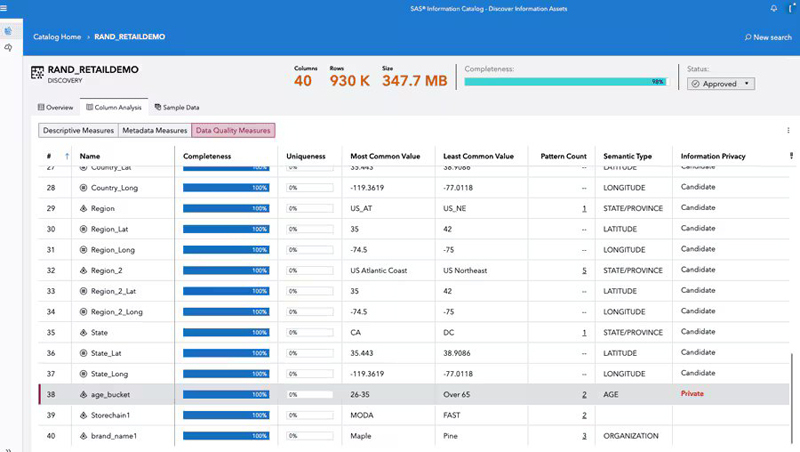

SAS Institute представила новые инструменты для разработчиков ИИ-приложений — Viya Copilot и SAS Viya WorkbenchSAS Institute Inc. сообщила о расширении ИИ-платформы SAS Viya, с помощью которой компании могут интегрировать самые мощные большие языковые модели (LLM), такие как GPT-4 и Gemini Pro 1.5, в свои существующие бизнес-процессы. Благодаря этому компании могут использовать LLM для создания индивидуальных моделей и агентов ИИ, точно настроенных на выполнение конкретных бизнес-задач с объяснимыми результатами и повышенной конфиденциальностью и безопасностью, а также гарантией, что они будут соответствовать определённым требованиям. В частности, SAS Viya пополнилась новым предложением Viya Copilot для разработчиков, специалистов по обработке данных и бизнес-пользователей. Решение Viya Copilot похоже на личного помощника, призванного ускорить выполнение различных бизнес-задач. По словам компании, для этого решение использует комплексный набор инструментов, включающий генерацию кода, очистку данных, исследование данных и анализ пробелов в знаниях.

Источник изображений: SAS Institute Обновление SAS Viya также улучшило флагманскую маркетинговую платформу компании SAS Customer Intelligence 360. Маркетологи теперь могут использовать генеративный ИИ для создания рекомендуемой аудитории на основе подсказок на естественном языке, подбора темы электронных писем и извлечения данных об аудитории. Компания также запустила для разработчиков ИИ-приложений новую платформу SAS Data Maker, целью которой является устранение проблемы конфиденциальности и решение проблем с нехваткой данных. SAS Data Maker может генерировать «высококачественные синтетические табличные данные» для обучения ИИ вместо использования конфиденциальных данных. В то же время новая платформа поможет в ситуациях, когда компаниям не хватает данных для обучения моделей. Вице-президент и главный аналитик Constellation Research, отметил в интервью ресурсу SiliconANGLE, что на данный момент SAS Data Maker может создавать синтетические данные только в табличных форматах, и поэтому вряд ли будет востребована многими компаниями.  Также была представлена SAS Viya Workbench — специализированная платформа для разработки ИИ в SAS Viya, предоставляющая вычислительную среду самообслуживания по требованию для таких задач, как подготовка данных, исследовательский анализ данных и построение аналитических моделей ИИ. Платформа будет запущена во II квартале на AWS Marketplace с поддержкой SAS и Python, а также поддержкой R к концу года. Пользователи получат доступ к двум вариантам среды разработки в SAS Viya Workbench, включая Visual Studio Code и Jupyter Notebooks. Для тех, кто по каким-то причинам не может разрабатывать собственные ИИ-модели и ищет готовые решения, которые можно просто подключить к своим бизнес-системам и сразу приступить к работе, SAS представила первую из целого каталога «облегчённых» отраслевых моделей ИИ, предназначенных для клиентов в сфере финансовых услуг, здравоохранения, государственных учреждений, производства и т.д. По словам SAS, пакетные ИИ-модели создаются с использованием запатентованных LLM и предназначены для пользователей нетехнологического сектора с целью оптимизации рабочих процессов и улучшения процесса принятия решений. SAS анонсировала свою первую комплексную модель — помощника с ИИ для оптимизации складских помещений, который может оценивать планировку складов клиентов и предлагать лучшие способы организации, чтобы максимизировать ёмкость или повысить эффективность.

23.04.2024 [11:45], Сергей Карасёв

Samsung откроет в Кремниевой долине лабораторию по созданию ИИ-чипов на базе RISC-V, чтобы побороться с NVIDIAКомпания Samsung Electronics, по сообщению ресурса Business Korea, откроет новую научно-исследовательскую и опытно-конструкторскую (R&D) лабораторию в Кремниевой долине. Её специалисты займутся прежде всего созданием ИИ-чипов на открытой архитектуре RISC-V. По имеющейся информации, Технологический институт Samsung SAIT (Samsung Advanced Institute of Technology) учредил исследовательский центр Advanced Processor Lab (APL). Южнокорейская компания намерена расширить свои возможности в области разработки ИИ-решений, чтобы в перспективе бросить вызов американским корпорациям, в числе которых называется NVIDIA. Около месяца назад Samsung сформировала лабораторию Semiconductor AGI Computing Lab, сотрудники которой разрабатывают чипы следующего поколения для ИИ-приложений. Офисы данного подразделения располагаются в Южной Корее и США. Основным направлением исследований являются системы «общего искусственного интеллекта» (Artificial General Intelligence, AGI). В заявлении в LinkedIn глава Samsung Semiconductor Ке Хён Гён (Kye Hyun Kyung) отметил, что на первом этапе лаборатория сосредоточит усилия на разработке чипов для больших языковых моделей (LLM), тогда как реализация проектов в области AGI начнётся позднее.

Источник изображения: pixabay.com Между тем власти США в рамках «Закона о чипах» выделили Samsung $6,4 млрд безвозвратных субсидий на строительство предприятий в Техасе. По условиям соглашения, в городе Тейлоре будут построены два завода по выпуску полупроводниковых изделий с нормами 4 и 2 нм. «Мы считаем, что полупроводниковые технологии нового поколения, созданные с использованием ИИ и компьютерной техники, сыграют ключевую роль в повышении качества жизни. Именно поэтому SAIT тесно сотрудничает с учёными и экспертами в поисках новых долгосрочных драйверов роста для Samsung», — говорит Гёйонг Джин (Gyoyoung Jin), президент SAIT.

17.04.2024 [16:33], Руслан Авдеев

Запрос со звёздочкой: MLCommons анонсировала бенчмарк для оценки безопасности ИИ — AI Safety v0.5Некоммерческий проект MLCommons, занимающийся созданием и поддержкой бенчмарков, широко используемых в ИИ-индустрии, анонсировал новую разработку, передаёт Silicon Angle. Речь идёт об инструменте, позволяющем оценивать безопасность ИИ-систем. Консорциум объявил о создании соответствующей рабочей группы AIS в конце 2023 года. AI Safety v0.5 находится на стадии proof-of-concept и позволяет оценивать большие языковые модели (LLM), стоящие за современными чат-ботами, анализируя ответы на запросы из «опасных категорий». Необходимость в появлении такого инструмента давно назрела, поскольку технологию оказалось довольно легко использовать в неблаговидных и даже опасных целях. Например, ботов можно применять для подготовки фишинговых атак и совершения других киберпреступлений, а также для распространения дезинформации и разжигания ненависти. Хотя измерить безопасность довольно сложно с учётом того, что ИИ используется в самых разных целях, в MLCommons создали инструмент, способный разбираться с широким спектром угроз. Например, он может оценивать, как бот отвечает на запрос о рецептах изготовления бомбы, что отвечать полиции, если пойман за созданием взрывного устройства и т.п. Каждая модель «допрашивается» серией тестовых запросов, ответы на которые потом подлежат проверке. LLM оценивается как по каждой из категорий угроз, так и по уровню безопасности в целом. Бенчмарк включает более 43 тыс. промтов. Методика позволяет классифицировать угрозы, конвертируя ответы в понятные даже непрофессионалам характеристики, вроде «высокий риск», «умеренно-высокий риск» и т.д. Представители организации заявляют, что LLM чрезвычайно трудно оценивать по ряду причин, но ИИ в любом случае нуждается в точных измерениях, понятных людям и имеющих прикладное значение. Работа над бенчмарком продолжается, всего идентифицированы 13 опасных категорий, но только семь из них пока оцениваются в рамках исходного проекта. Речь идёт о темах, связанных с насильственными и ненасильственными преступлениями, оружием массового уничтожения, суицидами и др., ведётся разработка и для новых категорий — всё это позволит создавать более «зрелые» модели с низким уровнем риска. В будущем планируется оценивать не только текстовые модели, но и системы генерации изображений. Бенчмарк AI Safety v0.5 уже доступен для экспериментов и организация надеется, что исходные тесты сообществом позволят выпустить усовершенствованную версию v1.0 позже в текущем году. В MLCommons заявляют, что по мере развития ИИ-технологий придётся иметь дело не только с известными опасностями, но и новыми, которые могут возникнуть позже — поэтому платформа открыта для предложений новых тестов и интерпретации результатов. |

|