Материалы по тегу: llm

|

09.04.2024 [12:45], Сергей Карасёв

Hyperion Research: спрос на облачные НРС-услуги будет быстро растиКомпания Hyperion Research, по сообщению ресурса HPC Wire, сделала прогноз по мировому рынку облачных HPC-решений. По мнению аналитиков, спрос на такие услуги в ближайшие годы будет быстро расти, что объясняется стремительным внедрением ИИ, генеративных сервисов и других современных решений. Говорится, что значение CAGR (среднегодовой темп роста в сложных процентах) на рынке облачных НРС-сервисов в перспективе пяти лет составит 18,1 %. При этом, как отмечается, данный показатель не в полной мере учитывает значительное влияние ИИ на увеличение спроса на технические вычисления в облаке. Аналитики отмечают, что обучение ИИ-моделей, имеющее большое значение, может быть отодвинуто на второй план из-за роста потребностей в инференсе. Дело в том, что обучение требует значительных вычислительных ресурсов, но на относительно небольшие периоды времени. Кроме того, обучение выполняет сравнительно небольшое количество пользователей. Вместе с тем инференс востребован среди широкого круга заказчиков для самых разных приложений.

Источник изображения: pixabay.com В исследовании также говорится, что рост использования генеративного ИИ продолжится, тогда как его темпы внедрения стабилизируются. В сегменте больших языковых моделей (LLM) популярность начнут обретать фреймворки. В плане аппаратного обеспечения, как полагают аналитики Hyperion Research, резко возрастёт востребованность Arm-процессоров. В сегменте НРС выручка от Arm-систем в 2024 году поднимется в два раза по отношению к предыдущему году. Кроме того, ожидается рост популярности чипов с открытой архитектурой RISC-V. Прогнозируется также увеличение интереса к локальным квантовым компьютерам, которые будут дополнять квантовые вычисления через облако.

08.04.2024 [11:35], Сергей Карасёв

BSC и NVIDIA займутся совместной разработкой HPC- и ИИ-решенийБарселонский суперкомпьютерный центр (Centro Nacional de Supercomputación, BSC-CNS) и NVIDIA объявили о заключении многолетнего соглашения о сотрудничестве, целью которого является совместная разработка инновационных решений, объединяющих технологии НРС и ИИ. Договор рассчитан на пять лет с возможностью последующего продления. При этом каждые шесть месяцев стороны намерены уточнять и оптимизировать направления сотрудничества. Новое соглашение будет действовать параллельно с ранее подписанным документом, касающимся совместных исследований в области сетевых решений. Первоначально сотрудничество между BSC и NVIDIA будет сосредоточено на разработке больших языковых моделей (LLM), а также приложений для метеорологии и анализа изменений климата. Кроме того, стороны займутся адаптацией вычислительной модели цифрового двойника сердца, разработанной в рамках проекта Alya, к различным платформам. Ещё одно направление работ — программная оптимизация процессов для GPU и архитектуры NVIDIA Grace с ядрами Arm, специально разработанной для ИИ и крупномасштабных суперкомпьютерных приложений. Предполагается также, что научный потенциал BSC вкупе с технологическими достижениями и опытом NVIDIA позволят максимизировать вычислительные возможности суперкомпьютера MareNostrum 5, который был запущен в Испании в конце 2023 года. Эта система, использующая ускорители NVIDIA H100, обладает производительностью 314 Пфлопс.

08.04.2024 [01:50], Владимир Мироненко

Groq больше не продаёт свои ИИ-ускорители, предлагая вместо этого совместно создавать ЦОД и облачные сервисыСтартап Groq, создавший ускоритель LPU на базе собственного массивно-параллельного тензорного процессора TSP, больше не продаёт оборудование, предлагая вместо этого воспользоваться его облачными ИИ-сервисами или стать партнёром в создании ЦОД. Об этом генеральный директор Groq Джонатан Росс (Jonathan Ross) сообщил ресурсу EE Times. Он пояснил, что для стартапа заниматься продажами чипов слишком сложно, потому что «минимальная сумма покупки, чтобы это имело смысл, высока, затраты высоки, и никто не хочет рисковать, покупая большое количество оборудования — неважно, насколько оно потрясающее». По его словам, в облаке GroqCloud для инференса больших языковых моделей (LLM) в реальном времени уже зарегистрировано 70 тыс. разработчиков и запущено более 19 тыс. новых приложений. В случае поступления заказов на поставку больших объёмов чипов для очень крупных систем Groq вместо продажи предлагает партнёрство по развёртыванию ЦОД. Groq подписала соглашение с саудовской государственной нефтяной компанией Aramco, которое предполагает масштабное развёртывание LPU. Похожее соглашение в ОАЭ подписала Cerebras, ещё один молодой разработчик ИИ-ускорителей. «Правительство США и его союзники — единственные, кому мы готовы продавать оборудование, — говорит Росс. — Для всех остальных мы лишь (совместно) создаём коммерческие облака». По его словам, в этом году Groq планирует разместить 42 тыс. LPU в GroqCloud, при этом Aramco и другие партнёры «завершают» свои сделки по получению такого же количества чипов. Компания способна выпустить 220 тыс. LPU только в этом году, а общий объём производства на ближайшее время составляет 1,5 млн ускорителей. Около 1 млн из них всё ещё не зарезверированы, но это количество быстро сокращается. Росс пообещал, что к концу 2025 году компания развернёт столько LPU, что их вычислительная мощность будет эквивалентна ИИ-мощностям всех гиперскейлерам вместе взятых. Росс с оптимизмом смотрит на перспективы Groq, поскольку чипы TSP не используют память HBM, на которую полагаются решения конкурентов, включая NVIDIA, и поставки которой расписаны до конца 2024 года. Что касается LPU следующего поколения, то компания планирует сразу перейти с 14-нм техпроцесса (Global Foundries) на 4-нм. По словам Росса, новый чип будет оптимизирован для генеративного ИИ, но у него в силу универсальности архитектуры не будет каких-то специальных функций для обработки LLM. Будет ли новый ускоритель всё так же изготавливаться на территории США, не уточняется. Groq, похоже, достаточно уверена в своих чипах, которые в бенчмарках действительно обгоняют конкурентов. После анонса архитектуры NVIDIA Blackwell, обеспечивающей кратное увеличение производительности в задачах генеративного ИИ, компания выпустил в ответ пресс-релиз из одного предложения: «Groq всё ещё быстрее». А чуть позже даже раскритиковала NVIDIA.

07.04.2024 [22:40], Сергей Карасёв

Oracle и Palantir предложат ИИ-решения для госсектора и предприятий

llm

oracle

oracle cloud infrastructure

palantir

software

ии

информационная безопасность

конфиденциальность

облако

Компании Oracle и Palantir объявили о заключении партнёрского соглашения, в рамках которого планируется развитие безопасных облачных сервисов и ИИ-систем для государственных организаций и корпоративных заказчиков по всему миру. Предполагается, что совместное предложение поможет клиентам максимизировать ценность своих данных и повысить эффективность работы. В рамках соглашения распределённое облако и ИИ-инфраструктура Oracle будут использоваться в сочетании с платформами ИИ и ускорения принятия решений Palantir. Вместе с тем Palantir перенесёт рабочие нагрузки своей платформы Foundry в Oracle Cloud Infrastructure (OCI). Отмечается, что Foundry позволяет переосмыслить то, как используются данные, а также устраняет барьеры между внутренним управлением и внешним анализом информации. По условиям подписанного договора, Palantir обеспечит возможность развёртывания своих систем Gotham и Artificial Intelligence (AI) в распределённом облаке Oracle. Речь идёт о публичных и выделенных регионах Oracle Cloud, европейском суверенном облаке Oracle EU Sovereign Cloud, инфраструктурной платформе Oracle Alloy, гособлаке Oracle Government Cloud, инфраструктуре Oracle Roving Edge, а также изолированных регионах Oracle для оборонных заказчиков и спецслужб.

Источник изображения: Oracle Платформа Palantir AI, как отмечается, позволяет организациям использовать возможности больших языковых моделей (LLM) в своих корпоративных сетях и интегрировать ИИ в основные операции с максимальной безопасностью. Решение предназначено для объединения разрозненных источников данных, логических активов и прочих ресурсов в единую операционную среду. В целом, как утверждается, партнёрство Oracle и Palantir позволит организациям использовать облачные сервисы и системы ИИ с соблюдением стандартов суверенитета и безопасности. Стороны намерены совместно предоставлять и поддерживать широкий спектр услуг.

06.04.2024 [17:48], Владимир Мироненко

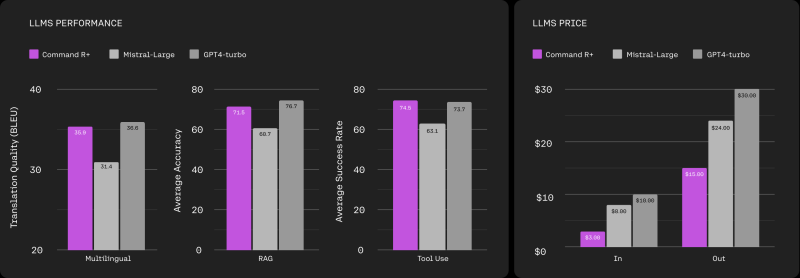

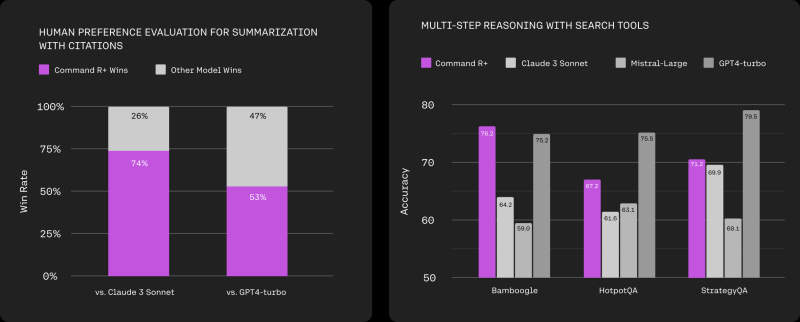

Cohere представила большую языковую модель Command R+ для корпоративного сегментаСтартап в области ИИ Cohere объявил о запуске новой большой языковой модели Command R+, предназначенной для поддержки реальных корпоративных бизнес-процессов и сценариев использования. Command R+ представляет собой самую мощную и масштабируемую на сегодняшний день LLM Cohere, которая пополнила серию моделей R, ориентированных на баланс точности и эффективности при низкой стоимости использования. Она опирается на наиболее сильные стороны вышедшей в прошлом месяце менее мощной модели Command R, говорит разработчик. Компании могут адаптировать Command R+ с использованием собственных данных, она оптимизирована для RAG. По словам Cohere, это позволяет Command R+ предоставлять высокоточные ответы и значительно снижает вероятность галлюцинаций. Как утверждает Cohere, Command R+ превосходит аналогичные модели как по стоимости, более низкой чем у конкурентов, так и масштабируемости в отношении решения корпоративных задач документооборота по ключевым «критически важным для бизнеса возможностям». Новая модель поддерживает корпоративные варианты использования, такие как категоризация, автоматизация использования инструментов документооборота, анализ данных и многое другое. Клиенты могут также использовать её для написания маркетинговых текстов. Подобно Command R, новая модель имеет контекстное окно на 128 тыс. токенов. Этого вполне достаточно для обработки больших объёмов документации. Также сообщается о поддержке более 10 языков, включая английский, французский, испанский, итальянский, немецкий, португальский, японский, корейский, арабский и китайский. Что немаловажно, Command R+ и семейство LLM R могут выступать в качестве основного аналитического центра для принятия решений при автоматизации бизнес-процессов. В сочетании с инструментами Cohere она может автоматически обновлять задачи, действия и записи по управлению взаимоотношениями с клиентами, помогать в обслуживании последних, выполнять заказы и другие обязанности, обещают авторы. Модель Command R+ поддерживает многоэтапное использование инструментов при выполнении сложных задач. Модель способна анализировать проблемы, возникающие при выходе конкретного инструмента из строя или ошибке, корректировать ходы и способы решения задачи. Такой подход позволяет повысить вероятность успешного решения задачи. Cohere также объявила о расширении сотрудничества с Microsoft с целью ускорения внедрения ИИ на предприятиях. Благодаря этому разработчики и предприятия могут получить доступ к Command R+ в Microsoft Azure. В ближайшие недели новая модель станет доступна в Oracle Cloud Infrastructure и других облачных платформах. В настоящий момент разработчики могут опробовать новую модель в демонстрационной среде Cohere и протестировать её в чате.

03.04.2024 [12:57], Руслан Авдеев

Выходцы из Google основали стартап MatX для разработки чипов для тренировки ИИ-моделейБывшие сотрудники Google объединились для создания стартапа, который займётся разработкой современных ИИ-чипов. По данным Bloomberg, новые продукты будут предназначены для тренировки больших языковых моделей (LLM), и компания уже привлекла $25 млн на реализацию собственных инициатив. В интервью Bloomberg основатели компании Майк Гюнтер (Mike Gunter) и Райнер Поуп (Reiner Pope) заявили, что Google удалось ускорить работу своих LLM, но её цели оказались слишком «размытыми», из-за чего коллеги решили заняться собственными разработками — чипами для обучения языковых моделей.

Источник изображения: MatX В Google Поуп занимался ПО, а Гюнтер — разработкой аппаратной составляющей, включая чипы для работы с создаваемым в компании ПО. В интервью предприниматели сообщили, что в Google разрабатывали тензорные ИИ-ускорители TPU задолго до появления современных ИИ-моделей, но оптимизировать их под актуальные задачи было довольно трудно, в том числе потому, что многие в Google требовали оптимизации ускорителей под собственные потребности. Теперь пара бизнесменов-энтузиастов рассчитывает, что MatX удастся создать процессоры как минимум в 10 раз лучше в обучении и эксплуатации LLM, чем ускорители NVIDIA. Добиться этого планируется удалением из чипов т.н. «дополнительной недвижимости» — функциональности, позволяющей выполнять ненужные для ИИ-систем вычислительные задачи. Утверждается, что NVIDIA просто повезло — GPU оказались намного лучше для решения ИИ-задач, чем обычные процессоры, поэтому сейчас компания зарабатывает на случайно пришедшейся к месту технологии, предназначавшейся совсем для другого. В MatX же займутся разработкой специализированных чипов с одним большим вычислительным ядром. Сообщается, что стартап уже нанял десятки сотрудников и рассчитывает подготовить окончательную версию своего продукта к 2025 году. По словам Поупа, чипы NVIDIA — по-настоящему сильные продукты и подходят большинству компаний. Но разработчики считают, что могут сделать чипы намного лучше. В MatX прогнозируют, что при сохранении вектора развития программного обеспечения, связанного с ИИ, понадобятся огромные вычислительные мощности. Если для тренировки современных моделей сегодня требуется в среднем $1 млрд, то для LLM будущего эта сумма вырастет до $10 млрд. Представители стартапа утверждают, что смогут добиться большего успеха, чем компании вроде OpenAI или Anthropic PBC. Те тратят все деньги на вычисления, фактически не заботясь о прибыли, так что в итоге, если ничего не изменится, деньги у них просто закончатся. Проблема в том, что на разработку нового чипа уходит от трёх до пяти лет, а гиганты вроде NVIDIA не будут стоять на месте, создавая собственные продукты. Стартапам придётся чрезвычайно точно оценивать современные тренды и предсказывать в каком направлении будет развиваться отрасль — причём права на ошибку, в отличие от крупных игроков, у них нет. Разработчиков ПО предстоит убедить в том, что переделка программ под новые полупроводники будет чрезвычайно выгодной — новый чип должен быть как минимум в 10 раз потенциально лучше прежних, чтобы им заинтересовались возможные клиенты.

29.03.2024 [13:48], Сергей Карасёв

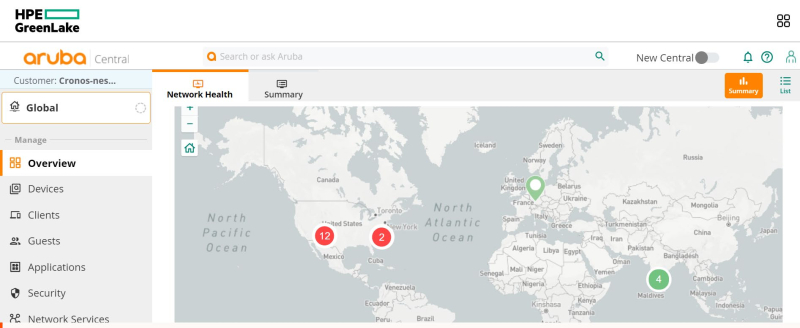

HPE внедрила генеративный ИИ в облачную платформу Aruba Networking CentralКомпания HPE объявила о внедрении нескольких больших языковых моделей (LLM) в облачную платформу Aruba Networking Central, которая предоставляет IT-специалистам аналитическую информацию, интуитивно понятную визуализацию данных, средства автоматизации рабочих процессов и пр. Сообщается, что LLM отвечают за работу функций на основе генеративного ИИ. Это, в частности, чат-бот, интегрированный в поисковый интерфейс. После ввода запроса система выдаёт контекстуализированный ответ, на подготовку которого, как утверждается, уходят доли секунды. При этом ИИ не принимает никакие административные решения самостоятельно. Модели обучены на собственных наборах данных компании. Это всевозможные документы службы поддержки, примерно 3 млн запросов клиентов и другие сведения, собранные за годы работы. HPE подчёркивает, что модели помещены в песочницу. При этом реализованы специальные средства, предназначенные для исключения личной и корпоративной информации из запросов, чтобы предотвратить её попадание в будущие наборы обучающих данных. HPE Aruba Networking собрала телеметрию почти с 4 млн сетевых устройств и более чем с 1 млрд уникальных конечных точек клиентов. В результате было сформировано одно из крупнейших озёр данных в сетевой отрасли. Эта информация используется в сервисах машинного обучения HPE Aruba Networking Central для прогнозного анализа и рекомендаций. Внедрение LLM поможет расширить ИИ-возможности платформы. На базе LLM, как отмечается, также будет работать функция обобщения документов, которая заработает в апреле нынешнего года. Она позволит клиентам задавать вопросы вида «Как сделать…», после чего система создаст соответствующее руководство и предоставит ссылки на нужную техническую документацию. Это позволит ускорить решение проблем и снизить вероятность ошибок.

28.03.2024 [22:01], Владимир Мироненко

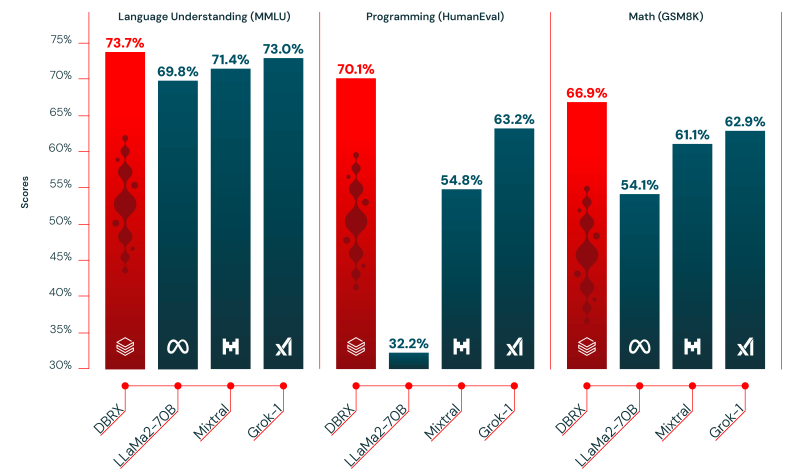

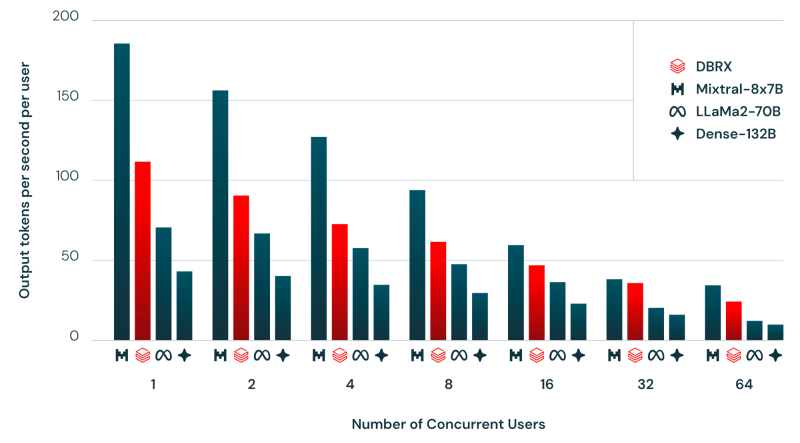

Databricks представила открытую LLM DBRX, превосходящую GPT-3.5 TurboАмериканский стартап в сфере аналитики больших данных и машинного обучения Databricks объявил о выходе DBRX, большой языковой модели (LLM) общего назначения, которая, по его словам, превосходит в стандартных бенчмарках все существующие LLM с открытым исходным кодом, а также некоторые проприетарные ИИ-модели. Стартап заявил, что открывает исходный код модели, чтобы побудить пользователей отказаться от коммерческих альтернатив. Он отметил, что согласно исследованию Andreessen Horowitz LLC, почти 60 % лидеров в области ИИ-технологий заинтересованы в увеличении использования или переходе на open source, если открытые модели после тюнинга примерно соответствуют по производительности проприетарным моделям.

Источник изображений: Databricks «Я считаю, что самые ценные данные хранятся внутри предприятий. ИИ как бы исключён из этих сфер, поэтому мы пытаемся реализовать это с помощью моделей с открытым исходным кодом», — цитирует ресурс SiliconANGLE заявление гендиректора Databricks Али Годси (Ali Ghodsi) на брифинге с журналистами. По словам Годси, лучше всего DBRX подходит для сфер, где критически важны управление и безопасность, например, для финансовых услуг и здравоохранения, или там, где важен тон ответов, например, в области самообслуживании клиентов. DBRX использует архитектуру Mixture of Experts (MoE, набор экспертов), которая делит процесс обучения между несколькими специализированными «экспертными» подсетями. Каждый «эксперт» владеет определёнными навыками, а исходный запрос оптимальным образом распределяется между «экспертами». Вице-президент Databricks по генеративному ИИ, перешедший в компанию вместе с приобретением MosaicML, соучредителем которой он был, заявил, что MoE работает даже лучше человека. Хотя DBRX с 132 млрд параметром почти в два раза больше Llama 2, она всё равно вдвое быстрее. Также сообщается, что DBRX превзошла существующие LLM с открытым исходным кодом Llama 2 70B и Mixtral-8x7B (тоже MoE), а также запатентованную GPT-3.5 Turbo в тестах на понимание языка, программирование, математику и логику. Обучение модели на общедоступных и лицензированных источниках данных в течение двухмесячного периода обошлось Databricks всего в $10 млн с использованием 3 тыс. ускорителей NVIDIA H100. По словам компании, при создании приложений генеративного ИИ модель DBRX можно использовать вместе с Databricks Mosaic AI, набором унифицированных инструментов для создания, развёртывания и мониторинга моделей ИИ. Базовая модель DBRX Base и продвинутая модель DBRX Instruct доступны по открытой лицензии для исследований и коммерческого использования на GitHub и Hugging Face. Разработчики могут уже сегодня создавать свои варианты DBRX на основе собственных данных на платформе Databricks.

20.03.2024 [22:19], Сергей Карасёв

Samsung создала лабораторию по разработке ИИ-чипов нового поколенияКомпания Samsung Electronics, по сообщению Bloomberg, сформировала лабораторию, специалистам которой предстоит заняться разработкой чипов следующего поколения для ИИ-приложений. Новое подразделение получило название Samsung Semiconductor AGI Computing Lab: его офисы будут располагаться в Южной Корее и США. Главной задачей лаборатории является проектирование полупроводниковых чипов, способных справляться с высокими вычислительными нагрузками, связанными с развитием так называемого «общего искусственного интеллекта» (Artificial General Intelligence, AGI). Речь идёт о системах, которые по возможностям смогут как минимум не уступать человеческому мозгу, а, возможно, и превосходить его.

Источник изображения: pixabay.com Современные ИИ-модели функционируют в рамках набора данных, на которых производилось обучение. Концепция AGI, в свою очередь, предполагает, что ИИ-система может выполнять задачи, для которых она изначально не обучалась. Такие модели должны обладать достаточной степенью самосознания и способностью осваивать новые навыки без вмешательства человека. Иными словами, AGI — это универсальный ИИ, способный решать сложные задачи, применяя обобщенные когнитивные способности. Фактически такая нейросеть может стать полноценной альтернативой человеческому мозгу. Однако для поддержания работы AGI потребуются чипы нового поколения, обладающие необходимой производительностью при сравнительно небольшом энергопотреблении. Для достижения таких характеристик Samsung планирует переосмыслить все аспекты архитектуры процессоров, включая память, интерконнект и даже упаковку. На первом этапе новая лаборатория сосредоточится на разработке чипов для больших языковых моделей (LLM) с упором на инференс. Руководителем Samsung Semiconductor AGI Computing Lab назначен Дон Хёк Ву (Dong Hyuk Wu), который ранее занимал должность старшего инженера-программиста Google.

19.03.2024 [03:18], Владимир Мироненко

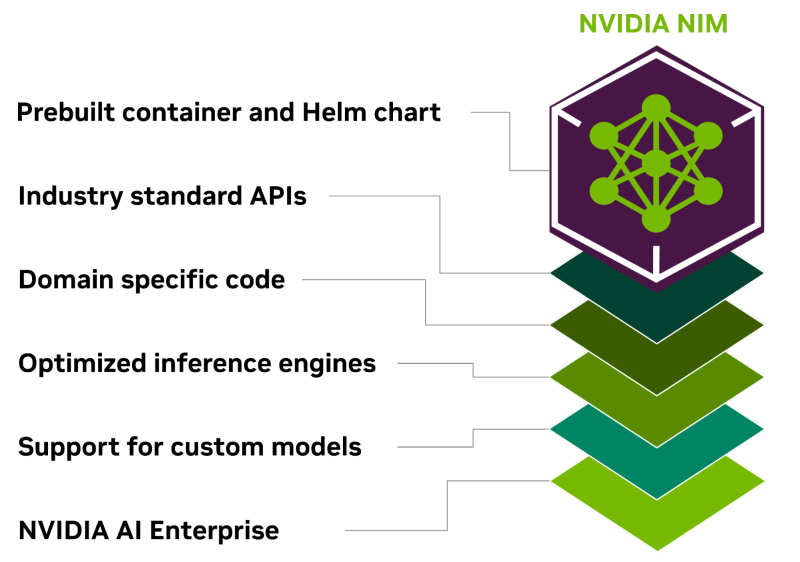

Всё своё ношу с собой: NVIDIA представила контейнеры NIM для быстрого развёртывания оптимизированных ИИ-моделейКомпания NVIDIA представила микросервис NIM, входящий в платформу NVIDIA AI Enterprise 5.0 и предназначенный для оптимизации запуска различных популярных моделей ИИ от NVIDIA и её партнёров. NVIDIA NIM позволяет развёртывать ИИ-модели в различных инфраструктурах: от локальных рабочих станций до облаков. Предварительно созданные контейнеры и Helm Chart'ы с оптимизированными моделями тщательно проверяются и тестируются на различных аппаратных платформах NVIDIA, у поставщиков облачных услуг и на дистрибутивах Kubernetes. Это обеспечивает поддержку всех сред с ускорителями NVIDIA и гарантирует, что компании смогут развёртывать свои приложения генеративного ИИ где угодно, сохраняя полный контроль над своими приложениями и данными, которые они обрабатывают. Разработчики могут получить доступ к моделям посредством стандартизированных API, что упрощает разработку и обновление приложений. NIM также может использоваться для оптимизации исполнения специализированных решений, поскольку не только использует NVIDIA CUDA, но и предлагает адаптацию для различных областей, таких как большие языковые модели (LLM), визуальные модели (VLM), а также модели речи, изображений, видео, 3D, разработки лекарств, медицинской визуализации и т.д. NIM использует оптимизированные механизмы инференса для каждой модели и конфигурации оборудования, обеспечивая наилучшую задержку и пропускную способность и позволяя более просто и быстро масштабироваться по мере роста нагрузок. В то же время NIM позволяет дообучить и настроить модели на собственных данных, поскольку можно не только воспользоваться облачными API NVIDIA для доступа к готовым моделями, но и самостоятельно развернуть NIM в Kubernetes-средах у крупных облачных провайдеров или локально, что сокращает время разработки, сложность и стоимость подобных проектов и позволяет интегрировать NIM в существующие приложения без необходимости глубокой настройки или специальных знаний. |

|