Материалы по тегу: c

|

08.05.2025 [19:22], Сергей Карасёв

Cadence представила суперкомпьютер Millennium M2000 на базе NVIDIA BlackwellКомпания Cadence анонсировала суперкомпьютер Millennium M2000, спроектированный для выполнения сложного моделирования с использованием ИИ. Новая НРС-система предназначена для ускорения проектирования микрочипов, разработки лекарственных препаратов следующего поколения и пр. Суперкомпьютер построен на платформе NVIDIA HGX B200. Кроме того, задействованы карты NVIDIA RTX Pro 6000 Blackwell Server Edition, оснащённые 96 Гбайт памяти GDDR7. Применены библиотеки NVIDIA CUDA-X и специализированное ПО для решения ресурсоёмких задач. Утверждается, что Millennium M2000 обеспечивает до 80 раз более высокую производительность по сравнению с системами на базе CPU в области автоматизации проектирования электроники (EDA), создания и анализа систем (SDA) и разработки медикаментов. При этом глубоко оптимизированный программно-аппаратный стек помогает существенно сократить общее энергопотребление. В качестве примера приводится моделирование подсистемы питания на уровне полупроводниковых чипов. В случае вычислительных комплексов на основе сотен традиционных CPU на выполнение такой задачи может потребоваться около двух недель. Суперкомпьютер Millennium M2000 позволит получить результат менее чем за один день. Генеральный директор NVIDIA Дженсен Хуанг (Jensen Huang) сообщил, что компания планирует приобрести десять суперкомпьютерных систем Millennium на базе GB200 NVL72 для ускорения проектирования собственных продуктов. Сторонние заказчики смогут получить доступ к Millennium M2000 через облако или купить устройство для установки в собственном дата-центре. Базовая конфигурация включает около 32 ускорителей и стоит $2 млн, но это не финальная цена.

06.05.2025 [11:12], Сергей Карасёв

Nebius внедрит системы хранения DDN в свою ИИ-инфраструктуруКомпания DataDirect Networks (DDN), специализирующаяся на системах хранения данных для НРС, объявила о заключении партнёрского соглашения с разработчиком ИИ-решений Nebius (бывшая материнская структура «Яндекса»). В рамках соглашения стороны займутся созданием высокопроизводительной подсистемы хранения данных для ресурсоёмких ИИ-задач. Речь идёт об интеграции решений DDN Infinia и EXAScaler в облачную инфраструктуру Nebius AI Cloud. Эти системы будут использоваться для хранения данных, предназначенных для обучения больших языковых моделей, инференса и поддержания работы ИИ-приложений в реальном времени. По заявлениям DDN, Infinia гарантирует надёжность и передовую производительность, благодаря чему ускоряется обучение и развёртывание моделей ИИ. Вместе с тем EXAScaler обеспечивает высокую пропускную способность и согласованность операций ввода-вывода. Другим преимуществом названных решений является возможность масштабирования в рамках облачных и локальных развёртываний: заказчики смогут быстро наращивать ресурсы в ИИ-облаке Nebius, гибридных и изолированных средах, используя параллельную файловую систему EXAScaler.

Источник изображения: Nebius Утверждается, что Infinia и EXAScaler устраняют проблемы с задержками при обработке данных. В результате, нагрузки ИИ могут обрабатываться с максимальной эффективностью — даже в случае моделей с несколькими триллионами параметров. В целом, как отмечают партнёры, благодаря интеграции систем DDN в облако Nebius клиенты смогут решать ИИ-задачи с более высокой скоростью и с меньшими временными и финансовыми затратами.

05.05.2025 [13:28], Сергей Карасёв

GigaIO и d-Matrix предоставят инференс-платформу для масштабных ИИ-развёртыванийКомпании GigaIO и d-Matrix объявили о стратегическом партнёрстве с целью создания «самого масштабируемого в мире» решения для инференса, ориентированного на крупные предприятия, которые разворачивают ИИ в большом масштабе. Ожидается, что новая платформа поможет устранить узкие места в плане производительности и упростить внедрение крупных ИИ-систем. В рамках сотрудничества осуществлена интеграция ИИ-ускорителей d-Matrix Corsair в состав НРС-платформы GigaIO SuperNODE. Архитектура Corsair основана на модифицированных ячейках SRAM для вычислений в памяти (DIMC), работающих на скорости около 150 Тбайт/с. По заявлениям d-Matrix, ускоритель обеспечивает непревзойдённую производительность и эффективность инференса для генеративного ИИ. Устройство выполнено в виде карты расширения с интерфейсом PCIe 5.0 х16. Быстродействие достигает 2,4 Пфлопс с (8-бит вычисления). Изделие имеет двухслотовое исполнение, а показатель TDP равен 600 Вт. В свою очередь, SuperNODE использует фирменную архитектуру FabreX на базе PCIe, которая позволяет объединять различные компоненты, включая GPU, FPGA и пулы памяти. По сравнению с обычными серверными кластерами SuperNODE обеспечивает более эффективное использование ресурсов.

Источник изображения: d-Matrix Новая модификация SuperNODE поддерживает десятки ускорителей Corsair в одном узле. Производительность составляет до 30 тыс. токенов в секунду при времени обработки 2 мс на токен для таких моделей, как Llama3 70B. По сравнению с решениями на базе GPU обещаны трёхкратное повышение энергоэффективности и в три раза более высокое быстродействие при сопоставимой стоимости владения. «Наша система избавляет от необходимости создания сложных многоузловых конфигураций и упрощает развёртывание, позволяя предприятиям быстро адаптироваться к меняющимся рабочим нагрузкам ИИ, при этом значительно улучшая совокупную стоимость владения и операционную эффективность», — говорит Alan Benjamin (Алан Бенджамин), генеральный директор GigaIO.

05.05.2025 [12:47], Сергей Карасёв

Терабитное облако: Backblaze запустила S3-хранилище B2 Overdrive для рабочих нагрузок ИИ и HPCАмериканская компания Backblaze анонсировала облачное S3-хранилище B2 Overdrive, оптимизированное для нагрузок с интенсивным обменом данными, таких как задачи ИИ и НРС. Утверждается, что платформа в плане соотношения производительности/цены значительно превосходит предложения конкурентов. Backblaze отмечает, что при работе с ресурсоёмкими приложениями ИИ, машинного обучения, доставки контента или аналитики, клиенты зачастую сталкиваются с выбором: платить больше за максимальную скорость доступа к облаку или жертвовать производительностью, чтобы сохранить расходы на приемлемом уровне. B2 Overdrive, как утверждается, решает эту проблему. Новый сервис обеспечивает пропускную способность до 1 Тбит/с, а цена начинается с $15 за 1 Тбайт в месяц. Минимальный заказ — несколько Пбайт. Заявленный показатель безотказного функционирования — 99,9 %. Предоставляется бесплатный вывод данных из облака в трехкратном среднем ежемесячном объёме хранения клиента. После превышения этого значения стоимость составляет $0,01 за 1 Гбайт. Скидки за объём и сроки хранения доступны с сервисом B2 Reserve. Для хранения данных в облаке B2 Overdrive применяются HDD. Подключение к инфраструктуре клиента осуществляется через защищённую частную сеть. Информацию в экзабайтном масштабе можно свободно перемещать в любой кластер GPU или HPC с неограниченным бесплатным выводом. Среди прочих преимуществ B2 Overdrive компания Backblaze выделяет отсутствие требований к минимальному размеру файлов, уведомления о событиях, а также бесплатное удаление информации. Приём заявок на подключение к сервису уже начался.

03.05.2025 [16:00], Руслан Авдеев

В Рио-де-Жанейро построят крупнейший в Латинской Америке кампус ЦОД Rio AI CityВ Рио-де-Жанейро объявлено о строительстве нового ИИ ЦОД. После завершения проекта кампус дата-центров станет крупнейшим в Латинской Америке и одним из крупнейших в мире, сообщает Datacenter Dynamics. Кампус Rio AI City расположится на территории Olympic Park. Первые 1,8 ГВт намерены ввести в строй к 2027 году, а к 2032 году возможно расширение до 3 ГВт. Ожидается, что в кампусе будут обеспечены условия для развёртывания новейших суперкомпьютеров. По словам мэра города, анонсировавшего проект, главная цель строительства нового кампуса — повысить роль Рио в развитии ИИ и закрепить за городом статус «столицы инноваций Латинской Америки». Город намерен стать движущей силой «ИИ-революции» и обеспечить гарантии того, что развитие искусственного интеллекта пойдёт обществу на благо. Мэр пообещал, что кампус будет целиком обеспечиваться «чистой» энергией и получит «неограниченный» запас воды для охлаждения оборудования. Кампус напрямую связан с проектом Porto Maravilha, предполагающим восстановление в городе старого портового района. По словам муниципальных властей, район станет центром экоустойчивых инноваций, а вычислительные мощности Rio AI City станут использовать для поддержки роста локальных стартапов. По данным Data Center Map, в Рио-де-Жанейро в настоящее время действует 21 дата-центр. В городе работают операторы Ascenty, Elea и Equinix. В прошлом месяце Equinix запустила в городе свой третий ЦОД — RJ3. Буквально на днях появилась информация, что ByteDance рассматривает строительство в Бразилии дата-центра TikTok, но он будет находиться в отдалении от Рио, в штате Сеара.

02.05.2025 [13:55], Сергей Карасёв

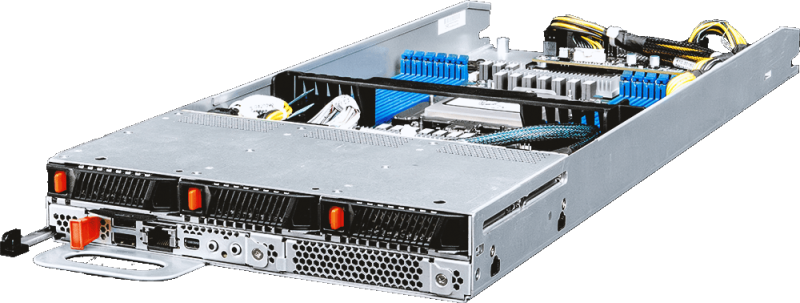

MSI представила многоузловые OCP-серверы на базе AMD EPYC 9005 TurinКомпания MSI анонсировала многоузловые серверы высокой плотности, выполненные в соответствии со стандартом OCP ORv3 (Open Rack v3). Дебютировали модели Open Compute CD281-S4051-X2 и Core Compute CD270-S4051-X4 на аппаратной платформе AMD EPYC 9005 Turin. Решение Open Compute CD281-S4051-X2, выполненное в форм-факторе 2OU, представляет собой двухузловой сервер для инфраструктур гиперскейлеров. Каждый узел может оснащаться одним процессором EPYC 9005 с показателем TDP до 500 Вт и 12 модулями DDR5. Доступны до 12 посадочных мест для накопителей E3.S с интерфейсом PCIe 5.0 (NVMe). Говорится о поддержке CPU-радиаторов Extended Volume Air Cooling (EVAC) и 48-вольтной архитектуры питания ORv3 (48VDC). В свою очередь, Core Compute CD270-S4051-X4 (S4051D270RAU3-X4) — это четырёхузловой сервер стандарта Data Center Modular Hardware Systems (DC-MHS). Устройство имеет типоразмер 2U. Оно подходит для облачных вычислений, CDN-сетей, ИИ-инференса и машинного обучения, виртуализации сетевых функций, телеком-приложений и пр. Каждый узел новинки рассчитан на один чип EPYC 9005 с TDP до 400 Вт. Есть 12 слотов для модулей DDR5-6000 RDIMM/RIMM-3DS суммарным объёмом до 3 Тбайт, три фронтальных отсека для накопителей U.2 с интерфейсом PCIe 5.0 x4 (NVMe), два внутренних коннектора M.2 2280/22110 для SSD с интерфейсом PCIe 3.0 x2 (NVMe), а также слот PCIe 5.0 x16 OCP 3.0. Кроме того, каждый узел располагает контроллером ASPEED AST2600, сетевым портом управления 1GbE, разъёмами USB 2.0 Type-A и Mini DisplayPort, последовательным портом (USB Type-A). Вся система Core Compute CD270-S4051-X4 оборудована двумя блоками питания мощностью 2700 Вт с сертификатом 80 PLUS Titanium. Установлены четыре вентилятора охлаждения с возможностью горячей замены. Диапазон рабочих температур — от 0 до +35 °C. Габариты составляют 448 × 87 × 747 мм.

02.05.2025 [13:50], Сергей Карасёв

MiTAC анонсировала OCP-серверы на основе AMD EPYC Turin с воздушным и жидкостным охлаждением, а также edge-сервер на базе Intel Xeon Sapphire RapidsКомпания MiTAC Computing Technology представила OCP-серверы нового поколения C2810Z5 и C2820Z5, предназначенные для приложений ИИ и НРС. Устройства выполнены на аппаратной платформе AMD EPYC 9005 Turin. Решение C2810Z5 типоразмера 2OU имеет двухузловую конструкцию. Каждый узел допускает установку одного процессора и 12 модулей оперативной памяти DDR5-6400. Доступны шесть отсеков для накопителей U.2 и два посадочных места для SSD стандарта E1.S. Предусмотрены слоты PCIe 5.0 x16 для карт FHHL, HHHL и OCP NIC 3.0. Устройство оснащено воздушным охлаждением. Данная модель подходит для развёртывания микросервисов в облачных средах. В свою очередь, вариант C2820Z5 — это четырёхузловая система 2OU с технологией прямого жидкостного охлаждения. Каждый узел поддерживает два процессора EPYC 9005 Turin и 24 модуля памяти DDR5. Сервер подходит для высокопроизводительных вычислений. Кроме того, MiTAC анонсировала семейство серверов Whitestone 2 (WS2): это, как утверждается, компактная, но мощная платформа, специально оптимизированная для сетей Open RAN и периферийных задач. Система выполнена в корпусе небольшой глубины формата 1U. Задействован процессор Intel Xeon поколения Sapphire Rapids. Предусмотрены восемь слотов для модулей DDR5. Во фронтальной части находятся четыре порта 25GbE SFP28 и восемь портов 10GbE SFP+. Говорится о поддержке IEEE 1588 v2, Sync-E и GPS для синхронизации. В тыльной части располагаются вентиляторы охлаждения в виде девяти сдвоенных блоков.

01.05.2025 [19:13], Сергей Карасёв

Schneider Electric наращивает выручку благодаря спросу на решения для ЦОДКомпания Schneider Electric отрапортовала о работе в I квартале 2025 года. Выручка французской энергомашиностроительной корпорации достигла €9,33 млрд, что на 7,4 % больше по сравнению с результатом за I четверть прошлого года. Положительная динамика, как отмечается, во многом обусловлена хорошим спросом на энергетические решения для ЦОД. В географическом плане наибольшая доля продаж пришлась на Северную Америку — €3,51 млрд. Западная Европа обеспечила вклад в размере €2,13 млрд, Азиатско-Тихоокеанский регион — €2,58 млрд. На все прочие региональные рынки вместе взятые пришлось €1,11 млрд.

Источник изображения: Schneider Electric В сегменте систем питания выручка увеличилась в годовом исчислении на 9,6 %, достигнув €7,57 млрд по итогам I квартала 2025 года. При этом в Северной Америке зафиксирован результат в €3,12 млрд, в Западной Европе — €1,66 млрд, в Азиатско-Тихоокеанском регионе — €1,99 млрд. На прочие географические рынки пришлось €803 млн. Финансовый директор Schneider Хилари Максон (Hilary Maxson) отмечает, что в сегменте ЦОД сохраняется высокий рост, исчисляемый «двузначными числами» в процентах. При этом наибольшая динамика отмечена в Северной Америке и Восточной Азии. Западная Европа демонстрирует не столь высокие темпы, что отчасти связано с вопросами получения разрешений на энергоснабжение дата-центров. В Азии значительную часть поступлений для Schneider обеспечивает Индия. В I четверти 2025 года суммарная выручка Schneider от поставок средств автоматизации составила €1,76 млрд, снизившись на 0,9 % в годовом исчислении. Северная Америка принесла €391 млн. Продажи такого оборудования в Западной Европе и Азиатско-Тихоокеанском регионе составили соответственно €471 млн и €591 млн. На все прочие рынки пришлось суммарно €302 млн.

29.04.2025 [22:41], Владимир Мироненко

Inventec вложит до $85 млн в производство серверов в ТехасеТайваньский производитель электроники Inventec объявил об утверждении советом директоров инвестиций на сумму до $85 млн в создание производственного предприятия в Техасе, что ознаменовало собой последний шаг крупного ODM-производителя по расширению операций в США, сообщил ресурс DigiTimes. Аналогичные решения по увеличению инвестирования производства в США приняли другие тайваньские технологические гиганты, включая Foxconn, Wistron и Wiwynn. Inventec заявила, что реализацией инвестиционного проекта займётся её дочерняя компания в США. Финансирование проекта будет осуществляться за счёт собственного оборотного капитала и банковских кредитов. Как сообщает компания, этот шаг направлен на укрепление отношений с клиентами и снижение рисков, связанных с торговой и тарифной политикой США. На первом этапе компания определится с участком, где будут располагаться производственные мощности. Inventec ранее заявила, что Техас является наиболее подходящим местом для строительства завода по сборке серверов в США, объяснив свой выбор близостью к собственному заводу в Мексике, а также стабильным и достаточным электроснабжением и общей пригодностью для сборки ИИ-серверов, требующей высокой мощности для тестирования. Как сообщают источники, Inventec с начала этого года изучает потенциальные площадки для размещения в Техасе. На данный момент из крупных тайваньских ODM-производителей серверов лишь Compal пока не объявил о планах по запуску производства серверного оборудования в США. У Quanta есть заводы в Калифорнии и Теннесси, у Foxconn — в Висконсине и Техасе, у Wistron и WiWynn — в Калифорнии и Техасе, у MiTAC и Pegatron — в Калифорнии. Ранее Inventec продала AMD свою долю в американском производителе серверов ZT Systems. Источники в отрасли полагают, что Compal рассматривает возможность участия в торгах по покупке производственных активов ZT Systems в США, что может обеспечить ей доступ к производственным мощностям и квалифицированным кадрам ZT, а также потенциально позволит углубить связи с AMD. Compal в настоящее время управляет заводом по производству автомобильного оборудования в Индиане.

28.04.2025 [14:48], Сергей Карасёв

ИИ-суперкомпьютер в чемодане — GigaIO Gryf обеспечит производительность до 30 ТфлопсКомпания GigaIO объявила о доступности системы Gryf — так называемого ИИ-суперкомпьютера в чемодане, разработанного в сотрудничестве с SourceCode. Это сравнительно компактное устройство, как утверждается, обеспечивает производительность ЦОД-класса для периферийных развёртываний. Первая информация о Gryf появилась около года назад. Устройство выполнено в корпусе с габаритами 228,6 × 355,6 × 622,3 мм, а масса составляет примерно 25 кг. Система может эксплуатироваться при температурах от +10 до +32 °C. Конструкция предусматривает использование модулей Sled четырёх типов: это вычислительный узел Compute Sled, блок ускорителя Accelerator Sled, узел хранения Storage Sled и сетевой блок Network Sled. Доступны различные конфигурации, но суммарное количество модулей Sled в составе Gryf не превышает шести. Плюс к этому в любой комплектации устанавливается модуль питания с двумя блоками мощностью 2500 Вт. Узел Compute Sled содержит процессор AMD EPYC 7003 Milan с 16, 32 или 64 ядрами, до 512 Гбайт DDR4, системный SSD формата M.2 (NVMe) вместимостью 512 Гбайт и два порта 100GbE QSFP56. Блок Storage Sled объединяет восемь накопителей NVMe SSD E1.L суммарной вместимостью до 492 Тбайт. Модуль Network Sled предоставляет два порта QSFP28 100GbE и шесть портов SFP28 25GbE. За ИИ-производительность отвечает модуль Accelerator Sled, который может нести на борту ускоритель NVIDIA L40S (48 Гбайт), H100 NVL (94 Гбайт) или H200 NVL (141 Гбайт). В максимальной конфигурации быстродействие в режиме FP64 достигает 30 Тфлопс (3,34 Пфлопс FP8), а пропускная способность памяти — 4,8 Тбайт/с.

Источник изображения: GigaIO Архитектура новинки обеспечивает возможность масштабирования путём объединения в единый комплекс до пяти экземпляров Gryf: в общей сложности можно совместить до 30 модулей Sled в той или иной конфигурации. Заказы на Gryf уже поступили со стороны Министерства обороны США, американских разведывательных структур и пр. |

|