Материалы по тегу:

|

01.07.2025 [12:33], Руслан Авдеев

Google договорилась о покупке термоядерной энергии у детища MIT — Commonwealth Fusion SystemsКомпания Google объявила о заключении сделки, предусматривающей покупку электричества у проекта ARC компании Commonwealth Fusion Systems (CFS). Последняя отделилась от Массачусетского технологического института (MIT) в 2018 году и занимается технологиями термоядерного синтеза, сообщает Reuters. В Google объявили, что речь идёт о первой в своём роде прямой корпоративной закупке электроэнергии (PPA) подобного типа. Google получит от ARC 200 из 400 возможных МВт. Проект реализуется в Вирджинии — там находится крупнейший хаб энергоёмких дата-центров. Поскольку ИИ и ЦОД стали драйвером роста спроса на электроэнергию по всему миру, стремительно растёт и интерес к термоядерному синтезу. Отсутствие радиоактивных отходов делает его более экологичным. Для стимулирования реакций термоядерного синтеза учёные всего мира десятилетиями пытались использовать различные технологии, от лазеров до, в случае с CFS, больших магнитов. По данным Reuters, в 2022 году в Ливерморской национальной Лаборатории им. Лоуренса (LLNL) в Калифорнии впервые на короткое время удалось добиться чистого энергетического выигрыша (net energy gain) в эксперименте с использованием лазеров.

Источник изображения: Luke Jones/unsplash.com Впрочем, о коммерческом использовании термоядерных технологий пока не может быть и речи. В Google сообщили, что есть ряд серьёзных физических и инженерных проблем, которые ещё предстоит решить, но компания готова инвестировать в такие технологии. CFS рассчитывает начать выработку электричества в рамках проекта ARC в начале 2030-х годов, но пока необходимо решить имеющиеся технические проблемы. В понедельник Google также заявила о наращивании инвестиций в CFS, хотя их объём не раскрывается. Ранее Google входила в число инвесторов, вложивших в компанию $1,8 млрд в 2021 году. Предполагается, что текущие усилия CFS по сбору средств сопоставимы с раундом финансирования 2021 года. В мае 2025 года CFS привлекла более $1 млрд благодаря неизвестному гиперскейлеру. Известно, что помимо Google довольно тесные отношения с компанией имеет и Microsoft. В июне Google также вложилась в разработчика термоядерных реакторов TAE Technologies.

01.07.2025 [11:45], Сергей Карасёв

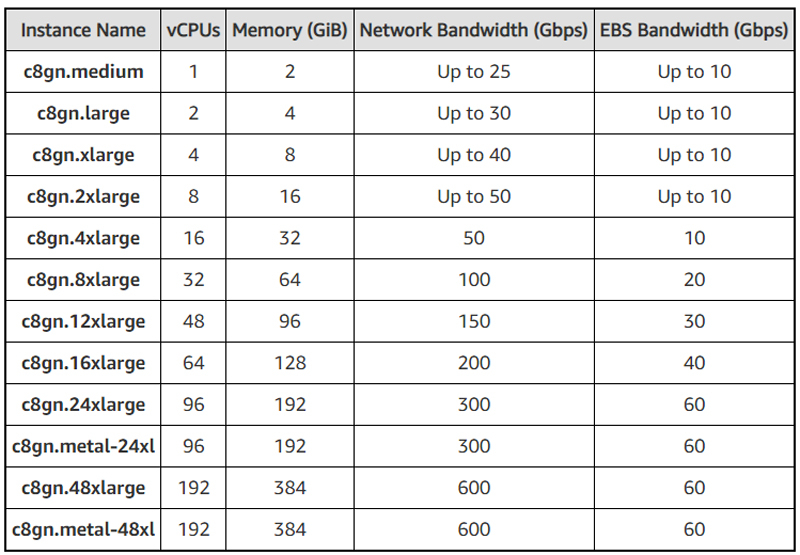

Amazon запустила инстансы EC2 C8gn с чипами Graviton4 для требовательных сетевых нагрузокAWS представила инстансы EC2 C8gn, рассчитанные на ресурсоёмкие сетевые нагрузки. Они обеспечивают пропускную способность до 600 Гбит/с, что является самым высоким показателем среди оптимизированных для подобных задач экземпляров EC2. В основу новых инстансов положены фирменные процессоры Graviton4 и карты AWS Nitro шестого поколения. CPU содержат 96 ядер Neoverse V2 (Demeter) с 2 Мбайт кеша L2 в расчёте на ядро. Экземпляры EC2 C8gn предоставляют от 1 до 192 vCPU, а объём оперативной памяти варьируется от 2 до 384 ГиБ. Пропускная способность сетевого подключения составляет от 25 до 600 Гбит/с, пропускная способность EBS — от 10 до 60 Гбит/с. Инстансы можно запускать через консоль управления AWS, интерфейс командной строки (AWS CLI) или AWS SDK.

Источник изображения: AWS Отмечается, что экземпляры EC2 C8gn подходят для таких задач, как виртуальные брандмауэры, маршрутизаторы, балансировщики нагрузки, прокси-серверы, системы защиты от DDoS-атак, платформы аналитики больших данных и пр. AWS подчёркивает, что инстансы EC2 C8gn обеспечивают на 30 % более высокую вычислительную производительность по сравнению с EC2 C7gn на базе Graviton3. При этом процесс миграции на новые экземпляры не должен вызвать у клиентов сложностей, поскольку EC2 C8gn предлагают схожие соотношения vCPU и памяти. Инстансы EC2 C8gn уже доступны в регионах US East (Северная Вирджиния) и US West (Орегон).

01.07.2025 [11:40], Сергей Карасёв

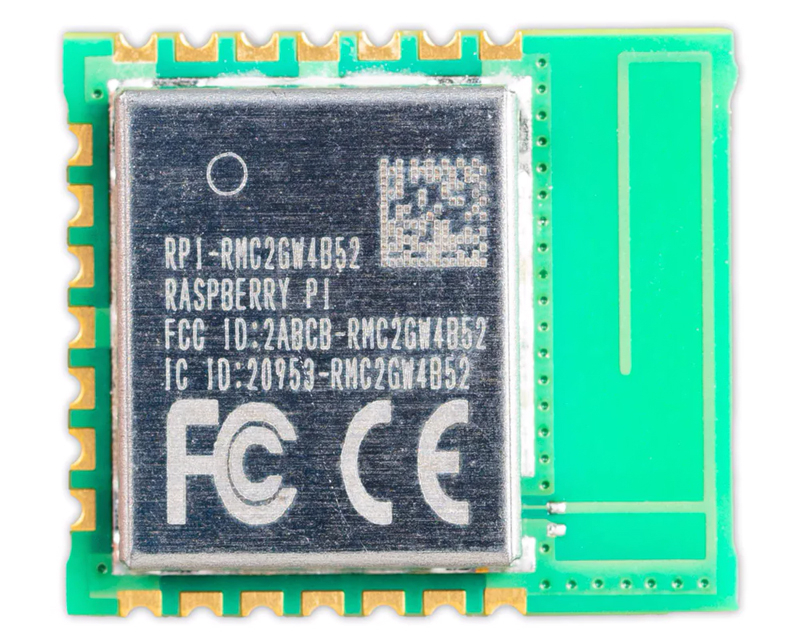

Вышел модуль Raspberry Pi Radio Module 2 с поддержкой Wi-Fi 4 за $4Компания Raspberry Pi сообщила о доступности модуля беспроводной связи Radio Module 2, рассчитанного на использование в связке с недорогими платами Raspberry Pi. Новинка уже доступна для заказа по цене $4. Изделие имеет обозначение RMC20452T. В его основу положен чипсет Infineon CYW43439. Обеспечивается поддержка Wi-Fi 4 (802.11b/g/n) в частотном диапазоне 2,4 ГГц с скоростью канала до 96 Мбит/с и возможностью использования 20-МГц каналов. Кроме того, модуль поддерживает связь Bluetooth 5.2, в том числе с низким энергопотреблением (Bluetooth Low Energy). Радиус действия достигает 100 м в случае Class 1 и 10 м в случае Class 2. Задействована общая антенна 2,4 ГГц для сигналов Wi-Fi и Bluetooth. Предусмотрены встроенный усилитель мощности и экранирование для защиты от электромагнитных помех. Дополнительные возможности ввода/вывода обеспечиваются благодаря наличию 3 × GPIO.

Источник изображения: Raspberry Pi Модуль Raspberry Pi Radio Module 2 полностью совместим с SDK-комплектами Raspberry Pi Pico W и Pico 2 W. Диапазон рабочих температур простирается от -30 до +70 °C. Габариты изделия составляют 16,5 × 14,5 мм. Напряжение питание ядра может варьироваться от 3,0 В до 4,8 В (по умолчанию 3,3 В), напряжение питания подсистемы ввода/вывода — 1,8 В или 3,3 В. Решение Radio Module 2 подходит для приложений с длительным жизненным циклом, поскольку Raspberry Pi гарантирует доступность до января 2036 года. Кроме того, как отмечает ресурс CNX Software, в перспективе может появиться модуль RMC256554T с поддержкой Bluetooth 5.4, а также Wi-Fi 6 в частотных диапазонах 2,4 и 5 ГГц.

01.07.2025 [09:02], Владимир Мироненко

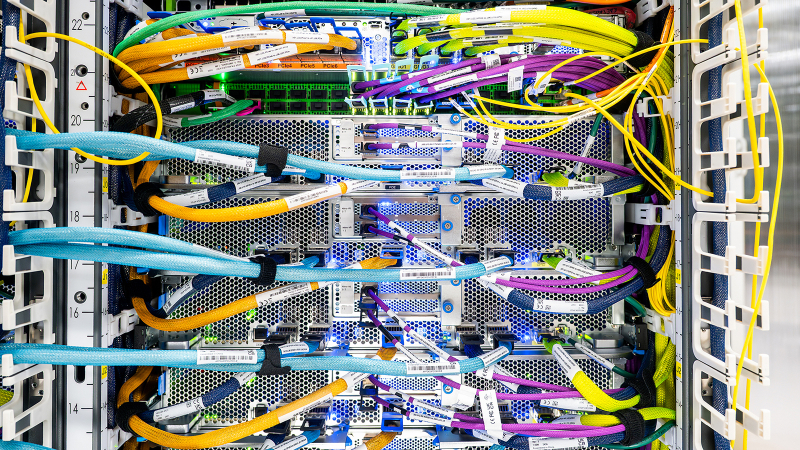

Крупнейший в истории AWS ИИ-суперкомпьютер Project Rainier охватит несколько ЦОД, но будет экологичнымВ настоящее время Amazon Web Services (AWS) занимается строительством ИИ-суперкомпьютера Project Rainier. Проект, охватывающий несколько ЦОД в США, по своим масштабам не похож ни на что, что когда-либо пыталась реализовать AWS. Этот огромный уникальный суперкомпьютер разработан для создания и работы ИИ-моделей следующего поколения. Партнёром AWS в реализации проекта выступает ИИ-стартап Anthropic, который будет использовать новый ИИ-кластер для создания и развёртывания будущих версий LLM Claude. У компаний довольно тесные отношения, а появление Project Rainier снизит зависимость Anthropic и AWS от дефицитных ускорителей NVIDIA, которых не хватает и для собственных нужд Amazon. «Rainier обеспечит в пять раз больше вычислительной мощности по сравнению с крупнейшим в настоящее время кластером Anthropic», — сообщил Гади Хатт (Gadi Hutt), директор по разработке и проектированию продуктов Annapurna Labs, подразделения AWS по разработке чипов. Чем больше вычислений вложить в обучение Claude, тем умнее и точнее будет модель. «Мы создаём вычислительную мощность в масштабах, которых никогда не было раньше, и мы делаем это с беспрецедентной скоростью и гибкостью», — подчеркнул Хатт. Сообщается, что Project Rainier спроектирован как огромный кластер EC2 UltraCluster, состоящий из серверов UltraServers с Trainium2. Trainium2 — ИИ-ускоритель собственной разработки Amazon, предназначенный для обучения ИИ-моделей. UltraServer — новый тип вычислительной системы, которая объединяет четыре физических сервера, каждый из которых содержит 16 ускорителей Trainium2, взаимодействие между которыми осуществляется с помощью интерконнекта NeuronLinks (кабели синего цвета на фото). Связь между компонентами суперкомпьютера реализуется на двух критических уровнях: NeuronLinks обеспечивают высокоскоростные соединения внутри UltraServer, в то время как DPU Elastic Fabric Adapter (EFA) объединяет UltraServer внутри ЦОД и между ЦОД. Этот двухуровневый подход позволяет максимизировать скорость в местах, где в этом больше всего есть потребность, сохраняя гибкость масштабирования в рамках нескольких дата-центров. Эксплуатация и обслуживание такого огромного вычислительного кластера отличается повышенной сложностью. И в данном случае надёжность системы имеет первостепенное значение. Именно здесь подход компании к разработке оборудования и ПО действительно выходит на первый план, говорит компания. Благодаря тому, что AWS сама занимается разработкой оборудования, она может контролировать каждый аспект технологического стека, от мельчайших компонентов чипа до ПО и архитектуры самого ЦОД. Это также позволяет ускорить внедрение технологий и снизить затраты при внедрении ИИ. «Когда у вас есть полная картина, от чипа до ПО и самих серверов, вы можете проводить оптимизацию там, где это имеет наибольший смысл», — говорит директор по инжинирингу Annapurna Labs Рами Синно (Rami Sinno). «Иногда лучшим решением может быть перепроектирование того, как подаётся питание серверов, или переписывание ПО, которое всё координирует. Это может происходить и одновременно. Поскольку у нас есть обзор всего на каждом уровне, мы можем быстро устранять неполадки и внедрять инновации гораздо быстрее», — добавил он. Вместе с тем, по словам Amazon, внедрение мощной ИИ-инфраструктуры будет достаточно экологичным. Вся электроэнергия, потребляемая Amazon, включая её ЦОД, в 2023 году была полностью компенсирована закупками из возобновляемых источников энергии. В течение последних пяти лет Amazon была крупнейшим корпоративным покупателем возобновляемой энергии в мире. Компания инвестирует миллиарды долларов в ядерную энергию и использование аккумуляторов, а также в финансирование масштабных проектов возобновляемой энергии по всему миру. Amazon по-прежнему намерена добиться нулевого уровня выбросов углерода к 2040 году. И Project Rainier ей в этом поможет. В прошлом году AWS объявила, что будет развёртывать новые компоненты, которые объединяют достижения в области питания и охлаждения, не только в строящихся, но и в существующих ЦОД. Их использование, как ожидается, позволит снизить потребление энергии механизмами до 46 % и сократить выбросы парниковых газов при производстве бетона на 35 %. Новые объекты для Project Rainier будут включать в себя различные усовершенствования для повышения энергоэффективности и экологичности с акцентом на сокращение потребления водных ресурсов и использованию забортного воздуха для охлаждения. Например, в ЦОД в округе Сент-Джозеф (St. Joseph), штат Индиана, с октября по март ЦОД вообще не будут использовать воду для охлаждения, а с апреля по сентябрь питьевая вода будет нужна только в течение нескольких часов в день. Amazon не уточняет, о каком именно кампусе идёт речь, но уже известно, что компания строит в Индиане дата-центр, который будет потреблять энергии как половина населения штата. Благодаря инженерным инновациям AWS является лидером отрасли по эффективности использования воды, заявляет компания. На основании результатов недавнего исследования Национальной лаборатории Лоуренса в Беркли, посвящённого эффективности использования воды в ЦОД, отраслевой стандартный показатель составляет 0,375 л/кВт·ч, тогда как у AWS он равен всего 0,15 л/кВт·ч. Компания улучшила этот параметр на 40 % по сравнению с 2021 годом.

30.06.2025 [22:25], Руслан Авдеев

В деревню, в глушь, на север: московский регион страдает от дефицита мощностей ЦОД, но скоро операторы могут уйти в провинциюХотя компании вводят всё новые мощности дата-центров в Московском регионе несмотря на дорогие кредиты, скоро ситуация может измениться. До сих пор большинство ЦОД размещались в Москве из-за удобной локации и наличия квалифицированных кадров, но скоро доля дата-центров за пределами столицы может вырасти в пользу провинции, сообщает «Коммерсантъ». Агентство iKS-Consulting и оператор ЦОД 3data провели исследование, согласно которому свободного предложения мощностей в Москве и Подмосковье для крупных клиентов практически не осталось. Сданные в прошлом и позапрошлом году площадки заполнены, остались ресурсы лишь для розничных клиентов, т.е. свободные мощности в Москве заканчиваются. Значимыми мощностями обладает лишь сданный в начале 2025 года ЦОД DC N1 и новые мощности IXcellerate. При этом стоимость колокейшн-сервисов за последний год выросла на 30 %, а дефицит только усиливается из-за роста числа компаний, работающих с облаками и большими данными. Свою роль сыграли и ИИ-приложения, требующие всё больше мощностей. Для подобных задач, по мнению экспертов, нужно немало высоконагруженных стоек, для чего необходимо менять структуру самих ЦОД, от систем охлаждения до энергоснабжения. По самым скромным оценкам, рынок дата-центров будет расти в России минимум на 10 % ежегодно.

Источник изображения: Roman Purtov/unsplash.com Пока основные ЦОД России расположены в Московском регионе и Санкт-Петербурге, что обусловлено высокой концентрацией там конечных пользователей. При этом свободных мест нет, а расширению готовых площадок мешает нехватка электричества, спрос на которое в столицах растёт не в последнюю очередь из-за ИИ. За пределами столиц такого дефицита нет, а условия для переезда компаний в другие регионы весьма благоприятны. По мнению экспертов, рано или поздно переезд в регионы неизбежен. При этом в близких от Москвы регионах мощности зачастую простаивают, поскольку важна не только близость к столице, но и транспортная доступность, наличие качественной связи и др. У колокейшн-провайдеров и бизнесов, строящих собственные дата-центры, параметры выбора значительно отличаются, поскольку первым важна доступность объектов для клиентов. В будущем перспективным видится размещение ЦОД в более северных районах, где возможен фрикулинг. Кроме того, для многих компаний актуально развитие ЦОД вблизи производственных площадок далеко от столиц. Регионы уже пытаются привлечь дата-центры, предлагая налоговые льготы и субсидии, повышая качество телеком-инфраструктуры. Строительство новых дата-центров может ускориться после снижения ключевой ставки ЦБ, хотя и сейчас проекты будут рентабельны при оптимизации затрат и эффективном планировании. Из-за высокой ключевой ставки был заморожен или отложен ряд новых проектов, но это касается в первую очередьь компаний, развивающихся за счёт кредитных средств. Крупные компании (ретейл, банки, промышленность и др.) продолжают строить свою инфраструктуру. Если на крупные ЦОД нужны десятки миллиардов рублей, то серверная комната может быть построена и за 100 млн руб. По оценкам, окупаемость ЦОД составляет 10–15 лет. Ещё одна проблема — импортозамещение оборудования и сопровождение имеющегося. Как считают эксперты, решающую роль в развитии рынка ЦОД в России играют меры по льготному кредитованию, возможность освобождения от НДС, субсидирование энерготарифов. Кроме того, в перспективе выбор госзаказчиков может упростить система оценки надёжности дата-центров, вводимая Минцифры.

30.06.2025 [21:20], Владимир Мироненко

Avanpost: в корпоративном сегменте по-прежнему большей частью полагаются на обычные пароли и LDAP

active directory

avanpost

openid

radius

software

аутентификация

информационная безопасность

исследование

пароли

разработка

россия

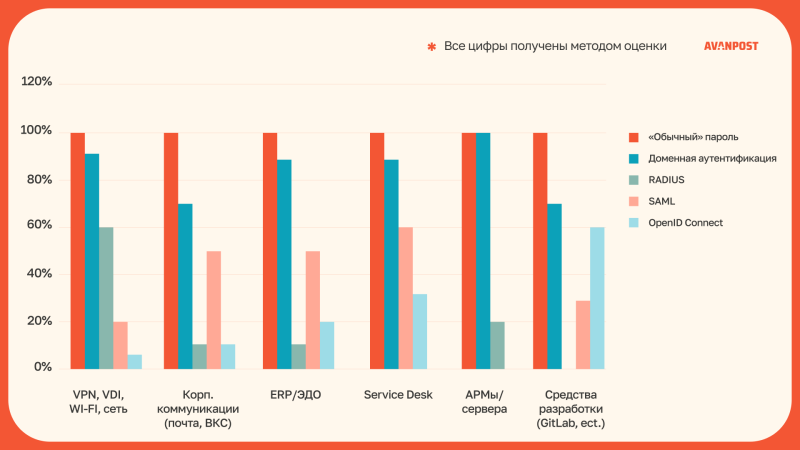

Согласно исследованию «Лаборатории Касперского», более трети россиян готовы вместо пароля использовать альтернативные способы авторизации. В корпоративном сегменте такой готовности пока не наблюдается, о чём свидетельствуют результаты исследования Avanpost. В рамках исследования специалисты Avanpost рассмотрели самые востребованные классы решений корпоративной инфраструктуры: VPN, VDI, Wi-Fi и сеть; корпоративные коммуникации (почта, ВКС); ERP/ЭДО; Service Desk; АРМы и серверы, а также средства разработки (например, GitLab). По каждому из них оценивалась доля использования пяти методов аутентификации: «обычные» пароли, доменная аутентификация, RADIUS, SAML и OpenID Connect. В исследовании отмечено, что в современных корпоративных системах по-прежнему широко используется аутентификация на основе паролей и LDAP. Основная причина заключается в том, что заказчиками зачастую не предъявляются требования по поддержке коробочными корпоративными решениями современных механизмов аутентификации, говорит компания. Это связано с отсутствием в корпоративных инфраструктурах централизованных современных сервисов Identity Provider (IDP), а также с длительным жизненным циклом (5–10 лет) ранее внедрённых систем. К тому же множество широко распространённых продуктов и платформ проектировались и развивались с учётом архитектуры, заложенной десятки лет назад.

Источник изображения: Bruno Brito / Unsplash В корпоративных системах по-прежнему остаются самым распространённым методом аутентификации традиционные «обычные» пароли, несмотря на агитацию Google, Apple и Microsoft за отказ от них. Во всех проанализированных в исследовании категориях их использование близко к 100 %, несмотря на наличие современных решений. На втором место по распространённости в корпоративном сегменте находится доменная LDAP-аутентификация, хотя это общепризнанный антипаттерн, говорит компания. Особенно широко она используется в инфраструктурном сегменте (АРМы и серверы), а также в корпоративных решениях для VPN, VDI и Wi-Fi-средах с долей до 90–100 %. Это объясняется высокой совместимостью с внутренними сетями и политиками безопасности Microsoft Active Directory и другими решениями экосистемы Microsoft. Протокол SAML (Security Assertion Markup Language) используется в 50–60 % системах ERP и службах поддержки, особенно — в SaaS/PaaS, интегрируемых с корпоративными провайдерами удостоверений, размещёнными во внутренней инфраструктуре, преимущественно за счёт возможности взаимодействия через пользователей. «Особенно удивляет сохраняющаяся тенденция реализовывать поддержку SAML в новых продуктах вместо поддержки более современного протокола OpenID Connect», — сообщили исследователи. OpenID Connect больше всего используют в средствах разработки — до 60 % случаев, тогда как в остальных категориях его доля составляет менее 30 %. При этом использование OpenID Connect в других классах корпоративных решений остаётся на достаточно низком уровне. По итогам исследования в Avanpost пришли к выводу, что корпоративные IT-инфраструктуры по-прежнему находятся в стадии трансформации в вопросах аутентификации. На фоне широкого распространения встроенной парольной и LDAP-аутентификации всё же заметен рост интереса к современным IdP-протоколам OpenID Connect и SAML. Вместе с тем уровень готовности большинства коробочных продуктов к использованию современных протоколов аутентификации оставляет желать. RADIUS по-прежнему широко используются при интеграции с внутренними системами из-за высокой совместимости с ранее закупленным сетевым оборудованием. Хотя большинство корпоративного ПО продолжает полагаться на традиционные схемы аутентификации с паролями и LDAP, и лишь незначительная часть приложений (примерно 5–10 %) из коробки поддерживает OpenID Connect, грамотная стратегия миграции позволит организациям постепенно повысить уровень безопасности и удобства для пользователей без чрезмерных рисков и затрат, отметили исследователи. «Фокус на централизованной платформе IAM и в целом на Identity-центричном подходе к аутентификации и развитие культуры безопасности поможет сделать переход последовательным и контролируемым, не остановив, при этом, текущие бизнес-процессы», — сообщили в Avanpost.

30.06.2025 [16:19], Руслан Авдеев

Б/у автоаккумуляторы запитали ИИ ЦОД с 2 тыс. ускорителейВ США заработал дата-центр на 2 тыс. ускорителей, оснащённый энергохранилищем с аккумуляторами, ранее применявшимися в электромобилях. Речь идёт о совместном проекте Redwood Materials и Crusoe — участнице проекта Stargate, курируемого компанией OpenAI, сообщает Bloomberg. Проект Crusoe и Redwood был реализован за четыре месяца. Спрос на «чистую» энергию растёт, подстёгиваемый ростом числа ИИ ЦОД. Благодаря аккумуляторным энергохранилищам можно запасать энергию, поступающую от магистральных электросетей и возобновляемых источников впрок с последующей стабильной подачей для питания серверов. Дата-центр на 2 тыс. ускорителей находится в кампусе Sparks в Неваде — именно там компания утилизирует аккумуляторы электромобилей в промышленных масштабах. По словам её представителя, новая система на 12 МВт использует сотни старых АКБ общей ёмкостью 62 МВт∙ч, а солнечные панели помогают напитать их энергией. По словам Redwood, это крупнейшая микросеть в Северной Америке, но компания уже нацелена на реализацию в 20–100 раз масштабнее. Redwood основана одним из соучредителей Tesla Джей Би Страубелом (JB Straubel) в 2017 году. Компания занимается выпуском материалов для аккумуляторов и переработкой отработавших АКБ. Это один из крупнейших переработчиков аккумуляторов в Северной Америке. Модули АКБ, характеристики которых уже не позволяют использовать их в электромобилях, всё ещё годятся для создания энергохранилищ, например, в сочетании с проектами ветряной и солнечной энергетики. Именно эта сфера применения станет основной для проектов нового подразделения — Redwood Energy.

Источник изображения: Redwood Materials Компания сравнивает такие проекты с «домом престарелых для батарей». Такие АКБ вдвое дешевле новых Li-Ion систем, но обеспечивают почти ту же производительность. В прошлом году Redwood выручила $200 млн на переработке АКБ и теперь ожидает значительного увеличения денежных поступлений во II половине 2025 года по мере развёртывания новых энергохранилищ. Как сообщил представитель Crusoe (Crusoe Energy), одним из важных факторов при реализации энергетических проектов является скорость, поскольку многие компании, подавшие заявки на подключение к сетям, оказываются в очередях на 5–10 лет. ИИ-суперкомпьютер Colossus компании xAI, которая вместе с Tesla принадлежит Илону Маску (Elon Musk), оснащён аккумуляторами Tesla MegaPack. Подобные BESS компания теперь предлагает и другим ЦОД.

30.06.2025 [13:13], Сергей Карасёв

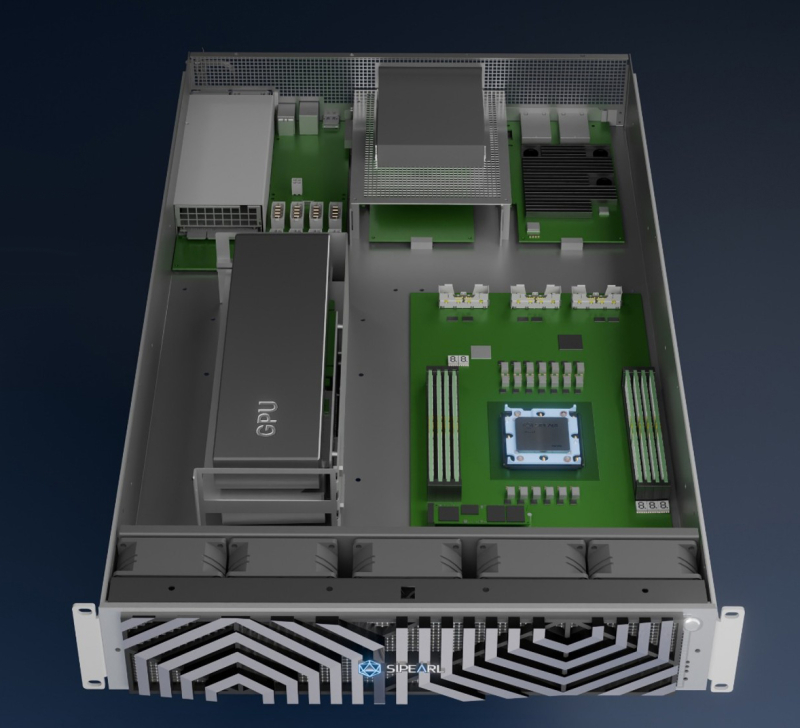

SiPearl Seine — сервер эталонного дизайна для европейских Arm-процессоров Rhea1Компания SiPearl анонсировала систему Seine Reference Server эталонного дизайна, предназначенную для установки процессоров Rhea1. Такие серверы подходят для решения различных задач в области молекулярного моделирования, обороны, энергетики, ИИ, вычислительной гидродинамики, материаловедения, астрофизики, химии и пр. Чипы Rhea1, разработанные специалистами SiPearl, насчитывают 80 ядер Arm Neoverse V1 (Zeus). Есть четыре стека памяти HBM, а также четыре канала памяти DDR5. Поддерживаются 104 линии PCIe 5.0 в виде шести блоков x16 и двух блоков x4. Процессоры Rhea1 войдут в состав первого европейского суперкомпьютера экзафлопсного класса JUPITER. Референсный сервер Seine имеет модульную конструкцию. Он доступен в одно- и двухсокетной модификациях. В обоих случаях возможна установка двух накопителей с интерфейсом SATA и двух сетевых адаптеров с интерфейсом PCIe. В случае однопроцессорной системы допускается применение двух GPU-ускорителей. Компания SiPearl выделяет несколько основных вариантов использования серверов эталонного дизайна. Это, в частности, задачи тестирования при разработке и портировании ПО, а также при интеграции различных компонентов. Использование платформы Seine также поможет снизить затраты на создание готовых аппаратных решений под чипы Rhea1. Кроме того, такие серверы могут использоваться для демонстрации возможностей партнёрам и конечным заказчикам. Отмечается, что на сегодняшний день платформа Seine Reference Server используется в четырёх проектах, направленных на обеспечение технологического суверенитета, независимости и конкурентоспособности Европы: это инициативы Aero, OpenCUBE и Riser, связанные с формированием облачной инфраструктуры, а также Plasma-PEPSC для моделирования плазмы.

30.06.2025 [12:20], Сергей Карасёв

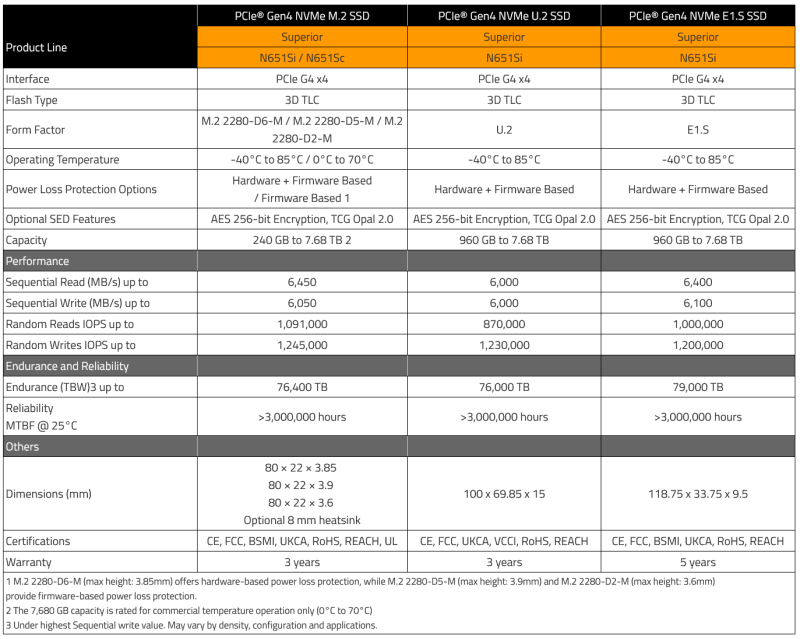

ATP представила индустриальные SSD серий N651Si/N651Sc с повышенной долговечностьюКомпания ATP Electronics анонсировала SSD серий N651Si/N651Sc с увеличенной надёжностью. Устройства, выполненные на основе чипов флеш-памяти 3D TLC NAND, предназначены для использования в индустриальной сфере. Новинки, как утверждается, выдерживают до 11 тыс. циклов записи/стирания. Это на 120 % превышает соответствующий показатель для оригинальных накопителей N651Si/N651Sc, которые были доступны ранее: они рассчитаны на 5 тыс. циклов перезаписи. Изделия проходят комплексное тестирование на выносливость и стабильность работы, эффективность исправления ошибок и пр. В SSD реализована фирменная технология AcuCurrent, обеспечивающая целостность сигнала при всех операциях. Эта система минимизирует ошибки и излишние повторные попытки чтения, что повышает срок службы и надёжность. Кроме того, обеспечивается стабильная производительность в широком диапазоне рабочих температур, который простирается от -40 до +85 °C.

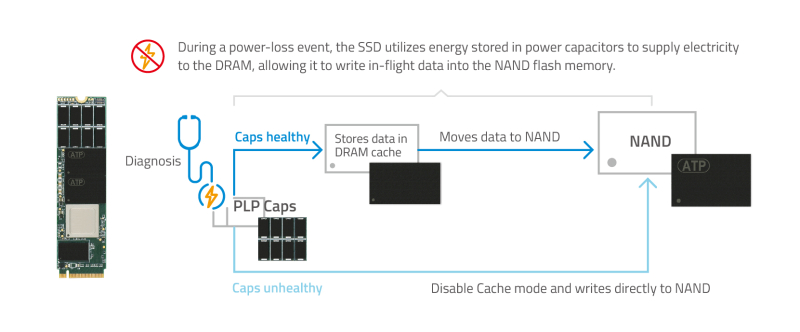

Источник изображений: ATP Вместе с тем средства PLP Diag предотвращают отказ механизма защиты от потери питания (PLP) путём упреждающей проверки функциональности и состояния полимерных танталовых конденсаторов: если они выходят из строя, накопитель переключается в режим Direct TLC, минуя DRAM-кеширование на операциях записи. Новинки доступны в различных вариантах исполнения. В частности, изделия N651Si/N651Sc в формате M.2 2280 имеют вместимость от 240 Гбайт до 7,68 Тбайт. Скорость последовательного чтения информации достигает 6450 Мбайт/с, скорость последовательной записи — 6050 Мбайт/с. Величина IOPS при произвольном чтении — до 1 091 000, при произвольной записи — до 1 245 000. Гарантированный объём записанной информации (показатель TBW) достигает 76 400 Тбайт. Кроме того, SSD серии N651Si предлагаются в форматах U.2 и E1.S. В обоих случаях ёмкость составляет от 960 Гбайт до 7,68 Тбайт. Величина TBW — до 76 000 и 79 000 соответственно. Накопители U.2 обеспечивают скорости последовательного чтения и записи до 6000 Мбайт/с, тогда как значение IOPS при произвольных чтении и записи — до 870 000 и 1 230 000. У устройств E1.S скорости чтения и записи достигают 6400 Мбайт/с и 6100 Мбайт/с, показатель IOPS при произвольных чтении и записи — до 1 000 000 и 1 200 000. У всех новинок значение MTBF (средняя наработка на отказ) превышает 3 млн ч. Реализована поддержка шифрования AES-256 и TCG Opal 2.0. Модели формата M.2 2280 могут комплектоваться опциональным радиатором охлаждения толщиной 8 мм. Производитель предоставляет на SSD трёхлетнюю гарантию (пять лет в случае изделий E1.S). Все устройства оснащены интерфейсом PCIe 4.0 x4.

30.06.2025 [11:11], Сергей Карасёв

Албания присоединилась к европейской суперкомпьютерной программе EuroHPC JUЕвропейское совместное предприятие по развитию высокопроизводительных вычислений (EuroHPC JU) сообщило о том, что Албания стала 36-м государством — участником проекта. Соответствующее решение принято по итогам 49-го заседания совета управляющих EuroHPC. Отмечается, что Албания принимает активное участие в программе Европейского союза по исследованиям и инновациям с 2008 года. Доступ к вычислительным ресурсам EuroHPC предоставляется научно-исследовательским институтам, государственным органам и промышленным предприятиям Албании. Теперь эта страна становится полноправным участником EuroHPC. Албанские специалисты смогут подавать заявки на исследовательские и инновационные инициативы EuroHPC JU, финансируемые в рамках программы Horizon Europe. Кроме того, Албания сможет внести свой вклад в развёртывание так называемых европейских фабрик ИИ — EuroHPC AI Factories. В 2025 году такие площадки появятся в Финляндии, Германии, Греции, Италии, Люксембурге, Испании и Швеции. В целом, EuroHPC JU курирует создание 13 фабрик ИИ по всей Европе, которые будут предоставлять ресурсы малым и средним компаниям, а также стартапам. Албания присоединилась к другим странам — членам EuroHPC JU, которые участвуют в программе Horizon Europe и при этом не входят в Европейский союз. Среди них — Исландия, Черногория, Северная Македония, Норвегия, Сербия, Турция и Великобритания. В целом, EuroHPC активно развивает инфраструктуру высокопроизводительных вычислений в Европе. В рамках инициативы на сегодняшний день развёрнуты десять НРС-систем. Три из суперкомпьютеров EuroHPC входят в десятку самых мощных НРС-комплексов мира: это Jupiter в Германии, который занимает 4-е место в июньском списке ТОР500, а также LUMI в Финляндии (9-я строка) и Leonardo в Италии (10-е место). Подписано соглашение с французским национальным агентством высокопроизводительных вычислений (GENCI) о размещении второго в Европе (после Jupiter) суперкомпьютера экзафлопсного класса — системы Alice Recoque. Кроме того, EuroHPC JU формирует европейскую инфраструктуру квантовых вычислений. В частности, в конце 2024 года была начата подготовка к созданию передовых сетей, которые соединят суперкомпьютеры, квантовые компьютеры и дата-центры Евросоюза. Вместе с тем Юлихский суперкомпьютерный центр в Германии (JSC) получил 100-кубитный квантовый компьютер на нейтральных атомах. EuroHPC также развернёт в Европе специализированные индустриальные суперкомпьютеры. |

|