Материалы по тегу:

|

12.03.2026 [15:52], Владимир Мироненко

Акции Oracle подскочили почти на 10 % благодаря высоким результатам и сильному прогнозуАкции Oracle выросли почти на 10 % на дополнительных торгах после того, как компания опубликовала высокие результаты за III квартал 2026 финансового года, закончившийся 28 февраля, и представила прогноз, свидетельствующий о том, что спрос на вычисления с использованием ИИ практически не снижается, сообщил Bloomberg. Компания отметила, что отчётный квартал стал первым за более чем 15 лет, когда органическая общая выручка и скорректированная прибыль на акцию (non-GAAP) выросли на 20 %. Выручка Oracle выросла год к году на 22 % до $17,2 млрд, превысив консенсус-прогноз аналитиков, опрошенных LSEG, в размере $16,91 млрд. Скорректированная прибыль на акцию (non-GAAP) составила $1,79 при прогнозе Уолл-стрит в $1,70. Чистая прибыль (GAAP) выросла до $3,72 млрд, или $1,27 на акцию, по сравнению с $2,94 млрд, или $1,02 на акцию годом ранее. Выручка от облачных сервисов выросла на 44 % — до $8,9 млрд, включая инфраструктуру и ПО как услугу (SaaS), превысив консенсус-прогноз аналитиков, опрошенных StreetAccount, в размере $8,85 млрд. Компания отметила облачный бизнес с Air France-KLM, Lockheed Martin, SoftBank и Activision Blizzard — дочерней компанией Microsoft, занимающейся видеоиграми. Выручка от облачной инфраструктуры (OCI IaaS) увеличилась на 84 % — до $4,9 млрд, тогда как в предыдущем квартале она выросла на 68 %. Аналитики прогнозировали рост на 79 %. Выручка от облачных приложений (SaaS) составила $4,0 млрд (+13 %), что соответствует прогнозам. Выручка от NetSuite Cloud ERP (SaaS) увеличилась до $1,1 млрд (+15 %). Выручка от разработки ПО выросла на 3 % — до $6,1 млрд. В ходе телефонной конференции со-генеральный директор Майк Сицилия (Mike Sicilia) затронул опасения Уолл-стрит по поводу того, что ИИ наносит ущерб традиционным компаниям-разработчикам ПО. «Некоторые более мелкие или узкоспециализированные SaaS-компании вполне могут столкнуться с дестабилизацией, но Oracle в их число не войдёт», — сказал Сицилия, имея в виду ПО как услугу. Объём оставшихся обязательств по выполнению контрактов (RPO) на конец квартала составил $553 млрд, что на 325 % больше, чем годом ранее, и на $29 млрд больше, чем в предыдущем квартале. Большая часть роста RPO в III квартале связана с крупномасштабными контрактами в области ИИ, где, по словам компании, нет необходимости в привлечении дополнительных средств, поскольку большая часть необходимого оборудования либо финансируется авансом за счёт предоплаты клиентами, чтобы Oracle могла приобрести GPU, либо клиент покупает GPU и поставляет их Oracle. Капитальные затраты составили за квартал около $18,6 млрд, что выше прогнозируемых аналитиками $14 млрд. Компания сохранила свой прогноз по капитальным затратам в размере $50 млрд в текущем финансовом году. «Это может решить проблемы перерасхода средств, которые преследуют Oracle и других поставщиков облачной инфраструктуры», — сообщил Анураг Рана (Anurag Rana), аналитик Bloomberg Intelligence. В IV финансовом квартале Oracle ожидает скорректированную прибыль на акцию в пределах $1,92–$1,96, при этом рост выручки составит от 19 до 20 %. Консенсус-прогноз аналитиков от LSEG составляет $1,70 на акцию и рост выручки на 20 %. Также компания прогнозирует рост выручки от облачных сервисов в пределах 44–48 %. В 2026 финансовом году Oracle прогнозирует выручку в $67 млрд. При этом компания повысила прогноз на 2027 год по выручке до $90 млрд. В свою очередь, аналитики прогнозируют выручку в $86,7 млрд. Oracle также выступила с опровержением сообщения Bloomberg о том, что Oracle и OpenAI отменили запланированное расширение своего проекта дата-центра Stargate в Техасе, что дало Meta✴ возможность начать переговоры с девелопером Crusoe об аренде помещений. «Недавние сообщения в СМИ о площадке в Абилине являются ложными и неверными», — заявила компания. «Во-первых, Crusoe и Oracle работают в тесном сотрудничестве, чтобы в рекордные сроки построить один из крупнейших в мире дата-центров для ИИ в Абилине. Два здания полностью введены в эксплуатацию, а остальная часть кампуса строится по плану. Во-вторых, Oracle завершила сдачу в аренду дополнительных 4,5 ГВт мощностей для выполнения своих обязательств перед OpenAI», — подчеркнула компания.

12.03.2026 [15:42], Андрей Крупин

RuVDS запустил дата-центр в АнтарктидеХостинг-провайдер RuVDS совместно с Университетом морской практики и арктического туризма и компанией «Стратонавтика» приступил к испытаниям возможностей экспериментального дата-центра, развёрнутого на российской антарктической станции Беллинсгаузен, расположенной на полуострове Файлдс юго-западной части субантарктического острова Кинг-Джордж (Ватерлоо). Оборудование для ЦОД было доставлено на станцию в два этапа: сначала – самолётом из России в аргентинский город Ушайя, а затем — морским путём, через пролив Дрейка. Перечень устройств, доставленных на антарктическую станцию, включал в себя защищённое серверное оборудование, подобранное в том числе и с учётом сложностей морского перехода, а также приёмник сигнала с космического аппарата. Транспортировка была обеспечена при поддержке аэрокосмической лаборатории «Стратонавтика».

География вычислительных площадок RuVDS (источник изображения: ruvds.com) Центр обработки данных реализован в рамках концепции минимального энергопотребления и влияния на окружающую среду Антарктиды. Вычислительный комплекс предназначен как для решения научных задач, так и для доступа обычных пользователей. «Мы подходили к проекту подготовленными, уже имея за плечами опыт запуска ЦОД на Северном полюсе. Но с Антарктидой, конечно, всё было сложнее: сказывались и логистические трудности, и в целом большая масштабность проекта. Рассчитываем, что локация в Антарктиде прослужит несколько месяцев, после чего оборудование будет безвозмездно передано в пользование сотрудникам станции», — сообщил генеральный директор RuVDS.

12.03.2026 [15:31], Руслан Авдеев

3i Infrastructure приобрела контрольный пакет норвежского подземного ЦОД Lefdal Mine Datacenter за €300 млнИнвестиционная группа 3i Infrastructure приобрела контрольный пакет акций норвежского оператора ЦОД Lefdal Mine Datacenter (LMD). Компания согласилась инвестировать в его бизнес €300 млн ($347,3 млн) в обмен на акции. Сделку планируют завершить летом 2026 года, сообщает Datacenter Dynamics. LMD принадлежит фонду, управляемому Columbia Threadneedle Investments, которая намерена продолжить инвестиции в компанию совместно с 3i Infrastructure. LMD фактически представляет собой крупнейший по площади дата-центр в Европе, открытие которого было анонсировано в 2015 году, а фактически состоялось в 2017-м. Он занимает 120 тыс. м2 в 75 подземных залах старой оливиновой шахты, но подавляющее большинство помещений остаются пустыми. В ЦОД находится крупнейший в Норвегии суперкомпьютер Olivia. В 2020 году контрольный пакет акций LMD приобрёл европейский фонд Columbia Threadneedle (ESIF) у компании Rittal, а в апреле 2023 года Lefdal увеличила мощность своего ЦОД на 60 МВт, подключившись к региональной электросети на 132 кВ, доступная мощность выросла с 20 до 80 МВт, а в перспективе может увеличиться до 200 МВт. По данным Lefdal, клиенты сегодня эксплуатируют мощности на 37 МВт, ещё 43 МВт законтрактованы и находятся в стадии строительства. Утверждается, что компаниям выгодны надёжное электроснабжение Норвегии и низкие затраты на обслуживание ЦОД. Достижению повышенной эффективности способствует подземное расположение объекта и используемая технология охлаждения морской водой с замкнутым контуром. Пока, по имеющимся данным, для размещения ЦОД используется лишь один из шести уровней шахты.

Источник изображения: LMD В рамках сделки покупается и портфель активов в сфере возобновляемой энергетики. 3i Investments будет контролировать совокупные инвестиции общим объёмом €400 млн. 3i Infrastructure, акции которой торгуются на Лондонской фондовой бирже, специализируется на инвестициях в инфраструктуру. Среди прочих подконтрольных активов — немецкая телеком-компания DNS:NET, занимающаяся прокладкой подводных кабелей FLAG, норвежская Tampnet, а также энергетические и коммунальные бизнесы по всей Европе. Управляющая инвестициями 3i Investments является дочерней структурой 3i Group — британской компании, действующей в сфере прямых инвестиций и венчурного капитала. Последняя основана в 1945 году Банком Англии. Дата-центры довольно часто размещаются в заброшенных шахтах. Осенью 2023 года сообщалось, что итальянцы построят ЦОД Trentino Data Mine в доломитовой шахте Сан-Ромедио. В январе 2024 года появилась информация о том, что заброшенные шахты могут стать хранилищами тепла эдинбургского суперкомпьютера. В том же месяце — о том, что дата-центр Data Center Ridge охладят водой из заброшенных шахт. Около года назад появилась информация, что Public Power Corp (PPC) представила план строительства ЦОД в старых угольных шахтах Греции. Более того, в конце 2024 года в Итальянских Альпах планировалось построить первый в Европе дата-центр в действующей шахте. В свете последних событий на Ближнем Востоке эксперты не исключают, что подход к обеспечению устойчивости облаков предстоит пересмотреть, в том числе уделив внимание физической защите ЦОД.

12.03.2026 [12:28], Руслан Авдеев

Google завершила сделку по покупке Wiz за $32 млрд, обеспечив облачным клиентам новые инструменты защитыGoogle анонсировала закрытие крупнейшей покупки компании в своей истории — Wiz считается ведущей платформой по обеспечению безопасности для облачных и ИИ-сред. Бизнес Wiz присоединится к Google Cloud в миссии по защите клиентов во всех облачных экосистемах. Google подчёркивает, что в эпоху ИИ всё больше компаний и правительств переносят важные данные в облака. Поскольку организации действуют в облачных средах и активно используют ИИ, злоумышленники тоже применяют искусственный интеллект для атак с повышенной скоростью и интенсивностью. По данным Google, Wiz предлагает простую в использовании платформу безопасности с глубоким знанием облачных сред и особенностей программирования — компания способна работать со всеми ключевыми облачными средами и помогает реагировать на инциденты кибербезопасности. Это дополнит облачные возможности Google Cloud, включая её собственные механизмы и инструменты киберзащиты.

Источник изображен ия: Google Cloud Вместе компании предоставят унифицированную платформу безопасности, позволяющую организациям распознавать угрозы, предотвращать их и реагировать на них. Это поможет противостоять даже угрозам нового типа, организованным с помощью ИИ, защищать ИИ-модели и использовать искусственный интеллект для помощи экспертам в сфере информационной безопасности. Платформа также предоставит набор инструментов, процессов и политик для всех ключевых облачных сред на всех уровнях. Объединённые возможности упростят обеспечение мультиоблачной безопасности, расширяя возможности компаний по использованию облаков разных провайдеров. Компании и правительства смогут оптимизировать и автоматизировать защиту, одновременно масштабируя команды, занимающиеся обеспечением кибербезопасности, и снижая стоимость этой защиты. Комбинированная платформа также поможет защитить и малый бизнес, часто не имеющий опыта и ресурсов для самозащиты от всё более сложных и разрушительных киберугроз. Продукты Wiz, по данным Google, будут по-прежнему доступны во всех ключевых облачных средах, включая Amazon Web Services, Google Cloud Platform, Microsoft Azure и Oracle Cloud. При этом Google Cloud продолжит предоставлять клиентам выбор, предлагая партнёрские решения по обеспечению безопасности в Google Cloud Marketplace. Google пыталась приобрести Wiz ещё в 2024 году, предложив $23 млрд, но руководство стартапа отказалось от сделки, намереваясь выйти на биржу вместо превращения в дочернюю структуру Google. Wiz провела 7 раундов финансирования, в ходе которых привлекла $1,9 млрд, включая раунд в $1 млрд при капитализации в $12 млрд в мае 2024 года . Весной 2025 года Google предложила стартапу уже $32 млрд. 10 % этой суммы Google обязана была выплатить стартапу, если покупка в итоге не состоится. Сделка значительно расширит портфель услуг облачной безопасности Google.

12.03.2026 [11:38], Руслан Авдеев

Amazon потребовала заблокировать запуск миллиона спутников-ЦОД SpaceX — и сама попала под критикуКомпания Amazon потребовала от американских регуляторов отклонить поданную SpaceX заявку на одобрение миллионной группировки спутников для ЦОД. Компания назвала идею «спекулятивной» и «нереалистичной», сообщает The Register. Тем временем она сама столкнулась с критикой со стороны Федеральной комиссии по связи США (FCC). Недавно SpaceX предложила создать орбитальную группировку спутников-ЦОД, подав соответствующую заявку в FCC. Amazon Leo, управляющая спутниковой сетью связи, конкурирующей со Starlink компании SpaceX, немедленно выступила с возражениями. В недавнем заявлении Amazon Leo объявила, что в заявке есть лишь самые общие сведения о том, как SpaceX намерена реализовать свои планы. Последняя запрашивает разрешение для вывода на низкую околоземную орбиту миллиона спутников. Для сравнения, сейчас вблизи Земли находится около 15 тыс. аппаратов. SpaceX заявляет, что создание такой группировки станет первым шагом на пути создания т. н. «цивилизации второго типа» по шкале Кардашева, способной использовать все энергетические ресурсы родной звезды. Amazon подчёркивает, что в заявке не указаны ни конструкция спутников, ни радиочастотные характеристики устройств, ни планы контроля сближений космических аппаратов и борьбы с помехами в подобном огромном масштабе. Другими словами, сообщается о «завышенных амбициях», а не о реальном плане. Критики утверждают, что речь идёт о спекуляциях, по форме не соответствующих правилам FCC. Вопросы по поводу возможного внесения помех астрономическим наблюдениям имеются и к группировке Amazon Leo. Кроме того, компанию и саму обвиняют в загрязнении окружающей среды из-за массовых ракетных пусков и сгорания спутников по мере их схода с орбиты. Ещё в 2025 году основатель Amazon Джефф Безос (Jeff Bezos) с удовлетворением прогнозировал, что гигаваттные ЦОД на солнечной энергии за два десятка лет заполнят орбиту Земли, поэтому жалобы на SpaceX вряд ли вызваны заботой об окружающей среде.

Источник изображения: David Clode/unsplash.com Более того, заявку требуют отклонить с довольно странной формулировкой — как «формально неполную». В любом случае, если FCC решит дать жалобе ход, Amazon просит «в полной мере разобраться» с проблемами, связанными с развёртыванием группировки подобного масштаба, и потребовать от SpaceX конкретных технических подробностей. Также Amazon предупреждает, что компания-конкурент фактически добивается разрешения на «орбитальную монополию», фактически превращающую SpaceX в эксклюзивного «привратника» в космосе — вероятно, в этом и заключаются основные опасения. Не так давно эксперты Gartner скептически отнеслись к идее размещения в космосе дата-центров, буквально назвав её «вершиной безумия». По их мнению, эксплуатация таких объектов никогда не будет рентабельной и не сможет удовлетворить спрос на вычислительные мощности на Земле. По имеющимся данным, группировка Amazon Leo (ранее Project Kuiper) насчитывает на орбите более 200 спутников, тогда как у Starlink их более 9,9 тыс. Тем временем FCC уже дала ответ на жалобу. По словам её представителя, Amazon лучше сосредоточиться на собственных планах запуска, поскольку компания на 1 тыс. спутников отстаёт от собственного проекта по выводу на орбиту спутников связи — к июлю 2026 года она должна вывести 1,6 тыс. аппаратов, а в конце января попросила FCC продлить срок их вывода до июля 2028 года по разным причинам, включая нехватку ракет в краткосрочной перспективе. При этом в отдельной заявке Amazon просит разрешение вывести на орбиту в общей сложности 4,5 тыс. интернет-спутников, что позволит увеличить её группировку более чем вдвое. Заявка на вывод миллиона спутников — рекордная из числа дошедших до стадии подачи. Планы развёртывания ЦОД в космосе имеют многие IT-бизнесы, включая Axiom Space, NTT, Ramon.Space, Aetherflux и Sophia Space, а Starcloud (ранее Lumen Orbit) уже вывела в космос микро-ЦОД на основе одного ИИ-ускорителя для тестов. Один из основателей Google Эрик Шмидт (Eric Schmidt) говорил, что купил компанию Relativity Space для вывода в космос собственных ЦОД. Наконец, Google в конце 2025 года анонсировала Project Suncatcher, предусматривающий создание в космосе совместно с компанией Planet дата-центров на основе тензорных ускорителей самой Google.

12.03.2026 [11:23], Владимир Мироненко

Intel представила чип Heracles, который в 5000 раз быстрее серверных процессоров в вычислениях с FHEКомпания Intel представила на Международной конференции IEEE по твердотельным схемам (ISSCC) в Сан-Франциско чип Heracles с полностью гомоморфным шифрованием (FHE), который превосходит топовый серверный процессор Intel по скорости вычислений с FHE в 5 тыс. раз, сообщил ресурс Spectrum. Полностью гомоморфное шифрование позволяет выполнять вычисления над данными в зашифрованном виде без их расшифровки, но на стандартных процессорах и видеокартах оно работает крайне медленно. Heracles построен на основе 3-нм технологии FinFET и примерно в 20 раз больше большинства исследовательских чипов FHE, имеющих размеры около 10 мм² или меньше. Он размещён в корпусе с жидкостным охлаждением вместе с двумя стеками памяти HBM по 24 Гбайт. Такая конфигурация обычно используется в GPU для обучения ИИ. В основе Heracles лежат 64 вычислительных ядра — так называемые пары тайлов, — расположенные в сетке восемь на восемь и служащие в качестве SIMD-движков для полиномиальных вычислений, манипуляций и других операций, составляющих вычисления в FHE, а также для их параллельного выполнения. Встроенная в кристалл сеть 2D-mesh соединяет тайлы друг с другом широкими шинами по 512 байт. Чип оснащён HBM-памятью объёмом 48 Гбайт со скоростью 819 Гбайт/с. На чипе данные размещаются в 64 Мбайт кеша, откуда они могут передаваться по массиву со скоростью 9,6 Тбайт/с, переходя от одной пары тайлов к другой. Чтобы предотвратить взаимное влияние перемещения данных и математических вычислений, Heracles использует три синхронизированных потока инструкций: один для перемещения вне чипа, один для перемещения внутри чипа и один для арифметических операций. Данная конструкция позволяет Heracles, работающему на частоте 1,2 ГГц, выполнять критически важные математические преобразования FHE всего за 39 мс, что в 2355 раз быстрее, чем процессор Intel Xeon, работающий на частоте 3,5 ГГц. По семи ключевым операциям Heracles быстрее него в 1074–5547 раз в зависимости от объёма необходимых операций перераспределения (shuffling). Компания продемонстрировала на ISSCC возможности Heracles на примере простого частного запроса к защищённому серверу. Он имитировал запрос избирателя на проверку правильности регистрации его бюллетеня. В данном случае у штата есть зашифрованная база данных избирателей и их голосов: избиратель шифрует свой идентификационный номер и голос, а сервер проверяет совпадение без расшифровки и возвращает зашифрованный ответ, который пользователь затем расшифровывает на своей стороне. На серверном процессоре Intel Xeon этот процесс занял 15 мс, а Heracles справился с задачей за 14 мс. Казалось бы, эта разница незаметна для отдельного человека, но проверка 100 млн бюллетеней занимает более 17 дней работы процессора Intel Xeon против всего 23 минут на Heracles. Проект Heracles был запущен пять лет назад в рамках программы DARPA по ускорению FHE с помощью специализированного оборудования. Разработкой подобных чипов также занимается ряд стартапов, включая Fabric Cryptography, Cornami и Optalysys. Сану Мэтью (Sanu Mathew), руководитель исследований в области защищённых схем в Intel, считает, что у компании есть большое преимущество, поскольку её чип может выполнять больше вычислений, чем любой другой ускоритель FHE, созданный до сих пор. «Heracles — это первое оборудование, работающее в масштабе», — говорит он. В дальнейшем компания планирует повышать скорость вычислений чипа за счёт тонкой настройки ПО. Она также будет испытывать более масштабные задачи FHE и изучать улучшения аппаратного обеспечения для потенциального следующего поколения. «Это как первый микропроцессор… начало целого пути», — отмечает Мэтью.

12.03.2026 [10:05], Руслан Авдеев

NVIDIA инвестирует в Nebius $2 млрд в рамках стратегического партнёрства в сфере ИИ ЦОДNVIDIA объявила о намерении инвестировать $2 млрд в компанию Nebius Group в рамках стратегического партнёрства, предусматривающего разработку и строительство ИИ ЦОД, сообщает Bloomberg. В последние дни новости об очередных миллиардных инвестициях NVIDIA публикуются почти регулярно. В этот раз NVIDIA потратит средства на Nebius в рамках стратегического партнёрства — фактически компания нередко вкладывает средства в бизнесы, покупающие её ускорители. Базирующаяся в Амстердаме Nebius к концу 2030 года намерена внедрить более 5 ГВт систем на решениях NVIDIA; такой энергии приблизительно хватило бы для электроснабжения 3,8 млн домохозяйств. Речь идёт о сотрудничестве, касающемся полного стека ИИ-технологий — от разработки архитектуры ИИ-фабрик до взаимодействия в сфере программного обеспечения. Это позволит Nebius ускорить строительство передовой облачной платформы. Nebius активно внедряет технологии NVIDIA на глобальном уровне, включая строительство многочисленных ИИ-фабрик гигаваттного уровня в США. Чтобы Nebius смогла обеспечить более 5 ГВт к концу 2030 года, NVIDIA поддержит раннее внедрение компанией своих ИИ-ускорителей новейшего поколения.

Источник изображения: NVIDIA В рамках партнёрства предусмотрено несколько векторов взаимодействия:

NVIDIA нередко использует свои, почти неисчерпаемые финансовые ресурсы для финансирования расширения ИИ-инфраструктуры на своих чипах. Это уже вызвало критику экспертов, допускающих, что такие циркулярные инвестиции способствуют возникновению пузыря на рынке ИИ. В январе 2026 года NVIDIA анонсировала вложение $2 млрд в конкурента Nebius — компанию CoreWeave для внедрения своих продуктов, а совсем недавно NVIDIA поддержала развёртывание 1 ГВт мощностей стартапом Thinking Machines Lab. Неооблачный провайдер Nebius появился после раскола «Яндекса» и продажи его российской части бизнеса в 2024 году за $5,2 млрд российским покупателям. В конце того же года Nebius привлекла $700 млн от группы инвесторов, включавшей NVIDIA. По состоянию на конец 2024 года NVIDIA владела акциями компании на сумму $33 млн. Совсем недавно IT-гигант выделил ещё $4 млрд на связанные с ИИ проекты. NVIDIA инвестировала по $2 млрд в поставщиков лазеров и фотоники для ИИ ЦОД — компании Lumentum и Coherent.

12.03.2026 [09:13], Сергей Карасёв

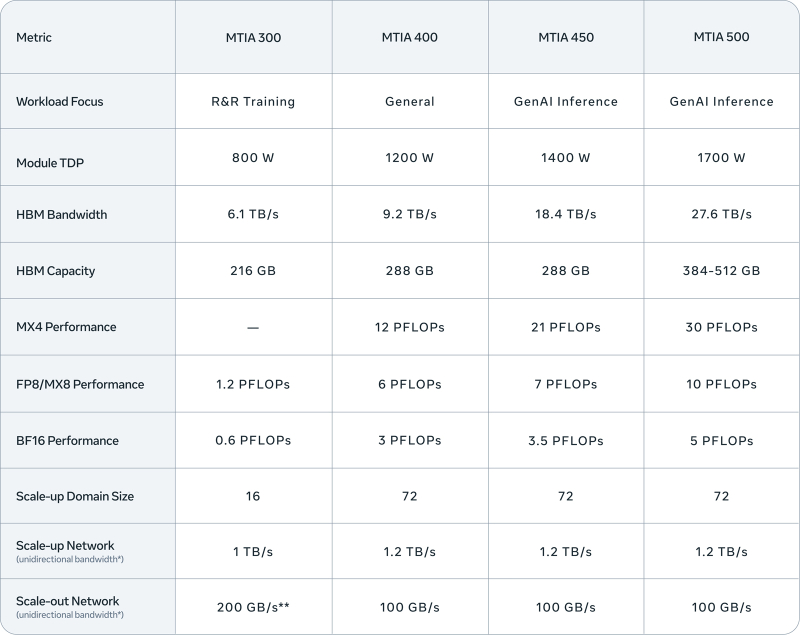

Meta✴ представила четыре новых ИИ-ускорителя MTIA — с FP8-производительностью до 10 ПфлопсКомпания Meta✴ анонсировала ИИ-ускорители MTIA (Meta✴ Training and Inference Accelerator) сразу четырёх новых поколений. Это решения MTIA 300, 400, 450 и 500: внедрение некоторых из них уже началось, тогда как развёртывание других запланировано на текущий и следующий годы. Устройства ориентированы на различные ИИ-нагрузки, включая инференс и генеративные сервисы. ИИ-процессор MTIA первого поколения (MTIA 100), напомним, дебютировал в 2023 году: изделие получило в общей сложности 128 ядер RISC-V и 128 Мбайт памяти SRAM. В 2024-м вышло решение второго поколения MTIA 200 с повышенной производительностью. В каждом из четырёх новых продуктов, по заявлениям Meta✴, упор сделан на улучшении вычислительных характеристик, пропускной способности памяти и эффективности.

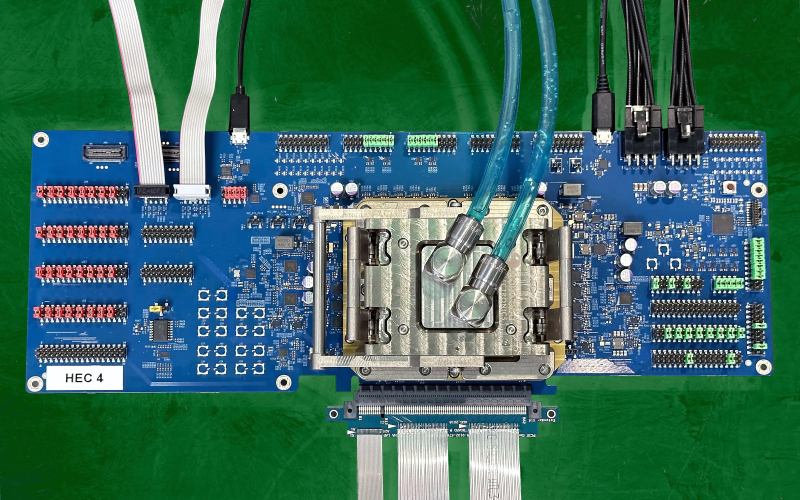

Источник изображений: Meta✴ Конструкция ускорителя MTIA 300 включает один вычислительный чиплет, два сетевых чиплета (NIC) и несколько стеков HBM. Каждый вычислительный чиплет состоит из матрицы процессорных элементов (PE), содержащих по два векторных ядра RISC-V. Объём памяти HBM составляет 216 Гбайт, её пропускная способность — 6,1 Тбайт/с. Заявленная ИИ-производительность в режимах FP8/МХ8 достигает 1,2 Пфлопс. Показатель TDP равен 800 Вт. Реализован движок DMA для взаимодействия с локальной памятью. Ускоритель, уже применяющийся в дата-центрах Meta✴, оптимизирован для задач обучения по принципу Rephrase and Respond (R&R). Ступенью выше располагается решение MTIA 400 общего назначения. Оно объединяет два вычислительных чиплета, а объём памяти HBM увеличен до 288 Гбайт (пропускная способность — 9,2 Тбайт/с). У этого ускорителя быстродействие на операциях FP8/МХ8 составляет до 6 Пфлопс. Величина TDP равна 1200 Вт. Стойка с 72 ускорителями MTIA 400, соединёнными через коммутируемую объединительную плату, образует единый масштабируемый домен. При этом может использоваться жидкостное охлаждение с воздушной поддержкой или полностью жидкостное охлаждение. На сегодняшний день Meta✴ завершила тестирование MTIA 400 и находится на этапе внедрения изделий. Вариант MTIA 450, в свою очередь, ориентирован на задачи инференса в сфере генеративного ИИ. Этот ускоритель также использует 288 Гбайт памяти HBM, но её пропускная способность достигает 18,4 Тбайт/с. Значение TDP подросло до 1400 Вт. Решение обеспечивает ИИ-производительность в режимах FP8/МХ8 до 7 Пфлопс, в режиме МХ4 — 21 Пфлопс. MTIA 450 также поддерживает смешанные вычисления с низкой точностью без дополнительного программного преобразования данных. Внедрение устройства в ЦОД Meta✴ намечено на начало 2027 года. Наконец, самый мощный из готовящихся ускорителей — MTIA 500 — также рассчитан на инференс в сфере генеративного ИИ. Используется конфигурация вычислительных чиплетов 2 × 2, окруженных несколькими стеками HBM и двумя сетевыми чиплетами. Это устройство может использовать от 384 до 512 Гбайт памяти HBM с пропускной способностью до 27,6 Тбайт/с. Показатель TDP достигает 1700 Вт. Заявленная производительность FP8/МХ8 — до 10 Пфлопс, МХ4 — до 30 Пфлопс. Массовое внедрение MTIA 500 запланировано на 2027 год. На системном уровне MTIA 400, 450 и 500 используют одно и то же шасси, стойку и сетевую инфраструктуру. Это обеспечивает возможность модернизации с минимальными затратами при переходе на изделия следующего поколения.

12.03.2026 [09:00], Сергей Карасёв

«Эксперт РА» перешло на ПО для управления динамической ИТ-инфраструктурой от «Базиса»Крупнейшее в России кредитное рейтинговое агентство «Эксперт РА» сообщило о переходе на отечественную платформу виртуализации рабочих мест и терминального доступа Basis Workplace и программно-определяемую СХД Basis SDS — решения лидера российского рынка ПО для управления динамической ИТ-инфраструктурой «Базис». Внедрение проводилось авторизованным партнёром — системным интегратором «КИТ-Системс». Основные сценарии использования флагманской платформы вендора охватывают удалённый доступ сотрудников к внутренней инфраструктуре и создание изолированных сред с повышенными требованиями к информационной безопасности. Basis Workplace позволяет использовать серверные мощности командам, которые работают на портативных устройствах, в том числе ноутбуках и планшетах. Ещё одно значимое преимущество — возможность автоматизировать жизненный цикл виртуальных сред. Система горизонтально масштабируется и устойчива к высоким нагрузкам, возможна реализация геораспределённой инсталляции для упрощения построения катастрофоустойчивых решений. При выборе платформы учитывались такие параметры, как рыночная доля вендора, зрелость решений, наличие успешных внедрений, стоимость и поддержка гиперконвергентных сценариев. В процессе эксплуатации Basis Workplace подтвердила стабильность, функциональность и соответствие требованиям к защите данных. Администрирование продукта осуществляется собственной ИТ-службой «Эксперт РА». Для обеспечения качественной эксплуатации специалисты прошли обучающий курс по работе с платформой, разработанный «Базисом» для системных администраторов. «Решение "Эксперт РА" перейти на отечественные разработки при отсутствии срочных регуляторных требований — сильный и показательный шаг. Это стратегическое решение — не про замену компонентов, а про контроль над критической инфраструктурой в долгосрочной перспективе», — подчеркнул Иван Ермаков, коммерческий директор «Базиса». «Для нас ключевым фактором было понимание того, кто стоит за продуктом. Мы не искали решения с неопределённой судьбой в открытом сообществе, а выбрали вендора с проприетарными разработками, прозрачной дорожной картой и полной ответственностью за развитие своих решений. И Basis Workplace, и Basis SDS соответствуют нашим требованиям к безопасности и устойчивости», — сообщил Денис Казанцев, директор по информационным сервисам и инфраструктуре «Эксперт РА». «Внедрение VDI способствует развитию в Агентстве гибкой ИТ-среды, где высокий уровень управляемости и простота эксплуатации оказывают позитивное влияние на непрерывность операционных процессов, что даёт бизнесу устойчивость при росте и адаптации к новым задачам», — отметил Алексей Милушин, директор по цифровой трансформации «Эксперт РА». «Эксперт РА» — старейшее и крупнейшее кредитное рейтинговое агентство в России, с 1997 года специализирующееся на оценке кредитоспособности, устойчивости и надёжности финансовых институтов, корпоративного сектора и органов власти. «Эксперт РА» включено в реестр кредитных рейтинговых агентств Банка России. Рейтинги «Эксперт РА» входят в перечни официальных требований к банкам, страховщикам, пенсионным фондам, эмитентам.

11.03.2026 [15:30], Руслан Авдеев

В жаркие дни ИИ ЦОД способны потреблять воды как весь Нью-Йорк за деньДаже если среднегодовое потребление воды дата-центрами США будет относительно скромным, в самые жаркие дни оно окажется огромным. Для модернизации американской системы водоснабжения в соответствии с запросами в такие периоды потребуются миллиардные инвестиции, сообщает The Register. Исследование на соответствующую тему провели учёные Калифорнийского университета в Риверсайде. Результаты показали, что вода эффективно охлаждает ИИ-оборудование, но растущий спрос на неё приведёт к огромным расходам этого ресурса в отдельные дни — и современные системы водоснабжения не способны удовлетворить потребности, особенно в жаркую погоду. Без внедрения новых технологий к 2030 году дополнительно может потребоваться 2,6–5,49 млн м³ воды в дни пикового спроса. Для сравнения: Нью-Йорк за сутки потребляет около 3,8 млн м³. Даже при самых оптимистичных сценариях внедрения новых технологий, сокращающих водопотребление ЦОД, новые мощности могут тратить половину объёма водоснабжения Нью-Йорка в течение значительной части года.

Источник изображения: Matteo Catanese/unsplash.com В исследовании подчеркнули, что охлаждение ЦОД обычно происходит в два этапа. Во-первых, охлаждение на уровне серверов, когда тепло передаётся в промежуточный теплообменник на уровне объекта с помощью воздушного или жидкостного охлаждения (замкнутого контура). В обоих случаях вода обычно не расходуется. Второй этап — охлаждение на уровне объекта. Тепло передаётся во внешнюю среду, при этом не исключено потребление воды, в том числе в градирнях, функционирующих за счёт испарения. Используются и другие системы охлаждения. При этом крупный комплекс ЦОД с испарительным охлаждением использует тысячи кубометров воды ежедневно, особенно в самые жаркие дни года. Впрочем, часть воды может «возвращаться» в систему охлаждения. Тем не менее объёмы воды, забираемые ЦОД, становятся недоступны другим пользователям, поэтому с проблемами столкнутся уже другие потребители. Согласно отчёту, в США около 50 тыс. коммунальных систем водоснабжения. Из них около 40 тыс. — небольшие, обслуживающие не более 3,3 тыс. человек; около 9 тыс. — среднего размера; и лишь 708 — крупные, обслуживающие более 100 тыс. человек. Практически все ЦОД гиперскейлеров снабжаются водой из централизованных систем (в основном питьевой), и лишь немногие организовали снабжение из частных подземных источников. По расчётам учёных, в зависимости от климата и особенностей систем охлаждения IT-нагрузка в 100 МВт требует 1892–9463 м³ воды в день. При этом по всей Америке планируется развёртывание дата-центров гигаваттного масштаба. С учётом резерва надёжности многим публичным системам водоснабжения будет сложно обеспечить потребности даже 100-МВт систем, не говоря об объектах гигантского масштаба. Фактически, по данным учёных, многие проекты ЦОД требовали существенной модернизации местной инфраструктуры водоснабжения даже тогда, когда пиковый спрос на воду составлял около 378 м³ в сутки. В целом исследователи пришли к выводу, что американским ЦОД потребуется дополнительно от 2,3 до 5,5 млн м³ воды ежесуточно. На модернизацию понадобится около $58 млрд — объёмы сопоставимы с суточным водопотреблением Нью-Йорка.

Источник изображения: Pawel Czerwinski/unsplash.com Операторам дата-центров рекомендуется обнародовать информацию о пиковом потреблении воды, а не только средние показатели за год. Кроме того, они могли бы взаимодействовать с местными сообществами для финансирования модернизации локальной инфраструктуры водоснабжения, а также наладить контакты с коммунальными предприятиями, корректируя методы охлаждения. Например, при перегрузке электросетей можно было бы использовать водяное охлаждение, а при перегрузке системы водоснабжения — воздушное. Правда, можно предположить, что основная проблема возникнет именно в жаркие дни, когда обе системы будут использоваться по максимуму. В декабре 2025 года появились данные о том, почему ЦОД никак не могут «напиться». В некоторых регионах не хватает даже воды для питья. Эксперты предлагают операторам дата-центров вкладывать средства в опреснительные установки, сети распределения воды, локальные очистные сооружения и другие решения для более широкого использования испарительных охладителей. По некоторым расчётам, опреснение и транспортировка воды с морского побережья пока эффективнее, чем отказ от испарительных систем — даже с доставкой не по трубопроводам, а в цистернах. Впрочем, Microsoft готовит дата-центры с почти нулевым расходом воды, а ранее экспериментировала со сбором дождевой . AWS обещала перевести ещё 100 дата-центров на использование очищенных сточных вод для охлаждения. В феврале власти США призвали операторов — Microsoft, Google, Amazon, Meta✴ и OpenAI — добровольно заключить соглашение, устанавливающее принципы ответственного потребления электроэнергии, воды и взаимодействия с жителями в местах размещения дата-центров. |

|