Материалы по тегу: ии

|

02.12.2025 [09:06], Андрей Крупин

ОС Astra Linux для рабочих станций дополнилась новым репозиторием и двумя уровнями технической поддержки«Группа Астра» сообщила об изменениях в условиях технической поддержки операционной системы Astra Linux для рабочих станций. Разработчиком введены новые уровни поддержки для коммерческих компаний среднего и малого бизнеса — «Базовый» и «Расширенный». Также в рамках поддержки теперь доступен репозиторий Neo с актуальными стабильными версиями open-source ПО и оперативными обновлениями. Репозиторий Neo представляет собой сервис поставки востребованного и актуального свободного ПО, инструментов администрирования и разработки, доступный в рамках технической поддержки всех уровней. Все включаемые в репозиторий open-source версии софта и программные компоненты проходят проверку на известные вирусы, тестируются на совместимость с операционной системой Astra Linux. Обладатели активных сертификатов технической поддержки всех уровней могут создавать запрос на добавление в репозиторий новых программных компонентов.  «Мы провели серию интервью с клиентами и выяснили, что требования к технической поддержке у корпораций и компаний сегмента СМБ существенно различаются. Для среднего и малого бизнеса часть услуг оказалась неактуальна, — поясняют в «Группе Астра». — На основе выявленных ключевых потребностей мы разработали два новых уровня технической поддержки — «Базовый» и «Расширенный», которые подходят сегменту среднего бизнеса как по составу услуг, так и по стоимости. Оба уровня включают возможность перехода на очередные обновления Astra Linux и, наряду с уровнями «Стандартный» и «Привилегированный», предоставляют клиентам право запрашивать добавление необходимого программного обеспечения и инструментов администрирования в Neo-репозиторий». Нововведения также коснулись компаний среднего и малого бизнеса. Согласно лицензионному соглашению, под понятие СМБ попадают коммерческие организации, не являющиеся частью холдинговой структуры, со среднесписочной численностью до 2,5 тыс. работников. По данным «Группы Астра», в 2025 году количество таких коммерческих заказчиков ОС Astra Linux в десктопной редакции увеличилось на 32,8 %.

01.12.2025 [15:59], Руслан Авдеев

Индийская Adani намерена вложить до $5 млрд в ЦОД для Google на фоне бума ИИ-проектовИндийская компания Adani Group рассчитывает инвестировать до $5 млрд в проект ИИ ЦОД, реализуемый Google в Индии, сообщает Reuters. В октябре Google объявила, что вложит $15 млрд в течение пяти лет в строительство ИИ ЦОД в штате Андхра-Прадеш (Andhra Pradesh) на юге Индии, это крупнейшая инвестиция компании в стране на текущий момент. Adani Group сообщает, что проект Google включает инвестиции до $5 млрд для Adani Connex — совместного предприятия Adani Enterprises и частного оператора ЦОД EdgeConneX. В компании заявили, что заключить партнёрские соглашения с Adani готова не только Google, но и другие потенциальные клиенты, особенно, когда ёмкость ЦОД достигнет 1 ГВт и выше. Google увеличила прогноз по капзатратам в уходящем году до $91–$93 млрд, в основном средства пойдут на расширение ёмкости дата-центров. Индийские миллиардеры Гуатам Адани (Gautam Adani) и Мукеш Амбани (Mukesh Ambani) также анонсировали намерение инвестировать в расширение ёмкости ЦОД. Кампус в городе-порту Вишакхапатнам (Visakhapatnam) должен обеспечить первоначальную мощность 1 ГВт с возможностью дальнейшего увеличения. В прочем, в первой половине октября сообщалось, что техногиганты из Соединённых Штатов приостановили развитие ЦОД в Индии, хотя ранее обещали вложить в них миллиарды долларов.

01.12.2025 [15:25], Андрей Крупин

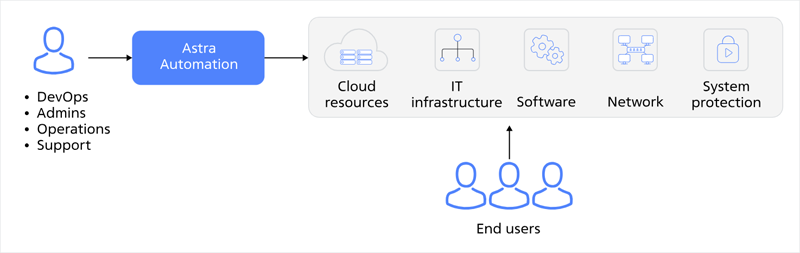

Состоялся релиз Astra Automation 2.0 — новой версии корпоративной платформы автоматизации IT-операций«Группа Астра» сообщила о выпуске на рынок обновлённого программного комплекса Astra Automation 2.0, предназначенного для автоматизации множества рутинных операций по управлению IT-инфраструктурой организации и позволяющего сократить затраты на поддержку и администрирование вычислительных систем. Платформа Astra Automation построена на базе открытого проекта Ansible, поддерживает управление Windows- и Linux-узлами, подходит для серверных, сетевых, облачных и прочих IT‑инфраструктур любого размера. Продукт позволяет автоматизировать решение следующих задач:

Программный комплекс можно как развернуть, так и использовать в полностью закрытом контуре организации без доступа в интернет.

Источник изображения: astra-automation.ru Платформа Astra Automation версии 2.0 получила доработанный инсталлятор, новый, выполненный в формате единой консоли пользовательский интерфейс и поддержку Kubernetes. Перед стартом система автоматически проверяет важные параметры: свободное место, доступность узлов, права записи, корректность настроек. Если что-то не так, процесс не запускается и показывает, как исправить. Это экономит время и снижает риск срывов. Система Astra Automation зарегистрирована в реестре российского ПО и подходит для задач импортозамещения.

01.12.2025 [12:28], Сергей Карасёв

MiTAC представила ИИ-сервер G4826Z5 с ускорителями AMD Instinct MI355X и СЖОКомпания MiTAC анонсировала высокопроизводительный GPU-сервер G4826Z5 на аппаратной платформе AMD, предназначенный для ресурсоёмких задач ИИ и НРС. Кроме того, представлены стойки и вычислительные кластеры на его основе. Сервер G4826Z5U2BC-355X-755 выполнен в форм-факторе 4U. Нижняя 2U-секция содержит два процессора AMD EPYC 9005 Turin и 24 слота для модулей оперативной памяти DDR5-6400. Во фронтальной части расположены восемь отсеков для SFF-накопителей; кроме того, есть два внутренних коннектора M.2 для SSD (NVMe). Верхний 2U-модуль несёт на борту восемь ускорителей AMD Instinct MI355X, оборудованных 288 Гбайт памяти HBM3E с пропускной способностью до 8 Тбайт/с. Машина G4826Z5 получила систему жидкостного охлаждения, которая охватывает CPU- и GPU-секции. Предусмотрена функция обнаружения утечек. Подсистема питания с резервированием выполнена по схеме: 1+1 мощностью 3200 Вт и 3+3 мощностью 15 600 Вт. Все блоки питания имеют сертификат 80 Plus Titanium и допускают горячую замену. На основе G4826Z5 формируется стоечная система (MR1100L-64355X-01): она содержит восемь GPU-серверов, что в сумме даёт 64 ускорителя и 18,4 Тбайт памяти HBM3E. Стойка также укомплектована коммутаторами 400GbE на 64 и 32 порта, двумя коммутаторами 1GbE на 48 портов, сервером управления B8056G68CE12HR-2T-TU, сервером хранения B8056T70AE26HR-2T-HE-TU и блоком распределения охлаждающей жидкости (CDU) в формате 4U. В свою очередь, стойки объединяются в кластеры из четырёх и восьми штук. Это в сумме обеспечивает 32 и 64 сервера GPU и 256 и 512 ускорителей Instinct MI355X соответственно. Таким образом, максимальная конфигурация включает приблизительно 147 Тбайт памяти HBM3E.

01.12.2025 [09:59], Сергей Карасёв

Рабочая станция ASRock GAI4G-R9700 получила четыре ускорителя AMD Radeon AI PRO R9700 Creator и Ryzen Threadripper PRO 9000 WXКомпания ASRock анонсировала рабочую станцию GAI4G-R9700 для задач, связанных с ИИ и другими ресурсоёмкими нагрузками. Новинка, выполненная в форм-факторе 4U, может монтироваться в стойку или использоваться отдельно в виде «настольной» системы. В основу положена аппаратная платформа AMD. Применена материнская плата ASRock WRX90 WS EVO с поддержкой одного процессора Socket sTR5: это может быть чип Ryzen Threadripper PRO 9000 WX (до 96 вычислительных ядер). Доступны восемь слотов для модулей оперативной памяти DDR5-6400 RDIMM/RDIMM-3DS суммарным объёмом до 2 Тбайт. Рабочая станция несёт на борту четыре ускорителя AMD Radeon AI PRO R9700 Creator, каждый из которых содержит 32 Гбайт GDRR6 (256 бит) и предлагает по четыре интерфейса DisplayPort 2.1a. Предусмотрены два посадочных места для SFF-накопителей, а также по одному коннектору M.2 M-key 22110/2280/2260 (PCIe 5.0 x4) и M.2 M-key 2280/2260 (PCIe 4.0 x4) для SSD. Новинка получила контроллер ASPEED BMC AST2600, два сетевых порт 10GbE на базе Intel X710-AT2 и выделенный сетевой порт управления (Realtek RTL8211F). На фронтальную панель выведены два разъёма USB 3.2 Gen1 Type-A. Сзади находятся интерфейс DisplayPort 1.1a (BMC), три гнезда RJ45, четыре порта USB 3.2 Type-A, по два порта USB 4 Type-C и USB 3.1 Type-A, интерфейс SPDIF и 3,5-мм аудиогнёзда. Установлен блок питания мощностью 2500 Вт с сертификатом 80 PLUS Platinum. Применяется воздушное охлаждение с пятью вентиляторами (3 × 120 мм и 2 × 80 мм), скорость вращения которых регулируется ШИМ-методом. Габариты рабочей станции составляют 526 × 430 × 175 мм (без монтажных элементов и ножек).

01.12.2025 [09:15], Руслан Авдеев

Японская Daikin намерена утроить продажи систем охлаждения ЦОД в Северной Америке, надеясь на гиперскейлеров и ИИ-бумЯпонская Daikin Industries рассчитывает утроить продажи охлаждающего оборудования для ЦОД в Северной Америке на фоне бума ИИ-технологий — до более чем ¥300 млрд ($1,92 млрд) к 2030 финансовому году, сообщает Nikkei Asian Review. Сейчас Daikin скупает технологии охлаждения американских компаний и намерена учредить отдельную штаб-квартиру для североамериканского рынка в 2026 финансовом году. Основная цель — работа со всеми гиперскейлерами. По оценкам Daikin, на Северную Америку приходится 40 % мирового рынка решений для охлаждения ЦОД, и её доля, вероятно, продолжит расти. Ключевыми заказчиками являются гиперскейлеры, и Daikin уже работает с Google и Amazon. Крупные HVAC-системы нередко приобретаются для нескольких зданий одновременно, так что объёмы единовременных продаж обычно составляют десятки миллионов долларов. Доля Daikin на североамериканском рынке, по её собственным оценкам, составляет около 12 %. Она занимает третье место в своём сегменте. К 2030 году компания намерена довести долю до 30 %. Конкуренцию ей составит как минимум LG, которая будет поставлять свои системы охлаждения для ИИ ЦОД Microsoft. В 2007 году Daikin купила малайзийскую OYL Industries, которая владела американским производителем кондиционеров McQuay International (бренд Applied). В 2023 году за ¥30 млрд ($192 млн) она купила американскую Alliance Air Products, специалиста по оборудованию для обработки воздуха. В августе того же года она приобрела американскую же Dynamic Data Centers Solutions, разрабатывавшую технологию индивидуального охлаждения стоек. Наконец, в ноябре компания купила американский стартап Chilldyne, специализирующийся на СЖО. Массовое производство систем воздушного и жидкостного охлаждения для серверов начнётся весной следующего года. По прогнозам Daikin, приблизительно 70 % рынка к 2030 году будет приходиться на системы воздушного охлаждения и около 30 % — на СЖО. Daikin намерена предлагать оптимальные комбинации этих методов для операторов ЦОД и отраслевых подрядчиков. Дополнительно она предлагает и системы контроля охлаждения. Также компания сообщает, что намерена создать в США хаб по выпуску решений для ЦОД в 2026 фискальном году для контроля над североамериканским рынком. По данным индийской Fortune Business Insights, мировой рынок систем охлаждения для ЦОД должен вырасти более чем вдвое с 2024 по 2032 гг. до $42,4 млрд. Впрочем, гиперскейлеры работают над собственными решениями, которые позволят обрести им «суверенитет» от независимых вендоров. Например, собственную СЖО всего за 11 месяцев разработала и запустила в производство AWS. А Meta✴ пришлось пойти на ухищрения, чтобы обойтись воздушным охлаждением ИИ-стоек.

30.11.2025 [17:35], Руслан Авдеев

Вьетнам годами не пускал китайское 5G-оборудование Huawei и ZTE, но новые пошлины США, похоже, заставили власти передуматьВедущие китайские телеком-гиганты Huawei и ZTE заключили во Вьетнаме серию контрактов на поставку 5G-оборудования. Это очередное косвенное свидетельство того, что Ханой укрепляет связи с Пекином, вызывая обеспокоенность западных политиков, сообщает Reuters. Годами Вьетнам весьма прохладно относился к идее использования китайских телеком-решений, но на фоне ухудшения связей Ханоя с Вашингтоном, который ввёл дополнительные тарифы на вьетнамские товары, было решено пересмотреть отношения с Пекином. Хотя шведская Ericsson, финская Nokia и американская Qualcomm давно поставляют в страну сетевое оборудование, китайские компании тоже начали выигрывать некрупные тендеры принадлежащих государству операторов. Консорциум, включающий Huawei, получил контракт на $23 млн на поставку 5G-оборудования в апреле, через несколько недель после повышения США пошлин на вьетнамские товары. ZTE заключила не менее двух контрактов, один на прошлой неделе — на поставку 5G-антенн на более $20 млн. Первая публично раскрытая сделка была заключена ещё в сентябре, через месяц после вступления в силу пошлин. Конечно, официальных подтверждений того, что заключение соглашений связано с политикой США, нет, но они уже вызвали озабоченность западных политиков. Отлучение китайских подрядчиков от создания цифровой инфраструктуры Вьетнама, включая оптоволоконные подводные кабели, давно называлось Вашингтоном ключевым условием поддержки поставок в страну передовых технологий. В самих США решения Huawei и ZTE давно запрещено использовать в сетевой инфраструктуре, поскольку это названо «неприемлемым риском» для национальной безопасности, схожие правила действуют в ряде европейских стран. Даже Северная Корея считает китайское оборудование небезопасным. Вьетнам является важным «полем боя» за мировое влияние. Географическая близость к Китаю превратила страну в крупный промышленный хаб для транснациональных компаний вроде Apple, Samsung и Nike, полагающихся одновременно на китайские компоненты и западных покупателей. Под западным давление Вьетнам занял выжидательную позицию в отношении китайских технологий, но, по мнению местных экспертов, у страны есть собственные приоритеты, а новые соглашения могу углубить экономическую интеграцию с КНР. Недавно Ханой и Пекин достигли соглашения о реализации других ключевых проектов, включая строительство трансграничных железнодорожных линий и создание специальных экономических зон у китайской границы — ранее во Вьетнаме такие начинания рассматривали как угрозу национальной безопасности. Контракты Вьетнама с Китаем обсуждались представителями западных стран на встречах в Ханое как минимум дважды. На одном представители Вашингтона пригрозили, что могут потерять доверие к вьетнамским сетям, и такое сотрудничество может поставить под вопрос получение американских передовых технологий. Даже в этом году Вьетнам неоднократно отклонял заявки Huawei на поставку 5G-оборудования, но в итоге компания всё же поучаствовала в некоторых проектах, а в июне 2025 года договорилась о передаче 5G-технологий вьетнамскому оператору Viettel, принадлежащему местному военному ведомству. Один из источников в компании сообщил, что китайские технологии дешевле западных. На встрече в ноябре западные представители вновь пригрозили, что территории, использующие китайские технологии, могут быть отключены от прочих сетей во избежание утечек информации. Западные подрядчики могут столкнуться с перспективой «работы бок о бок с компаниями, которым они не доверяют». У самого Вьетнама тем временем появились большие амбиции в IT-сфере. В начале ноябре сообщалось, что в стране нарастает бум дата-центров и она намерена стать «следующим Сингапуром», как и многие государства в регионе.

28.11.2025 [20:48], Андрей Крупин

«РТК-ЦОД» запустила новую площадку «Облака КИИ» в московском дата-центреКомпания «РТК-ЦОД» (входит в IT-кластер «Ростелекома») сообщила о запуске новой площадки «Облако КИИ», развёрнутой на базе ЦОД «Остаповский-2» в Москве и предназначенной для размещения критической информационной инфраструктуры. Инфраструктура «Облака КИИ» включает в себя аттестованное облако, соответствующее требованиям приказа ФСТЭК №239 на уровне IaaS; взаимодействие с НКЦКИ по передаче инцидентов информационной безопасности, событий и проведение расследований, связанных с ними; контроль соответствия ПО и СЗИ актуальным требованиям и нормативной документации; мониторинг событий ИБ и оперативное реагирование на инциденты; взаимодействие с ГосСОПКА для обмена информацией об инцидентах. Применённые в защищённом окружении «Облака КИИ» аппаратные решения внесены в реестр Минпромторга, а программное обеспечение — в реестр Минцифры России.

Источник изображения: «Ростелеком» / cloud.rt.ru Развёрнутая «РТК-ЦОД» облачная площадка соответствует требованиям к объектам критической информационной инфраструктуры до второй категории значимости, позволяет размещать государственные информационные системы первой категории и работать с персональными данными до первого уровня значимости включительно. Вычислительный комплекс «Остаповский-2» введён в эксплуатацию в 2024 году и вмещает 2048 стоек. ЦОД соответствует уровню защищённости Tier III, что гарантирует работу инженерных систем объекта в случае чрезвычайных ситуаций. Новая аттестованная площадка «Облака КИИ» станет частью отказоустойчивой инфраструктуры компании, которая уже включает площадку в дата-центре «Медведково-1». Расположение двух центров обработки данных в Москве на расстоянии около 20 км друг от друга позволяет обеспечить высокий уровень доступности сервисов и бесперебойность их работы.

28.11.2025 [17:29], Владимир Мироненко

Alibaba и ByteDance натренировались тренировать передовые ИИ-модели в ЦОД Юго-Восточной АзииВедущие китайские компании, включая Alibaba и ByteDance, используют для обучения своих самых передовых больших языковых моделей (LLM) дата-центры за пределами страны по всей Юго-Восточной Азии, поскольку в Китае у них нет доступа к продвинутым ускорителям NVIDIA из-за экспортных ограничений США, пишет The Financial Times со ссылкой на информированные источники. По их словам, после введением администрацией США в апреле ограничений на продажи NVIDIA H20, предназначенных только для Китая, наблюдается устойчивая тенденция роста обучения ИИ-моделей китайских технологических компаний за рубежом. Один из операторов сингапурских ЦОД назвал такой выбор вполне очевидным: «Для обучения самых современных моделей нужны лучшие чипы, и всё это соответствует законодательству». В настоящее время в Сингапуре и Малайзии идёт бурное развитие бизнеса ЦОД, чему способствует и спрос со стороны Китая. Многие из них оснащены высокопроизводительными ускорителями NVIDIA. По словам источников, используется довольно простая схема. Китайские компании заключают договор аренды на использование зарубежных ЦОД, принадлежащих и управляемых некитайскими компаниями. Это соответствует требованиям экспортного контроля США, поскольку правило AI Diffusion rule («Правило распространения ИИ»), принятое в начале года при Джо Байдене (Joe Biden) для регулирования режима экспортного контроля ИИ-технологий и призванное закрыть эту лазейку, было отменено президентом США Дональдом Трампом в мае. Китайские компании не раз ловили на использовании зарубежных площадок — что в этом году, что в прошлом. Но есть и исключения. Например, DeepSeek обучает свои ИИ-модели, по словам осведомленных источников, внутри страны. Как сообщают источники, знакомые с ситуацией, DeepSeek удалось создать запас чипов NVIDIA до вступления в силу запретов на экспорт в США. Компания также тесно сотрудничает с китайскими производителями чипов, включая лидера отрасли Huawei, чтобы оптимизировать и разработать следующее поколение ИИ-ускорителей, сообщают источники. При этом Huawei рассматривает партнёрство с DeepSeek как стратегическую возможность для продвижения своих продуктов в КНР. За последний год ИИ-модели Qwen от Alibaba и Doubao от ByteDance получили признание в мире как одни из эффективных LLM. Qwen также получила широкое распространение среди разработчиков за пределами Китая, поскольку является open source-моделью. При этом большинство китайских компаний предпочитают использовать для обучения передовые ускорители NVIDIA, но вот для инференса, который становится всё более важным, они всё чаще обращаются к чипам местного производства. Китайские технологические компании также используют ЦОД в Юго-Восточной Азии для обслуживания своих зарубежных клиентов, поскольку те же Alibaba и ByteDance стремятся увеличить свою долю на мировом рынке облачных вычислений. Китайские компании также расширяют использование ЦОД в других регионах, например, на Ближнем Востоке. Вместе с тем, в связи с действующим в Китае запретом на вывод личных данных за пределы страны, тюнинг моделей для местных клиентов необходимо проводить в Китае, сообщили представители отрасли.

28.11.2025 [14:51], Руслан Авдеев

SAP предложила клиентам из Евросоюза суверенное ИИ-облако EU AI CloudНемецкая SAP представила европейское суверенное ИИ-облако EU AI Cloud, которое может быть развёрнуто в ЦОД самой SAP, на «доверенной европейской инфраструктуре» или on-premise в рамках SAP Sovereign Cloud. Над предложением SAP работала совместно с североамериканской Cohere, последняя предоставляет платформу North для развёртывания ИИ-агентов в частных инфраструктурах. Также предполагается прямая интеграция решений Mistral AI, OpenAI и др. Будут доступны IaaS, PaaS и SaaS. Основная задача EU AI Cloud — предоставить клиентам из Евросоюзая доступ к передовым ИИ-моделям с соблюдением GDPR, EU AI Act и прочих регуляций, касающихся хранения, передачи и обработки данных. В частности, IaaS-вариант EU AI Cloud гарантирует, что все данные останутся в ЕС и будут обрабатываться в сети европейских дата-центров SAP. Версия on-premise на базе SAP Sovereign Cloud On-Site обеспечивает клиенту полный контроль над данными и их обработкой, а также «юридический суверенитет». Доступ к платформе также организован через суверенное немецкое облачное решение SAP, работающее на базе Microsoft Azure — Delos Cloud. Проект Delos Cloud предлагает сервисы Microsoft Azure, которыми SAP управляет независимо от Microsoft. Физически они базируются в ЦОД в Германии и отделены от сети Microsoft, а также спроектированы с учётом требований Германии к безопасности данных и инфраструктуры. Также новое решение будет доступно в виде SaaS у некоторых других гиперскейлеров.

Источник изображения: SAP В сентябре 2025 года OpenAI тоже объявила, что сервисы для Германии будут доступны через Delos Cloud. Ранее SAP обещала предоставить 4 тыс. ускорителей для ИИ-нагрузок Delos. Сервисы SAP сегодня доступны в десятках ЦОД по всему миру. По данным компании, она располагает 32 площадками в Северной Америке, двумя — в Южной, 33 — в Европе, 15 — в Африке и на Ближнем Востоке, 20 — в Азии и 4 — в Австралии. Недавно компания объявила, что намерена инвестировать более €20 млрд ($23,3 млрд) в расширение суверенного облачного сервиса в Европе. Примечательно, что глава SAP Кристиан Кляйн (Christian Klein) ранее заявлял, что не видит смысла в построении в Европе собственной облачной инфраструктуры в противовес созданной здесь американскими гиперскейлерами. Доля местных игроков годами остаётся низкой, так что отказаться от услуг заокеанских компаний практически невозможно. |

|