Материалы по тегу: ии

|

25.02.2026 [12:12], Владимир Мироненко

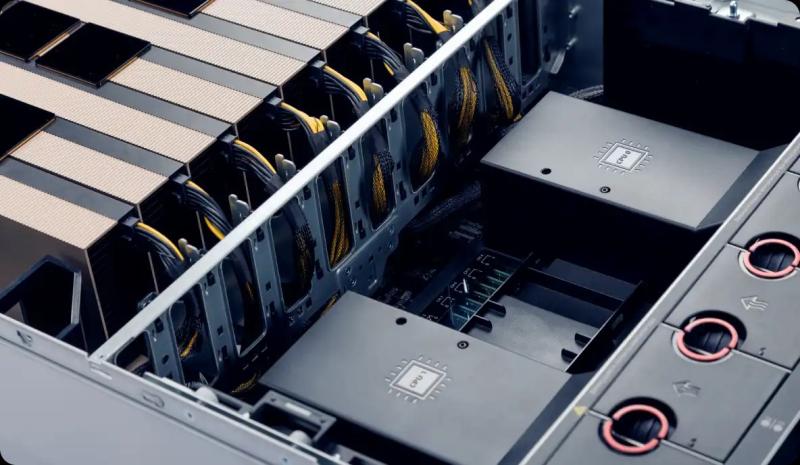

AMD поставит Meta✴ ускорители и процессоры на 6 ГВт, а Meta✴ получит акции AMD на $100 млрдAMD и Meta✴ заключили соглашение с целью развёртывания ИИ-инфраструктуры Meta✴ следующего поколения мощностью 6 ГВт на базе нескольких поколений ускорителей AMD Instinct. Соглашение расширяет существующее стратегическое партнёрство компаний, координируя их планы развития в области кремниевых компонентов, систем и ПО для создания ИИ-платформ, специально разработанных для рабочих нагрузок Meta✴. Соглашение рассчитано на несколько лет с поэтапной реализацией. Изначально планируется развернуть 1 ГВт во II половине 2026 года. AMD поставит кастомные ускорители AMD Instinct на базе MI450, созданные с учётом нагрузок Meta✴, а также процессоры AMD EPYC Venice, работающие под управлением ПО ROCm и построенные на стоечной архитектуре AMD Helios AI. Helios была разработана совместно AMD и Meta✴ в рамках проекта Open Compute Project (OCP) — двухсекционная стойка включает в себя процессоры EPYC Venice, ускорители MI455X и DPU Pensando Vulcano, обеспечивая производительность 2,9 Эфлопс в формате FP4 на стойку. Meta✴ также станет «ведущим заказчиком» процессоров AMD EPYC Venice и EPYC Verano, выпуск последних запланирован на 2027 год.

Источник изображения: Meta✴ В рамках сделки AMD выпустила для Meta✴ варрант на приобретение до 160 млн акций обыкновенного акционерного капитала AMD по цене 1¢/шт., привязанный к достижению определённых показателей, связанных с поставками Instinct. Первый транш предоставляется после поставок оборудования на 1 ГВт, а последующие транши будут предоставляться по мере дальнейших поставок. Предоставление прав на покупку акций также привязано к достижению AMD определённых пороговых значений цены акций, а исполнение прав — к достижению Meta✴ ключевых технических и коммерческих целей. Последняя партия акций будет реализована, если все запланированные заказы будут выполнены, а цена акций AMD превысит $600. По данным Wall Street Journal, общая стоимость сделки может превысить $100 млрд, пишет SiliconANGLE. «Это многолетнее сотрудничество, охватывающее несколько поколений, в рамках которого используются ускорители Instinct, процессоры EPYC и ИИ-системы стоечного масштаба, согласовывает наши планы по созданию высокопроизводительной, энергоэффективной инфраструктуры, оптимизированной для рабочих нагрузок Meta✴, ускоряя одно из крупнейших развёртываний ИИ в отрасли и ставя AMD в центр глобального развития ИИ», — отметила гендиректор AMD Лиза Су (Lisa Su). Марк Цукерберг (Mark Zuckerberg), основатель и генеральный директор Meta✴, назвал соглашение важным шагом для Meta✴ по диверсификации её вычислительных ресурсов. «Я ожидаю, что AMD останется важным партнёром на долгие годы», — заявил он. Как отметил ресурс Data Center Dynamics, это соглашение во многом похоже на сделку AMD с OpenAI, заключённую в октябре 2025 года, в соответствии с условиями которой AMD поставит OpenAI ускорители общей мощностью 6 ГВт. Ожидается, что поставки начнутся во II половине 2026 года, при этом OpenAI заявила о строительстве ЦОД мощностью 1 ГВт с использованием чипов MI450. На прошлой неделе Meta✴ подписала соглашение с NVIDIA о поставке нескольких поколений ускорителей, в рамках которого она будет использовать её Arm-процессоры чипов наряду с «миллионами» ускорителей Blackwell и Rubin, а также сетевой платформой Ethernet Spectrum-X.

25.02.2026 [11:55], Сергей Карасёв

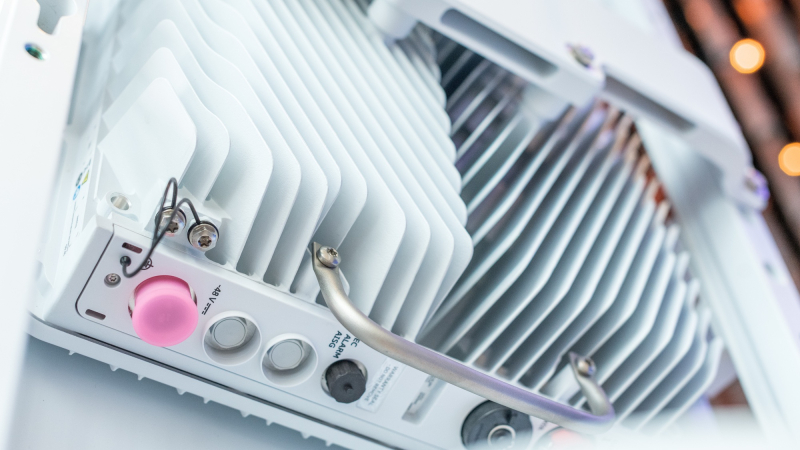

Akash Systems начала поставки первых в мире GPU-серверов с алмазным охлаждениемКомпания Akash Systems, базирующаяся в Сан-Франциско (Калифорния, США), объявила о начале поставок первых в мире ИИ-серверов, оснащённых системой алмазного охлаждения Diamond Cooling. Заказчиком выступил NxtGen AI PVT Ltd — крупнейший в Индии государственный облачный провайдер. Технология Diamond Cooling основана на применении синтетических алмазов. Этот материал обладает самой высокой теплопроводностью из всех известных соединений. Akash Systems подчёркивает, что синтетические алмазы способны отводить тепло от чипов в пять раз эффективнее по сравнению с медью, что открывает качественно новые возможности в плане охлаждения современного оборудования высокой плотности для дата-центров, ориентированных на задачи ИИ и НРС. Akash Systems поставляет серверы на базе NVIDIA H200, для охлаждения которых применяется система Diamond Cooling. В отличие от стандартных ЦОД, оборудование в которых функционирует при температурах от +24 до +29 °C, серверы с технологией Diamond Cooled способны обеспечивать максимальную производительность при температуре окружающей среды до +50 °C. Благодаря этому снижаются общие требования к системам охлаждения дата-центров, что позволяет уменьшить эксплуатационные расходы. Среди одного из ключевых преимуществ Diamond Cooling разработчики называют устранение теплового троттлинга: это обеспечивает наилучшее быстродействие при выполнении ресурсоёмких задач, таких как обучение больших языковых моделей (LLM) и инференс. Кроме того, достигается повышение производительности (Флопс/Вт) до 15 % на каждый сервер. Плюс к этому существенно сокращается общее энергопотребление ЦОД, поскольку отпадает необходимость в интенсивном охлаждении. «Система Diamond Cooling решает две самые сложные проблемы в гонке ИИ — повышение энергоэффективности и сокращение капиталовложений. В ситуации, когда увеличение вычислительной мощности на 1–2 % имеет большое значение, повышение на 15 % фактически меняет правила игры», — говорит доктор Феликс Эджекам (Felix Ejeckam), соучредитель и генеральный директор Akash Systems.

24.02.2026 [23:00], Владимир Мироненко

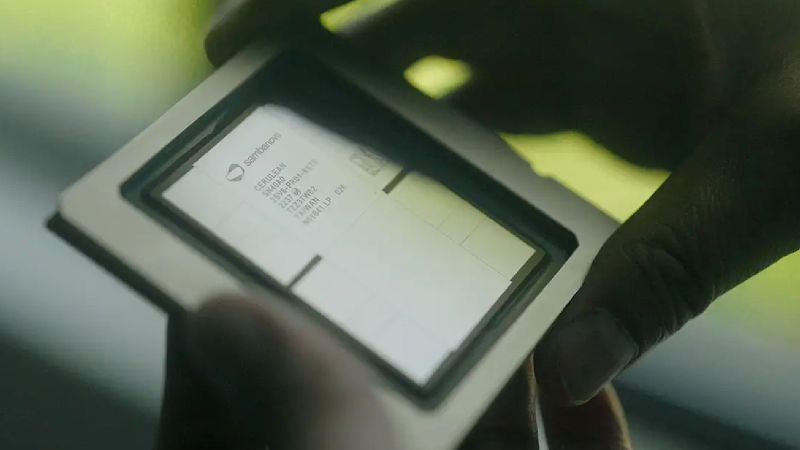

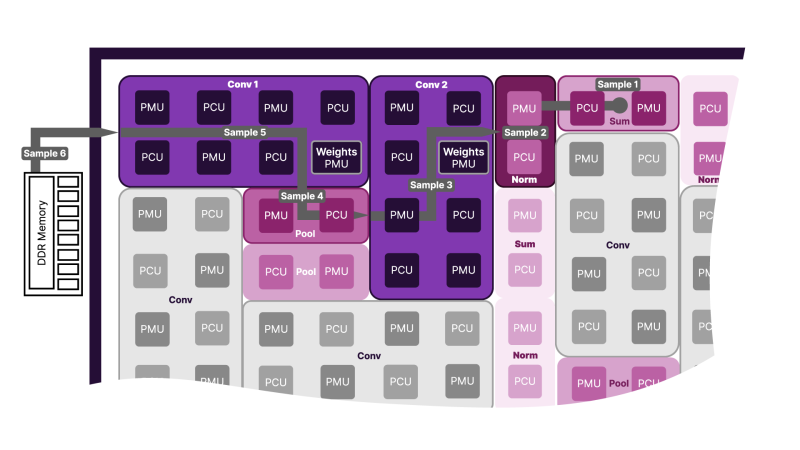

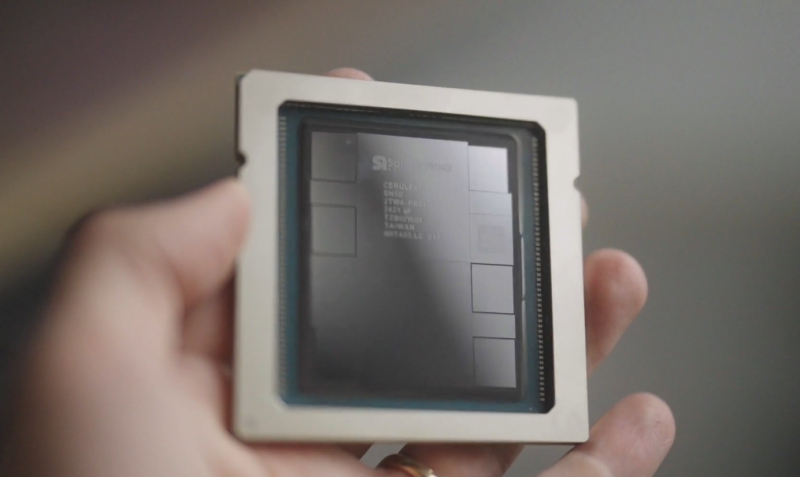

SambaNova представила ИИ-ускоритель SN50 и объявила о расширении партнёрства с IntelSambaNova представила ИИ-ускорители пятого поколения SN50 на основе фирменных RDU (Reconfigurable Dataflow Unit), которые, по словам компании, «обеспечивает непревзойденное сочетание сверхнизкой задержки, высокой пропускной способности и энергоэффективной производительности для рабочих нагрузок ИИ-инференса, коренным образом меняя экономику генерации токенов». Кроме того, объявлено об инвестициях и сотрудничестве с Intel, которая передумала покупать SambaNova целиком. Как отметил The Register, новый чип представляет собой значительное улучшение по сравнению с SN40L 2023 года. По данным компании, SN50 обеспечивает в 2,5 раза более высокую производительность при 16-бит вычислениях (1,6 Пфлопс) и в 5 раз более высокую производительность в режиме FP8 (3,2 Пфлопс). В основе SN50 лежит архитектура потоковой обработки данных (SambaNova DataFlow). Как и в предшественнике, в SN50 используется трёхуровневая иерархия памяти, которая сочетает в себе DDR5, HBM и SRAM, что позволяет платформам на основе новинки поддерживать ИИ-модели с 10 трлн параметров и длиной контекста до 10 млн токенов. Каждый RDU оснащен 432 Мбайт SRAM, 64 Гбайт HBM2E с пропускной способностью 1,8 Тбайт/с и от 256 Гбайт до 2 Тбайт памяти DDR5. Доступность HBM2E и конфигурируемый объём DDR5 позволят повысить привлекательность и доступность SN50 на фоне дефицита памяти. Каждый ускоритель получил интерконнект со скоростью 2,2 Тбайт/с (в каждую сторону) для связи с другими чипами через коммутируемую фабрику. Как утверждает SambaNova, по сравнению с ускорителем NVIDIA B200, SN50 обеспечивает в 5 раз большую максимальную скорость генерации токенов на пользователя и более чем в 3 раза большую пропускную способность для агентного инференса, что было продемонстрировано на примере ряда моделей, таких как Meta✴ Llama 3.3 70B. Архитектура позволяет эффективно разгружать KV-кеш и переключаться между моделям в HBM и SRAM в режиме «горячей замены» за миллисекунды, что крайне важно для агентных рабочих нагрузок, часто переключающихся между несколькими ИИ-моделями. Также в SN50 входные токены могут кешироваться в памяти, сокращая время предварительной обработки и время ожидания первого токена (TTFT) для запросов. Такое сочетание производительности, эффективности и масштабируемости обеспечивает преимущество в совокупной стоимости владения (TCO), по словам компании, не имеющее аналогов на рынке, для поставщиков сервисов инференса, использующих такие модели, как OpenAI GPT-OSS, с восьмикратной экономией по сравнению с NVIDIA B200. SN50 ориентирован и на такие приложения, как голосовые помощники на основе ИИ, требующие сверхнизкой задержки для работы в режиме реального времени. По заявлению компании, он сможет обеспечить работу тысяч одновременных сессий. Также была представлена 20-кВт система SambaRack SN50, которая объединяет 16 чипов SN50. SambaRack могут масштабироваться до кластера из 256 ускорителей с пропускной способностью интерконнекта в несколько Тбайт/с, что сокращает время обработки запросов и поддерживает большие размеры пакетов. В результате можно развёртывать модели с более высокой пропускной способностью и быстродействием. Поставки SN50 клиентам начнутся во II половине 2026 года. Раннее SambaNova сообщила о привлечении более $350 млн в рамках переподписанного раунда финансирования серии E, возглавляемого частной инвестиционной компанией Vista Equity Partners при партнёрстве с Cambium Capital. В нём также приняло «активное участие» инвестиционное подразделение Intel — Intel Capital, сообщил SiliconANGLE. Также SambaNova заявила о сотрудничестве с Intel в разработке новых высокопроизводительных и экономически эффективных систем для выполнения ИИ-задач. Цель — предоставить предприятиям альтернативу GPU, которые сегодня используются в большинстве рабочих нагрузок. Intel инвестирует в стартап, чтобы ускорить развёртывание нового «облачного решения для ИИ» на базе существующей платформы SambaNova Cloud. Обновлённая платформа, оптимизированная для многомодальных LLM, получит процессоры Xeon, а также GPU, сетевые и иные решения Intel, в том числе в области СХД. Идёт ли речь о создании специализированных моделей Xeon, как это было в случае NVIDIA, не уточняется. В дальнейшем Intel и SambaNova планируют совместно продвигать и продавать новую платформу, используя существующие связи Intel с предприятиями и партнёрские каналы. Партнёрство несёт выгоду обеим компаниям. SambaNova сможет воспользоваться глобальным охватом и производственной базой Intel для масштабирования своих ИИ-ускорителей, а Intel получит шанс наконец-то заявить о себе на ИИ-рынке. До сих пор Intel не могла конкурировать с NVIDIA и другими производителями чипов, такими как AMD, в ИИ-сфере. Чипы SN50 от SambaNova в сочетании с процессорами Intel Xeon потенциально могут изменить эту ситуацию. Стоит отметить, что у Intel, которая сама чувствует себя не лучшим образом, есть довольно крупная сделка с NVIDIA. Компания также предлагает собственные GPU для инференса, пусть и значительно более простые в сравнении с SN50, и даже странные гибриды из ускорителей Habana Gaudi 3 и NVIDIA B200. Наконец, имеется и сделка с AWS по выпуску кастомных Xeon 6 и неких ИИ-ускорителей. Что касается старых «коллег» SambaNova в деле борьбы с NVIDIA, то Groq в итоге была поглощена последней, а Cerebras, наконец, подписала заметную сделку с действительно крупным игроком на рынке ИИ — OpenAI.

24.02.2026 [16:32], Владимир Мироненко

Pure Storage сменила имя на Everpure и приобрела 1touch для управления данными в эпоху ИИPure Storage провела ребрендинг, сменив название на Everpure, а также объявила о приобретении стартапа 1touch, специализирующегося на контекстной аналитике данных, переходя от продажи флеш-массивов к позиционированию себя как полноценной платформы управления данными для эпохи ИИ. «[Название] Everpure отражает ту компанию, которой мы стали, помогая предприятиям раскрыть весь потенциал своих данных. Она воплощает в себе мощь нашей архитектуры Enterprise Data Cloud и адаптивность Evergreen, укрепляя то, что всегда отличало нас, поскольку мы переосмысливаем важные рынки», — заявил генеральный директор Everpure Чарльз Джанкарло (Charles Giancarlo). Как сообщает Blocks & Files, компания «осознала», что в эпоху аналитики и ИИ клиентам необходимо управление данными, а не просто массивы хранения и информация на них. И Джанкарло неоднократно говорил об этом, касаясь темы архитектуры. Компания сообщила, что стратегия Everpure решает две основные проблемы предприятий, позволяя клиентам создавать собственное корпоративное облако данных. Первая проблема заключается в том, что клиенты управляют своими наборами данных с помощью людей, а не ПО, что делает управление непоследовательным, трудоёмким и подверженным ошибкам. Вторая же заключается в том, что традиционная архитектура корпоративного хранения данных, разработанная для операционных систем учёта, не оптимизирована для обслуживания систем ИИ и аналитики. «Теперь мы можем не только автоматизировать хранение данных для наших клиентов, но и помочь им лучше управлять глобальными корпоративными данными в масштабе. С помощью Everpure Fusion и нашей архитектуры Enterprise Data Cloud предприятия могут применять управление на основе политик для всех рабочих нагрузок, выходя за рамки традиционного хранения и стандартизируя, защищая и интеллектуально управляя своими наборами данных», — сообщила Everpure. Everpure стремится обеспечить полное управление жизненным циклом данных, их конвейерную обработку для ИИ и аналитики, характеристику и обогащение, присвоение тегов, онтологию, семантику и автономный информационный слой во всех хранилищах Pure. В этом поможет приобретение 1touch. Теперь у Everpure будет интеллектуальная плоскость управления, охватывающая локальные среды — ЦОД и периферию — и публичные облачные среды, предоставляемая как услуга, пишет Blocks & Files. Как сообщила Everpure, «технология 1touch решает общекорпоративные проблемы с данными, повышая киберустойчивость, укрепляя суверенитет данных и соответствие нормативным требованиям, а также обеспечивая более глубокую классификацию и контекстуализацию данных для подготовки к ИИ». Компания отметила, что приобретение 1touch поможет расширить возможности управления, добавив в платформу Everpure функции обнаружения данных и семантического контекста. «Благодаря интеграции хранилища с возможностями 1touch по обнаружению, классификации, контекстуализации и обогащению данных во всех наборах данных и в любой среде — от SaaS до периферии — Everpure обеспечит готовность корпоративных данных к использованию ИИ на самом источнике», — сообщила Everpure. По данным Blocks & Files, 1touch привлекла $3,5 млн в рамках посевного финансирования, за которым последовал раунд A в июне 2020 года на сумму $14 млн, а также ещё $14 млн в рамках раунда B в мае 2023 года — в общей сложности $31,5 млн. В марте 2025 года 1touch сообщила о 500-% росте новых заказов в годовом исчислении, нулевом оттоке клиентов и растущем списке клиентов из списка Fortune 500. Также ею была заключена многомиллионная сделка с одной из трех крупнейших мировых компаний, выпускающих кредитные карты, которая использует 1touch.io для управления конфиденциальными данными. На основе ПО Inventa было разработано решение для анализа и оркестрации данных под названием Kontextual, которое было запущено в ноябре 2025 года.

24.02.2026 [12:16], Сергей Карасёв

Lenovo представила индустриальные мини-компьютеры ThinkEdge на платформе Intel для ИИ-задачLenovo анонсировала новые компьютеры ThinkEdge небольшого форм-фактора, предназначенные для решения ИИ-задач на периферии. Дебютировали модели ThinkEdge SE10n Gen 2, ThinkEdge SE30n Gen 2 и ThinkEdge SE60n Gen 2 на аппаратной платформе Intel. Кроме того, Lenovo представила свой первый промышленный ПК моноблочного типа — устройство ThinkEdge SE50a. ThinkEdge SE10n Gen 2 — это компактный интеллектуальный шлюз с пассивным охлаждением. Максимальная конфигурация включает чип Intel Core 3 Processor N355 (восемь ядер; до 3,9 ГГц) поколения Twin Lake и 16 Гбайт памяти DDR5 (один слот SO-DIMM). Имеется коннектор M.2 для SSD. Во фронтальной части расположены по два порта USB 2.0 и USB 3.1 (10 Гбит/с), комбинированный аудиоразъём, два последовательных порта RS-232/422/485. Сзади находятся ещё два порта USB 3.1, интерфейсы DP1.4 и HDMI 2.0b, два сетевых порта 2.5GbE. Говорится о сертификации MIL-STD- 810H и IP50 (опционально). Габариты составляют 179 × 135 × 34,5 мм, масса — 1,5 кг.

Источник изображений: Lenovo Модель ThinkEdge SE30n Gen 2, в свою очередь, оснащается процессором Intel Raptor Lake — вплоть до Core 7 150U (десять ядер; до 5,4 ГГц). Поддерживается до 48 Гбайт памяти DDR5-4800. Есть коннектор M.2 для NVMe SSD и опциональный разъём M.2 для SATA SSD. Могут быть установлены модули Wi-Fi 6E / Bluetooth 5.4 и 4G/5G. Спереди доступны два порта USB 2.0, два последовательных порта RS-232/422/485 и аудиогнездо, сзади — четыре порта USB 3.1, два разъёма USB 3.0 (5 Гбит/с), четыре интерфейса HDMI 2.0b, по одному сетевому порту 1GbE и 2.5GbE. Размеры — 174 × 125 × 38,7 мм, масса — 1,1 кг.  Компьютер ThinkEdge SE60n Gen 2 — производительная edge-система, предназначенная для решения более сложных задач в области ИИ. Её максимальная конфигурация включает процессор Intel Core Ultra 7 265H семейства Arrow Lake с 16 ядрами и тактовой частотой до 5,3 ГГц. Доступны два слота SO-DIMM для модулей DDR5-5600 суммарным объёмом до 64 Гбайт, коннектор M.2 для NVMe SSD и опциональный разъём M.2 для SATA SSD. Спереди находятся по два порта USB 2.0 и RS232/422/485, сзади — четыре порта USB 3.0, два интерфейса HDMI 2.0, разъём DP 1.2, два сетевых порта 2.5GbE, два аудиогнезда. Устройство имеет размеры 240 × 150 × 59 мм и весит 2,3 кг. Возможно подключение дополнительного блока расширения с набором вспомогательных интерфейсов (4 × RS232 + 2 × USB 2.0, 4 × LAN PoE IEEE 802.3af + 2 × USB 2.0, 4 × LAN + 2 × USB 2.0 или 4 × USB 3.0 + 3 × USB 2.0).  Наконец, моноблок ThinkEdge SE50a предлагается в вариантах с дисплеем размером 12,1″ (1024 × 768 точек), 15,6″ (1920 × 1080 пикселей) и 21,5″ (1920 × 1080 точек). Устанавливается чип Intel Core 7. Объём памяти DDR5-4800 составляет до 32 Гбайт. Имеются коннекторы M.2 Key M 2280 (PCIe x4) и M.2 Key B 2242 (SATA) для SSD, а также M.2 Key E 2230 для адаптера Wi-Fi 6E / Bluetooth 5.4. Реализованы три порта USB 3.2, по одному разъёму USB 2.0 и USB Type-C, два сетевых порта 2.5GbE и последовательный порт RS-232/422/485. В оснащение включён звуковой кодек Realtek ALC888S.  Все новинки могут работать с ОС Windows 11 IoT и Ubuntu. Устройства ThinkEdge SE30n Gen 2 и ThinkEdge SE60n Gen 2 поступят в продажу в апреле нынешнего года. Выход ThinkEdge SE50n ожидается в июне, а ThinkEdge SE10n Gen 2 — в июле.

24.02.2026 [09:46], Руслан Авдеев

По заветам Трампа: SoftBank вложится в исполинскую 9,2-ГВт газовую электростанцию в США для питания ИИ ЦОДSoftBank Group (SBG) выступила во главе инвестиционного альянса, планирующего потратить $33,3 млрд на строительство в США газовой электростанции для поддержки ИИ-инфраструктуры. Инициатива — один из трёх проектов, запущенных в рамках американо-японского торгового соглашения, сообщает Digitimes. Помимо SoftBank, в число желающих вложить миллиарды долларов входят Toshiba, Hitachi и Mitsubishi Electric, а также Panasonic, Murata Manufacturing, TDK, Mizuho Bank и Goldman Sachs. По данным американских и японских СМИ, Японское министерство экономики, торговли и промышленности (METI) на днях объявило, что первая волна инвестиций в рамках более широкого плана финансирования проектов в США на общую сумму $550 млрд, утверждена в качестве части продолжающихся переговоров по тарифам между двумя странами. Сама SoftBank стала крупным инвестором OpenAI, которая строит кампусы ИИ ЦОД Stargate. OpenAI в ответ инвестировала в SB Energy, «дочку» SoftBank. Ключевым проектом альянса будет строительство гигантской электростанции на природном газе мощностью 9,2 ГВт в Огайо. Она станет крупнейшей в США, а по мощности она будет в девять раз больше, чем любая из ныне действующих американских электростанций на природном газе. Электростанция станет частью энергосистемы PJM Interconnection, обслуживающей около 20 % населения США. Впрочем, для самой PJM проект оказался сюрпризом, пусть и приятным — компании не хватает мощностей для питания ИИ ЦОД.

Источник изображения: Billy Joachim/unsplash.com Один из топ-менеджеров компаний, участвующих в проекте, заявил, что точный объём инвестиций ещё не определён окончательно, но партнёры надеются, что проект можно будет использовать для расширения каналов сбыта японской продукции на фоне растущих инвестиций США в индустрию ЦОД. Дополнительно, в рамках общего плана японских инвестиций будет организовано строительство завода по выпуску искусственных алмазов за $600 млн в Джорджии и объект для экспорта сырой нефти в Мексиканском заливе стоимостью $2,1 млрд. На днях сообщалось, что ЦОД используют всё больше экологически небезопасных газовых турбин. Впрочем, альтернативы немногим лучше. В Соединённых Штатах Министерство энергетики (DoE) продвигает «атомные кампусы» с ослабленными требованиями к ядерной безопасности, чтобы запитать ИИ ЦОД.

24.02.2026 [08:59], Руслан Авдеев

К 2030 году Техас может стать крупнейшим рынком ЦОД в мире, а каждый пятый кампус будет уже гигаваттным

bloom energy

hardware

jll

ветроэнергетика

гиперскейлер

ии

полезные ископаемые

прогноз

солнечная энергия

сша

цод

экология

энергетика

Согласно анализу рынка JLL, индустрия ЦОД в Северной Америке перешла к новому этапу роста, обусловленному спросом на объекты гиперскейл-уровня и ИИ-платформы, из-за чего свободные мощности второй год подряд составляют всего 1 %, сообщает Datacenter Knowledge. Крупнейшим бенефициаром этих процессов становится Техас. Всего в Северной Америке насчитывается 39 ГВт мощностей ЦОД, в стадии реализации проекты ещё на 35 ГВт. Почти ⅔ новых мощностей — за пределами традиционных центров, Северной Вирджинии или Кремниевой долины. Тем временем, в Техасе ведётся строительство ЦОД на 6,5 ГВт — к 2030 году этот рынок может обогнать Северную Вирджинию, долгие годы бывшую абсолютным мировым лидером. Набирает обороты строительство и на рынках Теннеси, Висконсина и Огайо благодаря относительной доступности электроэнергии, наличию свободной земли и благоприятные условия ведения бизнеса. Здесь реализуются более десяти проектов мощностью более 1 ГВт. Дефицит предложения приводит к значительному ценовому давлению. Арендная плата у ЦОД выросла на 9 % в 2025 году, в результате чего рост с 2020 года составит 60 %. Отмечается, что большинство новых договоров аренды включает положение о ежегодном повышении арендной платы как минимум на 3 %, а договоры на новые площади заключаются на несколько лет вперёд, хотя зачастую ввод объектов в эксплуатацию состоится не раньше 2027 года или даже позже. Основным драйвером роста выступают крупные облачные провайдеры, капитальные затраты пяти облачных гиперскейлеров составят $710 млрд (От новости к новости цифра растёт и растёт. — Прим. ред.) только в 2026 году. Этого хватит на 35 ГВт глобальных мощностей. ИИ-компании вроде OpenAI и Anthropic анонсировали строительство ещё 10 ГВт мощностей, а неооблачные провайдеры арендовали порядка 1 ГВт.

Источник изображения: Sam LaRussa/unsplash.com При этом критическим препятствием является недостаток электроэнергии, сроки подключения составляют четыре года и выше, что вынуждает операторов осваивать новые рынки, переходить к поэтапному и модульному строительству, вырабатывать стратегии гибридного и временного энергообеспечения объектов, в том числе строить электростанций при ЦОД. И Техас в этом отношении наиболее удобен — здесь есть необходимая передающая инфраструктура, избыточная выработка электроэнергии и возможность ввода новых генерирующих объектов. А в местной энергосистеме ERCOT больше потенциальной энергии от солнечных и ветряных электростанций и природного газа, чем в любом другом регионе США. Как сообщает The Register, по данным доклада Bloom Energy 2026 Datacenter Power Report, общая IT-нагрузка в США может практически удвоиться в ближайшие несколько лет, с приблизительно 80 ГВт в 2025 году до 150 ГВт к 2028 году. По прогнозу, к 2028 году рынок ЦОД Техаса удвоится и превысит 40 ГВт. А основным источником локальной генерации для них станут газовые турбины, хотя их не хватает, да и экологичными их не назвать. Так или иначе, мощности будут наращиваться, как и масштаб новых дата-центров. В компании полагают, что к 2030 году каждый пятый ЦОД будет мощнее 1 ГВт, а к 2035 году — каждый третий.

23.02.2026 [23:22], Владимир Мироненко

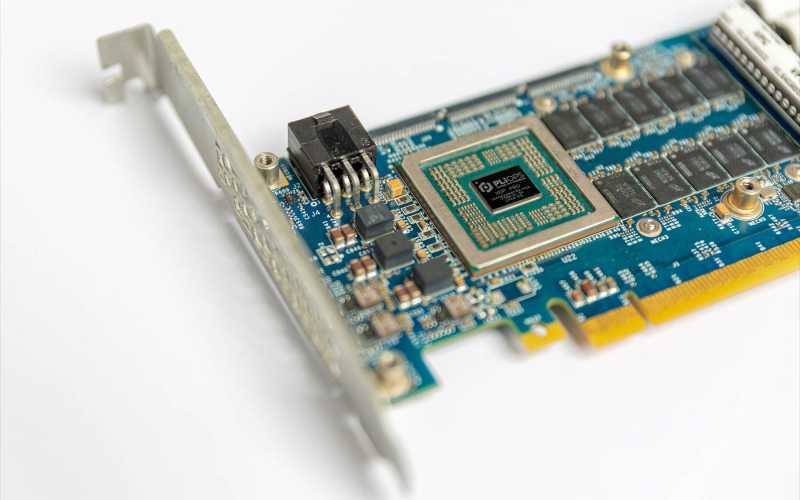

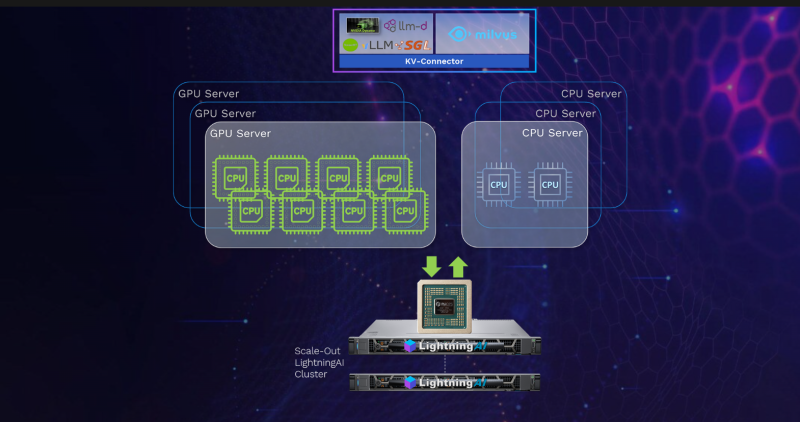

Astera Labs по-тихому купила PliopsAstera Labs приобрела Pliops, сообщил ресурс StorageNewsletter со ссылкой на заявление Мариуса Тудора (Marius Tudor), бывшего директора по развитию бизнеса Pliops, подтвердившего факт сделки на своей странице в соцсети LinkedIn. Финансовых подробностей о сделке не сообщается. Ресурс допустил, что компания приобрела Pliops для своего первого научно-исследовательского центра в Израиле. О создании своего передового R&D-центра в Израиле Astera Labs сообщила в начале февраля. Предполагается, что новый центр с офисами в Тель-Авиве и Хайфе ускорит разработку масштабируемых сетей следующего поколения для протоколов высокоскоростной связи, а также будет способствовать техническим исследованиям и разработкам, направленным на решение проблем с памятью в приложениях для обучения и инференса ИИ. Руководителем центра назначен ветеран полупроводниковой индустрии Гай Азрад (Guy Azrad), старший вице-президент по проектированию и генеральный директор Astera Labs Israel, а его помощником станет Идо Букспан (Ido Bukspan), вице-президент по проектированию ASIC, имеющий 20-летний стаж работы в Mellanox и NVIDIA, где он дошёл до должности старшего вице-президента по проектированию микросхем, разрабатывая высокопроизводительные решения InfiniBand, Ethernet и NVLink. «Новый израильский дизйн-центр будет стремиться использовать лучшие в регионе инженерные таланты, чтобы сосредоточиться на полном цикле проектирования микросхем — от архитектуры до производства, включая ПО и системное проектирование для передовых ИИ-платформ и новых приложений для инференса», — заявил Азрад. Разработанная Pliops PCIe-карта расширения XDP LightningAI с программным стеком FusIOnX функционирует как ещё один уровень памяти для GPU-серверов. Она работает на базе ASIC, которая «раскладывает» KV-кеш на SSD с доступом через NVMe-oF (RDMA) и горизонтальным масштабированием. Стек Pliops FusIOnX снижает стоимость, энергопотребление и вычислительные затраты путём оптимизации рабочих процессов инференса LLM. «Сочетание нашего оборудования LightningAI с ПО FusIOnX устраняет узкое место, связанное с памятью GPU, обеспечивая до восьми раз более быструю обработку данных и экономию энергии на уровне стойки. И это работает от начала до конца: на любом GPU, любой LLM, любом ПО для обработки данных и любой сетевой инфраструктуре», — заявил Идо Букспан. По данным компании, Pliops XDP LightningAI вместе с ПО расширяют возможности высокоскоростной памяти (HBM) для серверов с GPU и ускоряют работу vLLM на NVIDIA в 2,5 раза.

23.02.2026 [22:57], Владимир Мироненко

Чипы AMD прожорливы, NVIDIA — дороги, а Intel — ненадёжны: Ericsson остаётся верна кастомным ASICEricsson представила свой первый набор продуктов AI-RAN, подчеркнув приверженность стратегии, основанной на собственных ASIC для повышения производительности сетей радиодоступа (RAN). В то время как беспроводная индустрия всё чаще обращается к виртуализированным/облачным RAN с использованием универсальных процессоров (GPP) Intel, Ericsson защищает свои продолжающиеся инвестиции в кастомные чипы для высокопроизводительных задач, отметил ресурс IEEE ComSoc Technology Blog. Впрочем, Intel остаётся ключевым партнёром Ericsson, а вот с AMD и NVIDIA у компании не заладилось. Портфель решений Ericsson для RAN базируется на двух основных архитектурах. Большая часть основана на ASIC, разработанных как собственными силами, так и в партнёрстве с Intel. Также портфель включает Cloud RAN, которая объединяет программный стек Ericsson с процессорами Intel Xeon EE. Несмотря на надежды отрасли, что виртуализация позволит отделить аппаратное обеспечение от программного, Intel остаётся единственным партнером Ericsson по поставке микросхем для массового развёртывания, что создаёт некоторые риски. Фактически Ericsson подтвердила «коммерческую поддержку» исключительно решений Intel, в то время как в случае AMD, Arm и NVIDIA всё по-прежнему ограничивается «поддержкой прототипов». Несмотря на многолетние заявления отрасли о необходимости разнообразия микросхем в экосистеме vRAN, прогресс, похоже, застопорился. Кроме того, интеграция ИИ в ПО RAN добавляет новые уровни сложности, которые могут ещё больше укрепить зависимость компании от «железа» одного вендора. Отраслевые наблюдатели по-прежнему скептически относятся к стремлению Ericsson к «единому программному стеку» для гетерогенных аппаратных платформ. Хотя аппаратная и программная дезагрегация достижима на более высоких уровнях (L2/L3), PHY-уровень L1 — наиболее ресурсоёмкая часть стека — остаётся сильно оптимизированным для конкретного «кремния». Первоначально Ericsson рассчитывала на переносимость L1-кода между x86 (в т.ч. AMD) и Arm SVE2 (NVIDIA Grace) для соответствия возможностям Intel AVX-512. Однако достижение высокой производительности на этих платформах без существенного рефакторинга остается серьёзной инженерной проблемой. Критическим узким местом в обработке L1-трафика является коррекция ошибок (Forward Error Correction), которая традиционно требует выделенного аппаратного ускорения. Ericsson первоначально полагалась на разгрузку с переносом задач FEC на дискретные PCIe-ускорители Intel. Затем Intel внедрила ускорение FEC в Xeon EE в рамках vRAN Boost. Попытки использовать FPGA AMD показали их невысокую энергоэффективность, а GPU NVIDIA оказались слишком дороги для такой задачи. Однако развитие AI-RAN изменило экономику, поскольку теперь ускорители можно использовать как для RAN, так и для ИИ-задач. Так, Ericsson заинтересовали тензорные процессоры Google (TPU). Тем не менее, несмотря на стремление к созданию «единого ПО», планы Ericsson подтверждают существование проблем в реализации этой идеи. В то время как уровни L2 и выше используют универсальную кодовую базу для всех аппаратных платформ, уровень L1 требует адаптации под конкретные чипы. Чтобы избежать зависимости от одного поставщика чипов, компания уделяет приоритетное внимание развитию HAL (Hardware Abstraction Layers), что позволит портировать ПО на разные аппаратные платформы с минимальными изменениями. Основные инициативы включают внедрение интерфейса BBDev (Baseband Device) для отделения ПО RAN от базового аппаратного обеспечения. Рассматривается даже возможность интеграции с NVIDIA CUDA, но здесь многое зависит от более широкой отраслевой стандартизации. Что касается радиосвязи, менее подверженной полной виртуализации, Ericsson встраивает процессоры Neural Network Accelerators (NNA) непосредственно в радиомодули. Эти программируемые матричные ядра оптимизированы для обработки данных в системах Massive MIMO, обеспечивая формирование луча и оценку канала за доли миллисекунды при соблюдении строгих ограничений по мощности. Новые AI-радиомодули оснащены ASIC Ericsson с NNA. Утверждается, что они расширяют возможности локального инференса в радиосистемах Massive MIMO, обеспечивая оптимизацию в реальном времени.

22.02.2026 [15:58], Владимир Мироненко

Российский бизнес распробовал ИИ: рынок ИИ-серверов достиг 60 млрд рублейВ 2025 году в России на закупку ИИ-серверов компании потратили около 60 млрд руб., без учёта аренды вычислительных мощностей, обслуживания и модернизации сообщил коммерческий директор YADRO (входит в «ИКС холдинг») Александр Бакулин на цифровом форуме «Инфраструктурные вызовы для развития ИИ в России» в рамках Недели российского бизнеса, о чём пишут «Ведомости». Он добавил, что рынок находится «в стадии перелома» — за последние два года ИИ перестал быть «надстройкой» над IT-инфраструктурой, а стал менять правила проектирования вычислительных систем. Формируется новая инфраструктурная ниша, сравнимая с энергетикой и телекоммуникациями. Ключевые заказчики переходят от экспериментов к промышленной эксплуатации, начинают встраивать решение машинного обучения больших языковых моделей в свои бизнес-процессы и планы. И при этом на ИИ наблюдается большой спрос, сообщил Бакулин. По словам Бакулина, мировой рынок ИИ-серверов, который во многом формируют облачные провайдеры и крупные технологические компании, оценивается в сотни миллиардов долларов, демонстрируя устойчивую высокую динамику. Как и на мировом рынке основной спрос в России формируют крупные компании, работающие с большими массивами данных и развивающие собственные языковые модели, например крупные игроки e-commerce, финтеха и интернет-сервисов. Ранее «АТК консалтинг» сообщила, что закупки программных продуктов с ИИ в 2025 выросли год к году в 7,4 раза до 1,8 млрд руб. Как отметили тогда «Ведомости», рынок «железа» для ИИ в деньгах вырос значительно больше. В частности, это связано с подорожанием чипов памяти, на которую в современных серверах может приходиться до двух третей себестоимости. В «Группе Астра» считают, что 60 млрд руб. на ИИ-серверы звучит реалистично, но важнее динамика. Так, совокупный российский рынок серверов и СХД в 2025 году в целом составил 280 млрд руб. против 155 млрд руб. в 2024-м, сообщали «Ведомости» со ссылкой на данные YADRO и Fplus. Наибольшая часть рынка — около 55–60 % от суммы — пришлась на госзакупки по 44-ФЗ и 223-ФЗ, уточнили тогда в YADRO. По оценкам «Группы Астра», к концу 2026 года госзакупки, связанные с ИИ, вырастут на 20–30 %, а год к году — вполовину. Рынок действительно идёт к промышленной эксплуатации ИИ, считают в ЦКНТИ по направлению «Технологии хранения и анализа больших данных» МГУ, отметив, что банки, телеком, ретейл встраивают ИИ-модели в скоринг, поддержку, операционные процессы. До конца года рынок может вырасти за счёт дооснащения и повторных закупок, а год к году — на 25–40 %, если не будет жёстких ограничений по поставкам ускорителей и финансированию. |

|