Материалы по тегу: ии

|

26.02.2026 [23:11], Владимир Мироненко

AMD инвестирует в Nutanix $250 млн и создаст совместную платформу для агентного ИИAMD и Nutanix объявили о заключении соглашения о многолетнем стратегическом партнёрстве с целью разработки открытой инфраструктурной платформы для корпоративных приложений в области агентного ИИ, первая версия которой должна появиться к концу этого года. В рамках соглашения AMD инвестирует $150 млн в обыкновенные акции Nutanix по цене $36,26/шт. и предоставит до $100 млн дополнительного финансирования для совместных инженерных и маркетинговых инициатив, а также сотрудничества в области выхода на рынок с целью ускорения внедрения совместной платформы агентного ИИ. Ожидается, что сделка по инвестиции в акционерный капитал будет завершена во II квартале 2026 года после получения необходимых разрешений регулирующих органов. Совместно разработанная платформа агентного ИИ предназначена для обеспечения ускорения инференса на базе ускорителей Instinct и процессоров EPYC, HPC и оркестрации с использованием EPYC, а также унифицированного управления жизненным циклом с помощью Nutanix Enterprise AI, что позволит развёртывать открытые и коммерческие ИИ-модели без зависимости от вертикально интегрированных стеков ИИ. В рамках сделки Nutanix также интегрирует ПО AMD ROCm и Enterprise AI в свою облачную платформу Nutanix Cloud и платформу Nutanix Kubernetes, отметил ресурс SiliconANGLE. В настоящее время Nutanix поддерживает только ускорители NVIDIA. Благодаря этой сделке Nutanix будет поддерживать и ускорители AMD, что, как ожидается, позволит AMD расширить круг клиентов. «Наша цель — предоставить клиентам выбор, — заявил глава Nutanix Раджив Рамасвами (Rajiv Ramaswami) изданию The Register. — NVIDIA — лидер рынка, а AMD — ещё одна крупная компания, владеющая платформой». О сделке было объявлено после того, как Nutanix сообщила о финансовых результатах за II квартал 2026 финансового года. Выручка компании выросла год к году на 10 % до $723 млн. Скорректированная прибыль на акцию составила 56¢. Оба показателя превысили прогнозы аналитиков, ожидавших $710,35 млн выручки и 44¢ на акцию скорректированной прибыли. Высокие показатели были достигнуты благодаря росту клиентской базы: годовой доход от регулярных платежей по состоянию на конец января составил $2,36 млрд, что на 16 % больше, чем годом ранее. Рамасвами сообщил, что за прошедший квартал компания заключила 1000 новых контрактов с клиентами, и большинство из них намерены перейти с VMware на Nutanix. Вместе с тем дефицит в цепочках поставок процессоров и комплектующих, включая память и накопители, привёл к тому, что компания снизила свой прогноз на весь год с $2,82–$2,86 млрд до $2,80–$2,84 млрд. После объявления о сделке AMD и Nutanix акции Nutanix выросли в цене на 15 %.

26.02.2026 [18:15], Сергей Карасёв

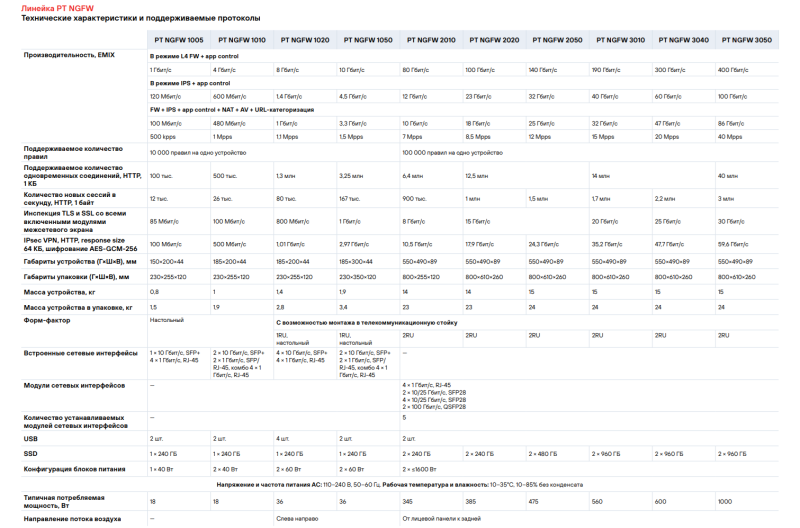

Positive Technologies выпустила межсетевой экран PT NGFW 3050 с производительностью до 400 Гбит/сКомпания Positive Technologies анонсировала межсетевой экран нового поколения PT NGFW 3050 — своё самое производительное решение данного типа. Устройство способно обрабатывать трафик со скоростью до 400 Гбит/с в L4-режиме Stateful Firewall с контролем приложений. Новинка выполнена в форм-факторе 2U. В основу положена аппаратная платформа Intel Xeon Sapphire Rapids. В оснащение входят 1 Тбайт оперативной памяти DDR5 и два SSD вместимостью 960 Гбайт каждый. Реализованы следующие сетевые интерфейсы: 4 × 1GbE (RJ-45), 6 × 10/25GbE (SFP28) и 2 × 100GbE (QSFP28). Габариты составляют 550 × 490 × 89 мм, масса — 15 кг. Модель PT NGFW 3050 использует модернизированный стек TCP/IP, работающий в пользовательском пространстве, специальный протокол отказоустойчивости, а также собственные движки системы предотвращения вторжений (IPS) и антивируса. Имеются выделенные порты для управления и синхронизации сессий, а также разъёмы USB 2.0 и USB 3.0 для токенов модулей доверенной загрузки и обслуживания. Заявленная пропускная способность с применением IPS достигает 100 Гбит/с. Со всеми активированными модулями безопасности (IPS, антивирус, NAT, URL-фильтрация) показатель составляет до 86 Гбит/с. Скорость инспекции TLS и SSL со всеми включёнными модулями межсетевого экрана — до 30 Гбит/с. Устройство поддерживает до 40 млн одновременных соединений и обрабатывает до 3 млн новых сессий в секунду. «На сегодняшний день PT NGFW 3050 — это самый производительный, сертифицированный во ФСТЭК, российский межсетевой экран нового поколения на рынке, способный детально анализировать трафик на скоростях магистральных каналов», — отмечает Positive Technologies.

26.02.2026 [17:31], Сергей Карасёв

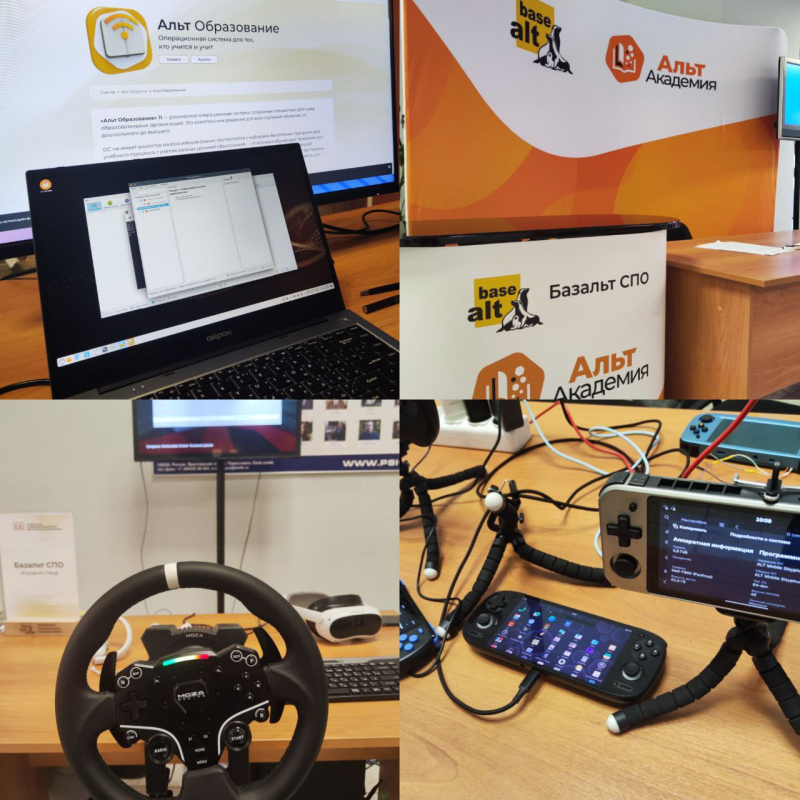

Искусственный интеллект в образовании, сетевая безопасность и открытые технологии: «Базальт СПО» провела XXI ежегодную конференцию «СПО в высшей школе»В Переславле-Залесском с 6 по 8 февраля 2026 года прошла ХXI конференция «Свободное программное обеспечение в высшей школе». Мероприятие объединило студентов, преподавателей и разработчиков из разных регионов России. Участники обсудили, как ИИ влияет на достоверную оценку знаний и какие решения позволят контролировать успеваемость учеников. Также на конференции представили новые форматы учебных материалов, продемонстрировали операционные системы для организации лабораторных работ и рассказали про комплексные решения, позволяющие незрячим специалистам осваивать ИТ-профессии. Организаторами мероприятия выступили «Базальт СПО» и Институт программных систем имени А.К. Айламазяна РАН (ИПС РАН). «За три дня с докладами выступили преподаватели и студенты почти 20 вузов. Кто-то уже успешно применяет свободные программы в образовательных целях, кто-то участвует в разработке, а кто-то приехал перенять опыт. Участники обсудили значение свободного ПО для повышения качества образования и для преодоления технологической зависимости», — отметил Алексей Смирнов, председатель совета директоров компании «Базальт СПО. Искусственный интеллект и образование — кто кого?Георгий Курячий, преподаватель МГУ им М. В. Ломоносова, проанализировал влияние нейросетей на современный учебный процесс. По словам эксперта, за последние несколько лет ИИ‑системы достигли уровня, позволяющего успешно выполнять типовые учебные задания по широкому кругу дисциплин. Из-за этого снижается достоверность оценки знаний, искажается система отбора студентов, утрачиваются практические навыки. Предлагаемые решения этих проблем неэффективны: они либо не достигают поставленных целей, либо требуют неоправданно много ресурсов. Часто предлагается признать пользу ИИ и разрешить студентам пользоваться этим инструментом. Но в этом случае они не обучаются базовым навыкам. По мнению эксперта, традиционные образовательные модели сталкиваются с системным кризисом и вопрос адаптации к новым реалиям остаётся открытым. Далее обсуждение использования ИИ в учебном процессе перешло в формат круглого стола. Старший преподаватель кафедры японской филологии ИСАА МГУ им М. В. Ломоносова Людмила Васильева рассказала, как студенты используют популярные онлайн-переводчики для выполнения заданий. Однако выдаваемый перевод содержит грамматические и стилистические ошибки, которые в дальнейшем ученики не редактируют. Для решения этой проблемы преподаватель задавала устные вопросы, чтобы удостовериться в переводческих навыках студентов. По её мнению, студенты обращаются к ИИ из‑за высокой учебной нагрузки и стремления всё успеть. В завершение своего выступления Людмила Васильева отметила, что нужно приспосабливаться к наличию ИИ и учиться им правильно пользоваться. Ряд участников обсуждения считают, что в сегодняшних условиях выявить реальные знания студентов могут устные экзамены и живое общение. Операционные системы для учёбы: атомарные, минимальные и переносныеВ рамках проекта ALT Atomic Семён Фомченков, разработчик «Базальт СПО» и активный участник сообщества ALT Gnome, продемонстрировал Atomic Package Manager. Это инструмент для управления состоянием системы через декларативное описание её состава. Можно создавать профили операционных систем для разных ролей, например, для рабочей станции или сервера. Для учебных целей удобно сформировать стандартизированные образы. В них студенты могут экспериментировать с ОС. При необходимости система быстро откатывается до начального состояния. Артём Осипчук, студент МГУ им. М.В. Ломоносова, поделился опытом использования специализированных образов операционной системы «Альт» для лабораторных работ по сетевым протоколам. При помощи инструмента mkimage-profiles на кафедре вычислительной математики и кибернетики были собраны минимальные образы (JeOS) с точно заданным набором пакетов, сервисов и настроек. Их используют, чтобы быстро разворачивать и клонировать виртуальные машины для моделирования сетевых топологий. Образы легко адаптируются и обновляются, что упрощает обучение студентов сетевым протоколам. В перспективе планируется создать сервис для автоматической настройки целых сетевых лабораторий на основе этих образов. Никита Шалаев, доцент СЗИУ РАНХиГС, рассказал про дистрибутив Linux — MiniOS. Он предназначен для быстрого развёртывания произвольного количества однотипных сред на рабочих местах, в учебных заведениях и на мероприятиях. MiniOS запускается с флешки по принципу LiveCD — «живой системы» и сохраняет изменения на загрузочном носителе. Презентации в браузере и «бесконечный свиток» — альтернативные формы учебных материаловВасилий Меленчук, старший преподаватель БрГТУ, представил набор инструментов для создания HTML‑презентаций. Для написания контента в формате AsciiDoc применяется фреймворк reveal.js для интерактивного отображения презентаций в браузере. Чтобы запустить локальный веб-сервер, конвертацию и экспорт HTML‑файлов, использовалось расширение для Visual Studio Code — AsciiDoc Presentations. Решение уже применяется для подготовки лекционных материалов по ИТ‑дисциплинам. Стас Фомин, преподаватель МФТИ, представил инструмент для создания инфографических конспектов — компактной и визуально насыщенной альтернативы статьям, книгам и презентациям. Проект содержит Markdown-редактор, расширения к code-server/code-oss/vscode и CSS-стили. Конспект преобразовывается в «майндмаппер на бесконечном свитке». Он вытягивается по вертикали для последовательного рассказа, а содержание темы уходит в горизонтальные ответвления. С помощью расширения «Freeze Markdown» можно преобразовать конспект в HTML-файл. Эксперт использовал решение для преподавания студентам, командной работы с IT-специалистами и подготовки докладов и видеороликов. Построение сетей и защита от киберугрозСтепан Мальчевский, студент МГУ им. М.В. Ломоносова, разработал серию лабораторных работ по изучению сетевых протоколов на базе виртуальных машин Linux в среде VirtualBox. При помощи инструмента mkimage-profiles был создан специализированный образ виртуальной машины без графической среды и с минимальным набором пакетов. На нём в среде VirtualBox реализованы лабораторные занятия по темам: VLAN, STP, статическая и динамическая маршрутизация (RIP, OSPF), фильтрация трафика, туннелирование и VPN. При этом студенты осваивают логику технологий, а не особенности конкретного ПО. Максим Зайка, студент Донецкого государственного университета, представил опыт использования эмулятора GNS3 для моделирования конфигурации сети и обучения основам сетевой безопасности. В рамках проекта была создана модель школьной локальной сети на маршрутизаторах Cisco. На этой модели можно изучать работу сетевых протоколов, тестировать варианты атак на сеть и отрабатывать методы защиты от киберугроз. Мобильные приложения для растениеводства и бизнесаДарья Морель, студент НИУ ВШЭ, представила мобильное приложение для удалённого управления системой гидропонного выращивания HotbedAgroControl. Пользователь может:

Планируется интегрировать в приложение искусственный интеллект, который будет давать рекомендации по выращиванию растений. Алиса Киселева, студентка НИУ МИЭТ, представила механизм настраиваемых уведомлений в мобильном приложении для управления бизнес-процессами RunaWFE. Также она рассказала про мобильный клиент RunaWFE Free для ОС ALT Mobile. Как пробудить интерес к разработке и экспериментамОбразовательный проект «Национальная киберфизическая платформа» направлен на обучение школьников программированию, электронике и созданию умных автономных устройств. О его работе рассказал президент Ассоциации участников технологических кружков Алексей Федосеев. Для обучения используется визуальный язык программирования (ПРИМС) который позволяет:

Такой метод обучения применяется в технологических кружках и на олимпиадах. Платформа Arduino помогает создать измерительные приборы для мониторинга окружающей среды. Александр Чернышов, доцент Мытищинского филиала МГТУ им. Н. Э. Баумана, рассказал про систему, которая используется на кафедре прикладной математики, информатики и вычислительной техники. В основе платформы лежит среда разработки микроконтроллеров Arduino IDE. С её помощью разработаны приборы, выполняющие измерения: атмосферного давления, влажности и температуры воздуха, уровня углекислого газа и т. д. Создан общедоступный сервер, где накапливается информация о проведённых измерениях и настройках приборов. Это позволило фиксировать результаты и передавать опыт следующим поколениям студентов. Александр Речицкий, преподаватель Computer Science, представил методику «Install Fest» для обучения основам системного тестирования с использованием ReactOS. Это свободная операционная система с открытым исходным кодом, архитектурно близкая к Windows. Студенты могут установить ОС на ПК через сетевую PXE‑загрузку с преподавательского сервера. В ходе «Install Fest» студенты фиксируют проблемы (отсутствие поддержки оборудования, ошибки драйверов, сбои), анализируют их причины, работают с документацией и ищут решения. Такая методика позволяет совместить теорию и практику и сформировать навыки работы с открытыми инженерными знаниями и сообществом Open Source. Комплексные решения для автоматизации, компьютерной графики и цифровой доступностиАлексей Драгунов, директор ГБУ ПО «Региональный центр информационных технологий», представил решение для автоматизации обмена данными между разрозненными информационными системами школ. Образовательным организациям необходимо одновременно работать с множеством веб-сервисов: госпаблики ВК, сайты, каналы в мессенджере MAX, электронные журналы. Ручная синхронизация данных между ними отнимает много времени и ресурсов. В качестве решения используются: инструмент для автоматизации действий в веб‑браузерах Selenium, библиотека для управления браузером WebDriver и Python‑скрипт. Эта технология позволяет:

Павел Жданович, доцент Волгоградского государственного социально-педагогического университета, поделился опытом внедрения языка программирования Asymptote в образовательный процесс вуза. Решение позволяет генерировать векторные изображения (в том числе 3D и анимации) через код. Особенности Asymptote:

Проект используется для построения чертежей и визуализации задач, освоения генерации кода и компьютерной графики. Программист Алексей Фитисов представил комплекс отечественных цифровых решений, которые позволяют незрячим пользователям полноценно обучаться и работать в ИТ-сфере. В него входят:

Представленный комплекс отечественных технологий формирует практическую основу для IT-образования и трудоустройства незрячих специалистов в России. Докладчик сам является незрячим и работает разработчиком в «Базальт СПО». Павел Митрофанов, студент МИФИ, рассказал про применение нейросетей для обработки аудио в реальном времени. Он разработал StudioFx — прототип системы, которая в реальном времени подавляет шумы, распознаёт речь и классифицирует звуковые команды. Проект содержит:

PipeWire захватывает звук с микрофона и передает данные в Gstreamer. Далее аудиопоток передается в RNNoise для обработки данных в реальном времени. Чтобы избежать задержек и сбоев, использовались кольцевые буферы для захвата звука, очереди без блокировок и группировка кадров. Проект ещё в разработке, но в планах сделать StudioFx доступным на всех платформах. На стендах показали VR-игры на Linux и решения для образованияВ перерывах между докладами участники могли поиграть в VR-игры через PortProton, увидеть ALT Mobile на нескольких портативных устройствах и телефонах, ознакомиться с решением ALT Atomic и с обновлённой версией ОС «Альт Рабочая станция» с графической оболочкой GNOME. Были представлены стенды с операционной системой для образовательных организаций ОС «Альт Образование». На стенде «Альт Академии» участникам рассказали о курсах и сертификации специалистов в области сетевого и системного администрирования. «Р7-Офис» продемонстрировали функции офисных пакетов, а на стенде RunaWFE можно было подробнее ознакомиться с мобильной версией приложения для управления бизнес-процессами. Запись трансляции конференции доступна на канале «Базальт СПО».

26.02.2026 [17:02], Руслан Авдеев

Meta✴ установит более 800 газовых генераторов для питания своего ИИ ЦОД в ТехасеСтроящийся в Эль-Пасо (El Paso, Техас) 1-ГВт дата-центр Meta✴ получит частично автономное питание от не менее 813 модульных газовых генераторов общей мощностью 366 МВт и стоимостью $473 млн, сообщает Datacenter Dynamics. Ввод в эксплуатацию запланировали на 2027 год. Предполагается, что в течение пятилетнего «переходного периода» Meta✴ покроет все расходы, связанные с новыми генерирующими мощностями, а кампус всё это время будет оставаться без подключения к местной энергосети. В конце 2023 года появились сведения о том, что Meta✴ намерена воспользоваться участком в Эль-Пасо при посредничестве дочерней WurldWide LLC с приобретением более 404 га на северо-востоке города. На первом этапе в строительство инвестируют около $1,5 млрд. Ранее появилась информация, что речь может идти даже о пяти этапах строительства, в ходе каждого из которых появятся более 74 тыс. м2 площадей. Кампус спроектирован как для поддержки серверов общего назначения, так и для ИИ-оборудования будущего, предусмотрена жидкостная система охлаждения замкнутого цикла, которая обойдётся без использования питьевой воды «большую часть года». Новый кампус станет уже третьим объектом ЦОД Meta✴ в Техасе. Компания уже располагает дата-центрами в Форт-Уэрте и Темпле. Кроме того, неподалёку в Аризоне и Нью-Мексико, она управляет ЦОД в Лос-Лунасе (Los Lunas) и Месе (Mesa) соответственно. Против проекта в Эль-Пасо выступили экологические активисты и другие НКО, призвавшие город и коммунальные предприятия расторгнуть соглашения с Meta✴, поскольку та обещала перейти на «чистые» технологии и возобновляемую энергию, однако на деле в контрактах «прописалась» импровизированная газовая электростанция. При этом Техас богат не только природным газом, в штате высокий потенциал развития солнечной и ветроэнергетики. Недавно сообщалось, что ИИ ЦОД используют всё больше экологически небезопасных газовых турбин, к операторам таких объектов есть даже иски. При этом традиционные газовые электростанции возводятся дольше, но зато считаются более экологичными и к тому же могут питать не только ЦОД — для гигаваттного кампуса Hyperion компания выбрала этот путь.

26.02.2026 [13:30], Руслан Авдеев

Amazon захотела пристроить крупный ЦОД к АЭС Comanche Peak в ТехасеКомпания Amazon намерена построить ещё один дата-центр в Техасе. На этот раз речь идёт об объекте в непосредственной близости от атомной электростанции, сообщает Datacenter Dynamics. На днях окружной суд Сомервелла (Somervell) подал ходатайство о заключении договора о развитии с дочерней структурой Amazon — Amazon Data Services. При её посредничестве Amazon осуществляет большую часть операций, связанных с рынком ЦОД. Предлагаемый проект предлагают реализовать на землях компании Vistra, прилегающих к АЭС Comanche Peak. В соответствии с данными из заявки на получение налоговых льгот, проект предусматривает строительство до 18 двухэтажных строений на площади около 176 га. Объём инвестиций составит порядка $5 млрд. По данным техасских СМИ, строительство может стартовать уже в 2027 году. Детали соглашения пока хранятся в секрете, но уже есть данные, что оно предусматривает выплату округу $2,5 млн после начала строительства и ещё по $300 тыс. за каждое здание. АЭС Comanche Peak мощностью 2,4 ГВт введена в эксплуатацию в 1974 году. Оператором выступает дочерняя структура Vistra — Luminant Generation. Станция находится в Соммервелле, граничащим с округом Худ (Hood). Amazon уже взаимодействует с властями последнего в рамках инициативы Project Spectrum, предусматривающей строительство кампуса ЦОД на территории площадью более 511 га, который тоже может быть запитан от Comanche Peak. Округ Худ привлекает пристальное внимание инвесторов и застройщиков. Sailfish намерена построить крупный объект на площади более 809 га и мощностью 5 ГВт, тоже недалеко от атомной электростанции. MARA занимается майнингом в том же округе, а Pacifico Energy планирует «несетевой» проект газовой энергетики, предназначенный для снабжения энергии дата-центров на территории Худа. Впрочем, единого мнения относительно разрешения строительства новых ЦОД среди местных властей нет. Ранее Amazon (AWS) приобрела кампус ЦОД, расположенный в непосредственной близости от АЭС Susquehanna в Пенсильвании (США). Изначально компания пыталась запитать ЦОД напрямую от АЭС, но власти и регуляторы не одобрили сделку. Тем не менее, планируется значительное расширение кампуса. Летом 2025 года также сообщалось, что компания инвестирует $20 млрд в развитие ИИ ЦОД в Пенсильвании и $10 млрд в Северной Каролине.

26.02.2026 [07:49], Владимир Мироненко

«Базис» увеличил годовую выручку до 6,3 млрд рублей — почти треть теперь приходится на комплементарные решенияКомпания «Базис», специализирующаяся на разработке ПО для организации динамической инфраструктуры, создания виртуальных рабочих мест и оказания облачных услуг, сообщила консолидированные финансовые результаты по стандартам МСФО за 2025 год. Выручка «Базиса» выросла год к году на 37 % до 6,3 млрд руб., что соответствует прогнозу компании, предоставленному в ноябре 2025 года. Рост выручки был достигнут за счёт увеличения продаж лицензий и роста числа подписок. Доля выручки от лицензий и подписок составила 91 %, в то время как на техническую поддержку приходится 8 % в объёме выручки, а на прочие услуги — около 1 %. При этом выручка от флагманских продуктов, включая решения для серверной виртуализации и виртуализации рабочих мест, выросла на 22 % до 4,2 млрд руб. Выручка от комплементарных решений, дополняющих экосистему продуктов «Базиса», выросла на 83,6 %, с 1,1 до 2,0 млрд руб., в результате чего их доля в выручке увеличилась с 24 до 32 %. К комплементарным продуктам относится ПО в области контейнеризации, резервного копирования, защиты виртуальных сред, автоматизированной миграции, а также программно-определяемых хранилищ (SDS) и сетей (SDN) и другие решения. Чистая прибыль выросла на 8,6 % до 2,22 млрд руб. Рентабельность чистой прибыли составила 35 % в сравнении с 44 % годом ранее. Количество клиентов выросло на 19 % до 248, а персонал увеличился на 37 % до 500 человек. В 2026 году компания ожидает увеличения выручки на 30–40 %. «Ключевым драйвером нашего роста в 2025 году стала последовательная реализация стратегии развития продуктовой экосистемы. Она заключается в совершенствовании флагманских продуктов и масштабировании комплементарных решений, доля которых в выручке превысила треть от всех доходов компании», — заявил глава ПАО «ГК «БАЗИС». Он подчеркнул, что 38 % выручки компании составили рекуррентные продажи, «что делает рост более качественным и устойчивым в долгосрочной перспективе, сглаживает сезонность и обеспечивает предсказуемость денежных потоков».

25.02.2026 [19:13], Андрей Крупин

«Группа Астра» представила комплексное решение для создания VDI-инфраструктур«Группа Астра» сообщила о доступности заказчикам единой лицензии Termidesk Enterprise, позволяющей компаниям развернуть инфраструктуру виртуальных рабочих столов (Virtual Desktop Infrastructure, VDI) любой сложности на базе интегрированных продуктов виртуализации из экосистемы вендора. В составе Termidesk Enterprise представлены три программных продукта. Первый — мультиплатформенное решение Termidesk VDI для создания виртуальных рабочих мест с защищённым доступом к рабочим окружениям, корпоративным данным и приложениям. Второй — разработка класса Application Delivery Controller (ADC) Termidesk Connect, выполняющая функции безопасного шлюза доступа к инфраструктуре. Третий — это масштабируемая платформа управления аппаратной и контейнерной виртуализацией VMmanager. Она играет роль поставщика вычислительных ресурсов и позволяет сделать весь IT-ландшафт более устойчивым.

Источник изображения: ThisisEngineering / unsplash.com Инструментарий Termidesk Enterprise ориентирован на широкую аудиторию — от государственного сектора и крупных корпораций, реализующих программы импортозамещения ПО, до предприятий малого и среднего бизнеса. Решение может применяться как для развёртывания классических VDI- и высоконагруженных 3D-VDI-инфраструктур в корпоративной среде, так и для работы с терминальными серверами, организация безопасного удалённого доступа к физическим компьютерам без сторонних продуктов-аналогов TeamViewer и решения прочих задач. Представленные в составе Termidesk Enterprise продукты зарегистрированы в реестре российского ПО и могут использоваться с целью импортозамещения зарубежных софтверных решений.

25.02.2026 [17:31], Владимир Мироненко

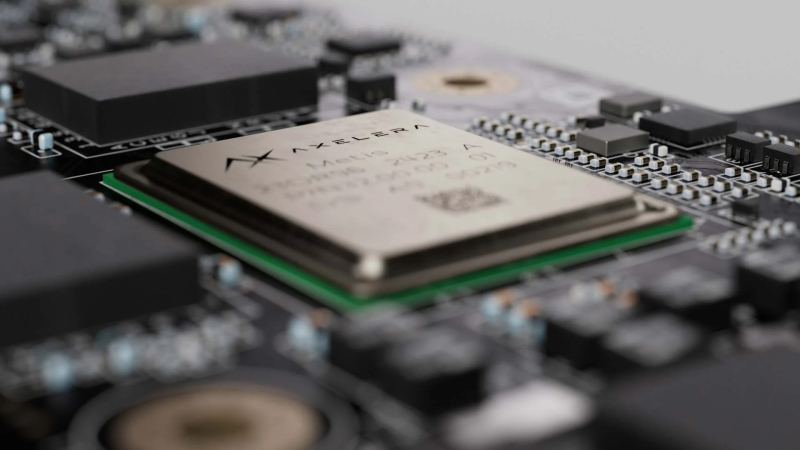

Axelera AI привлекла $250 млн для разработки европейских ИИ-чиповПроизводитель ИИ-чипов Axelera AI из Эйндховена (Нидерланды) привлёк $250 млн в рамках раунда финансирования, который возглавил европейский венчурный фонд Innovation Industries. Наряду с имеющимися инвесторами в нём также приняли участие BlackRock и SiteGround Capital в качестве новых инвесторов. Это одна из крупнейших инвестиций на сегодняшний день в европейскую компанию по производству ИИ-чипов, отметило агентство Reuters. Генеральный директор Фабрицио Дель Маффео (Fabrizio Del Maffeo) указал в своём заявлении, что компания использует привлечённые средства для расширения производства своего чипа Europa, запуск которого запланирован до июня, а также для дальнейшей разработки ПО, упрощающего использование чипов для клиентов. У Axelera «большой портфель возможностей, требующих инвестиций, и этот портфель растет», — заявил Фабрицио Дель Маффео в интервью Bloomberg. По его словам, клиенты ищут более доступные вычислительные ресурсы, более высокую эффективность и способы сокращения расходов на дорогостоящую ИИ-инфраструктуру. Дель Маффео сообщил, что инференс может осуществляться на децентрализованной архитектуре, которая потребляет меньше энергии. Большие потребности крупных ЦОД в энергии, необходимой для обеспечения вычислительных мощностей для обучения ИИ-моделей, подвергаются критике на фоне опасений по поводу перегрузки электросетей и резкого роста цен на электроэнергию для потребителей, отметил Bloomberg. С момента основания в июле 2021 года Axelera AI привлекла более $450 млн в виде акционерного капитала, грантов и венчурного кредитования. В частности, в марте 2025 года Axelera получила грант в размере €61,6 млн ($66 млн) от EuroHPC JU в рамках проекта Digital Autonomy with RISC-V for Europe (DARE) по разработке передового чипа Titania для использования в так называемых ИИ-фабриках. Ожидается, что этот чип появится в 2027 году. Компания отметила, что финансовый раунд прошёл в тот момент, когда она начала поставки своему 500-му глобальному клиенту в области физического и периферийного ИИ в таких отраслях, как оборона и общественная безопасность, промышленное производство, розничная торговля, агротехнологии, робототехника и безопасность. По словам Axelera AI, её клиентская база за последний год увеличилась более чем втрое.

25.02.2026 [16:39], Руслан Авдеев

STACK и AWS построят за $12 млрд «ответственный» ИИ ЦОД на северо-западе ЛуизианыSTACK Infrastructure обнародовала планы строительства многопрофильного дата-центра стоимостью $12 млрд на северо-западе Луизианы — в округах Каддо (Caddo Parish) и Божер (Bossier Parish). Партнёром компании выступила Amazon при поддержке региональных представителей публичного сектора, сообщает Converge Digest. По данным STACK, скоординированные инвестиции в несколько кампусов расширят возможности местной цифровой инфраструктуры и выступят драйверами экономической активности в регионе в долгосрочной перспективе. Проект связан с кампусами по обоим берегам Ред-Ривер (Red River). Планируется поддержка ИИ ЦОД и облачных мощностей нового поколения. После ввода кампусов в эксплуатацию будет обеспечено более 540 рабочих мест на постоянной основе, с полной занятостью. Местные власти заявляют, что новые объекты принесут в бюджет штата и муниципалитетов миллионы долларов. Кроме того, будет финансироваться и модернизация местной инфраструктуры, в т.ч. систем водоснабжения, водоотведения и электроснабжения. STACK намерена финансировать все инфраструктурные расходы, необходимые для поддержки работы ЦОД. При развитии будут учитываться имеющиеся мощности коммунальных компаний и уже запланированные улучшения энергосистемы. Эти шаги направлены на повышение надёжности и обеспечение долгосрочной стабильности местных тарифов. Дополнительно в соответствии с принципами «ответственного строительства» STACK будут внедряться программы оптимизации водопотребления.

Источник изобрапжения: Michael Sanchez/unsplash.com AWS и другие поставщики облачных сервисов активно диверсифицируют географическое присутствие за пределами классических рынков ЦОД вроде Северной Вирджинии, осваивая вторичные рынки, где есть земля, энергия, ВОЛС и прочая инфраструктура. STACK Infrastructure уже создала глобальную сеть ЦОД в Северной Америке, EMEA и Азиатско-Тихоокеанском регионе. Компания предлагает решения под заказ для гиперскейлеров и ИИ-сервисов. Основная специализация — на крупномасштабных кампусах с поэтапными схемами расширения. В последние годы компания расширила присутствие в Северной Вирджинии, Кремниевой долины, Портленда, Торонто, Милана, Осло и Токио, с акцентом на регионы с доступом к возобновляемыми источниками энергии, высокой плотностью оптоволоконных сетей, а также налаженным контактам с коммунальными структурами, способными обеспечить энергией высокопроизводительные ЦОД. Так, помимо проекта STACK-Amazon, Meta✴ строит гигаваттный ИИ ЦОД Hyperion в округе Ричленд (Richland Parish), для которого построят ЛЭП за $1,2 млрд и газовую электростанцию, а прочие операторы дата-центров рассматривают использование площадок на севере Луизианы, связанных с региональной инфраструктурой передачи данных и расположенных недалеко от технопарка National Cyber Research Park в округе Божер.

25.02.2026 [14:03], SN Team

Омниканальная коммуникационная платформа МТС Exolve включена в Реестр российского ПОКомпания МТС Exolve, предлагающая отечественный конструктор омниканальных диалогов для бизнеса и принадлежащая ПАО «МТС», сообщила, что её одноименная коммуникационная платформа была включена в Реестр российского ПО. Платформа зарегистрирована в категории «Программное обеспечение для решения отраслевых задач в области информации и связи». Единый реестр российских программ для электронных вычислительных машин и баз данных (Реестр российского ПО) — это система учета программ российского происхождения. Включение в реестр требует, чтобы правообладатель был из РФ, а ПО работало без использования иностранных компонентов. Продукты, находящиеся в реестре, гарантируют компаниям надёжность, соответствие стандартам безопасности и долгосрочную стабильность. Они всегда доступны на российском рынке вне зависимости от внешних факторов. Цифровая платформа МТС Exolve была запущена в январе 2023 года. Она позволяет бизнесу интегрировать различные каналы связи (звонки, SMS, мессенджеры, роботы) в свои приложения и CRM-системы через API. Благодаря платформе можно автоматизировать общение с клиентами, анализировать его и выстраивать сложные сценарии звонков, в том числе с использованием роботов и виртуальной АТС. «Платформа коммуникационных решений МТС Exolve — это актуальный ответ современным задачам бизнеса в области коммуникаций с клиентами. Над ее созданием работала большая команда, учитывала задачи и потребности бизнеса, который искал решение, позволяющее в режиме «единого окна» осуществлять, контролировать и повышать эффективность общения с клиентами. — говорит генеральный директор МТС Exolve Рамиль Биккужин. — Наша платформа — уникальный продукт на рынке, который по своим качествам не уступает, и даже наоборот, во многом превосходит зарубежные аналоги. Включение в реестр — это не только признание заслуг команды разработки, но и подтверждение ожиданий наших клиентов, которые повышают эффективность своих коммуникаций, используя сервисы, отвечающие самым современным требованиям». Платформа МТС Exolve и другие сервисы из реестра избавляют компании от зависимости от иностранных разработчиков и минимизируют риски для бизнеса, позволяя строить долгосрочные планы, не меняя инструменты. |

|