Материалы по тегу: ии

|

25.03.2025 [18:00], Татьяна Золотова

Минцифры РФ: уровень использования госкомпаниями отечественного ПО превышает 80 %В России уровень использования госкомпаниями и госорганизациями, включенными в реализацию стратегий цифровой трансформации, отечественного программного обеспечения (ПО) превышает 80 %. Об этом сообщили «Известия» со ссылкой на Министерство цифрового развития России (Минцифры). В Минцифры отметили, что «сейчас компании все чаще отдают предпочтение российским решениям». При этом требование по госзакупкам отечественного ПО и операционной системы (ОС) действует с 2016 года. В марте 2025 году глава Минцфиры сообщал, что больше ⅔ субъектов критической информационной инфраструктуры (КИИ) перешли на отечественное ПО. Так, «Ростелеком» в марте перевел виртуальную серверную инфраструктуру на платформу Basis Dynamix. Сам процесс миграции с иностранной платформы VMWare начался в 2023 году. Эксперты iKS-Consulting подсчитали, что с конца 2021 года по конец 2024 года отечественные решения серверной виртуализации занимают 60,2 % рынка РФ, а на долю VMware приходится 39 %. При этом треть российских предприятий сохраняют потребность в переходе на отечественные ИТ-продукты, а каждая пятая компания заявляет о нехватке квалифицированных ИТ-специалистов и эффективных решений в сфере кибербезопасности. В конце прошлого года крупные компании все еще просили отсрочить переход на отечественное ПО объектов КИИ.

25.03.2025 [17:08], Сергей Карасёв

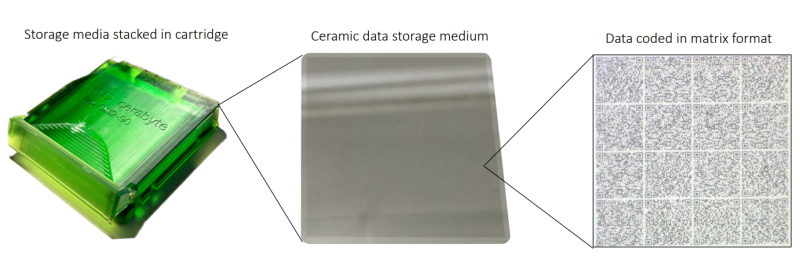

Керамические накопители Cerabyte заинтересовали In-Q-Tel, инвестирующую в перспективные технологии в интересах ЦРУ и др.Немецкая компания Cerabyte, специализирующаяся на разработке систем хранения данных на основе керамики, объявила о привлечении инвестиций со стороны компании In-Q-Tel (IQT), косвенно связанной с американскими спецслужбами. Полученные средства пойдут на ускорение создания продуктов, которые будут поставляться государственным заказчикам. Объём вложений со стороны IQT не раскрывается. Технология Cerabyte предполагает применение стекла или плёнки с тонким керамическим покрытием. Информация записывается при помощи лазера в виде наноразмерных «ямок» по аналогии с QR-кодами: заявленная скорость достигает 2 млн бит на лазерный импульс. Считывание также осуществляется посредством лазера. Одним из ключевых преимуществ технологии Cerabyte является долговечность: данные на таких накопителях могут храниться практически неограниченное количество времени, заявляет компания. Кроме того, обеспечивается высокая ёмкость: по заявлениям разработчика, технология до 2030 года позволит добиться вместимости до 100 Пбайт на стойку при использовании картриджей CeraMemory. In-Q-Tel — американская некоммерческая венчурная фирма, базирующаяся в Арлингтоне (Вирджиния). Она инвестирует в перспективные компании с тем, чтобы обеспечить ЦРУ и другие структуры США передовыми технологическими разработками. Ожидается, что американский государственный сектор будет оперировать огромными объемами данных, сопоставимыми с теми, которыми управляют ведущие интернет-корпорации, включая Meta✴ и Amazon. Причём основная часть такой информации у госструктур будет находиться в «холодном» хранилище в течение длительных периодов времени. Таким образом, технология Cerabyte обеспечит эффективное решение как с точки зрения долговечности, так и с точки зрения вместимости. Нужно отметить, что ранее Cerabyte привлекла инвестиции от компании Pure Storage, которая занимается разработкой All-Flash СХД. Кроме того, Cerabyte получила финансовую поддержку в рамках программы-акселератора Европейского совета по инновациям (EIC).

25.03.2025 [16:45], Руслан Авдеев

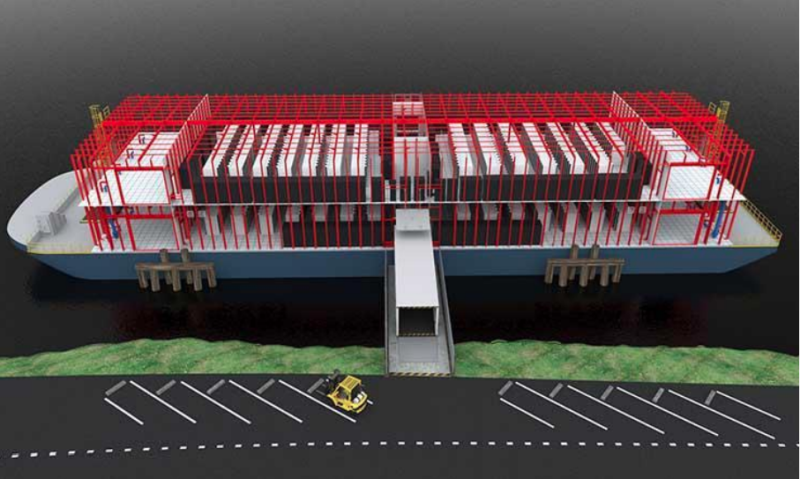

В России началась разработка проекта плавучих дата-центровВ России ведутся работы по проектированию плавучих дата-центров. Предполагается, что такие ЦОД можно развернуть значительно быстрее наземных вариантов, при этом они будут на 20–30 % дешевле в строительстве, сообщают «Известия» со ссылкой на пресс-службу Национальной технологической инициативы (НТИ). Описание проекта имеется на портале «Университета 20.35», связанного с НТИ, и некоторых других ресурсах. Работы ведутся не первый год. По словам авторов проекта, наземные ЦОД нередко сталкиваются с проблемами ещё на этапе строительства, в результате чего проекты могут свернуть из-за нехватки или высокой стоимости земли, удалённости площадки от доступной инфраструктуры, высоких тарифов на электричество, больших затрат на охлаждение и др. Особенными зонами риска для России считаются Арктическая зона, Сибирь и Дальний Восток. Кроме того, по словам экспертов, традиционный дата-центр может быть разрушен или повреждён из-за природных или техногенных катаклизмов. Фактически речь идёт об использовании несамоходных барж или самоходных судов с установленной инфраструктурой ЦОД. Их преимуществом является возможность быстро сменить локацию, чтобы быть ближе к источникам данных, и даже юрисдикцию, в том числе на время. Управление флотом плавучих дата-центров может осуществляться с помощью единой платформы оркестрации. Плавучий ЦОД можно быстро переместить к месту назначения водными путями, а для охлаждения оборудования использовать забортную воду. Энергия может поступать как от наземных электростанций, так и от автономных — например, от расположенных на самих судах мини-АЭС. По последним данным, авторы проекта приступили к эскизному проектированию плавучих ЦОД и подбору необходимых для реализации проекта технологий. Потенциальные заказчики — государственные корпорации, министерства и другие структуры, а также крупные бизнес-пользователи и даже иностранные государства, у которых имеются пригодные для развёртывания плавучих ЦОД водные ресурсы и ограничения по строительству наземной инфраструктуры — вроде Сингапура, где аналогичным проектом занимается Keppel Data Centres. Авторы проекта считают, что плавучие ЦОД могли бы быть интегрированы в инфраструктуру Севморпути или даже стать майнинговыми фермами в местах, где стоимость энергии невелика, а электростанции недостаточно загружены. Также ЦОД могут стать базами для хранения и обработки информации при совместном использовании парка беспилотников и безэкипажных судов. Результатом строительства может стать укрепление технологического суверенитета России, в том числе в сфере хранения и обработки критически важных для страны данных. Стоит отметить, что плавучие дата-центры уже довольно активно развиваются по всему миру. Так, ещё в октябре 2024 года французский стартап Denv-R запустил плавучий 200-кВт дата-центр на Луаре, а в ноябре того же года сообщалось, что Nautilus намерена продать уникальный плавучий ЦОД в Калифорнии. А Del Complex придумала, как обойти санкции и ограничения для ИИ в отдельных регионах — предполагается строительство модульных плавучих структур, имеющих почти государственный уровень суверенитета.

25.03.2025 [15:55], Татьяна Золотова

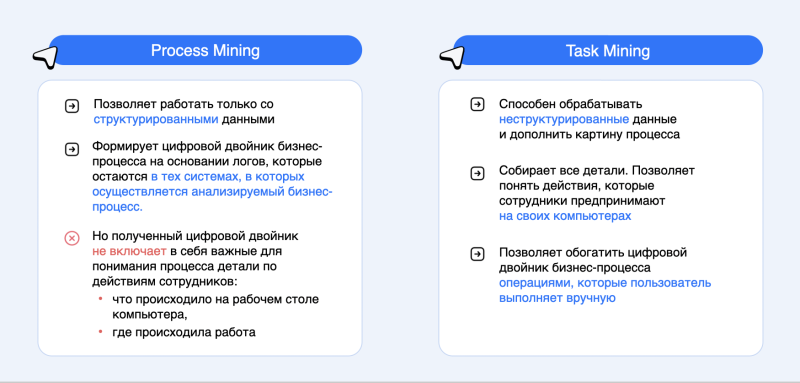

VK Task Mining расширил возможности платформы VK Process MiningVK Tech анонсировала продукт VK Task Mining — решения для анализа и оптимизации рабочих процессов внутри компании, которые помогут автоматизировать бизнес-процессы, сократив их время и стоимость. Новый инструмент является частью платформы процессной аналитики VK Process Mining, которая анализирует данные из корпоративных систем. Об этом сообщила пресс-служба компании. VK Task Mining собирает данные о рутинных действиях пользователей, анализирует информацию, объединяет ее с бизнес-данными и строит цифровую модель рабочего дня. На основе этой информации можно применить технологию RPA (Robotic Process Automation) или избежать ненужных действий. Это позволяет компаниям оценивать стоимость операций, управлять загрузкой персонала и минимизировать операционные риски. Система также маскирует или исключает конфиденциальные данные из мониторинга, а встроенные BI-дашборды обеспечивают глубокую аналитику рабочих процессов. По итогам сбора и обработки логов формируется интерактивная отчетность. Встроенное браузерное расширение позволяет извлекать дополнительный бизнес-контекст из веб-страниц. VK Task Mining состоит в реестре российского ПО. В 2025 году будет введена поддержка Linux и Mac OS. VK Process Mining — платформа процессной аналитики для управления процессами и показателями бизнеса в режиме реального времени. Как поясняют в компании, с ее помощью можно визуализировать реальные процессы и сравнить их с регламентами, выявить узкие места, предотвратить связанные с ними риски, а также определить потенциал для автоматизации.

25.03.2025 [12:52], Сергей Карасёв

«Скала^р» представила Машину для искусственного интеллекта — отечественный аналог NVIDIA DGX SuperPODКомпания «Скала^р» анонсировала специализированный программно-аппаратный комплекс (ПАК) для работы с ИИ-моделями — Машину Скала^р МБД.ИИ. Эта система, как утверждается, представляет собой функциональный аналог платформ NVIDIA DGX SuperPOD и Huawei Atlas 900 PoD. Полностью технические характеристики новинки пока не раскрываются. Известно, что Машина Скала^р МБД.ИИ использует интерконнект NVLink с возможностью объединения двух, четырёх или восьми ускорителей. Задействованы технологии GPUDirect и NVMe-oF для обработки и передачи данных, а также система прямого доступа к ресурсам RDMA. Заявлена поддержка всех популярных фреймворков для машинного обучения: TensorFlow, PyTorch, Keras и др. Вычислительный комплекс будет предлагаться в конфигурациях с ускорителями NVIDIA и в вариантах с альтернативными ИИ-картами, в том числе на основе неназванных тензорных процессоров. Кроме того, в разработке находятся решения с поддержкой отечественных ускорителей. Возможно развёртывание системы как в дата-центре заказчика, так и в составе частных и гетерогенных облачных систем. Машина может интегрироваться с другими ПАК семейства Скала^р, предназначенными для работы с большими данными. Для нового комплекса подтверждена совместимость с различными платформами машинного обучения и моделями ИИ, в том числе MTS AI Cotype Pro, T1 Сайбокс, Red_Mad_Robot Neuraldeep.tech, WaveAccess ValueAI, DeepSeek и LLaMA. По заявлениям разработчика, система имеет гибкую унифицированную архитектуру, соответствующую отраслевым стандартам, что позволяет использовать её с YandexGPT, GigaChat и др. Развёртывание приложений ИИ в контейнерной среде обеспечивает эффективное использование аппаратных ресурсов, а реализация интерконнекта с применением топологий Fat-tree, HyperCube, DragonFly или классической архитектуры Leaf-Spine даёт возможность более гибко масштабировать вычислительный кластер. Среди преимуществ Машины Скала^р МБД.ИИ названы:

«Машина Скала^р МБД.ИИ позволяет создать надёжную и производительную инфраструктуру для работы с искусственным интеллектом, используя проверенные технологии и компоненты из реестра Минпромторга и Минцифры РФ с подтверждённой производительностью до 1,5 Пфлопс на вычислительный кластер. Мы видим большой потенциал применения комплекса в различных отраслях экономики, включая промышленность и финансы, где использование ИИ помогает существенно повысить эффективность бизнес-процессов», — говорит директор по технологическим инновациям Скала^р.

25.03.2025 [11:40], Сергей Карасёв

«Ростелеком» перевел инфраструктуру на российскую платформу Basis Dynamix

mind software

software

базис

виртуализация

импортозамещение

миграция

россия

ростелеком

сделано в россии

«Ростелеком», крупнейший в России интегрированный провайдер цифровых услуг и решений, перевел виртуальную серверную инфраструктуру на платформу Basis Dynamix — флагманский продукт ИТ-разработчика «Базис». Отказ от зарубежного программного решения реализован в рамках выполнения требований по импортозамещению и достижению технологического суверенитета. С точки зрения качества предоставляемых решений экосистема «Базиса» соответствует ведущим мировым аналогам в области инфраструктурных сервисов. Процесс миграции с иностранной платформы VMWare начался в 2023 году с корпоративного центра и семи макрорегиональных филиалов «Ростелекома» по всей стране с более чем 120 тыс. сотрудников. На данный момент завершен перевод свыше 15 тыс. виртуальных серверов целевых информационных систем. Basis Dynamix включен в реестр отечественного ПО и полностью соответствует требованиям государства в части надежности и безопасности. Переход на платформу позволяет «Ростелекому» масштабировать и оптимизировать ИТ-инфраструктуру, снижая операционные затраты на лицензирование и техническую поддержку. В то же время механизмы балансировки нагрузки и автоматического перераспределения ресурсов повышают эффективность использования оборудования и управления вычислительными ресурсами и хранилищем данных. Платформа обладает встроенными механизмами шифрования, аутентификации и контроля доступа, а также сертифицирована по четвертому уровню доверия на соответствие требованиям ФСТЭК к средствам виртуализации. Basis Dynamix поддерживает API для интеграции с внешними системами и сервисами, что дает «Ростелекому» дополнительные возможности для автоматизации и управления ИТ-ресурсами. Для успешной миграции на Basis Dynamix «Ростелеком» использует набор программных инструментов от компании MIND Software, одного из технологических партнеров «Базиса». Решение позволяет производить перенос без ошибок и с минимальным простоем. В условиях сложной географически распределенной инфраструктуры за счет автоматизации процедуры удалось достичь высокого темпа миграции — до 300 виртуальных серверов в неделю. Благодаря использованию инструментов MIND Software «Ростелеком» получил возможность не только разово мигрировать на отечественную платформу, но и на постоянной основе перераспределять виртуальные рабочие нагрузки в рамках одного или нескольких кластеров виртуализации. Такой подход значительно расширяет функциональность используемой платформы виртуализации и позволяет избежать технологических простоев в ходе ее эксплуатации. Кирилл Песчаный, вице-президент, директор по ИТ-эксплуатации и инфраструктуре «Ростелекома»: «Процесс миграции на платформу Basis Dynamix с минимальными простоями критически важен для большинства информационных систем. Одновременная миграция большого количества виртуальных машин потребовала автоматизированных инструментов, благодаря которым весь проект миграции поддерживает команда всего из десяти инфраструктурных инженеров с нашей стороны и со стороны технологических партнеров. Вручную этот процесс потребовал бы существенно больше времени и сотрудников, и в целом был бы многократно сложнее в планировании и организации. Особенно хочется отметить глубокую вовлеченность и гибкость команды „Базиса“, благодаря которой удавалось решать самые сложные проблемы в процессе миграции и оперативно получать необходимые обновления для адаптации платформы к гетерогенному ландшафту „Ростелекома“». Давид Мартиросов, генеральный директор «Базиса»: «У „Базиса“ была возможность рассмотреть импортозамещение как со стороны вендора, так и со стороны заказчика, что позволило нам разработать оптимальную стратегию перехода и полностью исключить проблемы совместимости. Переход огромной инфраструктуры „Ростелекома“ с тысячами активных сервисов и миллионами клиентов можно по праву считать масштабным вызовом, который стал успешным кейсом. Знаем, что многие игроки рынка изучают наш опыт и внедряют аналогичную инфраструктуру на своих площадках, что особенно ценно для нас как для лидера рынка». Антон Груздев, технический директор MIND Software: «Благодаря открытой вовлеченной работе специалистов „Ростелекома“ и постоянной обратной связи от них, мы с коллегами из „Базиса“ смогли быстро адаптировать наше решение к особенностям инфраструктуры и условиям эксплуатации, добавить необходимые функции. Это позволило своевременно вывести проект на необходимый заказчику темп миграции».

25.03.2025 [08:45], Руслан Авдеев

Бум ИИ превратил азиатские проекты ЦОД в «магнит» для инвесторовРазвитие систем искусственного интеллекта (ИИ) подпитывает ажиотаж, связанный со строительством азиатских дата-центров. В результате на континенте выдана серия рекордных кредитов на создание ЦОД, ещё больше сделок может быть заключено в будущем, сообщает Bloomberg. Только за неделю два крупных азиатских оператора ЦОД получили самые значимые в своей истории кредиты, частично предназначенные для расширения проектов в Малайзии, намеренной стать новым региональным хабом для дата-центров. Сам факт таких крупных сделок свидетельствует о росте привлекательности отрасли для инвесторов, бум ИИ стимулирует их интерес. Также сделки стали своеобразным маркером того, что Азия становится одним из ключевых рынков ЦОД. Как прогнозирует Cushman and Wakefield, спрос будет расти на 32 % ежегодно до 2028 года. Это выше, чем предполагаемый рост в США (CAGR 18 %), хотя в начале 2024 года прогнозы были более скромными. По данным юридической компании Morrison Foerster, рост спроса на ЦОД вызвал интерес у пула инвесторов по всему Азиатско-Тихоокеанскому региону (АТР). Если раньше инвесторами выступали в основном банки, то теперь появились частные кредитные и инфраструктурные фонды. Среди недавних инициатив — проект компании Bridge Data Centres, принадлежащей Bain Capital. Она получила в кредит $2,8 млрд для развития в Малайзии, а DayOne (ранее GDS International) привлекла заём, эквивалентный $3,4 млрд. Готовятся и новые сделки. Сингапурское подразделение австралийской Firmus Technologies желает получить кредит на $120 млн, а индийская Yotta Data Services договаривается с частными фондами о привлечении около $500 млн для своих парков ЦОД. Боле того, чем сильнее напряжённость между США и КНР, тем активнее транснациональные компании готовы вкладывать средства в ЦОД за пределами Китая. Одним из ключевых бенефициаров наметившейся тенденции стал малайзийский штат Джохор (Johor), граничащий с Сингапуром, где около 30 проектов дата-центров завершены или находятся на стадии строительства, а ещё 20 ожидают одобрения регуляторов. Таиланд одобрил инвестиционные заявки на $5,9 млрд буквально на прошлой неделе, в том числе на проекты в секторе, связанном с ЦОД. Тем не менее, в отрасли царит неопределённость, поскольку США готовят новые пошлины, риск глобальной торговой войны не так уж мал. В числе возможных целей — страны, поставляющие продукцию для индустрии дата-центров (в основном в Азии). Также не исключено нарушение цепочек поставок, в том числе полупроводников. В Morrison Foerster допускают, что геополитические риски могут привести к росту кредитных рисков для финансистов, поэтому те могут потребовать большего вознаграждения или, например, отказаться от проектов, связанных с китайскими структурами. Это потенциально затормозит рост на рынке ЦОД в Юго-Восточной Азии.

25.03.2025 [07:38], Руслан Авдеев

5-ГВт дата-центр Data City в Техасе намерен стать «местом рождения AGI»На участке более 20 тыс. га корпорация Energy Abundance Development Corporation намерена построить кампус ЦОД ёмкостью 5 ГВт, использующий собственные источники энергии. Проект Data City намерены реализовать недалеко от города Ларедо (Laredo) на юго-западе Техаса вблизи от мексиканской границы, сообщает пресс-служба компании. Первые 300 МВт и более 92 тыс. м2 намерены ввести в эксплуатацию в 2026 году. Предполагается, что объект будет работать на «чистой» энергии. Фактически электричество будет поставляться с соседней площадки Hydrogen City, проект которой тоже реализуется Energy Abundance. Первую фазу «водородного города» намерены запустить до 2028 года. Также будут задействованы ветряные и солнечные генераторах, а также природный газ — фактически речь всё же идёт о применении ископаемого топлива, сообщает Datacenter Dynamics. Впрочем, в пресс-релизе компании говорится о постепенном переходе на питание на 100 % за счёт энергии водорода. Компания не сообщала, когда именно она намерена довести мощность ЦОД до 5 ГВт.

Источник изображения: Energy Abundance В Energy Abundance заявляют, что Data City — проект мирового класса, который поможет Америке выиграть «гонку ИИ», одновременно продемонстрировав, как добиться круглосуточных поставок «зелёной» энергии с помощью водорода и хранилищ в соляных пещерах. В компании считают, что именно Data City станет местом рождения AGI — «общего искусственного интеллекта», равного человеческому или превосходящему его. Energy Abundance ранее была известна как Green Hydrogen International. По словам её представителей, управленцы компании имеют большой опыт в развитии крупномасштабных инициатив в глобальной энергетике, а также проектировании генерирующих мощностей «на местах» — она подготовила и построила энергетические проекты по всему миру общей мощностью более 3 ГВт. Энергия водорода уже активно используется компаниями вроде Equinix . Более того, ECL намерена построить гигантский «зелёный» ЦОД TerraSite-TX1 ёмкостью до 2 ГВт (в перспективе), а Microsoft проводит эксперименты по питанию дублинского ЦОД от водородных топливных ячеек GeoPura. Наконец, Modern Hydrogen и Mesa Solutions объединились для выработки водорода из природного газа непосредственно на территории кампуса ЦОД.

24.03.2025 [23:55], Владимир Мироненко

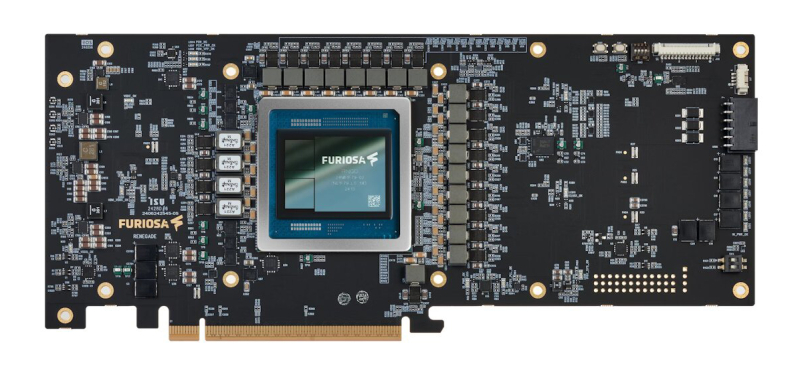

Разработчик ИИ-ускорителей FuriosaAI отказался «влиться» в Meta✴ за $800 млнСтартап FuriosaAI из Южной Кореи, представивший в прошлом году ИИ-ускоритель RNGD для работы с большими языковыми моделями (LLM) и мультимодальным ИИ, отклонил предложение о поглощении со стороны Meta✴ Platforms, которая была готова заплатить за это $800 млн. FuriosaAI намерена и дальше развивать бизнес в качестве независимой компании. Об этом сообщил Bloomberg со ссылкой на информированный источник. По словам собеседника Bloomberg, Meta✴ вела переговоры о приобретении FuriosaAI из Сеула с начала этого года. После того как в феврале появились слухи о возможном поглощении стартапа, начали расти в цене акции его крупнейшего инвестора, южнокорейской венчурной компании DSC Investment, но после известий об отказе их стоимость упала в понедельник на 16 %. Ускоритель RNGD, выполненный по 5-нм техпроцессу компании TSMC и использующий чипы памяти HBM3, поставляемые SK Hynix, способен конкурировать чипами NVIDIA, а также других ИИ-стартапов, включая Groq, SambaNova и Cerebras. Персонал FuriosaAI составляет около 150 сотрудников, включая 15 человек, работающих в офисе в Кремниевой долине. В конце прошлого года стартап начал тестирование RNGD и рассылку образцов чипов клиентам, включая LG AI Research (ИИ-подразделение LG Group) и Saudi Aramco. Сообщается, что более десяти потенциальных клиентов будут тестировать образцы RNGD в I половине этого года. По словам источников, FuriosaAI планирует привлечь дополнительный капитал и лишь потом провести первичное публичное размещение акций (IPO). Ожидается, что примерно через месяц компания завершит расширенный раунд финансирования серии C, который позволит получить намеченную сумму. До этого основанная в 2017 году FuriosaAI привлекла за четыре раунда финансирования $115 млн, пишет Data Center Dynamics. В свою очередь, Meta✴ вкладывает значительные средства в ИИ-инфраструктуру, стремясь опередить конкурентов, включая OpenAI и Google. В январе 2025 года гендиректор Meta✴ Марк Цукерберг (Mark Zuckerberg) заявил, что компания выделит до $65 млрд на развитие ИИ в 2025 году, включая расходы на строительство крупного ЦОД и найм персонала в сфере ИИ. А всего неделю спустя Цукерберг сообщил инвесторам, что Meta✴ планирует потратить сотни миллиардов долларов на инфраструктуру ИИ. Meta✴ также работает над созданием собственных чипов. В 2023 году она представила чип Meta✴ Training and Inference Accelerator (MTIA) для ИИ-нагрузок, а в 2024 году был анонсирован ИИ-ускоритель MTIA второго поколения, втрое превосходящий предшественника по производительности. Сейчас компания ведёт тестирование собственного ускорителя для обучения ИИ-моделей.

24.03.2025 [20:02], Владимир Мироненко

ИИ в один клик: NVIDIA и Equinix предложат готовые к использованию кластеры DGX GB300 и DGX B300 в 45 регионах по всему мируЧтобы удовлетворить растущий спрос на ИИ-инфраструктуру, NVIDIA представила NVIDIA Instant AI Factory — управляемый сервис на базе платформ NVIDIA DGX SuperPOD с ускорителями Blackwell Ultra и ПО NVIDIA Mission Control. NVIDIA сообщила, что её партнёр Equinix станет первой компанией, которая предложит новые системы DGX GB300 и DGX B300 в своих предварительно сконфигурированных ЦОД с жидкостным или воздушным охлаждением, готовых к обработке ИИ-нагрузок и расположенных на 45 рынках по всему миру. Как пишет SiliconANGLE, Тони Пейкдей (Tony Paikeday), старший директор NVIDIA по маркетингу продуктов и систем ИИ, заявил, что партнёрство с Equinix позволит компании выйти на более чем 45 рынков по всему миру «с предварительно настроенными объектами, которые готовы в зависимости от спроса клиентов масштабировать, эксплуатировать и управлять ИИ-инфраструктурой». NVIDIA отметила, что сервис предоставит предприятиям полностью готовые ИИ-фабрики, оптимизированные для обучения современных моделей и рабочих нагрузок моделей рассуждений в реальном времени, что избавит от многомесячного планирования инфраструктуры перед развёртыванием. Поскольку Equinix предоставляет средства и инфраструктуру для разработки ИИ, Пейкдей возлагает большие надежды на платформу SuperPOD и считает, что она окажет позитивное влияние на развёртывание ИИ компаниями. «Equinix — ключевой компонент этой платформы, потому что вам нужно жидкостное охлаждение, вам нужны ЦОД следующего поколения, вам нужны сверхскоростные соединения с внешним миром, чтобы передавать эти данные», — заявил он. |

|