Материалы по тегу: ии

|

27.03.2025 [11:29], Руслан Авдеев

Microsoft отказалась от проектов ЦОД общей ёмкостью 2 ГВтКомпания Microsoft отказалась от некоторых проектов дата-центров в США и Европе совокупной мощностью около 2 ГВт. Об этом сообщает Bloomberg со ссылкой на аналитику TD Cowen, связывающую подобные изменения с «перепроизводством» ИИ-кластеров. Примечательно, что в феврале сообщалось о том, что Microsoft отказалась от аренды ЦОД на «пару сотен мегаватт». Последние изменения могут быть также связаны с отказом Microsoft от некоторых совместных проектов с OpenAI, хотя на этот ИИ-стартап техногигант уже потратил $13 млрд. Не так давно компании сообщили, что изменили соглашение о многолетнем сотрудничестве, что позволило OpenAI использовать облачные сервисы сторонних компаний. Очевидно, что Microsoft сама не желала или не могла развивать сотрудничество. По данным TD Cowen, в последние полгода оптимизация бизнеса Microsoft заключалась в том числе в отказе от арендных обязательств и отложенных проектах. По мнению аналитиков, Google и Meta✴ воспользовались этим для получения дополнительных ёмкостей ЦОД в Европе. Не исключено что отказ связан с невозможностью объектов разместить самые современные ускорители. Так, грядущее поколение суперускорителей NVIDIA Rubin Ultra NVL576 потребует уже 600 кВт на стойку.

Источник изображения: Bermix Studio/unsplash.com В самой Microsoft заявляют, что в текущем финансовом году на строительство ЦОД будет потрачено $80 млрд. Год заканчивается в июне, но после этого рост соответствующего бизнеса компании начнёт замедляться. Как считают в руководстве компании, после стремительного расширения инфрасруктуры для поддержки OpenAI и прочих ИИ-проектов, теперь вместо новых строек средства будут тратиться на дооснащение серверами и оборудованием уже существующих объектов. Ранее на этой неделе Джо Цай (Joe Tsai) предупредил о потенциальном образовании «пузыря» на рынке строительства ЦОД, заявив, что новые проекты могут привести к «перепроизводству» мощностей, превышающему спрос на ИИ-серверы. В TD Cowen также уверены, что отмена и отсрочка аренды мощностей в дата-центрах указывает на их переизбыток из-за более низкого спроса, чем прогнозировалось.

27.03.2025 [09:19], Сергей Карасёв

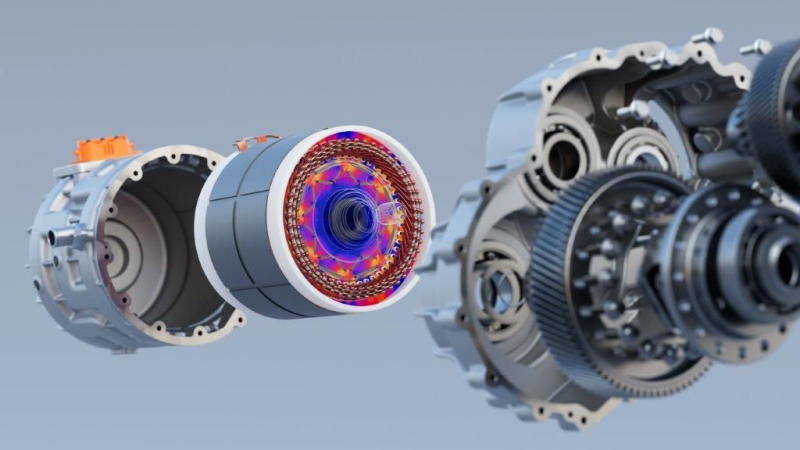

Siemens купила поставщика ПО для промышленного моделирования Altair за $10 млрдНемецкий концерн Siemens объявил о завершении сделки по покупке американской компании Altair Engineering, которая поставляет ПО и облачные решения для промышленного моделирования, интернета вещей (IoT), приложений ИИ и HPC, а также для анализа данных. О сделке было объявлено в конце октября 2024 года. По условиям соглашения, акционеры Altair получат $113 за каждую ценную бумагу, что соответствует премии в размере 19 % к стоимости акций на 21 октября — последний день до появления в СМИ информации о слиянии. Таким образом, общая сумма сделки составила $10 млрд. Благодаря приобретению Altair концерн Siemens рассчитывает укрепить позиции в области промышленного ПО, включая решения на основе ИИ. Немецкая компания намерена расширить возможности платформ для механического и электромагнитного моделирования, высокопроизводительных вычислений, создания цифровых двойников и пр. Утверждается, что все клиенты Siemens — от инженеров до специалистов широкого профиля — получат доступ к новым экспертным знаниям в области моделирования. Это позволит ускорить инновации и цифровую трансформацию компаний всех размеров. Приобретение Altair является частью масштабной инициативы Siemens ONE Tech Company, которая направлена на улучшение эффективности, увеличение прибыли и повышение удовлетворённости клиентов. Ожидается, что сделка значительно увеличит выручку Siemens от цифрового бизнеса, обеспечив прибавку на уровне 8 %. Программа Siemens ONE Tech Company также предполагает инвестиции в НИОКР в таких областях, как передовое ПО, системы с поддержкой ИИ, подключённое оборудование и пр.

26.03.2025 [18:42], Владимир Мироненко

ИТ-холдинг Т1 создаст в этом году СП по производству отечественных серверовВ этом году ИТ-холдинг Т1 планирует создать совместные предприятия, ориентированные на производство ИТ-оборудования, пишет «Интерфакс» со ссылкой на гендиректора компании Алексея Фетисова. Фетисов сообщил, что одно из предприятий будет выпускать серверное оборудование для критической информационной инфраструктуры (КИИ), совместимое с программными продуктами компаний холдинга. Он рассказал, что будущее СП с крупным партнёром, имя которого пока не раскрывается, получит уже работающую производственную площадку, на которой были выпущены первые опытные изделия и сейчас ведётся совместная работа по масштабированию производства. По аналогичной схеме будет также создано СП по выпуску банкоматов совместно с одной крупной ИТ-компанией. Объём инвестиций в эти СП, а также мощность производственных площадок пока не раскрываются. Директор департамента стратегии Т1 Кирилл Чебунин рассказал, что компания также планирует использовать выпускаемое оборудование для специальных программно-аппаратных комплексов (ПАК) для АСУ ТП промышленных предприятий, разработанных центром компетенций «Промышленная автоматизация». По его словам, Т1 считает очень перспективным направление АСУ ТП. Предполагается, что рынок АСУ ТП в России вырастет с 83 млрд руб. до 218 млрд рублей к 2027 году при среднем росте на 27 % в год. По мнению Чебунина, суммарная потенциальная ёмкость рынка в ближайшие 3–4 года будет ещё больше и составит порядка 500 млрд руб. Он пояснил, что в последние 20–30 лет российские промышленные предприятия устанавливали преимущественно зарубежные АСУ ТП, которые теперь предстоит заменить на российские. Т1 была создана на базе активов одной из старейших на российском ИT-рынке компаний «Техносерв». В 2018 году 40 % уставного капитала «Техносерва» приобрёл ВТБ. В марте 2022 года банк продал часть доли в капитале Т1 стороннему инвестору, а в конце прошлого года продал оставшуюся долю в 3,695 % и вышел из состава участников общества. По данным ЕГРЮЛ, на начало 2025 года Т1 напрямую владела 21 ИТ-компанией, включая «Т1 Интеграция», «Т1 Консалтинг», «Т1 Клауд», «МультиКарта», «Иннотех», «Дататех». В настоящее время компания находится в процессе реорганизации и преобразования в АО.

26.03.2025 [12:22], Руслан Авдеев

Выход Cerebras на IPO откладывается из-за нехватки чиновников и подозрениях в тайных связях с Китаем ключевого инвестора компанииАмериканский производитель ИИ-ускорителей Cerebras Systems вынужден отложить выход на биржу. IPO задерживается, поскольку компания пока не получила одобрение со стороны одного из американских регуляторов — Комитета по иностранным инвестициям в США (CFIUS), сообщает Reuters. По информации издания, ссылающегося на пять независимых анонимных источников, руководство Cerebras ждёт завершения рассмотрения заявки, а также назначения новых ключевых чиновников. Без разрешения регулятора IPO невозможно, поскольку среди инвесторов — компания G42 из Абу-Даби (ОАЭ), специализирующаяся на облачных технологиях и ИИ. Ранее американские власти уже уделяли внимание этому инвестору из-за его предполагаемых связей с китайским бизнесом. Cerebras неоднократно заявляла, что её решения не просто превосходят по многим характеристикам ускорители NVIDIA, но и являются более экономически эффективными. Впрочем, именно это сыграло против неё. Технологии Cerebras и их значение для национальной безопасности США стали причиной того, что процесс IPO оказался под вопросом или, как минимум, в центре пристального внимания регуляторов. Главной причиной задержки называется отсутствие действующего помощника министра финансов США по вопросам инвестиционной безопасности, который обычно курирует работу CFIUS. Хотя у сотрудников организации есть определённые полномочия для принятия решений, сделку с G42 сочли «политически рискованной». Источники Reuters предполагают, что чиновники решили не торопиться, дожидаясь назначения человека, готового взять на себя ответственность за окончательное решение. Ранее ожидалось, что инвестициям G42 дадут зелёный свет ещё до конца 2024 года, хотя IPO было решено отложить.

Источник изображения: Cerebras В преддверии возможных сложностей Cerebras и G42 заранее внесли поправки в документы для CFIUS, подчеркнув, что G42 получит лишь акции без права голоса. В теории это должно было упростить одобрение сделки. Однако проблема не решилась: в сентябре 2024 года стороны запросили отмену рассмотрения заявки, но окончательное решение в CFIUS пока так и не вынесли. Как сообщает Silicon Angle, ситуацию усугубляет инициатива администрации нового президента США Дональда Трампа (Donald Trump), активно поддерживаемая Илоном Маском (Elon Musk), по сокращению государственных расходов. В рамках нового плана численность сотрудников различных ведомств, включая CFIUS, уменьшится, что замедлит процесс рассмотрения заявок на сделки. Однако, хотя нынешняя оппозиция пытается возложить ответственность на новую администрацию, G42 стала «проблемным» партнёром намного. Так, в апреле 2024 года Microsoft вложила в G42 средства в объёме $1,5 млрд, из-за чего у властей возник ряд вопросов, касающихся возможных связей арабской компании с Китаем. Пока неизвестно, сколько времени потребуется для урегулирования ситуации, но в Cerebras уверены, что сделку в конечном счёте одобрят и компания возобновит подготовку к выходу на IPO.

26.03.2025 [11:13], Руслан Авдеев

Руководитель Alibaba предупредил о перегреве рынка ИИ ЦОДПредседатель Alibaba Group Джо Цай (Joe Tsai) предупредил, что дата-центров для ИИ может быть построено больше, чем необходимо. В ходе недавнего мероприятия HSBC Global Investment Summit в Гонконге он заявил, что текущие темпы строительства ЦОД могут опередить рост спроса на ИИ-сервисы, сообщает Bloomberg. По данным издания, бизнесмен заявил, что «начинает видеть пузырь некоего вида». Он отметил, что некоторые проекты строительства уже стартовали без заключения предварительных соглашений с будущими клиентами, без гарантированного спроса. Цай выразил озабоченность тем, что ЦОД строятся «наудачу», по инициативе появившихся в отрасли людей и фондов, с привлечением миллионов или даже миллиардов долларов. В частности, он обратил внимание на практику строительства дата-центров в США. Инвестиционные обязательства в соответствующем секторе страны уже весьма значительны. В этом году стартовал проект Stargate с участием OpenAI, Oracle и SoftBank, в рамках которого компании собираются потратить до $500 млрд, в основном на строительство ИИ ЦОД на всей территории США. Как сообщает Datacenter Dynamics, другие компании также планируют масштабные вложения в строительство ИИ-инфраструктуры в 2025 году. Так, Microsoft обещала потратить $80 млрд (хотя уже отказалась от 2 ГВт), Amazon (AWS) — $100 млрд, Google — $75 млрд, а Meta✴ — $60–65 млрд.

Источник изображения: Ben Allan/unsplash.com По словам Цая, он всё ещё поражён уровнем инвестиций в ИИ в США. Бизнесмен прямо заявил, что люди буквально говорят о $500 млрд — совершенно избыточной сумме. Бизнесмен считает, что люди, возможно, напрасно вкладывают деньги, рассчитывая на значительный рост спроса в будущем. Убеждённость в том, что ИИ-проекты представляют собой большой «мыльный пузырь», у некоторых экспертов существует уже давно, но усугубилась она к январю 2025 года, на фоне появления экономичных и эффективных ИИ-моделей китайского стартапа DeepSeek, сумевшего обучить модель R1 за весьма скромные деньги (хотя сенсационность новости несколько преувеличена). После новостей о триумфе китайских ИИ-технологий сегмент фондового рынка США, связанный с искусственным интеллектом, стремительно потерял около $1 трлн, $600 млрд из которых приходилось на акции NVIDIA. В текущем месяце Alibaba представила ИИ-модель QwQ-32B на 32 млрд параметров, которая, как утверждается, соответствует по производительности DeepSeek-R1, но требует ещё меньше вычислительных ресурсов. После этого китайская Tencent объявила, что замедлит развёртывание ускорителей, хотя её капитальные расходы всё ещё будут составлять более 10 % от выручки. В финансовом 2024 году та составляла $91,1 млрд, на 8 % выше год к году. Несмотря на слова Цая и более осмотрительный подход конкурентов к инвестициям, ранее в этом году Alibaba Group объявила, что намерена потратить на облачную и ИИ-инфраструктуру $52 млрд в следующие три года — это высочайший уровень инвестиций для компании к сегодняшнему дню.

26.03.2025 [01:00], Владимир Мироненко

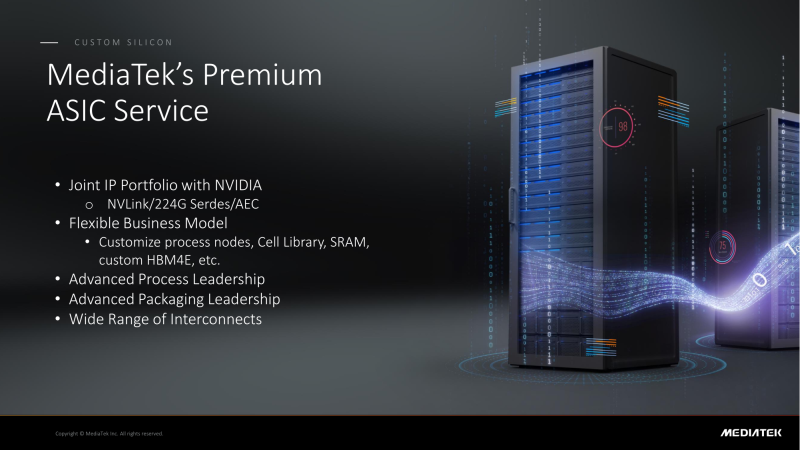

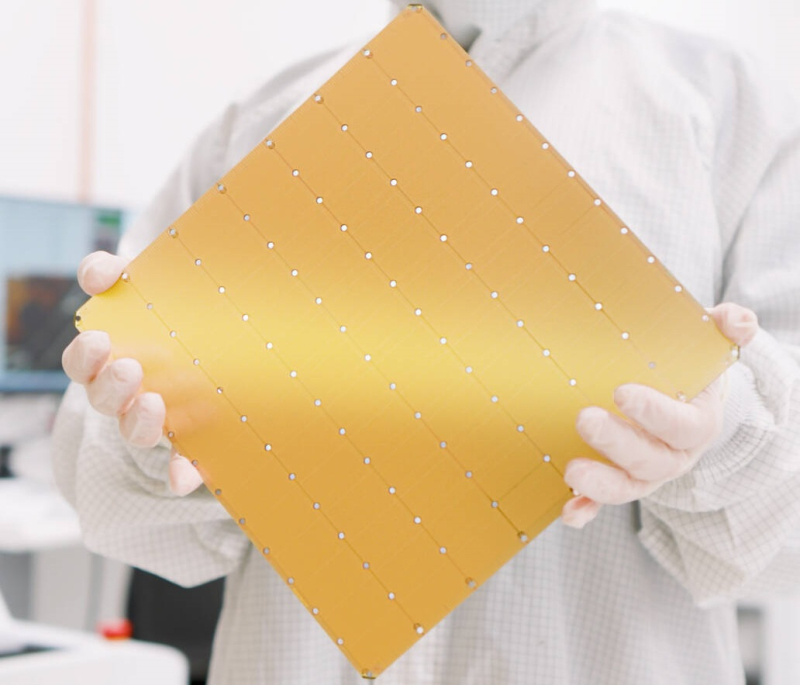

NVIDIA поделится с MediaTek фирменным интерконнектом NVLink для создания кастомных ASICMediaTek объявила о планах расширить сотрудничество с NVIDIA, интегрировав NVLink в разрабатываемые ей ASIC, сообщил ресурс DigiTimes. В свою очередь, ресурс smbom.com пишет, что партнёры намерены совместно разрабатывать передовые решения с использованием NVLink и 224G SerDes. Аналитики предполагают, что выход NVIDIA в сектор ASIC позволит ей ускорить дальнейшее продвижение на рынке с использованием опыта MediaTek и при этом решать имеющиеся проблемы. Как ожидают аналитики, по мере развития сотрудничества двух компаний всё больше провайдеров облачных услуг будет проявлять интерес к работе с MediaTek. Внедрение NVLink в ASIC MediaTek может значительно повысить привлекательность сетевых решений NVIDIA. Объединив усилия, NVIDIA и MediaTek смогут предложить комплексную разработку кастомных ASIC, которая будет включать поддержку HBM4e, обширную библиотеку IP-блоков, передовые процессы производства и упаковки. MediaTek отдельно подчеркнула, что её SerDes-блоки является ключевым преимуществом при разработке ASIC. Компании расширяют сотрудничество с ведущими мировыми производствами полупроводников, ориентируясь на передовые техпроцессы. Применяя технологию совместной оптимизации проектирования (DTCO), они стремятся достичь оптимального соотношения между производительностью, энергопотреблением и площадью (PPA). Сообщается, что несколько облачных провайдеров уже изучают объединённое IP-портфолио NVIDIA и MediaTek. По неофициальным данным, Google уже прибегла к услугам MediaTek при разработке 3-нм TPU седьмого поколения, которое поступит в массовое производство к III кварталу 2026 года. Ожидается, что переход на 3-нм процесс принесет MediaTek более $2 млрд дополнительных поступлений. По данным источников в цепочке поставок, восьмое поколение TPU перейдёт на 2-нм процесс TSMC, что вновь укрепит позиции MediaTek. Также прогнозируется, что предстоящий выход чипа GB10 совместной разработки NVIDIA и MediaTek, и долгожданного чипа N1x, значительно улучшат бизнес-операции MediaTek и ещё больше укрепят позиции компании в полупроводниковой отрасли. Эксперты отрасли считают, что MediaTek имеет все возможности для того, что стать ключевым бенефициаром роста спроса на ИИ-технологии, особенно для малых и средних предприятий.

25.03.2025 [23:13], Андрей Крупин

Правительство возьмёт объекты КИИ на карандаш и наведёт порядок в деле миграции на отечественное ПОГосударственная дума утвердила во втором и третьем чтениях поправки в Федеральный закон «О безопасности критической информационной инфраструктуры Российской Федерации». Новая редакция закона вступит в силу с 1 сентября 2025 года и призвана форсировать переход отрасли на отечественное ПО (в том числе в составе программно-аппаратных комплексов). Принятые изменения в ФЗ о безопасности КИИ наделяют правительство полномочиями устанавливать перечни типовых объектов критической информационной инфраструктуры (КИИ) и определять отраслевые признаки их значимости, будь то телекоммуникационные и IT-системы, а также АСУ ТП, которые используются в государственных органах, здравоохранении, на транспорте и в связи, кредитно-финансовой сфере, топливно-энергетическом комплексе и различных отраслях промышленности: атомной, оборонной, ракетно-космической, химической и других.

Источник изображения: Госдума РФ / duma.gov.ru Ранее право относить объект к КИИ принадлежало собственникам информационных систем, которые в свете сложностей с обеспечением нормативных требований и реализацией проектов импортозамещения старались минимизировать количество находящихся в ведении объектов критической инфраструктуры. Всё это в той или иной степени отразилось на исполнении указа от марта 2022 года о мерах по обеспечению технологической независимости и безопасности национальной КИИ. Напомним, что согласно указу, с 1 января 2025 года действует полный запрет на использование зарубежного софта на значимых объектах критической инфраструктуры, «Больше двух третей субъектов критической информационной инфраструктуры сегодня уже перешли на отечественное ПО. Тем не менее, мы далеко не всегда видим добросовестный подход в этом вопросе: владельцы крупных критически важных IT-систем не всегда их классифицируют как значимые объекты КИИ, понимая, что за этим следует большая ответственность», — сообщил на заседании Госдумы член IT-комитета Антон Немкин. По его словам, внесённые в закон поправки сведут на нет подобную практику. Согласно новой редакции ФЗ о безопасности КИИ, субъекты критической информационной инфраструктуры, владеющими значимыми объектами такой инфраструктуры, обязаны использовать на них ПО, сведения о котором внесены в реестр программ для электронных вычислительных машин и баз данных. Помимо этого, операторы крупных критически важных IT-систем должны взаимодействовать со средствами государственной системы обнаружения, предупреждения и ликвидации последствий компьютерных атак (ГосСОПКА).

25.03.2025 [21:13], Владимир Мироненко

Из-за проблем с ИИ Apple резко поменяла курс и решила потратить $1 млрд на суперускорители NVIDIA GB300 NVL72В отличие от других крупных технологических компаний, которые активно инвестируют в развёртывание ИИ ЦОД, Apple долгое время избегала резкого увеличения капитальных вложений в это направление. Но, похоже, ситуация изменилась, и Apple тоже начала наращивать инвестиции в это направление, пишет ресурс Investor's Business Daily (IBD). Аналитик Loop Capital Ананда Баруа (Ananda Baruah) сообщил в понедельник в записке для инвесторов, что Apple размещает заказы на поставку систем NVIDIA GB300 NVL72 на сумму около $1 млрд. Речь идёт о приблизительно 250 системах стоимостью $3,7– $4 млн каждая, пояснил аналитик. Баруа также сообщил, что Apple привлекла Dell и Supermicro к работе над собственным большим серверным кластером для поддержки приложений генеративного ИИ. Аналитик рассказал, что на текущий момент об этом проекте мало данных, но, похоже, Apple намерена использовать кластер для работы с большими языковыми моделями (LLM). Ранее компания сотрудничала с Google Cloud и использовала TPU для обучения своих ИИ-моделей. Для безопасного инференса компания использует серверы на базе собственных чипов серии M. По слухам, компания также работает над собственными серверными ИИ-ускорителями при поддержке Broadcom. Ананда Баруа считает, что резкая смена стратегии Apple связана с проблемами с выводом на рынок своего обновленного цифрового помощника Siri с поддержкой ИИ, который был анонсирован в прошлом году на конференции WWDC 2024. Компания планировала запустить новые функции Siri в начале этого года, но, похоже, что это произойдёт только в 2026 году. Один из топ-менеджеров Apple назвал задержки и промахи с запуском функций ИИ-платформы Apple Intelligence «отвратительными» и «позорными», поскольку компания продвигала возможности ИИ в телевизионной рекламе, сообщил ранее Bloomberg. В связи с этим на компанию уже подали в суд. В итоге новым руководителем направления ИИ вместо Джона Джаннандреа (John Giannandrea) был назначен Майк Роквелл (Mike Rockwell), глава отдела разработки Vision Pro.

25.03.2025 [18:00], Татьяна Золотова

Минцифры РФ: уровень использования госкомпаниями отечественного ПО превышает 80 %В России уровень использования госкомпаниями и госорганизациями, включенными в реализацию стратегий цифровой трансформации, отечественного программного обеспечения (ПО) превышает 80 %. Об этом сообщили «Известия» со ссылкой на Министерство цифрового развития России (Минцифры). В Минцифры отметили, что «сейчас компании все чаще отдают предпочтение российским решениям». При этом требование по госзакупкам отечественного ПО и операционной системы (ОС) действует с 2016 года. В марте 2025 году глава Минцфиры сообщал, что больше ⅔ субъектов критической информационной инфраструктуры (КИИ) перешли на отечественное ПО. Так, «Ростелеком» в марте перевел виртуальную серверную инфраструктуру на платформу Basis Dynamix. Сам процесс миграции с иностранной платформы VMWare начался в 2023 году. Эксперты iKS-Consulting подсчитали, что с конца 2021 года по конец 2024 года отечественные решения серверной виртуализации занимают 60,2 % рынка РФ, а на долю VMware приходится 39 %. При этом треть российских предприятий сохраняют потребность в переходе на отечественные ИТ-продукты, а каждая пятая компания заявляет о нехватке квалифицированных ИТ-специалистов и эффективных решений в сфере кибербезопасности. В конце прошлого года крупные компании все еще просили отсрочить переход на отечественное ПО объектов КИИ.

25.03.2025 [17:08], Сергей Карасёв

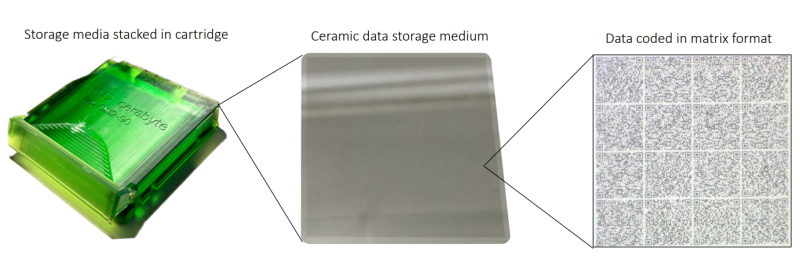

Керамические накопители Cerabyte заинтересовали In-Q-Tel, инвестирующую в перспективные технологии в интересах ЦРУ и др.Немецкая компания Cerabyte, специализирующаяся на разработке систем хранения данных на основе керамики, объявила о привлечении инвестиций со стороны компании In-Q-Tel (IQT), косвенно связанной с американскими спецслужбами. Полученные средства пойдут на ускорение создания продуктов, которые будут поставляться государственным заказчикам. Объём вложений со стороны IQT не раскрывается. Технология Cerabyte предполагает применение стекла или плёнки с тонким керамическим покрытием. Информация записывается при помощи лазера в виде наноразмерных «ямок» по аналогии с QR-кодами: заявленная скорость достигает 2 млн бит на лазерный импульс. Считывание также осуществляется посредством лазера. Одним из ключевых преимуществ технологии Cerabyte является долговечность: данные на таких накопителях могут храниться практически неограниченное количество времени, заявляет компания. Кроме того, обеспечивается высокая ёмкость: по заявлениям разработчика, технология до 2030 года позволит добиться вместимости до 100 Пбайт на стойку при использовании картриджей CeraMemory. In-Q-Tel — американская некоммерческая венчурная фирма, базирующаяся в Арлингтоне (Вирджиния). Она инвестирует в перспективные компании с тем, чтобы обеспечить ЦРУ и другие структуры США передовыми технологическими разработками. Ожидается, что американский государственный сектор будет оперировать огромными объемами данных, сопоставимыми с теми, которыми управляют ведущие интернет-корпорации, включая Meta✴ и Amazon. Причём основная часть такой информации у госструктур будет находиться в «холодном» хранилище в течение длительных периодов времени. Таким образом, технология Cerabyte обеспечит эффективное решение как с точки зрения долговечности, так и с точки зрения вместимости. Нужно отметить, что ранее Cerabyte привлекла инвестиции от компании Pure Storage, которая занимается разработкой All-Flash СХД. Кроме того, Cerabyte получила финансовую поддержку в рамках программы-акселератора Европейского совета по инновациям (EIC). |

|