Лента новостей

|

08.08.2025 [17:30], Андрей Крупин

Selectel зафиксировал двухкратный рост DDoS-атак на свою облачную IT-инфраструктуруПровайдер IT-инфраструктуры Selectel представил сведения о количестве инцидентов в I половине 2025 года, связанных с DDoS-атаками на облачную инфраструктуру компании и клиентские сервисы. Отчёт основан на анализе трафика системами защиты от DDoS-угроз, развёрнутыми в сетевой инфраструктуре дата-центров Selectel. За первые шесть месяцев 2025 года средства защиты Selectel отразили 61 212 атак, что почти вдвое больше, чем годом ранее (31 436 инцидентов). Ещё более заметным стал рост длительности атак — в 2,5 раза (с 3 895 до 9 652 часов) — это говорит о тенденции киберпреступных групп к осуществлению более продолжительных и повторяющихся атак, направленных на истощение сетевой инфраструктуры. При этом максимальная мощность атак сократилась: поток упал на 38,6 % (с 332 до 204 Гбит/с), а интенсивность — на 39,8 % (со 166 до 100 млн пакетов в секунду).

Источник инфографики: selectel.ru Средняя продолжительность одной атаки не превышала 10 минут, самый долгий инцидент был зафиксирован в апреле и длился 222 часа. Наиболее распространёнными типами атак стали TCP PSH/ACK Flood, TCP SYN Flood и UDP Flood, которые составили 76 % от общего числа инцидентов. «В сравнении с аналогичным периодом в 2024 году, кибератаки не только участились, но и стали дольше по продолжительности. Это говорит о том, что злоумышленники все чаще прибегают к повторным и затяжным атакам. Их подход изменился: вместо редких, но мощных ударов они теперь используют более частые, распределённые и менее интенсивные атаки, избегая резких скачков нагрузки. Эта смена тактики напрямую связана с резким ростом ботнетов. Если в 2024 году они насчитывали сотни тысяч устройств, то к 2025 их размер увеличился до нескольких миллионов. Непрерывные атаки низкой и средней интенсивности постепенно снижают производительность систем, но при этом могут оставаться незамеченными для защитных механизмов, настроенных на отражение мощных, но кратковременных угроз», — прокомментировал результаты исследования руководитель направления продуктовой безопасности в Selectel.

08.08.2025 [14:57], Владимир Мироненко

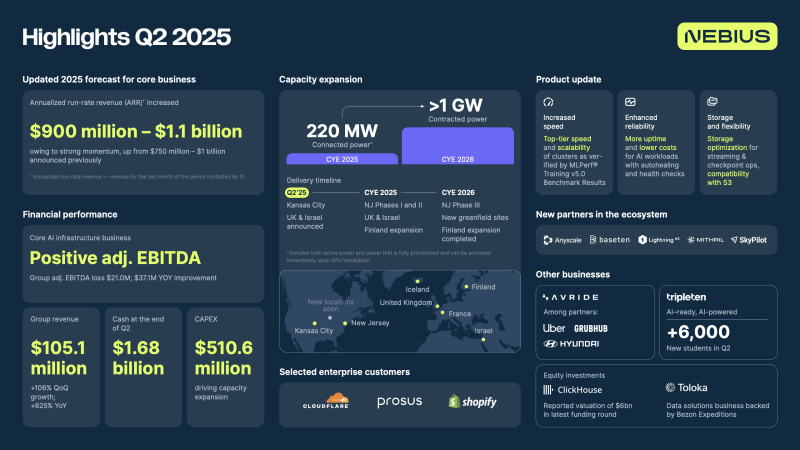

Nebius увеличила выручку на 625 % и повысила прогноз ARR до $0,9–$1,1 млрдПровайдер облачных ИИ-сервисов Nebius (ранее Yandex N.V.) объявил неаудированные финансовые результаты за II квартал, закончившийся 30 июня 2025 года. На фоне позитивных новостей акции компании подскочили на 18 %, в результате рост их стоимости с начала года составил 145 %. Выручка компании составила за отчётный квартал $105,1 млн, что на 625 % больше, чем годом ранее и выше консенсус-прогноза Уолл-стрит в размере около $101 млн, сообщил ресурс investors.com, отметив, что пока интерес к компании слабый. По данным FactSet, в настоящее время акции компании освещают всего лишь пять аналитиков. На сегодняшний день компания привлекла более $4 млрд капитала. В декабре Nebius объявила о привлечении $700 млн в ходе частного размещения от группы инвесторов, включая NVIDIA. В июне компания также привлекла $1 млрд в виде заёмных средств. Nebius завершила квартал со скорректированными чистыми убытками около $91,5 млн, что больше убытков годом ранее в размере $61,6 млн. Компания отразила в отчёте чистую прибыль в размере $502,5 млн, тогда как год назад у неё были убытки в $116,9 млн. Как сообщают «Ведомости», положительный финансовый результат был получен благодаря переоценке финансовых вложений, в том числе доли в платформе Toloka. Доход от этих активов составил $597,4 млн. Скорректированная EBITDA составила −$21 млн против −$58,1 млн годом ранее. В обращении к инвесторам генеральный директор Nebius Аркадий Волож заявил, что компания добилась значительного ускорения по сравнению с I первым кварталом благодаря высокому спросу клиентов и почти пиковой загрузке платформы. В связи с этим компания повышает прогноз годовой доходности (Annualized Run Rate, ARR) с $0,75–$1,0 млрд до $0,9–$1,1 млрд. «Спрос на инфраструктуру ИИ — вычислительные мощности, программное обеспечение и услуги — будет только расти по мере увеличения числа вариантов использования. Мы активно наращиваем мощности, чтобы воспользоваться этой существенной возможностью, и к концу 2026 года планируем получить более 1 ГВт», — сообщил Волож. Он рассказал, что к концу 2025 года подключённая мощность компании достигнет 220 МВт. В Финляндии она вырастет до 75 МВт. «В Нью-Джерси мы недавно увеличили наши обязательства по обеспечению 100 МВт мощности в этом году и 100 МВт мощности в 2026 году», — сообщил Волож, добавив, что сейчас идут переговоры ещё по двум крупным новым площадкам в США. По словам Воложа, компания усовершенствовала инфраструктуру, сделав её более доступной для разработчиков и исследователей ИИ, включая AnyScale, BaseTen, Mithril (Foundry), LightningAI, а также углубила сотрудничество со SkyPoint и NVIDIA. Он отметил, что компания осталась одним из ведущих поставщиков т.н. неооблака для стартапов, работающих с ИИ, привлекая таких клиентов, как HeyGen, Lightning.AI, Photoroom и многих других.

08.08.2025 [13:40], Руслан Авдеев

Крупному бизнесу в России могут запретить использование иностранных облаков

software

закон

импортозамещение

информационная безопасность

минцифры россии

облако

россия

сделано в россии

Минцифры России предлагает запретить использование облачных сервисов и приложений в системах хранения и обработки персональных данных корпоративных пользователей. Как следует из письма главы министерства Максута Шадаева главе Минпромторга Антону Алиханову, новые меры планируется ввести с 1 сентября 2027 года, сообщают «Ведомости». Запрет не коснётся малого и среднего бизнеса, ИП и физических лиц. Полная блокировка доступа к иностранному ПО тоже не предусмотрена, поскольку это «не представляется обоснованным». В Минпромторге предварительно согласны с новой концепцией. Минцифры предлагает поэтапно запрещать использовать такие решения и сервисы с учётом «зрелости и конкурентоспособности» российских аналогов. Законопроекты планируется разработать до мая 2026 года. Пока в России запрещено использование зарубежных облаков только для государственных структур — соответствующие поправки в закон «О связи» вступили в силу 1 сентября 2024 года. По данным «Ведомостей», Шадаев обеспокоен массовым использованием крупными российскими компаниями иностранных облаков, наиболее популярны AWS, Microsoft Azure и Google Cloud. Министр объясняет инициативу рисками потери доступа и компрометации данных, поскольку действующее российское законодательство не предусматривает обязанности использовать российское ПО в системах хранения и обработки персональных данных.

Источник изображения: Serge Kutuzov/unsplash.com В соответствии с национальным проектом «Экономика данных», курируемым Минцифры, на отечественное ПО к 2030 году должны перейти не менее 80 % российских организаций в ключевых отраслях. С 1 января 2025 года уже вступил в силу закон о запрете использования иностранного ПО на объектах КИИ. Новое ограничение, как следует из письма, позволит стимулировать спрос на отечественные ПО и облака. По мнению экспертов, если запрет установят, российские облачные сервисы ждёт рост спроса, поскольку многие бизнесы до сих пор пользуются иностранными облаками «по инерции», хотя их в любой момент могут отключить извне. Многие крупные компании всё ещё используют и иностранные сервисы вроде Microsoft Teams, ставя под угрозу корпоративные и персональные данные, хотя российские альтернативы уже закуплены. Миграция на отечественные облачные решения значительно ускорилась в 2022 году. В 2023–2024 гг. уже решались в основном точечные задачи и этап, по мнению экспертов, можно считать завершённым для компаний, планировавших переход на российские решения. Другими словами, «импортозамещение» иностранных сервисов к сентябрю 2027 года «кажется реалистичным». Стоит отметить, что в июле Минцифры РФ совместно с ФСБ и ФСТЭК предписано проработать изменения законов, устанавливающие обязанность операторов персональных данных граждан применять для обработки и хранения такой информации только ПО российской разработки. Варианты поправок должны быть готовы до 1 декабря 2025 года, а переходный период для внедрения изменений ограничат 1 сентября 2027 года.

08.08.2025 [12:44], Руслан Авдеев

OpenAI похвасталась, что на GPT-5 «ушло» 200 тыс. ИИ-ускорителей, а с 2024 года её вычислительные мощности выросли в 15 разОдновременно с премьерой новейшей ИИ-модели GPT-5 компания OpenAI рассказала некоторые подробности о своей инфраструктуре. В частности, появилась информация о том, что с 2024 года компания нарастила вычислительные мощности в 15 раз, сообщает Datacenter Dynamics. По словам представителя компании, только за последние 60 дней было развёрнуто более 60 кластеров, сформирована цифровая магистраль, пропускающая больше трафика, «чем целые континенты», а также задействовано более 200 тыс. ИИ-ускорителей для запуска LLM GPT-5 для 700 млн человек. Дополнительно ведётся подготовка ещё 4,5 ГВт мощностей для «сверхразума». Стало известно и о вакансиях для проекта Stargate, курируемого OpenAI. Было заявлено, что сегодня небольшая команда строит ИИ-инфраструктуру планетарного масштаба беспрецедентными темпами. Она нанимает специалистов в сфере обработки данных, энергетики, ЦОД, планирования новых мощностей, развития бизнеса, финансов и др.

Источник изображения: Felix Mittermeier/unsplash.com При этом компания «агрессивно» нанимает людей в команду Stargate, при этом преимущественно полагаясь на Oracle. Так, в июле компании подтвердили сделку по аренде 4,5 ГВт для проекта Stargate в США. Как ожидается, сделка будет обходиться в $30 млрд ежегодно. Впрочем, не так давно сообщалось, что OpenAI по-прежнему планирует самостоятельно строить собственные дата-центры. Также компания намерена построить кампус ЦОД Stargete в Объединённых Арабских Эмиратах (ОАЭ) при участии других IT-гигантов, включая Oracle, NVIDIA, Cisco, SoftBank и G42. В Европе компания уже работает над дата-центром в Норвегии совместно с Nscale. Кроме того, она ищет площадки для новых инициатив по всему миру. При этом развитием инфраструктуры занимается в основном сама OpenAI, а сам проект Stargate развивается не так быстро, как планировалось.

08.08.2025 [11:50], Руслан Авдеев

Tesla отказалась от развития ИИ-суперкомпьютеров DojoTesla распускает команду, стоявшую за суперкомпьютером Dojo, сообщает TechCrunch со ссылкой на Bloomberg. Как сообщают анонимные источники, глава проекта Питер Бэннон (Peter Bannon) покидает компанию, а оставшихся участников команды переведут на работу с другими вычислительными проектами Tesla. О закрытии Dojo стало известно после ухода из Tesla порядка 20 сотрудников, основавших собственный ИИ-стартап DensityAI, который займётся разработкой чипов, аппаратного и программного обеспечения для ИИ ЦОД, связанных с робототехникой, ИИ-агентами и автомобильными приложениями. DensityAI основана бывшим руководителем Dojo Ганешем Венкатарамананом (Ganesh Venkataramanan), причём в не самый удачный для Tesla момент, поскольку глава компании Илон Маск (Elon Musk) ранее настоял на том, чтобы акционеры рассматривали компанию как бизнес, занимающийся ИИ и робототехникой. Решение о закрытии Dojo стало значительным изменением стратегии. Ранее Маск утверждал, что суперкомпьютер станет краеугольным камнем для удовлетворения амбиций компании в сфере ИИ и основная цель — добиться полной автономии машин благодаря способности Dojo обрабатывать огромные массивы видеоданных. В 2023 году Morgan Stanley посчитал, что Dojo может поднять капитализацию Tesla на $500 млрд за счёт новых источников дохода — проектов роботакси и программных сервисов. В 2024 году Маск сообщил, что команда Tesla, занятая искусственным интеллектом, «удвоит ставку» на Dojo перед презентацией роботакси. Тем не менее разговоры о Dojo уже в августе того же года постепенно сошли на нет, когда Маск начал продвигать ИИ-кластер Cortex (на базе ускорителей NVIDIA) при штаб-квартире Tesla в Остине (Техас). Проект Dojo включал в себя как суперкомпьютер, так и предполагал собственное производство ИИ-ускорителей. Ещё в 2021 году Tesla во время официального анонса Dojo представила чип D1, который должен был бы использоваться совместно с ускорителями NVIDIA для обеспечения работы Dojo. Также сообщалось, что ведутся работы над чипом D2, в котором будут устранены недостатки предшественника. По данным источников Bloomberg, теперь Tesla намерена сделать ставку преимущественно на NVIDIA, а также других сторонних партнёров вроде AMD, а Samsung будет выпускать чипы на заказ. В прошлом месяце с Samsung подписан контракт на выпуск инференс-чипов AI6, которые будут работать как с автопилотами Tesla, так и использоваться в роботах Optimus и дата-центрах. Ранее Маск намекнул, что в случае с Dojo 3 (D3) и инференс-чипом AI6, речь, возможно, будет идти о едином чипе. Недавно совет директоров Tesla предложил Маску пакет акций на $29 млрд, чтобы тот оставался в Tesla и продвигал ИИ-разработки компании, вместо того чтобы отвлекаться на другие бизнесы.

08.08.2025 [10:44], Сергей Карасёв

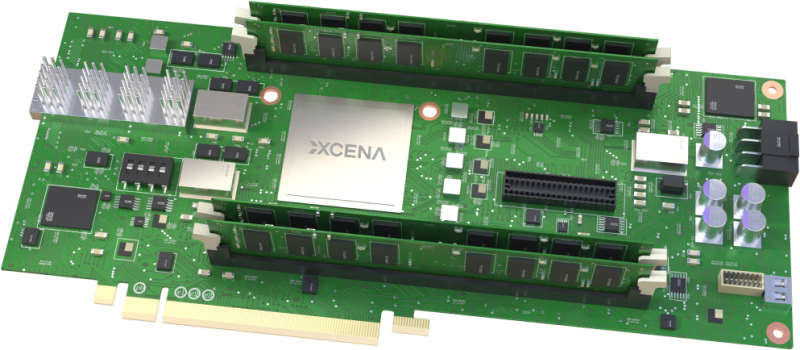

Стартап Xcena представил вычислительную память MX1 с поддержкой PCIe 6.0 и CXL 3.2Южнокорейский стартап Xcena анонсировал свой первый продукт — вычислительную память MX1. Избранные партнёры начнут получать образцы изделий с октября, тогда как массовое производство запланировано на 2026 год. Решение MX1 обладает поддержкой PCIe 6.0 и CXL 3.2. Новинка позволяет расширить основную память системы, добавив до 1 Тбайт в виде четырёх модулей DDR5 DIMM ёмкостью 256 Гбайт каждый. Реализована технология NDP (Near Data Processing), которая сводит к минимуму задержку при перемещении данных между интерфейсами и значительно снижает совокупную стоимость владения для приложений, требующих обработки больших объемов информации. Для выполнения вычислений в оперативной памяти используются «тысячи ядер» на открытой архитектуре RISC-V. Изделия MX1 позволяют существенно ускорить выполнение таких задач, как операции с векторными и графовыми базами данных, анализ информации и пр. При этом снижается нагрузка на CPU. Прототип на базе FPGA продемонстрировал сокращение времени обработки запросов при работе с базами данных на 46 % по сравнению с серверными CPU. Теоретически выигрыш может достигать 95 % при реализации в виде ASIC. Чип задействует 4-нм техпроцесс Samsung Foundry. Упомянута поддержка ECC. Компания Xcena предоставляет полностью интегрированный комплект для разработчиков (SDK), состоящий из низкоуровневых драйверов, библиотек среды выполнения и вспомогательных инструментов, которые помогают создавать прототипы и развертывать MX1 с минимальными усилиями по интеграции.

08.08.2025 [10:05], Руслан Авдеев

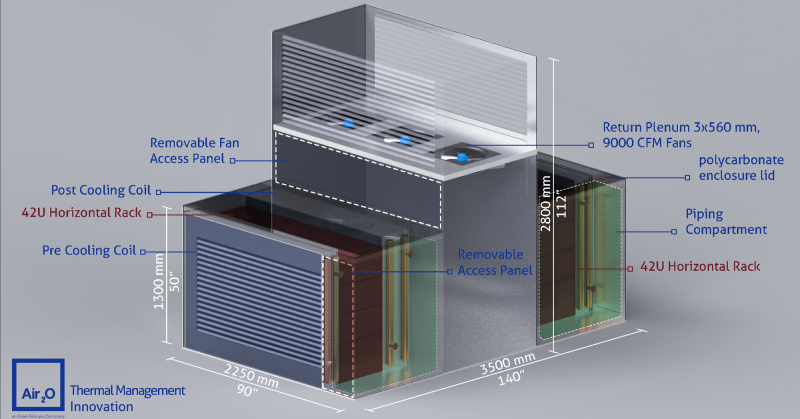

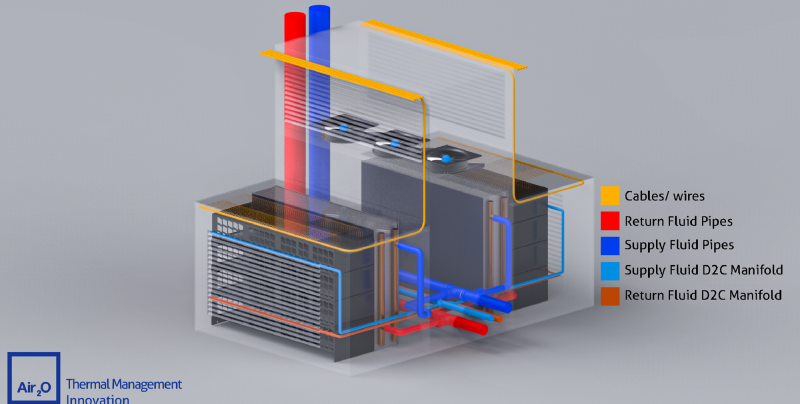

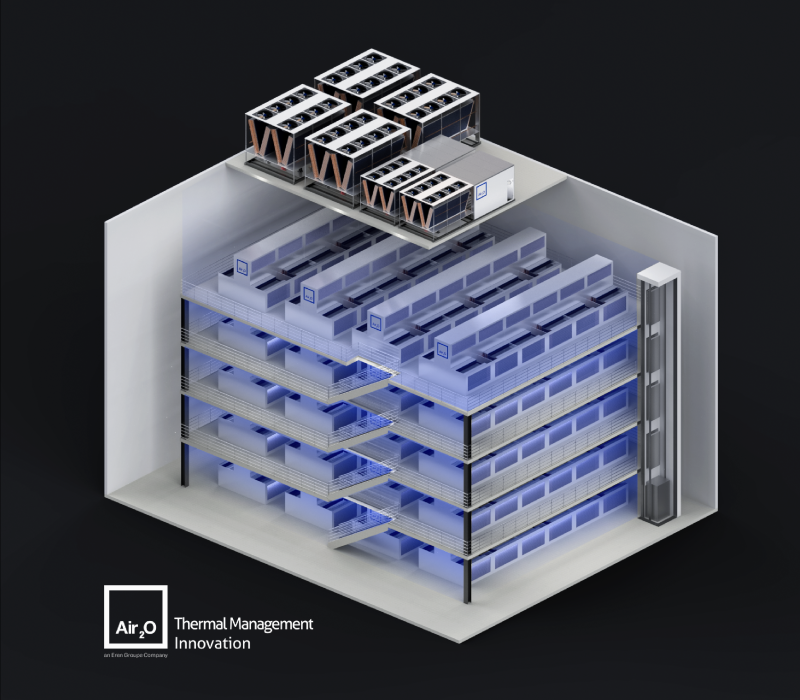

Масштабирование штабелированием: Air2O предложила высокоплотные модули с горизонтальными 42U-стойкамиРазработчик систем охлаждения Air2O предложил необычные модули High Thermal Density Air-Cooled Rack Assembly с двумя горизонтально расположенными 42U-стойками, которые, по словам компании, позволят заметно увеличить плотность размещения вычислительных мощностей, сообщает Datacenter Dynamics. К стойкам с двух сторон прилегают теплообменники, а между стойками находится воздушный коридор с собственными вытяжными вентиляторами высотой 2,8 м. Таким образом, воздух охлаждается до попадания в стойку и после выхода из него, что, по словам, Air2O, упрощает его повторное использование. По данным компании, новые модули обеспечивают энергетическую плотность до 320 кВт при фрикулинге и до 600 кВт при прямом жидкостном охлаждении. В версии с СЖО место одного из теплообменников занимает CDU. Масштабировать модули предполагается путём штабелирования. Air2O заявляет, что способна разместить до 120 соответствующих модулей общей мощностью до 40 МВт в помещении 16 × 25 × 20 м (400 м2), тогда как традиционный ЦОД такой же мощности может занимать более 25 тыс. м2. Каким образом предполагается обслуживать оборудование в таких стойках, компания, к сожалению, не уточняет. Также нет данных, построила ли компания хоть один такой модуль. По словам компании, стандартные 19″ стойки, разработанные AT&T более ста лет назад и используемые в большинстве дата-центров, устарели и никогда не предназначались для оборудования с высокой плотностью тепловой энергии. Подчёркивается, что оборудование современных ЦОД не должно выглядеть, как оснащение телефонной станции столетней давности. Со стойками экспериментируют не только специализированные компании, но и гиперскейлеры. Например, в конце 2024 года Microsoft и Meta✴ представили дизайн ИИ-стойки с раздельными шкафами для питания и IT-оборудования, а в мае 2025 года Google показала мегаваттные стойки с питанием 400 В и СЖО для ИИ-платформ будущего. А NVIDIA предлагает перейти уже к 800 В.

08.08.2025 [09:13], Руслан Авдеев

Сбавить обороты: Google сократит энергопотребление ИИ ЦОД в периоды пикового спросаGoogle объявила о новых соглашениях с американскими энергокомпаниями Indiana Michigan Power (I&M) и Tennessee Valley Authority (TVA). Договоры направлены на сокращение потребления ИИ ЦОД в периоды высокого спроса, сообщает Tech Republic. Поскольку ИИ-модели становятся всё сложнее, их обучение и запуск требует немало гигаватт энергии, иногда в течение нескольких часов или даже дней подряд, к чему энергосети не всегда готовы. Google в соглашениях с I&M и TVA обязалась переносить или вовсе приостанавливать ИИ-нагрузки небольшой срочности, если энергосеть будет перегружена — например, из-за плохой погоды или высокого спроса. Новый план разработан на основе результатов экспериментального соглашения с Omaha Public Power District (OPPD), в результате которого энергопотребление, связанное с машинным обучением, неоднократно и успешно снижалось в 2024 году. В Google подчёркивают, что подобная гибкость помогает снизить потребности в строительстве новых ЛЭП, электростанций и помогает операторам эффективнее управлять энергосетями. Компания начала внедрять перераспределение нагрузок между своими ЦОД в разных регионах в 2020 году, а два года назад она начала учитывать состояние энергосетей и перемещать или откладывать некритичные нагрузки. Похожую систему создала и Microsoft, правда, в обоих случаях изначально ставилась задача не повышения устойчивости энергосетей, а улучшение экологических показателей.

Источник изображения: Andrey Metelev/unspalsh.com По данным Indiana Michigan Power, по мере добавления в систему новых крупных нагрузок компания вынуждена сотрудничать с клиентами для эффективного управления генерацией и передачей энергии. Способность Google перераспределять рабочие нагрузки будет очень ценными «инструментом» для удовлетворения растущих потребностей в питании. Впрочем, некоторые рабочие нагрузки вроде поиска, карт, задач клиентов Google Cloud или заказчиков из сферы здравоохранения приостановить нельзя, поэтому внедрять технологии «гибкого спроса» будут только на некоторых площадках — там, где это не повлияет на надёжность обслуживания. Как сообщает Datacenter Dynamics, это не первая попытка Google координации с энергетиками и управления ресурсами. В апреле принадлежащий компании проект Tapestry договорился с PJM Interconnection об использовании ИИ для упрощения и ускорения присоединения объектов к энергосети. На первом этапе будут автоматизированы процессы, сегодня выполняющиеся специалистами-планировщиками. Со временем предполагается разработать для электросетей сервис наподобие Google Maps. Помимо Google, некоторые компании в последние месяцы уже объявили о намерении использовать ИИ для «умного» координирования задач в зависимости от спроса на электричество. В мае GridCare объявила о запуске проекта, который позволит находить в действующей энергосети «географические» и «временные» возможности использования электричества, что, по словам компании, позволит сократить время на подключение ЦОД к сети до 6–12 месяцев.

08.08.2025 [01:05], Владимир Мироненко

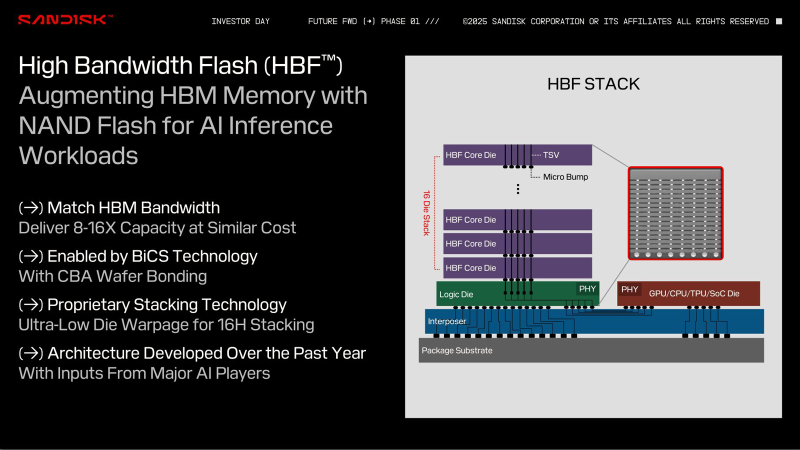

Sandisk и SK hynix разработают спецификации высокоскоростной флеш-памяти HBFSandisk объявила о подписании Меморандума о взаимопонимании (МОВ) с SK hynix, предусматривающего совместную разработку спецификации высокоскоростной флеш-памяти (HBF). В рамках сотрудничества компании планируют стандартизировать спецификацию, определить технологические требования и изучить возможность создания технологической экосистемы для высокоскоростной флеш-памяти. Технология HBF, анонсированная Sandisk в феврале этого года, обеспечит ускорители быстрым доступом к большим объёмам памяти NAND, что позволит ускорить обучение и инференс ИИ без длительных обращений к PCIe SSD. Как и HBM, чип HBF состоит из слоёв, в данном случае NAND, с TSV-каналами, соединяющими каждый слой с базовым интерпозером, что обеспечивает быстрый доступ к памяти — на порядки быстрее, чем в SSD. При сопоставимой с HBM пропускной способности и аналогичной цене HBF обеспечит в 8–16 раз большую, чем у HBM, ёмкость на стек. Вместе с тем HBF имеет более высокую задержку, чем DRAM, что ограничивает её применение определёнными рабочими нагрузками. На этой неделе Sandisk представила прототип памяти HBF, созданный с использованием фирменных технологий BiCS NAND и CBA (CMOS directly Bonded to Array). Меморандум о взаимопонимании подразумевает, что SK hynix может производить и поставлять собственные модули памяти HBF. Как отметил ресурс Blocks & Files, это подтверждает тот факт, что Sandisk осознаёт необходимость наличия рынка памяти HBF с несколькими поставщиками. Такой подход позволит гарантировать клиентам, что они не будут привязаны к одному поставщику. Также это обеспечит конкуренцию, которая ускорит разработку HBF. Sandisk планирует выпустить первые образцы памяти HBF во II половине 2026 года и ожидает, что образцы первых устройств с HBF для инференса появятся в продаже в начале 2027 года. Это могут быть как портативные устройства, так и ноутбуки, десктопы и серверы.

07.08.2025 [22:58], Андрей Крупин

«Мегафон» запустил на Дальнем Востоке 400-км магистральную линию связи с использованием отечественных DWDM-систем Т8Оператор «Мегафон» запустил на Дальнем Востоке магистральную линию связи с использованием DWDM-систем российского производителя «Т8». Новая линия, обеспечивающая скорость передачи данных в 100 Гбит/с, организована между Хабаровском и Комсомольском-на-Амуре, что составляет более 400 км. Сложность проекта заключалась в неоднородной структуре кабельной трассы: участок включал в себя волокна разных типов, для которых не подходят стандартные решения. Инженеры «Мегафона» совместно со специалистами «Т8» провели расчёты сети для оптимизации параметров всех компонентов DWDM-системы. Такой подход позволил адаптировать оборудование под условия протяжённой оптической трассы и обеспечить высокую скорость передачи данных. С запуском проекта в регионе оператору стал доступен новый маршрут, что повысило гибкость и надёжность магистральной сети.

Телекоммуникационное DWDM-оборудование «Волга» производства «Т8» (источник изображения: t8.ru) «Запуск новой магистральной линии — часть реализации нашей долгосрочной стратегии по развитию сети на Дальнем Востоке, она стала важным участком магистрали, соединяющей крупнейшие узлы в регионе. Вместе с партнёрами мы смогли не только обеспечить высокую скорость передачи данных, но и обеспечить возможность масштабирования DWDM-системы на данном направлении до 800 Гбит/с», — заявил «Мегафон». «T8» является российским предприятием полного цикла. Деятельность компании охватывает научные исследования в области оптоэлектроники и лазерной физики, проектирование, разработку и производство радиофотонной и радиоэлектронной компонентной базы, а также развёртывание оборудования и его последующее сервисное обслуживание. За годы своей работы «Т8» ввела в эксплуатацию свыше 135 тыс. км DWDM-сетей, из которых более 37 тыс. км составляют высокоскоростные системы 100–600 Гбит/с на канал. Компания занимает 26 % российского рынка DWDM-решений. |

|