Лента новостей

|

12.01.2023 [17:22], Владимир Мироненко

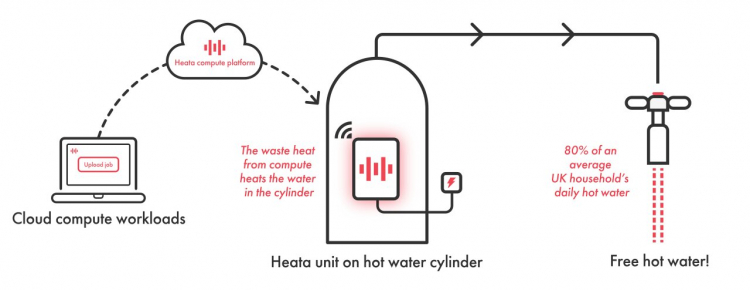

Civo и Heata предложили британцам устанавливать дома серверы для отопленияПровайдер облачных услуг Civo сообщил о сотрудничестве с компанией Heata с целью обеспечения горячей водой домов в Великобритании за счёт отвода тепла от размещённых локально серверов, подключённых к системам отопления. Heata позиционирует себя как разработчик инновационной экологически чистой распределённой вычислительной сети, которая использует «мусорное» тепло, генерируемое при обработке вычислительных нагрузок, для нагрева воды. Компании планируют запустить совместный пилотный проект, в рамках которого клиентам Civo будет предоставлена возможность опробовать облачные нагрузки в сети Heata. Компании заявили, что это позволит клиентам Civo обеспечить тех, кто столкнулся с нехваткой топлива, бесплатной горячей водой. Компактные серверы Heata (36 × 28 см) устанавливаются на внутридомовых бойлерах. Заказчики платят Heata за обработку своих облачных нагрузок на этих серверах (в пакетном режиме), а отводимое от них тепло используется для нагрева воды в бойлере. Работа системы увязана с существующими системами отопления. Бойлеры были протестированы в сотрудничестве с British Gas. Один такой блок позволяет сократить выбросы углекислого газа на 1 т в год. В настоящее время Heata вместе с Innovate UK занимается определением домов, где будет установлено вычислительное оборудование. Концепция «цифровых бойлеров» не нова. Наиболее известна такими решениями компания Qarnot из Франции, которая недавно привлекла €35 млн инвестиций. А вот компания Nerdalize, занимавшаяся производством «вычислительных» радиаторов, обанкротилась в 2019 году.

11.01.2023 [03:00], Игорь Осколков

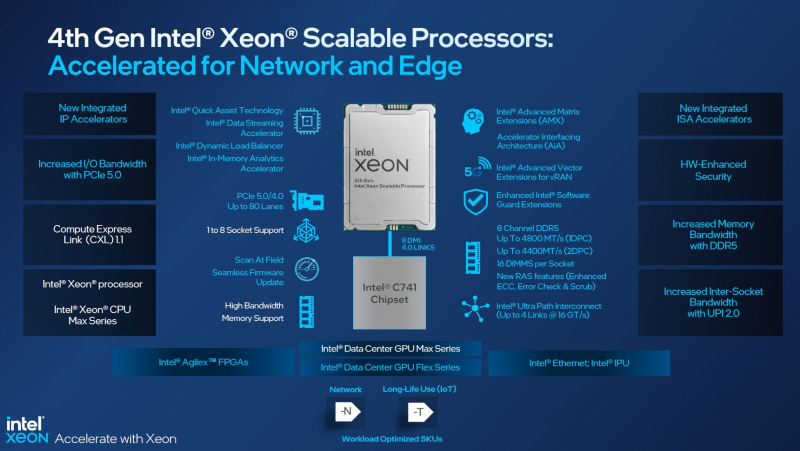

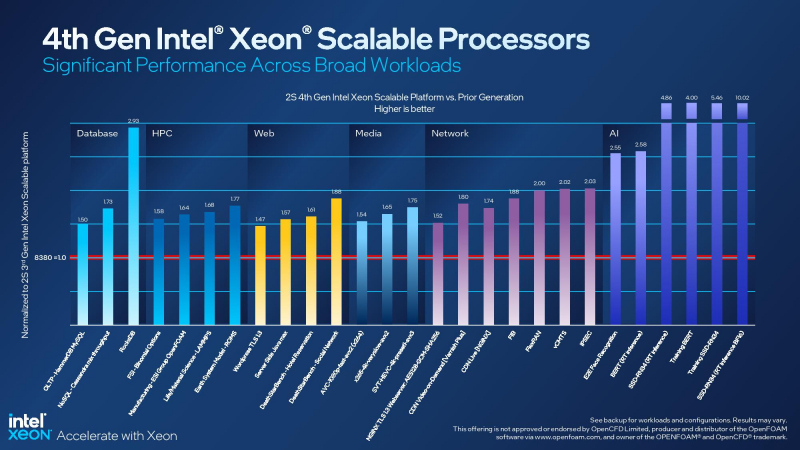

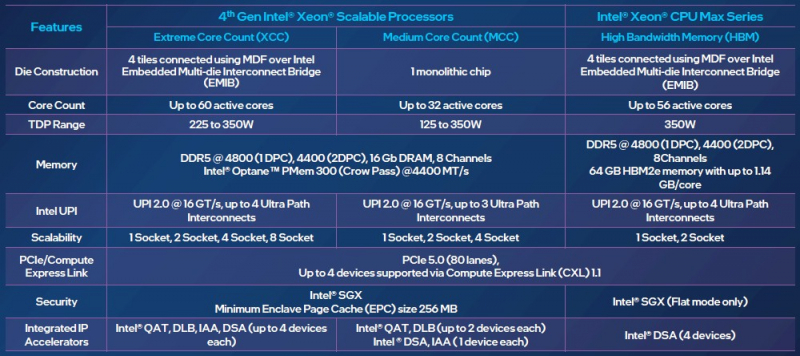

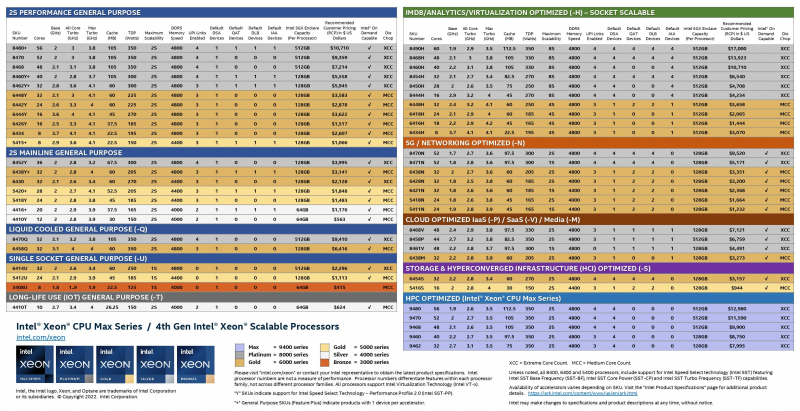

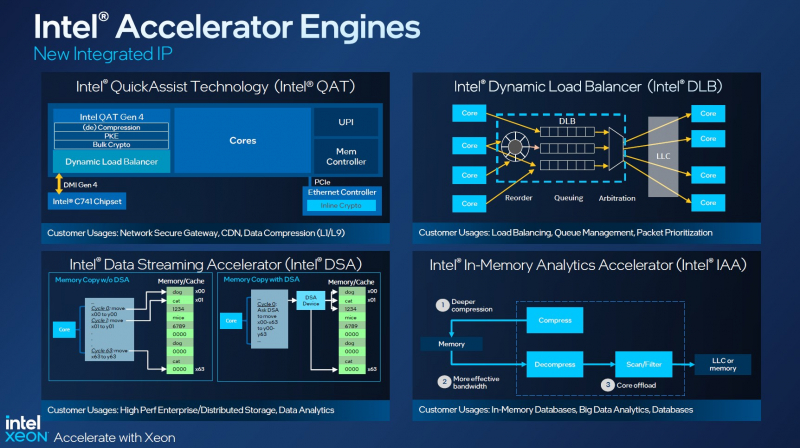

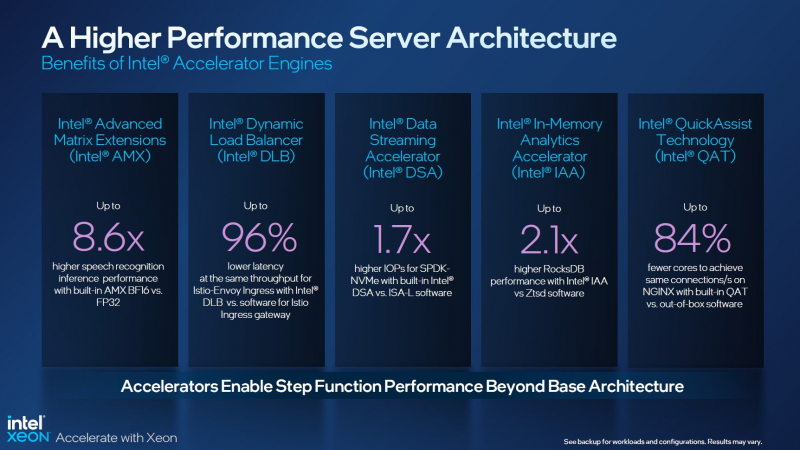

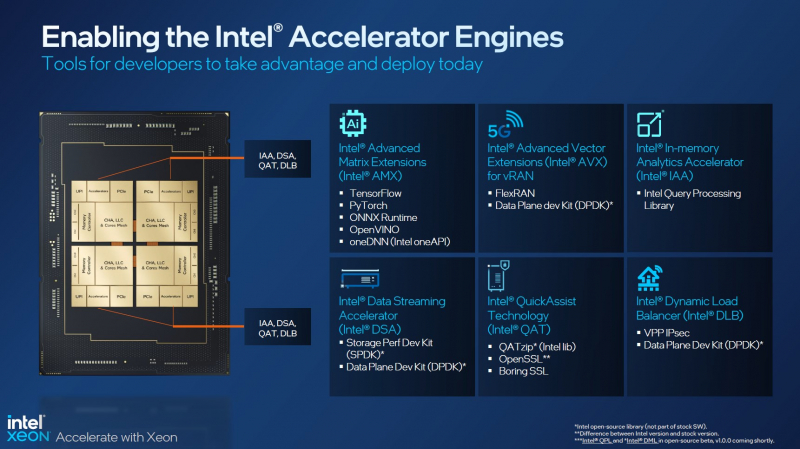

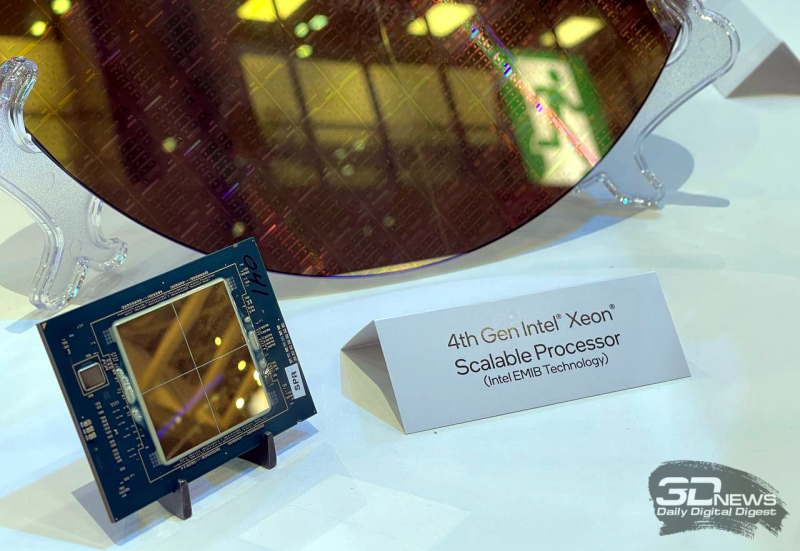

Асимметричный ответ: Intel официально представила процессоры Xeon Sapphire RapidsIntel официально представила серверные процессоры Xeon семейства Sapphire Rapids (SPR), выход которых изрядно задержался, а также ускорители ранее известные как Ponte Vecchio и теперь объединённые вместе с HBM-версиями SPR в отдельную HPC-серию Max. В этом поколении Intel не смогла догнать AMD EPYC Genoa по числу ядер, числу каналов памяти и линий PCIe, но заготовила ассиметричный, хотя и очень странно реализованный ответ. Всего представлено 52 модели с числом P-ядер от 8 до 60 и с TDP от 125 до 350 Вт. По числу ядер это существенный апгрейд по сравнению с Ice Lake-SP (до 40 ядер), да и IPC вырос у Golden Cove на 15 % в сравнении с Sunny Cove. Но это существенный проигрыш в сравнении с Genoa (до 96 ядер), особенно если учитывать их максимальный TDP в 360 Вт (cTDP до 400 Вт). Правда, у Sapphire Rapids есть ещё и экономичный режим работы, в котором энергопотребление снижается на 20 %, а производительность для некоторых нагрузок — всего на 5 %. Sapphire Rapids предлагают 8 каналов памяти DDR5-4800 (1DPC) и DDR5-4400 (2DPC). 2DPC у Genoa пока что нет. Кроме того, контроллеры поддерживают и модули Optane PMem 300 (Crow Pass), но с учётом того, что производство 3D XPoint прекращено, достаться они могут не всем (впрочем, не всем они и нужны). Ну а маленькая серия Max также включает 64 Гбайт набортной HBM2e-памяти (1,2 Тбайт/с). Остались и отличия в максимальном объёме SGX-анклавов в зависимости от модели CPU. Однако по числу ядер на узел всё равно лидирует Intel. Если AMD поддерживает только 2S-конфигурации, то Intel снова предлагает и 4S, и 8S (а с момента выхода Cooper Lake-SP прошло немало времени) — на процессор доступно до 4 линий UPI 2.0 (16 ГТ/с в сравнении с 11,2 ГТ/с у Ice Lake-SP). В 2S-платформах Sapphire Rapids также формально обгоняет Genoa по числу линий PCIe 5.0, которых тут по 80 шт. на сокет. Формально потому, что в случае Genoa при желании всё же можно получить 160 линий, пожертвовав скоростью шины между CPU, но в односокетном варианте EPYC в любом случае интереснее Xeon. Без нюансов тут не обошлось. Так, при бифуркации до 8 x2 скорость падает до PCIe 4.0. Зато каждый root-комплекс поддерживает CXL 1.1, тогда как у Genoa CXL есть только у половины! Впрочем, поддержка всё равно ограничена 4x CXL-устройствами на CPU. Что ещё более странно, официально заявлена поддержка только устройств Type 1 и Type 2, но не Type 3, хотя последние весьма пригодились бы в ряде конфигураций, где требуется больше относительно недорогой, пусть и несколько более медленной, RAM. Сохранилось традиционное разделение на серии Platinum (8000), Gold (6000/5000), Silver (4000) и Bronze (3000), к которым теперь добавилась серия Max (9400). Список суффиксов, означающих оптимизацию под те или иные задачи и наличие каких-то особенностей, стал чуть шире: Y (SST-PP 2.0), Q (рассчитаны на работу с СЖО), U (односокетные общего назначения), T (увеличенный жизненный цикл), H (in-memory СУБД, аналитика, виртуализация), N (сетевые решения, в том числе для 5G), облачные P/V/M (IaaS/Paa/медиа), S (СХД и HCI). Но некоторые модели также имеют в названии «+». И вот тут начинается самое интересное! Все процессоры получили «традиционную» (в сравнении с Genoa) реализацию AVX-512, включая DL Boost, а также целый новый набор ИИ-инструкций AMX (до 10 раз быстрее обучение и инференс в сравнении с Ice Lake-SP). Есть и всяческие Speed Select, DDIO, TDX, CET и т.д. Но Sapphire Rapids также получили четыре отдельных ускорителя:

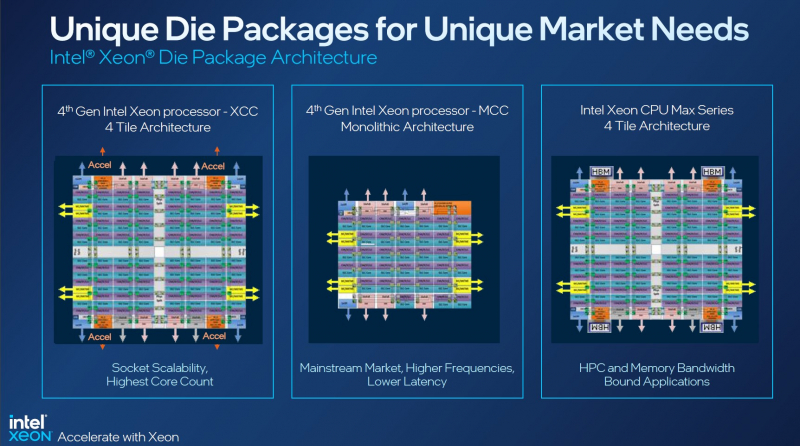

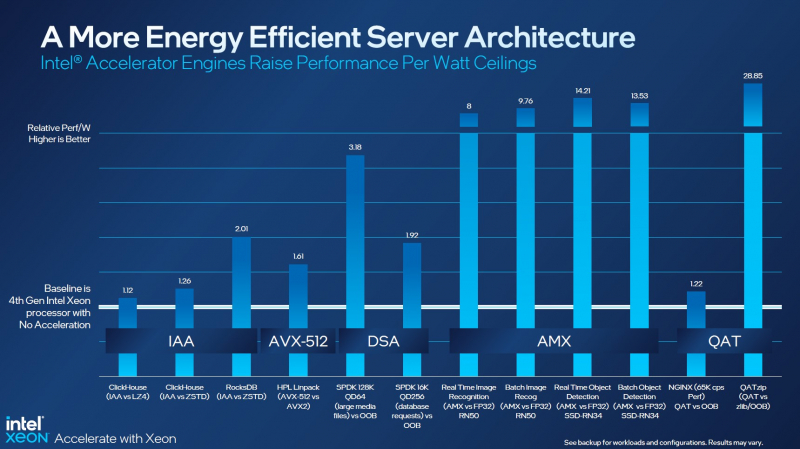

Intel заявляет, что средний прирост производительности Sapphire Rapids в сравнении с Ice Lake-SP составил 1,53 раза. А вот для ряда нагрузок, которые могут задействовать новые ускорители прирост производительности на Вт составляет уже до 2,9 раз! То есть Intel продолжает придерживаться стратегии создания максимально универсальных CPU для различных нагрузок. И действительно, спорить с гибкостью Sapphire Rapids трудно. Но какой ценой это достигается? Т.е. буквально: во сколько это обойдётся заказчику? Ответа пока нет. Дело в том, что в зависимости от модели отличается число доступных и число активированных ускорителей. Фактически в новом поколении используется два вида кристаллов: XCC, «сшитые» из четырёх отдельных тайлов, и монолитные MCC (до 32 ядер, причём 32-ядерных моделей в серии большинство). У каждого тайла в XCC есть по одному блоку QAT, DSA, DLB и IAA, т.е. суммарно на CPU приходится до четырёх ускорителей каждого типа. В случае MCC может быть по два QAT и DLB и по одному DSA и IAA на процессор. Например, у тех моделей, что помечены «+», активно по одному блоку каждого типа, а минимум один DSA активен есть вообще у всех CPU. За не активированные по умолчанию ускорители придётся заплатить в рамках программы Intel On Demand (SDSi), причём есть опции как с единовременным платежом за постоянную активацию, так и с оплатой по факту использования (это удобно в случае облаков и платформ по типу HPE Greenlake). Исключением являются H-модели, куда входит и самый дорогой ($17000) 60-ядерный процессор 8490H с полностью разблокированными ускорителями и поддержкой 8S-конфигураций, а также процессоры Max, которым доступно только четыре DSA-блока и 2S-платформы, например, 56-ядерный 9480 ($12980). С одной стороны, желание Intel предоставить больше гибкости заказчикам, а заодно чуть увеличить выход годных к продаже процессоров, понятно. С другой — не очень-то и похоже, что CPU без «лишних» ускорителей отдаются с какой-то существенной скидкой. При этом транзисторный бюджет на них всё равно расходуется. Кроме того, есть ещё момент востребованности этих ускорителей и готовности ПО. У Intel есть и опыт ресурсы для помощи разработчикам, но процесс адаптации в любом случае не мгновенен. Впрочем, у Intel по сравнению с AMD есть и ещё одно важное преимущество — в среднем более высокая доступность процессоров для большинства заказчиков. Так что с Sapphire Rapids может повториться та же история, что с Ice Lake-SP, когда вендоры здесь и сейчас готовы были предложить Intel-платформы. В целом же, в новом семействе наиболее любопытны Xeon Max, которые, по словам Intel, по сравнению с прошлым поколением в 3,7 раз производительнее в задачах, завязанных на пропускную способность памяти (а это целый пласт HPC-нагрузок), и которые не так уж дороги. Правда, и здесь без приключений не обошлось — несчастный суперкомпьютер Aurora ожидает утомительный апгрейд его 10 тыс. узлов c простых Xeon Sapphire Rapids на Xeon Max — по полчаса на каждый узел.

10.01.2023 [17:11], Сергей Карасёв

Microsoft подтвердила поглощение DPU-разработчика Fungible, но сумму сделки так и не назвалаКорпорация Microsoft официально объявила о заключении соглашения по покупке компании Fungible — молодого разработчика DPU (Data Processing Unit). О сумме сделки ничего не сообщается. Слухи о том, что редмондский гигант проявляет интерес к Fungible, появились в середине декабря 2022 года. Тогда говорилось, что приобретение стартапа обойдётся Microsoft приблизительно в $190 млн. Решения Fungible помогут Microsoft поднять производительность её дата-центров. По условиям соглашения, команда Fungible присоединится к подразделению разработки ЦОД-инфраструктур Microsoft. Специалисты компании сосредоточатся на создании нескольких специализированных DPU, а также на сетевых инновациях и улучшении аппаратных систем. «Технологии Fungible помогают создать высокопроизводительную, масштабируемую, дезагрегированную, горизонтально масштабируемую инфраструктуру ЦОД с высокими показателями надёжности и безопасности», — говорится в заявлении Microsoft.

Источник изображения: Fungible Добавим, что Fungible была основана в 2015 году выходцами из Xerox PARC Прадипом Синдху (Pradeep Sindhu, сооснователь и бывший глава Juniper Networks) и Бертраном Серле (Bertrand Serlet, работал в Apple и Parallels, основал Upthere). Стартап привлёк более $300 млн инвестиций, но в последнее время дела у него шли не слишком хорошо. По слухам, после неудачной попытки продать компанию Meta✴ стартап был вынужден уволить часть сотрудников и сократить портфолио решений. Fungible, как и ряд аналогичных проектов, по мере развития перешёл от создания сверхбыстрых хранилищ к идее переноса на DPU иных инфраструктурных задач по примеру AWS Nitro (собственная разработка Amazon). Однако, как утверждают некоторые источники, сложность разработки ПО негативно сказалась на популярности решений Fungible. Например, Google пошла по другому пути и заручилась поддержкой Intel.

28.12.2022 [21:30], Руслан Авдеев

Муниципалитет в США позволил превратить историческое кладбище в братские могилы ради очистки места для нового дата-центра MicrosoftВ ходе подготовки земли в округе Мекленберг штата Вирджиния к строительству дата-центра Microsoft, было обнаружено старое кладбище. Как сообщает DataCenter Dynamics со ссылкой на ProPublica, строители при содействии властей округа и самой Microsoft, попытались принизить его значение, предприняв ряд мер по сокрытию исторической важности объекта. После того как кладбище было обнаружено, округ обратился к археологам, как того требует федеральный закон. Вопреки надеждам заинтересованных сторон, археологи решили, что место захоронения должно быть внесено в Национальный реестр исторических мест — это означало бы, что строительство на площадке будет запрещено. Эксперт рекомендовал избегать строительства на данной территории. Консультант компании Enviro-Utilities, выполнявшей работы, заявил, что рекомендация будет оспорена. Все работы оплачивала Microsoft. Enviro-Utilities и власти округа попытались надавить на археологов, чтобы те отменили свои рекомендации о включении в Национальный реестр. Тем не менее, ещё один археолог, нанятый заказчиками, тоже порекомендовал провести дополнительные исследования. Вместо этого округ в соответствии с законами опубликовал в местной газете небольшую заметку о находке останков среди рекламных объявлений и намерении перенести их, после чего вскоре приступил к работам. При этом, как утверждает источник, минимум один ныне живущий потомок лиц, захороненных на найденном кладбище, широко известен в данной местности, но никаких попыток найти ни его, ни других членов семей похороненных не предпринималось. Всего было обнаружено 37 могил, которые Департамент исторических ресурсов штата разрешил перенести в другое место. Останки переносили очень быстро, под проливным дождём, а за сотрудниками, по слухам, следил беспилотник Microsoft. В результате буквально все кости перемешались и были захоронены всего в четырёх могилах, причём без необходимых отметок — о числе покоящихся, об изначальном местоположении могил, о датах и именах. В Microsoft сообщили, что округ придерживался всех федеральных и местных законов. Вирджиния, особенно её северная часть, является местом концентрации операторов дата-центров, построивших здесь многочисленные кампусы ЦОД благодаря привлекательным условиям, созданным местными властями для инвесторов. Впрочем, местные жители рады притоку средств далеко не так сильно, как местные власти. Они постоянно жалуются на захват земель с изменением зонирования и ущерб экологии, включая сильное шумовое загрязнение.

26.12.2022 [16:49], Руслан Авдеев

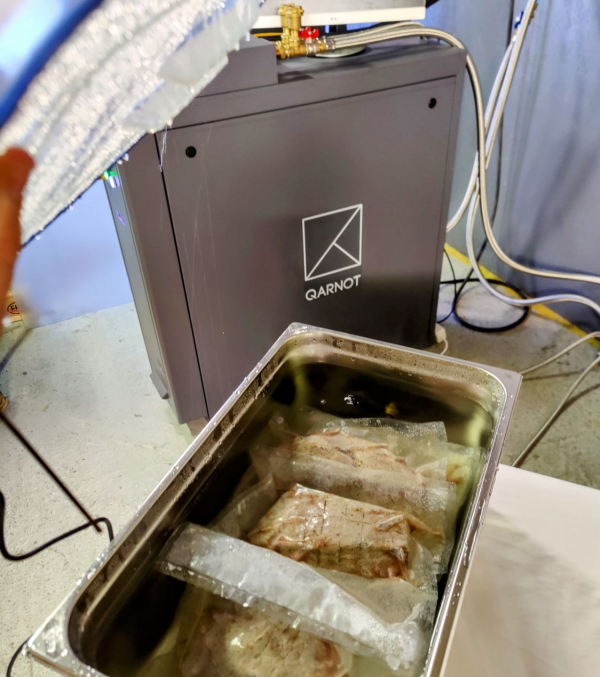

Су-вид в стиле Qarnot: как приготовить ужин с помощью сервераФранцузская компания Qarnot предоставляет услуги высокопроизводительных вычислений компаниям вроде Adobe, Societe Generale, Illumination и Fix Studio. Изюминкой её деятельности является акцент на использовании тепла серверов в разных целях — на этот раз его применили для приготовления ужина. Вычислительные кластеры Qarnot OBx, по данным компании, позволяют использовать до 96 % выделяемого серверами тепла для нагрева, например, воды. Один из них и использовала Qarnot, подойдя к вопросу использования тепла с кулинарной изобретательностью. Так, в ёмкости c циркулирующей горячей водой появились утка, говядина и лосось. Чтобы охлаждающая жидкость не превратилась в бульон, продукты разместили в вакуумированной упаковке. Пока система занималась 3D-рендерингом, температура в ёмкости поддерживалась на уровне +55 °C. Этого вполне достаточно, чтобы использовать французскую технологию приготовления мяса sous vide — она предусматривает приготовление блюд при относительно невысоких температурах. Правда, процесс приготовления в этом случае затягивается. Разумеется, в данном случае речь идёт лишь о демонстрации возможностей решений Qarnot. Компания активно продаёт отработанное тепло, но оно обычно применяется более традиционными способами, преимущественно для отопления жилых и коммерческих зданий. По словам технического директора компании, её решения снижают энергозатраты на отопление на 65 %, а сопутствующие выбросы углерода — на 81 %. В 2018 году компания представила «криптообогреватели», представляющие собой комбинацию вычислительного устройства и обогревателя для дома, а в 2020 году предложила отапливать дома с помощью б/у серверов.

20.12.2022 [17:06], Владимир Мироненко

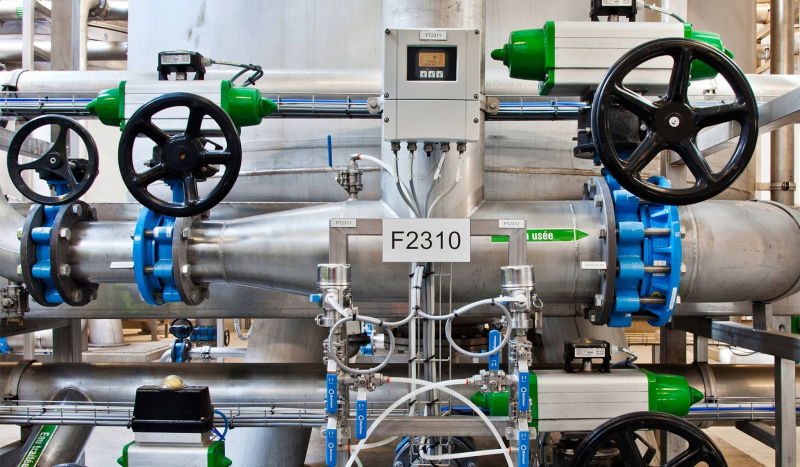

В результате судебного разбирательства выяснилось, что на один ЦОД Google приходится четверть объёма потребления питьевой воды американского городкаGoogle раскрыла объёмы потребления воды своих ЦОД. На этот шаг компания пошла после судебного процесса между местной газетой The Oregonian и властями Даллеса (штат Орегон), которые пытались сохранить данную информацию в секрете. В прошлом году The Oregonian затребовала данные о водопотреблении у Google, но не получила их и обратилась к городским властям. Муниципалитет отказался предоставлять эту информацию, объявив её коммерческой тайной, после чего газета подала к нему иск. В итоге городским властям пришлось пойти на попятную. Выяснилось, что в течение 2021 года на объектах поисковой компании в Даллесе было израсходовано около 1,2 млрд л воды, что гораздо меньше по сравнению с 3,8 млрд л, израсходованными инфраструктурой ЦОД Google в Каунсил-Блаффсе (штат Айова). В целом в 2021 году потребление воды на объектах Google в США составило 12,4 млрд л, а за пределами США — 4,4 млрд л. Сама компания считает, что это не так уж и много, утверждая, что общее годовое потребление воды её дата-центрами сопоставимо с расходом воды на обслуживание 29 полей для гольфа на юго-западе США. Google уточнила, что речь идёт о питьевой воде и указанные объёмы не включают воду из других источников, например, морскую воду. По данным The Oregonian, потребление воды ЦОД Google в Даллесе почти утроилось за последние пять лет и теперь составляет более четверти всего объёма воды, используемой в городе. Эти цифры будут расти, поскольку компания планирует построить в городе ещё два ЦОД. Следует также отметить, что Даллес находится в засушливом регионе и здесь наблюдается пик многолетней засухи.

Изображение: Google Исполнительный директор некоммерческой правозащитной группы WaterWatch Джон ДеВоу (John DeVoe) заявил, что увеличение потребления ЦОД воды в два или три раза в течение следующего десятилетия может иметь серьёзные последствия для обитателей водоёмов и других водопользователей в районе Даллеса. Он отметил, что потребление воды в городе удвоилось с 2002 по 2021 год, что поставило под угрозу протекающую здесь реку и отдельные виды обитающих в ней рыб. ДеВоу уточнил, что на долю Google приходится до 29 % всего городского потребления воды. В свою очередь, Google и городские власти заявили, что заключённый контракт учитывает потребности города в воде и что компания обязуется выделить $28,5 млн на модернизацию систем поставки воды. Кроме того, она передала городу права на использование воды на своих промышленных землях в обмен на большее количество воды из городских резервуаров. Город обязался предоставить Google больше воды для новых ЦОД, начав перекачку не использовавшихся ранее подземных вод. Понимая, что у общественности растёт обеспокоенность по поводу значительных объёмов расхода воды ЦОД, технологические компании весьма неохотно делятся такой информацией. Согласно исследованию Uptime Institute, лишь около половины компаний сообщает об использовании воды или выбросах углекислого газа в ЦОД.

14.12.2022 [15:31], Сергей Карасёв

Microsoft купила разработчика необычного оптоволокна LumenisityКорпорация Microsoft объявила о заключении соглашения о покупке компании Lumenisity, базирующейся в Великобритании. Этот стартап, основанный в 2017 году, специализируется на разработке решений для высокоскоростной передачи данных с применением технологии полого оптоволокна HCF (Hollow Core Fiber). Компания Lumenisity создана как дочерняя структура Исследовательского центра оптоэлектроники (ORC) Саутгемптонского университета. Конструкцией HCF предусмотрено наличие заполненного воздухом канала, окружённого кольцом стеклянных трубок, похожим на соты. Свет проходит не через обычное волокно, а через воздушный канал, так что, по словам Lumenisity, он распространяется по HCF-кабелям примерно на 47 % быстрее, чем через волокно из кварцевого стекла. Хотя это и не новая технология, интерес к ней растёт по мере улучшения пропускной способности и надёжности. Такая конструкция позволяет не только повысить скорость передачи данных и снизить задержки, но и открывает путь к созданию протяжённых ВОЛС без использования репитеров благодаря более низким потерям энергии. Кроме того, Lumenisity говорит, что её решение дешевле аналогов и лучше защищено от вторжений. Microsoft заявляет, что приобретение Lumenisity расширит возможности по дальнейшей оптимизации глобальной облачной инфраструктуры Azure. Lumenisity привлекла на развитие в общей сложности около $15,5 млн, а недавно открыла производственное предприятие HCF в Ромси, Великобритания. Финансовые условия сделки не раскрываются. Важно отметить, что волокно Lumenisity не требует для развёртывания специального оборудования и работает со многими оптическими системами, которые сегодня используются в телекоммуникационных сетях. По всей видимости, Microsoft будет применять технологию Lumenisity для объединения своих ЦОД. Также Microsoft по неподтверждённым пока официально данным приобрела Fungible, разработчика DPU. Компания, судя по всему, намерена задействовать эти DPU только для собственных нужд.

13.12.2022 [21:52], Алексей Степин

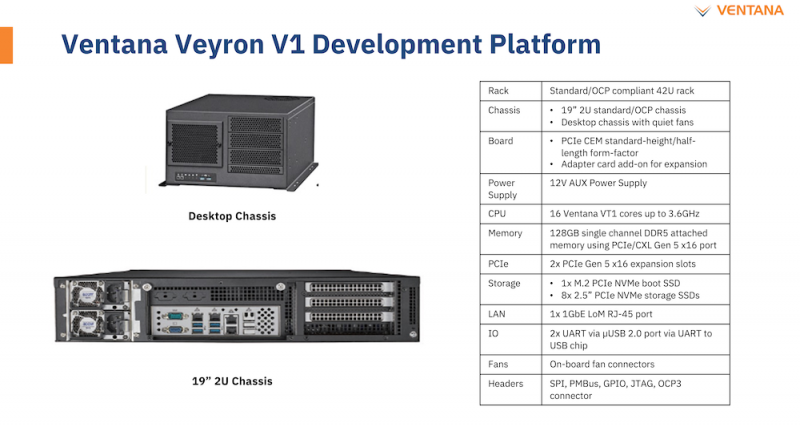

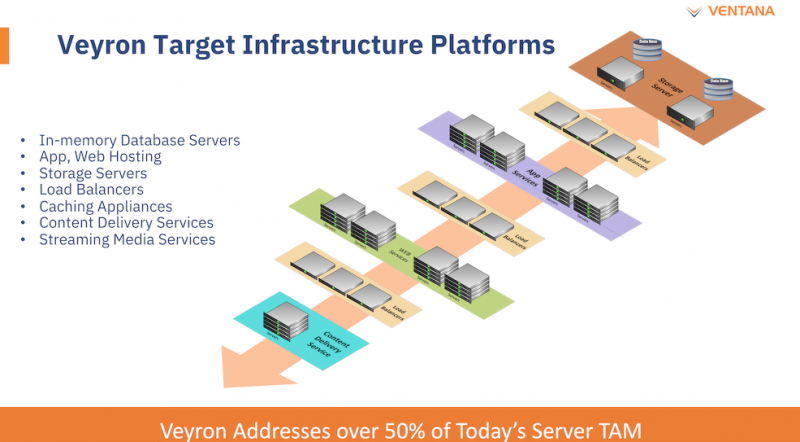

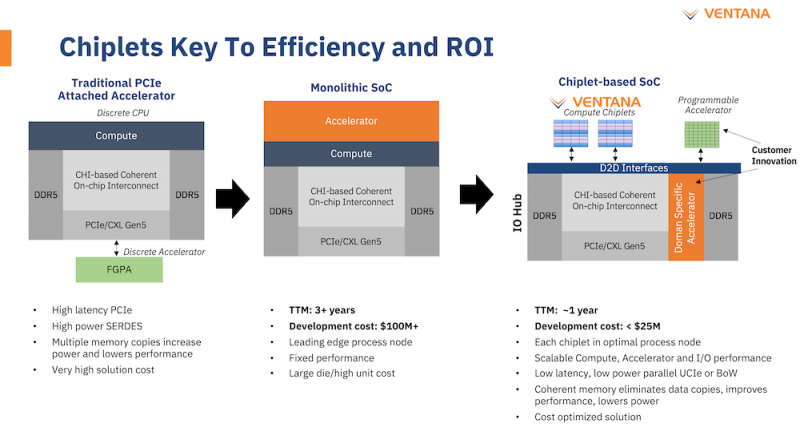

Ventana анонсировала первый по-настоящему серверный RISC-V процессор Veyron V1: 192 ядра с частотой 3,6 ГГцАрхитектура RISC-V достаточно молода и обычно ассоциируется с экономичными чипами на платах, подобных Raspberry Pi. Однако технически она позволяет создавать и мощные процессоры, способные поспорить с лучшими решениями на базе архитектур Arm и x86. На саммите RISC-V компания Ventana Micro Systems анонсировала целое семейство высокопроизводительных процессоров, первенцем в котором стал чип Veyron V1, который, по словам разработчиков, сможет потягаться в однопоточной производительности с самыми современными CPU класса High-End. Новинка нацелена на рынок гиперскейлеров, причём благодаря чиплетному дизайну новый процессор изначально разрабатывался как кастомизируемый под задачи заказчика. Veyron V1 будет предлагаться в виде своеобразного набора-конструктора, включающего в себя один или несколько вычислительных чиплетов Veyron, I/O-хаба и интерконнекта, позволяющего связать все компоненты воедино. Это, по словам разработчиков, должно серьёзно ускорить и удешевить процесс внедрения новой процессорной платформы, снизив расходы на разработку чипов на 75 %, а время создания — до не более чем двух лет.

Платформа Veyron V1 универсальна и покрывает широкий спектр задач. Источник здесь и далее: StorageReview Вычислительный чиплет Veyron V1 использует продвинутые 64-битные ядра RISC-V и располагает 2 Мбайт кеша L2, а также многопоточным контроллером памяти. Предусмотрены конфигурации чиплета с 6, 8, 12 или 16 ядрами с частотой в районе 3 ГГц, что сопоставимо с решениями Google и AWS. Использоваться процессор может не только в ЦОД, но и в различных встраиваемых системах, базовых станциях 5G или даже клиентских рабочих станциях.

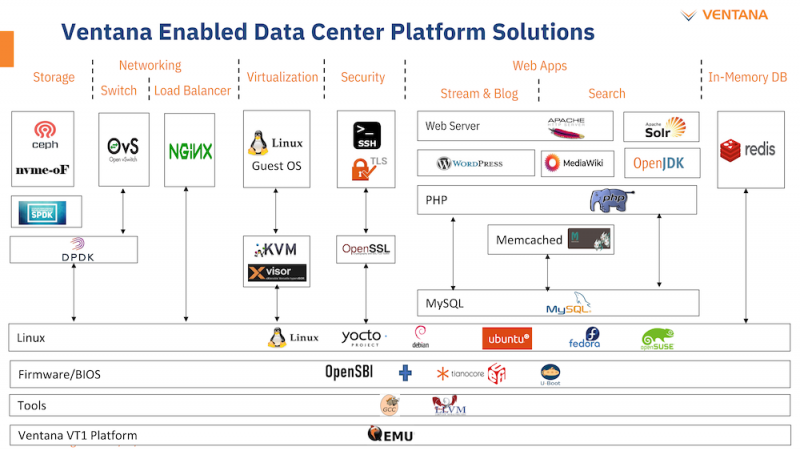

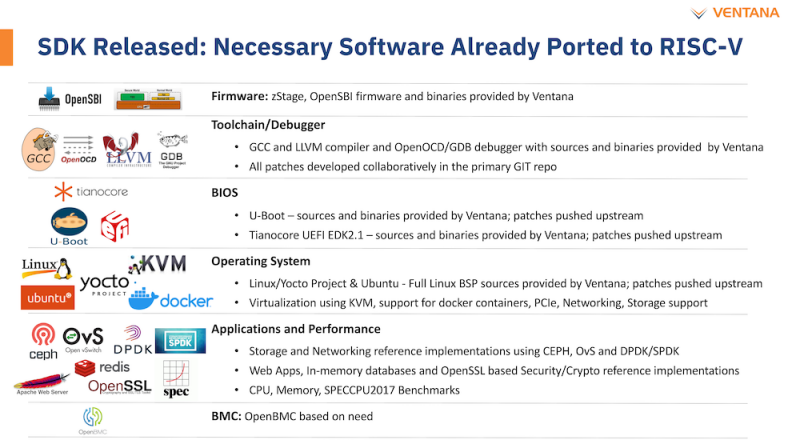

Чиплетная архитектура ускорит цикл разработки и внедрения, а также упростит задачу подключения кастомных ускорителей Архитектурно дизайн Veyron V1 использует агрессивный конвейер шириной восемь инструкций и с внеочередным исполнением. Чип способен работать на частоте до 3,6 ГГц благодаря использованию 5 нм техпроцесса TSMC. I/O-хаб может производиться с использованием более дешёвых 12 или даже 16-нм техпроцессов. Для соединения компонентов процессора разработан специальный низколатентный интерконнект D2D. Каждый чиплет включает в себя до 16 ядер, предусмотрена возможность масштабирования процессора до 192 ядер в 12 чиплетах. Общий объём разделяемого кеша L3 составляет 48 Мбайт. Заявлен высокий уровень защищённости архитектуры от атак по сторонним каналам. Разработчики заявляют о беспрецедентно низком энергопотреблении: 128 ядер V1 уложатся в 280 Вт; AMD EPYC 7763 потребляет столько же при вдвое меньшем числе ядер. Анонс Ventana нельзя назвать «бумажным» — компания говорит о доступности комплектов разработчика, причём сразу в двух типах шасси: в настольном и в серверном корпусе высотой 2U. Конфигурация включает в себя 16-ядерную версию V1, 128 гбайт памяти DDR5, подключенной с помощью интерфейса CXL (PCIe 5.0) x16, два свободных слота расширения PCIe 5.0 x16, загрузочный накопитель NVMe M.2 и 8 NVMe SFF SSD формата 2,5" для хранения данных. Для удалённого управления предусмотрен 1GbE-порт. Компания не забыла и о поддержке со стороны программного обеспечения: платформы разработчика Ventana Veyron V1 будут сопровождаться полноценным SDK с основным ПО, уже портированным на новую архитектуру. В список входят компиляторы GCC и LLVM, отладчик OpenOCD/GDB, исходные коды и бинарные файлы загрузчиков U-Boot и Tianocore UEFI EDK2.1. Поддерживается ряд дистрибутивов Linux, а также другое системное и прикладное ПО. Ожидается, что новые системы будут доступны в начале следующего года.

30.11.2022 [16:55], Алексей Степин

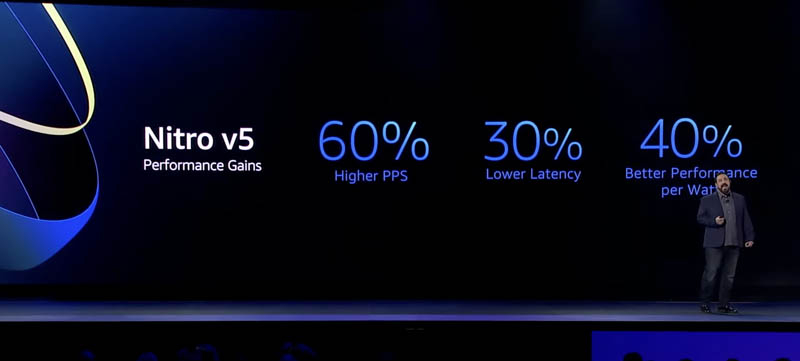

AWS представила пятое поколение аппаратных гипервизоров NitroНа днях крупный провайдер облачных услуг, компания Amazon Web Services представила новые варианты инстансов на базе новейших процессоров Graviton3E, но данный чип — не единственная новинка AWS. Одновременно с Graviton3E было представлено и пятое поколение аппаратных гипервизоров Nitro, существенно выигрывающих по ключевым показателям у решений предыдущего, четвёртого поколения.

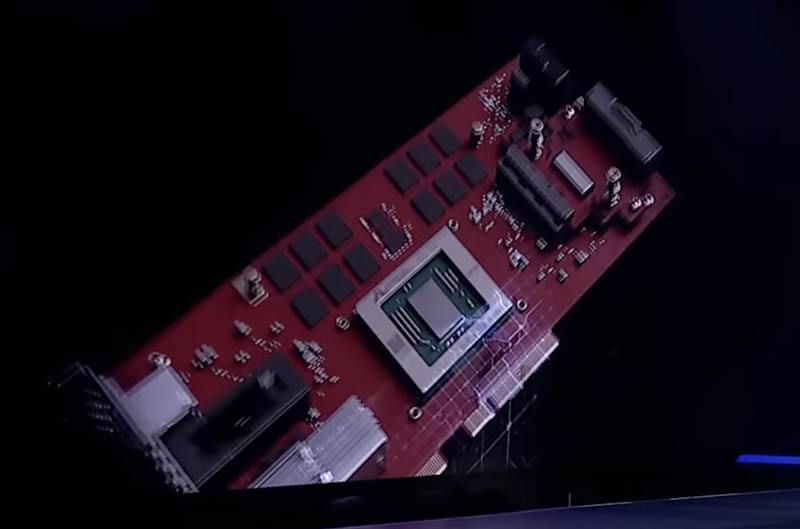

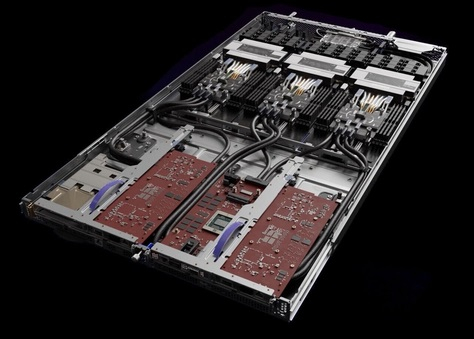

Здесь и далее источник изображений: ServeTheHome Главная идея Nitro — сочетание «кремния» гипервизора, DPU и сопроцессора безопасности с поддержкой Root of Trust в едином чипе. В системах AWS плата с чипом Nitro полностью управляет распределением вычислительных ресурсов и памяти, избавляя от этой нагрузки хост-процессоры. По результатам тестов, проведённых AWS, производительность облачных инстансов с использованием ускорителей Nitro практически не отличается от производительности классической bare metal-системы.  AWS Nitro v5 использует кастомный кристалл, разработанный Annapurna Labs. По сравнению с Nitro v4, количество транзисторов было удвоено, но за счёт этого удалось на 60 % поднять скорость обработки сетевых пакетов, на 30 % снизить латентность, а также, благодаря продвинутому техпроцессу, обеспечить лучшую удельную производительность.

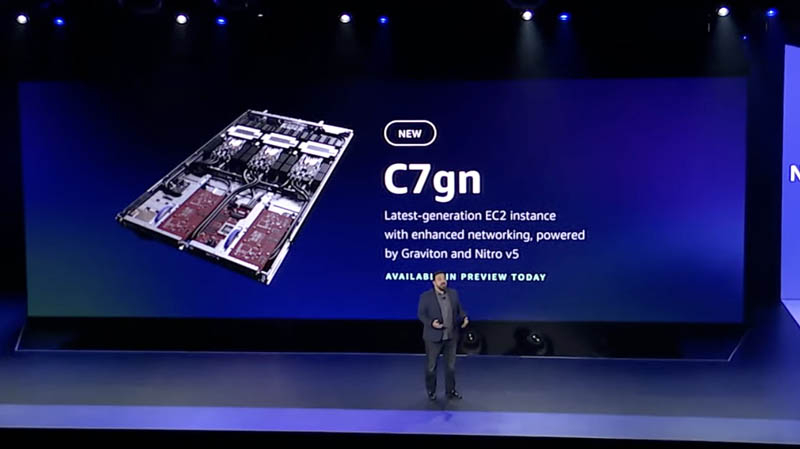

Платы AWS Nitro v5 используют проприетарные разъёмы Улучшились и другие характеристики: на 50 % выросла пропускная способность памяти и вдвое возросла производительность подсистемы PCI Express. Платы Nitro v5 станут сердцем новых инстансов C7gn, где обеспечат полную изоляцию критически важных подсистем, таких, как прошивки BIOS, BMC и накопителей от гостевого доступа извне и позволят обновлять эти прошивки без влияния на клиентские нагрузки.  Также они возьмут на себя обслуживание сетей VPC/EBS, включая переход на использование SRD вместо TCP, и накопителей Nitro SSD. AWS уже объявила о возможности предварительного тестирования систем C7gn на базе Nitro v5 и новейших процессоров Graviton3/3E.

29.11.2022 [17:12], Алексей Степин

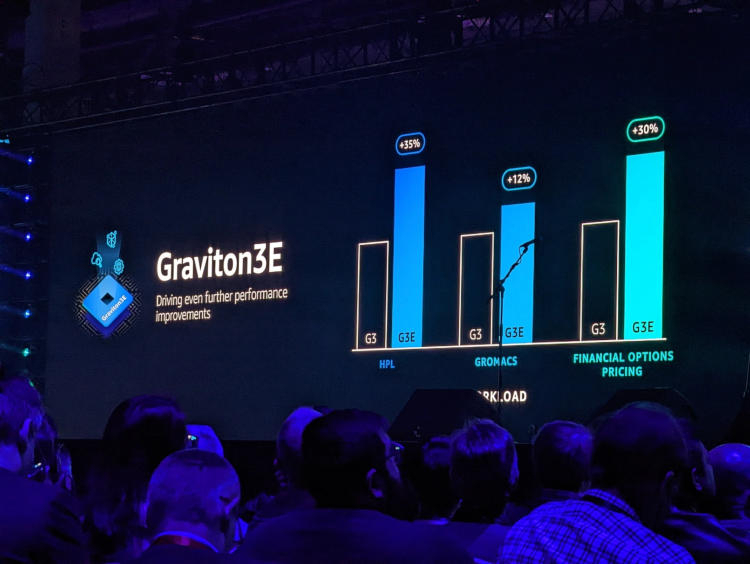

AWS представила Arm-процессор Graviton3E, оптимизированный для задач ИИ и HPCОдин из крупнейших облачных провайдеров, компания Amazon Web Services объявила о доступности новых инстансов EC2 на базе процессора Graviton3E. Новый чип — наследник анонсированного в конце 2021 года Graviton3, 5-нм 64-ядерного процессора на дизайне Arm Neoverse V1 (Zeus) с поддержкой DDR5 и PCI Express 5.0. Graviton3 использует набор команд Armv8.4 c расширениями Neon (4×128 бит) и SVE (2×256 бит) и поддерживает работу с популярными в сфере машинного обучения форматами данных INT8 и BF16. В сравнении c Graviton2 процессор быстрее на 25-60 % при сохранении аналогичного уровня тепловыделения. Дизайн серверов AWS предусматривает наличие трёх процессоров на узел высотой 1U.

Изображения: AWS Новый процессор Graviton3E представляет собой дальнейшее развитие Graviton3. Чип оптимизирован с учётом потребностей рынка высокопроизводительных вычислений и основное внимание в его архитектуре уделено повышению производительности на операциях с плавающей запятой и вычислениях с использованием векторной математики. AWS, к сожалению, пока не раскрывает деталей относительно архитектуры Graviton3E, но прирост производительности на векторных операциях относительно обычного Graviton3 может достигать 35 %. Помимо классического теста HPL новый процессор хорошо проявляет себя в тестах, имитирующих медико-биологические и финансовые задачи.  Сценарии нагрузок, характерные для HPC, как правило, активно оперируют перемещением крупных объемов данных. Чтобы оптимизировать этот процесс, в новых инстансах AWS использует сеть на базе Elastic Fabric с новыми адаптерами Elastic Network Adapter (ENA). Такая сеть оперирует т. н. Scalable Reliable Datagram (SRD) вместо всем привычных TCP-пакетов. SRD позволяет организовать повторную отправку пакетов за микросекунды вместо миллисекунд в классическом Ethernet. Сердцем же новых инстансов AWS стало пятое поколение аппаратных гипервизоров Nitro 5. В сравнении с предыдущим поколением, Nitro 5 обладает вдвое более высокой вычислительной производительностью, на 50 % повышенной пропускной способностью памяти, а также позволяет обрабатывать на 60 % больше сетевых пакетов при сниженной на 30 % латентности.

Здесь и далее источник изображений: AWS Инстансы Hpc7g с процессорами Graviton3E получат внутреннюю сеть с пропускной способностью 200 Гбит/с и станут доступны в различных конфигурациях вплоть до 64 vCPU и 128 ГиБ памяти. Аналогичные параметры имеют инстансы C7gn, предназначенные для задач с интенсивным сетевым трафиком: виртуальных маршрутизаторов, сетевых экранов, балансировщиков нагрузки и т.п. Также компания анонсировала инстансы R7iz, в которых используются процессоры Intel Xeon Scalable четвёртого поколения (Sapphire Rapids) с постоянной частотой всех ядер 3,9 ГГц. Они могут иметь конфигурацию до 128 vCPU с 1 ТиБ памяти. |

|