Лента новостей

|

18.06.2024 [00:18], Владимир Мироненко

С чистого листа: VMware возобновила сотрудничество с Dell и подписала OEM-соглашения с Lenovo и HPEVMware, поглощённая Broadcom в результате сделки на $69 млрд, переподписала OEM-соглашения с тремя ключевыми поставщиками оборудования: Dell, HPE и Lenovo. Это, в частности, позволит им и дальше продавать гиперконвергентные системы и серверы с предустановленным стеком ПО VMware. Сообщивший об этом ресурс The Register утверждает, что это большое достижение для VMware, поскольку гиперконвергентная инфраструктура, сочетающая в себе вычислительные мощности, СХД и сетевую виртуализацию, являются популярным способом комплектации ИТ-продуктов для корпоративного сегмента, и теперь к их продаже присоединились три крупнейших производителя соответствующего оборудования. Все три компании имеют значительную клиентскую базу, поэтому сделка с VMware тоже пойдёт им на пользу. Ранее Dell сообщила Комиссии по ценным бумагам и биржам США (SEC), что с 25 января перестали работать дистрибуторские соглашения, заключённые с VMware, когда та входила в состав Dell. В свою очередь, Broadcom объявила в феврале, что уравнивает правила игры для OEM-партнёров VMware, включая Dell, HPE, Lenovo и т.д.

Источник изображения: VMware После заключения нового соглашения с VMware компания Dell опубликовала заявление, в котором заявила: «Новое соглашение основано на более чем 20-летнем сотрудничестве Dell и VMware и позволяет компаниям продолжать предоставлять совместно разработанные решения, которые помогают организациям внедрять современные приложения и оптимизировать свои ЦОД». В заявлении указано, что сделка охватывает HCI-платформы Dell VxRail и Dell vSAN Ready Nodes, серверы Dell PowerEdge и системы Dell PowerFlex. Подписание новых соглашений произошло спустя после того, как Intel и AMD анонсировали новые линейки серверных процессоров. Виртуализация только выигрывает от многоядерности, поскольку позволяет обеспечить ещё большую консолидацию мощностей. По мнению The Register, это хорошая новость для Broadcom, которая изменила политику лицензирования продуктов VMware, что многие связали с повышением цен, хотя чипмейкер утверждает, что на самом деле новое предложение является более выгодными для клиентов.

17.06.2024 [22:49], Илья Коваль

Три квантовых компьютера, NVIDIA DGX Quantum, немножко HPC и облако: в Израиле открыт уникальный центр квантовых вычислений IQCC

aws

gh200

grace

hardware

hpc

nvidia

quantum machines

израиль

квантовые вычисления

квантовый компьютер

облако

разработка

Стартап Quantum Machines, разработчик систем управления квантовыми компьютерами, открыл Израильский центр квантовых вычислений (Israeli Quantum Computing Center, IQCC). Площадка, создание которой было частично профинансировано правительством страны, располагается в Тель-Авивском университете. По словам основателей, это первый в мире центр, располагающий квантовыми компьютерами разных типов, которые интегрированы с системой NVIDIA DGX Quantum, HPC-инфраструктурой и облаком. Приоритетный доступ со скидкой получат исследовательские организации Израиля, но в целом центр будет открыт для компаний со всего света. Как говорят создатели, IQCC — это лучший в мире полигон для создания новых технологий в области квантовых вычислений, а открытая архитектура площадки позволяет регулярно проводить обновления и упрощает дальнейшее масштабирование возможностей и вычислительных мощностей. Сейчас в IQCC установлены 21-кубитный компьютер Galilee от Quantware на сверхпроводящих кубитах (ещё один такой же используется в качестве тестовой платформы) и фотонный компьютер Negev от ORCA (8 кумод). Системы управляются контроллерами OPX1000 от самой Quantum Machines. HPC-инфраструктура представлена DGX A100, четырьмя GH200 и 128 vCPU на базе AMD EPYC 9334 (Genoa). Дополнительные ресурсы можно арендовать в облаке AWS. Для Galilee и Negev доступна интеграция с DGX Quantum, платформой для гибридных квантово-классических вычислений, которая была создана NVIDIA и Quantum Machines и впервые в мире развёрнута именно в IQCC. Управлять компьютерами и разрабатывать ПО можно с использованием Qiskit, QUA, OpenQASM3, QBridge, а также Classiq. К системе организован облачный доступ. В ближайшие месяцы в IQCC будут развёрнуты ещё несколько квантовых компьютеров и QPU.

17.06.2024 [13:09], Сергей Карасёв

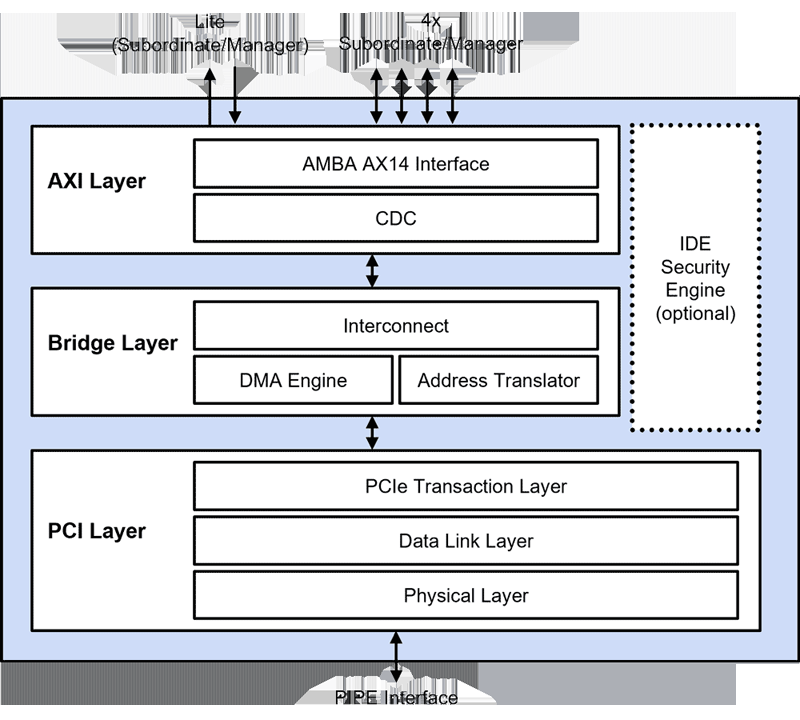

Rambus представила набор решений PCIe 7.0, включая высокопроизводительный контроллерКомпания Rambus анонсировала пакет IP-блоков для создания различных продуктов стандарта PCI Express (PCIe) 7.0. В частности, представлен высокопроизводительный контроллер для систем, ориентированных на решение задач в области ИИ и НРC. Предварительная версия спецификации PCIe 7.0 была обнародована в апреле нынешнего года. Стандарт предусматривает скорость передачи данных до 128 ГТ/с, что обеспечивает до 512 Гбайт/с в двустороннем режиме в конфигурации x16. Ожидается, что PCIe 7.0 найдёт применение в 800GbE-решениях, системах ИИ, платформах квантовых вычислений и ЦОД нового поколения.

Источник изображения: Rambus Контроллер Rambus стандарта PCIe 7.0 поддерживает максимально предусмотренную спецификацией скорость работы — 128 ГТ/с. Реализованы средства коррекции ошибок (Forward Error Correction, FEC) с малой задержкой. Среди прочего упомянуты обратная совместимость со стандартами PCIe предыдущих поколений (PCIe 6.0, 5.0, 4.0 и пр.), поддержка шины AMBA AXI, а также развитые инструменты обеспечения безопасности. «Контроллер PCIe 7.0 обеспечивает высокую пропускную способность, низкую задержку и надёжность, необходимые для приложений ИИ и НРС нового поколения», — заявляет разработчик. Кроме того, Rambus представила ретаймер PCIe 7.0 с поддержкой конфигураций от x2 до x16, высокопроизводительный коммутатор PCIe 7.0 Switch с возможностью использования до 32 портов и другие решения.

17.06.2024 [11:45], Сергей Карасёв

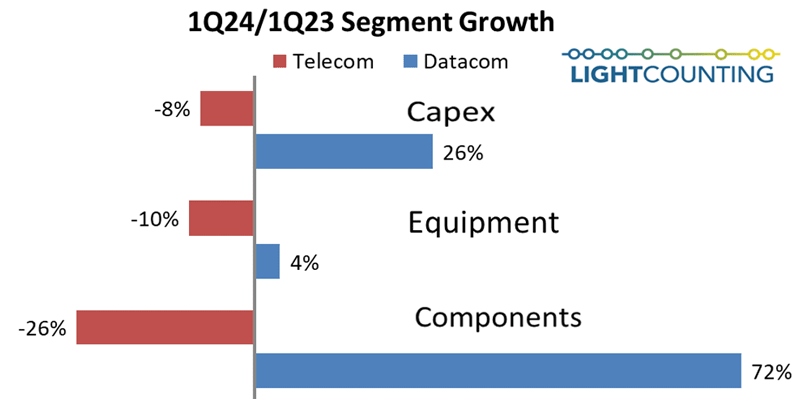

400G/800G для ИИ: спрос на оптическое сетевое оборудование для ЦОД растётКомпания LightCounting, по сообщению ресурса IEEE ComSoc, подвела итоги исследования мирового рынка оптического сетевого оборудования в I квартале 2024 года. Говорится, что отрасль демонстрирует разнородную динамику: в телекоммуникационном сегменте зафиксирован спад, тогда как сектор дата-центров (гиперскейлеров и облачных провайдеров) растёт. В частности, совокупные капвложения 15 крупнейших участников телеком-рынка в годовом исчислении снизились на 8 %. Затраты в данной сфере сокращаются шестой квартал подряд. А в области ЦОД капитальные затраты поднялись год к году на 26 %. Отмечается, что Alphabet (материнская компания Google) показала рост на 91 %, а Microsoft — на 66 %. Кроме того, существенную прибавку показали китайские провайдеры, что объясняется бумом ИИ.

Источник изображения: ComSoc В телекоммуникационном сегменте продажи оптического оборудования в I четверти 2024 года сократились на 10 % по сравнению с тем же периодом 2023-го. В то же время в ЦОД-секторе спрос на коммутаторы и другие устройства поднялся год к году на 4 %. В плане поставок различных оптических компонентов наблюдается схожая картина: в телеком-секторе зафиксировано падение на 26 % в годовом исчислении, тогда как по направлению дата-центров отмечена прибавка на уровне 72 %. В исследовании отмечается, что спрос на оптические трансиверы Ethernet 400G и 800G для ИИ-кластеров в целом соответствует ожиданиям. Продажи решений DWDM начали восстанавливаться в IV квартале 2023 года. Вместе с тем увеличение продаж трансиверов FTTx и WFH не ожидается до 2025–2026 гг. В сегменте полупроводниковых изделий продажи в I квартале 2024 года поднялись на 61 % в годовом исчислении. При этом, как отмечается, NVIDIA нарастила выручку на 262 %. Упомянута также компания Broadcom, у которой рост продаж зафиксирован на отметке 43 %.

17.06.2024 [08:53], Руслан Авдеев

Cerebras и Dell предложат заказчикам современные ИИ-платформыРазработчик ИИ-суперчипов Cerebras Systems анонсировал сотрудничество с Dell. Вместе компании займутся созданием передовых вычислительных инфраструктур для генеративного ИИ. В рамках сотрудничества будут создаваться масштабируемые решения для ИИ-суперкомпьютеров Cerebras с платформами Dell на базе процессоров AMD EPYC Genoa. По словам участников проекта, новые технологические решения дадут возможность обучать модели, на порядки более крупные, чем те, что есть на данный момент. В частности, будут задействованы системы Dell PowerEdge R6615 на базе AMD EPYC 9354P, которые предоставят потоковый доступ к 82 Тбайт памяти — для обучения моделей практически любого размера. Совместные платформы Cerebras и Dell будут включать ИИ-системы и суперкомпьютеры. Также будет предложена тренировка ИИ-моделей и иные сервисы поддержки машинного обучения. Как утверждают в самой Cerebras, сотрудничество с Dell станет поворотной точкой, открывающие каналы глобальной дистрибуции. Компании предоставят ИИ-оборудование, ПО и экспертизу, что позволит заказчикам упростить и ускорить внедрении современных ИИ-технологий, попутно снизив TCO. В марте Cerebras представила новейшие суперчипы Cerebras WSE-3, а в мае появилась новость, что совместно с Core42 из ОАЭ компания создаст суперкомпьютер Condor Galaxy 3 (CG-3) со 172,8 млн ИИ-ядер.

16.06.2024 [21:34], Руслан Авдеев

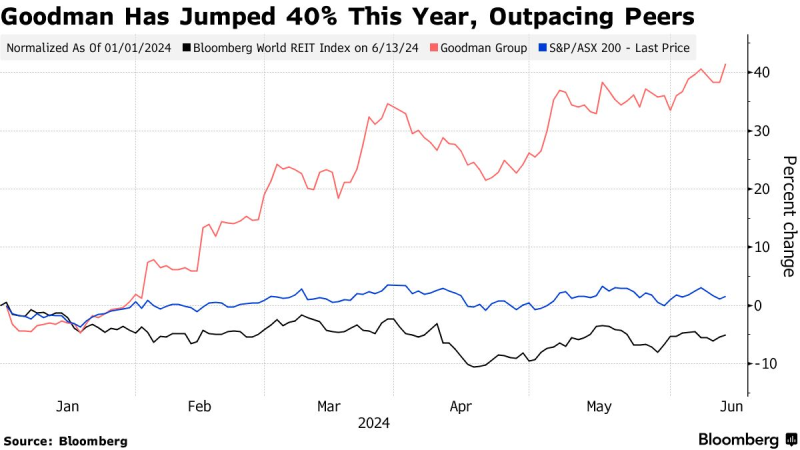

Дата-центры для ИИ обещают принести немало выгоды: лидером роста в глобальном REIT-индексе Bloomberg стала австралийская Goodman GroupИнвесторы делают ставки на то, что сиднейская Goodman Group в этом году продолжит стремительно расти. Bloomberg сообщает, ожидания экспертов обусловлены выгодным географическим расположением её активов и мощным потоком финансовых ресурсов, которые обеспечат существенное развитие бизнеса компании в сфере ЦОД для ИИ. В этом году акции REIT-траста Goodman, инвестирующего в недвижимость, выросли на 40 % — это лучший показатель в рейтинге Bloomberg World REIT Index. В портфеле компании множество объектов соответствующего профиля, от Сиднея до Гонконга, Лос-Анджелеса и Франкфурта. Более того, компания активно переоборудует в хранилища данных и принадлежащие ей склады. По мнению отраслевых экспертов, Goodman владеет буквально неоценимыми активами поблизости от ключевых регионов деловой активности.

Источник изображения: Googdman Group Показатели Goodman отражают то, как высоко инвесторы всего мира оценивают возможности заработка на ИИ, даже на рынках вроде Австралии, где доминируют глобальные игроки из числа добывающих компаний и банков. В прошлом месяце траст улучшил прогноз роста по итогам фискального года, который закончится 30 июня, с 11 % до 13 %. Предполагается, что этому помог растущий спрос на инфраструктуру для цифровой экономики. В Goodman уверены, что бухгалтерский баланс компании обеспечит ей успех даже на фоне продолжающейся высокой волатильности на мировом рынке недвижимости. При этом эксперты Bloomberg Intelligence уверены, что поворот бизнеса Goodman от традиционного рынка индустриальной недвижимости не просто «трюк с ИИ» — компания может сохранить рост выручки благодаря перепрофилированию существующих активов и развитию новых проектов для удовлетворения мировых требований к обработке данных. Впрочем, оценки биржевых показателей компании вызывают некоторую озабоченность аналитиков, хотя пока беспокоиться не о чем, поскольку у компании имеется большой потенциал роста. По мере того как будут вводиться в эксплуатацию всё новые энергетические резервы Goodman, будет расти и потенциал дальнейшего развития в сравнении с конкурентами. В Citigroup считают, что результаты работы компании могут превзойти прогнозы аналитиков. В феврале 2024 года сама Goodman сообщала, что обладает возможностями строительства ЦОД на десятки миллиардов долларов в ближайшие 7–10 лет.

16.06.2024 [16:25], Сергей Карасёв

Холодный приём: новый национальный суперкомпьютер Норвегии разместят в руднике и охладят водой из фьордаВласти Норвегии, по сообщению ресурса HPC Wire, подписали контракт стоимостью Kr225 млн ($21 млн) с корпорацией HPE, предусматривающий создание нового национального суперкомпьютера A2 (постоянное имя системе дадут позже). Он станет самым мощным в истории страны и значительно ускорит исследования и разработки в различных областях, в том числе в сфере ИИ. За закупку и эксплуатацию НРС-систем в Норвегии отвечает государственная компания Sigma2 AS. Вычислительные услуги предоставляются в сотрудничестве с университетами Бергена, Осло, Тромсё, а также Норвежским университетом естественных и технических наук (NTNU) в рамках проекта NRIS. В основу нового суперкомпьютера ляжет платформа HPE Cray EX4000. Известно, что в состав комплекса войдут 76 узлов с четырьмя гибридными суперчипами NVIDIA GH200 (всего 304 ускорителя), 252 узла с двумя 128-ядерными AMD EPYC Turin (64 512 ядер) и 5,3-Пбайт хранилище HPE Cray ClusterStor E1000. Узлы объединит интерконнект HPE Slingshot. Ожидаемая производительность системы составит порядка 10 Пфлопс. Монтаж системы планируется выполнить в течение весны–лета 2025 года. Машина расположится в дата-центре Лефдаль (Lefdal Mine Datacenter, LMD), развёрнутом на базе бывшего рудника. Этот объект имеет большую площадь и предоставляет гибкие возможности в плане масштабирования. Новый суперкомпьютер HPE станет первой национальной высокопроизводительной системой, установленной в этом ЦОД.

Источник изображения: Sigma2 Несмотря на то, что готовящийся комплекс будет значительно мощнее высокопроизводительных вычислительных систем Sigma2 предыдущего поколения, его энергопотребление окажется меньше примерно на 30 %. Для охлаждения будет использоваться холодная вода из близлежащего фьорда. Нагретая вода затем может быть направлена на нужды местных предприятий, в том числе, например, рыбных ферм. Ожидается, что суперкомпьютер сможет удовлетворить потребности Норвегии в НРС-ресурсах в течение следующих пяти лет. Он будет доступен исследователям по всей стране. В дальнейшем суперкомпьютер может дополнительно получить 119 808 CPU-ядер и/или 224 ускорителя. В целом же Норвегия рассчитывает, что современные ЦОД станут для страны «новой нефтью».

16.06.2024 [15:37], Руслан Авдеев

В Катманду запущен новый Tier III ЦОДКак сообщает Datacenter Dynamics в Катманду государственное Управление энергоснабжения Непала запустило дата-центр с высоким уровнем надёжности и реализовало вспомогательные инфраструктурные проекты. Новый ЦОД поможет автоматизировать управление энергосетью страны. Речь идёт об 1-МВт трёхэтажном объекте, который пока что включает 36 серверов в четырёх машинных залах и два модульных ИБП на 300 кВА. По словам представителя Nepal Electricity Authority, новый дата-центр соответствует уровню Tier III. В ЦОД предполагается развернуть частное облако для хранения и обработки государственных данных. Дополнительно прокладывается оптоволоконная магистраль для соединения нового ЦОД с офисом местных властей и уже действующим дата-центром в Ратнапарке. Последний также будет использоваться в качестве центра запасной площадки до тех пор, пока Nepal Electricity Authority не достроит новый резервный объект. Планы возведения нового ЦОД впервые анонсировали в июле 2021 года совместно с китайской Yantai Dongfag Wisdom Electric Company — после получения инвестиций от Азиатского банка развития. Работы начались в ноябре того же года. Индийский оператор ЦОД Yotta и непальский конгломерат BLC Holding Pvt Ltd в апреле объявили о планах строительства дата-центра на 4 МВт, тоже в Катманду. В числе уже действующих в Непале операторов — Cloud Himalaya, DataHub и NITC. Имеются собственные объекты в стране и у телеком-компаний Ncell и Subisu.

16.06.2024 [14:28], Сергей Карасёв

QNAP готовит NAS TS-432X и TS-632X с процессором Arm и поддержкой 10GbEВ ассортименте компании QNAP Systems, по сообщению ресурса NAS Compares, появятся новые десктопные NAS — модели TS-432X и TS-632X, ориентированные на малый и средний бизнес. Устройства допускают установку соответственно четырёх и шести LFF-накопителей с интерфейсом SATA-3. Новинки несут на борту 64-битный процессор Alpine AL524, разработанный фирмой Annapurna Labs (дочерняя структура Amazon). Чип содержит четыре ядра с архитектурой Arm, частота которых достигает 2 ГГц. Объём оперативной памяти DDR4 с поддержкой ECC в стандартной конфигурации составляет 4 Гбайт, в максимальной — 16 Гбайт (один слот SO-DIMM).

Источник изображения: QNAP Устройства наделены двумя сетевыми портами 2.5GbE и слотом расширения PCIe 3.0 x4. Младшая версия получила один порт 10GbE SFP+, старшая — два. Кроме того, предусмотрены два разъёма USB 3.2 Gen1, один из которых выведен на фронтальную панель. Поддерживается шифрование информации по алгоритму AES с 256-битным ключом. Модель TS-432X имеет габариты 226,5 × 170 × 165 мм и весит 1,99 кг без установленных накопителей. За охлаждение отвечает один вентилятор диаметром 120 мм. В комплект поставки входит адаптер питания на 90 Вт. Габариты TS-632X составляют 226,5 × 235 × 165 мм, масса — 2,5 кг. Задействованы два 90-мм вентилятора, а мощность адаптера питания равна 120 Вт. В качестве программной платформы используется QTS.

15.06.2024 [18:04], Владимир Мироненко

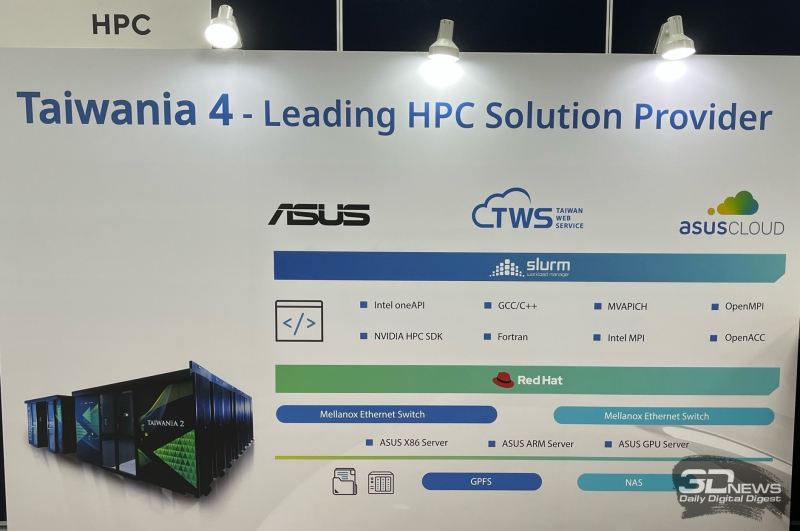

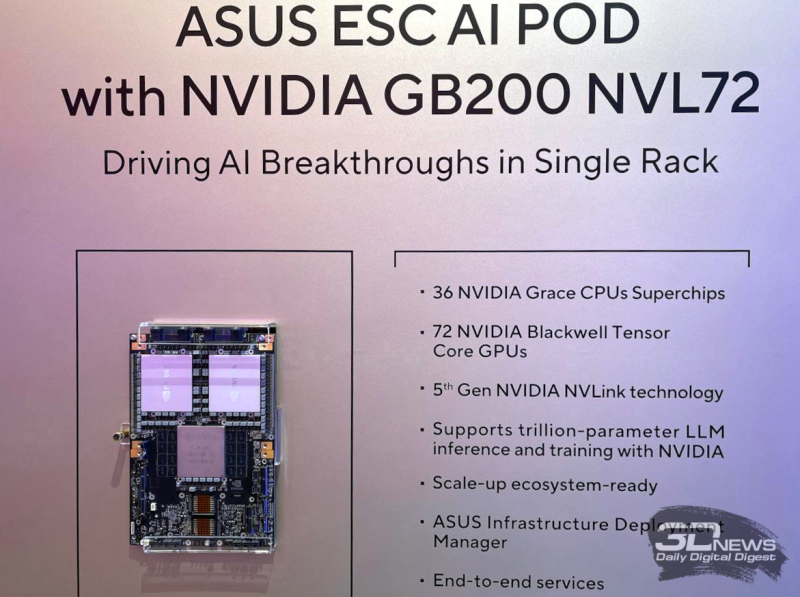

ASUS осваивает строительство суперкомпьютеров, ЦОД и комплексных ИИ-системПроизводитель потребительской электроники ASUS уже давно работает на рынке серверов и ЦОД. Пока он занимает на нём не очень большую долю, но как сообщил ресурсу The Register старший вице-президент ASUS Джеки Сюй (Jackie Hsu), высокопроизводительных вычислений (HPC) и серверов стал для компании «областью большого роста». Сюй рассказал, что ASUS участвовала в строительстве на Тайване суперкомпьютера Taiwania 2 производительностью 9 Пфлопс, занявшего в рейтинге TOP500 двадцатую позицию после дебюта в 2018 году. А в прошлом году ASUS выиграла тендер на участие в создании суперкомпьютера Taiwania 4. Сюй сообщил, что ASUS построила ЦОД для Taiwania 4. Причём PUE новой площадки составляет 1,17, что является неплохим показателем для любого подобного объекта, а тем более для Тайваня, отличающегося климатом с высокими температурой и влажностью. Также ASUS участвовала в ряде проектов в области ИИ, включая разработку собственной большой языковой модели (LLM) Formosa Foundation со 176 млрд параметров. Модель была обучена на наборах данных на местном языке для генерации текста с традиционной китайской семантикой. Благодаря накопленному опыту ASUS начала предлагать услуги на рынке ИИ. Компания уже заключила несколько контрактов, в рамках которых она проектирует и создаёт мощные системы для работы с ИИ, предлагая большую часть программного и аппаратного стека, необходимого для обработки ИИ-нагрузок. Гендиректор NVIDIA Дженсен Хуанг (Jensen Huang) назвал ASUS в числе компаний, с кем NVIDIA будет сотрудничать в работе над созданием так называемых фабрик ИИ. На Computex 2024 компания представила новые серии серверов ASUS RS700-E12 и RS720-E12 с процессорами Intel Xeon 6, разработанные специально для обработки высокопроизводительных рабочих нагрузок, а также серверы хранения семейства VS320D, предназначенные для использования в составе инфраструктур SAN для работы с базами данных, системами виртуализации и пр. Также ASUS представила ИИ-систему ESC AI POD на базе суперускорителей NVIDIA GB200 NVL72. |

|