Лента новостей

|

05.10.2024 [15:55], Сергей Карасёв

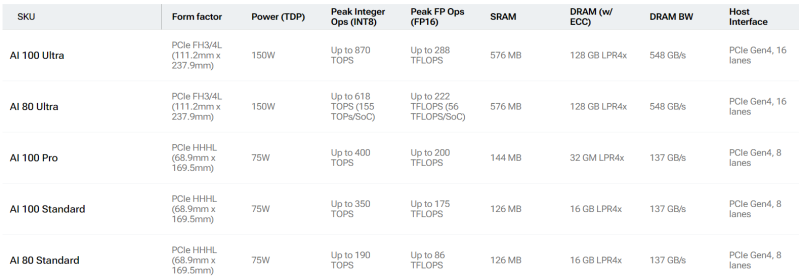

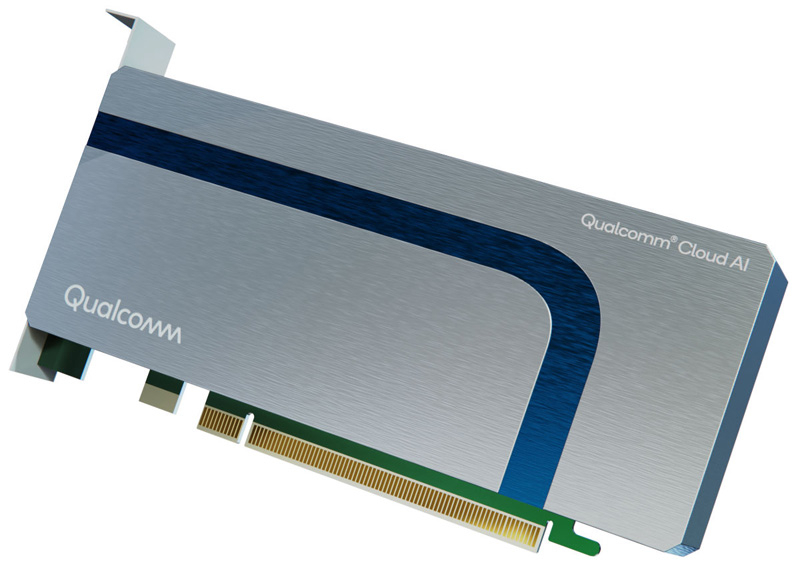

Qualcomm готовит «урезанные» ИИ-ускорители Cloud AI 80Qualcomm, по сообщению Phoronix, планирует выпустить ускорители Cloud AI 80 (AIC080) для ИИ-задач. Информация о них появилась на сайте самого разработчика, а также в драйверах Linux. Речь идёт об «урезанных» версиях изделий Cloud AI 100, уже доступных на рынке. Базовая версия Cloud AI 100 Standard выполнена в виде HHHL-карты (68,9 × 169,5 мм) с интерфейсом PCIe 4.0 х8 и пассивным охлаждением. Объём памяти LPDDR4x-2133 с пропускной способностью 137 Гбайт/с составляет 16 Гбайт. Есть также 126 Мбайт памяти SRAM. TDP равен 75 Вт. Заявленное быстродействие достигает 350 TOPS на операциях INT8 и 175 Тфлопс при вычислениях FP16. От них в своё время отказалась Meta✴, сославшись на сырость программной экосистемы и предпочтя разработать собственные ИИ-ускорители MTIA.

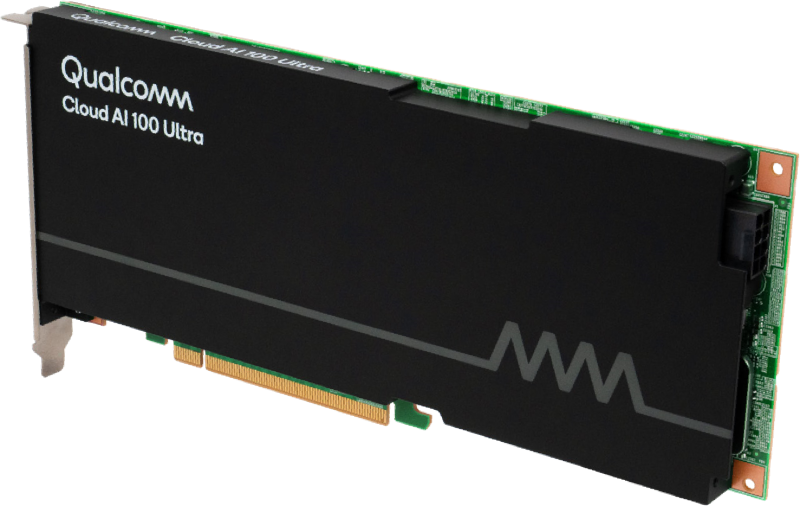

Источник изображений: Qualcomm Кроме того, существует решение Cloud AI 100 Ultra в виде карты FH3/4L (111,2 × 237,9 мм). Для обмена данными служит интерфейс PCIe 4.0 х16; значение TDP равно 150 Вт. В оснащение входят 128 Гбайт памяти LPDDR4x, пропускная способность которой достигает 548 Гбайт/с. Объём памяти SRAM — 576 Мбайт. INT8-производительность составляет до 870 TOPS, FP16 — до 288 Тфлопс. Сообщается, что к выпуску готовятся «урезанные» ускорители Cloud AI 80 Standard и Cloud AI 80 Ultra. Их характеристики в точности соответствуют таковым у Cloud AI 100 Standard и Cloud AI 100 Ultra. Отличия заключаются исключительно в пониженном быстродействии. Так, у Cloud AI 80 Standard производительность INT8 находится на уровне 190 TOPS, FP16 — 86 Тфлопс. У Cloud AI 80 Ultra значения равны 618 TOPS и 222 Тфлопс. Нужно отметить, что в старшее семейство также входит модель Cloud AI 100 Pro в формате карты HHHL с интерфейсом PCIe 4.0 х8 и TDP 75 Вт. Она несёт на борту 32 Гбайт памяти LPDDR4x (137 Гбайт/с) и 144 Мбайт памяти SRAM. Производительность INT8 составляет до 400 TOPS, FP16 — до 200 Тфлопс. Появится ли подобная модификация в серии Cloud AI 80, пока не ясно.

05.10.2024 [15:36], Владимир Мироненко

Accenture сформировала подразделение NVIDIA Business Group и обучит 30 тысяч сотрудников полному стеку ИИ-технологий NVIDIAГлобальная консалтинговая компания Accenture и NVIDIA объявили о расширении партнёрства, в рамках которого Accenture создала новую бизнес-группу Accenture NVIDIA Business Group с целью помочь предприятиям быстро внедрить и масштабировать ИИ-решения. Также будет проведено обучение 30 тыс. сотрудников Accenture по всему миру полному набору ИИ-технологий NVIDIA. Это одна из крупнейших сделок на рынке. Новая структура Accenture сосредоточится на стимулировании корпоративного внедрения так называемых «агентных систем ИИ», используя преимущества ключевых программных платформ NVIDIA. Как сообщает ресурс CRN, директор по ИИ Accenture Лань Гуань (Lan Guan) заявил на встрече с журналистами, что агентные системы включают в себя «армию ИИ-агентов», которые работают вместе с людьми, чтобы «принимать решения и точно выполнять задачи даже в самых сложных рабочих процессах». Согласно пресс-релизу, агентные системы — это прорыв в области генеративного ИИ. Они могут автономно действовать в соответствии с намерениями пользователя, создавать новые рабочие процессы и предпринимать действия с учётом окружения, что может целиком реорганизовать бизнес-процессы или отдельные функции. По словам Гуаня, в отличие от чат-ботов, таких как ChatGPT, ИИ-агенты не требуют запросов и подсказок от людей и не предназначены для автоматизации уже существующих бизнес-шагов. В своей работе Accenture NVIDIA Business Group будет полагаться на собственную платформу AI Refinery, которая использует полный стек NVIDIA AI, включая NVIDIA AI Foundry, AI Enterprise и Omniverse для продвижения таких направлений, как реорганизация процессов, моделирование на основе ИИ и суверенный ИИ. AI Foundry помогает в разработке кастомных ИИ-моделей, предоставляя доступ к базовым моделям, фреймворкам и инструментам. AI Enterprise предлагает микросервисы и инструменты для разработки, оптимизации и развёртывания приложений ИИ. Наконец, Omniverse ориентирована на создание цифровых двойников производственных процессов и т.п. Accenture также заявила, что открывает сеть инженерных ИИ-центров в Сингапуре, Токио, Малаге и Лондоне, которые помогут ей во внедрении агентных систем ИИ. Эти центры станут частью Центра передового ИИ Accenture (Center for Advanced AI) в дополнение существующим филиалам в Маунтин-Вью и Бангалоре, и будут сосредоточены на подборе и тюнинге базовых моделей с последующим крупномасштабном инференсом. Кроме того, Accenture предложит NVIDIA NIM Agent Blueprints, шаблоны ИИ-приложений NIM Agent Blueprints для типовых бизнес-задач. В частности, Accenture подготовит Blueprint для моделирования производств с использованием парка роботов, который объединяет NVIDIA Omniverse, Isaac и Metropolis. Accenture планирует использовать эти новые возможности в Eclipse Automation, принадлежащей её компании по автоматизации производств. Это позволит вполовину ускорить подготовку проектов и почти на треть сократить время развёртывания. Следует отметить, что на прошлой неделе Accenture сообщила о том, что в 2024 финансовом году, закончившемся 31 августа, у неё было на $3 млрд новых заказов на генеративный ИИ, $1 млрд из которых пришёлся на IV квартал. Для NVIDIA партнёрство с Accenture является частью реализации плана по расширению влияния на глобальных системных интеграторов (GSI) и другие многонациональные компании, которые имеют значительное влияние на предприятиях. Например, Infosys год назад заявила, что обучит и сертифицирует в рамках партнёрства с NVIDIA 50 тыс. сотрудников, которые изучат особенности аппаратных и программных ИИ-решений NVIDIA.

05.10.2024 [13:39], Руслан Авдеев

HMC Capital ведёт переговоры о покупке активов Global Switch Australia и других ЦОДHMC Capital ведёт переговоры о покупке ряда дата-центров, включая австралийский бизнес компании Global Switch. По данным Datacenter Dynamics, в пятницу инвестор сообщил, что проводит аудит перед несколькими потенциальными покупками. Заявляется, что стороны ведут переговоры, но условия возможных приобретений пока остаются конфиденциальными и ещё не носят юридически обязывающего характера. HMC Capital представила информацию после того, как некоторые данные обнародовали австралийские СМИ. По их информации, Global Switch Australia оценена в AU$2 млрд ($1,33 млрд). В июле, по слухам, Global Switch уже отклонила несколько предложений о покупке её австралийского подразделения, поскольку предложенные суммы не устроили компанию. Среди потенциальных покупателей были Stonepeak, Queensland Investment Corporation и Canada Pension Plan Investment Board (CPP Investments).

Источник изображения: Global Switch Global Switch управляет 13 объектами в Европе, Австралии и Азии. Также компания строит объект в Лондоне (Великобритании) и завершила строительство во Франкфурте (Германия). В Сиднее компания управляет двумя примыкающими друг к другу дата-центрами Sydney West (20,5 МВт) и Sydney East (22 МВт) с общей площадью зданиями на территории площадью 11 тыс. м2. Недавно компания подала заявку на надстройку дополнительных этажей на уже существующих зданиях. Продажа Global Switch целиком или по частям обсуждалась в течение нескольких лет после того, как китайский металлургический гигант Jiangsu Shagang Group взял компанию под контроль. Речь шла о $10–11 млрд. В числе потенциальных покупателей назывались больше дюжины компаний и инвестиционных фондов. Переговоры, судя по всему, прекратились в январе 2023 года — покупатели предлагали слишком мало. Впрочем, сообщалось, что EQT всё ещё интересовалась сделкой, оценивая всю Global Switch в $6–7 млрд. Несколько австралийских правительственных учреждений отказались от использования объектов в Сиднее после того, как китайский бизнес получил контроль над компанией. В том числе речь идёт о Министерстве внутренних дел, а также других крупных ведомствах, тесно связанных с вопросами национальной безопасности.

05.10.2024 [13:20], Руслан Авдеев

Meta✴ и CarbonBuilt объединили усилия для производства «низкоуглеродного» бетона для строительства ЦОДMeta✴ совместно с CarbonBuilt ускорят производство «низкоуглеродного» бетона. По информации Datacenter Dynamics, при выпуске нового продукта углеродные выбросы снижены приблизительно на 70 % в сравнении с базовыми отраслевыми показателями. Основанная в 2020 году CarbonBuilt специализируется на производстве низкоуглеродных бетонных продуктов. Соглашение позволит ей модернизировать и масштабировать производство альтернативного цемента, получившего название Reversa. Материал призван заменить т.н. портландцемент, при производстве которого углеродные выбросы довольно высоки — при этом это одна из самых распространённых марок в строительстве. В компании утверждают, что Reversa вступает в химическую реакцию с углекислым газом во время выдерживания бетона, при этом навсегда задерживая CO2 в материале. Все значимые решения, связанные с цементом и бетоном, требуют изменения инфраструктуры в той или иной степени. Быстрое изменение требует, чтобы участники отрасли видели привлекательную финансовую отдачу в ответ на свои инвестиции. Сотрудничество с Meta✴ поможет ускорить и масштабировать реализацию подобных проектов. В Meta✴ добавили, что компания ставит в приоритет многовекторный подход к ускорению декарбонизации в сложных секторах индустрии вроде производства строительных материалов бетона. Сотрудничество с CarbonBuilt позволит снизить выбросы и масштабировать бизнес. В августе 2024 года сообщалось об испытаниях Open Compute Project Foundation (OCP) «низкоуглеродного» бетона производства CarbonCure. Кроме того, Microsoft ведёт эксперименты с использованием в строительстве ЦОД в штате Вашингтон низкоуглеродных бетонных смесей. В 2022 году сообщалось о строительстве ЦОД Meta✴ из «зелёного» бетона, созданного с помощью ИИ. Впрочем, Meta✴ работает и в других направлениях. Так, в сентябре техногигант заключил сделку, связанную с восстановлением лесов в Латинской Америке. Также Meta✴ разрабатывает и собственную технологию захвата углекислого газа для своих дата-центров.

05.10.2024 [12:49], Сергей Карасёв

Cisco инвестирует в CoreWeave при оценке последней в $23 млрдCisco Systems, по информации Bloomberg, намерена инвестировать средства в компанию CoreWeave, предоставляющую облачные услуги для ИИ-задач. О какой именно сумме идёт речь, не уточняется. Но известно, что в рамках данной сделки CoreWeave может получить оценку на уровне $23 млрд. CoreWeave активно развивает бизнес, а капитализация компании быстро растёт. Так, если в декабре 2023 года рыночная стоимость CoreWeave составляла $7 млрд, то в мае 2024-го она достигла $19,1 млрд. В число инвесторов входят NVIDIA, Magnetar Capital, Coatue Management, Jane Street и Fidelity. В середине сентября 2024-го стало известно, что CoreWeave собирается осуществить продажу существующих акций. Нынешние акционеры компании смогут реализовать свои активы на сумму от $400 млн до $500 млн. Bloomberg отмечает, что эта сделка близка к завершению. А в 2025-м компания рассматривает возможность провести IPO.

Источник изображения: CoreWeave Cisco активно инвестирует в кибербезопасность и ИИ. В частности, в марте нынешнего года производитель сетевого оборудования закрыл сделку по покупке Splunk за рекордные $28 млрд. Кроме того, Cisco приобрела разработчика средств ИИ-безопасности Robust Intelligence за нераскрытую сумму. Корпорация также объявила о намерении купить Deeper Insights AI Ltd., частную компанию по предоставлению услуг ИИ, базирующуюся в Великобритании. В свою очередь, CoreWeave продолжает привлекать средства на расширение своей инфраструктуры и укрепление бизнеса. В апреле 2023 года компания получила $221 млн, а затем — ещё $200 млн. В августе того же года было объявлено о долговом финансировании в размере $2,3 млрд под залог ускорителей NVIDIA. В декабре CoreWeave провела раунд финансирования на $642 млн, а в мае 2024-го получила $1,1 млрд. Затем компания привлекла дополнительно $7,5 млрд. Недавно фонды под управлением Blue Owl Capital, Chirisa Technology Parks (CTP) и PowerHouse Data Centers сообщили о создании совместного предприятия с активами на $5 млрд, которое займётся созданием крупномасштабных ЦОД для CoreWeave.

04.10.2024 [18:31], Владимир Мироненко

Суперкомпьютеры по талонам: Минцифры намерено выделять гранты на HPC/ИИ-вычисленияМинцифры России планирует начать выделять гранты компаниям на использование мощностей суперкомпьютеров, заявил министр цифрового развития Максут Шадаев на заседании IT-комитета Госдумы 3 октября, пишет «Коммерсантъ». «Когда мы выделяем гранты на внедрение современных решений, внутри них будет возможность в том числе заказывать услуги по специализированным вычислениям у специализированных провайдеров», — рассказал глава Минцифры, добавив, что эта мера направлена на стимулирование спроса на специализированные вычисления, а выделение грантов компаниям позволит загрузить вычислительные мощности «Сбера» и «Яндекса». Насколько велики эти гранты и когда начнётся их выделение, в Минцифры не сообщили. Действительно ли указанные мощности недостаточно загружены, не уточняется. По словам источника «Коммерсанта», близкого к правительству, гранты на аренду вычислительных мощностей суперкомпьютеров планируется предоставлять с 2025 года. Речь идёт о крупных компаниях, которые внедряют «передовые решения». Источник отметил, что это позволит снять с крупных заказчиков часть рисков, связанных с внедрением инноваций. Сейчас для минимальных проектов в области ИИ требуются ускорители на сумму от 30 млн руб., говорит директор Института прикладных компьютерных наук ИТМО Антон Кузнецов. Позволить себе такие траты маленькие компании зачастую не в состоянии, хотя именно они нуждаются во внедрении современных решений для быстрого роста. Ранее в этом месяце также сообщалось о планах правительства стимулировать строительство компаниями суперкомпьютеров, оснащённых ускорителями для обучения ИИ. Как ожидается, в результате совокупная мощность всех ИИ-суперкомпьютеров вырастёт в 2027 году в три раза и в десять раз — в 2030-м. В последнем рейтинге TOP500 есть семь российских суперкомпьютеров: три принадлежат «Яндексу», два ессть у «Сбера», а ещё по одному у МГУ и МТС. Российский рейтинг ТОП50 не обновляется с 2023 года.

04.10.2024 [16:14], Руслан Авдеев

Google тоже не прочь запитать свои ИИ ЦОД от АЭСПо словам генерального директора Google Сундара Пичаи (Sundar Pichai), компания рассматривает снабжение своих дата-центров энергией атомных электростанций, в том числе SMR. По информации Asian Nikkei Review, техногигант ищет возможности снижения углеродных выбросов на фоне резко растущего энергопотребления ИИ ЦОД. Увеличатся и инвестиции в солнечную и тепловую энергетику. Пока же Google наращивает инвестиции в ЦОД для продвижения ИИ-проектов. Материнская компания Alphabet только за апрель-июнь увеличила год к году капитальные затраты на 90 % до $13,1 млрд. По словам Пичаи, впервые появилась новая базовая технология, «пронизывающая» все сферы деятельности — она станет основой бизнеса компании. В ответ на критику больших затрат на ИИ-разработки, Пичаи ответил, что при каждом крупном «сдвиге платформы» инвестиции на начальных этапах непропорционально высоки, но позже эффективность повышается. Компания стремится добиться нулевых выбросов как в своих собственных операциях, так и в «цепочке создания стоимости» уже к 2030 году. При этом в 2023 году общие выбросы её парниковых газов оказались на 48 % больше, чем в 2019 году. Правда, сама компания говорит, такой уж большой вины ИИ в этом нет. По словам Пичаи, сейчас рассматриваются дополнительные инвестиции в современные технологии, от солнечной энергетики до, возможно, малых модульных реакторов (SMR). Правда, глава Google не упомянул, когда могут начаться закупки энергии АЭС. Предполагается, что часть может закупаться в США. На этом поле не исключена конкуренция с Amazon, которая уже приобрела кампус ЦОД, запитанный от АЭС Susquehanna. Также в сентябре было объявлено о намерении Microsoft закупать электричество у АЭС Three Mile Island, которая будет перезапущена именно для этой цели.

04.10.2024 [15:22], Руслан Авдеев

Oracle вложит $6,5 млрд в ИИ и облако в МалайзииOracle намерена потратить $6,5 млрд на создание ЦОД и облачного региона в Малайзии. Как сообщает Bloomberg, компания станет последним крупным игроком, принявшим решение инвестировать в ИИ-инфраструктуру Юго-Восточной Азии. Пресс-служба самой компании объявила, что новый облачный регион даст возможность использовать инфраструктуру и сервисы ИИ, перенося критически важные нагрузки в Oracle Cloud Infrastructure (OCI). Создаваемое публичное облако поможет малайзийским компаниям модернизировать свои приложения, перенести в облако все типы рабочих нагрузок и выполнять ряд других задач. Клиенты получат доступ к агентам OCI Generative AI, ускоренным вычислениям и сервисам на базе генеративного ИИ, позволяющим хранить и обрабатывать суверенные модели в границах страны, а также доступ к OCI Supercluster на базе новейших ускорителей NVIDIA GB200 NVL72. Место размещения региона не названо, но облачные мощности страны сосредоточены в Джохоре и Куала-Лумпуре. Власти Малайзии приветствовали инициативу компании, работающей в стране уже в 36 лет. Только в этом году в облако OCI мигрировали две малайзийские компании — IHH Healthcare и Great Eastern. Ожидается, что инвестиции помогут развитию технологий для малого и среднего бизнеса, а также будут способствовать реализации национального план New Industrial Master Plan, предусматривающего создание в стране 3 тыс. «умных производств» к 2030 году. Малайзия становится крупным рынком ЦОД в Азиатско-Тихоокеанском регионе и имеет большие амбиции по его дальнейшему расширению. Хотя Сингапур начал постепенно ослаблять ограничения, связанные с мораторием на строительство новых ЦОД, Малайзия рассчитывает переманить к себе значительное число новых проектов у соседа. В начале октября 2024 года Google начала строительство дата-центра в Куала-Лумпуре, вскоре после анонса партнёрства с DNeX для предоставления в стране суверенных облачных сервисов и намерена вложить $2 млрд в ЦОД и облако в Малайзии. AWS запустила малайзийский облачный регион в августе, а Microsoft анонсировала планы создания в Куала-Лумпуре региона Azure ещё в апреле 2021 года. Общая сумма инвестиций должна составить $2,2 млрд. Oracle не называет точных временных рамок развёртывания инфраструктуры в Малайзии, но нет сомнений, что она готовится побыстрее получить часть ИИ-пирога в регионе.

04.10.2024 [14:35], Сергей Карасёв

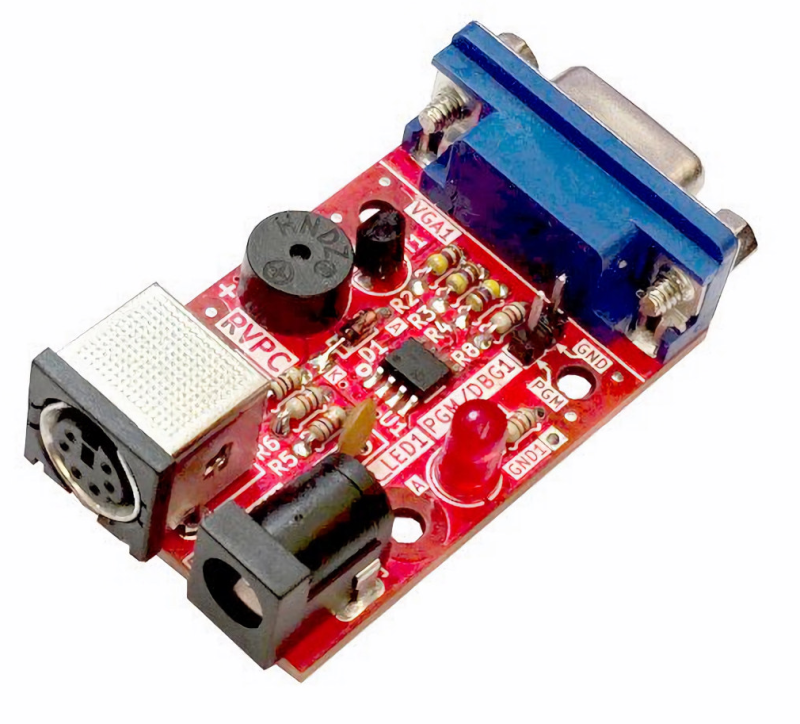

Микрокомпьютер с микроконтроллером по микроцене: Olimex RVPC за €1 получил чип RISC-V, порт PS/2 и видеовыход D-SubКомпания Olimex анонсировала одноплатную систему RVPC, оснащённую микроконтроллером с открытой архитектурой RISC-V. Изделие будет поставляться в виде комплекта для самостоятельной пайки, что позволит использовать его в том числе в образовательных целях. Сам производитель относит новинку к ретрокомпьютерам. Задействован 32-битный чип WCH CH32V003 RISC-V2A с частотой 48 МГц. Есть 2 Кбайт памяти SRAM и 16 Кбайт флеш-памяти. Предусмотрены аналоговый интерфейс D-Sub для подключения монитора (три линии GPIO для Vsync, HSync и RGB), а также коннектор PS/2 для клавиатуры (две линии GPIO). Новинка имеет размеры 50 × 30 мм. Питание (5 В) подаётся через отдельный разъём. Программирование микроконтроллера CH32V003 может осуществляться через вспомогательную плату ESP32-S2-DevKit-LiPo-USB. Среди прочего упомянуты зуммер и светодиодный индикатор состояния. Olimex предоставляет несколько примеров программного кода на языке C для использования интерфейса D-Sub, демонстрационную игру Tetris, эмулятор терминала (RVMON), который предварительно загружен во флеш-память, и пр. Цена Olimex RVPC составляет всего €1. При этом плата ESP32-S2-DevKit-LiPo-USB обойдётся ещё примерно в €8. За совместимый адаптер питания компания просит около €4.

04.10.2024 [13:57], Руслан Авдеев

Microsoft потратит €4,3 млрд на развитие облачной и ИИ-инфраструктуры в ИталииКомпания Microsoft пообещала инвестировать €4,3 млрд ($4,75 млрд) в расширение инфраструктуры облачных и ИИ ЦОД в Италии. Речь идёт о крупнейшей инвестиции компании в Италии на сегодняшний день. Компания расширит ЦОД на севере стране, а также обучит более 1 млн жителей страны работе с ИИ и цифровыми технологиями до конца 2025 года. После расширения бизнеса Microsoft Италия превратится в один из крупнейших хабов ЦОД в Европе, а местная инфраструктура станет ключевой не только для Италии, но и для стран Средиземноморья и Северной Африки. По словам президента Microsoft Брэда Смита (Brad Smith), инвестиции подчёркивают приверженность компании цифровой трансформации страны — итальянские власти и бизнес получат инструменты для построения экономики на основе ИИ-технологий, создающих рабочие места и способствующих процветанию государства. Компания также объявила, что инвестирует в обеспечение экоустойчивости ИИ в стране. Уже сегодня Microsoft заключила три PPA на поставку возобновляемой энергии в Италии, а в ближайшем будущем будут найдены дополнительные возможности в этой сфере. Подробности действующих PPA не разглашаются. Сообщается, что ЦОД также находятся в процессе перевода резервных генераторов на возобновляемое биотопливо, что позволит снизить углеродные выбросы.

Источник изображения: Anders Jildén/unspalsh.com В Microsoft сообщают, что дата-центры в Италии используют технологии «прямого испарительного охлаждения», позволяющие сократить расход воды, причём большая часть используемой берётся из дождевых либо грунтовых вод. Облачный регион Microsoft в Италии расположен в Милане. Впервые компания сообщила о планах его строительства ещё в 2020 году, запуск состоялся в 2023 году на объекте Stack (бывшем SuperNAP Italita). Компания стала последним из американских гиперскейлеров, запустивших в Италии облака. AWS ввела в эксплуатацию облачный регион в Милане в 2020 году и намерена тратить миллиарды дополнительно, Oracle — в 2021 году, а Google — в 2022 году, причём второй регион GCP компании уже запущен в Турине. |

|