Лента новостей

|

02.04.2025 [18:06], Руслан Авдеев

Arm собиралась купить Alphawave ради передовой технологии SerDes для выпуска ИИ-чипов — теперь её хочет купить QualcommПринадлежащий SoftBank разработчик архитектурных решений для полупроводников — компания Arm недавно собиралась приобрести британскую Alphawave для получения критически важной технологии, необходимой для создания ИИ-ускорителей. Об этом сообщили Reuters три независимых источника, «знакомых с вопросом». Теперь над покупкой Alphawave раздумывает Qualcomm, уточняет SiliconAngle. Alphawave владеет интеллектуальной собственностью, связанной с полупроводниковыми технологиями, и даже обсуждала с инвестиционными банкирами возможность продажи — после того как Arm и другие потенциальные покупатели выразили интерес к приобретению компании. Однако, по данным двух источников, в итоге было решено отказаться от сделки. На фоне новостей акции Alphawave взлетели на 21 % — рекордный рост с сентября 2021 года. По данным на конец торгов в понедельник капитализация компании составила £707 млн ($914 млн), а цена акции — 93,5 пенса. Arm рассчитывала получить от Alphawave технологию создания SerDes-блоков, которые определяют скорость передачи данных на чип и с него. Эта технология критически важна для ИИ-систем, таких как ChatGPT, где тысячи чипов должны работать согласованно. Так, SerDes является ключевым преимуществом Broadcom, помогая компании привлекать клиентов вроде Google и OpenAI.

Источник изображения: Arm Arm с головным офисом в Великобритании на 90 % принадлежит японской SoftBank Group. Компания сама не разрабатывает чипы, а продаёт «основные строительные блоки» для их создания, а также прочую интеллектуальную собственность. Основные доходы Arm получает за счёт лицензионных отчислений от других бизнесов, а также роялти за каждый проданный чип, использующий её технологии. Недавно сообщалось, что она рассчитывает, что её архитектура займёт 50 % на рынке чипов для ЦОД уже к концу 2025 года. У AWS, Google Cloud и Microsoft Azure уже есть собственные серверные Arm-процесоры: Graviton, Axion и Cobalt 100. Конечно, компания стремилась повысить прибыль и выручку, в том числе не исключалась самостоятельная разработка чипов и прямая конкуренция с собственными клиентами. Планы покупки Alphawave частично раскрылись в декабре 2024 года в ходе судебной тяжбы с Qualcomm. Однако руководство Arm заявило, что речь шла об обычном обмене идеями между менеджерами. Тем не менее, в ходе того же процесса в феврале стало известно, что компания искала специалистов, способных вывести на рынок чип собственной разработки. Теперь же выяснилось, что Qualcomm сама не прочь приобрести Alphawave — компания должна сделать предложение до 29 апреля или полностью отказаться от сделки. У Arm нет столь передовой технологии SerDes, какой располагает Alphawave. Хотя подробностей немного, известно, что SerDes-блоки служат основой многомиллиардных полупроводниковых бизнесов Broadcom и Marvell Technology. По прогнозам Bernstein, соответствующий рынок к 2028 году вырастет до $60 млрд. NVIDIA также разработала собственный вариант SerDes и уже заявила о намерении продавать лицензии на него другим компаниям. Создание передовых решений в этой сфере критически важно для выпуска ИИ-чипов, способных выгодно отличаться от продукции конкурентов. При этом, по мнению экспертов, разработка SerDes с нуля требует специфических навыков и около двух лет. Покупка Alphawave смогла бы сэкономить Arm значительное количество времени и ресурсов.

02.04.2025 [15:07], Руслан Авдеев

9000 домов в Великобритании подключат к сети отопления от ЦОДHemiko, занимающаяся системами центрального отопления в Великобритании, выбрана Old Oak and Park Royal Development Corporation (OPDC) и связанной с муниципальными властями London Mayoral Development Corporation (LMDC) для проектирования, строительства и эксплуатации специальной тепловой сети. Речь идёт о «низкоуглеродном» проекте, который будет использовать тепло дата-центров для отопления домохозяйств, сообщает Datacenter Dynamics. Сеть обеспечит теплом более 9 тыс. домов и предприятий, сообщает пресс-служба Hemiko. Строительство предусмотрено на территории, охватывающей сразу несколько боро Лондона — Илинг (Ealing), Брент (Brent), Хаммерсмит (Hammersmith) и Фулхэм (Fulham). Районы Old Oak и Park Royal, раскинувшиеся на территории лондонских боро, подверглись масштабной реконструкции и именно здесь реализуется крупнейший проект застройки британской столицы. В следующие 20 лет там планируется построить более 25 тыс. новых объектов. Проект намерены реализовать в пять этапов с 2028 по 2040 гг. Первый этап должен обеспечить более 95 ГВт∙ч тепла в год. Для поддержки инициативы Hemiko вложит £63 млн ($81,3 млн) в строительство на первых этапах, а к 2040 году объём инвестиций должен увеличиться до £600 млн ($774,3 млн). Партнёры сообщают, что это первый проект в Великобритании, в котором тепло ЦОД используется для отопления. Вопрос спорный — тепло дата-центров уже применяется в стране как минимум для подогрева бассейнов. Также предложено размещать для отопления серверы в жилых домах.

Источник изображения: Sander Crombach/unsplash.com Компания Hemiko (ранее Pinnacle Power), основанная в 2012 году, базируется в графстве Камбрия (Cumbria) и специализируется на развитии городских и районных сетей теплоснабжения с низким уровнем выбросов углерода. В Hemiko утверждают, что благодаря использованию тепла местных дата-центров не придётся сжигать газ в городе для отопления домов. Наличие подходящей инфраструктуры позволит не только обеспечивать теплом людей, но и создавать рабочие места для местных жителей. Проект уже получил значительные средства от местных властей. В ноябре 2023 года ODPC получила £36 млн ($46,4 млн) из средств государственного фонда Green Heat Network Fund. Средства предоставили и программа мэра столицы Local Energy Accelerator, и программа Green Finance, тоже подконтрольная мэрии. В районе строительства отопительной инфраструктуры хорошо развита сеть дата-центров: здесь имеются ЦОД Virtus, Ark Data Centres, Microsoft и Vantage. В октябре 2024 года Министерство энергетической безопасности и нулевых выбросов (Department for Energy Security and Net Zero, DESNZ) назвало территорию Old Oak и Park Royal одной из первых зон централизованных тепловых сетей Великобритании. В DESNZ отобрали шесть городов для развития таких зон, включая Лидс, Плимут, Бристоль, Стокпорт, Шеффилд и Лондон. Программа направлена на создание сетей подземных труб, распределяющих тепло от централизованных источников, в первую очередь в крупные нежилые здания, а также другие строения. Строительство, как ожидается, начнется в 2026 году. Отопление от дата-центров уже активно используется по всей Европе, особенно в скандинавских странах. Ярким примером является городской кампус Stockholm Data Parks, в котором каждый объект подключен к городской сети отопления. Реализуются такие проекты и в других странах вроде Франции.

02.04.2025 [12:19], Руслан Авдеев

AMD закрыла сделку по покупке ZT Systems за $4,9 млрдAMD вышла на новый уровень конкуренции с NVIDIA, объявив о завершении сделки по покупке компании ZT Systems, специализирующейся на выпуске серверов, в том числе высокопроизводительных решений для гиперскейлеров. Утверждается, что это позволит объединить «ведущие в индустрии системы» и «компетенции уровня стоек» с передовыми полупроводниковыми технологиями AMD, сообщает портал CRN. Также ожидается, что это приведёт к созданию нового класса комплексных ИИ-решений. В AMD заявили, что сделка стоимостью $4,9 млрд была завершена в понедельник. IT-гигант предложит для совместного бизнеса широкий ассортимент процессоров, ускорителей и сетевых чипов, чтобы вывести на рынок «новый класс ИИ-продуктов». ZT Systems предлагает универсальную вычислительную инфраструктуру, хотя именно производственное направление компании AMD продаст. Прошлым летом было объявлено, что покупка этой компании поможет AMD лучше конкурировать с ИИ-гигантом NVIDIA в сегменте ЦОД, особенно на рынке решений для крупных предприятий и гиперскейлеров.

Источник изображения: ZT Systems Хотя AMD значительно нарастила инвестиции в конкуренцию с продуктами NVIDIA и в последние годы активно развивает ускорители серии Instinct, а также ПО ROCm (Radeon Open Compute) — альтернативу NVIDIA CUDA, её выручка в сфере ИИ пока не сопоставима с показателями NVIDIA. В прошлом году чипы AMD Instinct принесли компании $5 млрд выручки, тогда как доход NVIDIA в бизнесе, связанном с ЦОД и ускорителями, составил $102,2 млрд. В AMD отказались давать прогноз по выручке от Instinct в 2025 году, в отличие от 2024 года. Вместо этого в компании заявили, что этот сегмент позволит получать десятки миллиардов долларов «в ближайшие годы». После завершения сделки команды разработчиков и поддержки ZT Systems будут работать совместно с подразделениями AMD, отвечающими за ЦОД и ИИ-проекты. Отмечается, что приобретение компании позволит партнёрам значительно сократить сроки разработки и внедрения ИИ-систем «кластерного уровня». В компании подчёркивают, что покупка ZT Systems — важный шаг в реализации стратегии AMD по разработке передовых решений для обучения ИИ-моделей и инференса, адаптированных под индивидуальные потребности клиентов. Новые решения будут базироваться на открытой экосистеме, объединяющей «открытое» ПО, корпоративные сетевые технологии, а теперь ещё и системы ZT Systems с их экспертизой в клиентской поддержке. В августе 2024 года ZT Systems оценивалась в $4,9 млрд. Согласно данным Комиссии по ценным бумагам и биржам США (SEC), сделка предусматривала передачу 8,3 млн обычных акций AMD и $3,4 млрд продавцам компании. В документе также указано, что AMD планирует передать им дополнительно 740 961 акцию и $300 млн после выполнения определённых условий. В феврале сообщалось, что выручка AMD в сегменте дата-центров бьёт рекорды, хотя акции компании на тот момент несколько упали в цене.

02.04.2025 [11:50], Руслан Авдеев

Царь-чипы с интегрированной фотоникой: Cerebras Systems и Ranovus выбраны DARPA для создания вычислительной платформы нового поколенияИИ-стартап Cerebras Systems выбран американским военно-техническим управлением DARPA для разработки высокопроизводительной вычислительной системы нового поколения. Cerebras объединит собственные ИИ-ускорители и фотонные CPO-интерконнекты Ranovus для обеспечения высокой производительности при малом энергопотреблении, сообщает пресс-центр Cerebras. Комбинация технологий двух компаний позволит обеспечить в реальном времени моделирование сложных физических процессов и выполнение масштабных ИИ-задач. С учётом успеха программы DARPA Digital RF Battlespace Emulator (DRBE), в рамках которой Cerebras уже разрабатывает передовой суперкомпьютер для радиочастотной эмуляции, именно Cerebras и Ranovus были выбраны для новой инициативы, позволяющей объединить вычислительные продукты Cerebras с первыми в отрасли фотонными интерконнектами Ranovus. Решение крайне актуальное, поскольку двумя ключевыми вопросами для современных вычислительных систем являются проблемы с памятью и обменом данных между ускорителями и иной серверной инфраструктурой — вычислительные потребности растут быстрее, чем возможности памяти или IO-систем ввода-вывода. Как утверждают в Cerebras, её WSE-чипы имеют в 7 тыс. раз большую пропускную способность, чем классические ускорители, что даёт самый быстрый в мире инференс и самое быстрое моделирование молекулярных процессов.

Источник изображения: Cerebras В рамках нового плана DARPA стартап Cerebras будет использовать интерконнект Ranovus, что позволит получить производительность, недоступную даже для крупнейших суперкомпьютерных кластеров современности. При этом энергопотребление будет значительно ниже, чем у самых современных решений с использованием коммутаторов. Последние являются одними из самых энергоёмких компонентов в современных ИИ-системах или суперкомпьютерах. Утверждается, что комбинация новых технологий двух компаний позволит искать решения самых сложных задач в реальном времени, будь то ИИ или сложное моделирование физических процессов, на недостижимом сегодня уровне. Подчёркивается, что оставаться впереди конкурентов — насущная необходимость для обороны США, а также местного коммерческого сектора. В частности, это открывает огромные возможности для работы ИИ в режиме реального времени — от обработки данных с сенсоров до симуляции боевых действий и управления боевыми или коммерческими роботами. В Ranovus заявили, что платформа Wafer-Scale Co-Packaged Optics в 100 раз производительнее аналогичных современных решений, что позволяет значительно повысить эффективность ИИ-кластеров, и значительно энергоэффективнее продуктов конкурентов. Партнёрство компаний позволит задать новый стандарт для суперкомпьютерной и ИИ-инфраструктуры, решая задачи роста спроса на передачу и обработку данных и давая возможность реализовать военное и коммерческое моделирование нового поколения. Помимо использования в целях американских военных, гигантские ИИ-чипы Cerebras применяются и оборонными ведомствами других стран. Так, весной 2024 года сообщалось, что продукты компании помогут натренировать ИИ для военных Германии.

02.04.2025 [11:04], Владимир Мироненко

MTS AI выпустила ИИ-модель Cotype Pro 2, которая станет основой ИИ-агентов для бизнесаКомпания MTS AI, дочерняя структура МТС, сообщила о выходе большой языковой модели (LLM) Cotype Pro 2 второго поколения, предназначенной для корпоративного сегмента. Новая модель значительно превосходит по целому ряду показателей предыдущую версию, адаптирована под выполнение более чем 100 сценариев использования компаниями в России и может быть запущена на собственной инфраструктуре предприятия без подключения к внешним серверам, чем обеспечивается защита от утечки данных. На основе Cotype Pro 2 компания подготовит в 2025–2026 гг. новую линейку ИИ-решений для семи отраслей: госсектора, банков, промышленности, ретейла, телекома, медицины и IT. Сначала будут созданы ИИ-помощники, затем — ИИ-агенты с большей автономностью, способные решать, как общие задачи (HR, клиентская поддержка, документооборот и другие), так и специфичные для каждой из этих отраслей. Cotype Pro 2 вошла в пятерку лучших русскоязычных LLM в бенчмарке MERA от Альянса в сфере ИИ. Она на 40 % быстрее предыдущей версии и на 50 % точнее обрабатывает длинные тексты — до 128 тыс. токенов, что соответствует примерно 900 тыс. символов с пробелами, сообщила компания. По сравнению с предшественником её эффективность в области генерации идей возросла с 44 до 57 %, точность в задаче извлечения информации выросла с 81 до 86 %, в части общения на общие темы зафиксировано улучшение с 55 до 64 %, благодаря чему обеспечивается более плавное и осмысленное взаимодействие. Также осталась на высоком уровне эффективность в классификации — 87 %, отмечены улучшения в суммаризации (с 79 до 85 %) и креативном письме (с 61 до 65 %). Для оценки эффективности сравнивалось количество ответов, схожих или превосходящих по качеству ответы модели GPT-4o. Как отметил директор по LLM-продуктам MTS AI, для ИИ-агентов важно не только работать с большим объёмом информации, но и давать ответы в структурированном виде, понятном другим системам. Чтобы оценить качество таких ответов компания разработала специальный бенчмарк, который включает задания с разным объёмом контекста и разной сложностью. В этом тесте Cotype Pro 2 справилась с 94 % задач, а GPT-4o — с 93 %. Также по данным бенчмарка длинного контекста LIBRA, качество работы Cotype Pro 2 в два раза выше, чем у Cotype Pro на задачах длиной 64 и 128 тыс. токенов (до 500 тыс. символов). В дополнение к выполнению базовых задач Cotype Pro 2 поддерживает «ролевой отыгрыш» — способность вести диалог от лица специалиста, адаптируя стиль общения под особенности профессии, что повышает качество взаимодействия в клиентской поддержке, обучении сотрудников и т.д. Перед анонсом Cotype Pro 2 прошла тестирование в реальных условиях. В течение трёх месяцев она автоматически сортировала обращения в поддержку банка, а для МТС Live создавала описания мероприятий. Также тестирование подтвердило возможность интеграции с инструментами RAG (Retrieval-Augmented Generation) для извлечения информации из баз знаний с генерацией текста, что будет востребовано, например, в чат-ботах, где нужно регулярно обновлять данные и в течение нескольких секунд предоставлять ответы на запросы. Как сообщили в MTS AI ресурсу Forbes, семейство корпоративных отраслевых ИИ-агентов, над которыми сейчас ведётся работа, будет, в частности, включать следующие решения:

Сообщается, что МТС также начала предоставлять консалтинговые услуги по внедрению ИИ-продуктов в эти сферы. Как ожидает компания, к 2027 году коммерциализация ИИ-агентов будет приносить её ИИ-направлению более половины выручки.

02.04.2025 [10:31], Сергей Карасёв

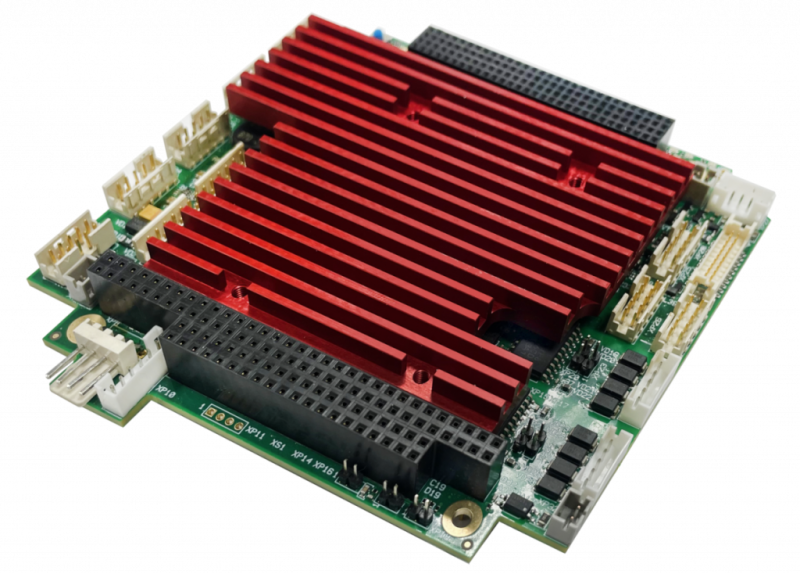

НПК «Атроник» выпустила одноплатный компьютер формата PC/104-Plus с чипом Vortex86 DX3Научно-производственная компания (НПК) «Атроник» представила встраиваемый одноплатный компьютер МЦП303 стандарта PC/104-Plus. Изделие, предназначенное для применения в промышленных системах управления, допускает эксплуатацию в широком температурном диапазоне, при высоких ударных и вибрационных нагрузках. Устройство выполнено на процессоре Vortex86DX3 с двумя ядрами, работающими на частоте 800 МГц. Объём памяти DDR3-533 SDRAM составляет 2 Гбайт, ёмкость встроенной флеш-памяти — до 64 Гбайт. Все эти компоненты напаяны на плате, что способствует повышению надёжности при работе в неблагоприятных условиях. Для вывода изображения могут быть задействованы интерфейсы D-Sub и LVDS (24 бит; до 1920 × 1440). Допускается подключение внешних устройств хранения данных через интерфейсы SATA и IDE (карта Compact Flash). Предусмотрены сетевые порты 1GbE и 100MbE, четыре последовательных порта, четыре порта USB 2.0 и восемь линий программируемого дискретного ввода-вывода, а также универсальный параллельный порт (LPT) с поддержкой режимов SPP/EPP и интерфейс PS/2 (клавиатура/мышь). Есть три сторожевых таймера (WDT): два внутренних с возможностью программного управления от 30,5 мкс до 512 с и внешний с фиксированным интервалом срабатывания 1,6 с. Габариты изделия составляют 115 × 102 × 24 мм, масса — 300 г. Диапазон рабочих температур простирается от -40 до +85 °C. Изделие выдерживает одиночные удары с пиковым ускорением до 150g. Среди прочего упомянуты часы реального времени, а также возможность сохранения настроек BIOS, установок системы и аварийных параметров в энергонезависимой памяти FRAM. Заявлена совместимость с программными платформами MS DOS, QNX, Windows, RTOS32 и Linux.

01.04.2025 [16:05], Руслан Авдеев

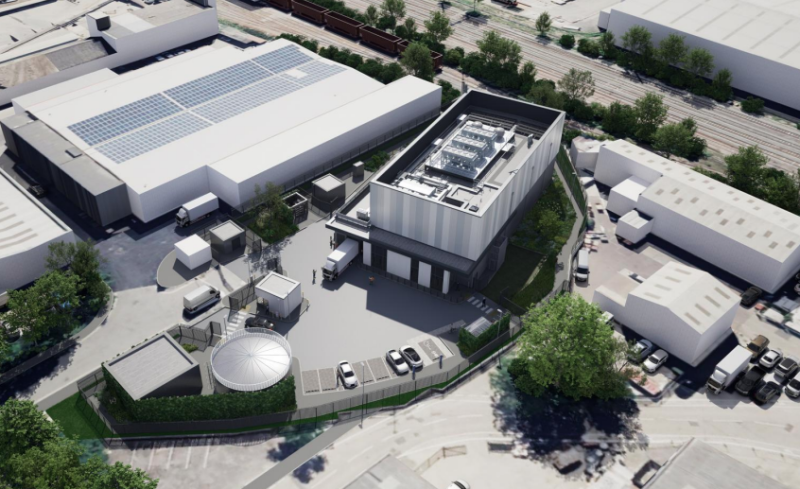

В Лондоне появится экобезопасный ЦОД AWS для ленточных накопителейНа территории технопарка Silverdale Industrial Estate на западе «Большого Лондона» в ближайшие годы появится экобезопасный и энергоэффективный дата-центр компании Amazon (AWS). Проект разрабатывается архитектурным бюро MCA Architects для инвесторов из Mulhaven Properties и представляет собой передовое решение для хранения данных, сообщает портал Blocks & Files. Как сообщается в презентации MCA Architects, предусмотрена полная рекультивация участка площадью 0,44 га — сейчас там находится пустой складской комплекс. На его месте появятся современные здания. В частности, речь идёт об основном здании высотой более 13 м (несколько этажей). Рядом разместится офисное здание высотой около 6 м. Общая площадь застройки — около 3200 м². Будут созданы раздельные въезды и выезды для грузового транспорта. Также предусмотрено внедрение современной системы безопасности и ограждений высотой 2,3–4 м.

Источник изображения: MCA Architects Новый дата-центр предназначен для размещения ленточных накопителей вместо традиционных серверов. Также ЦОД будет получит резервный генератор мощностью 1,08 МВт. Предусмотрено использование системы поддержания микроклимата (температура 16–25 °C, влажность 20–50 %). Водопотребление в сравнении с обычным ЦОД крайне невелико — менее 150 м³ в год, такими объёмами можно буквально пренебречь при расчётах. Особое внимание уделили минимизации воздействия на окружающую среду. Так, выбросы углекислого газа должны быть уменьшены на 15 % в сравнении с нормами Part L 2021 Building Regulations. Одной из главных целей является получение сертификата BREEAM Excellent, одного из самых престижных в области экологического строительства. Дополнительно планируется сбор дождевой воды, использование засухостойких растений, вертикального озеленения фасадов и др. Проект имеет для региона большие перспективы. Общий объём инвестиций AWS в связанные с ЦОД процессы в Великобритании в следующие пять лет составит £8 млрд. В целом с 2010 года инвестиции Amazon в Великобритании превысили £56 млрд. Проект уже вызвал интерес экспертного сообщества. Он демонстрирует возможности интеграции высокотехнологичной инфраструктуры в промышленную застройку и использования одних из самых передовых экорешений в Европе. Приветствуют новые инвестиции и местные власти. Пока проект находится на стадии согласования, строительство может начаться уже в 2025 году, а ввод объекта в эксплуатацию — в 2027 году. Это лишь один из расширяющейся сети ЦОД AWS в Великобритании, включающей уже несколько крупных кампусов, в том числе строящийся к югу от участка комплекс. В январе Trendfocus сообщала, что по итогам 2024 года спрос на ленточные накопители вырос на 12 %.

01.04.2025 [14:53], Владимир Мироненко

Arm намерена занять 50 % рынка чипов для ЦОД к концу 2025 года — NVIDIA ей в этом поможетСогласно прогнозу Arm Holdings, к концу 2025 года доля процессоров с Arm-архитектурой на мировом рынке CPU для ЦОД вырастет до 50 % с 15 % в 2024 году. В интервью агентству Reuters Мохамед Авад (Mohamed Awad), руководитель подразделения инфраструктурных решений Arm, отметил, что благодаря более низкому энергопотреблению, чем у процессоров Intel и AMD, Arm-чипы становятся все более популярными среди компаний, занимающихся облачными вычислениями. Журналист ресурса The Register обратился в Arm Holdings с просьбой пояснить, благодаря чему компания рассчитывает добиться столь стремительного роста доли на рынке. Как сообщили в британской компании, принадлежащей японскому конгломерату Softbank, её прогноз в значительной степени основан на росте поставок ИИ-серверов. Мохамед Авад сообщил The Register, что в течение следующих нескольких лет, как ожидает компания, продажи ИИ-серверов вырастут на 300 %. «Для этого увеличения энергоэффективность больше не является конкурентным преимуществом — это базовое отраслевое требование. Именно здесь вычислительная платформа Arm Neoverse является явным лидером и предпочтительной платформой для ведущих партнёров отрасли, включая AWS, Google, Microsoft и NVIDIA», — заявил он. Как утверждает Arm Holdings, Arm-архитектура всё чаще используется гиперскейлерами AWS, Google, Microsoft в своих чипах. По оценкам Bernstein Research, в 2023 году почти 10 % серверов по всему миру содержат Arm-процессоры приложений в качестве «основных мозгов», и половина из них была развёрнута Amazon, сообщившей, что у нее в облаке используется более 2 млн чипов Graviton собственной разработки. В свою очередь, Google объявила в 2024 году о выпуске собственного процессора Axion на базе Neoverse V2 для своих ЦОД, а Microsoft сообщила в конце прошлого года об общедоступности в облаке Azure инстансов с использованием процессоров собственной разработки Cobalt 100. Расширение использования этими провайдерами облачных услуг Arm-процессоров может объяснить часть роста, который Авад прогнозирует на этот год, но продукты NVIDIA также, вероятно, составят значительную долю, полагает The Register. Например, система DGX GB200 NVL72 включает 36 процессора NVIDIA Grace и 72 ускорителя Blackwell B200, что составляет 2592 ядра Arm Neoverse V2, и они, вероятно, будут востребованы в этом году, отметил ресурс. Также не следует забывать о других решениях для ЦОД, которые имеют ядра на базе Arm-архитектуры, такие как SmartNIC и DPU — BlueField-3 от NVIDIA, а также карты Nitro в серверах AWS.

01.04.2025 [14:51], Руслан Авдеев

Bharti Airtel подключила Мумбаи к мировой сети с помощью кабеля 2Africa Pearls с пропускной способностью 100 Тбит/сТелеком-оператор Bharti Airtel ввёл в эксплуатацию участок Pearls подводного кабеля 2Africa, обеспечивающий новое подключение Индии к глобальной сети. Сегмент Pearls с посадочной станцией в Мумбаи добавит 100 Тбит/с к пропускнуой способности интернет-каналов страны, сообщает Network World. По данным представителя Airtel Business, на подводные кабели приходится 95 % глобального трафика — от видеозвонков до другого контента и финансовых транзакций, а также трафика для обеспечения работы всевозможных облачных сервисов. Кабели обеспечивают высокоскоростную связь с низкой задержкой от континента к континенту. Проект Airtel позволяет напрямую связать Индию с Африкой, Европой и Ближним Востоком. По словам представителя Greyhound Research, дело не только в ёмкости — хотя 100 Тбит/с выглядит очень внушительно на бумаге. Важнее то, какие возможности обеспечивает такая пропускная способность. Долгое время индийский бизнес зависел от старых подводных кабелей с низкими пропускной способностью и надёжностью, а также с не самой эффективной маршрутизацией с большой задержкой.

Источник изображения: Previn Samuel/unsplash.com Подводная кабельная система 2Africa Pearls простирается на 45 тыс. км, к реализации проекта причастны многие компании, включая Bayobab, China Mobile International, Meta✴, Orange, Telecom Egypt, Vodafone Group и WIOCC. За производство кабеля и его прокладку отвечала Alcatel Submarine Networks (ASN). Новая кабельная система является частью более масштабного глобального проекта по обеспечению цифровой связи. Как утверждают в CyberMedia Research, пропускная способность Pearls превосходит большинство существующих кабельных систем. По имеющимся данным, теперь общая протяжённость инфраструктуры Airtel превышает 400 тыс. км — это более 34 кабелей, связывающих 50 стран на пяти континентах. Индийские компании получат небывалые преимущества от использования кабеля. Так, низкая задержка чрезвычайно важна для бизнес-операций, требующих немедленной, бесперебойной связи. Кроме того, инфраструктура поможет снизить общую стоимость связи, что обеспечит дополнительные преимущества малому и среднему бизнесу, особенно в сфере IT. Индийский бизнес получит «расширенный» доступ к африканскому и европейскому рынкам. Экономический эффект ожидается во многих сферах, от ИИ до облачных и периферийных вычислений вообще, появятся и расширенные возможности использования Интернета вещей, во многом — благодаря низкой задержке. В долгосрочной перспективе введение кабеля в эксплуатацию поможет Индии превратиться в один из локомотивов цифровой экономики. В Airtel пообещали продолжить инвестиции в новые подводные кабели для того, чтобы соответствовать запросам мировых бизнес-процессов. Это не единственный масштабный проект прокладки подводных кабелей в мире. В конце прошлого года сообщалось, что Meta✴ проложит «кругосветный» подводный интернет-кабель Waterworth протяжённостью 50 тыс. км и пропускной способностью 320 Тбит/с.

01.04.2025 [14:07], Руслан Авдеев

Microsoft вновь заявила о намерении сотрудничать с OpenAI несмотря на пересмотр планов по развитию ЦОДMicrosoft отрицает слухи о том, что её решение отказаться от проектов ЦОД минимум на 2 ГВт и/или отложить их реализацию может означать сокращение сотрудничества с OpenAI. Компания объяснила своё решение совсем иными причинами, сообщает Computer Weekly. Ранее об отказе Microsoft от проектов новых ЦОД объявили в своём докладе аналитики TD Cowen. Указывалось, что речь идёт о проектах в США и Европе. Причиной изменений было названо решение Microsoft не поддерживать растущие нагрузки OpenAI по обучению новых ИИ-моделей. В TD Cowen заявляли, что отношения двух компаний постепенно сворачиваются после того, как в январе 2025 года Microsoft подтвердила отказ от эксклюзивного соглашения в части хостинга проектов OpenAI. В блоге Microsoft сообщалось, что OpenAI сохранила приверженность к реализации крупного проекта на базе Azure. При этом подчёркивалось, что «эксклюзивность» более не предусмотрена — у Microsoft просто сохранится «право первого отказа» при выборе облака ИИ-стартапом. Это означает, что Microsoft сможет первой решать, отказываться ли ей от нагрузок OpenAI. При этом последняя сохраняет право реализовать альтернативные проекты, если Microsoft не сможет удовлетворить запросы компании.

Источник изображения: Jose Vazquez/unsplash.com Теперь Microsoft выступила с заявлением, подтверждающим прочность связей с OpenAI и опровергающим гипотезы TD Cowen. Что касается решения компании сократить экспансию на рынке ЦОД, Microsoft заявила, что имеет «хорошие возможности» для удовлетворения текущего и растущего пользовательского спроса на свои сервисы благодаря «значительным инвестициям», уже сделанным в инфраструктуру на данный момент. В компании подчёркивают, что только в прошлом году она добавила своим ЦОД больше ёмкости, чем в любой предыдущий год в своей истории. Хотя некоторые оптимизации возможны в отдельных сферах, Microsoft продолжит «сильный рост во всех регионах». В частности, это позволит инвестировать и распределять ресурсы в зоны роста во имя будущего компании. В её планах — потратить более $80 млрд на инфраструктуру в текущем финансовом году. Microsoft выступает партнёром с OpenAI с 2019 года. Ранее компании заявляли, что работают над общей целью «ответственного развития ИИ-исследований», в то же время обеспечивая демократизацию соответствующих технологий, чтобы все могли ими воспользоваться. Впоследствии Microsoft опубликовала детали будущего сотрудничества с OpenAI. Последняя сообщила о намерении потратить $500 млрд в рамках проекта Stargate. Softbank, Oracle, MGX и OpenAI — инвесторы-акционеры инициативы, а Microsoft названа «технологическим партнёром». Говоря о сотрудничестве с OpenAI, представитель Microsoft заявляет, что компании останутся хорошими партнёрами и сохраняют приверженность к «продвижению ИИ-фронтира вперёд», делая передовые ИИ-модели доступными для клиентов и партнёров. Тем временем сама OpenAI становится всё более могущественной структурой. В ходе последнего раунда финансирования компания привлекла рекордные для отрасли $40 млрд и, возможно, до конца года выйдет на IPO для привлечения новых денег. |

|