Материалы по тегу: разработка

|

21.10.2025 [12:13], Руслан Авдеев

ОАЭ собрались стать ИИ-сверхдержавой: за пять лет в стране появится 10 тыс. ИИ-компанийОтветственный за ИИ-проекты ОАЭ министр Омар Султан Аль Олама (Omar Sultan Al Olama) озвучил планы стимулировать развитие ИИ-стартапов в стране. По его словам, через пять лет в ОАЭ будет 10 тыс. таких компаний, тогда как на сегодняшний день их лишь 1,5 тыс., сообщает Computer Weekly. В то же время предполагается поощрять традиционные отрасли промышленности использовать решения на базе систем искусственного интеллекта — там, где он применим, для сохранения и наращивания рыночной доли. Стратегия Эмиратов по превращению в ИИ-сверхдержаву предусматривает реализацию специальных программ. Ещё 2017 году страна первой в мире назначила «министра по вопросам искусственного интеллекта, цифровой экономики и удалённой работы». ОАЭ стремятся привлечь в страну лучшие умы и компании. Даже сегодняшний показатель в 1,5 тыс. действующих ИИ-бизнесов — самый высокий в регионе. Для того, чтобы добиться уровня в 10 тыс., необходимо будет создать условия, при которых в Эмираты потянутся новые выдающиеся люди. Хотя на частный сектор в ОАЭ приходится большая часть экономической активности, государственный сектор — жизненно важный компонент экономики и общества. Планы развития ИИ в стране имеют обширную государственную поддержку в рамках инициативы UAE Centennial 2071.

Источник изображения: Fredrik Öhlander/unsplash.com Она предусматривает внедрение ИИ для развития частного и государственного секторов на всех уровнях и превращение страны в мирового лидера в данной сфере. Предполагается, что это поможет диверсифицировать экономику, избавившись от чрезмерной зависимости от нефтегазовых доходов. В ОАЭ развёрнута программа сертификации и ранжирования ИИ-бизнесов, в которой компании оцениваются по уровню компетентности и интеграции в экономику ОАЭ. Подающие заявку на получение сертификатов бизнесы ранжируются от просто «ИИ-компании» до компаний, имеющих «полное присутствие» в стране, т.е. тех, что создают свои модели и разрабатывают продукты для внутригосударственного использования. По слова министра, обычная компания получит рейтинг D, имеющая в стране представительство — C, ведущая там исследования — B, а та, у которой в ОАЭ штаб-квартира и есть локально разработанные модели специально для ОАЭ — рейтинг S. При прочих равных предпочтение государственными органами отдаётся при ведении дел компанией с рейтингом S. В дальнейших планах — распространить схему за пределы исключительно стартапов и технологических компаний, чтобы преимуществами ИИ могли воспользоваться и другие бизнесы, в том числе из сферы туризма, логистики, авиаперевозок и др. Главное в ИИ-программах — их прикладное значение. По словам министра, ИИ должен повышать качество жизни — неудачей будет использование бесполезных «безделушек», которые будут выдаваться за успехи внедрения ИИ. Тем временем в начале октября сообщалось, что что в NVIDIA расстроены задержками поставок ИИ-ускорителей в ОАЭ из-за особенностей американской политики, учитывающей конкуренцию с Китаем в сфере искусственного интеллекта. Не так давно в ОАЭ обязались инвестировать в США миллиарды долларов в обмен на поставки чипов в страну.

16.10.2025 [13:39], Руслан Авдеев

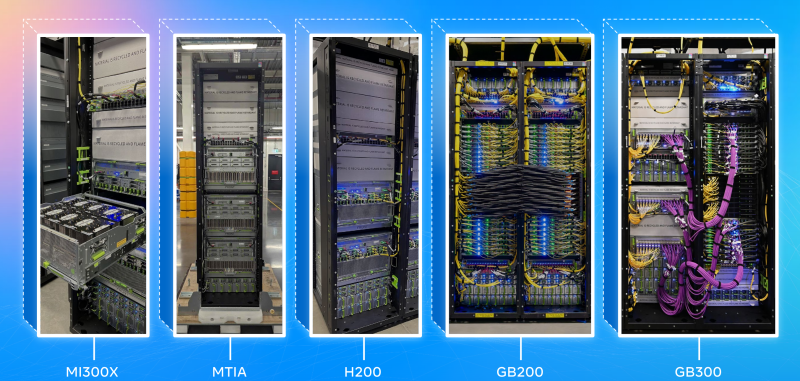

Унификация, стандартизация, совместимость: Google призвала создавать взаимозаменяемые компоненты для ИИ ЦОДВ ходе мероприятия OCP Summit компания Google выступила с общеотраслевой инициативой «переосмысления» архитектуры ЦОД, оптимизированных для эпохи ИИ. В рамках сообщества Open Compute Project (OCP) предлагается создать рабочее направление по разработке «гибких, взаимозаменяемых ЦОД», сообщает пресс-служба компании. Google подчеркнула, что скорость внедрения и неоднородность ИИ-технологий растёт, что затрудняет создание общей системы, проектирования, развёртывания и обслуживания ЦОД. Представленный Google проект предусматривает создание модульных, совместимых друг с другом решений для ЦОД, позволяющих легко адаптироваться к стремительному развитию ИИ и изменению рабочих нагрузок. Говорится о «начале революции» в сфере ИИ — мир радикально изменился и необходимо создавать дата-центры, способные меняться не менее быстро. По данным компании, за последние 24 месяца использование ИИ-ускорителей внутри Google увеличилось в 15 раз, объём хранилищ для машинного обучения Hyperdisk ML — в 37 раз, а количество обработанных токенов — до двух квадрлн/мес. В Google сравнивают исследователей ИИ с исследователями космоса, а участников OCP, строителей инфраструктуры — со строителями ракет. Сама инфраструктура компании, как утверждается, поддерживает ИИ-трансформацию на всех уровнях экосистемы, от пользовательских приложений (на основе Gemini) до корпоративных сервисов и научных изысканий в самых разных областях. Особое внимание уделяется обеспечению взаимозаменяемости и гибкости: модульные компоненты, спроектированные различными участниками отрасли, должны быть совместимы с компонентами и системами других поколений и вендоров, причём принципы унификации должны применяться ко всем компонентам ЦОД, включая электропитание, охлаждение, вычислительное оборудование, сетевые технологии и др. Стратегия самой Google строится вокруг т.н. ИИ-гиперкомпьютера — комплексной архитектуры, в которой все компоненты от чипов до электросетей разработаны с учётом общих особенностей системы для обеспечения максимальной эффективности. Благодаря использованию собственных TPU, оптических коммутаторов и СЖО, компания добилась роста энергоэффективности и снижения затрат в 10–100 раз за последние 10 лет. Google уже развернула мегаваттами инфраструктуры с жидкостным охлаждением. Компания вместе с партнёрами организовала в рамках OCP рабочую группу, целью которой является создание единых стандартов обеспечения модульности и совместимости компонентов, а также общих интерфейсов в области вычислений, сетей, хранилищ, безопасности и устойчивости. В частности, участники OCP договорились о разработке гибких систем электропитания для современных ЦОД. Речь идёт о стандартизации 400-В архитектур и модульных системах Mt. Diablo с использованием твердотельных преобразователей. Также ведутся работы в сфере микросетей и аккумуляторных хранилищ. Всё вместе это позволит сглаживать пики потребления энергии, характерные для обучения ИИ, а в перспективе и возвращать излишки энергии обратно в энергосети. Охлаждение также переосмысливается в эпоху ИИ. В начале 2025 года OCP представлено современное решение для жидкостного охлаждения Project Deschutes. Теперь оно получит широкое распространение среди вендоров, включая поставщиков жидкостного охлаждения вроде Boyd, CoolerMaster, Delta, Envicool, Nidec, nVent и Vertiv. Сообщество работает над унификацией интерфейсов охлаждения, новых теплообменников. Важную роль играет стандартизация компонентов и интерфейсов в колокейшн- и сторонних ЦОД. Наконец, Google подчёркивает необходимость унификации физических стандартов: высоты, ширины, глубины и даже грузоподъёмности стоек; ширины и планировки проходов, интерфейсов стоечного и сетевого оборудования. Также требуются единые стандарты для телеметрии и мехатроники, которые лягут в основу строительства и эксплуатации дата-центров следующего поколения. Совместно с партнёрами по OCP ведутся работы над стандартизацией интеграции телеметрии для сторонних дата-центров. Помимо физической инфраструктуры, по словам Google, необходимо внедрение открытых стандартов для обеспечения масштабируемости и безопасности систем:

Для измерения воздействия на окружающую среду предложена методология измерения потребления энергии, воды и подсчёта выбросов в ходе ИИ-нагрузок. В частности, с их помощью выяснилось, что медианный промпт Gemini тратит менее 5 капель воды и электричество в объёме, достаточном для просмотра телевизора в течение менее девяти секунд. Эти методы подсчёта касаются и других, совместных с OCP проектов, включая выпуск экобезопасного бетона, чистой резервной энергии и др. Google приглашает принять участие в инициативе OCP Open Data Center for AI Strategic для разработки общих стандартов. Наконец, сообщество OCP призвали работать над проектами «ИИ для ИИ» — использованием искусственного интеллекта для разработки ИИ-систем следующего поколения. Так, проект AlphaChip предусматривает использование ИИ для размещения компонентов чипов, что уже позволило улучшить показатели мощности, производительности и др., одновременно сократив время проектирования. Предполагается, что создание ИИ систем с помощью ИИ, от полупроводников до программного обеспечения, позволит достигнуть нового уровня эффективности технологий.

16.10.2025 [00:33], Владимир Мироненко

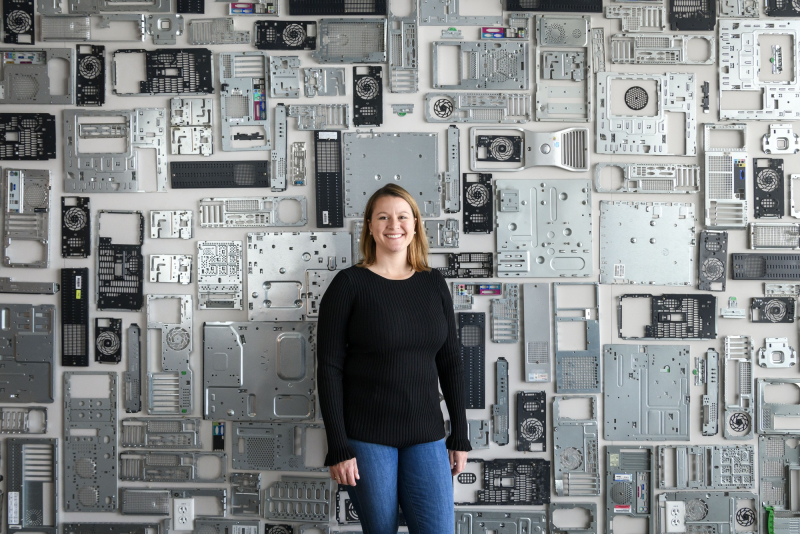

От мВт до МВт: Arm и Meta✴ объявили о стратегическом партнёрство в области ИИArm Holdings и Meta✴ Platforms объявили о стратегическом партнёрстве, направленном на «масштабирование эффективности ИИ на каждом уровне вычислений, охватывающем ПО и инфраструктуру ЦОД». Как отмечено в пресс-релизе, сотрудничество позволит использовать ИИ в различных типах вычислений, рабочих нагрузках и процессах, которые лежат в основе глобальных платформ Meta✴, а также объединить «лидерство Arm в области энергоэффективных вычислений на базе ИИ с инновациями Meta✴ в области продуктов, инфраструктуры и открытых технологий на базе ИИ для достижения значительного повышения производительности и эффективности». «От взаимодействия с нашими платформами до создаваемых нами устройств, ИИ меняет способы взаимодействия и творчества людей. Партнёрство с Arm позволяет нам эффективно масштабировать эти инновации для более чем 3 млрд пользователей приложений и технологий Meta✴», — заявил руководитель глобальной инфраструктуры Meta✴. Сообщается, что в рамках сотрудничества системы ранжирования и рекомендаций Meta✴ на основе ИИ, играющие ключевую роль в поиске и персонализации в таких сервисах, как Facebook✴ и Instagram✴, будут использовать платформы Arm Neoverse для обеспечения более высокой производительности и более низкого энергопотребления по сравнению с x86-системами. Решения британского разработчика также позволят Meta✴ улучшить показатель производительности на Вт, что подчёркивает эффективность и масштабируемость Arm для гиперскейлеров, отметила Arm. Сделка с Meta✴ станет важным подтверждением эффективности архитектуры Arm, которая конкурирует с устоявшейся архитектурой x86, используемой Intel и AMD, отметило агентство Reuters. Новое соглашение позволит углубить сотрудничество в области оптимизации ПО для ИИ-технологий в рамках фреймворка МО PyTorch, движка выполнения периферийных вычислений ExecuTorch и движка инференса vLLM, а также обеспечит дальнейшее совершенствование платформы Executorch, оптимизированной с помощью Arm KleidiAI. Также компании отметили, что сотрудничество позволит упростить развёртывание ИИ-моделей и повысить производительность ИИ-приложений от периферии до облака.

Источник изображения: Meta✴ Сообщается, что проекты с открытым исходным кодом играют ключевую роль в стратегии Meta✴ в области ИИ, позволяя разрабатывать и внедрять различные решения: от рекомендаций до разговорного интеллекта. Компании подтвердили намерение расширять в дальнейшем возможности оптимизации этих проектов с открытым исходным кодом, позволяя миллионам разработчиков по всему миру создавать и запускать ИИ-решения на базе Arm. Работа над открытым исходным кодом будет способствовать более широкому внедрению Arm-архитектуры за счет повышения совместимости ПО, что является ключевым препятствием для её более широкого использования, пишет Reuters. Как отметил ресурс TechCrunch, Arm и Meta✴ не обмениваются долями собственности или элементами инфраструктуры, что отличает это соглашение о сотрудничестве от ряда недавних сделок на рынке ИИ-инфраструктуры. Доля Arm на рынке серверных процессоров стремительно выросла за последние годы, во многом благодаря ИИ-платформам NVIDIA. По данным The Register, пока речь идёт как раз об оптимизации ПО для уже развёрнутых Arm-платформ, а не о создании кастомного CPU.

14.10.2025 [19:00], Сергей Карасёв

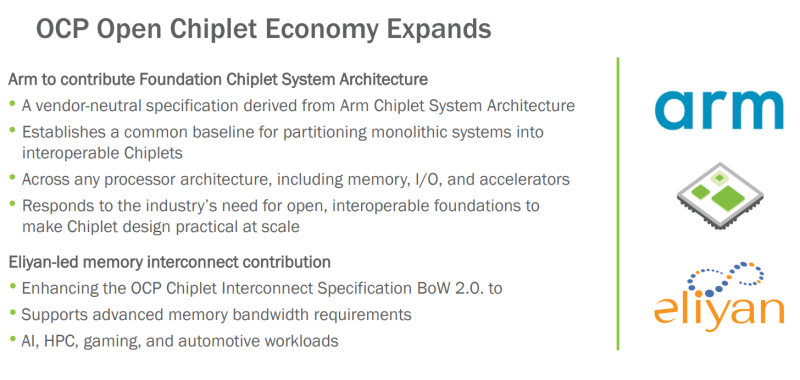

OCP поможет в унификации чиплетов с применением открытых стандартов: Arm и Eliyan поделились наработкамиНекоммерческая организация Open Compute Project Foundation (OCP) сообщила о расширении так называемой «открытой чиплетной экономики» (Open Chiplet Economy). Свои наработки в данной сфере сообществу передали компании Arm и Eliyan. Open Chiplet Economy — это инициатива OCP Server Project Group. Она позволяет разработчикам чиплетов посредством открытого рынка взаимодействовать с производителями продукции. Речь идет о формировании унифицированной экосистемы, за поддержание которой в актуальном состоянии отвечает OCP. В рамках проекта компания Arm передала организации OCP и её участникам архитектуру FCSA (Foundation Chiplet System Architecture), основанную на CSA (Chiplet System Architecture). Она определяет общие базовые стандарты для разделения монолитных систем на чиплеты, которые затем могут использоваться в составе различных изделий, включая память, устройства ввода-вывода и ускорители. Такой подход, как ожидается, упростит создание новых продуктов благодаря повторному использованию уже разработанных блоков. Кроме того, повысится гибкость за счёт отказа от привязки к проприетарным стандартам чиплетов. В свою очередь, Eliyan предоставит сообществу разработки, которые помогут расширить спецификацию интерконнекта для чиплетов OCP BoW 2.0 (Bunch of Wires). В частности, будут добавлены функции для систем, которым требуется высокая пропускная способность: это могут быть приложения ИИ, НРС, игры, автомобильные платформы и пр. Целевым показателем является поддержка скоростей памяти HBM4 (2 Тбайт/с для чтения или записи) вместе с дополнительным каналом связи для сигналов ECC и управления.

12.10.2025 [14:51], Сергей Карасёв

Graphcore, спасённая SoftBank, воспрянула духом — штат в Великобритании удвоится, а в разработку в Индии инвестируют $1 млрдБританский стартап Graphcore, занимающийся созданием специализированных ИИ-ускорителей, по сообщению Datacenter Dynamics, намерен инвестировать в Индии до $1 млрд в течение следующих 10 лет. При этом в Бангалоре на юге страны будет сформирован кампус для разработки ИИ-решений. Компания Graphcore, основанная в Бристоле в 2016 году, проектирует ускорители нового класса под названием Intelligence Processing Unit (IPU). Архитектура таких изделий основана на применении особых «тайлов» — это область кристалла, содержащая вычислительную логику и некоторое количество быстрой памяти. В июле прошлого года фирму Graphcore за неназванную сумму приобрела японская холдинговая корпорация SoftBank Group, которая активно развивает направление ИИ. Как отмечает Graphcore, на базе нового ИИ-кампуса в Индии будут сформированы около 500 новых рабочих мест. Планируется привлекать специалистов в области проектирования логических схем, дизайна, тестирования и пр. Инженеры Graphcore в Бангалоре займутся разработкой передовых ИИ-решений, которые в перспективе помогут в решении глобальных проблем в области общественного здравоохранения, экологической устойчивости и пр. Говорится, что с 2015 года SoftBank Group инвестировала в различные инициативы в Индии более $12 млрд. Создаваемая в Бангалоре площадка будет способствовать реализации комплексной стратегии SoftBank Group по трансформации в ведущего мирового поставщика ИИ-платформ. Напомним, японская корпорация участвует в масштабном проекте Stargate по развитию ИИ-инфраструктуры в США: предполагается, что суммарные затраты в рамках данной инициативы достигнут $500 млрд. Между тем Graphcore заявила о намерении увеличить численность персонала. Ожидается, что в ближайшие два года количество сотрудников в британском представительстве вырастет примерно вдвое, достигнув 750 человек. Речь идёт о привлечении разработчиков чипов и ПО, а также специалистов в сфере ИИ. При этом два года назад состояние компании было не лучшим. Из-за проблем с финансами она закрыла офис в Китае, свернула операции в Норвегии, Японии и Южной Корее, а также сократила пятую часть штата.

29.09.2025 [12:35], Сергей Карасёв

Databricks и OpenAI помогут клиентам в развёртывании приложений на базе передовых ИИ-моделейСтартап Databricks, специализирующийся на создании решений в сфере аналитики данных и ИИ, и компания OpenAI объявили о заключении многолетнего соглашения о сотрудничестве. Партнёры помогут клиентам в развёртывании агентов на базе передовых ИИ-моделей. В рамках соглашения модели OpenAI, включая GPT-5, будут тесно интегрированы со средой ИИ-разработки Databricks Agent Bricks. Заказчики получат возможность создавать готовые к использованию ИИ-приложения непосредственно на основе управляемых данных на платформе Databricks Data Intelligence. Цель сотрудничества Databricks и OpenAI в том, чтобы предоставить организациям единую инфраструктуру для разработки, оценки и масштабирования ИИ-агентов — систем, способных выполнять задачи автономно, практически без участия человека. Это могут быть агенты рассуждений для поддержки принятия решений в той или иной сфере, анализа финансовых рисков, проверки контрактов и планирования логистики. В качестве других примеров названы агенты повышения производительности для поддержки пользователей, а также агенты-разработчики для отладки систем, модернизации устаревших приложений и создания готового к использованию программного кода. Клиенты Databricks смогут запускать большие языковые модели (LLM) на основе собственных корпоративных данных, доступных через SQL-запросы или API, и безопасно развёртывать их в нужном масштабе с помощью встроенных средств управления и мониторинга. Сотрудничество также охватывает каталог Databricks Unity Catalog, который используется для управления данными и моделями ИИ. По заявлениям Databricks, он помогает отслеживать происхождение данных, контролировать доступ и обеспечивать соблюдение нормативных требований. В целом, партнёрство направлено на ускорение внедрения ИИ в корпоративном секторе. Ожидается, что в рамках сотрудничества Databricks и OpenAI получат более $100 млн выручки. В марте нынешнего года Databricks заключила аналогичное соглашение с компанией Anthropic PBC (разработчик LLM семейства Claude), которая была основана в 2021 году выходцами из OpenAI.

27.09.2025 [15:34], Андрей Крупин

Российская платформа для разработки GitFlic дополнилась интеграцией с системами управления проектами«Группа Астра» сообщила о выпуске обновления платформы для разработки GitFlic. Новый релиз продукта получил индекс 4.5.0. Ключевым улучшением GitFlic стала ликвидация разрыва между системами контроля версий и управления задачами благодаря интеграции программного комплекса с системами управления проектами — «Яндекс Трекером» и другими популярными трекерами. Теперь упоминание номера задания в коммите или запросе на слияние автоматически создаёт комментарий в связанной системе с деталями изменения. Интеграция поддерживает опции стандартных и расширенных примечаний, а также автоматически переводит статус задачи в финальный после выполнения обращения.

Источник изображения: gitflic.ru GitFlic 4.5.0 обеспечивает сквозную прослеживаемость изменений: участники проекта могут отслеживать всю историю правок, связанных с конкретной задачей, без переключения между интерфейсами. Это повышает дисциплину ведения задач и упрощает аудит процессов разработки. Интеграции доступны для настройки во всех проектах на платформе. «В современной бизнес-среде скорость и слаженность работы команды напрямую влияют на конкурентоспособность продукта. Разрыв между кодом и задачами — это потеря времени и источник ошибок. Интеграции GitFlic с такими отечественными инструментами, как, например, «Яндекс Трекер», устраняют эту пропасть, создавая единое рабочее пространство», — говорится в сообщении «Группы Астра».

25.09.2025 [19:14], Андрей Крупин

Selectel запустила программу OpenFix по работе с открытым кодом за вознаграждениеSelectel, крупнейший независимый провайдер сервисов IT-инфраструктуры в России, анонсировал запуск проекта OpenFix, в рамках которого намерена выплачивать IT-специалистам денежные вознаграждения за участие в работе по развитию и исправлению ошибок в программном обеспечении c открытым кодом. Инициатива направлена на поддержку сообщества Open Source и призвана привлечь больше ресурсов к повышению безопасности и надёжности подобных решений. Принять участие в проекте OpenFix может любой желающий, обладающий навыками программирования и разработки ПО. Для этого необходимо ознакомиться с условиями программы, выбрать из предложенного списка задачу по исправлению или доработке кода и отправить заявку для регистрации в проекте. За выполненную работу производится соответствующая оплата, при этом код реализованных проектов публикуется под пермиссивной лицензией с сохранением авторства и указанием участника, который работал над задачей. Задачи в OpenFix поделены на три уровня, предполагающих переписывание известных открытых проектов на язык Rust для обеспечения их надёжности и безопасности, пакетизацию ПО для Debian, чтобы пользователи быстрее получали полезные программы в официальных репозиториях, и исправление ошибок в существующих открытых проектах. Размер вознаграждения зависит от сложности задачи и может достигать 350 тыс. руб. Программа OpenFix нацелена на создание дополнительных стимулов для разработчиков и укрепление сообщества, что в конечном итоге способствует повышению надёжности и безопасности Open Source-решений, используемых повсеместно. Важным аспектом такой модели является возвращение доработок в общий репозиторий теми, кто использует код для своих продуктов. Это формирует устойчивую экосистему, способствуя более тесному взаимодействию и развитию Open Source-проектов в России, говорится в сообщении Selectel.

18.09.2025 [11:30], Сергей Карасёв

Впервые в России представлен суверенный конвейер разработки безопасного ПОКонвейер основан на отечественных решениях разработки, тестирования и контроля безопасности ПО Восемь отечественных вендоров совместно с Институтом системного программирования РАН им. В. П. Иванникова и НТЦ «ФОБОС-НТ» представили полностью импортонезависимый конвейер разработки безопасного программного обеспечения (РБПО). Первый показ решения состоялся на стендах компаний в рамках международного форума Kazan Digital Week. В конвейере разработки безопасного ПО используются продукты из Реестра российского ПО, а все инструменты предоставляются компаниями, зарегистрированными в России, поэтому заказчики обеспечены технической поддержкой от производителей. Это выгодно отличает их от открытого ПО. Важной особенностью созданного конвейера является также соответствие требованиям государственных регуляторов, в том числе и ФСТЭК России. Зачем нужен конвейер РБПОВ конвейере разработки безопасного ПО реализована автоматизация всех ключевых этапов разработки — от управления задачами и написания кода, до тестирования и эксплуатации опубликованного ПО. Также предусмотрена методическая поддержка, благодаря чему конвейер можно эффективно применять в реальных проектах. Он помогает ускорить выпуск продуктов за счёт динамической инфраструктуры, оптимизации ресурсов и упорядоченности процессов. Таким образом, применяя конвейер разработки безопасного ПО, заказчик получает управляемый и предсказуемый результат. Ключевое преимущество конвейера РБПО — в том, что проверки безопасности возможно проводить на различных этапах жизненного цикла разработки ПО, а не проверять только в конце, когда работа уже завершена. Такой подход позволяет выявлять и устранять ошибки на ранних стадиях, до того как они станут причинами наличия уязвимостей. По оценкам специалистов, исправление ошибок после выхода продукта в эксплуатацию обходится в среднем в 40 раз дороже, чем на стадии проектирования. В ряде случаев это может привести к существенным потерям и даже остановке бизнеса. Программное обеспечение, разработанное в инфраструктуре конвейера, может считаться более безопасным за счёт исправления недостатков, выявленных с применением специализированных инструментов: автоматического анализа поверхности атаки, статического анализа, сканирования зависимостей для выявления небезопасных библиотек и компонентов, фаззинг-тестирования и динамического тестирования приложений на типовые ошибки и уязвимости. Дополнительно используются средства формирования прозрачной аналитики и метрик для команды и руководства. Сочетание применения этих технологий позволяет своевременно выявлять ошибки в коде и конфигурациях, снижая вероятность их попадания в опубликованную версию разработанного ПО. Потенциальные клиентыНовый конвейер безопасной разработки ориентирован на широкий круг заказчиков. Его применение обеспечит выполнение требований по импортозамещению и разработке безопасного ПО как для организаций государственного сектора, так и крупнейших компаний страны, относящихся к критической информационной инфраструктуре (предприятия промышленности, электроэнергетики, топливно-энергетический сектора, финансов и пр.) и их поставщиков ПО. Организации из финансового сектора и их поставщики ПО также смогут выполнить требования к контролю безопасности ПО, используемого при финансовых операциях и обработке клиентских данных, утверждённых Банком России. Для широкого перечня организаций и вендоров это способ снизить расходы на устранение ошибок и встроить безопасность в привычные CI/CD-процессы, опираясь на лучшие мировые практики. А для стартапов и малого бизнеса — возможность с самого начала закладывать доверие и масштабируемость продукта, повышая его инвестиционную привлекательность. Роли участников«Лукоморье»Экосистема «Лукоморье» обеспечивает управление полным жизненным циклом IT-продуктов в рамках единого конвейера. Система «Яга» позволяет работать с проектами и задачами на всех этапах — от постановки задачи и проверки кода до тестирования, стейджинга и закрытия. В одной рабочей среде можно собрать команду, задачи и всю информацию по проекту. Эксплуатация и сопровождение продуктов организуются через ESM-систему «Диво», обеспечивая поддержку и управление сервисами после выпуска. «Базис»В основе инфраструктуры конвейера разработки безопасного ПО лежат два сертифицированных продукта компании «Базис» — платформа виртуализации Basis Dynamix Enterprise и платформа управления контейнерами Basis Digital Energy. Вместе они создают динамическую инфраструктуру для установки инструментов конвейера РБПО: Basis Dynamix Enterprise создаёт виртуальные узлы для работы конвейера, а Basis Digital Energy разворачивает на них кластеры Kubernetes. OpenIDEOpenIDE — открытая мультиязычная среда разработки и платформа для плагинов — усиливает конвейер на рабочем месте разработчика. OpenIDE переносит контроль безопасности «влево»: с помощью расширений для OpenIDE возможно внедрить предкоммит-проверки, secret-сканы, аудит зависимостей, генерацию SBOM и единые политики линтинга прямо в IDE. Решение работает для Java/Spring, TypeScript/Node.js, Python, Go и IaC и поддерживает локальный AI-ассистент в периметре компании. CodeScoringCodeScoring обеспечивает защиту на основных этапах жизненного цикла разработки программного обеспечения. IDE-плагины вовлекают разработчиков в обеспечение безопасности продуктов, используя привычное окружение и удобство использования. Модуль OSA выявляет уязвимости в используемых для сборки зависимостях и не допускает их попадания во внутреннюю инфраструктуру, а SCA формирует перечень компонентов приложения с указанием рисков безопасности и лицензирования. Система TQI постоянно анализирует качество кода, помогает находить дубликаты, утечки и выстраивать прозрачную работу команд. Дополнительно реализована безопасность секретов: поиск в коде оставленных паролей, токенов и другой чувствительной информации предотвращает утечки конфиденциальных данных и снижает риски несанкционированного доступа. GitFlicПлатформа работы с исходным кодом GitFlic выполняет центральную роль в конвейере разработки безопасного ПО, выступая его ключевым интеграционным хабом и технологическим фундаментом. Она служит не просто мостом между изолированными ранее командами разработки и безопасности, а единой средой, где безопасность становится неотъемлемым и автоматизированным свойством процесса разработки. Решая критически важную задачу защищённого хранения исходного кода с детализированным контролем доступа и аудитом, GitFlic закладывает основу для доверия ко всему конвейеру. «Девелоника» (FabricaONE.AI, ГК Softline)Связующим звеном для контроля процессов внутри конвейера инструментов РБПО выступит методология «Девелоника Fusion». Внедрение методологии, разработанной компанией «Девелоника», предполагает принципиальное соблюдение SLA. Подход объединил более 100 метрик под индивидуальные KPI (включая Cycle Time, Work in progress и Throughput). Заказчики смогут горизонтально декомпозировать работу по направлениям и срокам, получать аналитику по жизненному циклу задач и фиксировать результат на каждом этапе проекта. Комплексность практик позволяет сократить до 45 % времени и ресурсов разработки и повысить эффективность производственных команд до 30 %. Test IT («Девелоника», FabricaONE.AI, ГК Softline)В DevTestSecOps-процессах тестирование встроено на всех этапах — от проектирования до релиза. В импортонезависимом конвейере инструментов РБПО ключевую роль в организации и поддержании QA-процессов выполняет Test IT. Платформа для управления тестированием объединяет работу с ручными и автотестами в едином интерфейсе, упрощает подготовку, запуск и анализ тестов и обеспечивает прозрачность и предсказуемость процесса тестирования. Решение поддерживает десятки интеграций с инструментами для разработки и тестирования, а также с ИИ-моделями для генерации тест-кейсов внутри TMS, что позволяет многократно ускорить время на подготовку тестовой документации. ИСП РАНИСП РАН — это научная организация, развивающая тематику исследований безопасности ПО. Разработчик статического анализатора Svace и сервера сбора результатов Svacer, фаззера Sydr, системы определения поверхности атак Natch, и пр. Активно участвует в развитии направления РБПО в РФ: разрабатывая ГОСТы, проводя аудиты и внедрения своих инструментов в организациях-разработчиках ПО и ОКИИ. В ИСП РАН действует орган по сертификации процессов РБПО при ФСТЭК России. Подходы и инструменты ИСП РАН позволяют определять уязвимости в ПО на ранних стадиях его разработки, делая его более безопасным и надёжным. НТЦ «ФОБОС-НТ»Внедрение методологий и инструментов безопасной разработки ПО часто сопряжено с необходимостью одновременно выстраивать процессы разработки и соответствовать требованиям отечественной регуляторики. Для многих компаний это становится серьёзным вызовом. Эксперты НТЦ «Фобос-НТ» помогают компаниям-участницам альянса внедрять культуру безопасной и качественной разработки, повышать качество кода и эффективность работы команд. Результатом становится не только улучшение текущих бизнес-процессов, но и соответствие компаний требованиям действующей и перспективной отечественной нормативно-правовой базы в области РБПО. ПАО «Ростелеком»В DevSecOps процессах основным подходом является так называемый «сдвиг влево» (Shift left). Безопасный репозиторий «РТК Феникс» является решением класса OSA/SCA для работы с Open Source библиотеками, обеспечивая их контроль, прозрачное использование, безопасное хранение и постоянный мониторинг уязвимостей. Продукт реализует подход проактивной проверки библиотек до момента их интеграции в корпоративный репозиторий и позволяет перенести риски выявления уязвимых компонентов на максимально ранний этап разработки. Одновременно с этим, «РТК Феникс» является универсальным репозиторием для всех типов артефактов (maven, npm, pypi, deb, rpm, docker и др.), Репозиторий доступен как SaaS-сервис. «Ларец» — импортозамещенная система хранения собственных сборок и проксирования корпоративных репозиториев артефактов. Она позволяет реализовать в конвейере весь ключевой функционал работы с собранным ПО: управление артефактами и репозиториями, нативное API управление артефактами (для бесшовной интеграции с локальными сборщиками и средствами CI/CD), прокси и локальные репозитории. Использование в конвейере «Ларца» устраняет проблемы текущих свободно распространяемых систем хранения сборок, таких как nexus community и соответствует современным стандартам и требованиям к ним: безопасность хранения артефактов, работа со всеми ключевыми форматами репозиториев, а также защищённое подключение внутренних и внешних репозиториев.

11.09.2025 [08:48], Руслан Авдеев

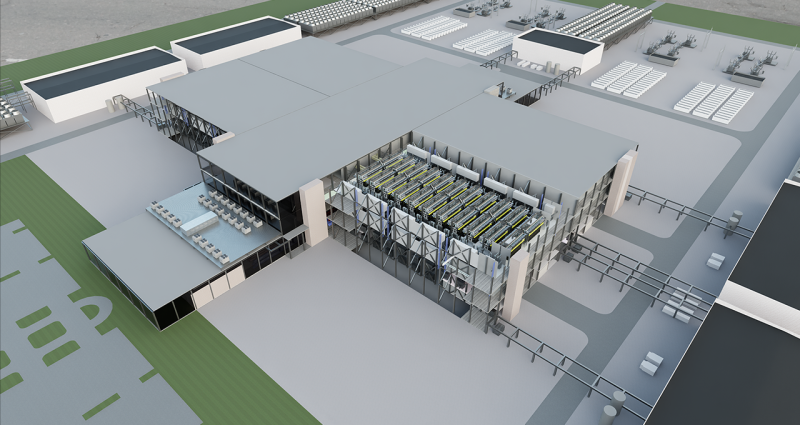

NVIDIA работает над эталонным дизайном гигаваттных ИИ-фабрикNVIDIA анонсировала разработку эталонного дизайна дата-центров гигаваттного уровня с использованием технологии цифровых двойников. Эталонные проекты ИИ ЦОД будут доступны компаниям-партнёрам по всему миру. В разработке нового решения компании помогают Schneider Electric, Siemens, Vertiv, Cadence, emeraldai, E Tech Group, phaidra.ai, PTC и Vertech. Для создания высокопроизводительной ИИ-инфраструктуры будет предложена технология цифровых двойников Omniverse Blueprint, позволяющая создавать высокопроизводительную и энергоэффективную ИИ-инфраструктуру. Технология позволяет заказчикам объединять все данные, связанные с созданием дата-центра, в единую универсальную модель, отражающую как можно больше деталей виртуального и физического строения объектов. Благодаря этому можно проектировать и моделировать оборудование с высокой энергетической и вычислительной плотностью. Модели ИИ-фабрики можно подключить к более масштабным системам: энергосетям, системам водоснабжения и транспортным артериям, что требует координации и моделирования на протяжении всего жизненного цикла кампусов ЦОД. В модель включаются локальные генерирующие мощности, энергохранилища, технологии охлаждения и даже ИИ-агенты для управления работой ЦОД. В компании заявляют, что только одновременное проектирование инфраструктуры и технологического стека обеспечивает настоящую оптимизацию, при которой питание, охлаждение, ускорители и ПО рассматриваются как единое целое.

Источник изображения: NVIDIA В марте 2024 года сообщалось, что NVIDIA и Siemens внедрят ИИ в промышленное проектирование и производство с помощью интеграции NVIDIA Omniverse Cloud API в платформу Xcelerator. Тогда же Schneider Electric и NVIDIA объявили о разработке эталонных проектов инфраструктур ИИ ЦОД. В рамках объявленного сотрудничества AVEVA, дочерняя компания Schneider Electric, должна была подключить свою платформу цифровых двойников к NVIDIA Omniverse, создав единую среду для виртуального моделирования и совместной работы. |

|