Материалы по тегу: s

|

04.04.2025 [11:00], Сергей Карасёв

«Тантор Лабс» выступит генеральным партнером PG BootCamp Russia 2025 в ЕкатеринбургеКомпания «Тантор Лабс» (входит в «Группу Астра») станет генеральным партнёром конференции PG BootCamp Russia 2025, которая пройдёт 10 апреля 2025 года в городе Екатеринбурге. Мероприятие является частью глобальной инициативы PG BootCamp, имеет официальный статус международного сообщества PostgreSQL и традиционно ориентировано как на опытных, так и на начинающих специалистов, желающих углубить свои знания и получить практические навыки работы с СУБД PostgreSQL. В программе запланированы лекции и мастер-классы, посвящённые наиболее актуальным для профи темам: оптимизации выполнения запросов, восстановлению данных при сбоях, работе с временными рядами, эффективности администрирования БД, реализации ILM в PostgreSQL и др. Участвовать можно очно или онлайн, в обоих случаях это будет бесплатно. «Мы уже не в первый раз выступаем в качестве генерального партнёра PG BootCamp, и для нас большая честь быть в авангарде развития PostgreSQL в России и поддерживать это мероприятие в уникальном некоммерческом формате для русскоязычной аудитории. PostgreSQL — одна из самых популярных СУБД, её сообщество объединяет огромное число энтузиастов вокруг ценностей открытости и инноваций, и официальные комьюнити-мероприятия в нашей стране служат мощным катализатором развития и открывают новые горизонты в построении качественных и масштабируемых решений. Присоединяйтесь к нашей инициативе, черпайте новые знания и вносите свой вклад в развитие этой замечательной СУБД», — заявил Вадим Яценко, генеральный директор компании «Тантор Лабс».

03.04.2025 [16:42], Владимир Мироненко

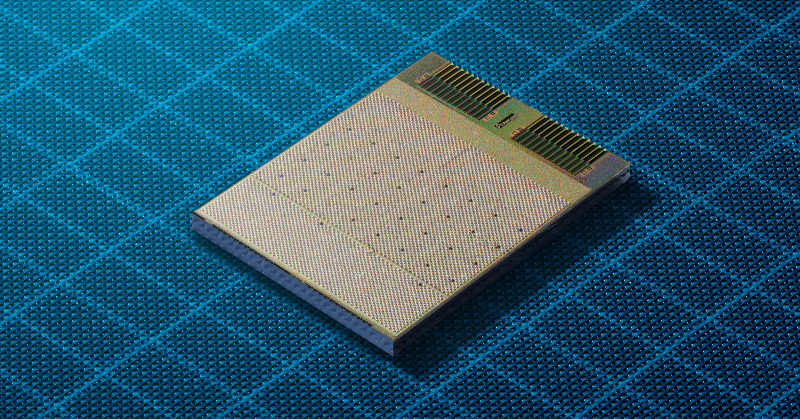

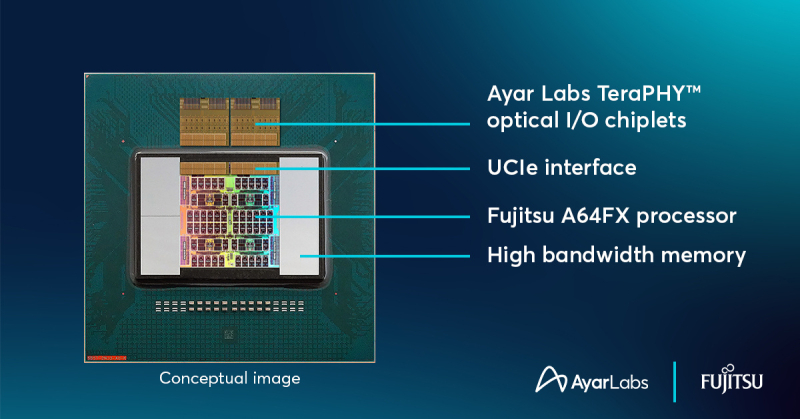

Ayar Labs анонсировала фотонный UCIe-чиплет TeraPHY с пропускной способностью 8 Тбит/сКомпания Ayar Labs, занимающаяся разработкой интерконнекта на базе кремниевой фотоники, анонсировала чиплет оптического I/O TeraPHY, способный обеспечить пропускную способность 8 Тбит/с и использующий оптический источник света SuperNova с поддержкой 16 длин волн. Чиплет поддерживает интерфейс Universal Chiplet Interconnect Express (UCIe), что означает возможность объединения в одном решении чиплетов от разных поставщиков. Ayar Labs отметила, что совместимость со стандартом UCIe позволяет создать более доступную и экономичную экосистему, которая упрощает внедрение передовых оптических технологий, необходимых для масштабирования рабочих ИИ-нагрузок и преодоления ограничений традиционных медных соединений. Ayar Labs сообщила, что объединила кремниевую фотонику с производственными процессами CMOS, чтобы обеспечить использование оптических соединений в форм-факторе чиплета в многочиповых корпусах. Это позволяет GPU и другим ускорителям взаимодействовать на широком диапазоне расстояний, от миллиметров до километров, при этом эффективно функционируя как единый гигантский ускоритель. Ранее компания совместно с Fujitsu показал концепт процессора A64FXс UCIe-чиплетом TeraPHY. Марк Уэйд (Mark Wade), генеральный директор и соучредитель Ayar Labs заявил, что в компании давно увидели потенциал совместно упакованной оптики (CPO), и поэтому занялись внедрением оптических решений в ИИ-приложениях. «Продолжая расширять границы оптических технологий, мы объединяем цепочку поставок, производство, а также процессы тестирования и проверки, необходимые клиентам для масштабного развёртывания этих решений», — подчеркнул он. Среди партнёров Ayar Labs крупнейшие компании отрасли, включая AMD, Intel, NVIDIA и TSMC. В последнем раунде финансирования, прошедшем в декабре прошлого года, компания привлекла $155 млн. Рыночная стоимость Ayar Labs, по оценкам, составляет $1 млрд.

03.04.2025 [12:50], Руслан Авдеев

Ближневосточный след: Cerebras Systems развеяла сомнения регулятора CFIUS в благонадёжности перед выходом на IPOCerebras Systems, разрабатывающая ИИ-ускорители, объявила о решении основных проблем с Комитетом США по иностранным инвестициям (CFIUS) перед выходом на IPO. Главным предметом беспокойства CFIUS стала связь американского стартапа с компанией G42 из ОАЭ, сообщает The Register. На G42, согласно поданным данным о доходах, пришлось более 87 % выручки Cerebras в I половине 2024 года. При этом с середины 2023 года экспорт ИИ-ускорителей в страны Ближнего Востока строго регулируется США. От разработчиков чипов из США требуется получение экспортных лицензий для продажи товаров в регионе. В результате G42 финансировала строительство ИИ-суперкомпьютеров на основе чипов Cerebras на территории США, а общая сумма проектов составила порядка $900 млн. Компания планировала получать к ним удалённый доступ. В рамках IPO G42 также собиралась купить 22 млн акций Cerebras, что, вероятно, вызвало настороженность CFIUS. Ранее G42 уже привлекала внимание американских властей, опасающихся, что закупающая большие объёмы ускорителей на Ближнем Востоке компания может работать на Китай. В результате G42 была вынуждена разорвать связи с рядом партнёров, включая Huawei, рассчитывая «умиротворить» американских регуляторов и устранить препятствия для сотрудничества с Cerebras и Microsoft.

Источник изображения: Nimisha Mekala/unsplash.com В Cerebras заявили, что компания развеяла опасения CFIUS, внеся поправки в соглашение с G42 — последняя сможет приобретать только «неголосующие» акции, поэтому дальнейшая проверка, вероятно, не потребуется. Впрочем, стороны пока не дают дополнительных комментариев. Тем не менее, руководство Cerebras отметило в одной из социальных сетей, что при тесном сотрудничестве с G42 удалось достичь урегулирования с CFIUS. Новости появились менее чем через неделю после того, как ведущие СМИ сообщили, что дебют Cerebras на фондовом рынке был отложен из-за ожидания новых ключевых назначений в администрации США. Условия IPO пока не разглашаются, но ранее сообщалось, что компания намерена привлечь до $1 млрд, а её капитализация составит $7–8 млрд. G42 останется одним из ключевых клиентов Cerebras, но стартап очевидно ориентирован на диверсификацию клиентской базы благодаря платформе «инференс как сервис» и создание масштабной инфраструктуры в США, Канаде и Франции. К концу 2025 года стартап пообещал развернуть более тысячи ускорителей в шести новых ЦОД. Хотя на первый взгляд это не так много в сравнении сотнями тысяч ускорителей, внедряемых xAI и другими компаниями, стоит отметить, что чипы Cerebras размером с целую кремниевую пластину способны обеспечивать производительность до 125 Пфлопс (FP16) — приблизительно в 62 раза выше, чем у моделей серии NVIDIA H100, применяемых для создания суперкомпьютера Colossus с Мемфисе (Теннесси).

03.04.2025 [11:38], Руслан Авдеев

Российская WildTeam выступила генеральным проектировщиком ЦОД общей ёмкостью 350 МВтКомпания WildTeam сегодня является генеральным проектировщиком ряда российских дата-центров общей ёмкостью 350 МВт. Эти объекты должны служить хранилищами, а также инструментами обработки и передачи данных для крупнейших технологических структур Российской Федерации, сообщает пресс-служба компании. WildTeam работает на рынке недвижимости с 2018 года и успешно завершила более 200 проектов — как коммерческих, так и жилых и общественных. Ряд спроектированных ЦОД находятся в Подмосковье — Домодедово и Дубне, а также регионах, расположенных недалеко от российской столицы. В компании утверждают, что проектирование осуществлялось с учётом актуальных требований к надёжности и энергоэффективности объектов. Компания активно внедряет в своих решениях технологии фрикулинга — охлаждения серверов с использованием обычного окружающего воздуха. Это позволяет снизить показатель PUE до 1,15, благодаря чему стоимость эксплуатации ЦОД уменьшается на «десятки процентов». В условиях высоких температур и плотной вычислительной нагрузки дополнительно применяется адиабатическое охлаждение с мелкодисперсным распылением воды и DX (Direct Expansion) системы.

Источник изображения: WildTeam Более того, тепло ЦОД используется для отопления административных помещений, что позволяет экономить до 700 кВт электроэнергии, а эксплуатация объектов становится более экологичной. Вместо традиционных вентиляторных установок применяются строительные вентмашины, что упрощает обслуживание оборудования, ускоряет его ремонт и снижает зависимость операторов от дорогих комплектующих. Дополнительно компания разрабатывает концепции «высокоплотных» ИИ-ЦОД с системами жидкостного охлаждения (СЖО), что обеспечивает оптимальную производительность ресурсоёмких систем нового поколения. Бесперебойное электроснабжение обеспечивается благодаря резервным источникам питания и использованию интеллектуальных систем управления электропитанием. В компании комбинируют ИБП, резервные генераторы, источники возобновляемой энергии и передовые системы мониторинга. Критически важные системы обеспечены питанием даже в случае отказа одной из ДГУ. В результате, даже при перебоях во внешней магистральной электросети и выходе из строя резервных линий, работоспособность объектов сохраняется. ЦОД соответствуют стандартам Uptime Institute Tier III и Tier IV. В WildTeam сообщают, что каждый дата-центр её разработки оснащён административно-бытовыми вспомогательными комплексами с офисами, спортивными залами, переговорными, техническими зонами и другими объектами. В компании ожидают, что её ЦОД станут ориентиром для проектирования современной цифровой инфраструктуры. Инфраструктура ЦОД и сопутствующая энергетика уже в большом дефиците в России. В январе сообщалось, что цены на услуги оборудования в российских ЦОД растут, а в конце февраля поступили данные о том, что в стране скоро может наступить дефицит энергии для обучения ИИ.

02.04.2025 [11:50], Руслан Авдеев

Царь-чипы с интегрированной фотоникой: Cerebras Systems и Ranovus выбраны DARPA для создания вычислительной платформы нового поколенияИИ-стартап Cerebras Systems выбран американским военно-техническим управлением DARPA для разработки высокопроизводительной вычислительной системы нового поколения. Cerebras объединит собственные ИИ-ускорители и фотонные CPO-интерконнекты Ranovus для обеспечения высокой производительности при малом энергопотреблении, сообщает пресс-центр Cerebras. Комбинация технологий двух компаний позволит обеспечить в реальном времени моделирование сложных физических процессов и выполнение масштабных ИИ-задач. С учётом успеха программы DARPA Digital RF Battlespace Emulator (DRBE), в рамках которой Cerebras уже разрабатывает передовой суперкомпьютер для радиочастотной эмуляции, именно Cerebras и Ranovus были выбраны для новой инициативы, позволяющей объединить вычислительные продукты Cerebras с первыми в отрасли фотонными интерконнектами Ranovus. Решение крайне актуальное, поскольку двумя ключевыми вопросами для современных вычислительных систем являются проблемы с памятью и обменом данных между ускорителями и иной серверной инфраструктурой — вычислительные потребности растут быстрее, чем возможности памяти или IO-систем ввода-вывода. Как утверждают в Cerebras, её WSE-чипы имеют в 7 тыс. раз большую пропускную способность, чем классические ускорители, что даёт самый быстрый в мире инференс и самое быстрое моделирование молекулярных процессов.

Источник изображения: Cerebras В рамках нового плана DARPA стартап Cerebras будет использовать интерконнект Ranovus, что позволит получить производительность, недоступную даже для крупнейших суперкомпьютерных кластеров современности. При этом энергопотребление будет значительно ниже, чем у самых современных решений с использованием коммутаторов. Последние являются одними из самых энергоёмких компонентов в современных ИИ-системах или суперкомпьютерах. Утверждается, что комбинация новых технологий двух компаний позволит искать решения самых сложных задач в реальном времени, будь то ИИ или сложное моделирование физических процессов, на недостижимом сегодня уровне. Подчёркивается, что оставаться впереди конкурентов — насущная необходимость для обороны США, а также местного коммерческого сектора. В частности, это открывает огромные возможности для работы ИИ в режиме реального времени — от обработки данных с сенсоров до симуляции боевых действий и управления боевыми или коммерческими роботами. В Ranovus заявили, что платформа Wafer-Scale Co-Packaged Optics в 100 раз производительнее аналогичных современных решений, что позволяет значительно повысить эффективность ИИ-кластеров, и значительно энергоэффективнее продуктов конкурентов. Партнёрство компаний позволит задать новый стандарт для суперкомпьютерной и ИИ-инфраструктуры, решая задачи роста спроса на передачу и обработку данных и давая возможность реализовать военное и коммерческое моделирование нового поколения. Помимо использования в целях американских военных, гигантские ИИ-чипы Cerebras применяются и оборонными ведомствами других стран. Так, весной 2024 года сообщалось, что продукты компании помогут натренировать ИИ для военных Германии.

01.04.2025 [16:05], Руслан Авдеев

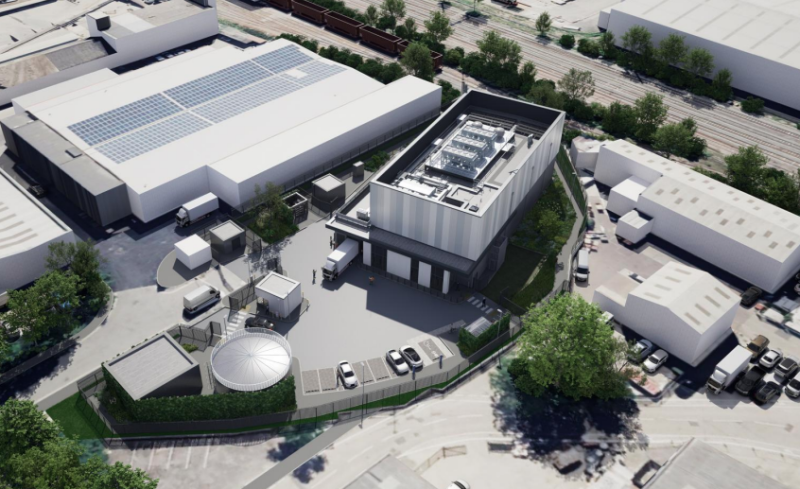

В Лондоне появится экобезопасный ЦОД AWS для ленточных накопителейНа территории технопарка Silverdale Industrial Estate на западе «Большого Лондона» в ближайшие годы появится экобезопасный и энергоэффективный дата-центр компании Amazon (AWS). Проект разрабатывается архитектурным бюро MCA Architects для инвесторов из Mulhaven Properties и представляет собой передовое решение для хранения данных, сообщает портал Blocks & Files. Как сообщается в презентации MCA Architects, предусмотрена полная рекультивация участка площадью 0,44 га — сейчас там находится пустой складской комплекс. На его месте появятся современные здания. В частности, речь идёт об основном здании высотой более 13 м (несколько этажей). Рядом разместится офисное здание высотой около 6 м. Общая площадь застройки — около 3200 м². Будут созданы раздельные въезды и выезды для грузового транспорта. Также предусмотрено внедрение современной системы безопасности и ограждений высотой 2,3–4 м.

Источник изображения: MCA Architects Новый дата-центр предназначен для размещения ленточных накопителей вместо традиционных серверов. Также ЦОД будет получит резервный генератор мощностью 1,08 МВт. Предусмотрено использование системы поддержания микроклимата (температура 16–25 °C, влажность 20–50 %). Водопотребление в сравнении с обычным ЦОД крайне невелико — менее 150 м³ в год, такими объёмами можно буквально пренебречь при расчётах. Особое внимание уделили минимизации воздействия на окружающую среду. Так, выбросы углекислого газа должны быть уменьшены на 15 % в сравнении с нормами Part L 2021 Building Regulations. Одной из главных целей является получение сертификата BREEAM Excellent, одного из самых престижных в области экологического строительства. Дополнительно планируется сбор дождевой воды, использование засухостойких растений, вертикального озеленения фасадов и др. Проект имеет для региона большие перспективы. Общий объём инвестиций AWS в связанные с ЦОД процессы в Великобритании в следующие пять лет составит £8 млрд. В целом с 2010 года инвестиции Amazon в Великобритании превысили £56 млрд. Проект уже вызвал интерес экспертного сообщества. Он демонстрирует возможности интеграции высокотехнологичной инфраструктуры в промышленную застройку и использования одних из самых передовых экорешений в Европе. Приветствуют новые инвестиции и местные власти. Пока проект находится на стадии согласования, строительство может начаться уже в 2025 году, а ввод объекта в эксплуатацию — в 2027 году. Это лишь один из расширяющейся сети ЦОД AWS в Великобритании, включающей уже несколько крупных кампусов, в том числе строящийся к югу от участка комплекс. В январе Trendfocus сообщала, что по итогам 2024 года спрос на ленточные накопители вырос на 12 %.

31.03.2025 [14:20], Сергей Карасёв

На заводе «ЦТС» в Калининградской области начали выпускать серверные платыНа предприятии АО «НПО «Цифровые Телевизионные Системы» («ЦТС»; входит в холдинг GS Group) в Калининградской области начато производство средних серверных плат с размерами 480 × 430 мм. Как отмечает генеральный директор предприятия, это изделия повышенной сложности, насчитывающие более 5 тыс. компонентов. Заказчиком выступает холдинг Fplus — российский поставщик электроники и оборудования для построения IT-инфраструктуры. Для организации выпуска плат была выполнена перекомпоновка оборудования на производственных линиях в рамках масштабной программы модернизации, в которую инвестировано 182 млн руб. Дело в том, что изготовление изделий указанного размера сопряжено с рядом сложностей. В частности, при нагревании такие печатные платы прогибаются под собственной массой. Кроме того, цикл сборки должен занимать не более трёх суток — в противном случае возникает риск чрезмерного окисления контактных площадок, что приводит к дефектам пайки. С целью решения указанных проблем на заводе «ЦТС» внедрено новейшее оборудование. Например, чтобы избежать искривления поверхности плат при нагревании, на предприятии разработаны специальные паяльные рамки. За один цикл возможно производить установку всех необходимых компонентов, что сокращает сроки изготовления продукции. В целом, мощности завода позволяют производить до 9 тыс. средних серверных плат ежемесячно. «Рассчитываем, что услуга по сборке средних серверных плат позволит нам укрепить позиции на рынке контрактного производства и расширить пул заказчиков», — говорит глава «ЦТС».

30.03.2025 [13:29], Сергей Карасёв

Supermicro представила широкий ассортимент односокетных серверов на базе Intel Xeon 6Компания Supermicro анонсировала большое количество однопроцессорных серверов на аппаратной платформе Intel Xeon 6 для различных рабочих нагрузок, включая ИИ-инференс, приложения НРС, аналитику данных и пр. Утверждается, что новинки способны справляться со многими задачами, которым традиционно требуются двухсокетные машины. В зависимости от серии и модификации серверы комплектуются чипами Xeon 6500P/6700P Granite Rapids с производительными Р-ядрами или изделиями Xeon 6700E Sierra Forest с энергоэффективными Е-ядрами. Используя односокетные системы, предприятия и операторы ЦОД, как отмечает Supermicro, могут сократить первоначальные затраты на закупку оборудования и эксплуатационные расходы, включая оплату электроэнергии. Ассортимент серверов Supermicro на платформе Intel Xeon 6 включает флагманские устройства SuperBlade с максимальной производительностью для ИИ, НРС, облачных и корпоративных нагрузок. Эти системы доступны в конфигурациях с воздушным или жидкостным охлаждением. В корпусе 8U может быть размещено до 20 узлов, в шасси 6U — до десяти. Серверы допускают установку до четырёх GPU-ускорителей двойной ширины. Кроме того, представлены стоечные серверы Hyper для масштабируемых облачных рабочих нагрузок, оптимизированные для инференса. На облачные дата-центры также ориентированы устройства CloudDC. Серверы серии WIO предлагают гибкие возможности в плане конфигурации подсистемы ввода-вывода, а модели Edge предназначены для использования на периферии. Вышли также обновлённые решения GrandTwin с возможностью горячей замены узлов и серверы хранения Top-loading Storage.

29.03.2025 [10:44], Сергей Карасёв

OWC представила хранилища данных Jellyfish B24 и S24 для создателей контентаКомпания Other World Computing (OWC) анонсировала стоечные СХД Jellyfish B24 и Jellyfish S24, рассчитанные прежде всего на создателей контента. Обе новинки допускают подключение модулей расширения, что позволяет наращивать вместимость по мере необходимости. Модель Jellyfish B24 на основе HDD представляет собой упрощённую версию мощного решения Jellyfish R24, разработанную для совместной работы небольших команд. Допускается установка 24 накопителей формата LFF суммарной вместимостью до 576 Тбайт. При необходимости можно подключить до четырёх модулей расширения Jellyfish B24-E посредством интерфейса mini-SAS, получив хранилище общей ёмкостью до 2,8 Пбайт.

Источник изображений: OWC Устройство Jellyfish B24 выполнено в форм-факторе 4U. Задействован неназванный процессор Intel Xeon Silver, работающий в тандеме с 64 Гбайт оперативной памяти DDR4 ECC. В оснащение входит кеширующий SSD на 2 Тбайт. Есть два порта 1GbE, а при необходимости могут быть добавлены сетевые интерфейсы 10GbE (RJ45/SFP+), 25GbE (QSFP), 50GbE (QSFP28) и 100GbE (QSFP28). Предусмотрены четыре порта USB 3.0 и разъём D-Sub. За питание отвечает блок мощностью 875 Вт с резервированием. Габариты СХД составляют 432 × 318 × 198 мм, масса — 15,9 кг без установленных накопителей. Поддерживаются протоколы SMB, NFS, FTP и SSH.  Вариант Jellyfish S24, в свою очередь, рассчитан на 24 SSD формата SFF. При подключении модуля расширения Jellyfish S24-E можно получить суммарную вместимость до 736 Тбайт на основе твердотельных накопителей. Добавив четыре модуля Jellyfish R24-E или B24-E, можно создать гибридное хранилище ёмкостью до 2,3 Пбайт. СХД располагает двумя портами 10GbE RJ45 и двумя блоками питания мощностью 650 Вт с возможностью горячей замены. Форм-фактор — 2U. Упомянуты протоколы SMB, NFS, FTP и SSH.

29.03.2025 [10:11], Алексей Степин

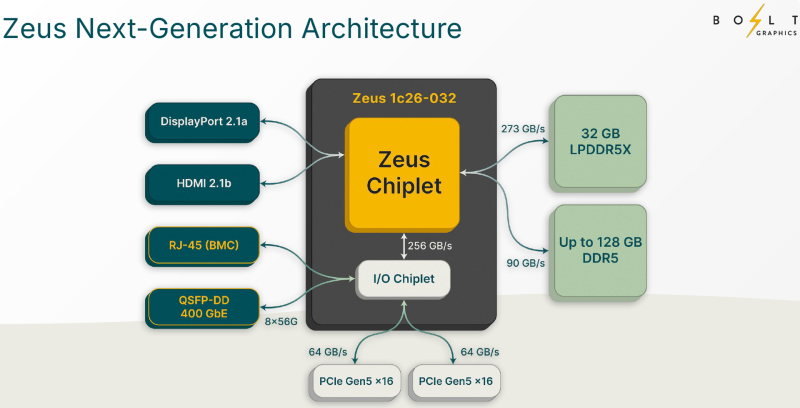

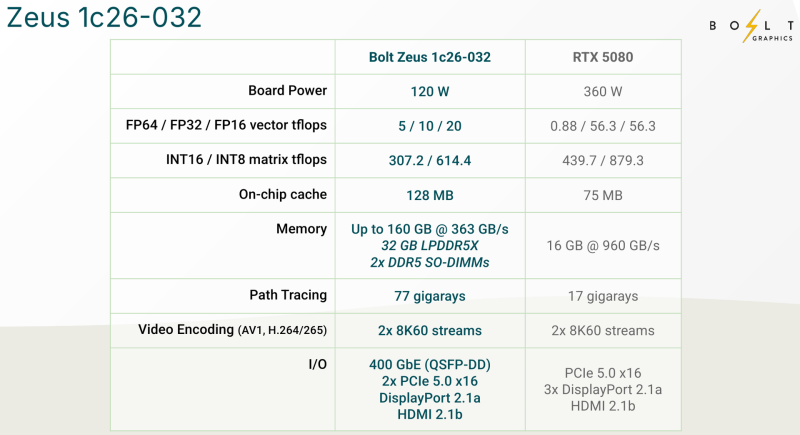

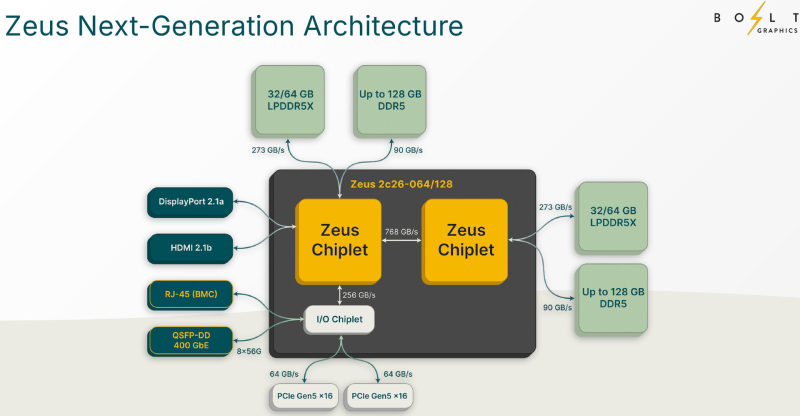

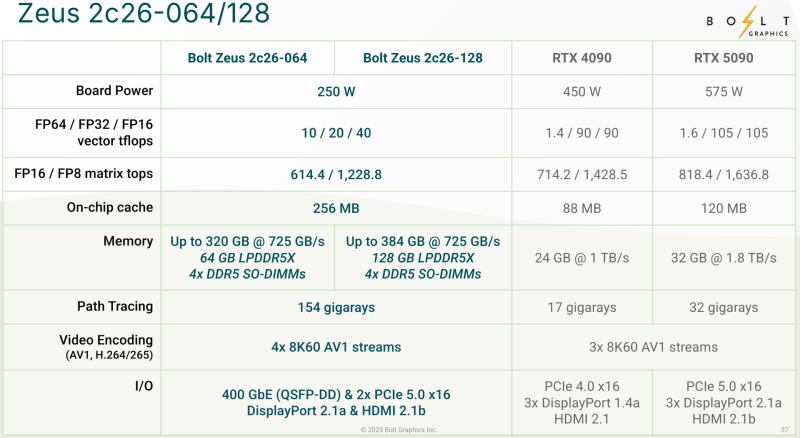

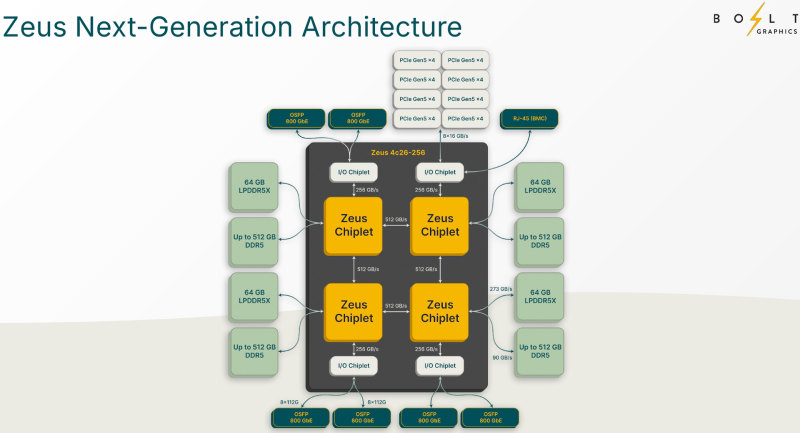

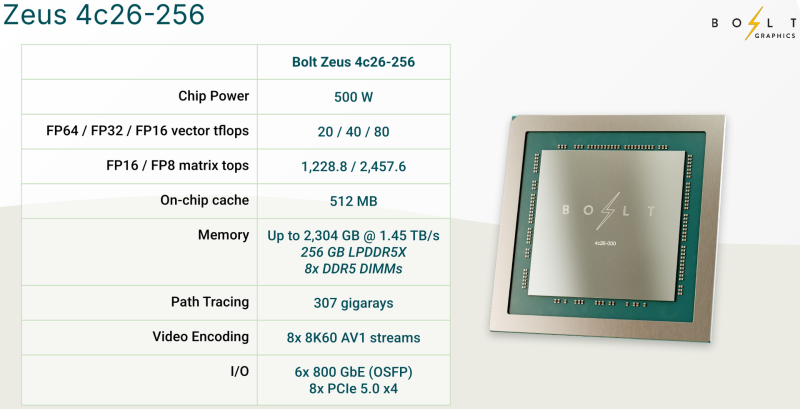

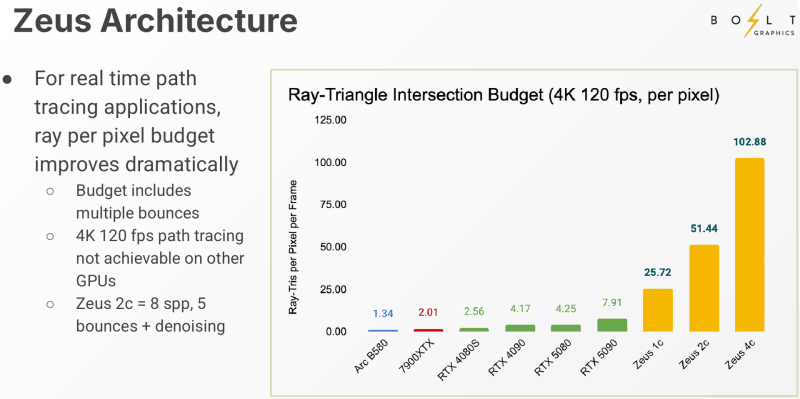

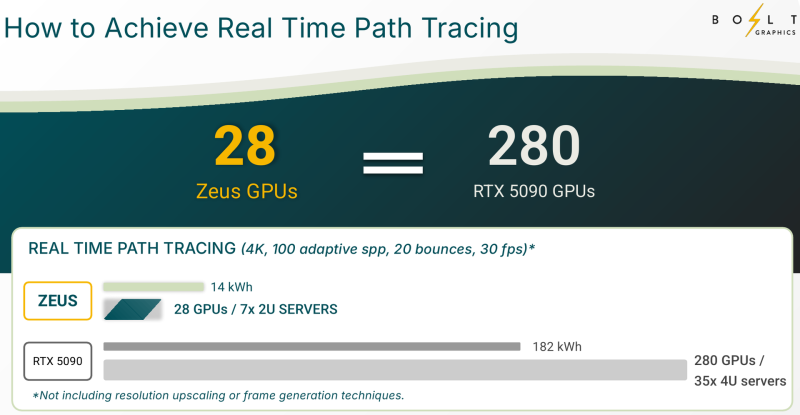

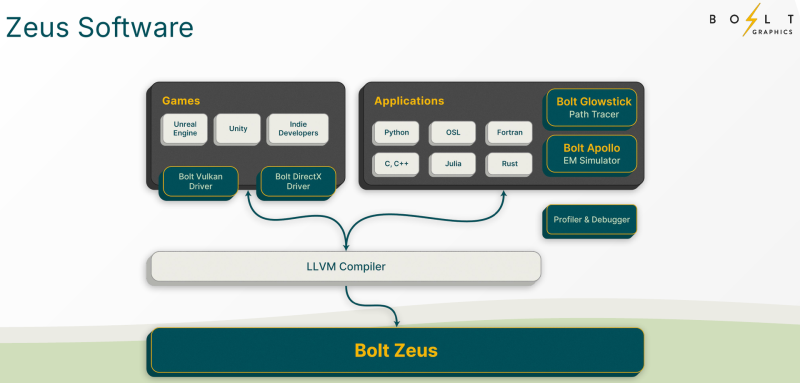

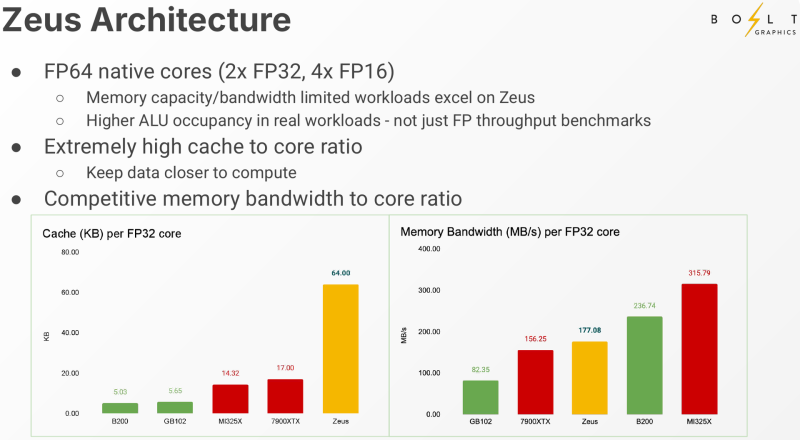

Bolt Graphics анонсировала универсальную видеокарту со слотами SO-DIMM, которая может потягаться с RTX 5080Все современные графические ускорители предлагаются с жёстко заданным при производстве объёмом видеопамяти, а в наиболее производительных моделях память типа HBM вообще интегрирована на одной с основным кристаллом подложке. Однако требования к объёму памяти в последнее время растут быстрее, а за дополнительный объём вендор просят всё больше. Кардинально иной подход предлагает компания Bolt Graphics, недавно анонсировавшая серию ускорителей Zeus. Несмотря на «ИИ-пандемию», Bolt Graphics в своём анонсе не делает упор на искусственный интеллект, а называет Zeus первым GPU, специально созданным для целей HPC, рендеринга, трассировки лучей и даже компьютерных игр. Что интересно, в основе Zeus лежит не некая закрытая архитектура: скалярная часть нового GPU построена на базе спецификации RISC-V RVA23, векторная представлена FP64 ALU на базе несколько модифицированной RVV 1.0. Прочие функции реализованы путём кастомных расширений и отдельных блоков-ускорителей. Все они пользуются общим кешем объёмом 128 Мбайт. Дополняет картину блок телеметрии и внутренний интерконнект для общения с другими вычислительным блоками. Используется чиплетный подход. Базовый «строительный блок» Zeus 1c26-032 включает GPU-чиплет, который соединён с 32 Гбайт набортной памяти LPDDR5x (273 Гбайт/с) и контроллером внешней памяти DDR5 (90 Гбайт/с), т.е. при желании можно установить ещё 128 Гбайт RAM (два модуля SO-DIMM). В GPU-чиплет встроены контроллеры DisplayPort 2.1a и HDMI 2.1b, а с внешним миром он общается посредством IO-чиплета, с которым он соединён 256-Гбайт/с каналом. IO-чиплет предлагает необычный набор портов. Помимо сразу двух интерфейсов PCIe 5.0 x16 (64 Гбайт/с каждый) имеется выделенный порт RJ-45 для BMC и 400GbE-порт QSFP-DD. Наконец, есть аппаратный блок видеокодирования, способный справиться с двумя потоками 8K@60 AV1/H.264/H.265. Заявленный уровень производительности в векторных FP64/FP32/FP16-вычислениях составляет 5/10/20 Тфлопс, а в матричных INT16/INT8 — 307,2/614,4 Топс. Аппаратный блок ускорения лучей (path tracing) выдаёт до 77 гигалучей. Для сравнения: NVIDIA RTX 5090 способна выдавать 32 гигалуча, а FP64-производительность составляет 1,6 Тфлопс. В то же время в расчётах пониженной точности актуальные решения NVIDIA всё равно быстрее Zeus 1c26-032. Однако у новинки есть важное преимущество — её уровень TDP составляет всего 120 Вт. Второй интерфейс PCIe 5.0 x16 можно использовать для прямого объединения двух карт. Вариант ускорителя с двумя чиплетами носит название Zeus 2c26-064/128, а с четырьмя — 4c26-256. Последние числа обозначают объём распаянной памяти LPDDR5X. Что касается расширяемой памяти, то количество доступных разъёмов SO-DIMM также зависит от модели и составляет до восьми, так что во флагманской конфигурации базовые 256 Гбайт LPDDR5x можно дополнить аж 2 Тбайт DDR5. Производительность с увеличением количеств GPU-чиплетов растёт практически пропорционально, но есть некоторые другие нюансы. Так, в Zeus 2c26-064 и Zeus 2c26-128 (оба варианта имеют TDP 250 Вт) есть только один IO-чиплет, а GPU-чиплеты объединены шиной со скоростью 768-Гбайт. Zeus 4c26-256 имеет сразу четыре I/O чиплета в составе, которые дают восемь контроллеров PCIe 5.0 x4 (один чиплет, совокупно 32 линии) и шесть 800GbE-портов OSFP (три чиплета). Между собой GPU-чиплеты объединены шиной со скоростью 512-Гбайт/с. Каждый из них соединён с собственным IO-чиплетом на скорости 256 Гбайт/с. Теплопакет флагмана составляет 500 Ватт, ускоритель, если верить Bolt Graphnics, развивает 20 Тфлопс в режиме FP64, почти 2500 Топс на вычислениях FP8 и способен обрабатывать до 307 гигалучей. Разработчики явно заложили в своё детище широкие возможности кластеризации, о чём свидетельствует наличие мощной сетевой подсистемы. Поддерживаются как скромные конфигурации из двух GPU, соединённых непосредственно по Ethernet 400GbE, так и масштабные системы уровня стойки, содержащей 80 плат Zeus 4c26-256, соединённых как с коммутатором, так и напрямую друг с другом. Такой кластер потребляет 44 кВт, но зато способен обеспечивать запуск крупных физических симуляций или обучение ИИ моделей за счёт огромного массива общей памяти, составляющего 160 Тбайт. Вычислительная производительность такого кластера достигает 1,6 Пфлопс в режиме FP64 и 196 Попс в режиме FP8. Одной из особенностей новинок является трассировщик лучей Glowstick, способный работать в режиме реального времени практически во всех современных пакетах 3D-моделирования или видеоредактирования, таких как Maya, 3ds Max, Blender, SketchUp, Houdini и Nuke. Он будет дополнен фирменной библиотекой Bolt MaterialX, содержащей более 5000 текстур высокого качества. А благодаря поддержке стандарта OpenUSD он сможет легко интегрироваться в любую цепочку рендеринга и пост-обработки. Также запланирован электромагнитный симулятор Bolt Apollo. Обещаны фирменные драйверы Vulkan/DirectX и SDK с использованием LLVM. Ранний доступ к комплектам разработчика Bolt Graphics наметила на IV квартал текущего года. В III квартале 2026 года должны появиться 2U-серверы на базе Zeus, а массовые поставки серверов и PCIe-карт начнутся не ранее IV квартала того же года. Пока сложно сказать, насколько хорошо новая архитектура себя проявит, но если верить предварительным тестам Zeus, выигрыш в сравнении с существующими ускорителями существенен, особенно в энергопотреблении. |

|