Материалы по тегу: s

|

11.04.2025 [22:33], Андрей Крупин

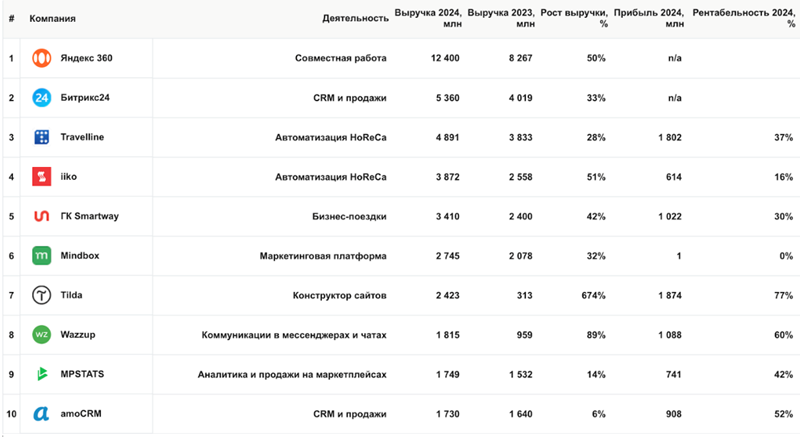

SaaS в России продолжает расти, однако не все направления показывают положительную динамикуВ 2024 году российский рынок облачных SaaS-решений продолжил демонстрировать уверенный рост, однако не все его направления показали положительную динамику. Об этом свидетельствует проведённое аналитиками сервиса «МойСклад» исследование. В число наиболее быстрорастущих SaaS-сервисов в России вошли решения для коммуникаций в мессенджерах и чатах, автоматизации бизнес-процессов транспортных и строительных компаний. Активно в прошлом году развивались облачные сервисы, предназначенные для управления репутацией и обработки отзывов, маркетинговыми проектами, персоналом, гостинично-ресторанной сферой. Среди столкнувшихся с падением спроса оказались сервисы для аналитики и продаж на маркетплейсах (основные причины: сокращение продавцов на этих платформах, развитие собственных личных кабинетов маркетплейсов и ужесточение конкуренции). Также с потерей позиций столкнулись сервисы телефонии, что обусловлено ростом популярности мессенджеров и нежеланием молодого поколения использовать традиционные звонки для связи.

Рейтинг российских SaaS-сервисов по выручке за 2024 год (источник изображения: пресс-служба сервиса «МойСклад» / moysklad.ru) Лидерами российского рынка SaaS в 2024 году, по данным аналитиков «МоегоСклада», стали сервисы «Яндекс 360», «Битрикс24», Travelline, Iiko и Smartway. Методология рейтинга составлена на основе данных годовой выручки из финансовой отчётности организаций за 2024 год. В него попали работающие в сегменте SaaS компании, чей годовой оборот превысил 200 млн руб. Рейтинг составлен с использованием метрик, включающих рост выручки, прибыльность и динамику за последние пять лет. В текущем году, согласно прогнозам экспертов, отечественный рынок облачных SaaS-решений продолжит рост, чему в немалой степени способствует тенденция импортозамещения зарубежного ПО: «Уже сейчас мы видим интерес к таким продуктам, как управление проектами, интерактивные доски, автоматизация бизнес-процессов и клиентской поддержки. Малый бизнес растёт как по количеству компаний, так и по оборотам, поэтому запрос на автоматизацию процессов увеличивается. Кроме того, маркировка товаров, онлайновая торговля, кассы заставляют предпринимателей автоматизировать торговлю — всё это в совокупности положительно сказывается на развитии разработок класса SaaS и расширении их ассортимента».

11.04.2025 [11:43], Алексей Степин

NERPA представила универсальные высокопроизводительные серверы NORD D5720Российская IT-сфера сегодня как никогда нуждается в отечественных аппаратных решениях, отвечающих современным стандартам производительности, расширяемости и совместимости. Отвечая на этот запрос, компания NERPA, производящая широкий спектр ИТ-оборудования для OCS Distribution, представила новые универсальные серверы NERPA NORD D5720 (НН 3000029184), сочетающие в себе поддержку современных процессоров Intel Xeon, памяти DDR5, гибко конфигурируемую дисковую подсистему и возможность установки современных мощных ускорителей. В основе новинки лежит серверная платформа Intel на базе чипсета C741 с двумя сокетами LGA 4677, поддерживающая процессоры Xeon Scalable четвёртого (Sapphire Rapids) и пятого (Emerald Rapids) поколений. Это делает NORD D5720 одним из самых производительных решений, доступных российскому заказчику. Эти процессоры имеют высокоскоростную восьмиканальную подсистему памяти DDR5. В реализации NORD D5720 используется материнская плата с 32 слотами DIMM, позволяющая устанавливать по 16 модулей (L)RDIMM процессор. Вкупе с поддержкой модулей LDRIMM объёмом 128 Гбайт это позволяет комплектовать серверы оперативной памятью DDR5-5200 объёмом до 2 Тбайт. Конфигурация дисковой подсистемы NORD D5720 может варьироваться в широки пределах, и, в зависимости от потребностей заказчика, выглядеть следующим образом:

Помимо этого, в задней части сервера может присутствовать дополнительная корзина для четырёх накопителей формата 2,5″, что позволяет довести количество дисков в системе до 28. За счёт возможностей платформы поддерживаются массивы SATA RAID 0/1/10/5, опционально доступна конфигурация с дополнительным HBA/RAID-контроллером. Доступ к передним дисковым корзинам может блокироваться при помощи декоративной панели с замком. Здесь же, на передней панели, расположена пара портов USB 3.0 и разъём VGA, что упрощает процедуру непосредственного администрирования. Как и у всех современных серверных платформ, у NORD D5720 имеется выделенный сетевой порт удалённого управления (BMC ASPEED AST 2600). Система NORD D5720 выполнена в форм-факторе 2U, но при этом имеет широкие возможности расширения — она, в зависимости от конфигурации дисковых корзин, может иметь до восьми слотов PCIe 5.0 (три райзера) и слот для высокоскоростного NIC OCP 3.0 (PCIe x16). Из восьми слотов PCIe три имеют подключение x16, остальные — x8. Все они рассчитаны на установку FHHL-карт. Подсистема питания может оснащатсья двумя (1+1) блоками питания мощностью по 1300 Вт каждый, либо одним блоком мощностью 1600 Ватт, оба варианта соответствуют стандарту 80 PLUS Platinum. За продувку и отвод тепла отвечают четыре вентилятора типоразмера 80 × 80 × 38 мм со скоростью вращения до 16300 об/мин. BMC в новых моделях NERPA NORD D5720 снабжена расширенной функциональностью, ранее в решениях NERPA недоступной. Это, например, возможность конфигурирования и управления RAID-массивами из графического интерфейса BMC. Также производитель заявляет о планах в ближайшее время полностью локализовать интерфейс BIOS и добавить поддержку группового управления для новых моделей. Серверы NERPA NORD D5720 уже доступны для заказа, стоимость, наличие на складе и сроки поставки можно уточнить непосредственно на сайте производителя или у представителей сети OCS Distribution.

10.04.2025 [15:01], Руслан Авдеев

В Эдинбургском университете заработал ИИ-кластер на базе Cerebras CS-3Эдинбургский университет и Cerebras Systems развернули в суперкомпьютерным центре EPCC кластера из четырёх ИИ-систем CS-3 на базе царь-ускорителей WSE-3. Новые мощности являются частью Edinburgh International Data Facility. По словам EPCC, это крупнейший кластер CS-3 в Европе. EPCC уже имеет опыт работы с системами CS-1 и CS-2. В Cerebras заявили, что гордятся расширением сотрудничества с EPCC, которое поможет стать Великобритании одним из ключевых мировых ИИ-хабов. Как заявляют в EPCC, ИИ сегодня изменяет все сферы жизни, поэтому новые системы помогут университетам, государственным организациям и компаниям обучать и использовать ИИ-модели на скоростях и с лёгкостью, недоступной другим ИИ-решениям. Платформы Cerebras оптимизированы не только для масштабного обучения моделей, но и для сверхбыстрого инференса — пользователям кластера теперь доступна платформа-рекордсмен Cerebras AI Inference. Системы CS-3 способны выдавать до 2000 токенов/с для популярных ИИ-моделей.

Источник изображения: Nadia Ramella/unsplash.com С новыми кластерами на основе Cerebras CS-3, EPCC сможет обучать модели от 240 млрд до 1 трлн параметров, а также ежедневно тюнинговать модели с 70 млрд параметров. Лёгкость использования технологий Cerebras позволяет использовать ИИ-модели и в дисциплинах, не относящихся к компьютерным наукам. Технологии Cerebras обеспечивают линейную масштабируемость, что ускоряет инновации и повышает продуктивность команды EPCC, говорится в сообщении. Эдинбургский университет считается одним из лидеров в разработке ИИ-систем в последние 60 лет. Системы CS-2 в распоряжении EPCC уже позволили исследователям разработать высокоэффективное ПО для инференса для больших языковых моделей (LLM) — как для местного применения, так и для помощи исследователям из Индии в разработке ИИ-моделей для материаловедения и из Швейцарии — для адаптации LLM к местному диалекту немецкого языка. Кроме того, платформы CS-3 с миллионами вычислительных ядер позволят продолжить исследования EPCC в областипараллельных вычислений и энергоэффективности.

10.04.2025 [09:14], Владимир Мироненко

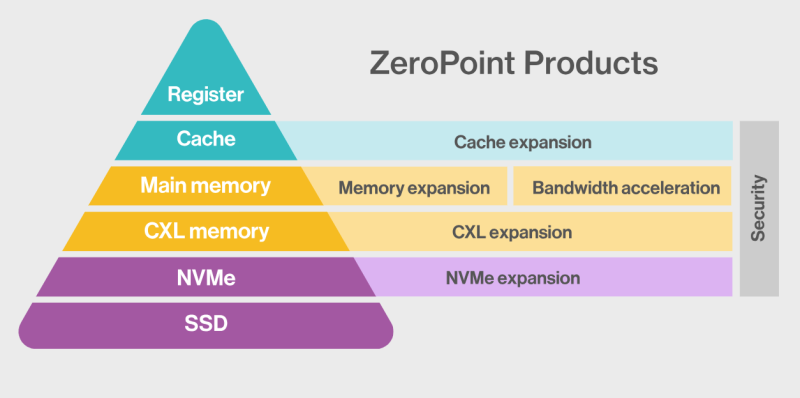

ZeroPoint Technologies и Rebellions займутся разработкой ИИ-ускорителей со «сжимаемой» памятьюШведская компания ZeroPoint Technologies, специализирующаяся на создании решений для оптимизации памяти, объявила о стратегическом альянсе с южнокорейским разработчиком ИИ-чипов Rebellions с целью разработки ИИ-ускорителей для инференс. Компании планируют представить новые продукты в 2026 году, обещая «беспрецедентную производительность в пересчёте на токены в секунду на Вт (TPS/W)», пишет EE Times. Компании планируют увеличить эффективную пропускную способность и ёмкость памяти для нагрузок инференса, используя технологии сжатия, уплотнения и управления памятью от ZeroPoint Technologies. По словам генерального директора ZeroPoint Technologies Класа Моро (Klas Moreau), аппаратная оптимизация работы с памятью на уровне ЦОД позволит увеличить адресуемую ёмкость с ускорением работы почти в 1000 раз по сравнению с использованием программного сжатия. Компании планируют улучшить показатели токенов в секунду на Вт без ущерба для точности, используя сжатие модели без потерь для уменьшения её размера и сокращения использования энергии, необходимой для перемещения компонентов модели. Гендиректор Rebellions Сонхён Пак (Sunghyun Park) указал, что партнёрство позволит компаниям переопределить возможности инференса, предоставляя более умную, экономичную и устойчивую ИИ-инфраструктуру. Моро ранее заявил, что более 70 % данных, хранящихся в памяти, являются избыточными, что позволяет полностью избавиться от них, добившись сжатия без потерь полезной информации. Такая технология сжатия должна выполнять ряд специфических действий в пределах наносекунды, т.е. всего нескольких тактов: «Во-первых, она должна отрабатывать сжатие и распаковку. Во-вторых, она должна уплотнять полученные данные, собирая небольшие фрагменты в единичную линию кеша, чтобы значительно улучшить видимую пропускную способность памяти, и, наконец, она должна бесперебойно управлять данными, отслеживая все фрагменты. Чтобы минимизировать задержку, такой подход должен работать с гранулярностью линий кеша — сжимая, уплотняя и управляя данными в 64-байт фрагментах — в отличие от гораздо больших блоков 4–128 Кбайт, используемых традиционными методами сжатия вроде ZSTD и LZ4». По словам Моро, благодаря этой технологии, для базовых рабочих нагрузок в ЦОД гиперскейлера адресуемая ёмкость памяти и пропускная способность могут быть увеличены в два-четыре раза, производительность на Вт может увеличиться на 50 %, а совокупная стоимость владения (TCO) может быть значительно снижена. А для специализированных нагрузок, таких как большие языковые модели (LLM), интеграция программного сжатия в сочетании с встроенной аппаратной декомпрессией (что минимизирует любую дополнительную задержку) уже продемонстрировала прирост примерно на 50 % в адресуемой ёмкости памяти, пропускной способности и токенах в секунду. Моро утверждает, что грядущая интеграция аппаратной (де-)компрессии обещает ещё более существенные улучшения. Например, для базовых ИИ-нагрузок кластер со 100 Гбайт физической памяти благодаря использованию этой технологии будет функционировать так, как если бы у него было 150 Гбайт памяти. «Это не только представляет собой миллиарды долларов потенциальной экономии, но и может повысить производительность сложных ИИ-моделей», — заявил Моро. «Эти достижения обеспечивают надёжную основу для компаний, производящих чипы ИИ, позволяя бросить вызов доминированию таких гигантов отрасли, как NVIDIA», — добавил он.

09.04.2025 [23:20], Владимир Мироненко

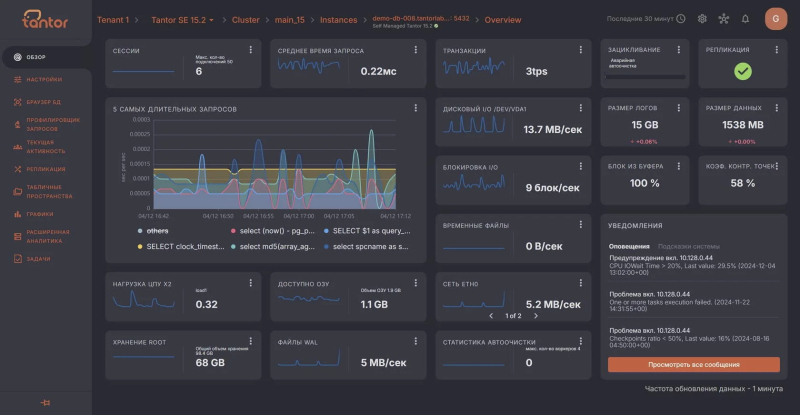

«Тантор Лабс» почти в пять раз увеличила выручку в 2024 годуКомпания «Тантор Лабс» (входит в «Группу Астра») объявила неаудированные финансовые результаты по РСБУ и управленческие показатели за 2024 год. Её выручка увеличилась год к году в 4,7 раза до 1,4 млрд руб. Компания отметила, что особенно высоким спросом пользовались лицензии на платформу Tantor, обеспечивающую централизованный мониторинг и администрирование корпоративных БД на основе PostgreSQL. Сообщается, что росту ключевых финансовых показателей способствовало прежде всего развитие продуктовой линейки, а также активное внедрение решений компании в ИТ-инфраструктуру организаций из ключевых отраслей экономики, что позволило удовлетворять потребность большего числа клиентов в энергетике, финансах, телекоммуникациях и госсекторе. В 2024 году «Тантор Лабс» росла опережающими темпами, говорит компания. Ключевым фактором этого роста стало создание целостной экосистемы управления корпоративными данными с четырьмя основными направлениями, включая высокопроизводительные СУБД, платформу управления большими данными, централизованное управление данными (Tantor DLH) и машины баз данных Tantor XData. Глава компании «Тантор Лабс», что за прошлый год компания значительно расширила экосистему продуктов и укрепила лидерские позиции в сегменте российских СУБД: «Особая гордость — запуск первой отечественной машины баз данных. Это подтверждает высокий потенциал российских технологий в области управления данными».

08.04.2025 [17:09], Руслан Авдеев

Windows 11 Enterprise научили обновляться без перезагрузки (ну, почти)

microsoft

software

windows

windows 11

windows update

информационная безопасность

операционная система

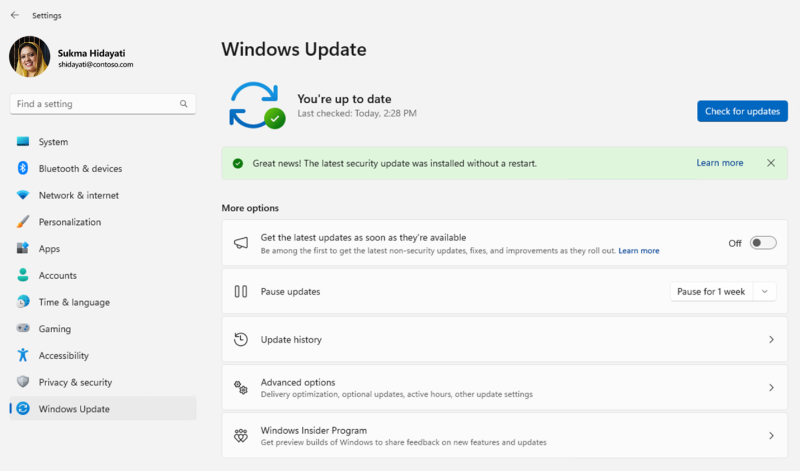

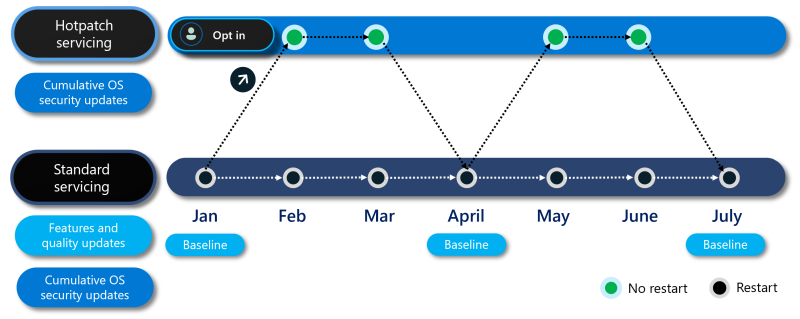

Microsoft объявила о запуске системы «горячих» обновлений (hotpatch) ОС в Windows 11 Enterprise версии 24H2. Теперь пользователи смогут устанавливать апдейты без необходимости перезагружать свои устройства в процессе работы — это нововведение призвано значительно упростить работу корпоративных пользователей. «Горячие» обновления доступны для x64-платформ AMD или Intel. Для Arm64-платформ функция пока тестируется, но её можно включить вручную в реестре. Конечно, периодически перезагрузки всё-таки потребуются. Но системы, по крайней мере, придётся перезапускать не ежемесячно, а ежеквартально — с выпуском кумулятивных апдейтов. Для того, чтобы пользоваться новыми преимуществами, потребуются:

Источник изображения: Microsoft Новые обновления будут выходить в соответствии со стандартным графиком, принятым для Windows 10 и Windows 11 23H2. Hotpatch-апдейты получат специальные идентификаторы, чтобы отличать их от обычных пакетов, и в основном содержать обновления, касающиеся безопасности. Система будет автоматически определять, соответствует ли каждое конкретное устройство требованиям для «горячего» обновления. Другими словами, операционная система сама предложит включить новую функцию, если та будет доступна.

Источник изображения: Microsoft Владельцы домашних (Home) и профессиональных (Pro) версий Windows 11 воспользоваться новым механизмом обновления пока не могут. Можно ожидать, что по мере распространения Windows 11 24H2 количество устройств, совместимых с Hotpatch, тоже будет расти. Однако для Microsoft в данном случае приоритетным является корпоративный рынок.

08.04.2025 [13:29], Сергей Карасёв

Eviden создаст для Сербии суперкомпьютер стоимостью €36 млнВласти Сербии, по сообщению ресурса Datacenter Dynamics, заключили контракт с Eviden (подразделение Atos Group) на создание нового суперкомпьютера. Речь идёт о приобретении системы BullSequana последнего поколения, которая будет поставлена к концу текущего года. Технические подробности проекта пока не раскрываются. Отмечается лишь, что контракт с Eviden является частью более широкого соглашения стоимостью €50 млн, подписанного между правительствами Сербии и Франции. Из этой суммы €36 млн пойдёт непосредственно на создание суперкомпьютера. Оставшаяся часть средств будет потрачена на ИИ-инициативы в таких сферах, как здравоохранение, энергетика, транспорт и государственное управление. На сегодняшний день, как отмечается, Сербия эксплуатирует как минимум один неназванный НРС-комплекс, созданный NVIDIA и размещённый в государственном дата-центре в Крагуеваце (столица административного региона Шумадия). Система, запущенная в декабре 2021 года, обошлась в €30 млн. В перспективе в модернизацию этого суперкомпьютера планируется инвестировать €40 млн, что позволит поднять его производительность в семь раз.

Источник изображения: Правительство Сербии Глава сербского управления по IT и электронному правительству Михайло Йованович (Mihailo Jovanovic) заявил, что новый суперкомпьютер, поставкой которого займётся Eviden, будет насчитывать «в 20 раз больше чипов, чем [нынешняя] система NVIDIA», и получит почти в 30 раз больше памяти. Какие именно чипы имеются в виду, Йованович уточнять не стал. Работа над государственным ЦОД в Крагуеваце стоимостью €30 млн началась в 2019 году, а открытие состоялось в 2020-м. Дата-центр состоит из двух объектов общей площадью около 14 тыс. м2 — это примерно в пять раз больше по сравнению с прежней ЦОД-площадкой в Белграде. Комплекс в Крагуеваце соответствует стандарту Tier IV: он предоставляет услуги хостинга для предприятий и правительственных структур.

08.04.2025 [11:42], Сергей Карасёв

Стоечное хранилище Blackmagic Cloud Backup 8 рассчитано на SATA-накопителиКомпания Blackmagic Design анонсировала стоечную систему хранения Cloud Backup 8, предназначенную прежде всего для резервного копирования и архивирования медиафайлов и проектов DaVinci Resolve. Устройство доступно для заказа по ориентировочной цене $1500. Новинка выполнена в форм-факторе 1U. Во фронтальной части располагаются восемь отсеков для HDD типоразмера LFF с интерфейсом SATA-3. Предусмотрена светодиодная индикация состояния накопителей: каждый слот подсвечивается световым кольцом, которое даёт наглядное представление об активности. Есть дополнительная защитная планка для фиксации дисков на месте. Система располагает четырьмя сетевыми портами 10GbE с разъёмами RJ45. Кроме того, есть порт USB 3.0 Type-C с поддержкой Ethernet Over USB. Заявленное энергопотребление составляет 180 Вт. Диапазон рабочих температур — от 0 до +40 °C. Новинка оснащена интерфейсом HDMI (1080p50, 1080p59.94, 1080p60): через него на мониторе или телевизоре может отображаться подробная информация о работе установленных HDD, загруженности сетевых подключений, подключенных пользователях и пр. Говорится о совместимости с Windows 10/11 и macOS 14/15 и выше. Реализована поддержка SMB 3 Multichannel. Одним из основных преимуществ платформы Cloud Backup 8 перед облачными хранилищами разработчик называет полное отсутствие подписок и каких-либо ежемесячных сборов. Пользователи получают локальный контроль над системой, что обеспечивает улучшенную безопасность: устройство можно применять без подключения к интернету.

07.04.2025 [16:37], Владимир Мироненко

MTS AI представила российского конкурента GitHub Copilot — ИИ-ассистента для разработчиков Kodify 2Компания MTS AI (дочерняя структура МТС Web Services) объявила о выходе ИИ-ассистента для разработчиков второго поколения Kodify 2. Новая версия ИИ-ассистента поддерживает 90 языков программирования, предлагая основные возможности для автоматизации и ускорения процесса разработки, включая автодополнение кода, исправление ошибок, генерацию тестов и документации, оптимизацию кода, а также преобразование текста в код. Kodify 2 с 7 млрд параметров поддерживает контекст длиной до 32 768 токенов и имеет API, совместимый OpenAI, что обеспечивает возможность интеграции с другими системами. Согласно проведённым тестам, Kodify 2 сопоставим по возможностям с лидирующим на рынке продуктом GitHub Copilot. В генерации тестов Kodify 2 выполнил задачу так же или лучше, чем GitHub Copilot, в 57 % случаев, а в преобразовании текста в код — в 48 % случаев. Тестирование проводилось методом прямого сравнения и оценки с помощью модели-судьи Claude Sonnet 3.5.

Источник изображения: MTS AI ИИ-агент Kodify используется c 2024 года командами разработки компаний из ПАО «МТС», а версия Kodify 2 будет доступна для покупки внешними заказчиками. По оценкам MTS AI, объём российского рынка ИИ-ассистентов для разработчиков в этом году составит 17,4 млрд руб., включая 13,9 млрд руб. сегмента on-premise-решений, и 3,5 млрд руб. — облачных. Доля рынка MTS AI может составить 10 %.

04.04.2025 [12:37], Руслан Авдеев

«Агрегатор ускорителей» Parasail анонсировал ИИ-гипероблакоСтартап Parasail привлёк $10 млн стартового капитала и выступил с необычным для рынка ИИ предложением. Компания стала своеобразным «агрегатором ускорителей», создав для инференса сеть, позволяющую свести вместе владельцев вычислительных мощностей и их клиентов с максимальной простотой, сообщает The Next Platform. Раунд финансирования возглавили Basis Set Ventures, Threshold Ventures, Buckley Ventures и Black Opal Ventures. Компанию основали Майк Генри (Mike Henry), ранее основавший производителя ИИ-решений Mythic и работавший одним из топ-менеджеров в Groq, и Тим Харрис (Tim Harris), генеральный директор Swift Navigation. Прежний опыт Майка Генри на рынке IT позволил заметить, что в последнее время ландшафт облачных сервисов стремительно меняется — если ранее на нём безраздельно доминировали гиперскейлеры вроде AWS, Microsoft Azure и Google Cloud, то с приходом ИИ они, казалось бы, сохраняют ведущие позиции, но на сцену выходят и новые облачные игроки, чья инфраструктура изначально рассчитана на ИИ-задачи, от обучения до инференса. В конце 2023 года бизнесмены основали компанию Parasail, которая совсем недавно заявила о себе, заодно собрав $10 млн финансирования. Фактически бизнес рассчитан на клиентов, которые заинтересованы в простом доступе к ИИ-технологиям — он будет связывать тех, кто располагает ими, и тех, кто в них нуждается.

Источник изображения: Campaign Creators/unsplash.com Parasail намеревается использовать рост облачных ИИ-провайдеров вроде CoreWeave (недавно вышедшей на IPO) и Lambda Labs. Для этого создана сеть AI Deployment Network, объединяющая их вычислительные ресурсы в единую инфраструктуру, которая масштабнее, чем Oracle Cloud Infrastructure (OCI). Компания применяет собственный «движок» для оркестрации процессов в этом гипероблаке. Ключевым преимуществом является низкая стоимость услуг — утверждается, что компании, желающие отказаться от сервисов вроде OpenAI и Anthropic, могут рассчитывать на экономию в 15–30 раз, а в сравнении с клиентами провайдеров open source моделей — в 2–5 раз. На настройку уходит несколько часов, а инференс после этого можно начать за считанные минуты. Сегодня Parasail предлагает в облаке ресурсы NVIDIA H200, H100 и A100, а также видеокарт NVIDIA GeForce RTX 4090. Цены составляют от $0,65 до $3,25 за час использования. Parasail столкнулась с проблемой несовместимости инфраструктур: разные облачные платформы используют уникальные подходы к вычислениям, хранению данных, сетевому взаимодействию, а также имеют различия в настройке, биллинге и автоматизации. Хотя Kubernetes и контейнеризация могли бы частично решить эти проблемы, их реализация у разных провайдеров сильно отличается, а Kubernetes изначально не предназначается для работы с несколькими кластерами, регионами или провайдерами одновременно. Чтобы обойти ограничения, Parasail разработала собственную систему, которая объединяет ускорители из разных облаков в единую глобальную сеть. Их решение позволяет централизованно управлять распределёнными узлами, игнорируя различия в инфраструктуре провайдеров. Если один облачный провайдер выйдет из строя, система автоматически заменяет его ресурсы другими, минимизируя простои. Дополняя эту систему автоматизированным динамическим выделением ускорителей, Parasail создаёт масштабируемую и эффективную глобальную инфраструктуру, способную оперативно адаптироваться к нагрузкам и сбоям. Оркестрация и оптимизация рабочих нагрузок в ИИ-инфраструктуре усложняются из-за огромного разнообразия моделей, архитектур, типов GPU и ASIC, а также множества способов их комбинирования. Parasail решает эту проблему с помощью гибридного подхода, сочетающего математическое моделирование, ИИ-алгоритмы и участие живых специалистов, что позволяет эффективно масштабироваться даже с небольшой командой.

Источник изображения: Campaign Creators/unsplash.com Закрытое бета-тестирование началось в январе, а позже спрос только вырос до той степени, что Parasail достигла семизначного ежегодного регулярного дохода (ARR). Теперь технология доступна всем, в числе клиентов — производитель чипов SambaNova, ИИ-платформа Oumi, ИИ-стартап Rasa и Elicit, позволяющий автоматизировать научные изыскания. В будущем стартап намерен быстро расширить штат из 12 работников, рассматриваются и варианты добавления в портфолио новых доступных ускорителей — сейчас там безусловно лидирует NVIDIA, но рынок вполне может измениться. В то же время отмечается парадоксальная ситуация, когда на рынке наблюдается и дефицит ускорителей, и простой мощностей в некоторых ЦОД одновременно. Предполагается, что дело в плохой оптимизации процессов на рынке ИИ. При этом в компании отмечают, что в данное время спрос на ИИ-приложения «почти бесконечен» и главная проблема — эффективно их использовать. Платформа Parasail для инференса максимально упрощает масштабное внедрение ИИ. |

|