Материалы по тегу: ix

|

01.03.2026 [18:15], Руслан Авдеев

CPP Investments и Equinix купили за $4 млрд оператора экологичных ИИ ЦОД atNorthКанадский пенсионный фонд Canada Pension Plan Investment Board (CPP Investments) и Equinix анонсировали соглашение о покупке у Partners Group компании atNorth за $4 млрд, специализирующейся на предоставлении колокейшн-площадок для HPC/ИИ-нагрузок и провайдере ЦОД «под ключ», сообщает HPC Wire. Digital Realty, тоже пытавшаяся купить atNorth, осталась не у дел. CPP и Equinix предварительно согласовали финансирование в объёме $4,2 млрд (€3,6 млрд) как для закрытия самой сделки, так и для расширения бизнеса atNorth. CPP Investments намерена вложить около $1,6 млрд, получив долю в 60 % компании, а Equinix — около 40 %. Сообщается, что сразу после закрытия сделка, которая ещё ожидает одобрение регуляторов, окажет положительное действие на скорректированный денежный поток от операционной деятельности (AFFO) Equinix. Сделка укрепляет долговременное сотрудничество между Equinix и CPP Investments — в 2024 году было создано совместное предприятие с сингапурской GIC для расширения портфоли ЦОД xScale. У atNorth есть восемь действующих дата-центров, ещё несколько строятся в Дании, Финляндии, Исландии, Норвегии и Швеции — общий объём портфолио составляет 800 МВт. Кроме того, компания уже зарезервировала поставки 1 ГВт энергии. Некоторые объекты, разработанные для ИИ и HPC, поддерживают жидкостное охлаждение. Также компания активно внедряет возобновляемую энергетику, инициативы по использованию избыточного тепла от оборудования, в том числе для выращивания овощей, и модульный дизайн для минимизации ущерба окружающей среде и продвижению экономики замкнутого цикла. atNorth заявляет, что компания по-прежнему будет придерживаться работы в северном регионе и продолжит независимую работу под собственным брендом, сохраняя приверженность культуре и ценностям, которые она продвигает. В CPP Investments подчеркнули, что сделка основана на уже имеющемся долгосрочном сотрудничестве с Equinix. Фонд намерен и далее наращивать бизнес в быстрорастущем секторе ЦОД. Equinix подчеркнула, что для клиентов, нуждающихся в надёжном масштабировании, компания предлагает готовую к будущим задачам инфраструктуру с сохранением юридического и информационного суверенитета. Северная Европа укрепляет статус критически важного хаба для следующего этапа цифрового роста. Он имеет сильную и надёжную экономику, активно внедряет инновации, делает ставку на исследования и техническую экспертизу, а также экоустойчивые проекты. Здесь есть много источников возобновляемой энергии и оптимальный для ЦОД климат. Equinix располагает восемью ЦОД на севере Европы: пять в Хельсинки и три в Стокгольме. Всего же в ведении компании есть более 100 объектов в 20 странах. В Европе компания на 100 % компенсирует энергопотребление своих дата-центров за счёт покупок возобновляемой энергии. Это вполне соответствует «зелёному» курсу atNorth и, как ожидается, Equinix добьётся нулевых выбросов к 2040 году.

26.02.2026 [23:11], Владимир Мироненко

AMD инвестирует в Nutanix $250 млн и создаст совместную платформу для агентного ИИAMD и Nutanix объявили о заключении соглашения о многолетнем стратегическом партнёрстве с целью разработки открытой инфраструктурной платформы для корпоративных приложений в области агентного ИИ, первая версия которой должна появиться к концу этого года. В рамках соглашения AMD инвестирует $150 млн в обыкновенные акции Nutanix по цене $36,26/шт. и предоставит до $100 млн дополнительного финансирования для совместных инженерных и маркетинговых инициатив, а также сотрудничества в области выхода на рынок с целью ускорения внедрения совместной платформы агентного ИИ. Ожидается, что сделка по инвестиции в акционерный капитал будет завершена во II квартале 2026 года после получения необходимых разрешений регулирующих органов. Совместно разработанная платформа агентного ИИ предназначена для обеспечения ускорения инференса на базе ускорителей Instinct и процессоров EPYC, HPC и оркестрации с использованием EPYC, а также унифицированного управления жизненным циклом с помощью Nutanix Enterprise AI, что позволит развёртывать открытые и коммерческие ИИ-модели без зависимости от вертикально интегрированных стеков ИИ. В рамках сделки Nutanix также интегрирует ПО AMD ROCm и Enterprise AI в свою облачную платформу Nutanix Cloud и платформу Nutanix Kubernetes, отметил ресурс SiliconANGLE. В настоящее время Nutanix поддерживает только ускорители NVIDIA. Благодаря этой сделке Nutanix будет поддерживать и ускорители AMD, что, как ожидается, позволит AMD расширить круг клиентов. «Наша цель — предоставить клиентам выбор, — заявил глава Nutanix Раджив Рамасвами (Rajiv Ramaswami) изданию The Register. — NVIDIA — лидер рынка, а AMD — ещё одна крупная компания, владеющая платформой». О сделке было объявлено после того, как Nutanix сообщила о финансовых результатах за II квартал 2026 финансового года. Выручка компании выросла год к году на 10 % до $723 млн. Скорректированная прибыль на акцию составила 56¢. Оба показателя превысили прогнозы аналитиков, ожидавших $710,35 млн выручки и 44¢ на акцию скорректированной прибыли. Высокие показатели были достигнуты благодаря росту клиентской базы: годовой доход от регулярных платежей по состоянию на конец января составил $2,36 млрд, что на 16 % больше, чем годом ранее. Рамасвами сообщил, что за прошедший квартал компания заключила 1000 новых контрактов с клиентами, и большинство из них намерены перейти с VMware на Nutanix. Вместе с тем дефицит в цепочках поставок процессоров и комплектующих, включая память и накопители, привёл к тому, что компания снизила свой прогноз на весь год с $2,82–$2,86 млрд до $2,80–$2,84 млрд. После объявления о сделке AMD и Nutanix акции Nutanix выросли в цене на 15 %.

17.02.2026 [11:08], Сергей Карасёв

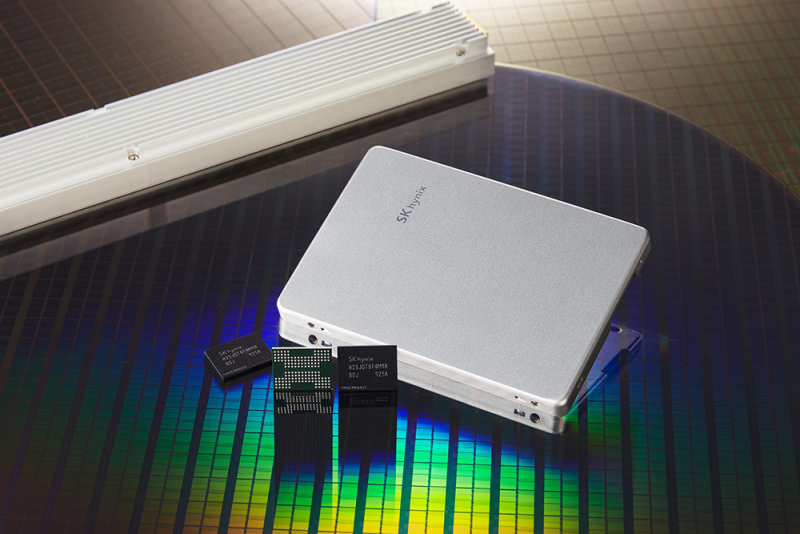

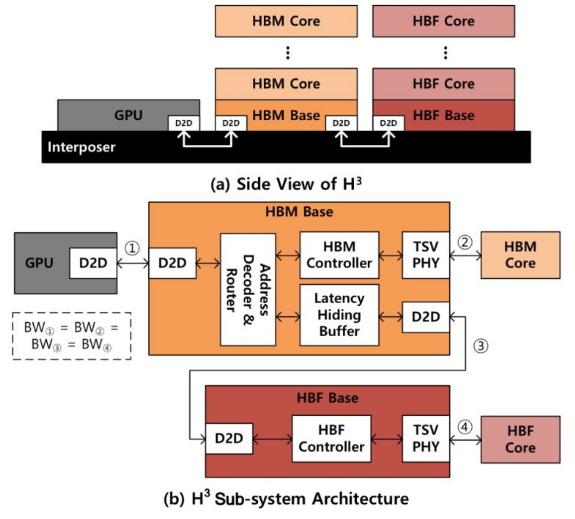

SK hynix предлагает гибридную память HBM/HBF для ускорения ИИ-инференсаКомпания SK hynix, по сообщению ресурса Blocks & Files, разработала концепцию гибридной памяти, объединяющей на одном интерпозере HBM (High Bandwidth Memory) и флеш-чипы с высокой пропускной способностью HBF (High Bandwidth Flash). Предполагается, что такое решение будет подключаться к GPU для повышения скорости ИИ-инференса. Современные ИИ-ускорители на основе GPU оснащаются высокопроизводительной памятью HBM. Однако существуют ограничения по её ёмкости, из-за чего операции инференса замедляются, поскольку доступ к данным приходится осуществлять с использованием более медленных SSD. Решить проблему SK hynix предлагает путём применения гибридной конструкции HBM/HBF под названием H3. Архитектура HBF предусматривает монтаж кристаллов NAND друг над другом поверх логического кристалла. Вся эта связка располагается на интерпозере рядом с контроллером памяти, а также GPU, CPU, TPU или SoC — в зависимости от предназначения конечного изделия. В случае H3 на интерпозере будет дополнительно размещён стек HBM. Отмечается, что время доступа к HBF больше, чем к HBM, но вместе с тем значительно меньше, нежели к традиционным SSD. Таким образом, HBF может служить в качестве быстрого кеша большого объёма.

Источник изображения: SK hynix По заявлениям SK hynix, стеки HBF могут иметь до 16 раз более высокую ёмкость по сравнению с HBM, обеспечивая при этом сопоставимую пропускную способность. С другой стороны, HBF обладает меньшей износостойкостью при записи, до 4 раз более высоким энергопотреблением и большим временем доступа. HBF выдерживает около 100 тыс. циклов записи, а поэтому лучше всего подходит для рабочих нагрузок с интенсивным чтением. В результате, как утверждается, гибридная конструкция сможет эффективно решать задачи инференса при использовании больших языковых моделей (LLM) с огромным количеством параметров. В ходе моделирования работы H3, проведенного специалистами SK hynix, рассматривался ускоритель NVIDIA Blackwell B200 с восемью стеками HBM3E и таким же количеством стеков HBF. В пересчете на токены в секунду производительность системы с памятью H3 оказалась в 1,25 раза выше при использовании 1 млн токенов и в 6,14 раза больше при использовании 10 млн токенов по сравнению с решениями, оборудованными только чипами HBM. Более того отмечено 2,69-кратное повышение производительности в расчёте на 1 Вт затрачиваемой энергии по сравнению с конфигурациями без HBF. К тому же связка HBM и HBF может обрабатывать в 18,8 раз больше одновременных запросов, чем только HBM.

10.02.2026 [16:42], Руслан Авдеев

В погоне за цифровым суверенитетом десятки стран обратились к открытому протоколу MatrixНа фоне растущего запроса на достижение цифрового суверенитета, открытый коммуникационный протокол Matrix получил второе дыхание и сегодня всё более востребован, сообщает The Register. Проект Matrix (и его коммерческое подразделение Element) существует многие годы. В 2014 году подразделение Matrix отделилось от телеком-провайдера Amdocs. В рамках Matrix действует некоммерческий фонд Matrix.org, стоящий за протоколом Matrix, а также отвечающая за клиентское приложение Element (ранее Vector и, позже, Riot). Коммерческое предприятие Element.io представляет не только клиентское ПО, но и серверное ПО, совместимое с протоколом Matrix. Помимо бесплатных версий с открытым кодом предлагаются коммерческие варианты Element Pro и Element Server Suite Pro. Matrix — открытый протокол, поэтому его используют многие сторонние приложения, поэтому нет необходимости использовать исключительно приложения Element для общения. По данным The Register, на фоне роста спроса ЕС на цифровой суверенитет, дела у Matrix идут весьма хорошо и, по словам одного из учредителей, «интерес растёт». Сегодня Matrix ведёт переговоры приблизительно с 35 странами о создании инфраструктуры связи на базе open source решений, причём инициативу, по словам разработчиков, поддерживает и ООН. Сообщается, что организация использовала Matrix в качестве основы для собственного решения для связи, независимого от любых стран и хостинг-провайдеров.

Источник изображения: Element Протокол используется и Международным уголовным судом (МУС), активно пытающимся отказаться от инструментов американского происхождения после того, как США ввели санкции против его членов, нарушившие работу электронной почты и др. МУС переходит на пакет OpenDesk вместо Microsoft Office, а в самом пакете есть Element. За внедрение отвечает немецкая ZenDiS (Zentrum für Digitale Souveränität der Öffentlichen Verwaltung — Центр цифрового суверенитета государственного управления). Протокол продвигается и в других странах, в многочисленных организациях Евросоюза. На мероприятии Ubuntu Summit в 2024 году анонсирована версия протокола Matrix 2.0, а официально её представили в конце того же года. Среди новых функций — ускоренная синхронизация и запуск клиента, многопользовательский видео- или VoIP-чат через Element Call. Хотя официальную спецификацию ещё не публиковали, новая версия протокола уже используется. Например, по умолчанию современным мобильным клиентом для Matrix 2.0 является Element X. Отличительная особенность протокола в том, что очень многие используют его, даже не слышав о нём, поскольку протокол интегрирован в инструменты и приложения с другими именами. Хотя технология, возможно, так и останется нишевой в сравнении с решениями крупных компаний с большими рекламными бюджетами, но это не означает, что она не имеет значения.

08.02.2026 [17:00], Владимир Мироненко

Из-за ИИ и так дефицитная SLC NAND подорожает на 400–500 %В связи с продолжающимся усовершенствованием ИИ-серверов и коммутаторов объём NOR-памяти на одну единицу такой продукции, как ожидают аналитики DigiTimes, вырастет в несколько раз на фоне прогнозируемого дефицита высокопроизводительных компонентов. Согласно прогнозу DigiTimes, во II квартале 2026 года цены на NOR Flash вырастут последовательно на 40–50 %, причем по некоторым позициям клиенты будут готовы платить надбавки, чтобы гарантировать поставки в рамках контрактов. Что касается памяти SLC NAND и MLC NAND, то здесь ожидается ещё более значительный рост цен — на 400–500 % во II квартале в годовом исчислении, что побудит тайваньского производителя Winbond Electronics ускорить расширение мощностей по производству SLC NAND. Winbond выпускает NOR-память для ИИ-серверов и сетевых приложений с использованием 58-нм техпроцесса, в то время как память для носимых устройств, таких как Bluetooth-гарнитуры, производится по 45-нм техпроцессу. DigiTimes отметил, что более сложный дизайн NVIDIA GB300 по сравнению с GB200 с большим объёмом памяти и более высокими требованиями к её спецификациям обусловил рост спроса на модули NOR ёмкостью 512 Мбайт и 1 Гбайт. Но запасы модули NOR-памяти большой ёмкости остаются относительно ограниченными. По данным источников, цены на NOR-флеш выросли в I квартале 2026 года примерно на 30 %, а на некоторые позиции — на 50 %. Хотя масштабы повышения цен менее значительны, чем в категории DDR4, предложение NOR остаётся ограниченным, и ожидается, что контрактные цены неё во II квартале вырастут ещё на 40–50 %, а сроки поставки специальных вариантов увеличатся до 12–14 недель.

Источник изображения: Winbond Тайваньский производитель Macronix тоже утверждает, что продолжающийся рост выпуска серверов для ИИ-нагрузок создаёт структурную напряжённость на рынке NOR, которую будет сложно преодолеть в краткосрочной перспективе. Уход крупных производителей NAND-памяти с рынков SLC NAND и MLC NAND ещё больше подстегнул дефицит и позволил Winbond и Macronix выступать на рынке в качестве основных поставщиков. Цены Macronix на MLC eMMC недавно выросли вдвое по сравнению с декабрём 2025 года. Несмотря на авансовые платежи, внесённые ранее в этом году, клиентам не обеспечили поставки до китайского Нового года, что сделало эту продукцию крайне дефицитной на нишевых рынках, пишет DigiTimes. Доля в выручке Macronix от памяти NAND (включая eMMC) выросла до 21 %, более чем вдвое превысив уровень прошлого года. Контрактные цены Winbond на память SLC NAND во II квартале 2026 года, как ожидается, резко вырастут по сравнению с аналогичным периодом 2025 года — до 400–500 %. Цены Winbond на SLC NAND в I квартале выросли больше всего в её портфолио, превысив рост цен на DDR4. Компания планирует расширение своих мощностей по производству памяти. В частности, будут запущены производственные линии по выпуску DRAM на заводе в Гаосюне (Gāoxióng). Сообщается, что мощность завода компании в Тайчжуне (Táizhōng) составляет примерно 58 тыс. пластин в месяц, включая приблизительно 25 тыс. пластин для NOR, 15 тыс. пластин для NAND и 10 тыс. пластин для DRAM. Ожидается значительное увеличение общего объёма производства до примерно 50 тыс. пластин памяти NOR и SLC NAND с более высокой рентабельностью. Согласно данным Winbond, на SLC NAND, производимую по 46-нм и 32-нм техпроцессам, приходится около 15–25 % выручки. Её доля в выручке компании будет расти по мере роста цен, что приведет к сокращению мощностей, выделенных на производство DRAM по устаревшим техпроцессам. Цены на флеш-память, изготовленную по традиционным технологиям, стремительно растут, а спрос на NOR-память большой ёмкости увеличился в несколько раз. По данным источников DigiTimes, Winbond, увеличившая объёмы поставок, недавно завершила согласование цен по контрактам на I квартал 2026 года. Ожидается, что рост цен на DRAM, начавшийся в IV квартале 2025 года, продолжится и во II квартале 2026 года, что ознаменует собой третий подряд квартал роста и фактически удвоение контрактных цен в годовом исчислении. Также сообщается, что новые производственные мощности Winbond, запланированные к вводу в эксплуатацию в 2027 году, уже полностью забронированы. Глава Winbond сообщил о резко увеличившемся количестве запросов от клиентов, что создало дефицит предложения и затрудняет удовлетворение всех их потребностей. Помимо прямых клиентов первого уровня, владельцы брендов второго уровня и операторы третьего уровня всё чаще обходят посредников и ведут переговоры напрямую с Winbond, что отражает высокий рыночный спрос, отметил DigiTimes.

28.01.2026 [23:51], Владимир Мироненко

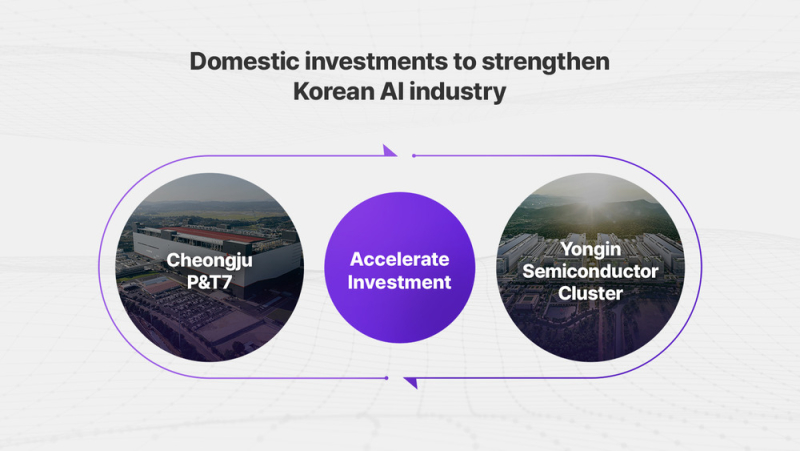

SK hynix создала на базе Solidigm американскую «дочку» для инвестиций в ИИ-решенияЮжнокорейская компания SK hynix объявила о создании в США новой компании, специализирующейся на решениях в сфере ИИ с предварительным названием AI Company (AI Co.). Новая компания будет сформирована путём реструктуризации Solidigm (SK hynix NAND Product Solutions Corp.), калифорнийской «дочки» SK hynix по производству SSD корпоративного класса, образованной в 2021 году в результате покупки NAND-бизнеса Intel за $9 млрд. При этом её бизнес-операции будут переданы новой дочерней компании, которая будет называться Solidigm Inc., «для обеспечения преемственности бренда». Новая структура призвана укрепить конкурентоспособность SK hynix в области технологий памяти для ИИ-платформ, включая высокоскоростную память (HBM). Компания заявила, что эта инициатива знаменует собой переход от традиционной роли производителя памяти к роли ключевого партнёра в решениях для ИИ ЦОД. Полученные в этой роли возможности будут объединены для создания синергии с дочерними компаниями и филиалами SK Group. SK hynix отметила, что благодаря своему бизнесу по производству SSD корпоративного класса, Solidigm уже является ключевым игроком в экосистеме ИИ ЦОД. Включение Solidigm в состав AI Company направлено на поиск возможностей для сотрудничества и развития бизнеса, которые могут создать синергию с различными направлениями бизнеса в ИИ-индустрии. Официальное название AI Company будет объявлено в феврале. Сначала будет сформирована временная управленческая команда и совет директоров, после чего запланирован переход к постоянной управленческой группе, состоящей из местных экспертов с глубокими знаниями рынка США. Для обеспечения первоначального финансирования SK hynix инвестирует в AI Company $10 млрд. Причём эта сумма будет структурирована как резерв на привлечение капитала, в рамках которого средства будут использоваться по запросу AI Co. для финансирования инвестиций. SK hynix планирует осуществлять через AI Co. стратегические инвестиции в ИИ-компании и расширять сотрудничество с американскими новаторами в сфере ИИ. SK hynix стремится укрепить своё лидерство в области производства памяти, одновременно развивая возможности решений по всей цепочке создания стоимости в ИИ ЦОД, поскольку растёт спрос на оптимизацию на системном уровне для решения проблем с узкими местами в передаче данных, отметил ресурс Korea IT Times. Первоначально SK hynix планирует сосредоточиться на ПО для оптимизации ИИ-систем, а затем постепенно расширять инвестиции в экосистему ИИ ЦОД. Недавно сообщалось о том, что SK hynix на три месяца ускорила график запуск завода по производству микросхем в южнокорейском Йонъине (Yongin), поскольку компания вкладывает большие деньги в освоение ИИ-волны. На поставках для ЦОД можно заработать ещё больше, поскольку, по крайней мере в краткосрочной перспективе, это создало дефицит памяти в потребительском секторе, отметил ресурс Hothardware. Также в этом месяце стало известно, что SK hynix инвестирует ₩19 трлн ($12,9 млрд) в строительство нового завода по упаковке и тестированию чипов для ИИ-технологий в Чхонджу (Cheongju). Планы по созданию нового предприятия в США также соответствуют политике США, стимулирующей размещение производства в стране с помощью регулирования пошлин на поставки извне. SK hynix уже строит в Индиане научно-исследовательский центр по производству современных микросхем и их упаковке стоимостью $3,87 млрд, о котором было объявлено ещё в 2024 году. Завод будет производить HBM для ИИ-ускорителей, начало его работы запланировано на 2028 год, пишет ресурс CNBC.

25.12.2025 [09:23], Владимир Мироненко

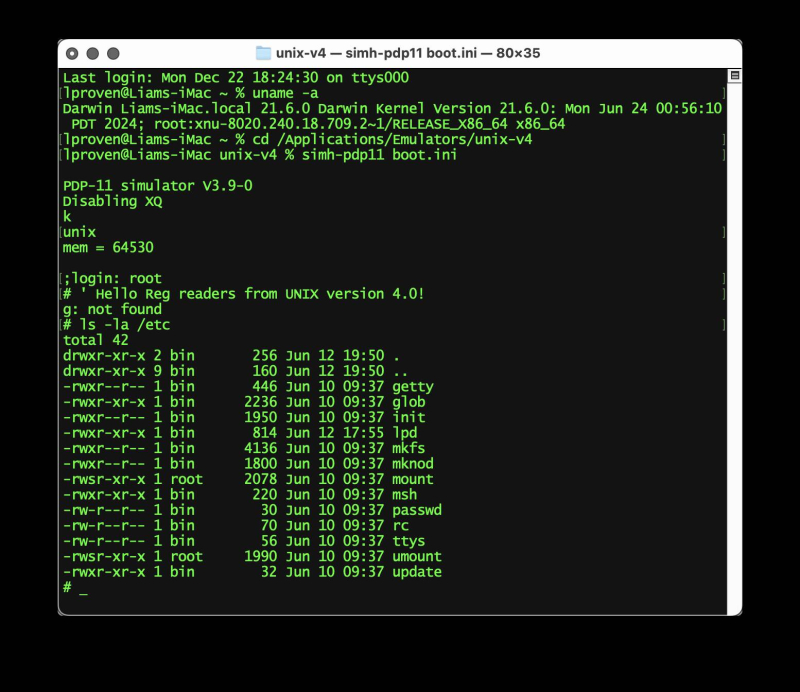

Считавшаяся утерянной легендарная ОС UNIX V4 по случайности была найдена в архивах, восстановлена и запущена полвека спустяПрофессору Роберту Риччи (Robert Ricci) из Школы вычислительной техники Калерта при Университете Юты (Kahlert School of Computing) удалось восстановить хранившуюся на ленточном накопителе выпуска 1970-х годов UNIX V4, первую в истории версию операционной системы UNIX, ядро которой было написано на новом на тот момент языке программирования C. Как сообщает ресурс The Register, её можно скачать с Internet Archive и запустить в SimH. Для восстановления данных Риччи воспользовался программой readtape, разработанной Леном Шустеком (Len Shustek) из Музея компьютерной истории (Computer History Museum). Как и более известный инструмент Greaseweazle для архивирования старых дискет эта программа вместо того, чтобы пытаться скопировать байты или секторы с носителя — другими словами, обработанные цифровые данные — напрямую работает с магнитным слоем накопителя, что делает возможным исправление некоторых ошибок. В данном случае только два блока не считывались должным образом, но и собранных данных оказалось достаточно для восстановления их содержимого. На Internet Archive хранится «сырой» образ размером 1,6 Гбайт, хотя сама лента имеет ёмкость 40 Мбайт. Анджело Папенхофф (Angelo Papenhoff) предложил более компактную версию, дополненную файлом README с объяснением, как её запустить. Восстановленные данные содержат всего лишь около 55 тыс. строк кода Version 4 Unix, из которых около 25 тыс. строк написаны на C, и менее тысячи строк комментариев. По-настоящему Unix начала разрастаться с седьмым изданием — Unix V7. Она стала вирусной, а её преемники, форки и переписанные версии были широко приняты в индустрии и академических кругах.

17.12.2025 [10:11], Сергей Карасёв

SK hynix и NVIDIA объединили усилия для создания сверхбыстрых SSD для ИИ-системКомпании SK hynix и NVIDIA, по сообщениям сетевых источников, занимаются совместной разработкой сверхбыстрых SSD, которые, как ожидается, помогут устранить узкие места современных ИИ-платформ. Проект получил название Storage Next: он предполагает создание чипов флеш-памяти NAND и сопутствующих контроллеров следующего поколения. По информации ресурса ZDNet, первые прототипы изделий партнёры намерены представить к концу следующего года. Речь идёт о накопителях с интерфейсом PCIe 6.0, которые смогут демонстрировать показатель IOPS (операций ввода/вывода в секунду) на уровне 25 млн. Более того, в 2027-м, как ожидается, будет выпущено устройство с величиной IOPS до 100 млн. Для сравнения, современные высокопроизводительные SSD корпоративного класса имеют значение IOPS на уровне 2–3 млн. В основу накопителей Storage Next лягут наработки SK hynix в области памяти AI-N (AI-NAND), оптимизированной для ИИ. В частности, упоминаются решения AI-N P: предполагается, что такие устройства будут выполнены в форм-факторе EDSFF E3.x. Они получат контроллер, предназначенный для выполнения как обычных рабочих нагрузок, так и с высоким показателем IOPS. По мере того, как ИИ-платформы переходят от обучения к инференсу, возможностей памяти HBM с высокой пропускной способностью оказывается недостаточно: наблюдается разрыв между объёмом и производительностью HBM и вычислительными возможностями ИИ-ускорителей на базе GPU. Цель проекта Storage Next состоит в том, чтобы решить эту проблему путём использования инноваций в области NAND. По сравнению с современными SSD накопители Storage Next смогут демонстрировать увеличение показателя IOPS в 30–50 раз. Кроме того, SK hynix разрабатывает память AI DRAM (AI-D) для ИИ-платформ: эти изделия, как предполагается, помогут справиться с нехваткой памяти.

29.11.2025 [15:32], Руслан Авдеев

Битва за Северную Европу: Digital Realty и Equinix борются за покупку скандинавского оператора ЦОД atNorth за €4,5 млрдDigitalRealty и Equinix (в сотрудничестве с Canada Pension Plan Investment Board) конкурируют за покупку скандинавского оператора ЦОД atNorth, сообщает The Register. Источники сообщают, что швейцарская Partners Group, купившая atNorth в 2021 году, вероятно, желает получить €4–€4,5 млрд ($4,6–$5,2 млрд). atNorth управляет девятью дата-центрами в странах с оптимально прохладным для ЦОД климатом, где довольно эффективно работает естественное охлаждение: в Швеции, Финляндии, Дании и Исландии. Любому из покупателей сделка сулит дополнительные мощности, а также выход на рынки ЦОД за пределами FLAPD. Вторичные рынки дата-центров в Европе расширяются из-за более низких цен на электричество и относительно прохладного европейского климата, а также благодаря большей доступности земли. В 2024 году объём слияний и поглощений на рынке ЦОД на фоне бума ИИ составил рекордные $73 млрд. Рынок привлекает крупных институциональных инвесторов, видящих потенциальную прибыль. Возможности для крупных игроков также открываются благодаря высокому порогу входа и тому, что многим корпоративным клиентам нелегко сменить поставщика услуг после заключения соглашения. Впрочем, многие эксперты, включая главу OpenAI Сэма Альтмана (Sam Altman), сравнивают ажиотаж, связанный с инвестициями в ИИ с пузырём сродни тому, что привёл к краху «доткомов». Такие соображения, возможно, побуждают Partners Group выйти из проекта, пока стоимость её актива находится на пике.

18.11.2025 [16:55], Владимир Мироненко

d-Matrix привлекла ещё $275 млн и объявила о разработке первого ИИ-ускорителя с 3D-памятью Raptord-Matrix сообщила о завершении раунда финансирования серии C, в ходе которого было привлечено $275 млн инвестиций с оценкой рыночной стоимости компании в $2 млрд. Общий объём привлечённых компанией средств достиг $450 млн. Полученные средства будут направлены на расширение международного присутствия компании и помощь клиентам в развёртывании ИИ-кластеров на основе её технологий. Раунд C возглавил глобальный консорциум, включающий BullhoundCapital, Triatomic Capital и суверенный фонд благосостояния Сингапура Temasek. В раунде приняли участие Qatar Investment Authority (QIA) и EDBI, M12, венчурный фонд Microsoft, а также Nautilus Venture Partners, Industry Ventures и Mirae Asset. Сид Шет (Sid Sheth), генеральный директор и соучредитель d-Matrix, отметил, с самого начала компания была сосредоточена исключительно на инференсе. «Мы предсказывали, что когда обученным моделям потребуется непрерывная масштабная работа, инфраструктура не будет готова. Последние шесть лет мы потратили на разработку решения: принципиально новой архитектуры, которая позволяет ИИ работать везде и всегда. Это финансирование подтверждает нашу концепцию, поскольку отрасль вступает в эпоху ИИ-инференса», — добавил он. d-Matrix разработала ускоритель инференса Corsair на базе архитектуры с вычислениями в памяти DIMC (digital in-memory computing) — процессорные компоненты в нём встроены в память. Ускоритель предлагается вместе с сетевой картой JetStream. Также предлагается референсная архитектура SquadRack, которая упрощает создание ИИ-кластеров на базе Corsair. Она поддерживает до восьми серверов в стойке, каждая из которых содержит восемь ускорителей Corsair. Шасси SquadRack позволяет запускать ИИ-модели размером до 100 млрд параметров, хранящиеся полностью в SRAM. По данным d-Matrix, такая конфигурация обеспечивает на порядок большую производительность по сравнению с чипами с HBM. Вместе с оборудованием компания предлагает программный стек Aviator, который автоматизирует часть работы, связанной с развертыванием ИИ-моделей на ускорителе. Aviator также включает набор инструментов для отладки моделей и мониторинга производительности. В следующем году d-Matrix планирует выпустить более производительный ускоритель инференса Raptor. Это первый в мире ускоритель на базе 3D DRAM. Решение разрабатывается в партнёрстве с Alchip, известной разработками в области ASIC. Благодаря сотрудничеству уже реализована ключевая технология d-Matrix 3DIMC, представленная в тестовом кристалле d-Matrix Pavehawk. По словам компаний, новинка обеспечит до 10 раз более быстрый инференс по сравнению с решениями на базе HBM4, что позволит повысить эффективность генеративных и агентных рабочих ИИ-нагрузок. Также в Raptor будет использоваться процессор AndesCore AX46MPV от Andes Technology. Компании заявили, что их сотрудничество представляет собой конвергенцию вычислений, ориентированных на память, и инноваций в области процессоров на основе открытых стандартов для рабочих ИИ-нагрузок в масштабах ЦОД. Andes AX46MPV будет отвечать за оркестрацию наргрузок, распределение памяти, векторные вычисления и функции активации. AX46MPV — 64-бит многоядерный RISC-V-процессор с поддержкой Linux. Он включает 2048-бит блок векторной обработки (RVV 1.0), высокоскоростную векторную память (HVM) и ряд других аппаратных блоков для работы с массивными вычислениями. В совокупности эти функции обеспечивают запас производительности и гибкость ПО, необходимые для систем инференса уровня ЦОД. Референсные ядра, являющиеся ключевыми для рабочих нагрузок ИИ-трансформеров и LLM, демонстрируют прирост производительности до 2,3 раза по сравнению с предшественником AX45MPV. |

|