Материалы по тегу: hardware

|

21.04.2025 [16:13], Руслан Авдеев

«Чудо-долина» для ИИ — в Канаде построят крупнейший в мире 7,5-ГВт ЦОД с питанием от природного газаИнвестор, бизнесмен и шоумен Кевин О’Лири (Kevin O’Leary) объявил о строительстве «крупнейшего в мире» ИИ ЦОД, сообщает Tech Republic. Проект Wonder Valley (букв. «Чудо-долина» или «Долина чудес») предусматривает строительство крупного ИИ ЦОД без подключения к магистральным энергосетям в муниципальном округе Гринвью (Greenview) провинции Альберта на западе Канады. Кампус займёт территорию более 2400 га, общая мощность составит беспрецедентные 7,5 ГВт. Первую фазу на 1,56 ГВт должны закончить в 2027–2028 гг., она обойдётся в $2 млрд. По словам О’Лири, дата-центры — своеобразная «золотая лихорадка» современности. Вместе с тем получение питания для ЦОД стало большой проблемой, поскольку на присоединение может уйти пять или более лет. Он привёл пример, когда оператор ЦОД запрашивает 250 МВт сразу и ещё 250 МВт в течение двух лет, а в ответ ему предлагают 25 МВт с задержкой на три года, тогда как сейчас нужны проекты, которые будут готовы к работе уже через 24 месяца. Поэтом для питания нового кампуса будет использоваться природный газ. Wonder Valley представляет собой не просто крупнейший в мире дата-центр, но и экоустойчивый кампус на лоне дикой природы. Он сможет работать без подключения к магистральным электросетям и, более того, владельцы намерены поставлять энергию местным жителям. В регионе достаточно земли, природного газа, ВОЛС, кадров, инфраструктуры и др. По словам О’Лири, ИИ ЦОД рентабельны при реализации крупных проектов, так что теперь бизнес ищет другие площадки с государственной поддержкой и дешёвой энергией как в Альберте. По мнению О’Лири, при строительстве ИИ ЦОД надо в целом менять подход и вместо того, чтобы забирать электроэнергию из уже загруженных сетей, повышая тем самым стоимость электричества для остальных, стоит самостоятельно генерировать энергию и передавать её часть местным жителям и бизнесу. Появление кампуса в Альберте даст не только дешёвое электричество для ИИ ЦОД, но создаст рабочие места для местных, сократит вредные выбросы (за счёт утилизации попутного газа и захвата углерода), а также пополнит бюджет за счёт налоговых поступлений. Хотя газовые проекты для дата-центров в Северной Америке в последнее время очень популярны, производители газовых турбин, едва справляющиеся с заказами для дата-центров, опасаются расширять производство. А крупнейшая в США энергокомпания NextEra Energy предупреждает, что полагаться в энергетике только на газ очень опрометчиво. Что касается «крупнейшего с мире ЦОД», совсем недавно на это звание претендовал проект индийской Reliance с мощностью 3 ГВт.

21.04.2025 [12:30], Сергей Карасёв

Fujitsu, Supermicro и Nidec сообща повысят энергоэффективность ИИ ЦОДFujitsu, Supermicro и Nidec объявили об объединении усилий с целью снижения энергопотребления ЦОД. Речь идёт о создании платформы, которая поможет операторам дата-центров повысить коэффициент эффективности использования энергии (PUE). Отмечается, что стремительное внедрение ИИ приводит к быстрому росту нагрузки на ЦОД. Это, в свою очередь, провоцирует увеличение энергопотребления, что объясняется установкой мощных серверов с ускорителями на базе GPU. Тем не менее, многие дата-центры продолжают использовать воздушное охлаждение. Хотя жидкостное охлаждение обеспечивает значительно более высокую эффективность, проектирование, строительство и эксплуатация таких систем требуют высокого уровня технических знаний и навыков. В рамках нового проекта партнёры объединят ПО для мониторинга и управления жидкостным охлаждением Fujitsu, высокопроизводительные GPU-серверы Supermicro и высокоэффективную систему жидкостного охлаждения Nidec. В частности, Fujitsu намерена использовать свой 40-летний опыт в области СЖО, которые применяются в суперкомпьютерах. Supermicro предоставит высокопроизводительные серверные комплексы высокой плотности, оптимизированные для жидкостного охлаждения: такие устройства позволят сократить энергопотребление и снизить уровень шума благодаря отсутствию вентиляторов. Nidec будет отвечать за поставки компонентов СЖО, включая блоки распределения охлаждающей жидкости (CDU), насосы и пр. Система охлаждения Nidec, как ожидается, улучшит управление температурой и снизит энергопотребление. В целом, как заявляют партнёры, новая инициатива поможет повысить общую энергоэффективность ЦОД до 40 % по сравнению с традиционными методами воздушного охлаждения. Fujitsu оценит преимущества решения в своем центре обработки данных Tatebayashi.

21.04.2025 [11:36], Сергей Карасёв

CoolIT представила 2-МВт блок распределения охлаждающей жидкости CHx2000 для ИИ и HPC ЦОДКомпания CoolIT Systems анонсировала блок распределения охлаждающей жидкости (CDU) CHx2000 для дата-центров, ориентированных на задачи ИИ и НРС. Новинка обеспечивает отвод более 2 МВт тепла: это, как утверждается, на сегодняшний день самый высокий показатель для CDU данного класса. Устройство выполнено в виде шкафа с размерами основания 750 × 1200 мм. Заявленный расход жидкости составляет 1,2 л/мин. на кВт (LPM/kW): допускается охлаждение до двенадцати стоек NVIDIA GB200 NVL72 мощностью 120 кВт. По сравнению со своим предшественником (модель CHx1500) новинка обеспечивает повышение охлаждающей способности на 66 %. При создании CHx2000 компания CoolIT Systems сделала упор на долговечность, безотказную работу и простоту обслуживания. Применены два насоса с возможностью горячей замены (N+N), обеспечивающие производительность 1500 л/мин. Трубы изготовлены из нержавеющей стали. В конструкции используются 4″ муфты Victaulic. Благодаря резервированию критически важных компонентов доступность находится на уровне 99,9999 %. Предусмотрена интегрированная система управления и мониторинга (Redfish, SNMP, TCP/IP, Modbus, BACnet и др.). Причём допускается групповое управление одновременно до 20 экземпляров CDU. Во время обслуживания возможен доступ с лицевой и тыльной сторон с поддержкой горячей замены насосов, фильтров и датчиков. Заявленная потребляемая мощность составляет 12,24 кВт при работе одного насоса (1500 л/мин). Во фронтальной части корпуса располагается информационный дисплей. Блок CHx2000 уже доступен для заказа. CoolIT Systems предоставляет комплексную поддержку и услуги по проектированию, монтажу и обслуживанию в более чем 70 странах по всему миру.

21.04.2025 [08:46], Сергей Карасёв

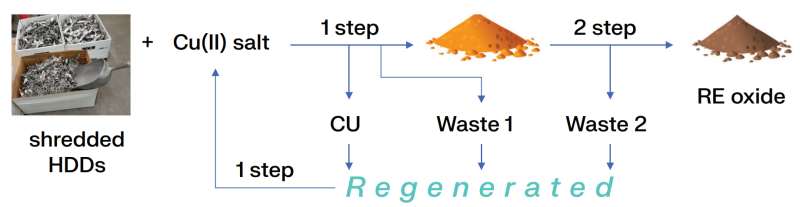

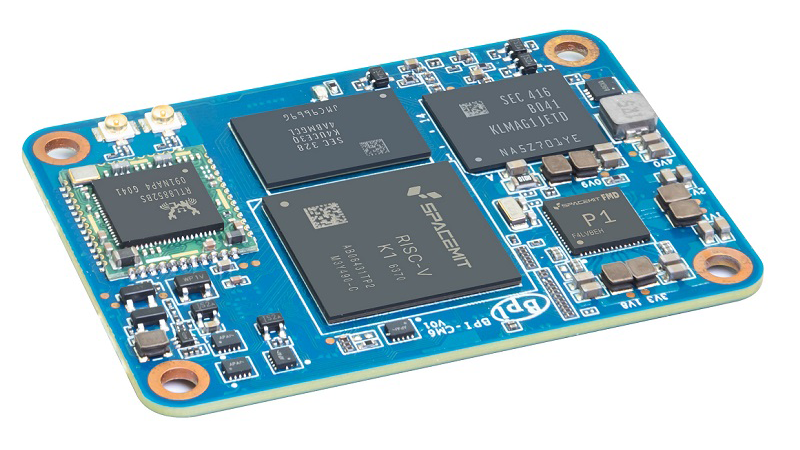

Представлен модуль Banana Pi BPI-CM6 — аналог Raspberry Pi CM4 на базе RISC-VВ ассортименте Banana Pi появился вычислительный модуль BPI-CM6 — это альтернатива Raspberry Pi CM4, выполненная на процессоре с открытой архитектурой RISC-V вместо Arm. Новинка подходит для создания систем промышленного контроля и автоматизации, NAS-устройств, робототехники, периферийных решений и пр. По форме, габаритам и расположению коннекторов новинка идентична Raspberry Pi CM4. Задействован чип SpacemiT K1, который объединяет восемь 64-битных ядер RISC-V, графический блок Imagination BXE-2-32 с поддержкой OpenCL 3.0, OpenGL ES3.2 и Vulkan 1.3, а также нейропроцессорный узел (NPU) с производительностью до 2 TOPS для ускорения ИИ-операций.

Источник изображений: Banana Pi Модуль Banana Pi BPI-CM6 располагает 8 Гбайт оперативной памяти LPDDR4 (максимум 16 Гбайт) и чипом eMMC вместимостью 16 Гбайт (максимум 128 Гбайт). Реализована поддержка Bluetooth и Wi-Fi, PCIe 2.1 (5 линий), USB 3.0 и USB 2.0 (×2), HDMI 1.4, MIPI DSI и MIPI CSI (×3). Размеры составляют 40 × 55 мм. Диапазон рабочих температур простирается от -40 до +85 °C. Говорится о совместимости с Ubuntu Linux.  Для новинки доступна сопутствующая интерфейсная плата, которая содержит по одному разъёму HDMI, USB 3.0 Type-A, USB 2.0 Type-A и USB Type-C OTG, два сетевых порта 1GbE RJ45 и слот для карты microSD. Кроме того, есть два коннектора M.2 M-Key (PCIe х2) для подключения SSD, 26-контактная колодка GPIO, два интерфейса MIPI CSI (4 линии) и один интерфейс MIPI DSI (4 линии). Питание (12 В) подаётся через DC-коннектор. Габариты — 56 × 85 мм.

20.04.2025 [14:40], Сергей Карасёв

Sitronics Group: российским ИИ ЦОД нужны единые стандартыSitronics Group намерена принять участие в разработке и продвижении единых стандартов для рынка модульных ЦОД. Об этом в ходе конференции Data Fusion заявил директор профильного департамента компании Игорь Анисимов, призвав участников отрасли присоединиться к инициативе. В России сектор ЦОД развивается и адаптируется к новым нагрузкам, в первую очередь к ИИ. При этом возрастает нагрузка на энергетическую инфраструктуру, что потенциально может спровоцировать дефицит. По словам Анисимова, участникам рынка следует заняться решением таких вопросов, как рост плотности энергопотребления, а также стандартизация строительства и эксплуатации дата-центров, ориентированных на ИИ-нагрузки. При этом необходимо сохранить рентабельность бизнеса с учётом технологических требований для развёртывания ЦОД. Модульные дата-центры позволяют заказчикам в сжатые сроки создавать платформы для ИИ, получив мощности в аренду или же масштабировав собственные посредством типовых модулей. «Сегодня нет единого стандарта для центров обработки данных с ИИ-нагрузкой, который позволил бы снизить капитальные затраты за счёт уменьшения затрат на разработку уникальных решений для каждого ЦОД. Стандартизация позволит проработать совместимость инфраструктуры ЦОД с системами ИИ. Мы намерены активно участвовать в этом процессе, особенно в части разработки стандартов для модульных ЦОД, которые, на наш взгляд, обладают большим потенциалом для эффективного размещения систем искусственного интеллекта», — говорит Анисимов.

Источник изображения: Sitronics Group По его словам, при развёртывании дата-центров для ИИ прежде всего требуется бесперебойное электроснабжение и эффективное охлаждение. Сама Sitronics Group ведёт разработки в соответствующих областях: в частности, компания занимается созданием системы фрикулинга с экономайзерами. Кроме того, при стандартизации ЦОД необходимо определить форм-фактор серверов (стандартный или OCP), оптимальную температуру теплоносителя на входе в стойку и на уровне процессора, изучить вопросы совмещения зон для стандартных и ИИ-вычислений в рамках одного объекта, рассчитать мощности инженерных систем и пр.

20.04.2025 [13:50], Сергей Карасёв

«Элар» представила российские системы хранения на основе Blu-ray для ЦОДКорпорация «Элар» представила отечественные системы хранения данных семейства «Элар НСМ» на основе оптических носителей Blu-ray. Эти устройства, как утверждается, позволяют расширить возможности дата-центров в плане организации безопасного долговременного хранилища. Роботизированные системы «Элар НСМ» интегрируются в существующую инфраструктуру ЦОД без необходимости перепроектирования или доработки помещений. Устройства призваны дополнить традиционные СХД на основе HDD или SSD. Новинки обеспечивают гарантированный срок хранения информации свыше 50 лет. В семейство входят оптические библиотеки «Элар НСМ BD 2105», «Элар НСМ BD 3350», «Элар НСМ BD 3560» и «Элар НСМ BD 10368», рассчитанные соответственно на 105, 350, 560 и 10 368 слотов. Максимальное количество приводов составляет 4, 6, 8 и 36. Номинальная ёмкость достигает 10,5, 35, 56 и 1036 Тбайт. Первые три модели поддерживают интерфейс подключения SAS/LAN/NAS, а старшая версия — LAN/Mini SAS/SATA.

Источник изображения: «Элар» Возможна работа с оптическими носителями CD, DVD±R (DL)/±RW/-RAM, BD-R/-RE (DL), BDXL. Системы «Элар НСМ BD 2105», «Элар НСМ BD 3350» и «Элар НСМ BD 3560» используют 35-дисковые съёмные магазины с поддержкой RFID-технологии, модификация «Элар НСМ BD 10368» — 12-дисковые. Заявленная наработка на отказ у всех новинок превышает 2,5 млн циклов. Потребляемая мощность — 110, 140, 140 и до 1200 Вт соответственно. К преимуществам систем «Элар НСМ» разработчик относит использование роботизированной библиотеки для выбора и смены носителей, быстроту доступа, централизованное управление, бесшовную интеграцию в инфраструктуры Windows и Linux, низкие затраты на организацию хранения больших объёмов данных. Модификации «Элар НСМ» вместимостью до 56 Тбайт могут быть использованы для создания защищённых контуров хранения и формирования архивов критически важной информации на производственных предприятиях и в государственных учреждениях. Устройства включены в реестр Минпромторга России и реестр ПАК Минцифры России. Решения соответствуют требованиям ПП РФ 1912 и являются доверенными программно-аппаратными комплексами.

19.04.2025 [23:28], Сергей Карасёв

Atos теряет выручку на всех ключевых рынкахФранцузский IT-холдинг Atos опубликовал показатели деятельности в I квартале 2025 года. Суммарная выручка составила €2,07 млрд: это примерно на 16 % меньше по сравнению с предыдущим годом, когда компания получила €2,48 млрд. Продажи в годовом исчислении снизились на всех ключевых географических рынках. Подразделение Eviden, которое специализируется на кибербезопасности и обработке больших данных, в период с января по март включительно получило €973 млн выручки. Для сравнения: годом ранее показатель составлял около €1,16 млрд. Таким образом, отмечено падение на 16,4 %. В сегменте Tech Foundations, который отвечает за дата-центры, хостинг и аутсорс-сервисы для бизнес-процессов, продажи в годовом исчислении уменьшились на 16,0 % — с €1,31 млрд до €1,1 млрд. В Центральной Европе в I квартале 2025 года зафиксировано снижение выручки примерно на 5,0 %. В Южной Европе падение составило 16,9 %, в Северной Америке — 27,6 %. В Великобритании и Ирландии отмечено сокращение на 28,8 %. В Бенилюксе и Северных странах продажи уменьшились на 3,6 %. Незначительная положительная динамика отмечена только на развивающихся рынках — плюс 2,0 % в годовом исчислении. В целом, сокращение выручки Atos связывает со снижением количества заказов и завершением ранее заключённых контрактов. Оценочная ликвидность составляла около €1,96 млрд по состоянию на 31 марта 2025 года по сравнению с €2,18 млрд на 31 декабря 2024-го. Несмотря на снижение продаж, компания заявляет о восстановлении коммерческой деятельности после завершения финансовой реструктуризации.

19.04.2025 [15:34], Сергей Карасёв

QNAP выпустила хранилище ES1686dc R2 на 16 SAS-накопителейКомпания QNAP Systems анонсировала стоечное сетевое хранилище ES1686dc R2 на аппаратной платформе Intel. Новинка, ориентированная на корпоративных заказчиков, обеспечивает высокую доступность и минимальное время простоя благодаря использованию двух контроллеров в режиме «активный — активный». Устройство выполнено в форм-факторе 3U. Во фронтальной части расположены 16 отсеков для накопителей LFF или SFF с интерфейсом SAS-3. Допускается горячая замена. Возможно формирование массивов RAID 0/1/5/6/10/50/60. Каждый из контроллеров в зависимости от модификации NAS несёт на борту процессор Xeon D-2142IT (8 ядер; 1,9–3,0 ГГц) или Xeon D-2123IT (4 ядра; 2,2–3,0 ГГц). Объём оперативной памяти DDR4 ECC в стандартной конфигурации составляет 32, 48 или 64 Гбайт на контроллер, что в сумме даёт 64, 96 или 128 Гбайт. Максимальная ёмкость ОЗУ достигает 512 Гбайт в конфигурации 8 × 64 Гбайт. Каждый контроллер располагает тремя сетевыми портами 1GbE RJ45, четырьмя портами 10GbE SFP+, двумя слотами PCIe 3.0 x8 и двумя портами USB 3.0. Новинка функционирует под управлением QES 2.2.1. Реализована поддержка протоколов CIFS/SMB2/SMB3, NFS v3/NFS v4.1, FTP, FTPS, TFTP, HTTP, HTTPS, SSH, iSCSI, Fibre Channel, SNMP, SMTP и SMSC. Возможно шифрование информации по алгоритму AES 256. Хранилище имеет размеры 132 × 446,2 × 587,75 мм и весит 30,22 кг без установленных накопителей. За питание отвечают два блока мощностью 700 Вт каждый. В системе охлаждения применяются вентиляторы со скоростью вращения до 16 000 об/мин. Диапазон рабочих температур — от 0 до +40 °C. На устройство предоставляется пятилетняя гарантия.

18.04.2025 [16:55], Руслан Авдеев

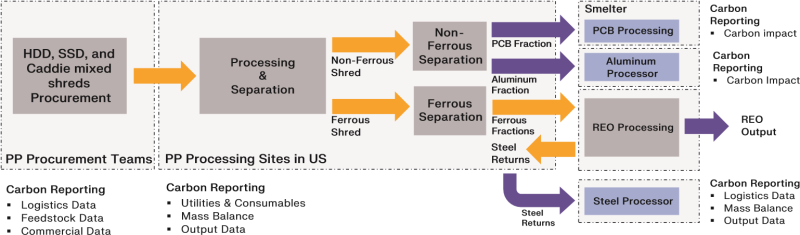

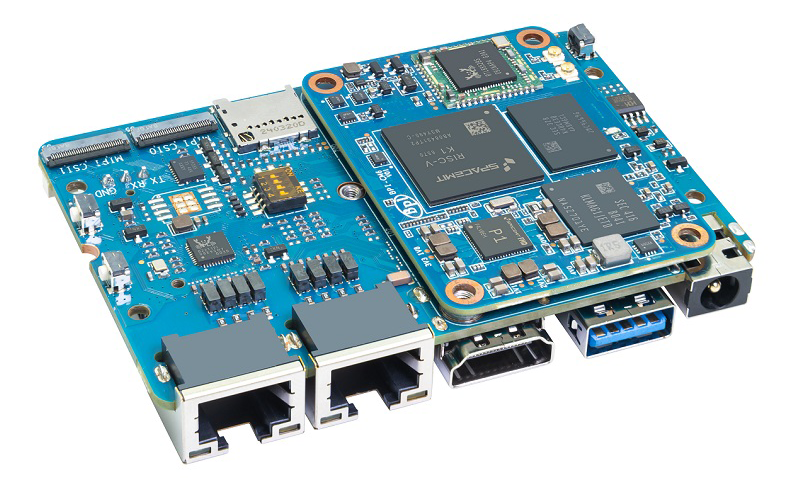

Western Digital запустила в США масштабную программу извлечения редкоземельных элементов из HDD — уже переработано почти 23 т дисков MicrosoftЖёсткие диски содержат ценные редкоземельные материалы (REE), в том числе неодим, празеодим и диспрозий. Традиционные методы утилизации позволяют восстанавливать только часть из этих материалов, а в некоторых случаях редкоземельные элементы и вовсе теряются. Пилотная программа с участием Western Digital, Microsoft, Critical Materials Recycling (CMR) и PedalPoint Recycling позволит изменить ситуацию, сообщает пресс-служба Western Digital. Компании совместно переработали уже более 22,5 т измельчённых списанных HDD, монтажных кронштейнов и прочих компонентов, собранных в дата-центрах Microsoft в США, в материалы критически высокой ценности. Передовая технология растворения без использования кислот, позволяет получать из старых HDD не только редкоземельные элементы, но и золото, медь, алюминий и сталь, возвращая их в американскую цепочку поставок и поддерживая отрасли, зависимые от таких элементов. Например, они применяются при выпуске электромобилей, ветрогенераторов и передовой электроники.

Источник изображений: Western Digital При масштабировании на весь мир, новый техпроцесс позволит возвращать элементы в больших объёмах на благо людей и планеты. На сегодня большинство первичного производства редкоземельных элементов (более 85 %) происходит за пределами США, а уровень переработки REE в стране ниже 10 %. Новый подход признан экономически целесообразным, поскольку позволяет извлечь приблизительно 90 % элементов, в том числе редкоземельных, которые можно переиспользовать. Передовые химические процессы совокупно с тщательным разделением компонентов позволяют системе перерабатывать до 80 % исходного сырья, превращая его в ценный актив. Этим полезность метода не ограничиваются — в сравнении с традиционными методами добычи и переработки металлов выбросы сокращаются на 95 %. Переработка на территории страны позволят минимизировать и выбросы, связанные с транспортировкой и повысить надёжность американской цепочки поставок, снижая зависимость от импортируемых материалов. Эффект от этого может быть весьма значительным, говоря партнёры. Программа позволяет снизить выбросы, связанные не только с дата-центрами, но и другими отраслями промышленности, где применяются редкоземельные элементы. По словам Western Digital, инициатива задаёт новый стандарт для переработки отслуживших своё накопителей. В Microsoft заявили, что пилотная программа продемонстрировала реальность устойчивой и экономически целесообразной переработки жёстких дисков, широко используемых в ЦОД Microsoft. Переработка методом безкислотного растворения (acid-free dissolution recycling, ADR) была создана Critical Materials Innovation (CMI) Hub. От разработки и до готовности метода к внедрению ушло восемь лет. В последнее время гиперскейлеры нарастили инвестиции в компании, занимающиеся утилизацией. Так, Microsoft инвестировала в Cyclic Materials — стартап, специализирующийся на переработке жёстких дисков. Seagate пришла к восстановлению и очистке б/у HDD. Lenovo готова продавать восстановленные ПК и серверы. Amazon создала фабрику по восстановлению и переработке собственного серверного оборудования, а Meta✴ и вовсе экспериментирует с технологиями утилизации строительных отходов с помощью грибов. Более того, в марте компания Bioscope Technologies заключила соглашение с Techbuyer, занимающейся восстановлением и перепродажей серверов и другого оборудования для дата-центров. На заводе Bioscope будут восстанавливать драгоценные или цветные металлы, используя процесс биовыщелачивания. Он предусматривает использование бактерий и позволяет восстанавливать из печатных плат широкий спектр металлов, включая золото, платину, палладий, серебро, медь и др.

18.04.2025 [15:17], Руслан Авдеев

Из-за политики США европейские пользователи задумались об уходе из американских облаковЕвропейские пользователи облачных сервисов становятся всё менее лояльны американским гиперскейлерам в условиях геополитической неопределённости — некоторые региональные европейские облака сообщают о росте спроса со стороны «соотечественников», сообщает The Register. После года «зацикливания» на ИИ-тематике, акцент сместился на обсуждение политики США. Даже до начала недавней, весьма опасной игры с пошлинами, европейские пользователи уже задавались вопросом, так ли необходимо включать базирующихся в США гиперскейлеров в свои бизнес-цепочки. По словам британского облачного провайдера CIVO, перемены происходят на удивление быстро — в компании всё ещё «ошеломлены» скоростью роста интереса к альтернативным облакам. Nextcloud говорит, что интерес к её сервисам вырос втрое, причём не только из-за действий самого президента США, но и его администрации в целом. В частности, Nextcloud обвиняет американскую сторону в «ненадёжности» и возможном росте цен из-за пошлин. Более того, на повестке появился даже фактор шпионажа — Илона Маска (Elon Musk) и департамент DOGE обвиняют в доступе к по-настоящему конфиденциальным базам (о том, что США регулярно следили даже за союзниками десятилетиями, не упоминается). Частный облачный оператор Vultr (американского происхождения) с площадками по всему миру тоже отметил рост интереса к суверенной инфраструктуре — правительства и организации желают знать, где хранятся, обрабатываются и резервируются их данные, как они используются. Теперь же опасения только усилились, поскольку нет ясности, как будут развиваться экономические отношения между сторонами. При этом уйти от гиперскейлеров непросто и на это могут уйти месяцы или даже годы, а приступать к переходу следует поэтапно, после того как найдутся альтернативные провайдеры. Впрочем, в Nextcloud сообщают, что некоторые организации, которым «по-настоящему угрожает» американский режим, запросили компанию о более быстром переходе. В Open Infrastructure Foundation подтверждают, что интерес к альтернативным облакам действительно резко вырос, хотя до этого разговоры о переходе велись годами. Ситуацию некоторые эксперты сравнили с покупкой VMware в 2023 году, когда для многих клиентов последней цена лицензий значительно выросла и отголоски до сих пор ощущаются в IT-индустрии, а многие клиенты начали лихорадочно искать альтернативы. Многие эксперты уверены, что с правильной мотивацией переход от американских гиперскейлеров вполне возможен, а мотивация именно сейчас как раз присутствует. Конечно, интерес ещё не значит, что все, выразившие его, обязательно мигрируют к европейским облачным провайдерам, но саму тенденцию уже невозможно не замечать. В октябре 2024 года сообщалось, что Евросоюзу не хватает мощностей ЦОД для обретения суверенного ИИ. Впрочем, строительством суверенных облаков для Европы занялись как гиперскейлеры вроде AWS и Microsoft, так и местные игроки, развивающие, например, суверенную платформу Virt8ra. |

|