Материалы по тегу: сервер

|

04.03.2026 [15:57], Руслан Авдеев

Amazon увеличит инвестиции в ИИ ЦОД в Испании до €33,7 млрд и откроет завод по выпуску ИИ-серверовAmazon объявила о намерении увеличить инвестиции в расширение и поддержку инфраструктуры ЦОД в Испании до €33,7 млрд ($39,8 млрд). Компания выделит ещё €18 млрд в дополнение к анонсированным в 2024 году €15,7 млрд инвестиций. В целом инвестиции AWS в Арагоне должны к 2035 году увеличить местный ВВП на €18,5 млрд, а Испании в целом — на €31,7 млрд. Инвестиции также обеспечат около 6,7 тыс. рабочих мест, из них 4,2 тыс. — в регионе, считает Amazon. Также планируется построить в Арагоне элементы цепочки поставок, напрямую поддерживающие работу дата-центров в Испании и Европе в целом: завод для завершения сборки и испытаний серверов, склад продукции, предприятие по выпуску и ремонту ИИ-серверов и др. Это ключевые объекты для стратегии «экономики замкнутого цикла» Amazon. Со времени прихода в Испанию в 2011 году компания инвестировала в страну более €20 млрд — в розничные операции, логистику, облачную и ИИ-инфраструктуру, программы развития местных сообществ, инновации и др. В ноябре 2022 года компания запустила в Испании облачный регион AWS Europe. До 2035 года Amazon намерена вложить в местные общественные программы €30 млн, с особым акцентом на образование, устойчивое развитие, локальные инициативы и др. С 2023 года компания поддержала более 100 общественных программ и инициатив в Арагоне. На национальном уровне с 2017 года компания обучила базовым цифровым навыкам более 200 тыс. человек. К 2027 году компания при содействии Министерства образования Испании намерена обучить 500 тыс. студентов навыкам работы с ИИ и цифровыми технологиями.

Источник изображения: Pedro Sanz/unsplash.com Amazon взяла на себя обязательства добиться нулевых углеродных выбросов к 2040 году. Чтобы обеспечить работу ЦОД за счёт возобновляемой энергии и поддержать расширенную облачную инфраструктуру, компания инвестирует в 100 проектов на территории Испании, связанных с солнечной и ветряной энергетикой, включая семь новых солнечных электростанций. В Арагоне электроснабжение ЦОД с момента запуска в 2022 году на 100 % компенсируется за счёт возобновляемой энергии. Кроме того, к 2030 году Amazon намерена стать «водно-положительной», возвращая больше воды, чем используется в её деятельности. В 2024 году AWS уже на 53 % достигла этой цели. В Арагоне компания оказывает поддержку пяти проектам водосбережения, борьбы с наводнениями и максимизации урожайности на общую сумму €17,2 млн, в том числе с использованием ИИ-инструментов компании. Дата-центры AWS стимулируют и экономический рост регионов присутствия, создавая возможности для местных поставщиков товаров и услуг и трудоустройства, что позволяет Арагону в перспективе стать одним из ключевых европейских цифровых хабов, говорит Amazon. AWS станет первой технологической компанией, объявившей о строительстве ЦОД в провинции Теруэль (Teruel), а также новых объектов в Уэске (Huesca) и Сарагосе (Zaragoza). Это позволяет внедрять передовые облачные решения во всех трех провинциях Арагона, создавать новые рабочие места и возможности для бизнеса. В 2025 году ЦОД Испании и Португалии успешно пережили крупнейший блэкаут в истории стран — правда, видимого ущерба пользователи не понесли, хотя телеком-инфраструктура пострадала гораздо серьёзнее. Впрочем, это не останавливает инвестиции. В конце 2025 года появилась информация о намерении Vantage вложить €3,2 млрд в кампус ЦОД в Сарагосе.

03.03.2026 [14:27], Руслан Авдеев

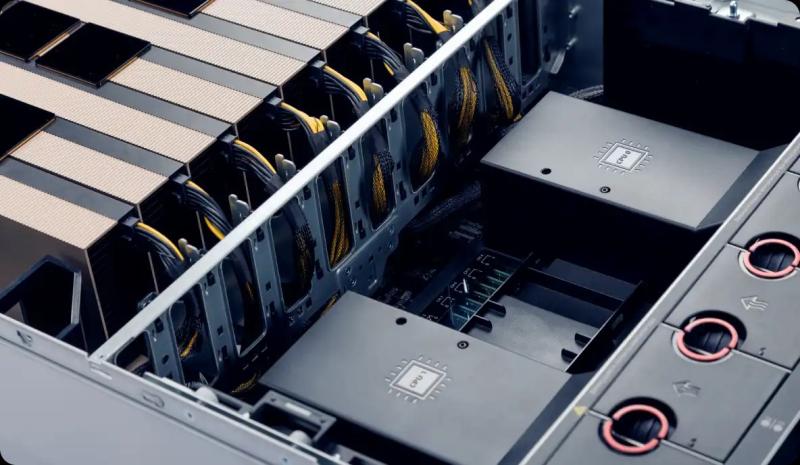

Сделано в США: Flex начала выпуск американских ИИ-серверов с AMD InstinctАмериканская производственная компания Flex, поставляющая решения для дата-центров, анонсировала расширение стратегического сотрудничества с AMD для выпуска решений на платформе Instinct. По словам Flex, это важная веха на пути укрепления локального производства на территории США, в том числе передовых ИИ- и HPC-продуктов. В рамках партнёрства выпуск платформы AMD Instinct MI355X организован на территории головного подразделения Flex в Остине (Техас). В следующем квартале объёмы выпуска должны увеличиться. Речь идёт не только о платформе текущего поколения, компания намерена поддержать выпуск и новых платформ Instinct для удовлетворения спроса со стороны крупномасштабных ИИ-проектов. Сейчас Flex выпускает высокоплотные системы с восемью ускорителями и сопутствующей обвязкой. Каждая платформа, как утверждают в компании, проходит строгие заводские испытания и оценку. Системы оснащаются СЖО JetCool, принадлежащей Flex. По данным производителя, комбинация передовых индустриальных мощностей Flex, надёжной цепочки поставок и производственных мощностей в США с передовыми позициями AMD в HPC-сегменте позволяет клиентам масштабировать свои ИИ-проекты быстрее и с повышенной надёжностью. Головная структура Flex в Техасе занимает площадь более 130 тыс. м2 и создана для поддержки комплексного производства в больших объёмах. Всего у Flex в США есть более 650 тыс. м2 площадей на 17 объектах.

Источник изображения: Flex Планы AMD по локализации производства включают и выпуск чипов на американских фабриках TSMC. NVIDIA идёт по тому же пути, но в части выпуска или хотя бы сборки серверов на территории США, в том числе для обслуживания гиперскейлеров, у неё гораздо больше возможностей. Но и AMD укрепила свои позиции в этой области в результате сделки с ZT Systems и Sanmina. США всеми силами стремятся локализовать производство и разработки на своей территории. В декабре 2025 года было объявлено о заключении партнёрских отношений с 24 ведущими IT-компаниями в рамках «Миссии Генезис», призванной стимулировать ИИ-разработки и производство на американской территории. Например, в конце января 2026 года сообщалось, что Corning построит крупнейшее в мире производство оптоволоконного кабеля для ЦОД в рамках сделки с Meta✴ на $6 млрд.

03.03.2026 [14:10], Сергей Карасёв

Gigabyte представила ИИ-сервер G893-ZX1-AAX4 на базе AMD Instinct MI355XGigabyte Technology анонсировала сервер G893-ZX1-AAX4, предназначенный для выполнения ресурсоёмких задач, таких как ИИ-инференс, сложное моделирование и пр. Новинка построена на аппаратной платформе AMD. Устройство типоразмера 8U рассчитано на два процессора EPYC 9005 Turin или EPYC 9004 Genoa в исполнении Socket SP5 (LGA 6096) с показателем TDP до 500 Вт. Доступны 24 слота для модулей оперативной памяти DDR5-4800/6400. Во фронтальной части расположены восемь отсеков для SFF-накопителей с интерфейсом PCIe 5.0 (NVMe). Кроме того, есть два внутренних коннектора для SSD формата M.2 2280/22110 с интерфейсом PCIe 3.0 x4 и PCIe 3.0 x1. Реализованы восемь разъёмов PCIe 5.0 x16 для однослотовых карт расширения FHHL и четыре разъёма PCIe 5.0 x16 для двухслотовых карт FHHL. В оснащение входят восемь ускорителей AMD Instinct MI355X OAM. Применяется полностью воздушное охлаждение с 15 вентиляторами диаметром 80 мм в области GPU-лотка, шестью кулерами на 60 мм в зоне материнской платы и четырьмя вентиляторами диаметром 80 мм в секции PCIe. Питание обеспечивают 12 блоков мощностью 3000 Вт каждый с сертификатом 80 PLUS Titanium.

Источник изображения: Gigabyte Technology Сервер оборудован контроллером ASPEED AST2600, двумя сетевыми портами 10GbE на базе Intel X710-AT2 (RJ45), выделенным сетевым портом управления 1GbE (RJ45), двумя портами USB 3.2 Gen1 (5 Гбит/с), аналоговым разъёмом D-Sub. Диапазон рабочих температур — от +10 до +30 °C. Габариты составляют 447 × 351 × 923 мм.

03.03.2026 [10:50], Сергей Карасёв

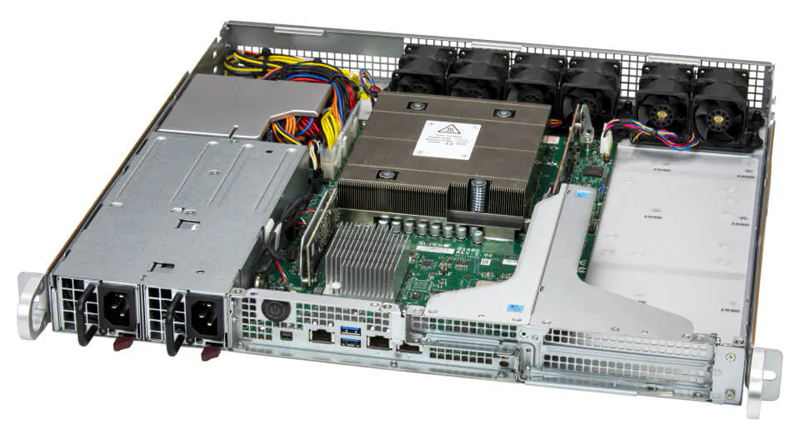

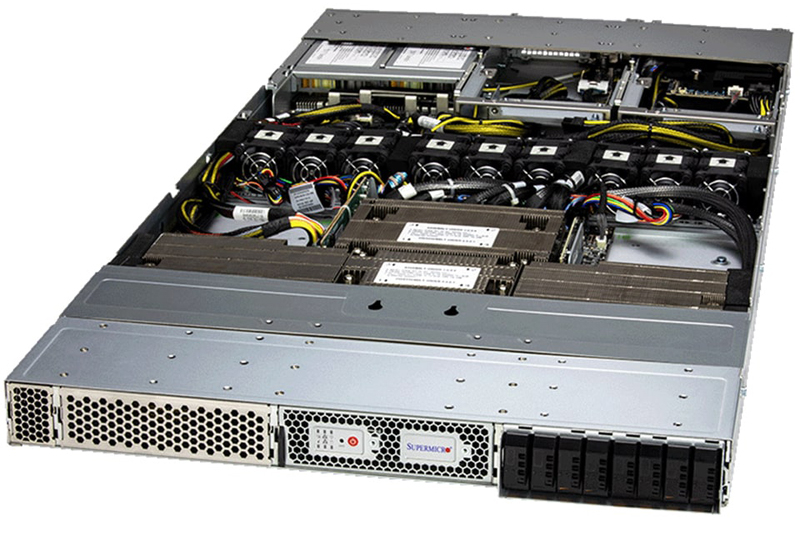

Supermicro представила серверы на базе NVIDIA Grace для инфраструктур AI-RANSupermicro анонсировала серверы на платформе NVIDIA Grace, ориентированные на применение в составе систем AI-RAN. Дебютировали устройства ARS-111L-FR, ARS-221GL-NR и ARS-111GL-NHR, использующие дизайн NVIDIA Aerial RAN Computer (ARC). Модель ARS-111L-FR выполнена в форм-факторе 1U. Задействован один чип NVIDIA Grace, объединяющий 72 вычислительных ядра Arm Neoverse V2 (Armv9). Говорится об использовании 240 Гбайт памяти LPDDR5X. Возможна установка двух ускорителей NVIDIA L4. Сервер оборудован двумя коннекторами M.2 для NVMe SSD с интерфейсом PCIe 5.0 x4, двумя посадочными местами для SFF-накопителей NVMe, двумя слотами для карт PCIe 5.0 x16 FHFL, одним разъёмом PCIe 5.0 x16 HHHL, портами 1GbE (RJ45), USB 3.2 Gen1 (5 Гбит/с) и mini-DP. Могут устанавливаться два блока питания мощностью до 800 Вт с сертификатом 80 Plus Titanium.

Источник изображений: Supermicro Устройство ARS-221GL-NR, в свою очередь, заключено в корпус 2U. Используется сборка Grace Superchip, которая состоит из двух кристаллов Grace и чипов памяти LPDDR5x общим объёмом до 960 Гбайт. Во фронтальной части располагаются отсеки для NVMe-накопителей E1.S с возможностью горячей замены. Есть два разъёма M.2 M-key 22110 для SSD с интерфейсом PCIe 5.0 x4 (NVMe), три слота для карт PCIe 5.0 x16 FHFL и два слота для карт PCIe 5.0 x16 FHFL двойной ширины. Реализованы порты 1GbE (RJ45), USB 3.0 Type-A (×2) и mini-DP. Питание обеспечивают три блока на 2000 Вт с сертификатом 80 Plus Titanium.  Сервер ARS-111GL-NHR типоразмера 1U несёт на борту NVIDIA GH200. Могут быть установлены до восьми NVMe-накопителей E1.S и два NVMe SSD формата M.2. Доступны два слота для карт PCIe 5.0 x16 FHFL, порты 1GbE (RJ45), USB 3.0 и mini-DP. За питание отвечают два блока мощностью 2000 Вт с сертификатом 80 Plus Titanium. Все новинки оснащены воздушным охлаждением.

28.02.2026 [11:43], Сергей Карасёв

Supermicro представила высокоплотную платформу MicroBlade на базе AMD EPYC 4005Компания Supermicro анонсировала новую серверную платформу MicroBlade для облачных и периферийных развёртываний. Система, как утверждается, на сегодняшний день обладает самой высокой плотностью компоновки из всех доступных решений, использующих процессоры AMD EPYC 4005 Grado. Основой MicroBlade служат узлы MBA-315R-1DE12, рассчитанные на чипы в исполнении AM5 (LGA-1718). Могут применяться процессоры с TDP до 110 Вт, насчитывающие до 16 вычислительных ядер (32 потока инструкций). В расчёте на процессор доступны два слота для модулей оперативной памяти DDR5-5600 суммарным объёмом до 128 Гбайт. Каждый узел оснащается контроллером Aspeed AST2600 BMC, двумя сетевыми портами 25GbE на базе Broadcom BCM57414, а также модулем TPM 2.0, отвечающим за безопасность. Возможна установка одного SSD формата M.2 (NVMe) и двух накопителей EDSFF E1.S. Диапазон рабочих температур — от +10 до +35 °C. Габариты составляют 589,28 × 125,48 × 30,48 мм, масса — около 1,5 кг. Новая платформа поддерживает до 40 узлов в одном корпусе форм-фактора 6U. Таким образом, в серверной стойке 48U могут разместиться до 320 узлов. Supermicro подчёркивает, что это обеспечивает «беспрецедентную вычислительную плотность, энергоэффективность и экономичность для масштабируемых и многопользовательских сред». Решение MicroBlade подходит для широкого спектра нагрузок, среди которых названы виртуальные частные серверы, периферийные системы, микросервисы, службы обработки данных, приложения в области кибербезопасности, площадки электронной коммерции и пр.

28.02.2026 [09:48], Сергей Карасёв

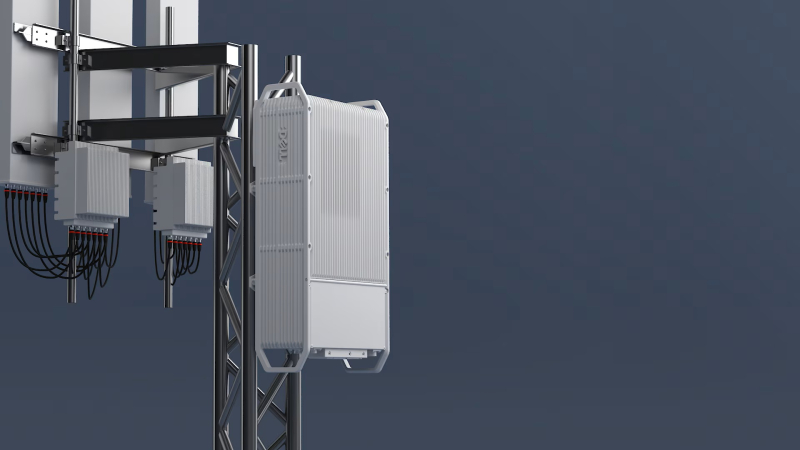

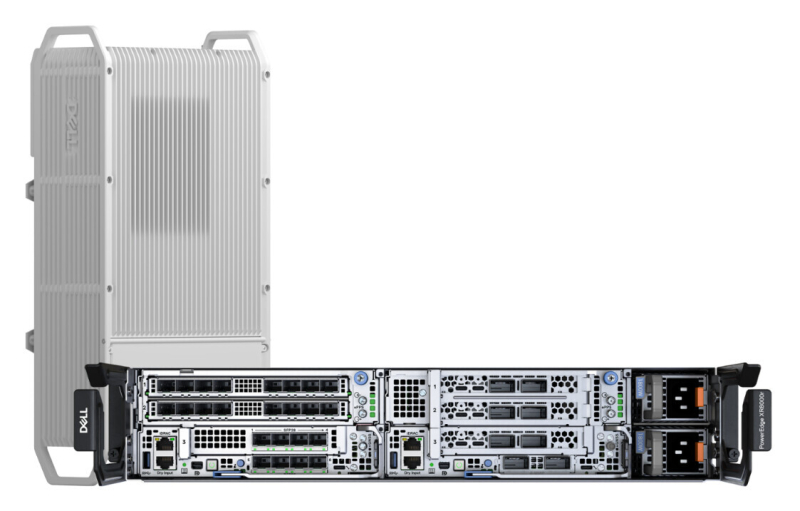

Dell представила подвесной уличный сервер PowerEdge XR9700 с замкнутой СЖОDell анонсировала сервер PowerEdge XR9700, предназначенный для инфраструктур Cloud RAN и ИИ-приложений на периферии. Устройство рассчитано на эксплуатацию в неблагоприятных условиях, в том числе на открытом воздухе: оно может монтироваться на опорах линий электропередач, крышах и фасадах зданий. Новинка заключена в корпус объёмом около 15 л. Говорится о сертификации IP66 и GR-3108 Class 4: серверу не страшны пыль, влага и воздействие прямого солнечного излучения. Диапазон рабочих температур простирается от -40 до +46 °C. В основу PowerEdge XR9700 положена аппаратная платформа Intel Xeon 6 SoC — Granite Rapids-D (до 72 P-ядер, TDP до 325 Вт). Также возможна установка ИИ-ускорителей и различных сетевых карт, в том числе для обработки L1-трафика. Задействована система жидкостного охлаждения с замкнутым контуром, а ребристая внешняя поверхность работает в качестве радиатора. Без СЖО с таким уровнем тепловыделения CPU/GPU и в таком компактном корпусе уже вряд ли можно обойтись. Отмечается, что с технической точки зрения устройство идентично модели PowerEdge XR8720t, которая дебютировала в октябре прошлого года. В зависимости от конфигурации это решения располагает четырьмя или восемью слотами для модулей DDR5. Возможна установка до трёх SSD формата M.2 (NVMe). В оснащение могут входить два порта 100GbE QSFP и восемь портов 10/25GbE SFP. Реализованы интерфейсы USB 3.0 Type-A, UCB Type-C, Mini-DisplayPort и пр. Заявлена поддержка Wind River SUSE Linux Enterprise Server/RT, Ubuntu Server LTS и Red Hat Enterprise Linux/RT. Интегрированный контроллер удалённого доступа Dell (iDRAC) обеспечивает мониторинг и управление. Говорится о совместимости с существующим набором решений для периферийных вычислений в области телекоммуникаций. В продажу PowerEdge XR9700 поступит во II половине текущего года.

22.02.2026 [15:58], Владимир Мироненко

Российский бизнес распробовал ИИ: рынок ИИ-серверов достиг 60 млрд рублейВ 2025 году в России на закупку ИИ-серверов компании потратили около 60 млрд руб., без учёта аренды вычислительных мощностей, обслуживания и модернизации сообщил коммерческий директор YADRO (входит в «ИКС холдинг») Александр Бакулин на цифровом форуме «Инфраструктурные вызовы для развития ИИ в России» в рамках Недели российского бизнеса, о чём пишут «Ведомости». Он добавил, что рынок находится «в стадии перелома» — за последние два года ИИ перестал быть «надстройкой» над IT-инфраструктурой, а стал менять правила проектирования вычислительных систем. Формируется новая инфраструктурная ниша, сравнимая с энергетикой и телекоммуникациями. Ключевые заказчики переходят от экспериментов к промышленной эксплуатации, начинают встраивать решение машинного обучения больших языковых моделей в свои бизнес-процессы и планы. И при этом на ИИ наблюдается большой спрос, сообщил Бакулин. По словам Бакулина, мировой рынок ИИ-серверов, который во многом формируют облачные провайдеры и крупные технологические компании, оценивается в сотни миллиардов долларов, демонстрируя устойчивую высокую динамику. Как и на мировом рынке основной спрос в России формируют крупные компании, работающие с большими массивами данных и развивающие собственные языковые модели, например крупные игроки e-commerce, финтеха и интернет-сервисов. Ранее «АТК консалтинг» сообщила, что закупки программных продуктов с ИИ в 2025 выросли год к году в 7,4 раза до 1,8 млрд руб. Как отметили тогда «Ведомости», рынок «железа» для ИИ в деньгах вырос значительно больше. В частности, это связано с подорожанием чипов памяти, на которую в современных серверах может приходиться до двух третей себестоимости. В «Группе Астра» считают, что 60 млрд руб. на ИИ-серверы звучит реалистично, но важнее динамика. Так, совокупный российский рынок серверов и СХД в 2025 году в целом составил 280 млрд руб. против 155 млрд руб. в 2024-м, сообщали «Ведомости» со ссылкой на данные YADRO и Fplus. Наибольшая часть рынка — около 55–60 % от суммы — пришлась на госзакупки по 44-ФЗ и 223-ФЗ, уточнили тогда в YADRO. По оценкам «Группы Астра», к концу 2026 года госзакупки, связанные с ИИ, вырастут на 20–30 %, а год к году — вполовину. Рынок действительно идёт к промышленной эксплуатации ИИ, считают в ЦКНТИ по направлению «Технологии хранения и анализа больших данных» МГУ, отметив, что банки, телеком, ретейл встраивают ИИ-модели в скоринг, поддержку, операционные процессы. До конца года рынок может вырасти за счёт дооснащения и повторных закупок, а год к году — на 25–40 %, если не будет жёстких ограничений по поставкам ускорителей и финансированию.

19.02.2026 [12:26], Сергей Карасёв

«НВБС» представила российские серверы «Необайт» на платформах Intel и AMDКомпания «НВБС», российский системный интегратор и производитель технологических решений, анонсировала собственные серверы семейства «Необайт». Дебютировали модели NeoByte NBR220 и NeoByte NBR680 на аппаратной платформе Intel, а также NeoByte NBR685 с процессорами AMD. По словам компании, новинки «сопоставимы с решениями ведущих компаний на рынке, но при этом в среднем стоят на 10–15 % дешевле за счёт широкого пула поставщиков и оптимизированной логистики». Система NeoByte NBR220 типоразмера 2U может нести на борту два чипа Intel Xeon Sapphire Rapids или Emerald Rapids с показателем TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти DDR5-4800. В зависимости от конфигурации во фронтальной части возможна установка 12 накопителей LFF/SFF или 24 устройств SFF с интерфейсом SATA/SAS/NVMe. В тыльной зоне корпуса расположены посадочные места ещё для четырёх накопителей LFF/SFF (SATA/SAS/NVMe), тогда как внутри есть два коннектора для SSD формата M.2 (SATA/NVMe). Реализована поддержка до 10 стандартных слотов PCIe и одного слота OCP 3.0. В оснащение входят контроллер AST2600, два сетевых порта 1GbE, выделенный сетевой порт управления 1GbE, четыре порта USB 3.0 (по два спереди и сзади), два интерфейса D-Sub (по одному спереди и сзади) и последовательный порт. Питание обеспечивают два блока с резервированием мощностью 800/1300/1600/2000 Вт. Сервер оптимизирован для ИИ-задач, виртуализации, баз данных и файловых хранилищ. Платформа практически идентична представленным ранее серверам «Аквариус» AQserv T50 D224RS и T50 D212RS. Модель NeoByte NBR680 стандарта 6U имеет аналогичные характеристики подсистем CPU, ОЗУ, хранения данных и интерфейсов ввода/вывода. При этом возможна установка до восьми GPU-ускорителей двойной ширины. Есть пять стандартных слотов PCIe и один слот OCP; передняя панель поддерживает до трёх стандартных слотов PCIe и один слот OCP. Мощность каждого из двух блоков питания — 2700 или 3200 Вт. Машина предназначена для научных исследований и крупных ИИ-проектов. В свою очередь, GPU-сервер NeoByte NBR685 формата 6U рассчитан на два процессора AMD EPYC 9005 Turin или EPYC 9004 Genoa с показателем TDP до 500 Вт. Предусмотрены 24 слота для модулей оперативной памяти DDR5-4800. Прочие характеристики идентичны версии NeoByte NBR680, включая поддержку восьми GPU-ускорителей двойной ширины. Система подходит для анализа больших данных в реальном времени, криптографии и блокчейна. Все новинки могут быть опционально укомплектованы контроллером SAS RAID/HBA. Заявлена совместимость с Windows Server 2022 SLES 12.5 и выше, RHEL7.8 и выше, Ubuntu18.04 и выше, CentOS7.6 и выше, Vmware ESXi 7.0 GA и выше. Гарантия производителя достигает пяти лет. Также «НВБС» говорит, что «не зависит от санкций, что снижает риски ограничения поставок».

16.02.2026 [16:15], Сергей Карасёв

Oxide Computer готовит блейд-платформу на базе AMD EPYC TurinКомпания Oxide Computer, по сообщению The Register, провела раунд финансирования Series C, в ходе которого на дальнейшее развитие привлечено $200 млн. Стартап планирует направить средства в том числе на создание новой стоечной платформы на аппаратной платформе AMD EPYC 9005 Turin. Oxide Computer основана в 2019 году группой бывших инженеров Joyent и Sun Microsystems. Стартап занимается разработкой оборудования для дата-центров. При этом в качестве новой вычислительной единицы компания рассматривает целую стойку, а не отдельный сервер. Система Oxide Computer первого поколения несёт на борту 32 вычислительных модуля, оснащённых чипами AMD EPYC 7713P (Milan). Каждый модуль содержит 64 ядра CPU, до 1 Тбайт DDR4-3200 и 10 NMVe-накопителей U.2 суммарной вместимостью 32 Тбайт. Применённая объединительная плата обеспечивает питание и коммутационную способность до 12,8 Тбит/с. Общее энергопотребление стойки находится на уровне 15 кВт.

Источник изображения: Oxide Computer По словам генерального директора Oxide Computer Стива Така (Steve Tuck), компания проектирует обновлённую версию своей стоечной системы, в которую будут устанавливаться процессоры EPYC поколения Turin. Такие чипы насчитывают до 192 вычислительных ядер. Говорится об использовании памяти DDR5-6400. Вкупе это даст значительный прирост производительности по сравнению с оригинальной машиной. Важным преимуществом Turin является поддержка инструкций AVX-512, предназначенных для ускорения ресурсоёмких вычислений, таких как обработка больших массивов данных, задачи ИИ и пр. Какие именно модели процессоров будут задействованы в новых серверных модулях, Так уточнять не стал. Кроме того, Oxide Computer рассматривает возможность перехода на новые коммутационные решения, которые в перспективе придут на смену ныне применяющимся изделиям Intel Tofino 2. Одним из вариантов является чип-коммутатор Xsight Labs X2, обеспечивающий пропускную способность до 12,8 Тбит/с. При этом изучаются и другие альтернативы. Oxide Computer также не исключает, что в будущем начнёт оснащать свои системы ИИ-ускорителями на базе GPU.

14.02.2026 [12:12], Сергей Карасёв

Сделано в Японии: Fujitsu организует производство суверенных ИИ-серверовКорпорация Fujitsu с марта текущего года начнёт выпускать в Японии суверенные серверы, ориентированные на задачи ИИ и другие ресурсоёмкие нагрузки. Такие системы с маркировкой «Made in Japan» будут выпускаться на предприятии Fujitsu Group в Касасиме (Kasashima) по полному циклу. Fujitsu отмечает, что геополитическая напряжённость, усиливающиеся киберугрозы и более жёсткие требования регулирующих органов приводят к необходимости усиления защиты критически важной информации. В Японии, в частности, в рамках Закона о содействии экономической безопасности управление системными рисками и цифровой суверенитет имеют первостепенное значение для клиентов, работающих с критической информационной инфраструктурой (КИИ). С целью удовлетворения растущего спроса на суверенные решения Fujitsu организует в Японии выпуск серверов, оборудованных ускорителями NVIDIA HGX B300 и NVIDIA RTX Pro 6000 Blackwell Server Edition. Кроме того, до конца 2026 финансового года (заканчивается 31 марта 2027-го) корпорация освоит производство систем на основе фирменных чипов Fujitsu Monaka, которые насчитывают до 144 вычислительных ядер с архитектурой Arm.

Источник изображения: Fujitsu Подчёркивается, что при изготовлении суверенных серверов завод Fujitsu Group будет использовать опыт, полученный при создании суперкомпьютера Fugaku и других высоконадёжных систем. Интегрированный процесс производства охватывает все этапы — от получения печатных плат до сборки устройств, что обеспечит полную отслеживаемость и прозрачность. Продукцию «Made in Japan» планируется поставлять на местный рынок, а также европейским заказчикам. Кром того, Fujitsu расширит сотрудничество с Supermicro для обеспечения непрерывного планирования, разработки, производства, продаж и технического обслуживания ИИ-серверов. В конце 2020 года «белую сборку» серверов наладила в США HPE. Эти машины тоже ориентированы в первую очередь на заказчиков из госсектор, а не обычных потребителей. |

|