Лента новостей

|

19.03.2024 [01:13], Сергей Карасёв

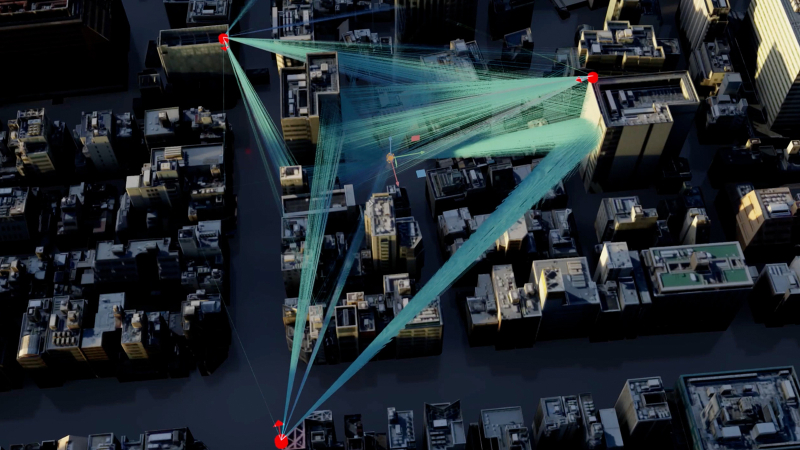

NVIDIA представила облачную платформу для исследований в сфере 6GКомпания NVIDIA анонсировала облачную исследовательскую платформу 6G Research Cloud, которая призвана помочь в разработке технологий связи следующего поколения. В число первых пользователей и партнёров по экосистеме вошли Ansys, Швейцарская высшая техническая школа Цюриха (ETH Zurich), Fujitsu, Keysight, Nokia, Северо-Восточный университет (Northeastern University), Rohde & Schwarz, Samsung, SoftBank и Viavi. Утверждается, что 6G Research Cloud предоставляет комплексный набор инструментов для внедрения ИИ в области сетей радиодоступа (RAN). NVIDIA отмечает, что платформа позволяет организациям ускорить развитие сервисов 6G, которые соединят «триллионы устройств» с облачными инфраструктурами, заложив основу для гиперинтеллектуального мира. NVIDIA 6G Research Cloud состоит из трёх ключевых компонентов. Это, в частности, подсистема NVIDIA Aerial Omniverse Digital Twin for 6G: специализированный «цифровой двойник», позволяющий физически точно моделировать системы 6G — от одной башни до масштабов целого города. Двойник включает в себя программно-определяемые симуляторы RAN и пользовательского оборудования, а также набор реалистичных свойств местности и объектов. Используя систему, исследователи смогут моделировать и создавать алгоритмы работы базовой станции на основе данных, специфичных для конкретной площадки, а также обучать модели в режиме реального времени для повышения эффективности передачи информации. Ещё один компонент называется NVIDIA Aerial CUDA-Accelerated RAN: это программно-определяемый стек RAN, который предназначен для настройки, программирования и тестирования сетей 6G в режиме реального времени. Третьим элементом является фреймворк NVIDIA Sionna Neural Radio Framework, обеспечивающий бесшовную интеграцию с популярными платформами, такими как PyTorch и TensorFlow. При этом задействованы ускорители NVIDIA на базе GPU для генерации и сбора данных, а также обучения моделей ИИ. Исследователи могут применять NVIDIA 6G Research Cloud для реализации различных проектов в сфере 6G. Это могут быть сервисы для автономного транспорта, интеллектуальных пространств, расширенной реальности, иммерсивного обучения, коллективной работы и пр.

19.03.2024 [01:06], Сергей Карасёв

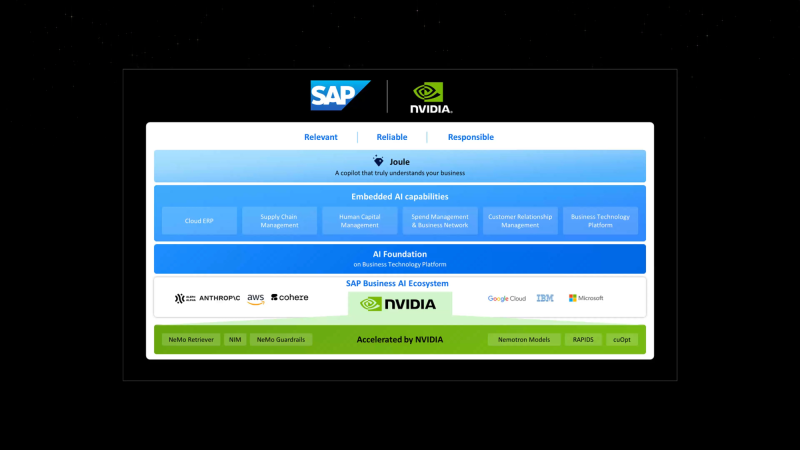

SAP и NVIDIA ускорят внедрение генеративного ИИ в корпоративные приложенияКомпании NVIDIA и SAP объявили о расширении сотрудничества с целью ускорения внедрения генеративного ИИ в корпоративном секторе. Стороны намерены совместно развивать платформу SAP Business AI, включая масштабируемые приложения, специфичные для бизнес-сферы. Речь, в частности, идёт об облачных решениях SAP. Кроме того, будут развиваться функции генеративного ИИ в составе помощника Joule, который был представлен осенью прошлого года. Его планируется интегрировать практически во все программные продукты SAP для упрощения процесса работы и оптимизации выполнения различных задач. Отмечается, что ИИ-помощник Joule следующего поколения может быть развёрнут на площадке гиперскейлеров или в собственном облаке SAP. Он поможет клиентам раскрыть потенциал своего бизнеса, автоматизируя трудоёмкие задачи и быстро анализируя критически важные корпоративные данные. Кроме того, генеративный ИИ поможет ABAP-разработчикам. В рамках партнёрства SAP будет использовать инструменты NVIDIA для точной настройки больших языковых моделей (LLM) для конкретных сценариев развёртывания. SAP и NVIDIA планируют представить новые интегрированные ИИ-возможности к концу 2024 года. Они затронут такие продукты, как SAP Datasphere, SAP Business Technology Platform (SAP BTP) и пр. SAP планирует задействовать облачный ИИ-сервис NVIDIA DGX Cloud AI, программное обеспечение NVIDIA AI Enterprise и базовые модели NVIDIA. В целом, SAP и NVIDIA изучают более 20 вариантов использования генеративного ИИ, в том числе для упрощения и улучшения цифровой трансформации. Это, в частности, автоматизация планирования ресурсов предприятия с помощью интеллектуального сопоставления счетов в SAP S/4HANA Cloud, улучшение сценариев использования ресурсов с помощью SAP SuccessFactors и др.

19.03.2024 [01:02], Сергей Карасёв

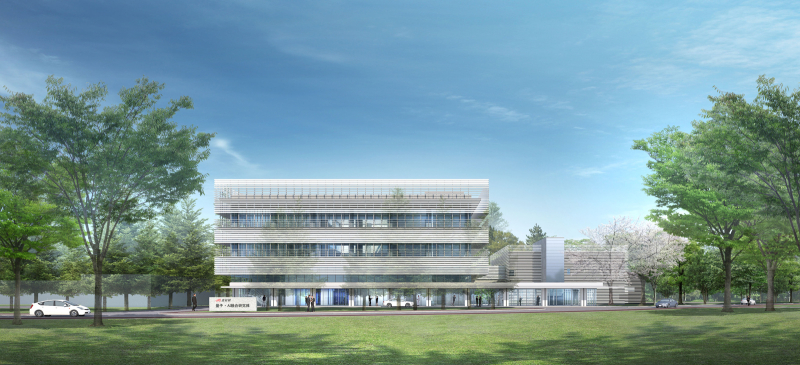

Ускорители NVIDIA H100 лягут в основу японского суперкомпьютера ABCI-Q для квантовых вычисленийКомпания NVIDIA сообщила о том, что её технологии лягут в основу нового японского суперкомпьютера ABCI-Q, предназначенного для проведения исследований в области квантовых вычислений. Платформа, в частности, будет использоваться для тестирования гибридных систем, объединяющих классические и квантовые технологии. Развёртыванием комплекса займётся корпорация Fujitsu. Машина расположится в суперкомпьютерном центре ABCI (AI Bridging Cloud Infrastructure) Национального института передовых промышленных наук и технологий Японии (AIST). Ввод ABCI-Q в эксплуатацию намечен на начало 2025 года. В состав суперкомпьютера войдут более 500 узлов, насчитывающих в общей сложности свыше 2000 ускорителей NVIDIA H100. Говорится о применении интерконнекта NVIDIA Quantum-2 InfiniBand, а также NVIDIA CUDA Quantum — открытой платформы для интеграции и программирования CPU, GPU и квантовых процессоров (QPU). Комплекс ABCI-Q проектируется с прицелом на возможность добавления будущих аппаратных компонентов для квантовых вычислений. Ожидается, что ABCI-Q позволит проводить высокоточное квантовое моделирование в рамках исследовательских проектов в различных отраслях. Учёные смогут тестировать приложения нового типа с целью ускорения их практического внедрения. Кроме того, специалисты смогут прорабатывать передовые алгоритмы для решения специфичных задач. NVIDIA и AIST также планируют сотрудничать при разработке промышленных приложений на базе ABCI-Q. В целом, ABCI-Q является частью стратегии Японии в области квантовых технологий, задачей которой является создание новых возможностей для бизнеса и общества, а также получение выгоды от квантовых технологий, в том числе посредством исследований в области ИИ, энергетики и биологии.

19.03.2024 [01:01], Сергей Карасёв

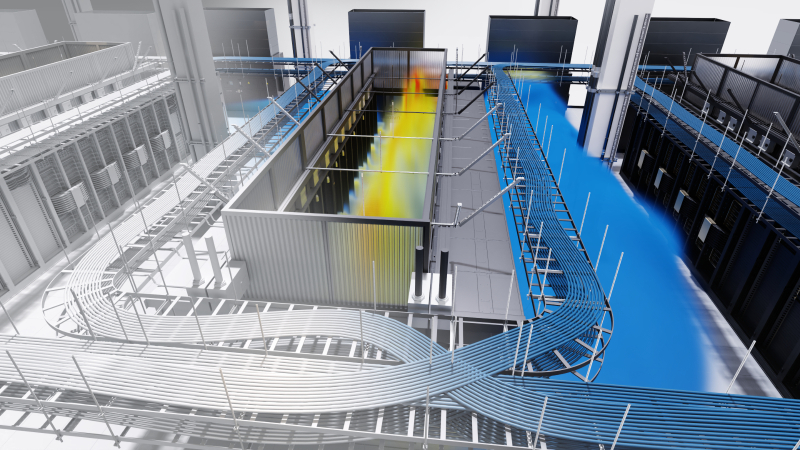

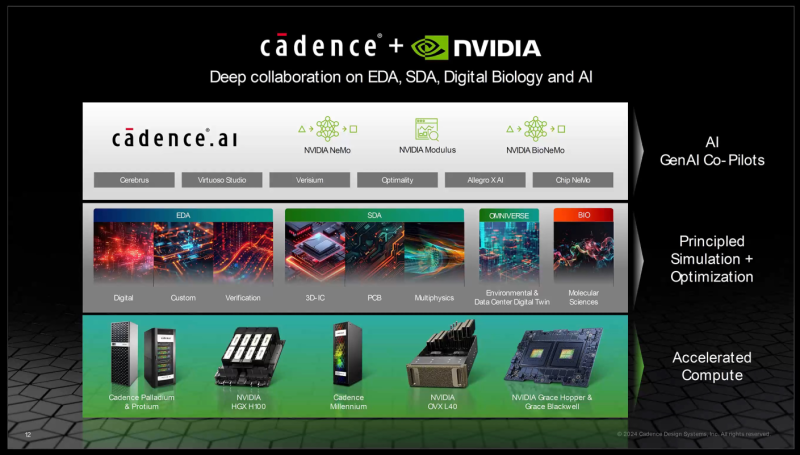

NVIDIA показала цифрового двойника нового дата-центра с ИИ-ускорителями BlackwellКомпания NVIDIA на конференции GTC 2024 приоткрыла завесу тайны над новым вычислительным кластером, предназначенным для решения ресурсоёмких задач в области ИИ. Полностью работоспособный дата-центр продемонстрирован в виде цифрового двойника на платформе Omniverse. Показанный кластер выполнен на платформе NVIDIA GB200 NVL72. Отмечается, что проектирование и создание современных ЦОД — очень трудоёмкий процесс, который требует объединения усилий самых разных команд специалистов. При этом должно учитываться огромное количество факторов, от которых зависят энергетическая эффективность, производительность, возможность масштабирования и пр. Цифровые двойники дают возможность упростить и ускорить процесс. Цифровой двойник создан на платформе Cadence Reality с применением Omniverse. Для создания цифровой копии будущего ЦОД, который заменит один из устаревших дата-центров NVIDIA, компания Kinetic Vision просканировала площадку с помощью носимого сканера NavVis VLX на основе лидара. В результате были получены высокоточные данные о физических характеристиках объекта и панорамные фотографии. Далее с помощью ПО Prevu3D была сформирована реалистичная 3D-модель ЦОД. Инженеры объединили и визуализировали несколько наборов данных САПР с высокой точностью с помощью платформы Cadence Reality. Программные интерфейсы Omniverse Cloud обеспечили совместимость с другими инструментами, включая Patch Manager и NVIDIA Air. С помощью Patch Manager специалисты разработали физическую схему кластера и сетевой инфраструктуры, включая необходимые кабели с расчётом их длины. Кроме того, были рассчитаны воздушные потоки и параметры СЖО от таких партнёров, как Vertiv и Schneider Electric. NVIDIA показала, что цифровые двойники позволяют проектировать, тестировать и оптимизировать ЦОД полностью в виртуальной среде. Визуализируя производительность дата-центра, команды могут изучать различные варианты компоновки и оценивать всевозможные сценарии. Таким образом, можно добиться оптимальной структуры ЦОД ещё до создания физического объекта.

19.03.2024 [01:00], Игорь Осколков

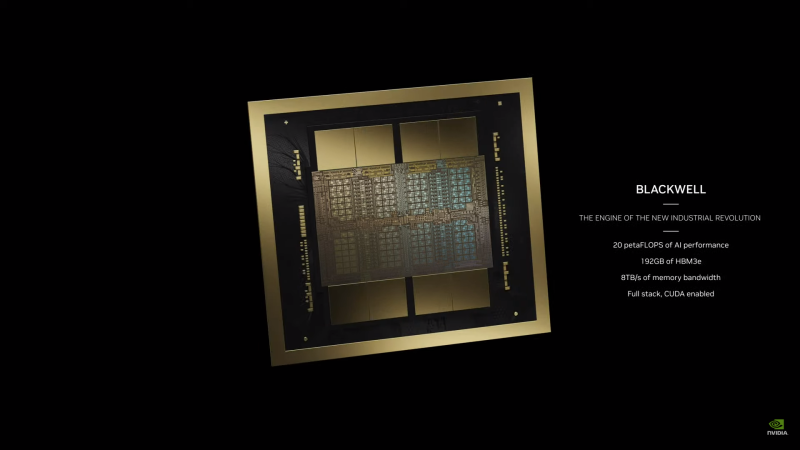

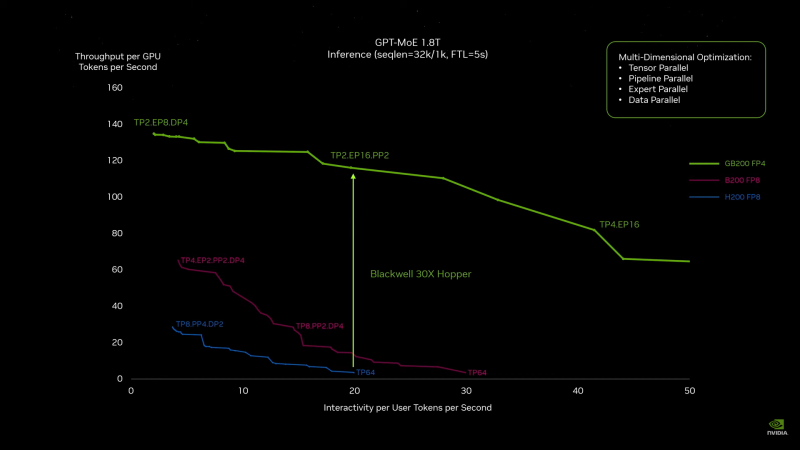

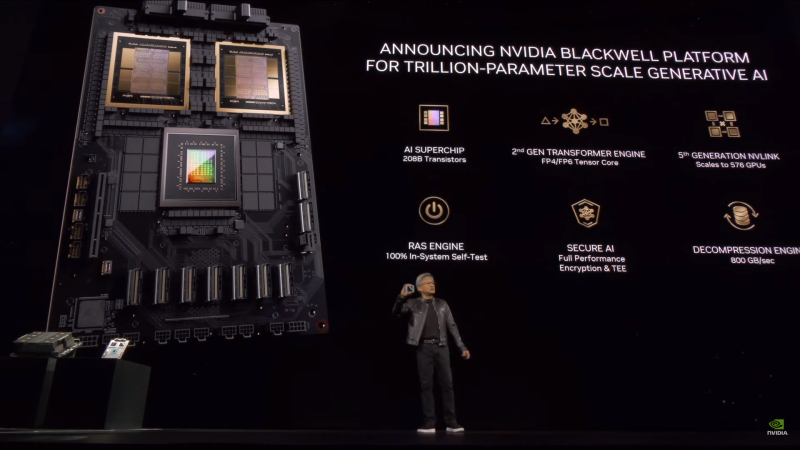

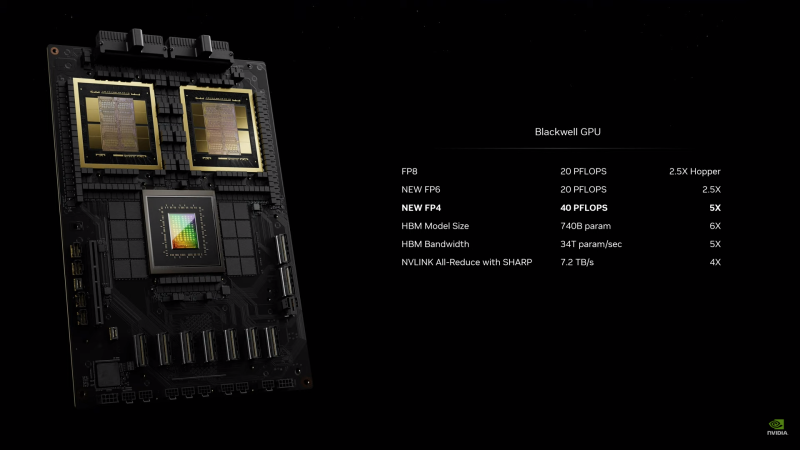

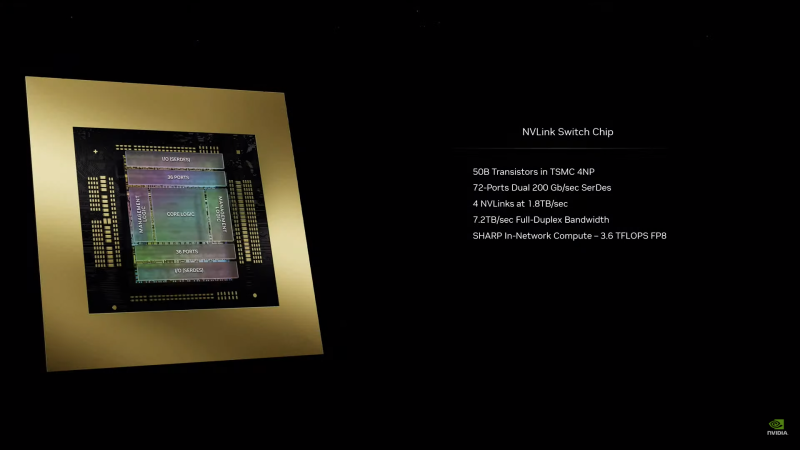

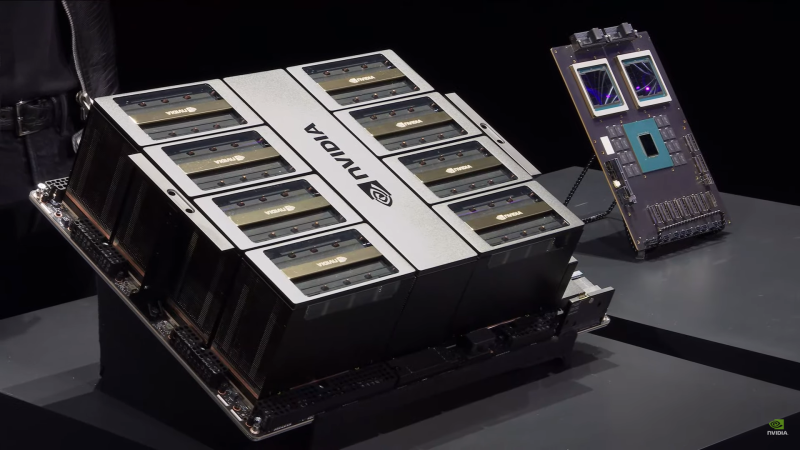

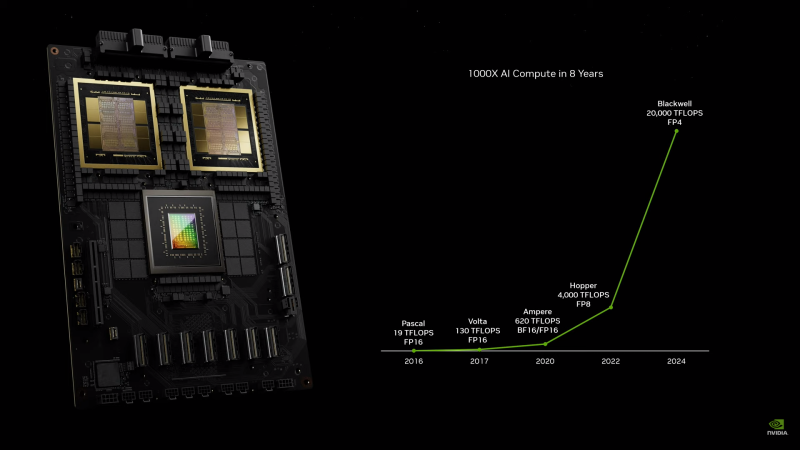

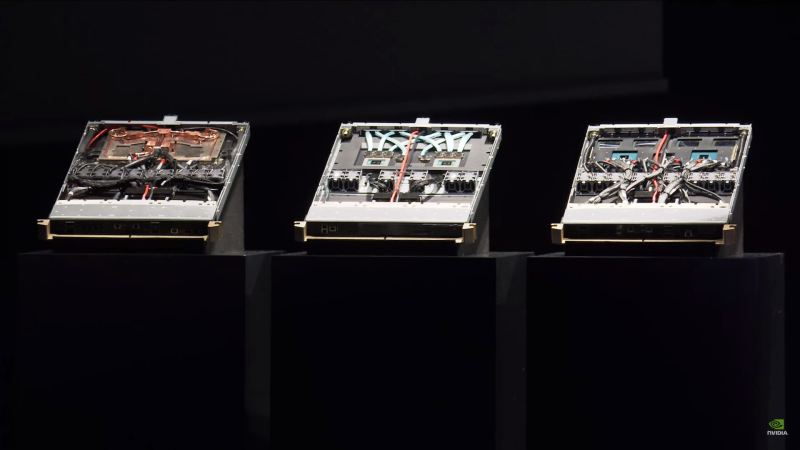

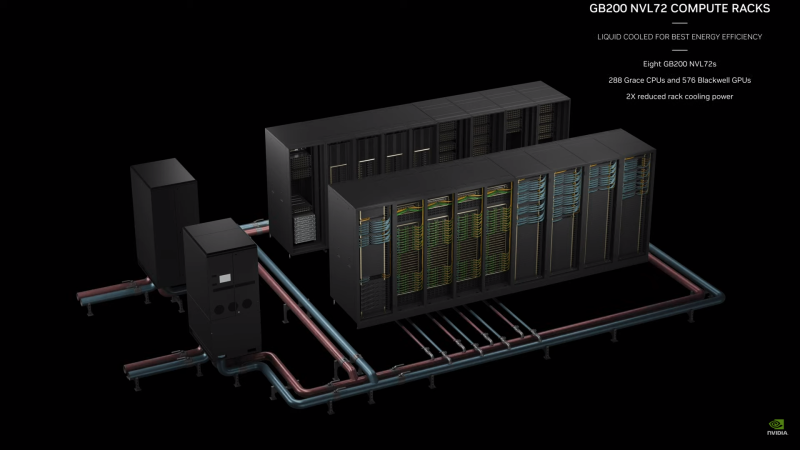

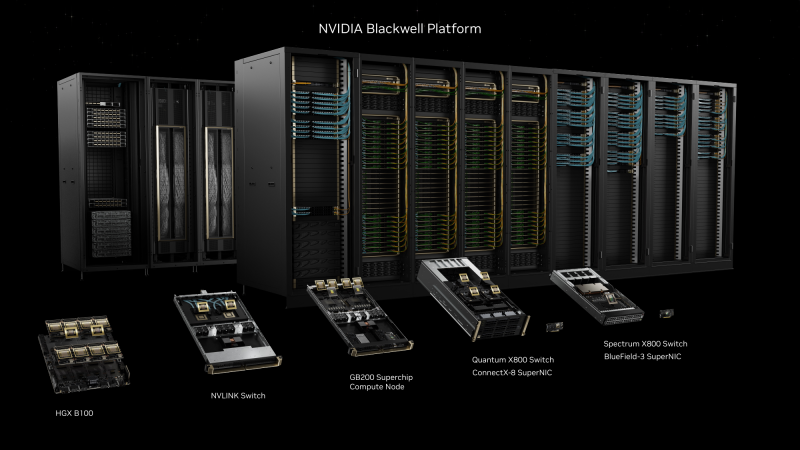

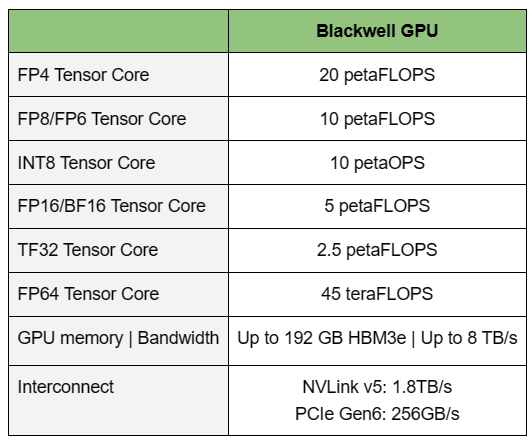

NVIDIA B200, GB200 и GB200 NVL72 — новые ускорители на базе архитектуры BlackwellNVIDIA представила сразу несколько ускорителей на базе новой архитектуры Blackwell, названной в честь американского статистика и математика Дэвида Блэквелла. На смену H100/H200, GH200 и GH200 NVL32 на базе архитектуры Hopper придут B200, GB200 и GB200 NVL72. Все они, как говорит NVIDIA, призваны демократизировать работу с большими языковыми моделями (LLM) с триллионами параметров. В частности, решения на базе Blackwell будут до 25 раз энергоэффективнее и экономичнее в сравнении с Hopper. В разреженных FP4- и FP8-вычислениях производительность B200 достигает 20 и 10 Пфлопс соответственно. Но без толики технического маркетинга не обошлось — показанные результаты достигнуты не только благодаря аппаратным улучшениям, но и программным оптимизациям. Это ни в коей мере не умаляет их важности и полезности, но затрудняет прямое сравнение с конкурирующими решениями. В общем, появление Blackwell стоит рассматривать не как очередное поколение ускорителей, а как расширение всей экосистемы NVIDIA. В Blackwell компания использует тайловую (чиплетную) компоновку — два тайла объединены 2,5D-упаковкой CoWoS-L и на двоих имеют 208 млрд транзисторов, изготовленных по техпроцессу TSMC 4NP. В одно целое со всех точек зрения их объединяет новый интерконнект NV-HBI с пропускной способностью 10 Тбайт/с, а дополняют их восемь стеков HBM3e-памяти ёмкостью до 192 Гбайт с агрегированной пропускной способностью до 8 Тбайт/с. Такой же объём памяти предлагает и Instinct MI300X, но с меньшей ПСП (5,3 Тбайт/с), хотя это скоро изменится. FP8-производительность в разреженных вычислениях у решения AMD составляет 5,23 Пфлопс, но зато компания не забывает и про FP64 в отличие от NVIDIA. Одними из ключевых нововведений, отвечающих за повышение производительности, стали новые Tensor-ядра и второе поколение механизма Transformer Engine, который научился заглядывать внутрь тензоров, ещё более тонко подбирая необходимую точность вычислений, что влияет и на скорость обучения с инференсом, и на максимальный объём модели, умещающейся в памяти ускорителя.  Теперь NVIDIA намекает на то, что обучение можно делать в FP8-формате, а для инференса хватит и FP4. Всё это без потери качества. Но вообще Blackwell поддерживает FP4/FP6/FP8, INT8, BF16/FP16, TF32 и FP64. И только для последнего нет поддержки разреженных вычислений. Дополнительно Blackwell обзавёлся движком для декомпрессии (в первую очередь LZ4, Deflate, Snappy) входящих данных со скоростью до 800 Гбайт/с, что тоже должно повысить производительность, т.к. теперь распаковкой будет заниматься не CPU и, соответственно, ускоритель не будет «голодать». Эта функция рассчитана в основном на Apache Spark и другие системы для аналитики больших данных. Также есть по семь движков NVDEC и NVJPEG. Наконец, NVIDIA упоминает ещё две новых возможности Blackwell: шифрование данных в памяти и RAS-функции. В первом случае речь идёт о защите конфиденциальности обрабатываемых данных, что важно в целом ряде областей. Причём формирование TEE-анклава возможно в рамках группы из 128 ускорителей. MIG-доменов по-прежнему семь. В случае RAS говорится о телеметрии и предиктивной аналитике (естественно, на базе ИИ), которые помогут заранее выявить возможные сбои и снизить время простоя. Это важно, поскольку многие модели могут обучаться неделями и месяцами, так что потеря даже относительно небольшого куска данных крайне неприятна и финансово затратна. Однако всё эти инновации не имеют смысла без возможности масштабирования, поэтому NVIDIA оснастила Blackwell не только интерфейсом PCIe 6.0 (32 линии), который играет всё меньшую роль, но и пятым поколением интерконнекта NVLink. NVLink 5 по сравнению с NVLink 4 удвоил пропускную способность до 1,8 Тбайт/с (по 900 Гбайт/с в каждую сторону), а соответствующий коммутатор NVSwitch 7.2T позволяет объединить до 576 ускорителей в одном домене. SHARP-движки с поддержкой FP8 дополнительно помогут ускорить обработку моделей, избавив ускорители от части работ по предобработке и трансформации данных. Чип коммутатора тоже изготавливается по техпроцессу TSMC N4P и содержит 50 млрд транзисторов. Для дальнейшего масштабирования и формирования кластеров из 10 тыс. ускорителей и более, вплоть до 100 тыс. ускорителей на уровне ЦОД, NVIDIA предлагает 800G-коммутаторы Quantum-X800 InfiniBand XDR и Spectrum-X800 Ethernet, имеющие соответственно 144 и 64 порта. Узлам же полагаются DPU ConnectX-8 SuperNIC и BlueField-3. Правда, последний предлагает только 400G-порты в отличие от первого. От InfiniBand компания отказываться не собирается. С базовыми кирпичиками разобрались, пора переходить к конструированию продуктов. Первым идёт HGX B100, в основе которой всё та же базовая плата с восемью ускорителями Blackwell, точно так же провязанных между собой NVLink 5 с агрегированной скоростью 14,4 Тбайт/с. Для связи с внешним миром предлагается пара интерфейсов PCIe 6.0 x16. HGX B100 предназначена для простой замены HGX H100, поэтому ускорители имеют TDP не более 700 Вт, что ограничивает пиковую производительность в разреженных FP4- и FP8/FP6/INT8-вычислениях до 14 и 7 Пфлопс соответственно, а для всей системы — 112 и 56 Пфлопс соответственно.  У HGX B200 показатель TDP ограничен уже 1 кВт, причём возможность воздушного охлаждения по-прежнему сохраняется. Производительность одного B200 в разреженных FP4- и FP8/FP6/INT8-вычислениях достигает уже 18 и 9 Пфлопс, а для всей системы — 144 и 72 Пфлопс соответственно. DGX B200 повторяет HGX B200 в плане производительности и является готовой системой от NVIDIA, тоже с воздушным охлаждением. В системе используются два чипа Intel Xeon Emerald Rapids. По словам NVIDIA, DGX B200 до 15 раз быстрее в задачах инференса «триллионных» моделей по сравнению с DGX-узлами прошлого поколения. 800G-интерконнект Ethernet/InfiniBand этим трём платформам не достался, только 400G. Основным же строительным блоком сама компания явно считает гибридный суперчип GB200, объединяющий уже имеющийся у неё Arm-процессор Grace сразу с двумя ускорителями Blackwell B200. CPU-часть включает 72 ядра Neoverse V2 (по 64 Кбайт L1-кеша для данных и инструкций, L2-кеш 1 Мбайт), 144 Мбайт L3-кеша и до 480 Гбайт LPDDR5x-памяти с ПСП до 512 Гбайт/с. С двумя B200 процессор связан 900-Гбайт/с шиной NVLink-C2C — по 450 Гбайт/с на каждый ускоритель. Между собой B200 напрямую подключены уже по полноценной 1,8-Тбайт/с шине NVLink 5. Вся эта немаленькая конструкция шириной в половину стойки имеет TDP до 2,7 кВт. 1U-узел с парой чипов GB200, каждый из которых может отъедать до 1,2 кВт, уже требует жидкостное охлаждение. FP4- и FP8/FP6/INT8-производительность (речь всё ещё о разреженных вычислениях) GB200 достигает 40 и 20 Пфлопс. И именно эти цифры NVIDIA нередко использует для сравнения новинок со старыми решениями. 18 узлов с парой GB200 (суммарно 72 шт.) и 9 узлов с парой коммутаторов NVSwitch 7.2T, которые провязывают все ускорители по схеме каждый-с-каждым (агрегированно 130 Тбайт/с, более 3 км соединений), формируют 120-кВт суперускоритель GB200 NVL72 размером со стойку, оснащённый СЖО и единой DC-шиной питания. Всё это даёт до 1,44 Эфлопс в FP4-вычислениях и до 720 Пфлопс в FP8, а также до 13,5 Тбайт HBM3e с агрегированной ПСП до 576 Тбайт/с. Ну а общий объём памяти составляет порядка 30 Тбайт. GB200 NVL72 одновременно является и узлом DGX GB200. Восемь DGX GB200 формируют DGX SuperPOD. Впрочем, будет доступен и SuperPOD попроще, на базе DGX B200. Ускорители B200 появятся в этом году и будут стоить в диапазоне $30–$40 тыс., что ненамного больше начальной цены Hopper в диапазоне $25–$40 тыс. Глава NVIDIA уже предупредил, что Blackwell сразу будут в дефиците. Вероятно, получить доступ к ним проще всего будет в облаках Amazon, Google, Microsoft и Oracle.

18.03.2024 [17:01], Руслан Авдеев

Министерство энергетики США выделило $750 млн на расширение производства водородных ячеек и электролизеровСоединённые Штаты активно занялись созданием инфраструктуры для выпуска водородных топливных элементов. Datacenter Dynamics сообщает, что Министерство энергетики страны выделило $750 млн на 52 проекта соответствующей тематики в 24 штатах. Предполагается, что они смогут снизить себестоимость водорода и увеличить объёмы поставок. Проекты выделены в рамках закона, подписанного в 2021 году и предполагавшего выделение на инфраструктурные проекты $1 трлн. Как сообщают в министерстве, новый план обеспечат США рост возможности производства водородных топливных ячеек в объёме до 14 ГВт/год, а также электролизеров на 10 ГВт ежегодно — этого будет достаточно для выпуска 1,3 млн тонн чистого водорода каждый год.

Источник изображения: akitada31/pixabay.com Средства распределят по шести направлениям: производство электролизеров, цепочка поставок для электролизеров, компоненты электролизеров, выпуск топливных ячеек, цепочка поставок для топливных ячеек, утилизация. В числе прочих получателем средства стала Plug Power, выпускающая топливные элементы. Ранее компания заявляла, что гиперскейлеры начнут внедрять водородные элементы для ЦОД в конце 2025 года. Речь, вероятно, о Google, Amazon и Microsoft. Последняя уже внедрила водородную систему Plug Power мощностью 3 МВт в 2022 году. Ранее Microsoft заявила, что объединила усилия с Caterpillar, обеспечив питание ЦОД в течение 48 часов исключительно за счёт энергии, вырабатываемой ячейками производства Ballard Power Systems. Как Caterpillar, так и Ballard тоже стали получателями субсидий Министерства энергетики. Также деньги выделены 3M, General Motors, Nuvera и Robert Bosch. Операторы ЦОД довольно давно присматриваются к топливным элементам, видя в них альтернативу дизельным электрогенераторам в качестве резервных источников питания. Не исключается, что такие ячейки в будущем могут стать и основными источниками питания.

18.03.2024 [15:37], Руслан Авдеев

Ardian закрыла сделку по покупке Verne у D9, пообещав вложиться в увеличение ёмкости ЦОДИнвестиционная компания Ardian завершила сделку по покупке европейского оператора ЦОД Verne у британской инфраструктурной группы Digital 9 Infrastructure plc (D9). По информации Datacenter Dynamics, инвестор намерен поддержать расширение Verne, вложив до $1,2 млрд для реализации «амбициозного плана роста» на рынке ЦОД на севере Европы. Принадлежащая Triple Point компания D9 анонсировала продажу Verne новому собственнику ещё в ноябре 2023 года. Хотя условия сделки не разглашались, по слухам, покупка обошлась в £465 млн ($575 млн). Для сравнения, D9 приобрела Verne в 2021 году за £231 млн ($320 млн по актуальному тогда курсу).

Источник изображения: Verne Компания управляет кампусом ЦОД потенциальной ёмкостью более 100 МВт на бывшей базе НАТО в Исландии, обеспечивая клиентов колокейшн- и HPC-сервисами. В пакет бренда Verne также включили купленных D9 операторов — финскую Ficolo и британскую Volta Data Centers. По данным Techerati, в Лондоне компания располагает ЦОД приблизительно на 10 МВт и порядка 25 МВт — в Финляндии. Как заявляют в Ardian, компания намерена в разы увеличить ёмкость ЦОД Verne в среднесрочной перспективе. Речь идёт как о расширении уже существующих объектов, так и о строительстве новых. Приоритет будет отдаваться проектам в Исландии, Финляндии, Швеции и Норвегии, а также в других районах Северной Европы. В Verne приветствовали присоединение к платформе Ardian — оператор создавать новые экоустойчивые ЦОД, позволяя организациям-клиентам экономично масштабировать цифровую инфраструктуру, попутно снижая воздействие на окружающую среду. Изначально D9 планировала продать миноритарную долю Verne, но на фоне роста долгов и падения курса акций владельцы настояли на полной продаже бизнеса. В Ardian утверждают, что Verne «действительно зелёный» оператор ЦОД в сравнении с конкурентами со всего мира. Новый владелец поможет топ-менеджменту приобретённого бизнеса удовлетворить растущий из-за массового внедрения ИИ спрос. На сайте компании указывается, что ЦОД в Исландии на 100 % питается энергией Солнца и геотермальных источников. У самой D9 дела обстоят не очень гладко — планируется продажа и других активов компании, среди которых есть компания Aqua Comms (подводные кабели), британская телерадиовещательная сеть Arquiva, ирландский ШПД-оператор Elio (ранее Host Ireland), а также доля в кабеле EMIC-1, связывающем юг Европы с Индией. Также в её собственности имеется ЦОД и посадочная станция в Великобритании — SeaEdge UK1.

18.03.2024 [15:28], Сергей Карасёв

Сервис диагностики МТС InetCore помог сократить количество инцидентов с Wi-Fi-маршрутизаторами на 15 %Компания МТС по итогам 2023 года смогла повысить эффективность службы техподдержки и сократить количество инцидентов с маршрутизаторами Wi-Fi на 15 %. Этого удалось достичь благодаря внедрению новых функций удалённого обслуживания абонентских устройств через диагностическую платформу InetCore. Сервис InetCore, запущенный МТС Digital, предназначен для дистанционной диагностики услуг фиксированной сети и мониторинга ресурсов. Система помогает уменьшить время обслуживания клиентов, которые пользуются услугами домашнего интернет-доступа. В 2023 году на базе платформы была реализована возможность самостоятельной настройки абонентами Wi-Fi-роутеров через чат-бот или голосовой бот. Кроме того, появился интерфейс диагностики для специалистов контактных центров с интерактивными сценариями обслуживания. Ещё одно нововведение — инструмент автоматического прогнозирования утилизации портов. Система также научилась заранее генерировать предупреждения о необходимости замены оборудования.

Источник изображения: pixabay.com Говорится, что, помимо снижения количества инцидентов с Wi-Fi-маршрутизаторами, нововведения также позволили на 17 % уменьшить среднее время консультаций. При этом успешность решения вопросов поднялась на 5 %, тогда как отказных заявок при подключении абонентов стало меньше на 10 %. Плюс к этому оптимизировано планирование расширения сети фиксированного доступа: оно теперь осуществляется автоматически, а выезд специалистов происходит на объекты с уже подготовленной инфраструктурой. В целом, платформа InetCore дала возможность перенаправить ресурсы с решения рутинных задач на стратегическое развитие сервисов и услуг. Расширение функций InetCore также позволило ускорить обучение сотрудников техподдержки благодаря интерактивным сценариям диагностики, сохранению и автоматизированному анализу сетевых данных. Утверждается, что работники достигают показателей специалистов с опытом от полугода всего за месяц. При этом уровень удовлетворенности сервисных специалистов новыми функциями составляет 73 %.

16.03.2024 [23:19], Сергей Карасёв

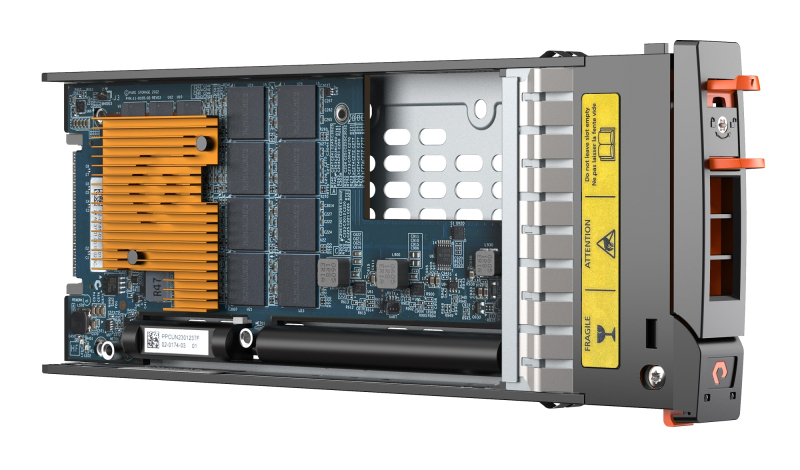

Pure Storage: рост ёмкости SSD будет ограничен возможностями DRAMКомпания Pure Storage, специализирующаяся на All-Flash СХД, считает, что дальнейшее увеличение вместимости SSD будет сопряжено с рядом трудностей, продиктованных необходимостью применения DRAM. Об этом, как сообщает ресурс Blocks & Files, рассказал Шон Роузмарин (Shawn Rosemarin), вице-президент Pure по исследованиям и разработкам. По его словам, коммерческим SSD требуется примерно 1 Гбайт DRAM на каждый 1 Тбайт флеш-памяти. Наличие DRAM необходимо для подсистемы Flash Translation Layer (FTL). По словам Роузмарина, для накопителя ёмкостью 30 Тбайт требуется 30 Гбайт DRAM, для 75 Тбайт — 75 Гбайт и т. д. Таким образом, для SSD вместимостью, например, 128 Тбайт нужно 128 Гбайт DRAM, а это уже сопоставимо с объёмом ОЗУ в сервере. Роузмарин отмечает, что увеличение вместимости корпоративных SSD свыше 30 Тбайт будет проблематично. Во-первых, DRAM заметно дороже NAND, что приведёт к значительному росту стоимости SSD. Во-вторых, из-за увеличения объёма DRAM возрастает энергопотребление, что не только поднимет стоимость владения, но и ухудшит надёжность накопителя. В результате по мере роста вместимости SSD заказчики могут столкнуться с серьёзным увеличением затрат. Роузмарин заявляет, что единственный способ обойти указанные проблемы — найти более экономичную и менее энергозатратную альтернативу DRAM. Необходимые функции, по его словам, могут быть перенесены непосредственно на ПО СХД. Именно такой подход Pure реализует со своими проприетарными накопителями DFM (Direct Flash Module), последняя модификация которых имеет ёмкость 75 Тбайт. В этих устройствах отсутствует зависимость от DRAM на уровне накопителей. Компания намерена выпустить DFM ёмкостью 150 Тбайт в 2025 году, а на 300 Тбайт — ориентировочно в 2026-м. В дальнейшие планы входит создание изделий вместимостью 600 Тбайт и 1,2 Пбайт. Аналогичного подхода придерживается и IBM в своих накопителях FlashCore Modules (FCM).

16.03.2024 [21:51], Сергей Карасёв

Глава Broadcom: изменения в политике VMware вызывают беспокойство у клиентов и партнёровГенеральный директор Broadcom Хок Тан (Hock Tan), по сообщению The Register, дал комментарии по поводу новой политики, реализуемой в отношении бизнеса VMware. Напомним, этого разработчика средств виртуализации Broadcom приобрела в ноябре 2023 года: сумма сделки составила $69 млрд. После завершения слияния структура VMware изменена с формированием четырёх ключевых подразделений. Broadcom отменила бессрочные лицензии, перевела все продукты на подписную схему, а ассортимент подвергся радикальному сокращению. В частности, прекращено распространение бесплатных версий гипервизора vSphere ESXi 7.x/8.x. Параллельно упразднены скидки и изменён подход к взаимодействию с партнёрами. Всё это породило недовольство со стороны ряда клиентов, некоторые из которых начали изучать возможность перехода на альтернативные решения.

Источник изображения: Broadcom Господин Тан заявляет, что изменения направлены на ускорение инноваций, более эффективное удовлетворение потребностей клиентов и упрощение бизнес-операций. Кроме того, как ожидается, новая политика поможет повысить прибыль и расширить возможности партнёров. Вместе с тем глава Broadcom признаёт, что столь значительная трансформация вызвала беспокойство у клиентов. «Хотя предстоит ещё много работы, мы добились существенного прогресса, создав ведущую в мире компанию в области инфраструктурных технологий. С момента завершения сделки мы действовали решительно, чтобы повысить ценность для заказчиков. Конечно, мы понимаем, что такой объём изменений по понятным причинам вызвал некоторое беспокойство среди наших клиентов и партнёров», — отметил Тан. Broadcom разделила все продукты на два направления: VMware Cloud Foundation (VCF) и VMware vSphere Foundation (VVF). Господин Тан говорит о преимуществах использования такого подхода, обещая выделить $1 млрд на исследования и разработки и подчёркивая, что Broadcom вдвое снизила цену подписки. Прашант Шеной (Prashanth Shenoy), вице-президент по маркетингу облачных платформ, инфраструктуры и продуктов VCF, также заявлял, что клиенты, использующие комплексное решение VCF, смогут сэкономить до половины затрат. Однако для тех клиентов, которые использовали только vSphere, расходы, напротив, увеличатся. |

|