Лента новостей

|

10.07.2024 [18:15], Руслан Авдеев

Китай намерен ускорить внедрение IPv6Внедрение интернет-протокола IPv6 в Китае несколько замедлилось. Тем не менее, как сообщает The Register, Пекин не намерен сдаваться и готовь принять новые меры для его повсеместного распространения. Об этом было рассказано в ходе конференции China IPv6 Innovation and Development. Согласно официальным данным, по состоянию на май 2024 года насчитывалось 794 млн пользователей IPv6 — 64,56 % мобильного трафика и 21,21 % стационарного приходится на IPv6-сети. В мае 2023 года такие сети охватывали 763 млн пользователей, а в 2022 — 697 млн пользователей. К 2025 году Китай намерен перевести на IPv6 уже 800 млн пользователей, причём в мобильных сетях его доля должна быть доведена до 70 %. А вот цель по охвату IPv6 15 % трафика сетей фиксированной связи уже достигнута. В следующие 12 месяцев Пекин реализует план развёртывания IPv6 в восьми китайских городах с общим населением более 110 млн человек. Мегаполисы, включая Пекин, Шанхай, Ханчжоу и Шэньчжэнь, примут участие в специальной акции по продвижению IPv6. Ранее Китай принимал и другие меры. Так, в прошлом году поддержка IPv6 по умолчанию обязательна для всех Wi-Fi роутеров, продаваемых в стране. Но пока статистика свидетельствует, что до достижения желаемого Китаю ещё очень далеко. По данными Akamai, лидерами по внедрению IPv6 являются Индия, Малайзия, Германия и Франция, а Китай занимает 61-е место с уровнем внедрение 22,2 %. Akamai учитывает тип исходящих подключений в стране. По данным APNIC безусловным лидером тоже является Индия, с 79,85 % сетей, способных поддерживать протокол, за ней следуют Малайзия, Саудовская Аравия, Франция и Германия, а в Китае уровень поддержки составляет 36,71 %. APNIC учитывает ASN, которые поддерживают IPv6. В Пекине считают, что поддержка современных сетевых технологий критически важна для экономического развития страны. За китайскими организациями закреплено примерно 330 млн IPv4-адресов, т.е. один адрес приходится приблизительно на 245 человек. При этом фактически количество пользователей сети намного больше, поскольку и у каждого человека сейчас не по одному гаджету, и количество разнообразных датчиков и «умных» устройств только растёт.

10.07.2024 [17:43], Владимир Мироненко

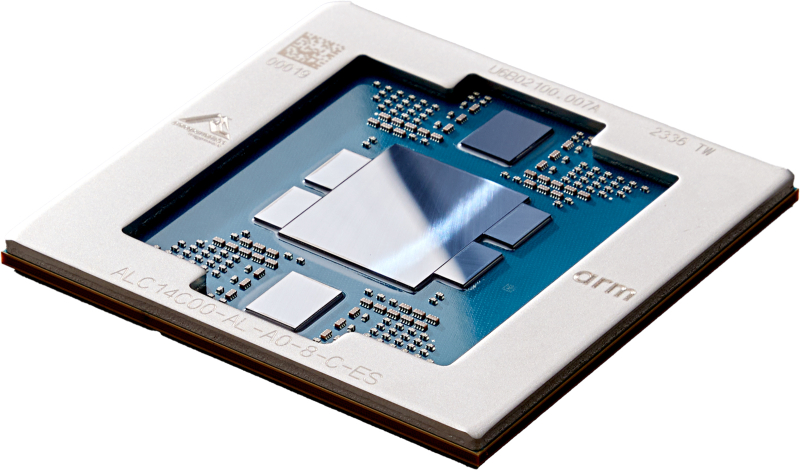

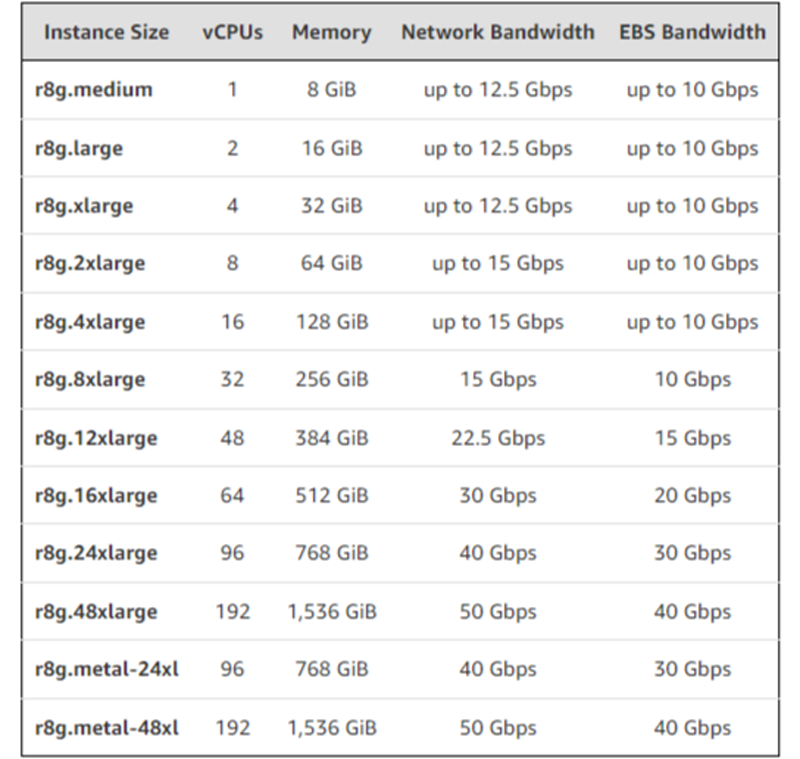

AWS объявила о доступности инстансов EC2 R8g на базе Arm-процессоров Graviton4AWS объявила о доступности инстансов EC2 R8g на базе Arm-процессоров Graviton4. По сравнению с Graviton3 они обладают на 30 % большей вычислительной мощностью, имеют на 50 % больше ядер и на 75 % выше пропускную способность памяти, говорит AWS. Также сообщается, что процессоры Graviton4 до 30 % быстрее в обработке веб-приложений, на 40 % быстрее в работе с базами данных и на 45 % быстрее при запуске больших Java-приложений, чем Graviton3. Инстансы Amazon EC2 R8g позволяют повысить производительность приложений, интенсивно использующих ресурсы памяти, включая высокопроизводительные СУБД, in-memory кеши и системы аналитики Big Data в режиме реального времени. Впрочем, согласно подсчётам The Next Platform, новые инстансы по сравнению с прошлыми по соотношению цены и производительности стали на четверть дороже. По сравнению с EC2 R7g инстансы R8g предлагают более крупные конфигурации: в три раза больше vCPU (до 192 шт.), в три раза больше памяти (до 1,5 Тбайт) и в два раза больше L2-кеша. Инстансы R8g также обеспечивают пропускную способность сети до 50 Гбит/с и пропускную способность EBS до 40 Гбит/с по сравнению с 30 Гбит/с и 20 Гбит/с соответственно у инстансов прошлого поколения. Кроме того, Amazon EC2 R8g — первые инстансы на чипах Graviton, предлагающие две крупные конфигурации bare metal (metal-24xl и metal-48xl).  Как сообщила компания, инстансы R8g идеально подходят для всех рабочих нагрузок на базе Linux, включая контейнерные приложения и приложения на основе микросервисов, созданные с использованием EKS, ECS, ECR, Kubernetes, и Docker, а также приложения, написанные на C/C++, Rust, Go, Java, Python, .NET Core, Node.js, Ruby и PHP. Новые инстантсы используют AWS Nitro. По словам AWS, с момента анонса превью R8g более 100 клиентов, включая Epic Games, SmugMug, Honeycomb, SAP и ClickHouse, протестировали свои рабочие нагрузки на этих инстансах и отметили значительное улучшение производительности по сравнению с сопоставимыми экземплярами на Graviton3. В настоящее время R8g доступны в регионах AWS US East (Северная Вирджиния), US East (Огайо), US Wes (Орегон) и Europe (Франкфурт). Они доступны как по запросу, так в качестве спотовых и зарезервированных инстансов, а также в рамках планов Savings. На текущий момент у AWS есть уже более 2 млн процессоров Graviton разных поколений, а инстансами на их основе пользуются более 50 тыс. клиентов.

10.07.2024 [17:08], Андрей Крупин

МТС создаст облачную IoT-платформу учёта электроэнергииКомпания «Мобильные ТелеСистемы» выиграла конкурс на создание интеллектуальной системы учёта электроэнергии для АО «Новосибирскэнергосбыт» по сервисной модели на базе облачной инфраструктуры МТС. Проект рассчитан на три года, а его реализация оценивается в 1,5 млрд рублей. В течение трёх лет МТС установит и обеспечит эксплуатацию 86,4 тысяч интеллектуальных приборов учёта в многоквартирных домах Новосибирской области, впервые на рынке выступив оператором передачи данных для ресурсоснабжающей организации. В рамках проекта планируется использовать «умные» устройства российского производства, которые будут интегрированы в IoT-платформу учёта и дистанционного управления энергоресурсами. Для связи каждого прибора будет задействован стандарт NB-IoT.

Источник изображения: pvproductions / freepik.com «Мы заключили с «Новосибирскэнергосбыт» долгосрочный контакт, который обеспечит регион уникальной IoT-платформой как по масштабу, срокам и наполнению. Впервые на рынке МТС берет на себя создание полной законченной автоматизированной системы, включающей программное обеспечение, приборы учёта, сеть передачи данных и дата-центры, а также сервисные работы по монтажу и эксплуатации. Клиент получает готовый продукт — данные. Интеллектуальный учёт сделает максимально прозрачным процесс начисления коммунальных платежей, также сможет обеспечить онлайн-контроль работоспособности устройств и сократит издержки на снятие показаний», — отметил вице-президент по развитию нового и корпоративного бизнеса МТС Олег Алдошин.

10.07.2024 [16:16], Руслан Авдеев

К 2029 году на ИИ-ускорители придётся 1,5 % всего энергопотребления на ЗемлеВ мире ожидается рост энергопотребления системами, связанными с генеративным ИИ. По данным HPC Wire, в следующие пять лет расход электричества на такие системы составит 1,5 % от общемирового — это весьма значимая доля, говорят эксперты. Соответствующее предположение выдвинули аналитики TechInsights. За основу взяты прогнозы Управления энергетической информации США (US Energy Information Administration, EIA) на 2025–2029 гг., в которых глобальное энергопотребление за этот период, по оценкам, составит 153 тыс. ТВт∙ч. Исследователи предполагают, что за то же время на ИИ-ускорители придётся 2318 ТВт∙ч. Расчёты исходят из того, что каждый ускоритель требует 700 Вт, а потребление флагманских NVIDIA Blackwell и вовсе составляет 1200 Вт, хотя новинки намного производительнее решений прошлых поколений. При составлении прогнозов учитывается лишь энергопотребление самих ускорителей — без модулей памяти, сетевого оборудования и прочих компонентов ИИ-систем. По мнению экспертов, «придётся попотеть», чтобы оправдать такие расходы. Согласно опросам McKinsey, 65 % респондентов намерены использовать генеративный ИИ. Для того, чтобы удовлетворить спрос, вкладываются огромные деньги в соответствующую отрасль. Если Microsoft полагается в основном на решения NVIDIA, то Meta✴ реализует и собственный проект, а её вычислительная экосистема будет эквивалентна около 600 тыс. H100. По данным TechInsights, в 2023 году NVIDIA поставила порядка 3,76 млн ускорителей — в сравнении с 2,6 млн в 2022 году. В прошлом году Gartner выступила даже с более смелым прогнозом — по её мнению, ИИ, возможно, будет потреблять и 3,5 % мирового электричества. Впрочем, методика компании не вполне ясна и, возможно, включает энергозатраты на сопутствующую экосистему помимо ускорителей. При этом расходы на электроэнергию в любом случае будут расти, а в случае дефицита поставщики энергии будут просто поднимать цены, а не пытаться разделить доступные мощности между потребителями. Поэтому сейчас всё острее становится вопрос разумного использования энергии. Так, на криптомайнинг в США, по данным EIA, приходится 2,3 % всего энергопотребления в стране, но эксперты сходятся во мнении, что использовать ресурсы для работы ИИ-систем намного рациональнее. Впрочем, и сами майнеры активно переключаются на ИИ-проекты. Кроме того, переход на СЖО и утилизация «мусорного» повышают общую энергоэффективность ЦОД. Но есть и другой путь. Так, Microsoft совместно с производителями «железа» довольно агрессивно продвигает т.н. ИИ ПК (AI PC), оснащённые NPU или иными ускорителями для локальных ИИ-вычислений. Это фактически позволяет перенести часть нагрузок на клиентские устройства, а в облаке обсчитываются те задачи, которые устройствам не под силу. Apple использует похожий подход.

10.07.2024 [11:12], Руслан Авдеев

CyrusOne получила новый кредит на $7,9 млрд для развития ЦОД в СШАПринадлежащий компании KKR оператор ЦОД CyrusOne получил в этом году кредитов на сумму порядка $8 млрд. Datacenter Dynamics сообщает, что новая кредитная линия Warehouse Credit Facility на $7,9 млрд дополнит уже имеющуюся линию Revolving Credit Facility на $1,8 млрд, открытую в мае 2024 года. Warehouse Credit Facility в первую очередь предназначена для финансирования существующих и будущих проектов строительства ЦОД в США, а Revolving Credit Facility — на обеспечение оборотного капитала и общекорпоративные цели.

Источник изображения: CyrusOne По словам главы по инвестициям CyrusOne Фрэн Федерман (Fran Federman), интерес со стороны заёмщиков — подтверждение прочности бизнеса компании и уверенности в её возможности продолжать развитие. По её словам, обе программы финансирования рассчитаны на устойчивое развитие. Условия кредитования будут меняться в зависимости от достижения компанией целевых показателей по выбросам парниковых газов. Morgan Stanley, TD Securities и KKR Capital Markets выступили ведущими организаторами, стоящими за кредитной линией Warehouse Credit Facility, а Wells Fargo — за линией Revolving Credit Facility. В рамках сделок с компанией тесно сотрудничала и Global Infrastructure Partners (GIP), которая частично владеет CyrusOne и которая вскоре будет выкуплена BlackRock. CyrusOne владеет десятками ЦОД на 13 региональных рынках США. Только в 2024 году она подала заявки на строительство кампусов в Чикаго (Иллинойс), Нью-Олбани (Огайо), а также начала строительство новых объектов в Сан-Антонио (Техас). В Аризоне власти города Меса рассмотрят предложение о строительстве компанией нового кампуса на 5 дата-центров в окрестностях Финикса. В 2018 году CyrusOne приобрела участок земли у Sunbelt Investment Holdings Inc. за $19,3 млн, а в прошлом году подала заявку на возведение кампуса.

10.07.2024 [10:59], Руслан Авдеев

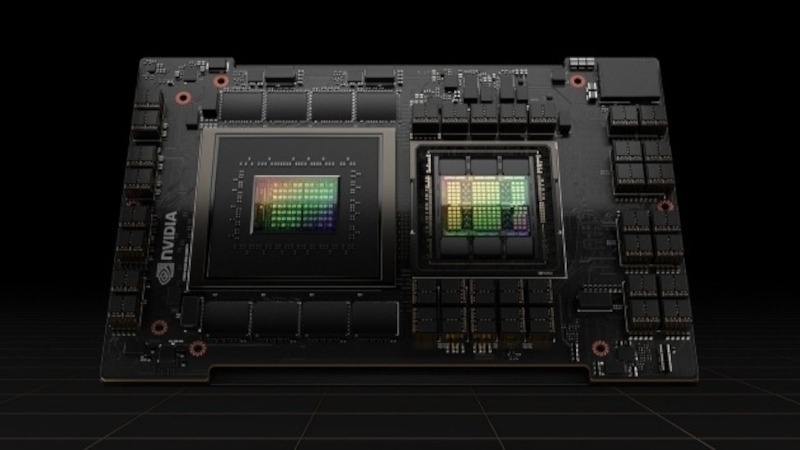

Венчурный инвестор Andreessen Horowitz (a16z) запасается ИИ-ускорителями, чтобы привлечь ИИ-стартапыВенчурная инвестиционная компания Andreessen Horowitz (a16z) получила тысячи современных ускорителей, включая большое количество NVIDIA H100. The Information сообщает, что компания создаёт собственные запасы для привлечения к сотрудничеству ИИ-стартапов. Компания явно не согласна с позицией венчурного фонда Sequoia Capital и аналитиков Goldman Sachs, которые опасаются, что нынешний бум ИИ — лишь пузырь. Инвестор имеет в управлении активы на $42 млрд. Как сообщают СМИ со ссылкой на источники, знакомыми с делами компании, своим подопечным компания сдаёт в аренду запасённые ускорители. Пока нет сведений, идёт ли речь о наполнении складов или компания только арендует их для передачи в субаренду. В будущем Andreessen Horowitz намерена получить более 20 тыс. ускорителей. Компания рассматривает оборудование как критически важный актив для дальнейшего развития бизнеса.

Источник изображения: NVIDIA На запросы журналистов Andreessen Horowitz и NVIDIA пока не отвечают. Уже не в первый раз ИИ-ускорители используются не вполне традиционным способом по мере того, как нарастает ажиотаж на рынке ресурсоёмких вычислений, связанных с искусственным интеллектом. Например, в прошлом августе облачный стартап CoreWeave, поддерживаемый NVIDIA, получил в долг $2,3 млрд под залог крупной партии NVIDIA H100 для покупки ещё большего количества ускорителей. В условиях дефицита ускорителей стартапам предлагаются различные варианты решения проблемы. Так, Alibaba Cloud предлагает ИИ-стартапам GPU-мощности в обмен на долю в компании, а AWS готова выделить им миллионы долларов, но в виде кредитов для оплаты ресурсов в своём же облаке. Некоторые стартапы сами готовы поделиться интеллектуальной собственностью в обмен на доступ к ускорителям.

09.07.2024 [23:33], Владимир Мироненко

$10-млрд сделка между Oracle и xAI сорваласьИИ-стартап Илона Маска (Elon Musk) xAI отказался от планов по расширению сотрудничества с Oracle. Как пишет The Wall Street Journal, во вторник миллиардер сообщил в соцсети X, что xAI прекратил переговоры с облачным провайдером о сделке на $10 млрд по поводу расширения аренды вычислительных мощностей, поскольку стартап сам построит «самый мощный кластер для обучения [ИИ-моделей] в мире с большим запасом». Сообщивший ранее о срыве сделки ресурс The Information рассказал, что многолетнее соглашение об аренде у Oracle запланированного к строительству суперкомпьютера на чипах NVIDIA уже было на стадии подписания, но переговоры зашли в тупик из-за того, что Маска не устроили сроки строительства, предложенные Oracle. Oracle же заявила об отсутствии доступа к адекватному источнику энергии для работы ИИ-суперкомпьютера в выбранном xAI регионе.

Источник изображения: xAI В итоге Маск заявил, что «самый мощный суперкомпьютер в мире» будет построен стартапом в Мемфисе (штат Теннесси, США) и начнёт работу осенью 2025 года. Ранее Маск сообщил, что в течение следующих нескольких месяцев xAI развернёт кластер из 100 тыс. ускорителей NVIDIA H100 с жидкостным охлаждением, а летом следующего года запустит ещё один кластер из 300 тыс. ускорителей NVIDIA B200. Как отметил ресурс Data Center Dynamics, xAI уже арендует у Oracle около 16 тыс. ускорителей NVIDIA, что делает его одним из крупнейших клиентов провайдера облачных услуг. Стартап также использует для работы сервисы AWS и резервные мощности в ЦОД соцсети X (Twitter). Oracle также предоставляет свою ИИ-инфраструктуру Microsoft и OpenAI.

09.07.2024 [17:02], Владимир Мироненко

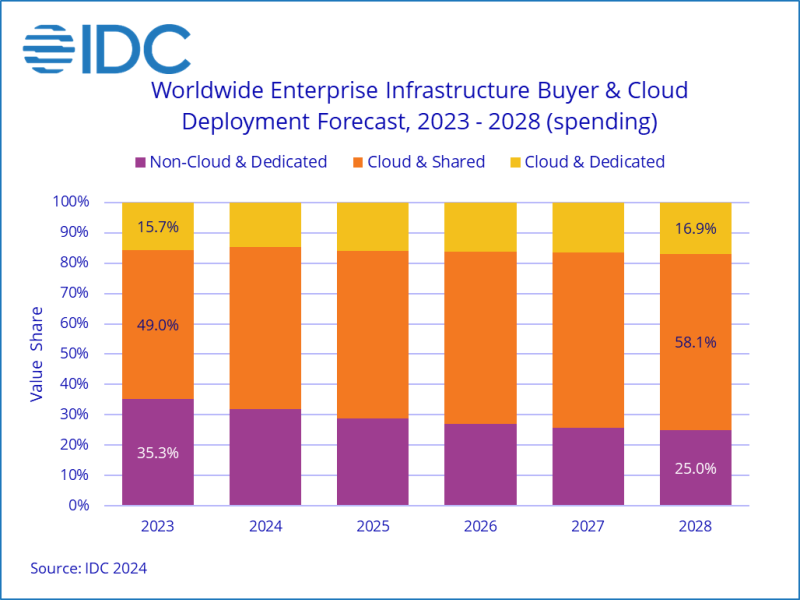

IDC увеличила прогноз затрат на облачную инфраструктуру в 2024 годуКомпания International Data Corporation (IDC) опубликовала результаты исследования мирового рынка облачных инфраструктур за I квартал 2024 года. Согласно оценкам IDC, за квартал, завершившийся в марте, на вычислительные мощности и хранилища по всему миру было израсходовано $54,4 млрд, что на 46 % больше показателя годичной давности. Часть суммы была потрачена на выделенную (dedicated) инфраструктуру, которая размещается в собственных ЦОД или колокейшн-объектах, а часть на общедоступную (shared) облачную инфраструктуру. Следует отметить, что речь в данном случае идёт о продажах конечным потребителям или партнёрам по сбыту. Как полагает ресурс The Next Platform, порядка 40 % этой суммы было потрачено на ИИ-системы, большей частью на их аренду, причём в основном эти системы используют ускорители NVIDIA. По данным IDC, из общей суммы компании потратили в I квартале 2024 года $26,3 млрд на общедоступную облачную инфраструктуру, что на 43,9 % больше, чем в прошлом году. Как отметили аналитики, на неё по-прежнему приходится наибольшая доля расходов по сравнению с выделенной инфраструктурой и необлачными расходами. В I квартале 2024 года на долю общедоступного облака пришлось 56,1 % всех расходов на инфраструктуру. Расходы на выделенную облачную инфраструктуру выросли не столь сильно — на 15,3 % до $6,7 млрд, что ниже среднего показателя за последние 24 месяца в $7,4 млрд в квартал. В сумме расходы на всю облачную инфраструктуру, как общедоступную, так и выделенную, составили $33,0 млрд, что больше год к году на 36 %. На традиционную (необлачную) инфраструктуру было израсходовано $13,9 млрд (рост — 5,7 %). Если оценивать динамику затрат по регионам, то в основном она была положительной, за исключением Латинской Америки, продемонстрировавшей снижение на 2,8 %. Почти во всех регионах рост затрат исчисляется двузначными цифрами, за исключением Западной Европы, а также Ближнего Востока и Африки, где он составил 4,0 % и 5,3 % соответственно. В число регионов, показавших уверенный двузначный рост расходов, вошли Азиатско-Тихоокеанский регион (исключая Японию и Китай), Япония, Центральная и Восточная Европа, США, Китай и Канада, где расходы на облачные технологии выросли год к году на 85,4 %, 53,1 %, 42,6 %, 37,0 %, 33,7 % и 16,1 % соответственно. Большая часть роста связана с крупными HPC- и ИИ-проектами, некоторые из которых в прошлом были отложены из-за проблем с поставками. IDC также значительно повысила прогноз по затратам на 2024 год. Согласно оценкам, в этом году затраты на облачную инфраструктуру вырастут год к году на 26,1 % до $138,3 млрд. Расходы на необлачную инфраструктуру вырастут на 8,4 % до $64,8 млрд. Общедоступная облачная инфраструктура, как ожидают в IDC, покажет рост 30,4 % год к году до $108,3 млрд (предыдущий прогноз — $95,3 млрд). Затраты на выделенную облачную инфраструктуру увеличатся на 12,8 % до $30,0 млрд (ранее ожидалось $34,6 млрд). Комментируя аналитические выкладки IDC, ресурс The Next Platform отметил, что облачная инфраструктура продолжит увеличивать долю в общих затратах на вычислительных ресурсы и СХД. Два года назад на неё приходилось 63,8 % все расходов, в прошлом году — 64,7 %, в этом году ожидается 68,1 %, а в 2028 году — 73,6 %.

09.07.2024 [15:59], Руслан Авдеев

Да будет свет: Corning повысила прогноз продаж благодаря буму ИИCorning повысила прогноз продаж во II квартале 2024 года на $200 млн. Datacenter Knowledge сообщает, что во многом это обусловлено недооценённым ранее спросом на оптоволоконные соединения в дата-центрах для ИИ-задача. Теперь квартальные продажи должны достичь $3,6 млрд, тогда как ранее ожидалось, что они не превысят $3,4 млрд. Также компания прогнозирует возвращение роста выручки год к году. Как заявили в компании, рост во многом связан с большой востребованностью новых оптоволоконных решений для генеративного ИИ. В следующие три года ожидается увеличение годовых продаж более чем на $3 млрд под влиянием «циклических факторов и долговременных трендов». Итоговые финансовые результаты II квартала будут объявлены 30 июля. На фоне этих заявлений акции Corning выросли в цене. В компании связывают более оптимистичные прогнозы с рядом факторов, в первую очередь — успешными продажами оптоволокна для интерконнекта. Так, по данным Corning, параллельные ИИ-вычисления с помощью современных ускорителей требуют в 10 раз больше оптоволокна, чем традиционные облачные сети. Согласен расчётам компании, NVIDIA GB200 NVL72 требуется 576 волокон, то есть в 18 раз больше, чем в стойке с классическими серверными CPU. Corning является стратегическим активом для США, поскольку выпускает значительную часть оптоволокна для американских ВОЛС. Оптоволокно также является и важнейшим компонентом в самих ЦОД. А гиперскейлеры сейчас активно вкладываются в развитие инфраструктуры. Одна только Microsoft ежемесячно развёртывает по пять ИИ-суперкомпьютеров и рассчитывает до конца года иметь до 1,8 млн ускорителей на базе GPU, практически каждому из которых требуется собственное сетевое подключение. По данным Synergy Research Group, количество крупных ЦОД, управляемых гиперскейлерами, достигло 992 шт. ещё в конце 2023 года. Ожидается, что ежегодно они будут вводить в строй ещё 120–130 дата-центров, а генеративный ИИ называют первоочередной причиной такого взрывного роста. Рост инвестиций в ЦОД совпадает со значительным падением трат телеком-операторов по всему миру — это отчасти сказалась на показателях вендоров от Ericsson до Crown Castle и Corning. В результате многие вендоры стали искать новые возможности для роста. Так, Nokia назвала желание укрепиться на рынке ЦОД первоочередной причиной покупки Infinera за $2,3 млрд — это увеличит влияние компании на рынке ЦОД. Большие планы, связанные с развитием ИИ, вынашивают и в Cisco. Тем не менее, поставщики уверены, что телеком-операторы со временем возобновят закупки оптоволокна. Пока они используют избыточные запасы, накопленные во время пандемии COVID-19, но скоро эти резервы истощатся. Кроме того, в последние месяцы ведутся переговоры о развёртывании новых широкополосных телеком-магистралей. Corning подтвердила эти ожидания, во многом связанные с масштабной государственной программой США Broadband Equity Access and Deployment (BEAD).

09.07.2024 [14:05], Руслан Авдеев

Wells Fargo: бум ИИ ЦОД в США сыграет на руку поставщикам природного газаБум спроса на дата-центры, работающие с ИИ-приложениями, сулит большие выгоды энергетическим компаниям, поставляющим природный газ. По данным Datacenter Dynamics, с соответствующим прогнозом выступили эксперты Wells Fargo. Специалисты Инвестиционного института банка (Investment Institute, WFII) уверены, что сегодня такие энергоснабжающие структуры находятся в сильной позиции, позволяющей им снабжать новые ИИ ЦОД, активно строящиеся на территории Соединённых Штатов. В марте уже сообщалось, что проект нового газопровода Mountain Valley Pipeline, реализуемого Equitrans Midstream Corp., будет способствовать буму ИИ-технологий. Хотя большинство операторов хотели бы получать энергию для новых объектов из возобновляемых источников и всеми силами стремятся к этому, природный газ в США всё ещё удовлетворяет 43 % спроса на энергию, о чём свидетельствует статистика Управления энергетической информации страны (Energy Information Administration, EIA). Согласно докладу WFII, компании, поставляющие природный газ, поспособствуют процветанию многих современных ЦОД. В WFII заявляют, что возможности добычи природного газа в США и имеющиеся резервы достаточны для удовлетворения растущего спроса. Ключевым ограничением для роста пока является сопутствующая инфраструктура. Ожидается, что бенефициарами в сложившейся ситуации в первую очередь станут компании среднего уровня, им представляется возможность роста и более активного использования доступных активов, а ценность существующей газовой инфраструктуры со временем будет только расти. Эксперты ожидают, что доля природного газа в энергоснабжении США в ближайшем будущем останется стабильной, несмотря на то что в эксплуатацию вводятся всё новые источники возобновляемой энергии. Получаемое с помощью природного газа электричество — более экобезопасная альтернатива прочим углеводородам из ископаемого топлива. По статистике EIA, при сжигании газа выбрасывается 430 г CO2 на каждый кВт∙ч. В случае с углём речь идёт об 1 кг CO2, а для нефти — уже об 1,1 кг. Впрочем, по данным Всемирной ядерной ассоциации (World Nuclear Association), это несопоставимо с выбросами, связанными с эксплуатацией солнечных элементов питания (48 г/кВт∙ч) или АЭС (12 г/кВт∙ч). В прошлом месяце появилась информация о том, что Amazon (AWS) отправила в долгий ящик планы по перекачке природного газа в Орегон для питания своих ЦОД — это увеличило бы углеродный выброс действующих объектах, поскольку сегодня те запитаны преимущественно от ГЭС (фактического разделения нет, электричество поставляется из электрических магистралей штата). |

|