Материалы по тегу: облако

|

23.10.2025 [15:49], Андрей Крупин

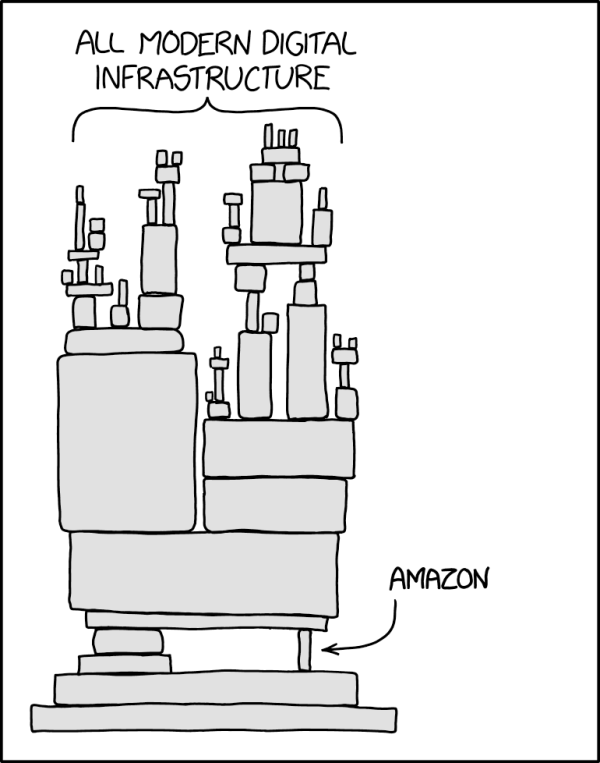

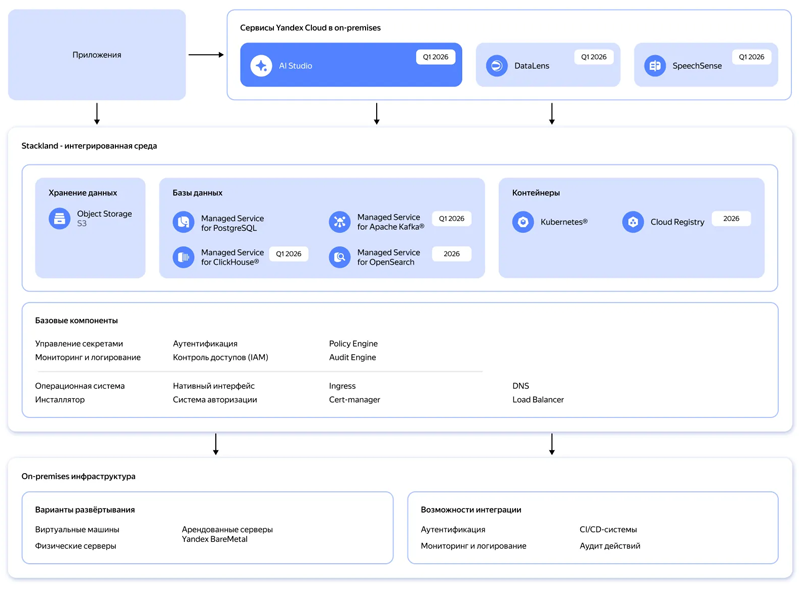

Yandex B2B Tech поможет компаниям быстро разворачивать инфраструктуру для ИИ-сервисов по модели On‑PremiseYandex B2B Tech (бизнес-группа «Яндекса», объединяющая технологии и инструменты компании для корпоративных пользователей, включая продукты Yandex Cloud и «Яндекс 360») сообщила о планах по запуску в первом квартале 2026 года нового инфраструктурного решения Yandex Cloud Stackland, с помощью которого организации смогут оперативно разворачивать инфраструктуру для управления ИИ‑нагрузками в закрытом контуре по модели on‑premise. Yandex Cloud Stackland предложит пользователям следующие компоненты для построения интегрированной ИИ-среды: платформу AI Studio для разработки ИИ-приложений и агентов, модуль речевой аналитики SpeechSense, BI-систему DataLens, контейнерный оркестратор, масштабируемое объектное S3-хранилище, управляемые СУБД PostgreSQL, ClickHouse, Kafka, а также векторные базы данных, которые распространены в RAG-решениях. В дополнение к этому будут представлены инструменты для обеспечения приложений доступом к графическим ускорителям и высокопроизводительным сетям, таким как InfiniBand, для задач распределённого инференса. Отдельное внимание будет уделено безопасности и защите обрабатываемых данных: Stackland получит встроенные средства IAM для гибкого разграничения доступов и инструменты для защищённого хранения паролей, токенов и сертификатов.

Архитектура Yandex Cloud Stackland (источник изображения: yandex.cloud/services/stackland) Stackland базируется на Kubernetes, что позволит компаниям применять привычные подходы и инструменты для управления микросервисными приложениями, а также управлять PaaS-сервисами Yandex Cloud через Kubernetes API. Ожидается, что интерес к Stackland проявят организации из сфер электронной коммерции, финтеха, ритейла и промышленного сектора, которые хотят использовать ИИ-решения на базе облачных технологий, но не могут сделать это из-за внутренних или регуляторных требований. Как передают «Ведомости», по оценке «Яндекса», в 2025 г. объём рынка контейнеризации составит 4–6 млрд руб., а к 2030 г. вырастет до 9–14 млрд руб. С новым решением компания планирует занять полоивину рынка инфраструктурного ПО для ИИ. Лицензирование Yandex Cloud Stackland будет производиться по количеству ядер CPU. Все инфраструктурные компоненты, в частности управляемые базы данных, будут включены в лицензию. Для отдельных сервисов, таких как AI Studio, DataLens и SpeechSense, нужно будет приобретать отдельные лицензии.

23.10.2025 [13:50], Руслан Авдеев

Неудобные вопросы: казначейство Великобритании выясняет, почему сбой AWS по ту сторону океана нарушил работу госведомств Соединённого Королевства

aws

lloyds banking

software

банк

великобритания

госуслуги

информационная безопасность

кии

конфиденциальность

облако

сбой

От правительства Великобритании потребовали ответить, почему многочасовой сбой в работе сервисов AWS (Amazon) на другом берегу Атлантики нарушил функциональность информационных систем британских структур, включая налоговую службу HMRC и Lloyds Banking Group, сообщает Computer Weekly. Многочасовой сбой 20 октября во флагманском регионе AWS US-East-1 в Северной Вирджинии (США) нарушил работу компаний и организаций по всему миру, в том числе и в Соединённом Королевстве. Поэтому в Великобритании и других странах растёт обеспокоенность тем, что частный и государственный сектора зависят от заокеанских служб — вновь появились призывы сохранить услуги национального значения под локальным контролем. Так, Казначейству Великобритании уже предложено отчитаться о том, почему предоставленные в январе этого года полномочия не помогли гарантировать надёжность сервисов в секторе финансовых услуг. В частности, почему платформа AWS (и не только она), которая является облачным провайдером большого числа финансовых учреждений Великобритании, до сих пор не включена в список критически важных третьих сторон (Critical Third Parties, CTP), который позволяет требовать от сторонних компаний соблюдения тех же высоких стандартов, что и от финансовых учреждений. Также чиновников попросили уточнить, не беспокоит ли их тот факт, что ключевые фрагменты британской IT-инфраструктуры размещены за рубежом, с учётом последствий недавнего сбоя. Также предлагается объяснить, какую работу проводят совместно с HMRC, чтобы предотвратить аналогичные сбои в будущем. В Министерстве финансов Великобритании заявили журналистам, что работают с регуляторами над внедрением режима CTP. В AWS же предложили спросить у самой HMRC, почему сбой в США так повлиял на неё. У AWS с 2016 года есть собственный облачный регион в Великобритании, причём платформа позволяет британским структурам получать доступ к локальным версиям публичных облачных сервисов. В AWS придерживаются «модели общей ответственности», при которой клиенты должны сами внимательно выбирать сервисы для размещения в облаке. Утверждается, что такой подход обеспечивает гибкость и контроль со стороны клиента. По мнению некоторых экспертов, сбой свидетельствует о том, что часть инфраструктуры HMRC и Lloyds зависела от американских мощностей, и это мог быть осознанный выбор британских структур, а не вина AWS. С другой стороны, инцидент показал, как сложна и взаимосвязана современная облачная инфраструктура. Заказчики могли не знать какие сервисы размещены в рамках их пакетов услуг в Великобритании и насколько они устойчивы. Например, Microsoft в своё сообщила, что не может гарантировать суверенитет данных полиции Великобритании, хранящихся и обрабатываемых на её платформе. Позже выяснилось, что данные британской полиции могут обрабатываться более чем в 100 странах, причём пользователи об этом не знали. В Forrester сообщают, что AWS осознаёт проблему и намерена запустить в Европе «идеальную копию» своих сервисов в рамках предложения суверенного облака. Первый изолированный регион предусмотрен в Германии. Фактически, единственный надёжный способ избавиться от иностранной зависимости — физическая и логическая изоляция облачных регионов, используемых клиентами. По словам экспертов, чем более «концентрированной» становится инфраструктура, тем более хрупкой и зависимой от внешнего управления она становится. Если Европа настроена на обретение цифрового суверенитета, ей необходимо скорее принять необходимые для этого меры. В частности, следует переосмыслить систему закупок, финансировать суверенные альтернативы и сделать обеспечение надёжности базовым требованием. Ранее эксперты пришли к выводу, что сбой в работе AWS наглядно продемонстрировал опасную зависимость всего мира от нескольких облачных гигантов из США. Европа так и не смогла избавиться от бремени американских гиперскейлеров, которые открыто признают, что даже не могут гарантировать суверенитет данных. При этом к AWS есть вопросы и у других британских регуляторов.

22.10.2025 [12:35], Руслан Авдеев

Сбой в работе AWS показал опасную зависимость мира от нескольких облачных гигантов из СШАМасштабный сбой в работе облака AWS в понедельник коснулся множества сервисов по всему миру во многих секторах экономики и общественной деятельности. Инцидент вызвал разговоры о зависимости пользователей от крупных облачных провайдеров из США, необходимости повышения цифрового суверенитета и диверсификации рисков, сообщает Datacenter Knowledge. В компании объявили, что причина — в «эксплуатационном инциденте» в регионе us-east-1, именно там расположен крупнейший кластер ЦОД провайдера. Облачный регион находится в т.н. «Аллее ЦОД» в Северной Вирджинии и состоит из 158 объектов общей мощностью 2,544 ГВт. По оценкам Amazon, более 90 % компаний из рейтинга Fortune 100 используют именно облачные сервисы AWS. Сбой стал крупнейшим инцидентом в работе интернета с тех пор, как в 2024 году из-за ошибки обновления Crowdstrike из строя по всему миру вышли миллионы систем Microsoft. По словам IDC, последний инцидент демонстрирует, как масштабные вычисления могут привести к масштабным проблемам. Хотя предприятия в целом приняли идею отказа от собственной инфраструктуры ЦОД, происшествие привлекает внимание к необходимости диверсификации рисков. Это может привести к созданию распределённых архитектур, охватывающих несколько облачных регионов в рамках пакетного предложения одного провайдера, и более широкому использованию нескольких облаков разных провайдеров одновременно. Эксперты обеспокоены зависимостью предприятий всего мира от американских гиперскейлеров — последствия инцидента носят трансграничный характер и касаются не только клиентов одного поставщика облачных сервисов. Многие уже задаются вопросом — стоит ли сохранять зависимость государственных учреждений, от налоговых служб государство до крупных банков службам, расположенным на другом побережье Атлантического океана. Европа так и не смогла избавиться от бремени американских гиперскейлеров, которые открыто признают, что даже не могут гарантировать суверенитет данных. Как заявляют в британской Asanti Data Centres, многие организации активно приняли концепцию публичных облаков, но сбой показал, что может случиться, когда всё построено на одном фундаменте. Проблема затронула не только структуры, напрямую использующие сервисы AWS, но и всех остальных в цепочке поставок услуг. Большинство организаций ведут дела с клиентами AWS, в результате чего речь идёт о каскадном, общесистемном ущербе.

Источник изображения: Oğuzhan Akdoğan/unspalsh.com В IDC подчёркивают, что роль в купировании негативных эффектов от будущих инцидентов может сыграть ИИ. Хотя у AWS в целом довольно хорошая репутация среди пользователей, на устранение последствий инцидента потребовалось слишком много времени, поэтому возникают сомнения, сможет ли AWS поддерживать репутацию по мере роста бизнеса и усложнения технологий. ИИ может помочь, создавая агентов, способных заранее выявлять и устранять проблемы до того, как они негативно скажутся на клиентах. Стоит отметить, что концентрация облачных ресурсов в одном месте может действительно крайне негативно сказаться на деятельности целых государств. Недавний пожар в южнокорейском ЦОД показывает, к каким катастрофическим последствиям для государственных услуг может привести консолидация облачных мощностей в одном месте. Более того, даже концентрация крупных ЦОД разных операторов в одном месте грозит тем, что сбой одного из них приведёт к проблемам у соседних. Особенно в случае ИИ ЦОД.

21.10.2025 [00:35], Владимир Мироненко

Ещё одна альтернатива платформам NVIDIA — IBM объединила усилия с GroqIBM и Groq объявили о стратегическом партнёрстве с целью предоставления клиентам возможностей высокоскоростного ИИ-инференса по доступной цене путём объединения watsonx Orchestrate от IBM с аппаратными решениями Groq, что позволит ускорить развёртывание агентных систем ИИ. В рамках партнёрства Groq и IBM планируют интегрировать и усовершенствовать технологию Red Hat vLLM с архитектурой LPU Groq. Ожидается, что совместное решение позволит клиентам использовать возможности watsonx Orchestrate привычным образом и с привычными инструментам в инференс-платформе GroqCloud, предоставляющей разработчикам доступ к высокоскоростной и недорогой обработке LLM. Эта интеграция позволит удовлетворить ключевые потребности разработчиков ИИ-решений, включая оркестрацию инференса, балансировку нагрузки и аппаратное ускорение, что в конечном итоге оптимизирует сам процесс инференса. Также планируется поддержка моделей IBM Granite в GroqCloud для клиентов IBM. IBM отметила, что предприятия при переводе ИИ-агентов из пилотной версии в промышленную эксплуатацию продолжают сталкиваться с проблемами обеспечения скорости, стоимости и надёжности. Партнёрство IBM и Groq позволяет объединить скорость инференса Groq, экономическую эффективность и доступ к новейшим open source моделям с оркестрацией агентского ИИ IBM, предоставляя клиентам инфраструктуру, необходимую для их масштабирования, говорит компания. IBM сообщила, что LPU обеспечивают минимум в пять раз более быстрый и экономичный инференс, чем системы на ускорителях конкурентов, имея, по всей видимости, в виду NVIDIA. Это позволяет обеспечить стабильно низкую задержку и производительность при масштабировании нагрузок, что особенно важно для ИИ-агентов в регулируемых отраслях. В качестве примера IBM привела деятельность клиентов из сферы здравоохранения, которые одновременно получают тысячи сложных вопросов пациентов. Благодаря Groq ИИ-агенты IBM смогут анализировать информацию в режиме реального времени и мгновенно предоставлять точные ответы, позволяя организациям в этой сфере принимать более оперативные и обоснованные решения. В нерегулируемых отраслях клиенты IBM с помощью платформы GroqCloud смогут ускорить работу ИИ-агентов и повысить автоматизацию кадровых процессов и производительность сотрудников. IBM объявила, что сразу же предоставит клиентам доступ к возможностям GroqCloud, а совместные с Groq команды сосредоточатся на предоставлении заказчикам IBM следующих возможностей:

Groq привлекла инвестиции в размере $1,8 млрд, включая раунд финансирования на сумму $750 млн в прошлом месяце с оценкой в $6,9 млрд. В числе её инвесторов — Cisco и Samsung. Также Groq сотрудничает с саудовской Aramco Digital. По данным WSJ, компания развернула в этом году 12 ЦОД и намерена развернуть как минимум ещё 12 в 2026 году. В 2024 году Groq сменила модель работы — с тех пор она больше не продаёт свои ИИ-ускорители, предлагая вместо этого создание ЦОД или облака.

20.10.2025 [14:16], Владимир Мироненко

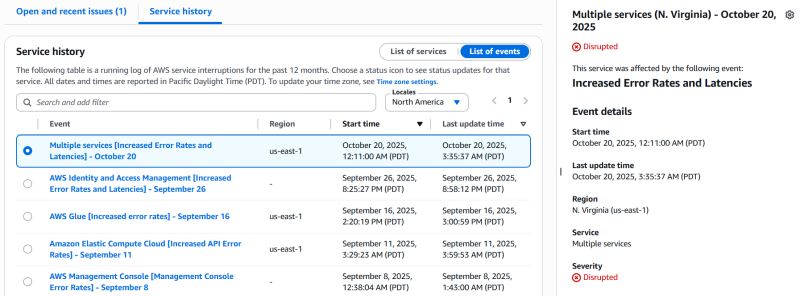

AWS столкнулась с серьёзным сбоем из-за ошибки DNS — падение одного сервиса потянуло за собой ещё 110 служб [Обновлено]Облако Amazon Web Services (AWS) столкнулось со серьёзным сбоем, из-за которого сейчас могут быть недоступны такие онлайн-сервисы, как Perplexity, Snapchat, Fortnite, Airtable, Canva, Amazon, Slack, Signal, PlayStation, Clash Royale, Brawl Stars, Epic Games Store и Ring Cameras, пишет Data Center Dynamics. Согласно отчёту Amazon, наблюдается «значительный уровень ошибок в запросах к DynamoDB в регионе US-EAST-1», который находится в Северной Вирджинии. Компания отметила, что эта проблема также затрагивает другие сервисы AWS в регионе US-EAST-1, а у клиентов может не быть возможности создавать или обновлять запросы в службу поддержки. Первопричиной проблем стала ошибка DNS. AWS её исправила и теперь занимается восстановлением доступности других сервисов. Проблема DynamoDB затронула другие сервисы AWS, включая AWS Global Accelerator, AWS VPCE PrivateLink, AWS Security Token Service, AWS Step Functions, AWS Systems Manager, Amazon CloudFront, Amazon DynamoDB, Amazon Elastic Compute Cloud, Amazon EventBridge, Amazon EventBridge Scheduler, Amazon GameLift Servers, Amazon Kinesis Data Streams, Amazon SageMaker и Amazon VPC Lattice — всего 82 службы. Сбои в работе сервисов AWS наблюдаются в других регионах по всему миру. Проблемы в работе AWS в регионе US-East-1 привели к масштабным сбоям в 2023, 2021 и 2020 годах, в результате чего было отключено множество веб-сайтов и платформ. Лишь спустя несколько часов было восстановлено нормальное обслуживание, сообщил The Verge. UPD: по состоянию на 21:45 МСК AWS продолжает работать над устранением проблем. По уточнённым данным, проблемы наблюдаются в 110 сервисах облака. Работа ещё 25 сервисов восстановлена. В качестве причины названы проблемы с сетью в US-EAST-1.

20.10.2025 [01:23], Владимир Мироненко

Ускорителей хватит на всех — Alibaba Aegaeon оптимизировал обработку ИИ-нагрузок, снизив использование дефицитных NVIDIA H20 на 82 %Alibaba Cloud представила Aegaeon, систему пулинга вычислений, позволяющую сократить количество ускорителей NVIDIA, необходимых для обслуживания ИИ-моделей, на 82 %, пишет ресурс SCMP. По словам разработчиков, благодаря Aegaeon количество ускорителей NVIDIA H20, необходимых для обслуживания десятков моделей с 72 млрд параметров, удалось сократить с 1192 до 213 единиц. «Aegaeon — это первое решение на рынке, которое выявило чрезмерные затраты, связанные с обслуживанием параллельных рабочих нагрузок LLM», — сообщили исследователи из Пекинского университета и Alibaba Cloud. Провайдеры облачных сервисов, такие как Alibaba Cloud и ByteDance Volcano Engine, предоставляют пользователям одновременно тысячи ИИ-моделей — множество вызовов API обрабатывается одновременно. Однако на практике для инференса чаще всего используются лишь несколько моделей, таких как Qwen и DeepSeek, а большинство других моделей применяются лишь эпизодически. Это приводит к неэффективному использованию вычислительных ресурсов: исследователи обнаружили, что 17,7 % ускорителей выделяется на обслуживание лишь 1,35 % запросов в Alibaba Cloud. Aegaeon выполняет «автоматическое масштабирование» на уровне токенов, обеспечивая переключение ускорителей между обслуживанием различных моделей в процессе генерации. В рамках системы один ускоритель поддерживает обработку до семи моделей по сравнению с двумя-тремя моделями в альтернативных системах. При этом задержка, связанная с переключением между моделями, снижена на 97 %, заявили исследователи. Alibaba Cloud сообщила, что решение уже используется на её торговой площадке моделей Bailian. Глава NVIDIA Дженсен Хуанг (Jensen Huang) объявил, что из-за экспортных ограничений доля компании на рынке передовых чипов в Китае сократилась с 95 % до нуля. Этому также способствовала стратегия Пекина, направленная на самообеспечение местного рынка. В связи с этим планы NVIDIA возобновить отгрузки ИИ-ускорителей H20, на которые ранее были установлены ограничения правительством США, встретили в Китае довольно прохладно. Более того, в Китае вынесли запрет местным компаниям на покупку разработанного специально для местного рынка ускорителя NVIDIA RTX Pro 6000D, поскольку пришли к выводу, что китайские ИИ-чипы не уступают продукции NVIDIA, разрешённой к экспорту в Китай.

17.10.2025 [14:49], Андрей Крупин

VK Cloud, Yandex Cloud и «Флант» создадут первую в России некоммерческую ассоциацию по облачным технологиямКомпании VK Cloud, Yandex Cloud и «Флант» объявили о планах по созданию некоммерческой Ассоциации облачно-ориентированных технологий (АОТ) — первой в РФ организации, которая займётся развитием новых подходов, стандартов и архитектуры нативных облачных технологий без привязки к конкретному вендору. АОТ призвана объединить игроков отечественного облачного рынка для популяризации облачных технологий, таких как Kubernetes и Cloud-native. Ключевыми задачами ассоциации станут продвижение и внедрение Cloud-native-решений через стандартизацию подходов и компетенций в разработке ПО, поддержка и развитие Open Source-продуктов, а также их внедрение в бизнес-среде, популяризация облачных технологий и Kubernetes, а также развитие и объединение профессионального сообщества.

Источник изображения: Monisha Selvakumar / unsplash.com Стать партнёром АОТ сможет любая компания, использующая в работе облачные технологии, а участником — любой IT-специалист. Статус партнёра предполагает ежегодные взносы, которые идут на проекты ассоциации, и открывает доступ к проектам и ресурсам АОТ. «Мы считаем, что базовые облачные технологии должны быть доступны всем, и у каждого должна быть возможность вносить в них свой вклад. Наша совместная задача с партнёрами из Ассоциации облачно-ориентированных технологий — объединить усилия крупнейших организаций и всех инженеров, которым не безразличен Open Source, чтобы ускорить развитие индустрии в целом», — прокомментировали инициативу в компании «Флант».

16.10.2025 [16:20], Андрей Крупин

VK Tech запустил сервис виртуальных карт GPUРоссийский разработчик корпоративного программного обеспечения VK Tech (входит в экосистему VK) сообщил о включении в состав облачной платформы VK Cloud виртуальных GPU-карт. Виртуальные GPU реализованы на базе аппаратных решений компании Nvidia и доступны в VDI-сервисе Cloud Desktop, предназначенном для доставки пользователям рабочих столов, развёрнутых на удалённом сервере и функционирующих в виртуализированном окружении. Поддержка GPU может быть актуальна для проектирования, анимации, редактирования видео, 3D-моделирования, рендеринга, тяжёлых вычислений, машинного обучения и других ресурсоёмких задач.

Источник изображения: Christina @ wocintechchat.com / unsplash.com «Мы стремимся сделать технологии более доступными для наших пользователей. Облачные вычисления на базе GPU помогут повысить производительность решений, сократить время на обработку данных и снизить расходы. Новый сервис позволяет быстро получить готовую к работе видеокарту и оплатить только необходимый объем её мощностей», — отмечает VK Tech. Инфраструктура VK Cloud соответствует 152-ФЗ на высшем уровне защищённости (УЗ-1), а также стандартам ГОСТ Р 57580 и PCI DSS.

15.10.2025 [13:34], Руслан Авдеев

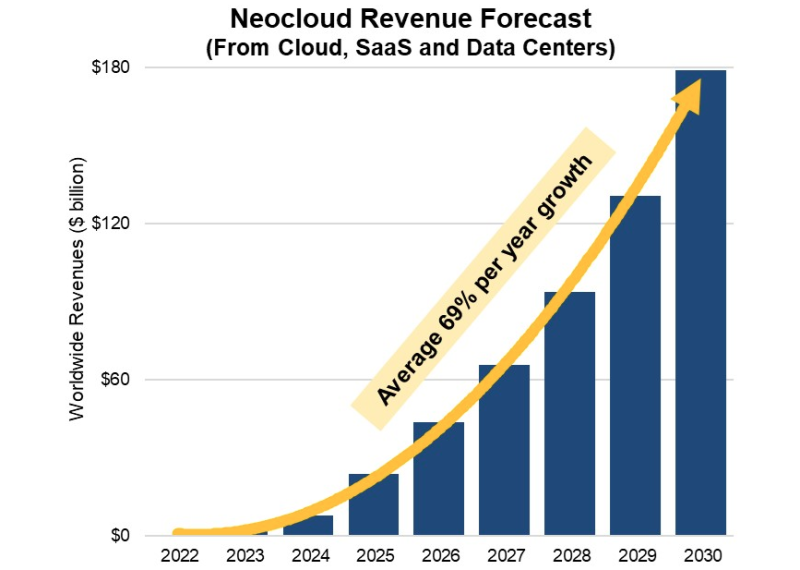

Квартальная выручка неооблаков выросла на 200 %, а в 2030 году она достигнет $180 млрдНовые данные Synergy Research Group свидетельствуют о том, что выручка неооблачных (neocloud) компаний преодолела во II квартале 2025 года отметку в $5 млрд, рост составил 205 % год к году. За весь год выручка, вероятно, превысит $23 млрд. Эксперты компании прогнозируют, что в 2030 году выручка достигнет почти $180 млрд, среднегодовой темп прироста составит порядка 69 %. Хотя неооблачные компании столкнулись с ожесточённой конкуренцией, они получают основную прибыль от работы с нишами, в которых наблюдается взрывной рост, и это чрезвычайно выгодно. Хотя перспективы таких компаний пока не вполне ясны, в среднем Synergy ожидает их стабильного роста. В конкуренции с «классическими» провайдерами-гиперскейлерами безусловным лидером посчитали компанию CoreWeave, в своё время оставившую криптовалютный бизнес для работы с ИИ-облаками. Хотя бизнес-модель OpenAI отличается от средств заработка прочих неооблачных провайдеров, компания считается в группе крупнейшей и останется ключевым игроком в ближайшие годы благодаря инициативам Stargate. Неооблачные компании представляют собой новые, развивающиеся облачные вычислительные платформы, обеспечивающие высокую производительность, ориентированную на использование ИИ-ускорителей инфраструктуру. Основными направлениями являются предоставление в аренду ускорителей (GPUaaS), платформенные сервисы для разработки и запуска генеративного ИИ (GenAI), а также управление высокопроизводительными дата-центрами.

Источник изображения: Synergy Research Group На сегодня основными компаниями, зарабатывающими на этом рынке существенные средства и влияющими на состояние фондового рынка, являются CoreWeave, Crusoe, Lambda, Nebius и OpenAI. В первую очередь благодаря OpenAI неооблака также предоставляют SaaS-подобные подписки для доступа к передовым ИИ-ботам. Помимо ведущих компаний из этой ниши, имеется ряд бизнесов намного менее масштабных или на ранних стадиях запуска: Altair, Applied Digital, Bitdeer, Core42, Core Scientific, DataRobot, Fluidstack, Hive Digital, HUMAIN, Hut8, IREN, Mawson, Northern Data Group, Nscale, TeraWulf, Together AI и WhiteFiber. Неооблачные компании являются относительно небольшими стартапами, либо компаниями, изменившими бизнес-модели с криптовалютных проектов на облачные вычислительные сервисы. Ведущие гиперскейлеры также предоставляют в аренду ИИ-ускорители и предлагают ИИ-сервисы, но неооблачные компании в основном обеспечивают доступ именно к чипам и сопутствующей инфраструктуре, а не широкому портфолио облачных сервисов. Как заявляют в Synergy, если не рассматривать «хайп», сопутствующий деятельности неооблачных компаний, темпы их роста и перспективы действительно впечатляют. GPUaaS и ИИ-сервисы растут сегодня на 165 % в год, причём неооблачные бизнесы играют в этих сегментах заметную роль. Есть все основания полагать, что они продолжать наращивать долю рынка на фоне того, что все облачные провайдеры стремятся удовлетворить растущий спрос на ИИ. У аналитиков JLL имеются собственные выкладки о прогрессе неооблачных компаний. В конце сентября компания сообщила, что среднегодовой темп роста выручки (GAGR) неооблаков с 2021 года составил 82 %.

15.10.2025 [12:14], Владимир Мироненко

Oracle запустит в 2026 году ИИ-кластер на базе 50 тыс. AMD Instinct MI450Oracle объявила о расширении сотрудничества с AMD, в рамках которого Oracle Cloud Infrastructure (OCI) запустит первый публично доступный ИИ-суперкластер на базе 50 тыс. ускорителей AMD Instinct MI450. Согласно пресс-релизу, первоначальное развёртывание кластера начнётся в III квартале 2026 года, после чего он будет расширяться в 2027 году, а также в дальнейшем. Будущие ИИ-кластеры OCI будут основаны на стоечной архитектуре AMD Helios с использованием ускорителей AMD Instinct серии MI450, процессоров AMD EPYC следующего поколения с кодовым названием Venice и сетевой системы AMD Pensando следующего поколения с кодовым названием Vulcano. Махеш Тиагараджан (Mahesh Thiagarajan), исполнительный вице-президент OCI отметил, что благодаря десятилетнему сотрудничеству с AMD — от ускорителей EPYC до AMD Instinct — компания продолжает предоставлять «оптимальную по соотношению цены и производительности, открытую, безопасную и масштабируемую облачную платформу в партнерстве с AMD, чтобы удовлетворить потребности клиентов в новой эре ИИ». Ускоритель AMD Instinct MI450 основан на архитектуре CDNA 5 и изготавливается по 2-нм техпроцессу TSMC. Ускоритель будет обладать до 432 Гбайт памяти HBM4 с пропускной способностью 20 Тбайт/с. Стойка AMD Helios с 72 ускорителями AMD Instinct MI450 объединяет возможности масштабирования UALoE и масштабируемую сеть на базе Ethernet, соответствующую стандартам Ultra Ethernet (UEC), для минимизации задержек и максимальной пропускной способности между модулями и стойками.

Источник изображения: Oracle Сообщается, что процессоры EPYC (Venice) будут предлагать возможности конфиденциальных вычислений и встроенные функции безопасности для комплексной защиты конфиденциальных рабочих ИИ-нагрузок. Конвергентные сети с DPU, созданные на основе полностью программируемой технологии AMD Pensando, обеспечат безопасность и производительность, необходимые ЦОД для работы с ИИ следующего поколения, включая обучение, инференс и облачные рабочие нагрузки. Каждый ускоритель может быть оснащён до трёх DPU Vulcano со скоростью передачи данных 800 Гбит/с. Несколько месяцев назад Oracle и AMD объявили, что провайдер облачных вычислений развернёт кластер, включающий до 131 072 ускорителей AMD MI355X, на основе ранее запущенного кластера на базе AMD Instinct MI300X. Ранее в этом месяце стало известно о соглашении AMD с OpenAI на поставку ИИ-ускорителей AMD нескольких поколений общей мощностью 6 ГВт на сумму около $60–$80 млрд для обеспечения её ИИ-инфраструктуры. |

|