Материалы по тегу: к

|

29.08.2024 [01:00], Владимир Мироненко

NVIDIA вновь показала лидирующие результаты в ИИ-бенчмарке MLPerf InferenceNVIDIA сообщила, что её платформы показали самые высокие результаты во всех тестах производительности уровня ЦОД в бенчмарке MLPerf Inference v4.1, где впервые дебютировал ускоритель семейства Blackwell. Ускоритель NVIDIA B200 (SXM, 180 Гбайт HBM) оказался вчетверо производительнее H100 на крупнейшей рабочей нагрузке среди больших языковых моделей (LLM) MLPerf — Llama 2 70B — благодаря использованию механизма Transformer Engine второго поколения и FP4-инференсу на Tensor-ядрах. Впрочем, именно B200 заказчики могут и не дождаться. Ускоритель NVIDIA H200, который стал доступен в облаке CoreWeave, а также в системах ASUS, Dell, HPE, QTC и Supermicro, показал лучшие результаты во всех тестах в категории ЦОД, включая последнее дополнение к бенчмарку, LLM Mixtral 8x7B с общим количеством параметров 46,7 млрд и 12,9 млрд активных параметров на токен, использующую архитектуру Mixture of Experts (MoE, набор экспертов). Как отметила NVIDIA, MoE приобрела популярность как способ привнести большую универсальность в LLM, поскольку позволяет отвечать на широкий спектр вопросов и выполнять более разнообразные задачи в рамках одного развёртывания. Архитектура также более эффективна, поскольку активируются только несколько экспертов на инференс — это означает, что такие модели выдают результаты намного быстрее, чем высокоплотные (Dense) модели аналогичного размера. Также NVIDIA отмечает, что с ростом размера моделей для снижения времени отклика при инференсе объединение нескольких ускорителей становится обязательными. По словам компании, NVLink и NVSwitch уже в поколении NVIDIA Hopper предоставляют значительные преимущества для экономичного инференса LLM в реальном времени. А платформа Blackwell ещё больше расширит возможности NVLink, позволив объединить до 72 ускорителей. Заодно компания в очередной раз напомнила о важности программной экосистемы. Так, в последнем раунде MLPerf Inference все основные платформы NVIDIA продемонстрировали резкий рост производительности. Например, ускорители NVIDIA H200 показали на 27 % большую производительность инференса генеративного ИИ по сравнению с предыдущим раундом. А Triton Inference Server продемонстрировал почти такую же производительность, как и у bare-metal платформ. Наконец, благодаря программным оптимизациям в этом раунде MLPerf платформа NVIDIA Jetson AGX Orin достигла более чем 6,2-кратного улучшения пропускной способности и 2,5-кратного улучшения задержки по сравнению с предыдущим раундом на рабочей нагрузке GPT-J LLM. По словам NVIDIA, Jetson способен локально обрабатывать любую модель-трансформер, включая LLM, модели класса Vision Transformer и, например, Stable Diffusion. А вместо разработки узкоспециализированных моделей теперь можно применять универсальную GPT-J-6B модель для обработки естественного языка на периферии.

26.08.2024 [11:16], Сергей Карасёв

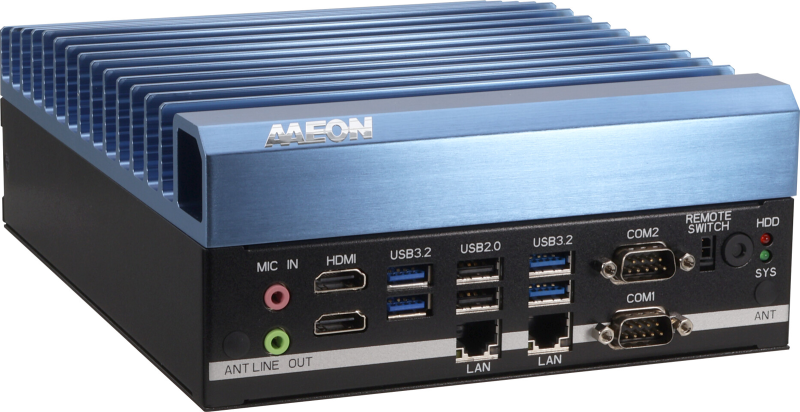

AAEON выпустила встраиваемую систему Boxer-6645U-RPL на базе Intel Raptor LakeКомпания AAEON анонсировала встраиваемые системы Boxer-6645U-RPL и Boxer-6406U-ADN на аппаратной платформе Intel. Устройства совместимы с Windows 10 IoT Enterprise, Windows 11 Pro и Ubuntu 22.04. Новинки могут применяться, в частности, для промышленной автоматизации. Модель Boxer-6645U-RPL допускает установку процессоров Core 14-го поколения семейства Raptor Lake. Максимальная конфигурация включает чип Core i9-14900 с 24 ядрами (8Р; 16Е; 32 потока; до 5,8 ГГц). Диапазон рабочих температур простирается от -25 до +70 °C при использовании процессоров с TDP до 35 Вт и -25 до +55 °C в случае применения изделий с TDP до 65 Вт. Компьютер оснащён двумя слотами SO-DIMM для модулей DDR5 суммарным объёмом до 64 Гбайт, двумя посадочными местами для SFF-накопителей, коннектором M.2 2280 M-Key (PCIe 3.0 x4) для SSD (NVMe), слотом M.2 2230 E-Key для адаптера Wi-Fi/Bluetooth, разъёмом MiniPCIe. Есть сетевые контроллеры Intel I219-LM 1GbE и Intel I226-LM 2.5GbE. На фронтальную панель выведены два интерфейса HDMI, четыре порта USB 3.2 Gen2 и два порта USB 2.0, два последовательных порта (RS-232/422/485), гнёзда RJ-45 для сетевых кабелей, аудиогнёзда на 3,5 мм. Габариты составляют 180 × 77,2 × 220 мм, масса — 2,9 кг. Встраиваемая система Boxer-6406U-ADN, в свою очередь, может комплектоваться чипом Intel Processor N200 (четыре ядра; четыре потока; 3,7 ГГц), Intel Processor N50 (два ядра; два потока; 3,4 ГГц) или Atom X7211E (два ядра; два потока; 3,2 ГГц) серии Alder Lake-N. Имеется один слот SO-DIMM для модуля DDR5-4800 ёмкостью до 32 Гбайт. Возможна установка одного SFF-накопителя и SSD формата M.2 2280 (PCIe 3.0 x2). В оснащение включены двухпортовый сетевой контроллер Intel I226-LM 2.5GbE, коннектор M.2 2230 E-Key, разъём Mini Card (PCIe + USB), слот для SIM-карты (может быть добавлен сотовый модем). Есть по два интерфейса HDMI, USB 3.2 Gen2 Type-A и USB 2.0, два гнезда RJ-45 и два последовательных порта (RS-232/422/485). Диапазон рабочих температур — от -20 до +60 °C. Устройство имеет размеры 164 × 104,5 × 47 мм и весит 0,93 кг.

22.08.2024 [17:26], Руслан Авдеев

Маск полтора года не платит даже за поставленные серверы: появились подробности об иске Wiwynn к X (Twitter)На прошлой неделе Wiwynn, поставляющая серверы и комплектующие для гиперскейлеров, подала в Калифорнии иск к X (бывшую Twitter), обвинив последнюю в нарушении соглашения о поставках оборудования, подписанного ещё в 2014 году и до недавних пор соблюдаемого соцсетью. По данным DigiTimes, в материалах иска были раскрыты подробности взаимоотношений компаний. X, судя по всему, более не является клиентом Wiwynn, свои последние ИИ-серверы соцсеть покупала у Dell и Supermicro. Заявляется, что с ноября 2022 года X прекратила платить Wiwynn и отказалась выполнять ранее взятые обязательства. Из-за этого Wiwynn пошла на обострение отношений с бывшим партнёром 16 августа 2024, потребовав компенсаций. Судя по материалам жалобы, политика X грозила Wiwynn потенциальными потерями в размере $101 млн — это соответствует 1,32 % всей выручки последней в 2023 году. Для смягчения потерь компании пришлось срочно продавать некоторые комплектующие, снизив прямые потери до $61 млн или 0,79 % выручки. По данным источников DigiTimes, Wiwynn уже некоторое время занимается решением данной проблемы, так что значительной части потерь, похоже, удалось избежать. 24 сентября 2014 года Wiwynn и X подписали соглашение Master Purchase Agreement (MPA), которое, в частности, покрывало поставки серверного оборудования. MPA предусматривало предварительный прогноз будущих заказов Twitter. На основе прогноза Wiwynn готовила список компонентов, закупки которых осуществлялись только после письменного одобрения со стороны Twitter. По условия соглашения, X несла ответственность за неиспользованное «железо». В последующие восемь лет компании соблюдали условия соглашения, а X (Twitter) добросовестно платила за продукты, поставлявшиеся партнёром. Последний одобренный и подписанный Twitter заказ предполагал закупку компонентов на $120 млн. В ноябре 2022 года, после перехода соцсети к Илону Маску (Elon Musk), который объявил о намерении урезать затраты на IT-инфраструктуру на $1 млрд/год, X прекратила оплачивать счета, в том числе за уже поставленное оборудование. Wiwynn безуспешно пыталась наладить контакт с X, стараясь получить платежи и решить вопросы с поставкой компонентов в целом, но ответа не последовало. Wiwynn попыталась минимизировать возможные убытки, отменив заказы на поставки компонентов приблизительно на $40 млн и вернув около $19 млн путём продажи неиспользованных компонентов или установки их в оборудование других заказчиков. Тем не менее, многие компоненты были высокоспециализированными и найти им другое применение оказалось нелегко или вовсе невозможно, что и стало причиной судебного иска. Забавно, что на фоне всевозможных тяжб за каждый доллар, в X нашёлся полностью готовый к работе, но простаивающий кластер некогда дефицитных ускорителей NVIDIA V100.

20.08.2024 [16:21], Руслан Авдеев

Wiwynn судится с X (Twitter), требуя $61 млн за серверы и компонентыПоставщик серверного оборудования для гиперскейлеров Wiwynn (подразделение Wistron) подал в суд на компанию X (ранее Twitter). По данным Datacenter Dynamics, тайваньский вендор обвиняет контрагента в отказе заплатить $120 млн в рамках договора на поставку серверов и требует компенсацию в объёме $61 млн. Утверждается, что после покупки Twitter Илоном Маском (Elon Musk) социальная сеть «внезапно прекратила» платить и начала игнорировать запросы на оплату уже готовых продуктов. В рамках соглашения с X компания закупила комплектующие для серверов на сумму $120 млн, которые так и не были доставлены заказчику. Тогда же соцсеть по указанию Маска начала сокращать облачные расходы и закрывать дата-центры для того, чтобы выплатить долги, связанные с её покупкой. Wiwynn смогла отменить заказы или вернуть компоненты на сумму приблизительно $59 млн, но теперь ищет компенсацию в размере $61 млн. В IV квартале 2022 года от действий Twitter также пострадала и MiTAC, списавшая $43,71 млн, передаёт UDN. Впрочем, прямых обвинений в сторону соцсети от компании не было, а ко II кварталу 2023 года она смогла исправить финансовую ситуацию, перепродав или вернув серверные компоненты, предназначавшиеся Twitter. Twitter оставила ЦОД в Сакраменто, который в итоге достался Tesla, и сократил ёмкости в Атланте (Джорджия). Причём в Джорджии Маск добился получения налоговых льгот на расширение инфраструктуры. Параллельно компания отказалась платить по счетам Google Cloud и Oracle Cloud, а также прекратила платежи AWS — до тех пор, пока Amazon не отказалась оплачивать рекламу в социальной сети. Исход из Сакраменто, по данным компании, позволил Twitter экономить $100 млн в год. Бизнес Маска отчаянно отбивается от многочисленных судебных исков, включая поданные бывшим генеральным директором Парагом Агарвалом (Parag Agarwal) на сумму $128 млн и бывшим председателем Омидом Кордестани (Omid Kordestani) на $20 млн, лишившимися своих мест. Впрочем, в прошлом месяце Маск уже выиграл дело против бывших сотрудников Twitter, требовавших $500 млн в качестве компенсации за массовые сокращения.

05.08.2024 [12:32], Сергей Карасёв

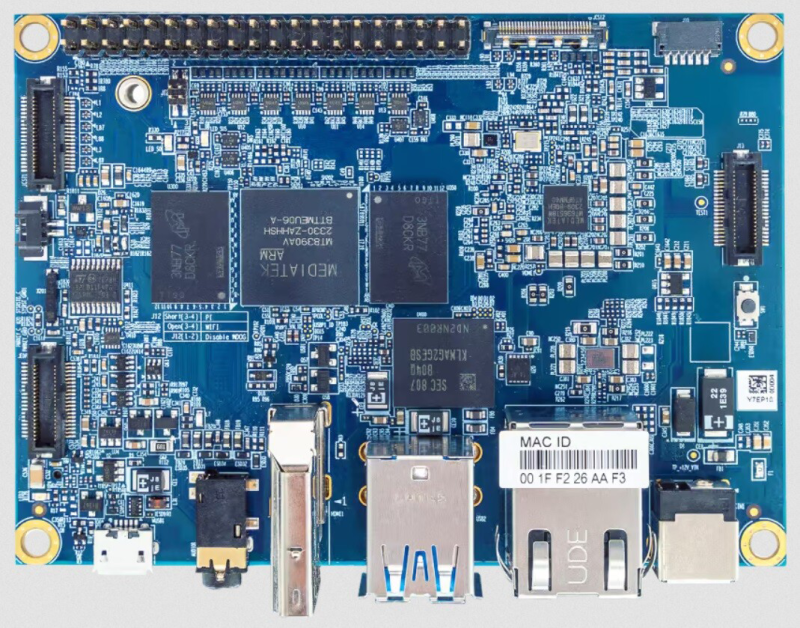

VIA представила edge-решения на платформе MediaTek Genio 700Компания VIA Technologies представила вычислительный модуль SOM-5000, одноплатный компьютер VAB-5000 и встраиваемую систему Artigo A5000 на аппаратной платформе MediaTek. Новинки предназначены для построения различных edge-решений с поддержкой ИИ-функций. Во всех изделиях применён процессор Genio 700. Чип содержит восемь вычислительных ядер: 2 × Arm Cortex A78 (2,2 ГГц) и 6 × Arm Cortex A55 (2,0 ГГц). В состав Genio 700 входит графический узел Arm Mali-G57 MC3 с поддержкой OpenGL ES 1.1/2.0/3.2, OpenCL ES 2.2, Vulkan 1.0/1.1. Возможно кодирование видео H.265 и H.264 в формате 4K (до 30 к/с).

Источник изображений: VIA Technologies Модуль SOM-5000 может нести на борту 4 или 8 Гбайт оперативной памяти LPDDR4X и 16 Гбайт флеш-памяти (eMMC). Поддерживаются интерфейсы 2 × MIPI DSI (4 линии), 2 × MIPI CSI (4 и 2 линии), HDMI 2.0, DisplayPort, USB 3.1, 3 × USB 2.0, 2 × SPI, I2S, 6 × I2C, 3 × UART, PCIe, SDIO, 1GbE, 11 × GPIO. Для модуля доступна плата SOMDB7 Carrier Board с набором разъёмов, включая HDMI, 2 × USB 3.1, Micro-USB 2.0, 2 × RJ-45 и 3,5-мм аудиогнездо. Диапазон рабочих температур — от -10 до +60 °C. Одноплатный компьютер VAB-5000 может комплектоваться 4 или 8 Гбайт памяти LPDDR4X и флеш-чипом eMMC на 16 Гбайт. В оснащение входит сетевой контроллер Realtek RTL8211F(I)-CG 1GbE. Предусмотрены интерфейс HDMI, два порта USB 3.1, порт Micro-USB 2.0, коннектор RJ-45 для сетевого кабеля и 3,5-мм аудиогнездо. Имеется слот M.2 для сотового модема 4G/5G (плюс разъём для карты Nano-SIM). Упомянута 40-контактная колодка GPIO в стиле Raspberry Pi. Изделие выполнено в формате Pico-ITX с размерами 100 × 72 мм. Плату можно использовать при температурах от -20 до +60 °C. Мини-компьютер Artigo A5000 выполнен в корпусе с размерами 118,61 × 37,6 × 82,2 мм. Технические характеристики аналогичны одноплатному компьютеру VAB-5000. Все новинки могут работать с Android 13, Yocto 4.0.x и Debian 12. Питание (12 В) подаётся через DC-разъём.

01.08.2024 [23:55], Алексей Степин

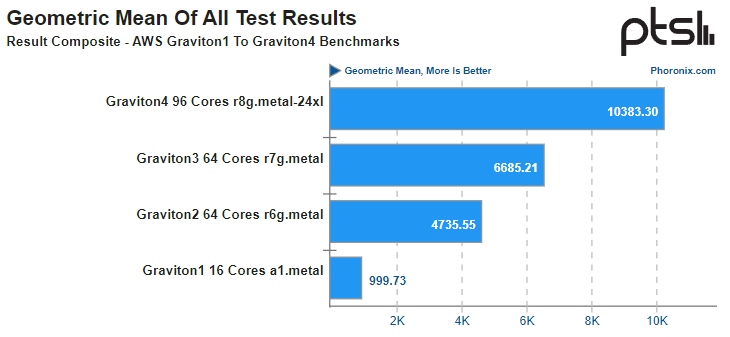

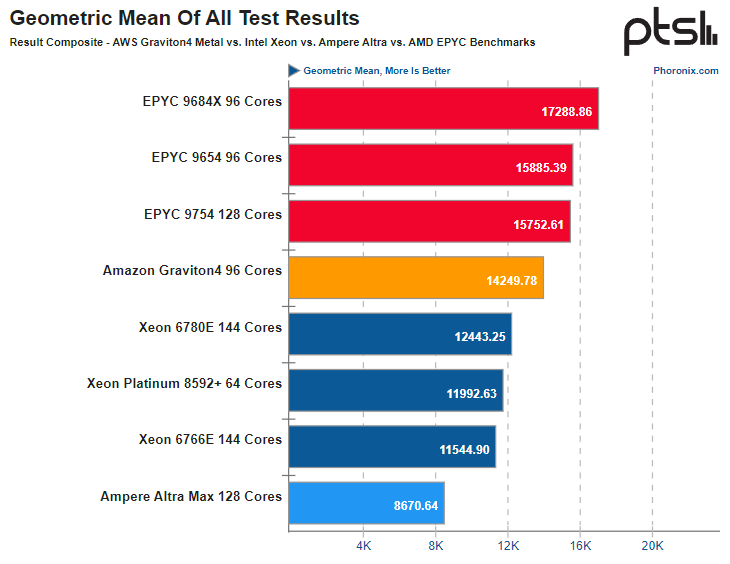

Arm-процессоры AWS Graviton4 успешно конкурируют с актуальными Intel Xeon, а иногда обгоняют даже AMD EPYCВсего за пять лет Amazon успела разработать и внедрить четыре поколения серверных Arm-процессоров Graviton. 4-нм Graviton4 получили 96 ядер и 12 каналов памяти DDR5-5600, а также поддержку PCIe 5.0. Всё это дало AWS основание утверждать, что Graviton4 производительнее предшественника на 30 %, а пропускная способность памяти у него выше на 75 %. Насколько это соответствует истине, выяснил ресурс Phoronix, который заодно сравнил новинки с другими современными процессорами. В тестировании Phoronix приняли участие следующие модели Graviton:

Источник: AWS Платформа Graviton в последней итерации выглядит вполне достойно. Она использует современный набор инструкций Arm, а по количеству ядер и каналов памяти сопоставима с новейшими решениями Intel и AMD. Производительность по мере смены поколений у Graviton растёт практически линейно, за исключением перехода от первого поколения ко второму, что легко объясняется возросшим сразу вчетверо количеством ядер. Что касается Graviton4, то новые процессоры в среднем быстрее Graviton3 примерно в 1,55 раза, а первенца серии они превосходят в 10,4 раза. В некоторых случаях выигрыш выходит далеко за рамки теоретических 1,5x, поскольку у Graviton4 более совершенная архитектура, новее набор инструкций, вдвое больший объем кеша на ядро и существенно более производительная подсистема памяти. Такое поведение, к примеру, характерно для тестов srsRAN, задач криптографии и особенно работы с базами данных.

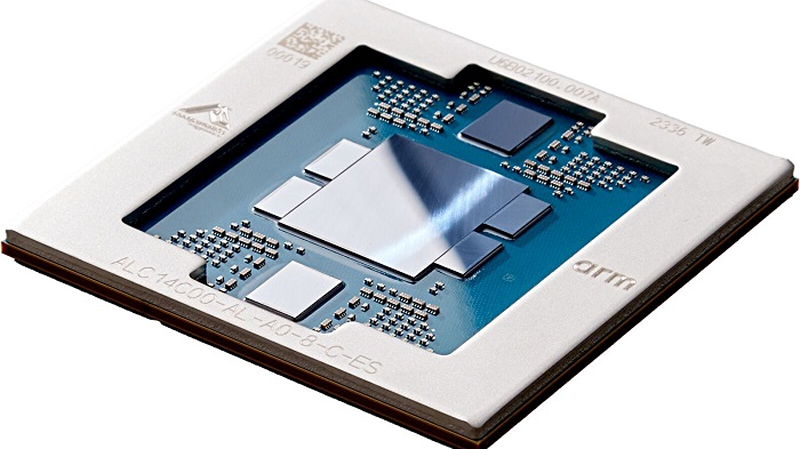

Источник здесь и далее: Phoronix В другом исследовании Phoronix процессорам Graviton4 довелось столкнуться с серьёзными соперниками из мира x86, включая 128-ядерный AMD EPYC 9754 (Bergamo) и 144-ядерные Intel Xeon 67xx (Sierra Forest), а также с ближайшим конкурентом по Arm-платформе, 128-ядерным процессором Ampere Altra Max. К сожалению, метрик энергопотребления в текущей версии инстанса r8g.metal-24xl получить не удалось, но и без этого результаты получены весьма интересные. С первых тестов очевидно, что Altra Max уже не соперник современным решениям, несмотря на сопоставимое количество ядер — сказывается не самая новая архитектура. А вот Graviton4 чувствует себя неплохо и в тестах на компиляцию может опережать даже AMD EPYC 9754. Хороша новинка и в базах данных, она лишь немного уступает процессорам Genoa и зачастую опережает 144-ядерное решение Intel c E-ядрами. И даже в HPC-нагрузках, для которых характерно активное использование FP-вычислений у Graviton4 всё хорошо! Неплохо себя детище AWS чувствует и в сценариях (де-)компрессии данных и кодировании видео.  В итоговом зачёте AWS Graviton4 уверенно занимает место в середине таблицы, опережая оба Xeon — и 64-ядерный Platinum 8592+ (Emerald Rapids), и 144-ядерный Xeon 6780E, но до уровня AMD EPYC 9754 всё же несколько недотягивая. Это вполне даёт основание считать, что платформа AWS Graviton достигла зрелости. Она вполне конкурентоспособна даже на фоне x86-монстров. Более того, на сегодня Graviton4 можно считать самым продвинутым серверным процессором с архитектурой AArch64. Впрочем, вскоре предстоят сражения с Granite Rapids, Turin и AmpereOne (а на подходе ещё и Aurora с HBM).

01.08.2024 [14:30], Руслан Авдеев

Amazon подала на Nokia в суд за нарушение облачных патентов, не преминув напомнить об ошибках прошлогоКомпания Amazon подала в штате Делавэр (США) иск к Nokia, обвинив последнюю в нарушении дюжины патентов, связанных с облачными вычислениями. Как передаёт Reuters, в материалах дела указывается, что Nokia злоупотребляла технологиями AWS, используя их в собственных облачных решениях. Год назад Nokia сама обратилась в суд с просьбой призвать к ответственности Amazon в связи с нарушением патентов на технологии видеостриминга. Сейчас Nokia заявила, что намерена изучить претензии Amazon и активно защищать свои права в суде. Amazon утверждает, что финская компания без разрешения использует технологии, изобретённые ей ещё в начале 2000-х годов, и просит суд заблокировать использование нарушающих её патенты решений Nokia, а также назначить денежную компенсацию. В Amazon заявляют, что с момента основания AWS в 2006 году компания фундаментально трансформировала вычисления и коммуникации. До появления AWS масштабные вычисления, связанные с большими объёмами данных, полагались в основном на om-premise серверную инфраструктуру компаний. В Amazon добавили, что через 14 лет после запуска AWS Nokia анонсировала новую стратегию, связанную с облачными вычислениями, открыв подразделение Cloud and Network Services. AWS утверждает, что облачные решения Nokia предусматривают использование интеллектуальной собственности Amazon. Так, Nokia CloudBand опирается на патентованные механизмы конфигурирования виртуальных машин, управления распределённым выполнением приложений, автоматического масштабирования ресурсов и т.д. А Nokia Nuage Networks нарушает патенты, связанные с управлением коммуникациями в виртуальных сетях и эмуляцией физических сетевых устройств, дополняет DataCenter Dynamics. Amazon не удержалась от колкостей, упомянув в иске, что неспособность Nokia оценить важность смартфонов чуть не довела компания до банкротства в 2013 году. В 186-страничном иске кропотливо упоминаются все случаи нарушения патентного законодательства, с цитатами маркетинговых и технических материалов Nokia, посвящённых облачным сервисам компании. Не исключено, что взаимные иски связаны. Процесс, инициированный Nokia против Amazon в октябре 2023 года, до сих пор не закончен. Утверждается, что Amazon Prime Video и устройства для стриминга нарушают пакет мультимедийных патентов Nokia, связанных с разнообразными технологиями, включая методы сжатия и доставки видео, системы рекомендации контента и даже аппаратные решения. Иск Amazon довольно необычен, поскольку Nokia практически забросила облачный бизнес летом 2023 года, признав, что у неё не хватит ресурсов, чтобы выдержать конкуренцию в этой области. Более того, Nokia является облачным партнёром AWS в Германии. Неизвестно, готова ли Amazon сражаться в суде до конца или просто пытается вынудить Nokia сесть за стол переговоров. Часто такие споры завершаются внесудебными договорённостями.

27.07.2024 [23:44], Алексей Степин

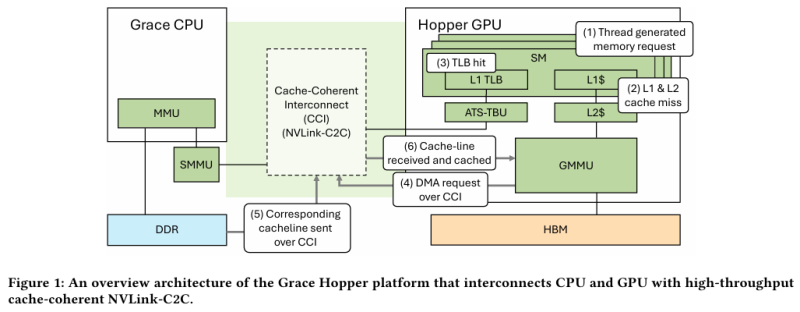

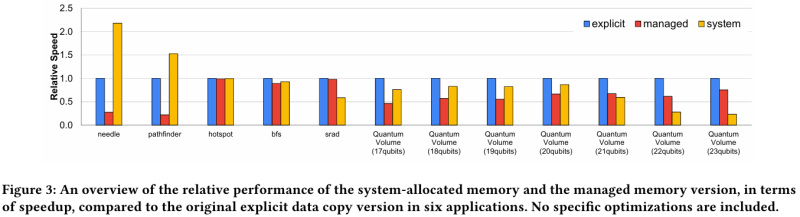

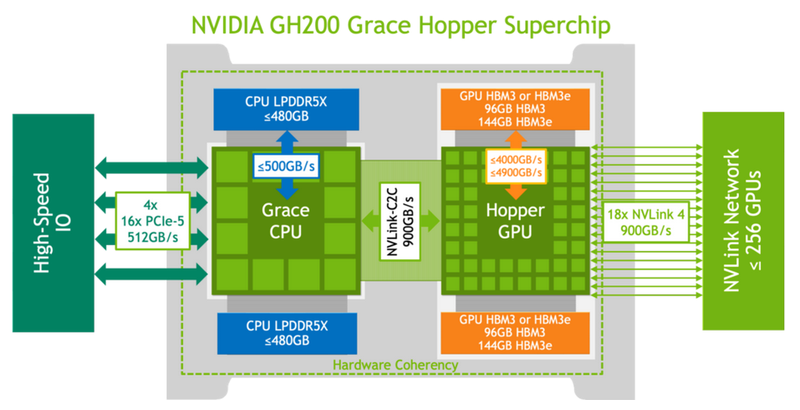

Не так просто и не так быстро: учёные исследовали особенности работы памяти и NVLink C2C в NVIDIA Grace HopperГибридный ускоритель NVIDIA Grace Hopper объединяет CPU- и GPU-модули, которые связаны интерконнектом NVLink C2C. Но, как передаёт HPCWire, в строении и работе суперчипа есть некоторые нюансы, о которых рассказали шведские исследователи. Им удалось замерить производительность подсистем памяти Grace Hopper и интерконнекта NVLink в реальных сценариях, дабы сравнить полученные результаты с характеристиками, заявленными NVIDIA. Напомним, для интерконнекта изначально заявлена скорость 900 Гбайт/с, что в семь раз превышает возможности PCIe 5.0. Память HBM3 в составе GPU-части имеет ПСП до 4 Тбайт/с, а вариант с HBM3e предлагает уже до 4,9 Тбайт/с. Процессорная часть (Grace) использует LPDDR5x с ПСП до 512 Гбайт/с. В руках исследователей оказалась базовая версия Grace Hopper с 480 Гбайт LPDDR5X и 96 Гбайт HBM3. Система работала под управлением Red Hat Enterprise Linux 9.3 и использовала CUDA 12.4. В бенчмарке STREAM исследователям удалось получить следующие показатели ПСП: 486 Гбайт/с для CPU и 3,4 Тбайт/с для GPU, что близко к заявленным характеристиками. Однако результат скорость NVLink-C2C составила всего 375 Гбайт/с в направлении host-to-device и лишь 297 Гбайт/с в обратном направлении. Совокупно выходит 672 Гбайт/с, что далеко от заявленных 900 Гбайт/с (75 % от теоретического максимума).

Источник: NVIDIA Grace Hopper в силу своей конструкции предлагает два вида таблицы для страниц памяти: общесистемную (по умолчанию страницы размером 4 Кбайт или 64 Кбайт), которая охватывает CPU и GPU, и эксклюзивную для GPU-части (2 Мбайт). При этом скорость инициализации зависит от того, откуда приходит запрос. Если инициализация памяти происходит на стороне CPU, то данные по умолчанию помещаются в LPDDR5x, к которой у GPU-части есть прямой доступ посредством NVLink C2C (без миграции), а таблица памяти видна и GPU, и CPU. Если же памятью управляет не ОС, а CUDA, то инициализацию можно сразу организовать на стороне GPU, что обычно гораздо быстрее, а данные поместить в HBM. При этом предоставляется единое виртуальное адресное пространство, но таблиц памяти две, для CPU и GPU, а сам механизм обмена данными между ними подразумевает миграцию страниц. Впрочем, несмотря на наличие NVLink C2C, идеальной остаётся ситуация, когда GPU-нагрузке хватает HBM, а CPU-нагрузкам достаточно LPDDR5x. Также исследователи затронули вопрос производительности при использовании страниц памяти разного размера. 4-Кбайт страницы обычно используются процессорной частью с LPDDR5X, а также в тех случаях, когда GPU нужно получить данные от CPU через NVLink-C2C. Но как правило в HPC-нагрузках оптимальнее использовать 64-Кбайт страницы, на управление которыми расходуется меньше ресурсов. Когда же доступ в память хаотичен и непостоянен, страницы размером 4 Кбайт позволяют более тонко управлять ресурсами. В некоторых случаях возможно двукратное преимущество в производительности за счёт отсутствия перемещения неиспользуемых данных в страницах объёмом 64 Кбайт. В опубликованной работе отмечается, что для более глубокого понимания механизмов работы унифицированной памяти у гетерогенных решений, подобных Grace Hopper, потребуются дальнейшие исследования.

25.07.2024 [11:15], Сергей Карасёв

ASRock представила встраиваемый компьютер DSF-A6000 с чипом AMD Ryzen Embedded R2314 и тремя Ethernet-контроллерамиКомпания ASRock Industrial анонсировала встраиваемую систему DSF-A6000 с возможностью вывода изображения одновременно на четыре дисплея формата 4K. Устройство может монтироваться на стену или DIN-рейку; поддерживается стандартное крепление VESA. В основу положен процессор AMD Ryzen Embedded R2314 с четырьмя ядрами, работающими на частоте 2,1–3,5 ГГц. Задействовано активное охлаждение с вентилятором. Возможно использование до 64 Гбайт оперативной памяти DDR4-2666 в виде двух модулей SO-DIMM. Для установки SSD с интерфейсом PCIe 3.0 x4 предусмотрен коннектор M.2 Key M 2242/2280. В оснащение включены три Ethernet-контроллера: Realtek RTL8111H и Intel I210 стандарта 1GbE, а также Realtek RTL8125BG стандарта 2.5GbE с опциональной поддержкой PoE+. Есть слот M.2 Key E 2230 (PCIe 3.0 x1; USB 2.0) для адаптера беспроводной связи и разъём M.2 Key B 3042/3052 (PCIe 3.0 x1; USB 3.2 Gen1; USB 2.0) для модема 4G/5G (плюс слот для SIM-карты). Звуковая подсистема базируется на кодеке Realtek ALC256 High Definition Audio. На фронтальную панель выведены четыре интерфейса HDMI 2.0b для мониторов, два порта USB 3.2 Gen2 и два гнезда RJ-45 для сетевых кабелей. Сзади расположены последовательный порт RS-232 (RJ-50), ещё одно гнездо RJ-45, порт USB 2.0, аудиоразъём на 3,5 мм и DC-гнездо для подключения блока питания (19 В/90 Вт). Новинка имеет размеры 182,2 × 175,2 × 25 мм и весит около 750 г. Диапазон рабочих температур — от 0 до +40 °C. Заявлена совместимость с Windows 11. За безопасность отвечает чип TPM 2.0.

25.07.2024 [10:12], Владимир Мироненко

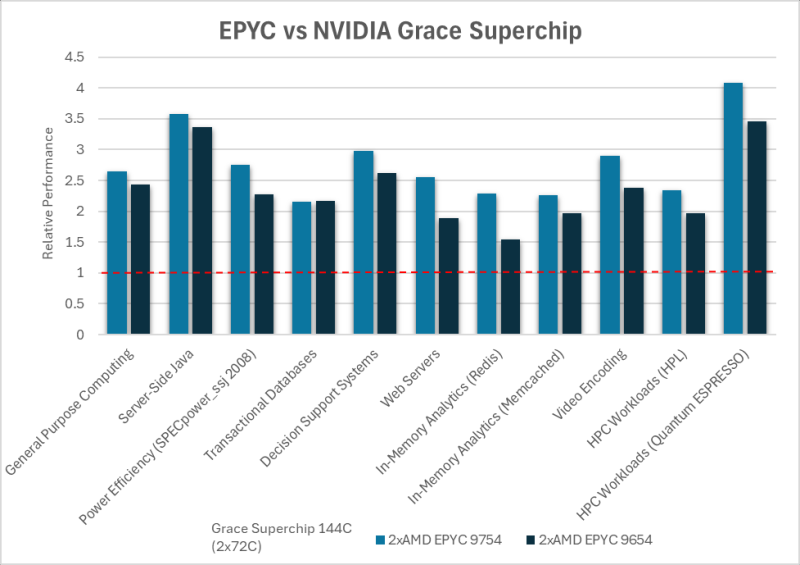

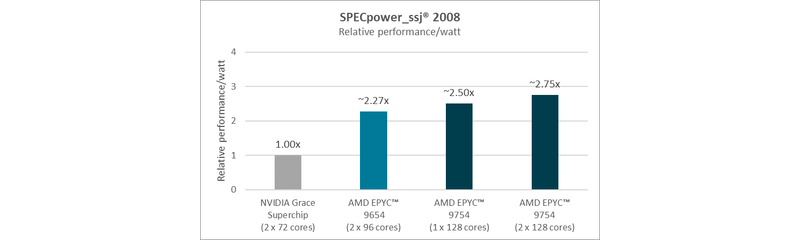

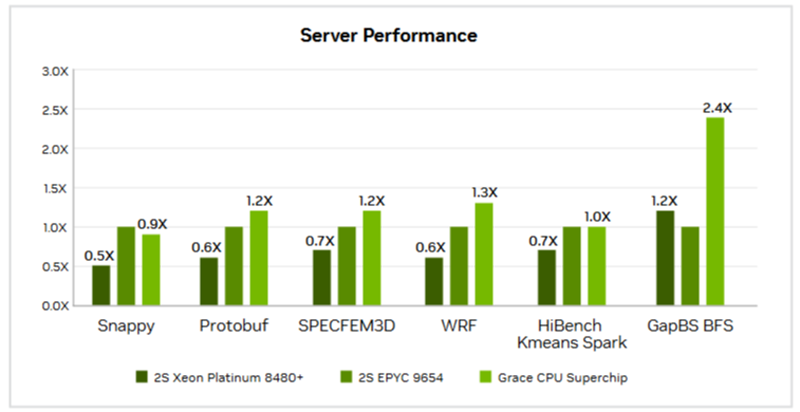

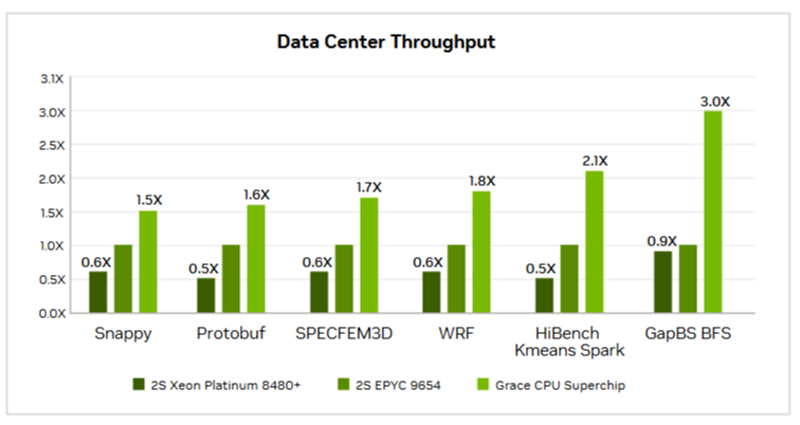

AMD показала превосходство чипов EPYC над Arm-процессорами NVIDIA Grace в серии бенчмарков, но не всё так простоAMD провела серию тестов, чтобы доказать преимущество своих нынешних процессоров AMD EPYC над Arm-процессорами NVIDIA Grace Superchip. Как отметила AMD, в связи с растущей востребованностью ЦОД некоторые компании начали предлагать альтернативные варианты процессоров, «часто обещающие преимущества по сравнению с обычными решениями x86». «Обычно их представляют с большой помпой и заявлениями о значительных преимуществах в производительности и энергоэффективности по сравнению с x86. Слишком часто эти утверждения довольно сложно воплотить в реальные сценарии конкурентной рабочей нагрузки — с использованием устаревших, недостаточно оптимизированных альтернатив или плохо документированных предположений», — отметила AMD. С помощью серии стандартных отраслевых тестов AMD, по её словам, продемонстрировала преимущество EPYC над решениями на базе Arm. «Благодаря проверенной архитектуре x86-64, впервые разработанной AMD, вы можете получить всё это без дорогостоящего портирования или изменений в архитектуре», — подчеркнула компания. Иными словами, тесты AMD могут быть просто попыткой развеять опасения, что архитектура x86 «выдыхается» и что Arm берёт верх. AMD сравнила производительность AMD EPYC и NVIDIA Grace CPU в десяти ключевых рабочих нагрузках, охватывающих вычисления общего назначения, Java, транзакционные базы данных, системы поддержки принятия решений, веб-серверы, аналитику, кодирование видео и нагрузки HPC. Согласно представленному выше графику, 128-ядерный процессор EPYC 9754 (Bergamo) и 96-ядерный EPYC 9654 (Genoa) более чем вдвое превзошли NVIDIA Grace CPU Superchip по производительности при обработке вышеуказанных нагрузок. Напомним, что Grace CPU Superchip содержит два 72-ядерных кристалла Grace, использующих ядра Arm Neoverse V2, соединённых шиной NVLink C2C с пропускной способность 900 Гбайт/с, и работает как единый 144-ядерный процессор. В свою очередь, ресурс The Register отметил, что речь идёт о версии с 480 Гбайт памяти LPDDR5x, а не с 960 Гбайт.  В тесте SPECpower-ssj2008, по данным AMD, одно- и двухсокетные системы на базе AMD EPYC 9754 превосходят систему NVIDIA Grace CPU Superchip по производительности на Вт примерно в 2,50 раза и 2,75 раза соответственно, а двухсокетная система AMD EPYC 9654 — примерно в 2,27 раза. Помимо производительности и эффективности, ещё одним важным фактором для операторов ЦОД является совместимость, сообщила AMD. По оценкам, во всем мире существуют триллионы строк программного кода, большая часть которого написана для архитектуры x86. EPYC основаны на архитектуре x86-64, впервые разработанной AMD, и эта архитектура является наиболее широко используемой и поддерживаемой в индустрии ЦОД, заявила компания, добавив, что изменения в архитектуре сложны, дороги и чреваты риском. AMD также отметила, что экосистема AMD EPYC включает более 250 различных конструкций серверов и поддерживает около 900 уникальных облачных инстансов. Также процессоры AMD EPYC установили более 300 мировых рекордов производительности и эффективности в широком спектре тестов. В то же время лишь немногие Arm-решения доказали свою эффективность. В свою очередь, ресурс The Register отметил, что ситуация не так проста, как AMD пытается всех убедить. В феврале сайт The Next Platform сообщил, что исследователи из университетов Стоуни-Брук и Буффало сравнили данные о производительности суперчипа NVIDIA Grace CPU Superchip и нескольких процессоров x86, предоставленные несколькими НИИ и разработчиком облачных решений.

Источник изображений: NVIDIA Большинство этих тестов были ориентированы на HPC, включая Linpack, HPCG, OpenFOAM и Gromacs. И хотя производительность системы Grace сильно различалась в разных тестах, в худшем случае она находилась где-то между Intel Skylake-SP и Ice Lake-SP, превосходя AMD Milan и находясь в пределах досягаемости от показателей Xeon Max. Данные результаты отражают тот факт, что самые мощные процессоры AMD EPYC Genoa и Bergamo могут превзойти первый процессор NVIDIA для ЦОД — при правильно выбранном тесте.  В техническом описании Grace CPU Superchip компания NVIDIA сообщает, что этот чип обеспечивает от 0,9- до 2,4-кратного увеличения производительности по сравнению с двумя 96-ядерными EPYC 9654 и предлагает до трёх раз большую пропускную способность в различных облачных и HPC-сервисах. NVIDIA отмечает, что Superchip предназначен для «обработки массивов для получения интеллектуальных данных с максимальной энергоэффективностью», говоря об ИИ, анализе данных, нагрузках облачных гиперскейлеров и приложениях HPC. |

|