Материалы по тегу: r200

|

06.01.2026 [14:28], Владимир Мироненко

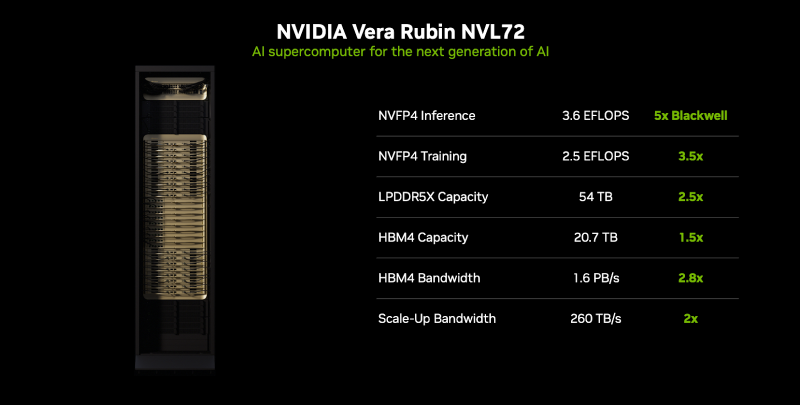

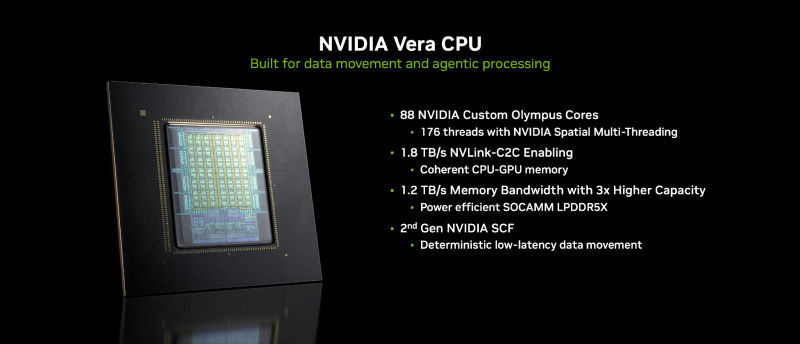

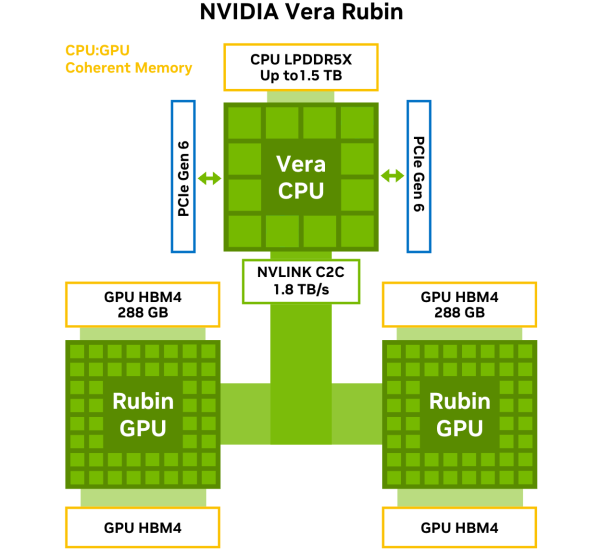

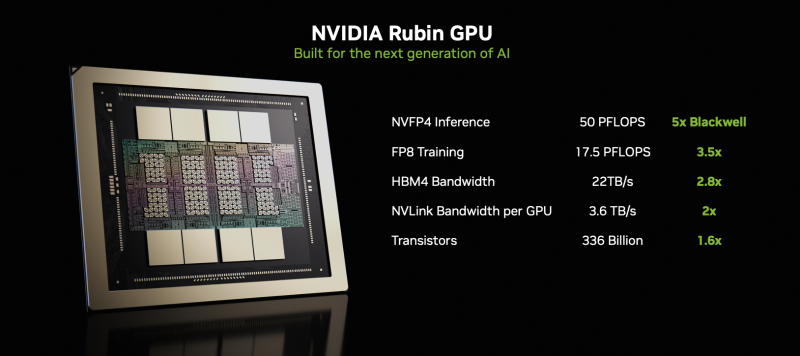

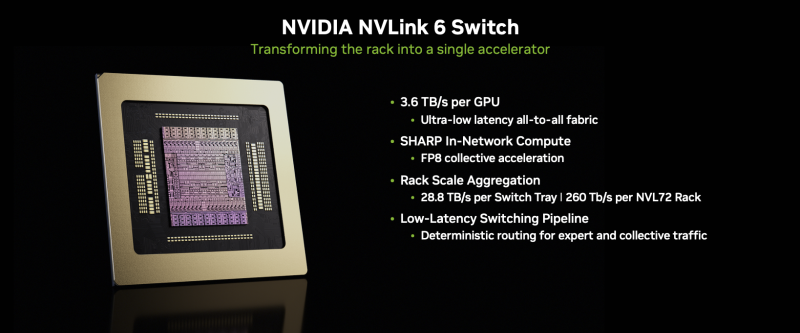

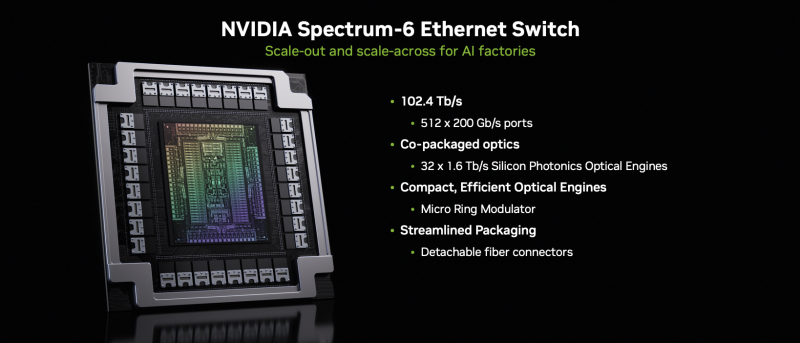

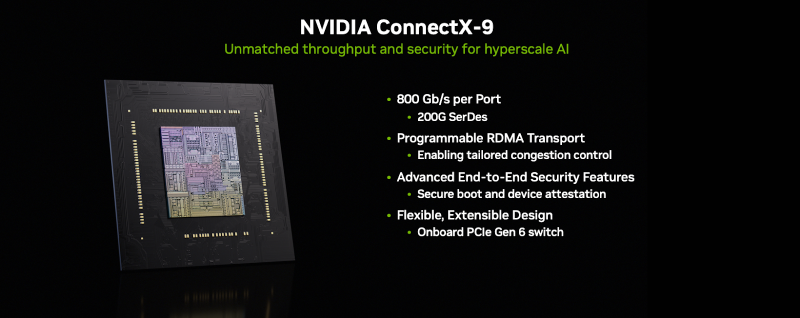

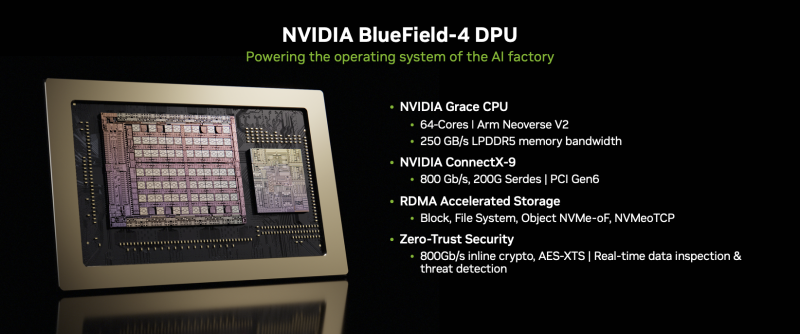

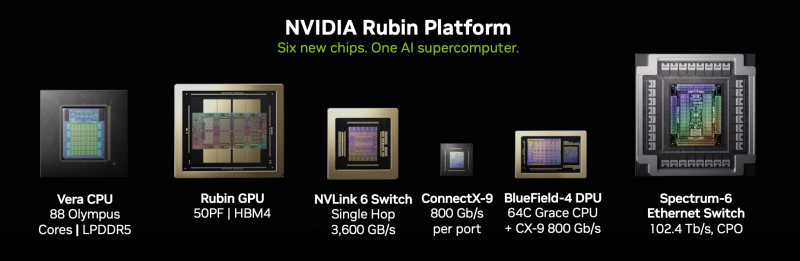

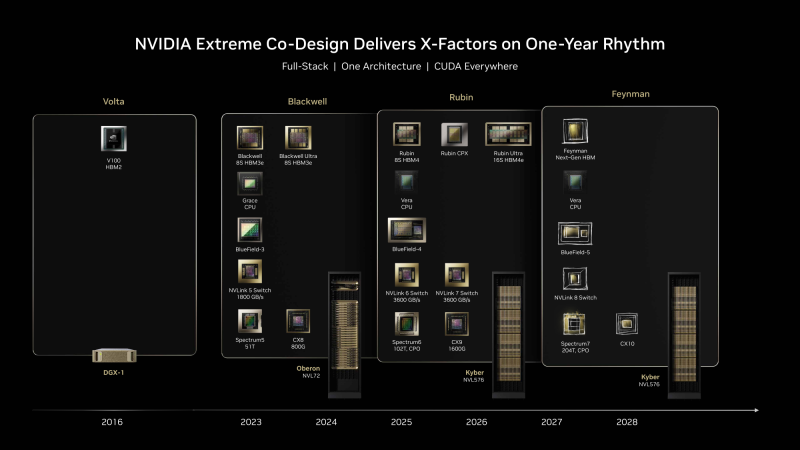

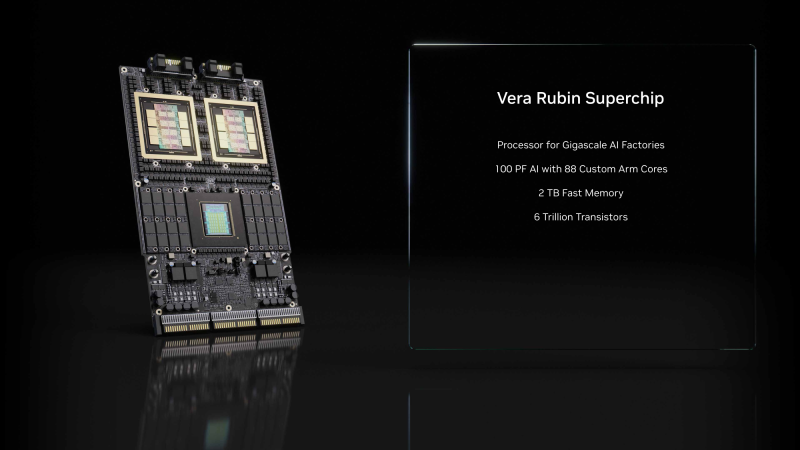

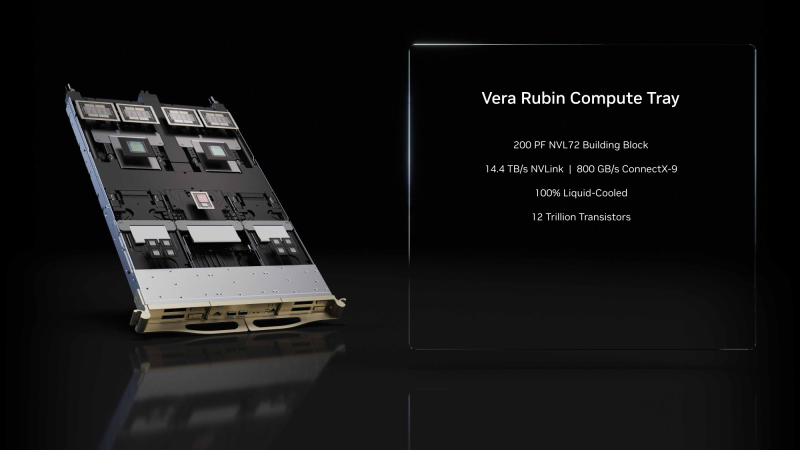

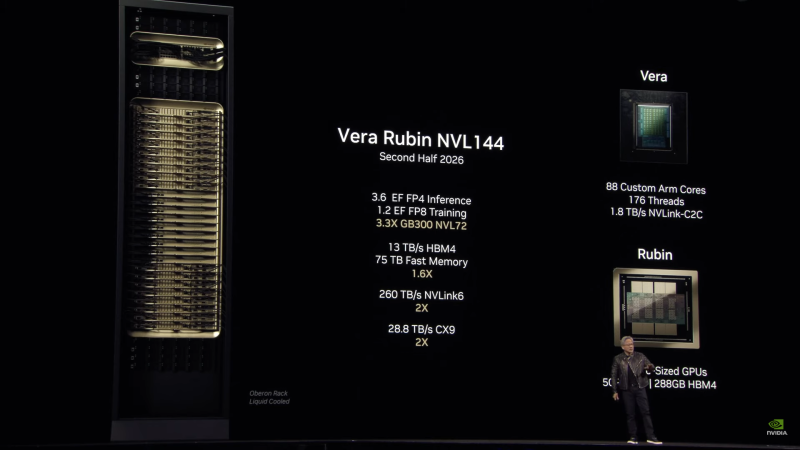

NVIDIA объявила о запуске платформы Vera Rubin NVL72NVIDIA объявила о запуске платформы следующего поколения Rubin, которая приходит на смену Blackwell Ultra. Компания отметила, что платформа Rubin объединяет сразу пять инноваций, включая новейшие поколения интерконнекта NVIDIA NVLink, Transformer Engine, Confidential Computing и RAS Engine, а также процессор NVIDIA Vera. Примечательно, что NVIDIA снова решила вернуться к именованию на основе количества суперчипов (NVL72), а не ускорителей (NVL144), как обещала в прошлом году. Созданная с использованием экстремального совместного проектирования на аппаратном и программном уровнях, NVIDIA Vera Rubin обеспечивает десятикратное снижение стоимости токенов для инференса и четырёхкратное сокращение количества ускорителей для обучения моделей MoE по сравнению с платформой NVIDIA Blackwell. Коммутационные системы NVIDIA Spectrum-X Ethernet Photonics обеспечивают пятикратное повышение энергоэффективности и времени безотказной работы. Платформа Rubin построена на шести чипах — Arm-процессоре Vera, ускорителе Rubin, коммутаторе NVLink 6, адаптере ConnectX-9 SuperNIC, DPU BlueField-4 и Ethernet-коммутаторе NVIDIA Spectrum-6. Ускорители Rubin поначалу будут доступны в двух форматах. В первом случае — в составе стоечной платформы DGX Vera Rubin NVL72, которая объединяет 72 ускорителя Rubin и 36 процессоров Vera, NVLink 6, ConnectX-9 SuperNIC и BlueField-4. Также ускорители Rubin будут доступны в составе платформы DGX/HGX Rubin NVL8 на базе x86-процессоров. Обе платформы будут поддерживаться кластерами NVIDIA DGX SuperPod, сообщил ресурс CRN. Как отметила NVIDIA, разработанный для агентного мышления, процессор NVIDIA Vera является самым энергоэффективным процессором для крупномасштабных ИИ-фабрик. Он оснащён 88 кастомными Armv9.2-ядрами Olympus с 176 потоками с новой технологией пространственной многопоточности NVIDIA, 1,5 Тбайт системной памяти SOCAMM LPDDR5x (1,2 Тбайт/с), возможностями конфиденциальных вычислений и быстрым интерконнектом NVLink-C2C (1,8 Тбайт/с в дуплексе). NVIDIA Rubin с аппаратным адаптивным сжатием данных обеспечивает до 50 Пфлопс (NVFP4) для инференса, что в пять раз быстрее, чем Blackwell. Он также обеспечивает до 35 Пфлопс (NVFP4) в режиме, что в 3,5 раза быстрее, чем его предшественник. Пропускная способность 288 Гбайт HBM4 составляет 22 Тбайт/с, что в 2,8 раза быстрее предшественника, а пропускная способность NVLink на один ускоритель вдвое выше — 3,6 Тбайт/с (в дуплексе). NVIDIA также сообщила, что Vera Rubin NVL72 обладает 54 Тбайт памяти LPDDR5x, что в 2,5 раза больше, чем у Blackwell, и 20,7 Тбайт памяти HBM4, что на 50 % больше, чем у предшественника. Агрегированная пропускная способность HBM4 достигает 1,6 Пбайт/с, что в 2,8 раза больше, а скорость интерконнекта составляет 260 Тбайт/с, что вдвое больше, чем у платформы Blackwell NVL72, и «больше, чем пропускная способность всего интернета». Ожидаемый уровень энергопотребления составит от 190 до 230 кВт на стойку. Компания отметила, что Vera Rubin NVL72 — первая стоечная платформа, обеспечивающая конфиденциальные вычисления, которая поддерживает безопасность данных на уровне доменов CPU, GPU и NVLink. Коммутатор NVLink 6 с жидкостным охлаждением оснащён 400G-блоками SerDes, обеспечивает пропускную способность 3,6 Тбайт/с на каждый GPU для связи между всеми GPU, общую пропускную способность 28,8 Тбайт/с и 14,4 Тфлопс внутрисетевых вычислений в формате FP8. Хотя NVIDIA заявила, что Rubin находится в «полномасштабном производстве», аналогичные продукты от партнёров появятся только во II половине этого года. Среди ведущих мировых ИИ-лабораторий, поставщиков облачных услуг, производителей компьютеров и стартапов, которые, как ожидается, внедрят Rubin, компания назвала Amazon Web Services (AWS), Anthropic, Black Forest Labs, Cisco, Cohere, CoreWeave, Cursor, Dell Technologies, Google, Harvey, HPE, Lambda, Lenovo, Meta✴, Microsoft, Mistral AI, Nebius, Nscale, OpenAI, OpenEvidence, Oracle Cloud Infrastructure (OCI), Perplexity, Runway, Supermicro, Thinking Machines Lab и xAI. ИИ-лаборатории, включая Anthropic, Black Forest, Cohere, Cursor, Harvey, Meta✴, Mistral AI, OpenAI, OpenEvidence, Perplexity, Runway, Thinking Machines Lab и xAI, рассматривают платформу NVIDIA Rubin для обучения более крупных и мощных моделей, а также для обслуживания мультимодальных систем с длинным контекстом с меньшей задержкой и стоимостью по сравнению предыдущими поколениями ускорителей. Партнёры по инфраструктурному ПО и хранению данных AIC, Canonical, Cloudian, DDN, Dell, HPE, Hitachi Vantara, IBM, NetApp, Nutanix, Pure Storage, Supermicro, SUSE, VAST Data и WEKA работают с NVIDIA над разработкой платформ следующего поколения для инфраструктуры Rubin. В связи с тем, что рабочие нагрузки агентного ИИ генерируют огромные объёмы контекстных данных, NVIDIA также представляла новую платформу хранения контекста инференса NVIDIA Inference Context Memory Storage Platform — новый класс инфраструктуры хранения, разработанной для масштабирования контекста инференса. Сообщается, что платформа, работающая на базе BlueField-4, обеспечивает эффективное совместное использование и повторное применение данных KV-кеша в рамках всей ИИ-инфраструктуры, повышая скорость отклика и пропускную способность, а также обеспечивая предсказуемое и энергоэффективное масштабирование агентного ИИ. Дион Харрис (Dion Harris), старший директор NVIDIA по высокопроизводительным вычислениям и решениям для ИИ-инфраструктуры, сообщил, что по сравнению с традиционными сетевыми хранилищами для данных контекста инференса, новая платформа обеспечивает до пяти раз больше токенов в секунду, в пять раз лучшую производительность на доллар и в пять раз лучшую энергоэффективность.

24.11.2025 [10:17], Руслан Авдеев

Перекрыть потоки: NVIDIA усиливает контроль над цепочкой поставок СЖО для Vera Rubin

cooler master

delta electronics

foxconn

hardware

nvidia

odm

qct

vr200

wistron

водоблок

ии

производство

сжо

NVIDIA намерена серьёзно изменить управление цепочкой поставок для серверной платформы новейшего поколения Vera Rubin. Она ужесточает контроль над сборкой и поставкой ключевых компонентов систем охлаждения, что связано с ростом энергопотребления и обязательным применением СЖО, сообщает DigiTimes. Это ещё один шаг в процессе усиления контроля над выпуском ИИ-платформ. NVIDIA уже давно внимательно следит за цепочками поставок для ускорителей и плат, но теперь намерена перейти на новый уровень. Источники сообщают, что компания намерена отобрать четырёх поставщиков водоблоков, перейти к координации производства и централизованным закупкам. Предполагается, что это будут Cooler Master, Asia Vital Components (AVC), Auras Technology и Delta Electronics. Ранее СЖО для NVIDIA занимались, в основном, Cooler Master, AVC и некоторые другие поставщики. Ожидается, что для Vera Rubin вместо поставки лишь отдельных компонентов (L6), NVIDIA будет участвовать в процессе и на более позднем этапе (L10), взяв ответственность за интеграцию и сборку готовых серверных шкафов. В целом окончательную сборку поручат Foxconn, Wistron и Quanta. Из-за необходимости быстрого выпуска продукции на поставщиков легла дополнительная нагрузка. Некоторые из них в частном порядке жалуются, что NVIDIA настаивает на запуске массового производства ещё до утверждения окончательного дизайна платформ, а новое поколение платформ часто появляется до того, как предыдущее достигло стабильного уровня производства и качества. Централизованные закупки помогут NVIDIA оптимизировать поставки и контролировать качество, но рентабельность работы поставщиков может пострадать, поскольку NVIDIA сама будет управлять спросом и торговаться по поводу цен. При этом отказ от подобных условий практически невозможен, учитывая доминирующее положение компании на рынке ИИ-инфраструктуры. В результате снижается самостоятельность как ODM, так и облачных провайдеров. Из-за этого же, как считается, во многом замедлено и развитие погружных СЖО — NVIDIA попросту не готова сертифицировать такие системы. Эксперты всё чаще говорят о росте напряжённости, которая со временем приведёт к открытому конфликту. Новый подход NVIDIA, вероятно, повлияет на цепочку поставок двумя путями. Во-первых, контракты на сборку консолидируются вокруг небольшого пула производителей, а выпуск водоблоков сконцентрируется в руках трёх-четырёх компаний. Облачным провайдерам, вероятно, тоже придётся идти на поводу NVIDIA при размещении крупных оптовых заказов, хотя они как раз предпочитают создавать собственные СЖО, что в целом тоже негативно влияет на некоторых игроков. Во-вторых, рост объёмов поставок не гарантирует роста рентабельности. Поставщики предполагают, что цена за единицу продукции в рамках попыток NVIDIA сконцентрировать производителей уменьшится, а более жёсткий контроль над проектированием снизит и стратегическую ценность индивидуальных разработок. Компании уже шутят, что статус крупнейшего поставщика NVIDIA может буквально навредить, поскольку по мере роста объёмов обычно растут и дисконты. Ожидается, что стойки поколения Vera Rubin обеспечат значительно более высокую плотность вычислений, чем уже доступные платформы GB200 и GB300, а для традиционного воздушного охлаждения места уже не останется. В отрасли ожидают, что Vera Rubin представят во II половине 2026 года. Платформа представляет собой важный шаг к созданию ИИ-инфраструктуры с полностью жидкостным охлаждением. Новейшая стратегия NVIDIA, касающаяся цепочек поставок, свидетельствует о решимости компании усилить прямой контроль качества, поставок и их стоимости по мере роста плотности мощности. В JPMorgan утверждают, что NVIDIA станет напрямую поставлять системы L10. Компания унифицирует конструкцию и заставит подрядчиков строго придерживаться предлагаемых чертежей и дизайна без использования проприетарных архитектур, созданных самими подрядчиками. Для NVIDIA это выгодно, поскольку позволяет значительно ускорить отгрузки и кратно сократить сроки развёртывания ИИ-инфраструктур (до 3 мес. вместо 9 мес.), опираясь на единые стандарты — от одного узла до целой ИИ-фабрики. При этом AWS, вероятно, придётся тяжелее всех, поскольку она пытается снизить зависимость от NVIDIA и в то же время не является активным сторонником OCP.

14.11.2025 [09:36], Сергей Карасёв

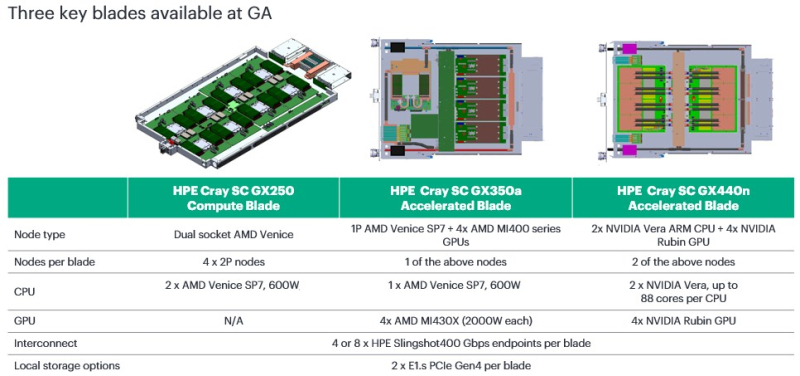

HPE представила CPU- и GPU-узлы суперкомпьютерной платформы Cray Supercomputing GX5000Компания HPE анонсировала новые решения для НРС-задач, являющиеся частью суперкомпьютерной платформы Cray Supercomputing GX5000. В частности, дебютировали узлы GX250 Compute Blade, GX350a Accelerated Blade и GX440n Accelerated Blade, а также высокопроизводительная СХД Storage Systems K3000. Устройство HPE Cray Supercomputing GX250 Compute Blade представляет собой CPU-сервер, оснащённый восемью процессорами AMD EPYC Venice (появятся во II половине 2026 года). В одной стойке могут быть размещены до 40 таких серверов, что обеспечивает самую высокую в отрасли плотность компоновки x86-ядер следующего поколения, говорит компания. В паре с CPU-узлами могут функционировать новые GPU-модули. Так, изделие HPE Cray Supercomputing GX350a Accelerated Blade несёт на борту один чип AMD EPYC Venice и четыре ускорителя AMD Instinct MI430X. В стойку могут устанавливаться до 28 таких серверов, что даёт в сумме 112 ускорителей MI430X. В свою очередь, HPE Cray Supercomputing GX440n Accelerated Blade содержит четыре NVIDIA Vera CPU и восемь NVIDIA Rubin GPU. Допускается монтаж до 24 подобных серверов на стойку, что обеспечивает 192 ускорителя Rubin. Все новинки оборудованы жидкостным охлаждением. СХД HPE Cray Supercomputing Storage Systems K3000 выполнена на сервере HPE ProLiant Compute DL360 Gen12. Могут устанавливаться 8, 12, 16 или 20 накопителей NVMe вместимостью 3,84, 7,68 или 15,36 Тбайт каждый. Объём памяти DRAM — 512 Гбайт, 1 или 2 Тбайт. Применяется платформа DAOS, разработанная для требовательных рабочих нагрузок, таких как анализ данных и машинное обучение. Поддерживаются технологии HPE Slingshot 200, HPE Slingshot 400, InfiniBand NDR и 400GbE. Кроме того, HPE сообщила о том, что для платформы HPE Cray Supercomputing GX5000 доступен интерконнект HPE Slingshot 400. Соответствующие коммутаторы с прямым жидкостным охлаждением наделены 64 портами на 400 Гбит/с. Возможны конфигурации с 8, 16 и 32 коммутаторами, что в сумме позволяет использовать до 512, 1024 и 2048 портов соответственно. О выборе платформы HPE Cray Supercomputing GX5000 для НРС-комплексов нового поколения уже объявили Центр высокопроизводительных вычислений Штутгартского университета (HLRS) и Центр суперкомпьютеров имени Лейбница (LRZ) Баварской академии естественных и гуманитарных наук (BADW). Кроме того, новая платформа является основой суперкомпьютера Discovery Министерства энергетики США (DOE).

10.06.2025 [18:55], Руслан Авдеев

Германия получит суперкомпьютер Blue Lion на новейших ускорителях NVIDIA Vera RubinНемецкий Суперкомпьютерный центр Лейбница (Leibniz Supercomputing Centre, LRZ), входящий в HPC-группу Gauss Centre for Supercomputing, получит в своё распоряжение суперкомпьютер Blue Lion на базе ускорителей Vera Rubin. Ожидается, что он будет приблизительно в 30 раз производительнее своего предшественника — SuperMUC-NG. Ожидается, что платформа NVIDIA нового поколения кардинально изменит подход к научным исследованиям, сообщается в блоге компании. Это второй анонс машины на базе Vera Rubin после американского суперкомпьютера Doudna. По словам NVIDIA, новая аппаратная платформа — это «слиянии симуляций, данных и ИИ в единый движок для науки с высокой пропускной способностью, низкой задержкой, когерентными вычислениями и общей памятью». Непосредственно суперкомпьютер будет использовать платформу HPE Cray нового поколения с СЖО с тёплой водой (до +40 °C) на входе и 100-% безвентиляторным дизайном. Тепло системы будет использоваться для отопления близлежащих зданий.

Источник изображения: NVIDIA Суперкомпьютер будет использоваться для исследований в областях климата, турбулентности, физики и машинного обучения — с комбинацией классических компьютерных симуляций и современного ИИ-моделирования. Также он станет помощником для реализации международных исследовательских проектов по всей Европе. Постройка новых компьютеров имеет важное значение, поскольку речь идёт о новой вехе в развитии суперкомпьютеров, которые теперь проектируются с прицелом на работу в реальном времени. ИИ более не является простым дополнением исследованиям, а данные постоянно находятся «в движении», поэтому стоящие за этим системы приходится постоянно поддерживать в актуальном состоянии, говорит NVIDIA.

02.06.2025 [17:48], Сергей Карасёв

Dell построит один из первых суперкомпьютеров на базе NVIDIA Vera Rubin — Doudna для Министерства энергетики СШАМинистерство энергетики США (DOE) объявило о заключении контракта с Dell Technologies на создание нового суперкомпьютера под названием Doudna, в основу которого лягут ИИ-ускорители NVIDIA Vera Rubin. НРС-комплекс расположится в Национальной лаборатории им. Лоуренса в Беркли (Berkeley Lab) в Калифорнии (США). Система Doudna, также известная как NERSC-10, станет флагманским суперкомпьютером Национального вычислительного центра энергетических исследований США (NERSC) в составе Berkeley Lab. Комплекс назван в честь Дженнифер Даудны (Jennifer Doudna) — американского биохимика и генетика, исследователя геномики, одной из создателей технологии редактирования генома CRISPR-Cas9. Ожидается, что Doudna по производительности в «научных результатах» превзойдёт своего предшественника — суперкомпьютер Perlmutter — более чем в 10 раз. При этом энергопотребление возрастёт только в 2–3 раза. Теоретически, как отмечает The Register, система должна демонстрировать FP64-быстродействие до 790 Пфлопс при потреблении 5,8–8,7 МВт. Однако на практике, скорее всего, показатели будут иными. Дело в том, что детальная информация о производительности суперчипов Vera Rubin пока не раскрывается. Но в случае NVIDIA Blackwell Ultra, например, быстродействие на операциях двойной точности, которое считается необходимым для научных вычислений, было принесено в жертву широкому использованию форматов с 4-бит точностью, адаптированных для рабочих нагрузок ИИ. Так, у GB300 NVL72 FP64-производительность составляет 100 Тфлопс, а у его предшественника GB200 NVL72 — 2880 Тфлопс. Эта тенденция может сохраниться и в случае Vera Rubin. AMD, по слухам, готовит два варианта ускорителей Instinct: MI430X с поддержкой FP64 и MI450X без таковой. Джек Донгарра (Jack Dongarra), один из крупнейших в мире специалистов области HPC и один создателей рейтинга самых мощных суперкомпьютеров в мире TOP500, предупреждает, что ИИ не сможет решить всех проблем научного сообщества, а отказ американских производителей от выпуска необходимых учёным чипов грозит большими проблемами уже всей стране. «Именно поэтому NVIDIA заявляет о более чем 10-кратном приросте "научного результата", а не производительности», — подчёркивает The Register. Таким образом, машина Doudna задумывается как нечто вроде «швейцарского армейского ножа», способного выполнять различные рабочие нагрузки, охватывающие и HPC-, и ИИ-задачи. Основой послужат системы Dell Integrated Rack Scalable Systems и серверы PowerEdge с ИИ-ускорителями NVIDIA Vera Rubin. Говорится об использовании платформы NVIDIA Quantum-X800 InfiniBand. Сообщается, что суперкомпьютер будут использовать примерно 11 тыс. специалистов и ученых, которые ведут исследования в таких областях, как термоядерная энергетика, материаловедение, разработка лекарственных препаратов, астрономия и многое другое. Машина заработает в 2026 году.

20.03.2025 [01:10], Владимир Мироненко

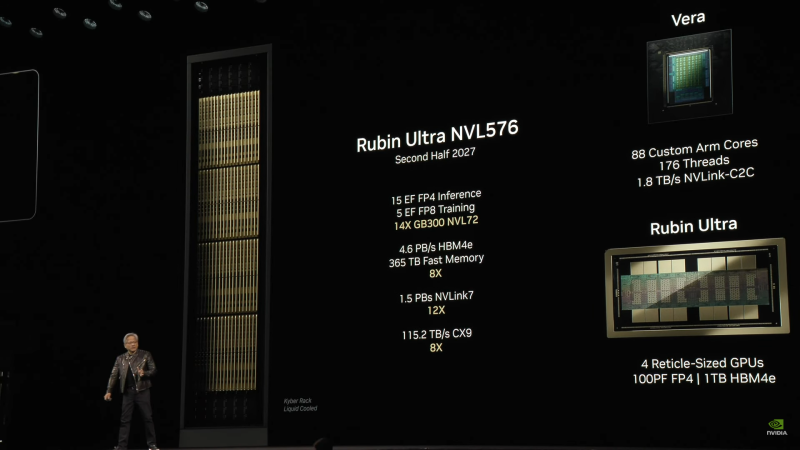

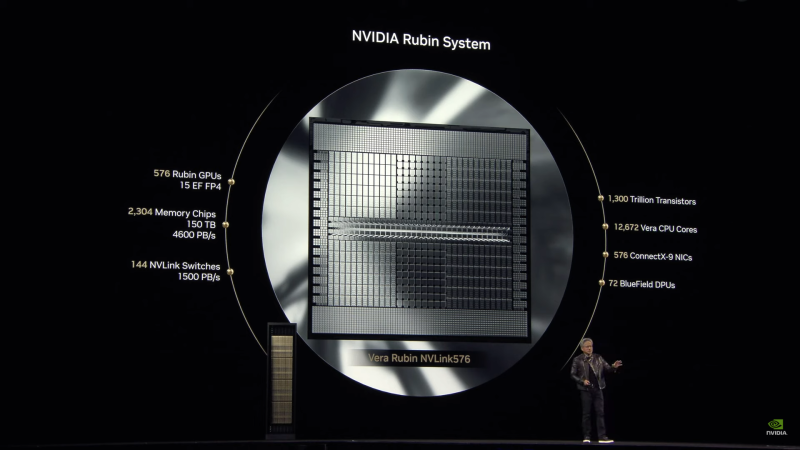

Анонсированы суперускорители на Rubin и Rubin Ultra, в которых NVIDIA не будет ошибаться в подсчётахNVIDIA анонсировала ИИ-ускорители следующего поколения Rubin, которые придут на смену Blackwell Ultra во II половине 2026 года. Выход Rubin Ultra запланирован на II половину 2027 года. Компанию им составят Arm-процессоры Vera. Серия названа в честь астронома Веры Купер Рубин (Vera Florence Cooper Rubin), известной своими исследованиями тёмной материи. NVIDIA отметила, что в названии предыдущих ускорителей была «допущена ошибка». В Blackwell каждый чип состоит из двух GPU, но, например, в названии GB200/GB300 NVL72 упоминается только 72 GPU, хотя речь фактически идёт о 144 GPU. Поэтому, начиная с Rubin компания будет использовать новую схему наименований, которая больше не учитывает количество чипов, а относится исключительно к количеству GPU. Таким образом, следующее поколение суперускорителей, упакованных в ту же стойку Oberon, что используется для Grace Blackwell, получило название Vera Rubin NVL144. Rubin во многом повторяет дизайн Blackwell, поскольку R200 всё так же включает два кристалла GPU (в составе SXM7), способных выдавать до 50 Пфлопс в вычислениях FP4 (без разреженности), и 288 Гбайт памяти в восьми стеках 12-Hi, но на этот раз уже HBM4 с общей пропускную способностью 13 Тбайт/с (2048-бит шина). Кристаллы GPU будут изготовлены по техпроцессу TSMC N3P, а компанию им составят два IO-чиплета, отвечающие за все внешние коммуникации, пишет SemiAnalysis. Всё вместе будет упаковано посредством CoWoS-L. TDP новинок не указывается.

Источник изображений: NVIDIA Чипы перейдут на интерконнект NVLink 6 со скоростью 1,8 Тбайт/с в каждую сторону (3,6 Тбайт/с в дуплексе), что вдвое выше, чем у текущего поколения NVLink 5. Аналогичным образом вырастет и коммутационная способность NVSwitch, а также NVLink C2C. Впрочем, при сохранении прежней схемы, когда один CPU обслуживает два модуля GPU, каждому из последних, по-видимому, достанется половина пропускной способности шины. Собственно процессор Vera получит 88 кастомных (а не Neoverse CSS в случае Grace) 3-нм Arm-ядра, причём с SMT, что даст 176 потоков. Каждый CPU получит порядка 1 Тбайт LPDDR-памяти и будет вдвое быстрее Grace при теплопакете в районе 50 Вт. По словам NVIDIA, VR200 NVL144 будет в 3,3 раза быстрее: 3,6 Эфлопс в FP4-вычислениях для инференса и 1,2 Эфлопс в FP8 для обучения. Суммарный объём HBM-памяти составит более 20,7 Тбайт, системной памяти — 75 Тбайт. Внешняя сеть будет представлена адаптерами ConnectX-9 SuperNIC со скоростью 1,6 Тбит/с на порт, что вдвое больше, чем у ConnectX-8, обслуживающих GB300. Во II половине 2027 года появится ускоритель Rubin Ultra (R300) с FP4-производительностью более 100 Пфлопс (без разреженности), объединяющий сразу четыре GPU, два IO-чиплета и 16 стеков HBM4e-памяти 16-Hi общим объёмом 1 Тбайт (32 Тбайт/с) в упаковке SXM8. Более того, ускорители, по-видимому, получат ещё и LPDDR-память. Процессор Vera перекочует в новую платформу без изменений, один CPU будет приходиться на четыре GPU. Внутренней шиной станет NVLink 7, которая сохранит скорость NVLink 6, зато получит вчетверо более производительные коммутатор NVSwitch. А вот внешнее подключение по-прежнему будут обслуживать адаптеры ConnectX-9. Новая стойка Kyber полностью поменяет компоновку. Узлы теперь напоминают вертикальные блейд-серверы, используемые в суперкомпьютерах. Каждый узел (VR300) будет включать один процессор Vera и один ускоритель Rubin Ultra. Всего таких узлов будет 144, что в сумме даёт 144 CPU, 576 GPU и 144 Тбайт HBM4e. Суперускоритель Rubin Ultra NVL576 будет потреблять 600 кВт и обеспечит быстродействие в 15 Эфлопс для инференса (FP4) и 5 Эфлопс для обучения (FP8). При этом упоминается, что объём быстрой (fast) памяти составит 365 Тбайт, но сколько из них достанется CPU, не уточняется. Дальнейшие планы NVIDIA включают выход во II половине 2028 года первого ускорителя на новой архитектуре Feynman, названной в честь физика-теоретика Ричарда Филлипса Фейнмана (Richard Phillips Feynman). Сообщается, что Feynman будет полагаться на память HBM «следующего поколения» и, вероятно, на CPU Vera. Это поколение также получит коммутаторы NVSwitch 8 (NVL-Next), сетевые коммутаторы Spectrum7 и адаптеры ConnectX-10. UPD: осенью компания представила соускорители Rubin CPX для масштабных задач ИИ-инференса, которые дополняют платформу Vera Rubin. Эти чипы будут доступны как в составе гибридной платформы NVIDIA Vera Rubin NVL144 CPX (144 × Rubin CPX + 144 × Rubin + 36 × Vera), так и в виде двухстоечного решения: Vera Rubin NVL144 CPX + Vera Rubin NVL144. |

|