Материалы по тегу: nvidia

|

30.10.2025 [12:20], Сергей Карасёв

ASUS представила ИИ-сервер XA NB3I-E12 на базе NVIDIA HGX B300Компания ASUS анонсировала сервер XA NB3I-E12 на аппаратной платформе NVIDIA HGX B300, предназначенный для интенсивных нагрузок ИИ. В качестве потенциальных заказчиков системы названы предприятия, которые работают с большими языковыми моделями (LLM) и НРС-приложениями: это могут быть научно-исследовательские структуры и финансовые организации, компании автомобильного сектора и пр. Сервер выполнен в форм-факторе 9U. Возможна установка двух процессоров Intel Xeon 6700P поколения Granite Rapids с показателем TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти DDR5-6400 RDIMM / 3DS RDIMM. Во фронтальной части расположены 10 посадочных мест на SFF-накопителей (NVMe). Предусмотрены четыре слота расширения PCIe 5.0 х16 и один слот PCIe 5.0 х8. Система имеет архитектуру 8-GPU (NVIDIA HGX B300 288GB 8-GPU). Задействованы сетевые адаптеры NVIDIA ConnectX-8 и DPU NVIDIA BlueField-3. Реализованы два сетевых порта 10GbE с разъёмами RJ45 на основе контроллера Intel X710-AT2 и выделенный сетевой порт управления (RJ45). Питание обеспечивают 10 блоков мощностью 3200 Вт с сертификатом 80 PLUS Titanium. Применяется воздушное охлаждение; диапазон рабочих температур — от +10 до +35 °C. ASUS отмечает, что сервер имеет модульную конструкцию, благодаря чему минимизируется использование кабелей, упрощается обслуживание и повышается ремонтопригодность. Габариты устройства составляют 945 × 447 × 394,5 мм, масса — примерно 120 кг без установленных накопителей.

29.10.2025 [16:53], Владимир Мироненко

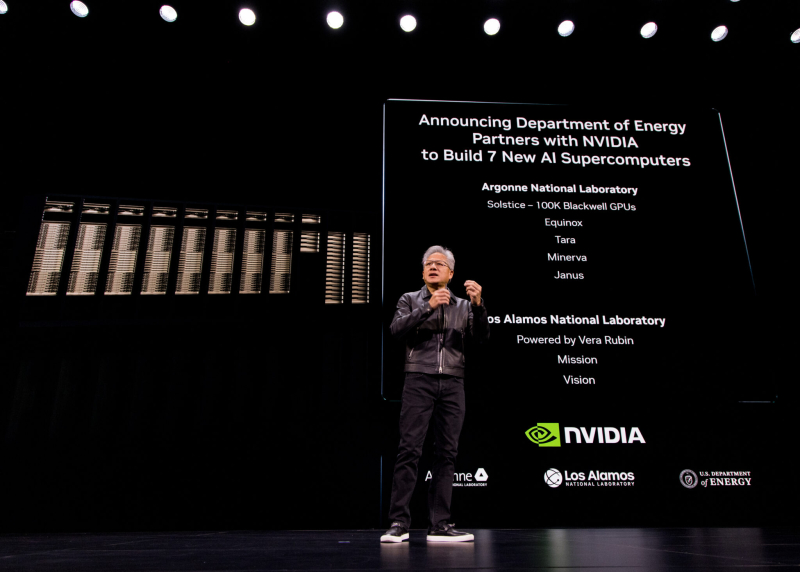

В США построят семь новых ИИ-компьютеров на чипах NVIDIA по заказу Министерства энергетики СШАNVIDIA объявила о сотрудничестве с национальными лабораториями Министерства энергетики США (DoE) и ведущими компаниями с целью развития ИИ-инфраструктуры страны, в рамках которого будет построено семь новых суперкомпьютеров в Аргоннской (ANL) и Лос-Аламосской (LANL) национальных лабораториях. На первом этапе проекта NVIDIA и Oracle совместно построят в Аргоннской национальной лаборатории (ANL) два новых суперкомпьютера Equinox и Solstice с суммарной ИИ-производительность 2,2 Зфлопс. Также ANL планирует запустить ещё три новые ИИ-системы на базе технологий NVIDIA: Tara, Minerva и Janus. Не вдаваясь в подробности по поводу спецификаций систем, руководство лаборатории заявило, что суперкомпьютеры призваны расширить доступ исследователям в сфере ИИ из других центров по всей стране. Лос-Аламосская национальная лаборатория (LANL) получит ИИ-системы Mission и Vision нового поколения, которые будут разработаны и поставлены компанией HPE. Уже известно, что они будут базироваться на платформе NVIDIA Vera Rubin с сетевой фабрикой Quantum‑X800 InfiniBand. Как сообщает NVIDIA, система Vision основана на достижениях суперкомпьютера Venado, созданного для несекретных исследований. Как уточнили в лаборатории, Vision будет использоваться для несекретных задач в области национальной безопасности, материаловедения и ядерной науки, энергетического моделирования и биомедицинских исследований, сообщили в лаборатории, пишет The Register. Mission — пятая система ATS5 (Advanced Technology System) в рамках программы усовершенствованного моделирования и вычислений (Advanced Simulation and Computing) Национального управления ядерной безопасности США (The National Nuclear Security Administration, NNSA), поддерживаемой LANL. Система предназначена для запуска секретных приложений, её ввод в эксплуатацию состоится в конце 2027 года. Vera Rubin в сочетании с Quantum‑X800 позволит учёным проводить сложное моделирование в области материаловедения, моделирования климата и квантовых вычислений. «Использование такого уровня вычислительной производительности критически важно для решения некоторых из самых сложных научных задач и задач национальной безопасности», — заявил Том Мейсон (Thom Mason), директор LANL.

29.10.2025 [16:01], Сергей Карасёв

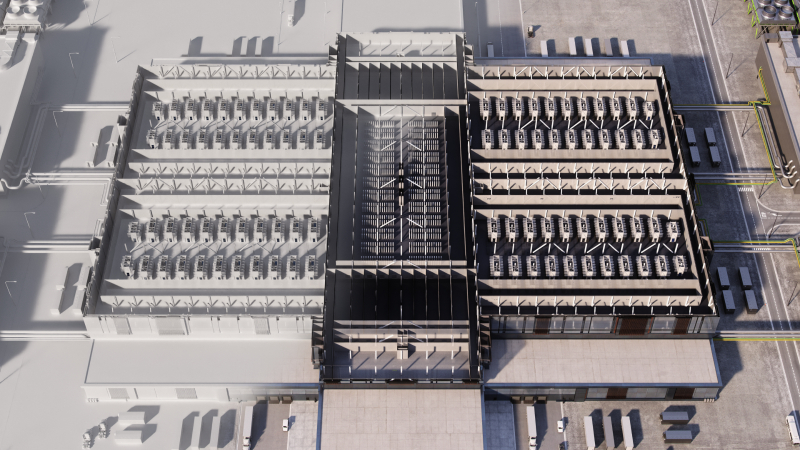

NVIDIA представила проект Omniverse DSX для ускоренного создания ИИ-фабрик гигаваттного масштабаNVIDIA анонсировала Omniverse DSX Blueprint — референсный проект, ориентированный на создание дата-центров гигаваттного масштаба для обучения и запуска наиболее крупных моделей ИИ. По общей мощности такие объекты будут сопоставимы с ядерными реакторами. Проект предполагает создание цифровых двойников в Omniverse с использованием реальных инженерных данных. Благодаря этому формируется единая среда, в которой партнёры могут планировать, прорабатывать и оптимизировать каждый аспект масштабного дата-центра для ресурсоёмких задач ИИ — от систем электропитания и охлаждения до вычислительных и сетевых компонентов. На практике Omniverse DSX Blueprint выступает в качестве эталонной архитектуры и программного уровня управления для ЦОД, мощность которых может варьироваться от 100 МВт до нескольких ГВт. Решение протестировано в исследовательском центре NVIDIA AI Factory на площадке Digital Realty в Манассасе (Manassas) в Вирджинии (США). Проект лежит в основе реальных дата-центров, включая площадку Switch мощностью 2 ГВт в Джорджии и площадку Stargate мощностью 1,2 ГВт в Абилине (Техас). Одним из ключевых элементов Omniverse DSX Blueprint является DSX Flex — это внешняя система, связывающая ЦОД с региональными электросетями и источниками возобновляемой энергии для задействования около 100 ГВт недоиспользуемой мощности сети путём динамической балансировки спроса и предложения. Ещё один компонент — DSX Boost: данная система регулирует управление питанием и распределение рабочей нагрузки в дата-центре, что позволяет добиться либо снижения энергопотребления примерно на 30 %, либо повышения пропускной способности GPU до 30 % при том же уровне энергопотребления. Третий элемент — DSX Exchange — выступает в качестве защищённой инфраструктурной среды передачи данных и управления. Референсный проект Omniverse DSX Blueprint призван помочь компаниям создавать масштабные ИИ-фабрики с нуля, используя оборудование NVIDIA и её партнёров. При этом гарантируется совместимость вычислительных и сетевых компонентов, а также инженерного оборудования. После виртуального проектирования объекта партнёры NVIDIA, такие как Bechtel и Vertiv, поставляют готовые к подключению модули, протестированные на заводе. Это значительно сокращает время сборки и обеспечивает масштабируемость, помогая быстрее достичь окупаемости. Архитектура проекта подразумевает, что после запуска физической ИИ-фабрики её цифровой двойник можно будет использовать в качестве операционной среды для мониторинга, проверки и дальнейшей оптимизации процессов.

29.10.2025 [13:31], Руслан Авдеев

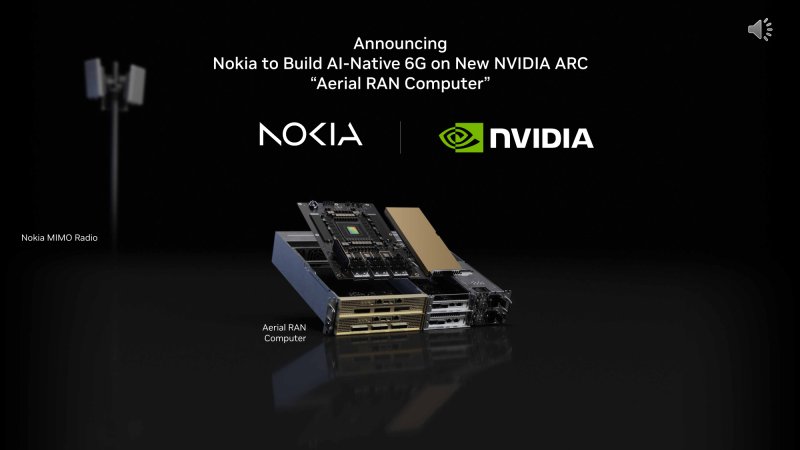

NVIDIA вложит в Nokia $1 млрд, чтобы ускорить интеграцию ИИ в сети 5G/6G28 октября торги акциями Nokia закрылись с ростом на 21 % после того, как NVIDIA объявила о намерении приобрести пакет ценных бумаг компании за $1 млрд. Такой цены акции в последний раз достигали в январе 2016 года. Это лишь часть партнёрства, которое позволит компаниям совместно готовить новые продукты для сетей 5G и 6G, сообщает Silicon Angle. Nokia входит в число крупнейших поставщиков базовых станций 5G и ПО для оптимизации сетевой инфраструктуры операторами связи. Также программное обеспечение применяется для управления данными абонентов и выполнения вспомогательных задач. По этим продуктам выручка Nokia за последний финансовый квартал составила €4,82 млрд. Ключевым в партнёрстве с NVIDIA является продукт Arc Aerial RAN Computer Pro (ARC-Pro). По сути, это референсный дизайн, который может использоваться производителями серверов при создании вычислительных модулей для телеком-провайдеров. Устройства получат прочные корпуса и смогут работать даже в неблагоприятных температурных условиях, с т.ч. на морозе. Каждая система ARC-Pro включает ускоритель Blackwell RTX PRO «уровня рабочей станции» на той же архитектуре, что и флагманские ускорители NVIDIA для дата-центров, 72-ядерный CPU Grace и сетевые интерфейсы ConnectX-8 (100/200GbE, 24 порта). Телеком-провайдеры могут использовать ARC-Pro с базовыми станциями, в т.ч. для обеспечения выполнения ИИ-задач. Например, оператор может внедрить нейросеть, способную автоматически оптимизировать энергопотребление станций стандарта 5G. В NVIDIA утверждают, что ARC-Pro поможет операторам и подготовить сети к переходу на 6G, упростить внедрение функций вроде Ultra MIMO. Последняя пока находится в стадии разработки и увеличит объём трафика, обрабатываемого базовыми станциями за счёт установки вспомогательных антенн. Кроме того, в семейство ARC входят ARC-Compact (NVIDIA L4 + ConnectX-7) и ARC-1 (GB200 NVL2 + BlueField-3/ConnectX). Nokia намерена интегрировать ARC-Pro в своё портфолио сетевого оборудования. Также компания намерена упростить использование приложений 5G и 6G с помощью экосистемы CUDA. По словам Nokia, новый качественный скачок на рынке телекоммуникаций — не просто переход от 5G к 6G, а фундаментальная перестройка сети на базе ИИ-решений всех уровней, от ЦОД до периферийных приложений. Партнёрство с NVIDIA ускорят внедрение концепции AI-RAN. Тестирование новых решений AI-RAN будут проводить при поддержке T-Mobile US. Ожидается, что оператор начнёт испытания в 2026 году в рамках подготовки инфраструктуры к 6G. Изначально испытания будут направлены на оценку производительности и эффективности технологии. Как сообщает Reuters, глава NVIDIA Дженсен Хуанг (Jensen Huang) заявил, что сделка поможет США стать центром новой революции в сфере внедрения связи шестого поколения. Он рассчитывает, что коммерческое внедрение нового ИИ-оборудования начнётся в 2027 году, сначала для 5G, потом для 6G. Переговоры Nokia и NVIDIA велись с прошлого года. Инвестиции сделают NVIDIA вторым по величине акционером Nokia. Последняя выпустит для NVIDIA более 166 млн дополнительных акций, каждая из которых будет стоить $6,01.

29.10.2025 [11:55], Сергей Карасёв

NVIDIA представила интерконнект NVQLink для гибридных вычислений на базе GPU и QPUКомпания NVIDIA анонсировала NVQLink — открытую системную архитектуру, предназначенную для тесной интеграции графических (GPU) и квантовых (QPU) процессоров с целью создания гибридных вычислительных платформ. В разработке интерконнекта NVQLink приняли участие Брукхейвенская национальная лаборатория (BNL), Национальная ускорительная лаборатория им. Ферми (Fermilab), Национальная лаборатория имени Лоуренса в Беркли (LBNL), Лос-Аламосская национальная лаборатория (LANL), Национальная лаборатория Ок-Ридж (ORNL), Национальные лаборатории Сандия (SNL) и Тихоокеанская северо-западная национальная лаборатория (PNNL), которые принадлежат Министерству энергетики США (DoE). Кроме того, были вовлечены специалисты Линкольнской лаборатории Массачусетского технологического института (MIT Lincoln Laboratory). Отмечается, что NVQLink обеспечивает открытый подход к квантовой интеграции. Максимальная пропускная способность в системах GPU — QPU заявлена в 400 Гбит/с, тогда как минимальная задержка (FPGA-GPU-FPGA) составляет менее 4 мкс. Интерконнект может применяться в составе ИИ-платформ, обладающих производительностью до 40 Пфлопс (FP4). Решение NVQLink оптимизировано для крупномасштабных квантовых вычислений в реальном времени. В целом, NVQLink обеспечивает возможность непосредственного взаимодействия QPU разных типов и систем управления квантовым оборудованием с ИИ-суперкомпьютерами. Технология предоставляет готовое унифицированное решение для преодоления ключевых проблем интеграции, с которыми сталкиваются исследователи в области квантовых вычислений при масштабировании своих систем. Разработчики могут получить доступ к NVQLink благодаря интеграции с программной платформой NVIDIA CUDA-Q. В число партнёров, вносящих вклад в NVQLink, входят разработчики квантового оборудования Alice & Bob, Anyon Computing, Atom Computing, Diraq, Infleqtion, IonQ, IQM Quantum Computers, ORCA Computing, Oxford Quantum Circuits, Pasqal, Quandela, Quantinuum, Quantum Circuits, Quantum Machines, Quantum Motion, QuEra, Rigetti, SEEQC и Silicon Quantum Computing, а также разработчики квантовых систем управления, включая Keysight Technologies, Quantum Machines, Qblox, QubiC и Zurich Instruments.

28.10.2025 [21:35], Владимир Мироненко

NVIDIA и Oracle построят для США ИИ-суперкомпьютер Solstice: 100 тыс. ускорителей Blackwell и государственно-частное партнёрствоNVIDIA объявила о новом совместном проекте с Oracle по созданию крупнейшей суперкомпьютерной системы с поддержкой ИИ в интересах Министерства энергетики США (DoE) для разработок в сфере науки. В рамках партнёрства NVIDIA и Oracle построят два суперкомпьютера — Solstice и Equinox, оснащённых 100 тыс. и 10 тыс. ускорителей NVIDIA Blackwell соответственно, которые будут объединены интерконнектом NVIDIA и обеспечат суммарную ИИ-производительность в 2,2 Зфлопс. Система Equinox будет введена в эксплуатацию в I половине 2026 года. Стоимость проекта не разглашается. Solstice будет построен с использованием новой модели государственно-частного партнёрства Министерства энергетики США, включающей инвестиции cо стороны промышленности. Сообщается, что суперкомпьютеры будут размещены в Аргоннской национальной лаборатории (ANL) Министерства энергетики США. С их помощью исследователи будут разрабатывать и обучать новые передовые ИИ-модели, включая модели рассуждений, для реализации проектов открытой науки, используя библиотеку NVIDIA Megatron-Core, а также масштабировать их с помощью программного стека для инференса NVIDIA TensorRT. Эти модели станут основой рабочих процессов агентного ИИ для научных исследований. Оба суперкомпьютера будут использоваться в рамках сотрудничества NVIDIA, ANL и DoE, повышая производительность исследований и разработок и ускоряя процесс научных открытий, которые будут осуществляться за счет государственных средств в течение десятилетия. Глава ANL, что новые суперкомпьютеры будут подключены к передовым экспериментальным установкам Министерства энергетики США, таким как усовершенствованный источник фотонов, что позволит решать самые насущные проблемы страны благодаря научным открытиям.

28.10.2025 [20:35], Сергей Карасёв

NVIDIA анонсировала DPU BlueField-4: 800G-порты, ConnectX-9, CPU Grace и PCIe 6.0NVIDIA анонсировала DPU BlueField 4, рассчитанный на использование в составе масштабных инфраструктур ИИ. Устройство оснащено 800G-портами. Новинка в этом отношении вдвое быстрее BlueField-3, дебютировавших ещё в 2021 году. NVIDIA отмечает, что ИИ-фабрики продолжают развиваться с беспрецедентной скоростью. При этом требуется обработка колоссальных массивов структурированных и неструктурированных данных. Для удовлетворения этих потребностей необходимо формирование инфраструктуры нового класса, на которую как раз и ориентирован DPU BlueField-4. Новинка использует программно-определяемую архитектуру для ускорения сетевых операций, функций безопасности и задач хранения данных. По заявлениям NVIDIA, BlueField-4 позволяет трансформировать дата-центры в безопасную интеллектуальную ИИ-инфраструктуру с высокой производительностью. BlueField-4 объединяет 64-ядерный Arm-процессор NVIDIA Grace (114 Мбайт L3-кеш), 128 Гбайт LPDDR5, 512 Гбайт SSD, сетевой адаптер NVIDIA ConnectX-9 SuperNic (1,6 Тбит/с), а также коммутатор PCIe 6.0 с 48 линиями. Новинка будет доступна в виде карты расширения (PCIe 6.0 x16) и в виде модуля для узлов VR NVL144. Утверждается, что по сравнению с BlueField-3 вычислительная производительность выросла в шесть раз. При этом возможно формирование ИИ-фабрик вчетверо большего масштаба. Кроме того, BlueField-4 поддерживает многопользовательскую сеть, быстрый доступ к данным и микросервисы NVIDIA DOCA. Задействована архитектура NVIDIA BlueField Advanced Secure Trusted Resource Architecture. Предполагается, что BlueField-4 возьмут на вооружение такие производители серверов и платформ хранения данных, как Cisco, DDN, Dell Technologies, HPE, IBM, Lenovo, Supermicro, VAST Data и WEKA. О поддержке новинки заявили Armis, Check Point, Cisco, F5, Forescout, Palo Alto Networks и Trend Micro, а также системные интеграторы Accenture, Deloitte и World Wide Technology. Интегрировать BlueField-4 в свои платформы намерены Canonical, Mirantis, Nutanix, Rafay, Red Hat, Spectro Cloud и SUSE. На рынок BlueField-4 поступит в 2026 году как часть экосистемы Vera Rubin.

23.10.2025 [00:40], Владимир Мироненко

Умение Альтмана играть на самолюбии руководителей позволило OpenAI заключить сделки на сотни миллиардов долларовГлава OpenAI Сэм Альтман (Sam Altman) оказался умелым стратегом. Чтобы обеспечить компанию чуть ли не бесконечными вычислительными мощностями, он организовал целую серию сделок на сотни миллиардов долларов, натравив друг на друга гигантов Кремниевой долины. Альтман сыграл на их самолюбии и желании нажиться на будущем росте OpenAI. Все они теперь делают ставку на успех стартапа, который пока невероятно далёк от прибыльности, пишет The Wall Street Journal. Но выйти из игры они уже не могут — OpenAI должна выжить любой ценой. А NVIDIA даже готова расплатиться по долгам OpenAI, если что-то пойдёт не так. За последние два месяца цены на акции Oracle, NVIDIA, AMD и Broadcom резко взлетали вверх после объявления о сделках, связанных с OpenAI. В общей сложности их рыночная стоимость выросла на $630 млрд в первый день торгов после этих объявлений. Каждый раз за этим следовал более масштабный рост акций технологических компаний, способствуя росту фондового рынка США до рекордных высот. «Самые успешные люди, которых я знаю, верят в себя почти до самообмана», — написал в 2019 году Альтман в блоге «Как достичь успеха», а затем добавил: «Одной веры в себя недостаточно — нужно ещё и уметь убеждать других в своей вере». В этом году OpenAI планирует получить выручку в размере $13 млрд, что несопоставимо со счетами на $650 млрд, которые компания получит только в рамках сделок с NVIDIA и Oracle, согласно подсчётам The Wall Street Journal. С учётом соглашений с AMD, Broadcom и другими провайдерами облачных услуг, такими как Microsoft, общая сумма затрат приближается к $1 трлн. Обязательства на такие объёмы поставок чипов и километровых ЦОД до того, как OpenAI сможет себе это позволить, вызывают опасения, что энтузиазм в отношении ИИ превращается в пузырь, зависящий от успеха всего одной компании. Некоторые партнёры даже помогают OpenAI оплачивать свои чипы, заключая циклические сделки. В прошлом году Альтман спросил гендиректора Microsoft Сатью Наделлу (Satya Nadella), готова ли его компания инвестировать не менее $100 млрд в создание новых ЦОД OpenAI в рамках будущего проекта Stargate. Тот ответил отказом. Такой же ответ он получил от TSMC. Последней он представил проект стоимостью $7 трлн по строительству новых заводов по производству микросхем по всему миру. Ситуация изменилась, когда Альтману удалось заручиться поддержкой гендиректора SoftBank Масаёси Сона (Masayoshi Son). Сон согласился возглавить проект стоимостью $500 млрд. После объявления Белого дома США о поддержке проекта Stargate, акции SoftBank подскочили на 11 %, как и акции других технологических партнёров, участвующих в проекте. Практически сразу NVIDIA предложила OpenAI организовать похожий проект и помочь с его финансированием, но без участия SoftBank. В последующие после анонса недели и месяцы OpenAI получила сотни предложений о потенциальных площадках для строительства, что подготовило почву для её следующих шагов. В свою очередь Microsoft расторгла договоры аренды некоторых ЦОД в США, ссылаясь на отказ от поддержки нагрузок OpenAI. Вместе с тем она, являясь на тот момент главным инвестором OpenAI, разрешила ей найти дополнительные вычислительные мощности у других поставщиков и сосредоточила усилия на привлечении клиентов. После этого OpenAI заключила контракт с Oracle на $300 млрд, что привело к рекордному за четверть века росту акций последней. Внутри Microsoft сделку раскритиковали — не было уверенности, что Oracle справится, поскольку строительство гигантских ЦОД обязывает OpenAI выплачивать в среднем $60 млрд/год, что более чем вчетверо превышает её текущую выручку. Между тем переговоры OpenAI и NVIDIA по их собственному проекту создания ИИ-инфраструктуры зашли в тупик. Всё изменилось в июне, когда стало известно о сделке между Google и OpenAI. А после появления сообщения о том, что OpenAI начала арендовать ускорители TPU у Google для поддержки ChatGPT, гендиректор NVIDIA Дженсен Хуанг (Jensen Huang) практически сразу позвонил Альтману, чтобы узнать, правда ли это, и дал понять, что готов возобновить переговоры. В итоге NVIDIA подписала соглашение о предоставлении в аренду OpenAI до 5 млн своих чипов, что по сегодняшним ценам обойдётся в $350 млрд. Также NVIDIA готова инвестировать до $100 млрд, чтобы помочь стартапу оплатить сделку. Более того, в рамках сделки NVIDIA также обсуждает предоставление гарантий по некоторым кредитам, которые OpenAI планирует взять на строительство собственных ЦОД, сообщили источники WSJ. Этим шагом NVIDIA может возложить на себя миллиардные долговые обязательства, если стартап не сможет вовремя погасить кредиты. Несмотря на заключённые с NVIDIA и другими компаниями контракты, OpenAI продолжала расширять свою вычислительную базу. Всего через несколько недель компания подписала с AMD контракт на 6 ГВт, в рамках которого может также получить до 10 % её акций. После объявления 6 октября о сделке с OpenAI акции AMD выросли на рекордные 24 %. Неделю спустя OpenAI официально представила проект по разработке ИИ-чипа совместно с Broadcom, над которым они работали с начала 2024 года. После объявления о сделке OpenAI с NVIDIA переговоры о заключении крупного соглашения ускорились. Сделка с Broadcom сопоставима по масштабу со сделкой с NVIDIA — до 10 ГВт вычислительной мощности для OpenAI к 2029 году.

22.10.2025 [17:09], Владимир Мироненко

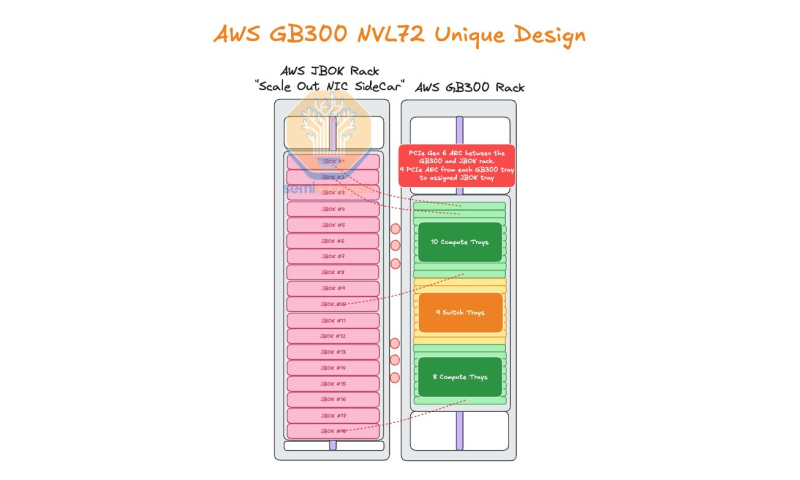

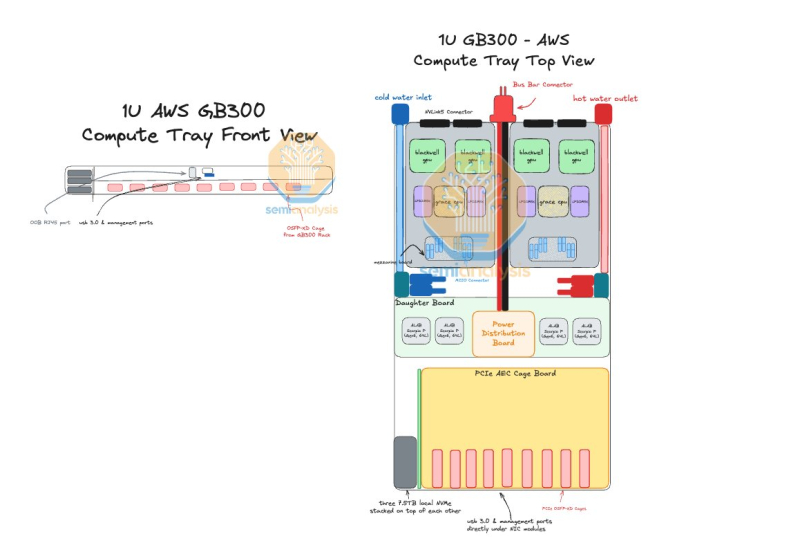

AWS пожертвовала компактностью GB300 NVL72, лишь бы снизить зависимость от NVIDIAAmazon Web Services (AWS) нашла выход, как использовать собственные Nitro DPU K2v5/6 (EFA) в новейших стоечных системах NVIDIA GB300 NVL72, которые, как считает гиперскейлер, превосходит адаптеры NVIDIA ConnectX-7/8 по производительности. В связи с тем, что в стойках NVIDIA Oberon используются укороченные лотки высотой 1U, AWS размещает NIC в отдельной стойке JBOK, предназначенной только для сетевых карт, пишет SemiAnalysis. Причина кроется в невозможности установить в 1U сразу девять фирменных адаптеров (8 × EFA + 1 × ENA/EBS). Для серверных систем GB200 NVL предыдущего поколения AWS выбрала вариант NVL36×2, поскольку только в этом случае использовались 2U-узлы, где достаточно места для всех NIC. Однако сдвоенная конфигурация менее эффективна, чем нативная конструкция NVL72. NVIDIA сама была не очень довольна вариантами NVL36. Meta✴, например, и вовсе «растянула» NVL36×2 на шесть стоек, чтобы обойтись воздушным охлаждением. AWS в случае Blackwell Ultra предпочла остановиться на NVL72-варианте, а DPU вынести в отдельную стойку — всего 18 узлов высотой 2U, по 9 NIC в каждом. С узлами NVIDIA они соединены активными электрическими кабелями (AEC) и портами OSFP-XD для передачи сигналов PCIe 6.0. По словам AWS, её адаптеры лучше справляются с нагрузками, чем ConnectX-8 (RoCEv2), что отчасти спорно. В любом случае таким образом компания снижается зависимость от NVIDIA. С точки зрения SemiAnalysis, доработка GB300 в AWS помогает устранить единую точку отказа в референсной архитектуре NVIDIA, где каждый ускоритель взаимодействует только с одним сетевым адаптером ConnectX-8, тогда как в конфигурации AWS каждый ускоритель общается с двумя NIC. У AWS накоплен богатый опыт разработки собственного оборудования для ЦОД. Ранее компания в партнёрстве с Broadcom разрабатывала специализированные сетевые коммутаторы. Также недавно представленные ею EC2-инстансы P6-B200 и P6e-GB200 оснащены собственным сетевым стеком Elastic Fabric Adapter (EFAv4) на базе собственных контроллеров Nitro, который оптимизирует обработку сетевых пакетов и снижает задержки для высокопроизводительных приложений.

21.10.2025 [21:50], Владимир Мироненко

Nebius запустила первый в Израиле ИИ ЦОД с NVIDIA HGX B200Компания Nebius объявила о доступности платформы Nebius AI Cloud в своем новом ЦОД в Израиле, запущенном на площадке в Модиине (Modiin). Сообщается, что это один из крупнейших в стране ИИ-кластеров и первый на архитектуре NVIDIA Blackwell. Кластер включает 4 тыс. ускорителей в составе HGX B200, объединённых интерконнектом NVIDIA Quantum InfiniBand, и предоставляет доступ к стеку NVIDIA AI Enterprise, в том числе к микросервисам NVIDIA NIM и инструментам управления ИИ-агентами NeMo. Запуск в Израиле последовал за аналогичными развёртываниями Nebius в Европе и США. Новая площадка объединяет передовую аппаратную и программную инфраструктуру, включая усовершенствованные системы охлаждения, системы управления энергопотреблением и механизмы управления данными, разработанные для интенсивных рабочих ИИ-нагрузок. Nebius — партнёр NVIDIA по облачным технологиям (NCP). «Запуск Nebius крупнейшего в Израиле облака ИИ на базе Blackwell знаменует собой начало развития инфраструктуры ИИ в стране», — сообщил директор представительства NVIDIA в Израиле, отметив, что благодаря суверенному доступу к передовым вычислительным, сетевым технологиям и ПО, израильские компании и разработчики смогут внедрять инновации, развёртывать и масштабировать следующее поколение агентного и физического ИИ. Nebius входит в число первых партнёров NCP, получивших сертификат Exemplar Cloud для учебных рабочих нагрузок на базе NVIDIA H100, продемонстрировав производительность в пределах 95 % от референсной архитектуры NVIDIA. Платформа Nebius AI Cloud получила сертификацию SOC2 Type II, включая HIPAA, и обеспечивает сквозное шифрование, а также полное соответствие стандартам защиты данных GDPR и CCPA. |

|