Материалы по тегу: nvidia

|

11.03.2024 [13:41], Сергей Карасёв

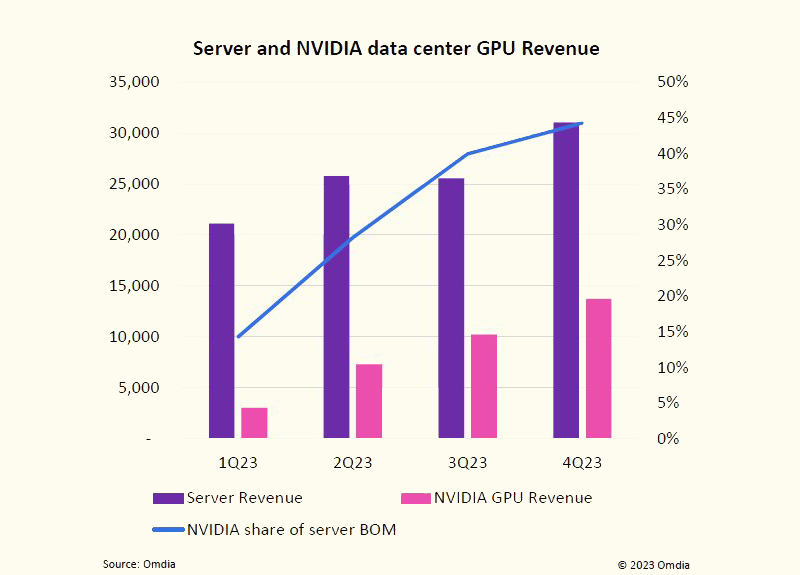

Рынок серверов растёт в деньгах, а NVIDIA оказывает ключевое влияние на его развитиеОбъём мирового рынка серверов увеличивается в денежном выражении, но продажи в штуках сокращаются, о чём, как сообщает The Register, говорится в исследовании Omdia. Дело в том, что заказчики смещают фокус на закупку более дорогих систем для обучения или запуска моделей ИИ и решения НРС-задач. По оценкам Omdia, в IV квартале 2023 года продажи серверов достигли приблизительно $31 млрд. Это на 12,7 % больше по сравнению с аналогичным периодом 2022-го и на 21,5 % больше по отношению к III четверти 2023-го. Вместе с тем в штучном выражении отгрузки оказались значительно ниже прогнозов. За квартал было реализовано от 2,8 до 2,9 млн серверов, что на 500 тыс. меньше ожидаемого значения. Результат оказался самым низким с 2017 года.

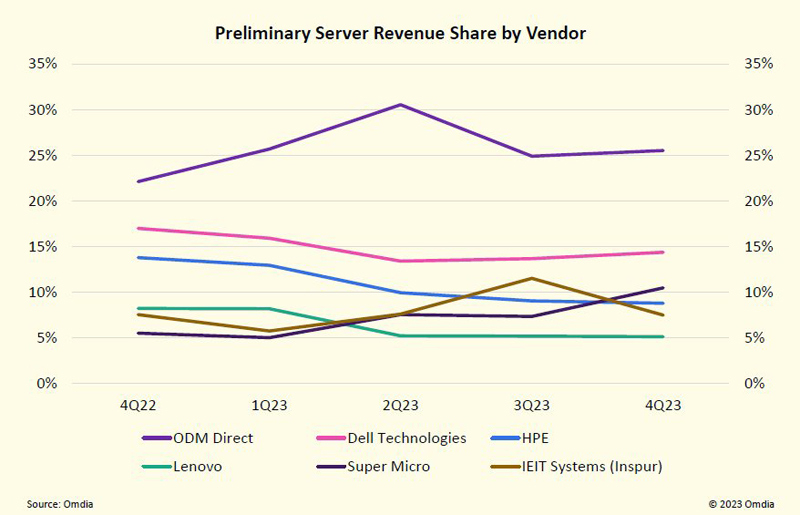

Источник изображений: Omdia Omdia отмечает, что объём поставок серверов во многом зависит от доступности ИИ-ускорителей NVIDIA. По оценкам, на изделия NVIDIA в настоящее время приходится в среднем 44 % от общей стоимости компонентов серверов. Для сравнения: в начале 2023 года этот показатель составлял примерно 15 %. Наблюдающаяся картина свидетельствует о стремительном развитии ИИ-сегмента в целом и генеративных систем в частности. На этом фоне быстро растёт выручка NVIDIA в сегменте дата-центров. Аналитики Omdia оценивают продажи ускорителей NVIDIA на базе GPU для ЦОД в $13,7 млрд по итогам IV квартала 2023 года. Это в несколько раз больше по сравнению с I четвертью 2023-го. Фактически, отмечает Omdia, именно NVIDIA определяет тенденции развития серверного рынка. При этом тесные партнёрские отношения с NVIDIA для производителей ЦОД-оборудования являются одним из наиболее значимых критериев успеха. В подтверждение этому Omdia приводит тот факт, что компания Supermicro в течение 2023 года увеличила свою долю в общем объёме выручки на серверном рынке вдвое — с 5 % до 10 %: этому способствовали продажи ИИ-систем. В результате, в IV квартале 2023-го Supermicro смогла обойти HPE.  Ещё одним фактором падения поставок серверов в штучном выражении является то, что гиперскейлеры продлевают срок эксплуатации оборудования. По оценкам Omdia, средний срок службы серверов, расположенных в корпоративных ЦОД или на колокейшн-площадках, теперь достигает 7,6 года, тогда как крупные операторы дата-центров довели это значение в среднем до 6,6 года.

03.03.2024 [21:59], Сергей Карасёв

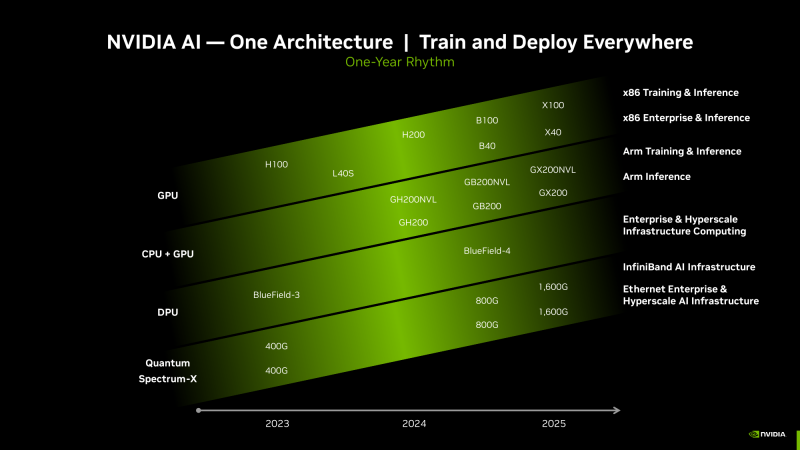

Киловаттный ускоритель NVIDIA B200 Blackwell появится в 2025 годуКомпания Dell во время конференции, посвящённой квартальному отчёту, подтвердила подготовку ускорителя нового поколения NVIDIA B200 семейства Blackwell для ресурсоёмких ИИ-задач и НРС-приложений, на что обратил внимание ресурс Videocardz. Ожидается, что это изделие появится в следующем году. Официальный анонс решений Blackwell состоится в этому году. Причём в NVIDIA прогнозируют, что ускорители окажутся в дефиците сразу после выхода. Объясняется это стремительным ростом рынка ИИ, в том числе быстрым развитием генеративных сервисов. Известно, что в семейство Blackwell войдут флагманское изделие B100 для ИИ и HPC-задач, модель B40 для корпоративных заказчиков, гибридное решение GB200, сочетающее чип B100 и Arm-процессор Grace, а также GB200 NVL для обработки больших языковых моделей (LLM). Теперь говорится, что также готовится ускоритель B200: отмечается, что это может быть название конечного продукта. По данным Dell, показатель TDP в случае B200 может достигать 1000 Вт. Для сравнения: ускоритель NVIDIA H100 в форм-факторе SXM обладает TDP в 700 Вт. На подготовку B200 намекнул операционный директор Dell Джефф Кларк (Jeff Clarke). По его словам, инженерная команда компании будет готова к появлению продукта. Таким образом, можно предположить, что Dell уже проектирует серверы нового поколения, рассчитанные на установку ускорителей B200. Отмечается также, что акции Dell по состоянию на 1 марта 2024 года выросли в цене на 32 %, тогда как капитализация NVIDIA превысила $2 трлн. При этом Dell является одним из ключевых партнёров NVIDIA в сегменте дата-центров.

29.02.2024 [23:59], Владимир Мироненко

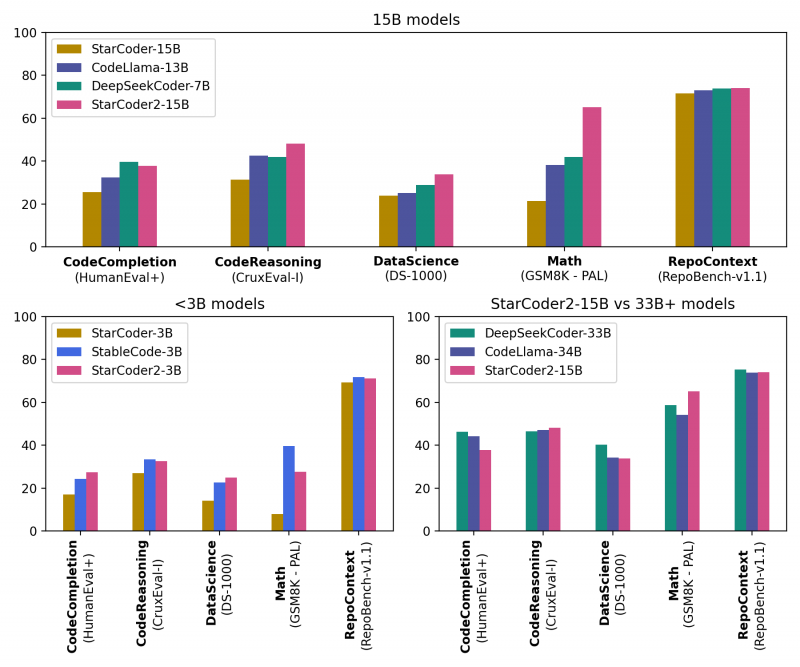

ServiceNow, Hugging Face и NVIDIA представили новое поколение ИИ-моделей StarCoder2 для генерации кодаКомпании ServiceNow, Hugging Face и NVIDIA представили семейство общедоступных больших языковых моделей (LLM) StarCoder2 для генерации кода, призванное помочь разработчикам использовать генеративный ИИ для создания корпоративных приложений. Семейство было разработано NVIDIA в сотрудничестве с исследовательским проектом BigCode, которым управляет ServiceNow, и Hugging Face, разработчиком открытой LLM-платформы. Модели StarCoder2 обучены 619 языкам программирования и могут быть дообучены на собственных данных и встроены в корпоративные приложения для выполнения специализированных задач, таких как генерация кода, управление рабочими процессами, обобщение текста и многое другое. Разработчики могут использовать автодополнение и обобщение кода, извлечение фрагментов кода и другие возможности. Набор StarCoder2 включает три модели: модель с 3 млрд параметров, обученная ServiceNow; модель с 7 млрд параметров, обученная Hugging Face; и модель с 15 млрд параметров, созданная NVIDIA с помощью NVIDIA NeMo. Варианты моделей с меньшим количеством параметров менее требовательны к вычислительной инфраструктуре, при этом модель StarCoder2 с 3 млрд параметров соответствует производительности исходной модели StarCoder с 15 млрд. параметров В основе StarCoder2 лежит новый набор данных Stack v2, который более чем в 7 раз больше, чем Stack v1. Кроме того, новые модели обучены работе с малораспространёнными языками вроде COBOL, «понимают» математику и могут обсуждать исходный код программ. Пользователи могут дообучить и настроить модели StarCoder2, используя данные, специфичные для отрасли или организации, с помощью NVIDIA NeMo или Hugging Face TRL. Разработчики смогут создавать продвинутых чат-ботов для решения более сложных задач обобщения или классификации и разрабатывать персонализированных помощников по программированию. Разработка ПО стала основной областью использования ИИ, чему отчасти способствовали такие инструменты как GitHub Copilot и AWS CodeWhisperer, отметил ресурс SiliconANGLE. Согласно недавнему опросу GitHub, 91 % разработчиков в США используют ИИ-инструменты для создания кода. Впрочем, опрос, проведённый CoderPad Inc., показал, что почти четверть разработчиков скептически относятся к ценности ИИ в работе, а 28 % и вовсе заявили, что их работодатель запрещает им пользоваться ИИ-инструментами. В числе причин негативного отношения — опасения, что ИИ-помощники создают неэффективный или уязвимый код, а также крадут интеллектуальную собственность, генерируя код на основе материалов, защищённых авторским правом, которые использовались при обучении модели. Создатели StarCoder2 подчёркивают, что модели были созданы с использованием данных Software Heritage, крупнейшей, по их словам, общедоступной коллекцию исходных кодов. В целях дальнейшего повышения прозрачности и сотрудничества вспомогательный код модели будет по-прежнему размещаться на странице проекта BigCode на GitHub. Он доступен по лицензии BigCode OpenRAIL-M, обеспечивающей бесплатный доступ и использование. Все модели StarCoder2 также будут доступны для загрузки с Hugging Face, а модель StarCoder2 с 15 млрд параметров доступна в составе NVIDIA AI Foundation.

28.02.2024 [15:54], Руслан Авдеев

Доступность ускорителей NVIDIA H100 повысилась, что привело к появлению вторичного рынкаСроки поставок ускорителей NVIDIA H100 значительно сократилось, с 8–11 мес. до всего 3-4. По данным Tom’s Hardware, в результате многие компании, ранее сделавшие огромные запасы, пытаются продать излишки. Кроме того, стало намного легче арендовать ускорители в облаках Amazon, Google и Microsoft. Впрочем, разработчики ИИ-моделей до сих пор испытывают проблемы с доступом к ресурсам ускорителей, поскольку спрос превышает предложение. Как сообщают СМИ, некоторые компании пытаются перепродать доставшиеся им H100, а другие стали заказывать меньше в связи с высокой стоимостью обслуживания складских запасов и окончанием паники на рынке. В прошлом году приобрести подобные ускорители было чрезвычайно сложно. Отчасти улучшение ситуации на рынке связано с тем, что провайдеры облачных сервисов вроде Amazon (AWS) и других крупных игроков упростили аренду H100. Несмотря на то, что доступ к H100 упростился, желающим обучать LLM добраться до ресурсов по-прежнему непросто, во многом потому, что им требуются ускорители в невероятных количествах, в некоторых случаях речь идёт о сотнях тысяч экземпляров, поэтому цены на них до сих пор не упали, а NVIDIA продолжает получать сверхприбыли. При этом рост доступности привёл к тому, что компании всё чаще пытаются сэкономить, ведут себя более избирательно при выборе предложений продажи или аренды, стараются приобрести более мелкие кластеры и внимательнее оценивают их экономическую целесообразность для бизнеса. Кроме того, альтернативные решения становятся все более распространёнными и всё лучше поддерживаются ПО. Это ведёт к формированию сбалансированной ситуации на рынке. Так или иначе, спрос на ИИ-чипы по-прежнему высок, а с учётом того, что LLM становятся всё масштабнее, требуется больше вычислительных мощностей. Поэтому крупные игроки, которые зависят от поставок решений NVIDIA, занялись созданием собственных ускорителей. Среди них Microsoft, Meta✴ и OpenAI.

27.02.2024 [21:44], Сергей Карасёв

Gigabyte представила новые серверы для ИИ, 5G и периферийных вычисленийКомпания Gigabyte Technology на MWC 2024 анонсировала новые серверы для ИИ-задач, 5G-сетей, облачных и периферийных вычислений. Дебютировали модели на процессорах AMD и Intel, оснащённые мощными ускорителями. В частности, представлены серверы G593-ZX1/ZX2, оборудованные восемью картами AMD Instinct MI300X для ресурсоёмких вычислений. Кроме того, демонстрируются сервер высокой плотности H223-V10 с поддержкой суперчипа NVIDIA Grace Hopper, модель G383-R80 с четырьмя APU AMD Instinct MI300A и сервер серии G593, оснащённый восемью ускорителями NVIDIA HGX H100. Ещё одна новинка — сервер хранения S183-SH0. Он допускает использование 32 SSD формата E1.S (NVMe), благодаря чему подходит для обработки сложных рабочих нагрузок, таких как большие языковые модели (LLM). Эти серверы также могут быть интегрированы в суперкомпьютерные кластеры и инфраструктуру 5G. На edge-сегмент рассчитан сервер E263-S30 с модульной архитектурой: он может быть адаптирован под различные сценарии использования путём установки необходимых аппаратных компонентов. А модель R163-P32 комплектуется процессором AmpereOne с архитектурой Arm (до 192 ядер Arm с частотой до 3,0 ГГц), что обеспечивает высокую энергетическую эффективность.

На ИИ-приложения и облачные периферийные вычисления ориентированы серверы R243-EG0 и R143-EG0, которые оснащены чипами AMD EPYC 8004 Siena. Для сегмента малого и среднего бизнеса Gigabyte предлагает серверы R113-C10 и R123-X00, наделённые процессорами AMD Ryzen 7000 и Intel Xeon E-2400: эти модели подходят для веб-хостинга, создания гибридных облаков и хранилищ данных.

27.02.2024 [16:08], Сергей Карасёв

Supermicro анонсировала ИИ- и телеком-серверы на базе AMD EPYC Siena, Intel Xeon Emerald Rapids и NVIDIA Grace Hopper

5g

amd

emerald rapids

epyc

gh200

grace

hardware

intel

mwc 2024

nvidia

siena

supermicro

ии

периферийные вычисления

сервер

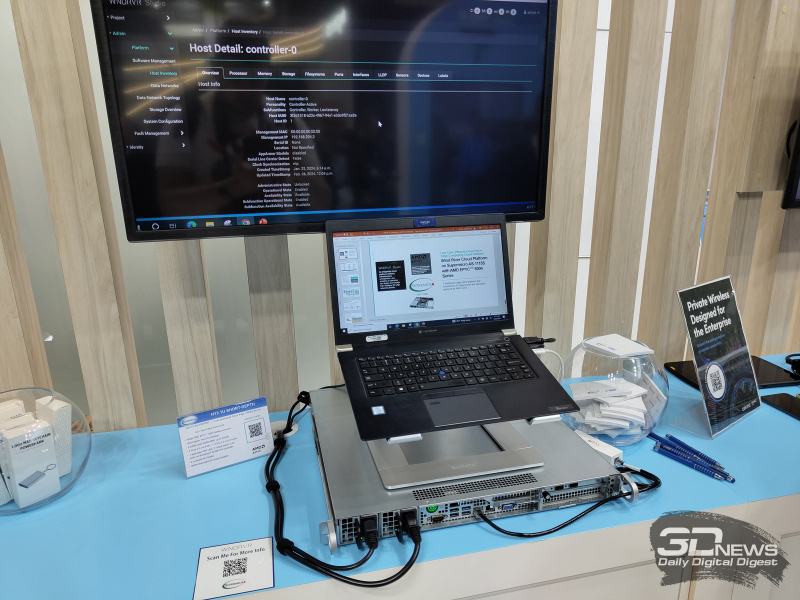

Компания Supermicro представила на выставке мобильной индустрии MWC 2024 в Барселоне (Испания) новые серверы для телекоммуникационной отрасли, 5G-инфраструктур, задач ИИ и периферийных вычислений. Дебютировали модели с процессорами AMD EPYC 8004 Siena, Intel Xeon Emerald Rapids и с суперчипами NVIDIA GH200 Grace Hopper. В частности, анонсирована стоечная система ARS-111GL-NHR высокой плотности в форм-факторе 1U на базе GH200. Устройство наделено двумя слотами PCIe 5.0 x16, восемью фронтальными отсеками для накопителей E1.S NVMe и двумя коннекторами для модулей M.2 NVMe. Сервер предназначен для работы с генеративным ИИ и большими языковыми моделями (LLM). На периферийные 5G-платформы ориентировано решение SYS-211E ультрамалой глубины — 298,8 мм. Модель рассчитана на один процессор Xeon Emerald Rapids в исполнении LGA-4677. Есть восемь слотов для модулей DDR5-5600 общей ёмкостью до 2 Тбайт и до шести слотов PCIe 5.0 в различных конфигурациях для карт расширения. Модификация SYS-211E-FRDN13P для сетей Open RAN предлагает 12 портов 25GbE и поддерживает технологию Intel vRAN Boost. Ещё одна новинка — сервер AS-1115S-FWTRT формата 1U с возможностью установки одного процессора EPYC 8004 Siena (до 64 ядер). Реализована поддержка до 576 Гбайт памяти DDR5-4800 (шесть слотов), двух портов 10GbE, двух слотов PCIe 5.0 x16 FHFL и одного слота PCIe 5.0 x16. Решение предназначено для edge-приложений.

Представлены также многоузловая платформа SYS-211SE-31D/A и система высокой плотности SYS-221HE: обе модели выполнены в формате 2U на процессорах Xeon Emerald Rapids. Второй из этих серверов допускает монтаж до трёх двухслотовых ускорителей NVIDIA H100, A10, L40S, A40 или A2. Наконец, анонсирован сервер AS-1115SV типоразмера 1U с поддержкой процессоров EPYC 8004 Siena, 576 Гбайт памяти DDR5, трёх слотов PCIe 5.0 x16 и 10 накопителей SFF.

27.02.2024 [13:24], Сергей Карасёв

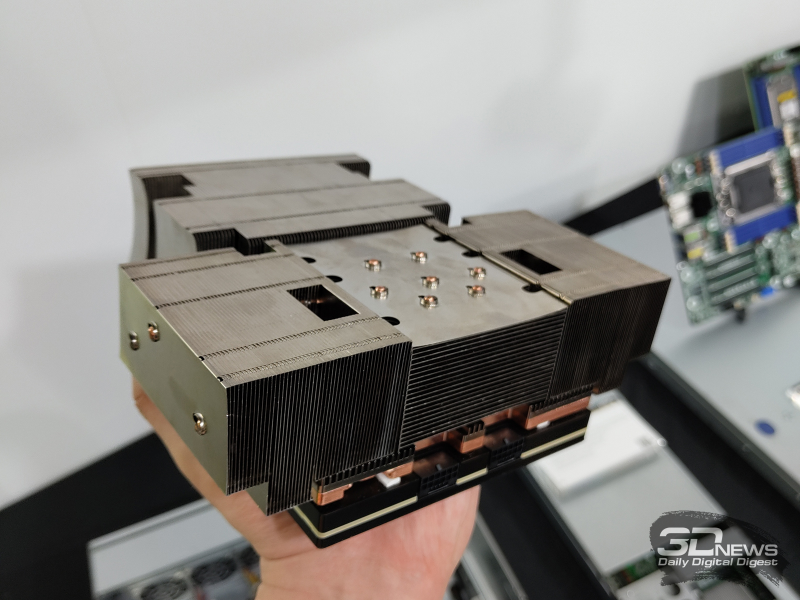

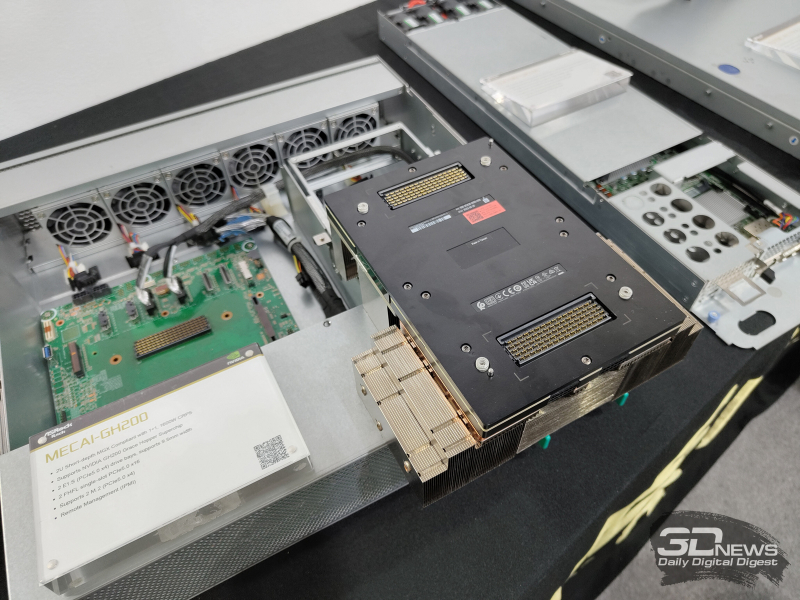

ASRock Rack представила MECAI-GH200 — самый компактный в мире сервер с суперчипом NVIDIA GH200Компания ASRock Rack продемонстрировала сервер MECAI-GH200: это, как утверждается, самая компактная в мире система, оснащённая гибридным суперчипом NVIDIA GH200 Grace Hopper с 72-ядерным Arm-процессором NVIDIA Grace и ускорителем NVIDIA H100 с 96 Гбайт памяти HBM3. Новинка выполнена в 2U-корпусе небольшой глубины. Доступны два посадочных места для накопителей формата E1.S (PCIe 5.0 х4), два коннектора для модулей М.2 (PCIe 5.0 х4) и два слота для карт расширения FHFL с интерфейсом PCIe 5.0 х16. Питание обеспечивают два блока мощностью 1600 Вт. Глубина MECAI-GH200 составляет 450 мм. Сервер предназначен для решения ИИ-задач на периферии. Прочие характеристики сервера пока не раскрываются. «В ASRock Rack мы стремимся обеспечить возможность повсеместного использования ИИ. Для достижения этой цели мы создаём надёжные серверные решения в различных форм-факторах и для различных сценариев», — говорит вице-президент компании Хантер Чен (Hunter Chen). ASRock Rack также представила на выставке MWC 2024 новые barebone-системы и материнские платы для процессоров Intel, AMD и Ampere. Например, впервые демонстрируется плата SIENAD8UD-2L2Q с поддержкой чипов AMD EPYC 8004 Siena и двумя сетевыми портами 25GbE SFP28.

24.02.2024 [19:46], Сергей Карасёв

ИИ-ускорители NVIDIA Blackwell сразу будут в дефицитеКомпания NVIDIA, по сообщению ресурса Seeking Alpha, прогнозирует высокий спрос на ИИ-ускорители следующего поколения Blackwell. Поэтому сразу после выхода на рынок эти изделия окажутся в дефиците, и их поставки будут ограничены. «На все новые продукты спрос превышает предложение — такова их природа. Но мы работаем так быстро, как только можем, чтобы удовлетворить потребности заказчиков», — говорит глава NVIDIA Дженсен Хуанг (Jensen Huang). Из-за стремительного развития генеративного ИИ на рынке сформировалась нехватка нынешних ускорителей NVIDIA H100 поколения Hopper. Срок выполнения заказов на серверы с этими изделиями достигает 52 недель. Аналогичная ситуация, вероятно, сложится и с ускорителями Blackwell, анонс которых ожидается в течение нынешнего года. «Полагаем, что отгрузки наших продуктов следующего поколения будут ограниченными, поскольку спрос намного превышает предложение», — сказала Колетт Кресс (Colette Kress), финансовый директор NVIDIA. Главный вопрос заключается в том, насколько быстро NVIDIA сможет организовать массовое производство Blackwell B100, а также серверов DGX на их основе. Дело в том, что это совершенно новые продукты, в которых используются другие компоненты. По имеющейся информации, Blackwell станет первой архитектурой NVIDIA, предусматривающей чиплетную компоновку. Это может упростить производство ускорителей на уровне кремния, но в то же время усложнит процесс упаковки. В дополнение к флагманскому чипу B100 для ИИ и HPC-задач компания готовит решение B40 для корпоративных заказчиков, гибридный ускоритель GB200, сочетающий ускоритель B100 и Arm-процессор Grace, а также GB200 NVL для обработки больших языковых моделей.

24.02.2024 [03:08], Сергей Карасёв

Arm-суперчипы NVIDIA Grace помогут Nokia создать 5G-сети с ИИКомпания Nokia объявила о сотрудничестве с NVIDIA в рамках проекта по созданию передовых решений для сетей радиодоступа (RAN), использующих технологии ИИ. Предполагается, что инициатива позволит изменить ландшафт телекоммуникационной инфраструктуры и повысить качество услуг в области мобильной связи. Nokia намерена заняться разработкой решений Cloud RAN (сеть радиодоступа на основе облака) на оборудовании NVIDIA. Речь, в частности, идёт о применении Arm-суперчипов NVIDIA Grace. Кроме того, Nokia задействует собственную энергоэффективную технологию ускорения In-Line Layer 1 (L1) и специализированный софт. В составе платформы будут также применяться ускорители NVIDIA. Всё это откроет путь для реализации концепции AI-RAN — сеть радиодоступа с ИИ-подкреплением. Отмечается, что сотрудничество с NVIDIA является частью концепции Nokia AnyRAN, которая предполагает возможность использования любой специализированной, гибридной или облачной среды RAN. Подход помогает ускорить развёртывание и начало эксплуатации сервисов Cloud RAN. При этом высокопроизводительная система Nokia In-Line может быть интегрирована с облачными или серверными инфраструктурами. Ранее Nokia успешно протестировала сквозные соединения 5G (Layer 3) для высокоскоростной передачи данных на оборудовании нескольких поставщиков, в том числе с Arm-чипами Ampere. Ожидается, что применение чипов NVIDIA в составе платформ Nokia поможет в создании более производительных и энергоэффективных решений Cloud RAN. При этом внедрение ИИ даст возможность повысить операционную эффективность. Примечательно, что и Nokia, и Ericsson при поддержке Intel стали развивать оборудование на базе общедоступных платформ, впоследствии добавив поддержку решений других вендоров. Сама Intel предлагает для 5G-систем специализированные процессоры Xeon EE.

23.02.2024 [19:07], Сергей Карасёв

Австралийский суперкомпьютерный центр внедрит суперчипы NVIDIA Grace Hopper для квантовых исследованийАвстралийский суперкомпьютерный центр Pawsey начнёт использовать решение NVIDIA CUDA Quantum — открытую платформу для интеграции и программирования CPU, GPU и квантовых компьютеров (QPU). Ожидается, что это поможет ускорить развитие перспективного направления квантовых вычислений. Pawsey развернёт в своём Национальном центре инноваций в области суперкомпьютеров и квантовых вычислений восемь узлов с суперчипами NVIDIA GH200. Эти изделия содержат 72-ядерный Arm-процессор Grace и ускоритель H100 с 96 Гбайт HBM3. Объём общей для обоих кристаллов памяти составляет 576 Гбайт (480 Гбайт LPDDR5x). Кристаллы соединены между собой шиной NVLink-C2C, обеспечивающей пропускную способность 900 Гбайт/с. Сообщается, что узлы проектируемой системы будут использовать модульную архитектуру NVIDIA MGX, которая предназначена для построения HPC-систем и комплексов ИИ. Предполагается, что высокопроизводительная гибридная платформа с CPU, GPU и QPU позволит выполнять высокоточные и гибко масштабируемые квантовые симуляции. В рамках проекта будет применяться специализированное ПО NVIDIA cuQuantum для разработки квантовых решений. Национальное научное агентство Австралии (CSIRO) оценивает размер внутреннего рынка квантовых вычислений в $2,5 млрд в год с потенциалом создания до 10 тыс. новых рабочих мест к 2040-му. Для достижения таких показателей необходимо внедрение квантовых вычислений в различных областях, включая астрономию, науки о жизни, медицину, финансы и пр. |

|