Материалы по тегу: intel

|

09.06.2022 [16:37], Сергей Карасёв

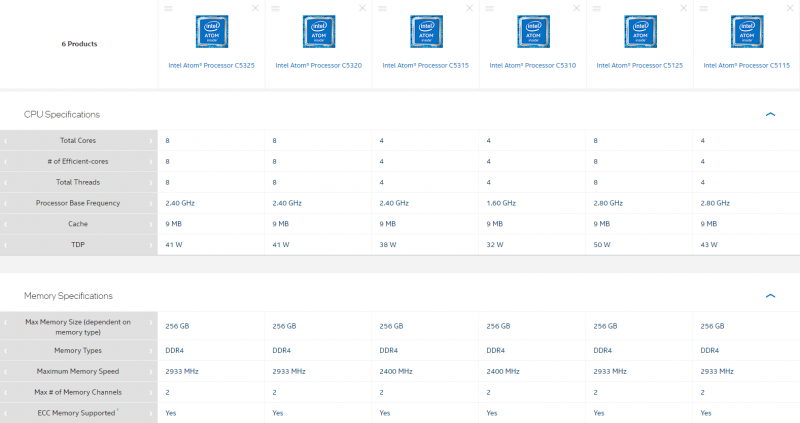

Intel представила первые процессоры серии Atom C5000 Parker RidgeКорпорация Intel анонсировала первые шесть процессоров семейства Atom C5000 (Parker Ridge), предназначенных для применения в серверном и сетевом оборудовании. Дебютировали изделия с обозначениями C5325, C5320, C5315, C5310, C5125 и C5115, которые изготавливаются по 10-нм техпроцессу. В зависимости от модификации чипы содержат четыре или восемь ядер (Tremont). Технология многопоточности не поддерживается. Тактовая частота модели C5310 составляет 1,6 ГГц. Версии C5325, C5320 и C5315 функционируют на частоте 2,4 ГГц, а C5125 и C5115 — 2,8 ГГц. Поддерживается работа с двухканальной оперативной памятью DDR4, частота которой может составлять 2400 или 2933 МГц (см. характеристики отдельных моделей в таблице ниже). Максимально поддерживаемый объём ОЗУ у всех решений равен 256 Гбайт. Все изделия наделены 9 Мбайт кеша второго уровня. Показатель TDP варьируется от 32 до 50 Вт. Это, как отмечает ресурс ServeTheHome, заметивший появление новинок в базе Intel, довольно много для изделий такого класса. Процессоры различаются количеством поддерживаемых линий PCIe — 12, 16 или 32. Чипы позволяют задействовать 12 или 16 портов SATA и восемь USB-портов в конфигурации 4 × USB 2.0 и 4 × USB 3.0. Все процессоры поддерживают технологию Intel QuickAssist (QAT) второго поколения (шифрование 20 Гбит/с), средства виртуализации Virtualization Technology (VT-x), инструкции AES, технологии Intel Trusted Execution и Enhanced Intel SpeedStep. Отличительной же чертой серии являются встроенные сетевые интерфейсы (до 8 шт., до 50GbE), которые есть в четырёх из шести представленных моделей.

16.05.2022 [23:41], Алексей Степин

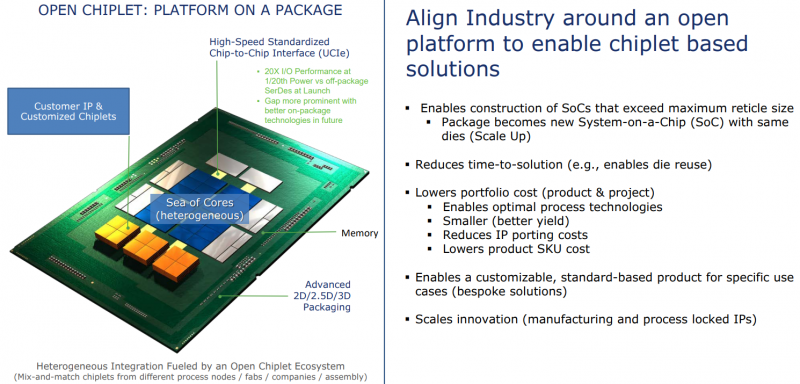

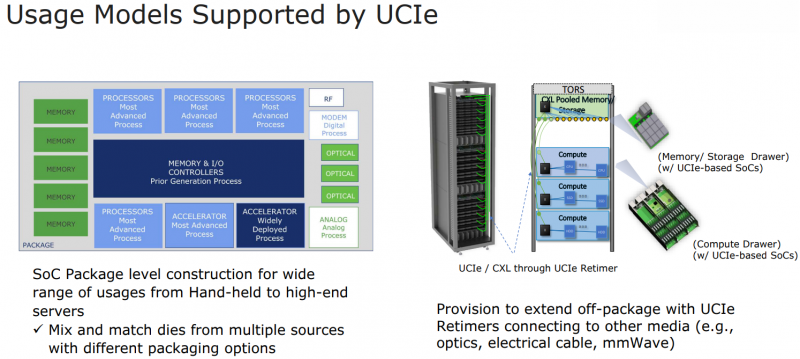

Intel: UCIe объединит разнородные чиплеты внутри одной упаковки и за её пределамиШина PCI Express давно стала стандартом де-факто: она не требует много контактов, её производительность в пересчёте на линию уже достигла ≈4 Гбайт/с (32 ГТ/с) в версии PCIe 5.0, а использование стека CXL сделает PCI Express поистине универсальной. Но для соединения чиплетов или межпроцессорной коммуникации эта шина в текущем её виде подходит не лучшим образом. Но использование проприетарных технологий существенно ограничивает потенциал чиплетных решений, и для преодоления этого ограничения в марте этого года 10-ю крупными компаниями-разработчиками, включая AMD, Qualcomm, TSMC, Arm и Samsung, был основан новый стандарт Universal Chiplet Interconnect Express (UCIe). Уже первая реализация UCIe должна превзойти PCI Express во многих аспектах: если линия PCIe 5.0 представляет собой четыре физических контакта с пропускной способностью 32 ГТ/с, то UCIe позволит передавать по единственному контакту до 12 Гбит/с, а затем планка будет повышена до 16 Гбит/с. При этом энергопотребление у UCIe ниже, а эффективность — выше. На равном с PCIe расстоянии новый стандарт может быть вчетверо производительнее при том же количестве проводников. В перспективе эта цифра может быть увеличена до 10–20 раз, то есть, узким местом между чиплетами UCIe явно не станет. Более того, новый интерконнект не только изначально совместим с CXL, но и гораздо лучше приспособлен к задачам дезагрегации. Иными словами, быстрая связь напрямую между чиплетами возможна не только в одной упаковке или внутри узла, но и за его пределами. Весьма заинтересована в новом стандарте Intel, которая планирует использовать UCIe таким образом, что в процессорах нового поколения ядра x86 смогут соседствовать с Arm или RISC-V. При этом планируется обеспечить совместимость UCIe с технологиями упаковки Intel EMIB и TSMC CoWoS, заодно добавив поддержку других шин, в том числе Arm AMBA, а также возможность легкой конвертации в проприетарные протоколы других разработчиков. В настоящее время Intel уже есть несколько примеров использования UCIe. Так, в одном из вариантов с помощью новой шины к процессорным ядрам подключаются ускорители и блок управления, а упаковка EMIB используется для подключения чипа к дезагрегированной памяти DDR5 и линиям PCI Express.

10.05.2022 [22:46], Игорь Осколков

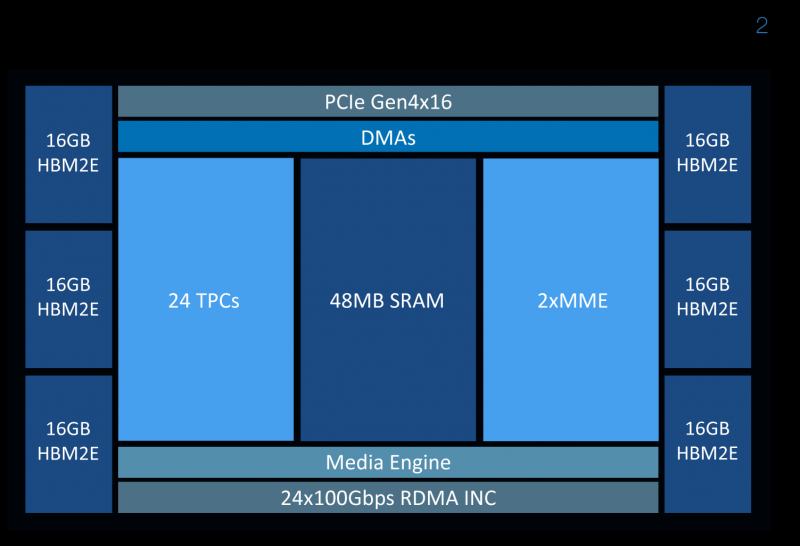

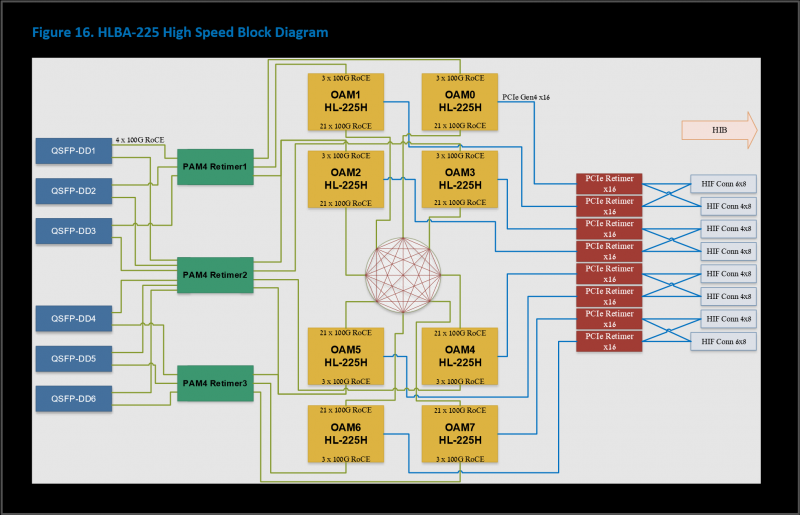

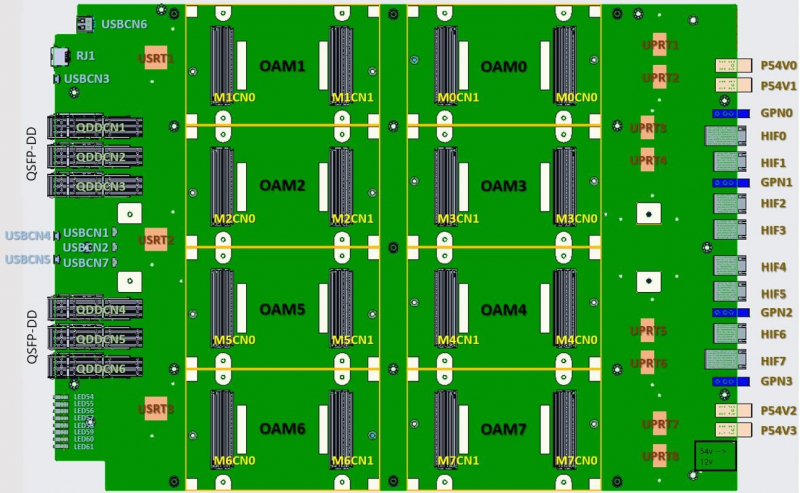

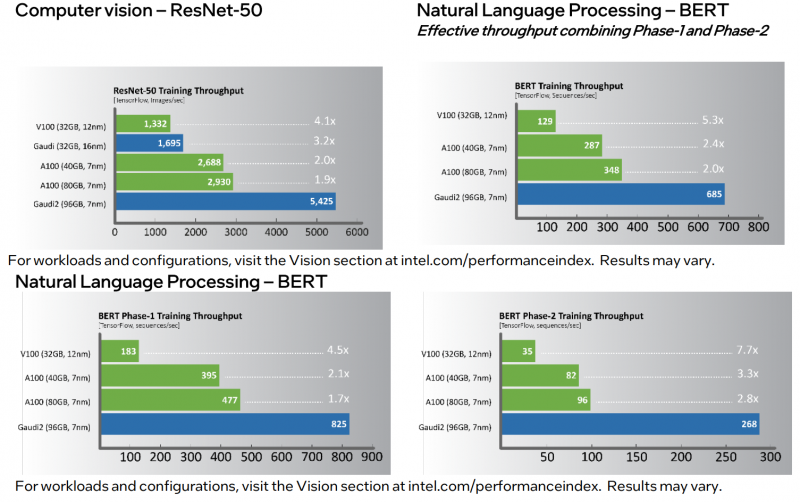

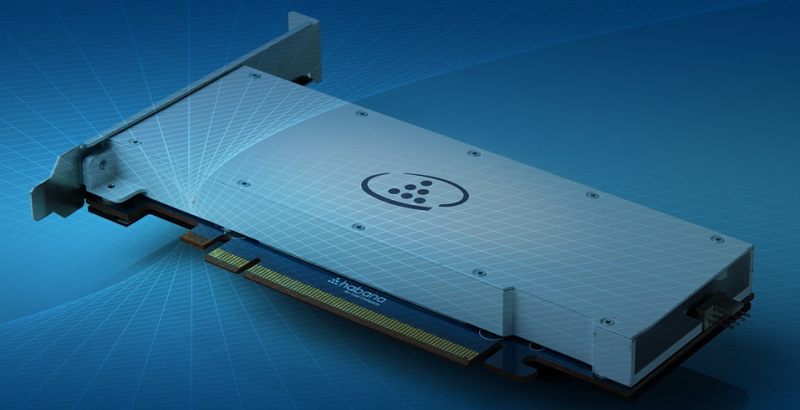

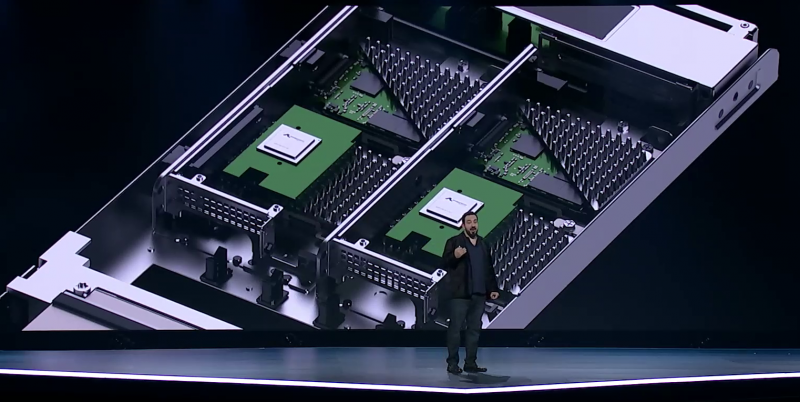

Intel анонсировала ИИ-ускорители Habana Gaudi2 и GrecoНа мероприятии Intel Vision было анонсировано второе поколение ИИ-ускорителей Habana: Gaudi2 для задач глубокого обучения и Greco для инференс-систем. Оба чипа теперь производятся с использованием 7-нм, а не 16-нм техпроцесса, но это далеко не единственное улучшение. Gaudi2 выпускается в форм-факторе OAM и имеет TDP 600 Вт. Это почти вдвое больше 350 Вт, которые были у Gaudi, но второе поколение чипов значительно отличается от первого. Так, объём набортной памяти увеличился втрое, т.е. до 96 Гбайт, и теперь это HBM2e, так что в итоге и пропускная способность выросла с 1 до 2,45 Тбайт/с. Объём SRAM вырос вдвое, до 48 Мбайт. Дополняют память DMA-движки, способные преобразовывать данные в нужную форму на лету. В Gaudi2 имеется два основных типа вычислительных блоков: Matrix Multiplication Engine (MME) и Tensor Processor Core (TPC). MME, как видно из названия, предназначен для ускорения перемножения матриц. TPC же являются программируемыми VLIW-блоками для работы с SIMD-операциями. TPC поддерживают все популярные форматы данных: FP32, BF16, FP16, FP8, а также INT32, INT16 и INT8. Есть и аппаратные декодеры HEVC, H.264, VP9 и JPEG. Особенностью Gaudi2 является возможность параллельной работы MME и TPC. Это, по словам создателей, значительно ускоряет процесс обучения моделей. Фирменное ПО SynapseAI поддерживает интеграцию с TensorFlow и PyTorch, а также предлагает инструменты для переноса и оптимизации готовых моделей и разработки новых, SDK для TPC, утилиты для мониторинга и оркестрации и т.д. Впрочем, до богатства программной экосистемы как у той же NVIDIA пока далеко. Интерфейсная часть новинок включает PCIe 4.0 x16 и сразу 24 (ранее было только 10) 100GbE-каналов с RDMA ROcE v2, которые используются для связи ускорителей между собой как в пределах одного узла (по 3 канала каждый-с-каждым), так и между узлами. Intel предлагает плату HLBA-225 (OCP UBB) с восемью Gaudi2 на борту и готовую ИИ-платформу, всё так же на базе серверов Supermicro X12, но уже с новыми платами, и СХД DDN AI400X2. Наконец, самое интересное — сравнение производительности. В ряде популярных нагрузок новинка оказывается быстрее NVIDIA A100 (80 Гбайт) в 1,7–2,8 раз. На первый взгляд результат впечатляющий. Однако A100 далеко не новы. Более того, в III квартале этого года ожидается выход ускорителей H100, которые, по словам NVIDIA, будут в среднем от трёх до шести раз быстрее A100, а благодаря новым функциям прирост в скорости обучения может быть и девятикратным. Ну и в целом H100 являются более универсальными решениями. Gaudi2 уже доступны клиентам Habana, а несколько тысяч ускорителей используются самой Intel для дальнейшей оптимизации ПО и разработки чипов Gaudi3. Greco будут доступны во втором полугодии, а их массовое производство намечено на I квартал 2023 года, так что информации о них пока немного. Например, сообщается, что ускорители стали намного менее прожорливыми по сравнению с Goya и снизили TDP с 200 до 75 Вт. Это позволило упаковать их в стандартную HHHL-карту расширения с интерфейсом PCIe 4.0 x8. Объём набортной памяти всё так же равен 16 Гбайт, но переход от DDR4 к LPDDR5 позволил впятеро повысить пропускную способность — с 40 до 204 Гбайт/с. Зато у самого чипа теперь 128 Мбайт SRAM, а не 40 как у Goya. Он поддерживает форматы BF16, FP16, (U)INT8 и (U)INT4. На борту имеются кодеки HEVC, H.264, JPEG и P-JPEG. Для работы с Greco предлагается тот же стек SynapseAI. Сравнения производительности новинки с другими инференс-решениями компания не предоставила.  Впрочем, оба решения Habana выглядят несколько запоздалыми. В отставании на ИИ-фронте, вероятно, отчасти «виновата» неудачная ставка на решения Nervana — на смену так и не вышедшим ускорителям NNP-T для обучения пришли как раз решения Habana, да и новых инференс-чипов NNP-I ждать не стоит. Тем не менее, судьба Habana даже внутри Intel не выглядит безоблачной, поскольку её решениям придётся конкурировать с серверными ускорителями Xe, а в случае инференс-систем даже с Xeon.

02.05.2022 [01:08], Владимир Мироненко

AWS представила инстансы I4i с Intel Xeon Ice Lake-SP и NVMe-накопителями Nitro SSD собственной разработкиAWS представила инстансы I4i со сверхбыстрым хранилищем. Новинки используют Intel Xeon Ice Lake-SP и NVMe-накопители Nitro SSD, разработанные самой Amazon. I4i обеспечивают снижение задержки операций ввода-вывода до 60 % (разброс тоже ниже на 75 %) по сравнению с инстансами I3, а также до 30 % лучшее соотношение цены и производительности. Благодаря использованию сразу нескольких компонентов Nitro, все физические ресурсы узлов доступны инстансам практически полностью. I4i «предназначены для минимизации задержки и максимизации количества транзакций в секунду (TPS) для рабочих нагрузок, которым требуется очень быстрый доступ к наборам данных среднего размера в локальном хранилище. Сюда входят транзакционные базы данных, такие как MySQL, Oracle DB и Microsoft SQL Server, а также базы данных NoSQL: MongoDB, Couchbase, Aerospike, Redis и т.д.». Они также подходят для рабочих нагрузок, требующих высокую производительность вычислений в пересчёте на Тбайт хранилища, таких как аналитика данных и поисковые системы.

Узлы с Nitro SSD (Изображение: AWS) У всех новинок частота всех ядер в турборежиме составляет 3,5 ГГц; есть поддержка AVX-512 и Intel Total Memory Encryption. Для особо ресурсоёмких задач предлагается инстанс I4i.32xlarge: 128 vCPU, 1 Тбайт RAM (с NUMA), сетевое подключение 75 Гбит/с, 40-Гбит/с доступ к EBS-томам и восемь локальных Nitro SSD суммарной ёмкостью 30 Тбайт. Nitro SSD имеют продвинутую прошивку, отвечающую за реализацию многих функций, включая телеметрию и диагностику на лету, а также управление хранилищем на уровне инстанса для повышения надёжности и обеспечения стабильного уровня производительности. Инстансы I4i уже доступны в регионах AWS US East (Северная Виргиния), US East (Огайо), US West (Орегон) и Европа (Ирландия) по запросу и в качестве спотовых и зарезервированных. Доступны планы Savings, а также выделенные инстансы и выделенные хосты. Клиентам рекомендуется использовать последние AMI, включающие текущие драйверы ENA и поддержку NVMe 1.4.

03.03.2022 [19:00], Алексей Степин

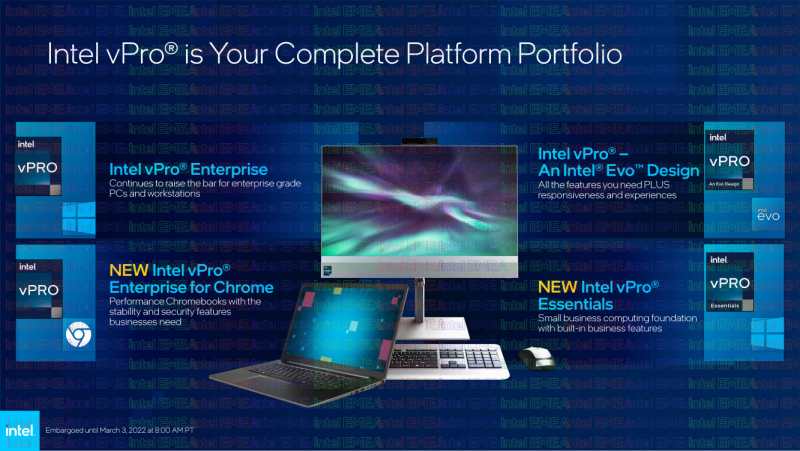

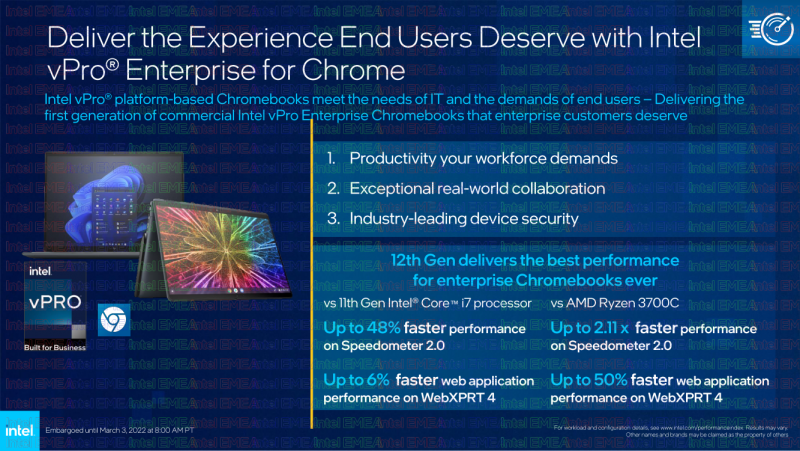

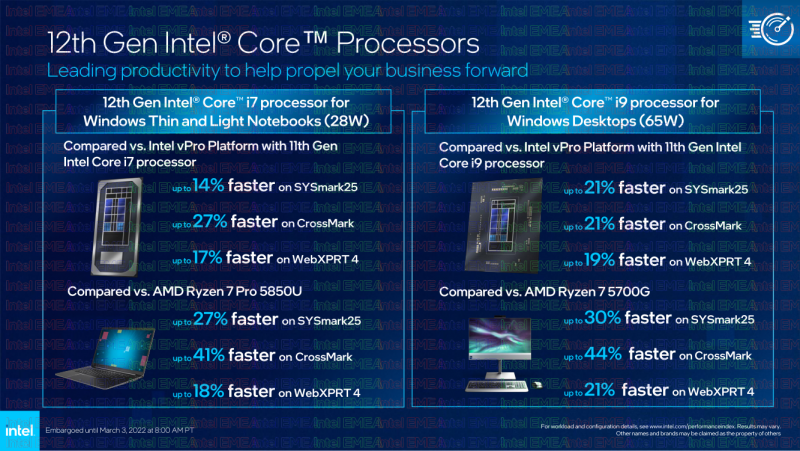

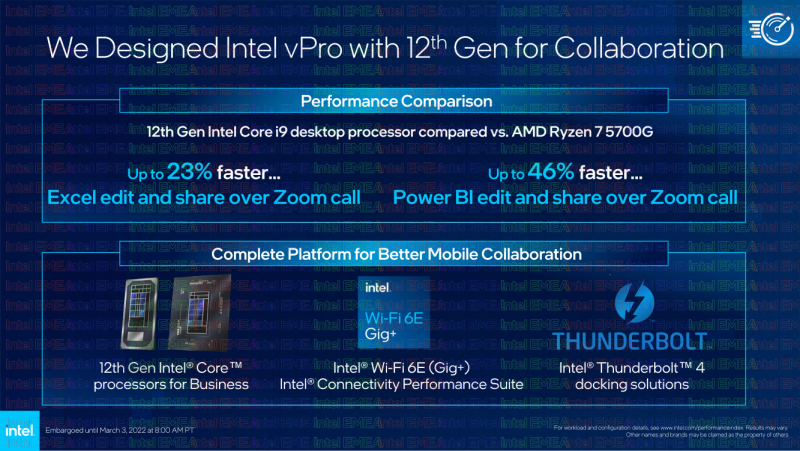

Intel анонсировала новую версию платформы vPro, в том числе для ChromeOSВместе с расширением двенадцатого поколения процессоров Core (Alder Lake) компания Intel представила и новую версию бизнес-платформы vPro, обеспечивающую улучшенные возможности в области удалённого управления и информационной безопасности. Сама платформа vPro насчитывает уже более 15 лет, но сегодня некогда достаточно простой набор технологий разросся до полноценного портфолио, покрывающего потребности бизнес-клиентов в любых масштабах. Обновлённое портфолио включает следующие разновидности Intel vPro:

В рамках новой версии vPro, по словам Intel, представлен полный спектр систем и решений, подходящий для любой задачи любой компании любого размера. Помимо всех тех особенностей, что предлагает архитектура Alder Lake (два вида ядер, DDR5 и т.д.), платформа vPro также включает ряд других программных и аппаратных компонентов:

На момент анонса партнёрами Intel представлено более 150 различных дизайнов вычислительных платформ, во всех форм-факторах. Все они должны быть доступны уже в этом году. Не забыта и сфера IoT, где процессоры Intel двенадцатого поколения в сочетании с vPro обеспечат высокую производительность и удобство удалённого управления. Новинки этого типа отлично впишутся в современную розничную торговлю, образование медицину, производственные и банковские процессы, экосистемы «умных городов» и т.д. С точки зрения Cisco, одного из крупнейших производителей сетевого оборудования, в новой платформе очень важна поддержка Wi-Fi 6E, не просто обеспечивающая настоящий «гигабит по воздуху», но и позволяющая без проблем подключать больше беспроводных устройств к точкам доступа, большую надёжность, и предсказуемость поведения Wi-Fi в сценариях класса mission critical. Компания считает очень удачным сочетание систем Intel с поддержкой Wi-Fi 6E c новыми точками доступа Cisco Catalyst и Meraki.

24.02.2022 [19:00], Алексей Степин

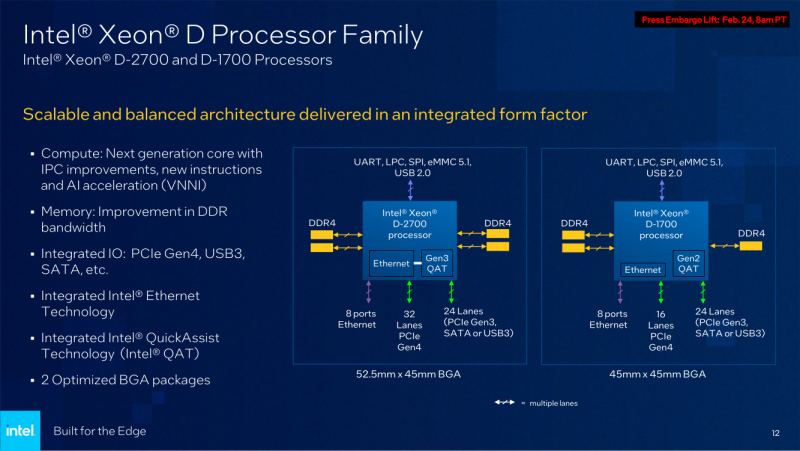

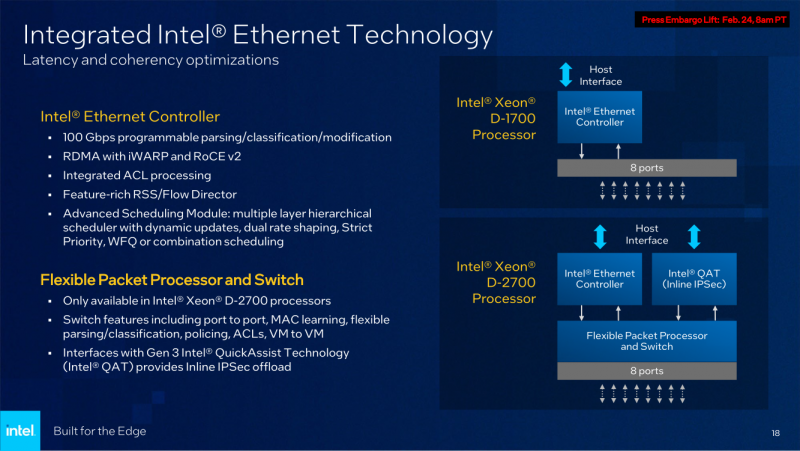

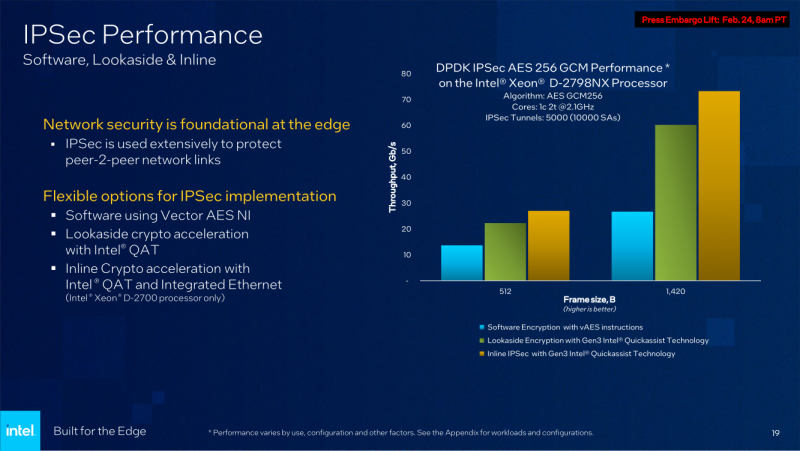

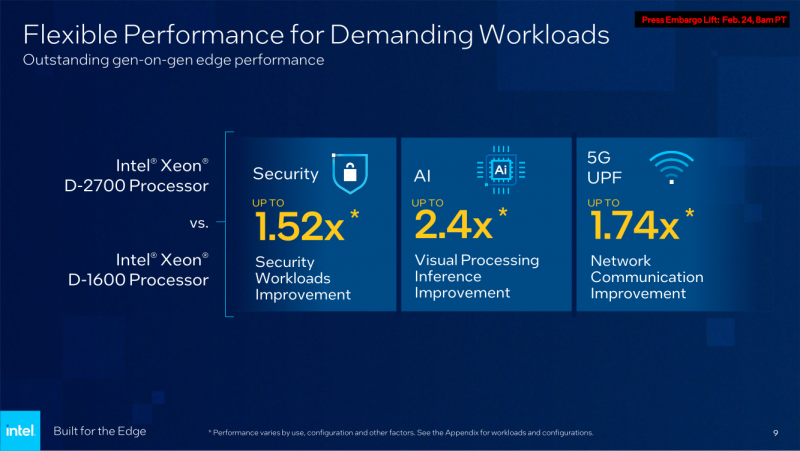

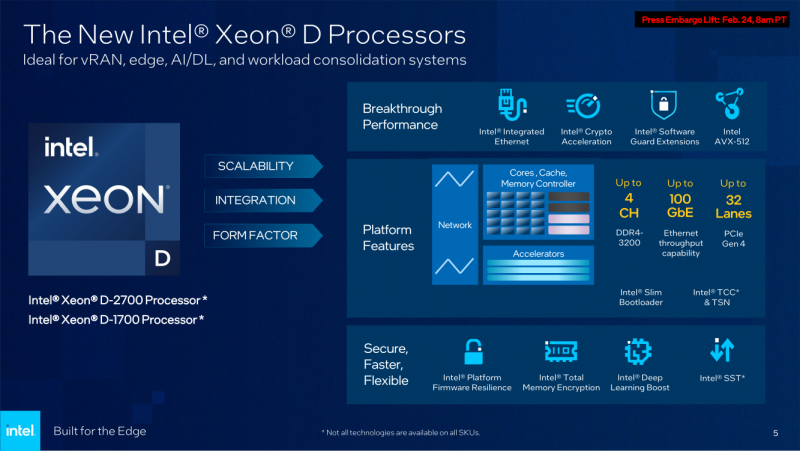

Intel анонсировала процессоры Xeon D-1700 и D-2700: Ice Lake-SP + 100GbEКонцепция периферийных вычислений сравнительно молода и до недавнего времени зачастую её реализации были вынуждены обходиться стандартными процессорами, разработанными для применения в серверах, или даже в обычных ПК и ноутбуках. Intel, достаточно давно имеющая в своём арсенале серию процессоров Xeon D, обновила модельный ряд этих CPU, которые теперь специально предназначены для использования на периферии. Анонс выглядит очень своевременно, поскольку по оценкам Intel, к 2025 году более 50% всех данных будет обрабатываться вне традиционных ЦОД. Новые серии процессоров Xeon D-1700 и D-2700 обладают рядом свойств, востребованных именно на периферии — особенно на периферии нового поколения. Новинки имеют следующие особенности:

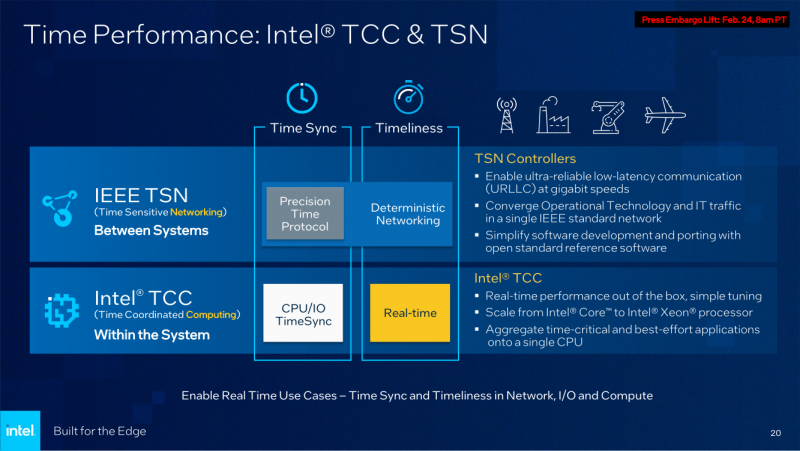

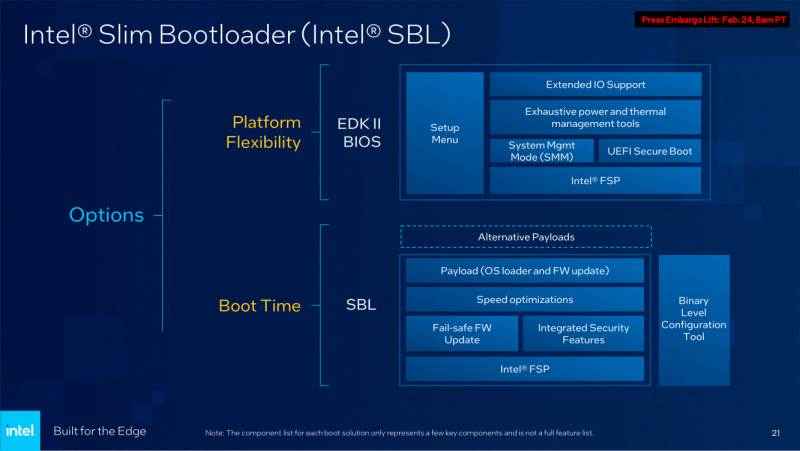

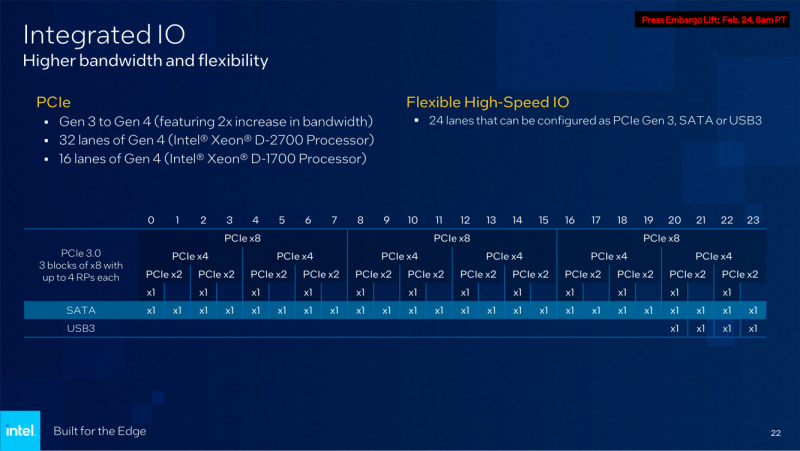

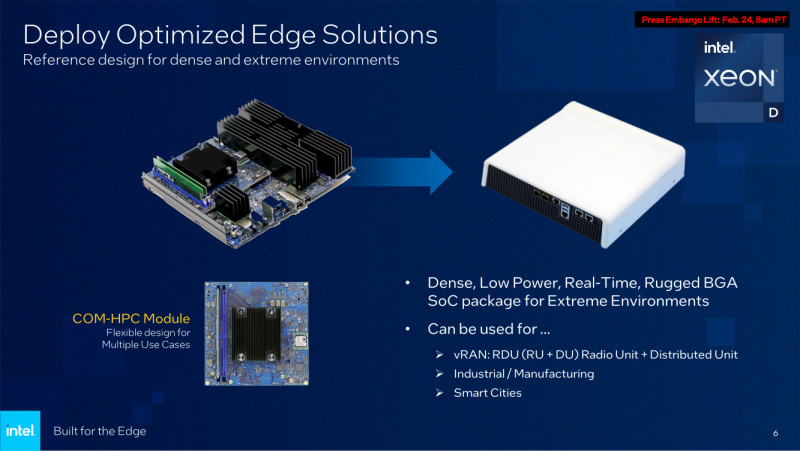

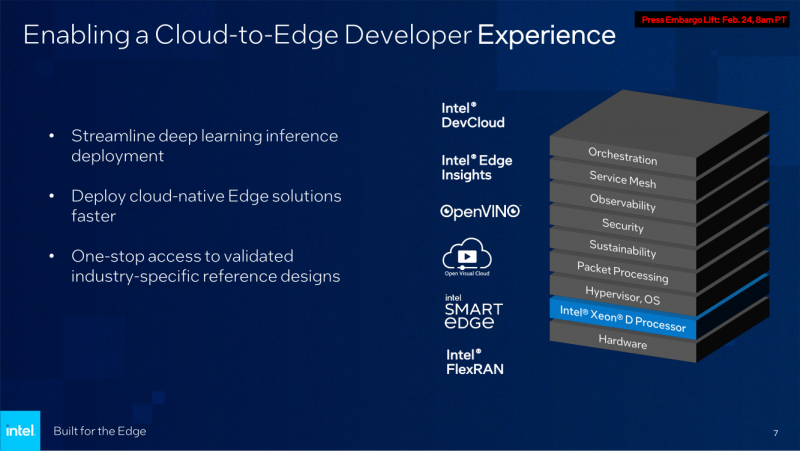

Последний пункт ранее был реализован в процессорах серий Atom x6000E, Xeon W-1100E и некоторых процессорах Core 11-го поколения. Вкратце это технология, позволяющая координировать вычисления с точностью менее 200 мкс в режиме TCC за счёт точной синхронизации таймингов внутри платформы. И здесь у Xeon D, как у высокоинтегрированной SoC, есть преимущество в реализации подобного класса точности. Помогает этому и наличие специального планировщика для общего кеша L3, позволяющего добиться более консистентного доступа к кешу и памяти. Это незаменимая возможность для систем, обслуживающих сверхточные промышленные процессы, тем более что Intel предлагает хорошо документированный набор API и средств разработки для извлечения из режима TCC всех возможностей. Важной также выглядит наличие поддержки пакета технологий Intel QuickAssist (QAT) для ускорения задач (де-)шифрования и (де-)компрессии. Третье поколение QAT, доступное, правда, только в Xeon D-2700, в отличие от второго (и это случай D-1700), связано в новых SoC непосредственно с контроллером Ethernet и встроенным программируемым коммутатором. В частности, поддерживается, и IPSec-шифрование на лету (inline) на полной скорости, и классификация (QoS) трафика. Также реализована поддержка новых алгоритмов, таких, как Chacha20-Poly1305 и SM3/4, имеется собственный движок для публичных ключей, улучшены алгоритмы компрессии. Но QAT может работать и совместно с CPU (lookaside-разгрузка), а можно и вовсе обойтись без него, воспользовавшись AES-NI. Поддержке безопасности помогает и полноценная поддержка защищённых вычислительных анклавов SGX, существенно ограничивающая векторы атак как со стороны ОС и программного обеспечения, так и со стороны гипервизора виртуальных машин. Это важно, поскольку на периферии уровень угрозы обычно выше, чем в контролируемом окружении в ЦОД, но для использования SGX требуется модификация ПО. В целом, «ядерная» часть новых Xeon-D — это всё та же архитектура Ice Lake-SP. Так что Intel в очередной раз напомнила про поддержку DL Boost/VNNI для работы с форматами пониженной точности и возможности эффективного выполнения инференс-нагрузок — новинки почти в 2,5 раза превосходят Xeon D-1600. Есть и прочие стандартные для платформы функции вроде PFR или SST. Из важных дополнений можно отметить поддержку Intel Slim BootLoader. Масштабируемость у новой платформы простирается от 2 до 10 (D-1700) или 20 (D-2700) ядер, а TDP составляет 25–90 и 65–129 Вт соответственно. В зависимости от модели поддерживается работа в расширенном диапазоне температур (до -40 °C). У обоих вариантов упаковка BGA, но с чуть отличными размерами — 45 × 45 мм против 45 × 52,5 мм. На этом различия не заканчиваются. У младших Xeon D-1700 поддержка памяти ограничена тремя каналами DDR4-2933, а вот у D-2700 четыре полноценных канала DDR4-3200. Однако возможности работы с Optane PMem обе модели лишены, несмотря на то, что контроллер памяти их поддерживать должен. Представитель Intel отметил, что если будет спрос со стороны заказчиков, то возможен выпуск вариантов CPU с поддержкой PMem. Дело в том, что прошлые поколения Xeon-D использовались и для создания СХД, а наличие 100GbE-контроллера с RDMA делает новинки не менее интересными для этого сегмента. Кроме того, есть и поддержка NTB, да и VROC с VMD вряд ли исчезли. Для подключения периферии у D-2700 доступно 32 линии PCIe 4.0, а у D-1700 — 16. У обоих серий CPU также есть 24 линии HSIO, которые на усмотрение производителя можно использовать для PCIe 3.0, SATA или USB 3.0. Впрочем, пока Intel предлагает использовать всё это разнообразие интерфейсов для подключения ускорителей и различных адаптеров. Поскольку в качестве одной из основных задач для новых процессоров компания видит их работу в качестве контроллеров программно-определяемых сетей, включая 5G, она разработала для этой цели референсную платформу. В ней предусматривается отдельный модуль COM-HPC с процессором и DIMM-модулями, что позволяет легко модернизировать систему. А базовая плата предусматривает наличие радиотрансиверов, что актуально для сценария vRAN. Поскольку речь идёт не столько о процессорах, сколько о полноценной платформе, Intel серьезное внимание уделила программной поддержке, причём, в основе лежат решения с открытым программным кодом. Это позволит заказчикам систем на базе новых Xeon D разворачивать новые точки и комплексы периферийных вычислений быстрее и проще. Многие производители серверного аппаратного обеспечения уже готовы представить свои решения на базе Xeon D-1700 и 2700.

08.02.2022 [00:30], Владимир Мироненко

Ventana, разработчик серверных процессоров RISC-V, объявил о стратегическом партнёрстве с IntelСтартап Ventana Micro Systems Inc., разработчик высокопроизводительных серверных процессоров на базе архитектуры RISC-V, объявил о стратегическом партнёрстве с Intel — ядра и чиплеты Ventana будут доступны в рамках Intel Foundry Services (IFS) для крупных клиентов ЦОД, операторов сетей 5G, потребителей в областях ИИ и машинного обучения, автомобильной индустрии и т. д. Ventana разрабатывает серверные CPU с расширяемыми возможностями, поставляемые в виде SoC с чиплетной компоновкой или IP-блоков. Процессоры предназначены для обеспечения лучшей в своём классе однопоточной производительности и могут быть оптимизированы для высокопроизводительных и облачных вычислений, ЦОД-нагрузок, 5G и периферийных вычислений, выполнения задач ИИ и машинного обучения, автомобильных и клиентских приложений.

Источник изображения: ventanamicro.com Модульная и масштабируемая продуктовая стратегия Ventana, основанная на использовании чиплетов, позволяет обеспечить быстрое коммерческое внедрение со значительной экономией времени и стоимости разработки по сравнению с преобладающими на рынке IP-моделями. Собственные ядра CPU компания намерена выпускать на TSMC по 5-нм нормам, но для остальных блоков могут использоваться сторонние производства. В рамках партнёрства с Intel ядра Ventana можно будет интегрировать в SoC конечных заказчиков. Кроме того, Ventana планирует предложить масштабируемую вычислительную платформу, которая позволит гиперскейлерам и крупным OEM-производителям гибко подбирать и настраивать функциональные блоки у заказываемых чипов, значительно сокращая время и стоимость разработки. Боб Бреннан (Bob Brennan), вице-президент Intel Foundry Services по разработке клиентских решений отметил, что у Ventana «самая совершенная и хорошо разработанная платформа» на базе Open Chiplet, которая полностью соответствует видению Intel. По его словам, чиплеты Ventana позволят IFS предоставлять модульные решения, повышающие производительность, снижающие энергопотребление и затраты на разработку, и ускоряющие время выхода продуктов на рынок.

29.10.2021 [02:28], Игорь Осколков

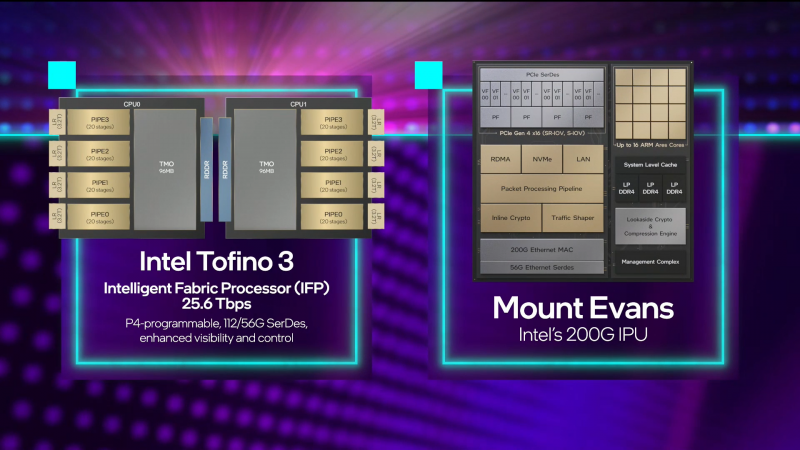

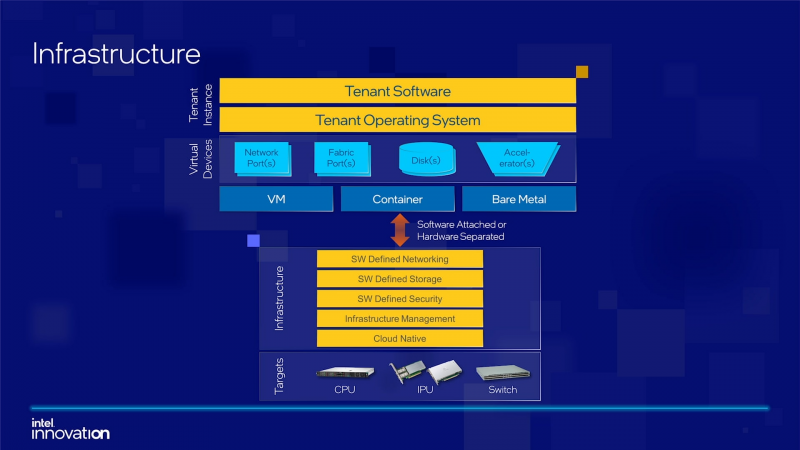

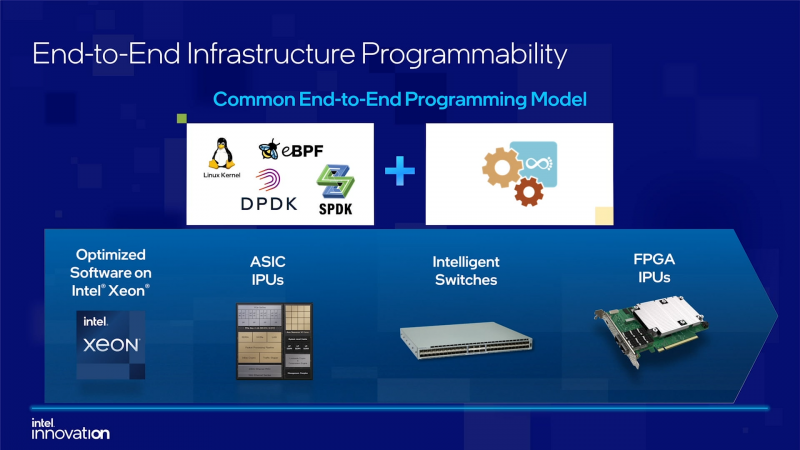

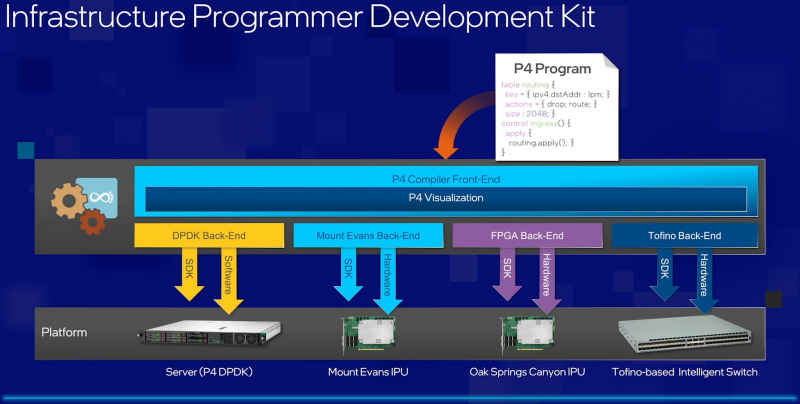

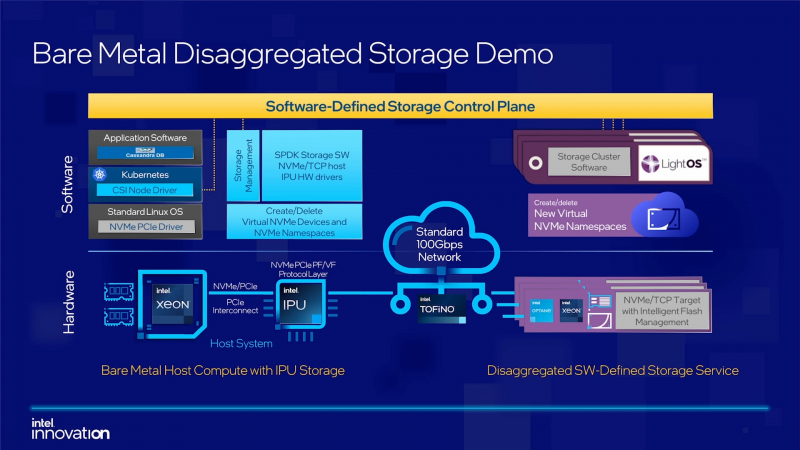

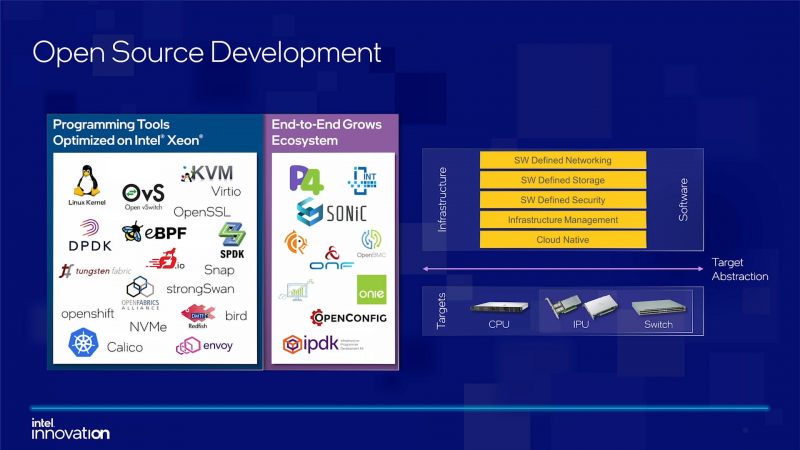

Intel объявила о совместной работе с Google над IPU Mount Evans и анонсировала IPDKIntel в рамках мероприятия Innovation раскрыла имя партнёра по разработке IPU Mount Evans — им оказалась компания Google. Впрочем, это не означает, что новинки будут доступны только ей и окажутся оптимизированы только под её задачи. IPU хоть и ориентированы в первую очередь на гиперскейлеров (среди возможных заказчиков называют и Facebook✴), но, по мнению Intel, будут интересны и менее крупным игрокам. Более того, было, наконец, прямо сказано, что ведётся работа и над Project Monterey от VMware. Как пояснил Гвидо Аппенцеллер (Guido Appenzeller), технический директор подразделения Data Platforms Group Intel, название IPU (Infrastructure Processing Unit) было выбрано в противовес всё ещё относительно новому, но более привычному термину DPU (Data Processing Unit) именно потому, что IPU охватывает более широкий спектр задач по работе именно с инфраструктурой, а не только c данными. Справедливости ради отметим, что и сами DPU, поначалу чаще ориентированные именно на ускорение работы с СХД и устранению узких мест в передаче данных, уже расширили свою функциональность и практически являются IPU именно в терминологии Intel — этот класс сопроцессоров независим от хост-системы и занимается обслуживанием инфраструктуры, включая работу с сетью и хранилищем, изоляцию и телеметрию, управление нагрузками и т.д. У Intel достаточно богатый опыт работы по сетевому направлению с гиперскейлерами. По словам Аппенцеллера, семь из восьми крупнейших компаний этого класса используют решения Intel во всей или хотя бы в некоторых частях своей инфраструктуры. Так, Microsoft, Baidu и JD полагаются на SmartNIC на базе FPGA. Партнёрство же с Google будет выгодно для обеих компаний. Intel получит заказы, а Google, наконец, обретёт то, что давно есть у Amazon — аналог Nitro. На масштабе в миллионы серверов это очень важно. Однако IPU (как аппаратные устройства) — только часть общей картины. Для полноты не хватает как минимум ещё двух компонентов: программного стека и сопутствующей инфраструктуру. Tofino-3 — анонсированный ранее чип или, как его называет сама Intel, Intelligent Fabric Processor — не только поддерживает коммутацию на скорости 25,6 Тбит/с с параллельным сбором телеметрии, но и является полностью P4-программируемым. А это позволяет организовать сквозные мониторинг, управление и оптимизацию трафика для конкретных задач. Или, иными словам, IPU и подходящие коммутаторы позволяют сделать всю инфраструктуру практически полностью программно определяемой, но с аппаратной разгрузкой части функций и близкой к bare metal итоговой производительностью. Правда, в качестве демо Intel опять же приводит «классические» примеры с СХД и Open vSwitch, а также сценарии глубокого мониторинга производительности и быстрого поиска проблемных мест в сети. Но этим потенциальные возможности не ограничиваются. Более того, со стороны ПО и средств разработки жёсткой привязки именно к «железу» Intel нет. Компания представила open source фреймворк IPDK (Infrastructure Programmer Development Kit) для упрощения переноса и, что важно, оптимизации наиболее тяжёлых или нетривиально реализуемых функций ПО на SmartNIC (с FPGA или иной программируемой логикой), IPU/DPU, коммутаторы или CPU. IPDK дополняет уже имеющиеся решения вроде DPDK, SPDK и т.д. возможностями работы с P4.

08.09.2021 [19:00], Алексей Степин

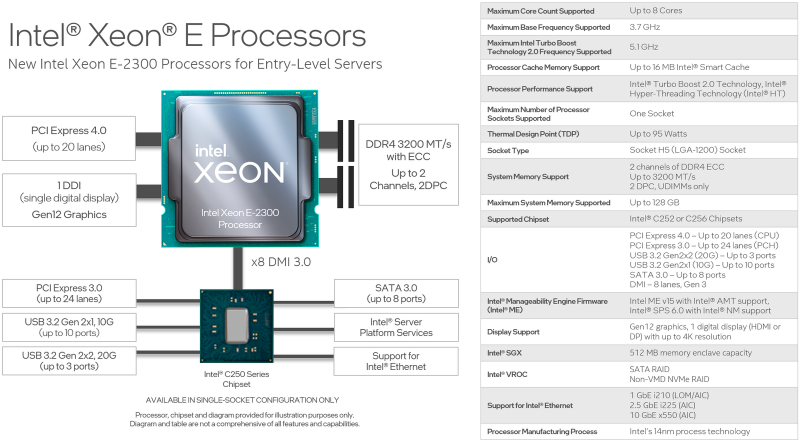

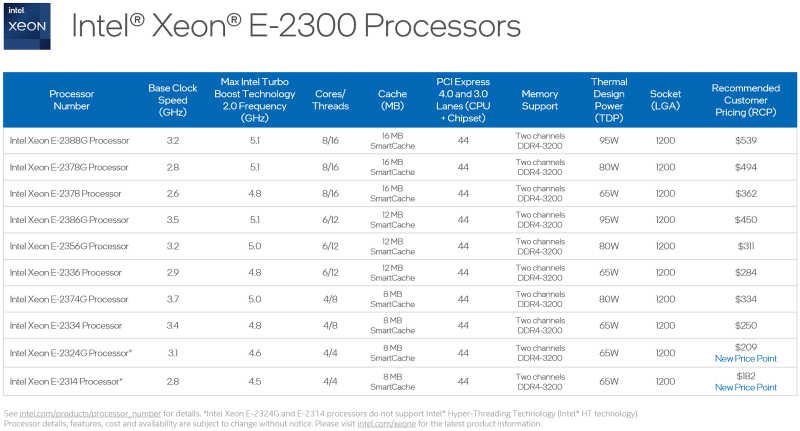

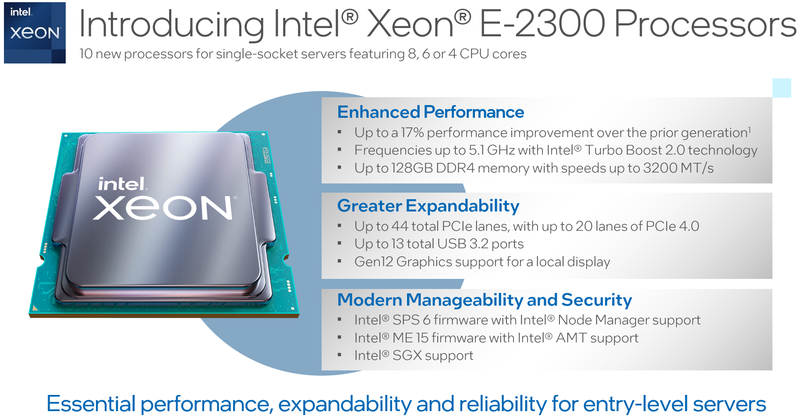

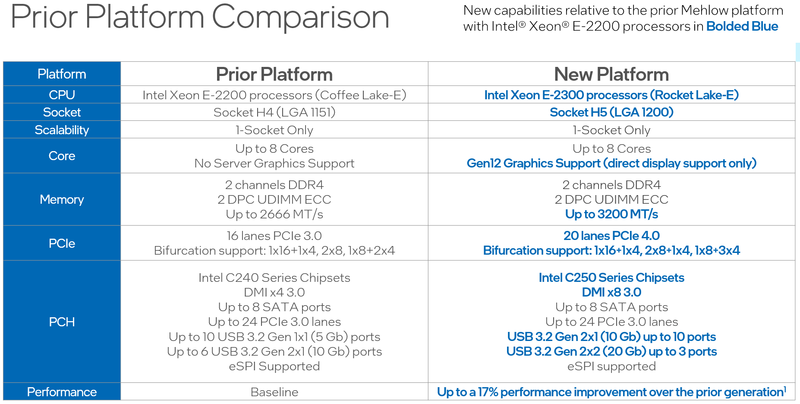

Intel представила процессоры Xeon E-2300: Rocket Lake-E для серверов и рабочих станций начального уровняВ современном мире нагрузки на процессор год от года становятся всё сложнее и объёмнее, и не только крупные ЦОД нуждаются в архитектурных новшествах и новых наборах инструкций — малому бизнесу также требуются чипы нового поколения. Корпорация Intel ответила на это выпуском новых процессоров Xeon серии E-2300 и соответствующей платформы для них. Новинки стали быстрее и получили долгожданную поддержку PCI Express 4.0. Платформа Xeon E-2x00 не обновлялась достаточно давно: процессоры серии E-2200 были представлены ещё в 2019 году. На тот момент это был действительно прорыв в сегменте чипов Intel начального уровня — они впервые получили до 8 ядер Coffee Lake-S, а поддерживаемый объём памяти вырос с 64 до 128 Гбайт. Однако на сегодня таких возможностей уже может оказаться недостаточно: у E-2200 нет AVX-512 с VNNI, шина PCIe ограничена версией 3.0, а графическое ядро HD Graphics P630 и по меркам 2019 года быстрым назвать было нельзя.

Источник изображений: Intel 10 новых процессоров Xeon E-2300, анонсированных Intel сегодня, должны заполнить пустующую нишу младших бизнес-решений. Нововведений в новой платформе не так уж мало, как может показаться на первый взгляд, ведь максимальное количество процессорных ядер у Xeon E-2300 по-прежнему восемь. Однако их максимальная частота выросла до 5,1 ГГц. Изменился процессорный разъём, теперь это LGA1200.  Ядра 11-го поколения Rocket Lake-E (Cypress Cove) по-прежнему используют 14-нм техпроцесс, но оптимизированная микроархитектура позволила Xeon E-2300 быть быстрее соответствующих моделей предыдущего поколения на 17%, и это без учёта качественных нововведений — теперь у них есть AVX-512 с поддержкой инструкций VNNI, ускоряющих работу нейросетей. Нововведения касаются и вопросов информационной безопасности, в которой малый бизнес нуждается не меньше крупного. Как и «большие» Xeon на базе Ice Lake-SP, процессоры Xeon E-2300 получили «взрослую» поддержку защищённых анклавов SGX объёмом до 512 Мбайт, что существенно выше максимально доступных для прошлого поколения Xeon E 64 Мбайт. Максимальный объём памяти остался прежним, но скорость подросла — до 128 Гбайт DDR4-3200 ECC UDIMM в двух каналах (2DPC). Весьма важно также появление нового графического ядра с архитектурой Xe-LP. Конечно, высокой 3D-производительности от него ждать не стоит, но даже в этом оно на шаг впереди устаревшей архитектуры. К этому стоит добавить поддержку HDMI 2.0b и DP 1.4a, аппаратное декодирование 12-бит HEVC и VP9 и 10-бит AV1, а также кодирование в 8-бит AVC и 10-бит HEVC и VP9. Поддержка PCIe 4.0 пришла и на платформу Xeon E — новые процессоры могут предложить 20 линий PCIe 4.0, причём с поддержкой бифуркации. Ещё 24 линии PCIe 3.0 включает чипсет серии C250. В нём же имеется поддержка 8 портов SATA-3 и USB 3.2 Gen 2x2 — до трёх портов со скоростью 20 Гбит/с. Сетевая часть может быть реализована как на базе недорогих чипов i210, так и более производительных i225 (2,5 Гбит/с) или x550 (10 Гбит/с).  В новой серии, как уже было сказано, представлено 10 процессоров, стоимостью от $182 до $539 и теплопакетами от 65 до 95 Вт. Лишь две младшие модели в списке не имеют поддержки Hyper-Threading. Все Xeon E-2300 располагают встроенным движком Manageability Engine 15 и поддержкой Intel Server Platform Services 6, облегчающей развёртывание и удалённое управление. Свои решения на базе новой платформы представят все ведущие производители серверного оборудования.

19.08.2021 [18:04], Алексей Степин

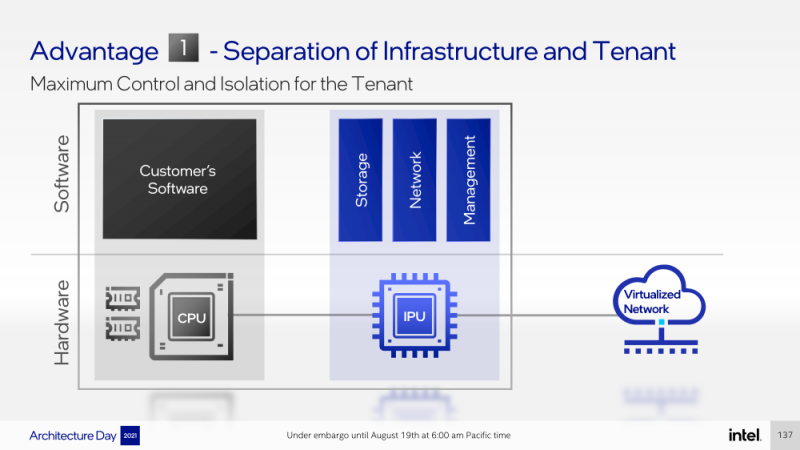

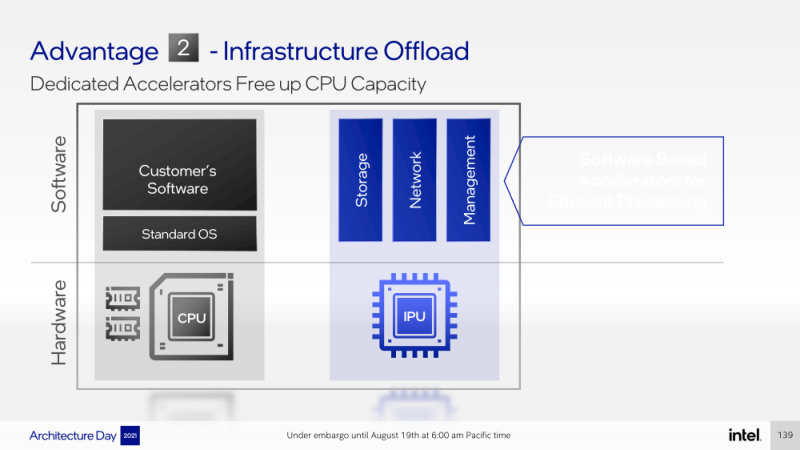

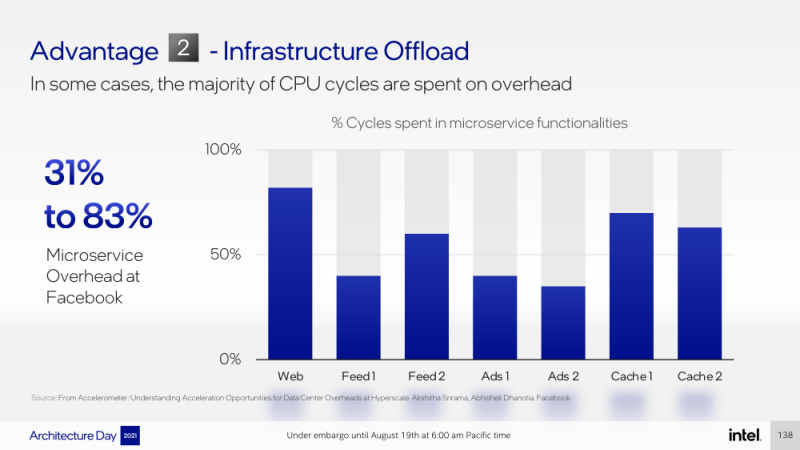

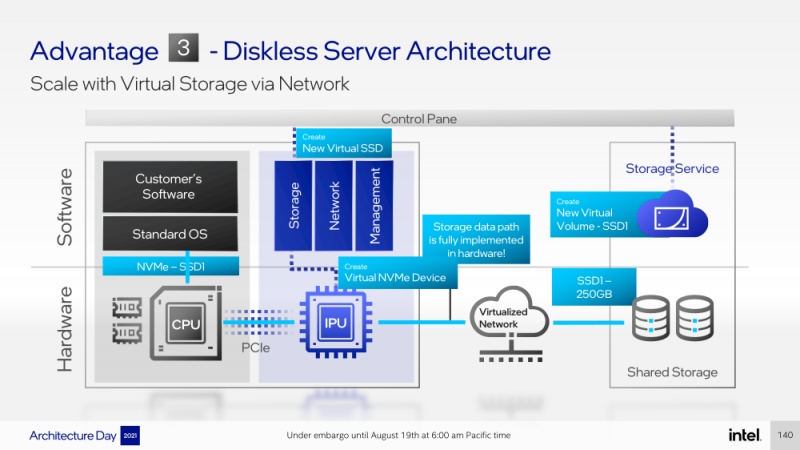

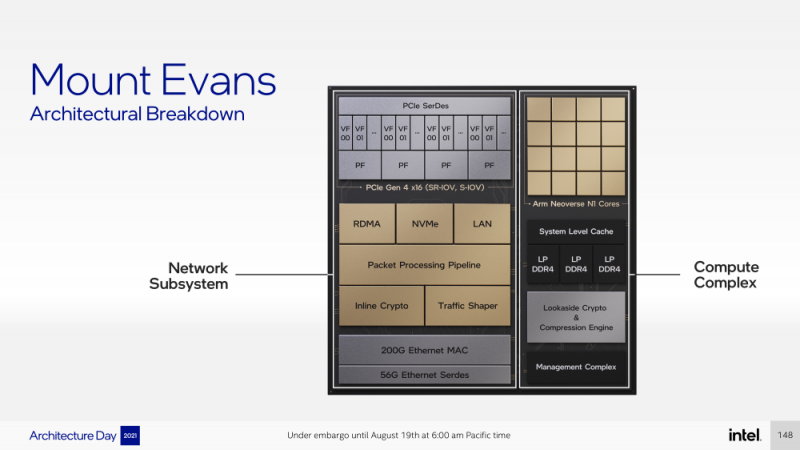

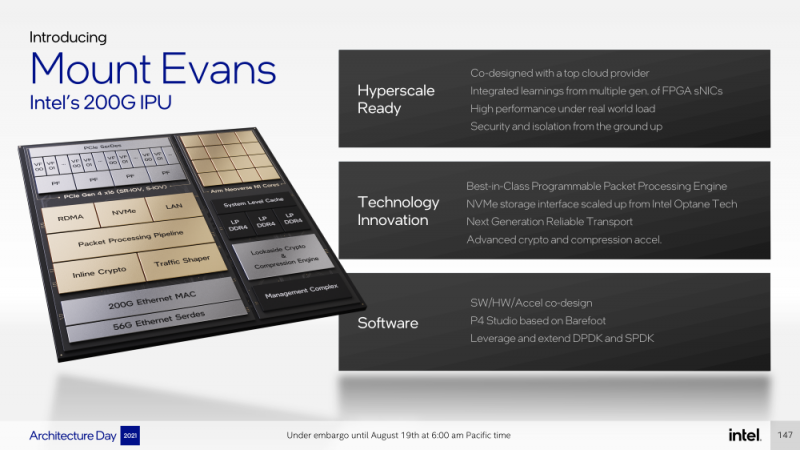

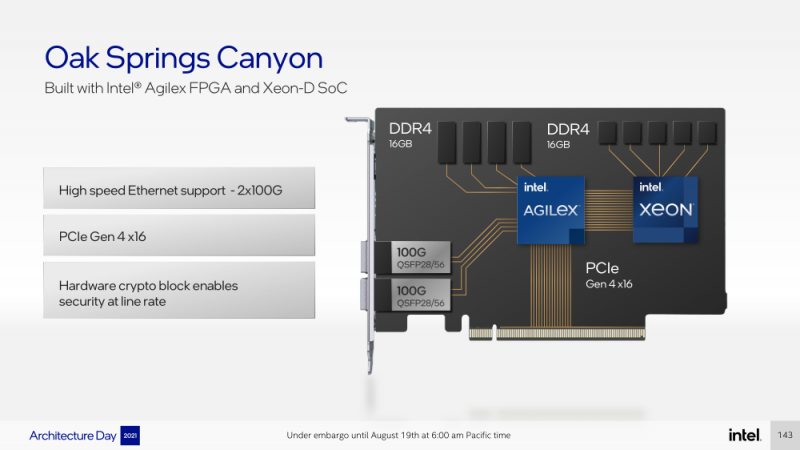

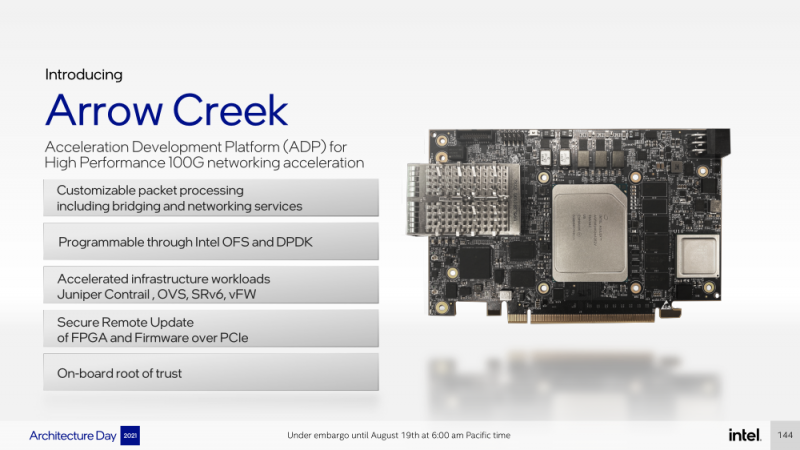

Intel представила IPU Mount Evans и Oak Springs Canyon, а также ODM-платформу N6000 Arrow CreekВесной Intel анонсировала свои первые DPU (Data Processing Unit), которые она предпочитает называть IPU (Infrastructure Processing Unit), утверждая, что такое именования является более корректным. Впрочем, цели у этого класса устройств, как их не называй, одинаковые — перенос части функций CPU по обслуживанию ряда подсистем на выделенные аппаратные блоки и ускорители. Классическая архитектура серверных систем такова, что при работе с сетью, хранилищем, безопасностью значительная часть нагрузки ложится на плечи центральных процессоров. Это далеко не всегда приемлемо — такая нагрузка может отъедать существенную часть ресурсов CPU, которые могли бы быть использованы более рационально, особенно в современных средах с активным использованием виртуализации, контейнеризации и микросервисов. Для решения этой проблемы и были созданы DPU, которые эволюционировали из SmartNIC, бравших на себя «тяжёлые» задачи по обработке трафика и данных. DPU имеют на борту солидный пул вычислительных возможностей, что позволяет на некоторых из них запускать даже гипервизор. Однако Intel IPU имеют свои особенности, отличающие их и от SmartNIC, и от виденных ранее DPU. Новый класс сопроцессоров Intel должен взять на себя все заботы по обслуживанию инфраструктуры во всех её проявлениях, будь то работа с сетью, с подсистемами хранения данных или удалённое управление. При этом и DPU, и IPU в отличие от SmartNIC полностью независим от хост-системы. Полное разделение инфраструктуры и гостевых задач обеспечивает дополнительную прослойку безопасности, поскольку аппаратный Root of Trust включён в IPU. Это не единственное преимущество нового подхода. Компания приводит статистику Facebook✴, из которой видно, что иногда более 50% процессорных тактов серверы тратят на «обслуживание самих себя». Все эти такты могут быть пущены в дело, если за это обслуживание возьмётся IPU. Кроме того, новый класс сетевых ускорителей открывает дорогу к бездисковой серверной инфраструктуре: виртуальные диски создаются и обслуживаются также чипом IPU. Первый чип в новом семействе IPU, получивший имя Mount Evans, создавался в сотрудничестве с крупными облачными провайдерами. Поэтому в нём широко используется кремний специального назначения (ASIC), обеспечивающий, однако, и нужную степень гибкости, За основу взяты ядра общего назначения Arm Neoverse N1 (до 16 шт.), дополненные тремя банками памяти LPDRR4 и различными ускорителями. Сетевая часть представлена 200GbE-интерфейсом с выделенным P4-программируемым движком для обработки сетевых пакетов и управления QoS. Дополняет его выделенный IPSec-движок, способный на лету шифровать весь трафик без потери скорости. Естественно, есть поддержка RDMA (RoCEv2) и разгрузки NVMe-oF, причём отличительной чертой является возможность создавать для хоста виртуальные NVMe-накопители — всё благодаря контроллеру, который был позаимствован у Optane SSD. Дополняют этот комплекс ускорители (де-)компресии и шифрования данных на лету. Они базируются на технологиях Intel QAT и, в частности, предложат поддержку современного алгоритма сжатия Zstandard. Наконец, у IPU будет выделенный блок для независимого внешнего управления. Работать с устройством можно будет посредством привычных SPDK и DPDK. Один IPU Mount Evans может обслуживать до четырёх процессоров. В целом, новинку можно назвать интересной и более доступной альтернативной AWS Nitro. Также Intel представила платформу Oak Springs Canyon с двумя 100GbE-интерфейсами, которая сочетает процессоры Xeon-D и FPGA семейства Agilex. Каждому чипу которых полагается по 16 Гбайт собственной памяти DDR4. Платформа может использоваться для ускорения Open vSwitch и NVMe-oF с поддержкой RDMA/RocE, имеет аппаратные криптодвижки т.д. Наличие FPGA позволяет выполнять специфичные для конкретного заказчика задачи, но вместе с тем совместимость с x86 существенно упрощает разработку ПО для этой платформы. В дополнение к SPDK и DPDK доступны и инструменты OFS. Наконец, компания показала и референсную плаформу для разработчиков Intel N6000 Acceleration Development Platform (Arrow Creek). Она несколько отличается от других IPU и относится скорее к SmartNIC, посколько сочетает FPGA Agilex, CPLD Max10 и сетевые контроллеры Intel Ethernet 800 (2 × 100GbE). Дополняет их аппаратный Root of Trust, а также PTP-блок. Работать с устройством можно также с помощью DPDK и OFS, да и функциональность во многом совпадает с Oak Springs Canyon. Но это всё же платформа для разработки конечных решений ODM-партнёрами Intel, которые могут с её помощью имплементировать какие-то специфические протоколы или функции с ускорением на FPGA, например, SRv6 или Juniper Contrail. IPU могут стать частью высокоинтегрированной ЦОД-платформы Intel, и на этом поле она будет соревноваться в первую очередь с NVIDIA, которая активно продвигает DPU BluefIeld, а вскоре обзаведётся ещё и собственным процессором. Из ближайших интересных анонсов, вероятно, стоит ждать поддержку Project Monterey, о которой уже заявили NVIDIA и Pensando. |

|