Материалы по тегу: i

|

10.05.2025 [10:07], Сергей Карасёв

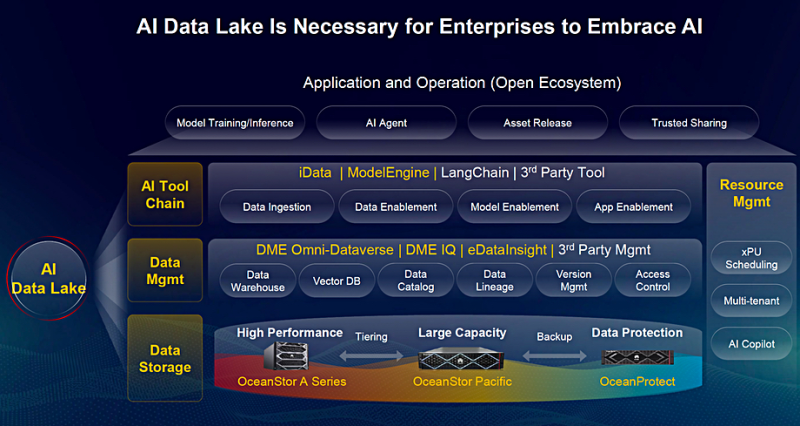

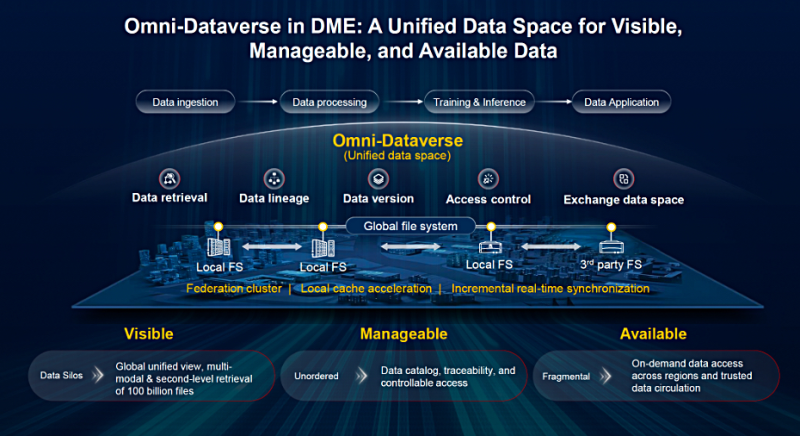

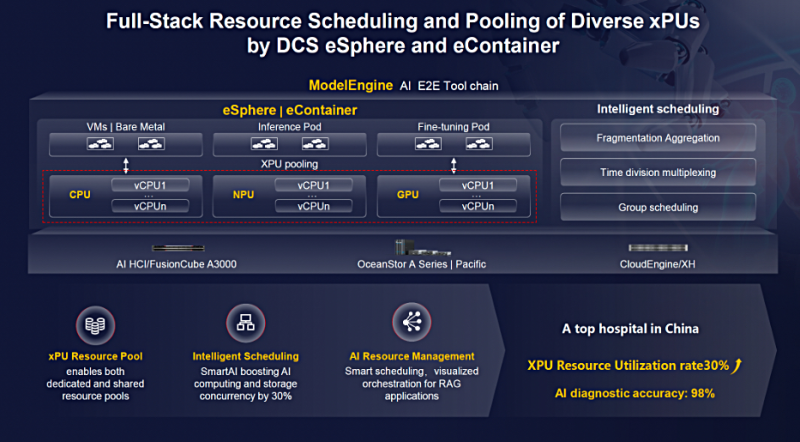

Huawei представила комплексную платформу хранения и обработки ИИ-данныхКомпания Huawei на форуме Innovative Data Infrastructure (IDI) в Мюнхене (Германия) анонсировала решение AI Data Lake для хранения и обработки данных, призванное ускорить внедрение ИИ в различных отраслях. Платформа ориентирована на обучение больших языковых моделей (LLM), инференс и другие нагрузки. Аппаратная составляющая AI Data Lake предполагает использование СХД трёх типов: Huawei OceanStor A Series для быстрого доступа к информации, Huawei OceanStor Pacific для Nearline-хранения с динамическим распределением по уровням и Huawei OceanProtect для резервного копирования из системы Pacific. В частности, OceanProtect E8000 вмещает до 16 Пбайт данных с пропускной способностью до 255 Тбайт/ч. Поверх аппаратного массива работают два программных уровня — слой управления данными и слой инструментов ИИ. Уровень управления базируется на движке Data Management Engine (DME) и включает три продукта: DME Omni-Dataverse, DME IQ и eDataInsight. Они отвечают за такие векторные БД, каталог данных, управление версиями, контроль доступа и пр. Omni-Dataverse — глобальная файловая система и фреймворк управления данными для устранения разрозненности информации в географически распределённых ЦОД: достигается это путём предоставления единого пространства имён. Иными словами, формируется единый виртуальный репозиторий (озеро данных), который охватывает несколько отдельных хранилищ в публичном облаке, на площадке клиента или в гибридной среде. Omni-Dataverse предоставляет средства для получения, индексации, обработки данных и их предоставления для обучения LLM, инференса и других задач. По заявлениям Huawei, система способна индексировать и/или извлекать наборы данных в масштабе экзабайт. Возможна обработка более 100 млрд файлов за считаные секунды с использованием более 15 критериев поиска. Omni-Dataverse поддерживает динамическое распределение данных между СХД OceanStor A Series и OceanStor Pacific. Устаревшие и неиспользуемые файлы удаляются. DME IQ — это облачная система на базе аналитики больших данных и AIOps для автоматизированного оповещения о неполадках и отслеживания проблем в режиме реального времени. В свою очередь, программный уровень ИИ-инструментов предназначен для предоставления наборов данных из хранилища для обработки различными аппаратными движками: Huawei iData, ModelEngine и др. Концепция виртуализации дата-центра DCS (Data Center Solution) объединяет вычисления, хранение, сетевые технологии и управление. Задействованы средства eSphere с использованием Omni-Dataverse для доступа к единому глобальному пространству имен.

09.05.2025 [01:40], Владимир Мироненко

Первая фаза ИИ-кластера xAI Colossus полностью обеспечена энергией1 мая ИИ-кластер xAI Colossus в Мемфисе (Теннесси, США), менее чем через год после запуска проекта, достиг полной готовности для эксплуатации в рамках первой фазы развёртывания, поскольку оборудование подключили к основной энергосети посредством недавно построенной электрической подстанции, сообщается на сайте Торговой палаты Большого Мемфиса. Питание ИИ-кластера в пределах 150 МВт будут обеспечивать энергоснабжающие компании Memphis Light, Gas, and Water (MLGW) и Tennessee Valley Authority (TVA). Кроме того, площадка оборудована аккумуляторными системами Tesla Megapack на 150 МВт (ёмкость явно не указана), предназначенными для использования в качестве резервного источника питания на случай аварийных отключений сети или повышенного спроса, говорится в сообщении. «xAI привержена Мемфису посредством своих устойчивых экологических практик. Компания участвует в программе Demand Response, как указала MLGW, и изучает способы подачи энергии в сеть на благо общества, особенно в чрезвычайных ситуациях или других случаях необходимости. По мере роста xAI будет расти и Мемфис», — отметила Торговая палата Большого Мемфиса. xAI запустила ИИ-кластер xAI Colossus в июле прошлого года. В нём было установлено 100 тыс. ускорителей NVIDIA H100. В связи с тем, что ИИ-кластер был построен в рекордные сроки — всего за 19 дней — на период строительства подстанций для подключения к сетям операторов, для обеспечения его энергией установили временные газовые генераторы, а также энергохранилища Tesla Megapack. Торговая палата сообщила, что примерно половина газовых турбин будет демонтирована в течение двух месяцев. Остальная часть продолжит функционировать до ввода в эксплуатацию второй подстанции на 150 МВт, строительство которой должны закончить осенью 2025 года, после чего газовые турбины переведут в резервную систему электропитания. Таким образом, власти косвенным образом признали, что xAI действительно воспользовалась лазейкой в законах, развернув 35 турбин вместо изначально разрешённых 15. Как сообщает The Register, всего в качестве резерва в дальнейшем будет использоваться 15 газовых турбин: восемь новых, оснащённых системами селективного каталитического восстановления (SCR) для снижения выбросов, и семь модернизированных, которые будут соответствовать существующим требованиям Закона о чистом воздухе США. По словам основателя xAI Илона Маска (Elon Musk), со временем в ИИ-кластере будет развернуто до 1 млн ускорителей. В феврале сообщалось, что xAI рассматривает возможность строительства ещё одного ЦОД.

03.05.2025 [13:50], Сергей Карасёв

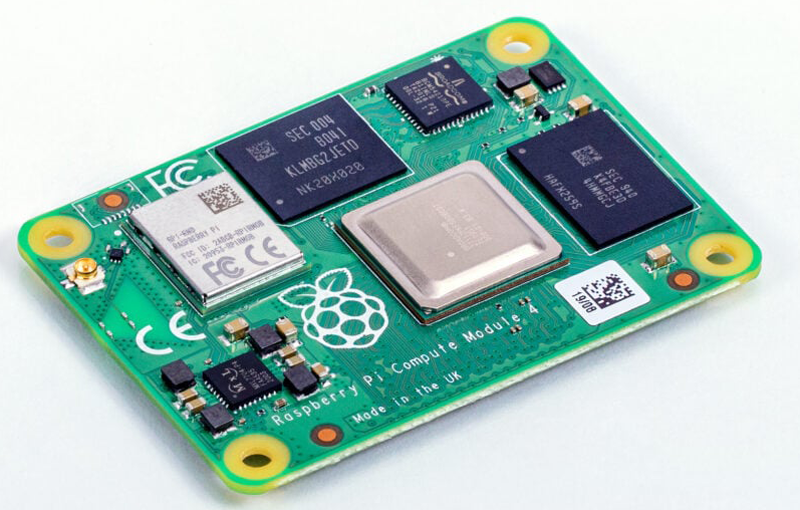

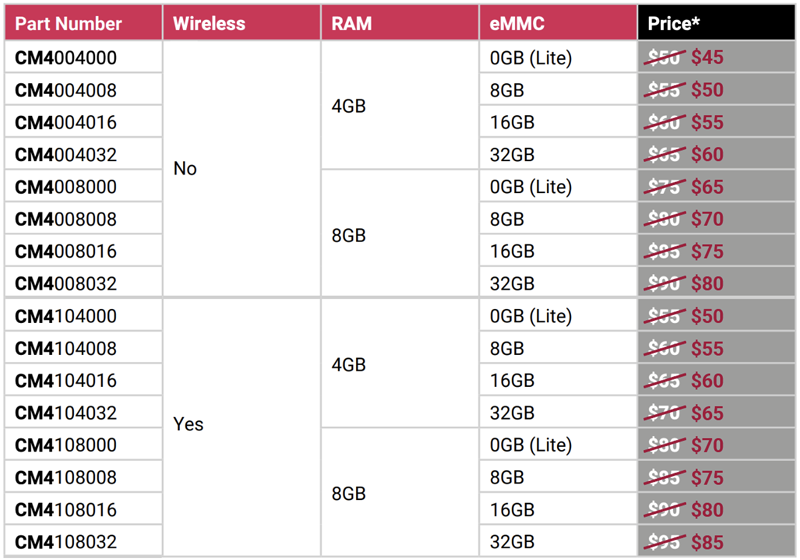

Raspberry Pi снизила цены на CM4: модули подешевели на $5–$10Raspberry Pi объявила о снижении цен на вычислительные модули Compute Module 4 (CM4), которые широко применяются в самых разных устройствах — от медицинского оборудования и средств индустриального мониторинга до игровых ретро-консолей и компактных медиасерверов. В общей сложности подешевели 16 вариантов CM4. Это модели с 4 и 8 Гбайт оперативной памяти LPDDR4-3200 с поддержкой беспроводной связи Wi-Fi 802.11b/g/n/ac и Bluetooth 5.0 (BLE) или без таковой. Снижена стоимость CM4 со всеми вариантами вместимости встроенного накопителя eMMC — 8, 16 и 32 Гбайт, а также без интегрированного флеш-чипа (модификация Lite).

Источник изображений: Raspberry Pi Версии с 4 Гбайт ОЗУ подешевели на $5: теперь их цена варьируется от $45 до $60 без Wi-Fi / Bluetooth и от $50 до $65 с поддержкой беспроводной связи. В случае модулей с 8 Гбайт ОЗУ падение стоимости достигает $10: новые цены составляют соответственно от $65 до $80 и от $70 до $85. Подчёркивается, что удешевление затронуло только модели CM4 со стандартным диапазоном рабочих температур — от -20 до +85 °C. Варианты Extended Temperature с расширенным температурным диапазоном — от -40 до +85 °C — предлагаются по прежним ценам.  Вычислительные модули комплектуются 64-бит SoC Broadcom BCM2711 с четырьмя ядрами Cortex-A72 (ARM v8), работающими на частоте до 1,5 ГГц. Говорится о поддержке H.265 (декодирование материалов в формате до 4Kp60), H.264 (декодирование 1080p60 и кодирование 1080p30), OpenGL ES 3.1, Vulkan 1.0. Производить изделия планируется как минимум до января 2034 года.

02.05.2025 [13:55], Сергей Карасёв

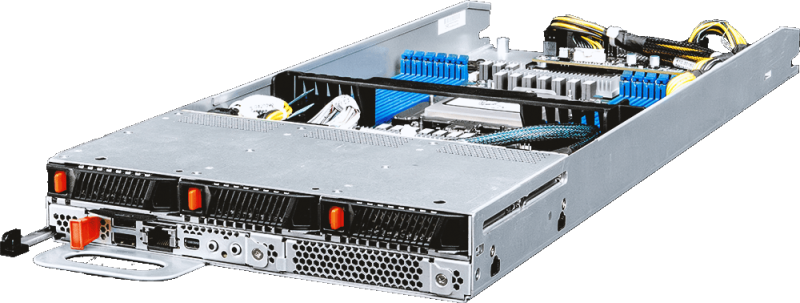

MSI представила многоузловые OCP-серверы на базе AMD EPYC 9005 TurinКомпания MSI анонсировала многоузловые серверы высокой плотности, выполненные в соответствии со стандартом OCP ORv3 (Open Rack v3). Дебютировали модели Open Compute CD281-S4051-X2 и Core Compute CD270-S4051-X4 на аппаратной платформе AMD EPYC 9005 Turin. Решение Open Compute CD281-S4051-X2, выполненное в форм-факторе 2OU, представляет собой двухузловой сервер для инфраструктур гиперскейлеров. Каждый узел может оснащаться одним процессором EPYC 9005 с показателем TDP до 500 Вт и 12 модулями DDR5. Доступны до 12 посадочных мест для накопителей E3.S с интерфейсом PCIe 5.0 (NVMe). Говорится о поддержке CPU-радиаторов Extended Volume Air Cooling (EVAC) и 48-вольтной архитектуры питания ORv3 (48VDC). В свою очередь, Core Compute CD270-S4051-X4 (S4051D270RAU3-X4) — это четырёхузловой сервер стандарта Data Center Modular Hardware Systems (DC-MHS). Устройство имеет типоразмер 2U. Оно подходит для облачных вычислений, CDN-сетей, ИИ-инференса и машинного обучения, виртуализации сетевых функций, телеком-приложений и пр. Каждый узел новинки рассчитан на один чип EPYC 9005 с TDP до 400 Вт. Есть 12 слотов для модулей DDR5-6000 RDIMM/RIMM-3DS суммарным объёмом до 3 Тбайт, три фронтальных отсека для накопителей U.2 с интерфейсом PCIe 5.0 x4 (NVMe), два внутренних коннектора M.2 2280/22110 для SSD с интерфейсом PCIe 3.0 x2 (NVMe), а также слот PCIe 5.0 x16 OCP 3.0. Кроме того, каждый узел располагает контроллером ASPEED AST2600, сетевым портом управления 1GbE, разъёмами USB 2.0 Type-A и Mini DisplayPort, последовательным портом (USB Type-A). Вся система Core Compute CD270-S4051-X4 оборудована двумя блоками питания мощностью 2700 Вт с сертификатом 80 PLUS Titanium. Установлены четыре вентилятора охлаждения с возможностью горячей замены. Диапазон рабочих температур — от 0 до +35 °C. Габариты составляют 448 × 87 × 747 мм.

01.05.2025 [22:55], Руслан Авдеев

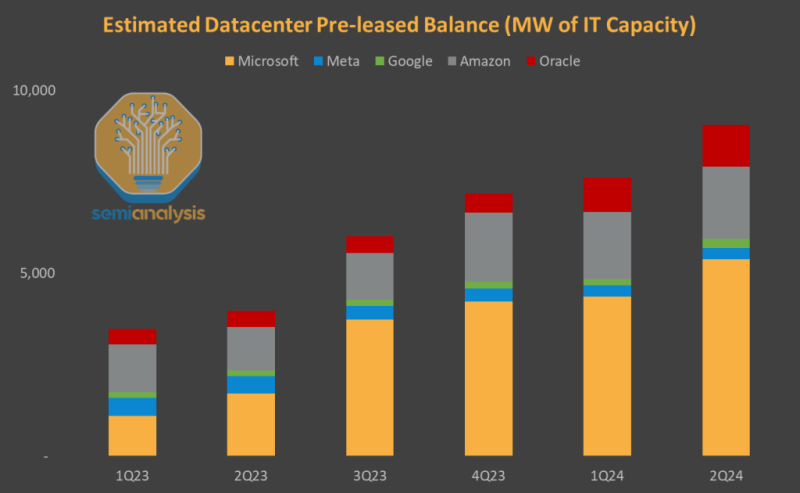

Тысячи гектар земли и гигаватты энергии: Microsoft готовилась к самому масштабному строительству ЦОД за всю свою историю, но затем передумалаВ последние месяцы сразу несколько источников сообщили о резком пересмотре планов Microsoft по аренде ЦОД, что насторожило аналитиков. Компания действительно расторгла несколько контрактов, но история гораздо сложнее, чем кажется, сообщает SemiAnalysis. В прошлом году компания «перестаралась», сумев предварительно застолбить больше мощностей, чем Amazon, Google, Meta✴ и Oracle вместе взятые. Microsoft фактически «заморозила» рынок аренды ЦОД, но в итоге решила существенно скорректировать планы. Так, внимание общественности привлёк отказ от аренды объектов суммарной мощностью 2 ГВт, однако в данном случае речь идёт о необязывающих предварительных соглашениях. По данным SemiAnalysis, в 2023 году и I половине 2024 года Microsoft безраздельно доминировала на рынке аренды и не только «агрессивно» заключала сделки, но и фактически контролировала рынок, резервируя мощности через предварительные соглашения. Microsoft забронировала более 60 % новых мощностей и к июню 2024 года обогнала по этому показателю четырёх других крупных гиперскейлеров вместе взятых. С тех пор компания полностью остановила активности по поиску новых мощностей для аренды. Microsoft успела обсудить аренду чуть ли не с каждым оператором, так что речь идёт об отказе от гораздо больших мощностей, чем 2 ГВт. Что важнее, у Microsoft есть и обязывающие соглашения о предварительной аренде приблизительно 5 ГВт, которые будут введены в строй в 2025–2028 гг. Хотя «замедление» аренды носит существенный характер, оно в кратко- и среднесрочной перспективе не скажется на инфраструктурных проектах, последствия этого шага станут заметны не раньше 2027 года. На этом фоне гораздо важнее заморозка планов Microsoft по строительству собственных дата-центров. Исследования SemiAnalysis показывают, что компания поставила на паузу по всему миру проекты ЦОД на 1,5 ГВт, которые планировалось запустить в 2025–2026 гг. В прошлом году компания занималась покупкой десятков тысяч га земли по всему миру и заключением договоров на поставку гигаватт энергии для будущих объектов. По оценке SemiAnalysis, Microsoft готовилась к самому масштабному строительству инфраструктуры за всю свою историю. Сейчас речь идёт об остановке ряда проектов (хоть и не всех), что обязательно скажется на доступности мощностей в ближайшем будущем. Фактически Microsoft намеренно замедляет свою деятельность в этом направлении. По словам SemiAnalysis, некоторые подготовительные работы на строительных площадках ещё ведутся, но само строительство фактически остановлено, как отложены или отменены новые заказы на охлаждающее и электрическое оборудование. Работы ведутся несопоставимо медленнее, чем в 2023–2024 гг. Несмотря на обещания потратить на инфраструктуру $80 млрд, Microsoft стала менее расточительной и более гибкой. Фактически на рынке неправильно поняли тенденции в поведении Microsoft и их причины. Судя по всему, решения о сокращении последовали за изменениями отношений с OpenAI и слабыми показателями собственных ИИ-разработок. Ранее экспансия основывалась на успехах OpenAI, тесно связанной с Microsoft. OpenAI планировала реализовать масштабные строительные проекты, и в планах по увеличению вычислительной мощности Microsoft играла центральную роль. Но позже OpenAI получила право работать и с другими операторами ЦОД. Ситуация кардинально изменилась в 2025 году, когда закончилось эксклюзивное партнёрство между Microsoft и OpenAI. Последняя перенесла значительные вычислительные мощности на площадки Oracle. Crusoe уже строит дата-центр на 1,2 ГВт для первого кампуса OpenAI Stargate в Техасе. Также OpenAI подписала контракт стоимостью $11,9 млрд сроком на пять лет с CoreWeave и вложила в компанию $350 млн. В будущем CoreWeave будет использоваться и для инференса OpenAI, тогда как ранее право на это принадлежало исключительно Microsoft. По мнению SemiAnalysis, Microsoft столкнулась и с внутренними проблемами. Её собственные ИИ-модели отстают от продуктов конкурентов, а спрос на её корпоративные ИИ-инструменты оказался ниже ожидаемого. Microsoft по-прежнему планирует нарастить мощность ЦОД в 2025–2026 гг., но структура инвестиций меняется. Значительно увеличились затраты на ускорители, а вот строительство новых собственных ЦОД действительно стагнирует или даже слегка идёт на спад. Более того, компания в целом переориентируется на схемы аренды ЦОД, а не их возведения. В целом на мировом рынке значительная часть заранее арендованных дата-центров уже строится. Но и сам рынок меняется — влияние CoreWeave и Oracle растёт, меняя расстановку сил.

29.04.2025 [16:49], Руслан Авдеев

Wi-Fi на аутсорс: абоненты AT&T получат доступ к сети HeliumАмериканский телеком-оператор AT&T подписал соглашение с компанией Helium, которая предоставляет децентрализованную сеть, построенную в соответствии с концепцией DePIN — отдельные граждане и организации могут предоставлять доступ к своим точкам доступа Wi-Fi в обмен на платежи в криптовалютах или другие «поощрения». Сеть Helium включает более 62 тыс. точек доступа в США и Мексике, тогда как AT&T имеет лишь около 20 тыс. точек доступа Wi-Fi в США, сообщает Datacenter Dynamics. В Helium называют такие точки доступа «мини-вышками» и подчёркивают, что её модель представляет собой надёжную, рентабельную альтернативу традиционной беспроводной инфраструктуре. Как заявляют в Helium, работа с AT&T — большой шаг вперёд в обеспечении масс доступным и досягаемым интернет-доступом. Сотрудничество с одним из лидеров мобильной индустрии позволит компании ускорить повсеместное внедрение сетей Helium и обеспечить реальную выгоду AT&T и её абонентам. В Helium утверждают, что её сетью пользуются более 800 тыс. человек. С ней уже сотрудничают телеком-гигант Movistar, предоставляющий услуги связи в Испании и Латинской Америке, а также американский спутниковый провайдер Dish Network. В частности, в феврале 2025 года Helium предоставила доступ к своим сервисам более 2,3 млн подписчикам Movistar в Мексике. Сотрудничество с Helium позволяет телеком-операторам частично разгрузить собственные мобильные сети.

Источник изображения: Brendan Stephens/unsplash.com Для расширения доступа в интернет, в том числе в труднодоступных местах, применяются самые разные технологии. Так, в 2023 году австралийский провайдер Move Up Internet (MUI) объявил о намерении предоставлять гигабитный интернет-доступ в регионе Саншайн-Кост (Квинсленд) — для этого будут применяться сети на базе технологии Terragraph. В феврале 2025 года сообщалось, что Vodafone испытала дроны с лазерными терминалами Google X Taara для организации экстренной связи даже в тех местах, где её обычно нет.

28.04.2025 [15:08], Сергей Карасёв

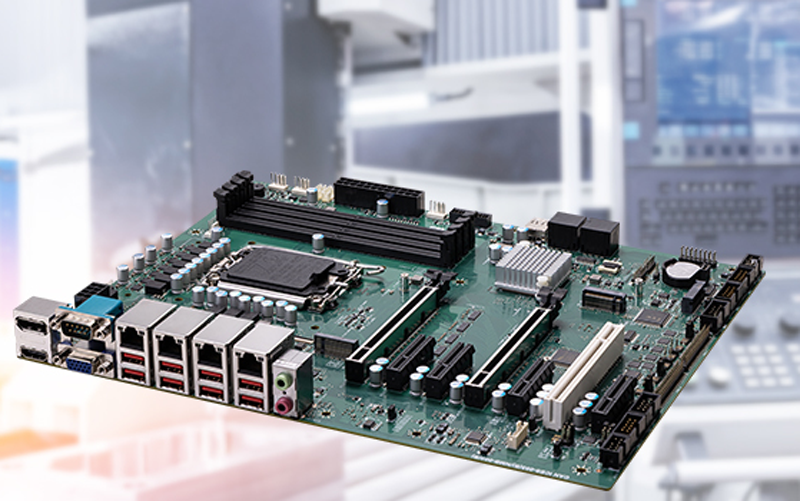

Intel Arrow Lake-S с PCI-слотом и COM-портами: представлена индустриальная ATX-плата MSI MS-CF20Компания MSI анонсировала индустриальную материнскую плату MS-CF20 типоразмера АТХ, рассчитанную на работу с процессорами Intel Arrow Lake-S (Core 15-го поколения). Новинка предназначена для построения систем промышленной автоматизации, контроля и видеонаблюдения, периферийного ИИ-оборудования, серверов обработки данных, транспортных платформ, медицинского оборудования и пр. Плата выполнена на наборе логики Intel W880. Допускается установка чипа в исполнении LGA1851 с показателем TDP до 125 Вт. Есть четыре слота для модулей оперативной памяти DDR5-5600 суммарным объёмом до 192 Гбайт, а также четыре порта SATA-3 для накопителей с возможностью формирования массивов RAID 0/1/5/10. Предусмотрены два разъёма М.2 M key 2280 для SSD и разъём М.2 E key (PCIe x1) 2230 для комбинированного модуля Wi-Fi/Bluetooth. Решение располагает классическим слотом PCI для старых карт расширения, гнездом PS/2 для клавиатуры/мыши, а также десятью последовательными портами (COM), один из которых выведен на интерфейсную панель. Кроме того, доступны два слота PCIe 5.0 x16 и четыре слота PCIe 4.0 x4.

Источник изображения: MSI В оснащение входят 2.5GbE-контроллер Intel I226-LM с четырьмя портами (RJ45), звуковой кодек Realtek ALC897 с 3,5-мм аудиогнёздами, контроллер ввода/вывода Fintek F81967D-I, TPM-чип Infineon SLB9672VU2.0. Для вывода изображения могут быть задействованы коннекторы D-Sub, HDMI и DisplayPort. Кроме того, присутствуют восемь портов USB 3.2 Gen2 Type-A (плюс два порта USB 3.2 Gen1 через коннекторы на плате). Модель MSI MS-CF20 имеет размеры 305 × 244 мм. Диапазон рабочих температур простирается от 0 до +60 °C. Гарантирована совместимость с Windows 10 IoT Enterprise 2021 LTSC, Windows 11 IoT Enterprise 24H2 LTSC и Linux.

28.04.2025 [12:32], Сергей Карасёв

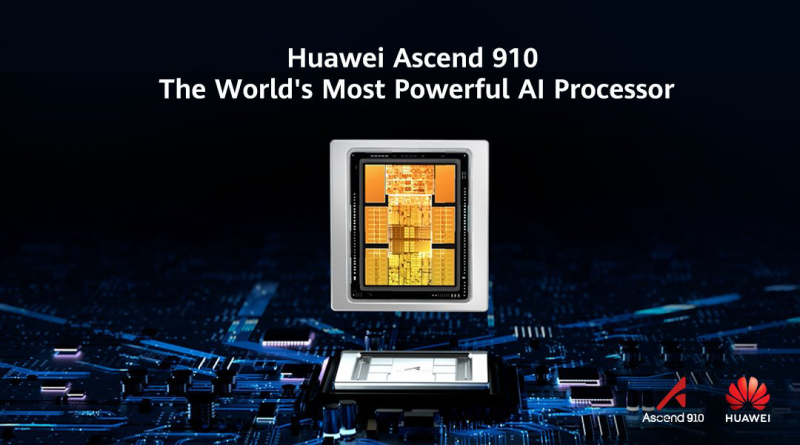

Huawei готовится к тестированию своего самого мощного ИИ-ускорителя — Ascend 910DКомпания Huawei, по сообщению газеты The Wall Street Journal, готовится к выводу на рынок своего самого производительно ИИ-ускорителя — изделия Ascend 910D. Ожидается, что новинка сможет составить конкуренцию решениям NVIDIA, которые китайские заказчики не могут приобретать в связи с американскими санкциями. Первые образцы Ascend 910D, как предполагается, будут изготовлены к концу мая. Huawei уже ведёт переговоры с рядом китайских технологических компаний по вопросу тестирования ускорителя. Испытания необходимы для оценки производительности новинки и подготовки к массовому производству. Huawei рассчитывает, что в плане быстродействия Ascend 910D сможет превзойти NVIDIA H100. В семейство Ascend 910 также входят модели 910B и 910C. Причём версия Ascend 910С позиционируется в качестве китайской альтернативы NVIDIA H100. Однако независимые тесты, проведённые сторонними специалистами, показали, что по производительности это изделие Huawei уступает продукту конкурента. Тем не менее, некоторые заказчики уже ведут переговоры с Huawei об увеличении объёмов закупок Ascend 910C. Связано это с новыми санкциями со стороны США, которые запрещают поставлять в КНР даже специально ослабленные ускорители NVIDIA H20. Сама Huawei в текущем году намерена отгрузить более 800 тыс. изделий Ascend 910B и 910C клиентам в различных отраслях, включая государственных операторов связи и частных ИИ-разработчиков, таких как ByteDance (родительская компания TikTok). Ранее также сообщалось, что Huawei готовит ИИ-ускорители следующего поколения — 6-нм решения Ascend 920 и Ascend 920C. По имеющейся информации, Ascend 920C сможет демонстрировать BF16-производительность на уровне 900 Тфлопс против 780 Тфлопс у Ascend 910C. Новинка получит память HBM3 с пропускной способностью до 4 Тбайт/с, поддержку интерфейса PCIe 5.0 и интерконнекта с высокой пропускной способностью. Начало массового производства ожидается во II половине 2025 года.

23.04.2025 [11:20], Сергей Карасёв

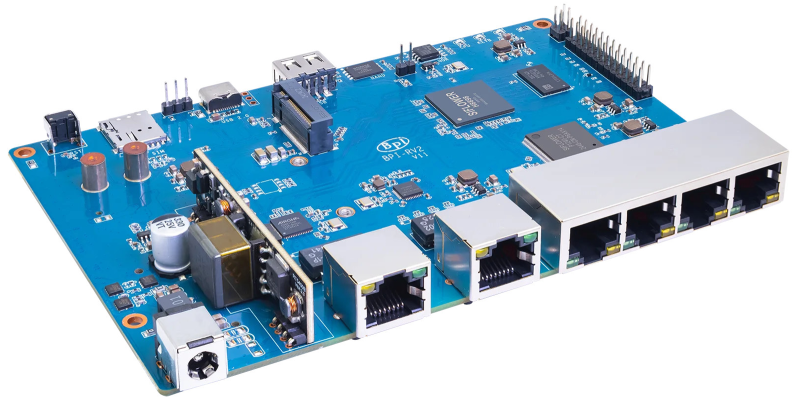

Плата Banana Pi BPI-RV2 для компактных маршрутизаторов оснащена чипом RISC-VВ ассортименте Banana Pi, по сообщению ресурса CNX-Software, появилась плата BPI-RV2, предназначенная для построения компактных маршрутизаторов. Изделие доступно для заказа по ориентировочной цене от $35. Основой новинки служит процессор Siflower SF21H8898 с четырьмя 64-битядрами с архитектурой RISC-V, работающими на тактовой частоте до 1,25 ГГц. Объём оперативной памяти DDR3 составляет 512 Мбайт. Предусмотрено 128 Мбайт памяти SPI NAND Flash (для U-Boot и Linux), а также 16 Мбайт памяти SPI NOR Flash (U-Boot и Linux) с защитой от записи по умолчанию. Плата располагает коннектором M2 Key-B (PCIe 2.0 x1 + USB 2.0) для NVMe SSD или модема 5G (плюс разъём для карты Nano SIM), а также слотом mini PCIe (PCIe 2.0 x1) для адаптера Wi-Fi или сетевой карты. Есть 26-контактная колодка GPIO, разъём USB 2.0 Type-A и порт USB Type-C. Изделие оборудовано шестью сетевыми портами RJ45, из которых пять поддерживают стандарт 1GbE, а один — 2.5GbE. Опционально может быть реализована поддержка 802.3at/af PoE (через порт 2.5GbE). Новинка имеет размеры 148 × 100,5 мм. Питание (12 В / 2 A) подаётся через коннектор 5.5/2.1 мм. Плата Banana Pi BPI-RV2 использует форк OpenWrt (Linux 5.10). Базовая версия изделия предлагается за $34,5, а доплатив ещё $4, можно приобрести вариант с PoE. На текущий момент для платы нет специализированного корпуса, позволяющего получить полноценный маршрутизатор. Но по габаритам решение идентично модели Banana Pi BPI-R3, для которой предлагается недорогой металлический корпус.

22.04.2025 [13:10], Сергей Карасёв

Huawei готовит 6-нм ИИ-ускоритель Ascend 920 с производительностью 900 ТфлопсКомпания Huawei, по сообщениям сетевых источников, готовит ускорители Ascend 920 и Ascend 920C для ИИ-задач. Эти изделия, как ожидается, станут альтернативой картам NVIDIA H20, поставки которых в Китай оказались под запретом в связи с новыми санкциями со стороны США. По имеющейся информации, при производстве изделий семейства Ascend 920 будет применяться 6-нм технология китайской компании SMIC. Ускорители будут оснащаться памятью HBM3 с пропускной способностью до 4 Тбайт/с. Для сравнения: память HBM2E в составе решений Ascend 910C обеспечивает скорость до 3,2 Тбайт/с. По имеющейся информации, модель Ascend 920C, ориентированная на обучение ИИ-моделей, сможет демонстрировать BF16-производительность на уровне 900 Тфлопс. У Ascend 910C быстродействие достигает 780 Тфлопс. В целом, как утверждается, общая эффективность ИИ-обучения у Ascend 920C улучшится на 30–40 % по сравнению с предшественником. Новые ускорители получат поддержку интерфейса PCIe 5.0 и интерконнекта с высокой пропускной способностью следующего поколения. Говорится об использовании архитектуры на основе чиплетов. Реализуемые улучшения призваны сократить разницу в производительности на ватт затрачиваемой энергии по сравнению с решениями конкурентов. Массовое производство ускорителей серии Ascend 920 запланировано на II половину 2025 года. Сетевые источники отмечают, что возможности Huawei по выпуску Ascend 920 будут отчасти зависеть от того, сможет ли компания получить доступ к высококачественной памяти HBM в нужных объёмах. Ранее сообщалось, что на китайском рынке ИИ-ускорителей, предназначенных для обучения моделей, доминирует NVIDIA. Вместе с тем Huawei со своими изделиями Ascend рассчитывает укрепить позиции в области инференса. |

|