Материалы по тегу: i

|

21.05.2025 [10:15], Руслан Авдеев

Малайзия проигнорировала США и развернула первую в регионе суверенную ИИ-платформу на чипах Huawei и LLM DeepSeekМалайзия официально объявила об успешной реализации проекта Strategic AI Infrastructure — теперь это первая в Юго-Восточной Азии страна с полностью суверенным стеком ИИ-технологий. Несмотря на настоятельные рекомендации Министерства торговли США не использовать передовые китайские ускорители вроде Huawei Ascend, новый проект реализован с использованием именно этих продуктов и китайской ИИ-модели семейства DeepSeek — впервые за пределами КНР, сообщает TrendForce. Как свидетельствует агентство со ссылкой на малайзийские СМИ, местные власти приветствовали запуск новой инфраструктуры, назвав событие важной вехой на пути развития ИИ в стране. Представитель министерства связи Малайзии подчеркнул, что локализация ИИ-моделей вроде DeepSeek и размещение ИИ-серверов на территории страны укрепляет цифровой суверенитет государства.

Источник изображения: Wengang Zhai/unsplash.com Предполагается, что теперь Малайзия не зависит от зарубежных облаков или ЦОД — вся инфраструктура, от серверов до ИИ-агентов, разрабатывается и управляется на месте. По имеющимся данным, первая суверенная генеративная ИИ-экосистема, оператором которой выступает малайзийская Skyvast Cloud, работает на основе серверов AlterMatic DT250 с восемью ускорителями Huawei Ascend. Skyvast и китайская компания Leadyo намерены развернуть к 2026 году 3 тыс. высокопроизводительных ускорителей в нескольких зонах в Малайзии. Это будет частью стратегии по масштабированию национальной ИИ-системы за счёт международного и локального сотрудничества. Примечательно, что в стране фактически проигнорировали предупреждение Министерства торговли США, которое недавно заявило о потенциальных рисках применения китайских ускорителей, а также предостерегло от использования американских ИИ-чипов для обучения и дальнейшего обеспечения работы китайских ИИ-моделей. В частности, утверждалось, что при их создании использовалась интеллектуальная собственность американских компаний. Дополнительно на днях сообщалось, что Соединённые Штаты готовят санкции против китайских производителей памяти CXMT, YMTC и других чипмейкеров.

20.05.2025 [19:00], Владимир Мироненко

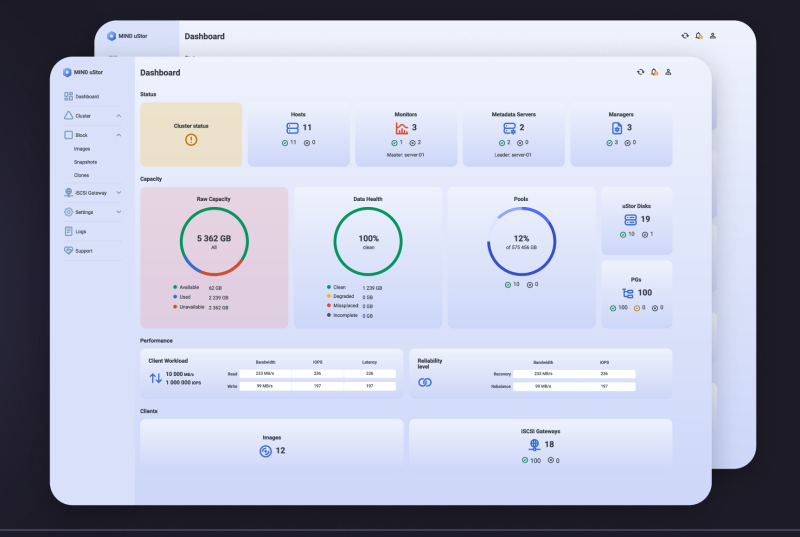

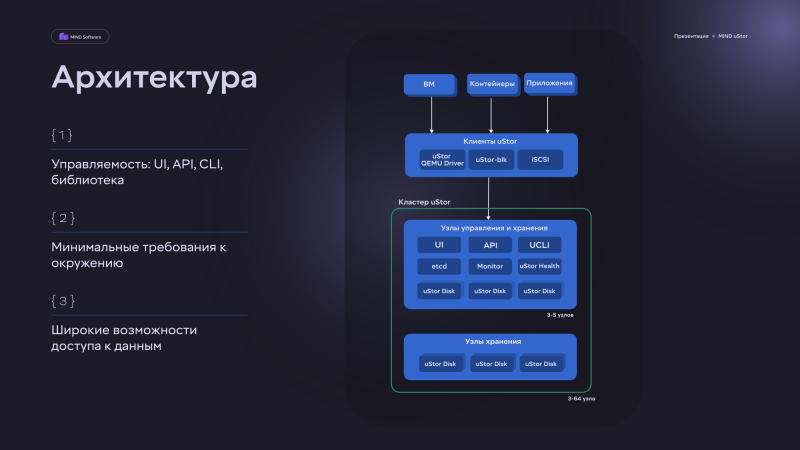

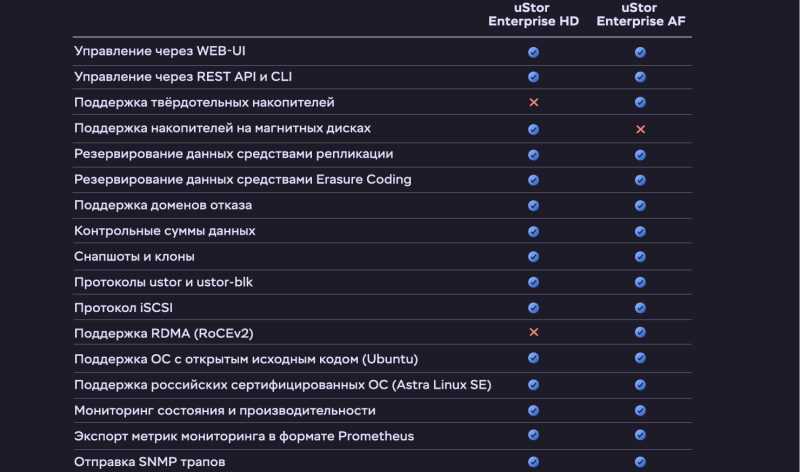

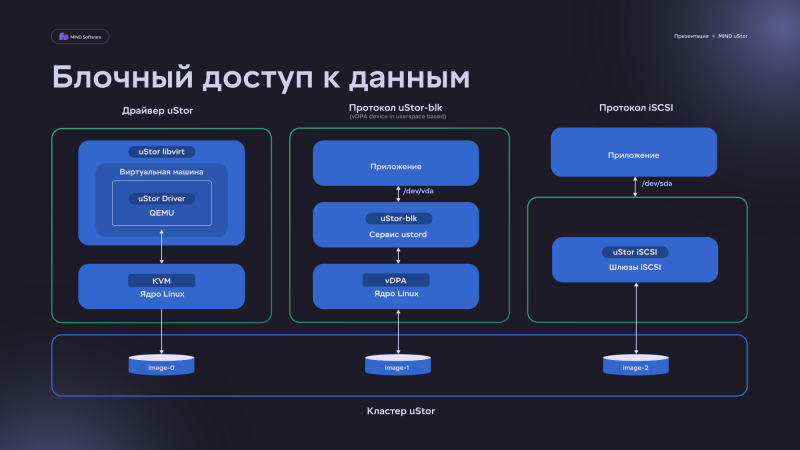

MIND Software анонсировала отечественную программно определяемую СХД MIND uStorMIND Software представила распределённую блочную программно определяемую СХД MIND uStor, предназначенную для корпоративного сегмента отечественного рынка. Ключевая функциональность новинки — сервисы оркестрации, мониторинга, информационной безопасности, графический интерфейс, снапшоты, REST API, CLI, доступ по iSCSI и т.п. — была создана компанией с нуля на основе собственных разработок в соответствии с современными требованиями к высокой надёжности, производительности и технологической независимости продукта, говорит MIND Software MIND uStor позволяет построить отказоустойчивое, масштабируемое и производительное хранилище данных с возможностью интеграции с платформами серверной и контейнерной виртуализации, в том числе в гиперконвергентных (HCI) конфигурациях. Платформа совместима с x86-серверами и поддерживает широкий спектр протоколов взаимодействия с виртуальной инфраструктурой. ПО MIND uStor может лицензироваться как для постоянного использования, так и в форме подписки. Доступны лицензии uStor Enterprise HD/AF и Standard. Компания также предлагает комплекс профессиональных услуг для помощи в проектировании и внедрении. Решение отличается универсальностью, позволяя применять его для организаций, чья инфраструктура включает различные облачные платформы и технологии виртуализации. Оно позволяет повысить эффективность использования систем хранения и оптимизировать совокупную стоимость владения инфраструктурой (TCO). По данным MIND Software, её SDS позволяет снизить TCO на 30–60 % по сравнению с традиционными СХД. По словам компании, MIND uStor — логичный и своевременный ответ на растущий спрос на отечественные инфраструктурные решения, способные заменить зарубежные аналоги без потери в надёжности и гибкости. Решение обладает простой архитектурой и минимальными требованиями к ресурсам, легко настраивается и масштабируется под любые задачи. Компания обеспечивает его поддержку на корпоративном уровне в режиме 24/7. Решение может использоваться для хранения томов виртуальных машин, данных контейнеров, а также для построения гиперконвергентных ландшафтов. СХД обладает поддержкой протоколов взаимодействия как собственной разработки, так и отраслевых, например, iSCSI. Подчёркивается, что решение «отлично работает в смешанных инфраструктурах и может применяться в качестве альтернативы или в дополнение к традиционным СХД». Минимальные требования MIND uStor к оборудованию включают наличие трёх узлов (оптимально от пяти узлов). Каждый узел должен иметь хотя бы 32 Гбайт RAM и два восьмиядерных процессора уровня Intel Xeon Skylake-SP с частотой от 2,8 ГГц. Также необходимо наличие двух портов 10/25/40/100GbE (лучше 25 Гбит/с и более) и накопителей NVMe/SATA/SAS SSD или SATA/SAS/NL-SAS HDD — оптимально 8–16 шт. в одном узле. В случае All-Flash конфигураций доступна поддержка RDMA (RoCEv2). Эффективная ёмкость SDS составляет до 80 % от «сырой», но в 2026 году появятся дедупликация и сжатие. Компания планирует запустить в июне программу сертифицированных конфигураций uStor, в рамках которых будет проводиться тестирование оборудования на совместимость и совместно с вендорами аппаратного обеспечения будут разработаны оптимальные конфигурации. На данный момент MIND Software находится на завершающей стадии интеграции с двумя лидирующими на российском рынке платформами виртуализации, официальный релиз совместных решений запланирован на лето 2025. Также на осень запланированы релизы решений по интеграции с платформами контейнеризации. Кроме того, прорабатывается создание ПАК на основе uStor.

16.05.2025 [18:25], Руслан Авдеев

Обойдёмся без Microsoft: OpenAI заключила сделку с CoreWeave на $4 млрдКомпания CoreWeave заключила очередную сделку с OpenAI на сумму $4 млрд до 2029 года. По данным Bloomberg, в недавнем финансовом отчёте компания отчиталась о новом соглашении «с крупным предприятием в сфере ИИ», но имя партнёра не называлось. Ранее компании OpenAI уже подписала с CoreWeave сделку на $11,9 млрд, предусматривающую использование вычислительных мощностей последней. Эта сделка не вошла в перечень текущих обязательств CoreWeave (RPO). Партнёрство двух компаний поможет CoreWeave диверсифицировать клиентскую базу, а OpenAI — сократить зависимость от Microsoft, а также собственного ИИ-проекта Stargate с участием SoftBank и Oracle. Впрочем, дело несколько сложнее, потому что якорным заказчиком CoreWeave, обеспечивающим 62 % выручки, была сама Microsoft, которая арендовала ресурсы в интересах OpenAI. Вторым по величине клиентом была NVIDIA. Ходили слухи, что в Microsoft намерены сократить расходы, но в CoreWeave информацию опровергали — ранее речь шла о контракте стоимостью $10 млрд. Ранее эксклюзивным поставщиком облачных сервисов для OpenAI была Microsoft, вложившая в компанию с 2019 года $19 млрд, но в 2024 году было объявлено, что OpenAI будет работать и с Oracle, правда, при посредничестве той же Microsoft. По данным Datacenter Dynamics, после анонса Stargate компании «выяснили отношения» и Microsoft получила почётное звание «ключевого первоначального технологического партнёра», но не получила доли в бизнесе в отличие от Oracle, SoftBank и арабской MGX. Microsoft подтвердила, что партнёрство более не является эксклюзивным, хотя у компании остаётся право «преимущественного выбора» (ROFR). В начале мая The Financial Times заявляла, что условия сотрудничества пересматриваются, а основные разговоры ведутся о том, какую долю должна получить в капитале OpenAI компания Microsoft в обмен на прошлые инвестиции. Источники заявляют также и о пересмотре условий контракта, заключённого компаниями ещё в 2019 году. По имеющимся данным, Microsoft готова отказаться от части доли в будущей коммерческой компании в обмен на доступ передовым к технологиям OpenAI, разработанным после 2030 года, когда текущий контракт закончится. Как сообщают некоторые источники, во многом проблема связана с «высокомерием» OpenAI, желающей денег, но также требующей не вмешиваться в рабочие процессы — Microsoft якобы должна радоваться самому факту такого сотрудничества. Впрочем, по словам близкого к OpenAI источника, Microsoft по-прежнему заинтересована в превращении последней в коммерческую структуру, хотя впереди предстоят сложные переговоры.

15.05.2025 [11:49], Сергей Карасёв

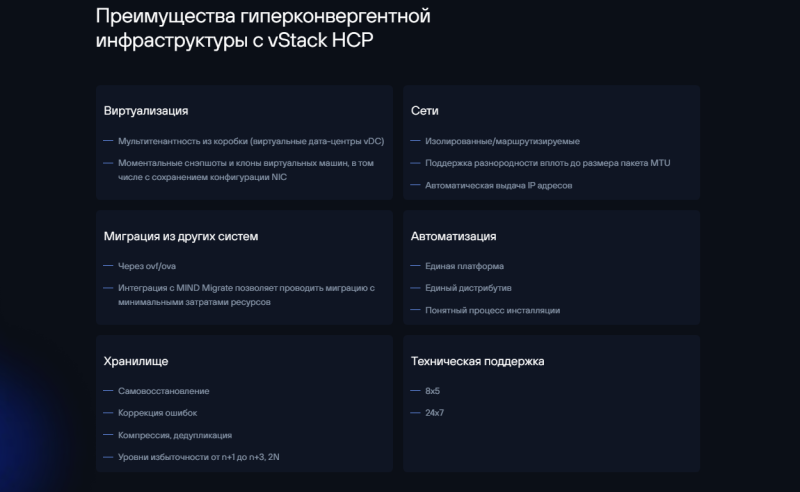

vStack и TERA IT готовят HCI ПАК для бизнеса и госсектораРазработчик программного обеспечения vStack (входит в корпорацию ITG) и российский IT-дистрибьютор TERA (TERA IT Distributor) анонсировали совместный проект по выпуску отечественных программно-аппаратных комплексов (ПАК) для виртуализации и управления инфраструктурой. Устройства, как ожидается, заинтересуют клиентов из различных отраслей — от малого бизнеса до крупных государственных предприятий. В качестве аппаратной основы ПАК будут использоваться собственные платформы «Система ИКС» дистрибьютора TERA, включая серверы, СХД и сетевые устройства. Программная составляющая ПАК предполагает применение гиперконвергентной платформы vStack с полной интеграцией слоев вычислений, хранения и сети в единой панели управления. Такая HCI-архитектура, как утверждается, позволит повысить надёжность благодаря сокращению количества точек отказа. Кроме того, упростится администрирование, что позволит уменьшить штат обслуживающего персонала. В зависимости от потребностей заказчика будут предлагаться ПАК в четырёх конфигурациях. Это, в частности, варианты на серверах ИКС S-серии, которая включает компактные одно- и двухпроцессорные системы с пониженным энергопотреблением. Подходят для задач малого и среднего бизнеса, в том числе для соответствия требованиям по хранению данных (СОРМ-3, закон «Яровой»). Корпоративным клиентам, которые работают с виртуализированными инфраструктурами, будут предложены модели на серверах ИКС D- и F-серии — это сбалансированные двухпроцессорные системы с большим объёмом RAM и поддержкой NVMe-накопителей.

Источник изображения: vStack Для высоконагруженных сред и дата-центров подойдут версии с серверами ИКС L- и H-серии с высокой плотностью вычислений. В 2026–2027 гг. появятся ПАК с серверами ИКС Z-серии (в разработке), ориентированные на госсектор и соответствующие требованиям локализации. «Мы видим стабильный рост спроса на российские IT-продукты, особенно в сфере виртуализации и управления инфраструктурой. Совместный ПАК с TERA даёт компаниям возможность выстраивать надёжные и гибкие IT-системы без привязки к зарубежным технологиям», — говорит генеральный директор vStack.

14.05.2025 [23:27], Руслан Авдеев

США отменили спорные ограничения на экспорт ИИ-ускорителей в другие страны, но запретили им покупать ускорители HuaweiВызвавшие немало споров «Правила распространения ИИ» (AI Diffusion rules), которые должны были ограничить продажу американских ускорителей уже на этой неделе, официально отменены президентом США Дональдом Трампом (Donald Trump), сообщает The Register. Министерство торговли США выполнило данное ранее обещание отменить экспортный контроль для большинства стран на том основании, что он «подавлял бы американские инновации и обременял бы компании новыми нормативными требованиями». В заявлении министерства также подчёркивалось, что новые правила подорвали бы дипломатические отношения Соединённых Штатов с десятками стран. Рамочную программу опубликовали в последние дни правления администрации Байдена — она была направлена на ограничение продаж ИИ-чипов буквально большинству стран мира, за исключением нескольких избранных союзников — в число счастливчиков не вошли даже многие страны НАТО. Предполагалось, что новые ограничения заставят «пострадавшие» страны серьёзно относиться к контролю возможного реэкспорта или контрабанды ИИ-чипов и оборудования в недружественные страны.

Источник изображения: Greg Bulla / Unsplash Хотя некоторые приветствовали ограничения, многие американские технологические компании выступили резко против новых правил, заявив, что страны, не получив ИИ-инфраструктуру от США, смогут получить её от Китая. В администрации Трампа разрабатывают собственный подход. Политики обещают защитить национальные интересы США, но подробностей пока очень мало. Ранее Министерство торговли также выпустило документ, в котором предупредило об опасностях IaaS — многие компании закрывают глаза на то, что китайские разработчики ИИ-моделей работают со своими проектами в их облаках. Хотя покупать передовые чипы структурам из КНР давно запрещено, им никто не мешает арендовать ИИ-инфраструктуру, в том числе в США. Во вторник Бюро промышленности и безопасности (BIS) Министерства торговли США также выпустило разъяснение к Правилам экспортного контроля (EAR), в котором предупредило, что производители чипов могут подпадать под экспортные ограничения при продажах иностранным облачным провайдерам. В этих правилах уже предусмотрен запрет гражданам США, а также поставщикам облачных услуг и операторам ЦОД без разрешения и сознательно предоставлять сервисы или заключать контракты, которые будут способствовать разработке ИИ-решений недружественным странами для целей военной разведки или создания оружия. В частности, в разъяснении указывается, что производителям также потребуется разрешение США на продажу чипов иностранным IaaS-провайдерам, если известно, что ускорители могут использоваться противниками США. Фактически поставщикам напомнили, что если таких провайдеров поймают на помощи в обучении моделей для китайских военных, за этим последует суровое наказание. Более того, США ужесточают контроль не только над новыми чипами для ИИ, но и над теми, что уже есть у иностранных компаний, если они могут быть использованы для разработки «враждебного» ИИ. Наконец, в BIS зашли настолько далеко, что ограничили использование в любой точке мира ускорителей Huawei — наиболее производительной альтернативы чипам NVIDIA в Китае, поскольку, якобы, есть высокая вероятность того, что такие чипы сделаны с использованием американских технологий, но без лицензии.

14.05.2025 [15:05], Руслан Авдеев

OpenAI рассматривает строительство ЦОД в ОАЭКомпания OpenAI рассматривает целесообразность строительства в Объединенных Арабских Эмиратах нового дата-центра. Это может значительно расширить её присутствие на Ближнем Востоке, сообщает Bloomberg со ссылкой на осведомлённые источники. Решение ещё не принято, ситуация может измениться по результатам визита в страну президента США Дональда Трампа (Donald Trump). Глава OpenAI Сэм Альтман (Sam Altman) тоже находится с в регионе в рамках делового тура технологических лидеров. В самой OpenAI слухи пока не комментируют, но недавно компания заявляла, что ищет сотрудничества с национальными правительствами для строительства ИИ-инфраструктуры за пределами США и продвижения американского лидерства в данной сфере. Возможная сделка, вероятно, связана с инвестиционной активностью на время поездки Трампа по региону. В том числе планируется предоставить расширенный доступ к передовым полупроводникам бизнесу из Саудовской Аравии — ранее США ограничили его для большей части мира. OpenAI уже сотрудничает с ОАЭ. Совместные проекты компания начала реализовать с G42 из Абу-Даби в 2023 году. В 2024 году последняя получила $1,5 млрд инвестиций от спонсора OpenAI — Microsoft. Инвестиционная компания MGX, контролируемая королевской семьёй ОАЭ, в своё время приняла участие в финансировании OpenAI на $6,6 млрд, раунд закрылся в октябре прошлого года. Также MGX намерена внести вклад в совместный проект Stargate в США, в котором помимо OpenAI участвуют SoftBank и Oracle.

Источник изображения: David Rodrigo/unsplash.com Пока нет данных, ЦОД какой мощности OpenAI намерена построить в ОАЭ. Во многом проект зависит от того, сможет ли компания импортировать передовые ускорители NVIDIA, поскольку США ограничили их продажу в страну с 2023 года. Впрочем, администрация Трампа относится к партнёрам с Ближнего Востока гораздо мягче администрации Байдена, поэтому не исключено соглашение о существенном упрощении доступа к полупроводникам странам Персидского залива. Сделка с США может привести к импорту в ОАЭ более 1 млн ускорителей NVIDIA, большая часть их них будет выделена американским компаниям, строящим ЦОД в государствах региона. На фоне обещаний стран Персидского залива инвестировать немалые средства в американскую экономику, администрация Трампа более охотно разрешает поставки полупроводников на Ближний Восток. Ранее администрация Трампа уже объявила, что рамочная программа эпохи Байдена, призванная регулировать некоторые из вопросов регулирования, будет пересмотрена. Пока чиновники Трампа разрабатывают новые глобальные правила в отношении оборота чипов.

13.05.2025 [13:53], Сергей Карасёв

Анонсирован настольный ИИ-суперкомпьютер MSI EdgeXpert MS-C931 на базе NVIDIA DGX SparkКомпания MSI анонсировала устройство EdgeXpert MS-C931 — так называемый ИИ-суперкомпьютер в «настольном» формате. В основу решения положена платформа NVIDIA DGX Spark. Компьютер заключён в корпус с габаритами 151 × 151 × 52 мм, а масса составляет около 1,2 кг. Задействован суперчип Grace Blackwell GB10, который объединяет ускоритель Blackwell и процессор Grace с 20 ядрами Arm в виде связки 10 × Arm Cortex-X925 и 10 × Arm Cortex-A725. Производительность достигает 1000 TOPS на операциях FP4. Питается новинка от внешнего БП мощностью около 240 Вт. В оснащение EdgeXpert MS-C931 входят 128 Гбайт памяти LPDDR5x, M.2 NVMe SSD вместимостью до 4 Тбайт, контроллеры Wi-Fi 7 и Bluetooth 5.3, сетевой адаптер NVIDIA ConnectX-7 SmartNIC. Разъёмы сосредоточены в тыльной части: это четыре порта USB 3.2 Type-С (до 20 Гбит/с), гнездо RJ45 (10GbE), интерфейс HDMI 2.1a, а также два порта для объединения нескольких устройств в кластер.

Источник изображения: MSI Используется программная платформа NVIDIA DGX OS — модификации Ubuntu, адаптированной для работы с ИИ. Утверждается, что устройство может использоваться для решения таких задач, как настройка ИИ-моделей, насчитывающих до 70 млрд параметров, инференс, тестирование приложений ИИ и пр. Кроме того, EdgeXpert MS-C931 подходит для использования на периферии — например, в составе систем машинного зрения или робототехнических комплексов. Среди основных категорий пользователей названы разработчики, специалисты в области данных и исследователи в сфере ИИ.

12.05.2025 [20:55], Владимир Мироненко

«Давайте нам деньги и вычислительные ресурсы и не путайтесь под ногами»: OpenAI и Microsoft пытаются договориться о продолжении сотрудничества на фоне роста амбиций стартапаВ прессе появились сообщения о переговорах между OpenAI и Microsoft по поводу пересмотра условий их дальнейшего партнёрства. В то время как OpenAI ищет пути для выхода на IPO, стремясь привлечь больше финансирования, необходимого для обеспечения разработки более мощного ИИ, Microsoft рассчитывает и в дальнейшем иметь доступ к новейшим разработкам создателя ChatGPT, пишет The Financial Times со ссылкой на информированные источники. Существующий контракт OpenAI и Microsoft был подписан в 2019 году, когда Microsoft инвестировала в стартап $1 млрд. В общей сложности софтверный гигант инвестировал в OpenAI более чем $13 млрд, получая взамен доступ к интеллектуальной собственности, а также долю дохода продаж продуктов. Действие контракта истекает в 2030 году. Microsoft хотела бы и в дальнейшем иметь доступ к новейшим разработкам OpenAI, ради чего готова пожертвовать частью своей доли доходах OpenAI, сообщили источники The Financial Times.

Источник изображения: Headway / Unsplash Стартап был создан как некоммерческая организация, что стало препятствием для расширения его финансирования. Компания не скрывает намерений перейти на коммерческие рельсы, однако решила изменить подход. На прошлой неделе OpenAI объявила об отказе от разделения на некоммерческое и коммерческое подразделения, выбрав вместо этого реструктуризацию бизнес-подразделения в корпорацию общественного блага (PBC). Это позволит ему привлекать инвестиции, не меняя социальные приоритеты. Данной корпоративной модели придерживаются Anthropic и xAI. Это также даст возможность OpenAI по-прежнему предлагать инвесторам долю в бизнесе. По словам источника, изменение является ключевым требованием инвесторов, и оно гарантирует, что «IPO станет возможным» в будущем. Но для реализации этого плана также требуется одобрение Microsoft, крупнейшего финансового спонсора OpenAI. Переговоры между OpenAI и Microsoft осложняются охлаждением между компаниями, поскольку с момента начала их партнёрства амбиции стартапа выросли, сейчас он параллельно работает с её конкурентами — SoftBank и Oracle — для создания собственной обширной ИИ-инфраструктуры Stargate стоимостью сотни миллиардов долларов. Один из топ-менеджеров раскритиковал OpenAI за высокомерие. «Отчасти трения возникают из-за стиля. OpenAI говорит Microsoft: ”Давайте нам деньги и вычислительные ресурсы и не путайтесь под ногами: будьте счастливы работать с нами". Естественно, это приводит к напряжённости», — отметил он. Вместе с тем в Microsoft сохраняют оптимизм по поводу того, что стороны уладят разногласия и придут к соглашению.

Источник изображения: Headway / Unsplash Разработка ИИ-технологий предполагает громадные расходы. В октябре прошлого года OpenAI привлёк $6,6 млрд от SoftBank, Microsoft и венчурных капиталистов, включая Thrive Capital и Altimeter Capital. В марте он получил ещё $40 млрд в раунде финансирования, возглавляемом SoftBank, причём в контрактах инвесторов оговорено, какой капитал они получат, когда OpenAI преобразуется в новую структуру. Инвесторы имеют возможность вернуть часть или все вложенные ими средства, если OpenAI не сможет стать коммерческой корпорацией. Вместе с тем в OpenAI уверены, что инвесторы сохранят приверженность компании, даже если реструктуризация будет отложена по каким-либо причинам. По словам источника, требование о преобразовании в более традиционную коммерческую структур является «признанием на высоком уровне того, что это требуется для привлечения такой суммы денег». Он добавил, что привлечение «$40 млрд в рамках структуры с ограниченной прибылью недостижимо». Даже в случае положительного исхода переговоров с Microsoft, стартап ожидают дополнительные препятствия. В понедельник OpenAI пообещал, что его бизнес-подразделение будет контролироваться некоммерческим советом, предоставив совету существенную долю в акционерном капитале корпорации общественного блага и право назначать его директоров.

Источник изображения: Headway / Unsplash Но критики считают, что OpenAI ставит под угрозу свою миссию, ставя прибыль выше остального. В частности, Маск, покинувший OpenAI после ссоры с главой OpenAI Сэмом Альтманом (Sam Altman), пообещал продолжить судебные разбирательства, чтобы заблокировать любую корпоративную реструктуризацию. Комментируя решение OpenAI провести преобразование в PBC, адвокат Маска Марк Тоберофф (Marc Toberoff) заявил агентству Bloomberg, что это ничего меняет. «Благотворительная организация по-прежнему передаёт свои активы и технологии частным лицам ради личной выгоды — включая Сэма Альтмана — и при этом переводит всю фактическую работу благотворительной организации по ИИ/AGI в гигантскую коммерческую корпорацию», — отметил он. Кроме того, OpenAI предстоит убедить власти Калифорнии и Делавэра — штатов, в которых находится её штаб-квартира и зарегистрирована организация, — что данное предложение будет соответствовать миссии компании по принесению пользы обществу. Генеральный прокурор штата Делавэр Кэти Дженнингс (Kathy Jennings) заявила о планах проверить намеченную реструктуризацию OpenAI на предмет соответствия законодательству Делавэра и благотворительным целям, а также то, что в новой структуре некоммерческая организация сохранит надлежащий контроль над коммерческой. Провал нового плана по реструктуризации может больно ударить по OpenAI, предупреждают эксперты, поскольку стартап не сможет привлекать больше денег, добиваться будущего размещения акций и получать финансовые ресурсы для оказания конкуренции крупным технологическим компаниям, таким как Google.

12.05.2025 [12:20], Сергей Карасёв

MSI представила мини-компьютер MS-C927 на базе Intel Arrow Lake-U для периферийных вычисленийКомпания MSI анонсировала индустриальный компьютер небольшого форм-фактора MS-C927, предназначенный для решения различных ИИ-задач на периферии: это могут быть обнаружение объектов, распознавание лиц, визуальный контроль, автоматизация тех или иных операций и пр. Устройство оснащается процессором Intel Core Ultra поколения Meteor Lake-U или Arrow Lake-U. Новинка заключена в корпус с габаритами 130 × 155 × 40 мм. Применено пассивное охлаждение, а верхняя ребристая панель выполняет функции радиатора для рассеяния тепла. Диапазон рабочих температур простирается от -10 до +60 °C. Компьютер соответствует стандарту IEC 61373 по ударопрочности и вибронагрузкам, что позволяет использовать его на транспорте. Напряжение питания DC-in может варьироваться от 12 до 24 В.

Источник изображения: MSI Устройство располагает двумя слотами SO-DIMM для модулей оперативной памяти DDR5-6400 суммарным объёмом до 96 Гбайт. Доступны слоты M.2 M-key для NVMe SSD, М.2 B-key для сотового модема и М.2 E-key для комбинированного адаптера Wi-Fi/Bluetooth. Предусмотрены сетевые порты 2.5GbE и 1GbE на основе контроллеров Intel I226-V и Intel I219-LM соответственно. В набор разъёмов входят гнёзда RJ45 для сетевых кабелей, четыре порта USB 3.х Type-A (10 Гбит/с), два интерфейса DisplayPort с поддержкой разрешения до 4096 × 2304 пикселя (60 Гц), два последовательных порта и интерфейс GPIO (4 GPI, 4 GPO). Кроме того, имеются гнёзда для подключения антенн беспроводной связи. Предусмотрен встроенный модуль TPM 2.0 для обеспечения безопасности. Заявлена совместимость с Windows 10/11 IoT Enterprise LTSC и Linux (по запросу).

10.05.2025 [14:59], Руслан Авдеев

xAI может построить 1,56-ГВт газовую электростанцию для очередного ИИ-суперкомпьютераЭкоактивисты уверены, что компания xAI, основанная Илоном Маском (Elon Musk), может построить электростанцию на природном газе для нового дата-центра в Мемфисе. Мощность электростанции составит 1,56 ГВт, а состоять она будет из десятков газовых турбин, сообщает Datacenter Dynamics. Согласно мартовскому отчёту агентства Trinity Consultants, подготовленному для xAI, возможно развёртывание 40–90 газовых турбин на Тулейн-роуд (Tulane Road) мощностью до 1,56 ГВт в одном из районов Мемфиса — данные получены экогруппой Southern Environmental Law Center (SELC). Ранее местная коммунальная компания Memphis, Light, Gas and Water (MLGW) заявляла, что xAI пока не подала заявку на электроснабжение объекта, но изучила несколько вариантов присоединения в диапазоне от 260 МВт до 1,1 ГВт. По данным отчёта Trinity, новая электростанция сможет применять два вида турбин Solar Turbines — PGM-130 и Solar Titan 350. По словам юристов SELC, xAI, вероятно, готовится к установке «ошеломляющего» количества загрязняющих воздух генераторов для второго ЦОД компании в Южном Мемфисе, одновременно эксплуатируя поблизости турбины, разрешение для которых вообще не получено. Деятельность xAI в Мемфисе неоднократно вызывала споры в городе с момента открытия в нём первого ЦОД на территории бывшего завода Electrolux, где разместился суперкомпьютер Colossus. Пока местный бизнес приветствовал появление компании в городе и тот стимул, который она обеспечит экономике Мемфиса, местные жители начали выражать обеспокоенность возможным влиянием на доступность электроэнергии и воды, а также влиянием объекта на качество воздуха. Для питания Colossus компания разместила 35 газовых турбин общей мощностью 422 МВт. По данным местных властей, примерно половина из них будет демонтирована в течение двух месяцев. Остальные продолжат функционировать до ввода в эксплуатацию второй подстанции на 150 МВт осенью 2025 года, после чего турбины переведут в резервную систему питания. Таким образом, власти косвенным образом признали, что xAI действительно воспользовалась лазейкой в законах, развернув 35 турбин вместо изначально разрешённых 15. От имени xAI было объявлено, что компания выводит из эксплуатации турбины в округе Шелби и не имеет планов размещения турбин на площадке в районе Тулейн-роуд. Компания продолжит рассматривать энергетические решения для объектов в Мемфисе с учётом всех применимых нормативных ограничений. Впрочем, ей никто не мешает снова повторить трюк с размещением нужного количества генераторов. |

|