Материалы по тегу: hpc

|

16.09.2024 [14:55], Руслан Авдеев

Государство может возместить строителям суперкомпьютеров в России подключение к электросетямКомпаниям, занимающимся созданием суперкомпьютеров для обучения ИИ, возможно, будут возмещать расходы на техническое присоединение к электрическим сетям за счёт государственных средств. «Коммерсантъ» сообщает, что соответствующую меру поддержки готовятся включить в национальный проект «Экономика данных». Конечная цель госпроектов — удвоение совокупной мощности российских суперкомпьютеров к 2030 году. По оценкам, операторы дата-центров тратят до 10 % от стоимости реализации проекта на техническое присоединение. Однако в случае ИИ-суперкомпьютеров, по словам экспертов, порядка 90 % расходов приходится на приобретение ускорителей и лишь около 10 % на капитальное строительство и подведение инженерной инфраструктуры. Некоторые эксперты утверждают, что в норме стоимость технического присоединения не превышает 2–3 % от общей стоимости проекта, но для бизнеса, строящего ЦОД для сдачи в аренду, цена будет выше, на уровне 3–10 %. Некоторые эксперты уверены, что расходы будут значительными в первую очередь в том случае, если для ввода ЦОД в эксплуатацию придётся построить понижающую подстанцию. При этом подчёркивается, что ещё с 2020 года действует возмещение затрат на строительство дата-центров или их модернизацию. Речь идёт о компенсации 50 % трат на обеспечивающую инфраструктуру и до 100 % — на сопутствующую. Правда, как сообщают в Миноэкономики, никакие проекты в подобном формате сегодня не реализуются. Информация о льготах представлена в предварительном варианте текста федерального проекта «Искусственный интеллект» — его предлагают включить в нацпроект «Экономика данных», который должен стартовать в следующем году. Речь идёт именно о поддержке строителей суперкомпьютеров, оснащённых ускорителями (GPU), применяемых для обучения ИИ-систем. Государственная финансовая поддержка подключения к энергосетям будет распределяться по конкурсу, а оператор дата-центра в этом случае обязуется построить суперкомпьютер. В Минцифры сообщают, что новый проект финансирования находится на межведомственном голосовании и ещё не утверждён. Предполагается, что в итоге совокупная ёмкость суперкомпьютеров для искусственного интеллекта должна достичь 300 Пфлопс (точность вычислений не указана) в 2027 году и до 1 Эфлопс — в 2030-м. Точкой отсчёта является базовое значение 2024 года, указанное на уровне 100 Пфлопс. По данным «Коммерсанта», компания Nebius AI, отделившаяся от «Яндекса», располагает суперкомпьютером ISEG с пиковой FP64-производительностью до 86,79 Пфлопс. В последнем рейтинге TOP500 машина занимает 19 место с фактической производительностью 46,54 Пфлопс. Всего же в списке есть семь российских суперкомпьютеров.

13.09.2024 [10:22], Сергей Карасёв

Некогда самый мощный в мире суперкомпьютер Summit уйдёт на покой в ноябреВысокопроизводительный вычислительный комплекс Summit, установленный в Окриджской национальной лаборатории (ORNL) Министерства энергетики США, будет выведен из эксплуатации в ноябре 2024 года. Обслуживать машину становится всё дороже, а по эффективности она уступает современным суперкомпьютерам. Summit был запущен в 2018 году и сразу же возглавил рейтинг мощнейших вычислительных систем мира TOP500. Комплекс насчитывает 4608 узлов, каждый из которых оборудован двумя 22-ядерными процессорами IBM POWER9 с частотой 3,07 ГГц и шестью ускорителями NVIDIA Tesla GV100. Узлы соединены через двухканальную сеть Mellanox EDR InfiniBand, что обеспечивает пропускную способность в 200 Гбит/с для каждого сервера. Энергопотребление машины составляет чуть больше 10 МВт. FP64-быстродействие Summit достигает 148,6 Пфлопс (Linpack), а пиковая производительность составляет 200,79 Пфлопс. За шесть лет своей работы суперкомпьютер ни разу не выбывал из первой десятки TOP500: так, в нынешнем рейтинге он занимает девятую позицию. Отправить Summit на покой планировалось в начале 2024-го. Однако затем была запущена инициатива SummitPLUS, и срок службы вычислительного комплекса увеличился практически на год. Отмечается, что этот суперкомпьютер оказался необычайно продуктивным. Он обеспечил исследователям по всему миру более 200 млн часов работы вычислительных узлов. В настоящее время ORNL эксплуатирует ряд других суперкомпьютеров, в число которых входит Frontier — самый мощный НРС-комплекс в мире. Его пиковое быстродействие достигает 1714,81 Пфлопс, или более 1,7 Эфлопс. При этом энергопотребление составляет 22 786 кВт: таким образом, система Frontier не только быстрее, но и значительно энергоэффективнее Summit. А весной этого года из-за растущего количества сбоев и протечек СЖО на аукционе был продан 5,34-ПФлопс суперкомпьютер Cheyenne.

13.09.2024 [00:17], Владимир Мироненко

Производительность суперкомпьютера «Сергей Годунов» выросла вдвое — до 114,67 Тфлопс

a100

hardware

hpc

ice lake-sp

intel

nvidia

rtx

xeon

новосибирск

россия

рск

сделано в россии

суперкомпьютер

Группа компаний РСК сообщила о завершении плановой модернизации суперкомпьютера «Сергей Годунов» в Институте математики имени С.Л. Соболева Сибирского отделения Российской академии наук (ИМ СО РАН), благодаря чему его суммарная пиковая FP64-производительность теперь составляет 114,67 Тфлопс: 75,87 Тфлопс на CPU и 38,8 Тфлопс на GPU. Работы по запуску машины были завершены РСК в ноябре 2023 года, а её официальное открытие состоялось в феврале этого года. На тот момент производительность суперкомпьютера составляла 54,4 Тфлопс. Директор ИМ СО РАН Андрей Евгеньевич Миронов отметил, что использование нового суперкомпьютера позволило существенно повысить эффективность научных исследований, и выразил уверенность, что он также будет способствовать развитию новых технологий. Миронов сообщил, что после запуска суперкомпьютера появилась возможность решать мультидисциплинарные задачи, моделировать объёмные процессы и предсказывать поведение сложных математических систем. По его словам, на суперкомпьютере проводятся вычисления по критически важным проблемам и задачам, среди которых:

Суперкомпьютер «Сергей Годунов» является основным инструментом для проведения исследований и прикладных разработок в Академгородке Новосибирска и создания технологической платформы под эгидой Научного совета Отделения математических наук РАН по математическому моделированию распространения эпидемий с учётом социальных, экономических и экологических процессов. Он был назван в память об известном советском и российском математике с мировым именем Сергее Константиновиче Годунове. Отечественный суперкомпьютер создан на базе высокоплотной и энергоэффективной платформы «РСК Торнадо» с жидкостным охлаждением. Система включает вычислительные узлы с двумя Intel Xeon Ice Lake-SP, узел на базе четырёх ускорителей NVIDIA A100 и сервер визуализации с большим объёмом памяти: Intel Xeon Platinum 8368, 4 Тбайт RAM, пара NVIDIA RTX 5000 Ada с 32 Гбайт GDDR6.

12.09.2024 [11:20], Сергей Карасёв

Начался монтаж модульного ЦОД для европейского экзафлопсного суперкомпьютера JUPITERЮлихский исследовательский центр (Forschungszentrum Jülich) объявил о начале фактического создания модульного дата-центра для европейского экзафлопсного суперкомпьютера JUPITER (Joint Undertaking Pioneer for Innovative and Transformative Exascale Research). Европейское совместное предприятие по развитию высокопроизводительных вычислений (EuroHPC JU) заключило контракт на создание JUPITER с консорциумом, в который входят Eviden (подразделение Atos) и ParTec. В рамках партнёрства за создание модульного ЦОД отвечает Eviden. После завершения строительства комплекс, как ожидается, объединит около 125 стоек BullSequana XH3000. Общая площадь ЦОД составит примерно 2300 м2. Он будет включать порядка 50 компактно расположенных контейнеров. Благодаря модульной конфигурации ускоряется монтаж систем, а также снижаются расходы на строительство объекта. Суперкомпьютер JUPITER получит энергоэффективные высокопроизводительные европейские Arm-процессоры SiPearl Rhea. CPU-блок будет включать 1300 узлов и иметь производительность около 5 Пфлопс (FP64). Кроме того, в состав машины войдут порядка 6000 узлов с NVIDIA Quad GH200, а общее количество суперчипов GH200 Grace Hopper составит почти 24 тыс. Именно они и обеспечат FP64-производительность на уровне 1 Эфлопс. Узлы объединит интерконнект NVIDIA InfiniBand NDR (DragonFly+). Хранилище системы будет включать два раздела: быстрый ExaFLASH и ёмкий ExaSTORE. ExaFLASH будет базироваться на сорока All-Flash СХД IBM Elastic Storage System 3500 с эффективной ёмкостью 21 Пбайт («сырая» 29 Пбайт), скоростью записи 2 Тбайт/с и скоростью чтения 3 Тбайт/с. ExaSTORE будет иметь «сырую» ёмкость 300 Пбайт, а для резервного копирования и архивов будет использоваться ленточная библиотека ёмкостью 700 Пбайт. «Первые контейнеры для нового европейского экзафлопсного суперкомпьютера доставлены компанией Eviden и установлены на площадке ЦОД. Мы рады, что этот масштабный проект, возглавляемый EuroHPC, всё больше обретает форму», — говорится в сообщении Юлихского исследовательского центра. Ожидаемое быстродействие JUPITER на операциях обучения ИИ составит до 93 Эфлопс, а FP64-производительность превысит 1 Эфлопс. Стоимость системы оценивается в €273 млн, включая доставку, установку и обслуживание НРС-системы. Общий бюджет проекта составит около €500 млн, часть средств уйдёт на подготовку площадки, оплату электроэнергии и т.д.

10.09.2024 [14:55], Сергей Карасёв

TACC ввёл в эксплуатацию Arm-суперкомпьютер Vista на базе NVIDIA GH200 для ИИ-задачТехасский центр передовых вычислений (TACC) при Техасском университете в Остине (США) объявил о том, что мощности нового НРС-комплекса Vista полностью доступны открытому научному сообществу. Суперкомпьютер предназначен для решения ресурсоёмких задач, связанных с ИИ. Формальный анонс машины Vista состоялся в ноябре 2023 года. Тогда говорилось, что Vista станет связующим звеном между существующим суперкомпьютером TACC Frontera и будущей системой TACC Horizon, проект которой финансируется Национальным научным фондом (NSF). Vista состоит из двух ключевых частей. Одна из них — кластер из 600 узлов на гибридных суперчипах NVIDIA GH200 Grace Hopper, которые содержат 72-ядерный Arm-процессор NVIDIA Grace и ускоритель H100/H200. Обеспечивается производительность на уровне 20,4 Пфлопс (FP64) и 40,8 Пфлопс на тензорных ядрах. Каждый узел содержит локальный накопитель вместимостью 512 Гбайт, 96 Гбайт памяти HBM3 и 120 Гбайт памяти LPDDR5. Интероконнект — Quantum 2 InfiniBand (400G). Второй раздел суперкомпьютера объединяет 256 узлов с процессорами NVIDIA Grace CPU Superchip, содержащими два кристалла Grace в одном модуле (144 ядра). Узлы укомплектованы 240 Гбайт памяти LPDDR5 и накопителем на 512 Гбайт. Интерконнект — Quantum 2 InfiniBand (200G). Узлы произведены Gigabyte, а за интеграцию всей системы отвечала Dell. Общее CPU-быстродействие Vista находится на отметке 4,1 Пфлопс. В состав комплекса входит NFS-хранилише VAST Data вместимостью 30 Пбайт. Суперкомпьютер будет использоваться для разработки и применения решений на основе генеративного ИИ в различных секторах, включая биологические науки и здравоохранение.

05.09.2024 [19:31], Владимир Мироненко

РСК увеличила производительность суперкомпьютера Института океанологии имени П.П. Ширшова до 308 ТфлопсИнститут океанологии имени П.П. Ширшова Российской академии наук (ИО РАН), единственный в России институт, занимающийся исследованиями во всех областях морских наук, включая физику, климатологию, химию, биологию и геологию океана, использует в своей работе суперкомпьютерный комплекс, разработанный и установленный специалистами группы компаний РСК. Используя вычислительные мощности суперкомпьютера, специалисты института изучают роль Мирового океана и морей России в формировании и прогнозировании климата, балансе парниковых газов, а также всего комплекса физических, химических, биологических и геологических процессов в океане и обеспечения экологической безопасности в интересах устойчивого развития человечества. По словам Сергея Гулева, заведующего Лабораторией взаимодействия океана и атмосферы и мониторинга климата ИО РАН, помимо всего прочего, суперкомпьютер РСК обеспечил для института необходимые вычислительные ресурсы для решения сложных задач в рамках двух важнейших инициатив — проекта государственного значения «Единая национальная система мониторинга климатически активных веществ» и Федеральной научно-технической программы в области экологического развития РФ и климатических изменений на 2021–2030 гг. Гулев также отметил, что работа на суперкомпьютере позволит накопить опыт, который будет полезен при использовании значительно более мощного вычислительного комплекса, запланированного к запуску в ближайшие два-три года в рамках Единой национальной системы мониторинга климатически активных веществ. После запуска суперкомпьютера РСК несколько раз модернизировала его в 2017–2024 гг. В этом году запланировано ещё одно обновление машины. Сейчас HPC-комплекс ИО РАН включает 50 вычислительных узлов на базе платформы «РСК Торнадо» с процессорами Intel Xeon и прямым жидкостным охлаждением. Недавно к ним были добавлены два узла с ускорителями NVIDIA H100 (тоже с СЖО) общей производительностью 104 Тфлопс (FP64). Теперь суммарная производительность суперкомпьютера превышает 308 Тфлопс. Хранилище машины включает All-Flash раздел ёмкостью 50 Тбайт, а также HDD-раздел объёмом более 1,5 Пбайт. Благодая программному комплексу «РСК БазИС» создана иерархическая среда хранения данных с возможностью создания конфигурации файловых систем по запросу.

03.09.2024 [11:04], Сергей Карасёв

Стартап xAI Илона Маска запустил ИИ-кластер со 100 тыс. ускорителей NVIDIA H100Илон Маск (Elon Musk) объявил о том, что курируемый им стартап xAI запустил кластер Colossus, предназначенный для обучения ИИ. На сегодняшний день в состав этого вычислительного комплекса входят 100 тыс. ускорителей NVIDIA H100, а в дальнейшем его мощности будут расширяться. Напомним, xAI реализует проект по созданию «гигафабрики» для задач ИИ. Предполагается, что этот суперкомпьютер в конечном итоге будет насчитывать до 300 тыс. новейших ускорителей NVIDIA B200. Оборудование для платформы поставляют компании Dell и Supermicro, а огромный дата-центр xAI расположен в окрестностях Мемфиса (штат Теннесси). «В эти выходные команда xAI запустила кластер Colossus для обучения ИИ со 100 тыс. карт H100. От начала до конца всё было сделано за 122 дня. Colossus — самая мощная система обучения ИИ в мире», — написал Маск в социальной сети Х. По его словам, в ближайшие месяцы вычислительная мощность платформы удвоится. В частности, будут добавлены 50 тыс. изделий NVIDIA H200. Маск подчёркивает, что Colossus — это не просто еще один кластер ИИ, это прыжок в будущее. Основное внимание в рамках проекта будет уделяться использованию мощностей Colossus для расширения границ ИИ: планируется разработка новых моделей и улучшение уже существующих. Ожидается, что по мере масштабирования и развития система станет важным ресурсом для широкого сообщества ИИ, предлагая беспрецедентные возможности для исследований и инноваций. Запуск столь производительного кластера всего за 122 дня — это значимое достижение для всей ИИ-отрасли. «Удивительно, как быстро это было сделано, и для Dell Technologies большая честь быть частью этой важной системы обучения ИИ», — сказал Майкл Делл (Michael Dell), генеральный директор Dell Technologies.

02.09.2024 [12:12], Сергей Карасёв

HPE создала суперкомпьютер Iridis 6 на платформе AMD для Саутгемптонского университетаКомпания НРЕ поставила в Саутгемптонский университет в Великобритании высокопроизводительный вычислительный комплекс Iridis 6, построенный на аппаратной платформе AMD. Использовать суперкомпьютер планируется для проведения исследований в таких областях, как геномика, аэродинамика и источники питания нового поколения. В основу Iridis 6 положены серверы HPE ProLiant Gen11 на процессорах AMD EPYC семейства Genoa. Задействованы 138 узлов, каждый из которых насчитывает 192 вычислительных ядра и несёт на борту 3 Тбайт памяти. Таким образом, в общей сложности используются 26 496 ядер. В частности, в состав Iridis 6 включены четыре узла с 6,6 Тбайт локального хранилища, а также три узла входа с хранилищем вместимостью 15 Тбайт. Используется интерконнект Infiniband HDR100. В HPE сообщили, что в настоящее время система обеспечивает производительность HPL (High-Performance Linpack) на уровне примерно 1 Пфлопс. В дальнейшем количество узлов планируется увеличивать, что позволит поднять быстродействие.

Источник изображения: НРЕ Отмечается, что Iridis 6 приходит на смену суперкомпьютеру Iridis 4, который имел немногим более 12 тыс. вычислительных ядер. При этом новая система будет сосуществовать с комплексом Iridis 5, который использует процессоры Intel Xeon Gold 6138, AMD 7452 и AMD 7502, а также ускорители NVIDIA Tesla V100, GTX 1080 Ti и А100. Эта машина была запущена в 2018-м и заняла 354-е место в списке TOP500 самых мощных суперкомпьютеров мира, опубликованном в июне того же года. Быстродействие Iridis 5 достигает 1,31 Пфлопс.

30.08.2024 [12:43], Сергей Карасёв

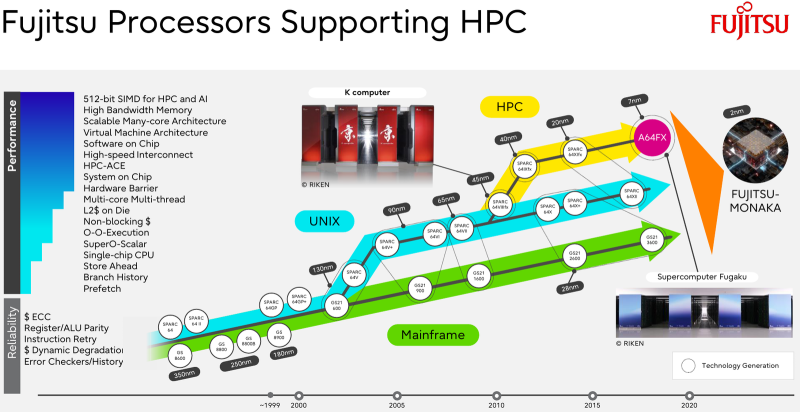

Fujitsu займётся созданием ИИ-суперкомпьютера Fugaku Next зеттафлопсного уровняМинистерство образования, культуры, спорта, науки и технологий Японии (MEXT) объявило о планах по созданию преемника суперкомпьютера Fugaku, который в своё время возглавлял мировой рейтинг ТОР500. Ожидается, что новая система, рассчитанная на ИИ-задачи, будет демонстрировать FP8-производительность зеттафлопсного уровня (1000 Эфлопс). В нынешнем списке TOP500 Fugaku занимает четвёртое место с FP64-быстродействием приблизительно 442 Пфлопс. Реализацией проекта Fugaku Next займутся японский Институт физико-химических исследований (RIKEN) и корпорация Fujitsu. Создание системы начнётся в 2025 году, а завершить её разработку планируется к 2030-му. На строительство комплекса MEXT выделит ¥4,2 млрд ($29,06 млн) в первый год, тогда как общий объём государственного финансирования, как ожидается, превысит ¥110 млрд ($761 млн). MEXT не прописывает какой-либо конкретной архитектуры для суперкомпьютера Fugaku Next, но в документации ведомства говорится, что комплекс может использовать CPU со специализированными ускорителями или комбинацию CPU и GPU. Кроме того, требуется наличие передовой подсистемы хранения, способной обрабатывать как традиционные рабочие нагрузки ввода-вывода, так и ресурсоёмкие нагрузки ИИ. Предполагается, что каждый узел Fugaku Next обеспечит пиковую производительность в «несколько сотен Тфлопс» для вычислений с двойной точностью (FP64), около 50 Пфлопс для вычислений FP16 и примерно 100 Пфлопс для вычислений FP8. Для сравнения, узлы системы Fugaku демонстрирует быстродействие FP64 на уровне 3,4 Тфлопс и показатель FP16 около 13,5 Тфлопс. Для Fugaku Next предусмотрено применение памяти HBM с пропускной способностью в несколько сотен Тбайт/с против 1,0 Тбайт/с у Fugaku. По всей видимости, в состав Fugaku Next войдут серверные процессоры Fujitsu следующего поколения, которые появятся после изделий MONAKA. Последние получат чиплетную компоновку с кристаллами SRAM и IO-блоками ввода-вывода, обеспечивающими поддержку DDR5, PCIe 6.0 и CXL 3.0. Говорится об использовании 2-нм техпроцесса.

29.08.2024 [13:43], Сергей Карасёв

«К2 НейроТех» представила российские ПАК для HPC-нагрузок, ИИ и машинного обученияКомпания К2Тех объявила о формировании нового бизнес-подразделения — «К2 НейроТех», специализацией которого являются проектирование, поддержка и масштабирование суперкомпьютерных кластеров. Созданное предприятие предлагает комплексные услуги по развёртыванию суперкомпьютеров «под ключ». Кроме того, «К2 НейроТех» представила два программно-аппаратных комплекса — ПАК-HPC и ПАК-ML. Отмечается, что в штат «К2 НейроТех» вошли высококвалифицированные инженеры, разработчики и системные архитекторы. Специалисты имеют опыт проектирования и построения суперкомпьютерных систем для добывающей промышленности и машиностроительной отрасли, а также для научных и образовательных организаций. В частности, команда участвовала в создании суперкомпьютера «Оракул» на базе Новосибирского государственного университета (НГУ), который победил в конкурсе «Проект года». ПАК-HPC и ПАК-ML построены на основе российских аппаратных и программных решений из реестров Минцифры и Минпромторга. Благодаря этому, как утверждается, снижаются риски, связанные с зависимостью от зарубежных поставок, и появляются возможности для стабильной техподдержки решений и дальнейшего их масштабирования по запросу. ПАК-HPC предназначен для ускорения научных исследований и разработки в таких отраслях, как фармацевтика, добывающая промышленность и машиностроение. В свою очередь, ПАК-ML ориентирован на работу с ресурсоёмкими приложениями ИИ и машинного обучения. Конфигурация обоих комплексов включает 18 серверов на стойку. Задействовано высокоскоростное соединение NVLink/Infinity Fabric. Объём оперативной памяти варьируется от 128 до 512 Гбайт на сервер. Для хранения данных применяются SSD вместимостью 1 Тбайт и более. Версия ПАК-HPC обеспечивает пиковую производительность до 7,6 Тфлопс (FP64) на один сервер. Вариант ПАК-ML, который, судя по всему, несёт восемь ускорителей NVIDIA H100, обладает пиковым быстродействием 536 Тфлопс (FP64 Tensor Core) на сервер. Преимуществами ПАК названы: высокая производительность, гибкая конфигурация, масштабируемость, единый графический интерфейс, безопасность, надёжность и импортонезависимость. «Создание бренда "К2 НейроТех" — это логичный ответ на запросы рынка по расширению вычислительных мощностей, необходимых для внедрения ИИ и ускорения проводимых исследований в условиях импортозамещения. Мало у кого сейчас есть практический опыт по созданию систем на базе отечественного оборудования с учётом оптимизации производительности. Именно поэтому мы решили вложить наши компетенции и опыт в создание комплексного предложения по построению суперкомпьютерных кластеров и разработку двух ПАК для задач HPC и ML под единым брендом», — отмечает директор по продвижению решений «К2 НейроТех». |

|