Материалы по тегу: hardware

|

25.06.2025 [11:20], Сергей Карасёв

SSSTC выпустила SATA SSD серии CVD для интенсивной записиКомпания Solid State Storage Technology Corporation (SSSTC) анонсировала SSD семейства CVD, оснащённые интерфейсом SATA-3. Накопители оптимизированы для приложений с интенсивной и продолжительной записью информации. Это могут быть системы видеонаблюдения и видеопроизводства, потоковой передачи данных, автомобильные регистраторы и т.п. Устройства представлены в форм-факторах M.2 2280 и SFF. В обоих случаях вместимость может составлять 128, 256 и 512 Гбайт, а также 1 и 2 Тбайт. Применены чипы флеш-памяти 3D TLC NAND — изделия Kioxia BiCS FLASH пятого поколения. Скорость последовательного чтения информации достигает 500 Мбайт/с, скорость последовательной записи — 260 Мбайт/с. Величина IOPS при произвольных чтении и записи блоками по 4 Кбайт — до 50 тыс. и 75 тыс. соответственно. Накопители способны выдерживать свыше одной полной перезаписи в сутки (1 DWPD) на протяжении трёх лет. Средняя заявленная наработка на отказ (MTBF) превышает 3 млн часов. Диапазон рабочих температур простирается от 0 до +85 °C. В устройствах реализована фирменная технология SSSTC Direct Write, специально разработанная для рабочих нагрузок с интенсивной записью. Система обеспечивает запись данных непосредственно в TLC, устраняя зависимость от кеша SLC. В результате, обеспечиваются стабильная производительность (предотвращается падение скорости) и низкие задержки. По заявлениям разработчика, даже при непрерывной записи видео в высоком разрешении в режиме 24/7 накопители демонстрируют устойчивую производительность. В новинках реализована поддержка шифрования AES-256 и TCG Opal. Средства Power Loss Protection (PLP) обеспечивают сохранность данных при внезапном отключении питания. Массовое производство накопителей серии CVD уже началось.

25.06.2025 [09:04], Руслан Авдеев

Недоступность ИИ-инфраструктуры усилит цифровое, экономическое и политическое неравенство

hardware

африка

гиперскейлер

дефицит

ии

импортозамещение

информационная безопасность

исследование

китай

конфиденциальность

облако

сша

цод

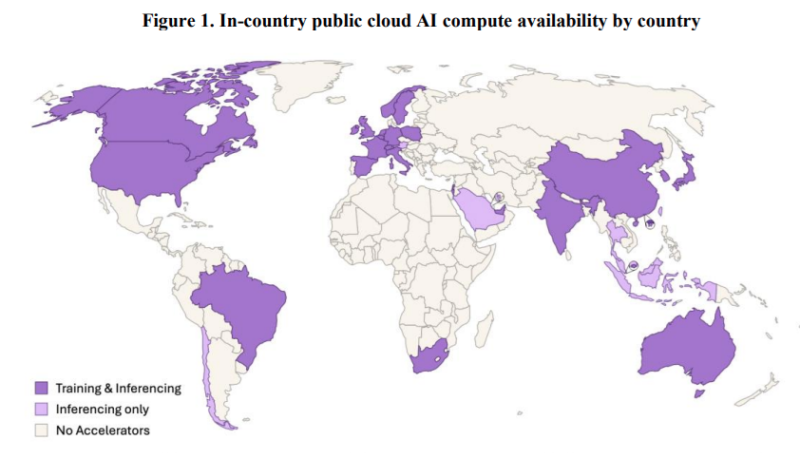

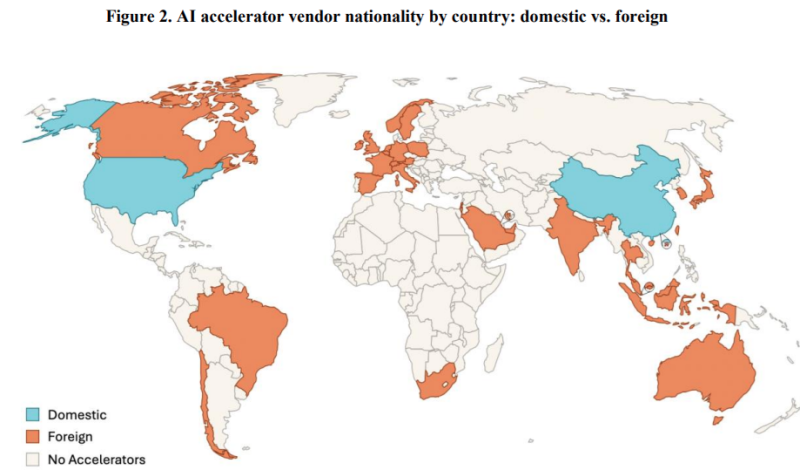

Искусственный интеллект становится основой глобальных инноваций, поэтому для развития стран наличия одних только талантов и идей мало, важно и наличие оборудование для работы с ИИ. Согласно исследованию учёных из Оксфордского университета, всего три десятка стран в мире обладают специализированными ИИ ЦОД, причём расположены они преимущественно в Северном полушарии планеты. Большинство же доступа к подобным технологиям не имеет, передаёт Tech Republic. В докладе подчёркивается, что только в США и Китае эксплуатируются более 90 % ИИ ЦОД. Американские техногиганты, включая AWS, Microsoft и Google, управляют 87 крупными ИИ ЦОД по всему миру, китайские компании — 39 площадками, а европейские — всего шестью. Африка, Южная Америка и Россия на карте фактически не отмечены, хотя в России ИИ-суперкомпьютеры есть. Кроме того, Гонконг и Тайвань посчитаны как отдельные страны. Так или иначе, более чем в 150 странах мира полноценная инфраструктура ИИ ЦОД отсутствует полностью, а без доступа к таким технологиям они рискуют отстать в освоении ИИ, в научных исследованиях и в экономическом развитии. Есть и ещё один важный фактор — технологический суверенитет. Многие государства вынужденно полагаются на мощности иностранных IT-гигантов, аренда которых обходится дорого, да и находятся они в чужой юрисдикции. Для стартапов и исследователей из ряда регионов Африки, Южной Америки и Юго-Восточной Азии это большая проблема. По словам президента Microsoft Брэда Смита (Brad Smith), эра ИИ может усугубить отставание Африки. Так, в Кении стартапы вроде Qhala разрабатывают ИИ-модели на африканских языках, но без местных ЦОД они вынуждены арендовать мощности на зарубежных серверах. Для сравнения: один только Институт Кемпнера (Kempner Institute) Гарвардского университета обладает большей вычислительной мощностью, чем все африканские ИИ-объекты вместе взятые.

Источник изображения: University of Oxford Подобное неравенство ведёт к печальным последствиям для слабых в технологическом отношении стран. Так, в Аргентине учёные жалуются на регулярный отъезд лучших студентов в США и Евросоюз для получения доступа к вычислительным мощностям. Проблема не просто техническая, поскольку без доступа к ИИ ЦОД страны лишаются инноваций, инвестиций и талантов. Например, некоторые страны открещиваются от сотрудничества с Китаем, чтобы не попасть под давление США. Впрочем, действительно и обратное — в Африке политики ведут переговоры с Huawei о переделке существующих ЦОД для размещения китайских ускорителей в попытке избавиться от зависимости от американской NVIDIA. Как отмечают исследователи, в недалёком будущем производители вычислительной техники смогут получить влияние, сопоставимое с тем, какое имеют поставщики нефти.

Источник изображения: University of Oxford Для того, чтобы преодолеть цифровое неравенство, Индия субсидирует создание собственной суверенной ИИ-инфраструктуры, Бразилия намерена выделить на аналогичные задачи $4 млрд, а Евросоюз готовится инвестировать €200 млрд. В Африке местный бизнес продвигает проект строительства пяти ЦОД стоимостью $500 млн, хотя даже это удовлетворит лишь малую часть запросов. Если раньше цифровое неравенство выражалось в неравномерном доступе к телефонным линиям или интернету, то теперь речь идёт о том, кто контролирует ИИ-инфраструктуры или распределение поставок её компонентов. Разрыв не только технологический, но и экономический и даже политический.

24.06.2025 [17:02], Руслан Авдеев

Нью-Йорк построит гигаваттную АЭС для ИИ ЦОД и других отраслей — крупнейший в стране проект за 15 летШтат Нью-Йорк принял решение построить в США первую за 15 лет новую атомную электростанцию гигаваттного класса. Проект будет реализован на фоне растущего спроса на электроэнергию, особенно со стороны ИИ ЦОД, сообщает The Register. Профильным ведомствам поручено найти подходящую для строительства площадку в северной части штата и утвердить дизайн самих реакторов. Проект предусматривает добавление как минимум 1 ГВт генерации. Пока не указаны ни дата ввода АЭС в эксплуатацию, ни стоимости проекта. В штате уже есть 219 дата-центров и их количество, вероятно, увеличится, поскольку бизнес спешит нарастить мощности на фоне бума энергоёмких ИИ-технологий. Помимо растущего спроса, играют роль и относительно недавние события. В 2021 году АЭС Indian Point, расположенная приблизительно в 58 км к северу от города Нью-Йорка, остановила два своих последних реактора, в результате чего мегаполис фактически лишился четверти доступной ему электроэнергии. В прошлогоднем отчете Bain & Company предупреждала, что поставщикам энергии в США нужно быстро адаптироваться к растущему спросу на электричество, поскольку прогнозируется, что в следующие несколько лет потребление электроэнергии превысит предложение. Срочность усугубляется и тем, что проектируемые АЭС, способные удовлетворить растущие потребности сразу нескольких отраслей, начнут работать не раньше следующего десятилетия, а больше энергии требуется уже сейчас.

Источник изображения: Vardan Papikyan/unsplash.com Президент США подписал указ о четырёхкратном увеличении атомных мощностей в мае 2025 года — со 100 ГВт до 400 ГВт к 2050 году. Это случилось после того, как группа ключевых потребителей энергии, включая Amazon (AWS), Meta✴ и Google призвала утроить глобальную генерацию атомной энергии к тому же времени. Недавно Amazon завершила сделку по покупке атомной энергии в Пенсильвании в обход прежних ограничений, поскольку компания планирует построить много новых облачных и ИИ ЦОД. На этом фоне энергокомпания Constellation приветствовала новость о желании властей Нью-Йорка добавить атомных мощностей в энергосистему штата. В компании подчёркивают, что речь идёт о новом признании важности ядерной энергетики в достижении ключевых целей страны в области «чистой» энергии. Сама Constellation подписала с Microsoft договор о перезапуске АЭС Three Miles Island. Недавно американский регулятор North American Electric Reliability (NERC), отвечающий за надзор за электросетями, заявил, что подключение к ним новых ЦОД пока весьма рискованно из-за нестабильности их энергопотребления. Bloom Energy объявила, что к 2030 году более четверти ЦОД в США обзаведутся собственными электростанциями.

24.06.2025 [16:15], Руслан Авдеев

400-кВт ЦОД Deep Green будет отапливать бассейн развлекательного центра в МанчестереDeep Green, внедряющая небольшие дата-центры при бассейнах, намерена развернуть объект близ Манчестера (Великобритания). Компания разместит оборудование на 400 кВт на площади 150 м2 в развлекательном центре Move Urmston в районе Урмстон (Urmston, Большой Манчестер), сообщает Datacenter Dynamics. Тепло дата-центра будет использоваться для подогрева воды. Система будет использовать комбинацию прямого жидкостного охлаждения и воздушное охлаждение. ЦОД получит восемь стоек мощностью до 60 кВт каждая, размещённых в контейнере. Целевой PUE — не более 1,2. В Deep Green подчеркнули, что ЦОД не просто обеспечит развлекательный центр теплом на десятки тысяч фунтов, но и позволить сократить углеродные выбросы на сотни тонн. Deep Green размещает HPC-серверы в местах, где их тепло можно будет использовать в полной мере. Само тепло предлагается пользователям, в том числе плавательным бассейнам, бесплатно. Деятельность Deep Green началась в 2023 году, первое вычислительное оборудование было размещено в развлекательном центре в Эксмуте (Exmouth, Девон). Клиентами Deep Green уже являются британский облачный провайдер Civo и постпродакшн-компания Dirty Looks. Инвестором Deep Green является британская коммунальная компания Octopus Energy. На сайте компании сообщается, что у неё уже есть один действующий объект, три в стадии строительства и один — в стадии планирования.

Источник изображения: David Romualdo/unsplash.com Уже действует объект DG03 в Суиндоне (Swindon, Уилтшир) на 1,1 МВт. Описываемый выше 400-кВт ЦОД DG01 в Манчестере пока строится, как и ещё один объект на 500 кВт — DG02 в Йорке (York, Норт-Йоркшир). Более крупный 4-МВт ЦОД возводится в Брэдфорде (Bradford, Уэст-Йоркшир). Ещё один объект на 20 МВт планируется построить в Линкольне (Lincoln, Линькольншир), но официальных подробностей пока немного. Также планируется дата-центр DG06 мощностью более 20 МВт, который расположится в Лансинге, столице американского штата Мичиган. Всего Deep Green намерена развернуть 300 МВт в Европе и США. Схожие решения создаёт французская компания Qarnot. В Великобритании производитель «цифровых бойлеров» Heata и облачный оператор Civo уже предлагают устанавливать серверы для отопления зданий. А Aventuur планирует обогревать аквапарк в Новой Зеландии теплом дата-центра, питающегося от солнечных элементов. При этом ещё в 2023 году сообщалось, что на практике такие решения дороги, а иногда и вовсе бессмысленны.

24.06.2025 [16:11], Руслан Авдеев

OpenAI ищет управляющего энергетической политикойКомпания OpenAI ищет специалиста по энергетической политике. Должность в первую очередь предусматривает взаимодействие с федеральными властями и руководством отдельных штатов для продвижения энергетических интересов компании в США, сообщает Datacenter Dynamics. В новом объявлении на сайте OpenAI объявляется, что роль сотрудника связана с разработкой позиций и стратегий компании по ключевым вопросам энергетики, включая генерацию и потребление энергии, развитие возобновляемых источников, надёжность энергосетей, вопросы присоединения и регулирования, а также устойчивость инфраструктуры — для обеспечения экобезопасного и эффективного функционирования технологий компании. Роль предполагает выстраивание внутренних коммуникаций в компании, а также контакты с Министерством энергетики (DoE), регулятором FERC и другими госорганами, региональными сетевыми операторами вроде ERCOT, коммунальными службами, экозащитниками и партнёрами в сфере «чистой» энергии. Хотя основное внимание сотрудника должно уделяться внутриамериканским задачам, он также будет играть и ключевую роль в поддержке энергетической стратегии компании в международном контексте.

Источник изображения: LinkedIn Sales Solutions/unsplash.com На позицию могут претендовать кандидаты с 10–15 годами опыта работы, связанной с выстраиванием энергетической политики, инфраструктуры или устойчивого развития. В том числе рассматриваются бывшие государственные служащие, сотрудники коммунальных, энергетических компаний и т.п. Успешный соискатель может рассчитывать на компенсацию $280–$325 тыс. ежегодно и акционерный капитал. Как сообщает Datacenter Dynamics, вероятно, новый сотрудник поможет реализовать проект Stargate. Проект оценивается в $100-500 млрд и предусматривает строительство дата-центров в США и других странах, например, в ОАЭ и открытие офисов, в частности, в Южной Корее. Stargate, по сути, представляет собой комбинацию облачных контрактов, партнёрств и самостоятельных инициатив OpenAI. Что касается требуемых мощностей, в каждом случае необходима разная степень участия компании. Если проект будет реализован, его крупнейшие кампусы будут потреблять по 1–2 ГВт, что потребует тщательного планирования в сфере энергетики.

24.06.2025 [11:42], Сергей Карасёв

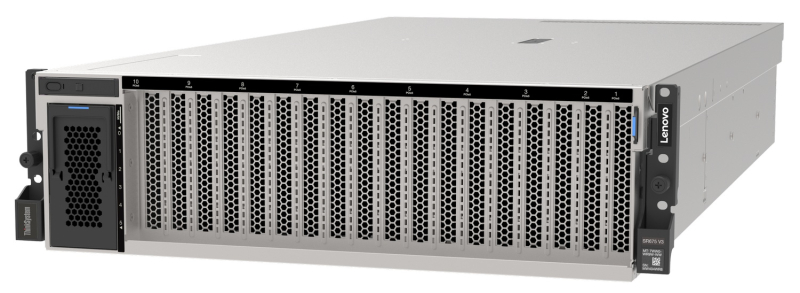

Lenovo анонсировала новые системы для дата-центров, оптимизированные для ИИКомпания Lenovo анонсировала новые гибридные платформы, оптимизированные для решения ресурсоёмких ИИ-задач в дата-центрах. Представлены системы различного уровня, созданные в партнёрстве с NVIDIA, Cisco и IBM. В частности, дебютировала модель ThinkSystem SR680a V4 на аппаратной платформе Intel. Полностью характеристики платформы не раскрываются. Известно, что применены процессоры семейства Xeon 6, в которое входят изделия на основе энергоэффективных E-ядер (Sierra Forest) и производительных P-ядер (Granite Rapids). Система несёт на борту восемь ускорителей NVIDIA Blackwell B200, а также восемь карт NVIDIA SuperNIC и NVIDIA BlueField-3 DPU. Утверждается, что по сравнению с серверами предыдущего поколения модель ThinkSystem SR680a V4 обеспечивает семикратный рост вычислительной производительности, тогда как объём памяти увеличился в четыре раза. Скорость инференса при работе с большими языковыми моделями (LLM) поднялась приблизительно в 11 раз. Кроме того, Lenovo представила ИИ-систему Hybrid AI на платформе IBM watsonx. В основу этого решения положены серверы Lenovo ThinkSystem SR675 (V3), оснащённые системой жидкостного охлаждения Neptune. Ещё одна система Lenovo Hybrid AI создана в партнёрстве с Cisco: она объединяет коммутаторы Cisco Nexus с технологией NVIDIA Spectrum-X для ускорения развёртывания ИИ-фабрик на предприятиях. Задействован сервер ThinkSystem SR675 V3, который может содержать до восьми ускорителей NVIDIA RTX Pro 6000 Blackwell Server Edition. Говорится о поддержке карт NVIDIA SuperNIC и NVIDIA BlueField-3 DPU. Платформа призвана ускорить переход организаций от ИИ-вычислений на базе CPU к средам на основе GPU.

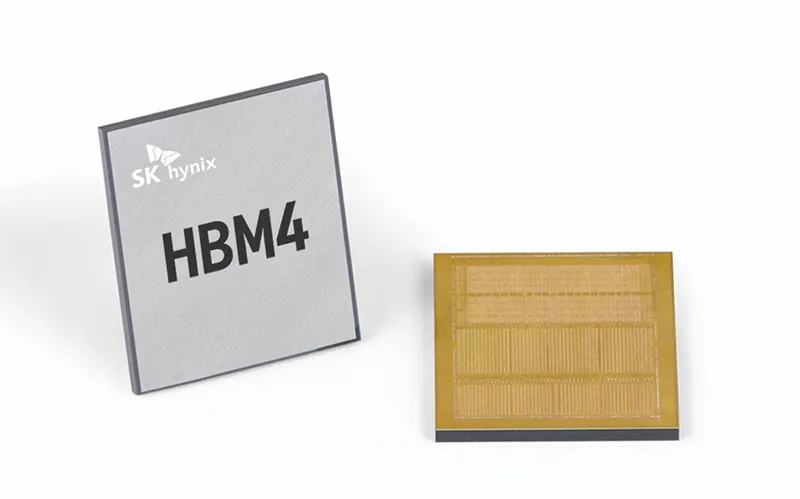

23.06.2025 [16:53], Владимир Мироненко

SK hynix выпустит кастомную HBM4E-память для NVIDIA, Microsoft и BroadcomСогласно данным The Korea Economic Daily, южнокорейская компания SK hynix заключила контракты на поставку кастомной памяти HBM с NVIDIA, Microsoft и Broadcom, опередив конкурента Samsung Electronics на рынке кастомной HBM, который, по прогнозам TrendForce и Bloomberg Intelligence к 2033 году вырастет до $130 млрд с $18,2 млрд в 2024 году. Ожидается, что поставки SK hynix кастомных чипов начнутся во второй половине 2025 года. По данным отраслевых источников, Samsung также ведёт переговоры с Broadcom и AMD о поставках кастомной HBM4. Ранее, в ходе квартального отчёта в апреле компания сообщила, что начнёт поставки памяти HBM4 в I половине 2026 года. Для наращивания производства HBM и передовой памяти DRAM компания SK hynix переоборудовала свой завод M15X в Чхонджу (Cheongju), изначально предназначенный для производства флеш-памяти NAND. Объём запланированных инвестиций составляет ₩20 трлн ($14,5 млрд). Кастомные HBM, предназначенные для удовлетворения конкретных потребностей клиентов, пользуются всё большим спросом, поскольку крупные технологические компании, стремясь оптимизировать производительность своих ИИ-решений, отказываются от использования универсальной памяти. О заключении контрактов стало известно примерно через 10 месяцев после того, как SK hynix объявила о получении запросов на поставку кастомной HBM от «Великолепной семёрки»: Apple, Microsoft, Google, Amazon, NVIDIA, Meta✴ и Tesla.

Источник изображения: SK hynix По словам источника The KED в полупроводниковой отрасли, «учитывая производственные мощности SK hynix и сроки запуска ИИ-сервисов крупными технологическими компаниями, удовлетворить все запросы “Великолепной семёрки” не представляется возможным». Тем не мене, он допустил, что SK hynix с учётом условий рынка может заключить контракты ещё с несколькими клиентами. Ранее SK hynix сообщила, что с поколением HBM4E она полностью перейдет на модель индивидуального производства. Текущее массовое внедрение сосредоточено вокруг HBM3E, а отрасль готовится в ближайшем будущем к переходу на шестое поколение памяти HBM — HBM4. По словам источников, выпуск кастомной памяти седьмого поколения HBM4E компания освоит во II половине 2026 года, а массовое производство HBM4 начнёт во второй II 2025 года. Начиная с HBM4, логические кристаллы для памяти SK hynix выпускает TSMC, поскольку усовершенствованный чип требует более продвинутых техпроцессов. До этого компания обходилась собственными мощностями. По данным TrendForce, SK hynix контролирует половину мирового рынка HBM, за ней следуют Samsung и Micron с долями рынка в размере 30 % и 20 % соответственно.

23.06.2025 [16:14], Руслан Авдеев

3data модернизировала московский ЦОД «М8», добавив мощности для колокейшн-клиентов3data объявила об успешной модернизации дата-центра «М8», находящегося на севере Москвы. Благодаря обновлению инфраструктуры ЦОД увеличилась энергоэффективность площадки — для колокейшн-клиентов высвободилось порядка 15 % дополнительной мощности, сообщает пресс-служба компании. По словам 3data, ЦОД «М8» стал первым объектом в сети компании, прошедшим «глобальную комплексную модернизацию». С момента ввода в эксплуатацию в 2014 году дата-центр отработал более 10 лет без значимых инцидентов. Обновление площадки своевременно, поскольку в Москве наблюдается дефицит свободных мощностей.

Источник изображения: 3data Модернизацию провели в несколько этапов для обеспечения непрерывности работы. На первой стадии внимание уделили системе безопасности проекта — доработали видеонаблюдение и СКУД. На следующем этапе за три дня заменили ИБП, установив три модульных ИБП по 100 кВА компании «ИМПУЛЬС». Во время проведения работ ЦОД обеспечили резервным питанием от дизельного генератора. Дополнительно заменили массивы аккумуляторов B.B.BATTERY и увеличили количество АКБ. В результате время автономной работы оборудования ЦОД выросло до 17 мин.

Источник изображения: 3data В мае 2025 года была модернизирована система кондиционирования: полная замена коснулась фреонопроводов, ресиверов, внешних блоков кондиционеров. Внутренние блоки планируется заменить в ближайшие три-четыре месяца. Предполагается, что такая замена позволит сохранить надёжность и увеличить производительность системы охлаждения. В результате клиенты смогут получить больше мощностей для своего серверного оборудования. Система холодоснабжения Stulz будет заменена на более современный и производительный вариант.

Источник изображения: 3data По словам компании, плановая модернизация объектов позволяет значительно усовершенствовать технические возможности ЦОД с учётом требований времени к отказоустойчивости и плотности размещения оборудования. Сейчас у 3data в России есть сеть из 24 ЦОД уровня Tier III. В ближайшие годы планируется поэтапная модернизация и других её объектов для повышения производительности и эффективности.

23.06.2025 [13:48], Руслан Авдеев

xAI воспользуется облаком Oracle для обучения и инференса GrokOracle частично раскрыла список компаний, использующих облачную инфраструктуру Oracle Cloud Infrastructure (OCI) для обучения ИИ-моделей и инференса. В их числе, несмотря на наличие собственных мощностей, оказался и стартап Илона Маска (Elon Musk) xAI, сообщает Datacenter Dynamics. xAI намерена использовать ИИ-инфраструктуру OCI для обучения моделей нового поколения, стоящих за чат-ботом Grok. Кроме того, OCI будет применяться и для инференса в интересах xAI. Также модели будут предлагаться через ИИ-сервис OCI, предлагающий доступ к моделям генеративного ИИ. По словам представителей xAI, Grok 3 знаменует собой прорыв в возможностях ИИ, а платформа Oracle ускорит его внедрение в корпоративном секторе. У xAI есть собственный ИИ-суперкомпьютер Colossus, который будет расширяться. Компания также намерена построить ещё один ЦОД. Правда, xAI столкнулась с судебным иском, связанным с увеличением мощности импровизированной электростанции из газовых генераторов.

Источник изображения: xAI Помимо xAI клиентами Oracle является множество других компаний. Как сообщил облачный оператор, в их число входят Fireworks AI, Hedra, Numenta, Soniox и даже Meta✴, у которой тоже есть собственные вычислительные мощности. Представители OCI подчёркивают, что площадка является предпочтительным местом для обучения и инференса в любых масштабах. ИИ-инфраструктура OCI обеспечивает доступ к сверхскоростной сети, «оптимизированному» хранилищу и передовым ускорителям, на которые клиенты полагаются для очередных инноваций. Кроме того, Oracle является участником проекта Stargate.

23.06.2025 [12:51], Руслан Авдеев

Бум ИИ-технологий заставляет Wistron оперативно масштабировать производство серверовСпрос на ИИ-технологии в мире по-прежнему остаётся устойчивым, а перспективы отрасли — весьма благоприятными. Президент и генеральный директор Wistron Джефф Лин (Jeff Lin) объявил, что большинство клиентов размещают долгосрочные 12-месячные заказы на оборудование компании и востребованность её продуктов останется высокой до мая 2026 года, сообщает DigiTimes. По словам директора, недавно введённый в эксплуатацию AI Smart Campus Wistron в Чжубэе (Zhubei), вероятно, уже столкнётся с дефицитом мощностей в 2026 году. Открытие кампуса, одновременно являющегося новой штаб-квартирой компании для глобальных операций, состоялось 19 июня. На мероприятии присутствовал ряд руководителей Wistron, а также представители поставщиков разных уровней. Глава NVIDIA Дженсен Хуанг (Jensen Huang), чья компания является ключевым клиентом Wistron, прислал специальное видеопоздравление. В интервью после мероприятия Джефф Лин сообщил, что новый объект будет использоваться для выпуска ИИ-серверов. Пока осуществляется монтаж оборудования, а производство начнётся после его установки. Исходя из текущих заказов ожидается, что завод выйдет на полную мощность к 2026 году. В феврале Wistron объявила, что для удовлетворения растущего спроса компания подписала договор с компанией Lien Fa Textile на аренду объекта площадью 56 тыс. м2. Он послужит дополнительной площадкой для выпуска ИИ-серверов. Аренда на 10 лет обойдётся не дороже NT$2,503 млрд ($84 млн).

Источник изображения: Wistron Хотя конкретики о параметрах масштабирования кампуса в Чжубэе немного, известно, что с использованием нового арендованного объекта Wistron рассчитывает существенно расширить производство на Тайване. В конце прошлого года уже сообщалось о намерении Wistron расширить мировое присутствие и укрепить производство ИИ-серверов. Линь признал, что загрузка производственных мощностей произошла неожиданно быстро, заставив компанию активно расширяться. Теперь у неё три производственных площадки в Синьчжу (Hsinchu), увеличиваются штаты исследователей и разработчиков, а также специалистов по продажам. Кроме того, новый головной офис в Тайбэе (Taipei) достроят к 2027 году, но действующий офис в Сичжи (Xizhi) пока сохранят из-за нехватки свободных площадей. Что касается производства ИИ-серверов за пределами Тайваня, небольшие партии выпускаются лишь в Техасе. Завод выпускает те же модели серверов, что и кампус в Чжубэе, предполагается расширить производство в 2026 году. Компания уже сообщала выделить на расширение производства в США $50 млн. На вопрос журналистов о возможности переноса выпуска вычислительной техники в США, Лин сообщил, что некоторые клиенты запросили подготовку технико-экономического обоснования. Впрочем, такие обсуждения пока находятся на ранней стадии и никакие решения ещё не приняты. При этом планирование цепочки поставок заметно усложнилось, поскольку приходится учитывать неопределённость тарифной политики США. |

|