Материалы по тегу: hardware

|

25.03.2024 [21:23], Владимир Мироненко

Samsung поставит Naver ИИ-ускорители Mach-1 на $752 млнКомпания Samsung Electronics поставит в этом году ведущей южнокорейской интернет-компании Naver Corp. ИИ-ускорители Mach-1 следующего поколения собственной разработки. Сумма контракта составит до ₩1 трлн (около $752 млн), сообщил ресурс KED Global со ссылкой на отраслевые источники. Это позволит Naver значительно сократить зависимость от поставок ускорителей NVIDIA. В октябре прошлого года Naver вынужденно стала использовать процессоры Intel Xeon вместо ускорителей NVIDIA. Смена оборудования Naver происходит на фоне роста недовольства технологических компаний увеличением цен на ускорители NVIDIA и их глобальной нехваткой. По словам Samsung, Mach-1 был разработан для поддержки Transformer-моделей и позволяет выполнять инференс больших языковых моделей (LLM) даже с маломощной памятью вместо энергоёмкой HBM, что делает его в восемь раз энергоэффективнее традиционных ускорителей на базе GPU. При этом Mach 1 на порядок дешевле чипов NVIDIA. По словам источников, бизнес-подразделение Samsung System LSI и Naver находятся в заключительной стадии переговоров о поставке 150–200 тыс. ИИ-ускорителей Mach-1, цена которых может составить ₩5 млн ($3756) за штуку. Цены и точный объём поставок пока не согласованы. Сообщается, что Naver будет использовать Mach-1 для инференса вместо ускорителей NVIDIA в картографическом сервисе AI Naver Place. Naver готова покупать эти чипы и в дальнейшем, если первая партия покажет «хорошую производительность», отметили источники, по словам которых Samsung также ведёт переговоры о поставках Mach-1 с Microsoft и Meta✴.

Источник изображения: Samsung Для Samsung сделка с Naver важна с точки зрения конкуренции с SK hynix, доминирующей в сегменте памяти HBM, спрос на которую в связи с популярностью генеративного ИИ резко вырос. Samsung сообщила о разработке первой в отрасли памяти HBM3E 12-Hi, массовое производство которой начнётся в I половине этого года. Кроме того, SK Group поддерживает разработку ИИ-ускорителей Sapeon, а Samsung сотрудничает с Rebellions. По оценкам Omdia, глобальный рынок ИИ-ускорителей вырастет с $6 млрд в 2023 году до $143 млрд к 2030 году.

25.03.2024 [18:12], Руслан Авдеев

Генеративный ИИ и HAMR станут драйверами роста рынка HDDВ своё время технология 3D NAND немало способствовала росту плотности записи и повышению ёмкости SSD. DigiTimes сообщает, что обычные жёсткие диски, в последнее время всё чаще заменяемые твердотельными альтернативами, могут получить второе дыхание благодаря развитию генеративного ИИ и внедрению техники термомагнитной записи (HAMR). Разработка Seagate Technology, по некоторым оценкам, способна дать ежегодный рост плотности записи HDD на уровне 20 %. По данным японского исследовательского института Techno System Research (TSR), мировые поставки HDD достигли пика в 2010 году, составив 650 млн единиц. С тех пор поставки поступательно уменьшались, в 2023 году упав до 120 млн единиц — более 500 млн «потерянных» HDD заменили SSD. Правда, суммарная ёмкость жёстких дисков продолжает расти, несмотря на снижение отгрузок в штуках. Вместе с тем HDD всё ещё выгоднее SSD по соотношению цена/ёмкость, особенно для накопителей nearline-класса. По данным Nikkei, в 2023 году у HDD цена за гигабайт составляла $0,013, а SSD большой ёмкости — на уровне $0,123/Гбайт, т.е. в 9,5 раз больше, чем HDD. По оценкам IDC, для хранения данных генеративного ИИ потребуется средний ежегодный прирост ёмкости накопителей на уровне около 20 %. Если компания ограничена в средствах, она предпочтёт HDD именно из-за более выгодного соотношения цена и ёмкости. Есть и ещё один фактор — сегодня на строительство каждого ЦОД уходит $1–1,5 млрд, а затраты на электроэнергию составляют $10–100 млн ежегодно. Однако технология PMR актуальна только для жёстких дисков относительно небольшой ёмкости, а более прогрессивные ePMR от Western Digital (WD) и FC-MAMR от Toshiba показывают ежегодный рост плотности примерно на 8 %, пишет DigiTimes. В 2021 году Toshiba предложила технологию MAS-MAMR, позволяющую поднять максимальную ёмкость HDD до 30 Тбайт и дополнительно снизить энергопотребление в пересчёте на Тбайт, что позволило бы модернизировать уже действующие дата-центры. Seagate же готова начать производство HAMR HDD ёмкостью более 30 Тбайт, в 2025 году она намерена выпустить HDD на 40 Тбайт, а в 2027–2028 гг. ёмкость её накопителей превысит 50 Тбайт. В результате у жёстких дисков действительно откроется второе дыхание к концу десятилетия. Впрочем, Pure Storage прогнозирует, что к этому моменту жёсткие диски, напротив, будут полностью вытеснены SSD благодаря энергоэффективности последних. А спрос на ИИ только подстегнёт замену. Не будут испытывать проблем, похоже, только LTO-библиотеки.

25.03.2024 [15:07], Руслан Авдеев

AWS намерена вложить $5,8 млрд в строительство ЦОД в Южной Корее и уже приобрела участок для первого объектаГиперскейлер Amazon Web Services (AWS) приобрёл земельный участок для строительства дата-центра в Южной Корее и уже получил разрешение на возведение соответствующего объекта. По данным TelecomPaper, покупкой занималось дочернее подразделение — Amazon Corporate Services Korea. И это только часть масштабного плана инвестиций в ЦОД на территории страны. По имеющимся сведениям, дочернее предприятие Amazon приобрело землю и другую недвижимость в окрестностях города Инчхон — разрешение на строительство получено недавно. ЦОД будет занимать площадь 32,475 м2 — речь идёт о комплексе высотой в семь этажей общей ёмкостью около 100 МВт. Кампус будет включать четыре дата-центра, а также телекоммуникационную площадку. Общий план AWS значительно масштабнее. Ещё в прошлом году компания заявила о намерении вложить в местную облачную инфраструктуру ₩7,85 трлн (более $5,8 млрд) в течение 5 лет, а таже сформировать 12,3 тыс рабочих мест. Теперь же сообщается, что AWS завершила подготовку подробного проекта кампуса ЦОД и начала выбирать подрядчика, готового взяться за непосредственную реализацию проекта. Amazon эти сообщения не комментирует. Это не единственный масштабный проект, связанный со строительством дата-центров в Южной Корее. В феврале 2024 года появилась информация о намерении создать в стране кластера из 50 ЦОД общей ёмкостью 1 ГВт, по 20 МВт каждый.

24.03.2024 [02:19], Сергей Карасёв

WEKApod для SuperPOD: WekaIO представила платформу хранения данных для ИИ-кластеров NVIDIAКомпания WekaIO, разработчик решений для хранения данных, анонсировала высокопроизводительное All-Flash хранилище WEKApod, оптимизированное для работы с платформой NVIDIA DGX SuperPOD на базе NVIDIA DGX H100. Новинка объединяет специализированное ПО WekaIO и «лучшее в своем классе оборудование». Хранилище WEKApod спроектировано для ресурсоёмких нагрузок ИИ. Базовая конфигурация состоит из восьми 1U-узлов, обеспечивающих суммарную вместимость в 1 Пбайт. Показатель IOPS (операций ввода-вывода в секунду) достигает 18,3 млн. Заявленная пропускная способность при чтении составляет до 720 Гбайт/с, при записи — до 186 Гбайт/с. Утверждается, что восемь узлов WEKApod обеспечивает производительность, необходимую для 128 систем NVIDIA DGX H100. При этом WEKApod может масштабироваться до сотен узлов блоками по четыре узла. Таким образом, можно сформировать систему необходимой вместимости с высокой отказоустойчивостью для обучения больших языковых моделей (LLM), ИИ-приложений, работающих в реальном времени, и пр.

Источник изображения: WekaIO Отмечается, что архитектура WEKApod обеспечивает снижение энергопотребления благодаря оптимальному использованию пространства, улучшенному охлаждению и средствам энергосбережения в режиме простоя. В результате, достигается потенциальное сокращение углеродного следа до 260 т/Пбайт. WEKApod использует адаптеры NVIDIA ConnectX-7 и NVIDIA Base Command Manager для мониторинга и управления. Каждый из узлов несёт на борту процессор AMD EPYC 9454P (48C/96T; 2,75–3,80 ГГц; 290 Вт) и 384 Гбайт памяти DDR5-4800. Есть посадочные места для 14 накопителей формата E3.S с интерфейсом PCIe 5.0. Производительность в расчёте на узел достигает 90 Гбайт/с при чтении и 23,3 Гбайт/с при записи, а величина IOPS равна 2,3 млн при произвольном чтении и 535 тыс. при произвольной записи.

24.03.2024 [02:06], Сергей Карасёв

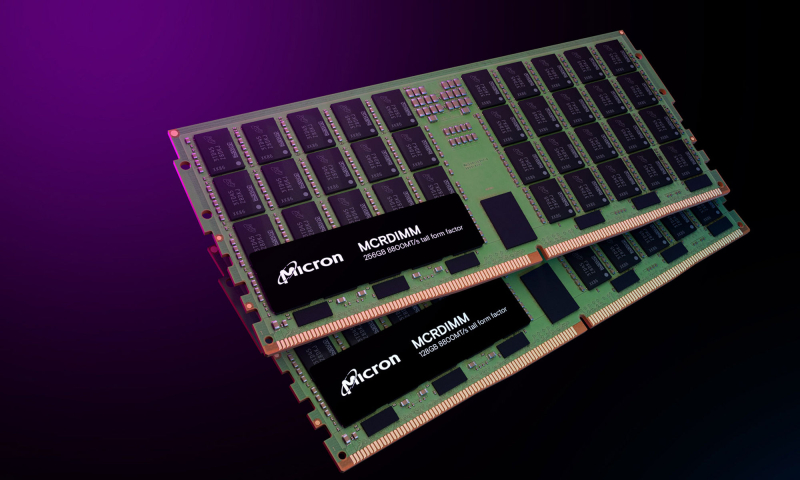

Micron показала модули памяти MCR DIMM DDR5-8800 ёмкостью 256 ГбайтКомпания Micron, по сообщению ресурса Tom's Hardware, продемонстрировала на конференции NVIDIA GTC 2024 модули оперативной памяти MCR DIMM ёмкостью 256 Гбайт для серверов следующего поколения, в том числе для систем, построенных на процессорах Intel Xeon Granite Rapids. Модули имеют увеличенную высоту, но Micron также намерена выпустить варианты стандартной высоты для серверов типоразмера 1U. Изделия соответствуют стандарту DDR5-8800. С каждой стороны модуля расположены по 40 чипов памяти. Заявленное энергопотребление изделия составляет 20 Вт, тогда как у RDIMM объёмом 128 Гбайт при использовании профиля DDR5-4800 оно равно 10 Вт. Новые изделия Micron позволяют оснащать серверы 3 Тбайт памяти при наличии 12 слотов ОЗУ и 6 Тбайт при наличии 24 слотов. MCR DIMM использует специальный буфер между DRAM и CPU, который позволяет двум физическим рангам функционировать так, как если бы они были двумя отдельными модулями памяти, работающими параллельно. Это позволяет извлекать из памяти вдвое больше данных за каждый такт, а также увеличить скорость обмена информацией с CPU. Таким образом, можно одновременно поднять и ёмкость, и производительность памяти. SK hynix также поддерживает MCR DIMM, а вот AMD и JEDEC готовят альтернативный стандарт MRDIMM, который тоже поддерживает создание высокоёмких модулей DDR5-8800. Впрочем, концептуально оба решения восходят к OMI/DDIMM от IBM и даже FB-DIMM.

24.03.2024 [01:23], Руслан Авдеев

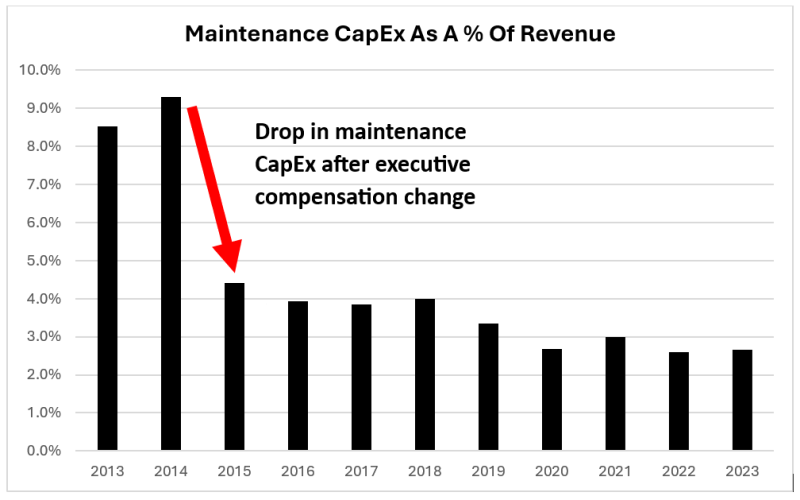

Equinix, одного из крупнейших операторов ЦОД, обвинили в подтасовке бухгалтерской отчётности и продаже несуществующих мощностейАналитическая компания Hindenburg Research обвинила одного из крупнейших в мире операторов ЦОД Equinix, который владеет более 260 объектами по всему миру, в манипуляциях с бухгалтерской отчётностью. По данным Datacenter Dynamics, речь идёт и о недостоверной трактовке фактов и, как сообщают СМИ, продаже клиентам «несбыточных мечтаний» об ИИ. Заявления Hindenburg поднимают вопросы, касающиеся будущего Equinix, извлекавшей определённые выгоды из рыночных ожиданий того, что ИИ-компаниям понадобится больше дата-центров большей ёмкости. После публикации отчёта акции компании упали в цене, а ранее планировавшийся выпуск облигаций был отложен. Equinix, чья рыночная капитализация составляет $80 млрд, заявила, что знает о докладе и сейчас изучает претензии.

Источник изображения: Equinix В Hindenburg заявляют, что REIT-фонд Equinix сразу после формирования в 2015 году начал использовать в отчётности показатели скорректированных фондов от операционной деятельности (AFFO) — ключевую метрику прибыльности таких структур, которая учитывает регулярные затраты на обслуживание. В том же году появились данные о значительном снижении расходов на обслуживание, что как раз приводит к завышению AFFO. Только в 2023 году показатели AFFO предположительно были завышены на 22 %. Отчасти речь идёт о прямом подлоге — регулярные работы по обслуживанию и модернизации систем представляются как капитальные инвестиции в развитие. Например, речь может идти о модификации серийных номеров на восстановленном оборудовании, чтобы представить его как новое, а рутинная замена батарей классифицируется как «замена аккумуляторной системы». Выяснилось, что подобные манипуляции привели к увеличению AFFO на $3 млрд с 2015 года, а также выплате топ-менеджменту бонусов акциями на сумму $295,8 млн. Более того, Hindenburg обвиняет Equinix в продаже ёмкостей, которых у оператора фактически нет, поскольку он рассчитывает, что клиенты всё равно не будут использовать все выкупленные ресурсы на 100 %. Hindenburg в комментарии Bloomberg отмечает, что на фоне эйфории, связанной с ИИ, Equinix кажется инвесторам ключевым бенефициаром этого сегмента, тогда как на деле верно обратное — ИИ представляет риск для бизнеса Equinix, поскольку оператор уже ограничен в доступных энергетических мощностях. В Hindenburg подчёркивают и угрозу, связанную с переходом многих финансовых институтов из ЦОД Equinix в облака. Речь идёт о биржах Nasdaq, CME Group, Deutsche Boerse и Лондонской фондовой бирже. Хотя у Equinix имеются решения для гиперскейлеров, на их долю приходится менее 1 % выручки. Впрочем, в Equinix уверены в наличии долгосрочных возможностей и соответствии требованиям клиентов, рассчитывающих на цифровую трансформацию и внедрение распределённой, гибридной и мультиоблачной инфраструктуры.

23.03.2024 [22:42], Сергей Карасёв

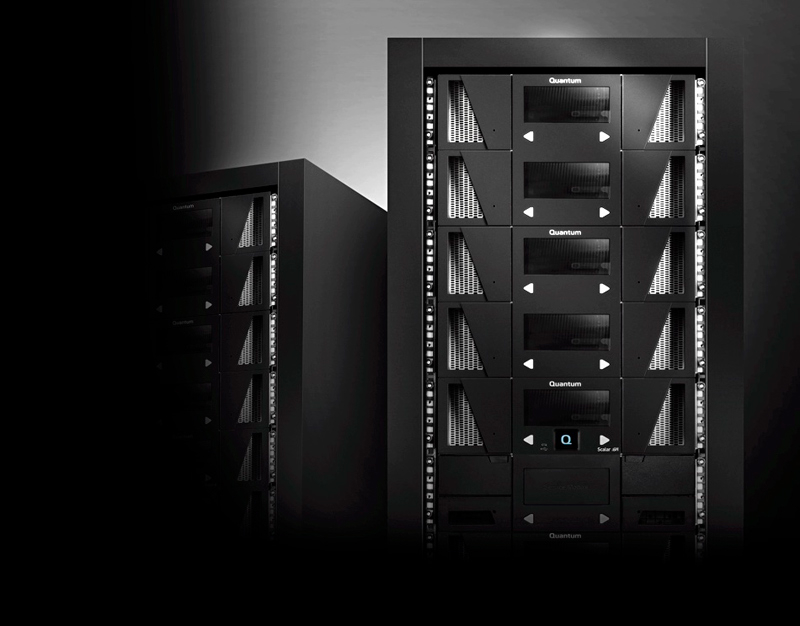

Quantum представила ленточную библиотеку Scalar i7 Raptor для ИИ-приложенийКомпания Quantum анонсировала ленточную библиотеку Scalar i7 Raptor, ориентированную на гиперскейлеров и крупных корпоративных заказчиков. Решение предназначено для работы в том числе с ИИ-приложениями, оперирующими большими объёмами данных. Разработчик заявляет, что на сегодняшний день Scalar i7 Raptor — это самое плотное и наиболее масштабируемое ленточное хранилище на рынке. Новинка предоставляет заказчикам «экономичную, экологичную и безопасную платформу» для формирования озёр данных, а также частных и гибридных облачных систем. Благодаря высокой плотности хранения информации клиенты могут снизить затраты на инфраструктуру, пространство в дата-центре, питание, охлаждение, обслуживание и администрирование. Реализованы функции защиты от программ-вымогателей, такие как блокировка ленты. Средства аналитики на базе ИИ позволяют прогнозировать возможные сбои и повышать общую производительность. В результате, улучшается доступность и минимизируется возможное время простоя.

Источник изображения: Quantum Scalar i7 Raptor интегрируется с ActiveScale — системой объектного S3-хранилища Quantum. Утверждается, что решение отличается самым низким в отрасли энергопотреблением и использует экологически чистые материалы и процессы на протяжении всего жизненного цикла: от производства и доставки до эксплуатации, технического обслуживания и утилизации. Кроме того, говорится об упрощённом развёртывании. Технические характеристики Scalar i7 Raptor пока не раскрываются. На сегодняшний день семейство ленточных библиотек Quantum включает варианты i3 на 25–400 слотов, i6 на 50–800 слотов и i600 на 100–14 100 слотов. Существует также масштабируемый продукт i6H (на изображении), предназначенный для гиперскейлеров: предполагается, что именно ему на смену и придёт Scalar i7 Raptor. В продажу новинка поступит в начале 2025 года. Quantum надеется, что она поможет ей поправить финансовое положение, а пока компании грозит делистинг с Nasdaq.

23.03.2024 [22:29], Владимир Мироненко

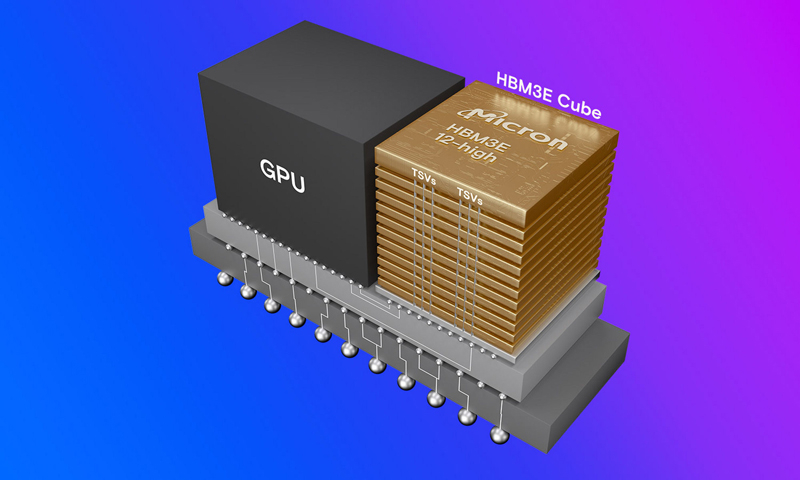

Micron уже продала всю HBM3E-память, которую выпустит в 2024 году и распределила заказы на 2025 годКомпания Micron Technology, приступившая в феврале к массовому производству передовой памяти HBM3E, сообщила, что уже имеет на руках контракты на весь объём поставок до конца 2024 года, а также на большую часть поставок в 2025 году. Память Micron HBM3E (Micron называет её HBM3 Gen2) одной из первых получила сертификацию для использования в ускорителях NVIDIA (G)H200, так что, по всей видимости, Micron станет ключевым поставщиком для NVIDIA, пишет AnandTech. «Наша HBM распродана на 2024 календарный год и подавляющая часть наших поставок на 2025 год уже распределена, — сообщил глава Micron Санджей Мехротра (Sanjay Mehrotra) в комментариях к отчёту за II квартал 2024 финансового года. Первый продукт HBM3E от Micron представляет собой сборку 8-Hi ёмкостью 24 Гбайт с 1024-бит интерфейсом и общей пропускной способностью 1,2 Тбайт/с. NVIDIA H200 использует шесть таких модулей. Micron также начала поставки образцов сборок 12-Hi ёмкостью 36 Гбайт.

Источник изображения: Micron В отчёте за II квартал 2024 финансового года Micron похвасталась результатами, которые оказались значительно выше прогнозов. Напомним, что до этого у компании были убытки пять кварталов подряд. В отчётном квартале Micron получила выручку в размере $5,82 млрд, превысив на 58 % на результат II квартала 2023 финансового года, равный $3,69 млрд, и на 23 % — результат предыдущего квартала, равный $4,73 млрд. При этом доля в общей выручке продаж DRAM составила 71 %, NAND — 27 %. Поставки подразделения сетевых и вычислительных решений (Compute and Networking, CNBU) выросли год к году на 59 % до $2,2 млрд, мобильного подразделения (Mobile, MBU) — на 69 % до $1,6 млрд, у подразделения встраиваемых решений (Embedded, EBU) зафиксирован рост на 28 % до $1,11 млрд, у подразделения решений для СХД — рост на 79 % до $905 млн. Компания сообщила о прибыли в размере $793 млн или $0,71 на акцию, в то время как годом ранее у неё были убытки (GAAP) в $2,31 млрд или $2,12 на акцию. Скорректированная прибыль (non-GAAP) составила $0,42 на акцию по сравнению с убытком в $1,91 на акцию годом ранее. Согласно прогнозу аналитиков, опрошенных FactSet, у Micron должны были быть убытки (non-GAAP) в размере $0,25 на акцию при выручке в $5,35 млрд. В текущем квартале Micron ожидает получить скорректированную прибыль (non-GAAP) в размере $0,42 на акцию при выручке в $6,6 млрд. Аналитики Уолл-стрит прогнозируют в III финансовом квартале прибыль (non-GAAP) в размере $0,09 на акцию при выручке в $6 млрд.

23.03.2024 [16:02], Сергей Карасёв

Supermicro представила ИИ-системы SuperCluster с ускорителями NVIDIA H100/H200 и суперчипами GH200Компания Supermicro анонсировала вычислительные кластеры SuperCluster с ускорителями NVIDIA, предназначенные для обработки наиболее ресурсоёмких приложений ИИ и обучения больших языковых моделей (LLM). Дебютировали системы, оснащённые жидкостным и воздушным охлаждением. В частности, представлен комплекс SuperCluster в составе пяти стоек на основе 4U-узлов СЖО. Каждый из узлов может нести на борту два процессора Intel Xeon Sapphire Rapids / Xeon Emerald Rapids или два чипа AMD EPYC 9004 (Genoa), дополненные памятью DDR5-5600. Доступны восемь фронтальных отсеков для SFF-накопителей NVMe и два слота M.2 NVMe. Каждый из узлов рассчитан на установку восьми ускорителей NVIDIA H100 или H200. Таким образом, в общей сложности SuperCluster с 32 узлами насчитывает до 256 ускорителей. Говорится о применении интерконнекта NVIDIA Quantum-2 InfiniBand, а также Ethernet-технологии NVIDIA Spectrum-X. Используется платформа для работы с ИИ-приложениями NVIDIA AI Enterprise 5.0, которая теперь включает микросервисы на базе загружаемых контейнеров.

Источник изображений: Supermicro Ещё одна система SuperCluster предусматривает конфигурацию из девяти стоек с узлами в форм-факторе 8U с воздушным охлаждением. У таких узлов во фронтальной части находятся 12 отсеков для SFF-накопителей NVMe и три отсека для SFF-устройств с интерфейсом SATA. В остальном характеристики аналогичны решениям типоразмера 4U. Общее количество узлов в системе равно 32.  Кроме того, вышел комплекс SuperCluster с девятью стойками на основе узлов 1U с воздушным охлаждением. Эти узлы комплектуются суперчипом NVIDIA GH200 Grace Hopper. Есть восемь посадочных мест для накопителей E1.S NVMe и два коннектора M.2 NVMe. В кластере объединены 256 узлов. Отмечается, что данная система оптимизирована для задач инференса в облачном масштабе.

22.03.2024 [23:59], Руслан Авдеев

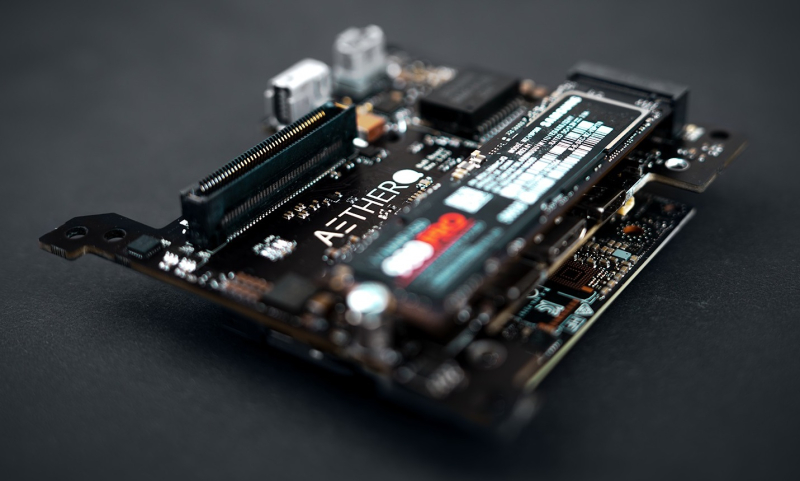

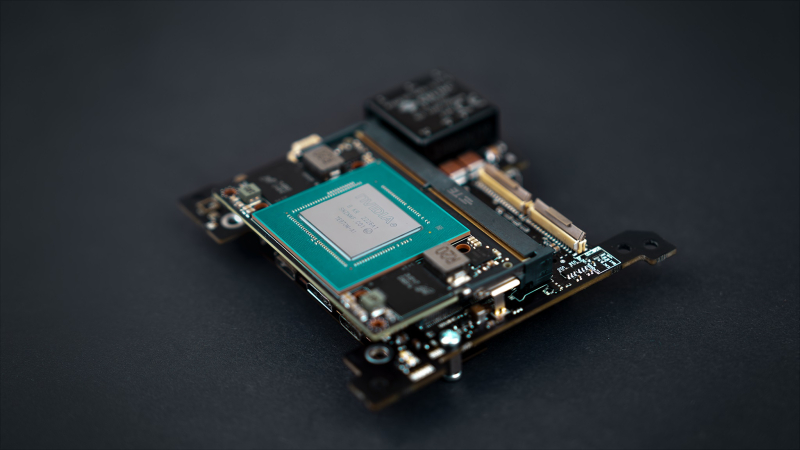

Aethero намерена стать «Intel или NVIDIA в космической индустрии», разработав защищённые ИИ-платформы для спутников и станцийХотя сенсоры многочисленных орбитальных спутников собирают немало информации, у космических аппаратов не хватает вычислительных способностей, чтобы обрабатывать данные на месте. TechCrunch сообщает, что стартап Aethero намерен стать «Intel или NVIDIA в космической индустрии» — компания разрабатывает защищённые от радиации компьютеры для периферийных вычислений на спутниках. Несколько лет назад основатели Aethero создали стартап Stratodyne, занимавшийся строительством стратостатов для дистанционного зондирования (ДЗЗ). Позже компания закрылась, а создатели вернулись к изучению встраиваемых систем для агрессивных сред. Как заявляет Aethero, современные компьютеры для космоса используют устаревшие FPGA и не способны выполнять сложные вычисления вроде тренировки на орбите ИИ-моделей или обслуживания систем компьютерного зрения. Aethero, привлёкшая $1,7 млн, намерена только в этому году трижды отправить свои разработки в космос. Одна из миссий будет выполнена SpaceX уже в июне. Целью является демонстрация работоспособности прототипов вроде возможности обновления набортных моделей компьютерного зрения или тренировки таких моделей непосредственно в космосе на собранных здесь же данных. Космический компьютер первого поколения ECM-NxN использует чип NVIDIA Jetson Orin Nano. В компании утверждают, что сегодня это лучший периферийный ИИ-ускоритель на рынке, а надёжное оборудование собственной разработки позволит сохранить его работоспособность на низкой околоземной орбите в течение 7–10 лет. При этом платформа уместится даже в небольшом аппарате вроде кубсата и обеспечивает производительность в 20 раз выше в сравнении с уже существующими решениями. Впоследствии Aethero намерена выпустить более крупный модуль ECM-NxA на базе NVIDIA AGX, а потом перейти к разработке собственного RISC-V чипа для модуля ECM-0x1. Утверждается, что тот будет потреблять меньше энергии и будет производительнее, чем продукты техногигантов. Выпуск планируется совместно с Intel приблизительно в 2026 году, хотя обстоятельства могут измениться. В Aethero отмечает, что подобные решения могут быть интересны операторам ДЗЗ, орбитальным сервисам и будущим частным космическим станциям. Например, только МКС генерирует терабайты данных ежедневно, напоминает компания. Правда, на МКС работает уже второе поколение космического суперкомпьютера HPE Spaceborne-2, разработчики которого отмечали проблемы с SSD и кешами процессоров из-за радиации. На МКС была протестирована и edge-платформа AWS Snowcone. Более того, ИИ-софт AWS для анализа снимков уже успел поработать на низкоорбитальном спутнике. |

|