Материалы по тегу: ai

|

19.11.2024 [12:57], Руслан Авдеев

Dell отобрала у Supermicro крупный заказ на ИИ-серверы для xAI Илона МаскаОснованный Илоном Маском (Elon Musk) стартап xAI, похоже, отнял все прежние заказы на ИИ-серверы у испытывающей не лучшие времена Supermicro, чтобы передать их её конкурентам. Как сообщает UDN, выгодоприобретателями станет Dell, а также её партнёры Inventec и Wistron. Для Supermicro, которой и без того грозит делистинг с Nasdaq, это станет очередным ударом. Ранее Dell и Supermicro поставляли оборудования компаниям Илона Маска, в т.ч. xAI и Tesla. Официально сообщалось, что xAI закупила ИИ-серверы с жидкостным охлаждением у Supermicro. Но после того, как Министерство юстиции США начало расследование деятельности поставщика в связи с вероятными махинациями с бухгалтерской отчётностью и нарушением санкционного режима, акции компании обрушились. После этого, по данным UDN, компании Маска и приняли решения передать заказы другим исполнителям. Среди поставщиков ИИ-серверов у Dell хорошие возможности получения заказов. Например, Wistron выпускает материнские платы для ИИ-серверов компании и выполняет некоторые задачи по сборке — партнёры станут одними из основных бенефициаров краха Supermicro. Фактически Wistron уже расширяет производственные мощности для удовлетворения спроса, в частности на трёх заводах на Тайване, а также в Мексике. В Wistron смотрят в будущее с большим оптимизмом и ожидают, что спрос на ИИ-серверы будет расти «трёхзначными» значениями в процентном отношении.

Источник изображения: Bermix Studio/unsplash.com Inventec также является крупным поставщиком Dell и тоже получит свою долю «пирога» от заказа Supermicro. Компания давно участвует в производстве ИИ-систем и входит в тройку ведущих партнёров Dell, участвующих в сборке серверов. В 2024 году компания поставляла машины на чипах семейства NVIDIA Hopper, но в I квартале 2025 года она сможет поставлять уже варианты на платформе NVIDIA Blackwell — с ускорителями B200 и B200A. Считается, что у компании есть свободные производственные мощности в Мексике, поэтому она сможет нарастить выпуск ИИ-серверов для компаний, ранее работавших с Supermicro. Одной из ключевых причин проблем Supermicro считается задержка с подачей финансовых документов, из-за чего компания рискует покинуть биржу Nasdaq. Чтобы избежать делистинга, Supermicro должна была объяснить задержки с подачей материалов и подать доклад по форме K-10 к 16 ноября, но сделать этого не успела. Впрочем, первые неприятности у Supermicro начались значительно раньше, когда Hindenburg Research опубликовала разгромный доклад о финансовой отчётности компании. Если Supermicro дождётся делистинга на бирже, это приведёт к серьёзными финансовыми последствиями, включая стремительное падение акций и необходимость немедленного погашения долга $1,725 млрд по конвертируемым облигациям — обычно такие «триггеры» учитываются в соглашениях и активируются при делистинге. Буквально на днях сообщалось, что Supermicro лишилась заказа от индонезийской YTL Group (YTLP) на поставку суперускорителей NVIDIA GB200 NVL72 для одного из крупнейших в Юго-Восточной Азии ИИ-суперкомпьютеров. Теперь поставками будет заниматься только Wiwynn, которая принадлежит всё той же Wistron. При этом сама Wiwynn сейчас судится с X (Twitter), которой владеет Илон Маск.

18.11.2024 [20:15], Руслан Авдеев

Ключевыми клиентами ИИ-сервиса Microsoft Azure OpenAI стали Adobe и Meta✴, но крупнейшим заказчиком всё ещё остаётся TikTokХотя крупнейшим облачным клиентом сервисов Azure OpenAI компании Microsoft по-прежнему остаётся социальная сеть TikTok, облачный ИИ-провайдер активно диверсифицирует свой бизнес. В распоряжение The Verge попал список крупнейших клиентов Microsoft, получающих облачный доступ к большим языковым моделям (LLM) — как оказалось, более $1 млн/мес. на сервисы Azure OpenAI тратит не только TikTok. В десятку ключевых пользователей Azure OpenAI вошли Adobe и Meta✴, каждая из которых потратила более $1 млн только в сентябре 2024 года. Впрочем, компании по-прежнему отстают от TikTok, принадлежащей ByteDance. Ранее сообщалось, что TikTok платила Microsoft почти $20 млн/мес. за доступ к моделям OpenAI. По итогам IV квартале 2024 финансового года, завершившемся 30 июня, на TikTok пришлось почти четверть выручки Azure OpenAI. Теперь траты ByteDance на Azure OpenAI составляют менее 15 % всей выручки Microsoft в этом сегменте — расходы ByteDance падают, а других клиентов растут. Например, G42 из ОАЭ тратит на сервисы Azure OpenAI миллионы долларов ежемесячно, являясь вторым по величине пользователем соответствующего сервиса после ByteDance. Ранее в этом году Microsoft инвестировала $1,5 млрд в G42, поэтому, вероятно, последняя сохранит статус одного из ключевых пользователей Azure OpenAI. Ранее в этом году главным потребителем ИИ-сервисов Microsoft считалась американская торговая сеть Walmart, но теперь её нет даже в десятке. Список серьёзно меняется от месяца к месяцу, во многом потому, что клиенты Microsoft время от времени запускают или тестируют новые ИИ-проекты. Так, постоянным клиентом остаётся Intuit, хотя её расходы несопоставимы с затратами G42 или ByteDance. Компания занимается разработкой инструментов для финансового управления и обучает собственные ИИ-модели на клиентских данных. Также Microsoft удалось привлечь к сотрудничеству тесно связанную с Alibaba компанию Ant Group, которая потратила на Azure OpenAI как минимум $1 млн. Среди ключевых клиентов есть и пекинская Sankuai Technology, а всего в десятку самых «дорогих» клиентов в сентябре вошли сразу три китайские компании. В Microsoft информацию не комментируют. В компании лишь отметили, что Azure OpenAI — один из самых быстрорастущих сервисов Azure за всю историю, которым уже пользуются 60 тыс. организаций по всему миру. За последние месяцы рост сервиса удвоился. Microsoft также продаёт лицензии Copilot для бизнеса, обеспечивающие ИИ-сервисы, например, в офисных приложениях. По данным самой компании, 70 % компаний из рейтинга Fortune 500 так или иначе пользуются Microsoft 365 Copilot. Скоро выручка ИИ-бизнеса Microsoft превысит $10 млрд в год. В Microsoft утверждают, что это будет самый быстрый в истории бизнес, достигший подобного показателя. Но пока затраты довольно велики, так что инвесторы внимательно наблюдают за показателями Azure OpenAI и Microsoft 365 Copilot. Microsoft уже не хватает ресурсов для обработки ИИ, но компания готова вкладывать деньги в новые ЦОД.

18.11.2024 [10:59], Сергей Карасёв

OpenAI раздумывала, не купить ли разработчика ИИ-ускорителей Cerebras при участии TeslaКомпания OpenAI, по информации ресурса TechCrunch, изучала возможность приобретения американского стартапа Cerebras Systems, специализирующегося на разработке ИИ-ускорителей. Такие сведения вскрылись в рамках судебного процесса по иску Илона Маска (Elon Musk) против OpenAI. Маск является одним из основателей OpenAI — он покинул эту компанию в 2018 году. В начале августа нынешнего года Маск подал в суд на OpenAI и её генерального директора Сэма Альтмана (Sam Altman), обвинив их в нарушении прав и интересов, а также во введении в заблуждение. Как теперь сообщается, в электронном письме, адресованном Альтману и Маску, Илья Суцкевер (Ilya Sutskever), один из соучредителей OpenAI и бывший главный научный сотрудник компании, обсуждал идею покупки Cerebras через Tesla. В другом письме от июля 2017 года Суцкевер затрагивает ряд вопросов, связанных с Cerebras, таких как переговоры об условиях слияния и проверка благонадёжности финансового состояния Cerebras. «Если мы решим купить Cerebras, я твердо уверен, что это будет сделано через Tesla. Но зачем делать это таким образом, если мы могли бы провести сделку изнутри OpenAI? В частности, вызывает беспокойство то, что Tesla имеет обязательство перед акционерами максимизировать их доход, что не соответствует миссии OpenAI», — написал Суцкевер. Cerebras создаёт ИИ-суперускорители размером с целую кремниевую пластину. Флагманским продуктом стартапа является решение Wafer Scale Engine третьего поколения (WSE-3). Это гигантское изделие содержит 4 трлн транзисторов, 900 тыс. ядер и 44 Гбайт памяти SRAM. Предполагалось, что слияние с OpenAI будет выгодно обеим сторонам. В частности, Cerebras избежала бы сложного пути, связанного с IPO, тогда как OpenAI смогла бы получить в своё распоряжение мощные аппаратные ускорители для ресурсоёмких ИИ-задач. Однако сделка в итоге провалилась, хотя причины сворачивания переговоров не раскрываются.

16.11.2024 [20:59], Сергей Карасёв

Стартап xAI Илона Маска получит от арабов $5 млрд на покупку ещё 100 тыс. ускорителей NVIDIAКак сообщает CNBC, стартап xAI Илона Маска (Elon Musk) привлёк многомиллиардные инвестиции: деньги будут направлены на закупку ускорителей NVIDIA для расширения вычислительных мощностей ИИ-суперкомпьютера. Напомним, в начале сентября нынешнего года компания xAI запустила ИИ-кластер Colossus со 100 тыс. ускорителей NVIDIA H100. В составе платформы применяются серверы Supermicro, узлы хранения типа All-Flash, адаптеры SuperNIC, а также СЖО. Суперкомпьютер располагается в огромном дата-центре в окрестностях Мемфиса (штат Теннесси). Как теперь стало известно, в рамках нового раунда финансирования xAI привлечёт $6 млрд. Из них $5 млрд поступит от суверенных фондов Ближнего Востока, а ещё $1 млрд — от других инвесторов, имена которых не раскрываются. При этом рыночная стоимость стартапа достигнет $50 млрд. О том, что xAI получит дополнительные средства на развитие, также сообщает Financial Times. По данным этой газеты, речь идёт о $5 млрд при капитализации стартапа на уровне $45 млрд.

Источник изображения: NVIDIA Ранее Маск говорил о намерении удвоить производительность Colossus: для этого, в частности, планируется приобрести примерно 100 тыс. ИИ-ускорителей, включая 50 тыс. изделий NVIDIA H200. Судя по всему, привлеченные средства стартап также направит на покупку других решений NVIDIA, в том числе коммутаторов Spectrum-X SN5600 и сетевых карт на базе BlueField-3. Между тем жители Мемфиса выражают недовольство в связи с развитием ИИ-комплекса xAI. Активисты, в частности, обвиняют стартап в том, что используемые на территории его дата-центра генераторы ухудшают качество воздуха в регионе.

14.11.2024 [18:28], Руслан Авдеев

АЭС от ВМС: OpenAI подготовила для правительства США детальные рекомендации по масштабному развитию ИИ-отраслиКомпания OpenAI приготовила пакет рекомендаций американским властям, в котором изложила меры, необходимые, как она считает, для развития ИИ-сектора. По данным CNBC, план ИИ-инфраструктуры США касается экономики ИИ, использования опыта ВМС США в сфере атомной энергетики, а также правительственных проектов, финансируемых частными инвесторами. Говорится и о необходимости создания североамериканского ИИ-альянса, к которому в перспективе могут присоединиться, например, страны Персидского залива. Критически важным считается принятия «Закона о национальных магистральных ЛЭП» (National Transmission Highway Act), который называется столь же амбициозным, как и «Закон о национальных межштатных и оборонных магистралях» (National Interstate and Defense Highways Act) 1956 года. В сентябре уже сообщалось, что топ-менеджеры OpenAI, включая гендиректора Сэма Альтмана (Sam Altman), провели ряд встреч с потенциальными инвесторами с целью заручиться поддержкой в создании многомиллиардной IT-инфраструктуры, необходимой для ускоренного развития ИИ. В документе OpenAI предсказывает ИИ блестящее будущее, называя искусственный интеллект «основополагающей» технологией, какой стало электричество, и обещающей такие же распределённый доступ и выгоды. Предполагается, что инвестиции в ИИ помогут создать десятки тысяч рабочих мест, приведут к росту ВВП, модернизации энергетической инфраструктуры, включая атомную энергетику и созданию новых заводов по выпуску чипов — а также миллиардным инвестициям из зарубежных фондов. OpenAI недвусмысленно выразила готовность сотрудничать с администрацией будущего президента США Дональда Трампа (Donald Trump). По имеющимся данным, Трамп намерен отменить указ действующего президента США Джо Байдена (Joe Biden), в котором упоминаются необходимость оценки безопасности технологий, защита прав сотрудников отрасли, защита принципов равенства, защита прав потребителей и др. Трамп заявлял, что указ препятствует инновациям в сфере ИИ. В презентации компании упоминается о необходимости создания экономических ИИ-зон совместно с властями штатов и федеральным правительством, что должно упростить выдачу разрешений на создание ИИ-инфраструктуры. Компания намерена строить новые солнечные и ветряные электростанции, а также добиться разрешения на эксплуатацию неиспользуемых реакторов. Предполагается, что штаты, предоставляющие поддержку ИИ-бизнесу, смогут требовать выделения части вычислительных мощностей государственным университетам для проведения собственных исследований. «Закон о национальных магистральных ЛЭП» должен расширить возможности электроснабжения, развить ВОЛС и обеспечить строительство газопроводов. В компании запрашивают новые полномочия для упрощения бюрократических процедур. Заявляется, что правительство может поощрять частные инвестиции в дорогостоящие проекты энергетической инфраструктуры и взять на себя ряд обязательств, в т.ч. по покупке энергии, чтобы снизить риски инвесторов. Также предлагается использовать опыт ВМС, уже эксплуатирующих около 100 малых модульных реакторов (SMR), питающих в основном подводные лодки — это поможет состязаться с Китаем, активно строящим новые АЭС. В США основными регионами для инвестиций в ИИ называются Средний Запад и Юго-Запад, пока они остаются «за бортом», несмотря на то что там есть земля и возможность строительства ветряных и солнечных электростанций и, возможно, ядерных объектов. Тем более, что в штатах вроде Канзаса или Айовы могут потребоваться собственные специализированные ИИ-модели для обработки сельскохозяйственных данных. По оценкам одного из представителей OpenAI, к 2030 году США понадобится 50 ГВт энергии для удовлетворения потребностей ИИ-отрасли и конкуренции с КНР, особенно с учётом того, что Китай за последние два года одобрил строительство 20 ядерных реакторов и ещё 11 на следующий год. Не так давно уже сообщалось об инициативе главы OpenAI Сэма Альтмана (Sam Altman), предлагавшего правительству США строительство сети 5-ГВт ЦОД. Позже данные получили подтверждение.

09.11.2024 [20:20], Руслан Авдеев

Жители Мемфиса не рады развитию ИИ-суперкомпьютера xAI Coloussus Илона МаскаАктивисты из числа жителей американского Мемфиса раскритиковали оператора энергосети Tennessee Valley Authority (TVA) за предоставление стартапу xAI Илона Маска доступа к дополнительным 150 МВт для питания ИИ-суперкомпьютера Colossus, сообщает Datacenter Dynamics. В минувший четверг TVA одобрил запрос от энергокомпании Memphis Light, Gas and Water (MLGW). Colossus предназначен для обучения и обслуживания ИИ-бота Grok, заработавшего ранее в этом году. Суперкомпьютер разместился в помещениях бывшего завода Electrolux в промышленном парке на юго-востоке Мемфиса. Ранее Маск заявлял, что речь идёт о самом быстром в мире ИИ-суперкомпьютере, включающем 100 тыс. ускорителей NVIDIA H100. Правда, буквально через несколько дней Meta✴ похвасталась ещё более крупной системой для обучения Llama-4. Но и Маск обещал в ближайшие месяцы удвоить мощность суперкомпьютера, который получит 50 тыс. ускорителей NVIDIA H200. Всё это означает, что машине потребуется много энергии. Ранее в этом году MLGW согласилась обеспечить xAI ещё 150 МВт, ожидалось лишь одобрение TVA. Комплекс даже пришлось запитать от мобильных газовых генераторов Voltagrid, что само по себе вызвало недовольство местных жителей. xAI со своей стороны пообещала построить крупнейшую в мире систему очистки сточных вод с керамическим мембранами, а также с дисконтом предоставлять ресурсы энергохранилища Tesla Megapack, построенного рядом с Colossus, для поддержки стабильности энергосети Мемфиса. Новость не вызывала энтузиазма у местных активистов и экозащитников, обеспокоенных вероятной нагрузкой на энергосети города и низким качеством воздуха. Активисты также подчёркивают, что оператор TVA обязан служить интересам общества и изучить последствия выделения xAI дополнительных 150 МВт, поскольку регион и так страдает от высоких нагрузок на сети и загрязнения окружающей среды. Дело, в частности, в том, что TVA намерена построить турбины на природном газе для получения ещё 200 МВт, поскольку оператор ещё прошлой осенью не справлялся со спросом. В TVA заявляют, что задача оператора — работать с партнёрами для привлечения в регион инвестиций и рабочих мест, в каждом случае аккуратно оцениваются детали каждого предложения. MLGW получит из бюджета $760 тыс. для введения в строй ещё 50 МВт, а xAI обязуется построить за $24 млн собственную подстанцию на 150 МВт. Существующие договорённости предусматривают, что xAI будет получать ежемесячные скидки от поставщика энергии, пока не компенсирует стоимость возводимой ей подстанции и та не перейдёт в собственность MLGW.

07.11.2024 [20:37], Руслан Авдеев

5 ГВт и 2 млн ускорителей: опубликованы детали проекта километровых ИИ ЦОД OpenAIВ сентябре 2024 года глава OpenAI Сэм Альтман (Sam Altman) обратился к американским властям с инициативой, предполагавшей строительство в стране целой сети 5-ГВт ЦОД. Альтман утверждал, что это поможет США сохранить первенство в сфере ИИ в мировом масштабе и является вопросом национальной безопасности. Datacenter Dynamics удалось получить доклад OpenAI, адресованный Национальному управлению по телекоммуникациям и информации (NTIA), где раскрыты некоторые детали амбициозного плана компании. Согласно расчётам OpenAI, ЦОД ёмкостью 5 ГВт будут занимать площадь около 2,78 км2 (278 га) и использовать до 2 млн ускорителей. Проект мог бы обеспечить США абсолютное мировое превосходство в сфере ИИ. Для сравнения, в 2023 году у AWS управляла ЦОД общей площадью 3,55 км2 (355 га, с учётом офисных помещений), а ёмкость ЦОД Microsoft в начале 2024 года составляла «всего» 5 ГВт, хотя компания до конца года рассчитывает освоить ещё 2,5 ГВт. Ряд компаний работают над гигаваттными ЦОД, но намерены построить их поэтапно в течение нескольких лет. В OpenAI утверждают, что 5-ГВт ЦОД обойдётся в $100 млрд (в ожидаемых ценах 2028 года), но при этом будет приносить по $40 млрд каждый год. На каждый 100 МВт ёмкости понадобится по 80 сотрудников, т.е. суммарно появится 4 тыс. постоянных рабочих мест. Для строительства дата-центров потребуется около 14 тыс. человек. Компания также привела расчёты прироста ВВП в отдельных штатах и локациях, где предполагается возведение новых ЦОД — от $16 до $20 млрд. В расчёт не принимались рабочие места и затраты на создание новой энергетической инфраструктуры и производство полупроводников. По оценкам OpenAI, глобальные фонды готовы инвестировать в инфраструктуру около $175 млрд. Компания грозит тем, что эти деньги могут быть потрачены не в США, а в недружественных странах. При этом в OpenAI подчёркивают, что развитие новых ИИ ЦОД будет иметь стратегическое значение с учётом того, что параллельно развиваются ИИ-платформы, например, в Китае. В компании отметили, что промедление грозит отставанием от КНР и других стран, не разделяющих ценности США и их союзников. Изначально компания планировала реализовать 5-ГВт проект Stargate совместно с Microsoft, крупнейшим спонсором и поставщиком ИИ-инфраструктуры для OpenAI. Однако в последнее время отношения между компаниями несколько охладели из-за конкуренции ИИ-подразделений и разногласиями, связанными со скоростью строительства ЦОД Microsoft. Попутно OpenAI добивается финансирования и правовой поддержки от властей США и проводит встречи с потенциальными инвесторами. Однако построить ЦОД мало, их ещё надо запитать. В некоторых штатах с большой концентрацией дата-центров ёмкость энергосетей придётся удвоить в ближайшие 10 лет. По оценкам, до 2030 года потребуется $50 млрд инвестиций в энергосистему. Предполагается, что к этом моменту энергосети Северной Америки вырастут приблизительно на 200 ГВт, а новые ИИ-проекты потребуется 100 ГВт. Однако из-за смены главы США даже текущие проекты по увеличению выработки и доставки энергии могут быть отменены, а Илон Маск (Elon Musk) и вовсе заявил, что намерен сократить расходы государства на $2 трлн.

30.10.2024 [11:49], Сергей Карасёв

OpenAI разрабатывает собственные ИИ-чипы совместно с Broadcom и TSMC, а пока задействует AMD Instinct MI300XКомпания OpenAI, по информации Reuters, разрабатывает собственные чипы для обработки ИИ-задач. Партнёром в рамках данного проекта выступает Broadcom, а организовать производство изделий планируется на мощностях TSMC ориентировочно в 2026 году. Слухи о том, что OpenAI обсуждает с Broadcom возможность создания собственного ИИ-ускорителя, появились минувшим летом. Тогда говорилось, что эта инициатива является частью более масштабной программы OpenAI по увеличению вычислительных мощностей компании для разработки ИИ, преодолению дефицита ускорителей и снижению зависимости от NVIDIA. Как теперь стало известно, OpenAI уже несколько месяцев работает с Broadcom над своим первым чипом ИИ, ориентированным на задачи инференса. Соответствующая команда разработчиков насчитывает около 20 человек, включая специалистов, которые ранее принимали участие в проектировании ускорителей TPU в Google, в том числе Томаса Норри (Thomas Norrie) и Ричарда Хо (Richard Ho). Подробности о проекте не раскрываются. Reuters, ссылаясь на собственные источники, также сообщает, что OpenAI в дополнение к ИИ-ускорителям NVIDIA намерена взять на вооружение решения AMD, что позволит диверсифицировать поставки оборудования. Речь идёт о применении изделий Instinct MI300X, ресурсы которых будут использоваться через облачную платформу Microsoft Azure. Это позволит увеличить вычислительные мощности: компания OpenAI только в 2024 году намерена потратить на обучение ИИ-моделей и задачи инференса около $7 млрд. Вместе с тем, как отмечается, OpenAI пока отказалась от амбициозных планов по созданию собственного производства ИИ-чипов. Связано это с большими финансовыми и временными затратами, необходимыми для строительства предприятий.

29.10.2024 [20:28], Сергей Карасёв

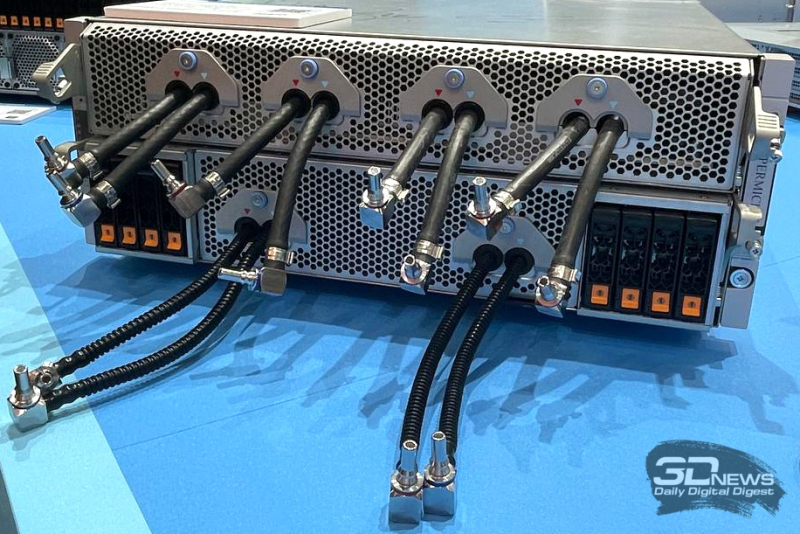

Раскрыты подробности архитектуры ИИ-кластера xAI Colossus со 100 тыс. ускорителей NVIDIA H100Портал ServeTheHome рассказал подробности об архитектуре вычислительного кластера xAI Colossus, предназначенного для обучения крупных ИИ-моделей. Эта система использует 100 тыс. NVIDIA H100, а в дальнейшем количество ускорителей планируется увеличить вдвое. Это самый крупный из известных ИИ-кластеров на текущий момент. Оборудование для него поставили компании Dell и Supermicro. Стартап xAI, курируемый Илоном Маском (Elon Musk), объявил о запуске суперкомпьютера Colossus в начале сентября нынешнего года. Утверждается, что на создание системы потребовалось всего 122 дня. Причём с момента установки первой стойки с серверами до начала обучения ИИ-моделей прошло только 19 суток. Впрочем, как отмечают эксперты, поскольку машина является «однозадачной», т.е. в отличие от традиционных суперкомпьютеров предназначенной только для работы с ИИ, ускорить строительство было не так уж сложно, хотя результат всё равно впечатляющий. Как сообщается, в составе Colossus применены серверы на платформе NVIDIA HGX H100, оборудованные системой жидкостного охлаждения. Каждый узел Supermicro серии TNHR2-LCC типоразмера 4U содержит восемь ускорителей NVIDIA H100 и два CPU. Узел разделён на две половинки, одна с CPU и PCIe-коммутаторами и одна с HGX-платой, которые могут извлекаться независимо для простоты обслуживания. CPU, коммутаторы и ускорители охлаждаются посредством СЖО. Вентиляторы в шасси тоже есть. Воздух от них попадает на теплообменники на задней двери, которые уносят остаточное тепло. Холодных и горячих коридоров в ЦОД нет, воздух имеет одинаковую температуру во всём зале. В нижней части стоек располагается ещё один 4U-блок Supermicro для CDU с резервированием и поддержкой горячей заменой насосов. Каждый сервер имеет четыре блока питания с резервированием и возможностью горячей замены, которые подключены к трёхфазным PDU. Одна стойка объединяет восемь узлов NVIDIA HGX H100, между которыми располагаются коллекторы СЖО в формате 1U. Таким образом, каждая стойка насчитывает 64 экземпляра H100. Стойки организованы в группы по восемь штук, которые образуют малые кластеры из 512 ускорителей H100. Они в свою очередь объединены в т.н. «острова» по 25 тыс. ускорителей, каждому из которых полагается собственный машинный зал. Общее количество стоек в составе Colossus превышает 1500. Помимо узлов с ускорителями также есть CPU-узлы и узлы хранения All-Flash (1U). Как отмечает NVIDIA, в кластере Colossus задействована сетевая платформа Spectrum-X Ethernet. Применены коммутаторы Spectrum-X SN5600 и сетевые карты на базе чипа BlueField-3. Компания говорит об использовании трёхуровневой Ethernet-сети с 400GbE-подключением, но точная топология не указана. Судя по всему, выделенной сети для работы с хранилищем не предусмотрено. Каждом ускорителю полагается один 400GbE-адаптер SuperNIC, который и объединяет их в RDMA-сеть. Кроме того, у каждого GPU-узла есть ещё один 400GbE DPU, а также подключение к сервисной сети. Сетевые карты находятся в собственных лотках, благодаря чему их можно заменять без демонтажа шасси. По словам NVIDIA, уровень утилизации сети достигает 95 %. В качестве энергетического буфера между электросетью и суперкомпьютером используются аккумуляторные банки Tesla Megapack ёмкостью 3,9 МВт·ч каждый. Они необходимы для того, чтобы компенсировать всплески потребляемой мощности, когда нагрузка на ускорители резко возрастает в силу выполняемых ИИ-задач. Впрочем, вероятно, есть и ещё одна причина для такого решения — на первом этапе Colossus был лишён подключения к основной энергосети и в вопросе питания во многом полагался на генераторы.

16.10.2024 [12:15], Руслан Авдеев

Crusoe Energy, Blue Owl и Primary Digital Infrastructure построят в Техасе 205-МВт ИИ ЦОД в ТехасеКомпания Crusoe Energy открывает совместное предприятие с Blue Owl Capital и Primary Digital Infrastructure для реализации проекта по строительству ЦОД в Техасе. По данным Silicon Angle, на эти цели будет потрачено $3,4 млрд, специализированный дата-центр должен появиться в кампусе Lancium Clean Campus. Будущий ЦОД Crusoe AI, уже сданный в аренду целиком некому гиперскейлеру из списка Fortune 500, будет кампусом из двух объектов, построенных по индивидуальному проекту. По имеющимся данным, он рассчитан на ёмкость 205 МВт. Конструкция ЦОД оптимизирована для использования систем с прямым жидкостным охлаждением, но будет поддерживаться и воздушное охлаждение. Готовый ЦОД сможет вместить до 100 тыс. ускорителей в составе одной сетевой фабрики. Предполагается, что энергоснабжение кампуса будет обеспечено внутренними и внешними источниками энергии. Освоение мощностей начнётся в I половине 2025 года. Ранее появилась информация, что ключевым арендатором станет компания Oracle, а конечным потребителем вычислительных мощностей — OpenAI. При этом Microsoft, вероятно, станет посредником, сохраняя свой статус поставщика облачных услуг для OpenAI. В руководстве Crusoe подчёркивает, что растущий спрос на ЦОД обусловлен большими перспективами ИИ. Lancium, с которой Crusoe уже сотрудничала, в 2021 году получила одобрение на строительство техасского кампуса ЦОД Project Artemis. Тогда речь шла о кампусе на участке 160–320 га ёмкостью от 200 МВт с возможностью масштабирования до 1 ГВт. Blue Owl Capital управляет активами на $192 млрд. Хотя ранее компания не инвестировала в ЦОД, в последние месяцы она вложила средства в проекты нескольких дата-центров, а недавно создала СП на $5 млрдс Chirisa и PowerHouse для строительства сети ЦОД на территории США, в первую очередь для ИИ-облака CoreWeave. Blue Owl также приобрела владельца Stack и RadiusDC — компанию IPI Partners за $1 млрд. Руководство Primary Digital Infrastructure говорит об инвестиционном буме — только в США в ближайшие четыре-пять лет на ЦОД будет потрачено около $1 трлн. Текущая цель компании — приобретение наиболее стабильных активов на этом рынке, а также инвестиции в строительство собственных облачных и ИИ-объектов. Crusoe Energy, основанная в 2018 году, начинала с доставки контейнерных ЦОД к нефтяным скважинам в США, запитанных от попутного газа. Если изначально Crusoe использовала свои ресурсы для майнинга, то позже появилось предложение Crusoe Cloud для ИИ- и HPC-нагрузок. В конце прошлого года компания занялась стационарными проектами. Компания разместила ускорители в ЦОД ICE02 оператора atNorth в Исландии и объявила о сотрудничестве с Digital Realty. |

|