Материалы по тегу: ai

|

10.10.2024 [11:34], Руслан Авдеев

OpenAI не хватает мощностей ЦОД Microsoft, компания готова арендовать у Oracle 2-ГВт кампусУ Microsoft, как оказалось, не хватает мощностей ЦОД для обеспечения всех потребностей OpenAI. По данным The Information, в ИИ-компании намерены агрессивно масштабировать свои вычислительные способности. По словам журналистов, после того как OpenAI привлекла в октябре $6,6 млрд инвестиций, финансовый директор Сара Фрайар (Sarah Friar) выступила перед сотрудниками, заявив, что компания будет активнее искать дата-центры и ИИ-чипы. Ранее она же сообщала акционерам, что Microsoft слишком медлительна для работы с ИИ-стартапом. Например, компания xAI Илона Маска (Elon Musk) в кратчайшие сроки запустила крупный ИИ ЦОД в Мемфисе, когда в этом возникла необходимость. OpenAI постепенно отдаляется от Microsoft, которая остаётся ключевым владельцем доли в компании. В июне была анонсирована сделка с Oracle по аренде серверов в дата-центре, пока что строящемся в Абилине (Техас). Хотя Microisoft упомянута в пресс-релизе, IT-гигант не слишком вовлечён в проект. Вместо этого он фактически будет арендовать серверы и предоставлять их OpenAI. Это позволяет говорить, что компания всё ещё является эксклюзивным облачным провайдером последней.

Источник изображения: Mariia Shalabaieva/unsplash.com Теперь OpenAI ведёт переговоры об аренде этого дата-центра целиком, к середине 2026 года его ёмкость составит почти 1 ГВт. Если Oracle удастся получить больше энергии, площадка вырастет до 2 ГВт. Дополнительно OpenAI может заняться своим давно обещанным дата-центром Stargate на 5 ГВт, но уже без Microsoft — если ИИ-компания сможет найти финансирование для ЦОД стоимостью более $100 млрд и снабдить его энергией. По словам главы OpenAI Сэма Альтмана, выступившего на этой неделе перед сотрудниками, затраты теоретически можно снизить, используя чипы, разрабатываемые самой OpenAI, но пока непонятно, на какой стадии реализации находится этот проект. Ранее сообщалось, что Альтман пытается убедить власти США в необходимости строительства в стране сети 5-ГВт ЦОД.

08.10.2024 [12:36], Сергей Карасёв

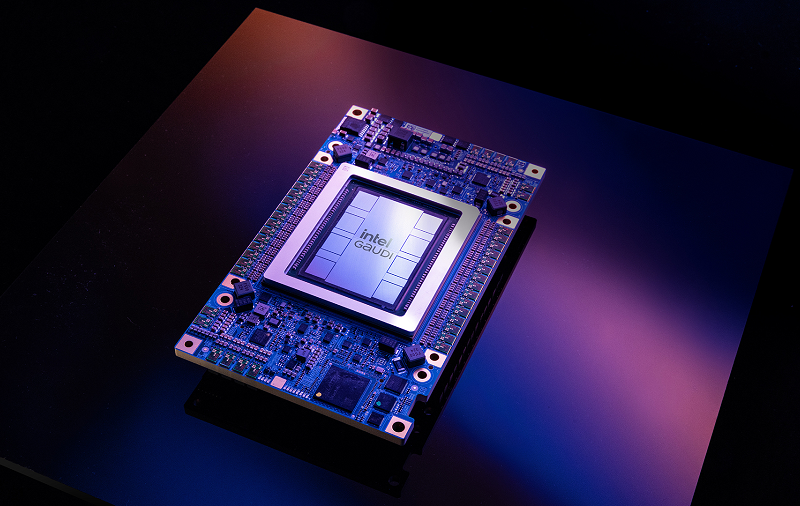

Inflection AI и Intel представили ИИ-систему на базе Gaudi3Стартап Inflection AI и корпорация Intel объявили о сотрудничестве с целью ускорения внедрения ИИ в корпоративном секторе. В рамках партнёрства состоялся анонс Inflection for Enterprise — первой в отрасли ИИ-системы корпоративного класса на базе ускорителей Intel Gaudi3 и облака Intel Tiber AI Cloud (AI Cloud). Inflection AI основана в 2022 году Мустафой Сулейманом (Mustafa Suleyman), одним из основателей Google DeepMind, а также Ридом Хоффманом (Reid Hoffman), одним из учредителей LinkedIn. Стартап специализируется на технологиях генеративного ИИ. В середине 2023 года Inflection AI получила на развитие $1,3 млрд: в число инвесторов вошли Microsoft и NVIDIA. Inflection for Enterprise объединяет Gaudi3 с большой языковой моделью (LLM) Inflection 3.0. Утверждается, что это ПО при использовании на аппаратной платформе Intel демонстрирует вдвое более высокую экономическую эффективность по сравнению с некоторыми конкурирующими изделиями. Заказчики получат LLM, настроенную в соответствии с их пожеланиями. Для удовлетворения потребностей каждого конкретного клиента применяется обучение с подкреплением на основе отзывов людей (RLHF). При этом используются данные, предоставленные самим заказчиком.

Источник изображения: Intel Отмечается, что облако AI Cloud упрощает создание, тестирование и развёртывание ИИ-приложений в единой среде, ускоряя время выхода продуктов на рынок. Тонко настроенные ИИ-модели доступны исключительно клиенту и не передаются в третьи руки. На первом этапе системы Inflection for Enterprise будут предлагаться через облако AI Cloud. В I квартале 2025 года планируется организовать поставки программно-аппаратных комплексов.

26.09.2024 [11:01], Руслан Авдеев

Слухи: Сэм Альтман убеждает власти США, что для нацбезопасности необходима целая сеть 5-ГВт ЦОДВ Сети появилась информация о том, что глава OpenAI Сэм Альтман (Sam Altman) пытается убедить президента США Джо Байдена (Joe Biden) в необходимости строительства большой сети ИИ ЦОД. Bloomberg сообщает, что каждый из этих дата-центров будет потреблять до 5 ГВт, как планируемый ЦОД Stargate. Предполагается, что такое строительство необходимо для обеспечения национальной безопасности США. Предложение, изложенное в документе, попавшем в руки журналистам Bloomberg, подчёркивает достоинства строительства нескольких таких ЦОД на территории Соединённых Штатов. Информация появилась спустя всего несколько недель после того, как Альтман и другие лидеры технологической отрасли посетили Белый Дом для обсуждения вопросов развития ИИ-технологий и инфраструктуры. Журналисты цитируют представителей Constellation Energy, сообщивших, что Альтман может планировать возведение 5–7 подобных мегацентров, но пока готов начать с одного. Впрочем, строительство даже единственного объекта будет весьма сложной задачей, поскольку каждый ЦОД на 5 ГВт потребует, по-видимому, подключения к АЭС или крупным ГЭС. В результате в США придётся реализовать гигантские энергопроекты.

Источник изображения: Glenov Brankovic/unsplash.com Так, ГЭС Grand Coulee в штате Вашингтон имеет мощность 6,8 ГВт, а атомные электростанции в Джорджии (Alvin W. Vogtle) и Аризоне (Palo Verde) обеспечивают 4,6 и 3,9 ГВт соответственно. Согласно докладу CBRE, вышедшему в конце прошлого месяца, уже отмечается нехватка энергии, препятствующая своевременному вводу объектов в эксплуатацию. При этом Министерство энергетики США действительно рассматривает массовый ввод в строй новых реакторов на старых угольных и атомных электростанциях. С учётом высокого спроса, облачные провайдеры уже принимают экстренные меры для обеспечения своих объектов энергией. Microsoft заключила PPA на 20 лет с Constellation Energy для возвращения в строй 837-МВт реактора АЭС Three Mile Island. Ранее в этом году AWS заключила соглашение с Talen Energy, владеющей и управляющей АЭС Susquehanna. Amazon приобрела у компании ЦОД Cumulus за $650 млн, получив доступ к 960 МВт, а Oracle планирует ЦОД на малых модульных реакторах (SMR). Сам Альтман поддерживает стартапы в области ядерной (Oklo), термоядерной (Helion) и солнечной (Exowatt) энергетики. В любом случае останется проблема получения огромного количества ускорителей для дата-центров. Если средний показатель PUE будет на уровне 1.1, то объект на 5 ГВт будет поддерживать до 35 тыс. суперускорителей NVIDIA Blackwell NVL72 или приблизительно 2,5 млн чипов Blackwell. Для сравнения, в 2023 году, по данным Uptime Institute, NVIDIA поставил всего около 600 тыс. ускорителей H100, а в этом вероятны поставки 1,5–2 млн ускорителей. При этом далеко не факт, что TSMC сможет справиться с выполнением заказа NVIDIA, особенно с учётом ограничений технологий упаковки CoWoS. Конечно, Альтман часто выдвигал полуфантастические идеи. Ранее в этом году сообщалось, что он предложил проект сети производств чипов на $7 трлн для удовлетворения аппетитов своего бизнеса. Впрочем, выступая на мероприятии Foundry компании Intel в феврале он напомнил, что не всё, что написано в интернет — правда. Другими словами, план Альтмана, который он пытается продвигать в администрации, возможно, лишь попытка заставить правительство задуматься о долгосрочных инвестициях в ИИ.

20.09.2024 [17:05], Руслан Авдеев

На генерацию ста слов у GPT-4 уходит до трёх бутылок водыИсследование, проведённое учёными Калифорнийского университета в Риверсайде показало, что использование ИИ-технологий для экологии обходится очень дорого. The Washington Post сообщает, что ИИ ЦОД требуют очень много питьевой воды и энергии, даже когда просто генерируют только текст. Дата-центры давно считаются довольно «жадными» до воды и электричества, причём наличие ЦОД поблизости крайне негативно влияет и на счета за коммунальные услуги обычных граждан. Конкретные затраты воды и энергии отличаются от штата к штату и зависят от близости их источников к дата-центру. Так, более низкое водопотребление напрямую зависит от стоимости энергии. Если в Техасе на подготовку электронного письма из 100 слов с помощью GPT-4 потребуется 235 мл, то в Вашингтоне — уже 1408 мл. Ранее те же исследователи выяснили, что диалог из 20–50 вопросов к ChatGPT на базе GPT-3 требуется 0,5 литра, а обучение GPT-3 обошлось в 320 тыс. литров. А на обучение Meta✴ Llama-3 потребовалось уже 22 млн литров. На первый взгляд кажется, что это не очень много, но пользователи редко ограничиваются написанием одного письма или другого материала в неделю или даже в день. Кроме того, при работе с изображениями и другим контентом расход, скорее всего, ещё выше. Если один из десяти работающих американцев использует GPT-4 раз в неделю в течение года (52 запроса от 17 млн человек), энергозатраты составляют 121 517 МВт∙ч. Примерно столько же потребляют все домохозяйства Вашингтона (Округ Колумбия, 672 тыс. человек) в течение двадцати дней. На практике же целевая аудитория GPT-4 применяет модель несопоставимо активнее. Представители OpenAI, Meta✴, Google и Microsoft неоднократно говорили о важности снижения экологической нагрузки своего бизнеса, но кардинальных шагов никто из них пока не совершил. Представитель Microsoft сообщил, что компания будет работать над методами охлаждения ЦОД, которые позволят полностью избавиться от потребления воды. Речь, например, об использовании воздушных систем охлаждения в сухой Аризоне. В августе сообщалось как об использовании Microsoft СЖО, так и систем на основе более прогрессивных технологий микрогидродинамики. Параллельно растут и углеродные выбросы той же Microsoft, связанные с развитием её ИИ-систем. По мнению многих экспертов, прибыль безусловно находится в приоритете в сравнении с климатическими целями, поставленными компаниями в прошлом, поэтому стоит подождать конкретных улучшений. Ранее сообщалось, что в «столице ЦОД», штате Вирджиния, дата-центры потребляют огромное количество воды, а развитие ИИ ухудшает ситуацию. Конечно, проблема актуальна не только для США. Например, в прошлом году британская коммунальная компания Thames Water пригрозила операторам ЦОД урезать подачу воды или поднять цены, если те не сократят расход этого важного ресурса. Весной 2024 года появились данные о том, что потребление воды китайскими дата-центрами удвоится к 2030 году.

05.09.2024 [00:40], Владимир Мироненко

OpenAI пытается ускорить запуск многомиллиардного проекта по расширению ИИ-инфраструктуры с участием глобальных инвесторовТоп-менеджеры OpenAI, включая гендиректора Сэма Альтмана (Sam Altman), провели ряд встреч с потенциальными инвесторами с целью заручиться поддержкой в создании многомиллиардной IT-инфраструктуры, необходимой для ускоренного развития ИИ, сообщило агентство Bloomberg. Обсуждения проходят в преддверии нового многомиллиардного раунда финансирования OpenAI, который, как ожидается, возглавит венчурный фонд Thrive Capital при участии Microsoft, Apple и NVIDIA. После завершения раунда оценка рыночной стоимости стартапа может превысить $100 млрд. По данным Bloomberg, Альтман провёл начало года, добиваясь одобрения правительством США своего плана по формированию коалиции глобальных инвесторов с целью финансирования дорогостоящего проекта. А в настоящее время он и его команда занимаются проработкой деталей своей инициативы. В частности, обсуждаются такие направления как строительство ЦОД, увеличение мощностей источников энергии и систем её передачи, а также расширение производства полупроводников. Группа поддержки проекта, как сообщается, скорее всего, будет включать инвесторов из Канады, Кореи, Японии и ОАЭ и иные частные компании. Крупнейший инвестор производителя ChatGPT, компания Microsoft, может стать одним из его потенциальных партнёров. В Microsoft не стали комментировать конкретно этот проект, но заявили, что компания участвует в любых инициативах OpenAI, направленных на укрепление инфраструктуры. С целью продвижения сделки топ-менеджеры OpenAI провели ряд встреч. Директор по стратегии OpenAI Джейсон Квон (Jason Kwon) провёл переговоры с инвесторами в Японии и Корее. Вице-президент OpenAI по глобальной политике Крис Лихейн (Chris Lehane) пообщался с инвесторами в Канаде. А Альтман провел дополнительные переговоры с инвесторами в ОАЭ, с которыми уже общался ранее, сообщили источники. Также он общался с инвесторами из США. Отвечая на вопрос о планах по развитию инфраструктуры, представитель OpenAI заявил, что компания «считает, что создание дополнительной инфраструктуры в США имеет решающее значение для дальнейшего развития ИИ и обеспечения широкого доступа к его преимуществам». По словам источника, знакомого с планами Альтмана, тот считает, что не только OpenAI, но и другие компании получат выгоду от инфраструктурных проектов, равно как и страны-союзники США. Дополнительным преимуществом станет создание рабочих мест для реализации проектов, дополняющих «Закон о чипах и науке» (CHIPS and Science Act). Но глобальные амбиции OpenAI могут вызвать опасения по поводу национальной безопасности США, поскольку потенциальные инвесторы — ближневосточные суверенные инвестиционные фонды — известны связями с Китаем. Во всяком случае, в последние месяцы OpenAI проводила встречи с Советом национальной безопасности США (NSC) по поводу планируемых инвестиций. В ходе этих переговоров, а также встреч с рядом официальных лиц США, руководители OpenAI подчёркивали, что инициатива поможет укрепить геополитическое преимущество Америки, создав многонациональную коалицию для конкуренции с китайскими структурами. В противном случае иностранный капитал получат китайские ИИ-проекты.

03.09.2024 [11:04], Сергей Карасёв

Стартап xAI Илона Маска запустил ИИ-кластер со 100 тыс. ускорителей NVIDIA H100Илон Маск (Elon Musk) объявил о том, что курируемый им стартап xAI запустил кластер Colossus, предназначенный для обучения ИИ. На сегодняшний день в состав этого вычислительного комплекса входят 100 тыс. ускорителей NVIDIA H100, а в дальнейшем его мощности будут расширяться. Напомним, xAI реализует проект по созданию «гигафабрики» для задач ИИ. Предполагается, что этот суперкомпьютер в конечном итоге будет насчитывать до 300 тыс. новейших ускорителей NVIDIA B200. Оборудование для платформы поставляют компании Dell и Supermicro, а огромный дата-центр xAI расположен в окрестностях Мемфиса (штат Теннесси). «В эти выходные команда xAI запустила кластер Colossus для обучения ИИ со 100 тыс. карт H100. От начала до конца всё было сделано за 122 дня. Colossus — самая мощная система обучения ИИ в мире», — написал Маск в социальной сети Х. По его словам, в ближайшие месяцы вычислительная мощность платформы удвоится. В частности, будут добавлены 50 тыс. изделий NVIDIA H200. Маск подчёркивает, что Colossus — это не просто еще один кластер ИИ, это прыжок в будущее. Основное внимание в рамках проекта будет уделяться использованию мощностей Colossus для расширения границ ИИ: планируется разработка новых моделей и улучшение уже существующих. Ожидается, что по мере масштабирования и развития система станет важным ресурсом для широкого сообщества ИИ, предлагая беспрецедентные возможности для исследований и инноваций. Запуск столь производительного кластера всего за 122 дня — это значимое достижение для всей ИИ-отрасли. «Удивительно, как быстро это было сделано, и для Dell Technologies большая честь быть частью этой важной системы обучения ИИ», — сказал Майкл Делл (Michael Dell), генеральный директор Dell Technologies.

28.08.2024 [16:47], Руслан Авдеев

Дата-центр xAI в Мемфисе загрязняет воздух своими генераторами, но других мощных источников энергии у ЦОД пока нетНКО Campaign group the Southern Environmental Law Center (SELC) призывает власти расследовать деятельность компании xAI Илона Маска (Elon Musk). По данным Datacenter Dynamics, активисты обвиняют ИИ-стартап в том, что используемые на территории его дата-центра генераторы усугубляют ситуацию с загрязнением воздуха в регионе. Представители SELC обратились в департамент здравоохранения округа Шелби (Shelby) штата Теннесси США, утверждая, что на площадке xAI в южной части Мемфиса применяется 18 генераторов, на использование которых необходимо получить разрешение властей. ЦОД xAI расположен на месте бывшего завода Electrolux площадью 69 677 м2, который закрылся в 2022 году. Илон Маск ранее заявлял, что со временем дата-центр будет использовать до 100 тыс. ускорителей NVIDIA H100 (часть которых забрали у Tesla) для обучения и обеспечения работы языковой модели Grok. Второй кластер из 300 тыс. ускорителей B200 планируется ввести в эксплуатацию в следующем году.

Источник изображения: Gabriel Tovar/unspalsh.com Для этого потребуется много энергии. В xAI пообещали вложить $24 млн в строительство подстанции, которая обеспечит ЦОД до 150 МВт (если одобрит оператор энергосети штата), но пока центр имеет доступ только к 7 МВт. Для решения проблемы подготовлены 14 генераторов Voltagrid на природном газе, каждый из которых способен обеспечить до 2,5 МВт. В письме SELC говорится, что компания Solar Turbines также установила на территории четыре турбины SMT-130 мощностью по 16 МВт. Предполагается, что это только усугубит проблему низкого качества воздуха в округе Шелби. Уровень приземного озона в регионе уже превышал допустимые нормы в последние три года, и вероятно, то же самое произойдёт и в 2024 году. Загрязнение озоном обостряет заболевания лёгких, такие как эмфизема и хронический бронхит, и увеличивает частоту приступов астмы. Между тем, генераторы xAI, предположительно, выбрасывают около 130 тонн прекурсоров O3 — оксидов азота (NOx) — ежегодно, что делает их девятым по масштабу источником таких оксидов в округе. SELC, выступающая от имени нескольких жилых сообществ Мемфиса, добавила, что минимальным требованием является получение разрешений для четырёх 16-МВт турбин до их установки и ввода в эксплуатацию — даже если они временные. Также необходимо потребовать получение разрешений на малые генераторы. Департамент здравоохранения округа призвали отреагировать на эксплуатацию генераторов без разрешений и принять предусмотренные законом меры за их использование без соответствующих разрешений. SELC уже не первый год борется со строительством дата-центра xAI. В июле группа предупредила о «вредоносных последствиях» для местных жителей из-за роста нагрузки на энергосети Мемфиса. Утверждается, что объект требует «непостижимые» 150 МВт уже к концу 2024 года — столько энергии достаточно для питания 100 тыс. домохозяйств. Это может сказаться на здоровье и даже жизнях местных жителей, поскольку во время пиковых нагрузок люди могут остаться без отопления или кондиционеров. Компания Маска также вызвала недовольство местных властей, которые заявили, что узнали о планах строительства дата-центра из средств массовой информации.

27.08.2024 [12:08], Сергей Карасёв

Стартап FuriosaAI представил эффективный ИИ-ускоритель RNGD для LLM и мультимодальных моделейЮжнокорейский стартап FuriosaAI на мероприятии анонсировал специализированный чип RNGD (произносится как «Renegade»), который позиционируется в качестве альтернативы ускорителям NVIDIA. Новинка предназначена для работы с большими языковыми моделями (LLM) и мультимодальным ИИ. FuriosaAI основана в 2017 году тремя инженерами, ранее работавшими в AMD, Qualcomm и Samsung. Своё первое решение компания выпустила в 2021 году: чип Warboy представляет собой высокопроизводительный ЦОД-ускоритель, специально разработанный для рабочих нагрузок компьютерного зрения. Новое изделие RNGD, как утверждает FuriosaAI, является результатом многолетних инноваций. Чип изготавливается по 5-нм техпроцессу TSMC. ИИ-ускоритель на базе RNGD выполнен в виде карты расширения PCIe 5.0 x16. Он наделён 48 Гбайт памяти HBM3 с пропускной способностью до 1,5 Тбайт/с и 256 Мбайт памяти SRAM (384 Тбайт/с). Показатель TDP находится на уровне 150 Вт, что позволяет использовать устройство в системах с воздушным охлаждением. Для сравнения: у некоторых ускорителей на базе GPU величина TDP достигает 1000 Вт и более. Утверждается, что RNGD обеспечивает производительность до 512 Тфлопс в режиме FP8 и до 256 Тфлопс в режиме BF16. Быстродействие INT8/INT4 достигает 512/1024 TOPS. Карта позволяет эффективно запускать открытые LLM, такие как Llama 3.1 8B. Говорится, что один PCIe-ускоритель RNGD обеспечивает пропускную способность от 2000 до 3000 токенов в секунду (в зависимости от длины контекста) для моделей с примерно 10 млрд параметров. В системе можно объединить до восьми карт для работы с моделями, насчитывающими около 100 млрд параметров. RNGD основан на архитектуре свёртки тензора (Tensor Contraction Processor, TCP), которая, как отмечается, обеспечивает оптимальный баланс между эффективностью, программируемостью и производительностью. Программный стек состоит из компрессора моделей, сервисного фреймворка, среды выполнения, компилятора, профилировщика, отладчика и набора API для простоты программирования и развёртывания. Говорится, что чипы RNGD можно настроить для выполнения практически любой рабочей нагрузки LLM или мультимодального ИИ.

19.08.2024 [12:52], Сергей Карасёв

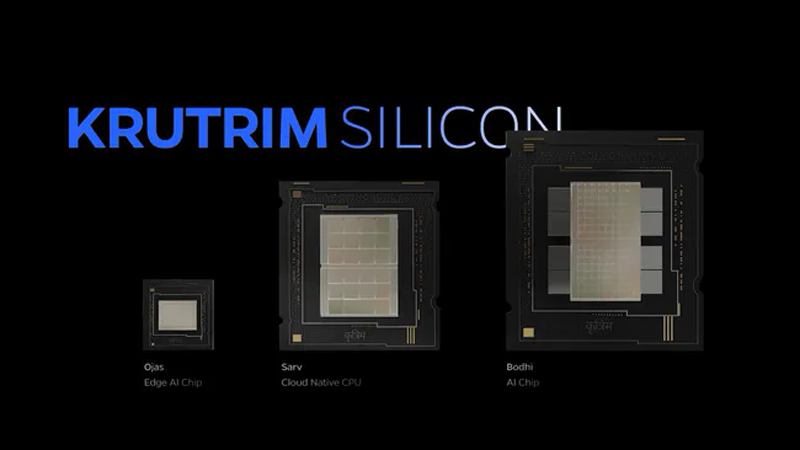

Ola представила индийские ИИ-чипы Bodhi 1, Ojas и Sarv 1Компания Ola-Krutrim, дочернее предприятие одного из крупнейших в Индии производителей электрических двухколёсных транспортных средств Ola Electric, по сообщению Tom's Hardware, объявила о разработке первых в стране специализированных чипов для задач ИИ. Анонсированы изделия Bodhi 1, Ojas и Sarv 1. Впоследствии выйдет решение Bodhi 2. Но, судя по всему, речь всё же идёт о совместной работе с Untether AI. Чип Bodhi 1 предназначен для инференса, благодаря чему может использоваться при обработке больших языковых моделей (LLM) и визуальных приложений. По заявлениям Ola Electric, Bodhi 1 обеспечивает «лучшую в своём классе энергоэффективность», что является критически важным параметром для ресурсоёмких ИИ-систем. Чип Sarv 1, в свою очередь, ориентирован на облачные платформы и дата-центры, обрабатывающие ИИ-нагрузки. Процессор Sarv 1 базируется на наборе инструкций Arm. Изделие Ojas предназначено для работы на периферии и может быть оптимизировано под специфичные задачи — автомобильные приложения, Интернет вещей, мобильные сервисы и пр. В частности, сама Ola Electric намерена применять Ojas в своих электрических скутерах следующего поколения для повышения эффективности зарядки, улучшения функциональности систем помощи водителю (ADAS) и пр.

Источник изображения: Tom's Hardware В рамках презентации Ola Electric продемонстрировала, что её ИИ-решения обеспечивают более высокие производительность и энергоэффективность, нежели ускорители NVIDIA. При этом индийская компания не уточнила, с какими именно ускорителями производилось сравнение. Ожидается, что процессоры Bodhi 1, Ojas и Sarv 1 выйдут на массовый рынок в 2026 году, тогда как Bodhi 2 появится в 2028-м. О том, где планируется изготавливать изделия, пока ничего не сообщается. Одновременно с анонсом индийских чипов производитель ИИ-ускорителей Untether AI объявил о сотрудничестве с Ola-Krutrim, в рамках которого была продемонстрирована производительность текущих решений speedAI и было объявлено о совместной разработке будущих ИИ-ускорителей для ЦОД, которые будут использованы для тюнинга и инференса ИИ-моделей Krutrim. В Индии активно развивается как ИИ-индустрия (в том числе на государственном уровне), так и рынок ЦОД. Попутно страна пытается добиться технологической независимости как от азиатских, так и от западных IT-гигантов.

01.08.2024 [16:34], Владимир Мироненко

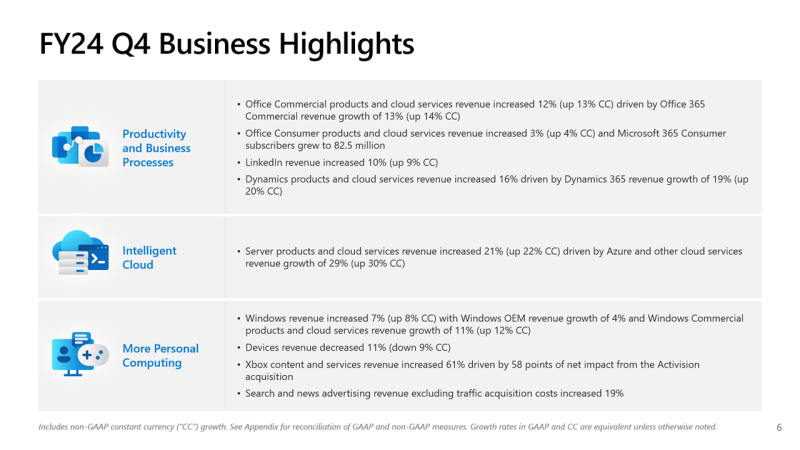

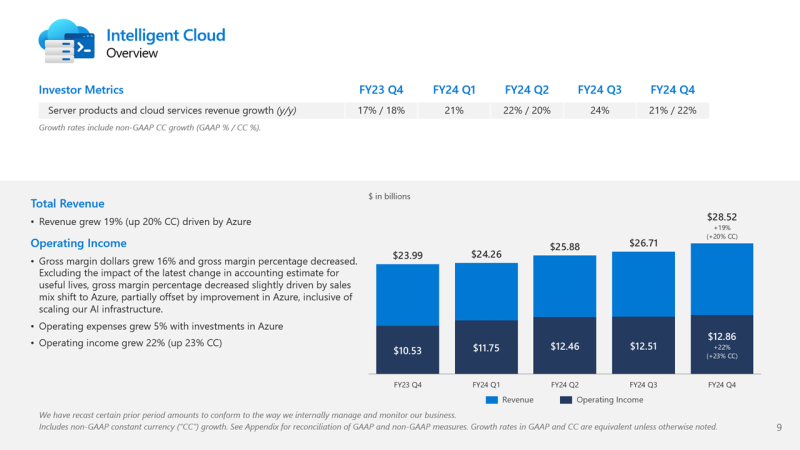

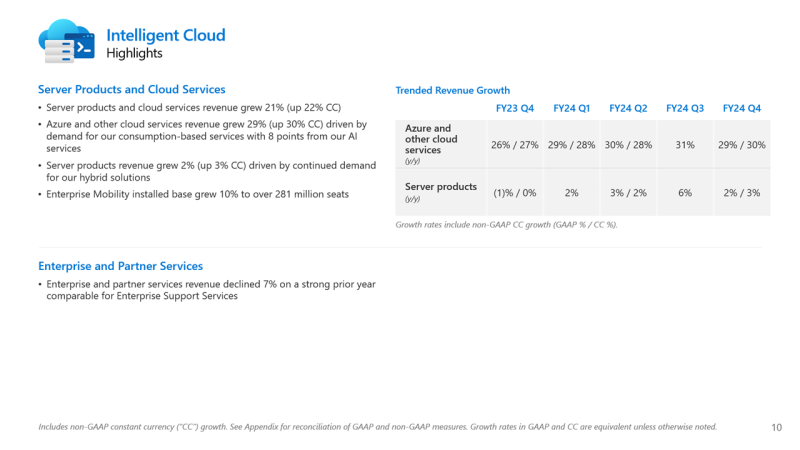

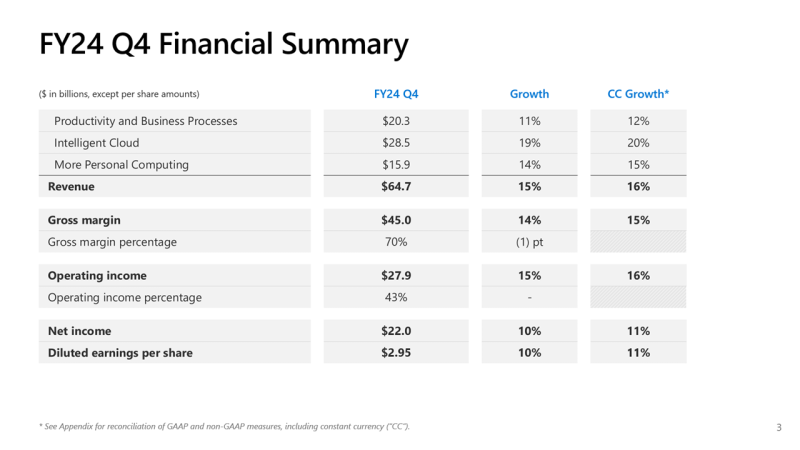

Почти половина выручки Microsoft теперь приходится на облачные сервисы, а четверть дохода Azure OpenAI принёс TikTokMicrosoft сообщила о результатах работы в IV квартале 2024 финансового года, завершившемся 30 июня. Несмотря на то, что выручка и прибыль Microsoft превысили прогнозы аналитиков, акции компании упали более чем на 7 % после публикации отчёта из-за недовольства инвесторов замедлением темпов роста облачной платформы Azure. На облачные сервисы теперь приходится около 45 % выручки корпорации. Microsoft сообщила о прибыли (GAAP) на акцию (EPS) в размере $2,95 при выручке в $64,73 млрд, превысившей показатель аналогичного квартала годом ранее на 15 %. Чистая прибыль компании увеличилась с $20,08 до $22,04 млрд. Согласно прогнозу аналитиков, опрошенных Bloomberg, показатели по прибыли и выручке могли составить $2,94 на акцию и $64,5 млрд. В IV квартале 2023 финансового года у Microsoft была прибыль на акцию в размере $2,69 и выручка в $56,19 млрд. Общий доход Microsoft от облачных вычислений составил $36,8 млрд, что полностью соответствует прогнозу Уолл-стрит, но выручка подразделения Intelligent Cloud, в которое входят облачные сервисы Azure, а также Windows Server, SQL Server, GitHub, Nuance, Visual Studio и корпоративные сервисы, оказалась ниже ожиданий аналитиков, составив $28,52 млрд (рост год к году на 19 %) при консенсус-прогнозе аналитиков, опрошенных StreetAccount, в $28,68 млрд. По данным Microsoft, на создание ЦОД и вычислительной инфраструктуры для обработки ИИ было израсходовано $13,9 млрд, что на 55 % больше, чем годом ранее. Компания заявила, что увеличение расходов было обусловлено более высокими доходами от ИИ, при этом спрос продолжает превышать предложение. Доход от Azure и других облачных сервисов вырос за квартал на 29 %. Аналитики, опрошенные CNBC и StreetAccount, ожидали рост на 31 %. При этом показатель Microsoft Azure не отставал от консенсус-прогноза с 2022 года. Абсолютные цифры в этой категории компания не раскрывает. Финансовый директор Эми Худ (Amy Hood) объяснила небольшое отставание облачного сегмента «слабостью в нескольких европейских географических регионах в плане потребления сервисов без ИИ». Как ожидает компания, эта тенденция сохранится в первой половине 2025 финансового года. Генеральный директор Microsoft Сатья Наделла (Satya Nadella), что количество клиентов Azure AI выросло на 60 %, и на 50 % увеличилось числа заказчиков ИИ, которые также используют аналитические инструменты Microsoft. Всего более 480 000 организаций использовали возможности ИИ на платформе Microsoft. По словам Наделлы, аудитория пользователей Microsoft Copilot удвоилась по сравнению с предыдущим кварталом. Он сообщил, что с нынешними темпами роста выручка GitHub превысит $2 млрд за год, что 40 % больше, чем в прошлом году. Добавим, что согласно данным ресурса The Information, ссылающегося на внутреннюю информацию компании, примерно четверть выручки Azure OpenAI принёс сервис коротких видео TikTok, чьи ежемесячные поступления составляли около $20 млн по состоянию на март 2024 года. По оценкам, служба Azure OpenAI принесёт $1 млрд за год или $83 млн в месяц. Интересно, что теперь OpenAI с точки зрения Microsoft является конкурентом, хотя IT-гигант и владеет почти половиной ИИ-компании. Продажи подразделения Microsoft Productivity and Business Processes выросли за отчётный квартал на 11 % до $20,3 млрд, превысив консенсус-прогноз аналитиков, опрошенных StreetAccount, в $20,13 млрд. Подразделение More Personal Computing принесло на 14 % больше дохода, составившего $15,90 млрд при консенсус-прогнозе аналитиков, опрошенных StreetAccount, в $15,49 млрд. Microsoft прогнозирует рост выручки Azure в I квартале 2025 финансового года в пределах 28–29 %, с более быстрым ростом во II половине финансового года, сообщила Худ. Согласно прогнозу Microsoft, выручка в I квартале 2025 финансового года составит от $63,8 млрд до $64,8 млрд, что подразумевает рост на 13,8 % в середине диапазона. Аналитики, опрошенные LSEG, прогнозируют $65,24 млрд дохода. Прогноз компании включает $15,25 млрд операционных расходов в середине диапазона, при консенсус-прогнозе StreetAccount в $16,10 млрд. |

|