Материалы по тегу: ai

|

01.08.2024 [16:34], Владимир Мироненко

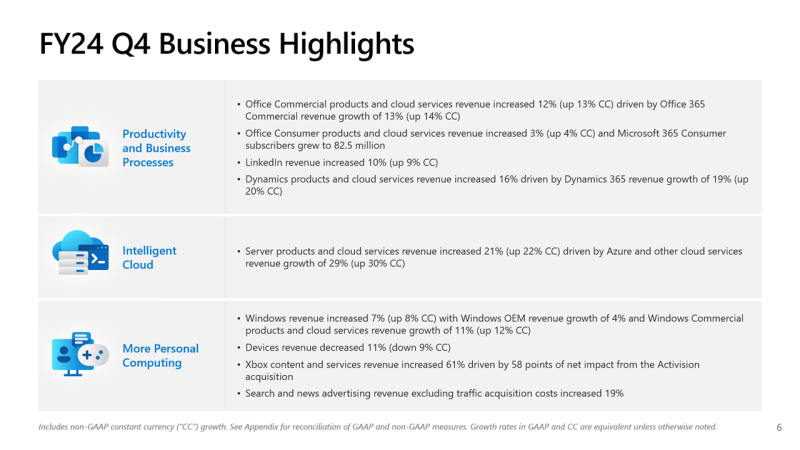

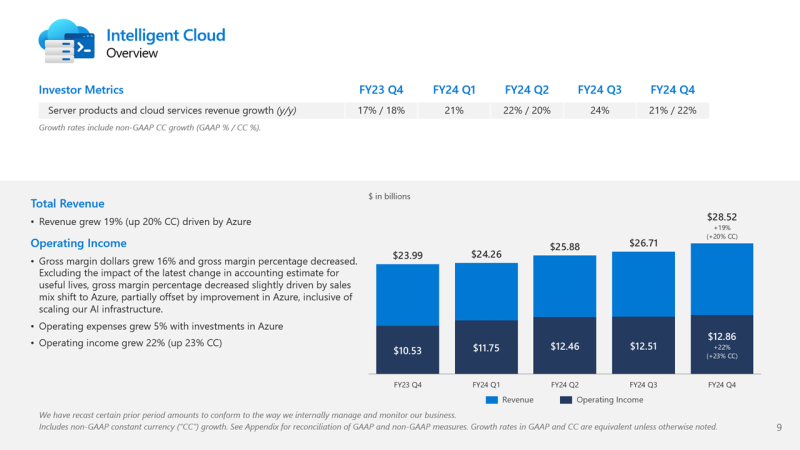

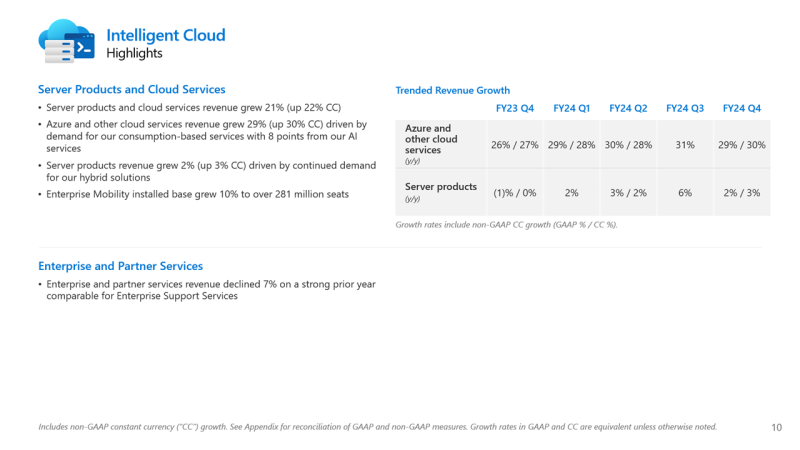

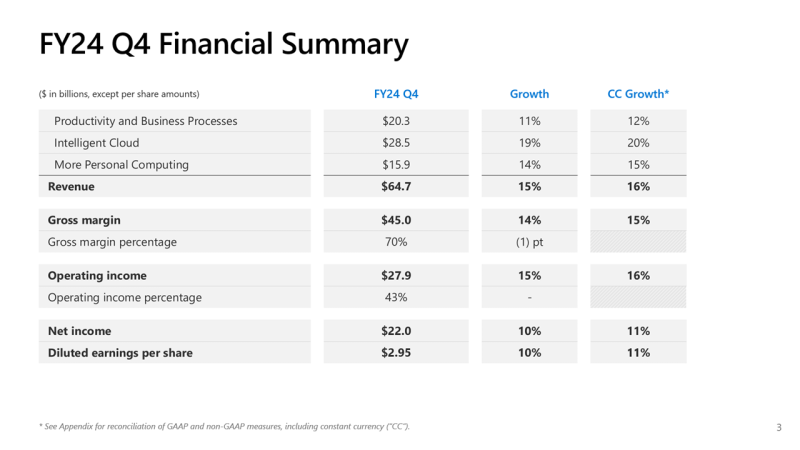

Почти половина выручки Microsoft теперь приходится на облачные сервисы, а четверть дохода Azure OpenAI принёс TikTokMicrosoft сообщила о результатах работы в IV квартале 2024 финансового года, завершившемся 30 июня. Несмотря на то, что выручка и прибыль Microsoft превысили прогнозы аналитиков, акции компании упали более чем на 7 % после публикации отчёта из-за недовольства инвесторов замедлением темпов роста облачной платформы Azure. На облачные сервисы теперь приходится около 45 % выручки корпорации. Microsoft сообщила о прибыли (GAAP) на акцию (EPS) в размере $2,95 при выручке в $64,73 млрд, превысившей показатель аналогичного квартала годом ранее на 15 %. Чистая прибыль компании увеличилась с $20,08 до $22,04 млрд. Согласно прогнозу аналитиков, опрошенных Bloomberg, показатели по прибыли и выручке могли составить $2,94 на акцию и $64,5 млрд. В IV квартале 2023 финансового года у Microsoft была прибыль на акцию в размере $2,69 и выручка в $56,19 млрд. Общий доход Microsoft от облачных вычислений составил $36,8 млрд, что полностью соответствует прогнозу Уолл-стрит, но выручка подразделения Intelligent Cloud, в которое входят облачные сервисы Azure, а также Windows Server, SQL Server, GitHub, Nuance, Visual Studio и корпоративные сервисы, оказалась ниже ожиданий аналитиков, составив $28,52 млрд (рост год к году на 19 %) при консенсус-прогнозе аналитиков, опрошенных StreetAccount, в $28,68 млрд. По данным Microsoft, на создание ЦОД и вычислительной инфраструктуры для обработки ИИ было израсходовано $13,9 млрд, что на 55 % больше, чем годом ранее. Компания заявила, что увеличение расходов было обусловлено более высокими доходами от ИИ, при этом спрос продолжает превышать предложение. Доход от Azure и других облачных сервисов вырос за квартал на 29 %. Аналитики, опрошенные CNBC и StreetAccount, ожидали рост на 31 %. При этом показатель Microsoft Azure не отставал от консенсус-прогноза с 2022 года. Абсолютные цифры в этой категории компания не раскрывает. Финансовый директор Эми Худ (Amy Hood) объяснила небольшое отставание облачного сегмента «слабостью в нескольких европейских географических регионах в плане потребления сервисов без ИИ». Как ожидает компания, эта тенденция сохранится в первой половине 2025 финансового года. Генеральный директор Microsoft Сатья Наделла (Satya Nadella), что количество клиентов Azure AI выросло на 60 %, и на 50 % увеличилось числа заказчиков ИИ, которые также используют аналитические инструменты Microsoft. Всего более 480 000 организаций использовали возможности ИИ на платформе Microsoft. По словам Наделлы, аудитория пользователей Microsoft Copilot удвоилась по сравнению с предыдущим кварталом. Он сообщил, что с нынешними темпами роста выручка GitHub превысит $2 млрд за год, что 40 % больше, чем в прошлом году. Добавим, что согласно данным ресурса The Information, ссылающегося на внутреннюю информацию компании, примерно четверть выручки Azure OpenAI принёс сервис коротких видео TikTok, чьи ежемесячные поступления составляли около $20 млн по состоянию на март 2024 года. По оценкам, служба Azure OpenAI принесёт $1 млрд за год или $83 млн в месяц. Интересно, что теперь OpenAI с точки зрения Microsoft является конкурентом, хотя IT-гигант и владеет почти половиной ИИ-компании. Продажи подразделения Microsoft Productivity and Business Processes выросли за отчётный квартал на 11 % до $20,3 млрд, превысив консенсус-прогноз аналитиков, опрошенных StreetAccount, в $20,13 млрд. Подразделение More Personal Computing принесло на 14 % больше дохода, составившего $15,90 млрд при консенсус-прогнозе аналитиков, опрошенных StreetAccount, в $15,49 млрд. Microsoft прогнозирует рост выручки Azure в I квартале 2025 финансового года в пределах 28–29 %, с более быстрым ростом во II половине финансового года, сообщила Худ. Согласно прогнозу Microsoft, выручка в I квартале 2025 финансового года составит от $63,8 млрд до $64,8 млрд, что подразумевает рост на 13,8 % в середине диапазона. Аналитики, опрошенные LSEG, прогнозируют $65,24 млрд дохода. Прогноз компании включает $15,25 млрд операционных расходов в середине диапазона, при консенсус-прогнозе StreetAccount в $16,10 млрд.

25.07.2024 [09:59], Сергей Карасёв

OpenAI намерена потратить до $7 млрд на обучение ИИ в 2024 году, потеряв при этом $5 млрдЗатраты OpenAI на обучение ИИ-моделей и задачи инференса в 2024 году, по сообщению The Information, могут составить до $7 млрд. При этом компания может зафиксировать денежные потери в размере $5 млрд, что вынудит её искать новые возможности для привлечения инвестиций. Как рассказали осведомлённые лица, OpenAI использует мощности, эквивалентные приблизительно 350 тыс. серверов с ускорителями NVIDIA A100. Из них около 290 тыс. обеспечивают работу ChatGPT. Утверждается, что оборудование работает практически на полную мощность. В рамках обучения ИИ-моделей и инференса OpenAI получает значительные скидки от облачной платформы Microsoft Azure. В частности, Microsoft взимает с OpenAI около $1,3/час за ускоритель A100, что намного ниже обычных ставок. Тем не менее, только на обучение ChatGPT и других моделей OpenAI может потратить в 2024 году около $3 млрд.

Источник изображения: pixabay.com На сегодняшний день в OpenAI работают примерно 1500 сотрудников, и компания продолжает расширять штат. Затраты на заработную плату и содержание работников в 2024-м могут достичь $1,5 млрд. Компания получает около $2 млрд в год от ChatGPT и может получить ещё примерно $1 млрд от взимания платы за доступ к своим большим языковым моделям (LLM). Общая выручка OpenAI, согласно недавним результатам, лежит на уровне $280 млн в месяц. В 2024 году, по оценкам, суммарные поступления компании окажутся в диапазоне от $3,5 млрд до $4,5 млрд. Таким образом, с учётом ожидаемых затрат в размере $7 млрд на обучение ИИ и инференс, а также расходов в $1,5 млрд на персонал OpenAI может потерять до $5 млрд. Это намного превышает прогнозируемые расходы конкурентов, таких как Anthropic (поддерживается Amazon), которая ожидает, что в 2024 году потратит $2,7 млрд. Не исключено, что OpenAI попытается провести очередной раунд финансирования. Компания уже завершила семь инвестиционных раундов, собрав в общей сложности более $11 млрд.

23.07.2024 [01:20], Владимир Мироненко

Стартап xAI Илона Маска запустил ИИ-кластер в Теннеси [Обновлено]Илон Маск объявил в соцсети X (ранее Twitter) о запуске стартапом xAI в дата-центре в Мемфисе «самого мощного в мире кластера для обучения ИИ», который будет использоваться для создания «самого мощного в мире по всем показателям искусственного интеллекта к декабрю этого года», пишет Tom's Hardware. Однако, судя по всему, на практике сейчас работает лишь очень небольшая часть кластера. «Отличная работа команды @xAI, команды @X, @Nvidia и компаний поддержки, которые начали обучение с кластером Memphis Supercluster примерно в 4:20 утра по местному времени. 100 тыс. H100 с жидкостным охлаждением в единой RDMA-фабрике — это самый мощный кластер обучения ИИ в мире!», — сообщил миллиардер в своём аккаунте. Как указали в xAI, новая вычислительная система будет использоваться для обучения новой версии @grok, которая будет доступна премиум-подписчикам @x. Ранее появились сообщения о том, что оборудование для ИИ-кластера будут поставлять Dell и Supermicro. Комментируя нынешнее заявление Маска, гендиректор Supermicro Чарльз Лян (Charles Liang) подтвердил, что большая часть оборудования для ИИ-кластера была поставлена его компанией. В мае этого года Маск поделился планами построить гигантский суперкомпьютер для xAI для работы над следующей версией чат-бота Grok, который будет включать 100 тыс. ускорителей Nvidia H100. А в следующем году Илон Маск планирует запустить ещё один кластер, который будет содержать 300 тыс. ускорителей NVIDIA B200. Для его создания Маск намеревался привлечь Oracle, планируя выделить $10 млрд на аренду ИИ-серверов компании, но затем отказался от этой идеи, так как его не устроили предложенные Oracle сроки реализации проекта. Как отметил ресурс Tom's Hardware, новый ИИ-кластер стартапа xAI превосходит все суперкомпьютеры из TOP500 с точки зрения количества ускорителей. Самые мощные в мире суперкомпьютеры, такие как Frontier (37 888 ускорителей AMD), Aurora (60 000 ускорителей Intel) и Microsoft Eagle (14 400 ускорителей NVIDIA), похоже, значительно уступают кластеру xAI. Впрочем, технические детали о сетевой фабрике нового кластера пока не предоставлены. Но, как выясняется, не всё в заявлении Маска соответствует действительности. Аналитик Dylan Patel (Дилан Пател) из SemiAnalysis обвинил Маска во лжи, поскольку в настоящее время кластеру доступно 7 МВт мощности, чего хватит для работы примерно 4 тыс. ускорителей. С 1 августа будет доступно 50 МВт, если xAI наконец подпишет соглашение с властями Теннесси. А подстанция мощностью 150 МВт все ещё находится в стадии строительства, которое завершится в IV квартале 2024 года. Как отмечает местное издание commercial appeal, поскольку речь идёт об объекте мощностью более 100 МВт, для его подключения требуется разрешение коммунальных компаний Memphis Light, Gas and Water (MLGW) и Tennessee Valley Authority (TVA). Контракт на подключение ЦОД к энергосети с TVA не был подписан. Более того, для охлаждения ЦОД, по оценкам MLGW, потребуется порядка 4,9 тыс. м3 воды ежедневно. UPD: Дилан Пател удалил исходный твит, но уточнил текущее положение дел. От энергосети кластер сейчас потребляет 8 МВт, однако рядом с площадкой установлены мобильные генераторы (14 × 2,5 МВт), так что сейчас в кластере активны около 32 тыс. ускорителей, а в полную силу он зарабатает в IV квартале. Если контракт с TVA будет подписан, то к 1 августу кампус получит ещё 50 МВт от сети, а к концу году будет подведено 200 МВт. Для работы 100 тыс. H100 требуется порядка 155 МВт.

22.07.2024 [08:57], Сергей Карасёв

Mistral AI и NVIDIA представили корпоративную ИИ-модель Mistral NeMo 12B со «здравым смыслом» и «мировыми знаниями»Корпорация NVIDIA и французская компания Mistral AI анонсировали большую языковую модель (LLM) Mistral NeMo 12B, специально разработанную для решения различных задач корпоративного уровня — чат-боты, обобщение данных, работа с программным кодом и пр. Mistral NeMo 12B насчитывает 12 млрд параметров и использует контекстное окно в 128 тыс. токенов. Для инференса применяется формат данных FP8, что, как утверждается, позволяет уменьшить размер требуемой памяти и ускорить развёртывание без какого-либо снижения точности ответов. При обучении модели была задействована библиотека Megatron-LM, являющаяся частью платформы NVIDIA NeMo. При этом использовались 3072 ускорителя NVIDIA H100 на базе DGX Cloud. Утверждается, что Mistral NeMo 12B отлично справляется с многоходовыми диалогами, математическими задачами, программированием и пр. Модель обладает «здравым смыслом» и «мировыми знаниями». В целом, говорится о точной и надёжной работе применительно к широкому спектру приложений. Модель выпущена под лицензией Apache 2.0 и предлагается в виде NIM-контейнера. На внедрение LLM, по словам создателей, требуются считанные минуты, а не дни. Для запуска модели достаточно одного ускорителя NVIDIA L40S, GeForce RTX 4090 или RTX 4500. Среди ключевых преимуществ развёртывания посредством NIM названы высокая эффективность, низкая стоимость вычислений, безопасность и конфиденциальность. UPD 21.08.2024: компании представили Mistral-NeMo-Minitron 8B, более компактную, но не менее эффективную, по словам создателей, версию Mistral NeMo 12B, которая может работать даже на ускорителе NVIDIA RTX.

19.07.2024 [14:29], Владимир Мироненко

OpenAI обсуждала с Broadcom возможность создания собственного ИИ-ускорителяСтало известно, что компания OpenAI вела переговоры с разработчиками чипов, включая Broadcom, по поводу создания нового серверного ИИ-ускорителя. Сообщивший об этом ресурс The Information утверждает, что данная инициатива, которую возглавил руководитель OpenAI Сэм Альтман (Sam Altman), является частью более широкого плана по увеличению вычислительной мощности компании для разработки ИИ, преодолению дефицита ИИ-ускорителей и снижению зависимости от NVIDIA. На фоне этих сообщений акции Broadcom выросли на 3 %. По словам источников The Information, компания наняла несколько сотрудников Google, участвовавших в создании ИИ-ускорителей TPU. Примечательно, что Broadcom работала с Google над созданием TPU, а это означает, что у компании есть опыт разработки чипов для обработки ИИ-приложений. И у неё есть подразделение, которое занимается созданием кастомных ASIC. «Миру нужно больше инфраструктуры ИИ — больших мощностей, энергии, ЦОД и т. д. — чем в настоящее время планируют построить, — сказал ранее Альтман. — OpenAI постарается помочь!». В настоящее время доля рынка ИИ-чипов NVIDIA оценивается от 70 % до 95 % рынка, а это означает, что компании, занимающиеся ИИ, находятся в полной зависимости от неё с точки зрения доступа к вычислениям. Если OpenAI удастся создать свой ИИ-ускоритель, то ей больше не нужно будет всецело полагаться на NVIDIA.

Источник изображения: Broadcom Если бы такой чип был создан, его производство началось бы не раньше 2026 года, сообщил один из источников, поскольку отдельные детали всё ещё прорабатываются, включая вопросы упаковки и доступности памяти. Альтман вёл переговоры с южнокорейскими компаниями Samsung и SK Hynix о поставках HBM и обсуждал планы по производству чипов, сообщил The Information со ссылкой на информированные источники. Кроме того, Альтман общался с TSMC по поводу возможности выпуска нового чипа, а также увеличения поставок ИИ-ускорителей NVIDIA для его компании. OpenAI не стала подтверждать факты, изложенные в публикации The Information, но и не опровергла её. Представитель компании заявил, что «OpenAI ведёт постоянные переговоры с представителями отрасли и правительства о расширении доступа к инфраструктуре, необходимой для обеспечения широкой доступности преимуществ ИИ». Ускорители собственной разработки есть у Amazon (Trainium и Inferentia), Google (TPU), Microsoft (Maia), Meta✴ (MTIA), а также Tesla (D1). Однако все эти компании всё равно массово скупают ускорители NVIDIA для работы над ИИ или для предоставления их своим клиентам. И всё возрастающая стоимость оборудования их пока не останавливает, хотя новейший суперускоритель NVIDIA GB200 NVL72, как ожидается, будет стоить $3 млн.

12.07.2024 [15:48], Руслан Авдеев

Oracle арендует у майнеров Crusoe Energy дата-центр, чтобы разместить там ускорители NVIDIA для OpenAIOracle намерена взять в аренду ЦОД Crusoe Energy, более всего известной проектами в сфере криптомайнинга. По данным Datacenter Dynamics, речь идёт о крупной сделке в интересах облака Oracle Cloud Infrastructure, которое в свою очередь будет обслуживать OpenAI. ИИ-стартап xAI Илона Маска (Elon Musk), отказавшись от сделки с Oracle по созданию крупного ИИ-кластера, походя сообщил о другом партнёре Oracle, готовом разместить в своих ЦОД ускорители NVIDIA GB200. Теперь же выяснилось, что этим партнёром и является Crusoe Energy, а компании уже близки к заключению сделки. Crusoe сдаст ЦОД в аренду Oracle, а та разместит как минимум часть из 100 тыс. ускорителей, предназначенных для нужд Microsoft. Microsoft же предоставит их в пользование OpenAI. Ранее с Crusoe Energy сотрудничала Lancium, строившая ЦОД для криптомайнинга в техасском Абилине (Abilene). Получивший добро в 2021 году Project Artemis описывался как кампус ЦОД с питанием от возобновляемой энергии, площадью более 320 га и ёмкостью до 200 МВт с возможностью расширения до 1 ГВт. Строительство должно было начаться в I квартале 2022 года. Основанная в 2018 году Crusoe Energy начала с поставок контейнерных ЦОД на нефтяные поля, где те могли использовать попутный природный газ из скважин для генерации электричества. Сейчас компания постепенно переходит от размещения модульных ЦОД рядом с нефтяными скважинами к строительству стационарных кампусов ЦОД и предлагает типовой проект ёмкостью до 100 МВт с возможностью размещения до 100 тыс. ускорителей. Также компания предлагает HPC/ИИ-ресурсы, в том числе посредством Crusoe Cloud. В последнем ESG-докладе Crusoe заявляла, что располагает ЦОД ёмкостью порядка, а около трети облака Crusoe Cloud снабжалось энергией за счёт газа с нефтяных скважин, оставшаяся ёмкость приходилась на сторонние ЦОД. Она, в частности, арендует мощности у atNorth и Digital Realty. Также компания намерена получить ещё 100 МВт от ветряной электростанции. Многие криптовалютные компании перепрофилируют деятельность под связанные с ИИ проекты, создавая облака на основе собственных ускорителей и/или размещая чужое оборудование на своих объектах. В числе подобных компаний — CoreWeave, Core Scientific, Northern Data, Hut 8 и Applied Digital.

09.07.2024 [23:33], Владимир Мироненко

$10-млрд сделка между Oracle и xAI сорваласьИИ-стартап Илона Маска (Elon Musk) xAI отказался от планов по расширению сотрудничества с Oracle. Как пишет The Wall Street Journal, во вторник миллиардер сообщил в соцсети X, что xAI прекратил переговоры с облачным провайдером о сделке на $10 млрд по поводу расширения аренды вычислительных мощностей, поскольку стартап сам построит «самый мощный кластер для обучения [ИИ-моделей] в мире с большим запасом». Сообщивший ранее о срыве сделки ресурс The Information рассказал, что многолетнее соглашение об аренде у Oracle запланированного к строительству суперкомпьютера на чипах NVIDIA уже было на стадии подписания, но переговоры зашли в тупик из-за того, что Маска не устроили сроки строительства, предложенные Oracle. Oracle же заявила об отсутствии доступа к адекватному источнику энергии для работы ИИ-суперкомпьютера в выбранном xAI регионе.

Источник изображения: xAI В итоге Маск заявил, что «самый мощный суперкомпьютер в мире» будет построен стартапом в Мемфисе (штат Теннесси, США) и начнёт работу осенью 2025 года. Ранее Маск сообщил, что в течение следующих нескольких месяцев xAI развернёт кластер из 100 тыс. ускорителей NVIDIA H100 с жидкостным охлаждением, а летом следующего года запустит ещё один кластер из 300 тыс. ускорителей NVIDIA B200. Как отметил ресурс Data Center Dynamics, xAI уже арендует у Oracle около 16 тыс. ускорителей NVIDIA, что делает его одним из крупнейших клиентов провайдера облачных услуг. Стартап также использует для работы сервисы AWS и резервные мощности в ЦОД соцсети X (Twitter). Oracle также предоставляет свою ИИ-инфраструктуру Microsoft и OpenAI.

03.07.2024 [16:27], Руслан Авдеев

Технологии в обмен на ресурсы: Character.AI провела переговоры о сотрудничестве с Google, Meta✴ и xAI [Обновлено]ИИ-стартап Character.AI провёл переговоры с несколькими IT-гигантами, передаёт The Information. По слухам, компания обсуждала возможности сотрудничества с Google, Meta✴ и контролируемой Илоном Маском (Elon Musk) xAI. Основанная бывшими сотрудниками Google компания уже привлекла $150 млн на создание чат-ботов, имитирующих поведение героев аниме, игр и др. На прошлой неделе компания представила функцию Character Call, обеспечивающую голосовое общение с ИИ-аватарами, готовыми ответить на запрос пользователя. Предполагается, что это добавит популярности сервисам компании. Если бы стартапу удалось заключить сделку с одним из крупных игроков вроде Google или xAI, он получил бы доступ к огромным вычислительным ресурсам, а в ответ поделился бы интеллектуальной собственностью, связанной со своими передовыми разработками. По сведениям The Information, компания обсуждала заключение аналогичной сделки о совместном участии в исследованиях и с Meta✴ Platforms.

Источник изображения: Character.AI Пока потенциальные участники сделки, включая Character.AI, не ответили на запросы журналистов. Некоторые эксперты полагают, что у компании слишком мало собственных вычислительных ресурсов, поэтому ей неизбежно пришлось бы прибегнуть к помощи игроков покрупнее. В индустрии это уже привычная практика. Так, Alibaba Cloud предлагает стартапам ИИ-мощности в обмен на долю в компании, а различные программы поддержки начинающих компаний в области ИИ нередко предполагают «выплаты» именно облачными ресурсами, а не живыми деньгами. UPD 03.08.2024: Google наняла основателей Character.AI и лицензировала ИИ-модели компании.

29.06.2024 [12:58], Сергей Карасёв

Бывший специалист Google по СЖО присоединился к OpenAIКомпания OpenAI, по сообщению ресурса Datacenter Dynamics, наняла еще одного бывшего сотрудника Tesla и Google для развития своей вычислительной инфраструктуры. Несмотря на использование облака Microsoft Azure, OpenAI развивает собственное направление ЦОД, в связи с чем расширяет штат специалистов в соответствующей области. В OpenAI перешел Реза Хиабани (Reza Khiabani), который ранее в течение почти двух лет работал в Tesla в качестве инженера-теплотехника. Он, в частности, помогал в создании системы охлаждения для ИИ-суперкомпьютера Dojo, для которого планируется построить специальный дата-центр. Однако с реализацией проекта возникли сложности. До прихода в Tesla Хиабани проработал почти девять лет в Google, из которых основную часть времени выполнял обязанности технического менеджера, архитектора тепловых систем и технического руководителя команды по разработке СЖО для ИИ-ускорителей семейства Cloud TPU. Он курировал проектирование ЦОД, тепловой дизайн TPU и «разработку машстабных систем жидкостного охлаждения». В OpenAI Хиабани войдёт в техническую команду. Чем именно ему предстоит заниматься, не уточняется. Но можно предположить, что его работа снова будет связана с решениями СЖО для дата-центров, ориентированных на ресурсоёмкие приложения ИИ. OpenAI активно нанимает бывших специалистов Tesla и Google. В частности, ранее ИИ-компания назначила бывшего руководителя Google TPU Ричарда Хо (Richard Ho) главой отдела аппаратного обеспечения. В OpenAI также перешли ветеран Google Тодд Андервуд (Todd Underwood) и старший инженер-программист команды Tesla Dojo Клайв Чан (Clive Chan).

25.06.2024 [13:26], Сергей Карасёв

OpenAI приобрела разработчика баз данных RocksetКомпания OpenAI, создатель чат-бота ChatGPT, объявила о заключении соглашения о поглощении стартапа Rockset — разработчика специализированной СУБД, которая пригодится в работе с ИИ. Информации об ориентировочной стоимости сделки нет. Rockset была учреждена около восьми лет назад выходцами из Facebook✴. Основателями Rockset являются Венкат Венкатарамани (Venkat Venkataramani) и Дхруба Бортакур (Dhruba Borthakur), занимающие должности генерального и технического директоров соответственно. В ходе «посевной» программы было привлечено $3 млн. Затем были осуществлены раунды Series A, В и В Extended на $18,5 млн, $40 млн и $37 млн соответственно. Кроме того, выполнено долговое финансирование на $7 млн. Таким образом, в общей сложности Rockset получила на развитие $105,5 млн. Инструменты Rockset, как утверждается, позволяют пользователям, разработчикам и предприятиям лучше использовать имеющиеся данные и получать доступ к информации в реальном времени. В результате может быть повышена эффективность ИИ-приложений. Rockset также ведёт разработки в области векторных баз данных, которые обычно используются для поддержки векторного поиска — визуального, семантического и мультимодального. Такие базы помогают ускорить разработку продуктов на базе ИИ и упростить эксплуатацию соответствующих рабочих нагрузок. В рамках сделки Rockset станет частью OpenAI, а решения стартапа будут интегрированы в системы OpenAI. Существующие клиенты Rockset в краткосрочной перспективе не ощутят существенных изменений. |

|