Лента новостей

|

29.03.2024 [17:48], Руслан Авдеев

Bain Capital ищет партнёров для продажи части активов китайского оператора ChindataАмериканская инвестиционная компания Bain Capital, по слухам, ищет новых партнёров, готовых поддержать китайского оператора дата-центров Chindata. Bloomberg сообщает, что от партнёров ожидают покупки некоторых активов компании. Сама Bain Capital продолжит получать доходы за обслуживание и поддержку операций на площадках китайской компании, а вырученные от продажи прав собственности на некоторые объекты средства потратит на расширение бизнеса ChinData. Часть полученных денег, вероятно, будет распределена среди инвесторов в качестве дивидендов. Правда, в самой Bain слухи пока не комментируют. Сегодня Chindata выступает оператором более 17 ЦОД в Китае, Малайзии и Таиланде, причём управлением некитайскими объектами занимается дочернее предприятие — Bridge Data Centers. Впрочем, более 90 % выручки поступает именно из Китая, а крупнейшим клиентом компании является владеющая TikTok китайская ByteDance.

Источник изображения: Chindata Основанная в 2015 году компания Chindata куплена Bain Capital в 2019 году у Wangsu Science & Technology Co. и позже объединилась с Bridge Data Centers, уже входившей в портфель Bain. Новый бизнес вышел на IPO в 2020 году, причём Bain оставила себе 42 % акций. Прочие доли принадлежат и другим компаниям, включая южнокорейскую SK Holdings. В этом году ChinData, как ожидается, принесёт $600 млн. В прошлом году Bain объединила Chindata в рамках сделки стоимостью $3,16 млрд с двумя полностью принадлежавшими Bain дочерними компаниями: BCPE Chivalry Bidco Limited и BCPE Chivalry Merger Sub Limited. На тот момент GDS и EdgeConneX рассматривали возможность инвестиций в Chindata, а поддерживаемая государством China Merchants хотела выкупить оператора за $3,4 млрд, но предложение было отклонено.

29.03.2024 [17:30], Сергей Карасёв

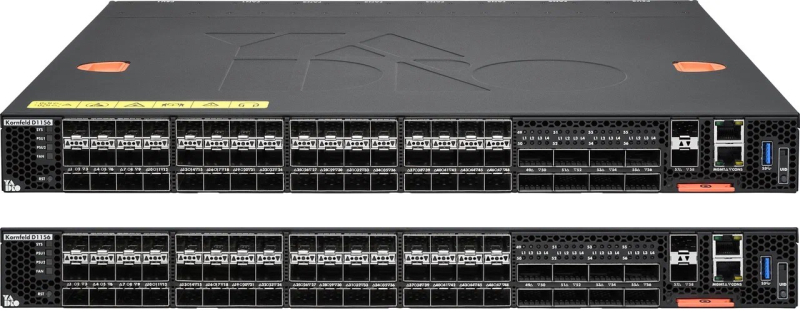

YADRO представила российский 25GbE-коммутатор KornfeldРоссийский разработчик и производитель вычислительной техники YADRO (ООО «КНС групп») анонсировал свой первый высокопроизводительный коммутатор Kornfeld для дата-центров. Устройство поддерживает обработку трафика L2 и L3, а коммутируемая ёмкость достигает 3,2 Тбит/с. Новинка выполнена в форм-факторе 1U. В основу положен неназванный ASIC с пакетным буфером объёмом 32 Мбайт, процессор Intel Xeon D-1712TR поколения Ice Lake (4C/8T; 2,0–3,1 ГГц; 40 Вт). Установлены два модулям оперативной памяти DDR4 SO-DIMM по 8 Гбайт каждый и M.2 SSD ёмкостью 120 Гбайт. Коммутатор оборудован 48 портами 10/25GbE SFP28 и восемью портами 25/40/100GbE QSFP28. Для управления служат разъёмы RJ-45 (1GbE и последовательный порт) и два коннектора SFP+ 1/10GbE. Имеется также порт USB Type-A. Устройство поддерживает традиционный набор протоколов, включая OSPF, BGP, ECMP, VRRP, MLAG и интерфейсы управления SSH, SNMP, REST API. Поддерживаются протоколы аутентификации TACACS+ и RADIUS, сети VLAN (802.1Q), агрегация LACP, а также LLDP. Коммутатор получил загрузчик ONIE и фирменную NOS Kornfeld. Новинка имеет размеры 434 × 536 × 44 мм и весит примерно 10 кг. Установлены два блока питания мощностью 800 Вт с возможностью резервирования. За охлаждение отвечают шесть вентиляторов с функцией горячей замены. Диапазон рабочих температур — от +10 до +35 °C. Коммутатор производится на заводе полного цикла «Ядро Фаб Дубна» и соответствуют всем требованиям к отечественному оборудованию согласно ПП878 (ТОРП). «Kornfeld — это полностью наша разработка, начиная от аппаратной платформы и заканчивая программным обеспечением. Мы стремились создать продукт с оптимальным сочетанием функциональности, производительности и надёжности, который бы максимально подходил для высоконагруженных ЦОД и удовлетворял потребности клиентов в различных сценариях использования, — отмечает директор по продуктам компании YADRO.

29.03.2024 [13:48], Сергей Карасёв

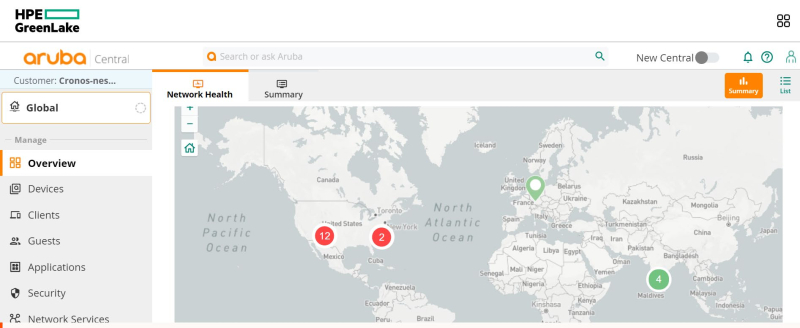

HPE внедрила генеративный ИИ в облачную платформу Aruba Networking CentralКомпания HPE объявила о внедрении нескольких больших языковых моделей (LLM) в облачную платформу Aruba Networking Central, которая предоставляет IT-специалистам аналитическую информацию, интуитивно понятную визуализацию данных, средства автоматизации рабочих процессов и пр. Сообщается, что LLM отвечают за работу функций на основе генеративного ИИ. Это, в частности, чат-бот, интегрированный в поисковый интерфейс. После ввода запроса система выдаёт контекстуализированный ответ, на подготовку которого, как утверждается, уходят доли секунды. При этом ИИ не принимает никакие административные решения самостоятельно. Модели обучены на собственных наборах данных компании. Это всевозможные документы службы поддержки, примерно 3 млн запросов клиентов и другие сведения, собранные за годы работы. HPE подчёркивает, что модели помещены в песочницу. При этом реализованы специальные средства, предназначенные для исключения личной и корпоративной информации из запросов, чтобы предотвратить её попадание в будущие наборы обучающих данных. HPE Aruba Networking собрала телеметрию почти с 4 млн сетевых устройств и более чем с 1 млрд уникальных конечных точек клиентов. В результате было сформировано одно из крупнейших озёр данных в сетевой отрасли. Эта информация используется в сервисах машинного обучения HPE Aruba Networking Central для прогнозного анализа и рекомендаций. Внедрение LLM поможет расширить ИИ-возможности платформы. На базе LLM, как отмечается, также будет работать функция обобщения документов, которая заработает в апреле нынешнего года. Она позволит клиентам задавать вопросы вида «Как сделать…», после чего система создаст соответствующее руководство и предоставит ссылки на нужную техническую документацию. Это позволит ускорить решение проблем и снизить вероятность ошибок.

29.03.2024 [13:39], Сергей Карасёв

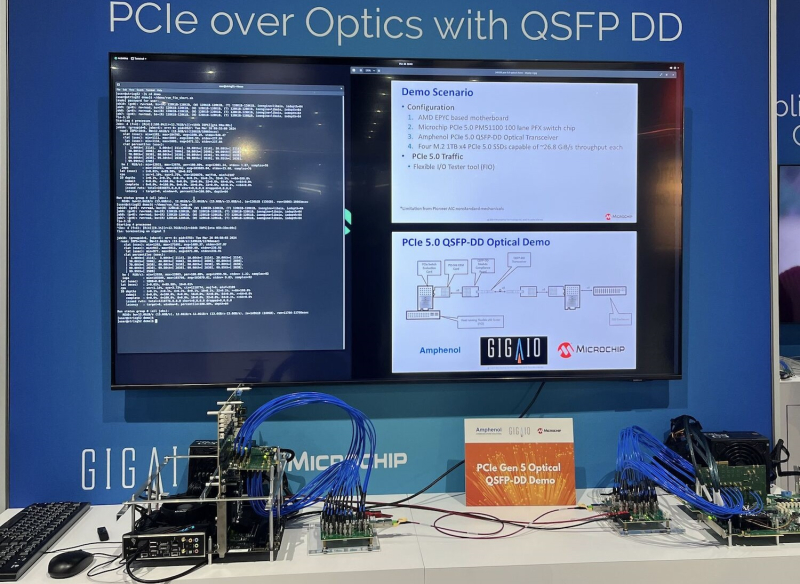

GigaIO представила оптические кабели PCIe 5.0 для развёртывания масштабных ИИ-кластеровКомпания GigaIO, разрабатывающая систему распределённого интерконнекта на базе PCI Express под названием FabreX, представила первые в отрасли оптические кабели QSFP-DD с поддержкой PCIe 5.0. Отмечается, что оптические кабели обеспечивают ряд преимуществ перед традиционными медными соединениями. Это, в частности, повышенная пропускная способность. Кроме того, длина оптических линий может превышать 3 м, что является ограничением для медных кабелей. Представленные кабели используют конфигурацию PCIe 5.0 x8 с возможностью агрегации 16 линий. Благодаря этим изделиям упрощается развёртывание высокопроизводительных систем GigaIO SuperNODE, которые позволяют связать воедино до 32 ускорителей посредством упомянутой платформы FabreX. Отмечается, что оптические кабели способны обеспечить передачу данных с высокой скоростью на десятки метров. Таким образом, несколько систем SuperNODE или SuperDuperNODE могут быть объединены в единый кластер для решения наиболее ресурсоёмких задач ИИ. Медные соединения обычно ограничивают размер кластеров двумя–тремя стойками. В случае оптических кабелей предоставляется гораздо большая гибкость в плане конфигурации оборудования. В результате системы SuperNODE могут быть развёрнуты даже в тех дата-центрах, в которых существуют жёсткие ограничения по мощности и охлаждению в расчёте на стойку. Оптические кабели QSFP-DD с поддержкой PCIe 5.0 станут доступны предстоящим летом.

29.03.2024 [13:24], Сергей Карасёв

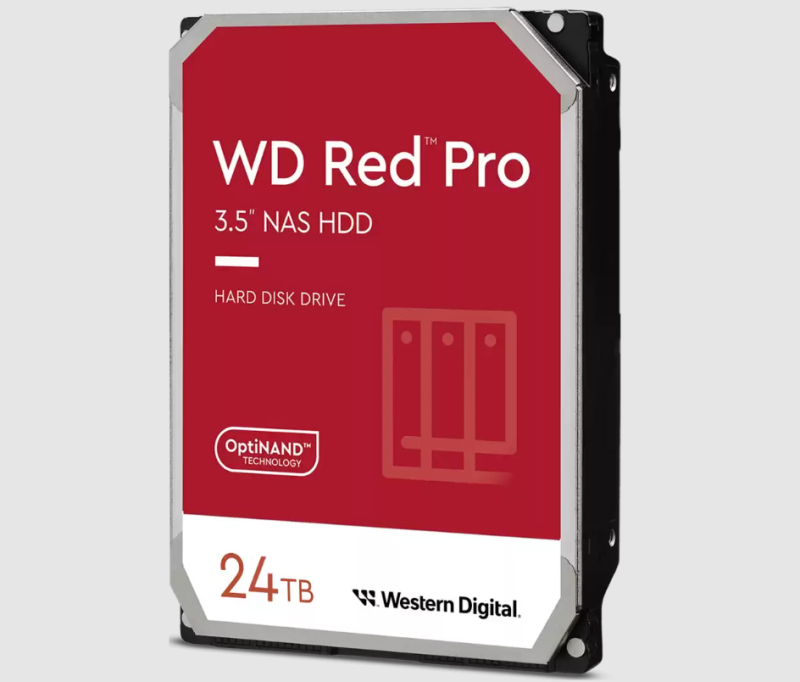

Western Digital выпустила HDD серии Red Pro вместимостью 24 Тбайт для NASКомпания Western Digital, по сообщению ресурса AnandTech, начала поставки своего самого ёмкого HDD серии Red Pro — устройства вместимостью 24 Тбайт. Новинка рассчитана на работу в круглосуточном режиме в составе NAS корпоративного уровня с большим количеством отсеков. Диск Red Pro на 24 Тбайт поступил в продажу примерно через 20 месяцев после того, как вышла модель на 22 Тбайт. HDD изготовлен в LFF-корпусе по технологии традиционной магнитной записи (CMR). Скорость вращения шпинделя составляет 7200 об/мин, объём буфера — 512 Мбайт. Для подключения служит интерфейс SATA-3. Накопитель выполнен с применением фирменной технологии OptiNAND, которая использует встроенную флеш-память iNAND для выполнения основных функций по обслуживанию: это позволяет повысить надёжность, оптимизировать производительность и энергопотребление. Встроенный датчик вибрации при вращении (Rotation Vibration, RV) помогает противодействовать эффектам, вызванным повышенной вибрацией при работе в составе NAS. Технология динамического управления высотой полёта головок при сотрясениях повышает надёжность. Благодаря рассеиванию избыточной вибрации по корпусу снижается турбулентность, сохраняется быстродействие и обеспечивается защита данных. Инструмент NASware позволяет точно настраивать параметры диска в соответствии с рабочими нагрузками NAS, что способствует улучшению быстродействия. Заявленная скорость передачи данных достигает 287 Мбайт/с. Показатель MTBF заявлен на отметке 2,5 млн часов. Среднее энергопотребление в активном режиме составляет 6,4 Вт, в режиме простоя — 3,9 Вт, в режиме сна — 1,2 Вт. Диапазон рабочих температур простирается от 0 до +65 °C. Накопитель имеет габариты 147 × 101,6 × 26,1 мм и массу около 0,67 кг. Предоставляется пятилетняя гарантия.

29.03.2024 [01:29], Владимир Мироненко

Amazon потратит почти $150 млрд на расширение ЦОД, чтобы стать лидером в области ИИВ ближайшие 15 лет Amazon планирует потратить $148 млрд на дата-центры, что позволит ей справиться с ожидаемым взрывным ростом спроса на приложения ИИ и другие цифровые сервисы, пишет Bloomberg. В прошлом году темпы роста выручки AWS упали до рекордно низкого уровня, поскольку клиенты стремились сократить расходы и откладывали реализацию проектов модернизации. Сейчас их расходы снова начинают расти, и Amazon готовит на будущее землю под расширение ЦОД и договаривается о поставках электроэнергии. Планируемые затраты Amazon на ЦОД превышают обязательства Microsoft и Google (холдинг Alphabet), хотя ни одна из компаний не раскрывает расходы, связанные с ЦОД, так последовательно, как Amazon, отметил Bloomberg. «Мы значительно расширяем мощности, — сообщил Кевин Миллер (Kevin Miller), вице-президент AWS, курирующий дата-центры компании. — Я думаю, это просто даёт нам возможность стать ближе к клиентам». Компания планирует расширить существующие ЦОД в Северной Вирджинии и Орегоне, а также развиваться в новых регионах, в том числе в Миссисипи, Саудовской Аравии и Малайзии. Эти усилия в основном направлены на удовлетворение растущего спроса на корпоративные сервисы, такие как хранение файлов и базы данных. Вместе с тем эти мощности наряду с передовыми ускорителями призваны обеспечить огромную вычислительную мощность, необходимую для ожидаемого бума генеративного ИИ. Развивая свои собственные ИИ-инструменты, чтобы конкурировать с ChatGPT компании OpenAI, и сотрудничая с другими компаниями для обеспечения поддержки ИИ-сервисов на своих серверах, Amazon рассчитывает заработать десятки миллиардов долларов. В последние годы Amazon была крупнейшим в мире корпоративным покупателем возобновляемой энергии, что является частью её обязательства обеспечить к 2025 году всю деятельность возобновляемой электроэнергией. Но эту цель реализовать не так уж и просто из-за несоответствия между спросом и предложением, которое вносит неразбериху в раздробленную энергосистему США. Миллер заявил, что компания продолжает оценивать проекты в сфере экологически чистой энергетики, включая использование аккумуляторных батарей и ядерную энергетику, которые позволят заменить электростанции, работающие на ископаемом топливе. Он пообещал найти способ «удовлетворить потребность в энергии благодаря возобновляемой, безуглеродной энергетике».

28.03.2024 [22:01], Владимир Мироненко

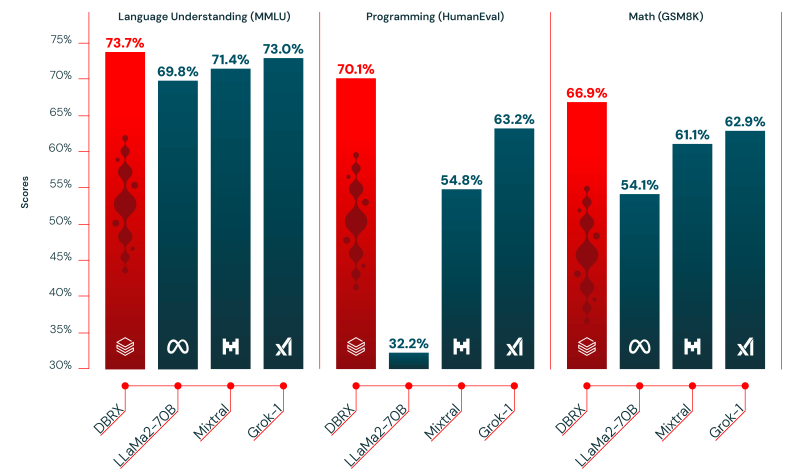

Databricks представила открытую LLM DBRX, превосходящую GPT-3.5 TurboАмериканский стартап в сфере аналитики больших данных и машинного обучения Databricks объявил о выходе DBRX, большой языковой модели (LLM) общего назначения, которая, по его словам, превосходит в стандартных бенчмарках все существующие LLM с открытым исходным кодом, а также некоторые проприетарные ИИ-модели. Стартап заявил, что открывает исходный код модели, чтобы побудить пользователей отказаться от коммерческих альтернатив. Он отметил, что согласно исследованию Andreessen Horowitz LLC, почти 60 % лидеров в области ИИ-технологий заинтересованы в увеличении использования или переходе на open source, если открытые модели после тюнинга примерно соответствуют по производительности проприетарным моделям.

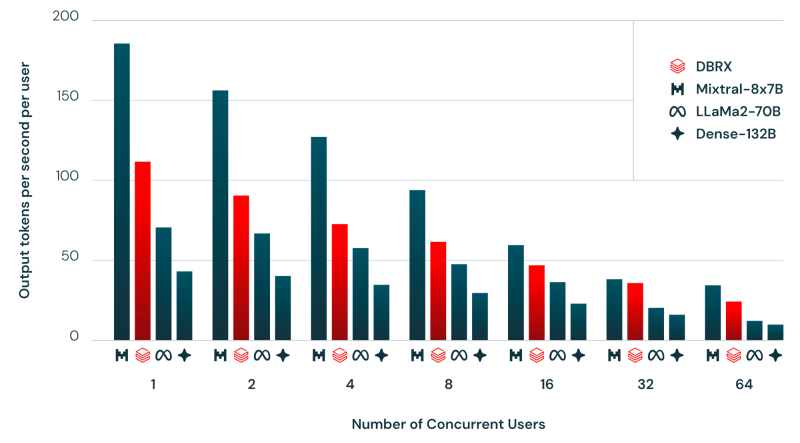

Источник изображений: Databricks «Я считаю, что самые ценные данные хранятся внутри предприятий. ИИ как бы исключён из этих сфер, поэтому мы пытаемся реализовать это с помощью моделей с открытым исходным кодом», — цитирует ресурс SiliconANGLE заявление гендиректора Databricks Али Годси (Ali Ghodsi) на брифинге с журналистами. По словам Годси, лучше всего DBRX подходит для сфер, где критически важны управление и безопасность, например, для финансовых услуг и здравоохранения, или там, где важен тон ответов, например, в области самообслуживании клиентов. DBRX использует архитектуру Mixture of Experts (MoE, набор экспертов), которая делит процесс обучения между несколькими специализированными «экспертными» подсетями. Каждый «эксперт» владеет определёнными навыками, а исходный запрос оптимальным образом распределяется между «экспертами». Вице-президент Databricks по генеративному ИИ, перешедший в компанию вместе с приобретением MosaicML, соучредителем которой он был, заявил, что MoE работает даже лучше человека. Хотя DBRX с 132 млрд параметром почти в два раза больше Llama 2, она всё равно вдвое быстрее. Также сообщается, что DBRX превзошла существующие LLM с открытым исходным кодом Llama 2 70B и Mixtral-8x7B (тоже MoE), а также запатентованную GPT-3.5 Turbo в тестах на понимание языка, программирование, математику и логику. Обучение модели на общедоступных и лицензированных источниках данных в течение двухмесячного периода обошлось Databricks всего в $10 млн с использованием 3 тыс. ускорителей NVIDIA H100. По словам компании, при создании приложений генеративного ИИ модель DBRX можно использовать вместе с Databricks Mosaic AI, набором унифицированных инструментов для создания, развёртывания и мониторинга моделей ИИ. Базовая модель DBRX Base и продвинутая модель DBRX Instruct доступны по открытой лицензии для исследований и коммерческого использования на GitHub и Hugging Face. Разработчики могут уже сегодня создавать свои варианты DBRX на основе собственных данных на платформе Databricks.

28.03.2024 [21:03], Руслан Авдеев

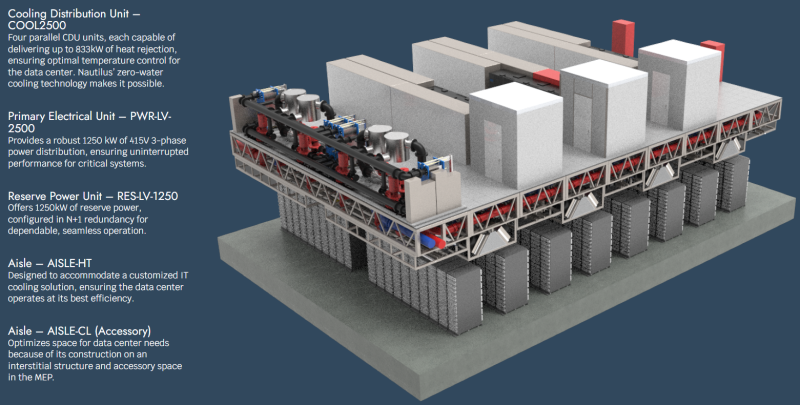

Nautilus запустила линейку инфраструктурных решений EcoCore для модульных ЦОДNautilus Data Technologies запустила новую серию решений для модульных дата-центров на основе разработанных ранее технологий охлаждения. По данным Datacenter Dynamics, новый проект предлагает варианты для ЦОД ёмкостью до 2,5 МВт. По словам Nautilus, EcoCore расширяет эффективность сборных конструкций и упрощает процесс строительства, позволяя интегрировать рабочее пространство с техническими помещениями и размещать MEP-компоненты (электрику, водоснабжение и вентиляцию) на крыше. Конструкция использует четыре CDU-установки для кондиционирования, каждая из которых способна отводить до 833 кВт тепла. Система поддерживает как традиционные варианты охлаждения, так и современные жидкостные. Основной модуль электропитания (PEU) обеспечивает мощность 1250 кВт (415 В, три фазы), но есть и точно такой же резервный (N+1). Новинка будет развёрнута в Start Campus в Синише (Португалия) — впервые за пределами собственных мощностей Nautilus. EcoCore, по словам компании, соответствует запросам Start по организации бесперебойной работы серверов высокой плотности с СЖО. Компании договорились о сотрудничестве в прошлом году и заключили «многомегаваттное» соглашение. Первый модуль EcoCore будет развёрнут в ходе первой фазы строительства кампуса Start. В Nautilus и Start заявляют, что экобезопасные технологии первой задают новый стандарт в индустрии, обеспечивая непревзойдённые эффективность и адаптивность. Nautilus известна прежде всего проектами плавучих ЦОД и системой охлаждения дата-центров речной или морской водой. Пока компания выступает лишь оператором ЦОД-баржи в Стоктоне (Калифорния), но планирует построить и наземный объект в Мэне. Также в работе находятся и другие проекты в США, Франции и Ирландии. Меморандумы о взаимопонимании заключены в Таиланде и на Филиппинах. Впрочем, появление EcoCore, похоже, указывает на желание стать поставщиком решений для других операторов. Принадлежащая инвестиционному фонду Davidson Kempner и британской British Pioneer Point Partners компания Start намерена построить 495-МВт кампус площадью 60 га в Португалии. Компании заявили, что Nautilus поставит охладительные системы и для второй фазы проекта, предусматривающего расширение на 120 МВт. Ранее Start оказалась вовлечена в коррупционный скандал.

28.03.2024 [20:42], Сергей Карасёв

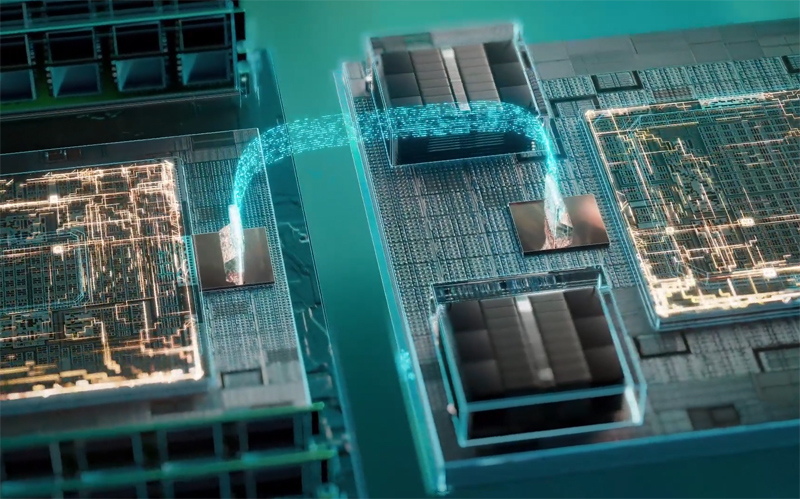

Оптика для HBM: стартап Celestial AI получил ещё $175 млн инвестиций, в том числе от AMD и SamsungКомпания Celestial AI, занимающаяся созданием технологий оптического интерконнекта, сообщила о проведении раунда финансирования Series C, в ходе которого привлечено $175 млн. Деньги будут использованы для ускорения разработки и вывода передовых продуктов на коммерческий рынок. Летом прошлого года Celestial AI объявила о разработке технологии Photonic Fabric. Она ориентирована на ИИ-платформы и системы НРС. Благодаря оптическому интерконнекту нового типа ИИ-чипы могут быть соединены с большим пулом высокопроизводительной памяти HBM3, а в перспективе — и HBM4. Таким образом, решается проблема ограниченного объёма памяти HBM в составе ИИ-ускорителей. По заявлениям Celestial AI, технология Photonic Fabric обеспечивает повышение пропускной способности и объёма доступной памяти более чем в 25 раз при одновременном снижении задержек и энергопотребления примерно в 10 раз по сравнению с существующими оптическими альтернативами и традиционными медными соединениями. Таким образом, можно масштабировать нагрузки ИИ.

Источник изображения: Celestial AI В июне 2023 года Celestial AI провела раунд финансирования Series B на сумму в $100 млн. Тогда средства предоставили IAG Capital Partners, Koch Disruptive Technologies (KDT), Temasek Xora Innovation, Samsung Catalyst, Smart Global Holdings (SGH), Porsche Automobil Holding SE, The Engine Fund, imec.xpand, M Ventures и Tyche Partners. Инвестиционная программа Series C проведена под предводительством Фонда инновационных технологий США (USIT) миллиардера Томаса Талла (Thomas Tull), основателя Legendary Entertainment. В программе также приняли участие AMD Ventures, KDT, Temasek, Xora Innovation, IAG Capital Partners, Samsung Catalyst, SGH, Porsche Automobil Holding SE, Engine Ventures, M-Ventures и Tyche Partners.

28.03.2024 [14:50], Сергей Карасёв

Canonical увеличила срок поддержки LTS-релизов Ubuntu до 12 летКомпания Canonical объявила о том, что срок поддержки LTS-релизов Ubuntu продлевается ещё на два года — до 12 лет. Новая модель выпуска обновлений будет распространяться на платформу Ubuntu 14.04 LTS и более поздние LTS-редакции, которые выходят раз в два года. В октябре 2023-го Canonical сообщила, что пользователи Ubuntu смогут получать обновления безопасности и другие критические апдейты ОС в течение десятилетнего периода. При этом срок стандартной поддержки составляет пять лет, тогда как дополнительный период приобретается в рамках платной опции Expanded Security Maintenance (ESM). Поддержка Ubuntu 14.04 LTS должна была истечь в апреле 2024 года, но в соответствии с новой схемой она продлится до апреля 2026-го. Основная поддержка, как и прежде, предоставляется в течение пятилетнего срока. Ещё семь лет будут доступны пользователям сервиса Ubuntu Pro. В частности, дополнительные два года поддержки можно приобрести в рамках опции Legacy Support. «Благодаря Legacy Support мы даём организациям возможность поддерживать их операционные потребности и инвестиции в открытый исходный код, гарантируя, что системы будут получать обновления безопасности в течение многих лет», — говорит Максимилиан Морган (Maximilian Morgan), вице-президент по технической поддержке Canonical. Таким образом, Ubuntu 16.04 LTS будет получать поддержку до 2028 года, Ubuntu 18.04 LTS — до 2030-го, Ubuntu 20.04 LTS — до 2032-го и т.д. Стоимость новой услуги Canonical пока не раскрывает. |

|