Лента новостей

|

03.06.2024 [16:59], Андрей Крупин

Облако Softline Multicloud дополнилось хранилищем S3 на базе «Кибер Инфраструктуры»Компания Softline сообщила о расширении функциональных возможностей облачной платформы Multicloud («Мультиоблако») и включении в её состав объектного хранилища S3, построенного на базе системы «Кибер Инфраструктура» российского разработчика «Киберпротект». Softline Multicloud предлагает две политики объектного хранилища: «холодное» хранилище (подходит для хранения бэкапов и данных, к которым нужен редкий доступ) и «тёплое» хранилище (подходит для хранения часто используемых данных: неструктурированных файлов, объектов, изображений, видео, программного кода, архивов, документов и так далее; применяется для частых операций чтение-запись и обеспечивает высокую скорость доступа к информации).

Ключевые особенности платформы Softline «Мультиоблако» (источник изображения: Softline) Для решения задач, связанных с созданием бэкапов, в составе «Мультиоблака» представлены инструменты для резервного копирования данных на базе решения «Кибер Бэкап Облачный» от компании «Киберпротект» и сервис резервного копирования виртуальных машин на платформе Open Nebula на базе решения от «Хайстекс». Для всех этих продуктов используется хранилище S3 на основе «Кибер Инфраструктуры». В будущем Softline планирует запустить ещё несколько сервисов с применением хранилища S3. В данный момент компания тестирует одно из решений для виртуального офиса — офисное приложение, предоставляющее доступ к почтовой системе, размещённой в облаке.

03.06.2024 [14:18], Руслан Авдеев

GitVerse развернул российское «зеркало» заблокированного Docker HubРоссийский сервис GitVerse оперативно сформировал собственное «зеркало» Docker Hub, так что теперь у пользователей из России есть доступ к актуальным docker-образам. Пресс-служба «СберТеха» («Сбербанк Технологии») сообщает, что сервис уже заработал в режиме «бета» — достаточно будет быстро перенастроить уже имеющиеся клиенты. В «СберТехе» сообщают, что размещённые на площадке образы полностью соответствуют исходным с Docker Hub. Уже опубликована инструкция по применению docker-образов и, там же, инструкция по применению альтернативного клиента podman. По словам генерального директора СберТеха, несмотря на то, что зарубежный сервис заблокирован для российских клиентов, он по-прежнему важен с точки зрения непрерывности рабочих процессов. Именно поэтому компания выпустила обновление GitVerse.

Источник изображения: Luke Peters/unsplash.com Платформа Docker Hub пользовалась большим спросом у российских индивидуальных и корпоративных пользователей, но в конце прошлого месяца доступ к ней был закрыт. Docker Hub активно используется для получения зависимостей и базовых docker-образов в ходе разработки и развёртывания ПО. При этом альтернативные репозитории и «зеркала», созданные неизвестными компаниями или лицами, могут быть опасны в связи с возможными атаками на цепочку поставок.

03.06.2024 [13:54], Сергей Карасёв

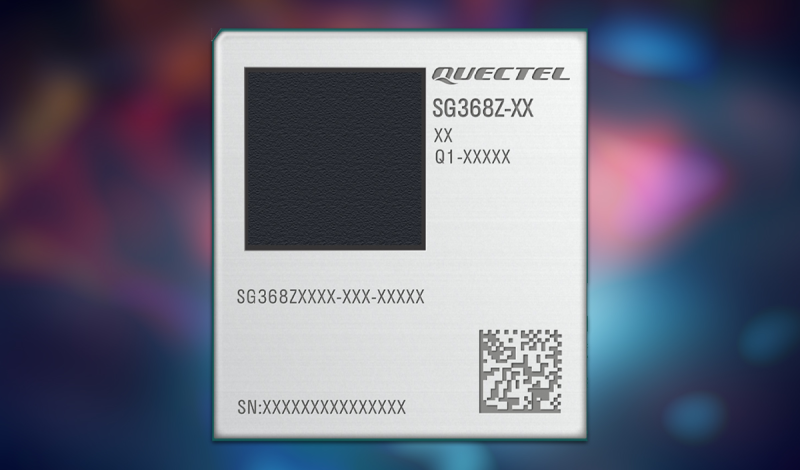

Смарт-модуль Quectel SG368Z с поддержкой Wi-Fi 5 и Bluetooth 4.2 выполнен на процессоре Rockchip RK3568Компания Quectel, по сообщению ресурса CNX Software, подготовила к выпуску смарт-модуль SG368Z в LGA-упаковке, предназначенный для устройств для умного дома, IoT-оборудования, систем промышленной автоматизации и пр. В основу изделия положена платформа Rockchip. Новинка выполнена в корпусе с размерами 46,0 × 42,0 × 3,15 мм. Задействован чип RK3568 с четырьмя ядрами Arm Cortex-A55 с тактовой частотой до 2,0 ГГц. Обработкой графики занят ускоритель Arm Mali-G52 с поддержкой OpenGL ES 1.1/2.0/3.2, OpenCL 2.0, Vulkan 1.1. Есть нейропроцессорный блок с производительностью до 0,8 TOPS. Возможна работа с видеоматериалами 4Kp60 H.264, H.265, VP9, 1080p60 MPEG-4/-2/-1, VP8, VC1. Смарт-модуль Quectel SG368Z может нести на борту 2 или 4 Гбайт оперативной памяти, а также 16 или 32 Гбайт флеш-памяти. В оснащение входят контроллеры Wi-Fi 5 и Bluetooth 4.2, два сетевых интерфейса 1GbE. Изделие может функционировать в тандеме с функциональными модулями Quectel, обеспечивающими поддержку 4G Cat 1/4, 5G, Wi-Fi 6 и GNSS. Это позволяет проектировать широкий спектр устройств для различных целей. Среди прочего упомянута поддержка интерфейсов HDMI, eDP, LVDS, MIPI и USB 2.0/3.0 (×4). Решение будет предлагаться в коммерческом и индустриальном вариантах исполнения: в первом случае диапазон рабочих температур простирается от -10 до +75 °C, во втором — от -40 до +85 °C. Говорится о совместимости с Linux, Android и OpenWrt. Новинка является основой платы для разработчиков Quectel SG368Z Smart Module Development Board, оснащённой набором различных разъёмов.

03.06.2024 [13:18], Руслан Авдеев

Dell прогнозирует рост цен на 20 % на DRAM и SSD до конца 2024 годаDell ожидает, что уже во II половине 2024 года цена DRAM и SSD вырастет на 15–20 %. По словам вице-председателя и операционного директора компании Джеффа Кларка (Jeff Clarke), цены вырастут как на компоненты, так и на логистику. The Register сообщает, что в связи с этим Dell намерена обновить цены на свою продукцию. По его словам, это связано с недостатком капитальных инвестиций, низкой загрузкой производств и другими факторами. Большая часть спроса придётся на продукцию для ИИ-серверов, за квартал принёсших Dell $1,7 млрд — рост квартал к кварталу составил более 100 %. Подобному оборудованию нужно много памяти с большой пропускной способностью, ёмкое внутренее и внешнее хранилище. По словам Кларка, компания уже начала пересмотр ценообразования с учётом новых реалий, что помогло Dell улучшить показатели своего серверного бизнеса. Речь как обычном оборудовании, так и о комплектах для ИИ. Объём невыполненных заказов на ИИ-серверы Dell достиг $3,8 млрд, но, по словам Кларка, NVIDIA справляется со спросом, поэтому задержек в поставках ускорителей H200 во II квартале опасаться не стоит. А вот ускорители B200, как и предупреждала NVIDIA, пока в дефиците.

03.06.2024 [10:53], Сергей Карасёв

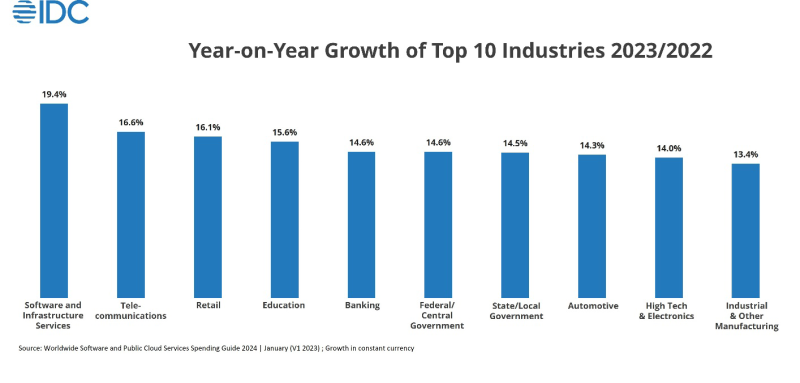

IDC: объём рынка публичных облаков и ПО в 2024 году достигнет $222 млрдКомпания IDC обнародовала свежий прогноз по глобальному рынку публичных облачных сервисов и ПО. По мнению аналитиков, затраты в соответствующих сегментах будут быстро расти на фоне стремительного развития ИИ и систем обеспечения информационной безопасности. Согласно прогнозам, в 2024 году объём отрасли публичных облаков и софта достигнет $222 млрд. Компании, как отмечается, всё чаще используют облачные среды в связи с их гибкостью, масштабируемостью и экономической эффективностью. Внедрение облачных сервисов стимулируется благодаря растущему спросу на решения для анализа больших данных, кибербезопасности и ИИ. По оценкам IDC, к 2027 году расходы на публичные облачные сервисы поднимутся до $219,3 млрд. При этом затраты на локальные платформы и другие сервисы составят ещё около 30 % от этой суммы, или приблизительно $65,8 млрд. Среди наиболее быстрорастущих направлений названы софт и инфраструктурные сервисы (+19,4 % в 2023 году), телекоммуникации (+16,6 %), ретейл (+16,1 %), образовательная сфера (+15,6 %) и банковский сектор (+14,6 %). Аналитики отмечают, что с географической точки зрения одним из наиболее активно развивающихся станет Азиатско-Тихоокеанский регион. Здесь величина CAGR (среднегодовой темп роста в сложных процентах) в плане расходов на публичные облачные сервисы и ПО в течение ближайших лет ожидается на уровне 14,2 %. Это подчёркивает «стратегическую направленность региона на цифровую трансформацию и технологические инновации». Среди факторов, сдерживающих внедрение облачных платформ, аналитики называют опасения по поводу безопасности данных, сетевые ограничения, отсутствие внутреннего опыта, желание контроля над IT-инфраструктурой и вопросы, связанные с первоначальными затратами. Поставщики услуг решают эти проблемы, повышая уровень защиты, улучшая сетевую инфраструктуру, предлагая обучение и поддержку, предоставляя гибридные/мультиоблачные варианты использования и внедряя гибкие модели ценообразования.

03.06.2024 [10:51], Сергей Карасёв

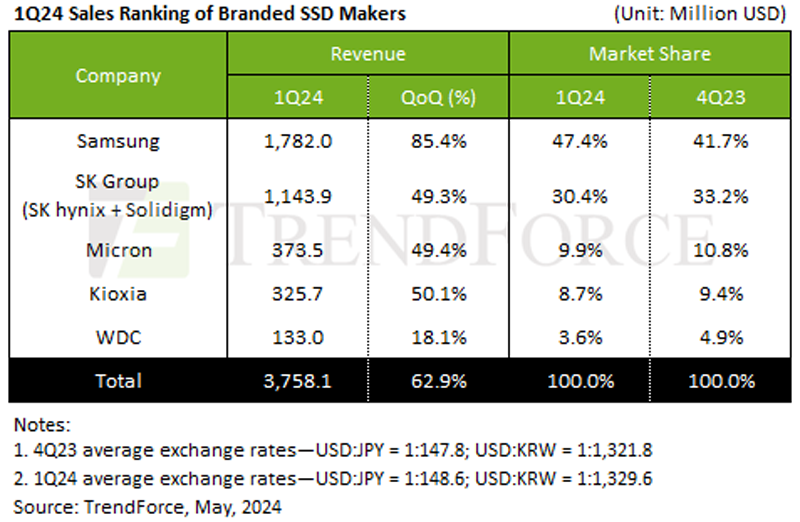

TrendForce: квартальные продажи серверных SSD взлетели на 63 %, а QLC всё чаще идёт на замену HDDКомпания TrendForce обнародовала результаты исследования мирового рынка SSD корпоративного класса в I квартале 2024 года. Отмечается, что спрос на такие накопители по сравнению с IV четвертью 2023-го подскочил на 62,9 %, что объяснятся в том числе стремительным развитием ИИ. Согласно подсчётам аналитиков, в период с января по март включительно отгрузки корпоративных SSD достигли в денежном выражении $3,76 млрд. TrendForce говорит о значительном увеличении спроса на высокопроизводительные серверы для задач ИИ. Причём заказчики из Северной Америки всё чаще используют SSD высокой ёмкости на основе чипов флеш-памяти QLC для замены HDD. Это приводит к росту поставок твердотельных накопителей.

Источник изображения: TrendForce Крупнейшим игроком мирового рынка по итогам I квартала 2024 года стала компания Samsung с долей 47,4 % и продажами в размере $1,78 млрд: рост по отношению к предыдущему кварталу зафиксирован на отметке 85,4 %. На втором месте располагается SK Group (SK hynix и Solidigm), у которой отгрузки поднялись в квартальном исчислении на 49,3 % — до $1,14 млрд, а доля оказалась на уровне 30,4 %. Замыкает тройку Micron с выручкой в размере $373,5 млн (рост на 49,4 % в квартальном сопоставлении) и долей около 9,9 %. В пятёрку ведущих игроков также вошли Kioxia и Western Digital, у которых продажи зафиксированы в объёме $325,7 млн и $133,0 млн соответственно, что соответствует 8,7 % и 3,6 % рынка. У Kioxia продажи год к году поднялись на 50,1 %, у Western Digital — на 18,1 %. Аналитики полагают, что во II квартале текущего года продажи SSD корпоративного класса увеличатся более чем на 20 %. Это приведёт к росту стоимости данной продукции примерно на 20 % и к сопоставимому увеличению объёма отрасли в денежном выражении.

03.06.2024 [09:21], Владимир Мироненко

NVIDIA объявила об интеграции NIM с KServeNVIDIA объявила, что набор инференес-микросервисов NVIDIA NIM будет работать с open source платформой KServe на базе Kubernetes, которая позволит автоматизировать развёртывание ИИ-моделей. Это также делает NIM широкодоступным на платформах различных компаний, таких как Canonical, Nutanix и Red Hat. Интеграция NIM в KServe позволяет расширить возможность использования технологий NVIDIA сообществом, партнёрами по экосистеме и клиентами. Благодаря интеграции с KServe пользователи смогут получить доступ к NIM на многих корпоративных платформах, таких как Charmed KubeFlow от Canonical, Charmed Kubernetes, Nutanix GPT-in-a-Box 2.0, Red Hat OpenShift AI и многих других.

Источник изображения: NVIDIA В рамках интеграции NIM компания NVIDIA планирует активно участвовать в продвижении KServe, опираясь на свой портфель ПО с открытым исходным кодом, включая Triton и TensorRT-LLM. NVIDIA также является активным членом фонда Cloud Native Computing Foundation. NVIDIA и ранее участвовала в разработке KServe и адаптации этого инструмента под свои нужды, равно как и AWS, Bloomberg, Canonical, Cisco, Hewlett Packard Enterprise, IBM, Red Hat, Zillow.

03.06.2024 [07:53], Владимир Мироненко

Сети и периферия: NVIDIA расширила свою программу сертификацииNVIDIA объявила о расширении программы сертифицирования систем, которая теперь включает две новых платформы: Spectrum-X и IGX. Как сообщается, каждая сертифицированная компанией система проходит тщательное тестирование и проверяется на предмет обеспечения должного уровня производительности, управляемости, безопасности и масштабируемости корпоративного уровня. Наличие сертификации свидетельствует о поддержке NVIDIA AI Enterprise, в том числе микросервисов MVIDIA NIM. Серверы, получившие сертификат NVIDIA Spectrum-X Ready, смогут выступать в качестве строительных блоков для HPC- и ИИ-кластеров и должны поддерживать современные ускорители NVIDIA. От сертифицированных периферийных систем на базе платформы NVIDIA IGX требуется долгосрочная поддержка, защищённость и проактивная безопасность, возможность удалённого управления и высокая производительность с низкой задержкой отклика. NVIDIA сообщила, что её ведущие партнёры готовы получить новые сертификаты. Такие компании, как ASUS, Dell, GIGABYTE, HPE, Ingrasys, Lenovo, QCT и Supermicro вскоре предложат сертифицированные NVIDIA системы Spectrum-X Ready. А сертифицированные NVIDIA системы IGX скоро будут доступны у ADLINK, Advantech, Aetina, Ahead, Cosmo Intelligent Medical Devices (подразделение Cosmo Pharmaceuticals), Dedicated Computing, Leadtek, Onyx и YUAN.

02.06.2024 [16:20], Сергей Карасёв

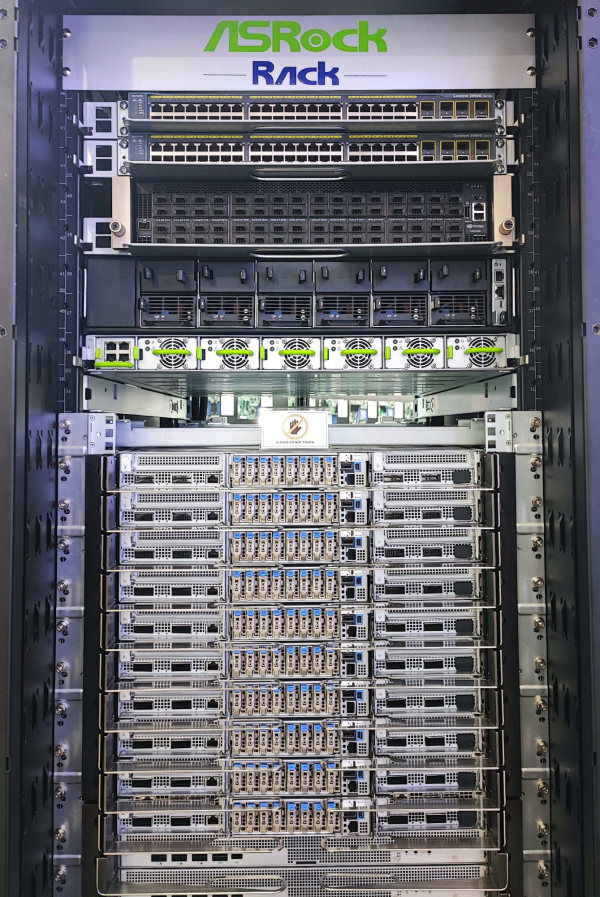

NVIDIA представила ускорители GB200 NVL2, платформы HGX B100/B200 и анонсировала экосистему следуюшего поколения Vera RubinNVIDIA сообщила о широкой отраслевой поддержке своей архитектуры нового поколения Blackwell. Эти ускорители, а также чипы Grace легли в основу многочисленных систем для ИИ-фабрик и дата-центров, которые, как ожидается, будут способствовать «следующей промышленной революции». Генеральный директор NVIDIA Дженсен Хуанг (Jensen Huang) объявил о том, что серверы на базе Blackwell выпустят ASRock Rack, ASUS, Gigabyte, Ingrasys, Inventec, Pegatron, QCT, Supermicro, Wistron и Wiwynn. Речь идёт об устройствах разного уровня, рассчитанных на облачные платформы, периферийные вычисления и ЦОД клиентов. «Началась очередная промышленная революция. Компании и целые страны сотрудничают с NVIDIA, чтобы трансформировать традиционные дата-центры общей стоимостью в триллионы долларов в платформы нового типа — фабрики ИИ», — говорит Хуанг. Для решения ИИ-задач и поддержания других ресурсоёмких приложений будут выпущены серверы с CPU на архитектурах х86 и Arm (изделия Grace) с воздушным и жидкостным охлаждением. Заказчикам будут доступны модели с одним и несколькими ускорителями. В частности, сама NVIDIA предлагает DGX-системы Blackwell, а для сторонних производителей доступны готовые платформы HGX B100 и HGX B200. Кроме того, компания представила ускоритель GB200 NVL2, т.е. сборку из двух GB200, объединённых NVLink 5. NVIDIA также сообщила о том, что модульная архитектура NVIDIA MGX отныне поддерживает Blackwell, включая и GB200 NVL2. В целом, NVIDIA MGX предлагает свыше 100 различных конфигураций. На сегодняшний день на базе MGX выпущены или находятся в разработке более 90 серверов от более чем 25 партнёров NVIDIA по сравнению с 14 системами от шести партнёров в 2023 году. В составе MGX, в частности, впервые будут использоваться изделия AMD EPYC Turin и чипы Intel Xeon 6 (ранее — Granite Rapids). Отмечается, что глобальная партнёрская экосистема NVIDIA включает TSMC, а также поставщиков различных компонентов, включая серверные стойки, системы электропитания, решения для охлаждения и пр. В число поставщиков такой продукции входят Amphenol, Asia Vital Components (AVC), Cooler Master, Colder Products Company (CPC), Danfoss, Delta Electronics и Liteon. Серверы нового поколения готовят Dell Technologies, Hewlett Packard Enterprise (HPE) и Lenovo. В скором времени NVIDIA представит улучшенные ускорители Blackwell Ultra, которые получат более современную HBM3e-память. А уже в следующем году компания покажет решения на архитектуре следующего поколения: ускорители Rubin, процессоры Vera, NVLink 6 с удвоенной пропускной способностью (3,6 Тбайт/с), коммутаторы X1600 и DPU SuperNIC CX9 для сетей 1,6 Тбит/с.

02.06.2024 [15:30], Сергей Карасёв

ASRock Rack анонсировала ИИ-системы с ускорителями NVIDIA Blackwell GB200, B200 и B100Компания ASRock Rack представила серверы с ускорителями NVIDIA Blackwell, предназначенные для решения ресурсоёмких задач в области ИИ и НРС. В частности, демонстрируются устройства, оборудованные системой жидкостного охлаждения. В число новинок на базе архитектуры NVIDIA Blackwell входят стоечная система ORV3 NVIDIA GB200 NVL72 с СЖО и сервер 6U8X-GNR2/DLC NVIDIA HGX B200 с технологией прямого жидкостного охлаждения Direct-to-chip. Второе из названных устройств выполнено в формате 6U; поддерживаются до восьми ускорителей NVIDIA HGX B200. А сервер 6U8X-EGS2 NVIDIA HGX B100, в свою очередь, рассчитан на восемь NVIDIA HGX B100. Все новые серверы ASRock Rack NVIDIA HGX допускают использование до восьми DPU NVIDIA BlueField-3 SuperNIC. ASRock Rack также продемонстрировала системы, выполненные на модульной архитектуре NVIDIA MGX. Это, в частности, двухсокетный сервер 4UMGX-GNR2 формата 4U с возможностью установки восьми ускорителей FHFL. Устройство располагает пятью слотами FHHL PCIe 5.0 x16 и одним разъёмом HHHL PCIe 5.0 x16 с поддержкой NVIDIA BlueField-3 DPU и NVIDIA ConnectX-7 NIC. Есть 16 отсеков для накопителей E1.S (PCIe 5.0 x4) с возможностью горячей замены. «Мы представили решения для дата-центров на базе архитектуры NVIDIA Blackwell для самых требовательных рабочих нагрузок в области обучения больших языковых моделей (LLM) и генеративного ИИ. Мы и дальше намерены расширять семейство этих серверов», — сказал Вейши Са, президент ASRock Rack. На выставке Computex 2024 компания ASRock Rack демонстрирует и другие системы с ускорителями NVIDIA. Например, представлена модель MECAI-GH200 (на изображении) — на момент анонса это самый компактный в мире сервер с суперчипом NVIDIA GH200. |

|