Лента новостей

|

15.05.2025 [19:13], Татьяна Золотова

Выручка Selectel за I квартал 2025 года выросла на 49 % до 4,4 млрд рублей — помогли облакаПровайдер ИТ-инфраструктуры Selectel по итогам I квартала 2025 года увеличил выручку на 49 % год к году, до 4,4 млрд руб. по МСФО. Об этом сообщила пресс-служба компании. Скорректированная EBITDA увеличилась на 53 %, до 2,6 млрд руб. Чистая прибыль составила 1,0 млрд руб., рентабельность по чистой прибыли — 22 %. В общих показателях учитывается выручка от продажи облачных инфраструктурных сервисов, которая выросла на 51 %, до 3,8 млрд руб. На этот сегмент приходится 87 % оборота компании. Капитальные затраты здесь составили 1,7 млрд руб.: 1,3 млрд руб. на серверное оборудование (рост в 1,8 раза) и 0,4 млрд руб. на развитие инфраструктуры дата-центров. В том числе на строительство московского ЦОД «Юрловский», ввод первой очереди которого намечен на 2025 год. Его строительство началось в 2022 году. Согласно исследованию развития ИТ-инфраструктуры российским бизнесом, рост спроса на облачные сервисы сохраняется: 42 % компаний планируют расширять вычислительные мощности в этом году. К 2029 году рынок предположительно вырастет со 166 млрд руб. до 464 млрд руб. Услуги дата-центров принесли Selectel 0,3 млрд руб. (рост год к году на 25 %). В декабре 2024 года Selectel приобрел компанию «Единая сеть», которая ведет деятельность под брендами Servers.ru, Exepto.ru и Fozzy.ru, что прибавило выручке ещё 500 млн руб. По оценке iKS-Consulting, «Единая сеть» в 2023 году занимала третье место среди провайдеров услуг аренды выделенных серверов с долей 10 %.

15.05.2025 [16:46], Руслан Авдеев

Prometheus Hyperscale и XL Batteries впервые задействуют в американском ИИ ЦОД проточные аккумуляторы без литияPrometheus Hyperscale развернёт в строящемся в Вайоминге ИИ ЦОД гигаваттного класса органические проточные аккумуляторы стартапа XL Batteries, которые не используют литий, сообщает Bloomberg. Пока речь идёт о небольшом пилотном проекте в 2027 году с планами установить АКБ ещё на 25 МВт в 2028–2029 гг. Органичные проточные аккумуляторы по-своему уникальны, поскольку выдерживают тысячи циклов зарядки-разрядки и в целом более эффективнее своих литиевых конкурентов. Ожидается, что потребность ЦОД в энергии будет расти стремительными темпами и дальше. По прогнозам BloombergNEF, если сегодня ЦОД в США потребляют 3,5 % от общего энергопотребления в стране, то к 2035 году этот показатель вырастет до 8,6 %. Рост спроса заставляет коммунальные служба и операторов ЦОД искать новые источники энергии — строятся новые газовые электростанции, перезапускаются ядерные объекты, рассматриваются геотермальные проекты. Пока, по данным BloombergNEF, нет данных об использовании проточных батарей с органическими компонентами в дата-центрах США. Впрочем, могут быть и непубличные проекты и прототипы. Аккумуляторы XL Batteries используют солёную воду, благодаря чему они намного дешевле в производстве, чем системы, в которых ванадий растворяется в серной кислоте. Также они не зависят от поставок лития из зарубежа и обеспечивают питание дольше, чем литиевые АКБ. По словам представителя Prometheus, индустрии ЦОД нужны аккумуляторы, способные обеспечить производительность на уровне литиевых вариантов или лучше. Технология XL Batteries предлагает масштабируемое, долговременное, нетоксичное решение для хранения энергии. Финансовые условия сделки не разглашаются. ЦОД в Вайоминге, по данным Prometheus, будет использовать природный газ, а также системы улавливания и хранения углерода. Рынок энергохранилищ продолжает расти. В феврале появилась новость, что BYD построит в Саудовской Аравии «крупнейшие в мире» аккумуляторные энергохранилища ёмкостью 12,5 ГВт∙ч.

15.05.2025 [15:48], Татьяна Золотова

Правительство РФ снова взялось за цифровизацию государственного документооборотаПравительство РФ запустило пилотный проект по внедрению единых стандартов электронного документооборота (ЭДО) для федеральных министерств и ведомств. Соответствующее постановление подписал премьер-министр Михаил Мишустин. В пилоте, который продлится до 30 июня 2026 года, будут участвовать Минприроды, Минпромторг, Минцифры и ФНС. Ведомствам предстоит протестировать процедуры автоматизированной подготовки документов и их обмена между своими системами. Кроме того, участники проекта должны выработать единые требования к ведомственным системам ЭДО и актуализировать нормативную базу, регулирующую электронное взаимодействие госорганов. Как отмечается в сообщении Белого дома, за последние пять лет бумажные носители и их электронные копии заменили на цифровые документы со структурированными данными. На первом этапе в электронной форме с аппаратом правительства начали взаимодействовать федеральные министерства и ведомства. Затем были внедрены цифровые поручения, которые формируются непосредственно в системе документооборота в машиночитаемом формате. Сейчас предстоит масштабировать этот опыт на все процессы и все федеральные органы исполнительной власти. В начале 2025 года около 90 % документов на площадке аппарата правительства были представлены в электронном виде, сообщалось на сайте государственной информационной системы «Платформа «Центр хранения электронных документов» (ГИС «Платформа «ЦХЭД») со ссылкой на слова Дмитрия Григоренко. Пять лет назад этот показатель не превышал 40 %. Согласно распоряжению Правительства РФ от 16 марта 2024 г. № 637-р, полностью перейти на ЭДО органы местного самоуправления, государственные и муниципальные учреждения должны к 2030 году. Для обмена документами между госорганами в электронном виде используется система ГосЭДО.

15.05.2025 [15:40], Руслан Авдеев

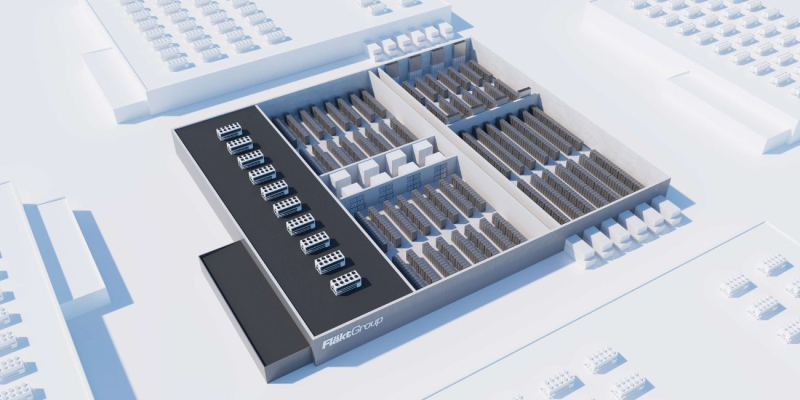

Samsung купила за €1,5 млрд поставщика систем охлаждения для ЦОД и предприятий FläktGroupSamsung Electronics приобрела за €1,5 млрд ($1,69 млрд) поставщика HVAC-систем FläktGroup. Последняя поставляет оборудования для охлаждения и CDU-модули для дата-центров и крупных промышленных площадок, сообщает Datacenter Dynamics. Пока компания принадлежит инвестиционным фондам под эгидой европейской компании Triton. Ожидается, что сделку закроют до конца года. FläktGroup основана в октябре 2016 года в результате слияния DencoHappel, ранее входившей в принадлежащую Triton группу специалистов по теплообменным решениям Galapagos, и разработчика систем охлаждения FläktWoods. После слияния FläktGroup расширила своё портфолио и вышла на рынки ЦОД, крупных производственных комплексов и фармацевтических компаний. В число клиентов FläktGroup, судя по данным на официальном сайте, входят дата-центры по всей Великобритании и даже штаб-квартира Microsoft в Дублине. По словам Triton, работать с компанией и её руководством было одновременно удовольствием и «привилегией». Команда компании вывела её на передовые позиции в своей отрасли и открыла пути для будущего роста. Сделка с Samsung позволит вывести FläktGroup на новый уровень развития, выразили уверенность в пресс-службе Triton. Samsung подчёркивает, что благодаря покупке ключевого игрока в области HVAC-решений она закладывает основу для того, чтобы самой стать лидером на мировом рынке HVAC, предлагающим полный спектр соответствующих решений. В компании намерены продолжать инвестировать в быстрорастущий бизнес HVAC, который станет одним из ключевых двигателей будущего роста. Ранее конкурирующая LG Electronics (LG) представила собственные комплексные решения для охлаждения ЦОД.

15.05.2025 [15:12], Руслан Авдеев

Потенциал импортозамещения почти исчерпан: АРПЭ выпустила отчёт о состоянии российского рынка серверного оборудованияАссоциация разработчиков и производителей электроники (АРПЭ) России провела исследования рынка серверного оборудования в стране. В подготовке доклада приняли участие «Гравитон», СИЛА, «Тринити», Fplus, BITBLAZE и GS Group, сообщает пресс-служба АРПЭ. Исследование показало, что рынок уже два года подряд сокращается в количественном выражении, за последний год быстрее, чем раньше — в 2024 году продали 147,95 тыс. серверов, на 15,1 % меньше, чем годом ранее. В денежном выражении рынок несколько вырос до $1,78 млрд, что больше год к году на 1,4 %. Рост рынка в денежном выражении исследователи объяснили в основном «технологическими и экономическими составляющими» — переход на использование процессоров новых поколений и более дорогих конфигураций. При этом санкции и без того влияют на издержки — в последние три года выросла как цена серверного оборудования, так и расходы на производство и логистику. Кроме того, многое зависит от курса доллара. После ухода западных компаний, российские производители серверов активно росли благодаря импортозамещению, но теперь рост почти остановился — в 2024 году доля отечественных производителей серверов на рынке составила 43%, что всего на 1,7% больше, чем годом ранее.

Источник изображения: Alexander Smagin/unsplash.com По словам АРПЭ, основным драйвером развития российского производства серверного оборудования в 2022 и 2023 гг. стал уход ключевых иностранных вендоров. Тогда выпуском серверов под собственными брендами занялись десятки компаний, многие из них вложили средства в локальное производство и разработки. Однако потенциал импортозамещения исчерпался довольно быстро, уже в 2024 тренд в России для местных компаний изменился. Сегодня основной моделью работы для российских вендоров является локализация производства в стране серверов, разработанных за рубежом, и ценовая конкуренция не позволяет отечественным производителям выйти «за пределы регулируемых рынков». Другими словами, в обычных коммерческих проектах серверное оборудование обычно просто завозится вендорами из-за границы, но под собственными торговыми марками. Благодаря такой модели российский бизнес сохраняет авторизованные каналы поставок и техподдержки, в то же время не сталкиваясь с барьерами, характерными для параллельного импорта. Как отмечают в РАПЭ, с учётом действующей в России нормативной базы, для локализации производства достаточно покупки конструкторской документации за рубежом у ODM-компаний, с дальнейшим размещением производства в России и включением готового оборудования в Реестр российской промышленной продукции. Фактически речь идёт о монтаже компонентов на печатные платы, изготовлении корпусов, сборке и тестировании оборудования, а использования российской компонентной базы касается лишь позиций, не влияющих на схемотехнику серверных плат.

Источник изображения: Fplus В прошлом году, по данным исследования, многие заказчики стремились снизить закупки нового оборудования вообще, как российского, так и зарубежного, стремясь продлить жизненный цикл уже имеющихся платформ. В текущем году АРПЭ ожидает стагнацию на российском рынке — он должен вырасти, когда действующее оборудование потребует замены. Предполагается, что спрос на российские продукты будут стимулировать регулированием рынка критической информационной инфраструктуры (КИИ), процесс уже идёт в настоящее время. Впрочем, вопрос требует всестороннего изучения. В начале мая Fplus предоставляла информацию о том, что в 2024 году российские корпоративные заказчики приобрели гораздо больше закупали отечественных серверов, чем зарубежных — в примерном соотношении 3:1, несмотря на то что у многих компаний IT-инфраструктура по-прежнему базируется на зарубежном оборудовании.

15.05.2025 [13:51], Владимир Мироненко

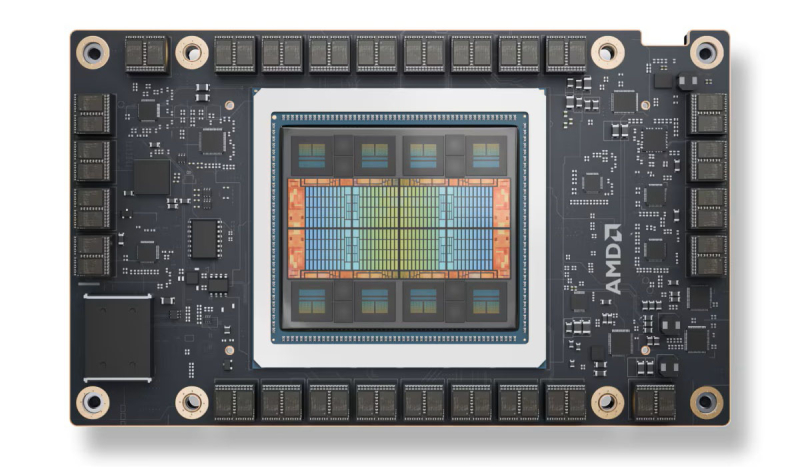

Спрос на AMD Instinct MI325X со стороны крупных компаний оказался ниже ожиданий из-за ограниченных возможностей масштабированияОдно из последних предложений AMD для рынка ЦОД — ускоритель AMD Instinct MI325X — не вызвал большого интереса у крупных заказчиков, отдавших предпочтение чипам NVIDIA Blackwell из-за лучшего соотношения цены и производительности, сообщили аналитики SemiAnalysis. После тестовых закупок чипа в 2024 году Microsoft не стала размещать заказы на дальнейшие поставки. Пытаясь привлечь интерес других крупных клиентов, AMD снизила цены на Instinct MI325X. После этого чипы приобрела Oracle и ещё несколько гиперскейлеров, но объёмы закупок не идут ни в какое сравнение с продажами ускорителей NVIDIA. Отсутствие интереса крупных компаний связано с ограничением MI325X в возможности масштабирования лишь до восьми ускорителей, объединённых быстрым интерконнектом, тогда как суперускоритель GB200 NVL72 размер со стойку поддерживает объединение 72 ускорителей. Когда дело касается крупномасштабных рабочих нагрузок ИИ-инференса и рассуждений на on-premise уровне, такая разница имеет решающее значение, отметил ресурс SemiAnalysis. AMD позиционировала MI325X в качестве альтернативы NVIDIA HGX B200 (NVL8) и HGX B300 (NVL16), но даже в этом сегменте NVIDIA имеет преимущество как в чистой производительности, так и в совокупной стоимости владения. Вместе с тем, у MI325X имеются перспективы для менее масштабных развёртываний, не требующих больших кластеров ускорителей, например, для инференса небольших моделей, когда требуется много памяти с большой пропускной способностью. AMD продолжает совершенствовать свою программную экосистему, с которой у неё были очень большие проблемы, и MI325X при условии конкурентоспособной цены может вызвать интерес у компаний, разрабатывающих ИИ-модели среднего размера, считают в SemiAnalysis.

15.05.2025 [13:32], Владимир Мироненко

«Аквариус» предложил президенту распространить на весь ИТ-сектор меры поддержки выхода на фондовый рынокПредседатель совета директоров «Аквариус» предложил на встрече «Деловой России» с президентом РФ ввести поддержу со стороны государства выхода высокотехнологичных компаний на фондовый рынок, поскольку первичное размещение акций является для их бюджета весьма затратным, пишут «Ведомости». Он также предложил ввести льготы по НДФЛ для инвесторов, покупающих акции при IPO или SPO, что «создаст здоровую конкуренцию с депозитами», обеспечив привлекательность покупки ценных бумаг для розничных инвесторов. В связи с этим предложено распространить на весь высокотехнологический сектор меру компенсации части затрат на IPO, предусмотренную в рамках федерального проекта «Технологии», которая сейчас действует только для малых технологических компаний (МТК), а также создать стимулы для банков и институциональных инвесторов, включая послабления по требованиям к резервированию при вложениях в акции.

Источник изображения: Московская биржа Президент назвал тему важной. «Стимулирование [инвесторов] — это правильно. [Но] снижение требований ЦБ по резервированию к коммерческим банкам — это очень тонкая вещь. Это один из способов борьбы с инфляцией. Регулятор тем не менее идёт на определённые исключения. Но надо с ЦБ отдельно поговорить», — сказал он. Председатель Банка России назвала возможным расширение списка технологических компаний с целью поддержки при выходе на биржу, уточнив, что в этом вопросе главенство принадлежит правительству, поскольку оно определяет критерии. Она сообщила, что ЦБ направил правительству предложения по этому поводу, выразив надежду на то, что обсуждение критериев будет завершено и тогда можно будет распространить льготы, которые действуют для МТК, на более широкий круг компаний. По оценкам экспертов, затраты на IPO в России достигают 7–20 % от суммы размещения. Они включают расходы на юристов, аудиторов, андеррайтеров, регистрационные сборы, маркетинг и т.п., а также организационные затраты, в том числе создание новых структур — совета директоров, комитетов и т.д. Послабления по резервным требованиям для банков и институциональных инвесторов соответствуют международной практике и стратегии ЦБ РФ, утверждают в юридической компании O2 Consulting. В свою очередь, сооснователь ShareAI раскритиковал предложение ввести НДФЛ-льготы для инвесторов. «Если акция объективно проигрывает депозиту, и мы льготой её вытащим на IPO, что случится дальше? Потребуется льгота, чтобы обеспечить ей ликвидность на бирже?» — задал он вопрос.

15.05.2025 [13:08], Андрей Крупин

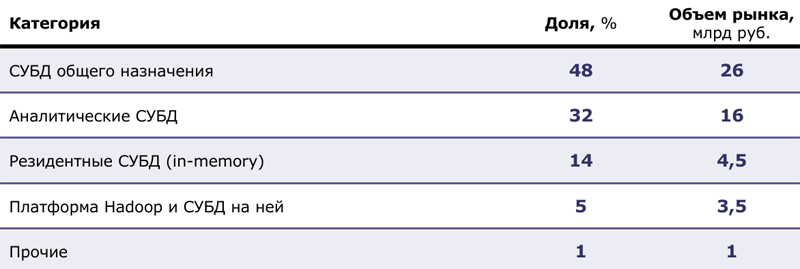

Объём российского рынка СУБД к 2031 году превысит 251 млрд рублейВ 2024 году российский рынок систем управления базами данных достиг 89,5 млрд руб., что на 34 % больше, чем годом ранее. При этом, несмотря на сокращение продаж иностранного софта и услуг до 10 процентов, более чем 60 % отечественных организаций продолжают эксплуатировать СУБД зарубежного производства. Таковы результаты исследования, проведённого Центром стратегических разработок (ЦСР). Согласно представленным аналитиками ЦСР сведениям, лидирующую позицию на отечественном IT-рынке занимают СУБД общего назначения (доля рынка 48 %, 26 млрд руб. в денежном выражении). Далее следуют аналитические платформы (32 %, 16 млрд руб.) и резидентные (In-Memory) базы данных (14 %, 4,5 млрд руб.). В структуре рынка доминирует программное обеспечение — его доля составляет 78 %, остальные 22 % приходятся на сегмент услуг, включающий техническую поддержку, консалтинг и профессиональные сервисы. В числе ключевых игроков на рынке фигурируют компании PostgresPro, Arenadata, DIS Group, Yandex Cloud, «Тантор Лабс», VK Tech и «Ростелеком».

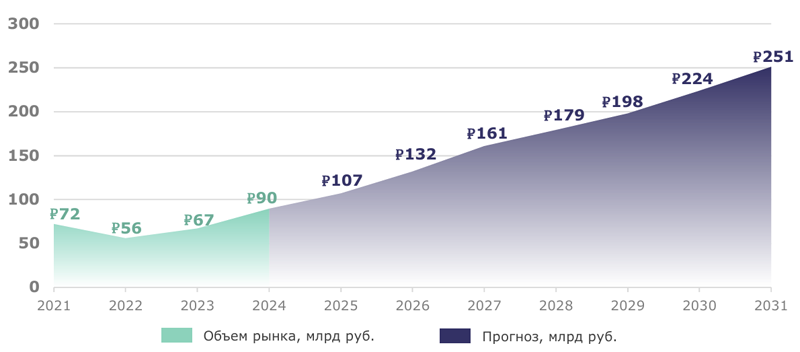

Детализация оценки долей в сегменте СУБД по категориям (источник: Центр стратегических разработок / csr.ru) К 2031 году рынок систем управления и обработки данных в России, как ожидается, вырастет более чем на 180 % (в сравнении с 2024 г.) и составит 251 млрд руб.

Прогноз динамики российского рынка систем управления и обработки данных, млрд руб. (источник: Центр стратегических разработок / csr.ru) «В период с 2024 по 2027 год ожидается стремительный рост рынка на уровне 21,6 %. Однако далее темпы роста замедлятся до 11,9 %, что будет соответствовать общемировым показателям. Это связано с тем, что до 2027 года основным фактором роста будут процессы замещения импорта. Далее рост продолжится за счёт увеличения объёма генерируемых данных, увеличения применения технологий искусственного интеллекта. Что касается западного программного обеспечения, то его доля на рынке продолжит уменьшаться и к 2031 году составит примерно 1 % от общего объёма новых продаж. При этом ПО отечественных разработчиков будет активно развиваться и к 2031 году может занять до 99 % рынка», — поделились прогнозами аналитики ЦСР. Более подробнее с материалами исследования Центра стратегических разработок и аналитическими выкладками можно ознакомиться по этой ссылке.

15.05.2025 [12:02], Руслан Авдеев

Oracle выделит $14 млрд на развитие ИИ и облака в Саудовской АравииКомпания Oracle намерена инвестировать в расширение облачных ИИ-сервисов в Саудовской Аравии $14 млрд в течение следующих 10 лет, сообщает Datacenter Dynamics. Как заявила генеральный директор Oracle Сафра Кац (Safra Catz), Oracle поставляет Саудовской Аравии передовые облачные и ИИ-технологии «благодаря решительным действиям и сильному руководству президента и его администрации». По мнению Кац, партнёрство со страной создаст новые возможности для её экономики, обеспечит прогресс в области здравоохранения и укрепит союз с Соединёнными штатами — это, как ожидается, создаст «волновой эффект мира и процветания» на Ближнем Востоке и в мире в целом, сообщает пресс-служба компании. Подробности инвестиций не называются. У Oracle уже есть в Саудовской Аравии два облачных региона: Saudi Arabia West расположен в Джидде (Jeddah), Saudi Arabia Central — в Эр-Рияде (Riyadh) в ЦОД Center3. Первый из них запустили ещё в 2020 году, а второй, размещённый — в 2024-м. С октября 2021 года Oracle планирует создать третий регион в высокотехнологичном городе Неом (Neom), но пока на сайте Oracle регион остаётся в статусе «скоро». Новое обязательство компания приняла вскоре после того, как Oracle пообещала пятикратно увеличить инвестиции в Абу-Даби (Abu Dhabi, ОАЭ). Всего Oracle распоряжается пятью действующими облачными регионами на Ближнем Востоке и в соседней Северной Африке, ещё четыре находятся в стадии строительства. Совсем недавно США отменили спорные ограничения на экспорт ИИ-ускорителей в другие страны, поэтому сотрудничество с Ближним Востоком обещает стать намного более плодотворным.

15.05.2025 [11:49], Сергей Карасёв

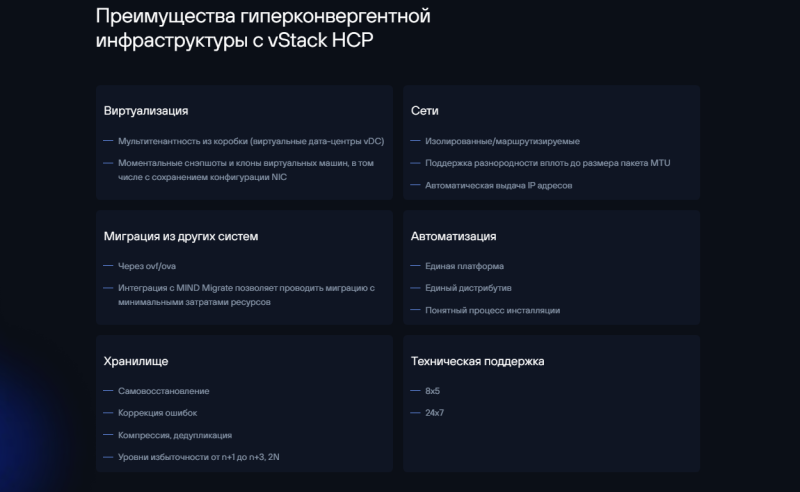

vStack и TERA IT готовят HCI ПАК для бизнеса и госсектораРазработчик программного обеспечения vStack (входит в корпорацию ITG) и российский IT-дистрибьютор TERA (TERA IT Distributor) анонсировали совместный проект по выпуску отечественных программно-аппаратных комплексов (ПАК) для виртуализации и управления инфраструктурой. Устройства, как ожидается, заинтересуют клиентов из различных отраслей — от малого бизнеса до крупных государственных предприятий. В качестве аппаратной основы ПАК будут использоваться собственные платформы «Система ИКС» дистрибьютора TERA, включая серверы, СХД и сетевые устройства. Программная составляющая ПАК предполагает применение гиперконвергентной платформы vStack с полной интеграцией слоев вычислений, хранения и сети в единой панели управления. Такая HCI-архитектура, как утверждается, позволит повысить надёжность благодаря сокращению количества точек отказа. Кроме того, упростится администрирование, что позволит уменьшить штат обслуживающего персонала. В зависимости от потребностей заказчика будут предлагаться ПАК в четырёх конфигурациях. Это, в частности, варианты на серверах ИКС S-серии, которая включает компактные одно- и двухпроцессорные системы с пониженным энергопотреблением. Подходят для задач малого и среднего бизнеса, в том числе для соответствия требованиям по хранению данных (СОРМ-3, закон «Яровой»). Корпоративным клиентам, которые работают с виртуализированными инфраструктурами, будут предложены модели на серверах ИКС D- и F-серии — это сбалансированные двухпроцессорные системы с большим объёмом RAM и поддержкой NVMe-накопителей.

Источник изображения: vStack Для высоконагруженных сред и дата-центров подойдут версии с серверами ИКС L- и H-серии с высокой плотностью вычислений. В 2026–2027 гг. появятся ПАК с серверами ИКС Z-серии (в разработке), ориентированные на госсектор и соответствующие требованиям локализации. «Мы видим стабильный рост спроса на российские IT-продукты, особенно в сфере виртуализации и управления инфраструктурой. Совместный ПАК с TERA даёт компаниям возможность выстраивать надёжные и гибкие IT-системы без привязки к зарубежным технологиям», — говорит генеральный директор vStack. |

|