Материалы по тегу: ускоритель

|

23.06.2024 [12:35], Сергей Карасёв

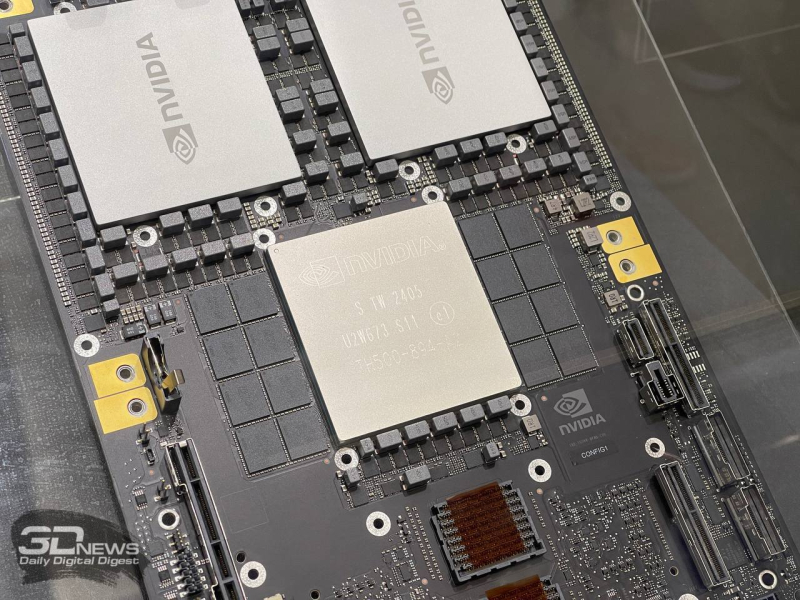

Между Microsoft и NVIDIA возникли разногласия по поводу использования ускорителей B200У компаний Microsoft и NVIDIA, по сообщению The Information, возникли разногласия по поводу использования новейших ускорителей B200 на архитектуре Blackwell. NVIDIA настаивает на том, чтобы клиенты приобретали эти изделия в составе полноценных серверных стоек, тогда как Microsoft с этим не согласна. Отмечается, что NVIDIA, удерживающая приблизительно 98 % рынка ускорителей для ЦОД, стремится контролировать использование своих продуктов. В частности, компания накладывает ограничения в отношении дизайна ускорителей, которые партнёры создают на чипах NVIDIA. Во время презентации Blackwell глава NVIDIA Дженсен Хуанг (Jensen Huang) неоднократно указывал на то, что теперь минимальной единицей для развёртывания должен стать суперускоритель GB200 NVL72. То есть NVIDIA призывает клиентов приобретать вместо отдельных ускорителей целые стойки и даже кластеры SuperPOD. По заявлениям компании, это позволит повысить ИИ-производительность благодаря оптимизации всех компонентов и их максимальной совместимости друг с другом. Кроме того, такая бизнес-модель позволит NVIDIA получить дополнительную выручку от распространения серверного оборудования и ещё больше укрепить позиции на стремительно развивающемся рынке ИИ. Однако у Microsoft, которая оперирует огромным количеством разнообразных ускорителей и других систем в составе своей инфраструктуры, возникли возражения в отношении подхода NVIDIA. Сообщается, что вице-президент NVIDIA Эндрю Белл (Andrew Bell) попросил Microsoft приобрести специализированные серверные стойки для ускорителей Blackwell, но редмондский гигант ответил отказом. По заявлениям Microsoft, решения NVIDIA затруднят корпорации внедрение альтернативных ускорителей, таких как AMD Instinct MI300X. Дело в том, что форм-факторы стоек NVIDIA и стоек Microsoft различаются на несколько дюймов. Из-за этого могут возникнуть сложности с изменением конфигурации и модернизацией, предусматривающей использование конкурирующих компонентов. Так, Microsoft использует единую базовую платформу и для ускорителей NVIDIA, и для ускорителей AMD. Microsoft эксплуатирует вариант стоек OCP и старается максимально унифицировать инфраструктуру своих многочисленных дата-центров. NVIDIA, в конце концов, согласилась с доводами Microsoft и пошла на уступки, но это, похоже, не последнее подобное разногласие между компаниями.

14.06.2024 [23:15], Владимир Мироненко

Южнокорейские ИИ-стартапы Sapeon и Rebellions объединятся, чтобы вместе противостоять NVIDIASapeon и Rebellions, два южнокорейский участника альянса AI Platform Alliance, сформированного в прошлом году с целью ускорения внедрения передовых решений в области ИИ, объявили о планах по объединению усилий, чтобы ускорить работу и добиться больших масштабов бизнеса. Компания Sapeon предлагает чип X330, предназначенный для инференса и обслуживания больших языковых моделей (LLM), а также основанные на этом чипе серверы. В свою очередь, Rebellions разработала NPU ATOM для систем компьютерного зрения и использования с чат-ботами на базе ИИ. Оба производителя участвуют в программе по импортозамещению ИИ-ускорителей, CPU и иных чипов. Сейчас Южная Корея стремится добиться технологической независимости от зарубежных поставщиков оборудования и ПО. Речь, в первую очередь, об NVIDIA. Ускорители последней в своё время не достались местному IT-гиганту Naver, который временно был вынужден заменить их процессорами Intel Xeon, а впоследствии вместе с Samsung создал собственные ИИ-чипы Mach-1.

Источник изображения: Rebellions Инициатором слияния Sapeon и Rebellions выступила SK hynix, которая вместе с SK Telecom является акционером Sapeon. В своём заявлении она отметила, эти компании согласились на слияние, поскольку, по их мнению, это позволит создать компанию, способную оказать конкуренцию другим участникам глобального рынка ИИ. Как отметил The Register, время сейчас имеет решающее значение для Sapeon и Rebellions, поскольку следующие два или три года воспринимаются как «золотое время» для создания компаний, способных стать крупными игроками в области ИИ. Поэтому предполагается провести слияние в кратчайшие сроки с завершением сделки в III квартале и запуском объединённой компании до конца 2024 года. В свою очередь, SK hynix планирует оказать помощь объединенной компании в разработке ИИ-полупроводников. Sapeon была выделена SK Telecom в отдельную компанию в 2016 году. Rebellions была создана всего четыре года назад при поддержке прямого конкурента SK Telecom в лице KT Corp., но уже договорилась с Samsung о поставке ей ИИ-чипов, которые будут производиться компанией Chaebol с использованием 4-нм процесса с интеграцией HBM3e.

11.06.2024 [15:22], Сергей Карасёв

3,76 млн ускорителей в 2023 году: NVIDIA захватила 98 % рынка GPU для ЦОДПо оценкам аналитической фирмы Tech Insights, которые приводит ресурс HPC Wire, компания NVIDIA в 2023 году отгрузила приблизительно 3,76 млн ускорителей на базе GPU, ориентированных на ЦОД. Это более чем на 1 млн штук превосходит результат 2022 года, когда поставки таких изделий оценивались в 2,64 млн единиц. С учётом решений AMD и Intel общий объём поставок GPU-ускорителей для ЦОД в 2023 году составил 3,85 млн единиц против примерно 2,67 млн штук в 2022 году. Правда, столь малая доля отгрузок решений AMD и Intel вызывает некоторые сомнения. Как отмечает аналитик Tech Insights Джеймс Сандерс (James Sanders), в настоящее время на рынке не хватает аппаратных ресурсов для удовлетворения всех ИИ-потребностей. А поэтому будет расти спрос на ускорители и специализированные чипы разработчиков, конкурирующих с NVIDIA. Согласно подсчётам TechInsights, по итогам 2023-го NVIDIA контролировала около 98 % мирового рынка ускорителей на базе GPU для дата-центров. Схожий результат компания продемонстрировала и годом ранее. Такой рост связан со стремительным развитием ИИ-приложений и увеличением спроса на НРС-системы. При этом на NVIDIA приходится и 98 % выручки от реализации таких ускорителей: в 2023 году они принесли компании $36,2 млрд, что более чем в три раза превышает прошлогодний показатель в $10,9 млрд. По данным TechInsights, в 2023 году AMD поставила около 50 тыс. ускорителей для ЦОД, а Intel — примерно 40 тыс. единиц (в оригинальном материале HPCWire указаны на порядок более высокие значения; корректировка сделана в соответствии с оставшейся долей в 2 % рынка). В 2024-м, как полагают эксперты, спрос на такие продукты в глобальном масштабе поднимется. Речь, в частности, идёт об ускорителях серии Instinct MI300, разработанных AMD. При этом AMD заявляет, что намерена выпускать новые решения ежегодно: ускоритель MI325X запланирован на 2024 год, MI350 — на 2025-й, а MI400 — на 2026-й. В свою очередь, Intel продвигает изделия Gaudi3. Специализированные ИИ-чипы проектируют и ведущие гиперскейлеры. Так, AWS в конце прошлого года представила ИИ-ускоритель Trainium2, предназначенный для обучения нейронных сетей. Google анонсировала изделия Cloud TPU v5p, а Microsoft — Maia 100. Meta✴ намерена активно внедрять собственные ИИ-ускорители Artemis.

07.06.2024 [13:35], Руслан Авдеев

Новый трюк КНР: китайские компании пытаются использовать запрещённые к экспорту чипы на территории самих СШАКитайские компании, лишённые доступа к передовым ИИ-чипам из-за введённых США санкций, освоили новую схему обхода ограничений. По данным The Register, теперь они покупают доступ к подсанкционному оборудованию непосредственно на территории Соединённых Штатов. О возможности подобной схемы эксперты предупреждали уже давно. По слухам, Alibaba и Tencent вели переговоры с NVIDIA о получении тем или иным способом доступа к ускорителям, продажа которых в Китай ограничена — бизнесы из КНР рассматривали возможность использовать их в ЦОД на территории США. China Telecom, как считается, тоже вела переговоры с облачными провайдерами о получении доступа к высокопроизводительному ИИ-оборудованию. Другими словами, китайский бизнес намерен обходить американские санкции, покупая или арендуя оборудование под боком у Вашингтона. Владелец TikTok — компания ByteDance, похоже, тоже участвует в подобных схемах со своим партнёром Oracle, у которого она арендует доступ к передовым ускорителям NVIDIA.

Источник изображения: Mark Daynes/unsplash.com В NVIDIA ответили на запросы журналистов, сообщив, что поддерживают новые дата-центры в США, расширяя вычислительные экосистемы и создавая рабочие места. В компании подчеркнули, что все клиенты американских ЦОД должны соблюдать местные законы, включая правила экспортного контроля и прочие ограничения. США уже годами вовлечены в «полупроводниковую войну» и применили в отношении Китая несколько пакетов санкций, призванных ограничить доступ Китаю к данным о передовых архитектурах чипов и современному оборудованию для их производства. Конечно, КНР ищет пути для обхода ограничений — например, компании вроде Huawei неоднократно ловили на попытках так или иначе обмануть американскую санкционную машину. В то же время США пытаются наладить производство чипов на территории страны — сегодня большинство передовых полупроводников выпускается на Тайване. Это только усилит желание КНР получить доступ к самым современным технологиям и подстегнёт не только инвестиции в полупроводниковую отрасль, но и поиск новых путей обхода санкций. Правда, пока не известно, могут ли считаться китайские компании, пытающиеся организовать вычисления на территории США, нарушителями законов или они просто ловко нашли пробел в американском законодательстве.

06.06.2024 [13:23], Руслан Авдеев

Маск подтвердил передачу ИИ-стартапу xAI 12 тыс. ускорителей H100, предназначавшихся TeslaГлава Tesla и других компаний Илон Маск (Elon Musk) подтвердил передачу ускорителей NVIDIA H100, ранее заказанных Tesla, социальной сети X и ИИ-стартапу xAI. Слухи об этом, напоминает The Register, появились в СМИ — в распоряжение журналистов попала внутренняя документация и электронная переписка с NVIDIA. В частности, в одной из записок за декабрь прошлого года прямо указывалось, что Илон отдаёт приоритет внедрению 12 тыс. ускорителей в X вместо Tesla. Общая стоимость такого количества H100 превышает $500 млн. Вместо этого заказанные для X экземпляры H100 позже будут переданы Tesla (поставки ожидались в январе и июне 2024 года). Кроме того, есть проблемы и с созданием ИИ-суперкомпьютера Dojo на базе собственных чипов, который должен улучшить положение Tesla. Приоритетным для Маска, вероятно, является кластер H100, создаваемый X и тесно связанным с сетью стартапом xAI. Компании совместно работают над большими языковыми моделями, стоящими за чат-ботом Grok, уже доступным премиум-подписчикам X. По данным утечки из NVIDIA, 100 тыс. H100 приказано передать к концу года в xAI для создания «крупнейшего в мире» кластера ускорителей, который разместится в Северной Дакоте.

Источник изображения: Alexander Shatov/unsplash.com Хотя на уровне компаний комментариев не поступало, сам Маск подтвердил, что у Tesla просто не было места для чипов NVIDIA, поэтому они хранились на складе. При этом ещё не так давно Маск уверял инвесторов Tesla, как важны HPC-системы и ИИ для компании. Более того, ещё в апреле появилась новость о том, что автопроизводитель только в течение одного квартала вложил в ИИ $1 млрд. Также миллиардер сообщал, что один из заводов Tesla в Техасе вместит 50 тыс. H100 для обучения систем автономного вождения, в общей сложности число ускорителей достигло бы 85 тыс. Пока нет точных данных об обстоятельствах передачи ускорителей между Tesla и X или xAI. Нет даже информации о том, заплатила ли уже Tesla за «железо» и получила ли за него какую-то компенсацию. Условия передачи H100 могут иметь большое значение с учётом того, что Маск не является единоличным владельцем Tesla. Если выяснится, что Маск злоупотребил властью, к нему могут возникнуть вопросы как у инвесторов, так и у регуляторов. Впрочем, Tesla не впервые приходится делиться активами с X. Вскоре после покупки Twitter более 50 сотрудников автопроизводителя якобы отправили на «усиление» социальной соцсети. Есть данные, что сотрудников Tesla привлекают к работам и в других компаниях Маска, причём без дополнительной платы. Время для новостей не особенно удачное — на следующей неделе акционеры Tesla будут голосовать по ряду предложений, главным из которых является официальный перенос штаб-квартиры в Техас. Также речь пойдёт о переизбрании брата Кимбала, брата Илона Маска (Kimbal Musk), в совет директоров и других ключевых для бизнесмена вопросах. Тем временем в Tesla падают продажи со II половины 2022 года, увольняют сотрудников и, главное, стоимость акций компании падает критическими темпами. Приказ передать H100 станет дополнительным козырем в руках критиков миллиардера, которые утверждают, что его активное участие в других проектах мешает ему сконцентрироваться на автобизнесе и эффективно выполнять обязанности главы Tesla.

05.06.2024 [14:07], Руслан Авдеев

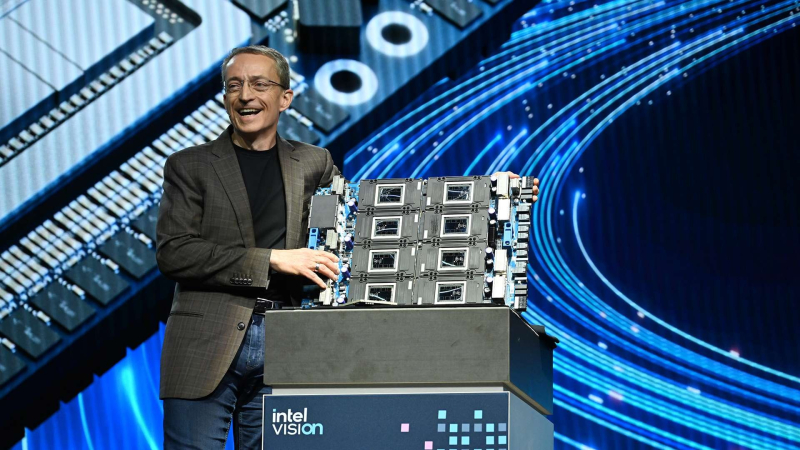

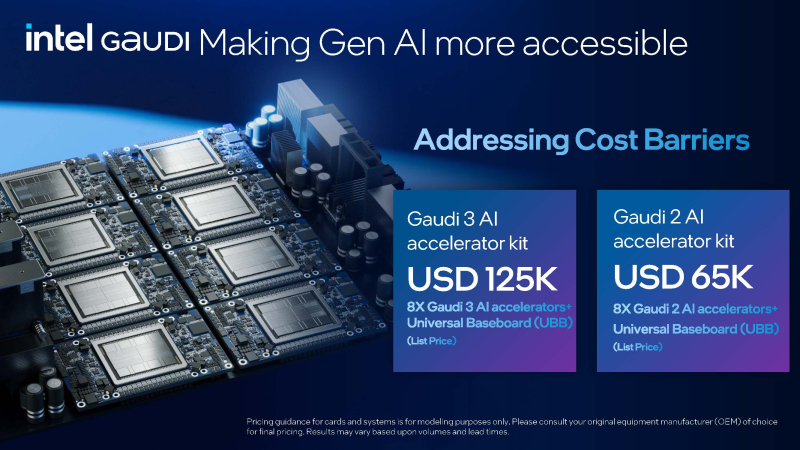

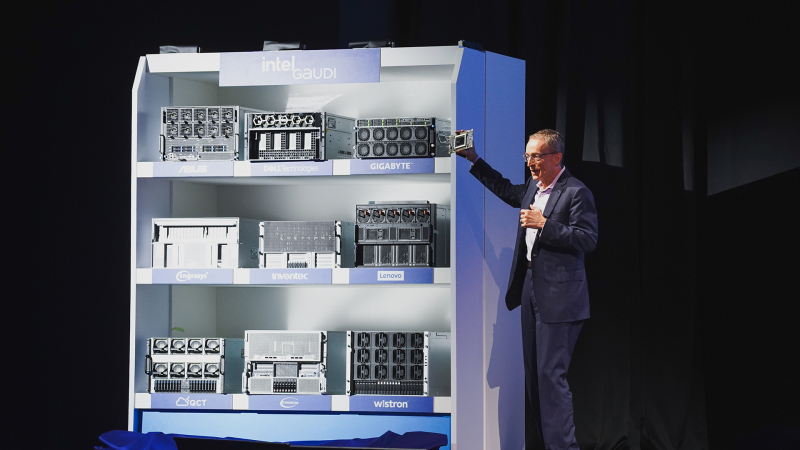

Против всех правил: Intel публично раскрыла стоимость ИИ-ускорителей GaudiХотя производители легко раскрывают рекомендованные цены на классические процессоры, в случае с ИИ-ускорителями ситуация обстоит иначе. Как сообщает портал CRN, Intel публично объявила стоимость новейшей платформы Gaudi3. Фактически компания нарушила негласно принятые в отрасли нормы секретности, сообщив в ходе выставки Computex, что UBB-плата с восемью OAM-модулями Gaudi3 будет стоить $125 тыс. для производителей серверов, намеренных поддержать платформу в момент выпуска в III квартале 2024 года. Intel раскрыла цены после того, как конкуренты в лице NVIDIA и AMD пообещали представлять всё более мощные чипы ежегодно — это станет серьёзной угрозой как для Intel, так и для менее крупных игроков. По оценкам Intel, $125 тыс. — это всего ⅔ стоимости платформы NVIDIA с восемью ускорителями H100, лежащих в основе системы NVIDIA DGX и серверов стороннего производства. Хотя в самой NVIDIA цены своих ускорителей или платформ не раскрывают, если верить расчётам Intel, платформа HGX H100 обходится приблизительно в $187 тыс. Цена может меняться в зависимости от объёмов закупок и конфигурации серверов. При этом ускорители Blackwell B200 будут стоить уже $30-$40 тыс./шт. В Intel утверждают, что по соотношению цена/производительность чипы Gaudi3 в сравнении с H100 в 2,3 раза эффективнее при инференсе и на 90 % — при обучении. UBB-плата с восемью ускорителями Gaudi2 стоит всего $65 тыс., это приблизительно треть от стоимости платформы NVIDIA HGX H100. При этом в публичных бенчмарках MLPerf только Gaudi2 смогли составить конкуренцию H100 как в обучении, так и в инференсе. Цены на отдельные чипы Gaudi 3 пока не называются. Есть и ещё один важный момент — ускорители Gaudi используют встроенные Ethernet-контроллеры как для связи между собой, так и для общения с внешним миром, тогда как решениям NVIDIA требуется отдельный адаптер InfiniBand/Ethernet на каждый ускоритель, что увеличивает итоговую стоимость платформы. В Intel уверены, что клиенты всё больше уделяют внимания показателю токен/$, на который большое влияние оказывает стоимость инфраструктуры. В компании пояснили, что раскрытие цен на Gaudi2 и Gaudi3 поможет клиентам более эффективно планировать инвестиции в ИИ-проекты. Например, стартапы часто не имеют точных сведений об экосистеме, ценах и процессе закупок, так что теперь им будет легче рассчитать, чего можно ожидать от предлагаемого оборудования. Открытость Intel нашла поддержку у крупных производителей IT-оборудования.

05.06.2024 [12:15], Сергей Карасёв

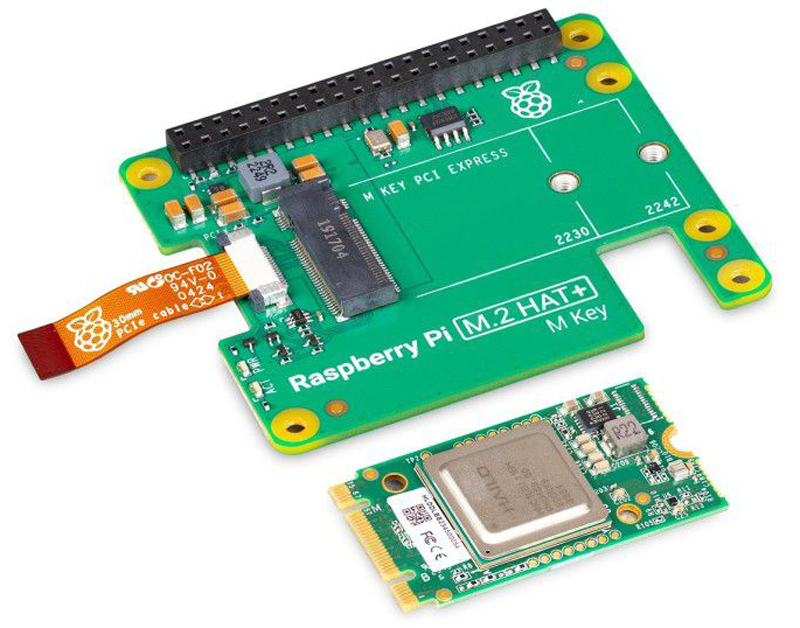

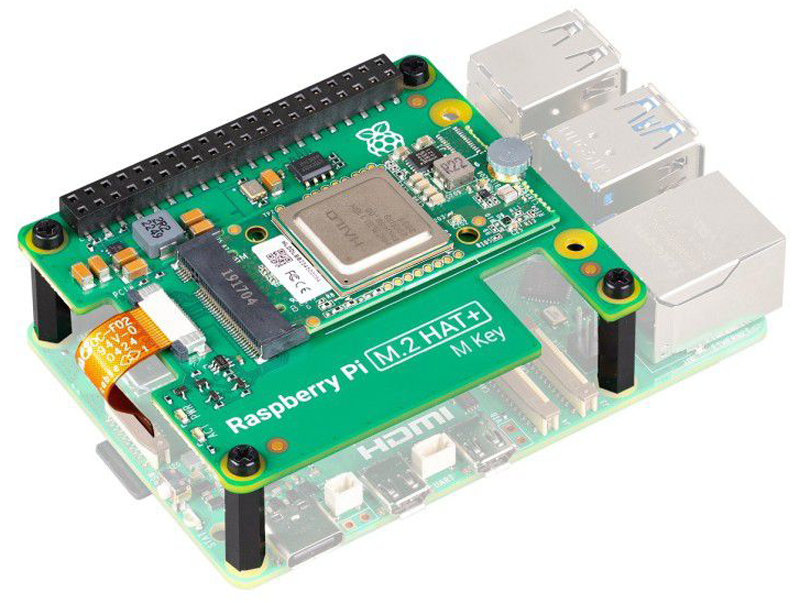

Комплект Raspberry Pi AI Kit с ИИ-ускорителем Hailo расширит возможности Raspberry Pi 5Команда Raspberry Pi анонсировала комплект Raspberry Pi AI Kit, который позволяет наделить ИИ-возможностями одноплатный компьютер Raspberry Pi 5, дебютировавший в сентябре 2023 года. Модуль расширения уже доступен для заказа по ориентировочной цене $70. В основу Raspberry Pi AI Kit положен ИИ-чип Hailo-8L, созданный Hailo Technologies. Это изделие ориентировано на приложения, которым не требуется слишком высокое ИИ-быстродействие. Заявленное быстродействие достигает 13 TOPS, а стандартное энергопотребление составляет 1,5 Вт.

Источник изображений: Raspberry Pi В случае Raspberry Pi AI Kit чип Hailo-8L установлен на модуль типоразмера M.2 2242, который подключается к соответствующему коннектору на плате расширения M.2 HAT+. Эта плата, в свою очередь, обменивается данными с Raspberry Pi 5 посредством интерфейса PCIe 2.0. Габариты M.2 HAT+ составляют 65 × 56,5 × 5,6 мм. Заявленный диапазон рабочих температур простирается от 0 до +50 °C. Новинка может быть смонтирована поверх одноплатного компьютера.  Отмечается, что при использовании обновлённой версии Raspberry Pi OS распознавание чипа Hailo-8L происходит автоматически, после чего ускоритель становится доступен для обработки ИИ-нагрузок. Говорится о полной интеграции с программным стеком Raspberry Pi Camera, что позволяет реализовывать различные приложения на основе машинного зрения.

03.06.2024 [23:50], Алексей Степин

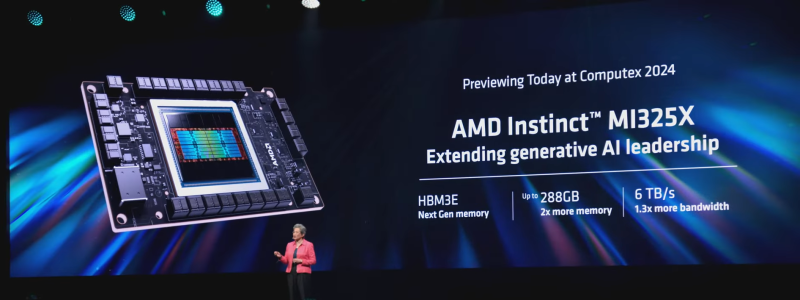

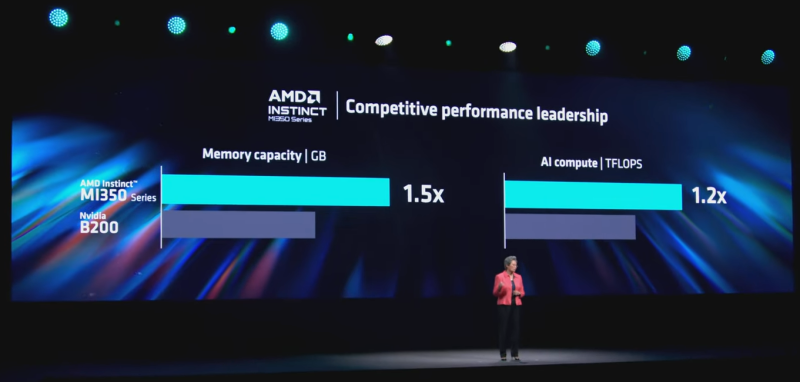

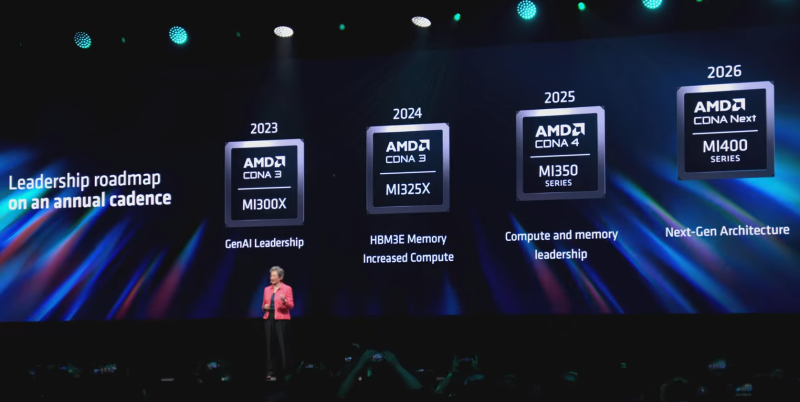

AMD готовит ускорители Instinct MI325X и MI350XВместе с EPYC Turin компания AMD анонсировала и новые ускорители серии Instinct. Так, на смену MI300X компания предложит Instinct MI325X, оснащённый памятью HBM3e. Он должен стать достойным ответом на серию ускорителей NVIDIA Blackwell. Последний также получит память данного типа, тогда как более совершенные NVIDIA Rubin с памятью HBM4 увидят свет лишь в 2026 году. Технически MI325X представляет собой усовершенствованный вариант MI300X. Использование более плотной HBM3e позволило довести объём набортной памяти до 288 Гбайт, что больше, нежели у Blackwell В100 (192 Гбайт) и Hopper H200 (141 Гбайт). Выросла и пропускная способность, с 5,3 до 6 Тбайт/с. В настоящее время тройка главных поставщиков памяти уже готовят HBM3e-сборки 12-Hi ёмкостью до 36 Гбайт. Micron и SK Hynix освоили ПСП 9,2 Гбит/с на контакт, в то время как Samsung планирует достичь 9,8 Гбит/с. Правда, для MI325X эта цифра составит примерно 5,9 Гбит/с на контакт. В остальном конфигурация нового ускорителя осталась прежней в сравнении с MI300X. Под вопросом разве что теплопакет, но вряд ли он так уж значительно превысит уже имеющиеся 750 Вт. AMD Instinct MI325X получит полную совместимость с любой инфраструктурой на базе MI300X, достаточно будет лишь заменить модули OAM. Начало поставок новинки запланировано на IV квартал 2024 года, но, как считают зарубежные обозреватели, AMD придётся конкурировать за поставки памяти с другими разработчиками ускорителей. Вместе с анонсом MI325X компания впервые за два года опубликовала план дальнейшего развития семейства Instinct. Сейчас AMD активно работает над архитектурой CDNA4, которая дебютирует в ускорителях MI350 в 2025 году. Они будут производиться с использованием 3-нм техпроцесса и получат поддержку FP4/FP6. Ожидается повышение как производительности, так и энергоэффективности. Причём AMD намеревается сохранить лидерство по объёму памяти. Следующее поколение архитектуры под условным названием CDNA Next появится лишь в 2026 году в серии Instinct MI400, где AMD ещё более активно задействует чиплетный подход. AMD вслед за NVIDIA переходит к ежегодному выпуску новых ускорителей и к переходу на новую архитектуру каждые два года. Гонка в сфере ИИ ускоряется и взятый темп позволит компании более успешно играть на этом рынке. Работает AMD и над программной составляющей, развивая пакет ROCm, адаптирую и упрощая запуск всё большего количества моделей, сотрудничая с Hugging Face и развивая PyTorch, TensorFlow и JAX.

30.05.2024 [11:05], Сергей Карасёв

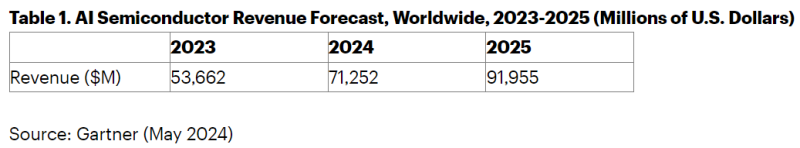

Gartner: объём рынка ИИ-чипов в 2024 году увеличится на третьВ 2023 году, по оценкам Gartner, объём глобального рынка ИИ-чипов достиг приблизительно $53,66 млрд. В дальнейшем ожидается стремительный рост данной отрасли. Так, в 2024-м затраты могут увеличиться на треть — до $71,25 млрд, а в 2025-м достигнут $91,96 млрд. Отмечается, что в 2024 году расходы на ИИ-ускорители для серверов составят приблизительно $21 млрд. К 2028-му, прогнозируют аналитики, затраты в этом сегменте поднимутся до $33 млрд. Gartner подчёркивает, что на сегодняшний день все основные гиперскейлеры, включая AWS, Google, Meta✴ и Microsoft, инвестируют в разработку собственных ИИ-чипов.

Источник изображения: pixabay.com Так, AWS предлагает ИИ-ускорители Trainium2 и Inferentia2. Google выпустила изделия Cloud TPU v5p и v5e и уже готовит TPU v6. Microsoft представила Maia 100, а Meta✴ намерена активно внедрять собственные ИИ-ускорители Artemis. Хотя разработка ИИ-чипов обходится дорого, использование специально созданных решений может повысить эффективность работы ЦОД и снизить затраты на предоставление пользователям услуг на основе ИИ. Gartner прогнозирует, что поставки ПК с возможностями ИИ достигнут 22 % от общего объёма продаж в 2024 году. А к концу 2026-го 100 % новых компьютеров корпоративного класса будут оснащаться нейропроцессорным модулем (NPU) для ускорения ИИ-задач. Ожидается, что в 2024 году выручка от продаж ИИ-чипов для вычислительной электроники составит $33,4 млрд, или 47 % от общего объёма рынка. На ИИ-изделия для автомобильной электроники придётся $7,1 млрд, для бытовой электроники — $1,8 млрд.

25.05.2024 [20:50], Сергей Карасёв

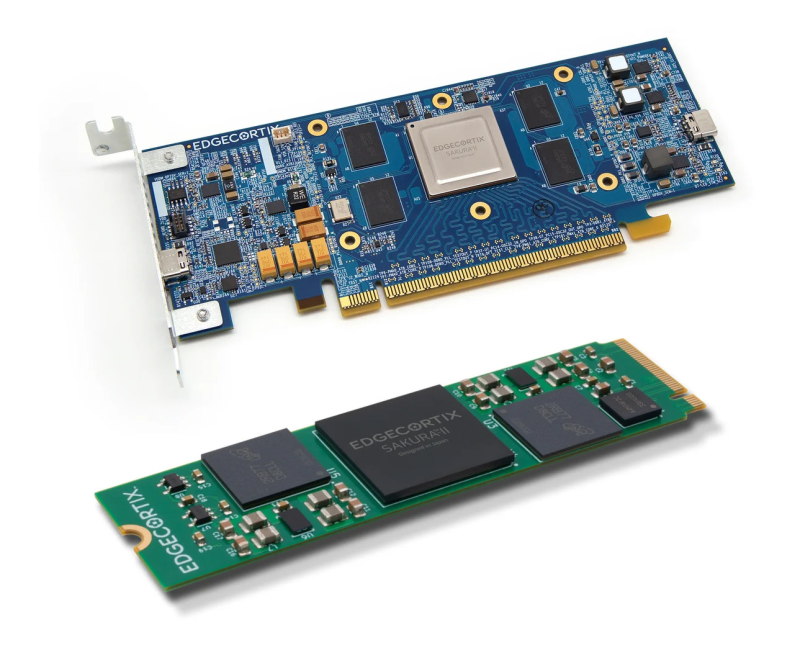

EdgeCortix представила ИИ-ускоритель SAKURA-II Edge AI с производительностью до 60 TOPSКомпания EdgeCortix, по сообщению CNX Software, анонсировала ускоритель SAKURA-II Edge AI, предназначенный для выполнения ИИ-задач на периферии. Новинка, как утверждается, способна справляться с обработкой больших языковых моделей (LLM), больших визуальных моделей (LVM) и пр. В основу изделия положен нейропроцессорный движок с архитектурой Dynamic Neural Accelerator (DNA) второго поколения. Заявленная производительность достигает 60 TOPS на операциях INT8 и 30 Тфлопс на операциях BF16. Ускоритель может нести на борту 8, 16 или 32 Гбайт памяти LPDDR4x с пропускной способностью 68 Гбайт/с. Есть 20 Мбайт памяти SRAM. Заявленное типовое энергопотребление составляет 8 Вт. Изделие имеет упаковку BGA с размерами 19 × 19 мм. Диапазон рабочих температур простирается от -40 до +85 °C. Для ускорителя доступен программный комплект MERA с поддержкой PyTorch, TensorFlow Lite и ONNX. Помимо собственно ускорителя SAKURA-II Edge AI, компания EdgeCortix представила решения на его основе. Это, в частности, модуль формата M.2 2280: он использует интерфейс PCIe Gen 3.0 x4, а энергопотребление равно 10 Вт. Доступны модификации с 8 и 16 Гбайт памяти LPDDR4. Стоят такие модули $249 и $299. Кроме того, выпущены однослотовые низкопрофильные карты расширения с интерфейсом PCIe 3.0 x8. Такие устройства существуют в вариантах с одним и двумя чипами SAKURA-II Edge AI. Во втором случае производительность удваивается и достигает 120 TOPS на операциях INT8 и 60 Тфлопс на операциях BF16. Младшая версия оснащена 16 Гбайт памяти и имеет энергопотребление 10 Вт. Старший вариант несёт на борту 32 Гбайт памяти и обладает энергопотреблением 20 Вт. Цена — $429 и $749 соответственно. |

|