Материалы по тегу: сжо

|

26.03.2025 [17:05], Руслан Авдеев

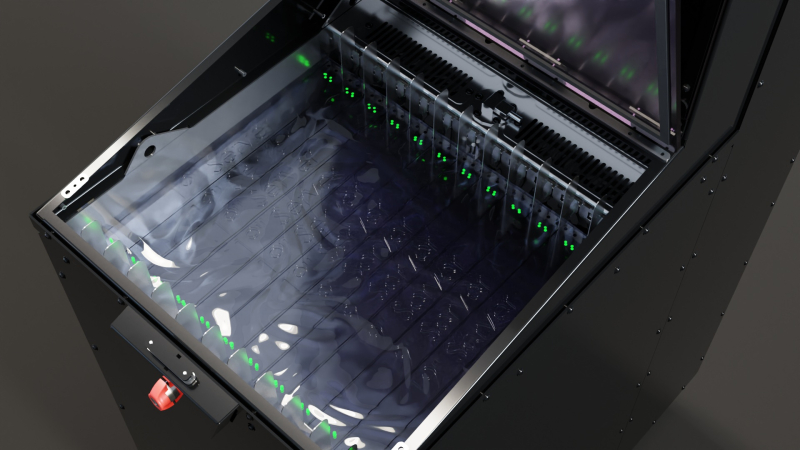

LiquidStack удвоила производственные мощности по выпуску СЖО в США, открыв второй завод в ТехасеИзвестный производитель решений для жидкостного охлаждения — компания LiquidStack — объявила об открытии второго завода в Карролтоне (Техас). Предполагается, что это поможет удовлетворить растущий спрос на СЖО, сообщает пресс-центр компании. Расположенный всего в паре кварталов от штаб-квартиры и производственной площадки LiquidStack в агломерации Даллас/Форт-Уэрт (Dallas-Fort Worth), новый объект площадью более 1,5 тыс. м² значительно увеличит производственные возможности компании. Одновременно он будет служить в качестве нового исследовательского центра и площадки для обучения сотрудников. Расширение выпуска происходит в важное для производителя время. Спрос на его универсальный блок CDU-1MW для DLC-систем остаётся высоким с момента появления в продаже в августе 2024 года. Продукт также попал в список Recommended Vendor List компании NVIDIA.

Источник изображения: LiquidStack В компании заявляют, что сейчас LiquidStack переживает беспрецедентный спрос на высокопроизводительные решения для охлаждения на фоне роста ИИ ЦОД. LiquidStack считает колоссальным преимуществом для клиентов наличие производства в США. Масштабирование производственных мощностей позволит LiquidStack поддерживать стабильное время поставок своих решений клиентам в рамках программы Quick-Ship, обеспечивающей быструю транспортировку критически важных компонентов. Это важно, поскольку многие операторы ЦОД столкнулись с задержками выполнения заказов из-за нарушений в цепочках поставок. Утверждается, что сообщество жителей агломерации Даллас/Форт-Уэрт полно энтузиазма после того, как компания открыла в регионе штаб-квартиру и первый в США завод в прошлом году. В компании намерены и дальше инвестировать в агломерацию, а расширение производства позволит создать немало рабочих мест на севере Техаса и углубить связь с местным бизнес-сообществом.

Источник изображения: LiquidStack Все решения LiquidStack для жидкостного охлаждения выпускаются на заводах в Карролтоне — включая CDU-1MW, двухфазные и однофазные решения для погружного охлаждения и модульные ЦОД MacroModular и MicroModular. Новый объект LiquidStack в Карролтоне полностью введут в эксплуатацию в мае 2025 года. В 2021 году LiquidStack и Microsoft продемонстрировали ИИ-серверы с двухфазным иммерсионным охлаждением, а в марте 2024 года компания запустила в США производство погружных СЖО. В сентябре, через месяц после премьеры CDU-1MW, компания привлекла $20 млн на расширение разработки серверных СЖО.

24.03.2025 [14:21], Руслан Авдеев

Страховка от протечек: Accelsius выплатит до $100 тыс., если её СЖО прохудится и зальёт оборудование в стойкеКомпания Accelsius, специализирующаяся на системах двухфазного жидкостного охлаждения, при поддержке одного из крупнейших в США страховщиков CNA запустила программу поддержки использования СЖО — страхование от утечек. Новая программа NeuGuard обеспечивает основные и дополнительные виды защиты и обслуживания. Как заявляет пресс-служба Accelsius, более половины респондентов (54 %) Uptime Institute в 2024 году заявили, что последний сбой оборудования обошёлся им дороже $100 тыс., а 16 % — что издержки составили более $1 млн. В рамках программы NeuGuard предлагается индивидуальная многолетняя гарантия. Предусмотрена гибкая поддержка и компенсация в объёме до $100 тыс. на стойку в случае повреждений оборудования из-за протечек СЖО Accelsius NeuCool. NeuCool изначально разрабатывалась подразделением Bell Labs компании Nokia. СЖО использует диэлектрический хладагент — он кипит в циркуляционной системе и отводит больше тепла, чем решения конкурентов, говорит компания. В самой CNA сообщают, что защита критически важной инфраструктуры важнее, чем когда-либо и индивидуальный подход страховой компании в рамках NeuGuard демонстрируют приверженность решать проблемы с учётом меняющихся потребностей индустрии ЦОД. Accelsius также предлагает гарантии на уровне ведущих мировых OEM-производителей для серверов. После тестирования и проверки ключевыми поставщиками OEM-решений вводятся гарантии на индивидуальном уровне для отдельных единиц — наряду с предложением NeuGuard.

24.03.2025 [10:56], Сергей Карасёв

Chemours, NTT Data и Hibiya Engineering опробуют передовую жидкость для двухфазных систем погружного охлажденияКомпании Chemours, NTT Data и Hibiya Engineering объявили об объединении усилий с целью полномасштабных испытаний системы двухфазного иммерсионного (погружного) охлаждения для дата-центров. Речь идёт, в частности, об использовании специальной жидкости Chemours Opteon 2P50. Партнёры отмечают, что сектор ЦОД быстро развивается на фоне активного внедрения ИИ и НРС. Однако существует значительный разрыв между ростом энергопотребления таких объектов и повышением эффективности систем охлаждения. Сотрудничество Chemours, NTT Data и Hibiya Engineering направлено на исследование технологий охлаждения следующего поколения, которые обеспечат повышение эффективности и устойчивости дата-центров при увеличении их мощности.

Источник изображения: Chemours Проект ориентирован на тестирование Opteon 2P50 с целью последующей коммерциализации. Эта запатентованная диэлектрическая жидкость разработана специально для двухфазного иммерсионного охлаждения. Жидкость выполнена на основе гидрофторолефина (HFO) с нулевым озоноразрушающим потенциалом (ODP). Коэффициент GWP (потенциал глобального потепления), определяющий степень воздействия различных парниковых газов на глобальное потепление, равен 10 (AR6). По заявлениям разработчика, жидкость Opteon 2P50 позволяет снизить энергозатраты ЦОД на охлаждение до 90 % и уменьшить общее энергопотребление дата-центров на 40 %. Кроме того, в большинстве климатических зон Opteon 2P50 даёт возможность практически полностью исключить использование воды, а также значительно уменьшить шумовое загрязнение внутри помещений. Физическая площадь ЦОД может быть сокращена на 60 %. Плюс к этому жидкость может повторно использоваться неограниченное количество раз. В испытаниях системы двухфазного иммерсионного охлаждения на основе Opteon 2P50 примут участие различные заинтересованные стороны — от операторов дата-центров, производителей оборудования и проектно-конструкторских фирм до поставщиков ИТ-услуг и научно-исследовательских институтов.

19.03.2025 [16:54], Руслан Авдеев

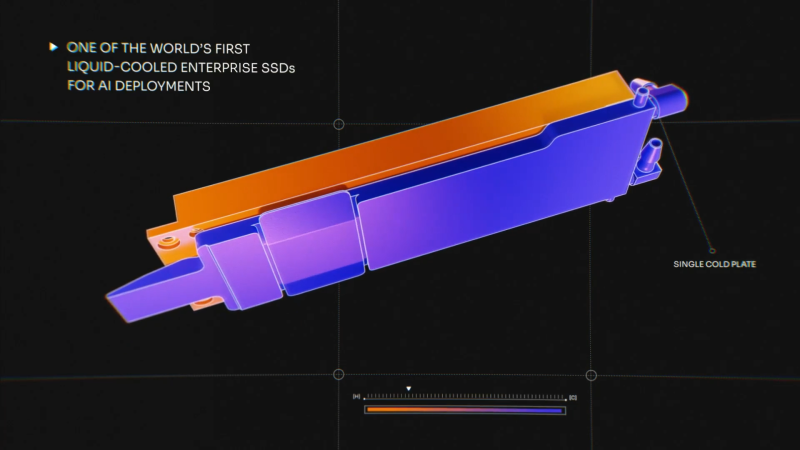

Solidigm представила СЖО для SSDПринадлежащая южнокорейской SK Hynix компания Solidigm представила технологию жидкостного охлаждения SSD. По словам разработчиков, благодаря этому можно будет создавать более компактные безвентиляторные серверы с ИИ-ускорителями и высокой плотностью хранения данных. По данным Solidigm, типичный ИИ-сервер на базе ИИ-ускорителей обычно имеет около 30 Тбайт памяти в восьми слотах и рост ёмкости будет, вероятно, продолжаться. SSD обычно охлаждается воздухом, но с ростом плотности компоновки такой подход становится проблематичным, поскольку твердотельные накопители сами достаточно горячи, что повышает риск отключений, а традиционное сочетание радиаторов и вентиляторов мешают эффективному использованию пространства. Поэтому Solidigm представила накопитель D7 PS110 E1.S толщиной 9,5 мм, дополненный водоблоком. Точнее говоря, сами водоблоки находятся в дисковой корзине, что оставляет возможность «горячей» замены самих SSD и в то же время позволяет отводить до 30 Вт, причём охлаждаются обе стороны накопителя. В Solidigm утверждается, что её технология станет первым решением корпоративного уровня с «полным жидкостным охлаждением», хотя на рынке уже есть варианты с похожей функциональностью. Например, у российской РСК давно есть и All-Flash СХД с полностью жидкостным охлаждением, и SSD в вычислительных узлах оснащены водоблоками. Технология Solidigm разработана совместно с неназванным партнёром и нацелена на «ИИ-серверы будущего». Точная дата премьеры пока не объявлена, но она состоится не раньше II половины текущего года. Пока Solidigm изучает точное влияние технологии охлаждения на общее энергопотребление. Переход к СЖО позволит избавиться от вентиляторов, которые сами по себе потребляют довольно много энергии. Кроме того, в этом случае не нужно будет обеспечивать относительно низкую температуру воздуха между стойками. При этом контур СЖО для SSD будет работать параллельно контуру СЖО для CPU и ускорителей, что потенциально может усложнить компоновку всей системы.

16.03.2025 [00:15], Владимир Мироненко

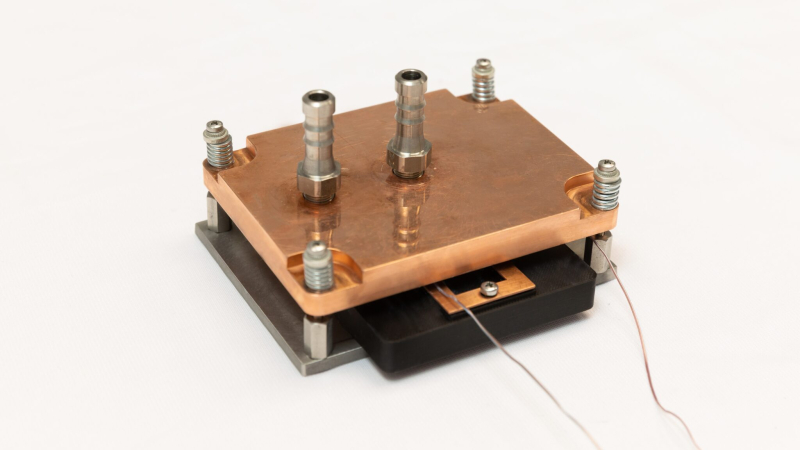

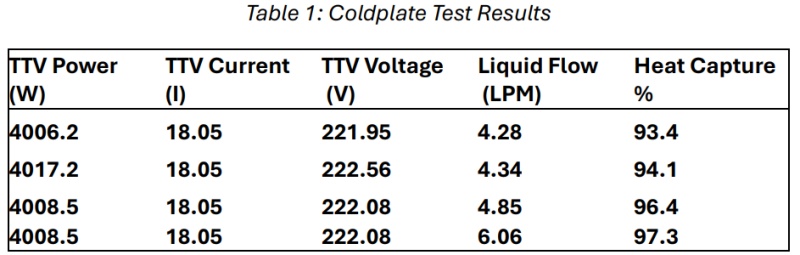

CoolIT представила водоблок для 4-кВт чипов, которых пока ещё нетCoolIT Systems представила водоблок для однофазного прямого жидкостного охлаждения (DLC) чипов мощностью 4 кВт. Это вдвое выше, чем у других решений такого типа. Новинка смогла отвести более 97 % тепла от 4-кВт тестовой нагрузки (Thermal Test Vehicle, TTV) при расходе 6 л/мин. (LPM). Это эквивалентно 1,5 LPM на кВт, что совпадает с рекомендуемым потоком для чипов высокой мощности, говорит компания. Тепловое сопротивление является ещё одним критическим фактором высокопроизводительного охлаждения — новый водоблок имеет сверхнизкое сопротивление Tr<0,009 К/Вт. При этом полное падение давления в контуре, включая фитинги и быстроразъёмные соединения, остаётся на уровне всего 8 фунтов на кв. дюйм (0,5625 кгс/см²). А фирменная технология Split-Flow позволяет почти на треть улучшить поток и отвод тепла по сравнению с традиционными водоблокам, обеспечивая целенаправленное охлаждение наиболее нагревающихся областей чипов, говорит компания. Пока столь мощных чипов нет. Даже самые современные NVIDIA Blackwell имеют TDP до 1200 Вт, а AMD Instinct MI355X — до 1100 Вт. Однако для CoolIT важно показать, что у однофазных СЖО есть существенный задел на будущее. Конкуренцию таким систем пытаются составить погружные СЖО, а также двухфазные DLC, например, ZutaCore. Впрочем, есть и необычные однофазные DLC. Так, Chilldyne использует технологию циркуляции теплоносителя с отрицательным давлением, которая снижает риски протечки. А Iceotope предлагает гибридное решение, сочетающее водоблоки и иммерсионную СЖО. При этом DLC с водой в качестве теплоносителя остаются наиболее широко распространёнными СЖО. На них приходится более 60 % рынка жидкостного охлаждения ЦОД из-за высокой экономической и тепловой эффективности, сообщает StorageReview со ссылкой на исследование Market Research Future.

10.03.2025 [12:16], Сергей Карасёв

SK Telecom займётся созданием ИИ ЦОД совместно с Elice, Schneider Electric и Giga ComputingЮжнокорейская телекоммуникационная компания SK Telecom, по сообщению Datacenter Dynamics, объявила о заключении партнёрских соглашений с Elice, Schneider Electric и Giga Computing с целью развития проектов в области ЦОД, ориентированных на ИИ. В частности, в сотрудничестве с Elice планируется развитие модульных дата-центров для ИИ. Южнокорейская Elice, основанная в 2015 году, предоставляет облачные сервисы в сфере ИИ. Elice предлагает доступ к ускорителям NVIDIA и FuriosaAI. В дальнейшем планируется использовать разработки Rebellions для машинного зрения, чат-ботов и больших языковых моделей (LLM). Кроме того, Elice создала модульный контейнерный ЦОД Elice AI Portable Modular Data Center (PMDC). Отмечается, что SK Telecom подписала меморандум о взаимопонимании (MoU) с Giga Computing и SK Enmove: стороны намерены осуществлять научно-исследовательские и опытно-конструкторские работы в сфере систем охлаждения следующего поколения для дата-центров. Речь идёт о развитии технологий прямого жидкостного охлаждения Direct-To-Chip и иммерсионного (погружного) охлаждения. В рамках партнёрства Giga Computing поделится опытом в создании передовых СЖО, тогда как SK Enmove будет поставлять охлаждающие жидкости. Аналогичное соглашение было заключен с Iceotope.

Источник изображения: Elice В свою очередь, партнёрство между SK Telecom и Schneider Electric ориентировано на разработку и внедрение MEP-систем (вентиляция, электрика, водоснабжение и водоотведение). На первом этапе стороны намерены заниматься развитием проектов в различных регионах Южной Кореи, после чего сотрудничество расширится по всему миру. Наконец, SK Telecom планирует взаимодействовать с компанией IonQ, которая специализируется на разработках в области квантовых вычислений. SK Telecom рассчитывает интегрировать квантовые технологии IonQ в свои ИИ-платформы, включая Personal AI Agent (PAA), GPUaaS (GPU-as-a-Service) и Edge AI. При этом не уточняется, будет ли SK Telecom устанавливать квантовые компьютеры IonQ, такие как Forte Enterprise и Tempo.

04.03.2025 [11:10], Сергей Карасёв

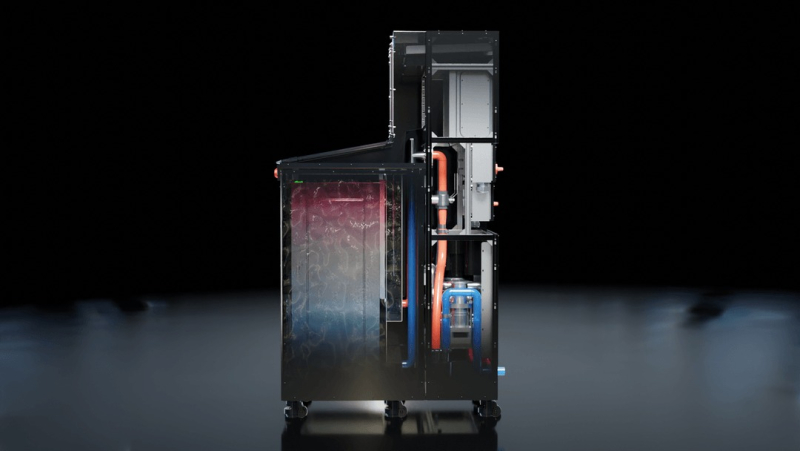

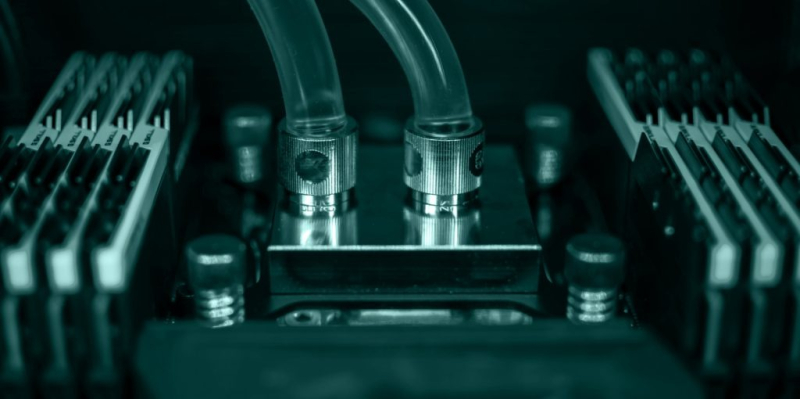

SoftBank, ZutaCore и Foxconn представили стоечную систему с ИИ-серверами на базе NVIDIA H200 и двухфазной СЖОКомпании ZutaCore, Hon Hai Technology Group (Foxconn) и SoftBank объявили о внедрении двухфазной технологии прямого жидкостного охлаждения (DLC) в ИИ-сервер с ускорителями NVIDIA H200. Утверждается, что это первая подобная реализация на рынке. Двухфазная DLC-система ZutaCore служит для отвода тепла от CPU, GPU, микросхем памяти и других критичных компонентов в серверах. Данное решение по сравнению с традиционными средствами охлаждения позволяет снизить энергопотребление дата-центра и повысить общую эффективность. В результате сокращаются выбросы вредных газов в атмосферу. Система ZutaCore использует специальную охлаждающую пластину, которая находится в контакте с CPU, GPU и другими элементами сервера с большим тепловыделением. Применяется диэлектрическая жидкость с низкой температурой кипения: при нагреве происходит фазовый переход из жидкого в газообразное состояние. Эффективное охлаждение достигается благодаря многократному испарению и конденсации.

Источник изображений: ZutaCore При этом температура жидкости может поддерживаться на более высоком уровне, чем в обычных системах с водяным охлаждением, что повышает эффективность отвода тепла, говорится в пресс-релизе. Кроме того, снижается нагрузка на насос, что способствует сокращению энергопотребления. Использование диэлектрического состава предотвращает серьезные повреждения сервера в случае протечки. В рамках партнёрства Foxconn разработала ИИ-сервер на базе NVIDIA H200 с двухфазной DLC-системой ZutaCore. В свою очередь, SoftBank создала серверную стойку, предназначенную для максимально эффективного охлаждения оборудования посредством двухфазной DLC-технологии. Эта ORv3-стойка совместима с 21″ и 19″ серверами. Источники питания и основная проводка сосредоточены в задней части для обеспечения безопасности эксплуатации и повышения удобства обслуживания.

27.02.2025 [08:27], Руслан Авдеев

Asperitas выпустила модульные погружные СЖО Direct Forced Convection для GPU-серверовЗанимающаяся разработкой СЖО серверов компания Asperitas запустила новую линейку модульных продуктов Direct Forced Convection (DFCX) для систем иммерсионного охлаждения. Речь идёт о модульных ёмкостях, предназначенных для Edge-объектов, сообщает пресс-служба компании. Продукты были анонсированы ещё в июне 2024 года. Ранее Asperitas предлагала иммерсионный бак с естественной конвекцией, а теперь представлен вариант с принудительной циркуляцией жидкости. Модульная архитектура обеспечивает размещение стоек размером от 12U в каждой ёмкости. Также поддерживаются конфигурации «суперкластера» с многочисленными ёмкостями и блоками распределения жидкости (CDU). Ёмкости для стоек размера 12U обеспечивают отвод до 5 кВт на 1U или более 1 кВт на чип. Решение DFCX1 обеспечивает поддержку кластеров из трёх 4U-узлов с 24 ускорителями с возможностью отвода до 60 кВт. По данным на сайте компании, размеры модуля составляют 600 × 1215 × 1990 мм. Он весит около 1120 кг с вместе с установленным оборудованием. На бак требуется минимум 352 л диэлектрической жидкости, поставщиком которой является Shell. Впрочем, тут же описаны и чуть более скромные возможности охлаждения: до 3,6кВт/1U. Также предусмотрены два места для 19″ коммутаторов глубиной до 480 мм. В компании заявляют, что надёжность и бесшовная интеграция являются базовыми ценностями при разработке продуктов, бизнес компании успешно растёт с системами на основе естественной конвекции Perpetual Natural Convection (PNC) и технологией DFCX, особенно теперь, в эпоху ИИ. Вскоре производитель намерен представить новые продукты серии DFCX, которые поддержат растущие потребности цифровой инфраструктуры.

24.02.2025 [18:12], Руслан Авдеев

Submer выпустит автономного робота для систем погружного охлажденияКомпания Submer, специализирующаяся на системах погружного (иммерсионного) охлаждения, работает над роботом ADA (Autonomous Datacenter Assistant) для автоматизации процесса установки и извлечения серверов из резервуаров СЖО, сообщает Datacenter Dynamics. Резервуары в помещениях дата-центров значительно отличаются от традиционных стоек. Серверы и оборудование из охлаждающей жидкости необходимо погружать и извлекать вертикально. Нередко для этого применяется переносной кран, похожий на лебёдку для снятия автомобильных двигателей. Встречаются и стационарные подвесные системы, если это позволяют ресурсы и размеры помещения. После извлечения серверов необходимо очистить их от диэлектрической жидкости — нередко в процессе используется специальный поддон и чистящий раствор. Робот может значительно ускорить и упростить процесс извлечения и очистки. Сообщается, что подвижная роботизированная платформа появится в продаже в конце 2025 года, хотя исходная версия ADA была представлена ещё в октябре 2021 года. Систему изначально разрабатывали для мониторинга, а также вывода серверов из эксплуатации и ввода в эксплуатацию, в том числе для установки и извлечения серверов из резервуаров с жидкостью. Дополнительной информации о новинке журналистам не представили. По последним данным Submer получила на развитие $55,5 млн. Помимо Submer автоматизацией установки серверов в резервуарах занималась, например, TMGcore. Она запустила платформу двухфазного иммерсионного охлаждения Otto, которая включала роботизированную лебёдку. Разработанная при сотрудничестве с Olympus Controls, система обеспечивала «горячую замену» с использованием расположенного рядом резервного сервера. В 2021 году была анонсирована версия Ottomobile, которая крепилась к задней части грузовика Ford, спроектированного как мобильный микро-ЦОД. С тех пор компанию купила Modline и включила её в подразделение Airedale.

23.02.2025 [13:10], Сергей Карасёв

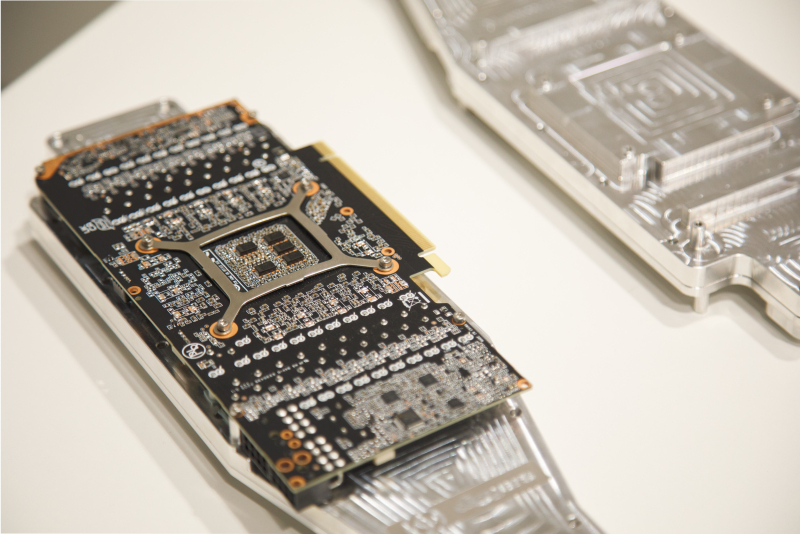

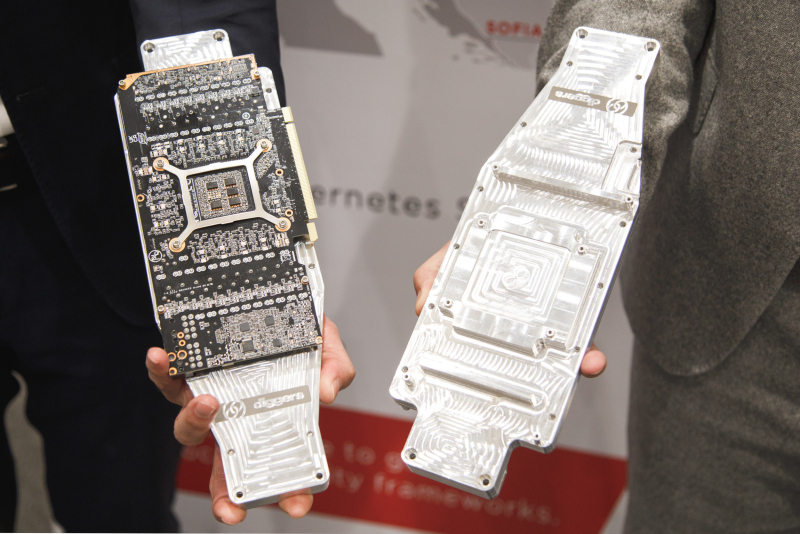

Австрийская Diggers разработала новую СЖО для GPU-серверовЕвропейский поставщик облачных услуг Exoscale, входящий в состав A1 Digital, в партнёрстве с австрийской компанией Diggers работает над созданием устойчивых дата-центров нового поколения, ориентированных на ресурсоёмкие задачи ИИ. Речь идёт о внедрении новой технологии прямого жидкостного охлаждения (DLC). Архитектура, разработанная специалистами Diggers, предполагает размещение серверов в «холодных ящиках» — шкафах, в которые не попадает и не выходит воздух. Для отвода тепла от CPU и GPU служат специальные пластины с микроканалами, через которые циркулирует охлаждающая жидкость. Для работы системы требуется подача только электричества и воды. Водоблоки выполнены из алюминия, что предотвращает коррозию. Микроканалы распределяют жидкость таким образом, чтобы увеличить теплопередачу. Каждый водоблок может отводить тепло от двух GPU, которые монтируются с противоположных сторон. Предложенная архитектура устраняет необходимость в холодном коридоре. Утверждается, что по сравнению с обычными системами охлаждения энергопотребление сокращается на 50 %. Показатель PUE составляет до 1,05. «Мы достигаем практически таких же технических показателей, что и при использовании погружного охлаждения, но при этом не применяется минеральное масло и нет сложностей с обслуживанием. Всё легко меняется. Вы можете менять память и накопители», — говорит генеральный директор Diggers Мартин Шехтнер (Martin Schechtner). Вода на выходе имеет температуру около 50 °C: она может использоваться либо для нужд самого дата-центра, либо направляться в местную отопительную сеть. Решение может быть интегрировано как в новые, так и в существующие ЦОД. Exoscale испытывает систему на своём объекте в Вене (Австрия). |

|