Материалы по тегу: ии

|

05.11.2024 [21:42], Руслан Авдеев

SK Telecom построит гигаваттные ИИ ЦОД в Южной Корее и за её пределамиВ ходе мероприятия SK AI Summit 2024 глава южнокорейского оператора SK Telecom Рю Ён Сан (Ryu Young-sang) объявил, что стратегия компании будет связана с тремя основными компонентами: ИИ ЦОД, облачным доступом к ИИ-ускорителям (GPUaaS) и периферийными ИИ-сервисами (Edge AI). По данным блога IEEE ComSoc, компания рассчитывает развивать соответствующий бизнес в Южной Корее и в Азиатско-Тихоокеанском регионе (АТР), а также за его пределами, в том числе с партнёрами. SK Telecom намерена построить в ключевых регионах страны и за её пределами ИИ ЦОД гиперскейл-уровня, став инфраструктурным ИИ-хабом для всего АТР. Компания также будет предоставлять облачный доступ к ИИ-ускорителям, чтобы компенсировать их дефицит в Южной Корее и развернёт периферийную ИИ-инфраструктуру для быстрого обслуживания оконечных устройств. SK Telecom начнёт строительство «небольших» ИИ ЦОД ёмкостью от 100 МВт каждый, со временем доведя общую ёмкость до нескольких гигаватт. В Корее дата-центры смогут рассчитывать на стабильные поставки энергии из возобновляемых источников на основе водородной, солнечной или ветряной энергетики. Дополнят ЦОД международные ВОЛС. При этом «материнская» SK Group намерена задействовать для обеспечения работы все свои ресурсы, от передовых полупроводников до систем погружного охлаждения и других технологий.

Источник изображения: SK Telecom SK Telecom намерена уже в декабре развернуть тестовый ИИ ЦОД в Южной Корее для испытания комбинации технологий SK Group и партнёров. В частности, в ЦОД будут испытывать три типа СЖО: прямое жидкостное охлаждение, иммерсионное охлаждение и прецизионное жидкостного охлаждения (Precision Liquid Cooling, PLC). Там же проведут испытания чипов SK hynix, включая передовую память HBM, решения для виртуализации ускорителей и ИИ-технологии оптимизации энергозатрат. Один из имеющихся ЦОД в Гасане в спешном порядке оснастят современными ускорителями. С декабря в рамках GPUaaS станут доступны NVIDIA H100 — это совместный проект с американской Lambda Labs. В марте 2025 года планируется развернуть NVIDIA H200. Наконец, периферийные сервисы Edge AI задействуют национальную телеком-инфраструктуру, чтобы «установить контакт» между ЦОД и ИИ на оконечных устройствах. Сейчас SK Telecom проводит исследования совместно с партнёрами со всего мира, изучая пути возможности развития ИИ-инфраструктуры и разработки новых ИИ-сервисов в области здравоохранения, робототехники, видеонаблюдения и др. В компании утверждают, что если раньше конкуренция в сфере телекоммуникаций была связана в основном со скоростью и ёмкостью каналов, то теперь «парадигму сетевой эволюции» следует изменить — будущие 6G-сети эволюционируют в ИИ-инфраструктуру следующего поколения, где коммуникации и ИИ интегрированы.

05.11.2024 [18:19], Андрей Крупин

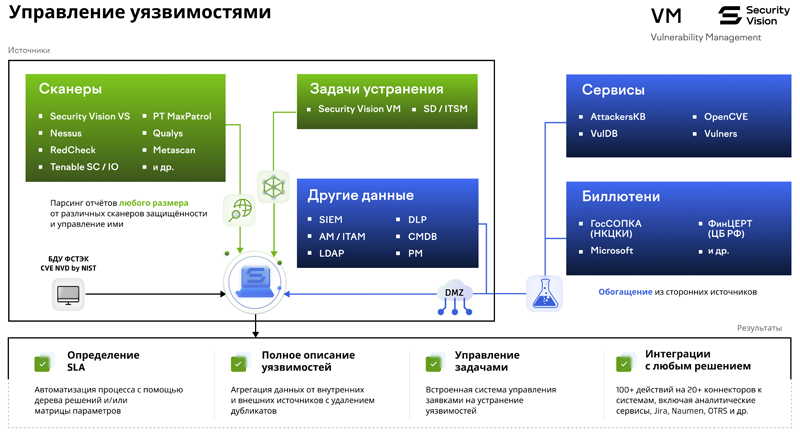

Система управления уязвимостями Security Vision Vulnerability Management получила крупное обновлениеКомпания «Интеллектуальная безопасность» сообщила о выпуске новой версии программного комплекса Security Vision Vulnerability Management (VM), предназначенного для анализа защищённости корпоративных IT-систем и оперативного устранения обнаруженных уязвимостей. Security Vision VM позволяет выстраивать процессы обнаружения и устранения уязвимостей, сбор информации с имеющихся сканеров защищённости, платформ управления обновлениями, экспертных внешних сервисов и других решений. Продукт обеспечивает сбор полной картины уязвимостей, их взаимосвязей и рекомендаций из различных источников, формируя постоянный циклический процесс с автоматизацией оповещений, отчётов и других необходимых действий.

Схема работы и взаимодействия Security Vision Vulnerability Management с IT-инфраструктурой предприятия (источник изображения: securityvision.ru/products/vm) В обновлённом Security Vision VM доработаны механизмы поиска уязвимостей в контейнерных средах, отдельно реализованные для запущенных, остановленных контейнеров и образов, в том числе в окружениях под управлением Kubernetes. Также в программный комплекс добавлены новые режимы сканирования: Pentest (обнаружение и проверка возможности эксплуатации сетевых уязвимостей, применения наиболее серьёзных эксплойтов, подбор слабых паролей, проверка устаревших/уязвимых алгоритмов шифрования и др.), «Сканирование веб-приложений» (проводится проверка на XSS-, CSRF-уязвимости, SQL-инъекции, RFI, Сode injection, раскрытие внутренней информации и настроек сайтов, подбор слабых паролей, перебор учётных записей, проверка эксплуатации специфичных веб-уязвимостей и др.) и «Ретро-скан» (поиск уязвимостей по полученным ранее данным из активов, без подключения к ним и ожидания окон сканирования). Немало в новой версии Security Vision VM реализовано прочих доработок. В частности, сообщается о расширении списка скриптов для взаимодействия с IT-активами, которые позволяют выполнять типовые действия по получению информации, администрированию и изменению конфигураций на Windows- и Linux-хостах, различных видах сетевого оборудования и базах данных. В дополнение к этому доработан механизм белых/черных списков, контроля разрешённого и запрещённого ПО, а также выполнения сложных скриптов при автоматическом патчинге, включая возможность отмены внесённых изменений. В рамках регулярных обновлений баз уязвимостей со стороны компании «Интеллектуальная безопасность» предоставляются сведения об актуальных уязвимостях и выполнение дополнительных проверок по обнаружению наиболее критичных уязвимостей.

05.11.2024 [17:34], Руслан Авдеев

Развитие генеративного ИИ всё больше зависит от доступности качественных данных, пресной воды, электроэнергии и чистой медиСистемам генеративного ИИ требуются самые разные ресурсы, но в некоторых сферах их нехватка может носить критический характер. По данным DigiTimes, серьёзную проблему может составить нехватка качественных массивов данных, рост потребления электроэнергии и пресной воды, а также дефицит поставок меди для IT-индустрии. Как сообщают эксперты CB Insights, к 2026 году может снизиться доступность высококачественных данных для обучения языковых моделей. В результате их разработчикам придётся полагаться либо на дорогие лицензированные данные, либо на синтезированные самим же ИИ наборы данных. С 2022 года около 50 вендоров уже вышли на рынок синтетических данных для обучения, а ещё 30 компаний ищут средства. Однако выход на этот рынок гигантов вроде Microsoft и Meta✴ сократил возможности привлечения средств стартапами. В 2024 году в этой сфере отмечены всего пять раундов финансирования, тогда как в 2022 году был 21 раунд. Кроме того, теперь в некоторых стартапах соответствующего профиля начались и увольнения, а израильская Datagen, основанная ещё в 2018 году, подала заявление о банкротстве. При этом Scale AI, основанная чуть раньше, сумела привлечь $1 млрд. Развитие ИИ также значительно увеличивает энергопотребление, например, ИИ-поиск Google, по слухам, требует в 10 раз больше энергии, чем обычный. По информации Международного энергетического агентства (IEA), спрос на электроэнергию, связанный ЦОД. ИИ и криптовалютами, достиг в 2022 году 460 ТВт∙ч, а к 2026 году должен вырасти до 620–1050 ТВт∙ч. По оценкам IEA к 2026 году отрасли на основе ИИ, возможно, будут потреблять в 10 раз больше энергии, чем в 2023 году. Компенсировать спрос частично могут технологические инновации в сфере энергетики. Исследователи Central Research Institute of Electric Power Industry (CRIEPI) отмечают, что развитие энергосберегающих технологий может вдвое снизить рост спроса на электричество. Впрочем, коммерческая судьба таких проектов не всегда благоприятна. Развитию ИИ угрожает и рост потребления воды системами охлаждения ЦОД. В 2023 году Microsoft сообщала о 23-% росте потребления воды до 7,844 млн м3, в основном из-за расширения ЦОД. Например, обучение модели OpenAI GPT-3 с 175 млрд параметров потребовало 700 м3 только на охлаждение серверов в новейшем американском ЦОД Microsoft. С учётом воды, потраченной при генерации энергии и производстве оборудования, расход составил и вовсе 5,4 тыс. м3. А при эксплуатации GPT-3 каждый диалог из 10–50 запросов обходился в 0,5 л воды. К 2027 году спрос на воду на охлаждение и производство энергии во всех ЦОД должен достичь 4,2–6,6 млрд м3/год. Приблизительно столько за полгода потребляет Великобритания. Наконец, угрозу индустрии ИИ представляет дефицит меди. Спрос на медь растёт вместе со спросом на возобновляемую энергию, электротранспорт и генеративный ИИ. По данным JPMorgan Chase & Co. К 2030 году только ИИ ЦОД могут требовать 2,6 млн т меди ежегодно. Каждый дополнительный МВт ёмкости может требовать 20–40 т меди. Дефицит предложения меди по прогнозам вырастет до 4 млн т в год к 2030 году, спрос ИИ-индустрии добавит этому показателю ещё 2,6 млн т. Здесь тоже могут помочь новые технологии, способные прямо или косвенно снизить спрос или замедлить его рост. По оценкам Macquarie Investment Bank, ежегодный рост спроса на медь может быть ограничен 200 тыс. т до 2030 года — другие аналитики куда более пессимистичны. Оценка потребления для ЦОД составляет 27 т/МВт, что приблизительно соответствует оценкам JPMorgan. В Macquarie отмечают, что технологии энергосбережения помогут компенсировать рост энергопотребления ИИ-инфраструктурой, а также рост использования меди в отрасли.

05.11.2024 [15:40], Сергей Карасёв

MONAKA + Instinct: AMD и Fujitsu вместе создадут Arm-платформы для ИИ и HPCAMD и Fujitsu объявили о подписании меморандума о взаимопонимании с целью формирования стратегического партнёрства, направленного на создание вычислительных платформ для ИИ и HPC. Предполагается, что сотрудничество охватит различные сферы — от разработки специализированных решений до коммерциализации. Речь идёт об объединении передовых аппаратных решений в области CPU и GPU с сопутствующим ПО. Партнёры намерены содействовать формированию открытой экосистемы для задач ИИ. В частности, упомянуты Arm-процессоры Fujitsu MONAKA и ускорители AMD Instinct. Стороны намерены задействовать открытый программный стек AMD ROCm и специализированный софт Fujitsu для изделий с архитектурой Arm. В целом, сотрудничество будет сосредоточено на трёх ключевых направлениях — инжиниринг, экосистемы и бизнес. Партнёры рассчитывают создать инновационные вычислительные платформы для ИИ и HPC к 2027 году. AMD и Fujitsu также будут сообща работать над маркетинговыми кампаниями и улучшать взаимодействие с заказчиками. Например, планируется создание совместного центра для клиентов. «Объединяя инновационную технологию графических чипов AMD с эффективными и высокопроизводительными процессорами Fujitsu, мы стремимся создать среду, в которой больше компаний смогут использовать инструменты ИИ при одновременном снижении энергопотребления в дата-центрах», — говорит Вивек Махаджан (Vivek Mahajan), корпоративный вице-президент и технический директор Fujitsu. Нужно отметить, что ранее Fujitsu заключила соглашение о сотрудничестве с Supermicro. Компании займутся разработкой СЖО для ЦОД, а также серверов следующего поколения на чипах Fujitsu MONAKA для широкого спектра рабочих нагрузок — от ИИ и НРС до облачных и периферийных задач. Два года назад AMD также подписала аналогичное соглашение о сотрудничестве с европейским разработчиком серверных Arm-процессоров SiPearl.

05.11.2024 [11:26], Владимир Мироненко

Microsoft потратит $10 млрд на аренду ИИ-серверов у своего конкурента CoreWeaveMicrosoft и CoreWeave являются конкурентами на рынке ИИ-решений, но это не мешает Microsoft быть крупнейшим клиентом стартапа. Затраты Microsoft на аренду серверов у CoreWeave в период с 2023 по 2030 год составят почти $10 млрд, пишет ресурс The Information. Эта сумма больше, чем сообщалось ранее, и составляет более половины от всех имеющихся у CoreWeave контрактов с клиентами в объёме $17 млрд, отметил ресурс, ссылаясь на комментарии компании в ходе общения с инвесторами. Недавно CoreWeave получила кредитную линию на $650 млн от нескольких инвестиционных банков, включая JPMorgan Chase, Goldman Sachs и Morgan Stanley. До этого CoreWeave за 12 месяцев привлекла $12,7 млрд в виде акционерного и долгового финансирования, включая раунд долгового финансирования на $7,5 млрд в мае. Также компания в августе 2023 года привлекла $2,3 млрд в виде долга под залог ускорителей NVIDIA от ряда инвесторов. Кроме того, в компанию инвестировала и сама NVIDIA. CoreWeave, основанная в 2017 году в Роузленде (штат Нью-Джерси), предоставляет облачный доступ на правах аренды к самым передовым ускорителям NVIDIA в своих 14 ЦОД. К концу года компания планирует открыть ещё 28 ЦОД. Ранее сообщалось о подготовке CoreWeave к первичному публичному размещению ценных бумаг (IPO), которое может пройти в начале 2025 года. Сама Microsoft стремительно наращивает закупки суперускорителей NVIDIA GB200 NVL нового поколения и намерена агрессивно масштабировать свои вычислительные ресурсы. Причём не только для себя — Microsoft арендует у Oracle ускорители для нужд OpenAI.

05.11.2024 [11:17], Сергей Карасёв

Создан консорциум UALink по разработке альтернативы NVIDIA NVLinkВ мае нынешнего года был сформирован альянс Ultra Accelerator Link (UALink) по разработке технологии, призванной составить конкуренцию NVIDIA NVLink. А теперь участники отрасли объявили о создании соответствующего консорциума — UALink Consortium. Новую структуру возглавляют представители AMD, AWS, Astera Labs, Cisco, Google, HPE, Intel, Meta✴ и Microsoft. В состав консорциума также входят Cadence, Lenovo, H3C, Centec, Anapass и пр. Кроме того, к участию приглашаются другие заинтересованные стороны. Фактически участники заняты созданием более открытой альтернативы NVLink. «Стандарт UALink определяет высокоскоростную связь с низкими задержками для масштабируемых систем ИИ в дата-центрах. Заинтересованные компании могут присоединиться к консорциуму и поддержать нашу миссию: создание открытого и высокопроизводительного интерконнекта для рабочих нагрузок ИИ», — сказал Вилли Нельсон (Willie Nelson), президент UALink. Отмечается, что компании, входящие в совет консорциума, охватывают широкий спектр отраслей — от поставщиков облачных услуг и OEM-производителей до разработчиков ПО и полупроводниковых компонентов. В I квартале 2025 года планируется представить общедоступную спецификацию UALink 1.0, которая предусматривает пропускную способность до 200 Гбит/с на соединение. В пределах одного домена при этом могут быть объединены до 1024 ускорителей ИИ. Выпуск спецификации UALink 1.0 станет важной вехой, поскольку она определит открытый отраслевой стандарт, позволяющий ускорителям и коммутаторам ИИ взаимодействовать более эффективно. Это откроет новые возможности в плане развития и внедрения крупных ИИ-моделей.

04.11.2024 [17:05], Сергей Карасёв

NextSilicon представила самооптимизирующиеся ускорители вычислений Maverick-2Компания NextSilicon сообщила о разработке устройств Maverick-2 — так называемых интеллектуальных вычислительных ускорителей (Intelligent Compute Accelerator, ICA). Изделия, как утверждается, обеспечивают высокую производительность и эффективность при решении задач HPC и ИИ, а также при обслуживании векторных баз данных. NextSilicon разрабатывает новую вычислительную платформу для ресурсоёмких приложений. Применяются специальные программные алгоритмы для динамической реконфигурации оборудования на основе данных, получаемых непосредственно во время выполнения задачи. Это позволяет оптимизировать производительность и энергопотребление. Maverick-2 ICA, по словам компании, представляет собой программно-определяемый аппаратный ускоритель. По заявлениям NextSilicon, изделие в плане производительности на один ватт затрачиваемой энергии более чем в четыре раза превосходит традиционные GPU, а в сравнении с топовыми CPU и вовсе достигается 20-кратное превосходство. При этом говорится об уменьшении эксплуатационных расходов более чем в два раза. «Телеметрические данные, собранные во время работы приложения, используются интеллектуальными алгоритмами NextSilicon для непрерывной самооптимизации в реальном времени. Результатом являются эффективность и производительность в задачах HPC при сокращении потребления энергии на 50–80 % по сравнению с традиционными GPU», — заявляет компания. Решения Maverick-2 доступны в виде однокристальной карты расширения PCIe 5.0 x16 и двухкристального OAM-модуля. В первом случае объём памяти HBM3e составляет 96 Гбайт, энергопотребление — 300 Вт. У второго изделия эти показатели равны 192 Гбайт и 600 Вт. Тактовая частота в обоих вариантах — 1,5 ГГц. При производстве применяется 5-нм технология TSMC. Говорится о совместимости с популярными языками программирования и фреймворками, такими как C/C++, Fortran, OpenMP и Kokkos. Это позволяет многим приложениям работать без изменений, упрощая портирование и устраняя необходимость в проприетарном программном стеке.

04.11.2024 [13:05], Сергей Карасёв

DeepL развернёт в Швеции ИИ-платформу на базе NVIDIA DGX GB200 SuperPod, чтобы «разрушить языковые барьеры»Компания DeepL объявила о намерении развернуть вычислительный комплекс на платформе NVIDIA DGX SuperPOD с ускорителями GB200. Система расположится на площадке EcoDataCenter в Швеции, а её ввод в эксплуатацию запланирован на середину 2025 года. DeepL специализируется на разработке средств автоматического перевода на основе ИИ. По заявлениям Ярека Кутыловски (Jarek Kutylowski), генерального директора и основателя DeepL, компания создала решение, которое по точности перевода превосходит все другие сервисы на рынке. Более 100 тыс. предприятий, правительственных структур и других организаций, а также миллионы индивидуальных пользователей по всему миру применяют языковые ИИ-инструменты DeepL. Штат компании насчитывает более 1 тыс. сотрудников. Её поддерживают инвестициями Benchmark, IVP, Index Ventures и др. В 2023 году DeepL развернула суперкомпьютер Mercury на базе NVIDIA DGX SuperPOD с ускорителями H100. В июньском рейтинге TOP500 эта система занимает 41-е место с FP64-производительностью 21,85 Пфлопс и теоретическим пиковым быстродействием 33,85 Пфлопс. Платформа NVIDIA DGX SuperPOD с ускорителями GB200 предусматривает использование жидкостного охлаждения. Возможно масштабирование до десятков тысяч ускорителей. DeepL намерена применять новый комплекс для исследовательских задач — в частности, для разработки передовых ИИ-моделей, которые позволят ещё больше расширить возможности средств перевода между различными языками. Это позволит «разрушить языковые барьеры для предприятий и профессионалов по всему миру», обещает компания.

03.11.2024 [23:50], Владимир Мироненко

Lumen организует частные ВОЛС между ИИ ЦОД AWS, а взамен воспользуется ИИ-сервисами AmazonLumen Technologies и Amazon Web Services (AWS) объявили о сделке, которая обещает быть взаимовыгодной для обеих сторон. Финансовые условия соглашения не разглашаются. В рамках сделки Lumen предоставит выделенную инфраструктуру Private Connectivity Fabric на базе частных ВОЛС между регионами и локальными зонами AWS в США. AWS продолжит развёртывать свои собственные сетевые решения на данных ВОЛС. Как указано в пресс-релизе, усовершенствованная сеть AWS обеспечит высокоскоростные и динамические соединения, которые предоставят клиентам возможность разрабатывать приложения генеративного ИИ, обучать ИИ-модели и поставлять новые продукты на базе ИИ по всему региону и в локальных зонах. «ИИ меняет отрасли, и поддерживающая его сетевая инфраструктура должна быть такой же динамичной и отзывчивой, — сказала Кейт Джонсон (Kate Johnson), президент и генеральный директор Lumen Technologies. — Будучи доверенной сетью для ИИ, Lumen использует ВОЛС следующего поколения, чтобы помочь AWS предоставлять решения с высокой пропускной способностью, которые позволят их клиентам испытать и реализовать весь потенциал ИИ».

Источник изображения: Lumen Technologies Также в рамках сделки Lumen переместит свои продуктовые и IT-платформы в облако AWS. В будущем Lumen сможет применять ИИ-технологии Amazon, включая сервис Bedrock, для лучшего планирования и оптимизации работы сети. Это обеспечит Lumen полную видимость своей сети, позволит повысить качество обслуживания клиентов и сократить расходы. В Lumen планируют перейти на автономную сетевую платформу на базе генеративного ИИ, которая позволит динамически управлять распределением ресурсов, а также быстро выявлять и решать проблемы, связанные с обслуживанием и сетью. «С AWS мы можем поддерживать нашу трансформацию и удовлетворять растущие потребности наших клиентов», — сказала Джонсон. В пресс-релизе также отмечено, что Lumen и AWS уже много лет являются партнёрами. Имея статус провайдера AWS MSP (Managed Service Provider), Lumen помогает клиентам переносить рабочие нагрузки в AWS, обеспечивая плавный переход к их облачной инфраструктуре. Lumen управляет инфраструктурой, включающей более чем 423 тыс. км оптоволоконных линий связи. Компания стремится извлечь выгоду из растущего спроса на ИИ-технологии, чтобы компенсировать падение выручки от устаревших направлений бизнеса, включя предоставление голосовых, широкополосных и других сервисов для предприятий и частных лиц. Недавно компания объявила о заключении подобных сделок с Meta✴ и Microsoft, причём в Azure она тоже перенесёт часть нагрузок. Кейт Джонсон заявила в интервью Bloomberg TV, что сети этих компаний не отвечают их потребностям в экономике ИИ, поскольку недостаточно велики, недостаточно быстры и недостаточно безопасны, но Lumen под силу исправить эти проблемы. В августе Lumen сообщила, что благодаря буму вокруг ИИ получила новые заказы на сумму $5 млрд и ведёт «активные переговоры с клиентами», чтобы заключить сделки ещё на $7 млрд.

03.11.2024 [13:15], Сергей Карасёв

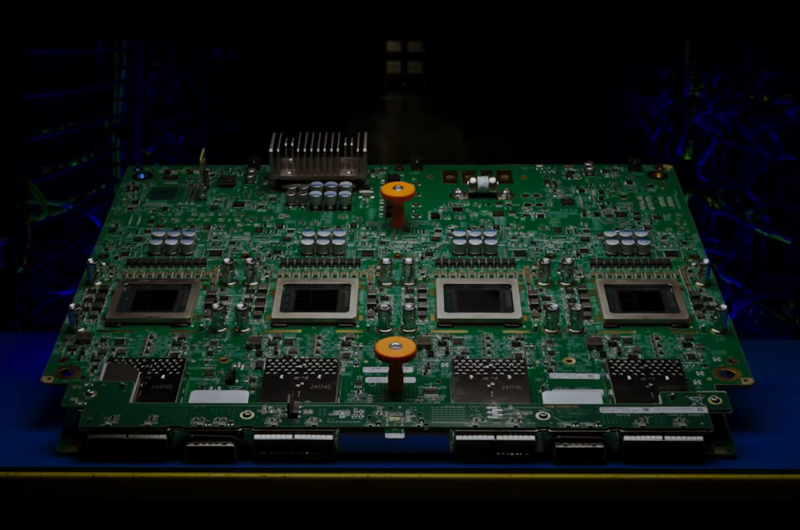

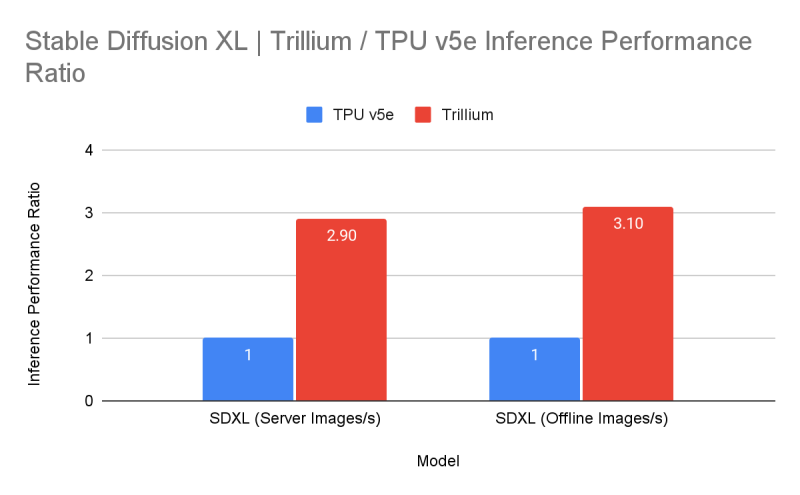

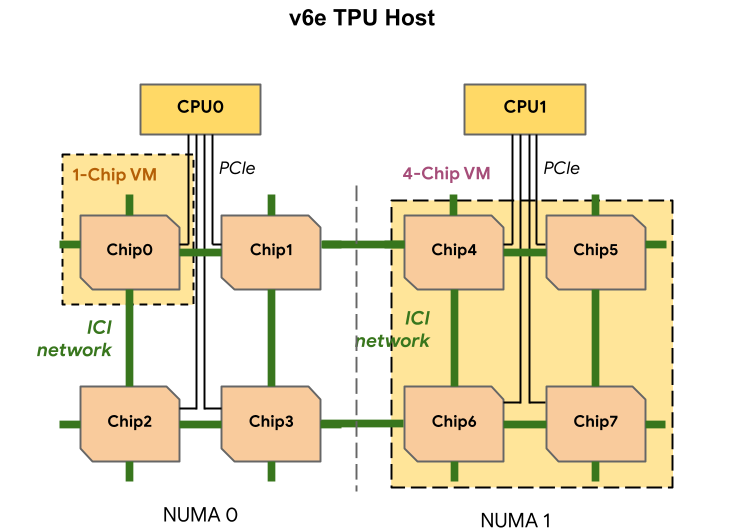

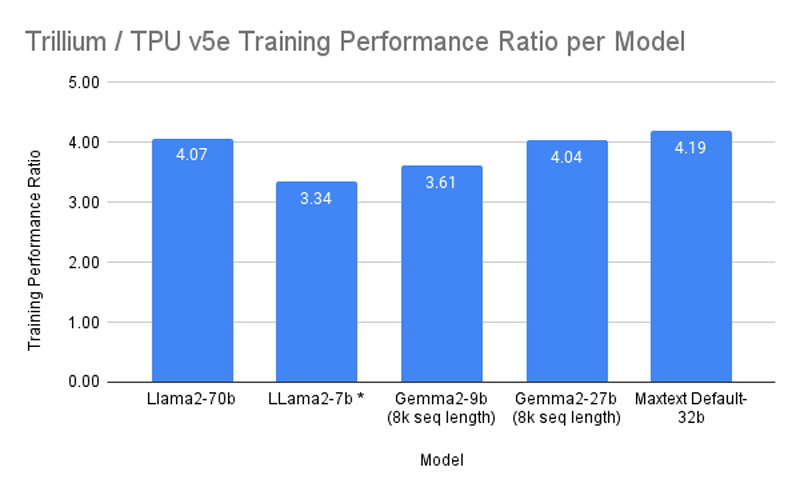

Google объявила о доступности ИИ-ускорителей TPU v6 TrilliumКомпания Google сообщила о том, что её новейшие ИИ-ускорители TPU v6 с кодовым именем Trillium доступны клиентам для ознакомления в составе облачной платформы GCP. Утверждается, что на сегодняшний день новинка является самым эффективным решением Google по соотношению цена/производительность. Официальная презентация Trillium состоялась в мае нынешнего года. Изделие оснащено 32 Гбайт памяти HBM с пропускной способностью 1,6 Тбайт/с, а межчиповый интерконнект ICI обеспечивает возможность передачи данных со скоростью до 3,58 Тбит/с (по четыре порта на чип). Задействованы блоки SparseCore третьего поколения, предназначенные для ускорения работы с ИИ-моделями, которые используются в системах ранжирования и рекомендаций. Google выделяет ряд существенных преимуществ Trillium (TPU v6e) перед ускорителями TPU v5e:

Один узел включает восемь ускорителей TPU v6e (в двух NUMA-доменах), два неназванных процессора (суммарно 180 vCPU), 1,44 Тбайт RAM и четыре 200G-адаптера (по два на CPU) для связи с внешним миром. Отмечается, что посредством ICI напрямую могут быть объединены до 256 изделий Trillium, а агрегированная скорость сетевого подключение такого кластера (Pod) составляет 25,6 Тбит/с. Десятки тысяч ускорителей могут быть связаны в масштабный ИИ-кластер благодаря платформе Google Jupiter с оптической коммутацией, совокупная пропускная способность которой достигает 13 Пбит/с. Trillium доступны в составе интегрированной ИИ-платформы AI Hypercomputer. Заявляется, что благодаря ПО Multislice Trillium обеспечивается практически линейное масштабирование производительности для рабочих нагрузок, связанных с обучением ИИ. Производительность кластеров на базе Trillium может достигать 91 Эфлопс на ИИ-операциях: это в четыре раза больше по сравнению с самыми крупными развёртываниями систем на основе TPU v5p. BF16-производительность одного чипа TPU v6e составляет 918 Тфлопс, а INT8 — 1836 Топс.  В бенчмарках Trillium по сравнению с TPU v5e показал более чем четырёхкратное увеличение производительности при обучении моделей Gemma 2-27b, MaxText Default-32b и Llama2-70B, а также более чем трёхкратный прирост для LLama2-7b и Gemma2-9b. Кроме того, Trillium обеспечивает трёхкратное увеличение производительности инференса для Stable Diffusion XL (по отношению к TPU v5e). По соотношению цена/производительность TPU v6e демонстрирует 1,8-кратный рост по сравнению с TPU v5e и примерно двукратный рост по сравнению с TPU v5p. Появится ли более производительная модификация TPU v6p, не уточняется. |

|