Материалы по тегу: ии

|

31.10.2024 [14:56], Владимир Мироненко

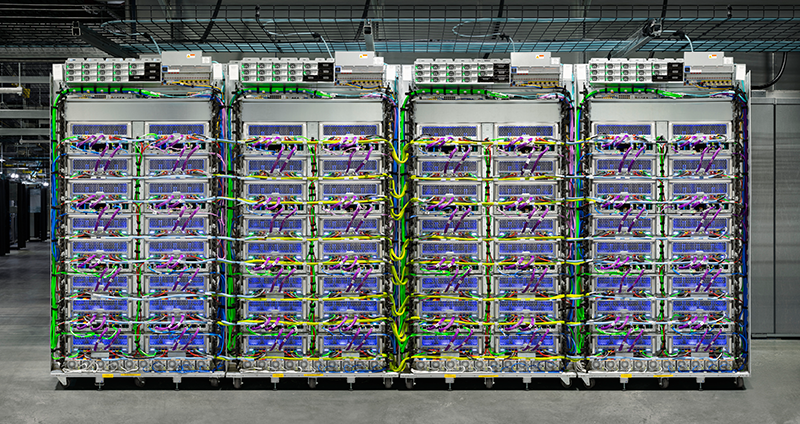

DIGITIMES Research: в 2024 году Google увеличит долю на рынке кастомных ИИ ASIC до 74 %Согласно отчету DIGITIMES Research, в 2024 году глобальные поставки ИИ ASIC собственной разработки для ЦОД, как ожидается, достигнут 3,45 млн единиц, а доля рынка Google вырастет до 74 %. Как сообщают аналитики Research, до конца года Google начнёт массовое производство нового поколения ИИ-ускорителей TPU v6 (Trillium), что ещё больше увеличит её присутствие на рынке. В 2023 году доля Google на рынке ИИ ASIC собственной разработки для ЦОД оценивалась в 71 %. В отчёте отмечено, что помимо самой высокой доли рынка, Google также является первым из трёх крупнейших сервис-провайдеров в мире, кто разработал собственные ИИ-ускорители. Первый TPU компания представила в 2016 году. Ожидается, что TPU v6 будет изготавливаться с применением 5-нм процесса TSMC, в основном с использованием 8-слойных чипов памяти HBM3 от Samsung. Также в отчёте сообщается, что Google интегрировала собственную архитектуру оптического интерконнекта в кластеры TPU v6, позиционируя себя в качестве лидера среди конкурирующих провайдеров облачных сервисов с точки зрения внедрения технологий и масштаба развёртывания. Google заменила традиционные spine-коммутаторы на полностью оптические коммутаторы Jupiter собственной разработки, которые позволяют значительно снизить энергопотребление и стоимость обслуживания ИИ-кластеров TPU POD по сравнению с решениями Broadcom или Mellanox.

Источник изображения: cloud.google.com Кроме того, трансиверы Google получил ряд усовершенствований, значительно нарастив пропускную способность. Если в 2017 году речь шла о полнодуплексном 200G-решении, то в этом году речь идёт уже о 800G-решениях с возможностью модернизации до 1,6T. Скорость одного канала также существенно выросла — с 50G PAM4 в 2017 году до 200G PAM4 в 2024 году.

31.10.2024 [13:14], Руслан Авдеев

Минцифры РФ подготовит единый прайс-лист на ПО для государственных структурДо конца 2024 года Минцифры России намерено сформировать универсальный прайс-лист для закупок программного обеспечения (ПО) государственными структурами. РБК сообщает, что это может решить проблему с большой разницей цен при различных госзакупках — сейчас по этому поводу возникают вопросы у Счётной палаты. Информацию о создании прайс-листа подтвердил глава Минцифры Максут Шадаев на заседании Ассоциации предприятий компьютерных и информационных технологий (АПКИТ). Предполагается, что соответствующие работы проведут совместно со Счётной палатой. По словам министра, в Счётной палате зафиксировали закупки одного и того же ПО с приблизительно равными условиями лицензирования, но цены при этом были совершенно разными. В Счётной палате предполагают недобросовестность со стороны заказчиков, а также разработчиков. По словам Шадаева, в прайс-листе установят диапазон допустимых цен в зависимости от объёмов закупок. Это обеспечит «прозрачные» закупки, чтобы продукт при схожих условиях не закупался по разным ценам. В самой Счётной палате результаты проверок разработчиков комментировать отказались. Среди возможных объяснений большой разницы в стоимости эксперты называют поведение посредников, которые могут сами формировать расценки, отличающиеся требования заказчика, когда, к примеру, помимо закупки ПО необходима его донастройка, интеграция с другими системами и дообучение персонала, а также необходимость доработки в сжатые сроки, что при снижении цен может повлиять на окупаемость. Многие участники отрасли предполагают, что в случае появление единого прайс-листа цены могут только вырасти, поскольку компании, прибегающие сегодня к гибкому ценообразованию, вероятно, сдвинут цены к верхней границе диапазона. Кроме того, сейчас некоторые поставщики при госзакупках готовы максимально снижать цены, лишь бы получить контракты. Ранее уже неоднократно сообщалось, что цены на программное обеспечение отечественной разработки растут и будут расти, в том числе на фоне снижения конкуренции со стороны зарубежных игроков. Так, по словам ФСТЭК, некоторое ПО разом подорожало «в десятки раз», хотя качество его в сравнении с зарубежными аналогами не выросло. Летом 2023 года ряд крупнейших российских разработчиков подписал соглашение, добровольно ограничивающее рост цен, но присоединились к нему далеко не все.

31.10.2024 [11:44], Руслан Авдеев

KKR подписала соглашение о партнёрстве с ECP для строительства ЦОД и реализации энергетических проектов на $50 млрдКомпания KKR подписала соглашение о стратегическом партнёрстве с американской инвестиционной компанией Energy Capital Partners (ECP) на $50 млрд. По данным пресс-службы KKR, сотрудничество будет связано с ускоренным развитием ЦОД, генерацией энергии, а также строительством инфраструктуры для облачных и ИИ-сервисов по всему миру. Как заявляют в KKR, объединив свои ресурсы и возможности, компании получат портфель проектов ЦОД более чем на 8 ГВт, а также 100 ГВт уже действующих и готовых к строительству источников энергии, что позволит быстро реализовать все планы. Сотрудничество направлено на поддержку крупномасштабных проектов по обучению ИИ-моделей, их тюнингу и инференсу в разных регионах. Партнёры будут работать с участниками отрасли, включая коммунальные службы, производителей энергии, а также девелоперов для того, чтобы ускорить создание крупных кампусов для гиперскейлеров. KKR внесёт вклад в совместные проекты существующей инфраструктурой, стратегическими проектами в сфере недвижимости и страховыми счетами. ECP предложит свои нынешние и будущие пулы капитала для инфраструктурных инициатив. Как считают в ECP, чтобы сохранить лидерство США в сфере ИИ, понадобятся крупные инвестиции в энергетическую инфраструктуру, которые помогут решить вопросы, связанные с ценами на электричество и углеродными выбросами. ECP уже сегодня инвестирует в возобновляемую энергетику, в частности, в системы хранения энергии, экоинфраструктуру, повышение эффективности и надёжности объектов и др. Компания владеет более 83 ГВт генерирующих мощностей на рынке США. KKR владеет и управляет значительным числом ЦОД — более 100 объектов по всему миру. Компания называет себя одним из ключевых инвесторов на рынке дата-центров. В 2021 году компания закрыла одну из крупнейших сделок по покупке ЦОД, купив вместе с Global Infrastructure Partners (теперь BlackRock) компанию CyrusOne за $15 млрд. Недавно в союзе с Singtel компания объявила о намерении инвестировать S$1,75 млрд ($1,3 млрд) в оператора ST Telemedia Global Data Centres, с возможностью вложить дополнительные S$1,24 млрд ($920 млн). Есть собственные инфраструктурные проекты и у других компаний. Например, BlackRock запустила собственный фонд инвестиций в ИИ-инфраструктуру для дата-центров и энергетических проектов — инициатива поддерживается Microsoft и NVIDIA.

31.10.2024 [11:33], Сергей Карасёв

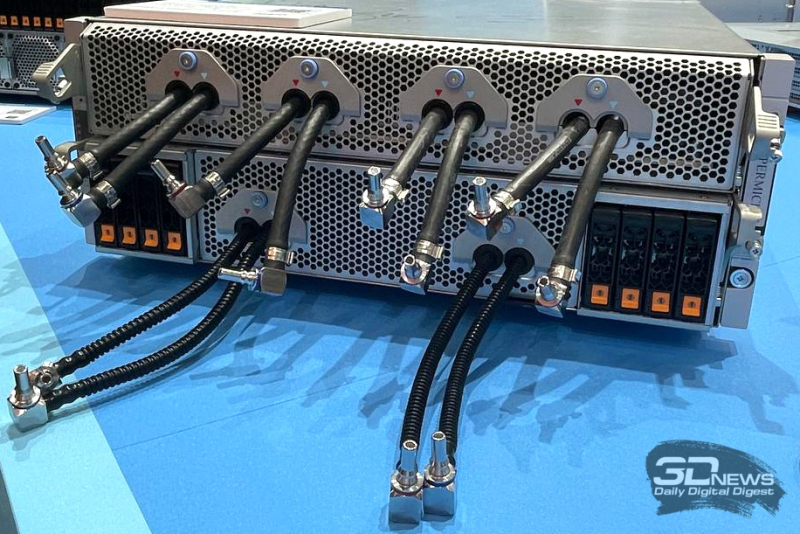

Cisco представила ИИ-сервер UCS C885A M8 на базе NVIDIA H100/H200 или AMD Instinct MI300XКомпания Cisco анонсировала сервер высокой плотности UCS C885A M8, предназначенный для решения задач в области ИИ, таких как обучение больших языковых моделей (LLM), тонкая настройка моделей, инференс, RAG и пр. Устройство выполнено в форм-факторе 8U. В зависимости от модификации устанавливаются два процессора AMD EPYC 9554 поколения Genoa (64 ядра; 128 потоков; 3,1–3,75 ГГц; 360 Вт) или два чипа EPYC 9575F семейства Turin (64 ядра; 128 потоков; 3,3–5,0 ГГц; 400 Вт). Доступны 24 слота для модулей DDR5-600 суммарным объёмом 2,3 Тбайт. В максимальной конфигурации могут быть задействованы восемь SXM-ускорителей NVIDIA H100, H200 или AMD Instinct MI300X. Каждый ускоритель дополнен сетевым адаптером NVIDIA ConnectX-7 или NVIDIA BlueField-3 SuperNIC. Кроме того, в состав сервера входит DPU BlueField-3. Слоты расширения выполнены по схеме 5 × PCIe 5.0 x16 FHHL плюс 8 × PCIe 5.0 x16 HHHL и 1 × OCP 3.0 PCIe 5.0 x8 (для карты X710-T2L 2x10G RJ45 NIC). Новинка оборудована загрузочным SSD вместимостью 1 Тбайт (M.2 NVMe), а также 16 накопителями U.2 NVMe SSD на 1,92 Тбайт каждый. Установлены два блока питания мощностью 2700 Вт и шесть блоков на 3000 Вт с возможностью горячей замены. Cisco также представила инфраструктурные стеки AI POD, адаптированные для конкретных вариантов использования ИИ в различных отраслях. Они объединяют вычислительные узлы, сетевые компоненты, средства хранения и управления. Стеки, как утверждается, обеспечивают хорошую масштабируемость и высокую эффективность при решении ИИ-задач.

30.10.2024 [23:59], Владимир Мироненко

Облако Google Cloud увеличило выручку на 35 % и компания готова вложить ещё $7 млрд в ЦОД и оборудованиеХолдинг Alphabet, материнская структура Google, сообщил неаудированные финансовые результаты III квартала 2024 года, завершившегося 30 сентября. Alphabet заявил, что его инвестиции в ИИ окупаются, поскольку выручка облачного подразделения выросла на 35 %. Также значительно увеличилась выручка самого холдинга, значительно превысив прогнозы Уолл-стрит, благодаря чему его акции выросли в цене почти на 6 % на внебиржевых торгах во вторник. Перед пресс-конференцией в среду гендиректор Alphabet Сундар Пичаи (Sundar Pichai) отметил, что «долгосрочная ориентация и инвестиции компании в ИИ» начинают приносить плоды как корпоративным клиентам, так и обычным потребителям. Выручка Alphabet составила за квартал $88,27 млрд, превысив показатель аналогичного квартала в 2023 году на 15 %, а также консенсус-прогноз аналитиков, опрошенных LSEG, в размере $86,30 млрд. При этом доход Google Cloud вырос год к году на 35 % до $11,35 млрд, а операционная прибыль платформы увеличилась в семь раз до $1,9 млрд с $266 млн в прошлом году. Как отметила финансовый директор Alphabet Анат Ашкенази (Anat Ashkenazi), присоединившаяся к холдингу в июне после 23 лет работы в фармацевтической компании Eli Lilly, набор облачных услуг Google Workspace показал сильный рост в III квартале. При этом набор облачных инструментов для управления данными и ИИ опередил по темпам роста показатель облачного подразделения в целом. Ашкенази также сообщила, что капитальные затраты Alphabet в 2025 году будут выше, чем в этом году. В III квартале капзатраты Alphabet выросли на 62 % до $13 млрд. Большая часть этих расходов пошла на «техническую инфраструктуру, из которых около 60 % пришлось на серверы, а 40 % — на ЦОД и сетевое оборудование. По словам финдиректора, Google взяла на себя обязательство вложить в текущем квартале более $7 млрд в запланированные инвестиции в ЦОД, из которых $6 млрд будут инвестированы в объекты на территории США. Компания планирует оптимизировать «физическое присутствие и повысить эффективность технической инфраструктуры», а также «оптимизировать операции всей компании с помощью ИИ», сказала Ашкенази. Ожидается, что в IV квартале капзатраты будут такими же, как в III квартале. Чистая прибыль Alphabet выросла до $26,3 млрд или $2,12 на акцию, по сравнению с $19,7 млрд или $1,55 на акцию в аналогичном квартале прошлого года при консенсус-прогнозе аналитиков, опрошенных LSEG, в размере $1,85 прибыли на акцию.

30.10.2024 [14:46], Руслан Авдеев

Портфолио ЦОД Blackstone выросло до $70 млрд, но компания намерена увеличить его ещё на $100 млрдBlackstone продолжает пополнять портфолио своих дата-центров. По данным Datacenter Dynamics, сейчас она управляет активами ЦОД на $70 млрд, но уже готова увеличить их ещё на $100 млрд. Примечательно, как заметно планы и показатели компании изменились с прошлого квартала. В III календарном квартале 2024 года компания располагала ЦОД «всего» на $55 млрд и только-только намеревалась построить объекты на $70 млрд. Впрочем, основной причиной роста в последние месяцы стало приобретение Blackstone компании AirTrunk за AU$24 млрд ($16 млрд). Как заявил покупатель, сегодня Blackstone является крупнейшим провайдером ЦОД в мире, с объектами в США, Европе, Индии и Японии. AirTrunk, по оценкам Blackstone, была крупнейшим оператором ЦОД в Азиатско-Тихоокеанском регионе.

Источник изображения: Tuân Nguyễn Minh/unsplash.com В компании заявили, что оценили потенциал новой сферы и всего за три года масштабировали соответствующий бизнес до «крупнейшего в мире». Впрочем, много ещё предстоит сделать. В частности, компания займётся решение проблем с энергоснабжением ЦОД, что со временем откроет дополнительные возможности для инвестиций. По словам представителя компании, ЦОД остались крупнейшим драйвером роста в III квартале в инфраструктурных проектах, связанных с недвижимостью, а также для компании в целом. Тот факт, что у компании оказались масштабные запасы капитала, стало огромным конкурентным преимуществом — на покупку и развитие соответствующих бизнесов требуется немало средств. По данным компании, с момента покупки QTS за $10 млрд в 2021 году, ёмкость арендуемых мощностей её ЦОД выросла в восемь раз. При этом Blacskstone располагает не только ЦОД, но и сопутствующей инфраструктурой, доступом к энергии и прочим активам. В Blackstone утверждают, что компания является ведущим поставщиком финансирования для приблизительно 15 % всех проектов возобновляемой энергетики в США за последние 12 месяцев. Помимо QTS и AirTrunk, Blackstone неоднократно инвестировала и в другие проекты, связанные с ЦОД, включая Vnet, Lumina CloudInfra, Copeland, Park Place Technologies и Winthrop Technologies, а также имеет совместные инвестиционные проекты с COPT, Digital Realty и другими компаниями. Так, Blackstone вложит £10 млрд в создание крупнейшего ЦОД в Европе ЦОД в Великобритании.

30.10.2024 [12:00], Сергей Карасёв

NVIDIA представила эталонные архитектуры для корпоративных ИИ-фабрикКомпания NVIDIA анонсировала инициативу Enterprise Reference Architectures (Enterprise RA), в рамках которой партнёры и заказчики смогут использовать эталонные архитектуры для построения собственных ИИ-платформ корпоративного уровня, рассчитанных на ресурсоёмкие нагрузки. NVIDIA отмечает, что на фоне перехода от вычислений общего назначения к ускоренным вычислениям предприятия сталкиваются с различными трудностями при проектировании и развёртывании инфраструктуры ЦОД. Это затрудняет разработку долгосрочных стратегий и снижает эффективность инвестиций. Инициатива Enterprise RA призвана решить проблемы. Эталонные архитектуры Enterprise RA помогут организациям минимизировать ошибки при проектировании так называемых фабрик ИИ (дата-центров для задач ИИ), предоставляя комплексные рекомендации по аппаратному и программному обеспечению, а также подробные указания по оптимальным конфигурациям серверов, кластеров и сетей. В результате клиенты смогут снизить затраты и сократить время, необходимое для построения вычислительной ИИ-инфраструктуры нового поколения. Среди преимуществ предлагаемого подхода названы масштабируемость и управляемость, высокий уровень безопасности (применяется принцип нулевого доверия), оптимальная производительность, снижение сложности систем и ускоренный выход на рынок. Эталонные архитектуры спроектированы таким образом, чтобы их можно было легко модернизировать в будущем. Говорится о совместимости с различными сторонними аппаратными и программными компонентами, но в перечень рекомендаций входят прежде всего решения самой NVIDIA, включая:

Решения на базе NVIDIA Enterprise RA будут предлагаться партнёрами NVIDIA, включая Dell, НРЕ, Lenovo и Supermicro.

30.10.2024 [11:49], Сергей Карасёв

OpenAI разрабатывает собственные ИИ-чипы совместно с Broadcom и TSMC, а пока задействует AMD Instinct MI300XКомпания OpenAI, по информации Reuters, разрабатывает собственные чипы для обработки ИИ-задач. Партнёром в рамках данного проекта выступает Broadcom, а организовать производство изделий планируется на мощностях TSMC ориентировочно в 2026 году. Слухи о том, что OpenAI обсуждает с Broadcom возможность создания собственного ИИ-ускорителя, появились минувшим летом. Тогда говорилось, что эта инициатива является частью более масштабной программы OpenAI по увеличению вычислительных мощностей компании для разработки ИИ, преодолению дефицита ускорителей и снижению зависимости от NVIDIA. Как теперь стало известно, OpenAI уже несколько месяцев работает с Broadcom над своим первым чипом ИИ, ориентированным на задачи инференса. Соответствующая команда разработчиков насчитывает около 20 человек, включая специалистов, которые ранее принимали участие в проектировании ускорителей TPU в Google, в том числе Томаса Норри (Thomas Norrie) и Ричарда Хо (Richard Ho). Подробности о проекте не раскрываются. Reuters, ссылаясь на собственные источники, также сообщает, что OpenAI в дополнение к ИИ-ускорителям NVIDIA намерена взять на вооружение решения AMD, что позволит диверсифицировать поставки оборудования. Речь идёт о применении изделий Instinct MI300X, ресурсы которых будут использоваться через облачную платформу Microsoft Azure. Это позволит увеличить вычислительные мощности: компания OpenAI только в 2024 году намерена потратить на обучение ИИ-моделей и задачи инференса около $7 млрд. Вместе с тем, как отмечается, OpenAI пока отказалась от амбициозных планов по созданию собственного производства ИИ-чипов. Связано это с большими финансовыми и временными затратами, необходимыми для строительства предприятий.

30.10.2024 [10:00], Сергей Карасёв

«Базис» и Angie создадут российский аналог VMware NSXПоставщик средств виртуализации «Базис» и российский разработчик программных продуктов для высоконагруженных систем Angie (ООО «Веб-сервер») объявили о заключении соглашения по созданию первого в РФ коробочного решения для организации программно-определяемых сетей (SDN). Ожидается, что новая платформа станет альтернативой VMware NSX. Ядром команды, формируемой в рамках новой инициативы, являются специалисты Angie. Проект Angie, напомним, был анонсирован в октябре 2022 года. Его развитием занимается компания «Веб-Сервер», которую учредили в России разработчики Nginx. При этом решение Angie является форком Nginx (принадлежит F5 Networks). Говорится, что отечественное SDN-решение разрабатывается эксклюзивно для «Базиса», все права на него будут принадлежать компании. В общей сложности в создании продукта примут участие около 100 архитекторов, инженеров и разработчиков, некоторые из которых ранее занимали ведущие инженерные позиции в F5 Networks. Бета-версия нового продукта появится к концу 2024 года, а выход полноценной коммерческой платформы намечен на 2025-й. Ожидается, что заказчиками SDN-решения станут крупные компании с обширной IT-инфраструктурой — финансовые организации, телекоммуникационные компании, маркетплейсы и пр. Направление SDN, как отмечается, активно развивается в России: совокупный среднегодовой темп роста составляет 14 %. Прогнозируется, что к 2027 году такие продукты займут треть рынка инфраструктурных сервисов в стране, а объём соответствующего сегмента достигнет примерно 30 млрд. руб. Вместе с тем разработка полноценной SDN-системы — сложный процесс, и для этого требуется команда профессиональных специалистов. Первоочередной задачей в рамках нового проекта станет качественная и стабильная реализация ключевых возможностей SDN с приоритетом на внедрение современных инструментов информационной безопасности. Продукт предоставит заказчикам возможность централизованно управлять корпоративной сетью на программном уровне. Для использования системы не потребуется значительная модернизация имеющегося оборудования. Планируется создание единой точки входа для получения полной технической поддержки. Кроме того, предусмотрены инструменты бесшовного внедрения, в том числе миграции бизнес-процессов с VMWare NSX. «Давно назрела необходимость полноценного отечественного SDN-решения на замену недоступным на российском рынке зарубежным продуктам, таким как VMWare NSX, Juniper Contrail, Cisco ACI, HPE SDE Controller и др. И дело не только в импортозамещении, направление программно-определяемых сетей само по себе является одним из наиболее перспективных в мире. Потому для достижения главной цели «Базиса» — получения статуса национального чемпиона — нам нужно уже сейчас вкладывать значительные ресурсы в разработку полноценного отечественного SDN. Для этого нужна команда профессионалов, обладающая экспертизой в предметной области, и здесь нам повезло объединить наши усилия со специалистами Angie, у которых есть опыт создания мировых лидирующих решений. У такой именитой команды было множество предложений поучаствовать в перспективных проектах, в том числе международных, однако они выбрали «Базис» и ту амбициозную задачу, которая перед нами стоит», — говорит генеральный директор «Базис» Давид Мартиросов. «Разработка полноценного SDN-решения — сложный процесс, выполнение которого под силу лишь профессиональной команде инженеров, сетевых архитекторов и разработчиков. В Angie мы собрали именно такую команду, одну из сильнейших в мире. Качество нашей работы можно увидеть на примере открытого кода нашего веб-сервера, кроме того, нас высоко оценивают другие компании, с которыми мы работали. Сотрудничество с «Базис» обеспечит Angie необходимые ресурсы и обогатит экспертизой в сфере виртуализации, мы уже выстроили обмен опытом на уровне архитектуры решений», — прокомментировал генеральный директор Angie Заур Абасмирзоев.

29.10.2024 [20:28], Сергей Карасёв

Раскрыты подробности архитектуры ИИ-кластера xAI Colossus со 100 тыс. ускорителей NVIDIA H100Портал ServeTheHome рассказал подробности об архитектуре вычислительного кластера xAI Colossus, предназначенного для обучения крупных ИИ-моделей. Эта система использует 100 тыс. NVIDIA H100, а в дальнейшем количество ускорителей планируется увеличить вдвое. Это самый крупный из известных ИИ-кластеров на текущий момент. Оборудование для него поставили компании Dell и Supermicro. Стартап xAI, курируемый Илоном Маском (Elon Musk), объявил о запуске суперкомпьютера Colossus в начале сентября нынешнего года. Утверждается, что на создание системы потребовалось всего 122 дня. Причём с момента установки первой стойки с серверами до начала обучения ИИ-моделей прошло только 19 суток. Впрочем, как отмечают эксперты, поскольку машина является «однозадачной», т.е. в отличие от традиционных суперкомпьютеров предназначенной только для работы с ИИ, ускорить строительство было не так уж сложно, хотя результат всё равно впечатляющий. Как сообщается, в составе Colossus применены серверы на платформе NVIDIA HGX H100, оборудованные системой жидкостного охлаждения. Каждый узел Supermicro серии TNHR2-LCC типоразмера 4U содержит восемь ускорителей NVIDIA H100 и два CPU. Узел разделён на две половинки, одна с CPU и PCIe-коммутаторами и одна с HGX-платой, которые могут извлекаться независимо для простоты обслуживания. CPU, коммутаторы и ускорители охлаждаются посредством СЖО. Вентиляторы в шасси тоже есть. Воздух от них попадает на теплообменники на задней двери, которые уносят остаточное тепло. Холодных и горячих коридоров в ЦОД нет, воздух имеет одинаковую температуру во всём зале. В нижней части стоек располагается ещё один 4U-блок Supermicro для CDU с резервированием и поддержкой горячей заменой насосов. Каждый сервер имеет четыре блока питания с резервированием и возможностью горячей замены, которые подключены к трёхфазным PDU. Одна стойка объединяет восемь узлов NVIDIA HGX H100, между которыми располагаются коллекторы СЖО в формате 1U. Таким образом, каждая стойка насчитывает 64 экземпляра H100. Стойки организованы в группы по восемь штук, которые образуют малые кластеры из 512 ускорителей H100. Они в свою очередь объединены в т.н. «острова» по 25 тыс. ускорителей, каждому из которых полагается собственный машинный зал. Общее количество стоек в составе Colossus превышает 1500. Помимо узлов с ускорителями также есть CPU-узлы и узлы хранения All-Flash (1U). Как отмечает NVIDIA, в кластере Colossus задействована сетевая платформа Spectrum-X Ethernet. Применены коммутаторы Spectrum-X SN5600 и сетевые карты на базе чипа BlueField-3. Компания говорит об использовании трёхуровневой Ethernet-сети с 400GbE-подключением, но точная топология не указана. Судя по всему, выделенной сети для работы с хранилищем не предусмотрено. Каждом ускорителю полагается один 400GbE-адаптер SuperNIC, который и объединяет их в RDMA-сеть. Кроме того, у каждого GPU-узла есть ещё один 400GbE DPU, а также подключение к сервисной сети. Сетевые карты находятся в собственных лотках, благодаря чему их можно заменять без демонтажа шасси. По словам NVIDIA, уровень утилизации сети достигает 95 %. В качестве энергетического буфера между электросетью и суперкомпьютером используются аккумуляторные банки Tesla Megapack ёмкостью 3,9 МВт·ч каждый. Они необходимы для того, чтобы компенсировать всплески потребляемой мощности, когда нагрузка на ускорители резко возрастает в силу выполняемых ИИ-задач. Впрочем, вероятно, есть и ещё одна причина для такого решения — на первом этапе Colossus был лишён подключения к основной энергосети и в вопросе питания во многом полагался на генераторы. |

|