Материалы по тегу: ocp

|

03.03.2025 [15:23], Руслан Авдеев

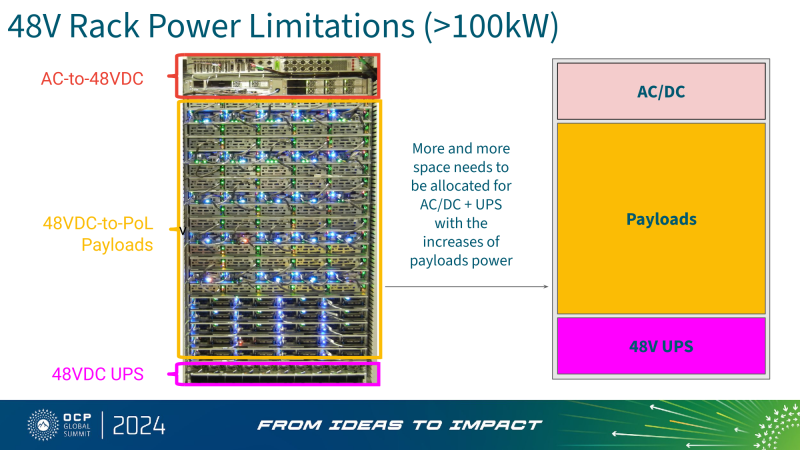

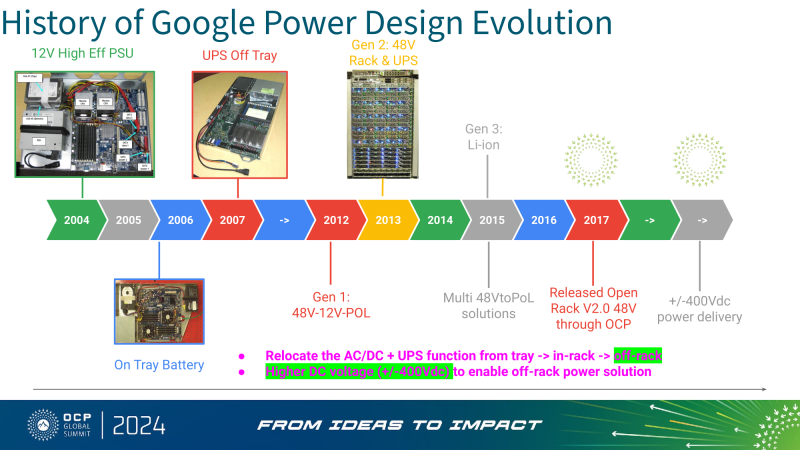

Google развернула уже 100 млн литий-ионных ячеек в своих ЦОДСистемы энергоснабжения дата-центров во многом зависят от аккумуляторов в составе ИБП. Участники рынка ЦОД активно инвестируют в создание аккумуляторных систем — не так давно число используемых Li-Ion элементов в дата-центрах Google по всему миру достигло 100 млн шт., сообщает пресс-служба компании. В Google используются системы электропитания с 48 В постоянного тока (48Vdc), причём ИБП интегрированы непосредственно в стойки. Такая распределённая архитектура обладает двумя ключевыми преимуществами: область возможного сбоя ИБП ограничивается одной стойкой; нет дополнительной точки отказа между ИБП и серверами. Такой подход снижает общую стоимость владения (TCO), поскольку ИБП масштабируется вместе с инфраструктурой, благодаря чему уменьшаются затраты на начальном этапе внедрения, говорит компания. Размещение батарей на DC-шине вместе с серверами исключает потери энергии, связанные с промежуточными преобразованиями переменного тока (AC) в постоянный (DC), положительно влияя на общую эффективность системы. В 2016 году Google открыла спецификации своей системы электропитания стоек, включая спецификации для литий-ионных BBU, в рамках Open Compute Project (OCP). Кроме того, Li-Ion аккумуляторы вдвое долговечнее и вдвое мощнее свинцово-кислотных элементов, применявшихся ранее. Таким образом, переход с одних на другие означает, что теперь можно использовать меньше батарей, что также положительно влияет на экологичность ЦОД, говорит Google. В Google отмечают, что развернуть 100 млн Li-Ion элементов можно только благодаря подходу «безопасность прежде всего», принятому в компании. Основным риском для такого типа элементов является возможность неуправляемого нагрева, т. н. «теплового разгона» в случае, если с ними некорректно обращаются, чрезмерно заряжают или не охлаждают должным образом. В результате могут случаться пожары, и хотя такое бывает редко, огонь очень трудно погасить из-за выделения большого количества тепла и риска «цепной реакции» воспламенения соседних элементов. Для использования большого «парка» АКБ в Google применяют метод тестирования UL9540A (стандарт, разработанный для оценки безопасности энергосистем, включая аккумуляторы) и проводит строгие испытания литий-ионных блоков BBU. В результате Google успешно получила от регуляторов разрешения на использование BBU даже в Азиатско-Тихоокеанском регионе, где действуют самые жёсткие правила. Сейчас в Google изучают возможность использования больших энергохранилищ (BESS). Безопасность аккумуляторов — не праздный вопрос. Пожары в дата-центрах вообще случаются не так уж редко, а во многих случаях причиной служат именно инциденты с аккумуляторами. За примерами не надо далеко ходить: один из крупнейших в мире сбоев ЦОД южнокорейской площадки Kakao произошёл именно из-за перегрева и возгорания литий-ионных аккумуляторов SK On, что привело к пожару. В сентябре 2024 года из-за возгорания Li-Ion элементов ИБП пострадал сингапурский ЦОД Digital Realty. В 2023 году эксперты Uptime Institute предупреждали о возможной опасности использования Li-Ion элементов в дата-центрах, поскольку они подвержены повышенному риску возгорания.

04.01.2025 [15:21], Руслан Авдеев

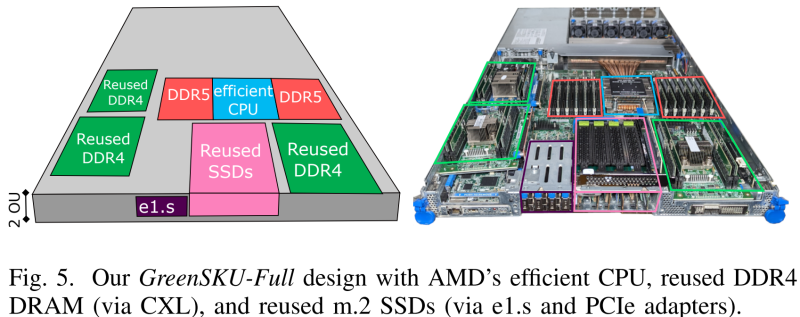

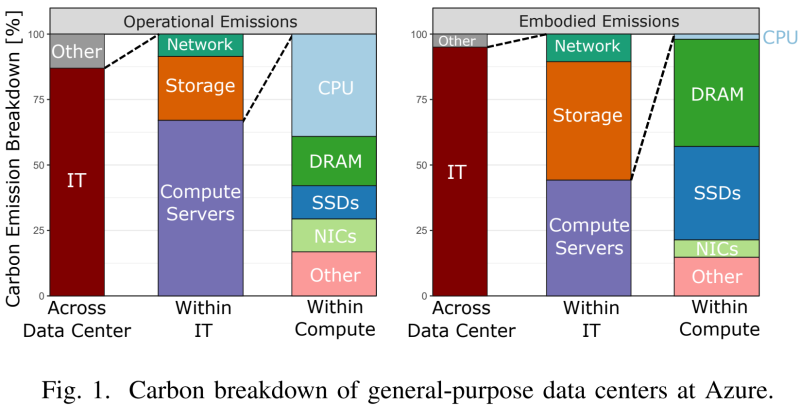

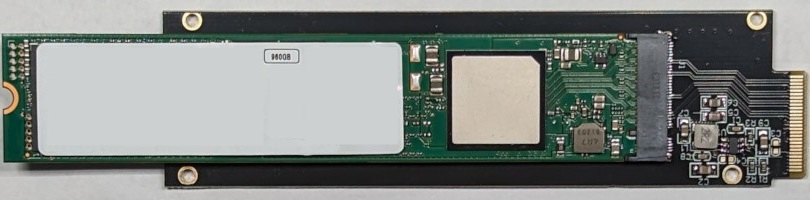

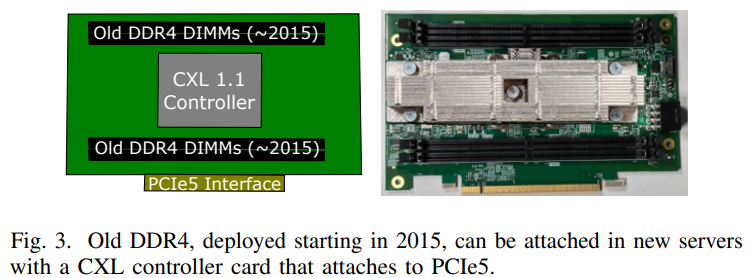

Microsoft совместно с учёными США разработала экологичные облачные серверы GreenSKU, которые используют RAM и SSD из старых системУчёные из Microsoft, Университета Карнеги-Меллона и Вашингтонского университета разработали новый стандарт экологичных серверов GreenSKU, которые позволят снизят углеродные выбросы ЦОД, сообщает IEEE Spectrum. Кроме того, была представлена модель GreenSKU Framework для расчёта целесообразности использования подобных систем в дата-центрах гиперскейлеров и подбора оптимальных конфигураций. Созданные в рамках концепции GreenSKU прототипы серверов были протестированы в ЦОД Azure.

Источник изображений: Microsoft Исследование, вышедшее минувшим летом, изучает возможность использования компонентов из списанных серверов. Это важно, поскольку сегодня во многих случаях при сбое одного компонента из эксплуатации выводится сервер целиком. Кроме того, Microsoft меняет серверы Azure каждые 3–5 лет для оптимизации производительности. И в этом случае работоспособные компоненты всё равно обычно не используются в других серверах. Согласно выкладкам исследователей, уровень сбоев оперативной памяти (AFR) после кратковременного всплеска вскоре после развёртывания остаётся примерно одинаковым на протяжении не менее семи лет. А износ SSD составляет около половины. Впрочем, в данном случае речь идёт об M.2-накопителях. Их надёжность и скорость работы можно повысить простым объединением в RAID-массив. А для их использования в современных платформах с E1.S-корзинами есть готовые пассивные адаптеры, благо стандарт PCIe обладает обратной совместимостью.  С памятью дело обстоит не так просто. Предыдущие поколения серверов использовали DDR4, тогда как актуальные платформы работают только с DDR5. Однако выход есть — в современных CPU появилась поддержка CXL. Точнее, CXL Type 3 (CXL.mem), что позволяет подключать по PCIe пулы DRAM. Они представлены в виде NUMA-узлов без CPU. Такое подключение памяти даёт большую задержку, но современные гипервизоры умеют работать с такими пулами, отправляя в них редко используемые массивы данных.  Старые процессоры переиспользовать не выйдет. Они гораздо менее энергоэффективны и производительны, при этом на CPU приходится основная часть энергопотребления и, соответственно, углеродных выбросов. Исследователи изучили актуальные предложения вендоров и пришли к выводу, что среди доступных на рынке процессоров наилучшим образом для GreenSKU подходят AMD EPYC Bergamo, которые предлагает большое количество ядер и потоков при сравнимом уровне TDP, пусть и при пониженной производительности каждого ядра, а также поддерживают необходимые протоколы CXL. Для распределения нагрузок используется отдельный программный слой, определяющий, какие задачи можно выполнять на серверах GreenSKU, а какие — на стандартных серверах Azure в зависимости от требований к производительности. Как отмечают исследователи, три четверти развёрнутых в Azure инстансов в среднем используют лишь 25 % выделенных ресурсов CPU и около 15 % от доступной пропускной способности памяти. Точно так же далеко не в полной мере используются и SSD. Вместе с тем есть клиенты, которые выживают максимум из каждого инстанcа. Снижение углеродных выбросов имеет большое значение для облачных вычислений, поскольку они могут составить 20 % всех выбросов к 2030 году — об этом свидетельствуют данные НКО Ассоциация вычислительной техники. В пересчёте на ядро выбросы серверов GreenSKU на 28 % ниже, чем выбросы обычных серверов Azure. А на уровне ЦОД с учётом всех накладных расходов снижение выбросов составляет 8 %.

06.12.2024 [12:03], Сергей Карасёв

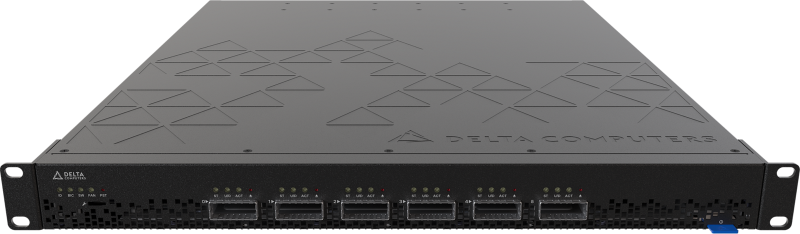

Delta Computers представила СХД Delta Marlin с поддержкой 36 NVMe SSD с интерфейсом PCIe 5.0Компания Delta Computers, российский производитель IT-оборудования и поставщик ПО, анонсировала СХД Delta Marlin, рассчитанную на работу с накопителями U.2 NVMe, оснащёнными интерфейсом PCIe 5.0. Кроме того, представлена платформа хранения Delta Guepard с гибкими вариантами конфигурации. Решение Delta Marlin — система высокой плотности, которая может использоваться как для расширения дискового пространства сервера, так и в составе высокоскоростных программного-определяемых СХД. Возможна организация двухконтроллерного сценария благодаря dual-port режиму SSD. Система в зависимости от варианта исполнения допускает установку 18 накопителей SFF толщиной 7мм или девяти SSD толщиной 15 мм. Кроме того, возможно подключение до 36 накопителей в 2OU-модуле. Предусмотрены два слота расширения для карт PCIe 5.0 х16 HHHL. Применяется встроенное ПО Delta BMC. Питание осуществляется от общей DC-шины OCP на 12 В. В системе охлаждения задействованы шесть вентиляторов с резервированием по схеме N+1. В свою очередь, Delta Guepard — это семейство СХД, оптимизированных для высокопроизводительных приложений, требующих низкой задержки ввода-вывода и высокой пропускной способности. Устройства основаны на модульной архитектуре. Модификации Delta Guepard Gen 1 в форм-факторах 4U и 6U/8U рассчитаны соответственно на 30 и 60 накопителей SFF/LFF SATA HDD или U.2 (7–15 мм) NVMe SSD. Максимальная суммарная вместимость — 720 (30 накопителей) и 1440 (60 накопителей) Тбайт. Варианты Delta Guepard Gen 2 в исполнениях 4U и 6U/8U допускают установку до 36 и 72 накопителей U.2 NVMe, а общая вместимость составляет до 276 и 552 Тбайт. Все устройства Delta Guepard наделены двумя контроллерами. Возможно формирование массивов RAID 0/1/5/6/10/50/60/70. Поддерживаются протоколы SMB v2/v3, NFS v3/v4, AFP, FTP, а также Fibre Channel; iSCSI; InfiniBand (FDR, QDR, DDR, EDR). Питание осуществляется от централизованного шинопровода OCP на 12 В. В продажу решения поступят в I квартале 2025 года.

03.12.2024 [17:58], Сергей Карасёв

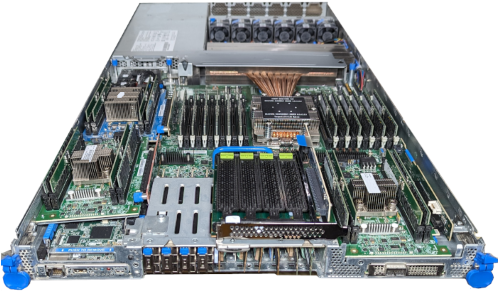

Delta Computers представила первый в России модульный восьмипроцессорный сервер Delta SpiderРоссийская компания Delta Computers анонсировала систему Delta Spider. Это, как утверждается, первый в РФ модульный восьмипроцессорный сервер на аппаратной платформе Intel Xeon Sapphire Rapids. В составе Delta Spider применяются чипы с 60 ядрами, значение TDP которых может достигать 385 Вт. Возможны конфигурации с двумя, четырьмя и восемью процессорами, что в сумме даёт до 480 ядер. Процессоры объединены шиной UPI. Поддерживается память DDR5-4400/4800, объём которой в максимальной конфигурации составляет 32 Тбайт (128 × 256 Гбайт). Доступны базовые варианты Spider L и Spider XL в формате 7OU и 13OU соответственно. Допускается установка соответственно 16 и 32 SSD типоразмера SFF (U.2; NVMe) толщиной 7 мм или 8 и 16 SSD толщиной 15 мм. В модуле управления предусмотрены ещё два посадочных места для SSD (U.2; NVMe) толщиной 7 мм. Версия Spider L располагает 12 слотами для карт PCIe 5.0 х16 HHHL, модификация Spider XL — 24 слотами. Серверы оборудованы гибридной системой охлаждения (вода+воздух) Delta Hybrid Cooling с возможность горячей замены вентиляторов, которая позволяет процессорам постоянно работать в Boost-режиме. Питание осуществляется от централизованного шинопровода OCP (12 В). Модуль управления наделён двумя портами USB 3.0, разъёмом 1GbE RJ-45, интерфейсами D-Sub и Mini-DP, а также сервисным портом USB Type-C. Применяется разработанное в России микропрограммное обеспечение Delta BIOS и Delta BMC. По заявлениям Delta Computers, платформа Delta Spider подходит для высоконагруженных приложений, таких как системы управления предприятием (ERP и CRM), автоматизированные банковские системы (ABS), аналитические сервисы принятия решений реального времени, биллинговые и платежные системы, а также иных in-memory приложений.

03.12.2024 [11:01], Сергей Карасёв

Delta Computers представила российские 400G-коммутатор Delta Dragonfly и PCIe-коммутатор Delta FirebirdРоссийский производитель IT-оборудования Delta Computers анонсировал Ethernet-коммутатор Delta Dragonfly типа Bare Metal, предназначенный для развёртывания высокоскоростных инфраструктур уровня ядра сети, а также уровней агрегации и доступа в средних и крупных компаниях. Решение выполнено в форм-факторе 1U с габаритами 630 × 439 × 43 мм. Задействованы ASIC Broadcom Tomahawk 3 (коммутационная ёмкость — 12,8 Тбит/с), а также процессор Intel Xeon Emerald Rapids. Предусмотрены четыре слота для модулей оперативной памяти DDR5-5600. Для Delta Dragonfly доступны модификации DN5032, DN4032, DN3032, DN4424, а также DN3424 с поддержкой соответственно 32 портов QSFP-DD 400 Гбит/с, 32 портов QSFP-56 200 Гбит/с, 32 портов QSFP-28 100 Гбит/с, 24 портов QSFP-56 200 Гбит/с и четырёх портов QSFP-DD 400 Гбит/с, а также 24 портов QSFP-28 100 Гбит/с и четырёх портов QSFP-DD 400 Гбит/с. Все варианты располагают двумя разъёмами SFP+ 10 Гбит/с. Коммутаторы могут получать питание от двух блоков CRPS, общей DC-шины OCP (12 В) или от сети 48–60 В телеком-стандарта (Telco Rack). В системе охлаждения задействованы пять вентиляторов. Применяется созданные в России прошивки Delta BIOS и Delta BMC. Утверждается, что Delta Dragonfly является оптимальным выбором для ЦОД, корпоративных сред и HPC-платформ. Кроме того, компания Delta Computers представила высокоскоростной PCIe-коммутатор Delta Firebird, обеспечивающий возможность объединения до шести устройств по интерфейсу PCIe 5.0 x16 в кластер. Горизонтальная масштабируемость на базе PCIe 5.0 позволяет создавать разнообразные конфигурации кластеров высоконагруженных систем. Изделие выполнено в формате 1U с размерами 481 × 629 × 43 мм. Возможно питание от двух блоков CRPS или от централизованного шинопровода OCP на 12 В. Применено встроенное ПО Delta BMC. Оба коммутатора могут быть использованы в стандартных 19″ серверных стойках и в OCP-шасси формата 21″.

23.11.2024 [15:57], Сергей Карасёв

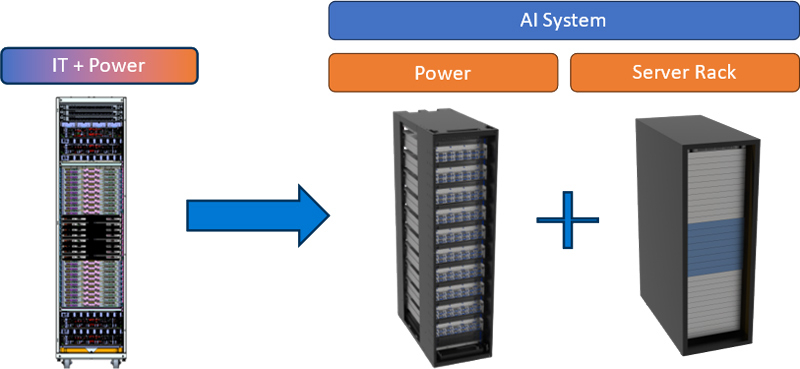

Microsoft и Meta✴ представили дизайн ИИ-стойки с раздельными шкафами для питания и IT-оборудованияКорпорация Microsoft в сотрудничестве с Meta✴ представила дизайн серверной стойки нового поколения для дата-центров, ориентированных на задачи ИИ. Спецификации системы, получившей название Mt. Diablo, предоставляются участникам проекта Open Compute Project (OCP). Отмечается, что инфраструктура ЦОД постоянно эволюционирует, а наиболее значительное влияние на неё оказывает стремительное внедрение ИИ. Тогда как традиционные стойки с вычислительным оборудованием и средствами хранения данных имеют мощность максимум до 20 кВт, при размещении современных ИИ-ускорителей этот показатель исчисляется сотнями киловатт. В результате при развёртывании дата-центров могут возникать различные сложности. Идея Mt. Diablo заключается в разделении стойки на независимые шкафы для компонентов подсистемы питания и вычислительного оборудования. То есть, речь идёт о дезагрегированной архитектуре, позволяющей гибко регулировать мощность в соответствии с меняющимися требованиями.

Источник изображения: Microsoft Одним из ключевых преимуществ нового подхода является оптимизация пространства. Утверждается, что в каждой серверной стойке можно размещать на 35 % больше ИИ-ускорителей по сравнению с традиционным дизайном. Ещё одним достоинством названа масштабируемость: конфигурацию стойки питания можно изменять в соответствии с растущими потребностями. Плюс к этому модульная конструкция позволяет реализовывать несколько проектов одновременно. Отмечается, что в современных OCP-системах уже используется единая шина питания постоянного тока с напряжением 48 В. В случае с новым дизайном возможен переход на архитектуру 400 В DC. Это открывает путь для создания более мощных и эффективных систем ИИ. Однако для внедрения стандарта 400 В потребуется общеотраслевая стандартизация. В индивидуальных проектах — например, суперкомпьютерах — для питания узлов уже используется шина HVDC.

21.10.2024 [19:23], Руслан Авдеев

От накопителей к ускорителям: Google тестирует роботов для обслуживания ЦОДВ Google занялись испытаниями роботов для управления и обслуживания оборудования в своих дата-центрах. Как сообщает Datacenter Dynamics со ссылкой на Рика Миллера (Rich Miller) из Data Center Frontier, соответствующую информацию представитель Google обнародовал в ходе недавнего мероприятия Open Compute Summit — роботы уже действуют на одном из объектов. В Google заявили, что роботы помогут кардинально пересмотреть подход к масштабированию операций, а их внедрение благотворно скажется на безопасности и надёжности работ. Робототехника может сыграть важную роль в задачах вроде перемещения компонентов и стоек, мониторинга оборудования и даже его обслуживания и ремонта. В прошлом году компания начала эксперименты по использованию роботов для замены вышедших из строя накопителей. А сейчас компания намерена привлечь роботов к обслуживанию стоек с ускорителями, которые значительно тяжелее традиционных стоек. Использование роботов для обеспечения работы ЦОД давно рассматривается гиперскейлерами и колокейшн-провайдерами. Впрочем, в большинстве случаев речь идёт о робособаках вроде моделей, выпускаемых Boston Dynamics, Unitree Go1 и Anybotics. Такие модели обычно выполняют в основном патрульные функции — для охраны и оповещения об инцидентах. Пока что Google использует довольно массивную, автономно передвигающуюся платформу собственной разработки. В 2023 году Microsoft создала команду, занимающуюся автоматизацией работы ЦОД вообще и роботами в частности. В том же году Digital Edge, Digital Realty, Scala Data Centers, и Oracle протестировали роботов для выполнения самых разных операций в дата-центрах. А вот у японской NTT Data подход иной — компания создала робота Ugo на моторизованной платформе, который получил две роборуки-манипулятора.

20.10.2024 [11:01], Сергей Карасёв

NVIDIA передаст OCP спецификации компонентов суперускорителя GB200 NVL72Некоммерческая организация Open Compute Project Foundation (OCP), специализирующаяся на создании открытых спецификаций оборудования для ЦОД, сообщила о том, что для её инициативы Open Systems for AI собственные разработки предоставят NVIDIA и Meta✴. Проект Open Systems for AI был анонсирован в январе 2024 года при участии Intel, Microsoft, Google, Meta✴, NVIDIA, AMD, Arm, Ampere, Samsung, Seagate, SuperMicro, Dell и Broadcom. Цель инициативы заключается в разработке открытых стандартов для кластеров ИИ и дата-центров, в которых размещаются такие системы. Предполагается, что Open Systems for AI поможет повысить эффективность и устойчивость ИИ-платформ, а также обеспечит возможность формирования цепочек поставок оборудования от нескольких производителей. В рамках инициативы NVIDIA предоставит OCP спецификации элементы электромеханической конструкции суперускорителей GB200 NVL72, включая архитектуры стойки и жидкостного охлаждения, механические части вычислительного и коммутационного лотков. Кроме того, NVIDIA расширит поддержку стандартов OCP в своей сетевой инфраструктуре Spectrum-X. Речь идёт об обеспечении совместимости со стандартами OCP Switch Abstraction Interface (SAI) и Software for Open Networking in the Cloud (SONiC). Это позволит клиентам использовать адаптивную маршрутизацию Spectrum-X и управление перегрузками на основе телеметрии для повышения производительности Ethernet-соединений в составе масштабируемой инфраструктуры ИИ. Адаптеры ConnectX-8 SuperNIC с поддержкой OCP 3.0 появятся в 2025 году. В свою очередь, Meta✴ передаст проекту Open Systems for AI свою архитектуру Catalina AI Rack, которая специально предназначена для создания ИИ-систем высокой плотности с поддержкой GB200. Это, как ожидается, позволит организации OCP «внедрять инновации, необходимые для создания более устойчивой экосистемы ИИ».

18.10.2024 [00:10], Алексей Степин

Meta✴ представила свой вариант суперускорителя NVIDIA GB200 NVL72Meta✴ поделилась своими новинками в области аппаратной инфраструктуры и рассказала, каким именно видит будущее открытых ИИ-платформ. В своей презентации Meta✴ рассказала о новой ИИ-платформе, новых дизайнах стоек, включая варианты с повышенной мощностью питания, а также о новинках в области сетевой инфраструктуры.

Источник изображений: Meta✴ В настоящее время компания использует нейросеть Llama 3.1 405B. Контекстное окно у этой LLM достигает 128 тыс. токенов, всего же токенов свыше 15 трлн. Чтобы обучать такие модели, требуются очень серьёзные ресурсы и глубокая оптимизация всего программно-аппаратного стека. В обучении базовой модели Llama 3.1 405B участвовал кластер 16 тыс. ускорителей NVIDIA H100, один из первых такого масштаба. Но уже сейчас для обучения ИИ-моделей Meta✴ использует два кластера, каждый с 24 тыс. ускорителей. Проекты такого масштаба зависят не только от ускорителей. На передний план выходят проблемы питания, охлаждения и, главное, интерконнекта. В течение нескольких следующих лет Meta✴ ожидает скоростей в районе 1 Тбайт/с на каждый ускоритель. Всё это потребует новой, ещё более плотной архитектуры, которая, как считает Meta✴, должна базироваться на открытых аппаратных стандартах. Одной из новинок стала платформа Catalina. Это Orv3-стойка, сердцем которой являются гибридные процессоры NVIDIA GB200. Стойка относится к классу HPR (High Power Rack) и рассчитана на 140 КВт. Сейчас Microsoft и Meta✴ ведут работы над модульной и масштабируемой системой питания Mount Diablo. Свой вариант GB200 NVL72 у Microsoft тоже есть. Также Meta✴ обновила ИИ-серверы Grand Teton, впервые представленные в 2022 году. Это по-прежнему монолитные системы, но теперь они поддерживают не только ускорители NVIDIA, но и AMD Instinct MI300X и будущие MI325X.  Интерконнектом будущих платформ станет сеть DSF (Disaggregated Scheduled Fabric). Благодаря переходу на открытые стандарты компания планирует избежать ограничений, связанных с масштабированием, зависимостью от вендоров аппаратных компонентов и плотностью подсистем питания. В основе DSF лежит стандарт OCP-SAI и ОС Meta✴ FBOSS для коммутаторов. Аппаратная часть базируется на стандартном интерфейсе Ethernet/RoCE. Meta✴ уже разработала и воплотила в металл новые коммутаторы класса 51Т на базе кремния Broadcom и Cisco, а также сетевые адаптеры FBNIC, созданные при поддержке Marvell. FBNIC может иметь до четырёх 100GbE-портов. Используется интерфейс PCIe 5.0, причём могущий работать как четыре отдельных слайса. Новинка соответствует открытому стандарту OCP NIC 3.0 v1.2.0.

17.10.2024 [12:20], Сергей Карасёв

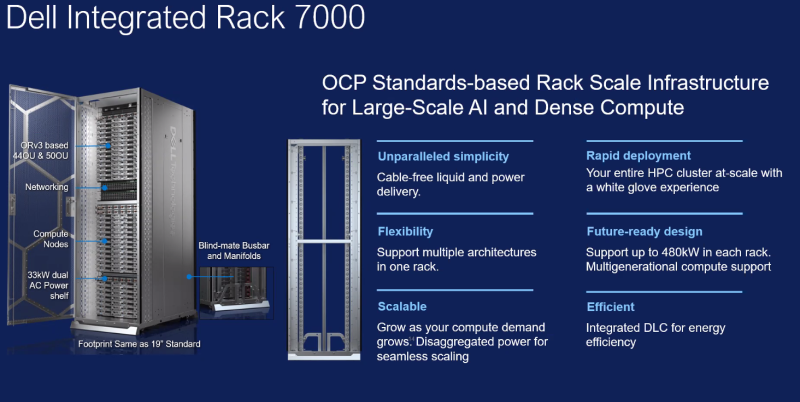

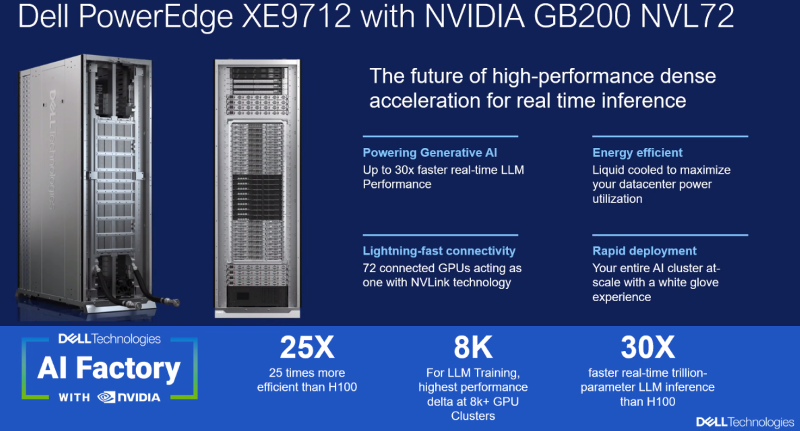

Dell представила решения AI Factory на базе NVIDIA GB200 и AMD EPYC TurinКомпания Dell Technologies анонсировала интегрированные стоечные масштабируемые системы для экосистемы AI Factory, рассчитанные на задачи НРС и ресурсоёмкие приложения ИИ. В частности, дебютировали решения Integrated Rack 7000 (IR7000), PowerEdge M7725 и PowerEdge XE9712.

Источник изображений: Dell IR7000 — это высокоплотная 21″ стойка Open Rack Version 3 (Orv3) с поддержкой жидкостного охлаждения. Говорится о совместимости с мощными CPU и GPU с высоким значением TDP. Модификации 44OU и 50OU оснащены салазками, которые шире и выше традиционных: это гарантирует совместимость с несколькими поколениями архитектур процессоров и ИИ-ускорителей. Полки питания в настоящее время поддерживают мощность от 33 кВт до 264 кВт на стойку с последующим увеличением до 480 кВт. Система Dell PowerEdge M7725 специально спроектирована для вычислений высокой плотности. В основу положены процессоры AMD серии EPYC 9005 (Turin), насчитывающие до 192 вычислительных ядер. Одна стойка IR7000 может вместить 72 серверных узла M7725, каждый из которых оборудован двумя CPU. Таким образом, общее количество вычислительных ядер превышает 27 тыс. на стойку. Возможно развёртывание прямого жидкостного охлаждения (DLC) и воздушного охлаждения. Доступны два IO-слота (PCIe 5.0 x16) в расчёте на узел с поддержкой Ethernet и InfiniBand.  В свою очередь, система Dell PowerEdge XE9712 разработана для обучения больших языковых моделей (LLM) и инференса в реальном времени. Эта новинка использует архитектуру суперускорителя NVIDIA GB200 NVL72. В общей сложности задействованы 72 чипа B200 и 36 процессоров Grace. Утверждается, что такая конфигурация обеспечивает скорость инференса до 30 раз выше по сравнению с системами предыдущего поколения. |

|