Материалы по тегу: i

|

09.11.2024 [22:23], Сергей Карасёв

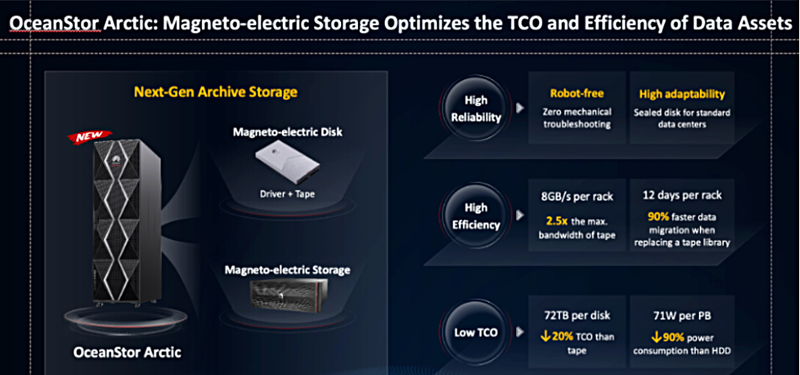

Huawei скрестила SSD с лентой в MED-накопителе: из-за санкций компания больше не может полагаться на поставки HDDHuawei, по сообщению Blocks&Files, разрабатывает технологию хранения больших объёмов данных на основе так называемых магнитоэлектрических дисков (MED). Фактически речь идёт о совмещении SSD и ленточных накопителей в одном корпусе, что позволит объединить преимущества «горячего» и «холодного» хранения. Необходимость создания СХД нового типа обусловлена жёсткими санкциями со стороны США — Huawei опасается возможных перебоев с закупками традиционных HDD. Концепция MED заключается в объединении в одном герметичном корпусе носителей разных типов. Это твердотельный накопитель на основе флеш-памяти NAND и ленточная система, включающая привод, катушки с лентой и головки чтения-записи. Таким образом, для работы с «горячими» данными может использоваться SSD, обеспечивающий низкие задержки и высокие скорости чтения/записи, а с «холодными» — ленточный модуль. Длина ленты приблизительно вдвое меньше, чем в LTO-картриджах, т.е. около 480 м вместо 960 м. Конструктивно MED напоминает кассету для магнитофона и содержит две катушки для ленты, электромотор и головки. MED имеет блочный интерфейс и два слоя трансляции. При записи информация попадает сначала на SSD, а после переупорядочивания последовательно записывается на ленту. При чтении накопитель, опираясь на метаданные во флеш-памяти, считывает данные либо с SSD («тёплые»), либо с ленты («холодные»). В последнем случае задержка доступа может составлять до двух минут.

Источник изображения: Blocks & Files В составе платформы MED не используются технологии ленточных накопителей IBM, Fujifilm или Sony. Вместо этого Huawei разработала необходимые компоненты совместно с китайскими партнёрами, а чипы NAND и так производятся в КНР. Это обеспечивает независимость от зарубежных изделий, которые могут подпасть под санкции. Шасси MED не нуждается в роботизированных манипуляторах и обеспечивает высокую плотность размещения накопителей. MED первого поколения вмещает 72 Тбайт информации, потребляя при этом всего 10 % электроэнергии, необходимой обычному жёсткому диску. Совокупная стоимость владения (TCO) примерно на 20 % ниже по сравнению с другими ленточными системами эквивалентной ёмкости. Стойка MED первого поколения обеспечивает скорость передачи данных на уровне 8 Гбит/с, вмещает более 10 Пбайт информации и потребляет менее 2 кВт. Системам MED не грозит перегрев, поскольку они в основном рассчитаны на хранение архивных данных. На систему MED и её компоненты компанией Huawei получен ряд патентов. Решения первого поколения, как ожидается, выйдут в 2025 году. А на 2026–2027 гг. запланирован выпуск устройств второго поколения с отсеками формата 3,5″ (LFF). Нечто похожее предложила и Western Digital — компания запатентовала высокоинтегрированный LTO-картридж в корпусе HDD. Что касается дальнейших планов Huawei, то сейчас она разрабатывает собственные SSD вместимостью 60 Тбайт на основе флеш-памяти QLC NAND с SLC-кешированием.

09.11.2024 [20:20], Руслан Авдеев

Жители Мемфиса не рады развитию ИИ-суперкомпьютера xAI Coloussus Илона МаскаАктивисты из числа жителей американского Мемфиса раскритиковали оператора энергосети Tennessee Valley Authority (TVA) за предоставление стартапу xAI Илона Маска доступа к дополнительным 150 МВт для питания ИИ-суперкомпьютера Colossus, сообщает Datacenter Dynamics. В минувший четверг TVA одобрил запрос от энергокомпании Memphis Light, Gas and Water (MLGW). Colossus предназначен для обучения и обслуживания ИИ-бота Grok, заработавшего ранее в этом году. Суперкомпьютер разместился в помещениях бывшего завода Electrolux в промышленном парке на юго-востоке Мемфиса. Ранее Маск заявлял, что речь идёт о самом быстром в мире ИИ-суперкомпьютере, включающем 100 тыс. ускорителей NVIDIA H100. Правда, буквально через несколько дней Meta✴ похвасталась ещё более крупной системой для обучения Llama-4. Но и Маск обещал в ближайшие месяцы удвоить мощность суперкомпьютера, который получит 50 тыс. ускорителей NVIDIA H200. Всё это означает, что машине потребуется много энергии. Ранее в этом году MLGW согласилась обеспечить xAI ещё 150 МВт, ожидалось лишь одобрение TVA. Комплекс даже пришлось запитать от мобильных газовых генераторов Voltagrid, что само по себе вызвало недовольство местных жителей. xAI со своей стороны пообещала построить крупнейшую в мире систему очистки сточных вод с керамическим мембранами, а также с дисконтом предоставлять ресурсы энергохранилища Tesla Megapack, построенного рядом с Colossus, для поддержки стабильности энергосети Мемфиса. Новость не вызывала энтузиазма у местных активистов и экозащитников, обеспокоенных вероятной нагрузкой на энергосети города и низким качеством воздуха. Активисты также подчёркивают, что оператор TVA обязан служить интересам общества и изучить последствия выделения xAI дополнительных 150 МВт, поскольку регион и так страдает от высоких нагрузок на сети и загрязнения окружающей среды. Дело, в частности, в том, что TVA намерена построить турбины на природном газе для получения ещё 200 МВт, поскольку оператор ещё прошлой осенью не справлялся со спросом. В TVA заявляют, что задача оператора — работать с партнёрами для привлечения в регион инвестиций и рабочих мест, в каждом случае аккуратно оцениваются детали каждого предложения. MLGW получит из бюджета $760 тыс. для введения в строй ещё 50 МВт, а xAI обязуется построить за $24 млн собственную подстанцию на 150 МВт. Существующие договорённости предусматривают, что xAI будет получать ежемесячные скидки от поставщика энергии, пока не компенсирует стоимость возводимой ей подстанции и та не перейдёт в собственность MLGW.

07.11.2024 [20:37], Руслан Авдеев

5 ГВт и 2 млн ускорителей: опубликованы детали проекта километровых ИИ ЦОД OpenAIВ сентябре 2024 года глава OpenAI Сэм Альтман (Sam Altman) обратился к американским властям с инициативой, предполагавшей строительство в стране целой сети 5-ГВт ЦОД. Альтман утверждал, что это поможет США сохранить первенство в сфере ИИ в мировом масштабе и является вопросом национальной безопасности. Datacenter Dynamics удалось получить доклад OpenAI, адресованный Национальному управлению по телекоммуникациям и информации (NTIA), где раскрыты некоторые детали амбициозного плана компании. Согласно расчётам OpenAI, ЦОД ёмкостью 5 ГВт будут занимать площадь около 2,78 км2 (278 га) и использовать до 2 млн ускорителей. Проект мог бы обеспечить США абсолютное мировое превосходство в сфере ИИ. Для сравнения, в 2023 году у AWS управляла ЦОД общей площадью 3,55 км2 (355 га, с учётом офисных помещений), а ёмкость ЦОД Microsoft в начале 2024 года составляла «всего» 5 ГВт, хотя компания до конца года рассчитывает освоить ещё 2,5 ГВт. Ряд компаний работают над гигаваттными ЦОД, но намерены построить их поэтапно в течение нескольких лет. В OpenAI утверждают, что 5-ГВт ЦОД обойдётся в $100 млрд (в ожидаемых ценах 2028 года), но при этом будет приносить по $40 млрд каждый год. На каждый 100 МВт ёмкости понадобится по 80 сотрудников, т.е. суммарно появится 4 тыс. постоянных рабочих мест. Для строительства дата-центров потребуется около 14 тыс. человек. Компания также привела расчёты прироста ВВП в отдельных штатах и локациях, где предполагается возведение новых ЦОД — от $16 до $20 млрд. В расчёт не принимались рабочие места и затраты на создание новой энергетической инфраструктуры и производство полупроводников. По оценкам OpenAI, глобальные фонды готовы инвестировать в инфраструктуру около $175 млрд. Компания грозит тем, что эти деньги могут быть потрачены не в США, а в недружественных странах. При этом в OpenAI подчёркивают, что развитие новых ИИ ЦОД будет иметь стратегическое значение с учётом того, что параллельно развиваются ИИ-платформы, например, в Китае. В компании отметили, что промедление грозит отставанием от КНР и других стран, не разделяющих ценности США и их союзников. Изначально компания планировала реализовать 5-ГВт проект Stargate совместно с Microsoft, крупнейшим спонсором и поставщиком ИИ-инфраструктуры для OpenAI. Однако в последнее время отношения между компаниями несколько охладели из-за конкуренции ИИ-подразделений и разногласиями, связанными со скоростью строительства ЦОД Microsoft. Попутно OpenAI добивается финансирования и правовой поддержки от властей США и проводит встречи с потенциальными инвесторами. Однако построить ЦОД мало, их ещё надо запитать. В некоторых штатах с большой концентрацией дата-центров ёмкость энергосетей придётся удвоить в ближайшие 10 лет. По оценкам, до 2030 года потребуется $50 млрд инвестиций в энергосистему. Предполагается, что к этом моменту энергосети Северной Америки вырастут приблизительно на 200 ГВт, а новые ИИ-проекты потребуется 100 ГВт. Однако из-за смены главы США даже текущие проекты по увеличению выработки и доставки энергии могут быть отменены, а Илон Маск (Elon Musk) и вовсе заявил, что намерен сократить расходы государства на $2 трлн.

30.10.2024 [11:49], Сергей Карасёв

OpenAI разрабатывает собственные ИИ-чипы совместно с Broadcom и TSMC, а пока задействует AMD Instinct MI300XКомпания OpenAI, по информации Reuters, разрабатывает собственные чипы для обработки ИИ-задач. Партнёром в рамках данного проекта выступает Broadcom, а организовать производство изделий планируется на мощностях TSMC ориентировочно в 2026 году. Слухи о том, что OpenAI обсуждает с Broadcom возможность создания собственного ИИ-ускорителя, появились минувшим летом. Тогда говорилось, что эта инициатива является частью более масштабной программы OpenAI по увеличению вычислительных мощностей компании для разработки ИИ, преодолению дефицита ускорителей и снижению зависимости от NVIDIA. Как теперь стало известно, OpenAI уже несколько месяцев работает с Broadcom над своим первым чипом ИИ, ориентированным на задачи инференса. Соответствующая команда разработчиков насчитывает около 20 человек, включая специалистов, которые ранее принимали участие в проектировании ускорителей TPU в Google, в том числе Томаса Норри (Thomas Norrie) и Ричарда Хо (Richard Ho). Подробности о проекте не раскрываются. Reuters, ссылаясь на собственные источники, также сообщает, что OpenAI в дополнение к ИИ-ускорителям NVIDIA намерена взять на вооружение решения AMD, что позволит диверсифицировать поставки оборудования. Речь идёт о применении изделий Instinct MI300X, ресурсы которых будут использоваться через облачную платформу Microsoft Azure. Это позволит увеличить вычислительные мощности: компания OpenAI только в 2024 году намерена потратить на обучение ИИ-моделей и задачи инференса около $7 млрд. Вместе с тем, как отмечается, OpenAI пока отказалась от амбициозных планов по созданию собственного производства ИИ-чипов. Связано это с большими финансовыми и временными затратами, необходимыми для строительства предприятий.

29.10.2024 [20:28], Сергей Карасёв

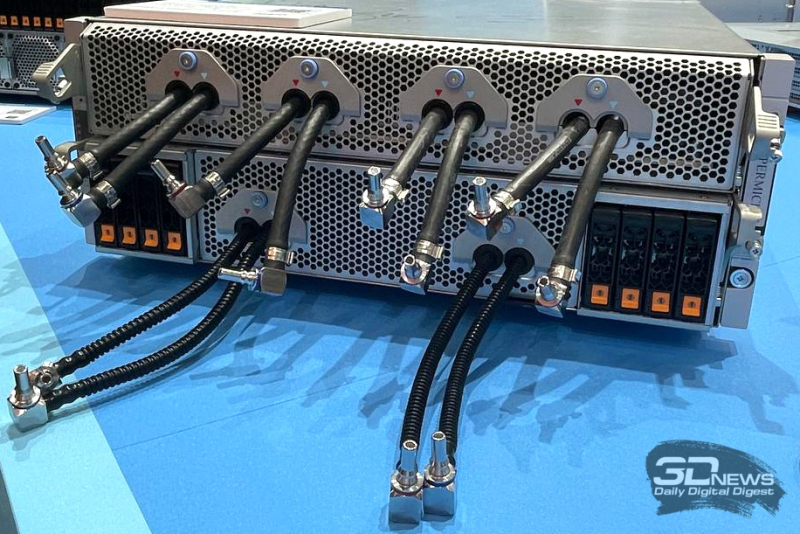

Раскрыты подробности архитектуры ИИ-кластера xAI Colossus со 100 тыс. ускорителей NVIDIA H100Портал ServeTheHome рассказал подробности об архитектуре вычислительного кластера xAI Colossus, предназначенного для обучения крупных ИИ-моделей. Эта система использует 100 тыс. NVIDIA H100, а в дальнейшем количество ускорителей планируется увеличить вдвое. Это самый крупный из известных ИИ-кластеров на текущий момент. Оборудование для него поставили компании Dell и Supermicro. Стартап xAI, курируемый Илоном Маском (Elon Musk), объявил о запуске суперкомпьютера Colossus в начале сентября нынешнего года. Утверждается, что на создание системы потребовалось всего 122 дня. Причём с момента установки первой стойки с серверами до начала обучения ИИ-моделей прошло только 19 суток. Впрочем, как отмечают эксперты, поскольку машина является «однозадачной», т.е. в отличие от традиционных суперкомпьютеров предназначенной только для работы с ИИ, ускорить строительство было не так уж сложно, хотя результат всё равно впечатляющий. Как сообщается, в составе Colossus применены серверы на платформе NVIDIA HGX H100, оборудованные системой жидкостного охлаждения. Каждый узел Supermicro серии TNHR2-LCC типоразмера 4U содержит восемь ускорителей NVIDIA H100 и два CPU. Узел разделён на две половинки, одна с CPU и PCIe-коммутаторами и одна с HGX-платой, которые могут извлекаться независимо для простоты обслуживания. CPU, коммутаторы и ускорители охлаждаются посредством СЖО. Вентиляторы в шасси тоже есть. Воздух от них попадает на теплообменники на задней двери, которые уносят остаточное тепло. Холодных и горячих коридоров в ЦОД нет, воздух имеет одинаковую температуру во всём зале. В нижней части стоек располагается ещё один 4U-блок Supermicro для CDU с резервированием и поддержкой горячей заменой насосов. Каждый сервер имеет четыре блока питания с резервированием и возможностью горячей замены, которые подключены к трёхфазным PDU. Одна стойка объединяет восемь узлов NVIDIA HGX H100, между которыми располагаются коллекторы СЖО в формате 1U. Таким образом, каждая стойка насчитывает 64 экземпляра H100. Стойки организованы в группы по восемь штук, которые образуют малые кластеры из 512 ускорителей H100. Они в свою очередь объединены в т.н. «острова» по 25 тыс. ускорителей, каждому из которых полагается собственный машинный зал. Общее количество стоек в составе Colossus превышает 1500. Помимо узлов с ускорителями также есть CPU-узлы и узлы хранения All-Flash (1U). Как отмечает NVIDIA, в кластере Colossus задействована сетевая платформа Spectrum-X Ethernet. Применены коммутаторы Spectrum-X SN5600 и сетевые карты на базе чипа BlueField-3. Компания говорит об использовании трёхуровневой Ethernet-сети с 400GbE-подключением, но точная топология не указана. Судя по всему, выделенной сети для работы с хранилищем не предусмотрено. Каждом ускорителю полагается один 400GbE-адаптер SuperNIC, который и объединяет их в RDMA-сеть. Кроме того, у каждого GPU-узла есть ещё один 400GbE DPU, а также подключение к сервисной сети. Сетевые карты находятся в собственных лотках, благодаря чему их можно заменять без демонтажа шасси. По словам NVIDIA, уровень утилизации сети достигает 95 %. В качестве энергетического буфера между электросетью и суперкомпьютером используются аккумуляторные банки Tesla Megapack ёмкостью 3,9 МВт·ч каждый. Они необходимы для того, чтобы компенсировать всплески потребляемой мощности, когда нагрузка на ускорители резко возрастает в силу выполняемых ИИ-задач. Впрочем, вероятно, есть и ещё одна причина для такого решения — на первом этапе Colossus был лишён подключения к основной энергосети и в вопросе питания во многом полагался на генераторы.

29.10.2024 [11:58], Сергей Карасёв

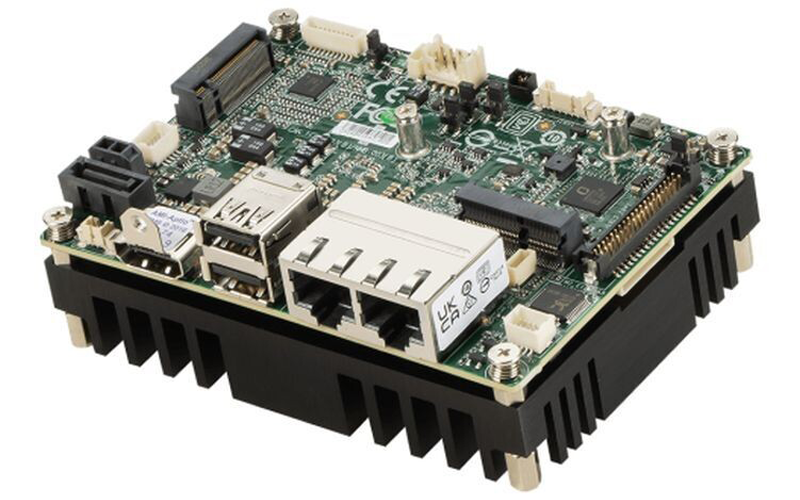

MSI выпустила одноплатный компьютер MS-CF16 формата Pico-ITX на базе Intel Amston LakeКомпания MSI расширила ассортимент одноплатных компьютеров, анонсировав модель MS-CF16 типоразмера Pico-ITX на аппаратной платформе Intel. Новинка предназначена для создания систем промышленной автоматизации, периферийных устройств, медицинского оборудования и пр. В зависимости от модификации изделие комплектуется процессором Alder Lake-N или Amston Lake. В частности, доступны варианты с чипом Intel Processor N97 (4C/4T; до 3,6 ГГц; 12 Вт), Atom x7425E (4C/4T; до 3,4 ГГц; 12 Вт) и Atom x7433RE (4С/4Т; до 3,4 ГГц; 9 Вт). Объём оперативной памяти LPDDR5-4800 может достигать 16 Гбайт. Одноплатный компьютер располагает одним портом SATA-3 для накопителя, разъёмом М.2 E-Key 2230 (PCIe x1 + USB 2.0) для адаптера Wi-Fi и коннектором М.2 B-Key 2242/3042 (PCIe x1/SATA 3.0 + USB 3.2 Gen 2 + USB 2.0). В оснащение входят сетевые контроллеры Realtek RTL8125BG-CG 2.5GbE и Realtek RTL8111K-CG 1GbE, звуковой кодек Realtek ALC897, IO-чип Fintek F81966AB-I и ТРМ-контроллер Infineon SLB 9672VU2.0.

Источник изображения: MSI Возможен вывод изображения одновременно на два дисплея через интерфейсы LVDS/eDP (1920 × 1200 пикселей, 60 Гц) и HDMI (3840 × 2160 точек, 30 Гц). Есть два порта USB 3.2 Type-A и два гнезда RJ45 для сетевых кабелей. Через разъёмы на плате можно задействовать два порта USB 2.0 и последовательный порт RS-232/422/485. Новинка оснащена системой пассивного охлаждения с крупным радиатором на тыльной стороне. Диапазон рабочих температур простирается от -10 до +60 °C у версий с процессором Alder Lake-N и от -40 до +70 °C у модели с чипом Amston Lake. Питание (12 В) подаётся через DC-разъём. Габариты составляют 101 × 73 мм. Заявлена совместимость с Windows 10 IoT Enterprise LTSC 2021, Windows 11 IoT Enterprise LTSC 22H2 и Linux.

24.10.2024 [12:40], Сергей Карасёв

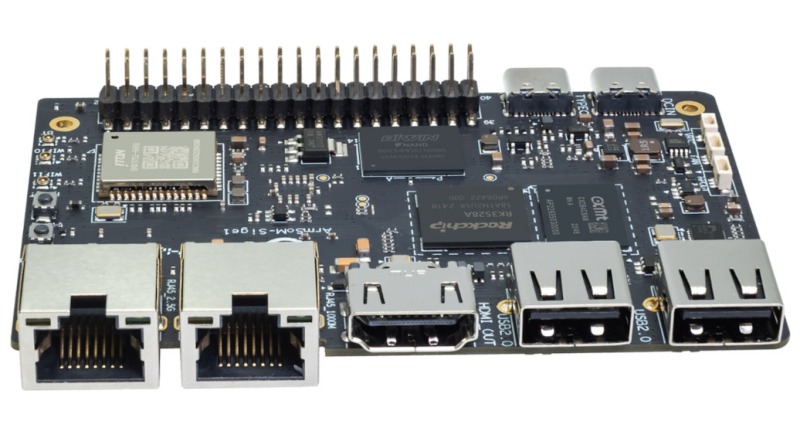

Одноплатный компьютер Banana Pi BPI-M1S получил поддержку HDMI 2.0, 2.5GbE и Wi-Fi 6В ассортименте Banana Pi появился одноплатный компьютер BPI-M1S, подходящий для построения различных терминалов, встраиваемых систем и пр. Изделие выполнено на аппаратной платформе Rockchip и совместимо с Debian11, а также с Android 13. Применён процессор RK3528. Этот чип содержит четыре ядра Arm Cortex-A53 с частотой до 2 ГГц и графический ускоритель Arm Mali-G450 GPU с поддержкой OpenGL ES1.1, ES2.0, OpenVG 1.1. Встроенный блок VPU обеспечивает возможность декодирования видеоматериалов H.264, H.265 и AVS2 в формате 4Kp60, а также кодирования H.264 и H.265 в формате 1080p60. Для вывода изображения служит интерфейс HDMI 2.0b. Одноплатный компьютер несёт на борту 4 Гбайт оперативной памяти LPDDR4x и флеш-модуль eMMC вместимостью 32 Гбайт. Дополнительно можно установить карту microSD. Изделие располагает сетевыми портами 1GbE и 2.5GbE с разъёмами RJ45 для подключения кабелей. На базе контроллера Realtek RTL8852BS реализована поддержка Wi-Fi 6 (802.11a/b/g/n/ac/ax) и Bluetooth 5.2. Новинка получила два порта USB 2.0 Type-A, один порт USB 2.0 OTG Type-C и дополнительный разъём USB Type-C для подачи питания (режимы 9 В/2 A, 12 В/2 A, 15 В/2 A). Есть 40-контактная колодка GPIO, совместимая с Raspberry Pi (UART, SPI, I2C, I2S, PWM, GND и пр.). При необходимости может быть подключён вентилятор охлаждения. Габариты Banana Pi BPI-M1S составляют 92 × 62 мм. Эксплуатироваться устройство может при температурах от 0 до +80 °C. Приобрести одноплатный компьютер можно по ориентировочной цене $53.

24.10.2024 [12:36], Сергей Карасёв

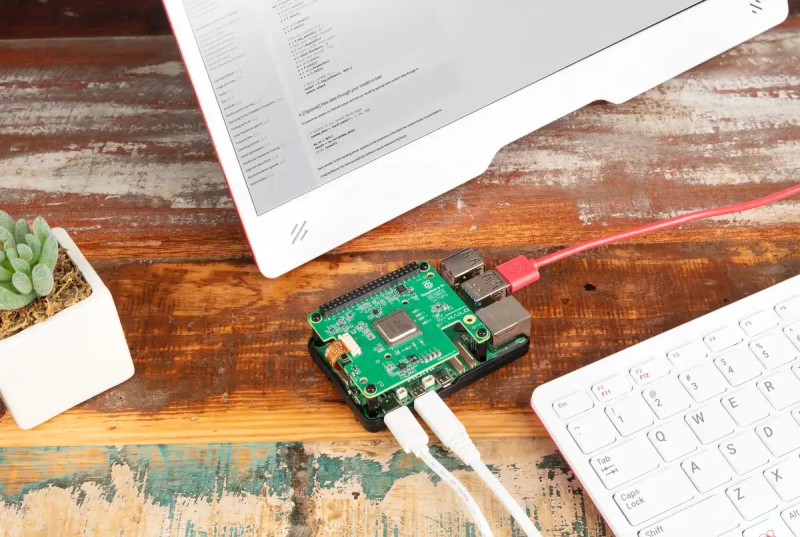

Raspberry Pi выпустила фирменные M.2 SSD и ИИ-модуль AI HAT+Компания Raspberry Pi представила под собственным брендом первые SSD и наборы SSD Kit для одноплатного компьютера Raspberry Pi 5. Дебютировали накопители в форм-факторе M.2 2230 вместимостью 256 и 512 Гбайт. На сайте Raspberry Pi говорится, что SSD используют интерфейс PCIe 3.0 (NVMe 1.4). Однако в описании самого мини-компьютера Raspberry Pi 5 упомянута только поддержка PCIe 2.0 x1 (для подключения периферии). Ресурс Tom's Hardware отмечает, что совместимость с PCIe 3.0 можно задать в настройках raspi-config, что позволит повысить скорость передачи данных. Для установки накопителей на Raspberry Pi 5 требуется модуль Raspberry Pi M.2 HAT+ (Hardware Attached on Top) с коннектором M.2: эта вспомогательная плата изначально включена в комплекты SSD Kit. В набор также входят соединительный шлейф и необходимый крепёж. В характеристиках SSD указан показатель IOPS (операций ввода-вывода в секунду) при работе с блоками данных по 4 Кбайт. У младшей версии он достигает 40 тыс. при произвольном чтении и 70 тыс. при произвольной записи, у старшей — 50 тыс. и 90 тыс. соответственно. Диапазон рабочих температур — от 0 до +70 °C. Стоимость накопителя на 256 Гбайт составляет $30, на 512 Гбайт — $45. Комплекты с модулем Raspberry Pi M.2 HAT+ обойдутся в $40 и $55. Приём заказов уже начался. Производиться новинки будут минимум до января 2032 года. Также компания представила обновлённый вариант ИИ-модуля для инференса — Raspberry Pi AI HAT+. От представленного ранее AI Kit новинка отличается тем, что теперь чип ускорителя интегрирован непосредственно на плату, а не подключается через M.2-коннектор. На выбор по-прежнему доступны чипы Hailo-8 (26 TOPS) и Hailo-8L (13 TOPS). Стоят модули с ними $110 и $70 соответственно. Диапазон рабочих температур — от 0 до +50 °C. Выпускаться модули будут минимум до января 2030 года.

24.10.2024 [12:15], Сергей Карасёв

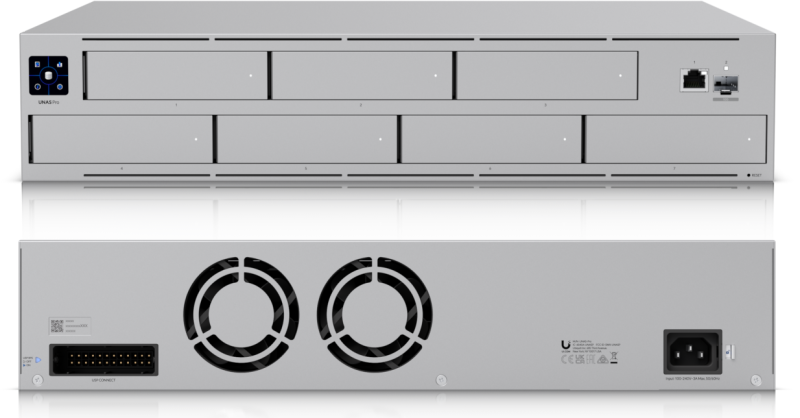

Ubiquiti представила сетевое хранилище UniFi UNAS Pro на семь LFF-накопителейКомпания Ubiquiti анонсировала сетевое хранилище UniFi UNAS Pro (UniFi UNAS Professional Rackmount NAS), ориентированное на корпоративных заказчиков. Устройство выполнено в форм-факторе 2U. В новинке применён неназванный процессор с четырьмя вычислительными ядрами Arm Cortex-A57, функционирующими на тактовой частоте 1,7 ГГц. Объём оперативной памяти DDR4 составляет 8 Гбайт. В оснащение также входят 32 Мбайт памяти SPI NOR и 8 Гбайт флеш-памяти. Во фронтальной части предусмотрены семь отсеков для HDD/SSD в форм-факторе LFF/SFF с интерфейсом SATA-3; допускается горячая замена. Имеется сенсорный дисплей с диагональю 1,3", который служит для управления и отображения информации о работе NAS. Предусмотрены по одному сетевому порту 1GbE RJ45 и 10GbE SFP+: разъёмы для подключения кабелей выведены на лицевую панель. Кроме того, есть контроллер Bluetooth 4.1. Габариты UniFi UNAS Pro составляют 442 × 325 × 87 мм, вес — 9,2 кг (без крепления для монтажа в стойку и накопителей). Диапазон рабочих температур простирается от -5 до +40 °C. В тыльной части расположены два вентилятора охлаждения. Максимальное энергопотребление заявлено на уровне 160 Вт, а энергобюджет для накопителей — 135 Вт. Устройство имеет встроенный блок питания (100–240 В AC или 11,5 В DC). Имеется порт резервного питания с поддержкой UniFi Power Backup, что делает хранилище устойчивым к перебоям в энергоснабжении. Приобрести новинку можно по ориентировочной цене $500.

18.10.2024 [10:51], Сергей Карасёв

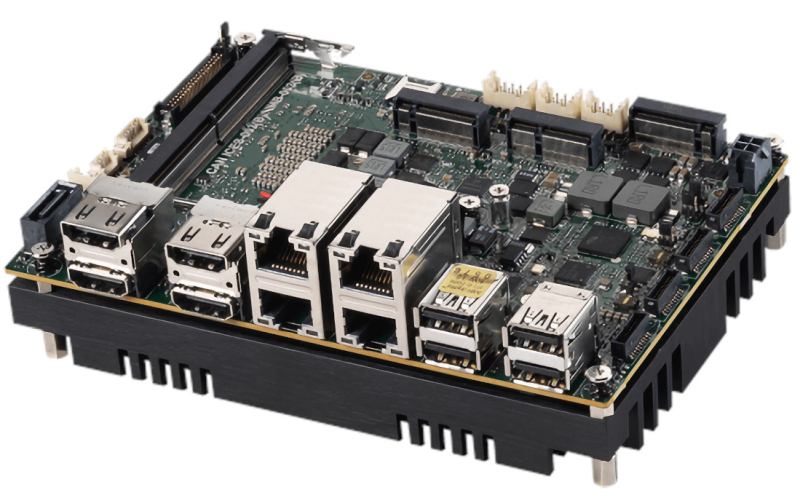

Одноплатный компьютер MSI MS-CF17 формата 3,5″ получил процессор Intel Raptor Lake-PКомпания MSI анонсировала одноплатный компьютер MS-CF17, предназначенный для широкого спектра промышленных приложений. На его основе могут создаваться системы автоматизации, edge-решения, платформы для транспортной отрасли, устройства визуализации и пр. Новинка выполнена в 3,5″ форм-факторе с габаритами 146 × 102 мм. Доступны встраиваемая и индустриальная модификации. В первом случае диапазон рабочих температур простирается от 0 до +60 °C, во втором — от -40 до +70 °C. Аппаратной основой служит платформа Intel Raptor Lake-P. Предлагаются варианты с различными процессорами, включая Core i7-1365UE (2P + 8E; 12 потоков; до 4,9 ГГц). Применена система пассивного охлаждения. В зависимости от модификации задействован графический ускоритель Intel Iris Xe или Intel UHD Graphics. Имеется один слот SO-DIMM для модуля LPDDR5-5200 ёмкостью до 32 Гбайт. Накопители могут быть подключены к порту SATA-3 и коннектору M.2 M-Key 2280 (для NVMe SSD с интерфейсом PCIe 4.0 x4). В оснащение входят четырёхпортовый 2.5GbE-контроллер Intel I226-LM, звуковой кодек Realtek ALC897 HD, IO-чип Fintek F81966AB-I и ТРМ-контроллер Infineon SLB9672VU2.0. Упомянуты также коннектор M.2 B-key 2242/3042 (PCIe x1, USB 2.0, слот для карты nanoSIM) для сотового модема и разъём M.2 E-key 2230 (PCIe x1, USB 2.0) для адаптера Wi-Fi/Bluetooth. Компьютер располагает четырьмя портами USB 3.2 Gen2, четырьмя коннекторами HDMI 2.0 (до 4Kp60), интерфейсом eDP/LVDS. Через разъёмы на плате можно задействовать четыре последовательных порта и четыре порта USB 2.0. Питание в диапазоне 12–24 В подаётся через DC-разъём. Заявлена совместимость с Windows 10 IoT Enterprise 2021 LTSC, Windows 11 IoT Enterprise и Linux. |

|