Материалы по тегу: hardware

|

13.07.2025 [10:57], Сергей Карасёв

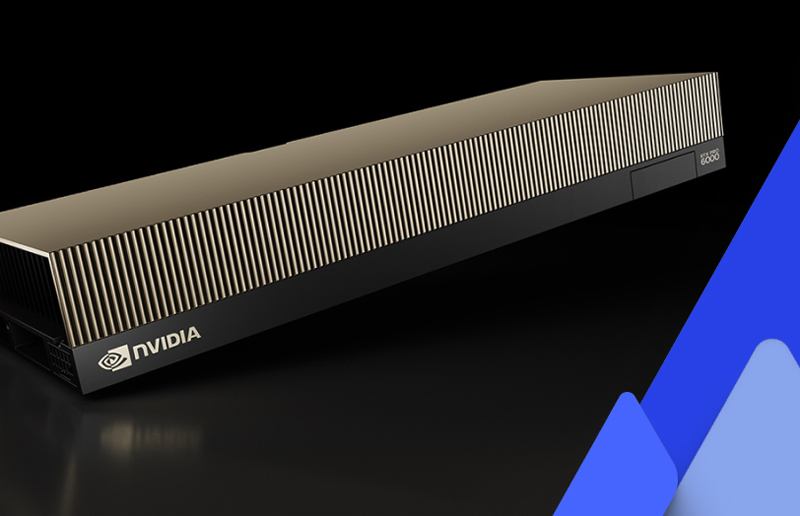

CoreWeave запустила первые общедоступные инстансы на базе NVIDIA RTX Pro 6000 Blackwell Server EditionОператор ИИ-облака CoreWeave объявил о запуске инстансов с ускорителями NVIDIA RTX Pro 6000 Blackwell Server Edition для генеративных приложений, рендеринга в реальном времени и работы с большими языковыми моделями (LLM). Утверждается, что это первые общедоступные облачные экземпляры, построенные на базе названных GPU. Изделия RTX Pro 6000 Blackwell Server Edition на архитектуре Blackwell насчитывают 24 064 ядра CUDA, 752 тензорных ядра пятого поколения и 188 ядер RT четвёртого поколения. В оснащение входят 96 Гбайт памяти GDDR7 с пропускной способностью до 1,6 Тбайт/с. CoreWeave заявляет, что по сравнению с инстансами на основе NVIDIA L40S новые экземпляры обеспечивают 5,6-кратное повышение производительности при LLM-инференсе, 3,5-кратное увеличение быстродействия на операциях преобразования текста в видео и более чем 2-кратное повышение скорости тонкой настройки ИИ-моделей. Заявленная ИИ-производительность в режиме FP4 достигает 3,8 Пфлопс.

Источник изображения: CoreWeave / NVIDIA Инстансы CoreWeave с ускорителями NVIDIA RTX Pro 6000 Blackwell Server Edition доступны в конфигурациях, насчитывающих до восьми GPU. Задействованы два процессора Intel Xeon поколения Emerald Rapids, а также DPU NVIDIA BlueField-3. Экземпляры предоставляют свыше 7 Тбайт пространства для хранения данных на основе NVMe SSD. Говорится о поддержке служб CoreWeave Observability Services, которые отвечают за детальный мониторинг использования ресурсов, а также предоставляют данные о системных ошибках, температуре и пр. Это помогает быстро обнаруживать и устранять проблемы, минимизируя сбои в рабочих процессах. Новые инстансы доступны посредством CoreWeave Kubernetes Service (CKS) и Slurm on Kubernetes (SUNK) в американском регионе CoreWeave US-EAST-04.

12.07.2025 [17:08], Руслан Авдеев

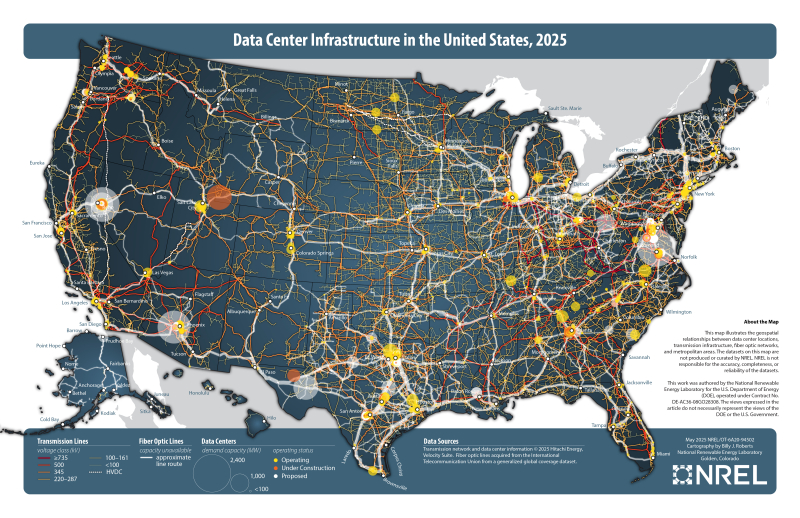

Нет чипов — нет ЦОД: строящиеся ради ИИ электростанции могут так и не пригодитьсяСогласно докладу London Economics International (LEI), хотя ИИ ЦОД требуют всё больше энергии, всё ещё нельзя точно сказать, насколько целесообразно строить много электростанций и ЛЭП для них — не исключено, что производители чипов попросту не справятся с поставками ускорителей, сообщает The Register. О «прожорливости» ИИ ЦОД говорят достаточно давно. Так, Deloitte Insights предсказывает, что к 2035 году общий объём потребляемой энергии дата-центрами в США увеличится в пять раз. Для их поддержки необходимо построить множество новых электростанций и обновить энергосети. Тем не менее, есть риск, что рост ЦОД не достигнет прогнозируемого уровня, а станции и ЛЭП окажутся невостребованными. При этом немалые расходы на такое масштабирование энергетической инфраструктуры придётся нести другим клиентам. London Economics International (LEI) по запросу SELC (Southern Environmental Law Center), известной своими тяжбами с xAI по вопросам экологии, подготовила исследование рынка энергетики и ЦОД в США. LEI пришла к выводу, что прогнозировать будущий спрос на электричество довольно трудно, в результате компании заведомо завышают его. Например, строители ЦОД буквально дублируют заявки на подключение ЦОД в разных юрисдикциях, что усложняет реальную оценку спроса. Впрочем, это не главное. Основная проблема в том, что для столь масштабного развития ИИ-инфраструктуры может попросту не хватить чипов. Если ЦОД не удаётся ввести в эксплуатацию из-за нехватки компонентов, то и лишние энергетические мощности не понадобятся. По словам авторов доклада, если все проекты ЦОД, запланированные к постройке в США в 2025–2030 гг., будут реализованы, то 90 % глобального прироста поставок ИИ-чипов в тот же период придётся на Соединённые Штаты. Такой сценарий совершенно не реалистичен, поскольку сегодня на США приходится менее 50 % спроса на полупроводники. Наращивать закупки ИИ-чипов намерены и другие страны. Кроме того, сама политики новой администрации США тормозит развитие данного сегмента. В LEI пришли к выводу, что риск построить слишком много энергомощностей выше, чем слишком мало. При этом ошибка прогнозирования может дорого обойтись, а в первую очередь пострадают существующие клиенты энергокомпаний. Строго говоря, энергокомпании США уже повышают тарифы. По данным The Financial Times, такое решение приняли National Grid и Northern Indiana Public Service Company. А Reuters сообщила, что PJM Interconnection, которая обслуживает Аллею дата-центров в Вирджинии, рассчитывает уже этим летом увеличить счета более чем на 20 %.

11.07.2025 [18:32], Руслан Авдеев

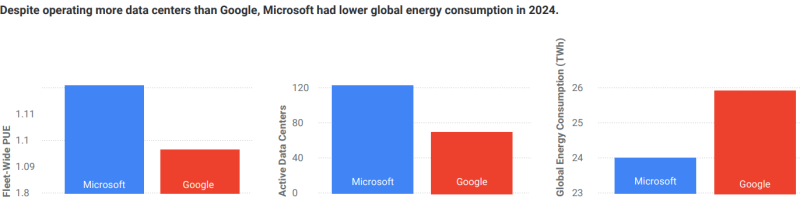

Бюрократы да экологи: Microsoft посетовала на трудность развития ЦОД в ЕвропеК 2027 году Microsoft рассчитывает более чем удвоить мощность европейских дата-центров. При этом в компании предполагают, что добиться необходимых результатов будет непросто из-за раздутой бюрократии и экологических норм, сообщает The Register. Компания пообещала усилить поддержку европейского бизнеса на фоне трений с США, в т.ч. в области защиты пользовательских данных и обеспечения «цифровой надёжности». Ранее Microsoft пообещала расширить парк дата-центров в 16 европейских странах, нарастив в течение двух лет их мощность на 40 % и более чем вдвое увеличив присутствие в сравнении с 2023 годом — всего компания будет располагать более 200 ЦОД в регионе. Утверждается, что компания не выросла в Европе так же, как выросла в США, из-за ряда сложностей, в том числе регулирования деятельности и строгих оценок воздействия на окружающую среду. Именно поэтому работать в Европе немного сложнее и несколько дороже, чем в США, считают в Microsoft. В Европе компании угрожают моратории, да и не везде рады расширению её присутствия. Речь, по-видимому, идёт об Ирландии, где в некоторых регионах фактически введён мораторий на создание новых ЦОД из-за нехватки энергии, но в то же время проводится «зелёная» политика. Впрочем, в других странах быстро закупить много мощностей ЦОД тоже непросто, хотя именно это и требуется. С точки зрения Microsoft, время выхода на рынок играет решающую роль. За последние два года компания заключила много арендных сделок, что создало давление на компанию в условиях жёстких рыночных требований.

Источник изображения: Microsoft Microsoft хотела бы строить собственные дата-центры, но задержки в выдаче разрешений на покупку земель вынуждают использовать аренду как временное решение, чтобы не останавливать проекты. Однако инвестиции в колокацию становятся ненадёжными из-за масштабов проектов и бюрократических сложностей. Отдельно отмечается проблема с доступом к электроэнергии — в Европе планирование осуществляется на 18 месяцев дольше, чем где-либо ещё. Операторы энергосетей не справляются с нагрузкой, что приводит к задержкам в присоединении дата-центров. Из-за этого та же Ирландия теряет инвестиции в пользу скандинавских стран. Необходимость строительства новых ЦОД мешает Microsoft добиться «отрицательного» уровня выбросов к 2030 году. В отчёте об экоустойчивости за 2025 год компания заявила, что её выбросы всех типов (Scope 1, 2 и 3) увеличились на 23,4 % в сравнении с показателями 2020 года. Это не так плохо, как данные в докладе за предшествовавший год, где рост составил почти 30 % к 2020 году — в основном из-за развития ИИ и облака. Директор Microsoft по устойчивому развитию отметил, что в поставленные в 2020 году цели сравнимы «полётом на Луну». А пять лет спустя стало понятно, что до этого «полёта» ещё дальше. Впрочем, в Microsoft довольны тем, что рост является весьма скромным с учётом роста потребления энергии на 168 % и роста выручки на 71 % с 2020 года. Также указывается на усилия вроде подписания контрактов на 19 ГВт возобновляемой энергии в 16 странах (фактически покупке PPA) и строительстве дата-центров с применением дерева или низкоуглеродного бетона. Как утверждают в компании, это снижает углеродный след на 65 %.

11.07.2025 [14:49], Сергей Карасёв

В семейство самоуничтожающихся SSD Team Group P250Q вошли модели вместимостью до 2 ТбайтКомпания Team Group выпустила SSD серии P250Q, о подготовке которых сообщалось в марте нынешнего года. Особенностью новинок является аппаратная система самоуничтожения One-Click Data Destruction, которая гарантирует полное удаление хранящейся информации без возможности восстановления. В устройствах реализована запатентованная технология, основанная на использовании независимой электрической цепи для стирания данных на аппаратном уровне: осуществляется это путём непосредственного воздействия на чипы флеш-памяти. Для активации функции может использоваться специальная физическая кнопка: в зависимости от продолжительности нажатия на неё запускаются различные режимы уничтожения информации, а о ходе процесса информируют светодиодные индикаторы. Кроме того, предусмотрена интеллектуальная программная система автоматического возобновления процесса самоуничтожения на случай внезапного отключения питания. Таким образом, даже если выключить компьютер или извлечь накопитель после активации функции удаления, стирание данных будет завершено после восстановления подачи питания.

Источник изображения: Team Group SSD семейства P250Q выполнены в формате М.2 2280 с интерфейсом PCIe 4.0 x4 (NVMe 1.4). Применены чипы флеш-памяти 3D TLC NAND. В семейство входят модели вместимостью 256 и 512 Гбайт, а также 1 и 2 Тбайт. Заявленная скорость последовательного чтения информации достигает 7000 Мбайт/с, скорость последовательной записи — 5500 Мбайт/с. Величина MTBF (средняя наработка на отказ) превышает 3 млн часов. Диапазон рабочих температур — от 0 до +70 °C. Производитель предоставляет на накопители трёхлетнюю гарантию. Новинки ориентированы на использование в оборонном секторе, индустриальной сфере и в других областях, где требуется повышенный уровень конфиденциальности и защиты данных.

11.07.2025 [09:09], Сергей Карасёв

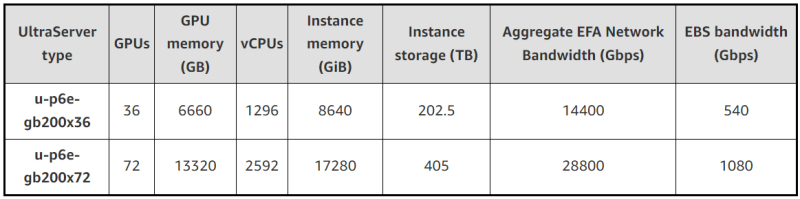

В облаке AWS появились инстансы EC2 P6e-GB200 UltraServer на базе ИИ-суперускорителей NVIDIA GB200 NVL72Облачная платформа AWS объявила о доступности высокопроизводительных инстансов EC2 P6e-GB200 UltraServer, рассчитанных на наиболее ресурсоёмкие нагрузки ИИ. В основу экземпляров положены суперускорители NVIDIA GB200 NVL72. Система GB200 NVL72 объединяет в одной стойке 18 узлов 1U, каждый из которых содержит два ускорителя GB200, что даёт в общей сложности 72 чипа B200 и 36 процессоров Grace. Задействована шина NVLink 5. Инстансы u-p6e-gb200-x72 предоставляют доступ к 72 чипам поколения Blackwell в одном домене NVLink, включая примерно 13,4 Тбайт памяти HBM3e. Производительность в режиме FP8 достигает 360 Пфлопс. Количество vCPU составляет до 2592, объём памяти — до 17 280 ГиБ. Кроме того, предоставляется до 405 Тбайт пространства для хранения данных. Используются адаптеры AWS Elastic Fabric Adapter (EFAv4) с низкой задержкой, агрегированной скоростью передачи данных 28,8 Тбит/с и поддержкой NVIDIA GPUDirect RDMA. Пропускная способность EBS достигает 1080 Гбит/с. Также доступны u-p6e-gb200-x36 с вдвое меньшими характеристиками.

Источник изображений: AWS Применяется система AWS Nitro, которая переносит функции виртуализации, хранения и сетевые операции на выделенное оборудование и ПО для повышения производительности и улучшения безопасности. Инстансы EC2 P6e-GB200 UltraServer объединяются в кластеры EC2 UltraCluster, что обеспечивает возможность безопасного и надёжного масштабирования до десятков тысяч ускорителей. AWS отмечает, что новые экземпляры подходят для работы с передовыми ИИ-моделями, насчитывающими триллионы параметров. При этом может использоваться сочетание экспертных и рассуждающих моделей. После резервирования ёмкости стоимость за инстанс списывается авансом, и цена не меняется после оплаты.

10.07.2025 [17:30], Сергей Карасёв

Bloomberg: Китай строит в пустыне гигантский комплекс ИИ ЦОД для 115 тыс. ускорителей NVIDIA, поставки которых запрещены СШАНа окраине пустыни Гоби в Синьцзяне (автономный район на северо-западе Китая), по сообщению Bloomberg News, ведутся активные работы по строительству кампуса ЦОД для ИИ-задач. Согласно имеющейся информации, в этих дата-центрах будут применяться серверы с ускорителями NVIDIA, поставки которых запрещены в КНР в соответствии с американскими санкциями. Специалисты Bloomberg News проанализировали сведения, содержащиеся в инвестиционных одобрениях, тендерных документах и заявках китайских компаний. Утверждается, что масштабные планы Китая в отношении развития ИИ прямо предусматривают использование «запрещённых» продуктов NVIDIA, а не только местных решений вроде Huawei Ascend. В частности, в IV квартале 2024 года власти Синьцзяна (Xinjiang) и соседней провинции Цинхай (Qinghai) одобрили создание в общей сложности 39 дата-центров, в которых будет задействовано более 115 тыс. ИИ-ускорителей NVIDIA. Причём во всех случаях речь идёт об H100 и H200. Операторы ЦОД в Синьцзяне намерены разместить львиную долю этих ускорителей в одном крупном комплексе, который будет использоваться для обучения передовых ИИ-моделей и других ресурсоёмких нагрузок. Строительные работы организованы в уезде Иу (Yìwū). Сотрудникам Bloomberg News не удалось установить, каким способом китайские компании намерены приобретать изделия NVIDIA, закупки которых запрещены без получения специальных лицензий от правительства США. Местные операторы дата-центров, государственные чиновники и представители центрального правительства в Пекине отказались давать какие-либо комментарии по данному вопросу. Между тем, как отмечается в публикации, стоимость 115 тыс. указанных ИИ-ускорителей может составить миллиарды долларов, исходя из цен на чёрном рынке Китая. И всё же строительство комплекса ЦОД продолжается. Синьцзян, и особенно регион Хами (Hāmì), включающий уезд Иу, богаты ветровой и солнечной энергией, а также углём. Это позволит решить вопросы, связанные с энергообеспечением дата-центров. Дополнительными достоинствами выбранного региона являются доступность больших территорий, низкая стоимость земли и прохладный климат в высотных районах. Согласно тендерной документации, полученной Bloomberg, по состоянию на июнь 2025 года по семи проектам ЦОД в Синьцзяне либо начаты строительные работы, либо выиграны тендеры на услуги ИИ-вычислений. В частности, один из крупнейших проектов связан с энергокомпанией Nyocor из Тяньцзиня (Tianjin), которая специализируется на солнечной и ветровой энергетике. Инициатива предусматривает создание дата-центра на базе 625 серверов с ускорителями H100. Nyocor продаёт вычислительные мощности корпорации Infinigence AI — одной из крупнейших организаций в сфере ИИ-инфраструктуры в Китае. В документах по 27 другим проектам ЦОД, одобренным в Синьцзяне и Цинхае в прошлом году, упоминаются в общей сложности более 9 тыс. серверов и около 72 тыс. ускорителей H100/H200. Два высокопоставленных чиновника американской администрации заявили, что по их оценкам, в Китае имеется примерно 25 тыс. запрещенных ИИ-ускорителей NVIDIA: такое количество, как утверждается, не вызывает серьёзного беспокойства. Более того, даже в случае приобретения ещё 115 тыс. карт NVIDIA масштабы соответствующих ИИ-платформ в КНР окажутся несопоставимы с мощью развитой инфраструктурой ИИ в США. Нужно отметить, что за последние годы власти Китая потратили $6,1 млрд на строительство крупных кампусов ЦОД, тогда как ещё $28 млрд вложили частные инвесторы. Площадки дата-центров появились в регионе Внутренняя Монголия, провинциях Нинся, Ганьсу, Гуйчжоу, регионе Пекин-Тяньцзинь-Хэбэй, а также в дельте Янцзы и на других территориях. Однако многие подобные объекты оказались невостребованными из-за переоценённого спроса и архитектурных недоработок.

10.07.2025 [15:49], Владимир Мироненко

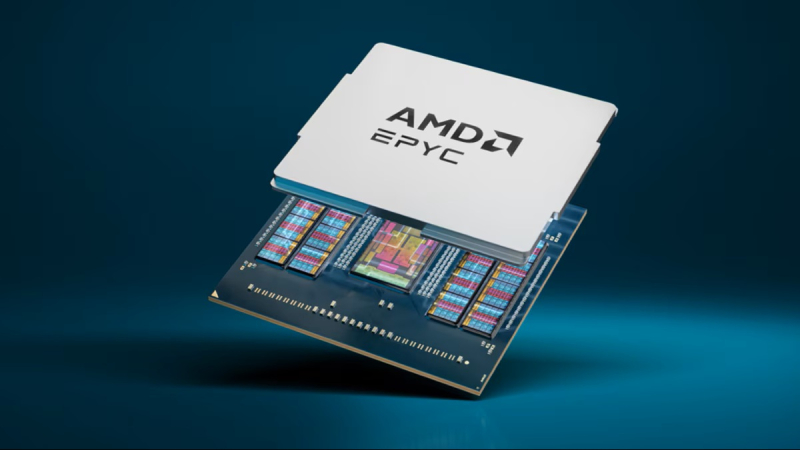

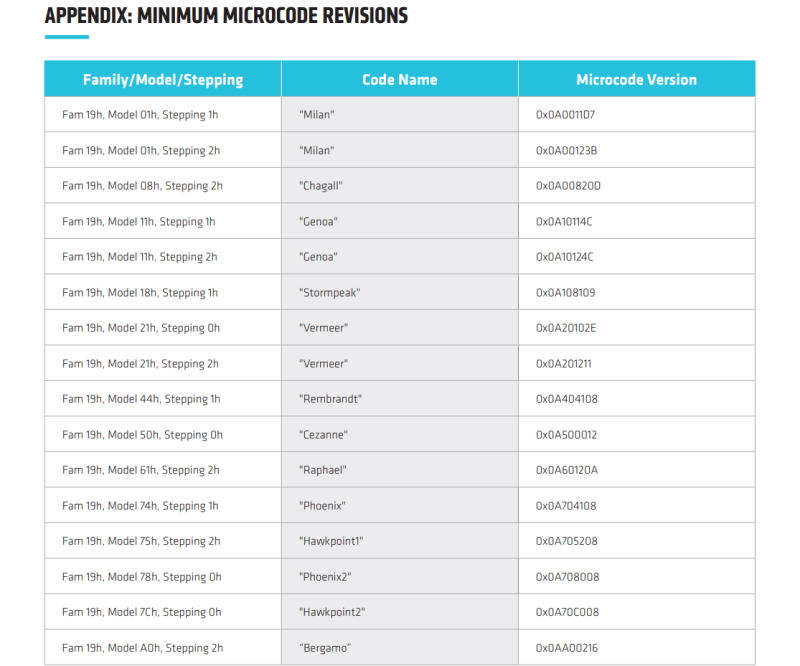

В процессорах AMD найдены уязвимости TSA, похожие на Meltdown и SpectreAMD сообщила об обнаружении нового класса микроархитектурных атак на свои процессоры — TSA (Transient Scheduler Attack). TSA подобны Meltdown и Spectre и затрагивают широкий спектр CPU AMD и способны привести к раскрытию информации. TSA включает сразу четыре уязвимости, которые были обнаружены исследователями Microsoft и Швейцарской высшей технической школы Цюриха (ETH Zurich). Две из них имеют средний уровень (medium severity) опасности, две — низкий уровень (Low severity). Несмотря на это Trend Micro и CrowdStrike оценили угрозу как «критическую», пишет ресурс The Register. Низкие оценки серьёзности объясняются высокой сложностью выполнения успешной атаки. AMD заявила, что её может осуществить только злоумышленник, способный запустить произвольный код на целевой машине, получив доступ через вредоносное ПО или вредоносную виртуальную машину, но для успешного выполнения атак требуются лишь низкие привилегии. Как утверждает AMD, TSA невозможно эксплуатировать через вредоносные веб-сайты, а для надёжного извлечения данных потребуется многократный запуск. Это связано с тем, что атака основана на использовании состояния «ложного завершения» (false completion), которое возникает, когда процессор ожидает быстрого завершения исполнения инструкций загрузки, но какое-либо условие препятствует их успешному завершению. В результате происходит повторная загрузка данных и выполнение зависимых операций, но из-за особенностей чипов «анализ времени выполнения может использоваться как источник утечки информации из микроархитектурных структур, оставшейся после спекулятивного выполнения других операций», — сообщил ресурс OpenNet. При использовании двух уязвимостей средней степени серьёзности успешные атаки на чипы AMD могут привести к утечке информации из ядра ОС. В других сценариях утечка данных может произойти также из приложений или виртуальных машин. Доступ к данным ядра потенциально может позволить злоумышленникам повысить привилегии, обойти механизмы безопасности, обеспечить персистентность и т.д. Баги низкого уровня могут привести к утечке внутренних данных о работе процессора, которые AMD не считает конфиденциальными.

Источник: AMD AMD заявила о двух различных вариантах TSA, которые могут быть реализованы на её чипах в зависимости от источника извлечения данных — TSA-SQ и TSA-L1.

Согласно технической документации AMD, уязвимости TSA-L1 вызваны ошибкой в использовании микротегов кешем L1 для поиска. Процессор может полагать, что данные находятся в кеше, хотя на самом деле это не так, что приводит к загрузке неверных данных, которые злоумышленник может затем вывести. Уязвимости TSA-SQ возникают, когда инструкция загрузки ошибочно извлекает данные из Store Queue, когда необходимые данные недоступны. В этом случае злоумышленник может обнаружить неверные данные и использовать их для извлечения информации, например, из ядра ОС, из ранее загруженных данных, даже если они выполнялись в другом контексте. Уязвимости проявляются в семействе процессоров AMD на базе микроархитектур Zen 3 и Zen 4, в том числе, в сериях Ryzen 5000/6000/7000/8000, EPYC Milan/Milan-X/Genoa/Genoa-X/Bergamo/Siena, Instinct MI300A, AMD Ryzen Threadripper PRO 7000 WX, EPYC Embedded 7003/8004/9004/97X4, Ryzen Embedded 5000/7000/V3000. В целом обновление микрокода и PI-прошивок (Platform Initialization) необходимо для чипов серий EPYC, Ryzen, Instinct.

10.07.2025 [13:32], Руслан Авдеев

«МегаФон» ввёл в эксплуатацию новые ЦОД в Твери и ЕкатеринбургеНовые дата-центры «МегаФона» заработали в Твери и Екатеринбурге. Оба ЦОД предназначены для хранения и резервного копирования информации. Предполагается, что это обеспечит сети компании дополнительные надёжность и устойчивость, сообщает пресс-служба «МегаФона». К строительству новых площадок пришлось прибегнуть из-за стремительного роста трафика и «цифровизации» различных сфер деятельности — для этого было необходимо расширить инфраструктуру оператора. Новые ЦОД используют идентичные инженерные решения, компоненты, процессы и стандарты. По данным «МегаФона», площадь каждого дата-центра составляет 800 м2, оба вмещают по 110 стоек, а IT-мощность составит 1 МВт (при размещении стандартных стоек на 7 кВт). При этом центры построены с учётом возможного использования стоек на 15 кВт с увеличением общей мощности до 1,5 МВт. Как сообщил представитель «МегаФона», сегодня повышается производительность уже действующих ЦОД и строятся новые объекты с учётом требований к энергоэффективности и высокой производительности вычислительного оборудования. Компании удалось спроектировать с нуля и построить дата-центры с учётом опыта крупных игроков рынка IT и собственных технических компетенций.

Источник изображения: Aleksei Zaitcev/unsplash.com Использованные в новых ЦОД решения позволили повысить эффективность работы на 25 %. Благодаря этому компания смогла обеспечить «большую плотность эксплуатации сегмента IT-инфраструктуры», сообщают в «МегаФоне». Такой подход позволяет развивать новые услуги и сервисы с повышенными требованиями к качеству, надёжности и доступности. Введённые в эксплуатацию ЦОД соответствуют мировым стандартам надёжности и предполагают возможность ремонта без остановки работы. Они стали частью обширной сети ЦОД «МегаФона» из 115 объектов общей ёмкостью более 10 тыс. стоек. Ключевые дата-центры находятся в Москве, Санкт-Петербурге, Новосибирске, Екатеринбурге, Самаре и Хабаровске. В этом году запланирован запуск двух ЦОД «принципиально новой конструкции» в Санкт-Петербурге и Новосибирске. В конце июня сообщалось, что «МегаФон» заканчивает строительство 5-МВт ЦОД в Новосибирске с возможностью масштабирования до 20 МВт.

10.07.2025 [13:27], Руслан Авдеев

Количество заказчиков Arm из сферы ЦОД выросло в 14 раз с 2021 годаПо словам Arm, с 2021 года количество заказчиков, использующих в дата-центрах Arm-чипы, выросло в 14 раз до 70 тыс. Под руководством генерального директора компании Рене Хааса (Rene Haas) разработчик полупроводниковых технологий расширяет бизнес работал над продвижением своих решений на рынке ПК и существенно нарастив продажи на рынке чипов для ЦОД, сообщает Reuters. По словам IDC, Arm-чипы постепенно захватывают рынок, но до доминирования на рынке ЦОД им ещё далеко. Как и другие полупроводниковые компании, Arm немало выиграла от ИИ-бума — значительная доля роста в сегменте решений для ЦОД связана именно с ИИ. Компания заявила, что число стартапов, использующих Arm-архитектуру для чипов с 2021 года выросло в 12 раз. Это помогает компании, поскольку сегменты ПК и мобильных решений развиваются весьма медленно. Компания отказалась предоставить годовой финансовый прогноз при публикации последнего отчёта, сославшись на неопределенность на рынках.

Источник изображения: Arm Ранее рынок ЦОД считался довольно сложным для проникновения на него Arm-технологий, но не так давно AWS, Google и Microsoft занялись разработкой собственных чипов для дата-центров на Arm-архитектуре. Amazon уже представила несколько поколений классических серверных CPU для дата-центров с 2018 года, а также варианты для ИИ-задач — с тех пор она добавила миллионы чипов на базе Arm для обслуживания своей облачной платформы. Пользователи некоторых сервисов могут даже не знать, что их задачи обрабатываются Arm-процессорами Amazon. Для успеха компании, создающей полупроводниковые технологии, необходимо, чтоб их поддерживали разработчики приложений по всему миру. По данным Arm, компания с 2021 года добилась приблизительного удвоения числа приложений, работающих на Arm-процессорах — приблизительно до 9 млн. Количество разработчиков, работающих с вычислительной архитектурой Arm, увеличилось с 2021 года в 1,5 раза до 22 млн человек.

10.07.2025 [10:03], Руслан Авдеев

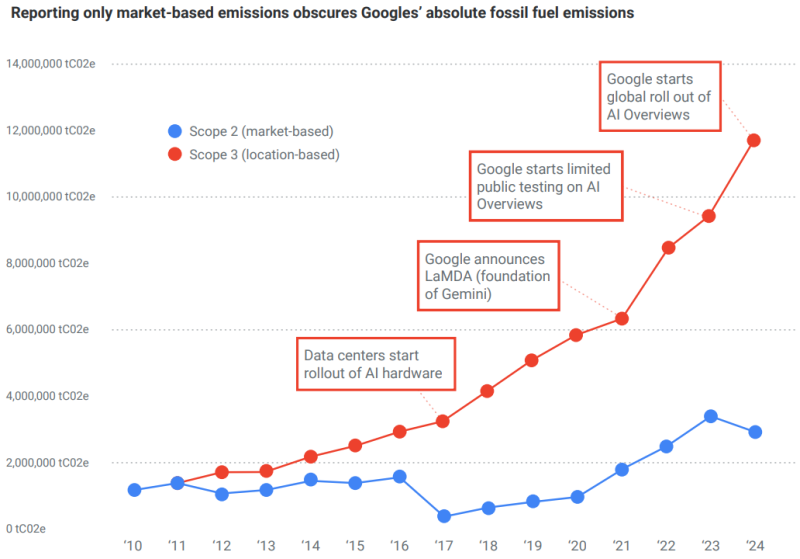

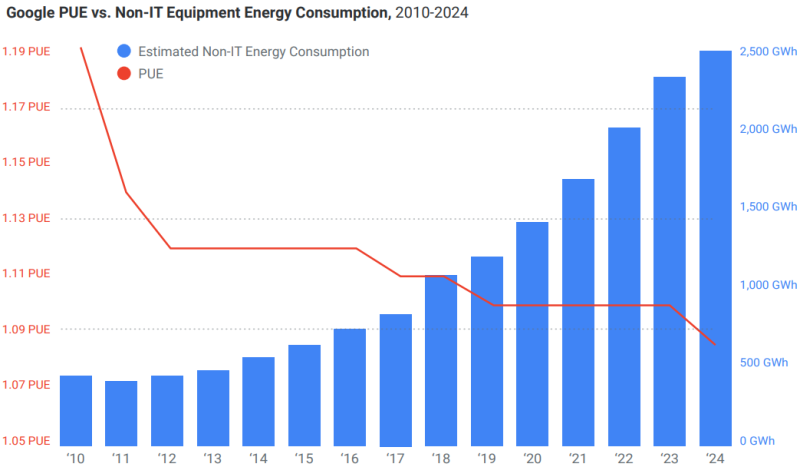

Углеродные выбросы Google выросли на 1515 % за 14 лет, но компания уверяет, что экоактивисты перевирают фактыGoogle негативно отреагировала на доклад НКО Kairos Fellowship, где говорится о «пробелах» в данных Google о сокращении углеродных выбросов. В Google утверждают, что анализ, проведённый НКО, «искажает факты» из ежегодных отчётов об экоустойчивости, сообщает Computer Weekly. В докладе Kairos Fellowship утверждается, что Google использует отчёты об экоустойчивости, чтобы ввести в заблуждение общество относительно прогресса в деле сокращения углеродных выбросов. Kairos Fellowship заявила, что 2,5 года работала над освещением вклада техногигантов в климатический кризис. Были тщательно проанализированы публичные отчёты Google, связанные с охраной окружающей среды, и проведены подробные расчёты и анализ представленных экологических данных. В результате НКО пришла к выводу, что данные о прогрессе Google в сокращении выбросов в 2024 календарном году не соответствуют истине. В отчёте Google говорится о сокращении выбросов ЦОД на 12 % несмотря на увеличение энергопотребления на 27 %. Также сообщается, что общие выбросы парниковых газов Scope 1, 2 и 3 выросли год к году на 6,2 %, они растут третий год подряд вместе с ростом бизнеса. Утверждается, что большая часть выбросов — косвенные, связанные с цепочкой поставок (Scope 3). При этом выбросы Scope 1 и 2 сократились на 8 % и 11 % соответственно год к году.

Источник изображения: Ella Ivanescu/unsplash.com Выбросы Scope 3 выросли на 22 %, во многом из-за роста мощностей ЦОД. Подчёркивается, что выбросы Scope 3 будут возникать в процессе производства и развёртывания ИИ-инфраструктуры, сопутствующей логистики, а также в процессе строительства самих дата-центров. Хотя в целом выбросы и увеличились, Google по-прежнему намерена достичь нулевых выбросов к 2030 году благодаря инвестициям в технологические решения, связанные с удалением углерода.

Источник: Kairos Fellowship Вместе с тем в отчёте признаётся, что отрасль ЦОД переживает переломный момент из-за быстрого внедрения ИИ и ситуация вносит значительную неопределённость, способную повлиять на будущие показатели. Одной из главных проблем является потенциальная возможность «нелинейного» роста ИИ из-за высоких темпов его развития и неизвестно, сколько для этого потребуется энергии и инфраструктуры, что затрудняет возможность прогнозирования. В Kairos Fellowship утверждают, что выбросы парниковых газов Google росли не три года, а почти 15 лет. В НКО уверены, что Google вводит общественность в заблуждение относительно сокращения выбросов. Так, расследование показало, что с 2010 по 2024 гг. они выросли на 1515 %. Другими словами, в 2024 году Google выбросила на 21,9 млн т больше, чем 14 лет назад. Снижение выбросов, связанных с энергопотреблением, рассчитывается по «рыночному» методу, который учитывает покупку «зелёной» энергии (включая экологические сертификаты), но не отражает физические выбросы от работы дата-центров.

Источник: Kairos Fellowship В том, что ИИ виновен в росте выбросов, выводы Google и Kairos Fellowship совпадают. В НКО заявили, что агрессивные инвестиции в генеративный ИИ и сопутствующую инфраструктуру — один из главных факторов, влияющих на климатические проблемы. Выбросы Scope 2, связанные с энергией, покупаемой Google для своих ЦОД, выросли с 2010 года на 820 %. Более того, с 2019 года Google сумела фактически сократить только выбросы Scope 1, составляющие лишь 0,31 % от общего объёма выбросов в 2025 году. Главная проблема, по мнению Kairos Fellowship, в том, что Google представляется добросовестным игроком, в то же время скрывая рост выбросов углерода и прочие подробности вроде объёмов использования питьевой воды, играя терминологией и т.п. Данные скрываются или маскируются, поэтому часто остаются незамеченными.

Источник: Kairos Fellowship Google заявила, что факты искажает сама Kairos Fellowship. Выбросы компании, как утверждается, подсчитываются в соответствии с распространённым Протоколом по парниковым газам (Greenhouse Gas Protocol) и подтверждаются независимыми экспертами. В частности, амбиции положительно оценила ведущая отраслевая организация Science Based Targets. Выбросы не просто сократились на 12 % — в этом году запущено более 25 проектов в области чистой энергетики. Правда, в прошлом году компания сама призналась, что из-за ИИ за пять лет выбросы парниковых газов выросли на 48 %. |

|