Материалы по тегу: aws

|

04.09.2025 [16:33], Руслан Авдеев

AWS инвестирует $4,4 млрд в новозеландские облачные ЦОДAmazon (AWS) анонсировала открытие в Новой Зеландии облачного региона, а также намерение потратить более NZ$7,5 млрд ($4,4 млрд) на местные дата-центры. Впервые о плане было объявлено ещё в 2021 году, а теперь он получил «второе дыхание», сообщает Bloomberg. Для страны это достаточно значимая инвестиция. AWS создаст облачный регион AWS Asia Pacific, чтобы удовлетворить растущий спрос на облачные сервисы по всей стране. Как сообщают в AWS, строительство, эксплуатация и обслуживание дата-центров позволит ежегодно создавать более 1 тыс. рабочих мест с полной занятостью. Кроме того, увеличится валовый внутренний продукт Новой Зеландии — приблизительно на NZ$10,8 млрд. (более $6.3 млрд). Сроки инвестиций не называются. Новая Зеландия стремится стать новым «магнитом» для иностранных инвестиций в ЦОД, чтобы придать импульс местной экономике, в прошлом году погрузившейся в глубокую рецессию и до сих пор не восстановившейся. Власти специально реформировали градостроительные законы, желая ускорить выдачу разрешений на новые проекты. Кроме того, для привлечения иностранных инвесторов и предпринимателей скорректирован визовый режим. Власти отметили, что по данным Amazon, строительство в Новой Зеландии на 20 % дороже, чем в соседней Австралии, поэтому необходимо менять законы. Новый облачный регион обеспечит уже имеющимся клиентам вроде Xero и Kiwibank возможность локального выполнения любых рабочих нагрузок, локального же хранения данных и предоставления цифровых услуг с малой задержкой. Это, по мнению AWS, позволит быстрее создавать новые облачные продукты. В Новой Зеландии постепенно реализуют всё новые проекты, связанные с дата-центрами и сопутствующей инфраструктурой. Одним из важнейших стал анонсированный весной 2025 года проект Google и Vocus, желающих дотянуть до побережья страны подводный интернет-кабель Honomoana.

27.08.2025 [08:58], Руслан Авдеев

Южнокорейские энергетики помогут AWS и X-energy развернуть в США сеть малых модульных реакторов для ИИ ЦОДAmazon (AWS) и разработчик малых модульных реакторов (SMR) X-energy заключили соглашения о партнёрстве с южнокорейскими Korea Hydro & Nuclear Power и Doosan Enerbility с целью развёртывания в США более 5 ГВт атомных мощностей на базе SMR Xe-100 к 2039 году — в первую очередь для удовлетворения потребностей ЦОД в электричестве, сообщает Datacenter Dynamics. Компании намерены привлечь до $50 млрд государственных и частных инвестиций для постройки Xe-100 и расширения цепочек поставок. В X-energy заявляют, что партнёрство объединяет южнокорейские энергетические и атомные технологии с передовыми реакторными и топливными технологиями X-energy, чтобы решить «историческую» энергетическую задачу, ускорив вывод Xe-100 на рынок. Утверждается, что сотрудничество США и Южной Кореи в этом секторе жизненно важно для сохранения лидерства США в гонке за ИИ. Соглашение будет способствовать более тесному сотрудничеству между ядерными секторами Южной Кореи и США, с опорой на существующие отношения X-energy. В частности, предусмотрено сотрудничество в сфере проектирования реакторов, развития цепочек поставок, планирования строительных проектов, в сфере инвестиционных стратегий и долгосрочной эксплуатации реакторов для комбинации атомных и ИИ-проектов. В AWS подчёркивают, что потребности ИИ ЦОД в электроэнергии растут, поэтому новое партнёрство позволит развить инновационные безуглеродные решения и технологии в этой сфере, что поможет получить США более 5 ГВт новых генерирующих мощностей.

Источник изображения: X-energy Xe-100 представляет собой высокотемпературный газовый реактор, использующий топливные элементы размером с бильярдный шар, каждый из которых содержит тысячи фрагментов уранового топлива. Реактор будет вырабатывать 80 МВт электрической и 200 МВт тепловой энергии. В феврале X-energy завершила раунд финансирования серии C-1, аккумулировав $700 млн. Средства потратят на завершение проектирования и лицензирования SMR, строительство первой очереди завода по производству топлива TRISO-X в США, а также на проекты, в которых предполагается использовать SMR X-energy. В прошлом году Amazon уже объявила о партнёрстве с X-energy и инвестициях в стартап. В рамках соглашения с Amazon будет поставлено четыре SMR консорциуму государственных коммунальных предприятий Energy Northwest. Ожидается, что реакторы станут генерировать порядка 320 МВт на начальном этапе, но с возможностью увеличения общей мощности до 960 МВт. Ввод в эксплуатацию первых мощностей запланирован на начало 2030-х гг. На днях также стало известно, что американская TerraPower поможет SK Group сформировать в Южной Корее экосистему малых модульных реакторов. Ранее в августе поддерживаемая Google компания Kairos Power подписала соглашение о покупке 50 МВт электроэнергии с Tennessee Valley Authority (TVA) для поставок электричества в дата-центры Google. А Equinix подписала три крупных соглашения с передовыми разработчиками атомных реакторов на поставку до 774 МВт электроэнергии. Кроме того, за последний год Data4, Oracle, Switch и Endeavour также подписали соглашения с разработчиками SMR.

23.08.2025 [12:29], Владимир Мироненко

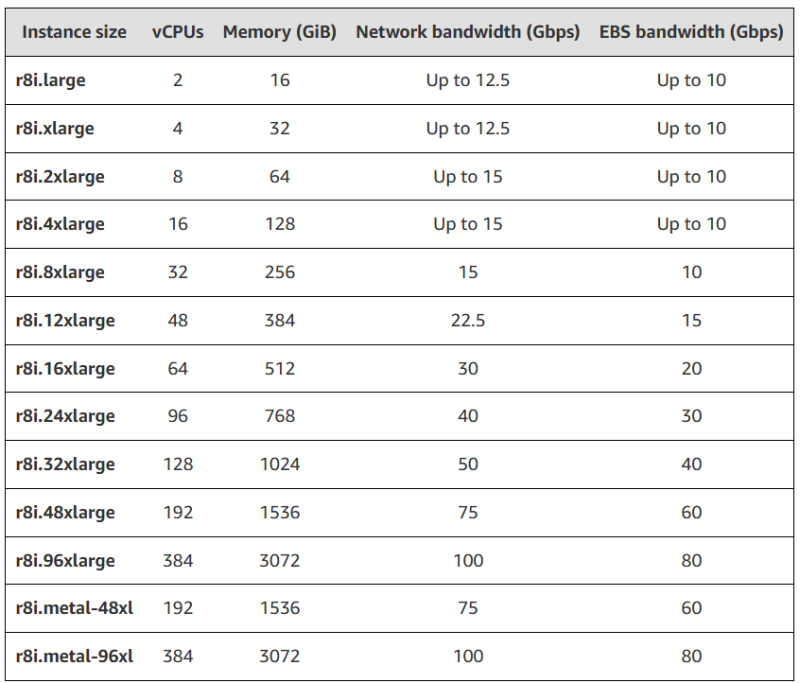

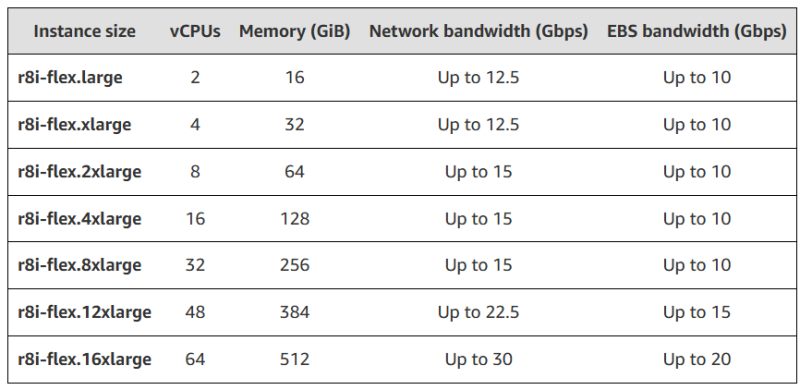

AWS анонсировала инстансы R8i и R8i-flex на кастомных Intel Xeon 6Amazon Web Services объявила об доступности инстансов R8i и R8i-flex, оптимизированных для рабочих нагрузок с интенсивным использованием памяти и базирующихся на кастомных процессорах Intel Xeon 6, доступных только в AWS. По словам компании, эти CPU «обеспечивают самую высокую производительность и самую высокую пропускную способность памяти среди сопоставимых процессоров Intel в облаке». Инстансы R8i и R8i-flex предлагают до 15 % лучшее соотношение цены и производительности и в 2,5 раза большую пропускную способность памяти по сравнению с инстансами предыдущего поколения на базе процессоров Intel. Новинки обеспечивают на 20 % более высокую производительность, чем инстансы R7i, с ещё большим приростом производительности для определённых рабочих нагрузок. Они обеспечивают до 30 % более высокую скорость обработки для баз данных PostgreSQL, до 60 % быстрее работают с NGINX и до 40 % быстрее — с рекомендательными DL-моделями по сравнению с R7i. Инстансы R8i и R8i-flex идеально подходят для различных рабочих нагрузок, требующих больших объёмов памяти, таких как базы данных SQL и NoSQL, распределённые кеши (Memcached и Redis), in-memory СУБД (SAP HANA) и инструменты аналитики больших данных в реальном времени (Apache Hadoop и Apache Spark). R8i-flex — первые оптимизированные для интенсивного использования памяти инстансы Flex — доступны в наиболее распространённых размерах, от L до 16xLarge, и, по словам компании, являются отличным выбором для приложений, которые не используют все вычислительные ресурсы полностью, позволяющим добиться дополнительного 5 % улучшения соотношения цены и производительности при 5 % снижении цен. Инстансы R8i доступны в 13 размерах, включая два bare metal-инстанса и новый экземпляр 96xLarge для самых крупных приложений: 384 vCPU и 3 ТиБ RAM. Инстансы R8i сертифицированы SAP и обеспечивают производительность 142 100 aSAPS, что является самым высоким показателем среди всех сопоставимых машин в локальных и облачных средах. Инстансы R8i и R8i-flex используют карты AWS Nitro шестого поколения с Amazon EBS, что значительно повышает пропускную способность сети для рабочих нагрузок, обрабатывающих небольшие пакеты, таких как веб-серверы, серверы приложений и игровые серверы. Экземпляры R8i и R8i-flex также поддерживают настройку полосы пропускания сети с 25-% корректировкой распределения между внешней сетью и полосой Amazon EBS, что позволяет повысить производительность базы данных, скорость обработки запросов и ведения журнала. Дополнительные улучшения включают поддержку типа данных FP16 в Intel AMX для поддержки ИИ-обучения и инференса. Как отметил ресурс The Register, этот анонс — хорошая новость для Intel, поскольку в эти непростые времена гиперскейлеры являются ключевым клиентом для любого производителя чипов. Инстансы R8i и R8i-flex доступны в регионах AWS: US East (Северная Вирджиния), US East (Огайо), US West (Орегон) и Europe (Испания).

11.08.2025 [09:00], Руслан Авдеев

AWS предложила «дяде Сэму» облачные услуги на $1 млрдПравительство США намерено расширить использование AWS — компания готова предоставить американским властям облачные кредиты на сумму $1 млрд до 31 декабря 2028 года, сообщает The Register. Кредиты можно использовать для внедрения облачных технологий, получения IT-сервисов, обучения и иных услуг, необходимых правительству для «перехода от устаревшей локальной инфраструктуры к облачной». Администрация общего обслуживания США (англ. General Services Administration, GSA), обеспечивающая связью и прочей инфраструктурой другие федеральные ведомства страны, заявило, что соглашение с AWS позволит оптимизировать предоставление критически важных сервисов, поможет внедрению облачных и ИИ-технологий, а также значительно сократить расходы. Это последняя из сделок в рамках стратегии государственных закупок OneGov, о которой GSA объявило в апреле 2025 года. OneGov может изменить порядок закупок товаров и услуг госучреждениями, при этом первый этап программы сосредоточен на IT-продуктах. OneGov во многом предусматривает отказ от разрозненных закупок товаров и услуг в пользу крупных соглашений федерального масштаба со стандартизированными условиями и ценами. Поскольку необходимость согласования каждой закупки отпадёт, ожидается экономия как времени, так и средств. В рамках OneGov уже заключены соглашения, предусматривающее значительные скидки на технологии Oracle для госзаказчиков, а также предоставление государственным ведомствам доступа к ChatGPT Enterprise за символическую сумму в $1. В рамках проекта AWS услуги будут предоставляться любым федеральным правительственным клиентам при посредничестве GSA. Также соглашение предусматривает «оптимизированное взаимодействие» между AWS и федеральными агентствами без посредников и со значительной экономией. Выход AWS на федеральный уровень в облачном сегменте оказался как нельзя кстати. Недавно Microsoft обвинили в привлечении китайских сотрудников для поддержки клиентов Azure из числа американских госструктур. Это может поставить крест на всех усилиях Microsoft, которая потратила годы на завоевание расположения властей США.

02.08.2025 [21:58], Владимир Мироненко

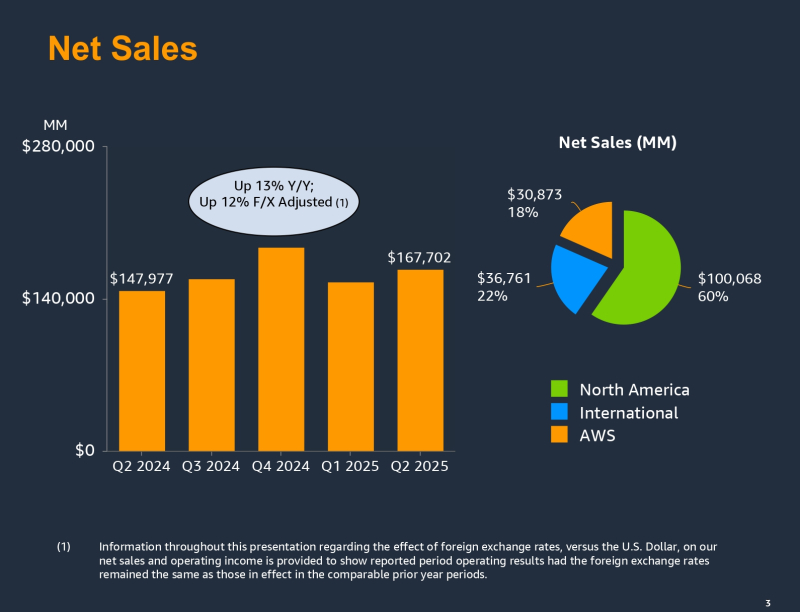

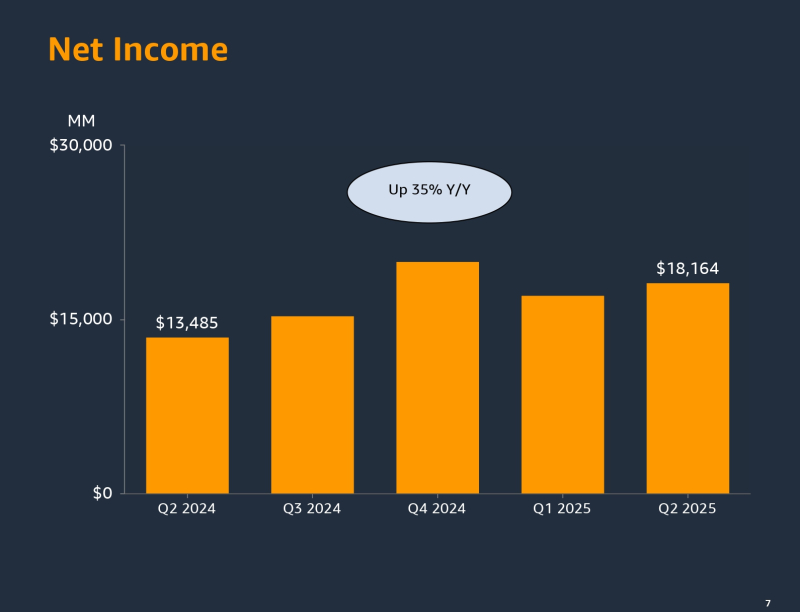

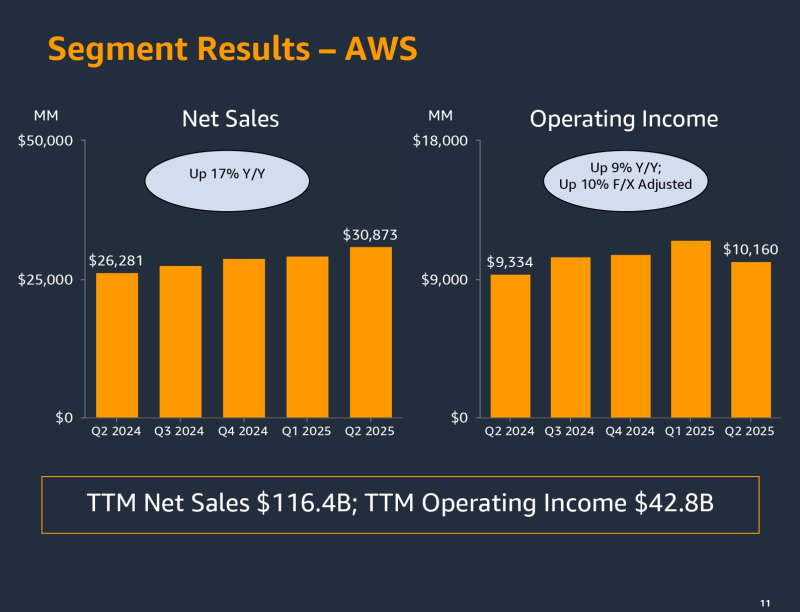

Amazon за год вложит в инфраструктуру рекордные $118 млрд, но рост ИИ ЦОД сдерживает нехватка электроэнергииAmazon.com сообщила о значительном росте выручки и прибыли во II квартале 2025 года, завершившемся 30 июня, но акции гиганта электронной коммерции упали более чем на 7 % после закрытия торгов, поскольку темпы роста её подразделения облачных вычислений Amazon Web Services (AWS) не оправдали ожиданий инвесторов, пишет Reuters. Вместе с тем результаты II квартала показали, что Amazon лучше справляется с меняющейся тарифной политикой США, чем опасались на Уолл-стрит, отметил ресурс CNBC. Amazon увеличила выручку на 13 % до $167,7 млрд, превысив прогноз Уолл-стрит в размере $162.1 млрд. Чистая прибыль компании составила $18,2 млрд, что на 35 % больше результата годом ранее. Прибыль на разводнённую акцию составила $1,68 при прогнозе аналитиков $1,33. Облачное подразделение AWS принесло компании $30,9 млрд, что на 17,5 % больше, чем годом ранее, и на 3 % — чем в предыдущем квартале. Выручка AWS больше, чем у облачных подразделений Microsoft и Google, сообщивших о $29,9 и $13,6 млрд соответственно, но инвесторы отметили значительно более низкие темпы роста выручки AWS. У Google Cloud выручка выросла за последний квартал на 32 % в годовом исчислении, у Microsoft Azure — на 26 %. Согласно публикации Data Center Dynamics, глава Amazon Энди Джасси (Andy Jassy) сказал: «Годовые проценты и темпы роста всегда зависят от базы, с которой вы работаете. И наш бизнес в сегменте AWS значительно крупнее, чем у других. Думаю, доля второго игрока составляет около 65 % от размера AWS». В отчётном квартале у AWS была более низкая рентабельность, чем в предыдущих кварталах. Его операционная прибыль составила $10,2 млрд, что ниже средней оценки аналитиков в $10,9 млрд, согласно StreetAccount. Это чуть более половины операционной прибыли компании, равной $19,2 млрд. Доход AWS составляет небольшую часть общей выручки Amazon, но является ключевым источником прибыли, обычно обеспечивая около 60 % от общей операционной прибыли компании. Во II квартале капитальные вложения Amazon составили $31,4 млрд, что выше прогноза Уолл-стрит, равного $26,4 млрд (по данным The Wall Street Journal). По словам Джасси, Amazon будет тратить примерно столько же в следующих двух кварталах. С учётом того, что капзатраты в I квартале составили $24,3 млрд общая сумма капвложений в 2025 финансовом году составит $118 млрд, что намного больше прогнозируемых $100 млрд. Капитальные вложения Google в последнем квартале составили $22,4 млрд, Microsoft — $24,2 млрд. Энди Джасси отметил ряд факторов, сдерживающих развёртывание облачной инфраструктуры компании и не позволяющий обеспечить растущий спрос на ИИ-сервисы. Наибольшее влияние оказывают проблемы с обеспечением объектов электроэнергией. За ними следуют «периодические ограничения, связанные с чипами, а затем с некоторыми компонентами для производства серверов». Он заявил, что вряд ли эти проблемы решатся в 2025 году, но выразил уверенность, что ситуация будет улучшаться с каждым кварталом. Несмотря на большие вложения в ИИ-инфраструктуру аналитики отмечают, что отсутствие у AWS сильной ИИ-модели вызывает опасения, что компания может отставать от конкурентов в разработке ИИ. Результаты AWS «вызывают тревогу», заявил Дэйв Вагнер (Dave Wagner), управляющий портфелем Aptus Capital Advisers, владеющей акциями Amazon. В ответ Джасси сообщил, что «сейчас ещё слишком рано говорить об ИИ», отметив партнёрство компании с Anthropic, которая обучает свои модели на ускорителях Trainium2 от Amazon. Он добавил, что чипы собственной разработки компании предлагают на 30–40 % лучшее соотношение цены и производительности. «Я думаю, что значительная часть вычислений и инференса в конечном итоге будет выполняться на базе Tranium. И я думаю, что это соотношение цены и производительности будет иметь значение для людей по мере масштабирования», — сообщил руководитель Amazon. Джасси также отметил то, что 85–90 % мировых ИТ-расходов приходится на локальные, а не на облачные решения, и компания ожидает, что ситуация изменится в ближайшие 10–15 лет. Этот сдвиг, по словам Джасси, принесёт пользу AWS. «Значительная часть инференса генеративного ИИ станет просто ещё одним строительным блоком, таким как вычисления, хранение и базы данных. И пользователи захотят запускать эти приложения рядом с теми местами, где работают их другие приложения, где находятся их данные. В AWS обрабатывается гораздо больше приложений и данных, чем где-либо ещё», — отметил глава Amazon. Касаясь миграции из локальной среды в облако, Джасси также отметил несколько новых соглашений с такими компаниями, как PepsiCo, Airbnb, Peloton, Nasdaq, Лондонская фондовая биржа, Nissan Motor, GitLab, SAP, Warner Bros. Discovery, Twelve Labs, FICO, Iberia Airlines, SK Telecom и NatWest. Amazon сообщила о сокращении 14 тыс. рабочих мест в отчётном квартале, в том числе в AWS, книжном подразделении, отделе гаджетов и подкастов, что стало первым сокращением с начала 2024 года. В настоящее время штат компании составляет 1,46 млн человек. Согласно прогнозу Amazon, в III квартале 2025 года выручка будет находиться в диапазоне $174,0– $179,5 млрд, что представляет собой рост год к году от 10 до 13 % и выше консенсус-прогноза аналитиков, опрошенных LSEG, в $173,08 млрд. Прогноз компании по операционной прибыли оказался ниже ожиданий аналитиков — $15,5–$20,5 млрд, что в средней точке ниже целевого показателя Уолл-стрит в $19,45 млрд.

29.07.2025 [14:58], Руслан Авдеев

Удар по Ирландии: Amazon отказалась от строительства фабрики серверов в стране за €300 млнAmazon отказалась от нового объекта в Дублине. Инвестиции, оцениваемые приблизительно в €300 млн ($353 млн), предназначались для AWS. По имеющимся данным, компания планировала построить новую площадку для производства передовых серверных стоек для ЦОД, сообщает Bloomberg. Отмена такого знакового проекта вызывает особое беспокойство у местных экспертов, учитывая огромную зависимость страны от прямых иностранных инвестиций, в первую очередь из США. Сегодня в Ирландии более 600 тыс. человек работают в иностранных компаниях — это около 20 % от общего числа работающего населения. Инвестиции приносят немалые деньги и государству. В прошлом году Ирландия получила рекордные €39 млрд корпоративного налога. В результате в стране сформировался даже бюджетный профицит — довольно редкое явление для современных европейских стран. В AWS сообщили, что компания разочарована тем, что проект не удалось реализовать, но предполагаются и другие инвестиции в Ирландию, если для этого будут созданы благоприятные условия. На Amazon в стране сегодня уже работает порядка 6,5 тыс. человек. Эта новость усиливает обеспокоенность властей страны нестабильностью корпоративного налога — особенно с учётом того, что президент США и его соратники неоднократно подчёркивали, что профицитом Ирландия обязана именно Америке. С учётом столь значимой угрозы правительство Ирландии уже дало понять, что в текущем году придётся расходовать бюджет более осторожно — в отличие от 2024 года, когда средства буквально «раздавались».

Источник изображения: Dmitry Ant/unsplash.com По данным Bloomberg, решение AWS связано с проблемами энергоснабжения проекта и большими сроками подключения объекта к электросети. Решение Amazon может усилить беспокойство, связанное с нехваткой электричества для ИИ, дата-центров и других передовых технологий — особенно в тех местах, где энергетические сети уже находятся в плохом состоянии и под большой нагрузкой. Хотя бум ИИ позволил выделить на ЦОД миллиарды долларов, строительство некоторых объектов уже пришлось отменить. В марте-апреле сообщалось, что Microsoft отложила реализацию в текущем году ряда проектов, в том числе в Индонезии, Великобритании, Австралии и нескольких штатах США, включая Огайо. Желая повысить конкурентоспособность отрасли ЦОД, правительство Ирландии буквально на днях подписало обновлённый план развития инфраструктуры на €112 млрд, рассчитанный до 2030 года, и направленный на решение проблем с размещением, энергоснабжением и водными ресурсами. Инвестиции в ключевые коммунальные структуры уже пострадали от мирового финансового кризиса, и это стало большим разочарованием для предприятий различного назначения. Ассоциация IBEC (Irish Business and Employers Confederation) — крупнейший лоббист интересов бизнеса в Ирландии — призвала правительство отдать приоритет инфраструктуре в сравнении с другими расходами, включая сокращение налогов. Утверждается, что стране необходимо наверстать десятилетия недостаточных инвестиций и задержек в реализации планов. Американская торговая палата в Ирландии (American Chamber of Commerce in Ireland) также предупредила, что инфраструктура является критически важным приоритетом для её членов. На этом фоне положение с энергоснабжением в стране настолько серьёзное, что в феврале местный регулятор CRU предложил операторам ЦОД самим заняться строительством электростанций и энергохранилищ. Проблема в том, что Ирландские ЦОД за восемь лет увеличили энергопотребление на 473 %. В июне сообщалось, что Ирландия готова разрешить дата-центрам строить не только электростанции, но и частные линии электропередач.

27.07.2025 [23:55], Владимир Мироненко

Microsoft признала, что не может гарантировать суверенитет данных в Европе

aws

microsoft

microsoft azure

software

гиперскейлер

европа

евросоюз

закон

информационная безопасность

конфиденциальность

облако

сша

франция

Microsoft «не может гарантировать» суверенитет данных клиентам во Франции, и, как следствие, всему Европейскому союзу, если администрация Трампа потребует доступ к информации о клиентах, хранящейся на её серверах, пишет The Register. Об этом сообщил, выступая перед Сенатом Франции в рамках расследования государственных закупок и их роли в обеспечении цифрового суверенитета Европы, Антон Карньо (Anton Carniaux), директор по связям с общественностью и правовым вопросам французского отделения Microsoft. Согласно Акту о законном использовании данных за рубежом (The Cloud Act), правительство США наделено правом получать цифровые данные, хранящиеся у американских технологических корпораций, причём в независимости от того, хранятся ли эти данные на серверах внутри страны или за рубежом, и даже если эти данные принадлежат не гражданам США. Отвечая на вопрос о технических или юридических механизмах, которые могли бы помешать такому доступу в соответствии с The Cloud Act, Карньо заявил, что компания «имеет договорное обязательство перед своими клиентами, включая клиентов государственного сектора, отклонять эти запросы, если они необоснованны». Ранее Microsoft заверила, что работа облачных сервисов в ЕС будут контролироваться местным советом директоров и действовать в соответствии с местным законодательством. Карньо подчеркнул, что правительство не может делать запросы, которые не имеют чёткого определения — если такие запросы поступают, компания просит о возможности уведомить об этом соответствующего клиента. Карньо также спросили, может ли он, как представитель руководства Microsoft, в случае юридически обоснованного судебного запрета «гарантировать нашему комитету под присягой», что данные французских граждан не будут переданы американскому правительству без явного согласия французского правительства. «Нет, — сказал Карньо, — я не могу этого гарантировать, но, опять же, такого никогда раньше не случалось». Марк Буст (Mark Boost), генеральный директор облачного провайдера Civo, заявил: «Одна строка показаний только что подтвердила, что американские гиперскейлеры не могут гарантировать суверенитет данных в Европе». По его словам, Microsoft открыто признала то, что многим давно известно: согласно законам вроде The Cloud Act власти США могут принудительно запрашивать доступ к данным, хранящимся у американских провайдеров облачных услуг, независимо от того, где эти данные физически хранятся. «Это больше, чем просто формальность. Это реальная проблема, которая может повлиять на национальную безопасность, конфиденциальность персональных данных и конкурентоспособность бизнеса», — заявил Марк Буст. Параллельно на этой неделе AWS пояснила некоторые моменты реализации требований The Cloud Act в связи с ростом числа «запросов о том, как мы обрабатываем запросы государственных органов на предоставление данных». AWS утверждает, что закон не предоставляет правительству США «беспрепятственный или автоматический доступ к данным, хранящимся в облаке». The Cloud Act позволил США заключать взаимные исполнительные соглашения с доверенными иностранными партнёрами с целью получения доступа к электронным доказательствам для расследования тяжких преступлений, где бы эти доказательства ни находились, устранив препятствия, предусмотренные законодательством США. «Согласно законодательству США, провайдерам фактически запрещено раскрывать данные правительству США при отсутствии предусмотренного законом исключения», — сообщила AWS. — «Чтобы обязать провайдера раскрыть данные, правоохранительные органы должны убедить независимого федерального судью в наличии причины, связанной с конкретным преступлением, и в том, что доказательства преступления будут обнаружены там, где должен быть произведён обыск». AWS заявила, что до этого момента не раскрывала данные корпоративных или государственных клиентов в соответствии с законом The Cloud Act. По словам AWS, принципы закона «соответствуют международному праву и законам других стран»; и закон «не ограничивает технические меры и операционные средства контроля, которые AWS предлагает клиентам для предотвращения несанкционированного доступа к их данным». И последний аргумент AWS, который явно направлен против европейских конкурентов, пытающихся воспользоваться движением за суверенитет данных, заключается в том, что The Cloud Act распространяется не только на компании с головным офисом в США, но и на всех «поставщиков услуг электронной связи или удалённых вычислений», ведущих бизнес в США. То есть поставщики облачных услуг со штаб-квартирой в Европе, ведущие деятельность в США, также подпадают под его действие. Microsoft, AWS и Google пытаются заверить обеспокоенных клиентов в ЕС в том, что они смогут обеспечить суверенитет данных при не совсем дружелюбной позиции США по отношению к странам, некогда считавшимся близкими союзниками. Несмотря на это, в ЕС наблюдается тенденция на создание суверенной инфраструктуры, отметил The Register, хотя не все поддерживают эту идею. Более того, многие в Европе смирились с тем, что без американских облаков уже не обойтись. Согласно данным Synergy Research Group, доля локальных игроков на облачном рынке Европы замерла на уровне 15 %. При этом часть из них ещё и попала в зависимость от новой политики Broadcom в отношении VMware.

24.07.2025 [15:50], Руслан Авдеев

AWS закрыла ИИ-лабораторию в ШанхаеAmazon Web Services закрыла лабораторию, занимавшуюся разработками в сфере искусственного интеллекта в Шанхае (КНР). Речь идёт о центре Amazon Web Services AI Shanghai Lablet, открывшемся в 2018 году, сообщает The Financial Times. Сколько сотрудников работало в китайском подразделении, не уточняется. Бывший сотрудник лаборатории сообщил, что структура ликвидируется в связи со «стратегическими изменениями на фоне напряжённости в отношениях США и Китая». Предполагается, что в основном сотрудники занимались разработкой инструментов для ИИ и вопросами обработки естественного языка. По имеющимся данным, именно шанхайская лаборатория сыграла ключевую роль в создании open source инструмента Deep Graph — библиотека предназначалась для работы с графовыми нейросетями. Хотя ранее в этом месяце США отменили правила, запрещавшие NVIDIA и AMD поставлять в КНР ослабленные ИИ-ускорители, представители американских властей подчеркнули, что в будущем контроль за продажами таких чипов вновь может быть ужесточён. В новейшем программном документе Белого дома AI Action Plan рекомендуется «использовать творческие подходы к обеспечению экспортного контроля» и противостоянию с соперниками в целом уделяется немало внимания.

Источник изображения: Jerry Zhang/unsplash.com Также не исключается, что закрытие ИИ-лаборатории связано с недавней волной сокращений в AWS по собственной инициативе, которая коснулась «как минимум сотни» должностей. Вероятно, это коснулось и подразделения AWS, занимающегося обучением и сертификацией. Как сообщал представитель Amazon, после тщательного анализа деятельности организации, её приоритетов и целей на будущее принято трудное бизнес-решение о ликвидации некоторых ролей в командах AWS. Сокращают работы над ИИ в Китае и некоторые другие компании. Ранее сообщалось, что консалтинговая McKinsey & Co. приказала местному подразделению воздержаться от проектов, связанных с системами генеративного ИИ. В китайском подразделении работают более 1 тыс. сотрудников. В начале марта появилась информация, что IBM закроет в стране R&D-центр, оставив без работы 1,8 тыс. сотрудников. Впрочем, IBM поспешила заверить, что не уходит из КНР. В 2025 году Microsoft предложила «релокацию» 700–800 сотрудникам в Китае. По данным СМИ, речь идёт о специалистах в сфере ИИ и облаков. По некоторым расчётам, это около 10 % от общего числа сотрудников в филиале, относящемся к Азиатско-Тихоокеанскому региону, в основном действующем в Китае. Предполагается, что ранее компания уже закрыла лабораторию IoT and AI Insider Lab в Шанхае. С 2017 года такие центры по всему миру в основном помогают клиентам компании создавать подключенные устройства с ИИ-функциями. Буквально на днях представитель Microsoft заявил о смене политики в отношении госзаказчиков из Минобороны США — теперь ни одна инженерная команда из Китая не будет оказывать техподдержку облаку Пентагона и связанным сервисам. Дело в том, что Microsoft, как оказалось, передавала данные из Пентагона на аутсорс китайским коллегам.

19.07.2025 [00:15], Руслан Авдеев

Углеродные выбросы Amazon выросли в 2024 году на 6 % из-за ИИ ЦОД и любителей шопингаУглеродные выбросы Amazon выросли в 2024 году, впервые за три года — это следствие масштабного строительства дата-центров, сообщает Bloomberg. Правда, компанию обвиняют в сокрытии реальных объёмов выбросов её ЦОД. Некоторую роль в росте выбросов сыграло и потребление топлива сервисами доставки. В ежегодном отчёте Amazon, посвящённом устойчивому развитию, крупнейший онлайн-ретейлер мира сообщил росте выбросов на 6 % год к году — они составили 68,25 млн т в CO2-эквиваленте (при этом показатель за 2023 год был скорректирован до 64,38 млн т). В 2019 году компания обязалась свести выбросы к нулю к 2040 году, однако с тех пор они выросли на треть. Впрочем, и к этим данным у активистов есть вопросы. Для сравнения, с 2019 по 2023 гг. включительно выбросы Google выросли на 48 %, а за последние 14 лет, по данным НКО Kairos Fellowship, на 1515 %. Amazon, как и её конкуренты, вкладывает немалые ресурсы в строительство и эксплуатацию дата-центров для ИИ-приложений. Всё это требует очень много бетона и стали, которые требуют много энергии при производстве. Да и самим ИИ ЦОД нужно немало электричества. В некоторых регионах энергокомпании возвращаются к использованию газа и угля для генерации электричества, хотя ещё совсем недавно такие энергоносители теряли популярность. Технологические компании обещали найти более «чистые» источники энергии и свести к минимуму углеродные выбросы. Amazon, как и Alphabet (Google), Meta✴ и Microsoft заключили ряд сделок, связанных с использованием «безуглеродной» атомной энергии в ближайшие годы. В целом сообщалось, что Amazon, Meta✴ и Google помогут утроить мощность АЭС во всём мире к 2050 году. Среди гиперскейлеров Amazon первой обратилась напрямую к АЭС для закупки энергии. Тем временем в 2024 году выбросы Amazon, связанные с закупаемой электроэнергией, выросли на 1 % год к году — впервые с тех пор, как компания начала публиковать соответствующие показатели в 2019 году. Сообщается, что отчасти это связано с повышением потребления электричества. Как заявляют в отчёте Amazon, именно поэтому так важно масштабировать безуглеродную энергетику. В прошлом году Amazon снова стала крупнейшим в мире корпоративным покупателем возобновляемой энергии.

16.07.2025 [12:16], Руслан Авдеев

Пенсильвания получит более $90 млрд инвестиций на развитие ИИ, ЦОД и энергетики

aws

blackstone

brookfield

coreweave

google

hardware

ии

инвестиции

полезные ископаемые

сша

финансы

цод

энергетика

Президент США Дональд Трамп (Donald Trump) объявил о частных инвестициях в Пенсильвании на сумму более $90 млрд, которые связаны с ИИ, технологиями и энергетикой, сообщает The Verge. Пенсильвания лидирует по добыче газа в стране, а сам Трамп неоднократно призывал «бурить и бурить», чтобы спасти энергетику США, и поддержал угольный сектор ради удовлетворения спроса ИИ ЦОД на электричество. BlackStone вложит $25 млрд в развитие ЦОД и энергетической инфраструктуры на северо-востоке Пенсильвании, а First Energy потратит $15 млрд. Enbridge планирует инвестировать $1 млрд в расширение газопроводов в Пенсильванию, Equinor потратит $1,6 млрд на увеличение добычи природного газа в штате и его доставку для гибкой генерации энергии для дата-центров. Capital Power заявила, что потратит на модернизацию «газового объекта» в штате $3 млрд в течение 10 лет. Google намерена инвестировать $25 млрд в строительство ЦОД и ИИ-инфраструктуры в следующие два года в регион PJM (Pennsylvania-New Jersey-Maryland), фактически объединяющий 13 штатов и Вашингтон (округ Колумбия). Кроме того, планируется заключить 20-летний контракт на $3 млрд с Brookfield Energy для развития гидроэнергетики. Кроме того, в апреле сообщалось, что в Пенсильвании построят газовую электростанцию мощностью 4,5 ГВт для ИИ ЦОД на месте заброшенной угольной. CoreWeave объявила о планах инвестировать $6 млрд в ИИ ЦОД в штате. По данным Bloomberg, речь идёт о запуске в Ланкастере (Lancaster) кампуса мощностью 100 МВт в 2026 году с возможным масштабированием до 300 МВт. Примечательно, что объявление сделано после того, как власти Пенсильвании пригрозили отключить штат от сети PJM Interconnection из-за высокого спроса со стороны ИИ ЦОД в соседних штатах. Пенсильвания является нетто-экспортёром электроэнергии и, по данным BAI Group, обеспечивает до четверти энергоснабжения штатов на востоке США и Среднем Западе.

Источник изображения: Addy Mae/unsplash.com Amazon упомянула планы вложить $20 млрд в расширение инфраструктуры облачных вычислений и продвижения ИИ-инноваций в Пенсильвании. Ранее AWS уже получила 650 га для постройки 15 ЦОД в Пенсильвании недалеко от АЭС, но столкнулась с некоторыми проблемами, которые теперь решает. Anthropic потратит $1 млн в течение трёх лет на поддержку программы обучения кибербезопасности, а также $1 млн за три года на исследования в области энергетики в Университете Карнеги-Меллона. Meta✴ же анонсировала партнёрство для поддержки стартапов в сельской местности Пенсильвании на сумму $2,5 млн, а также поддержку обучение представителей малого бизнеса. |

|